文章信息

- 李金瑶, 柳懿垚, 姜伟

- Li Jinyao, Liu Yiyao, Jiang Wei

- 基于多模态超声图像的深度学习在鉴别诊断乳腺良恶性肿块中的应用

- Application of deep learning based on multimodal ultrasound images in differential diagnosis of benign and malignant breast masses

- 实用肿瘤杂志, 2025, 40(1): 20-27

- Journal of Practical Oncology, 2025, 40(1): 20-27

基金项目

- 深圳市科创委基金面上项目(JCYJ20220530142002005)

-

通信作者

- 姜伟, Email: 2646748175@qq.com

-

文章历史

- 收稿日期:2024-03-15

2. 深圳大学医学部生物医学工程学院, 广东 深圳 518060

2. School of Biomedical Engineering, Health Science Center, Shenzhen University, Shenzhen 518060, China

乳腺癌是一种常见的恶性肿瘤,严重危害女性生命健康。根据世界卫生组织国际癌症研究机构(International Agency for Research on Cancer, IARC)发布的数据显示,2020年乳腺癌在全球新发病例超过230万例,使乳腺癌成为当年全球发病率最高的癌症[1]。2020年我国乳腺癌女性新发病近42万例,死亡近12万例,分别占我国女性癌症新发病例数和死亡病例的20.1%和10.2%[1]。乳腺癌作为我国发病率最高的癌症之一,给患者家庭和社会带来沉重的负担[2]。中国卫生健康“十四五”全民健康信息化规划提出,希望通过数字化和智能化的手段,加强癌症早期筛查和诊断的力度,改善治疗效果和患者生活质量;鼓励推广智能医疗设备和平台,提高医疗资源的利用效率,降低医疗成本;同时促进智能医学的发展,加强乳腺癌的早期筛查与精准诊断,提升乳腺癌防控效果。然而研究表明,我国乳腺癌早期发现率 < 20%,通过筛查发现的乳腺癌比例 < 5%,且我国乳腺癌患者患病5年内生存率明显低于欧美国家[3]。

临床实践中通常使用影像学检查实现乳腺癌早期精准诊断[4],如超声、X光钼靶和MRI等。超声无辐射、价格低且适用于亚洲女性致密型乳房,是我国早期乳腺癌最常见的影像筛查方法,可用于发现肿块、囊肿和钙化等异常情况[5]。除常规灰度超声外,超声弹性成像近来也被用于乳腺肿瘤的筛查和诊断,其测得的肿瘤硬度值和图像模式均对肿瘤诊断具有重要意义[6]。最新的自动乳腺全容积成像通过自动扫查整个乳腺,对于小体积病灶具有较低的漏诊率,且其独特的冠状面特征具有较高的临床诊断价值[7]。不同的超声成像模式可以显示互补的临床特征信息,综合分析不同模态影像的数据有助于实现乳腺癌早期精准诊断。有学者设计的可解释的深度学习(deep learning, DL)系统将彩色多普勒图像的血流特征与B型(B-mode)和应变弹性成像(strain elastography, SE)图像相结合,形成三模态诊断模型,受试者工作特征(receiver operating characteristic, ROC)曲线的曲线下面积(area under the curve, AUC)为0.955[5]。但关于联合二维与三维乳腺超声结合的多模态的DL模型尚未见报道。本研究拟以乳腺B型、SE和ABVS超声图像为基础,利用人工智能(artificial intelligence, AI)进行DL,设计可以智能识别乳腺肿块并进行分类的模型,比较各模型在诊断乳腺肿块中的诊断效能,为乳腺疾病智能化诊断提供临床与科研的新思路。

1 资料与方法 1.1 一般资料回顾性收集并分析2021年8月至2023年8月在华中科技大学协和深圳医院超声科进行乳腺超声检查的病例508例,其中良性病例449例,恶性病例59例,所有病例均行B型、SE和ABVS检查。本研究经华中科技大学协和深圳医院科研伦理委员会批准(批件号:KY-2022-042)。

1.2 仪器和检查方法 1.2.1 仪器3种模态的超声图像采集都由SIEMENS ACUSON Oxana 2型ABVS系统的超声诊断仪(西门子股份公司,德国)采集,探头配置14L5BV高频线阵探头。实验室的处理器为Intel Xeon E7 56核心(英特尔公司,美国),512 GB运行内存,图形处理单元(graphics processing unit, GPU)为英伟达TITAN RTX显存24 GB(NVIDIA,美国)。

1.2.2 检查方法患者平躺,手臂举过头顶,保持轻松的呼吸。由2名超声科高年资医师(从事乳腺超声诊断工作 > 20年)扫查乳腺并进行B型图像和SE图像的采集。对ABVS图像的采集,调整超声机械臂以确保探头对乳房施加最佳压力,不会造成患者不适。对乳房的中线、外侧和内侧位置进行连续扫描,如有需要,扫描额外的平面。检查后,将轴向图像发送到专用工作站进行图像矢状和冠状重建。

1.3 图像预处理研究中的体素间隔范围为0.212~0.219,0.0490.102,1.0 mm/voxel,故需对图像数据进行体素一致化操作,利用3次样条插值将原始体素间隔转变为[1.0, 1.0, 1.0] mm/voxel,使得图像数据的单个体素在3个维度都表示1 mm的物理间隔。

1.4 多模态交互融合模型的构建与分类 1.4.1 单模态模型的构建基于B型图像和SE图像的单模态模型分别于单模态下对乳腺肿块B型图像和SE图像分类,通过训练数据样本有监督地学习特征后分类,采用DenseNet 121[8]、GoogleNet[9]、MobileNet[10]、NasNet[11]、ResNet18[12]、ResNext[13]、SENet[14]和ShuffleNet[15]等网络模型进行对比。

1.4.2 基于ABVS图像模型的分割与分类模型ABVS系统产生的三维乳腺图像数据量较大,常规的DL方式训练时间长。本研究使用三维双分支分割网络模型[16]。三维双分支分割网络模型是由DS-Transformer和卷积神经网络(convolutional neural network, CNN)结构组成的双分支分割网络模型。在减小自注意力复杂度的同时可实现ABVS图像中的肿块诊断,有效解决ABVS图像阅片这一艰巨的任务。为了该模型的有效性,将该模型与2种现有模型进行比较,包括nnUNet[17]和CoTr[18]。由于Dice系数(Dice coefficient, DC)和交并比(intersection over union, IoU)的微小改进并不是模型有效性的良好指标,因此采用敏感度和false-positive numbers per volume(FPs/vol)来评估每种模型在肿瘤水平上的性能。先使用三维双分支分割网络[16]对ABVS图像肿瘤分割定位,然后运用基于双分支多视角自注意力编码器[19]的乳腺肿瘤良恶性分类模型,将原始ABVS图像进行预处理并提取多视角切片图像,再将3个主视角图像和6个辅助视角图像分别送入网络的2个分支,之后分别输出其特征信息并进行特征融合,得到最终的肿瘤良恶性分类结果。

1.4.3 双模态模型的构建与分类将B型和SE图像分别输入2个并行的CNN编码器中。在编码器的最后一层之后,使用类激活图的概念来准确标定两组图像中的肿瘤位置,并使用仿射变换大致对齐这2种图像。同时,采用2个不同的互注意力融合模块来交互性地融合来自2个分支的特征。最后用基于强化学习的方法,通过输出概率和批次内的数据分布来监控状态。

1.5 多模态DL(Multimodal-DL)模型的构建与分类[20]将原始ABVS图像进行预处理并提取多视角切片图像,得到主视角交叉图像和6个视角截面图像;扫描获取B型图像和SE图像。将6个视角截面图像、B型图像和SE图像分别进行切块嵌入操作处理后输入到深度自注意力编码器中,得到辅助视角特征、B型图像特征和SE图像特征。将主视角交叉图像中3个角度视图进行两两交叉组合形成3个交叉视角图像,将SE图像进行切块嵌入操作处理后通过空间注意力计算得到包含硬度信息的注意力矩阵,通过注意力矩阵对3个交叉视角图像加权。将硬度信息添加到3个交叉视角图像中,经过交叉视角切块嵌入操作后输入到深度自注意力编码器中,得到主视角交叉图像特征。将主视角交叉图像特征、辅助视角特征、B型图像特征和SE图像特征进行特征融合(图 1)。

|

| 注 ABVS:自动乳腺全容积成像(automated breast volume scanner);ROI:感兴趣区域(region of interest);Fa:ABVS图像特征;Fg:灰度图像特征;MAF:互注意力融合(mutual attention fusion);CEM:色彩提取模块(color extract module);Ffusion1:融合特征1;Fe:弹性图像特征;EEM:边缘提取模块(edge extract module);Ffusion2:融合特征2;αt:损失函数的系数权重;γ:损失函数的指数权重 图 1 多模态特征融合的分类网络 Fig.1 Classification network with multimodal feature fusion |

使用PyTorch框架在配备24 GB内存的5个TITAN RTX GPU上训练模型。将输入的图像块大小设置为[256, 256],批量大小设置为16,初始学习率设置为5×10-4。此外,学习率衰减权重设置为0.98,衰减周期设置为5,最大周期设置为5 000。

1.7 统计学分析采用SPSS 26.0统计学软件进行统计学分析。计量资料采用均数±标准差(x±s)表示,组间比较采用t检验。采用ROC曲线的AUC评价DL模型的诊断效能,各模型AUC的比较采用t检验。采用准确度、敏感度、特异度、Youden指数、F1分数和AUC作为分类评估指标。在数据不平衡的情境下,F1分数和Youden指数较准确度更能有意义地展示结果。以P < 0.05为差异具有统计学意义。

2 结果 2.1 基本信息最终采集508例肿瘤图像,包括B型508幅、SE 508幅和ABVS 508幅,其中良性肿瘤449例,恶性肿瘤59例,均为女性。508例采用简单随机抽样方法分为模型训练集(n=284)和测试集(n=224)。训练集中,良性肿瘤250例,年龄18~62岁,(36.3±9.1)岁,肿块大小(11.8±6.1)mm;恶性肿瘤34例,年龄32~66岁,(48.8±11.2)岁,肿块大小(18.2±8.2)mm。测试集中,良性肿瘤199例,年龄20~61岁,(37.7±9.2)岁,肿块大小(12.7±5.9)mm;恶性肿瘤25例,年龄26~65岁,(47.5±10.1)岁,肿块大小(18.7±8.4)mm。

2.2 基于ABVS图像的分割比较三维双分支分割网络模型、nnUNet模型和CoTr模型分割ABVS图像的结果显示,三维双分支分割网络模型DC、IoU和敏感度最高,分别为73.65%、61.10%和91.7%,FPs/vol最低(表 1),整体优于另外2种模型。初步推断分层变压器结构更适合于ABVS图像的分割定位,有助于运用基于双分支多视角自注意力编码器的分类模型对分割出来的乳腺肿块进行分类。

| 模型 | DC(%) | IoU(%) | HD_95 | ASD | 敏感度 | FPs/vol |

| nnUNet | 67.81±2.80 | 56.70±1.91 | 14.22±4.12 | 1.62±1.40 | 0.861 | 0.500 |

| CoTr | 71.26±3.54 | 59.88±4.81 | 21.55±4.58 | 1.58±1.65 | 0.917 | 0.500 |

| 三维双分支分割网络 | 73.65±1.56 | 61.10±2.36 | 23.23±5.92 | 0.87±0.76 | 0.917 | 0.467 |

| 注 DC:Dice系数(Dice coefficient);IoU:交并比(intersection over union);HD_95:95%的Hausdorff distance(HD);ASD:平均表面距离(average surface distance);FPs/vol:false-positive numbers per volume | ||||||

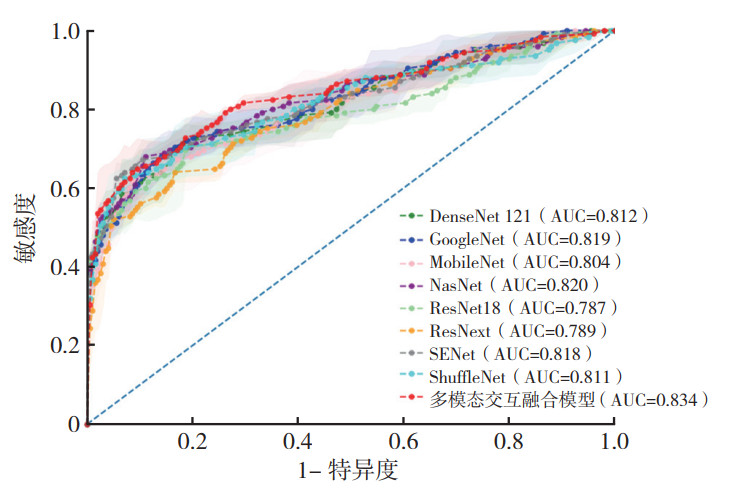

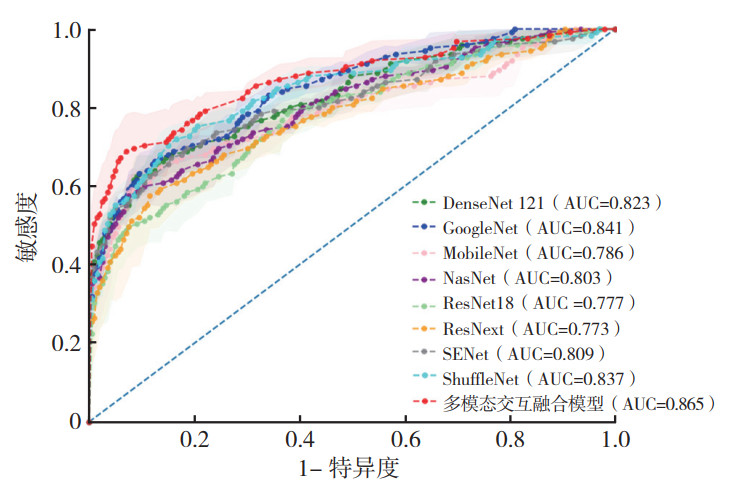

基于单独B型图像的9种DL模型诊断效能分析显示,多模态交互融合模型对B型图像的分类性能最优,对乳腺肿块的分类准确度达90.6%,特异度为98.1%,AUC为0.817(表 2,图 2)。基于SE图像的9种DL模型诊断效能分析显示,多模态交互融合模型对SE图像的分类性能亦最优,AUC为0.834(表 3,图 3)。

| DL模型 | 准确度 | 敏感度 | 特异度 | F1分数 | Youden指数 | AUC |

| DenseNet 121 | 0.762 | 0.600 | 0.782 | 0.366 | 0.382 | 0.766 |

| GoogleNet | 0.873 | 0.416 | 0.931 | 0.423 | 0.347 | 0.812 |

| MobileNet | 0.863 | 0.424 | 0.919 | 0.410 | 0.343 | 0.738 |

| NasNet | 0.838 | 0.456 | 0.885 | 0.391 | 0.341 | 0.797 |

| ResNet18 | 0.834 | 0.480 | 0.878 | 0.403 | 0.358 | 0.812 |

| ResNext | 0.756 | 0.664 | 0.768 | 0.402 | 0.432 | 0.760 |

| SENet | 0.751 | 0.632 | 0.766 | 0.373 | 0.398 | 0.764 |

| ShuffleNet | 0.876 | 0.256 | 0.954 | 0.258 | 0.210 | 0.760 |

| 多模态交互融合模型 | 0.906 | 0.312 | 0.981 | 0.426 | 0.293 | 0.817 |

| 注 DL:深度学习(deep learning);AUC:曲线下面积(area under the curve) | ||||||

|

| 注 AUC:曲线下面积(area under the curve) 图 2 不同DL模型基于B型图像鉴别乳腺良恶性肿块的ROC曲线 Fig.2 ROC curves of different DL models based on B-mode images for differentiating benign and malignant breast masses |

| DL模型 | 准确度 | 敏感度 | 特异度 | F1分数 | Youden指数 | AUC |

| DenseNet 121 | 0.828 | 0.616 | 0.854 | 0.470 | 0.470 | 0.812 |

| GoogleNet | 0.892 | 0.520 | 0.939 | 0.519 | 0.459 | 0.819 |

| MobileNet | 0.832 | 0.600 | 0.861 | 0.450 | 0.461 | 0.804 |

| NasNet | 0.839 | 0.640 | 0.864 | 0.489 | 0.504 | 0.820 |

| ResNet18 | 0.902 | 0.512 | 0.951 | 0.537 | 0.463 | 0.787 |

| ResNext | 0.801 | 0.624 | 0.823 | 0.420 | 0.447 | 0.789 |

| SENet | 0.829 | 0.688 | 0.847 | 0.476 | 0.535 | 0.818 |

| ShuffleNet | 0.858 | 0.624 | 0.887 | 0.513 | 0.511 | 0.811 |

| 多模态交互融合模型 | 0.859 | 0.608 | 0.890 | 0.485 | 0.498 | 0.834 |

| 注 DL:深度学习(deep learning);AUC:曲线下面积(area under the curve) | ||||||

|

| 注 AUC:曲线下面积(area under the curve) 图 3 不同DL模型基于SE图像鉴别乳腺良恶性肿块的ROC曲线 Fig.3 ROC curves of different DL models based on SE images for differentiating benign and malignant breast masses |

基于单独ABVS图像的DL模型诊断乳腺肿块的准确度为91.5%,敏感度为64.0%,特异度为95.0%,F1分数为0.627,Youden指数为0.590,AUC为0.781。

2.4 双模态DL模型的诊断效能基于联合B型和SE图像的9种DL模型对乳腺良恶性肿块诊断效能显示,多模态交互融合模型分类性能最优,准确度达90.9%,AUC为0.865(表 4,图 4)。

| DL模型 | 准确度 | 敏感度 | 特异度 | F1分数 | Youden指数 | AUC |

| DenseNet 121 | 0.850 | 0.576 | 0.884 | 0.485 | 0.460 | 0.823 |

| GoogleNet | 0.900 | 0.504 | 0.950 | 0.537 | 0.454 | 0.841 |

| MobileNet | 0.889 | 0.536 | 0.934 | 0.519 | 0.469 | 0.786 |

| NasNet | 0.813 | 0.624 | 0.837 | 0.435 | 0.461 | 0.803 |

| ResNet18 | 0.886 | 0.312 | 0.960 | 0.328 | 0.272 | 0.777 |

| ResNext | 0.762 | 0.664 | 0.775 | 0.385 | 0.439 | 0.773 |

| SENet | 0.856 | 0.624 | 0.885 | 0.495 | 0.509 | 0.809 |

| ShuffleNet | 0.895 | 0.552 | 0.938 | 0.548 | 0.490 | 0.837 |

| 多模态交互融合模型 | 0.909 | 0.624 | 0.945 | 0.587 | 0.569 | 0.865 |

| 注 DL:深度学习(deep learning);AUC:曲线下面积(area under the curve) | ||||||

|

| 注 AUC:曲线下面积(area under the curve) 图 4 不同DL模型基于联合B型和SE图像鉴别乳腺良恶性肿块的ROC曲线 Fig.4 ROC curves of different DL models based on a combination of B-mode and SE images for differentiating benign and malignant breast masses |

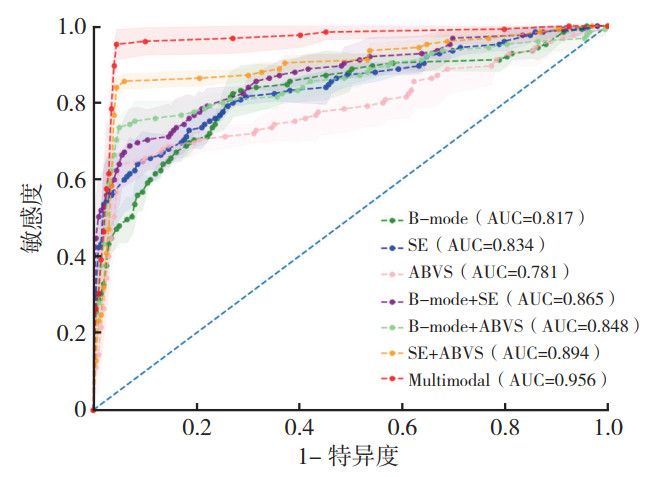

针对构建的7个多模态交互融合模型,包括基于B型(B-mode)、SE、ABVS、联合B型和SE(B-mode+SE)、联合B型和ABVS(B-mode+ABVS)及联合SE和ABVS(SE+ABVS)的DL模型,以及联合B型、SE和ABVS(B-mode+SE+ABVS)的Multimodal-DL模型,比较其诊断乳腺良恶性肿块的效能。结果显示,Multimodal-DL模型诊断乳腺良恶性肿块的准确度和敏感度分别为95.4%和95.2%,均高于其他6种DL模型,差异均具有统计学意义(均P < 0.05,表 5)。Multimodal-DL模型诊断AUC和Youden指数分别为0.955和0.907,均大于其他6种DL模型(表 5,图 5)。Multimodal-DL模型对乳腺良恶性肿块的诊断效能效果最好。

| DL模型 | 准确度 | 敏感度 | 特异度 | F1分数 | Youden指数 | AUC |

| B-mode | 0.906 | 0.312 | 0.981 | 0.426 | 0.293 | 0.817 |

| SE | 0.859 | 0.608 | 0.890 | 0.485 | 0.498 | 0.834 |

| ABVS | 0.915 | 0.640 | 0.950 | 0.627 | 0.590 | 0.781 |

| B-mode+SE | 0.909 | 0.624 | 0.945 | 0.587 | 0.569 | 0.865 |

| B-mode+ABVS | 0.929 | 0.736 | 0.953 | 0.697 | 0.689 | 0.848 |

| SE+ABVS | 0.944 | 0.840 | 0.957 | 0.769 | 0.797 | 0.894 |

| Multimodal | 0.954 | 0.952 | 0.955 | 0.823 | 0.907 | 0.955 |

| 注 DL:深度学习(deep learning);AUC:曲线下面积(area under the curve);B-mode:B型;SE:应变弹性成像(strain elastography);ABVS:自动乳腺全容积成像(automated breast volume scanner);Multimodal:多模态 | ||||||

|

| 注 AUC:曲线下面积(area under the curve);B-mode:B型;SE:应变弹性成像(strain elastography);ABVS:自动乳腺全容积成像(automated breast volume scanner);Multimodal:多模态 图 5 基于不同超声图像的DL模型鉴别乳腺良恶性肿块的ROC曲线 Fig.5 ROC curves of DL models based on different ultrasound images for differentiating benign and malignant breast masses |

各模态的超声图像均已用于乳腺肿块的智能分析工作中,但是仅利用单模态图像进行智能诊断的准确度还可以提高,且目前研究工作大部分基于相对平衡的数据集或在训练前对数据集进行筛选,提前进行平衡操作,不符合超声数据临床采集的规律。单模态方法缺乏多模态图像特征的互补性,因此对多模态图像DL方法的相关研究弥补了单模态模型的不足。

ABVS的冠状面特征和对于小体积肿块较低漏诊率的特点也导致其成为研究热点,其中在整个容积中检测和勾画病变区域是进行智能诊断的基础。本研究使用三维双分支分割网络,由Transformer-CNN双分支网络和双分支多视角Transformer构成,在减小自注意力复杂度的同时实现ABVS图像中的肿块诊断,有效解决了ABVS图像阅片这一艰巨的任务。

医学图像样本量通常较小,导致需要大量数据的DL模型难以学习到有效特征,且临床中因病情差异,导致多模态图像可能存在模态缺失现象,影响DL模型的训练和推理过程。本研究通过一种基于条件式扩散模型生成的图像补全方法和样本扩充方法,实现模态补全和样本扩充,并且能将所学习到的图像表征用于乳腺肿块的诊断,提高多模态模型的分类性能。

既往研究利用强化学习实现自适应权重方法来分配B型、多普勒、剪切波弹性成像(shear wave elastography, SWE)和SE特征对于诊断的贡献度[21-22]。然而,这些方法多数依然以平衡数据作为研究对象,且专注配对多模态图像,或忽略图像未对齐问题,直接使用拼接或加权和的方式融合各模态特征。本研究的DL模型对研究区域感知特征对齐方法的设计,在实际工作中补充了乳腺肿瘤的其他模态信息,有利于医师对于乳腺肿瘤的诊断。

本研究中,融合B型与SE图像的模型、融合B型与ABVS图像的模型和融合SE与ABVS图像的DL模型的分类表现均优于单模态模型,说明单模态模型缺乏多模态图像特征的互补性,多模态图像DL方法对乳腺良恶性肿块的鉴别诊断具有较高价值。有研究通过DL模型利用B型和SE图像将良性与恶性乳腺肿块分类,在双模态数据上取得96.9%的准确度[23]。在实际临床工作中,二维图像提供信息单一,弹性图像易受操作者主观影响,多模态超声成像模式可以显示互补的临床特征信息,DL模型综合分析不同模态影像的数据有助于实现乳腺癌早期精准诊断。本研究结果显示,基于二维灰阶乳腺肿块图像为基础,通过结合弹性和ABVS模态的信息后,DL模型诊断的准确度、敏感度和特异度均有所提高,分别为95.4%、95.2%和95.5%,同时含有3个模态超声图像所训练的Multimodal-DL模型诊断效能最显著,AUC达0.955,说明基于单一的二维形态学征象、弹性硬度信息或ABVS“汇聚征”在诊断乳腺良恶性肿块方面的敏感度和特异度有限。该多模态乳腺超声DL模型能够有效提取多模态影像的互补信息进行特征融合,有助于提升乳腺癌的早期诊断准确度。

本研究存在一定的局限性。本研究用于验证模型的数据量相对较小,验证结果可能存在偏倚,有待多中心、大样本量的前瞻性研究进一步优化模型。

本研究基于乳腺肿块不同模态图像,结合临床准则,运用DL的前沿技术,设计新的DL模型,对多模态超声影像特征进行有效融合,实现乳腺病灶的自动勾画和自动诊断,进而为多模态人工智能超声在乳腺疾病的诊断和研究奠定重要的基础。

| [1] |

Sung H, Ferlay J, Siegel RL, et al. Global cancer statistics 2020: GLOBOCAN estimates of incidence and mortality worldwide for 36 cancers in 185 countries[J]. CA Cancer J Clin, 2021, 71(3): 209-249. DOI:10.3322/caac.21660 |

| [2] |

徐娇娇, 陈占红, 王晓稼. 2023年ASCO乳腺癌治疗进展[J]. 实用肿瘤杂志, 2023, 38(4): 317-323. |

| [3] |

Huang RB, Ying QL, Lin ZH, et al. Extracting keyframes of breast ultrasound video using deep reinforcement learning[J]. Med Image Anal, 2022, 80: 102490. DOI:10.1016/j.media.2022.102490 |

| [4] |

胡亮武, 陈洪亮, 周文强, 等. 乳腺癌动态增强MRI征象特征及病灶周围血管征与诺丁汉预后指数的相关性[J]. 实用肿瘤杂志, 2023, 38(3): 281-285. |

| [5] |

Qian XJ, Pei J, Zheng H, et al. Prospective assessment of breast cancer risk from multimodal multiview ultrasound images via clinically applicable deep learning[J]. Nat Biomed Eng, 2021, 5(6): 522-532. DOI:10.1038/s41551-021-00711-2 |

| [6] |

Chen C, Wang Y, Niu JW, et al. Domain knowledge powered deep learning for breast cancer diagnosis based on contrast-enhanced ultrasound videos[J]. IEEE Trans Med Imaging, 2021, 40(9): 2439-2451. DOI:10.1109/TMI.2021.3078370 |

| [7] |

Boca Bene I, Ciurea AI, Ciortea CA, et al. Pros and cons for automated breast ultrasound (ABUS): a narrative review[J]. J Pers Med, 2021, 11(8): 703. DOI:10.3390/jpm11080703 |

| [8] |

Huang G, Liu Z, van Der Maaten L, et al. Densely connected convolutional networks[C/OL]//2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Honolulu: IEEE, 2017: 2261-2269. [2024-01-09]. https://ieeexplore.ieee.org/document/8099726/.

|

| [9] |

Szegedy C, Liu W, Jia YQ, et al. Going deeper with convolutions[C]//2015 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Boston: IEEE, 2015: 1-9.

|

| [10] |

Sandler M, Howard A, Zhu ML, et al. MobileNetV2: inverted residuals and linear bottlenecks[C]//2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City: IEEE, 2018: 4510-4520.

|

| [11] |

Zoph B, Vasudevan V, Shlens J, et al. Learning transferable architectures for scalable image recognition[C]//2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City: IEEE, 2018: 8697-8710.

|

| [12] |

He KM, Zhang XY, Ren SQ, et al. Deep residual learning for image recognition[C]//2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Las Vegas: IEEE, 2016: 770-778.

|

| [13] |

Xie SN, Girshick R, Dollár P, et al. Aggregated residual transformations for deep neural networks[C]//2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Honolulu: IEEE, 2017: 5987-5995.

|

| [14] |

Hu J, Shen L, Sun G. Squeeze-and-excitation networks[C]//2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City: IEEE, 2018: 7132-7141.

|

| [15] |

Ma NN, Zhang XY, Zheng HT, et al. ShuffleNet V2: practical guidelines for efficient CNN architecture design[M]. Cham: Springer International Publishing, 2018: 122-138.

|

| [16] |

Liu Y, Li J, Yang Y, et al. ABVS breast tumor segmentation via integrating CNN with dilated sampling self-attention and feature interaction transformer[EB/OL]. (2024-06-25)[2025-01-15]. https://www.ssrn.com/abstract=4893252.

|

| [17] |

Isensee F, Jaeger PF, Kohl SAA, et al. nnU-Net: a self-configuring method for deep learning-based biomedical image segmentation[J]. Nat Methods, 2021, 18(2): 203-211. DOI:10.1038/s41592-020-01008-z |

| [18] |

Xie YT, Zhang JP, Shen CH, et al. CoTr: efficiently bridging CNN and transformer for 3D medical image segmentation[M]. Cham: Springer International Publishing, 2021: 171-180.

|

| [19] |

柳懿垚, 杨意, 陈敏思, 等. 基于双分支多视角深度自注意力编码器的乳腺肿瘤分类方法[J]. 中国生物医学工程学报, 2022, 41(5): 527-536. DOI:10.3969/j.issn.0258-8021.2022.05.002 |

| [20] |

华中科技大学协和深圳医院. 乳腺肿瘤良恶性分类模型方法、系统、终端及存储介质: 中国, CN202310140716.0[P]. 2023-03-28.

|

| [21] |

Wang J, Miao JZ, Yang X, et al. Auto-weighting for breast cancer classification in multimodal ultrasound[M]. Cham: Springer International Publishing, 2020: 190-199.

|

| [22] |

Huang RB, Lin ZH, Dou HR, et al. AW3M: an auto-weighting and recovery framework for breast cancer diagnosis using multi-modal ultrasound[J]. Med Image Anal, 2021, 72: 102137. DOI:10.1016/j.media.2021.102137 |

| [23] |

Misra S, Yoon C, Kim KJ, et al. Deep learning-based multimodal fusion network for segmentation and classification of breast cancers using B-mode and elastography ultrasound images[J]. Bioeng Transl Med, 2022, 8(6): e10480. |

2025, Vol. 40

2025, Vol. 40