2. 湖北商贸学院人工智能学院, 430070, 武汉

-

第一作者简介

- 康芮(1989-), 女, 硕士。主要研究方向: 遥感和地理信息系统。E-mail: 1123133901@qq.com

-

通信作者简介

- 邱新玲(1994-), 女, 硕士。主要研究方向: 深度学习算法。E-mail: qiuxinling@hbc.edu.cn

-

文章历史

-

收稿日期:2021-07-21

修回日期:2022-05-10

2. 湖北商贸学院人工智能学院, 430070, 武汉

2. School of Artificial Intelligence, Hubei Business College, 430070, Wuhan, China

随着GF-1、GF-6、ZY-3等国产高分辨率遥感卫星的出现,遥感技术在水土保持业务中的应用逐渐普遍。2015年以来,水利部组织开展生产建设项目遥感监管工作[1],每年采用高分辨率卫星遥感影像,对全国范围进行至少一次生产建设项目扰动状况遥感调查,提取所有存在开挖、占压、堆弃等扰动或者破坏地表行为的生产建设项目,成果可为水行政主管部门开展生产建设项目监督检查工作提供依据。

遥感监管工作在各省市逐步开展,促使生产建设项目扰动图斑的自动提取研究不断出现。徐晓伟等[2]采用基于规则的和以光谱信息辅助的面向对象监督分类方法,分别对天津市静海区不同时相高分影像上的扰动图斑进行提取;毕永清[3]采用面向对象的分类后监测法和分类前监测法,实现对西藏墨竹工卡县扰动区的动态监测;亢庆等[4]采用面向对象的监督分类方法,实现对广东省生产建设项目水土保持监管示范县典型样区内扰动图斑的自动识别;高志强等[5]构建面向对象的多层次提取模型,获取陕西省榆林市横山县生产建设项目地块信息。现有研究以局部地区的探索试验为主,主要采用面向对象的分类方法,虽提取精度较高,但需针对不同地区设置不同分割尺度、选择不同分类特征、确定不同分类规则,并且对人员专业知识水平要求高。因此,目前自动检测方法仍处于研究阶段,遥感监管将人机交互解译作为主要的技术方法。

深度学习作为人工智能的关键技术,具有提取特征能力强、识别精度高、效率高等优点,目前已在人脸识别、医学图像识别等图像识别领域被广泛应用,同时也被逐渐引入遥感图像分类中[6]。为提高生产建设项目遥感监管工作效率,笔者探索应用深度学习技术进行生产建设项目扰动图斑自动提取。

1 研究区概况研究区位于甘肃省中部和东部,地理位置为E 100°42′44″~108°47′,N 32°30′37″~37°46′26″,包括兰州、白银、定西、临夏、甘南、陇南、天水、平凉、庆阳等9个市(自治州),共计67个县(市、区)。土地总面积16.77万km2,占全省总面积的39.38%。

研究区地处青藏高原、内蒙古高原和黄土高原的交汇地带,全区大部分地区海拔>1 000 m,山地和高原是主要的地貌类型。由于纬度、气候、土壤和地貌等因素的差异,植被具有明显的纬度地带性和海拔地带性,可分为阔叶混交林地带、落叶阔叶林地带、森林草原地带和草原地带。

近年来,甘肃省经济发展速度不断加快,房地产工程、加工制造类项目、公路工程、露天非金属矿等生产建设活动频繁,破坏地表植被,人为水土流失日益严重,制约区域经济社会可持续发展。

2 数据和方法本研究所使用的数据主要是高分辨率遥感影像和生产建设项目区域监管扰动图斑矢量数据。遥感影像采用高分一号(GF-1)影像、高分六号(GF-6)影像,获取时间为2020年7—9月,空间分辨率为2 m,含有RGB 3个波段。生产建设项目区域监管扰动图斑矢量数据来源于甘肃省2020年生产建设项目遥感监管项目,采用内业目视解译和现场复核相结合的方法获得。扰动图斑包括历史图斑和2020年新增图斑,历史图斑已根据2020年影像进行边界更新和属性更新。选取扰动变化类型为“新增”“扰动范围扩大”“扰动范围缩小”“扰动范围不变”的扰动图斑用于样本库构建和精度评价。

2.1 生产建设项目扰动特征分析生产建设项目在工程施工前期,破坏原有地形地貌,进行场地平整和开挖堆积,会形成大面积的裸露地表,在遥感影像上表现为裸地;施工后期,修建房屋、硬化地表,在遥感影像上表现新增建设用地。因此,根据扰动图斑地表覆盖特征,将裸地、新增建设用地作为生产建设项目扰动图斑自动化提取的目标地物。

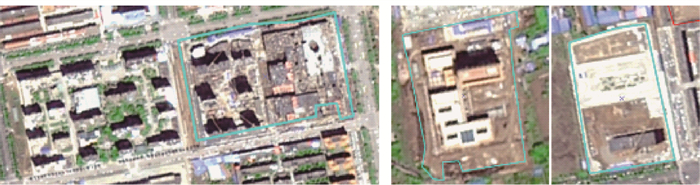

裸地在遥感影像上具有以下特征:反射率较高,面积较大,边界清晰,纹理均一,内部有小面积建筑物或防尘网,周边有道路(图 1)。

|

图 1 裸地遥感解译标志 Fig. 1 Remote sensing interpretation mark of bare land |

新增建设用地在遥感影像上具体以下特征:形状规则,边界清晰;建筑物、硬化地表周边或内部有连续、成片裸地;内部无植被覆盖;部分新增建设用地纹理杂乱无序,内部有脚架等施工设施(图 2)。

|

图 2 新增建设用地遥感解译标志 Fig. 2 Remote sensing interpretation mark of new construction land |

样本库构建是深度学习模型训练的基础。基于2020年7—9月高分遥感影像,通过手动标注的方式,建立生产建设项目扰动图斑样本库,包括1 156个样本,其中裸地样本927个,新增建设用地样本229个。

1) 样本区域确定。由于生产建设项目扰动图斑影像特征复杂多变,并且容易受到周边地形地貌、植被等自然条件的影响,为确保选取的样本具有代表性,在兰州市皋兰县、兰州市榆中县、天水市麦积区、天水市秦州区、平凉市庄浪县、平凉市庄浪县、平凉市华亭市、平凉市崆峒区、庆阳市西峰区、庆阳市庆城县、陇南市武都区、陇南市文县等12个区(县)内选取生产建设项目扰动图斑样本。

2) 样本标注。根据生产建设项目扰动图斑自动提取的需求,基于2020年生产建设项目区域监管成果,进行样本标注。根据地表覆盖特征,将扰动图斑分为裸地、新增建设用地2类。

3) 样本标签制作。通过数据格式转换,将每一个样本区域遥感影像对应的矢量数据转换成栅格数据,即样本标签数据,数据分辨率、像元数与对应的遥感影像保持一致。由于GPU内存有限,模型输入数据大小受限,将样本标签数据、遥感影像裁剪为512像素×512像素的切片数据。为增加样本数量,提高模型精度,裁剪步长取256,即相邻切片具有50%的重合率,共获得2 589张切片数据。将处理好的切片数据进行随机划分,其中训练集和验证集的比例为7 ∶3。

4) 样本增强。采用水平翻转、竖直翻转、随机旋转、随机裁剪、变形缩放、颜色变换、噪声、模糊等数据增强方式来增加样本的数据量和多样性,提高模型的泛化能力及其模型的鲁棒性。

2.3 模型训练和验证利用PyTorch深度学习框架,分别采用DeepLabV3 +模型和U-Net模型对生产建设项目扰动图斑进行自动提取试验。

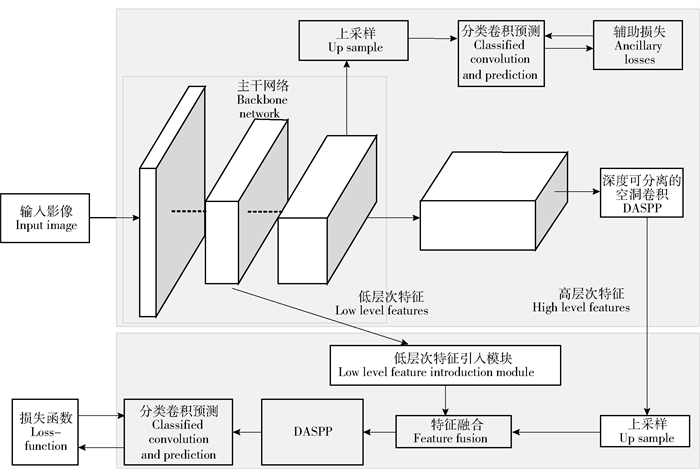

1) DeepLabV3 +模型。DeepLabV3 +模型将ASPP(atrous spatial pyramid pooling)模块应用到encoder-decoder网络执行语义分割任务中。在编码阶段,首先应用SEResNet 50作为骨干网络提取原图像特征,然后引入DASPP(depthwise atrous spatial pyramid pooling)模块提取高层次特征,与原始ASPP模块不同,改进后的模块利用深度可分离的空洞卷积进行计算,大大减少了参数数量和运算成本,同时保持精度[7]。如图 3所示,深度可分离卷积首先对每个通道特征图分别进行3×3的卷积计算,然后再进行1×1的点卷积运算将不同通道信息融合。将ASPP模块与深度可分离卷积进行融合,需要将深度可分离卷积中的3×3大小的一般卷积改为带孔卷积,再进行深度可分离卷积计算。ASPP模块参考遥感影像不同尺度的特征图,并且空洞卷积的使用加强了提取稠密特征的能力,因此该结构具有可以提取遥感影像高层特征的优点,但是ASPP模块存在池化和有步长的卷积,导致遥感影像的边界信息严重丢失[8-12]。

|

DASPP: Depthwise atrous spatial pyramid pooling. The same below. 图 3 DeepLabV3 +网络结构 Fig. 3 DeepLabV3 + network architecture |

因此,在解码器阶段,借鉴FCN(fully convolutional networks)的跳步连接方式,连接低层特征和高层特征,修复遥感影像尖锐边界的问题。其中,通过低层次特征的引入增强影像特征非线性表达能力,有效缓解DeepLabV3 +模型在小尺度目标提取方面所出现的孔洞问题。利用48通道1×1卷积对低层次特征图卷积,再融入DASPP采样的高层次特征图,从而实现模型更好地优化。将融合后的特征输入到深度可分离卷积结构模块中,此结构是多个深度可分离卷积串行组成,本研究默认为2个。最后接入分类卷积进行分类预测和损失计算。

由于样本数量差异较大,裸地样本数远远大于新增建设用地类别数量,导致样本不均衡问题较严重,因此将损失函数取为在线困难样例挖掘(online hard example mining,OHEM)交叉熵损失函数。该函数对损失较大的样本赋予权重,从而通过反向传递改善该类样本的预测精度。另外通过在低层次模块进行上采样和卷积操作计算交叉熵损失。2种损失函数的权重比例设为1.0 ∶0.4。

本次在训练网络学习参数的过程中,使用基于Imagenet数据集的预训练模型,利用随机梯度下降算法(stochastic gradient descent,SGD)为优化算法,初始学习率为0.01,动量参数为0.9,权重衰减率为0.000 5,学习率的下降函数采用多项式计算,指数参数为0.9,最小学习率达到0.000 1。利用4张NVIDIA GTX1080显卡,11G显存进行分布式训练,同时加入混合精度加速模型训练。

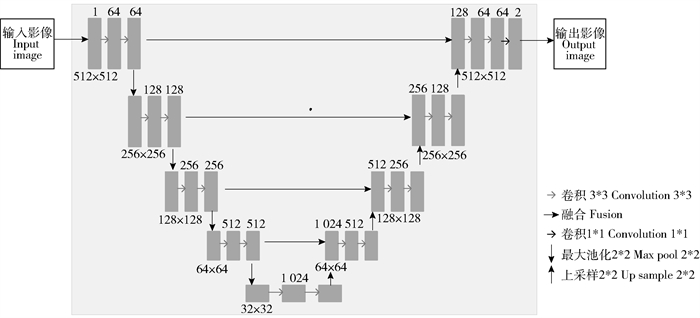

2) U-Net模型。U-Net模型是一种改进的FCN结构,模型由压缩通道和扩展通道组成(图 4)。压缩通道用于特征提取,属于典型的卷积神经网络结构,重复采用2个卷积层和1个最大池化层的结构,卷积核大小为3×3,池化层步长为2,激活函数为线性整流函数。扩展通道利用反卷积层还原影像尺寸[13-17]。

|

图 4 U-Net网络结构 Fig. 4 U-Net network architecture |

采用EfficientNe t-b0[18]作为骨干网,是具有高精度的轻量型网络,替代原始的U-Net编码结构可大大减小计算量,同时保持精度。另外在解码模块加入注意力机制,采用同时考虑空间和通道维度的注意力机制spatial-channel sequeeze & excitation (SCSE)用于提高模型精度。训练方法同上,不再赘述。

3) 模型验证。采用基于像素的精度评价方法,针对裸地、新增建设用地2种类型,选取像素精度、交互比(intersection over union,IoU)、准确率、召回率等评价指标,分别对DeepLabV3 +模型、U-Net模型预测结果进行精度验证。验证集不同模型精度评价如表 1所示。结果显示,DeepLabV3 +模型、U-Net模型对裸地的预测效果较好,像素精度、准确率达到80%以上,交互比和召回率分别达到70%以上;DeepLabV3 +模型对样本数量较少的新增建设用地预测效果较好,各项指标均达到80%以上;DeepLabV3 +模型各项指标均优于U-Net模型,整体分类效果较好,并且能够有效缓解样本数量不均衡的问题。

| 表 1 2个模型验证精度评价结果 Tab. 1 Accuracy evaluation results of 2 models |

模型预测结束后,根据目标大小及影像分辨率,设置最小识别面积,对面积小于一定阈值的图斑进行过滤,减少小图斑对提取结果的干扰。统计分析甘肃省2020年生产建设项目遥感监管结果发现,面积>1 hm2的扰动图斑比例>80%;因此,设置0.1、0.5和1.0 hm2 3类最小识别面积进行提取结果对比。

2.5 精度评价将甘肃省2020年生产建设项目遥感监管项目成果作为验证数据,以提取结果与地表真值重叠率达到25%以上的图斑为正确图斑,采用数量召回率、数量准确率、面积召回率、面积准确率等指标定量评价生产建设项目扰动图斑自动提取结果。计算式如下:

| $ 数量召回率 = \frac{{正确图斑数量}}{{实际图斑数量}} \times 100\% ; $ | (1) |

| $ 数量准确率 = \frac{{正确图斑数量}}{{提取图斑数量}} \times 100\% ; $ | (2) |

| $ 面积召回率 = \frac{{正确图斑面积}}{{实际图斑面积}} \times 100\% ; $ | (3) |

| $ 面积准确率 = \frac{{正确图斑面积}}{{提取图斑面积}} \times 100\% 。$ | (4) |

为验证模型适用性,选取兰州市城关区、庆阳市正宁县和白银市白银区3个区(县),分别采用DeepLabV3 +模型、U-Net模型,设置0.1、0.5和1 hm2 3类最小识别面积开展生产建设项目扰动图斑自动提取试验,并与2020年生产建设项目遥感监管项目成果进行对比分析。

3.1 兰州市城关区城关区位于甘肃省中东部,是兰州市的经济、交通中心,区域总面积220 km2。以2020年生产建设项目遥感监管项目成果为基础,经过人工筛选确定全区共有67个扰动图斑,扰动面积1 649.07 hm2。项目类型以房地产工程为主。模型预测耗时4 min。

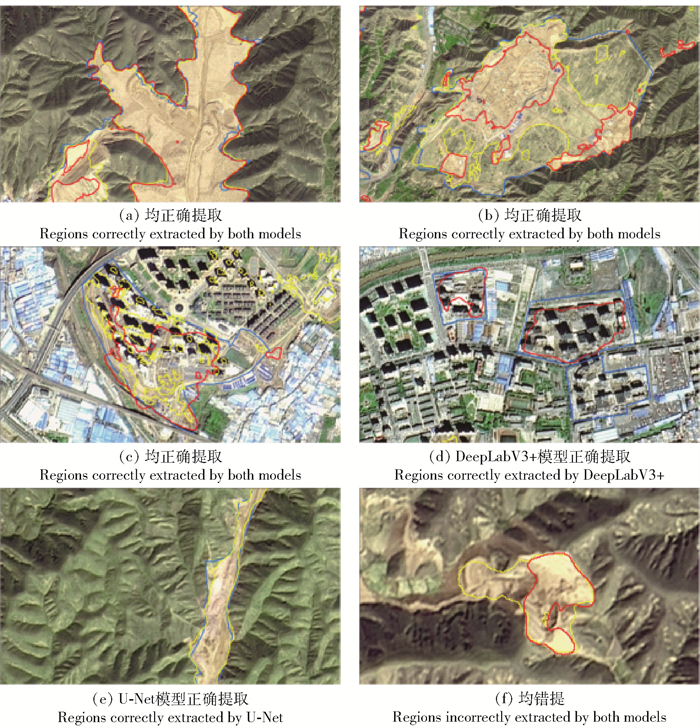

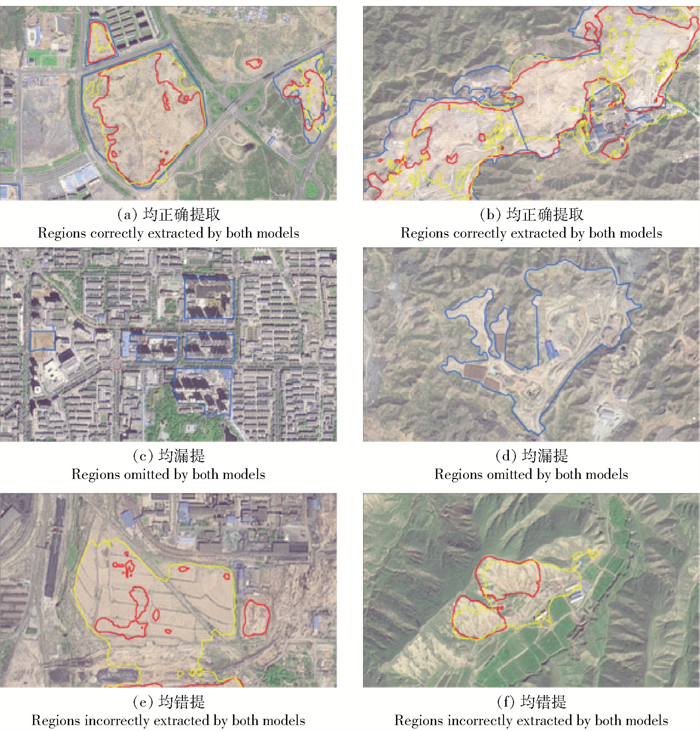

城关区生产建设项目扰动图斑自动提取效果如图 5所示。从定性的角度分析,2种模型均可正确提取裸地类型的扰动图斑,并且U-Net模型提取结果更为完整;对于新增建设用地类型的扰动图斑,DeepLabV3 +模型提取效果更好,漏提少,并且边界规则,而U-Net模型提取结果破碎,且漏提较多;DeepLabV3 +模型、U-Net模型均将部分荒地错提为扰动图斑。

|

蓝色:目视解译成果;红色:DeepLabV3 +模型提取结果;黄色:U-Net模型提取结果。 Blue: Regions extracted by visual interpretation. Red: Regions extracted by DeepLabV3 +. Yellow: Regions extracted by U-Net. 图 5 城关区2个模型提取效果 Fig. 5 Extraction effects by 2 models in Chengguan district |

城关区生产建设项目扰动图斑自动提取精度如表 2所示。从定量的角度分析,DeepLabV3 +模型的准确率、召回率均高于U-Net模型,数量准确率相差15%以上,数量召回率相差10%左右,面积准确率、面积召回率相差2%左右,DeepLabV3 +模型的扰动图斑提取效果整体优于U-Net模型;2模型的面积准确率均高于数量准确率,面积召回率均高于数量召回率,并且随着最小识别面积增大,准确率提高,召回率降低。这说明模型对于面积较大的图斑提取效果漏提、错提较少。结果表明,采用DeepLabV3 + 模型,最小识别面积为0.5 hm2或1 hm2时,提取效果最好。

| 表 2 城关区2个模型精度评价结果 Tab. 2 Accuracy evaluation results of 2 models in Chengguan district |

正宁县位于甘肃省东部,区域总面积1 330 km2。全区植被状况优越,森林覆盖率达50.9%。以2020年生产建设项目遥感监管项目成果为基础,经过人工筛选确定全县共有57个扰动图斑,扰动面积201.26 hm2。项目类型以公路工程、铁路工程、其他城建工程为主。模型预测耗时18 min。

正宁县生产建设项目扰动图斑自动提取效果如图 6所示。从定性的角度分析,2种模型均可正确提取裸地类型的扰动图斑,并且U-Net模型提取结果更为完整;DeepLabV3 +模型可正确提取新增建设用地类型的扰动图斑;2种模型对于线状扰动图斑提取效果较差,存在一定的漏提;2种模型均将部分空闲耕地、荒地错提为扰动图斑。

|

蓝色:目视解译成果;红色:DeepLabV3 +模型提取结果;黄色:U-Net模型提取结果。 Blue: Regions extracted by visual interpretation. Red: Regions extracted by DeepLabV3 +. Yellow: Regions extracted by U-Net. 图 6 正宁县2个模型提取效果 Fig. 6 Extraction effects by 2 models in Zhengning county |

正宁县生产建设项目扰动图斑自动提取精度如表 3所示。从定量的角度分析,DeepLabV3 +模型的准确率、召回率均高于U-Net模型,数量准确率、面积准确率相差30%以上,数量召回率相差5%左右,面积召回率相差1%左右,说明DeepLabV3 +模型错提、漏提少于U-Net模型;两模型的面积准确率均高于数量准确率,面积召回率均高于数量召回率,并且随着最小识别面积增大,准确率提高,召回率降低。这说明模型对于面积较大的图斑提取效果漏提、错提较少。结果表明,采用DeepLabV3 +模型,最小识别面积为1 hm2时,提取效果最好。

| 表 3 正宁县2个模型精度评价结果 Tab. 3 Accuracy evaluation results of 2 models in Zhengning county |

白银区位于甘肃省中部,是中国重要的有色金属基地和甘肃省重要的能源化工基地。全区总面积1 372 km2,受地理及气候的影响,白银区自然植被类型以草原和荒漠草原为主。以2020年生产建设项目遥感监管项目成果为基础,经过人工筛选确定全区共有142个扰动图斑,扰动面积2 603.17 hm2。项目类型以公路工程、露天非金属矿、加工制造类项目为主。模型预测耗时20 min。

白银区生产建设项目扰动图斑自动提取效果如图 7所示。从定性的角度分析,2种模型均可正确提取裸地类型的扰动图斑,U-Net模型提取更为完整,但结果比较破碎,小图斑较多,部分图斑内部有孔洞;2种模型对于新增建设用地类型以及边界不清晰的扰动图斑提取效果较差,存在一定的漏提;2种模型均将部分空闲耕地、荒地错提为扰动图斑,并且U-Net模型错提数量更多、面积更大。

|

蓝色:目视解译成果;红色:DeepLabV3 +模型提取结果;黄色:U-Net模型提取结果。 Blue: Regions extracted by visual interpretation. Red: Regions extracted by DeepLabV3 +. Yellow: Regions extracted by U-Net. 图 7 白银区2个模型提取效果 Fig. 7 Extraction effects by 2 models in Baiyin district |

白银区生产建设项目扰动图斑自动提取精度如表 4所示。从定量的角度分析,DeepLabV3 +模型的准确率高于U-Net模型,数量准确率相差20%以上,面积准确率相差10%左右,说明DeepLabV3 + 模型错提少;U-Net模型的召回率高于DeepLabV3 + 模型,数量召回率相差5%左右,面积召回率相差7%左右,说明U-Net模型漏提少;2模型的面积准确率均高于数量准确率,面积召回率均高于数量召回率,并且随着最小识别面积增大,准确率提高,召回率降低,说明模型对于面积较大的图斑提取效果漏提、错提较少。结果表明,采用DeepLabV3 +模型,最小识别面积为0.5 hm2或1 hm2时,提取效果最好。

| 表 4 白银区2个模型精度评价结果 Tab. 4 Accuracy evaluation results of 2 models in Baiyin district |

1) U-Net模型可正确提取裸地类型的扰动图斑,但会漏提新增建设用地类型、线状以及边界不清晰的扰动图斑,部分空闲耕地、荒地被错分为扰动图斑。最小识别面积为1 hm2时,模型平均数量准确率为51.46%,数量召回率为56.64%,面积准确率为75.04%,面积召回率为80.75%。

2) DeepLabV3 + 模型可正确提取裸地类型以及部分新增建设用地的扰动图斑,但会漏分部分线状以及边界不清晰的扰动图斑,少量空闲耕地、荒地被错分为扰动图斑。最小识别面积为1 hm2时,模型平均数量准确率为78.31%,数量召回率为61.69%,面积准确率为88.82%,面积召回率为80.60%。DeepLabV3 +模型整体分类效果较好,并且能够有效缓解样本数量不均衡的问题,更适用于生产建设项目扰动图斑自动提取。

3) 最小识别面积会影响模型提取效果。随着最小识别面积增大,准确率提高,召回率降低。需根据不同区域扰动图斑特征,设置合适的最小识别面积,平衡自动提取结果的准确率和召回率,提高模型预测精度。

深度学习算法能够快速、准确地获取生产建设项目扰动图斑空间分布信息,与人机交互解译相比效率更高,与面向对象分类方法相比区域适用性更强、工程化应用难度较低,能够有效提升生产建设项目遥感监管工作的自动化水平。本研究尚处于探索阶段,仅针对甘肃省中、东部地区,利用单期遥感影像开展研究,样本数量有限,与工程化应用仍有一定的差距,后续需要针对不同区域总结分析生产建设项目扰动特征,补充完善样本库,持续优化深度学习模型。

| [1] |

李智广, 王敬贵. 生产建设项目"天地一体化"监管示范总体实施方案[J]. 中国水土保持, 2016(2): 14. LI Zhiguang, WANG Jinggui. Overall implementation plan for supervision and demonstration of "integration of heaven and earth" in production and construction projects[J]. Soil and Water Conservation in China, 2016(2): 14. |

| [2] |

徐晓伟, 李晓松, 李周. 基于高分影像的生产建设项目水土保持监管应用研究[J]. 甘肃科学学报, 2019, 31(1): 92. XU Xiaowei, LI Xiaosong, LI Zhou. Application of production construction project water and soil conservation monitoring based on images with high resolution[J]. Journal of Gansu Sciences, 2019, 31(1): 92. |

| [3] |

毕永清. 高寒地区生产建设项目扰动区的遥感监测方法研究[D]. 成都: 西南交通大学, 2017: 31. BI Yongqing. Study on the remote sensing monitoring method for disturbance area of production and construction project in arctic-alpine region[D]. Chengdu: Southwest Jiaotong University, 2017: 31. |

| [4] |

亢庆, 姜德文, 扶卿华, 等. 基于最优尺度的生产建设扰动图斑识别[J]. 中国水土保持科学, 2017, 15(6): 126. KANG Qing, JIANG Dewen, FU Qinghua, et al. On the identification of construction disturbance patches based on optimal segmentation scale[J]. Science of Soil and Water Conservation, 2017, 15(6): 126. |

| [5] |

高志强, 史明昌, 杨文涛, 等. 面向水土保持监管的黄土高原区生产建设项目地块快速提取[J]. 中国水土保持科学, 2017, 15(3): 81. GAO Zhiqiang, SHI Mingchang, YANG Wentao, et al. Rapid extraction of land parcels from soil and water conservation supervision-oriented productive and constructive projects in the Loess Plateau[J]. Science of Soil and Water Conservation, 2017, 15(3): 81. |

| [6] |

郑远攀, 李广阳, 李晔. 深度学习在图像识别中的应用研究综述[J]. 计算机工程与应用, 2019, 55(12): 20. ZHENG Yuanpan, LI Guangyang, LI Ye. Survey of application of deep learning in image recognition[J]. Computer Engineering and Applications, 2019, 55(12): 20. DOI:10.3778/j.issn.1002-8331.1903-0031 |

| [7] |

LIU Man, FU Bolin, XIE Shuyu, et al. Comparison of multi-source satellite images for classifying marsh vegetation using DeepLabV3 Plus deep learning algorithm[J]. Ecological Indicators, 2021, 125(11): 107562. |

| [8] |

CHEN Liangchieh, ZHU Yukun, PAPANDREOU G, et al. Encoder-decoder with atrous separable convolution for semantic image segmentation[C]. Munich, Germany: ECCV, 2018: 833.

|

| [9] |

WANG Junqiang, LI Jiansheng, ZHOU Huachun, et al. Typical element extraction method of remote sensing image based on DeeplabV3 + and CRF[J]. Computer Engineering, 2019, 45(10): 260. |

| [10] |

张鑫禄, 张崇涛, 戴晨光, 等. 基于DeepLabv3架构的高分辨率遥感图像分类[J]. 海洋测绘, 2019, 39(2): 40. ZHANG Xinlu, ZHANG Chongtao, DAI Chenguang, et al. High resolution remote sensing image classification based on DeepLabV3 architecture[J]. Hydrographic Surveying and Charting, 2019, 39(2): 40. |

| [11] |

傅晓梦. 基于深度学习的高分辨率遥感影像语义分割方法研究[D]. 南京: 南京理工大学, 2019: 35. FU Xiaomeng. Semantic segmentation of high resolution remote sensing image based on deep learning[D]. Nanjing: Nanjing University of Science and Technology, 2019: 35. |

| [12] |

王蓝玉. 基于Deeplab V3+网络的遥感地物图像语义分割研究[D]. 哈尔滨: 哈尔滨工业大学, 2020: 31. WANG Lanyu. Research on semantic segmentation of remote sensing images of the ground objects based on DeeplabV3+ network[D]. Harbin: Harbin Institute of Technology, 2020: 31. |

| [13] |

薛磊. 基于改进U-Net的多光谱遥感影像分类方法研究[D]. 吉林: 吉林大学, 2018: 30. XUE Lei. Research on multi-spectral remote sensing image classification based on improved U-Net[D]. Jilin: Jilin University, 2018: 30. |

| [14] |

许慧敏. 基于深度学习U-Net模型的高分辨率遥感影像分类方法研究[D]. 成都: 西南交通大学, 2018: 32. XU Huimin. Method research of high resolution remote sensing imagery classification based on U-Net model of deep learning[D]. Chengdu: Southwest Jiaotong University, 2018: 32. |

| [15] |

杨瑞, 祁元, 苏阳. 深度学习U-Net方法及其在高分辨卫星影像分类中的应用[J]. 遥感技术与应用, 2020, 35(4): 767. YANG Rui, QI Yuan, SU Yang. U-Net neural networks and its application in high resolution satellite image classification[J]. Remote Sensing Technology and Application, 2020, 35(4): 767. |

| [16] |

WAGNER F H, SANCHEZ A, TARABALKA Y, et al. Using the U-Net convolutional network to map forest types and disturbance in the Atlantic rainforest with very high resolution images[J]. Remote Sensing in Ecology & Conservation, 2019. |

| [17] |

WEI Yang, LIU Xiaofang. The application of deep convolution neural network to building extraction in remote sensing images[J]. World Scientific Research Journal, 2020, 6(3): 136. |

| [18] |

TAN Mingxing, LE Q V. EfficientNet: Rethinking model scaling for convolutional neural networks[C]. Los Angeles, USA: ICML 2019.

|

2023, Vol. 21

2023, Vol. 21