文章信息

- 谢元澄, 于增源, 姜海燕, 金前, 蔡娜娜, 梁敬东

- XIE Yuancheng, YU Zengyuan, JIANG Haiyan, JIN Qian, CAI Nana, LIANG Jingdong

- 小麦麦穗几何表型测量的精准分割方法研究

- Study on precise segmentation method for geometric phenotype measurement of wheat ear

- 南京农业大学学报, 2019, 42(5): 956-966

- Journal of Nanjing Agricultural University, 2019, 42(5): 956-966.

- http://dx.doi.org/10.7685/jnau.201901026

-

文章历史

- 收稿日期: 2019-01-12

2. 南京农业大学国家信息农业工程技术中心, 江苏 南京 210095

2. National Engineering and Technology Center for Information Agriculture, Nanjing Agricultural University, Nanjing 210095, China

小麦作为我国主要的粮食作物之一, 研究者通常获取其几何表型信息作为育种、产量评估和质量检测的支撑[1-2]。传统的几何表型测量依赖于人工利用度量工具进行田间随机采样, 现阶段学者们主要利用图像处理技术和深度学习方法将作物与背景分割, 从而得到其麦穗长宽、含颖壳包裹籽粒的投影面积和朝向等一系列重要表型参数[3]。

现有的研究中, 利用图像处理技术获取表型参数减少了人工的参与度, 在速度和精度上较之前的方法显著提升。在麦穗研究方面[4-6], 运用图像处理方法已经实现了穗数、穗行数和小穗数等重要表型信息参数的提取, 但在籽粒大小的测量和籽粒与麦穗夹角朝向信息的获取上还存在一定的困难; 在边缘分割方面[7-8], 学者们通常基于图像使用最大类间方差分割算法实现目标和背景分割, 但粘连现象较为严重; 在果穗籽粒分割上[9-10], 基于高分辨率图像利用分水岭算法和欧氏距离判定可以分割出单个籽粒, 但必须依赖于高精密摄像设备, 鲁棒性较差。此外可以采用基于深度学习的方法进行图像分割[11], 例如改换全连接层为卷积层的全卷积网络(fully convolutional networks, FCN)[12], 利用编码和解码做采样的U-Net[13], 引入空洞卷积的DeepLab[14], 这些方法通过对采集得到的图像进行标注, 利用卷积神经网络提取高维特征[15-17], 以共享和网络结构组合的方式充分利用每层特征信息[18-22], 再综合所有输出特征信息进行种类、位置和分割边界的精确判别。这些基于深度学习的分割方法目前已有成功的应用, 如利用U-Net在小样本情况下进行上采样和降采样实现纳米材料的分割[23], 利用DeepLab实现遥感图像的分割[24], 利用全卷积网络实现大田水稻穗部的分割[25]等。

上述方法中, 人工测量方法通过统计平均值来消除测量误差, 除了效率较低以外, 不同的检测者会引入不同的测量误差, 难以以一个统一的标准对单株麦穗表型进行测量, 进而影响麦穗表型大数据的收集与精确分析; 而利用分水岭算法、OTSU等图像处理方法进行作物穗部和籽粒分割依赖精密的实验装置, 在实际场景中应用存在困难; 以FCN为代表的传统深度学习分割算法, 则存在精度低、速度慢、测量效率较低等问题, 因此迫切需要一种可以在麦穗及籽粒分割的速度和准确性上较之前方法有显著提升的分割方法。该方法以期能在麦穗轮廓粗分割的基础上, 进一步对麦穗籽粒进行分割, 其关键工作在于采用基于深度学习的分割方法克服传统图像处理分割算法存在的籽粒粘连现象, 从传统的籽粒数估计进一步推进到对单个籽粒的精准分割、定位、分析。笔者通过选择合适的特征提取网络, 提出一种基于Mask R-CNN[26]的麦穗及侧面籽粒分割算法, 对小麦实现了像素级别的分割, 为小麦几何表型参数的精准测量提供了技术支撑。

1 试验数据 1.1 数据采集选取南京市江宁区(118°55′E, 31°53′N)4块麦田, 随机采样800株成熟待收获小麦(品种为‘宁麦8号’, 穗为长方型), 使用带独立编号的保护袋保存收集的每一株小麦麦穗, 做好标记并拍照核对, 以防范麦穗在运输过程中的籽粒缺失。

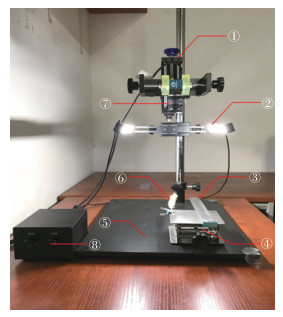

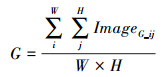

图像采集平台(图 1):相机(大恒MER-310-12UC, 分辨率2 048×1 536像素)、镜头(M0814-MPW2, 8 mm)、LED条形光源(12 V-4 W, 白光)、光源控制器、固定机构、载物台、可升降夹物台、计算机系统平台(ASUS, CPU:i5-4200U, RAM:16G, SSD:240G, OS:Windows10)和大恒图像处理软件。

|

图 1 数据采集系统 Fig. 1 Data collection system ①固定机构Fixed institution; ②光源The light source; ③刻度尺Ruler; ④可升降夹物台Lifting clamp table; ⑤载物台Objective table; ⑥麦穗Ear; ⑦相机Camera; ⑧光源控制器Light source controller. |

拍照装置的基本操作顺序为:1)通过①固定机构将相机夹持到离④载物台固定高度, 利用水平仪调节镜头中轴线与桌面垂直; 2)利用④载物台夹持麦穗移动到镜头中心位置, 调节⑧光源控制器选取合适的拍摄亮度; 3)利用张正友棋盘格相机标定法[27]实现畸变校正, 拍摄测试数据计算偏差; 4)计算每株小麦的麦芒数, 图像采集时每株小麦按照中轴90°旋转拍摄1张图像, 共采集4张, 并进行人工测量, 手工剥粒统计麦粒数, 称质量, 记录采集数据。通过以上步骤, 共得到数据800组, 其中有效数据724组, 共有图片2 896张。

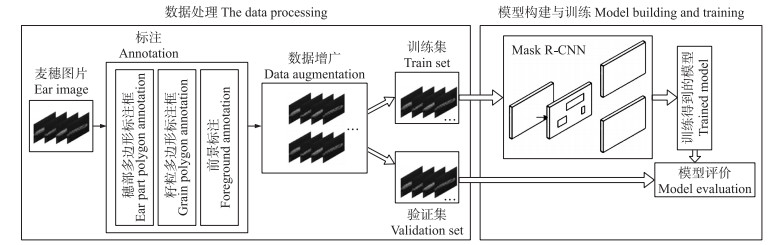

1.2 数据制作Mask R-CNN数据制作过程如下:1)数据标注:基于Labelme标注软件标注, 通过不规则多边形包围穗部整体轮廓与籽粒精细轮廓。2)数据增广:对原始图像数据进行高斯噪声、平滑滤波以及调整明亮度变化等操作进行数据增广, 获得5 792张图片(图 2)。3)背景去除:利用感兴趣区域(ROI)将原始图片中麦芒减除。4)划分数据集:将原始数据集按照8:2随机选择划分为训练集和测试集, 其中4 634张训练集, 1 158张测试集。

|

图 2 麦穗图像增广 Fig. 2 Ear image augmentation |

基于Mask R-CNN对小麦穗部以及籽粒进行实例分割:一是将在大田中采集到的小麦数据经过人工标注送入神经网络经过迭代离线训练得到1个包含神经网络参数的模型, 二是基于Mask R-CNN训练获得的神经网络模型实现在线推演得到穗部的完整区域和不粘连的每个籽粒及数量。流程如图 3所示。

|

图 3 小麦分割训练流程 Fig. 3 Wheat segmentation training process |

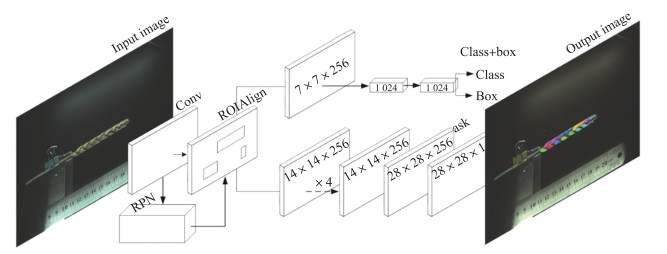

Mask R-CNN的网络结构是Faster R-CNN与FCN的结合体, 为了更好地检测小目标更改ROIPooling为ROIAlign。Faster R-CNN是用于目标检测的网络结构, 而FCN是用于进行语义分割的神经网络模型, 对小麦穗部的分割效果很好, 但是对籽粒的分割存在大量粘连。因此, 利用二者结合的Mask R-CNN对小麦的穗部和籽粒分割是一个最合适的选择。

Mask R-CNN采用残差网络(ResNet)结合特征金字塔模型(feature pyramid networks, FPN)作为特征提取器, 改进使用双线性插值的ROIAlign来处理更小的目标, 输出分两部分, 一是运用原始Faster R-CNN得到种类信息和位置信息, 二是通过全卷积神经网络预测Mask的信息, 即像素级别的分割。

Mask R-CNN的具体结构见图 4。图像首先经过卷积层提取特征, ROIAlign与区域建议网络(region proposal network, RPN)共享这些卷积特征并生成候选框, 再经过ROIAlign生成感兴趣区域(region of interest, ROI)。感兴趣区域经过卷积层和全连接层预测种类信息和位置信息, 再经过全卷积神经网络生成Mask, 最后将网络的不同分支所预测的3种信息进行综合得到包含分类、定位和分割的结果。

|

图 4 Mask R-CNN网络结构示意图 Fig. 4 Mask R-CNN network structure |

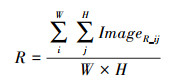

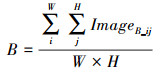

采用基于Keras(TensorFlow backend)深度学习框架训练Mask R-CNN, 采用不同的残差网络(ResNet-101, ResNet-50)和FPN作为骨干网络, 采用随机梯度下降算法(stochastic gradient descent, SGD)训练网络, 权重衰减系数(weight decay)设置为0.000 1, 动量因子(momentum)设置为0.9, 初始学习率(learning rate)设置为0.000 2, 训练BatchSize设置为4。为了使训练收敛加快并减轻计算负担, 我们对每张训练图像的R、G、B这3个通道计算得到像素平均值, 然后把训练图片放入网络之前, 运用每张图像减去各自通道的平均像素值, 这样也起到正则化的作用。计算见公式(1)—公式(3), 其中Image为原始图像, R、G、B为图像的3个通道, W、H为图像宽和高, R_ij为图像的第i行j列像素点的红色通道值, G_ij和B_ij为相应的绿色通道值和蓝色通道值。

|

(1) |

|

(2) |

|

(3) |

离线训练得到Mask R-CNN的模型, 利用其进行实时图像分割和籽粒表型测量。步骤如下:1)读取图像并利用感兴趣区域剔除干扰并缩放到800×800像素; 2)加载Mask R-CNN模型对图像进行分割; 3)将分割得到的信息写入图片上; 4)将图片通过双线性插值法转至原始大小; 5)输出种类信息、坐标信息和Mask信息, 依靠此信息进一步测量相应几何表型参数。

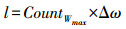

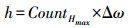

基于以上分割结果, 对预测数据进行分析和评估, 计算出麦穗的长、宽。通过单平面棋盘格摄像机标定方法得到像素间距离为Δω, l代表穗宽, h代表穗长, 在宽方向麦穗像素最大值和在高方向麦穗像素最大值与像素间距相乘, 计算出最大穗长和穗宽, 计算公式如下:

|

(4) |

|

(5) |

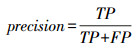

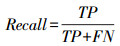

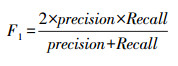

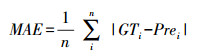

利用公式(4)—公式(5)计算预测结果, 得出每个麦穗的长、宽。此外, 对于Mask R-CNN分割的掩膜结果使用召回率、准确度和F1值综合评价。三者取值范围都在区间中, 值越大代表分割效果越好。召回率(recall)反映麦穗预测结果中正确掩膜像素数占真实掩膜像素数的比例, 精确度(precision)反映预测的掩膜像素数中真实掩膜像素数的比例。召回率和准确度呈负相关, 综合二者得到F1作为评价指标。其中, TP为预测的掩膜为真实标签中掩膜的像素数, FP为预测的掩膜不为真实标签中掩膜的像素数, FN为真实标签中掩膜未被预测到的像素数。

|

(6) |

|

(7) |

|

(8) |

平均绝对误差计算公式:

|

(9) |

平均相对误差计算公式:

|

(10) |

平均准确度(AP)的计算公式:

|

(11) |

基于Ubuntu 16.04.5 LTS版本操作系统, 10核心Intel Xeon E5-2650 v3@2.0GHz处理器, 128 G内存及2张NVIDIA TITAN XP显卡的配置下进行训练, 模型收敛共耗时37 h; 测试时, 对于1张2 048×1 536像素的图片, 耗时0.235 s, 达到4.26 FPS。综上评价指标, Mask R-CNN对小麦穗部的分割速度略微增加, 精度高于OTSU。对小麦籽粒进行精确分割。

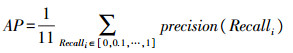

图 5为麦穗传统的OTSU自适应阈值分割方法、FCN分割方法和本文Mask R-CNN分割方法对麦穗的4个侧面进行分割的结果。从图 5可见:基于OTSU分割方法小麦穗部表型存在一些缺失部分, 对穗部边缘不能完整分割勾勒出来; 利用FCN进行分割可以分割出完整边缘, 但与真实值误差较大。而Mask R-CNN的分割方法不仅实现了小麦穗部像素级别的分割水平, 而且能对穗部进行识别得到包围框。表 1中误差计算方法见公式(10)。利用训练得到的模型对测试集进行预测, 对比不同的分割算法的预测结果见表 1。

|

图 5 不同分割算法对麦穗分割效果对比 Fig. 5 Comparison of different segmentation algorithms for wheat ear segmentation |

| 麦穗分组编号 Ear groupingnumber |

表型 Phenotype |

实际值/mm True value |

OTSU | FCN | Mask R-CNN | |||||

| 测量值/mm Measured value |

误差/% Error |

测量值/mm Measured value |

误差/% Error |

测量值/mm Measured value |

误差/% Error |

|||||

| 1 | 长Length | 65.60 | 61.4 | 6.38 | 54.6 | 16.77 | 66.1 | 0.83 | ||

| 宽Width | 15.58 | 13.3 | 14.55 | 14.3 | 7.70 | 14.8 | 4.61 | |||

| 2 | 长Length | 92.10 | 82.4 | 10.40 | 75.7 | 17.80 | 88.4 | 3.96 | ||

| 宽Width | 16.51 | 14.5 | 11.86 | 19.4 | 17.50 | 14.6 | 11.23 | |||

| 3 | 长Length | 62.60 | 64.6 | 3.20 | 59.8 | 4.35 | 63.1 | 0.89 | ||

| 宽Width | 16.82 | 19.7 | 17.19 | 19.7 | 17.36 | 16.2 | 3.67 | |||

| 4 | 长Length | 88.24 | 83.2 | 5.62 | 80.1 | 9.17 | 81.8 | 7.25 | ||

| 宽Width | 20.02 | 21.7 | 8.77 | 18.0 | 9.79 | 19.7 | 1.54 | |||

| 5 | 长Length | 69.16 | 74.1 | 7.14 | 66.9 | 3.22 | 70.6 | 2.22 | ||

| 宽Width | 17.23 | 16.5 | 4.16 | 14.9 | 13.17 | 17.2 | 0.03 | |||

| 6 | 长Length | 79.14 | 75.0 | 5.20 | 73.1 | 7.63 | 73.5 | 7.02 | ||

| 宽Width | 17.13 | 15.1 | 11.4 | 15.2 | 11.20 | 16.9 | 1.20 | |||

| 7 | 长Length | 70.70 | 65.1 | 7.89 | 62.5 | 11.56 | 65.9 | 6.72 | ||

| 宽Width | 20.74 | 17.0 | 17.89 | 18.5 | 10.56 | 19.6 | 5.45 | |||

| 平均Average | 长Length | 75.36 | 72.2 | 6.55 | 67.5 | 10.07 | 72.8 | 4.13 | ||

| 宽Width | 17.72 | 16.8 | 12.26 | 17.1 | 12.47 | 17.0 | 3.96 | |||

利用3种算法对每组麦穗测量长和宽的均值, 与麦穗长和宽的实际测量平均值对比, 利用公式(9)计算出绝对误差(表 2), 再利用公式(10)计算相对误差(表 3)。由表 2可见:Mask R-CNN方法测量穗长和穗宽的平均绝对误差分别为3.30和0.72 mm, 其中穗宽小于已有研究中的4.70 mm[27]。从表 3可见:OTSU对麦穗长和宽测量的相对误差分别为4.20%和5.20%, 平均误差为4.70%;FCN对麦穗长和宽测量的相对误差分别为10.40%和3.50%, 平均误差为6.95%;Mask R-CNN对麦穗长和宽测量的相对误差分别为3.40%和4.10%, 平均误差3.75%, 低于前面两种方法, 且优于已有研究中的3.95%[28]。由此可得, Mask R-CNN在对穗部的表型测量上有更高的精确度。

| 表型 Phenotype |

麦穗分组编号Ear grouping number | 平均绝对误差 Mean absolute error |

||||||

| 1 | 2 | 3 | 4 | 5 | 6 | 7 | ||

| 长Length | 0.50 | 3.70 | 0.50 | 6.44 | 1.44 | 5.64 | 4.80 | 3.30 |

| 宽Width | 0.78 | 1.91 | 0.62 | 0.32 | 0.03 | 0.23 | 1.14 | 0.72 |

| 表型Phenotype | OTSU | FCN | Mask R-CNN |

| 长Length | 6.55 | 10.07 | 4.13 |

| 宽Width | 12.26 | 12.47 | 3.96 |

| 平均Average | 9.41 | 11.27 | 4.05 |

利用Mask R-CNN对小麦穗部进行整体分割, 由表 3可知综合性能优于已有的OTSU方法和FCN方法。在对穗部进行检测和分割的同时也对小麦单侧籽粒进行实例分割, 这是先前的研究中基于全卷积神经网络的分割方法所不能够实现的。在对分割模型进行训练时, 使用ResNet-50和ResNet-101两种卷积神经网络模型结合特征金字塔网络将高层次和低层次的特征融合进行特征提取, 通过相同次数的迭代对7组测试数据进行试验比较, 结果如表 4所示。通过改变不同的特征提取网络进行训练, 从召回率、准确度和F1的结果可以看出:使用ResNet-101和FPN结合可以达到最优结果, 其中F1均值达到0.830。

| 麦穗分组编号 Ear grouping number |

ResNet-101+FPN | ResNet-50+FPN | |||||

| 准确度Precision | 召回率Recall | 平衡数F1 | 准确度Precision | 召回率Recall | 平衡数F1 | ||

| 1 | 0.875 | 0.835 | 0.849 | 0.853 | 0.737 | 0.788 | |

| 2 | 0.836 | 0.821 | 0.818 | 0.761 | 0.724 | 0.733 | |

| 3 | 0.830 | 0.795 | 0.803 | 0.753 | 0.635 | 0.683 | |

| 4 | 0.878 | 0.774 | 0.810 | 0.779 | 0.725 | 0.739 | |

| 5 | 0.896 | 0.834 | 0.862 | 0.891 | 0.833 | 0.857 | |

| 6 | 0.802 | 0.844 | 0.827 | 0.757 | 0.866 | 0.801 | |

| 7 | 0.818 | 0.864 | 0.838 | 0.803 | 0.836 | 0.815 | |

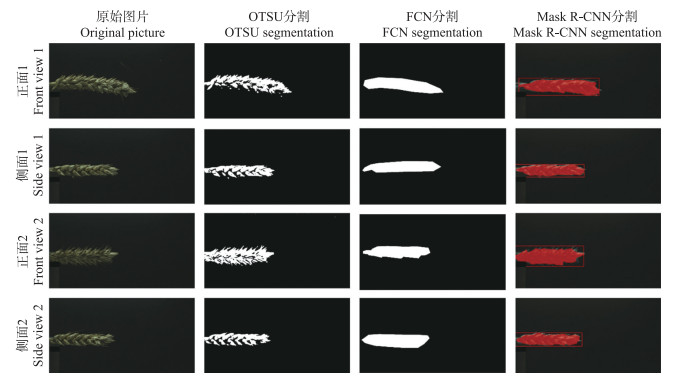

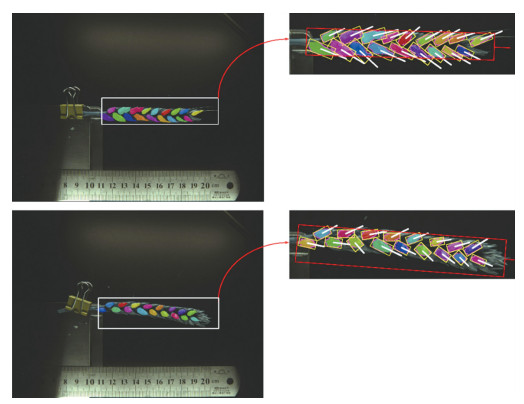

利用分割模型对测试图片进行籽粒分割, 部分分割效果如图 6所示:A1和B1为人工标注互不粘连籽粒, A2和B2显示为原始图片上的标注信息。A3和B3是利用Mask R-CNN预测的籽粒位置和数量, 利用不同的颜色代表不同的籽粒Mask, 且预测结果为相互间不粘连的闭合形态。通过与真实籽粒组比较, 无漏检现象。

|

图 6 基于Mask R-CNN模型的籽粒分割结果 Fig. 6 Grain segmentation result based on Mask R-CNN |

在进行籽粒分割的同时, 利用最小外接矩形法对每个籽粒进行朝向和角度测量。由每个籽粒分割得到的掩膜坐标推导出最小外接矩形, 进而由最小外接矩形计算籽粒的法向量, 通过与麦穗法向量求夹角得出该籽粒的朝向。再遍历每个籽粒, 则可对单个麦穗的籽粒都进行角度判定和朝向预测, 进一步获得麦穗的表型性状。如图 7为将籽粒分割之后用最小外接矩形处理然后标出每个籽粒的法向量。

|

图 7 小麦籽粒最小外接矩形 Fig. 7 Minimum outer rectangle of wheat grain |

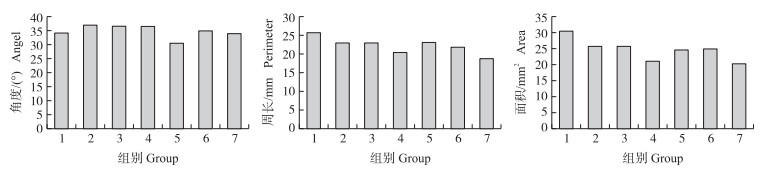

利用籽粒Mask及最小外接矩形, 得到每株麦穗上的籽粒区域, 对测试集图片的籽粒进行分析, 分7组求出籽粒的绝对角度、面积和周长。由图 8可见:每组籽粒朝向角度平均为35°, 籽粒平均周长为22 mm, 平均面积为23 mm2。

|

图 8 籽粒角度、周长和面积分布 Fig. 8 Grain angle, perimeter and area distribution |

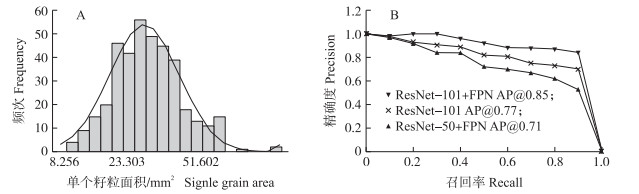

从图 9-A可见:籽粒面积符合高斯分布, 2 258个(均值)像素区域与像素间距相乘测量出本批次小麦籽粒的面积均值为23.303 mm2, 由投影面积可得每个籽粒的大小, 其与籽粒的质量密切相关。将ResNet-50+FPN、ReNet-101和ResNet-101+FPN作为特征提取网络在籽粒分割上的P-R曲线(图 9-B), 可见, 在高的查全率区间上ResNet-101+FPN依然能保持高精度。此外, 对单张图片进行测试, 在NVIDIA Titan XP上预测1张2 048×1 536像素的图片, ResNet-101需要0.235 s, 而ResNet-50+FPN需要0.210 s, 综合精度和速度考虑, 使用ResNet-101+FPN作为基本特征提取网络分割更准确。

|

图 9 麦穗籽粒分布频次(A)及P-R曲线(B) Fig. 9 P-R curves and grain distribution A.柱状图表示每一个投影面积区间麦穗面积出现的频次, 折线图为分布函数; B. ResNet-50+FPN、ReNet-101和ResNet-101+FPN代表不同的特征提取网络结构, 图中坐标点表示不同的召回率下模型的精确度。 A. The histogram shows the frequency of occurrence of ear area in each projected area interval, and the broken line graph shows the distribution function; B. ResNet-50+FPN, ReNet-101, ResNet-101+FPN represent different feature extraction network structures, and coordinate points in the figure represent model accuracy under different recall rates. |

表 5为3种算法在不同查全率阈值下的准确度, 其数据可视化结果如9-B所示, 利用公式(11)对数据进行计算得到平均准确度(AP)的值, 可得ResNet-101+FPN得到了最高的准确度, 这也是本文使用其作为特征提取的依据。

| 不同网络结构 Different network structures |

不同召回率下的准确度Precision under different recall | 平均准确度 AP |

||||||||||

| 0.0 | 0.1 | 0.2 | 0.3 | 0.4 | 0.5 | 0.6 | 0.7 | 0.8 | 0.9 | 1.0 | ||

| ResNet-101+FPN | 1.00 | 0.98 | 1.00 | 1.00 | 0.96 | 0.92 | 0.88 | 0.88 | 0.87 | 0.84 | 0.00 | 0.85 |

| ResNet-101 | 1.00 | 0.98 | 0.93 | 0.91 | 0.89 | 0.82 | 0.81 | 0.75 | 0.73 | 0.70 | 0.00 | 0.77 |

| ResNet-50+FPN | 1.00 | 0.97 | 0.92 | 0.84 | 0.84 | 0.72 | 0.70 | 0.67 | 0.62 | 0.53 | 0.00 | 0.71 |

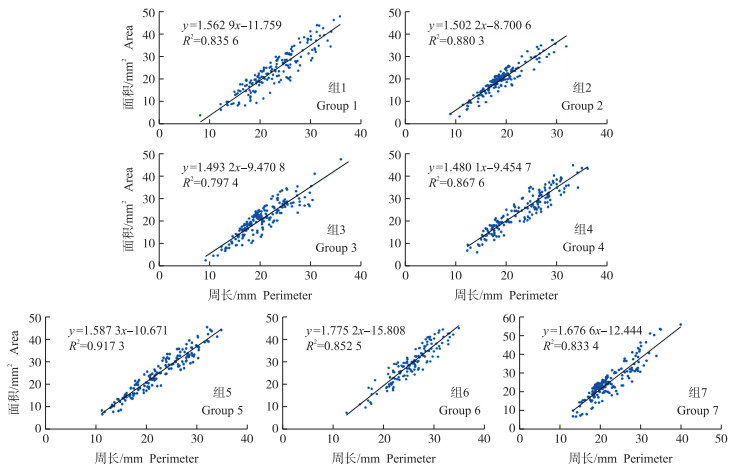

计算单籽粒周长和面积, 对二者相关性进行分析(图 10), 得出籽粒周长分布聚集在10~30 mm, 面积分布聚集在10~40 mm2, 二者平均相关系数为0.85。因此可进一步求出籽粒饱满程度, 为考种、品种选育提供支持。

|

图 10 小麦单籽粒周长和面积相关性分析 Fig. 10 Correlation analysis of perimeter and area of a single grain |

本文提出一种基于卷积神经网络端对端的分割方法, 利用Mask R-CNN网络模型架构, 对经过标注和数据增广的小麦图像进行感兴趣区域建议分析和特征提取, 训练得到用于小麦麦穗及侧面籽粒精准分割的Mask R-CNN算法模型。

1) 在小麦穗部的分割结果中, 本文基于Mask R-CNN的麦穗分割方法测量穗长的平均绝对误差为3.30 mm, 平均相对误差为3.40%, 测量穗宽的平均绝对误差为0.72 mm, 平均相对误差为4.10%, 综合平均误差为3.75%, 相比较于OTSU、FCN方法误差更低。

2) 与FCN分割结果相比, 本文中的Mask R-CNN利用ResNet-101+FPN作为特征提取网络处理单张2 048×1 536像素的图片需要时间为0.235 s, 处理速度比FCN方法提高了8.5倍。

3) 在对小麦穗部进行籽粒分割, 得到各自闭合的小麦籽粒组, 由结果分析得到籽粒分割AP值为0.85, F1值为0.830, 籽粒面积呈现高斯分布, 均值为23.303 mm2。

4) 利用籽粒分割得到的掩膜坐标, 可计算每个籽粒侧面的投影面积、最小外接矩形, 从而得到麦穗中相应籽粒的夹角和朝向。

利用Mask R-CNN算法分别对麦穗和籽粒几何尺度进行粗分割和精细分割, 籽粒几何尺度精细分割实现了单像素级别的分割, 基本解决相邻籽粒图像间的粘连现象, 因此不仅籽粒图像分割精准, 而且麦穗轮廓分割精准度也获得大幅提升。在精准分割的基础上, 采用传统图像处理方法能够很容易得到麦穗籽粒尺度的相关几何参数, 包括穗长、穗宽、侧面籽粒与麦穗夹角、侧面籽粒投影面积和周长等, 该分割方法的性能得到了较充分的体现, 为小麦育种、质量评估与产量预测提供更丰富的技术手段。另外, 利用数据增广技术提高了模型泛化能力, 通过标注数据迭代训练, 在处理速度提升的基础上使该方法鲁棒性也较好。本文基于Mask R-CNN的麦穗分割算法处理的麦穗图像数据不依赖于高精密的图像采集设备和特殊的光源设计方法, 为下一步田间的表型测量研究提供了借鉴思路, 这也是后继工作的研究方向与目标。

| [1] |

王寒冬, 陈文杰, 张波, 等. 人工合成小麦改良品系的种子表型性状分析[J]. 分子植物育种, 2018, 16(18): 6097-6104. Wang H D, Chen W J, Zhang B, et al. Phenotypic analysis of grain traits in improved lines of synthetic wheat[J]. Molecular Plant Breeding, 2018, 16(18): 6097-6104 (in Chinese with English abstract). |

| [2] |

田纪春, 邓志英, 胡瑞波, 等. 不同类型超级小麦产量构成因素及籽粒产量的通径分析[J]. 作物学报, 2006, 32(11): 1699-1705. Tian J C, Deng Z Y, Hu R B, et al. Yield components of super wheat cultivars with different types and the path coefficient analysis on grain yield[J]. Acta Agronomica Sinica, 2006, 32(11): 1699-1705 (in Chinese with English abstract). DOI:10.3321/j.issn:0496-3490.2006.11.017 |

| [3] |

王桂琴.图像处理技术在小麦产量预测中的应用研究[D].北京: 中国农业大学, 2004. Wang G Q. Application of image processing technology in prediction of wheat yield[D]. Beijing: China Agricultural University, 2004(in Chinese with English abstract). |

| [4] |

杜世伟, 李毅念, 姚敏, 等. 基于小麦穗部小穗图像分割的籽粒计数方法[J]. 南京农业大学学报, 2018, 41(4): 742-751. Du S W, Li Y N, Yao M, et al. Counting method of grain number based on wheatear spikelet image segmentation[J]. Journal of Nanjing Agricultural University, 2018, 41(4): 742-751 (in Chinese with English abstract). DOI:10.7685/jnau.201709043 |

| [5] |

王宁, 孔斌, 王灿, 等. 基于图像分形分割的麦穗粒数计算方法[J]. 计算机系统应用, 2017, 26(10): 219-224. Wang N, Kong B, Wang C, et al. Counting grains per wheat spike based on fractal segmentation of image[J]. Computer Systems & Applications, 2017, 26(10): 219-224 (in Chinese). |

| [6] |

刘涛, 孙成明, 王力坚, 等. 基于图像处理技术的大田麦穗计数[J]. 农业机械学报, 2014, 45(2): 282-290. Liu T, Sun C M, Wang L J, et al. In-field wheatear counting based on image processing technology[J]. Transactions of the Chinese Society for Agricultural Machinery, 2014, 45(2): 282-290 (in Chinese with English abstract). |

| [7] |

孙俊, 宋佳, 武小红, 等. 基于改进Otsu算法的生菜叶片图像分割方法[J]. 江苏大学学报(自然科学版), 2018, 39(2): 179-184. Sun J, Song J, Wu X H, et al. Image segmentation method of lettuce leaf based on improved Otsu algorithm[J]. Journal of Jiangsu University(Natural Science Edition), 2018, 39(2): 179-184 (in Chinese with English abstract). DOI:10.3969/j.issn.1671-7775.2018.02.010 |

| [8] |

于洪涛, 袁明新, 谢丰, 等. 一种融合动态OTSU和几何特征的苹果视觉分割算法[J]. 信息技术, 2018, 42(8): 39-43, 47. Yu H T, Yuan M X, Xie F, et al. A visual segmentation algorithm for apples based on dynamic OTSU and geometrical features[J]. Information Technology, 2018, 42(8): 39-43, 47 (in Chinese). |

| [9] |

杨蜀秦, 宁纪锋, 何东健, 等. 一种基于主动轮廓模型的连接米粒图像分割算法[J]. 农业工程学报, 2010, 26(2): 207-211. Yang S Q, Ning J F, He D J, et al. Image segmentation algorithm of touching rice kernels based on active contour model[J]. Transactions of the Chinese Society of Agricultural Engineering, 2010, 26(2): 207-211 (in Chinese with English abstract). DOI:10.3969/j.issn.1002-6819.2010.02.036 |

| [10] |

柳冠伊, 刘平义, 魏文军, 等. 玉米果穗粘连籽粒图像分割方法[J]. 农业机械学报, 2014, 45(9): 285-290. Liu G Y, Liu P Y, Wei W J, et al. Method of image segmentation for touching maize kernels[J]. Transactions of the Chinese Society for Agricultural Machinery, 2014, 45(9): 285-290 (in Chinese with English abstract). |

| [11] |

尹宏鹏, 陈波, 柴毅, 等. 基于视觉的目标检测与跟踪综述[J]. 自动化学报, 2016, 42(10): 1466-1489. Yin H P, Chen B, Chai Y, et al. Vision-based object detection and tracking:a review[J]. Acta Automatica Sinica, 2016, 42(10): 1466-1489 (in Chinese with English abstract). |

| [12] |

Long J, Shelhamer E, Darrell T. Fully convolutional networks for semantic segmentation[C]//IEEE Conference on Computer Vision and Pattern Recognition. IEEE Computer Society, 2015: 3431-3440.

|

| [13] |

Ronneberger O, Fischer P, Brox T. U-Net: convolutional networks for biomedical image segmentation[C]//18th International Conference on Medical Image Computing and Computer-Assisted Intervention(MICCAI), 2015: 234-241.

|

| [14] |

Chen L C, Papandreou G, Kokkinos I, et al. DeepLab:semantic image segmentation with deep convolutional nets, atrous convolution, and fully connected CRFs[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2018, 40(4): 834-848. DOI:10.1109/TPAMI.2017.2699184 |

| [15] |

Krizhevsky A, Sutskever I, Hinton G E. ImageNet classification with deep convolutional neural networks[J]. Communications of the ACM, 2012, 60(2): 1097-1105. |

| [16] |

Simonyan K, Zisserman A. Very deep convolutional networks for large-scale image recognition[J/OL]. Computer Science, 2014, 1409: 1556.

|

| [17] |

Szegedy C, Liu W, Jia Y, et al. Going deeper with convolutions[C]//IEEE Conference on Computer Vision and Pattern Recognition. IEEE Computer Society, 2015: 1-9.

|

| [18] |

He K M, Zhang X Y, Ren S Q, et al. Deep residual learning for image recognition[C]//IEEE Conference on Computer Vision and Pattern Recognition. IEEE Computer Society, 2016: 770-778.

|

| [19] |

Girshick R. Fast R-CNN[C]//IEEE International Conference on Computer Vision. IEEE Computer Society, 2015: 1440-1448.

|

| [20] |

Ren S Q, He K M, Girshick R, et al. Faster R-CNN:towards real-time object detection with region proposal networks[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2015, 39(6): 1137-1149. |

| [21] |

Liu W, Anguelov D, Erhan D, et al. SSD: single shot MultiBox detector[C]//European Conference on Computer Vision. Springer International Publishing, 2016: 21-37.

|

| [22] |

He K M, Zhang X Y, Ren S Q, et al. Spatial pyramid pooling in deep convolutional networks for visual recognition[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2015, 37(9): 1904-1916. DOI:10.1109/TPAMI.2015.2389824 |

| [23] |

张芳, 吴玥, 肖志涛, 等. 基于U-Net卷积神经网络的纳米颗粒分割[J]. 激光与光电子学进展, 2019, 56(6): 137-143. Zhang F, Wu Y, Xiao Z T, et al. Nanoparticle segmentation based on U-Net convolutional neural network[J]. Laser & Optoelectronics Progress, 2019, 56(6): 137-143 (in Chinese with English abstract). |

| [24] |

陈天华, 郑司群, 于峻川. 采用改进DeepLab网络的遥感图像分割[J]. 测控技术, 2018, 37(11): 34-39. Chen T H, Zheng S Q, Yu J C. Remote sensing image segmentation based on improved DeepLab network[J]. Measurement & Control Technology, 2018, 37(11): 34-39 (in Chinese with English abstract). |

| [25] |

段凌凤, 熊雄, 刘谦, 等. 基于深度全卷积神经网络的大田稻穗分割[J]. 农业工程学报, 2018, 34(12): 202-209. Duan L F, Xiong X, Liu Q, et al. Field rice panicle segmentation based on deep full convolutional neural network[J]. Transactions of the Chinese Society of Agricultural Engineering, 2018, 34(12): 202-209 (in Chinese with English abstract). DOI:10.11975/j.issn.1002-6819.2018.12.024 |

| [26] |

He K M, Gkioxari G, Dollar P, et al. Mask R-CNN[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2018, 1-12. |

| [27] |

邱茂林, 马颂德, 李毅. 计算机视觉中摄像机定标综述[J]. 自动化学报, 2000, 26(1): 43-55. Qiu M L, Ma S D, Li Y. Overview of camera calibra on computer vision[J]. Acta Automatic Sincia, 2000, 26(1): 43-55 (in Chinese with English abstract). |

| [28] |

路文超, 罗斌, 潘大宇, 等. 基于图像处理的小麦穗长和小穗数同步测量[J]. 中国农机化学报, 2016, 37(6): 210-215. Lu W C, Luo B, Pan D Y, et al. Synchronous measurement of wheat ear length and spikelets number based on image processing[J]. Journal of Chinese Agricultural Mechanization, 2016, 37(6): 210-215 (in Chinese with English abstract). |