2. 中国科学院机器人与智能制造创新研究院, 辽宁 沈阳 110169;

3. 中国科学院大学, 北京 100049

2. Institutes for Robotics and Intelligent Manufacturing, Chinese Academy of Sciences, Shenyang 110169, China;

3. University of Chinese Academy of Sciences, Beijing 100049, China

在低光照条件下或相机曝光时间不足的情况下拍摄的图像称为低照度图像。低照度图像通常具有低亮度、低对比度以及结构信息模糊的特点,这给很多机器人视觉任务带来了困难,如低照度图像的人脸识别、目标跟踪[1]、自动驾驶[2]、特征提取[3]等任务。低照度图像的增强方法不仅可以改善图像的视觉效果,还可以提高后续机器人视觉任务算法的鲁棒性,具有重要的实际应用价值。

根据是否需要依赖大量的数据进行训练,目前已有的低照度图像增强算法可以分为传统方法和基于深度学习的方法两类。在传统的低照度图像增强方法中,基于直方图的方法[4-5]通过调整图像的直方图来提高图像的对比度,达到增强低照度图像的目的,这类方法简单高效,但缺乏物理机制,常常导致图像的过增强或欠增强,并且图像的噪声也会被明显地放大。基于Retinex理论[6]的方法先通过将图像分解得到光照分量和反射分量,再分别进行增强。Wang等[7]设计了一个低通滤波器将图像分解为反射图像和光照图像,并使用一个双对数变换对图像进行增强来平衡自然度和图像细节。Guo等[8]先对低照度图像的RGB三通道取最大值得到一个初始的光照图像,再通过结构先验信息来修正初始光照,使用伽马校正法调整图像亮度,再将调整后的光照图像与反射图像合成得到最终的增强结果。Ren等[9]提出了一种抑制噪声的序列评估模型来分别估计光照分量和反射分量,在这种噪声抑制的序列分解过程中,对每个分量进行空间平滑并巧妙地利用权重矩阵来抑制噪声和提高对比度,最后将估计得到的反射分量与伽马校正后的光照分量合并得到增强图像,最终达到低照度增强联合去噪的目的。

基于深度学习的方法[10-13]通过对大量数据的训练,在低照度图像增强上取得了很好的效果。Lore等[10]最先提出了一个用于对比度增强和噪声消除的深度自动编码器来增强低照度图像。Wei等[11]将Retinex模型和深度神经网络结合用于低照度图像增强中。Jiang等[12]利用生成式对抗网络实现了低照度图像增强模型,该模型无需使用配对的训练数据进行训练。Guo等[13]将低照度图像增强任务转换为一项具有深度网络的特定曲线估计任务。这些基于深度学习的方法的训练过程通常需要耗费大量的时间和计算资源。并且这些方法的效果在很大程度上取决于训练数据,不准确的参考图像会影响训练结果,比如在真实拍摄的正常光照图像中,由于光照不均匀可能存在局部高光照区域过曝光或局部低光照区域欠曝光的问题。

在低照度图像增强中,不均匀的光照也是一个需要解决的问题。对于局部低照度图像来说,将图像亮度提升过高会导致图像的高光照区域过曝光,而亮度提升不足又无法将低光照区域的图像细节信息展示出来。得益于拍照设备的进步,可以固定拍照设备并在短时间内获取不同曝光时长的图像,并将拍摄所得的一组图像融合得到具有更大动态范围的图像。Wang等[14]在YUV色彩空间中设计了一种基于边缘信息保留的平滑多尺度曝光融合算法,可以同时保留场景中高光照区域和低光照区域中的细节,为了弥补融合过程中丢失的细节信息,设计了一个矢量场构造算法从矢量字段中提取可见的图像细节,且该方法可避免图像融合过程中出现的颜色失真。图像融合的方法虽然可以有效地提高图像动态范围,但需要预先获取一组不同曝光时长的图像,无法对单张低照度图像增强。拍摄动态场景或拍摄时相机发生抖动都会使得所拍摄的图像对准困难,进而导致融合结果中存在伪影。

为了将图像融合的方法应用到低照度图像增强中达到提高图像动态范围的目的,需要先根据单张图像生成一组用于融合的信息。目前已有一些方法将图像融合的思想用于低照度图像增强。其中,Fu等[15]先通过一种基于形态学闭合的光照估计算法将图像分解得到光照图像和反射图像,再分别使用Sigmoid函数和自适应直方图均衡化算法对照明图像进行处理得到亮度提升后的光照图像和对比度增强的光照图像,将两个增强后的光照图像进行融合再与反射图像合成得到最终的增强图像。Cai等[16]采集了589组多曝光图像,并用13种已有的方法对多曝光图像进行融合,选取最优结果作为参考图像,设计了一个卷积神经网络在这个数据集上进行训练,最终得到一个低照度图像增强器。基于图像融合的单张低照度图像增强方法有效解决了图像融合需要多张曝光图像作为输入图像的问题,但Fu等[15]和Cai等[16]的方法仍然存在缺乏物理机制的问题。

针对目前方法存在的问题,本文提出了一个基于多曝光图像生成的低照度图像增强方法。首先从物理成像机制出发,分析了曝光图像之间的关系,发现不同曝光时长的图像之间存在与阴影和非阴影图像之间相似形式的关系。基于此,首次提出将正交分解方法[17]用于多曝光图像融合,即使用正交分解的方法将图像分解得到光照分量与光照不变量,通过改变光照分量生成具有不同曝光时长的图像。再利用图像融合的方法将生成图像融合得到具有高动态范围的图像。由于生成的图像与真实拍摄的图像比较接近,融合所得的增强图像自然度也保持得很好。同时,由单张图像生成的多曝光图像是逐像素对应的,融合结果不存在伪影,也解决了拍摄多曝光图像时相机需要固定的问题。并且,本文方法无需依赖大量的数据进行训练,具有很好的通用性。

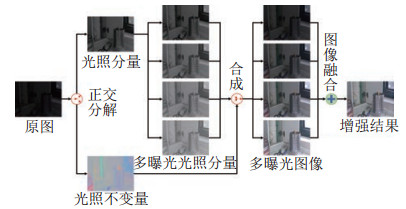

2 多曝光图像的生成与低照度图像增强(Generation of multi-exposure images and low-light image enhancement)本文方法主要包含3个部分:(1)图像正交分解。将原图分解得到一个光照分量和一个光照不变量。(2)多曝光图像生成。通过改变光照分量的大小生成多曝光光照分量,并将其与原始光照不变量合成,得到多曝光图像;(3)多曝光图像融合。将多曝光图像融合,得到最终增强后的图像。图 1所示为本文算法框架。

|

图 1 算法框架 Fig.1 Framework of the algorithm |

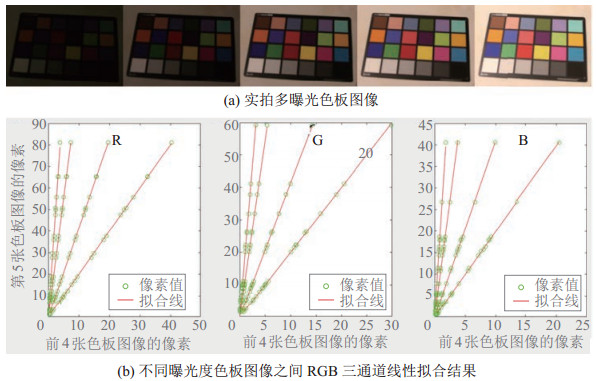

通过实验发现,在光照和相机参数固定的情况下所拍摄的不同曝光度的图像之间存在线性关系,如图 2所示,图 2(a)为一组不同曝光时长下拍摄的色板图像,图 2(b)分别展示了RGB三通道在不同曝光度下色板中24个颜色的真实像素值与拟合线,绿色圆圈代表了真实像素值,红色实线代表拟合线,像素值均为伽马校正前的RGB像素值,横坐标代表前4张色板图像的像素值,纵坐标代表第5张色板图像的像素值。

|

图 2 实拍多曝光图像的像素间的线性关系 Fig.2 Linear relationship between pixels of real-captured multi-exposure images |

图 2中所示的线性关系可以表达为

| $ \begin{align} \frac{E_{H}^{\rm L}} {e_{H}^{\rm L}} =K_{H} \end{align} $ | (1) |

其中

对式(1)中的

| $ \begin{align} \lg E_{H} =\frac{\lg K_{H}} {2.4}+\lg e_{H} \end{align} $ | (2) |

这与同一物体在阴影区域和非阴影区域中的像素所展示出的RGB三通道之间的关系[18]有相似的表达形式。

与文[17]中相似,由式(1)可以得到:

| $ \begin{align} {\mathit{\boldsymbol{AE}}}'=\mathit{\boldsymbol{Ae}}'=\mathit{\boldsymbol{C}} \end{align} $ | (3) |

其中

| $ \begin{align*} & \mathit{\boldsymbol{A}} =\begin{bmatrix} 1 & 1 & -\beta_{1} \\ 1 & -\beta_{2} & 1 \\ -\beta_{3} & 1 & 1 \end{bmatrix}, \; \; \; \beta_{1} =\frac{\lg K_{\rm R} +\lg K_{\rm G}} {\lg K_{\rm B}} \\ & \beta_{2} =\frac{\lg K_{\rm R} +\lg K_{\rm B}} {\lg K_{\rm G}}, \; \; \; \; \; \qquad \beta_{3} =\frac{\lg K_{\rm B} +\lg K_{\rm G}} {\lg K_{\rm R}}\\ & \mathit{\boldsymbol{E}}'=[\lg (E_{\rm R} +14), \; \; \; \lg (E_{\rm G} +14), \; \lg (E_{\rm B} +14)]^{\rm T}\\ & {\mathit{\boldsymbol{e}}}'=[\lg (e_{\rm R} +14), \; \; \; \lg (e_{\rm G} +14), \; \lg (e_{\rm B} +14)]^{\rm T} \end{align*} $ |

对图像中任一像素,像素值为

| $ \begin{align} \mathit{\boldsymbol{Au}} = \mathit{\boldsymbol{C}} \end{align} $ | (4) |

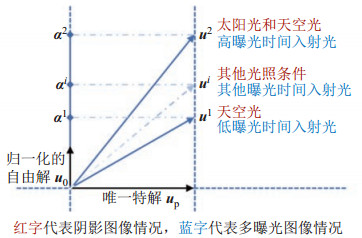

本课题组首次在文[17]中提出正交分解方法,如式(5)所示:

| $ \begin{align} {\mathit{\boldsymbol{u}}}=\mathit{\boldsymbol{u}}_{\rm p} +\alpha \mathit{\boldsymbol{u}}_{0} \end{align} $ | (5) |

其中

|

图 3 阴影图像与多曝光图像中的正交分解示意图 Fig.3 Illustration of orthogonal decomposition in shadow images and multi-exposure images |

在得到原图的光照不变量与光照分量后,对光照分量进行增强或减弱即可得到具有不同曝光时长的光照分量:

| $ \begin{align} \alpha'=\alpha +\Delta \alpha \end{align} $ | (6) |

其中

| $ \begin{align} \mathit{\boldsymbol{u}}'=\mathit{\boldsymbol{u}}_{\rm p} +\alpha'\mathit{\boldsymbol{u}}_{0} \end{align} $ | (7) |

最后根据式(8)对

| $ \begin{align} \mathit{\boldsymbol{v}}'=10^{\mathit{\boldsymbol{u}}'}-14\times {\mathit{\boldsymbol{1}}}_{3\times 1} \end{align} $ | (8) |

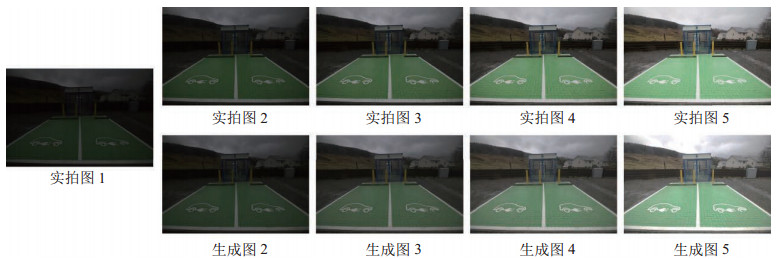

图 4所示为一组真实拍摄的多曝光图像和通过控制

|

图 4 一组实拍多曝光图像与生成的多曝光图像 Fig.4 A set of real-captured multi-exposure images and generated multi-exposure images |

为了自动地生成具有不同曝光时长的多曝光图像,设计了自适应生成多曝光图像的算法,可以根据原图的亮度自动选择光照增量

将图像中任一像素(像素值

| $ \begin{align} l=\frac{0.299\times v_{\rm R} +0.587\times v_{\rm G} +0.114\times v_{\rm B}} {255} \end{align} $ | (9) |

整张图像的亮度

| $ \begin{align} L=\frac{ \sum l} {p} \end{align} $ | (10) |

其中

记

| $ \begin{align} \Delta \alpha^{i}=\Delta \alpha^{1}+(i-1)\frac{\Delta \alpha^{N}-\Delta \alpha^{1}}{N-1} \end{align} $ | (11) |

当

| $ \begin{align} \mathop{\arg\min} \limits_{\Delta \alpha^{N}} \frac{ \sum\limits_n f_{\max} (\Delta \alpha^{N})} {p}>0.5 \end{align} $ | (12) |

其中,

| $ \begin{align} f_{\max} (\Delta \alpha^{N}) =\begin{cases} 1, & \max (v_{\rm R}^{N}, v_{\rm G}^{N}, v_{\rm B}^{N})>0.7\times 255 \\ 0, & \text{其他} \end{cases} \end{align} $ | (13) |

其中,

由于生成图像与原图之间的光照增量越大,所生成的图像与真实的不同曝光图像之间的误差越大,故当

当

| $ \begin{align} \mathop{\arg\min}\limits_{\Delta \alpha^{1}} \frac{ \sum\limits_n f_{\min} (\Delta \alpha^{1})} {p}>0.5 \end{align} $ | (14) |

其中,

| $ \begin{align} f_{\min} (\Delta \alpha^{1}) =\begin{cases} 1, & \min (v_{\rm R}^{1}, v_{\rm G}^{1}, v_{\rm B}^{1})<0.3\times 255 \\ 0, & \text{其他} \end{cases} \end{align} $ | (15) |

其中

本文中设置

|

图 5 一组自适应生成的多曝光图像 Fig.5 A set of adaptively generated multi-exposure images |

为了得到更大动态范围的增强图像,本文采用多尺度曝光融合方法[14]将多曝光图像融合生成最终的增强图像。与该方法利用拍摄所得的一组多曝光图像进行融合不同,本文将单张图像自适应生成的

(1) 根据原图通过2.3节中的方法生成

(2) 将

(3) 根据式(16)计算多曝光图像的加权图:

| $ \begin{align} W_{i, j, k} =C_{i, j, k} \times S_{i, j, k} \times E_{i, j, k} \times B_{k} \end{align} $ | (16) |

其中

(4) 对

(5) 对1到

| $ \begin{align} R_{l}^{k} =G_{l} \{\bar{W}(k)\}L_{l} \{I(k)\}, \quad l=1, 2, \cdots, n-1 \end{align} $ | (17) |

(6) 对第

| $ \begin{align} R_{n}^{k} =\Big(G_{2}' \{G_{n} \{\bar{W}(k)\}\}+\beta | L_{1} \{L_{n} \{I(k)\}\} |\Big)L_{n} \{I(k)\} \end{align} $ | (18) |

(7) 由下式得到最终的低照度图像增强结果:

| $ \begin{align} R_{l} =\sum\limits_{k=1}^N R_{l}^{k}, \; \quad l=1, 2, \cdots, n \end{align} $ | (19) |

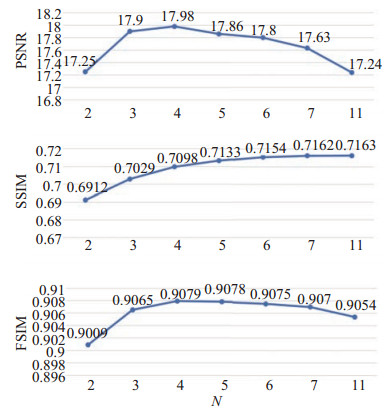

为了确定生成多曝光图像张数

|

图 6 参数N的选择与LOL数据集上的评价结果 Fig.6 Selection of the parameter N and the corresponding evaluation results on LOL dataset |

峰值信噪比(PSNR)、结构相似性(SSIM)和特征相似性(FSIM)[19]这3个全参考的评价指标,均为值越大说明增强效果越好。从图 6中可以看出,指标PSNR先是随着

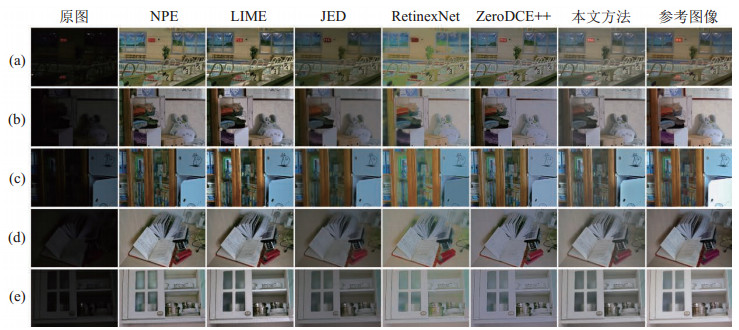

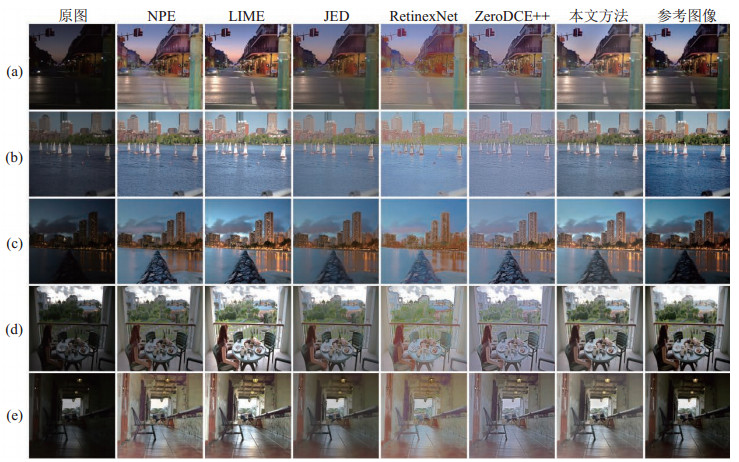

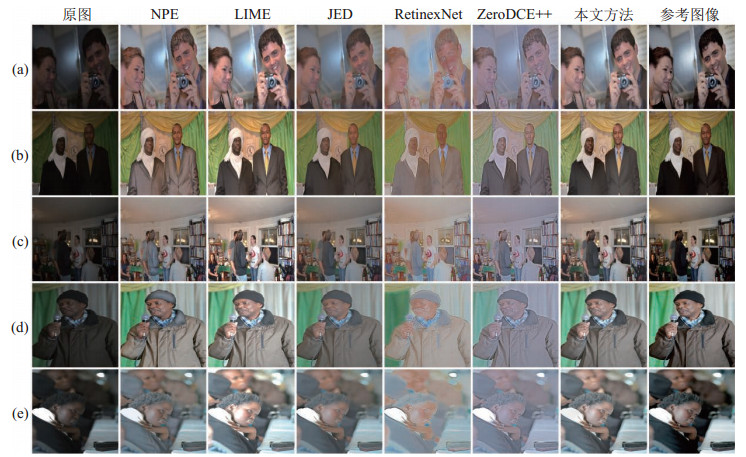

本节分别从主观恢复效果和客观评价指标2个方面,对本文方法与5个代表性的低照度增强方法在2个公开数据集的测试集上进行对比。其中,NPE方法[7]、LIME方法[8]、JED方法[9]为传统方法,RetinexNet方法[11]和ZeroDCE++方法[13]为基于深度学习的方法。LOL数据集[11]的测试集包含15组图像,其中低照度图像和参考图像均为相机拍摄所得。MIT数据集[20]的测试集包含500组图像,其中低照度图像为相机拍摄所得,参考图像为由5位摄影师(A/B/C/D/E)利用软件手动调整所得,本文采用摄影师C的调整结果作为参考图像,并将图像转为400

|

图 8 MIT测试数据集[20]上室外低照度图像的增强结果 Fig.8 Enhanced results of outdoor low-light images on MIT test dataset[20] |

|

图 9 MIT测试数据集[20]上室内低照度图像的增强结果 Fig.9 Enhanced results of indoor low-light images on MIT test dataset[20] |

为了定量评价本文方法的增强效果,采用全参考的评价指标PSNR、SSIM和FSIM[19]对各个方法的增强结果进行评价。其中PSNR越大,说明增强结果与参考图像在像素值上越接近;SSIM越大,说明增强结果与参考图像在结构上越接近;FSIM越大,说明增强结果与参考图像在特征上越接近。

表 1给出了LOL测试集[11]上不同方法的定量评价结果,表 2给出了MIT测试集[20]上不同方法的定量评价结果。其中最优的指标值以红色表示,次优的指标值以蓝色表示。从表 1可以看出,本文方法在LOL测试集[11]上3个评价指标均最优,即本文方法得到了与真实拍摄图像最为接近的增强结果。从表 2可以看出,本文方法在MIT测试集[20]上SSIM和FSIM均取得最优结果,PSNR取得了次优的结果,说明本文方法的增强结果与手工调整的参考图像在结构和特征上最为接近。

3.3 多曝光融合实验分析本节首先对本文所生成的多曝光图像与固定相机拍摄的多曝光图像在融合增强性能方面进行了对比,效果如图 10所示。其中图 10(a)(b)为固定相机后拍摄的具有不同曝光时长的图像,图 10(c)为本文方法将图 10(a)作为输入图像得到的增强结果,图 10(d)为将图 10(a)(b)作为输入图像融合得到的结果。从图中可以看出,本文方法增强结果图 10(c)的对比度好于实拍多曝光图像的融合结果图 10(d),并且从红框放大区域可以看出,本文方法结果的清晰度要更高。从图 10(d)的黄框中可以看到,由于拍摄到动态场景(骑摩托车的人)而在融合中产生了伪影,但此问题在本文方法的结果中则不存在。

|

图 10 本文方法与实拍多曝光图像融合结果对比 Fig.10 Comparison between results of the proposed method and the real-captured multi-exposure image fusion method |

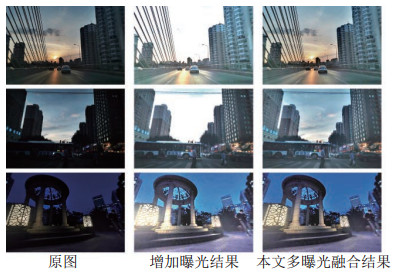

其次,对本文生成的多曝光图像融合结果与单一增加曝光结果进行了图像增强效果对比,如图 11所示。在仅仅增加曝光量的实验结果中,原图像中光照低的部分(如建筑)得到了明显的增强,但原图像中光照高的部分(如天空和灯)则由于过曝光而丢失了原有图像的信息,在多曝光融合的结果中,则成功将低光照和高光照部分的信息同时保留,说明本文方法可以在有效提高图像亮度的同时得到具有更大动态范围的增强结果。

|

图 11 多曝光融合结果与增加曝光结果对比 Fig.11 Comparison between the multi-exposure fusion results and the increased exposure results |

提出了一个基于多曝光图像生成的低照度图像增强方法。该方法基于物理机制,根据单张低照度图像生成多曝光图像,实现了单张图像的低照度增强,其效果优于一些现有的单张低照度图像增强方法以及多张曝光图像融合的方法。本文提出的根据单张低照度图像进行增强的方式,可有效避免伪影的产生,与使用多张曝光图像进行融合的方式相比具有更好的通用性。

| [1] |

苏贇, 王挺, 姚辰, 等. 基于合作目标的无人机目标跟踪方法[J]. 机器人, 2019, 41(4): 425-432. Su Y, Wang T, Yao C, et al. A target tracking method of UAV based on cooperative target[J]. Robot, 2019, 41(4): 425-432. |

| [2] |

高兴波, 史旭华, 葛群峰, 等. 面向动态物体场景的视觉SLAM综述[J]. 机器人, 2021, 43(6): 733-750. Gao X B, Shi X H, Ge Q F, et al. A survey of visual SLAM for scenes with dynamic objects[J]. Robot, 2021, 43(6): 733-750. |

| [3] |

谢自强, 葛为民, 王肖锋, 等. 发展型机器人实时特征提取方法研究[J]. 机器人, 2017, 39(2): 189-196. Xie Z Q, Ge W M, Wang X F, et al. Real time feature extraction method of developmental robot[J]. Robot, 2017, 39(2): 189-196. |

| [4] |

Singh K, Kapoor R. Image enhancement using exposure based sub image histogram equalization[J]. Pattern Recognition Letters, 2014, 36(1): 10-14. |

| [5] |

Lee C, Lee C, Kim C S. Contrast enhancement based on layered difference representation of 2D histograms[J]. IEEE Transactions on Image Processing, 2013, 22(12): 5372-5384. DOI:10.1109/TIP.2013.2284059 |

| [6] |

Land E H, McCann J J. Lightness and Retinex theory[J]. Journal of the Optical Society of America, 1971, 61(1): 1-11. DOI:10.1364/JOSA.61.000001 |

| [7] |

Wang S H, Zheng J, Hu H M, et al. Naturalness preserved enhancement algorithm for non-uniform illumination images[J]. IEEE Transactions on Image Processing, 2013, 22(9): 3538-3548. DOI:10.1109/TIP.2013.2261309 |

| [8] |

Guo X J, Li Y B, Ling H. LIME: Low-light image enhancement via illumination map estimation[J]. IEEE Transactions on Image Processing, 2016, 26(2): 982-993. |

| [9] |

Ren X, Li M, Cheng W H, et al. Joint enhancement and denoising method via sequential decomposition[C]//IEEE International Symposium on Circuits and Systems. Piscataway, USA: IEEE, 2018: 1-5.

|

| [10] |

Lore K G, Akintayo A, Sarkar S. LLNet: A deep autoencoder approach to natural low-light image enhancement[J]. Pattern Recognition, 2017, 61: 650-662. |

| [11] |

Wei C, Wang W J, Yang W H, et al. Deep Retinex decomposition for low-light enhancement[DB/OL]. (2018-08-14)[2018-12-05]. https://arxiv.org/abs/1808.04560.

|

| [12] |

Jiang Y F, Gong X Y, Liu D, et al. EnlightenGAN: Deep light enhancement without paired supervision[J]. IEEE Transactions on Image Processing, 2021, 30: 2340-2349. |

| [13] |

Li C Y, Guo C L, Loy C C. Learning to enhance low-light image via zero-reference deep curve estimation[DB/OL]. (2021-03-01)[2021-05-01]. https://arxiv.org/abs/2103.00860.

|

| [14] |

Wang Q T, Chen W H, Wu X M, et al. Detail-enhanced multi-scale exposure fusion in YUV color space[J]. IEEE Transactions on Circuits and Systems for Video Technology, 2019, 30(8): 2418-2429. |

| [15] |

Fu X Y, Zeng D L, Huang Y, et al. A fusion-based enhancing method for weakly illuminated images[J]. Signal Processing, 2016, 129(12): 82-96. |

| [16] |

Cai J R, Gu S H, Zhang L. Learning a deep single image contrast enhancer from multi-exposure images[J]. IEEE Transactions on Image Processing, 2018, 27(4): 2049-2062. |

| [17] |

Qu L D, Tian J D, Han Z, et al. Pixel-wise orthogonal decomposition for color illumination invariant and shadow-free image[J]. Optics Express, 2015, 23(3): 2220-2239. |

| [18] |

Tian J, Tang Y. Linearity of each channel pixel values from a surface in and out of shadows and its applications[C]//Conference on Computer Vision and Pattern Recognition. Piscataway, USA: IEEE, 2011: 985-992.

|

| [19] |

Zhang L, Zhang L, Mou X Q, et al. FSIM: A feature similarity index for image quality assessment[J]. IEEE Transactions on Image Processing, 2011, 20(8): 2378-2386. |

| [20] |

Bychkovsky V, Paris S, Chan E, et al. Learning photographic global tonal adjustment with a database of input/output image pairs[C]//Conference on Computer Vision and Pattern Recognition. Piscataway, USA: IEEE, 2011: 97-104.

|

2023, Vol. 45

2023, Vol. 45