深空探测是人类探索宇宙起源、研究生命进化、寻找新生活家园的重要手段,也是21世纪人类进行空间资源开发利用、空间科学技术创新的重要途径。目前,开展深空探测研究的国家越来越多,主要的研究目标集中于月球、火星和小行星。星表探测器可完成星表巡视、科学规划与感知、仪器部署与采样操作等任务[1-4],因而在此类研究中发挥着举足轻重的作用。星表探测器长期工作于未知、复杂、动态的地外环境,如何自主感知地形信息并理解环境信息,直接影响探测器的安全和探测效率。真实的地外环境,具有非结构化场景差异不明显、危险场景区域难界定、目标先验知识欠缺、目标尺度大小不一、光照变化复杂等一系列特性,给地外环境感知任务带来极大挑战。

随着深度学习的发展,机器视觉中的图像语义分割技术逐渐被用于环境信息理解。目前,传统的语义分割算法研究大多基于RGB数据,在缺乏足够信息的复杂场景、颜色和纹理等特征相似度高的任务中表现较差。近年来,随着深度传感器的迅速发展,出现了许多便携式RGB-D数据采集设备以及相对应的RGB-D数据集,也衍生了多模态信息融合的语义分割方法。相较于单模态RGB图像的语义分割,深度数据提供了更可靠的几何信息作为RGB数据的补充,有效地解决了单目视觉特征的歧义问题。

地外环境信息理解任务中,尤其是地形分割任务中,RGB-D多模态信息的运用能够有效地提升语义分割进度,改善地形边界不精准的问题,提高无人系统对地外环境的感知能力。同时,受限于地外环境恶劣、计算资源有限等条件,低开销或者无开销的性能优化方法也将具有更高的工程价值。因此,提出了一种基于邻域度量关系的RGB-D融合语义分割方法,在不增加模型推理开销的条件下,实现更好的性能表现。具体步骤如下:1) 以传统的图像处理以及深度学习理论,设计RGB-D多模态融合语义分割框架;2) 不增加推理开销,以辅助损失的形式构建邻域度量关系,优化语义分割任务的表现。3) 围绕公开数据集NYUDv2以及自建的火星模拟场地数据集MARSv1,对算法进行验证。与其他RGB-D语义分割方法相比,本文算法在不增加推理开销的情况下,可得到精度更高的语义分割结果以及更好的语义边缘表现。

2 相关文献(Related work) 2.1 RGB-D融合RGB-D语义融合方法大体上可以分为前期融合、中期融合、后期融合3种方式。

前期融合通常是将深度图与RGB图在输入网络模型之前进行数据级的融合。LeCun等[5]首次提出基于多尺度卷积网络学习层次化特征,将深度图像视为附加通道。Gupta等[6]引入一种新的编码方式来捕获图像的几何姿态特征,并且这种新的编码方式比单纯使用深度通道有了明显的改进。该工作将RGB与深度图像信息联合编码为HHA(水平视差、垂直视差、重力方向角)3种特征,而后将这3种特征堆叠成为三通道数据进行训练。

后期融合可以认为是决策层面的融合,通常表现为深度图与RGB图对应模型输出结果的融合。Long等[7]在完全卷积网络(FCN)式体系结构上引入了模态相似性的思想,通过融合图像和深度2种模态的特征进行预测。Cheng等[8]提出了门控融合方法,基于网络输入来学习每种模态组合的有效权重。上述2种融合方法在早期研究工作中较为常见,而RGB和深度信息存在维度差异性,仅使用预测结果并不能充分利用2种模态的有效信息。

中期融合方法,使用模态之间的多级共同特征来关联这2个模态,较充分地利用RGB和深度数据的互补信息。Eigen和Fergus等[9]在全局到局部框架中利用了深度信息和RGB信息。Li等[10]将一种新的长短期记忆(LSTM)网络应用于深度上下文的计算,并从RGB的多个颜色通道和深度数据通道中捕获和融合有效信息。文[11]提出了一种新颖的网络FuseNet,将16层VGG(visual geometry group)用于RGB和深度编码器分支,并将上述分支的特征融合在一起,以产生一个主编码器流。文[12]扩展了用于RGB-D语义分割的RefineNet。中期多级融合网络的主要思路是从RGB和深度图像中提取特征,并随着网络的深入将深度特征融合到RGB特征图中。

除上述针对2D信息的融合方案外,学者们还提出一些通过深度信息恢复点云并作为输入的融合方案。Qi等[13]以深度图的点云信息构建3D图神经网络,预测每个像素的语义标签。该方法在挖掘空间信息特征时取得了一定的效果,但同步增加的信息量也带来了网络参数以及计算复杂度的增加。

2.2 度量学习度量学习(metric learning)以分类问题中的最近邻思想[14]为基础,研究如何在特定任务中学习一个距离函数,使得目标算法取得较好性能。传统的度量学习算法包括主成分分析(PCA)[15]、局部线性嵌入(LLE)[16]等算法。上述方法存在如下问题:1) 度量关系的构建受限于原始输入空间的特征表达形式;2) 针对未知样本,其特征映射效果不佳。

近年来,随着深度学习的发展,深度度量学习方法逐渐涌现,也在一定程度上解决了传统方法中存在的问题。深度度量学习的目标是学习一个从原始特征到低维稠密向量空间的映射,以达到在嵌入空间上同类样本距离近而异类样本距离远的效果。该方法在人脸识别、人脸验证、图像检索、行人重识别等计算机视觉任务(类别多、同类样本少)中已经取得了很好的应用。

文[17]基于深度学习框架构建对比损失(contrastive loss)方法,利用二元样本对来判断样本与标签是否一致。该方法将正负样本对的距离损失分开计算,其性能表现受约束距离边界的影响,需针对数据集进行试验调整。在此基础上,Schroff发表的FaceNet[18]中提出了三元损失(triplet loss)方法,从输入样本中构建包含正负样本、锚点的三元组,并使用相对距离来约束网络的更新。三元损失方法依赖于困难样本挖掘,要求寻找数据集中的最远同类及最近异类样本,带来了大量的预处理开销。Song等[19]不再只选用部分正负样例构建度量关系,提出了能够计算所有正负样本对之间距离的结构损失方法,但带来了大量的计算开销。Sun等[20]提出了圈损失(circle loss)方法,实现了对欠优化样本的重新加权。该工作认为,如果一组样本的相似性得分远离最优的类别中心,那么其应该被添加一个惩罚项以得到更多的关注。圈损失方法将分类损失与度量损失统一计算,引入了更多的边界约束与超参数进行训练,带来了网络的拟合困难,不适用于当前的语义分割任务。

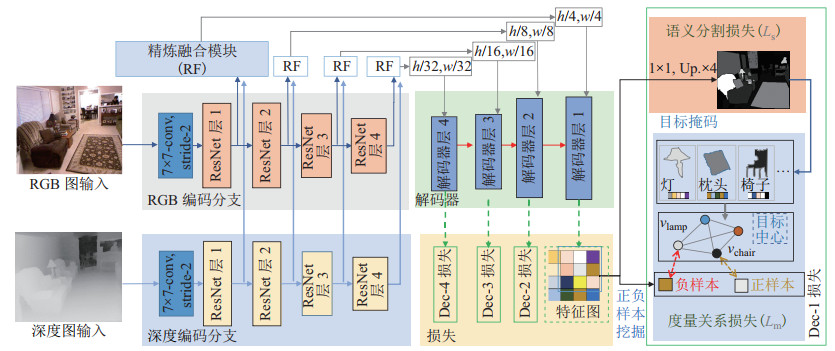

3 邻域度量关系语义分割方法(Semantic segmentation method of neighborhood metric relations)基于邻域度量关系的RGB-D语义分割模型NMRNet(neighborhood metric relations net),采用了编-解码器[21]的通用结构,实现跨层级特征的累加互补,并以中期融合的方式完成RGB与深度信息的融合。模型架构如图 1所示,分割网络的主体包括了多分支编码器、解码器以及精炼融合模块3个部分,而网络损失部分则包括语义分割损失与邻域度量损失。

|

图 1 NMRNet的网络结构图 Fig.1 Diagram of NMRNet network structure |

具体地,给定RGB-D输入信息

| $ \begin{align} \min \limits_{\mathit{\boldsymbol{\theta}}} \sum _{0<i\leqslant n} \left(L_{\rm S} (\mathit{\boldsymbol{M}}(\mathit{\boldsymbol{r}}_{i} , \mathit{\boldsymbol{d}}_{i};\mathit{\boldsymbol{\theta}}), \mathit{\boldsymbol{s}}_{i})+L_{\rm MR} (\mathit{\boldsymbol{o}}_{i}, \mathit{\boldsymbol{s}}_{i})\right) \end{align} $ | (1) |

式中:

| $ \begin{align} \mathit{\boldsymbol{o}}_{i} =\mathit{\boldsymbol{M}}_{\rm D} (\mathit{\boldsymbol{r}}_{i}, \mathit{\boldsymbol{d}}_{i};\mathit{\boldsymbol{\theta}}_{\rm D}) \end{align} $ | (2) |

式中:

编码器(RE/DE)。编码器部分包含了2组并行的ResNet网络[22]以接收RGB与深度信息的同步输入,其分别由4组结构相似的子模块堆叠而成。将编码器中的RGB与深度分支分别表示为

| $ \begin{align} \mathit{\boldsymbol{e}}_{{\rm R}, k} = \begin{cases} \mathit{\boldsymbol{M}}_{{\rm RE}, k} (\mathit{\boldsymbol{e}}_{{\rm R}, k-1};\mathit{\boldsymbol{\theta}}_{{\rm RE}, k}), & 0< k<4 \\ \mathit{\boldsymbol{M}}_{{\rm RE}, k} (\mathit{\boldsymbol{r}}_{i};\mathit{\boldsymbol{\theta}}_{{\rm RE}, k}), & k=0 \end{cases} \end{align} $ | (3) |

式中:

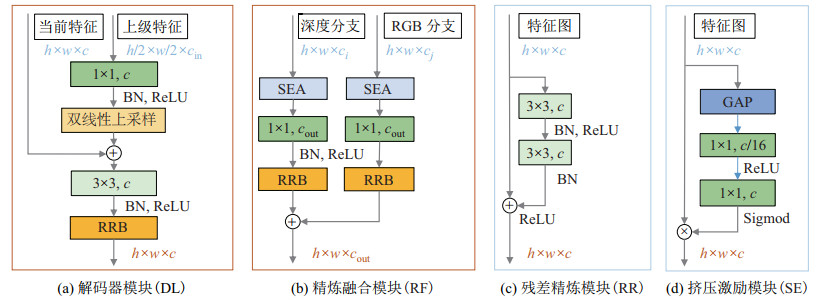

精炼融合模块(RF)。RF模块是联接编码器与解码器的组件,其显式地将融合后的空间语义信息作用于网络的更新,促进跨模态RGB-D特征的有效融合。如图 2(b)所示,RF模块中包含了与编码器分支相对应的两路并行子网,并进使用挤压激励模块[23](SE)分别提取特征信息。如图 2(d)所示,SE模块通过全局池化、特征通道变化的方式,为当前特征图的不同通道重新赋予权重,引导网络更加关注与任务目标相关的特征信息。具体地,与编码器相对应的、序号为

| $ \begin{align} \mathit{\boldsymbol{u}}_{k} =\mathit{\boldsymbol{M}}_{{\rm RF}, k} (\mathit{\boldsymbol{e}}_{{\rm R}, k}, \mathit{\boldsymbol{e}}_{{\rm D}, k};\mathit{\boldsymbol{\theta}}_{{\rm RF}, k}) \end{align} $ | (4) |

|

图 2 NMRNet网络的子模块结构 Fig.2 Sub-module structure of NMRNet network |

式中:

解码器(D)。解码器部分也采用了逐层堆叠的方式,接受RF模块不同层级的融合信息,实现跨层级特征的互补。其具体构造如图 2(a)所示,上层模块的特征经点卷积(1 × 1 conv)[24]、上采样后,与当前的融合信息一起输入残差精炼(RR)模块。RR模块采用与残差卷积单元(ResNet模型的基础组成单元)相似的方法,以跳跃连接[22]的方式累加上层的特征输出,有效地抑制了深度网络中梯度消失的问题,在多篇工作[25-27]中被证明有效。具体地,解码器中序号为

| $ \begin{align} \mathit{\boldsymbol{o}}_{k} = \begin{cases} \mathit{\boldsymbol{M}}_{{\rm D}, k} (\mathit{\boldsymbol{o}}_{k+1}, \mathit{\boldsymbol{u}}_{k};\mathit{\boldsymbol{\theta}}_{{\rm D}, k}), & 0\leqslant k<3 \\ \mathit{\boldsymbol{M}}_{{\rm D}, k} (\mathit{\boldsymbol{u}}_{k};\mathit{\boldsymbol{\theta}}_{{\rm D}, k}), & k=3 \end{cases} \end{align} $ | (5) |

式中:

NMRNet模型除了常用的语义分割损失(

本文设计的邻域度量关系模块(NMR),将解决下列几个问题:1) 语义标签与分类标签的差别很大,无法直接对样本进行预先构建;2) 语义分割任务需求复杂度高的网络结构,新模块应避免带来额外的推理开销;3) 高效利用RGB-D网络中的局部与全局信息,将度量学习的思想迁移至当前的语义分割任务。

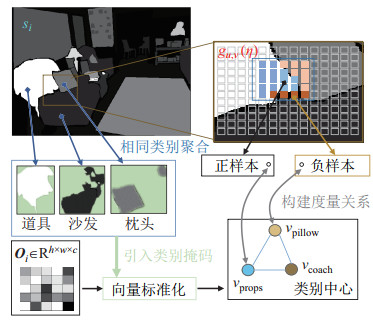

具体地,给定当前输入

| $ \begin{align} I(i, u, v)= \begin{cases} 1, & \exists p_{\tilde{u}, \tilde{v}} \in g_{u, v} (\eta) \\ 0, & \text{其他} \end{cases} \end{align} $ | (6) |

式中:

不同于FaceNet方法中使用的随机采样方式,NMR方法关注目标点在其邻域空间内的表现。具体的,定义正样本

| $ \begin{align} C_{j} =\mathop{\arg \max} \limits_{j} F_{\text{count}} (\mathit{\boldsymbol{s}}_{i, \tilde{u}, \tilde{v}}, j) \end{align} $ | (7) |

式中,

邻域区间内正、负样本间的度量关系,描述的是中心点与周边点的关联关系,促使网络显式地关注局部信息。同步地,将全图中同类别点的向量均值

| $ \begin{align} \mathit{\boldsymbol{l}}_{i, j} =\mathit{\boldsymbol{F}}_{\text{norm}} (\mathit{\boldsymbol{o}}_{i} \times F_{\text{mask}} (\mathit{\boldsymbol{s}}_{i}, j) ) \end{align} $ | (8) |

式中,

| $ \begin{align} m_{{\rm P}, i, u, v} & =\|\mathit{\boldsymbol{o}}_{i, u, v} -\mathit{\boldsymbol{l}}_{i, \tau_{{\rm P}, i, u, v}} \|_{2}^{2} \end{align} $ | (9) |

| $ \begin{align} m_{{\rm N}, i, u, v} & =\|\mathit{\boldsymbol{o}}_{i, u, v} -\mathit{\boldsymbol{l}}_{i, \tau_{{\rm N}, i, u, v}} \|_{2}^{2} \end{align} $ | (10) |

图 3展示了NMR方法对不同语义类别中心的构建以及正、负样本的筛选过程。本文在三元度量关系的基础上,同步加入对比损失约束,强化同类聚合作用。最终的度量损失表示为

| $ \begin{align} L_{\rm MR} =\alpha \cdot \max (m_{\rm P} -m_{\rm N} +\mu, \; 0)+\beta \cdot m_{\rm P} \end{align} $ | (11) |

|

图 3 邻域度量关系的构建流程 Fig.3 Construction process of neighborhood metric relationship |

式中,

分别选取纽约大学公开的RGB-D数据集NYUDv2[30]、本文项目组自建的火星模拟数据集MARSv1,对RGB-D语义分割方法的表现进行评估,以说明多模态RGB-D数据与设计的融合网络的有效性,以及引入邻域度量关系的作用。

4.1 训练细节以开源的PyTorch框架构建RGB-D融合语义分割网络,并在2组Tesla-V100上实现模型部署。网络的编码器部分使用了ResNet模型的预训练参数,其他模块则使用默认的随机初始化方法。采用随机梯度下降法(SGD)优化整个网络,动量与正则项参数分别设置为0.9、10-5。除了解码器部分的初始学习率被设置为10-2外,其他部分都为10-3,并采用余弦退火方法[31]将学习率逐步衰减至10-4。训练过程中,RGB与深度图片都被统一调整为480 × 480 像素大小,并采用了如随机裁剪、亮度偏移、水平翻转、高斯模糊等在线增强方法来提高模型的泛化能力。

网络更新过程中,语义分割损失

NYUDv2为主流的RGB-D公开数据集之一,包括了1449组成对的RGB与深度图片数据。该数据集中的数据由微软Kinect设备采集,在经由Levin着色算法[33]处理后,得到了相匹配的稠密深度图片。同时,参照原始的人工语义分割标注标签,文[34]提供了共计40类重新组合的标签。依据数据集给定的训练集与测试集划分文件,得到了795张训练图片与654张测试图片。实验将采用语义分割常用的指标来评判本文网络的性能,包括像素准确率(PA)、平均准确率(MPA)以及平均交并比(MIoU)。

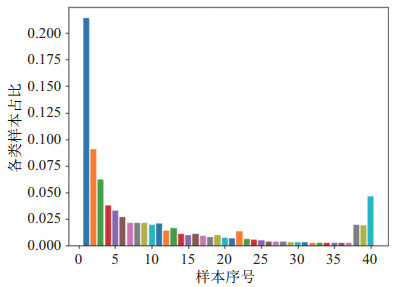

分析NYUDv2数据的样本分布情况,如图 4所示。其中,占比最重的类别样本可达24.1%,而最少的“37号”样本仅占0.23%,长尾现象明显。相较于交叉熵损失,本文选用的FL方法能更好地适应类别不均衡的任务场景。

|

图 4 NYUDv2数据集样本分布 Fig.4 Sample distribution of NYUDv2 dataset |

实验结果如表 1所示,与仅使用RGB单模信息的网络模型(符号“*”)相比,本文的语义分割模型在不使用深度信息的情况下,性能表现仍保有竞争力。而与现有的一些RGB-D融合语义工作相比,NMRNet模型的指标也有明显提升。

|

|

表 1 不同模型在NYUDv2数据集上的性能对比 Tab. 1 Comparison of different models on NYUDv2 dataset |

从表 1不难发现,相较于使用交叉熵的RGB/RGBD-base网络,FL方法给MPA指标带来了明显提升;RF模块中“SE,注意力模块”的使用,则进一步提高了多模态信息的融合能力,其在RGBD网络中MIoU指标的表现(

对比使用“中期融合”方法的SOTA工作(HS3-Fuse[39]),该方法在中期融合的过程中堆叠了多组OCRNet模块[30],取得MIoU

|

图 5 NMRNet与其他公开工作在NYUDv2数据集上的对比 Fig.5 Comparison among NMRNet and other public works on NYUDv2 dataset |

进一步地,为说明本文的NMR模块的有效性,构造不同参数量级的NMRNet模型进行对比实验,性能指标提升明显。如表 2所示,选取了ResNet18/34/50/101共4组不同参数量的编码器(网络中其他模块计算量相应增加),NMR模块的辅助更新(w/NMRNet)带来了显著的性能提升,

|

|

表 2 不同参数量级网络中NMR模块的表现 Tab. 2 Performance of NMR module in the network of different parameter magnitudes |

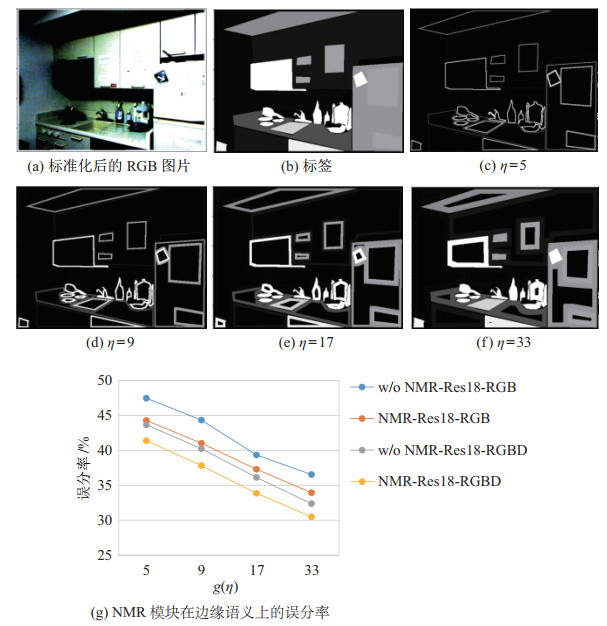

为了更好说明NMR模块对边缘语义的作用,选取了测试样本中的边缘像素进行对比实验。如图 6(c)~(f)所示,定义不同扩张系数下的邻域区间

|

图 6 NMR模块对边缘语义推理的提升作用 Fig.6 Improvement of edge semantic prediction by NMR module |

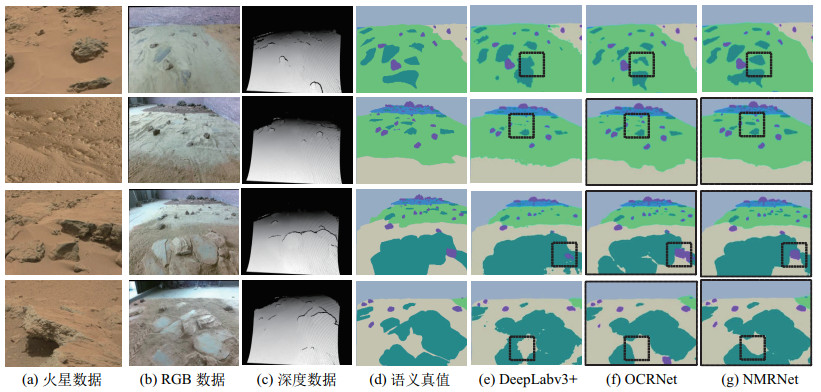

本文的工作目标是实现对地外环境语义的高精度理解,为探险车的路径规划、障碍识别等后续任务提供可靠的信息支撑,需要在真实的火星数据集上对本算法进行测试。

MARSv1数据集为本团队自行采集并标注的RGB-D数据集。具体如图 7所示,图 7(a)为NASA公开的真实火星地形图片,图 7(b)则是自建的火星模拟试验场,部分还原了土壤、基岩、岩石、碎石地、沙地等典型的火星地貌数据。MARSv1数据集基于该模拟场地,以Kinect-v2设备采集完成。

|

图 7 与其他公开工作在MARSv1数据集上的对比 Fig.7 Comparison with other public works on MARSv1 dataset |

MARSv1数据集共包含3种典型的火星场景(沙地、砂土地、碎石地)以及4组不同的地形布置与光照条件。选取其中3组共1090张图片用于训练,利用剩下的一组共223张图片进行测试。具体结果如表 3所示,RGB-D融合数据的表现远远优于单RGB信息的输入,NMR模块同样能够带来显著的指标提升。

|

|

表 3 MARSv1数据集上的对比结果 Tab. 3 Comparison results on MARSv1 dataset |

综上所述,相较于近年来性能表现优异的语义分割模型,本文的NMRNet模型能够提供更为清晰的物体轮廓边缘,并降低了不同层次目标区域之间的串扰问题。如图 7(g)所示,黑框部分标出了在MARSv1数据集上更好的语义边缘推理结果。

5 结论(Conclusion)提出了一种基于邻域度量关系的RGB-D融合语义分割算法。其利用多模态的RGB-D信息突破传统单目RGB数据的限制,构建以中期融合为基础的语义分割网络NMRNet,实现了跨模态以及跨层级信息的有效融合。进一步的,考虑到地外环境下移动平台的算力及存储量的限制,以分支损失的形式构建邻域度量关系,挖掘语义特征在全局以及局部的关联关系,在不增加推理功耗的条件下提升了语义分割性能,具备实际的工程价值。在NYUDv2室内数据集、自建的火星模拟场地数据集MARSv1上的实验表明,该方法相比于其他方法在复杂的场景下指标提升明显且有更好的语义边缘表现。本文算法可应用于深空探测机器人领域,以提高机器人在非结构化环境中的自主导航能力和感知鲁棒性。

| [1] |

Gao Y, Chien S. Review on space robotics: Toward top-level science through space exploration[J]. Science Robotics, 2017, 2(7). DOI:10.1126/scirobotics.aan5074 |

| [2] |

Rybus T. Obstacle avoidance in space robotics: Review of major challenges and proposed solutions[J]. Progress in Aerospace Sciences, 2018, 101: 31-48. DOI:10.1016/j.paerosci.2018.07.001 |

| [3] |

da Fonseca I M, Pontuschka M N. The state-of-the-art in space robotics[J]. Journal of Physics: Conference Series, 2015, 641(1). DOI:10.1088/1742-6596/641/1/012025 |

| [4] |

Nishida S I, Wakabayashi S. Lunar surface exploration using mobile robots[J]. Open Engineering, 2012, 2(2): 156-163. |

| [5] |

Couprie C, Farabet C, Najman L, et al. Indoor semantic segmentation using depth information[DB/OL]. (2013-03-14)[2021-12-01]. https://arxiv.org/abs/1301.3572.

|

| [6] |

Gupta S, Girshick R, Arbeláez P, et al. Learning rich features from RGB-D images for object detection and segmentation[C]//European Conference on Computer Vision. Cham, Switzerland: Springer, 2014: 345-360.

|

| [7] |

Long J, Shelhamer E, Darrell T. Fully convolutional networks for semantic segmentation[C]//IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, USA: IEEE, 2015: 3431-3440.

|

| [8] |

Cheng Y H, Cai R, Li Z W, et al. Locality-sensitive deconvolution networks with gated fusion for RGB-D indoor semantic segmentation[C]//IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, USA: IEEE, 2017: 3029-3037.

|

| [9] |

Eigen D, Fergus R. Predicting depth, surface normals and semantic labels with a common multi-scale convolutional architecture[C]//IEEE International Conference on Computer Vision. Piscataway, USA: IEEE, 2015: 2650-2658.

|

| [10] |

Li Z, Gan Y K, Liang X D, et al. LSTM-CF: Unifying context modeling and fusion with LSTMs for RGB-D scene labeling[C]//European Conference on Computer Vision. Cham, Switzerland: Springer, 2016: 541-557.

|

| [11] |

Hazirbas C, Ma L, Domokos C, et al. FuseNet: Incorporating depth into semantic segmentation via fusion-based CNN architecture[C]//Asian Conference on Computer Vision. Cham, Switzerland: Springer, 2016: 213-228

|

| [12] |

Lee S, Park S J, Hong K S. RDFNet: RGB-D multi-level residual feature fusion for indoor semantic segmentation[C]//IEEE International Conference on Computer Vision. Piscataway, USA: IEEE, 2017: 4980-4989.

|

| [13] |

Qi X J, Liao R J, Jia J Y, et al. 3D graph neural networks for RGBD semantic segmentation[C]//IEEE International Conference on Computer Vision. Piscataway, USA: IEEE, 2017: 5199-5208.

|

| [14] |

Cover T, Hart P. Nearest neighbor pattern classification[J]. IEEE Transactions on Information Theory, 1967, 13(1): 21-27. DOI:10.1109/TIT.1967.1053964 |

| [15] |

Abdi H, Williams L J. Principal component analysis[J]. WIREs Computational Statistics, 2010, 2(4): 433-459. DOI:10.1002/wics.101 |

| [16] |

Roweis S T, Saul L K. Nonlinear dimensionality reduction by locally linear embedding[J]. Science, 2000, 290(5500): 2323-2326. DOI:10.1126/science.290.5500.2323 |

| [17] |

Chopra S, Hadsell R, LeCun Y. Learning a similarity metric discriminatively, with application to face verification[C]//IEEE Computer Society Conference on Computer Vision and Pattern Recognition. Piscataway, USA: IEEE, 2005: 539-546.

|

| [18] |

Schroff F, Kalenichenko D, Philbin J. FaceNet: A unified embedding for face recognition and clustering[C]//IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, USA: IEEE, 2015: 815-823.

|

| [19] |

Song H O, Xiang Y, Jegelka S, et al. Deep metric learning via lifted structured feature embedding[C]//IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, USA: IEEE, 2016: 4004-4012.

|

| [20] |

Sun Y F, Cheng C M, Zhang Y H, et al. Circle loss: A unified perspective of pair similarity optimization[C]//IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway, USA: IEEE, 2020: 6398-6407.

|

| [21] |

Ronneberger O, Fischer P, Brox T. U-Net: Convolutional networks for biomedical image segmentation[C]//International Conference on Medical Image Computing and Computer-Assisted Intervention. Cham, Switzerland: Springer, 2015: 234-241.

|

| [22] |

He K M, Zhang X Y, Ren S Q, et al. Deep residual learning for image recognition[C]//IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, USA: IEEE, 2016: 770-778.

|

| [23] |

Hu J, Shen L, Sun G. Squeeze-and-excitation networks[C]//IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, USA: IEEE, 2018: 7132-7141.

|

| [24] |

Chollet F. Xception: Deep learning with depthwise separable convolutions[C]//IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, USA: IEEE, 2017: 1251-1258.

|

| [25] |

Lin G S, Milan A, Shen C H, et al. RefineNet: Multi-path refinement networks for high-resolution semantic segmentation[C]//IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, USA: IEEE, 2017: 1925-1934.

|

| [26] |

Hu X X, Yang K L, Fei L, et al. ACNET: Attention based network to exploit complementary features for RGBD semantic segmentation[C]//IEEE International Conference on Image Processing. Piscataway, USA: IEEE, 2019: 1440-1444.

|

| [27] |

Seichter D, Köhler M, Lewandowski B, et al. Efficient RGB-D semantic segmentation for indoor scene analysis[C]//IEEE International Conference on Robotics and Automation. Piscataway, USA: IEEE, 2021: 13525-13531.

|

| [28] |

Wen Y D, Zhang K P, Li Z F, et al. A discriminative feature learning approach for deep face recognition[C]//European Conference on Computer Vision. Cham, Switzerland: Springer, 2016: 499-515.

|

| [29] |

Cao J M, Leng H C, Lischinski D, et al. ShapeConv: Shape-aware convolutional layer for indoor RGB-D semantic segmentation[C]//IEEE/CVF International Conference on Computer Vision. Piscataway, USA: IEEE, 2021: 7088-7097.

|

| [30] |

Silberman N, Hoiem D, Kohli P, et al. Indoor segmentation and support inference from RGBD images[C]//European Conference on Computer Vision. Berlin, Germany: Springer, 2012: 746-760.

|

| [31] |

Loshchilov I, Hutter F. SGDR: Stochastic gradient descent with warm restarts[DB/OL]. (2017-05-03)[2021-12-01]. https://arxiv.org/abs/1608.03983.

|

| [32] |

Lin T Y, Goyal P, Girshick R, et al. Focal loss for dense object detection[C]//IEEE International Conference on Computer Vision. Piscataway, USA: IEEE, 2017: 2980-2988.

|

| [33] |

Levin A, Lischinski D, Weiss Y. Colorization using optimization[J]. ACM Transactions on Graphics, 2004, 23(3): 689-694. DOI:10.1145/1015706.1015780 |

| [34] |

Gupta S, Arbelaez P, Malik J. Perceptual organization and recognition of indoor scenes from RGB-D images[C]//IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, USA: IEEE, 2013: 564-571.

|

| [35] |

Chen L C, Zhu Y, Papandreou G, et al. Encoder-decoder with atrous separable convolution for semantic image segmentation[C]//European Conference on Computer Vision. Cham, Switzerland: Springer, 2018: 833-851.

|

| [36] |

Yuan Y, Chen X, Wang J. Object-contextual representations for semantic segmentation[C]//European Conference on Computer Vision. Cham, Switzerland: Springer, 2020: 173-190.

|

| [37] |

Deng Z, Todorovic S, Jan Latecki L. Semantic segmentation of RGBD images with mutex constraints[C]//IEEE International Conference on Computer Vision. Piscataway, USA: IEEE, 2015: 1733-1741.

|

| [38] |

Wang W Y, Neumann U. Depth-aware CNN for RGB-D segmentation[C]//European Conference on Computer Vision. Cham, Switzerland: Springer, 2018: 144-161.

|

| [39] |

Borse S, Cai H, Zhang Y, et al. HS3: Learning with proper task complexity in hierarchically supervised semantic segmentation[DB/OL]. (2021-11-03)[2021-12-01]. https://arxiv.org/abs/2111.02333v1.

|

2023, Vol. 45

2023, Vol. 45