2. 国家超级计算郑州中心,河南 郑州 450001;

3. 智能集群系统教育部工程研究中心,河南 郑州 450001

2. National Supercomputing Center in Zhengzhou, Zhengzhou 450001, China;

3. Engineering Research Center of Intelligent Swarm Systems, Ministry of Education, Zhengzhou 450001, China

连续长航时任务中的定位精度是潜航器发挥战略战术价值的必要基础[1]。由于水下环境中高频信号易衰减以及隐蔽性方面的需求,潜航器一般不能接受水面及地上的卫星定位信号,因此陆上常用的GPS等被动定位方式难以直接应用于水下潜航器[2]。作为代表性自主式导航技术的惯性导航在定位过程中具有不依赖外界信息,不易受干扰的优势。但惯性导航系统存在定位误差随时间累积的局限性,需要依靠其他定位技术修正和抑制误差[3]。水下地形匹配定位是对水下地形地貌的分布、形态特征进行匹配,从而实现定位的技术,具有自主、隐蔽、全天候、定位精度与航程无关等优点,可作为一种辅助定位手段对惯导系统的定位结果进行修正。由于声波在水中不易衰减,是水下信息远距离传播的理想载体。因此,发展基于声学感知的水下地形匹配定位技术具有重要的研究意义和应用价值。

水下地形匹配定位技术在近年来取得了一定进展,声呐探测技术与装备的发展也为水下地形匹配技术的实现提供了基础支撑[4]。但目前的水下地形匹配定位仍面临效率低、泛化性差、抗干扰能力弱、初始定位难、不同区域的探测数据难以有效区分等问题[5],尚不具备作为导航功能单元应有的稳定性和鲁棒性。

针对水下地形匹配定位问题,本文提出一种基于多粒度声呐图像匹配的水下定位方法,将定位过程分解为特征抽取和特征匹配2个阶段。特征抽取阶段,构建了基于U-Net[6]架构的图像特征抽取模型来提取特征,通过无监督学习方式,自适应学习地形特征,节约地图标注的人工成本。同时训练模型使用多样化的地形数据,添加多种模拟海洋噪声,解决模型泛化性差、抗干扰能力弱的问题,提升地形定位的鲁棒性。为解决水下地形定位部分区域可识别特征弱、定位精度差的问题。在特征匹配阶段,设计了一种具有时空约束的多粒度匹配算法,充分挖掘地形特征,在特征空间内进行多粒度匹配,其中粗粒度匹配结合时空约束先验实现搜索空间的约简,细粒度匹配得到最终的定位结果。为了评估所提方法的性能,本文对典型水下环境进行了可视建模,对声呐探测过程进行了仿真,并基于此构建了包括水下地形高程数据与相应声呐探测数据的数据集。

1 相关工作水下地形图像匹配定位指利用水下地形信息实现水下潜航器辅助定位[7]的方法。其基本思想是将多波束测深声呐获取的水深信息以图像的形式表示出来,从而将水下地形定位策略转化为基于图像的匹配定位问题。水下声呐图像是深度信息在二维平面的投影,其相当于以俯视的视角观察海底的起伏变化。一些平均起伏不大的区域会体现出一定的纹理特征,该特征使其能够在水下地形数据库中被检测出来,从而使水下地形匹配在此类地形区域内得以实施。当前水下地形图像匹配定位方法主要包括基于传统方法的匹配定位方法和基于深度学习的匹配定位方法。

1.1 传统水下地形定位方法传统水下地形图像匹配方法可分为地形高程匹配(Terrain Elevation Matching, TEM)和场景匹配区域相关器(Scene Matching Area Correlator, SMAC)[8]。相比之下,尽管SMAC具有较高的定位精度,但由于SMAC对设备精度和地形数据的要求较高,因此在实际应用中通常采用TEM。TEM技术通过测量载体运动路径下方的实时地形高程数据,将其与已知的数字地形参考进行比较进而得到载体的位置信息[9]。

目前常用的地形匹配算法主要有基于地形轮廓相关匹配的地形轮廓匹配(Terrain Contour Matching, TERCOM)算法[10]、基于扩展卡尔曼滤波的桑迪亚惯性地形辅助导航(Sandia Inertial Terrain Aided Navigation, SITAN)算法和基于直接概率准则的递归贝叶斯估计算法。Han等[11]基于TERCOM算法的原理,提出了一种改进的重力匹配算法。匹配算法采用最短路径算法,提高更新频率,并且采用了新的相关分析方法,在获得更好的实时性和定位精度的同时,减少了计算量。Li等[12]利用改进的卡尔曼滤波对SITAN进行了优化,其设计并实现了一种基于反向传播神经网络(Back Propagation Neural Network, BPNN)的改进联合卡尔曼滤波器,提出了精度更高的智能卡尔曼滤波算法。Ingemar等[7]提出一种基于贝叶斯估计和相关比较的自主水下航行器(Autonomous Underwater Vehicle, AUV)水下地形匹配方法,通过实验结果表明,该方法具有较高的精度、鲁棒性和计算效率,更适用于连续导航。Huang等[13]提出了一种基于惯性测量单元(Inertial Measurement Unit, IMU)和声呐的水下航行器自主导航算法−惯性即时定位与地图构建(Simultaneous Localization and Mapping, SLAM)算法。该算法采用Rao-Blackwellised混合SLAM算法估计潜航器的速度、位置、姿态、惯性测量单元的偏置误差以及潜航器周围的特征图。惯性SLAM算法是惯性导航系统(Inertial Navigation System, INS)和基于粒子滤波的SLAM算法的结合。实验结果表明,该算法的时间复杂度和估计误差较小。Tan等[14]提出了一种基于Q-learning的分段水下地形匹配方法(Segmented Underwater Terrain Matching Method Based on Q-learning, S-UTMQ),其提出的S-UTMQ方法的主要思想是综合考虑定位节点前后的高程数据,基于Q-learning动态调整每个定位节点的角度范围进行实时匹配,使地形匹配过程更加准确高效。仿真结果表明,在不同分段定位长度、不同航向角和轨迹曲线的情况下,所提出的S-UTMQ比分段地形轮廓匹配方法更有效,在精度和效率上更有优势。

1.2 基于深度学习的水下地形定位方法传统的水下地形匹配定位方法在特定区域的定位精度和效率上已经能够满足潜航器水下作业的需求,但是在泛化性和抗干扰能力方面表现不佳,在面对海洋声源噪声频繁干扰和海洋生物严重遮挡的区域,很容易出现定位失败的情况。

为解决传统的水下地形匹配定位方法问题,基于深度学习的水下地形匹配技术开始得到了研究。Yang等[15]提出了一种基于卷积神经网络(Convolutional Neural Networks, CNN)的图像匹配算法,用于无外部导航辅助设备的自主水下航行器(AUV)的导航。其目标是解决传统图像特征表示和相似学习无法共同学习的问题,提高深海动态背景、低强度、高噪声场景下声呐图像的匹配精度。Santos等[16]将传统图像处理方法和神经网络技术相结合,提出了一种跨域跨视角的图像匹配,采用多步方法对彩色航空图像和水下声呐图像进行匹配,实验结果表明其方法获得了较高的匹配精度和优异的抗干扰性能。

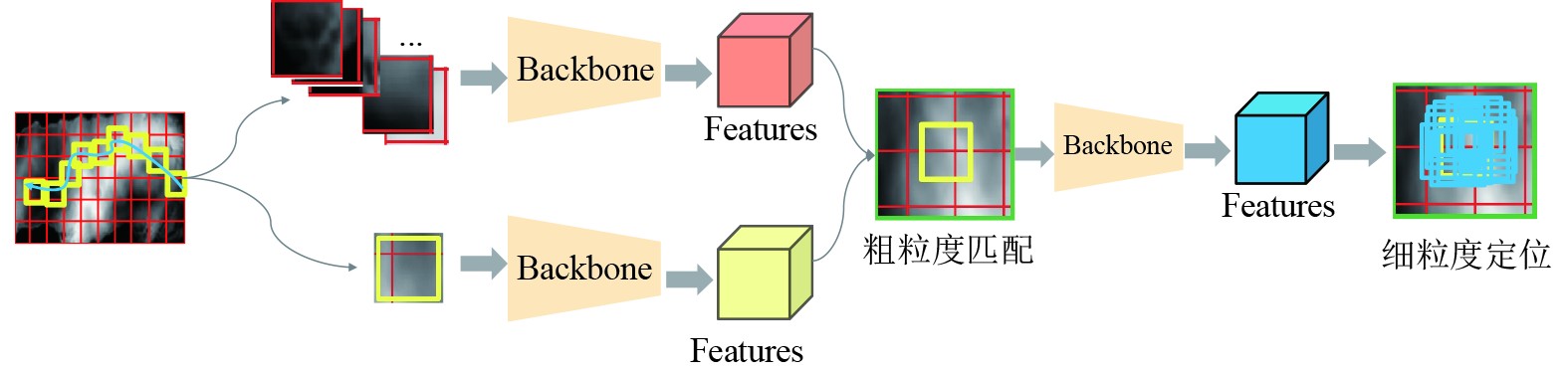

2 本文方法本文方法框架如图1所示,主要包括特征提取模块和匹配定位模块。特征提取模块基于U-Net架构构建,用于对输入声呐图像进行特征提取,并将提取出的特征作为匹配定位模块的输入。匹配定位模块采用具有时空约束的多粒度匹配算法,首先使用粗粒度匹配并结合时空约束约简问题规模,然后在约简后的搜索空间内进行细粒度匹配以实现精确定位。

|

图 1 基于多粒度声呐图像匹配的水下定位方法框架 Fig. 1 Framework of underwater localization method based on multi-granularity sonar image matching |

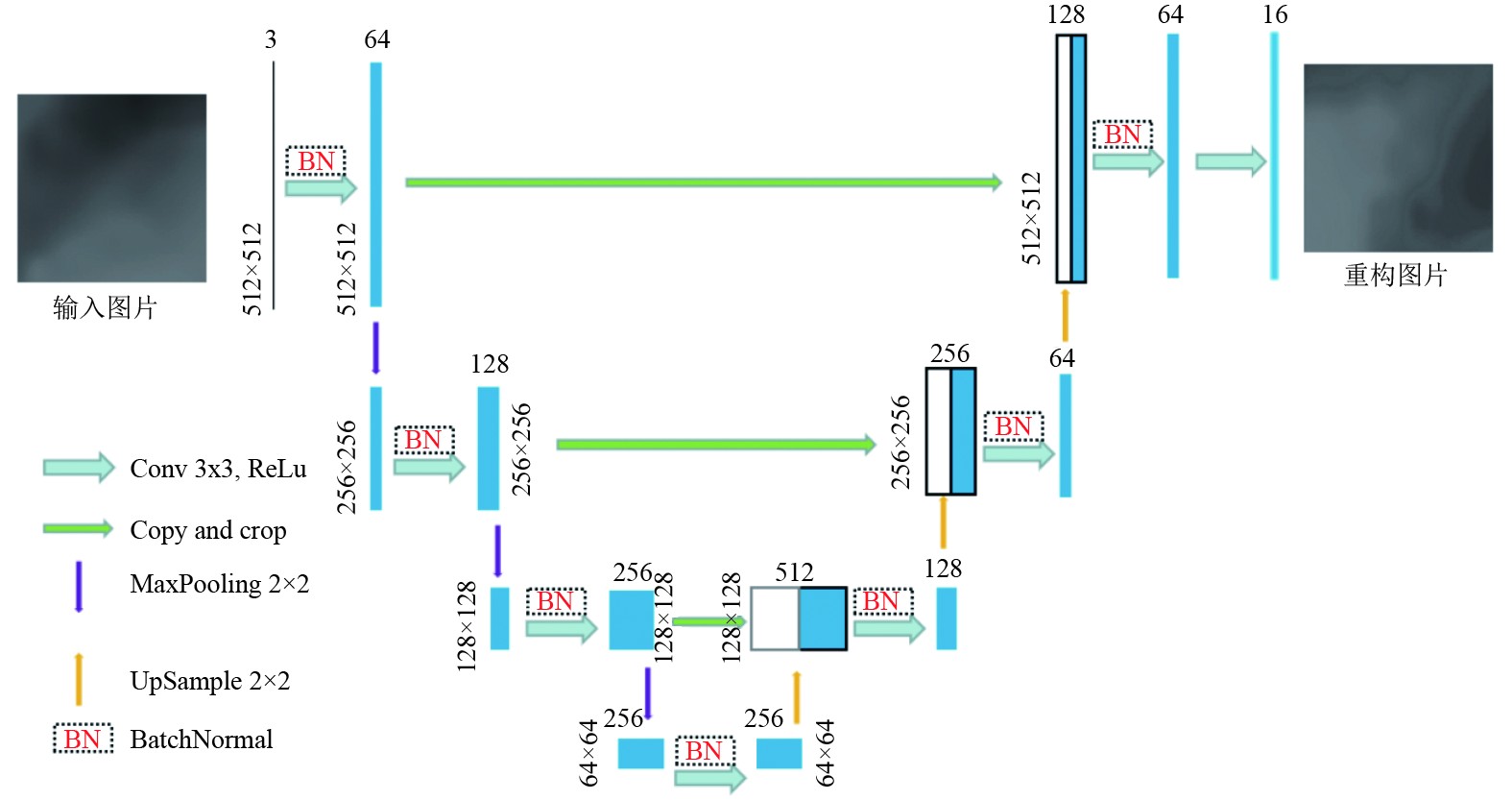

U-Net的特点是采用了一个U字形的网络结构,这种结构可以充分利用图像中的上下文信息。具体来说,模型的左半部分是一个典型的卷积神经网络,用于提取图像中的特征;右半部分是一个对称的结构,用于将提取出的特征映射回原始图像的尺寸,从而进行像素级别的图像分类或图像分割。同时,U-Net模型还采用了跳跃连接的方式,将左半部分提取出的特征图与右半部分对应的特征图进行连接,这样可以更好地保留图像中的细节信息。声呐图像无语义标签,难以设计有效的辅助任务,因此本文构建了无监督特征提取网络。自编码器网络[17–18]是有代表性的一类无监督特征学习网络,但由于其使用逐级下采样卷积提取不同层次特征的编码器和使用反卷积上采样的解码器,易造成各层之间的梯度消失与信息失衡问题[19]。为解决这些问题,本文提出一种基于U-Net网络架构的特征抽取网络如图2所示。下采样与上采样层数设置为3,卷积核与反卷积核大小设置为3

|

图 2 U-Net网络结构 Fig. 2 U-Net network architecture |

根据水下地形图像数据的规模和特性,本文构建的基于U-Net架构的特征提取网络不必进行过多的下采样操作,否则会增加过拟合的风险。具体地,所提模型对输入图像共进行3次下采样操作,并池化输出张量得到最终的特征。

2.2 时空约束多粒度匹配定位算法本文提出一种具有时空约束的多粒度匹配定位算法,将定位过程分为粗粒度匹配和细粒度匹配2个阶段。粗粒度匹配阶段采用二次匹配的方法确定与探测图像具有较高相似性的区域以约简候选匹配的问题规模。细粒度匹配重新对约简后的候选区域进行细分扩展,最后根据匹配结果实现精确定位。

2.2.1 粗粒度匹配粗粒度匹配的算法流程如下:

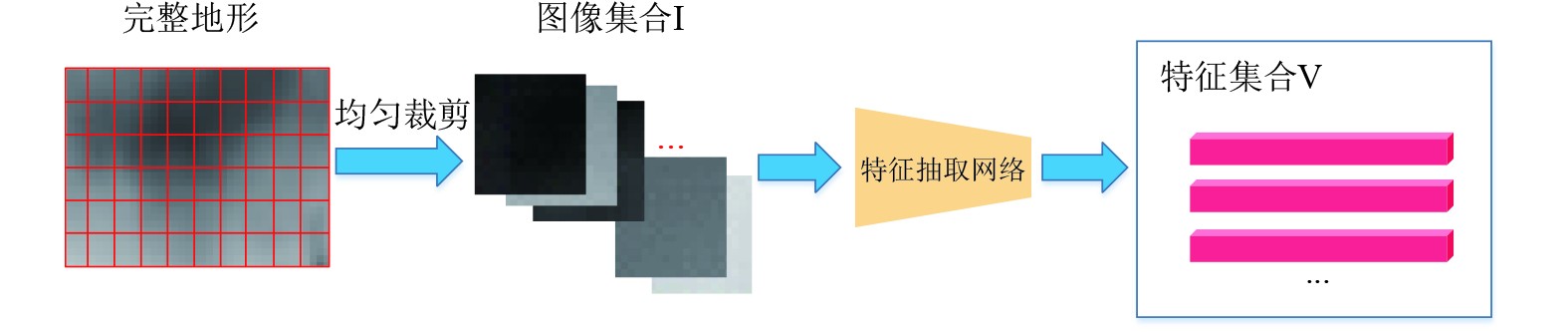

1)图3为提取全局地形特征的流程。均匀切割全局地形图,生成图像块集合I,集合图像大小为512×512。使用基于U-Net特征抽取网络提取出I集合的特征集V。输入的图像经过该过程生成256维的特征向量。

|

图 3 提取全局特征 Fig. 3 Extract global feature |

2)提取V及潜航器的实时探测图像的特征向量SVi,使用式(1)计算V中的每个特征Vj和SVi的相似程度。

| $ {S_{\cos }} = \frac{{S{V_i}Vj}}{{|S{V_i}||Vj|}} 。$ | (1) |

3)取Vj中相似度最高的前n个特征,将特征对应的图像块组成集合Im。

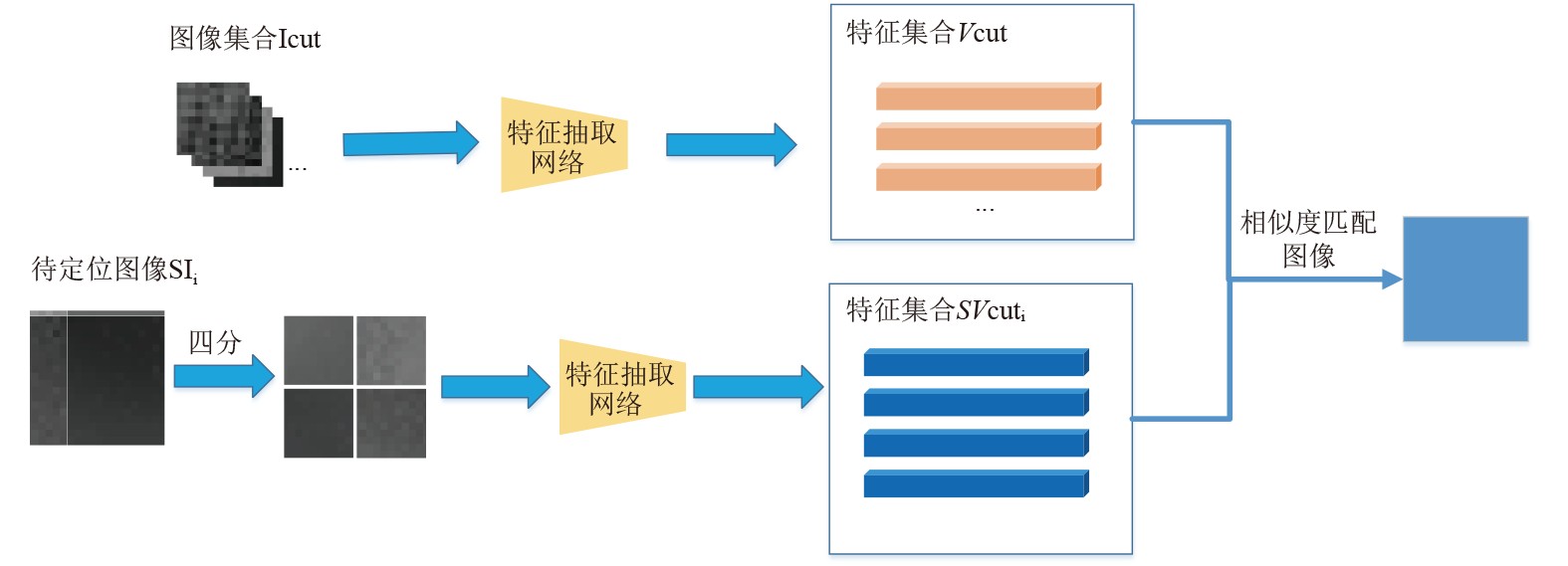

4)粗粒度二次匹配的过程如图4所示。利用潜航器移动的时空连续性,过滤Im中不满足时空约束的图像,其余图像四分切割,集合图像大小为256×256。同样方法处理实时声呐图像,并分别提取特征,得到2个特征集Vcut和SVcuti。

|

图 4 粗粒度二次匹配 Fig. 4 Coarse grain secondary matching |

5)再次计算2个集合的相似度特征,相似度计算见式(1),根据相似度得到粗粒度第二次匹配的结果。

2.2.2 细粒度匹配细粒度匹配基于粗粒度匹配的结果,在约简后的搜索空间中进行匹配,进而得到更加精确的定位结果。

细粒度匹配定位算法流程如下:

1)扩充粗粒度结果图像边缘。若实时声呐探测图像SIi和粗粒度匹配的图像块有重复区域,则扩充区域需完全包含SIi。将区域内横纵方向均每隔s距离进行采样,采样图像块个数N计算式为:

| $ N = \frac{{(a - z + s)(b - z + s)}}{{{s^2}}}。$ | (2) |

式中:a和b分别为扩充区域的长和宽;s为采样间隔;z为单张图像的边长。

2)提取候选匹配数据集的特征,与Vi进行相似度计算,取相似度最高对应的位置作为匹配定位结果。

2.2.3 时空约束水下潜航器移动的速度一般不会剧烈变化,因此在等时间间隔内的位移应该是相近的。基于此假设,将等时间间隔内位移作为约束,过滤掉出现“漂移”的结果。具体计算方法如下:

| $ C = \left\{ {{c_0},{c_1}, \cdots ,{c_n}} \right\} ,$ | (3) |

| $ {c_n} = \left( {\frac{{{x_n} + {\omega _n}}}{2},\frac{{{y_n} + {h_n}}}{2}} \right),{c_n} \in C ,$ | (4) |

| $ S = \left\{ {{s_1},{s_2}, \cdots ,{s_n}} \right\},$ | (5) |

| $ {s_n} = {\left\| {{C_{n + 1}} - {C_n}} \right\|_2},$ | (6) |

| $ {e_n} = \omega {({s_n},{s_{n - 1}},{s_{n - 2}})^T},{s_n} \in S,$ | (7) |

| $ \left\{\begin{aligned} &{s}_{n}-{\epsilon }_{n} \geqslant 0,{漂移},\\ &{s}_{n}-{\epsilon }_{n} \lt 0,{正常}。\end{aligned} \right.$ | (8) |

式中:

本文使用一种将特征集成到地形中的程序性方法,沿复合立方3D贝塞尔曲线编辑高程图,构建了一个范围大于4 km2的区域,包含12种典型水下环境,其中包括海地平原、海底山脉、海沟等多种地形地貌,同时设计不同种类和规模的鱼群,作为声呐地形采样的随机噪声。水下环境可视建模效果如图5所示。

|

图 5 水下环境可视建模 Fig. 5 Visual modeling of underwater environment |

为了提高运行效率,该方法通过使用计算着色器来调用GPU并行处理。使用该方法能够实时计算适合地形所需的位移,并将位移值存储在一个分离的纹理中,从而在编辑过程中保持原始高度图值不变[20]。

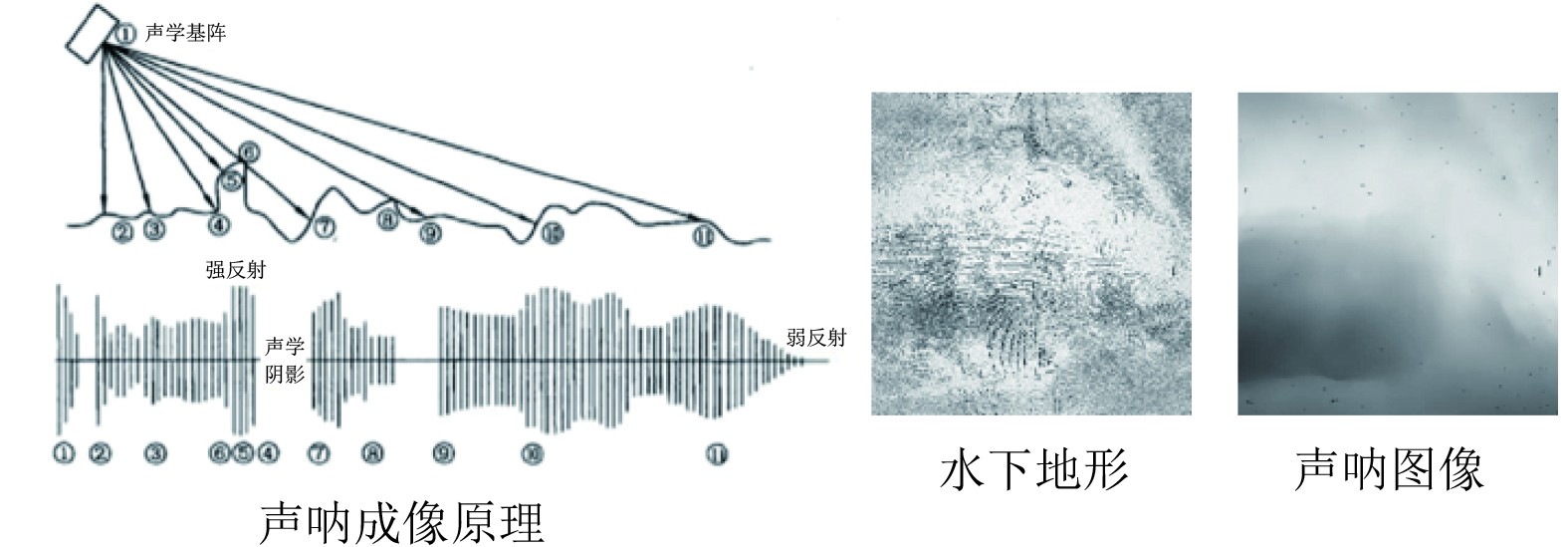

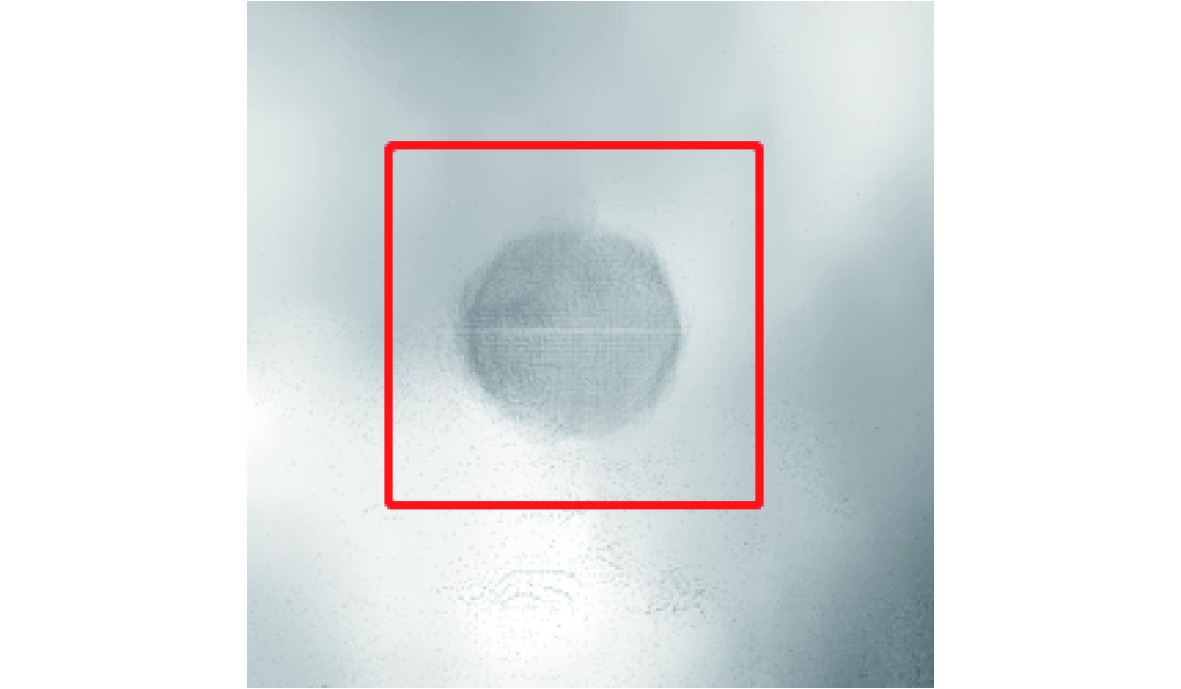

3.2 水下声呐探测仿真声呐探测仿真是模拟声呐探测物体并根据返回的声呐信号生成图像的过程,图6为多波束声呐探测水下地形的成像原理。虚拟声呐探测仪以60°的水平视场角和垂直视场角,每间隔0.1 s发送一个声能脉冲,在水中传播的过程中碰到水底、鱼群等障碍物发生反射,根据脉冲返回时间及回波参数可判断目标物体的距离及形态[2]。

|

图 6 声呐成像基本原理与成像结果 Fig. 6 Fundamental principle and results of sonar imaging |

使用Unity软件作为海洋环境和声呐设备的仿真平台来模拟水下作业过程,生成地形图像数据。Unity内置完善的物理引擎,在模拟声呐探测时,多波束声波的反射、散射和折射都能够完整的表现,并且可以通过调用GPU并行加速处理接受到的声波信息。同时,Unity的脚本挂载控制方式也便于声呐在水下进行地形探测时,引导海洋生物个体的运动,以更贴近于真实海洋环境中存在的随机干扰。

本文中的虚拟声呐的多波束声波主要采用Unity仿真引擎中的射线类和射线投射碰撞信息类实现。利用上述2类可在水下仿真环境中模拟多个方位的声波传播及反射过程,根据发射方向、起始位置、反射位置、接收时间等信息生成声呐图像。

4 实 验水下定位作为水下作业的基础任务,应满足实时性、精准性、适应性和抗干扰性等多方面的要求。所以将一次水下作业的平均定位时间限定为<1 s,平均定位误差限定为<1 m,定位算法应在平原、高地、盆地等常见水下地形下正常使用,同时也要能够应对地形和生物遮挡等常见水下干扰的情况。

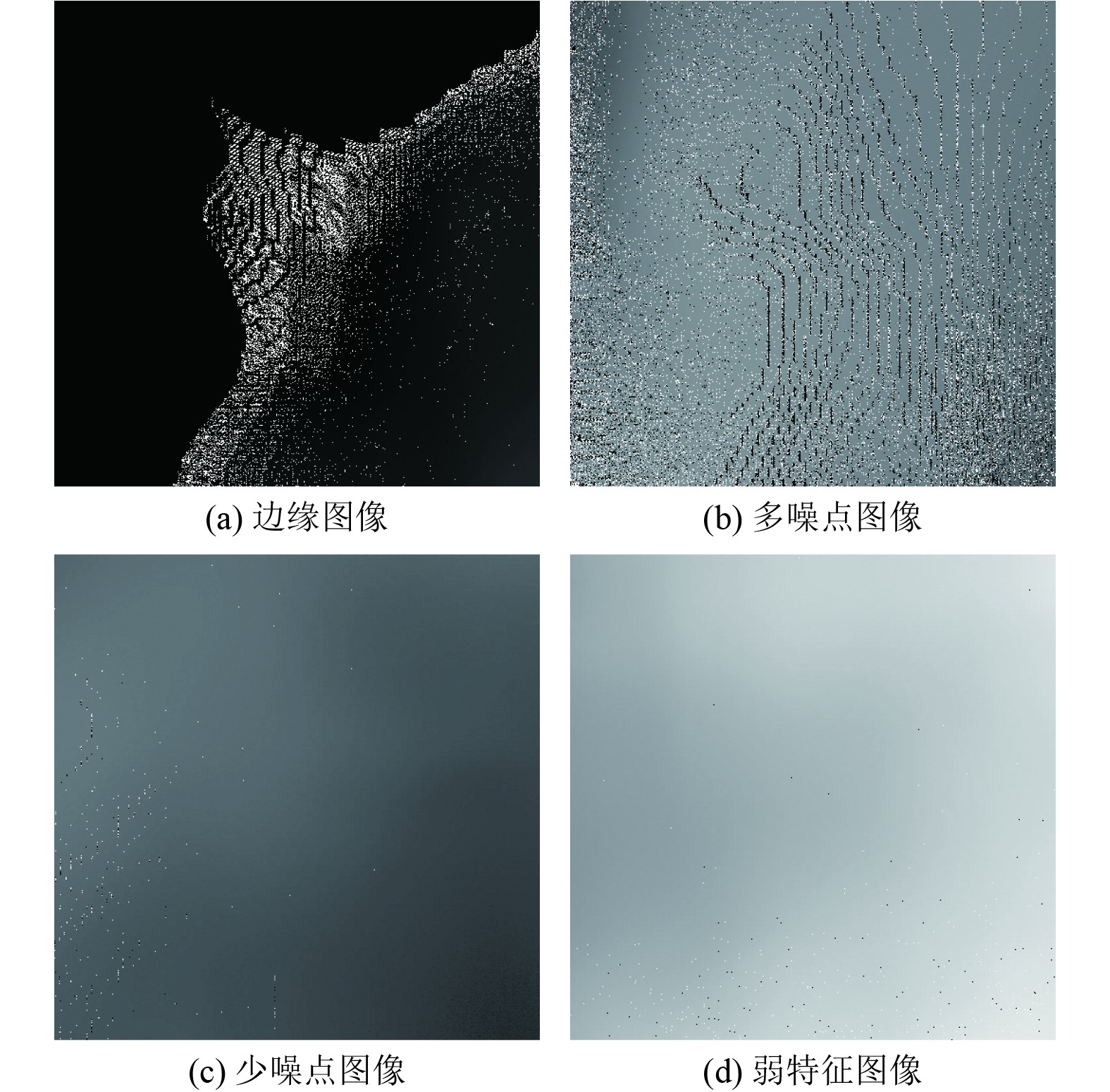

4.1 数据集基于前述水下典型环境建模和声呐探测仿真,生成了完整水下地形高程数据和相应声呐探测数据。该数据覆盖范围为约4 km2,分辨率为0.1 m,包含共12种水下典型环境。由于声呐探测易受到地形遮挡或水下移动物体的干扰,生成的数据中会存在分布无规律的噪声和盲点区域,如图7所示。

|

图 7 含有噪声的地形灰度图 Fig. 7 Terrain grayscale images with noise |

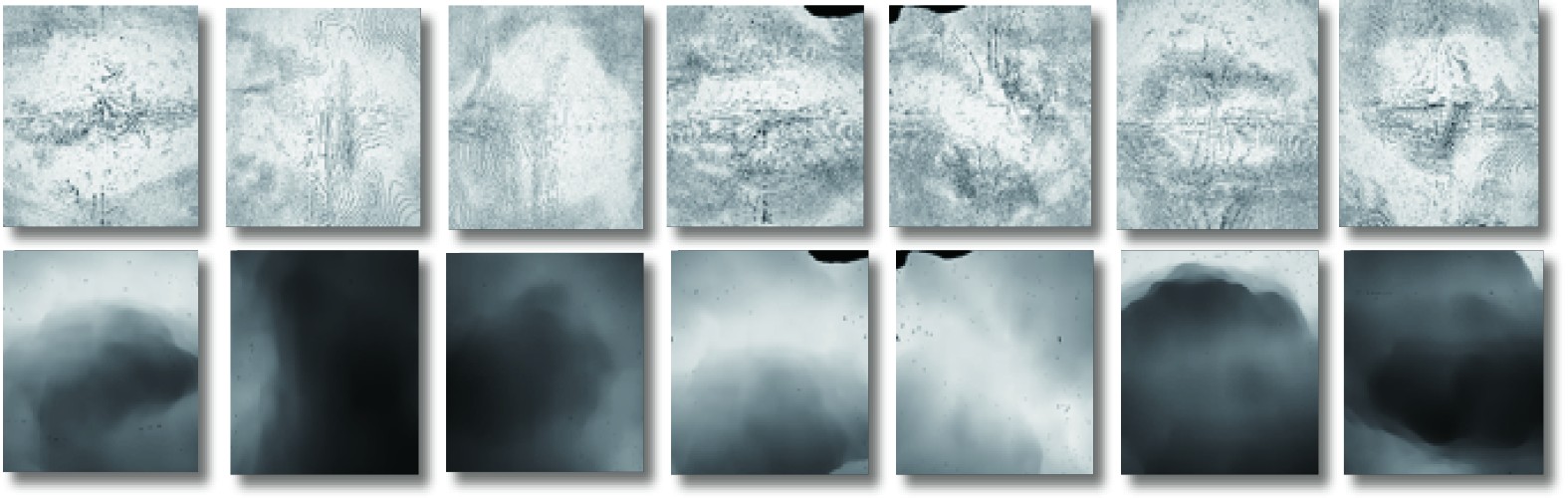

将仿真地形图按照512

|

图 8 声呐地形样本实例 Fig. 8 Sonar terrain samples |

选择不同的潜航器初始位置,并随机选择一定范围内的另一坐标作为移动目标,在每次到达新位置时进行一次声呐采样,重复30次,模拟潜航器执行任务时移动和探测的过程。

从随机的初始位置出发,共采集10段共300张地形图像作为实验的待匹配样本集,图9为样本集中的典型的图像数据。为保证实验数据的完备性,该样本集中包含了多种状态的地形图像块,包括边缘图像、多噪点图像、少噪点图像、弱特征图像等。

|

图 9 实验数据集样例 Fig. 9 Experimental dataset example |

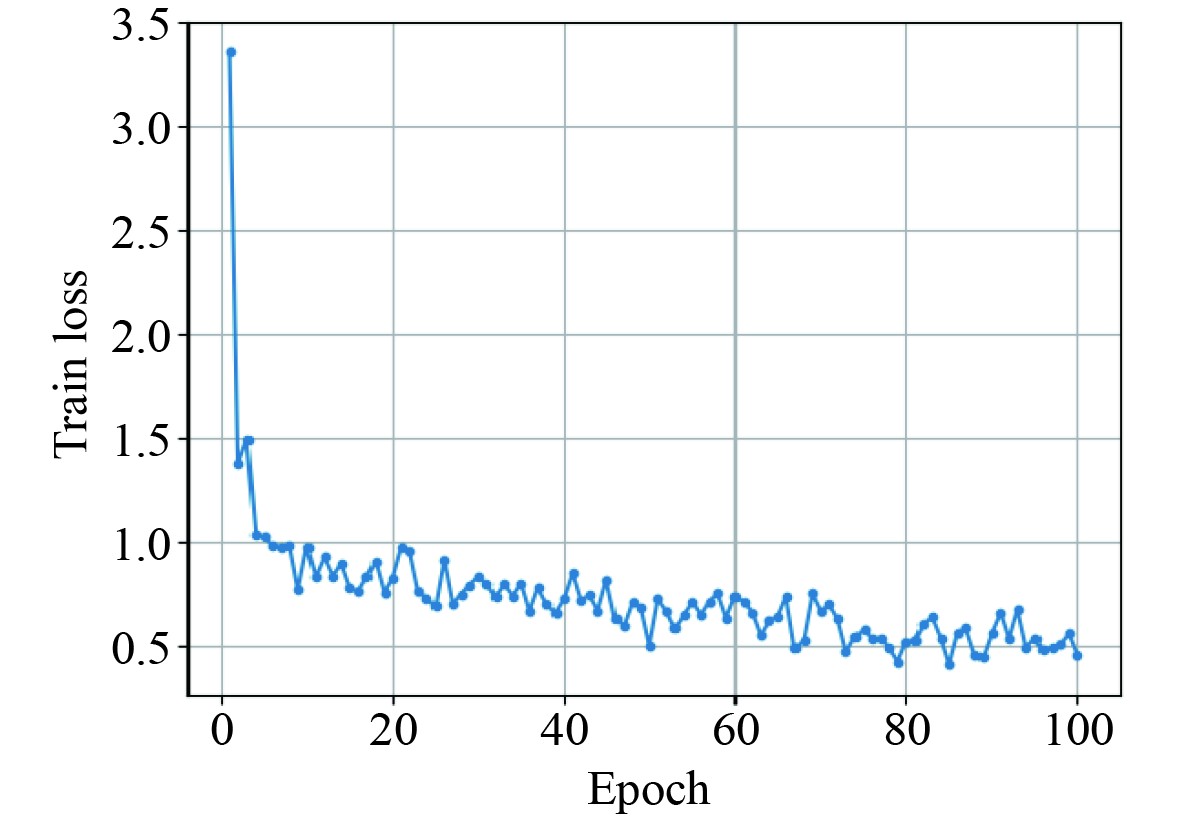

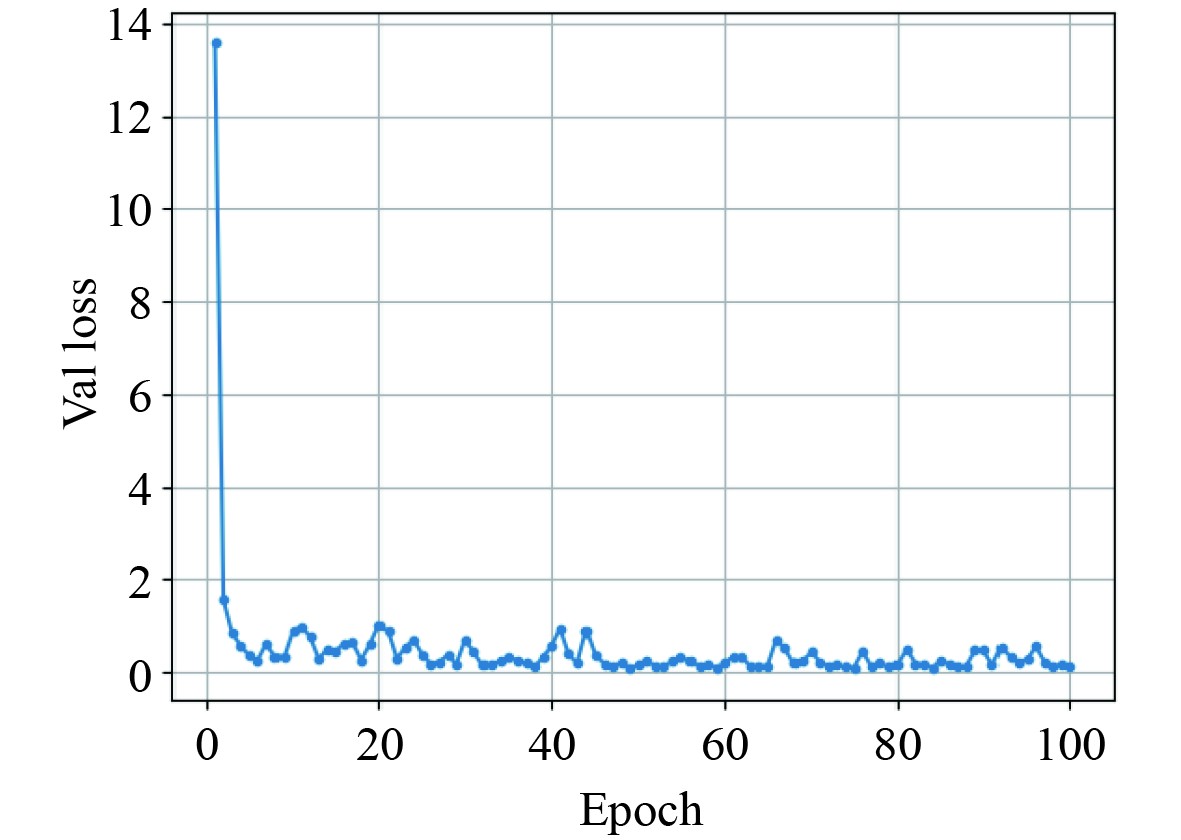

特征提取网络的主要超参数设置如下:学习率 = 0.001,训练批量 = 2,验证批量 = 2,特征批量 = 2,训练迭代次数 = 100,动量 = 0.99,权重衰退 = 1e-4。如图10所示,经过100轮迭代后,特征提取网络的训练损失收敛。在验证集上的验证损失如图11所示。

|

图 10 训练损失 Fig. 10 Train loss |

|

图 11 验证损失 Fig. 11 Validation loss |

使用多粒度组合匹配的策略可以充分利用地形中的特征信息,提高定位精度。先使用粗粒度匹配结合时空约束方法简化搜索空间,然后使用细粒度匹配来实现水下精确定位。

粗粒度匹配使用二次匹配的形式约简候选匹配位置。其中首次匹配过滤地形特征差异过大的候选地形图像,对于后续匹配成功与否具有连锁效果。因此过滤范围的选择对于平衡后续匹配时间和精度非常重要。

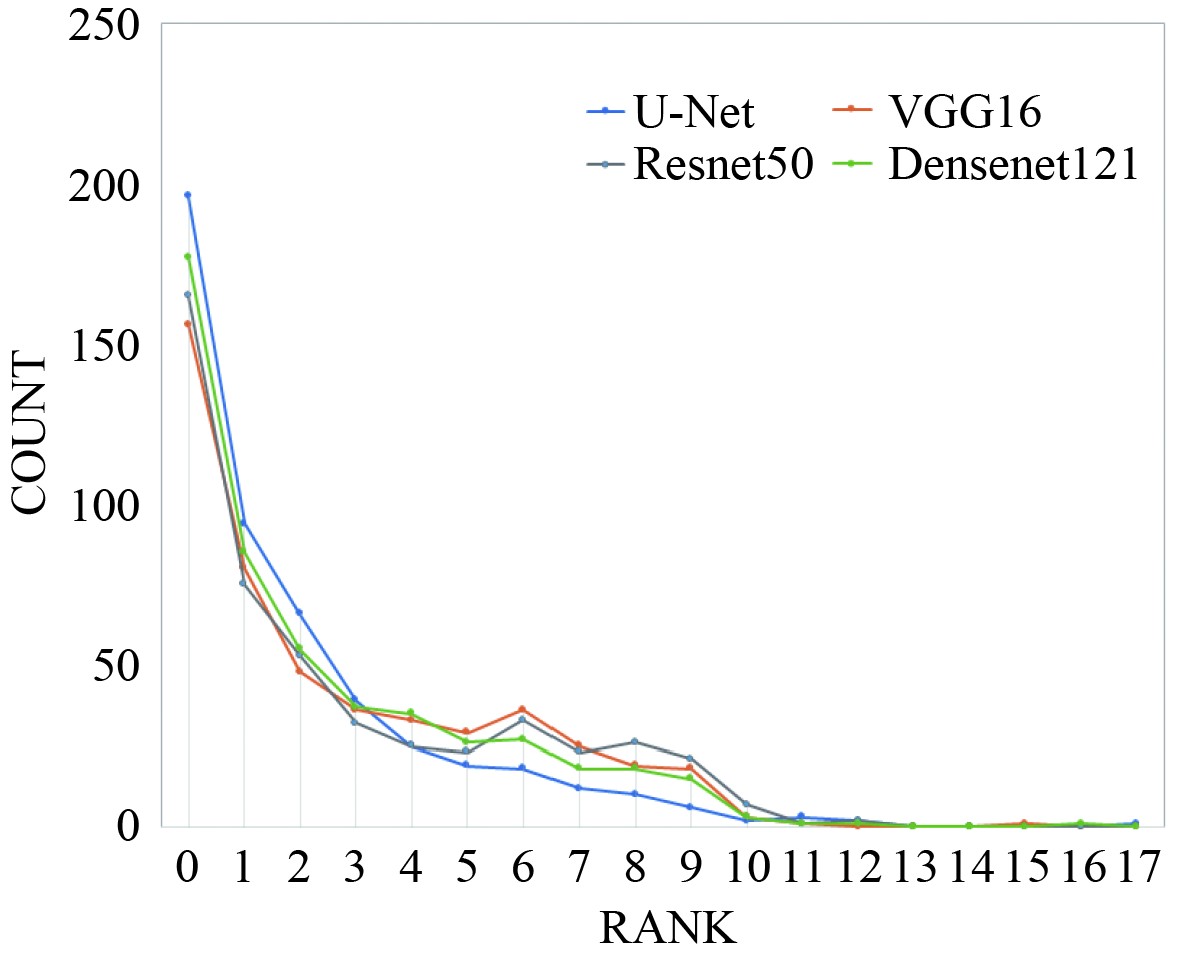

图12为各模型经过粗粒度首次匹配后的相似度排名分布结果。实验采用了随机采样的500张图片,分别使用基线模型和U-Net结构特征提取模型进行粗粒度匹配。模型U-Net和DenseNet121匹配最近邻图像块的结果相似度较高且相对集中,在相似度排名前10的比例分别占到99.2%和98.2%,说明U-Net和DenseNet121模型在匹配效果方面表现更出色。可以将首次匹配约简范围d设定为10,作为初次筛选的阈值,在平均定位误差增大0.8%的情况下,减少87.5%的定位时间。有效地减少候选区域的数量,大大加快匹配速度的同时,保持了较高的匹配精度。

|

图 12 粗粒度首次匹配相似度分布 Fig. 12 Coarse-grained first matching similarity distribution |

在d = 10的条件下,实验将使用平均定位误差和平均定位时间作为多粒度水下匹配定位效果的评价指标,并采用几种常见的特征提取网络对比水下匹配定位的效果,包括VGG16、ResNet50、DenseNet121[21 − 23]。

记第i组任务路径中第j次采集数据的坐标为

| $ {V_{ij}} = \sqrt {{{({x_{ij}} - x{'_{ij}})}^2} + {{({y_{ij}} - y{'_{ij}})}^2}}。$ | (9) |

第i组任务的定位误差和所有测试样本的误差分别用Ei和T表示,计算方法分别为:

| $ {E_i} = \frac{1}{n}\sum\limits_{j = 1}^n {{V_{ij}}},$ | (10) |

| $ T = \frac{1}{g}\sum\limits_{i = 1}^g {{E_i}} 。$ | (11) |

式中:n为潜航器每次任务采样个数;g为样本任务的个数。

相邻2次声呐采样的最大距离

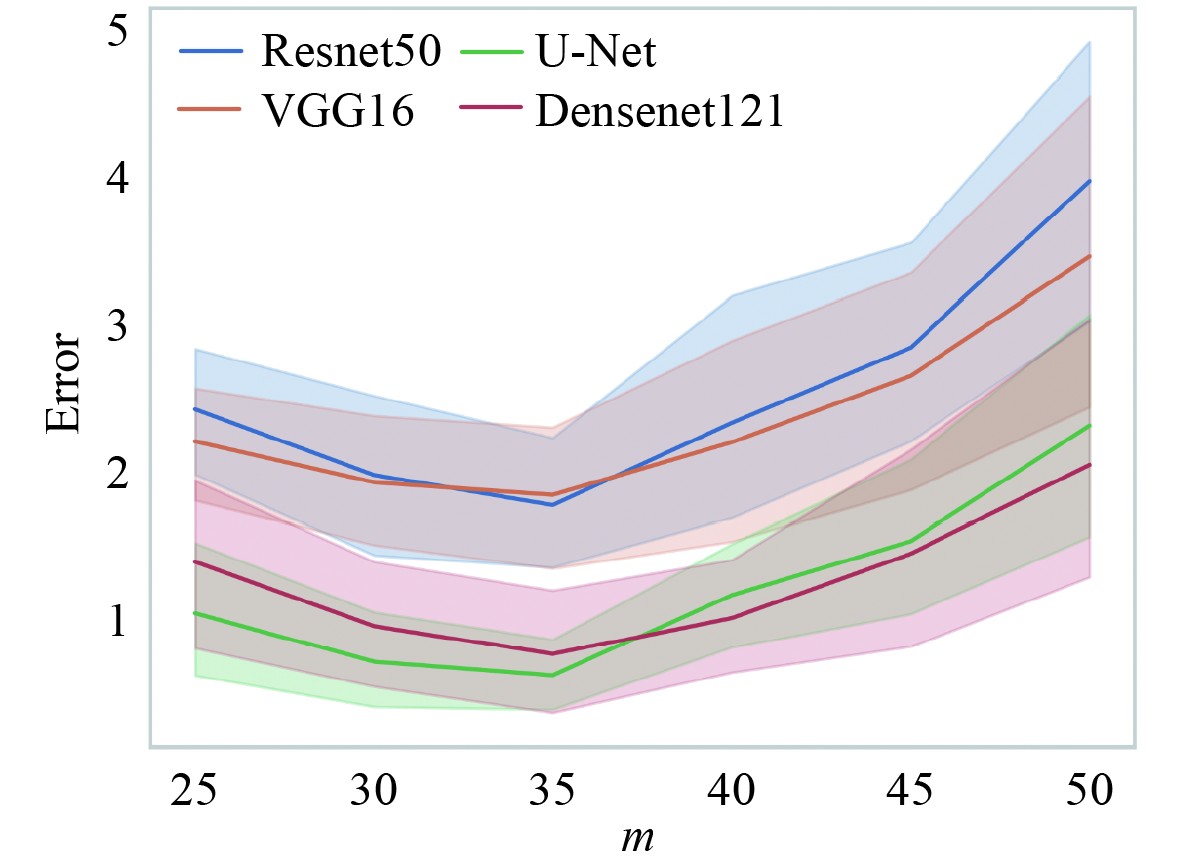

图13为使用多粒度声呐图像匹配算法在不同m值时各模型的定位效果。实线表示各个模型在多次实验后的平均定位误差,阴影部分表示相对于平均定位误差的最大浮动值。相对于其他模型,U-Net和DenseNet121模型在定位精度和稳定性方面表现更优,当m = 35时,U-Net模型的匹配效果最好,此时平均定位误差最小。同时,由于最大采样距离和时空约束的区域大小正相关,m增大时待匹配区域也会增大,导致定位失败概率增加,进而增大平均定位误差。相反,若m过小,经过第二次过滤可能会除去最相近的匹配区域,同样会降低定位的准确性。其次,在实际的场景中m的大小还要结合潜航器行进速度以及声呐单次采样间隔。

|

图 13 不同m参数下模型定位效果对比图 Fig. 13 Comparison of model positioning result under different m parameters |

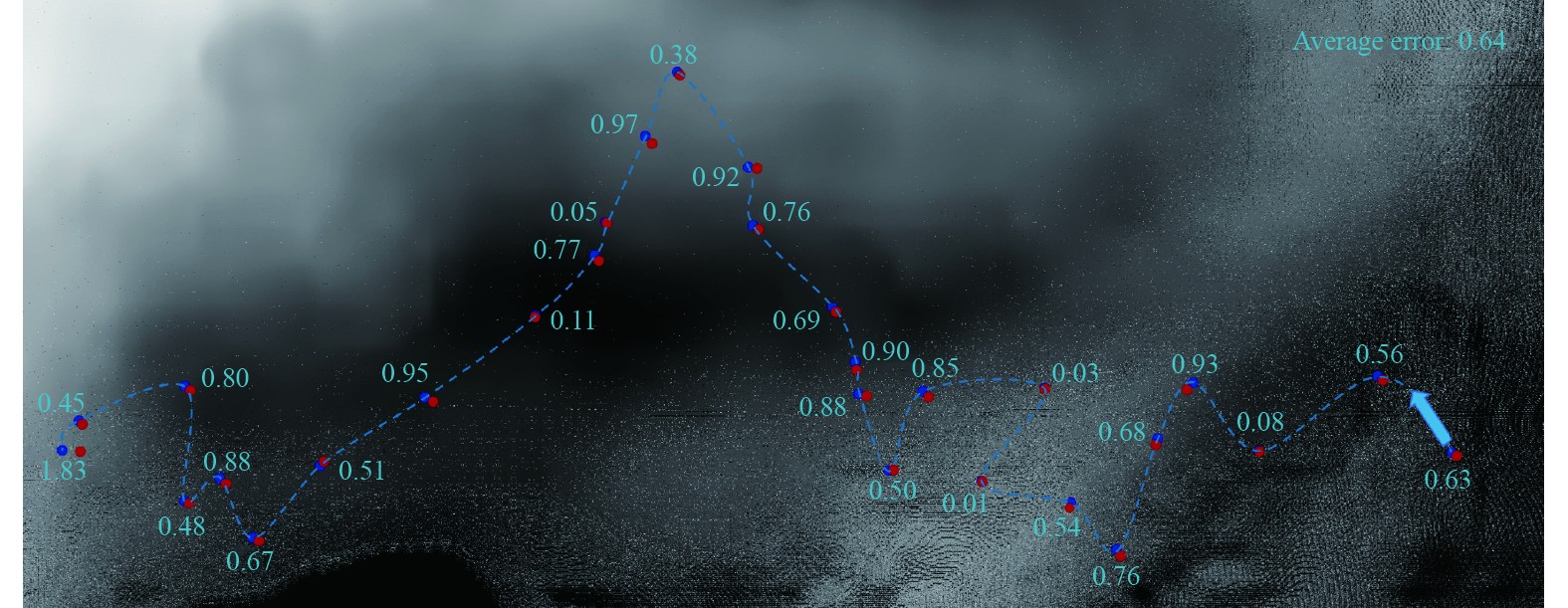

图14为潜航器执行一次任务的定位效果,其中蓝色箭头指示潜航器的行进方向,蓝色点是声呐探测信号的位置,红色点对应预测位置。

|

图 14 一次航行任务的匹配结果 Fig. 14 Matching result of a navigation mission |

可以看到,预测位置和真实位置基本重合,证明多粒度匹配定位算法具有很好的匹配定位精度。

细粒度匹配的粒度

|

|

表 1 U-Net模型在不同粒度s下的定位效果 Tab.1 Localization performance of U-Net model under different granularities s |

使用不同模型进行特征提取的匹配结果如表2所示,可以看到,相比于其他模型,使用U-Net模型来提取特征相比于其他模型在定位精度和定位时间上都有一定优势。其中,VGG16模型可以获得和U-Net模型相近的精度,但其平均定位时间过长,不符合实时定位场景的要求,ResNet50模型和DenseNet121模型则在精度和定位的实时性上均不如U-Net模型。所以选用U-Net模型作为主干特征提取网络可以获得更好的匹配定位效果。

|

|

表 2 不同特征模型的定位效果(d=10, m=35, s=0.8) Tab.2 Localization performance of different feature models (d=10, m=35, s=0.8) |

本文提出一种基于多粒度声呐图像匹配的水下定位方法,该方法包括特征提取和匹配定位两部分。特征提取模块基于U-Net网络架构构建,通过无监督学习的方法训练模型,自适应学习水下地形图像特征,然后使用U-Net编码部分提取声呐图像的特征。匹配定位模块实现了一种具有时空约束的多粒度匹配定位算法,通过对地形特征进行多粒度的充分挖掘,准确在水下多场景复杂环境下定位潜航器的位置。该算法首先通过折半二次匹配的方法结合时空约束对探测图像进行粗粒度匹配以约简候选匹配的问题规模,然后重新对约简后的候选区域进行细粒度匹配,从而实现精确定位。

为了验证所提方法的有效性,本文在基于水下典型环境建模和声呐探测仿真生成的数据集上进行了实验和分析,结果表明所提方法平均定位误差最小可以达到0.68 m,单次的平均定位时长为0.46 s,定位精度和定位实时性可满足水下定位的需求。

| [1] |

SALAVASIDIS G , MUNAFÒ, ANDREA, HARRIS C A , et al. Terrain‐aided navigation for long‐endurance and deep‐rated autonomous underwater vehicles[J]. Journal of Field Robotics, 2018.

|

| [2] |

MAI N T , JI Y , WOO H , et al. Acoustic Image Simulator Based on Active Sonar Model in Underwater Environment[C]// 2018.

|

| [3] |

L PAULL, S SAEEDI, M SETO, et al. AUV Navigation and Localization: A Review[J]. IEEE Journal of Oceanic Engineering, 2014, 39(1): 131−149.

|

| [4] |

桑恩方, 庞永杰, 卞红雨. 水下机器人技术[J]. 机器人技术与应用, 2003(3): 8-13. SANG E F, PANG Y J, BIAN H Y. Underwater robot technology[J]. Robotics and applications, 2003(3): 8-13. DOI:10.3969/j.issn.1004-6437.2003.03.003 |

| [5] |

陈小龙. AUV水下地形匹配辅助导航技术研究[D]. 哈尔滨: 哈尔滨工程大学, 2012.

|

| [6] |

RONNEBERGER O, FISCHER P, BROX T. U-net: Convolutional Networks for Biomedical Image Segmentation[C]// Medical Image Computing and Computer-Assisted Intervention– MICCAI 2015. Springer, Cham, 2015.

|

| [7] |

INGEMAR N, MEMBER. Terrain navigation for underwater vehicles using the correlator method[J]. IEEE Journal of Oceanic Engineering, 2004, 29(3): 906-915. DOI:10.1109/JOE.2004.833222 |

| [8] |

HUANG Y, ZHANG Y, ZHAO Y. Review of autonomous undersea vehicle navigation methods[J]. Journal of Unmanned Undersea Systems, 2019, 27(3): 232-253. |

| [9] |

宋子奇. 基于声呐图像处理的水下地形地貌匹配定位方法研究[D]. 哈尔滨: 哈尔滨工程大学, 2017.

|

| [10] |

GOLDEN J P . Terrain Contour Matching (TERCOM): A Cruise Missile Guidance Aid[C]// Technical Symposium, 1980.

|

| [11] |

HAN Y R, WANG B, DENG Z H, et al. An Improved TERCOM-Based Algorithm for Gravity-Aided Navigation[J]. IEEE Sensors Journal, 2016, 16(8): 2537-2544. DOI:10.1109/JSEN.2016.2518686 |

| [12] |

LI P J, ZHANG X F, XU X S. Novel terrain integrated navigation system using neural network aided Kalman filter[C]// 2010 Sixth International Conference on Natural Computation. Yantai, 2010.

|

| [13] |

HUANG L Y, HE B, ZHANG T. An autonomous navigation algorithm for underwater vehicles based on inertial measurement units and sonar[C]// 2010 2nd International Asia Conference on Informatics in Control, Automation and Robotics (CAR 2010). Wuhan, 2010.

|

| [14] |

TAN S L, DU K Y, HUANG W D, et al. Segmented Underwater Terrain Matching Based on Q-Learning[C]// IEEE International Conference on Signal Processing, Communications and Computing (ICSPCC). Xi'an, 2022.

|

| [15] |

YANG W L, FAN S S, XU S X, et al. Autonomous Underwater Vehicle Navigation Using Sonar Image Matching based on Convolutional Neural Network[J]. IFAC-PapersOnline, 2019, 52(21): 156-162. DOI:10.1016/j.ifacol.2019.12.300 |

| [16] |

SANTOS M M D, GIACOMO G G D, DREWS P L J, et al. Matching Color Aerial Images and Underwater Sonar Images Using Deep Learning for Underwater Localization[J]. IEEE Robotics and Automation Letters, 2020, 5(4): 6365-6370. DOI:10.1109/LRA.2020.3013852 |

| [17] |

MATHIEU M, COUPRIE C, LECUN Y. Deep multi-scale video prediction beyond mean square error[J]. Computer Science, 2015.

|

| [18] |

HASAN M, CHOI J, NEUMANN J, et al. Learning Temporal Regularity in Video Sequences[C]// 2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Las Vegas, 2016.

|

| [19] |

梁家菲, 李婷, 杨佳琪, 等. 融合自注意力和自编码器的视频异常检测[J]. 中国图象图形学报, 2023, 28(4): 1029-1040. LIANG J F, LI T, YANG J Q, et al. Video anomaly detection combining autoattentional and autoencoder[J]. Chinese Journal of Image and Graphics, 2023, 28(4): 1029-1040. DOI:10.11834/jig.211147 |

| [20] |

RÔMULO CERQUEIRA, TROCOLI T, NEVES G, et al. A novel GPU-based sonar simulator for real-time applications[J]. Computers & Graphics, 2017, 68: 66−76.

|

| [21] |

SIMONYAN K, ZISSERMAN A. Very deep convolutional networks for large-scale image recognition[J]. Computer Science, 2014.

|

| [22] |

HE K, ZHANG X, REN S, et al. Deep Residual Learning for Image Recognition[C]// IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas, 2016.

|

| [23] |

HUANG G, LIU Z, LAURENS V, et al. Densely Connected Convolutional Networks[C]// 2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Honolulu, 2016.

|

2025, Vol. 47

2025, Vol. 47