2. 同济大学 电子与信息工程学院 上海 201804

2. School of Electronics and Information Engineering, Tongji University, Shanghai 201804, China

机器人的自主导航可拆分为位置估计、地图构建和路径规划。自主移动机器人想要实现未知环境下的自主导航,位置估计和地图构建是不可或缺的,而且它们往往是同时进行的,即机器人的SLAM技术。视觉SLAM是指使用相机作为主要信息来源,通过计算得到相机姿态,继而完成定位和地图构建的技术。在部分场景中,基于GPS的定位方法精度有限,甚至接收不到GPS信号,而基于磁条的方法又不够灵活。因此,能够在陌生环境中进行定位和地图构建的SLAM技术,是自主移动机器人必备的能力。激光SLAM技术成熟较早,其中Grisetti等[1]提出的算法表现出很好的性能。在过去的一段时间,激光SLAM一直是移动机器人的标配。然而,随着机器人智能化的需求,视觉SLAM可以赋予移动机器人更强的感知能力。视觉SLAM更为丰富的信息,可以帮助机器人更好地进行回环检测、障碍规避甚至路径规划。近年来,许多出色的研究工作使得视觉SLAM可以应用在一些特定场景中。本文在介绍视觉SLAM的基本原理和经典框架的同时,探讨了视觉SLAM的最新技术、研究热点和亟待解决的问题。

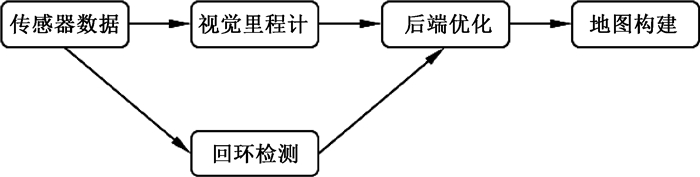

1 视觉SLAM概述 1.1 视觉SLAM原理图 1为一种经典的视觉SLAM框架。如图 1所示,视觉SLAM框架通常包括传感器数据、视觉里程计、后端优化、地图构建、回环检测。视觉SLAM也可分为前端和后端。前端又称视觉里程计,它通过对相机的图像进行处理和计算,得到相机各个时刻的姿态,形成相机运动的轨迹(自主移动机器人的视觉里程计可能还会融合码盘、惯性传感器的信息)。后端对前端的相机姿态进行优化,使相机姿态的累计误差最小化,并完成地图构建。如果SLAM框架中包含回环检测,那么回环检测会利用相机的图像,将检测结果送到后端处理。

|

图 1 一种经典的视觉SLAM框架 Fig. 1 A classical framework of visual SLAM |

视觉里程计算法主要分为直接法和间接法,间接法又称为特征点法。直接法是从光流法演变而来的。在直接法中,假设某个空间点在各个视角下成像的灰度是不变的。首先提取关键点,既不计算描述子,也不进行匹配,然后考虑空间点在两帧中的像素位置,最后建立误差模型,通过计算最小光度误差来优化旋转矩阵和平移向量。为了求解这个优化问题,需要关心误差是如何随相机位姿变化的,分析它们的导数关系。

特征点法就是通过比对两幅图像中特征点对应关系,利用几何方法计算相机的位姿变化。在单目视觉SLAM中,需要进行求解的是两组2D点,使用对极几何求解。双目或RGB-D视觉SLAM可以先得到或者计算出2D点的深度信息,将2D点转化成3D点,使用ICP求解。当一组点为3D,一组点为2D时,使用PnP求解。因此,如何得到准确稳定的特征点对应关系是十分关键的。在数字图像中,图像以矩阵的形式存储,RGB图像通常有三个通道。常见的特征点是角点,例如Harris角点[2]、FAST角点[3]等,这些特征点较为简单,具有速度快、鲁棒性低的特点。图 2展示了VINS-Mono[4]使用Harris角点作为特征点的应用案例。研究者们陆续设计了更加复杂稳定的局部图像特征,例如SIFT[5]、SURF[6]、ORB[7],这些特征点有着更好的鲁棒性以及特征点之间的分辨能力。但是,特征点法也有一些不足之处。首先,特征点的提取和描述子的计算会耗费大量的计算力。比如SIFT特征点,在效果稳定的同时带来了大量的计算,这导致SIFT在三维重建这种离线计算领域应用广泛。即使是ORB特征点,也需要20 ms的计算时间。可见,使用特征点法会大大降低SLAM系统的实时性。其次,特征点只是图像的一部分像素,而图像中还有大量其他有用的信息没有被提取。此外,特征点法有一个致命缺陷,就是真实场景中有些场景是低纹理的,特征点数量十分少,这将导致帧间的跟踪失败。因此,还需要根据应用场景进行方法的选择,没有完美的方案。

|

图 2 VINS-Mono使用Harris角点作为特征点 Fig. 2 VINS-Mono used Harris corners as feature points |

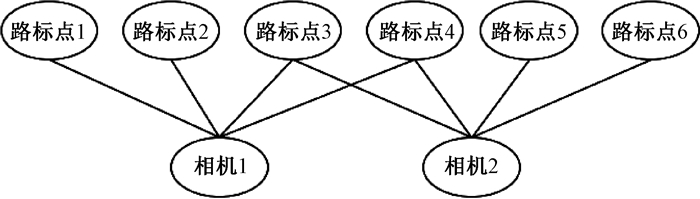

视觉SLAM的后端是非线性优化的。由于真实世界存在大量噪声干扰,前端在某一时刻的误差有可能会逐渐累积,使得整个系统瘫痪,所以后端优化就尤为重要。过去采用以扩展卡尔曼滤波为主的滤波方案,现在大多采用非线性优化方法。扩展卡尔曼滤波由于假设了马尔可夫性质,只利用前一状态来估计当前状态的值,这有点像视觉里程计中只考虑相邻两帧的关系一样,很难做到全局的优化。而现在常用的非线性优化方法,则是把所有数据都考虑进来,放在一起优化。虽然这种方法增大了计算量,但效果会好得多。对于后端优化来说,需要优化整个地图的全部位姿和全部路标点。近年来,研究者们逐渐意识到如果矩阵具有一定形式的稀疏性,则可以加速求逆的过程,SLAM后端的非线性优化恰恰可以利用这一性质。SLAM的相机位姿和路标点具有非常特殊的结构,并非随机产生。图 3为相机位姿与观测到的路标点的关系。可以看出,一个相机位姿可以观测到多个路标点,一个路标点也可以被多个相机位姿观测到。

|

图 3 相机位姿与观测到的路标点的关系 Fig. 3 The relationship between camera pose and observed landmark points |

由于相机的大范围运动,局部区域的路标点只会被局部的几个相机位姿观测到,而其他大部分相机位姿观测不到这些点,这是产生稀疏性的根源。当构建了非线性优化的代价函数后,需要求代价函数对所有优化变量的偏导数。稀疏性意味着这些偏导数只有小部分不为0,这些不为0的项对应着相机位姿与其能够观测到的路标点的组合。Schur消元法利用矩阵的稀疏性求逆,是集束调整中求解增量方程的常用手段。

回环检测是中小规模场景SLAM非常需要的模块,通过回环检测,可以有效地减小累积误差。当跟踪丢失时,还可以用来进行重定位。当相机观察到某一帧与之前某个关键帧匹配时,就可以认为是回环。然而,对每个历史关键帧进行像跟踪那样的计算是非常耗时的。词袋模型(BoW)是图像检索领域常用的方法,将特征点进一步抽象为视觉单词,通过对比词袋向量来获得两幅关键帧之间的相似性。图 4展示了VINS-Mono使用DBoW做回环检测的效果。为了进一步提高匹配效率,采用K叉树来表达字典,大大降低了时间复杂度,有效提高了特征匹配的速度。在室内自主移动机器人的应用场景中,回环检测的重要性是不言而喻的,机器人经常能够观测到已经到过的地方,通过回环检测可以大大降低累积误差所带来的影响。

|

图 4 VINS-Mono使用DBoW做回环检测 Fig. 4 VINS-Mono used DBoW for loopback detection |

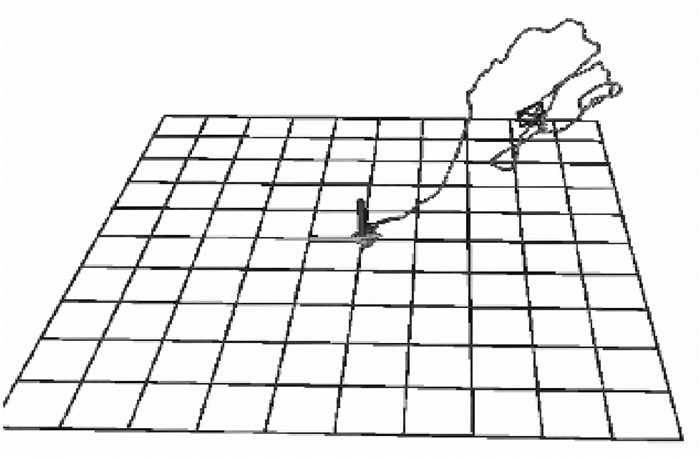

MonoSLAM[8]是第一个实时的单目SLAM系统,被认为是基于滤波方法的代表。MonoSLAM使用扩展卡尔曼滤波同时估计相机运动和未知环境的结构,扩展卡尔曼滤波的状态向量用来表示六自由度的相机运动和特征点的空间位置。在预测模型中假设为匀速运动,并将特征点跟踪结果作为观测值。根据摄像机的运动,新的特征点被添加到状态向量中。初始地图是通过观察确定了全局坐标系的已知对象创建的。图 5展示了MonoSLAM系统的运行截图。

|

图 5 MonoSLAM系统的运行截图 Fig. 5 Screenshot of MonoSLAM system |

PTAM[9]将跟踪和建图分离成两个不同的线程,这两个线程是并行的,解决了MonoSLAM的计算成本问题。PTAM第一个将集束调整应用到实时视觉SLAM算法中,其多线程方法被后来的大部分视觉SLAM系统所采用。PTAM使用五点法重建初始化地图。在跟踪线程中,使用纹理匹配将建图的点投影到图像上,以进行2D-3D对应,根据对应关系计算相机位姿;在建图线程中,使用三角测量在关键帧上计算新特征点的空间位置。PTAM的突出贡献之一就是介绍了视觉SLAM中基于关键帧的建图方法。当输入帧与某一测量的关键帧存在大的视差时,输入帧会被选为一个关键帧,而准确的三角测量需要较大的视差。相比MonoSLAM,PTAM使用部分关键帧的局部集束调整和所有地图里关键帧的全局集束调整来优化特征点的3D点。在跟踪线程中,PTAM的新视野采用了重定位算法,使用基于树的随机特征分类器来搜索输入帧的最近关键帧。与MonoSLAM相比,使用跟踪和建图线程分离的PTAM可以容纳上千个特征点。S-PTAM[10]是双目版本的PTAM,双目约束用于点初始化、建图和跟踪,从而提高系统的准确性和鲁棒性。系统中包含实时回路检测和校正。为了获得最佳性能,S-PTAM将SLAM的定位和建图任务分离为两个独立的线程。在独立线程中运行的维护过程会迭代地在局部可见区域内细化地图(集束调整),从而提高全局一致性。尽管该方法仅适用于双目图像的输入,但也可以使用轮式里程计来提高准确性和鲁棒性。二进制特征用于描述视觉点地标,从而降低了存储要求和匹配成本。

ORB-SLAM[11]是比较成熟的视觉SLAM系统,它像是PTAM的升级版,使用3个独立线程进行跟踪、地图构建、回环检测。ORB-SLAM使用DBoW2库实现回环检测,使用g2o库进行PnP计算、全局优化、局部优化,其采用的ORB特征具有更好的视角不变性,相比SIFT也有更快的速度。ORB-SLAM增加了循环回路检测和闭合机制,通过匹配回路两侧关键帧的公共点来检测回路,使用位姿图优化闭合回路。ORB-SLAM在8个金字塔层提取FAST角点,为了保证角点在整个图像中均匀分布,每个金字塔层被划分成单元,并且在线调整FAST检测器的参数以保证每个单元提取角点的个数最小值为5,对每一个提取的特征点计算256 bit的ORB描述子。ORB-SLAM将描述符离散化并存储到称为视觉词汇表的词包中,约束词汇树中属于同一节点的特征,这些词包用于加速图像和特征的匹配。为了处理视点变化,ORB-SLAM跟踪观察到路标的所有关键帧,并从与当前帧具有最小视点差异的关键帧中选择描述符。ORB-SLAM的代码清晰,且系统具有较好的鲁棒性,受到开发者们的欢迎。然而,ORB-SLAM构建的稀疏点云地图,应用场景还十分有限。而且ORB-SLAM在视角旋转时跟踪失败概率较大,只能在相机低速运动的情况下正常工作。虽然ORB-SLAM在后来支持了双目和RGB-D摄像头数据,但主要还是用于单目相机。

1.2.2 直接法DTAM[12]是基于直接法的视觉SLAM,通过比较输入图像和从重建地图生成的合成视角图像来实现跟踪,完全等效于在图像和地图的3D模型之间进行配准,并且可以在GPU上高效实现。使用多基线立体法估计每个像素的深度值,并通过考虑空间连续性来优化深度值。LSD-SLAM[13]也是直接法的代表之一,其核心思想是半稠密的视觉里程计。LSD-SLAM的重建目标为有强度梯度的区域,而DTAM的重建目标为所有区域。这样,LSD-SLAM会选择性地忽略那些低纹理的区域。后端使用七自由度的位姿图优化来得到几何一致的地图,在建图时使用随机数初始化每个像素的深度值,并使用光度一致性来优化这些值,这种半稠密的方法可以实时运行在普通的CPU设备上。

SVO[14]是一种半直接法的视觉里程计,其跟踪使用了特征点匹配,使用光度误差最小化来估计相机运动, 而地图构建使用了直接法。特征点可以认为是梯度明显的像素,而LSD-SLAM的重建目标是梯度明显的区域,所以这种方法可以看作是DTAM和LSD-SLAM的稀疏版本。SVO使用独特的深度滤波器来估计关键点的深度,并使用逆深度作为参数化形式。

DSO[15]是一种直接法的视觉里程计,它将输入图像分成了若干块,选择高强度点作为重建候选对象。这样,点就会散布在整个图像,视觉里程计对于不同环境的自适应能力得到了增强。候选点使用围绕目标点分布的8个像素,这个数值是根据经验折中选取,能够平衡计算时间、足够的跟踪信息以及应对运动模糊。DSO可以利用具有足够强度梯度的任何图像像素,即使在无特征的区域中也可以使其具有鲁棒性。LDSO[16]保留了这种鲁棒性,通过跟踪前端中的拐角特征来确保其中一些点的可重复性,这种可重复性允许使用常规的基于特征的词袋方法可靠地检测候选闭环。通过几何方法验证闭环候选者,并通过共同最小化2D和3D几何误差项来估算相对姿态约束,这些约束与从DSO的滑动窗口优化中提取的相对姿态的共同可见度图融合在一起。改进的点选择策略保留了跟踪的准确性和鲁棒性,而集成的姿态图优化显著降低了累积的旋转、平移和比例漂移。文献[17]设计了直接法和基于特征的算法之间的松散耦合。局部采用直接法对局部精确、短期、半稠密的图像进行快速、稳健的姿态跟踪;基于特征的算法用于重新确定关键帧姿势、执行循环闭合,并构建可重复使用、全局一致、长期、稀疏的特征映射。实验使用了DSO和ORB-SLAM,该策略在不影响实时效率和性能的情况下,弥补了不同方法的弱点。

1.2.3 视觉惯性融合VINS-Mono[4]是视觉与惯性测量单元(IMU)融合的重要工作,使用滑动窗口优化进行视觉和加速度传感器的紧耦合来实现视觉惯性里程计,可以获得较高的精度。视觉与IMU融合,借助IMU较高的采样频率来提高系统的采样频率,可以在恶劣环境下大幅提升鲁棒性。IMU可以解决单目视觉SLAM的尺度问题,视觉可以帮助IMU消除积分漂移,校正IMU的偏差。VINS-Mono使用Harris角点和LK光流跟踪,使用DBoW做回环检测,由于VINS-Mono定位精度高、鲁棒性好,使得它在大量实际项目中被使用。图 6展示了VINS-Mono在无人机数据集上生成的较为精确的运动轨迹。

|

图 6 VINS-Mono生成的无人机运动轨迹 Fig. 6 Motion trajectory of drone generated by VINS-Mono |

随着互联网大数据和计算机性能的发展,深度学习在各个领域都取得了令人惊喜的成绩。SLAM研究者们进行了很多尝试,使用深度学习来替代传统SLAM中的模块,例如特征提取、特征匹配、深度估计、位姿估计等。文献[18]提出基于左右和前后约束的深度视觉里程计估计, 其中左右两个连续视频序列分别估计位姿, 然后对其作一致性损失,基本上集成了单目深度估计所有可能的损失函数。SLAM中的几何位置关系能更好地提取语义信息,深度学习可以提取图像中的语义信息来促进SLAM的定位和闭环检测,例如使用语义目标作为路标点。文献[19]使用单目深度图像估计神经网络来预测单张图片的深度值,对特征点的深度均值和方差进行初始化,提供了一个不同角度的视觉SLAM和深度学习相结合的方法。这种方法减少了初始化地图点深度的不确定性,使得帧与帧之间的特征匹配错误率低,地图点收敛速度更快。Semantic-Fusion[20]将ElasticFusion[21]的几何信息与基于CNN的语义分割结合,ElasticFusion特别适合于语义标签的融合。曲面表示是变形和校正的,因此单个曲面始终与真实世界实体保持关联,这使得在视点的广泛变化上能够实现每帧语义预测的长期融合。地图本身的几何学也提供了有用的信息,可有效地调整预测。这意味着SLAM的加入不仅提供了一个即时有用的语义3D地图,还意味着许多最先进的2D单帧语义分割方法在与SLAM相连接时可以提高性能。MaskFusion[22]是一种实时的、可感知对象的、语义和动态的RGB-D SLAM系统,它超越了传统系统,可输出静态场景的纯几何图。MaskFusion可以识别、分割语义类别标签,并将其分配给场景中的不同对象,即使它们独立于摄像机移动也可以对其进行跟踪和重构。当RGB-D相机扫描混乱的场景时,基于图像的实例级语义分割会创建语义对象蒙版,从而实现实时对象识别以及为世界地图创建对象级表示。与以前的基于识别的SLAM系统不同,MaskFusion不需要其可识别对象的已知模型,并且可以处理多个独立的运动。MaskFusion充分利用了使用实例级语义分段的优势,以使语义标签能够融合到一个对象感知映射中,这与最近语义SLAM系统执行体素级语义分段的方式不同。

2.2 基于事件相机的视觉SLAM作为一种新型相机,事件相机有很多传统相机无法比拟的优点。文献[23]从器件的设计方法和性能方面介绍了事件相机。与像素具有相同曝光时间的传统相机相比,基于事件的摄像机,例如动态视觉传感器(DVS),是新颖的受生物启发的视觉传感器。与以固定速率生成图像的常规相机相比,基于事件的相机中像素独立且异步运行,通过生成事件来响应强度变化。事件由强度变化及其极性(即像素变暗还是变亮)的x、y像素位置和时间t表示。基于事件的摄像机本质上是以与场景动力学相同的速率对场景进行采样,与常规摄像机相比,它们具有以下优点:非常高的时间分辨率,低延迟,非常高的动态范围(HDR,140 dB)以及低功耗和带宽要求,这些特性使其非常适合捕捉运动。因此,基于事件的摄像机可应用于传统摄像机无法访问的挑战性场景。

2.3 动态环境下的视觉SLAMSLAM方案绝大多数是基于静态环境、良好光照、丰富特征的假设,而真实场景中包含了大量动态物体。因此,研究动态环境下的SLAM是非常有意义的。动态环境SLAM的关键就是将动态物体的特征点等信息移除,避免其对定位和回环检测造成干扰。动态物体的判断有基于多视图几何的特征点筛选和基于深度学习的语义分割等方法。DS-SLAM[24]采用语义分割和特征点检测作为两个并行的计算模块,将动态语义对象范围内的特征点剔除。DynaSLAM[25]用Mask R-CNN[26]分割远距离的动态目标, 结合多视图几何对近距离的动态目标进行分割,效果如图 7所示,人体区域像素值会被剔除。这样能够提高多视图几何对于近距离动态目标检测的精确性,以及深度学习对较远处动态目标的检测能力。背景修复使用多个关键帧来完成, 当数个关键帧中动态目标移动范围较大时, 背景修复的效果才会更好一些。

|

图 7 DynaSLAM采用多视图几何和深度学习结合来分割动态目标 Fig. 7 DynaSLAM used a combination of multi-view geometry and deep learning to segment dynamic targets |

实时度量语义SLAM开源系统Kimera[27],使用相机图像和惯导数据来构建语义注释的3D环境网格,相较于之前的工作,它是模块化的结构,并且支持开源机器人操作系统ROS。Kimera包含以下模块:用于快速和准确状态估计的视觉惯性里程计模块,用于全局轨迹估计的强大姿态图优化器模块,用于快速网格重建的轻型3D网格划分器模块以及密集的3D度量语义重建模块。这些模块可以单独运行,也可以组合运行,具有强大的灵活性。文献[28]提出了3D动态场景图作为可操作空间感知的统一表示,这个场景图是有向图,节点表示场景中的实体,边缘表示节点之间的关系,并且包含支持规划和决策的可行信息,还提出了全自动空间感知引擎。这些工作对于自主移动机器人在包含大量动态目标的真实场景中的运行,有着深远的影响。

2.4 协同SLAM文献[29]提到,协作视觉SLAM能够克服单视角SLAM的诸多问题, 利用各个独立的SLAM视角联合位姿估计、建图、点云分组等。文献[30]介绍了一种多无人机协同SLAM系统,每个无人机在有限的硬件环境下进行SLAM工作来探索环境,并将收集的信息传给地面服务器。服务器维护所有无人机的地图,处理回环检测、地图融合、优化并分发信息给每个无人机。这样,每个无人机可以将其他无人机的观测纳入自己的SLAM估计当中。这种共享信息的协作系统,可以有效地改善每个机器人单位的轨迹,提升SLAM系统构建的地图规模。同样,轮式移动机器人也可以共享地图信息来构建大规模地图。如何减少地图融合产生的多种误差,也是非常有意义的研究方向。

3 视觉SLAM待解决问题 3.1 计算力问题视觉SLAM中大量使用了运动恢复结构(SFM)中的方法,如特征点跟踪、集束优化等,以至于许多研究者把它们视为同一个研究领域。然而,尽管方法上很相似,但SLAM和SFM的侧重点是不同的。SLAM的应用场合主要在机器人和VR/AR,计算资源有限,需要很强的实时性,侧重于如何在有限的资源里快速地对相机进行定位。而SFM方法通常是离线的,可以调用大量计算资源进行长时间的计算,侧重于重建出更精确、美观的场景。因此,计算力是在自主移动机器人上运行视觉SLAM系统的重要考虑参数。

3.2 大规模地图构建自主移动机器人要想完成更为复杂的任务,大规模地图构建是十分重要的。无论使用哪种传感器,大规模地图构建都要考虑误差积累所带来的影响。对于视觉传感器,前端产生漂移对地图构建产生的影响也非常棘手,这样对后端优化的要求会更高。对于有限的硬件条件,还要使SLAM系统的计算量和存储不会随着构建地图规模的增大而无限增加,这就需要在SLAM系统中适当加入舍弃策略等。

3.3 视觉地图复用目前导航算法主要依赖于2D的栅格地图,实现较为容易。视觉地图中含有更多信息,尤其是大量物体的动态变化,比如室内床上含有丰富纹理信息的被子的更换、桌椅的挪动等。视觉地图中的信息还会受到光照等外部环境以及大量存在的干扰因素所带来的影响。如何有效利用视觉信息帮助导航(视觉重定位、回环检测、路径规划),仍需要更多的研究工作。

4 结束语视觉SLAM中有许多出色的研究已经应用于工业界。视觉SLAM运行条件较为苛刻,而其赋能的应用(机器人、自动驾驶、虚拟现实、增强现实等)都需要较高的精度和鲁棒性,因此产生了许多专注于动态场景的视觉SLAM工作。如何让视觉SLAM构建的地图更加精确、地图数据压缩得更小以及地图可复用、可维护等,是视觉SLAM的研究热点,也是视觉SLAM扩大应用场景的关键。得益于深度学习的快速发展,我们能够去获取场景中的语义信息,这些语义信息有助于更好地建图以及复用地图和更新地图,还可以作为导航的路标信息。研究人员也可以利用深度学习领域的技术,尝试将度量、拓扑、语义等相互结合,来探索视觉地图新的表示方法,尤其是高纬度的表达方法。

| [1] |

GRISETTI G, STACHNISS C, BURGARD W. Improved techniques for grid mapping with Rao-Blackwellized particle filters[J]. IEEE transactions on robotics, 2007, 23(1): 34-46. DOI:10.1109/TRO.2006.889486 (  0) 0) |

| [2] |

HARRIS C, STEPHENS M.A combined corner and edge detector[C]//Proceedings of the Alvey Vision Conference.Manchester, 1988: 1-6.

(  0) 0) |

| [3] |

ROSTEN E, DRUMMOND T. Machine learning for high-speed corner detection[M]//Computer Vision-ECCV 2006.Berlin: Springer, 2006: 430-443.

(  0) 0) |

| [4] |

QIN T, LI P L, SHEN S J. VINS-Mono: a robust and versatile monocular visual-inertial state estimator[J]. IEEE transactions on robotics, 2018, 34(4): 1004-1020. DOI:10.1109/TRO.2018.2853729 (  0) 0) |

| [5] |

LOWE D G.Object recognition from local scale-invariant features[C]//Proceedings of the International Conference on Computer Vision.Kerkyra, 1999: 1150-1157.

(  0) 0) |

| [6] |

BAY H, ESS A, TUYTELAARS T, et al. Speeded-up robust features (SURF)[J]. Computer vision and image understanding, 2008, 110(3): 346-359. DOI:10.1016/j.cviu.2007.09.014 (  0) 0) |

| [7] |

RUBLEE E, RABAUD V, KONOLIGE K, et al. ORB: an efficient alternative to SIFT or SURF[C]//Proceedings of the International Conference on Computer Vision.Barcelona, 2011: 2564-2571.

(  0) 0) |

| [8] |

DAVISON A J, REID I D, MOLTON N D, et al. MonoSLAM: real-time single camera SLAM[J]. IEEE transactions on pattern analysis and machine intelligence, 2007, 29(6): 1052-1067. DOI:10.1109/TPAMI.2007.1049 (  0) 0) |

| [9] |

KLEIN G, MURRAY D.Parallel tracking and mapping for small AR workspaces[C]//Proceedings of the 6th IEEE International Symposium on Mixed and Augmented Reality.Nara, 2007: 225-234.

(  0) 0) |

| [10] |

PIRE T, FISCHER T, CASTRO G, et al. S-PTAM: stereo parallel tracking and mapping[J]. Robotics and autonomous systems, 2017, 93: 27-42. DOI:10.1016/j.robot.2017.03.019 (  0) 0) |

| [11] |

MUR-ARTAL R, MONTIEL J M M, TARDOS J D. ORB-SLAM: a versatile and accurate monocular SLAM system[J]. IEEE transactions on robotics, 2015, 31(5): 1147-1163. DOI:10.1109/TRO.2015.2463671 (  0) 0) |

| [12] |

NEWCOMBE R A, LOVEGROVE S J, DAVISON A J. DTAM: Dense tracking and mapping in real-time[C]//Proceedings of the International Conference on Computer Vision.Barcelona, 2011: 2320-2327.

(  0) 0) |

| [13] |

ENGEL J, SCHÖPS T, CREMERS D.LSD-SLAM: large-scale direct monocular SLAM[M]//Computer Vision-ECCV 2014. Cham: Springer, 2014: 834-849.

(  0) 0) |

| [14] |

FORSTER C, PIZZOLI M, SCARAMUZZA D.SVO: fast semi-direct monocular visual odometry[C]//IEEE International Conference on Robotics and Automation.Hong Kong, 2014: 15-22.

(  0) 0) |

| [15] |

ENGEL J, KOLTUN V, CREMERS D. Direct sparse odometry[J]. IEEE transactions on pattern analysis and machine intelligence, 2018, 40(3): 611-625. DOI:10.1109/TPAMI.2017.2658577 (  0) 0) |

| [16] |

GAO X, WANG R, DEMMEL N, et al. LDSO: direct sparse odometry with loop closure[C]//IEEE International Conference on Intelligent Robots and Systems.Madrid, 2018: 2198-2204.

(  0) 0) |

| [17] |

LEE S H, CIVERA J. Loosely-coupled semi-direct monocular SLAM[J]. IEEE robotics and automation letters, 2019, 4(2): 399-406. DOI:10.1109/LRA.2018.2889156 (  0) 0) |

| [18] |

LI R H, WANG S, LONG Z Q, et al. UnDeepVO: monocular visual odometry through unsupervised deep learning[C]//IEEE International Conference on Robotics and Automation. Brisbane, 2018: 7286-7291.

(  0) 0) |

| [19] |

LOO S, AMIRI A, MASHOHOR S, et al.CNN-SVO: improving the mapping in semi-direct visual odometry using single-image depth prediction[C]//IEEE International Conference on Robotics and Automation.Montreal, 2019: 5218-5223.

(  0) 0) |

| [20] |

MCCORMAC J, HANDA A, DAVISON A, et al. SemanticFusion: dense 3D semantic mapping with convolutional neural networks[C]//IEEE International Conference on Robotics and Automation. Singapore, 2017: 4628-4635.

(  0) 0) |

| [21] |

WHELAN T, LEUTENEGGER S, SALAS MORENO R, et al. ElasticFusion: dense SLAM without a pose graph[C]//Robotics: Science and Systems Conference.Rome, 2015: 1-11.

(  0) 0) |

| [22] |

RVNZ M, BUFFIER M, AGAPITO L.MaskFusion: real-time recognition, tracking and reconstruction of multiple moving objects[C]//Proceedings of the 17th IEEE International Symposium on Mixed and Augmented Reality. Munich, 2018: 10-20.

(  0) 0) |

| [23] |

LICHTSTEINER P, POSCH C, DELBRUCK T. A 128×128 120 dB 15 μs latency asynchronous temporal contrast vision sensor[J]. IEEE journal of solid-state circuits, 2008, 43(2): 566-576. DOI:10.1109/JSSC.2007.914337 (  0) 0) |

| [24] |

YU C, LIU Z X, LIU X J, et al.DS-SLAM: a semantic visual SLAM towards dynamic environments[C]//IEEE International Conference on Intelligent Robots and Systems.Madrid, 2018: 1168-1174.

(  0) 0) |

| [25] |

BESCOS B, FACIL J M, CIVERA J, et al. DynaSLAM: tracking, mapping, and inpainting in dynamic scenes[J]. IEEE robotics and automation letters, 2018, 3(4): 4076-4083. DOI:10.1109/LRA.2018.2860039 (  0) 0) |

| [26] |

HE K M, GKIOXARI G, DOLLAR P, et al.Mask R-CNN[C]//Proceedings of the IEEE International Conference on Computer Vision. Venice, 2017: 2961-2969.

(  0) 0) |

| [27] |

ROSINOL A, ABATE M, CHANG Y, et al.Kimera: an open-source library for real-time metric-semantic localization and mapping[EB/OL]. [2020-08-03]. https://arxiv.org/abs/1910.02490.

(  0) 0) |

| [28] |

ROSINOL A, GUPTA A, ABATE M, et al.3D dynamic scene graphs: actionable spatial perception with places, objects, and humans[EB/OL]. [2020-08-03]. http://arxiv.org/pdf/2002.06289.pdf.

(  0) 0) |

| [29] |

ZOU D P, TAN P. CoSLAM: collaborative visual SLAM in dynamic environments[J]. IEEE transactions on pattern analysis and machine intelligence, 2013, 35(2): 354-366. DOI:10.1109/TPAMI.2012.104 (  0) 0) |

| [30] |

SCHMUCK P, CHLI M.Multi-UAV collaborative monocular SLAM[C]//IEEE International Conference on Robotics and Automation. Singapore, 2017: 3863-3870.

(  0) 0) |

2021, Vol. 53

2021, Vol. 53