2. 宁夏智能信息与大数据处理重点实验室(北方民族大学) 宁夏 银川 750021;

3. 同济大学 电子与信息工程学院 上海 201804

2. Ningxia Key Laboratory of Intelligent Information and Big Data Processing(North Minzu University), Yinchuan 750021, China;

3. School of Electronics and Information Science, Tongji University, Shanghai 201804, China

高斯混合模型(Gaussian mixture model,GMM)的实质是通过多个高斯函数的加权平均和来刻画样本数据的分布。使用GMM进行聚类时,将数据视作若干高斯分布的加权组合,每个高斯分布均为一个类簇,选择所属概率最大的类簇作为对数据的划分结果。Huang等[1]针对GMM需要事先确定聚类数目的问题,将探路者算法与高斯混合聚类相结合,根据数据集自动确定最优聚类数目。Wang等[2]针对GMM聚类算法中需要更多的迭代次数和通信开销的问题,提出了基于迁移学习的分布式聚类GMM,利用迁移分布式GMM聚类框架提升聚类性能,加速聚类收敛。Zhang等[3]针对GMM无法有效解决数据缺失的问题,提出由GMM聚类的结果填充缺失的数据,然后将插补数据用于GMM聚类。程宏兵等[4]提出了基于GMM和自适应簇数的文本聚类算法,自适应文本聚类数量并获得其分布,实现海量文本的精确聚类。陈佳琪等[5]从估计给定数据集的未知概率密度函数入手,建立了核密度估计与GMM之间的关联,提出了基于统计感知策略的GMM求解方法。

针对隶属关系不明确会导致GMM聚类存在较大的误判风险的问题,万仁霞等[6]将三支决策思想融入GMM中,提出一种基于三支决策的高斯混合聚类模型(three-way Gaussian mixture model,T-GMM),有效减小误判代价。然而,GMM和T-GMM在高维空间中进行聚类时,数据的稀疏性会干扰算法的聚类过程,从而影响聚类结果的准确性,降低算法的聚类质量。

属性约简是高维数据处理的一种重要手段,基于粗糙集理论的属性约简方法已经形成较为完备的理论体系[7-10]。粗糙集理论(rough set,RS)[11]是由波兰数学家Pawlak于1982年所提出的一种处理不确定性知识的数学工具。模糊粗糙集[12]是粗糙集的一种模糊推广,依赖先验知识去设定隶属函数。邻域粗糙集(neighborhood rough set,NRS)[13]则可以不依赖隶属函数和先验知识就能进行属性约简。在使用NRS进行属性约简时,当多个属性具有相同的重要程度时,Jia等[14]通过比较属性的信息熵进行属性约简,并对约简后的数据集进行光谱聚类,使最终的聚类结果更接近真实类簇,从而获得更高的聚类精度。

虽然NRS相比其他粗糙集具有诸多优点,但其需要通过网格搜索的方式对半径参数寻优,造成大量的时间消耗。粒球邻域粗糙集(granular ball neighborhood rough set,GBNRS)[15]不仅沿袭了NRS不依赖隶属函数和先验知识的优点,同时能够依据数据分布,自适应地生成合适的粒结构[16]。为提高三支高斯混合聚类模型在高维空间的聚类质量,本文将GBNRS约简技术引入聚类过程,提出了基于GBNRS的三支高斯混合聚类。所提算法可有效消除冗余属性,提高三支高斯混合聚类在高维空间中的聚类质量,并且能够更准确地刻画类簇的边界信息。

1 相关理论 1.1 粒球邻域粗糙集定义1 [17]

| $ \boldsymbol{Q}=\frac{1}{m} \sum\limits_{d=1}^m \boldsymbol{u}_d, $ | (1) |

| $ r=\max \left\{dist\left(\boldsymbol{u}_d, \boldsymbol{Q}\right) \mid \boldsymbol{u}_d \in G B\right\}, $ | (2) |

| $ H(G B)=\frac{\left|\left\{\boldsymbol{u}_d \in G B, Y\left(\boldsymbol{u}_d\right)=Y(G B)\right\}\right|}{|G B|}, $ | (3) |

其中:

定义2 [15] 给定实数空间上的非空有限集合

| $ r\left(\boldsymbol{u}_i\right)=\left\{\boldsymbol{u} \mid \forall \boldsymbol{u} \in G B_t, \left\|\boldsymbol{u}, \boldsymbol{Q}_t\right\| \leqslant r_t\right\}, $ |

其中:

根据定义2可以看出,ui的r-邻域就是与其同属一个粒球中的数据点所构成的集合。

定义3 [15] 给定邻域决策信息系统〈U, C, D〉,决策属性集D将U划分为N个等价类:X1, X2, …, XN。C为条件属性集,对于

| $ \underline{B } D^{\prime}=\bigcup\limits_{l=1}^N \underline{B } X_l^{\prime} \text { 。} $ |

式中,

| $ \underline{B }X_l^{\prime}=\left\{\left.\boldsymbol{c}_t^{\prime}=\frac{1}{m_t} \sum\limits_{d=1}^{m_t} \boldsymbol{u}_d \right\rvert\, \boldsymbol{u}_d \in G B_t(B), r\left(\boldsymbol{u}_d\right) \subseteq X_l\right\}, $ |

其中:mt表示第t个粒球中样本的数量。

D的生成正域定义为

| $ \operatorname{GPOS}_B(D)=\underline{B }D^{\prime} \text { 。} $ |

定义4 [15] 给定邻域决策信息系统〈U, C, D〉,对于

| $ \begin{gathered} \operatorname{GPOS}_B(D)=\operatorname{GPOS}_C(D), \\ \operatorname{GPOS}_B(D) \neq \operatorname{GPOS}_{B-\{b\}}(D), b \subseteq B_{\circ} \end{gathered} $ |

粗糙集通常在保持正域不变的条件下进行属性约简,与之同理,在定义4中GBNRS通过保持粒球的生成正域不变来进行约简。

1.2 三支聚类Yu[18]将三支决策思想引入数据的聚类分析中,提出了三支聚类的算法框架。对于每个类簇,三支聚类将论域U划分为核心域Co、边界域Fr和琐碎域Tr。核心域中的对象肯定属于该簇,边界域中的对象可能属于也可能不属于该簇,琐碎域中的对象肯定不属于该簇[19]。三支聚类中的每个类通过核心域和边界域的二元组来表示,即Z={Co, Fr}。对于每个数据对象ui,聚类决策规则为

| $ \text { 若 } P\left(Z_j \mid \boldsymbol{u}_i\right) \geqslant \alpha \text {, 则 } \boldsymbol{u}_i \in C o(j) \text {; } $ |

| $ \text { 若 } \beta <P\left(Z_j \mid \boldsymbol{u}_i\right)<\alpha \text { ,则 } \boldsymbol{u}_i \in \operatorname{Fr}(j) \text { 。} $ |

式中,

| $ \left\{\begin{array}{l} \alpha=\frac{\lambda_{\mathrm{PN}}-\lambda_{\mathrm{BN}}}{\left(\lambda_{\mathrm{PN}}-\lambda_{\mathrm{BN}}\right)-\left(\lambda_{\mathrm{BP}}-\lambda_{\mathrm{PP}}\right)}, \\ \beta=\frac{\lambda_{\mathrm{PN}}-\lambda_{\mathrm{NN}}}{\left(\lambda_{\mathrm{BN}}-\lambda_{\mathrm{NN}}\right)-\left(\lambda_{\mathrm{NP}}-\lambda_{\mathrm{BP}}\right)}, \end{array}\right. $ | (4) |

其中:λPP、λBP、λNP分别表示当对象属于第j类时,将其划分到该类核心域、边界域和琐碎域的损失代价;λPN、λBN、λNN分别表示当对象不属于第j类时,将其划分到该类核心域、边界域和琐碎域的损失代价[20]。

由决策规则可以得到三支聚类结果,

| $ C S=\{(C o(1), F r(1)), \cdots, (C o(K), F r(K))\}, $ |

其中:K为类簇个数。

1.3 高斯混合聚类 [21]高斯混合分布

| $ P_M(\boldsymbol{u})=\sum\limits_{j=1}^K p_j \cdot P\left(\boldsymbol{u} \mid \boldsymbol{\mu}_j, \boldsymbol{\Sigma}_j\right), $ |

其中:

令随机变量zi∈{1, 2, …, K}表示生成样本ui的高斯混合成分,根据贝叶斯定理可以得出样本ui由第j个高斯混合成分生成的后验概率,

| $ \omega_i^j=P_M\left(z_i=j \mid \boldsymbol{u}_i\right)=p_j \cdot \frac{P\left(\boldsymbol{u}_i \mid \boldsymbol{\mu}_j, \boldsymbol{\Sigma}_j\right)}{\sum\limits_{h=1}^K p_h \cdot P\left(\boldsymbol{u}_i \mid \boldsymbol{\mu}_h, \boldsymbol{\Sigma}_h\right)}, $ | (5) |

| $ L_i=\operatorname{argmax} \omega_i^j, $ | (6) |

其中:Li为样本ui的最大后验概率,其所属类簇即为对ui的划分结果。当存在多个近似的后验概率时,GMM对样本做出误判的风险增大。

2 基于粒球邻域粗糙集的三支高斯混合聚类算法相较于NRS使用固定的邻域半径,GBNRS通过适应不同粒球的尺寸来拟合数据分布,提供了更高的灵活性,并能实现更精确的聚类结果。本文提出了基于粒球邻域粗糙集的三支高斯混合聚类(three-way Gaussian mixture clustering model based on granular ball neighborhood rough set),简称为GBT-GMM算法。该算法的主要目的是在高维空间进行高斯混合聚类时,为了降低数据稀疏性的影响,通过使用GBNRS对数据进行属性约简处理。

2.1 粒球集生成粒球集生成在本文算法中具有重要意义,其主要思想为:对于数据对象集

GBT-GMM算法具体步骤如下。

输入:样本集U,属性集A={a1, a2, …, ae},粒球纯度阈值θ,最大迭代次数I,收敛阈值ε,决策参数λPP、λNN、λNP、λPN、λBP、λBN。

输出:约简后属性集A,类簇划分结果。

Step 1 初始化A为A,高斯混合分布模型参数

Step 2 在U上生成粒球集,然后从粒球集中去掉只包含一个对象的粒球,以剩下的粒球数为聚类簇数,粒球的中心为初始质心,对剔除离群点的数据集进行k-means聚类,获得新粒球集。

Step 3 去掉纯度低于阈值θ的粒球,生成正域由纯度不低于θ的粒球的中心组成。

Step 4 如果从属性集A中去掉属性av后,以生成正域中的粒球中心为初始质心,再次使用k-means聚类获得新粒球集。若所有粒球的纯度都不低于阈值,表示生成正域不变,应删除属性

Step 5 如果Step 4中存在纯度低于θ的粒球,则保留属性av。从A中选择一个新属性,回到Step 4,直至所有属性检查完毕,输出约简后的属性集。

Step 6 对约简后的数据集,根据(5)式计算ui由各混合成分生成的后验概率ωij,更新参数p′j,μ′j和Σ′j。

Step 7 更新

Step 8 根据(4)式计算决策阈值α和β,根据(6)式计算对象

Step 9 输出划分结果,

| $ C S=\{(C o(1), F r(1)), \cdots, (C o(K), F r(K))\} 。$ |

在Step 2中实现粒球集生成时,利用k-means算法对不满足纯度阈值要求的粒球进行分割,将每个类簇都视为一个子球。因为聚类后各类簇中的数据具有更高的相似性,所以相较于分割前,分割后的子球具有更高的纯度。对子球的纯度继续进行考察,若满足纯度要求,则停止分割,否则使用k-means算法继续分割,直至每个粒球的纯度都不低于纯度阈值。通过Step 4~Step 7对数据进行属性约简,并为聚类决策提供后验概率的计算依据,即在粒球集的基础上,对约简后的数据集计算对象由每个混合成分生成的后验概率。最后,将最大的后验概率与决策阈值α和β进行比较,从而将对象划分到类簇的核心域或边界域。在Step 6中,使用如下公式更新参数:

| $ \begin{gathered} p_j^{\prime}=\frac{1}{n} \sum\limits_{i=1}^n \omega_i^j, \\ \boldsymbol{\mu}_j^{\prime}=\frac{\sum\limits_{i=1}^n \omega_i^j \boldsymbol{u}_i}{\sum\limits_{i=1}^n \omega_i^j}, \\ \boldsymbol{\Sigma}_j^{\prime}=\frac{\sum\limits_{i=1}^n \omega_i^j\left(\boldsymbol{u}_i-\boldsymbol{\mu}_j\right)\left(\boldsymbol{u}_i-\boldsymbol{\mu}_j\right)^{\mathrm{T}}}{\sum\limits_{i=1}^n \omega_i^j} 。\end{gathered} $ |

实验采用Python3.11.2语言编写,处理器为Intel(R) Core(TM) i7-9700(3.00 GHz),存储器为16.0 GB,Windows 10操作系统,集成开发环境为PyCharm。实验使用的7个数据集均来自UCI数据库,相关信息见表 1。

|

|

表 1 实验数据集信息 Tab. 1 Experimental dataset information |

实验依据3种指标(准确率、戴维森堡丁指数和轮廓系数)对聚类效果进行评价。

1) 准确率(Acc)[22]的计算公式为

| $ A c c=\frac{n^{\mathrm{TT}}+n^{\mathrm{NN}}}{n^{\mathrm{TT}}+n^{\mathrm{TN}}+n^{\mathrm{NT}}+n^{\mathrm{NN}}}, $ |

其中:nTT表示实际为正,被检测为正的样本数;nNN表示实际为负,被检测为负的样本数;nTN表示实际为正,被检测为负的样本数;nNT表示实际为负,被检测为正的样本数。Acc值越高,聚类效果越好。

2) 戴维森堡丁指数(DBI)[23]的计算公式为

| $ D B I=\frac{1}{K} \sum\limits_{j=1}^K \max\limits_{j \neq q}\left(\frac{f_j+f_q}{\left\|o_j-o_q\right\|^2}\right), $ |

其中:f表示类中的所有样本数据到聚类中心o的平均距离;

3) 轮廓系数(SC)[24]的计算公式为

| $ \begin{gathered} S C=\frac{1}{n} \sum\limits_{i=1}^n S_i, \\ S_i=\frac{w_i-g_i}{\max \left(g_i, w_i\right)}, w_i=\min \left\{M\left(\boldsymbol{u}_i-Z_j\right)\right\}, \end{gathered} $ |

其中:Si为单个样本ui的轮廓系数;gi为样本ui到所属簇中其他样本的平均距离;

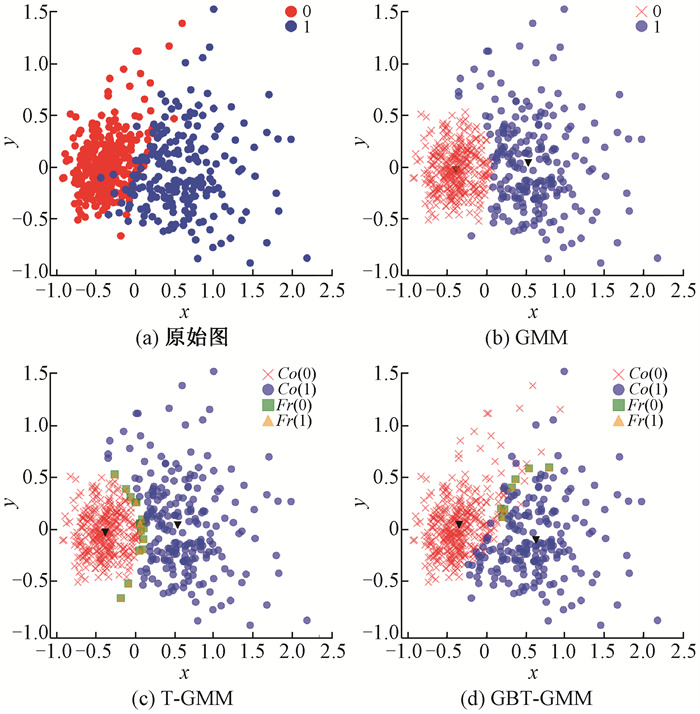

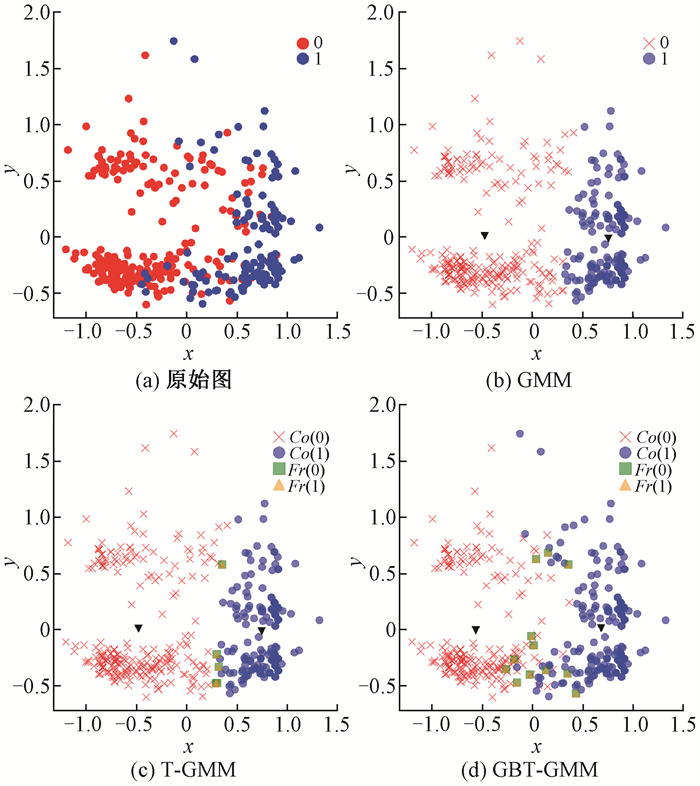

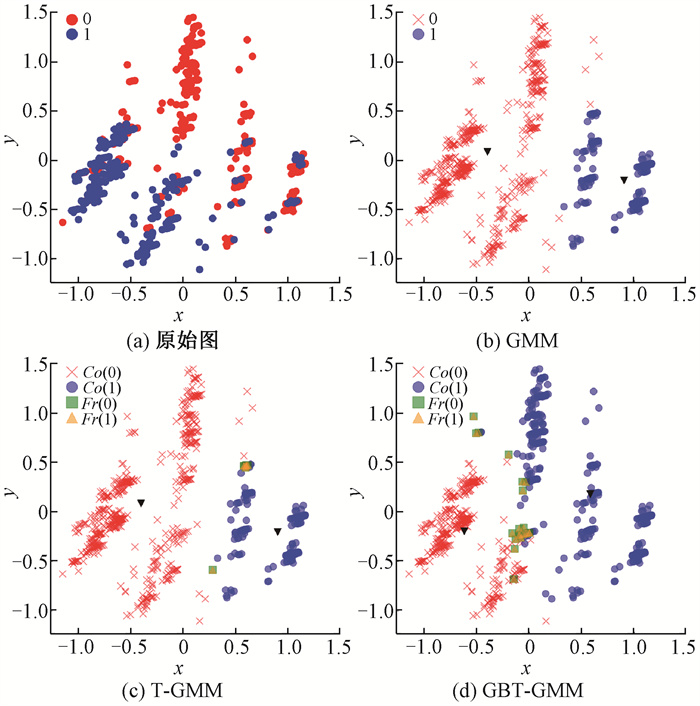

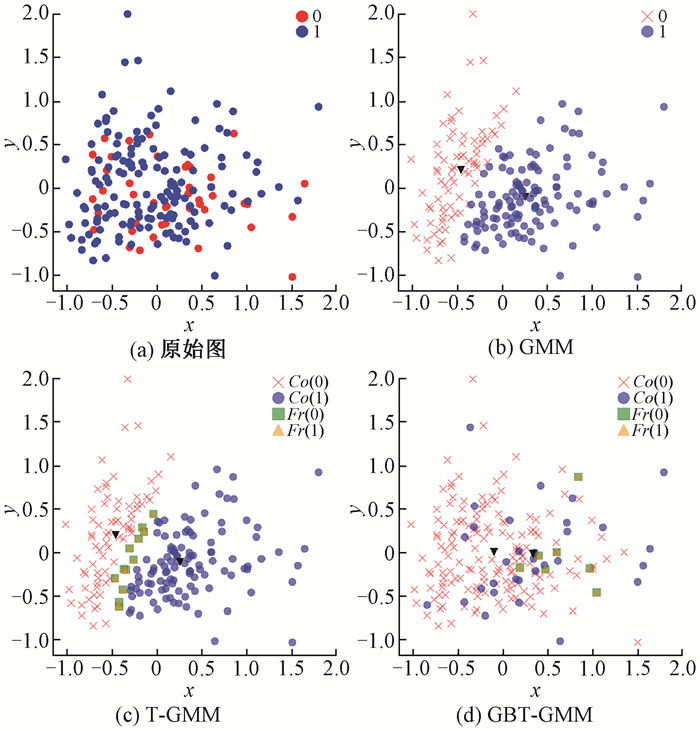

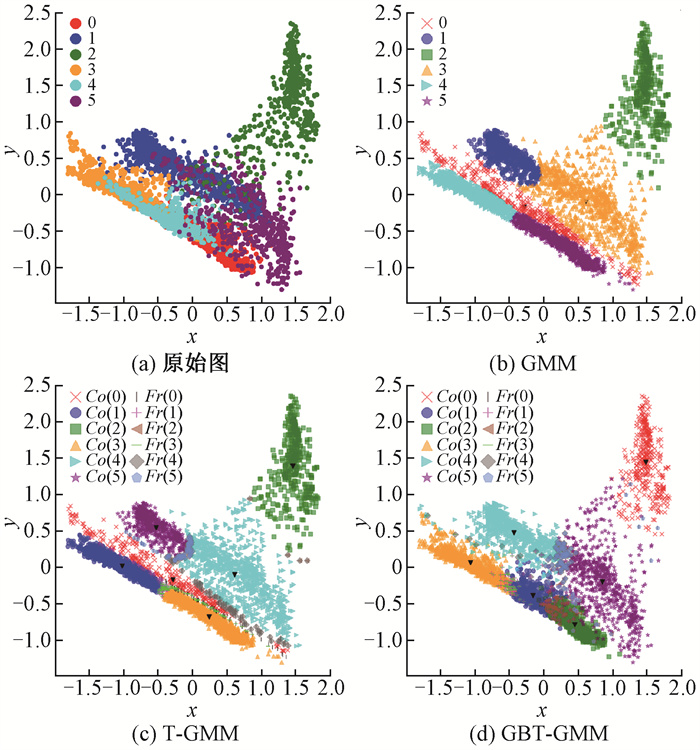

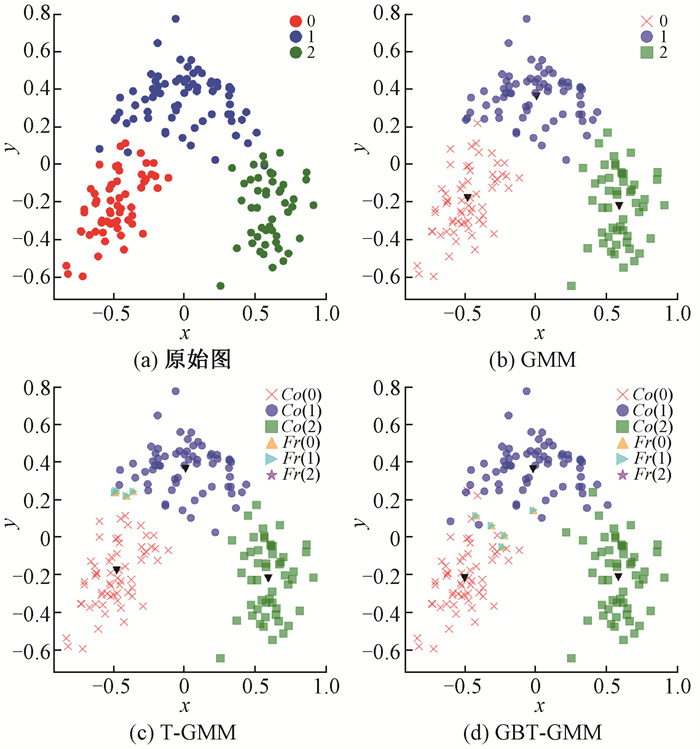

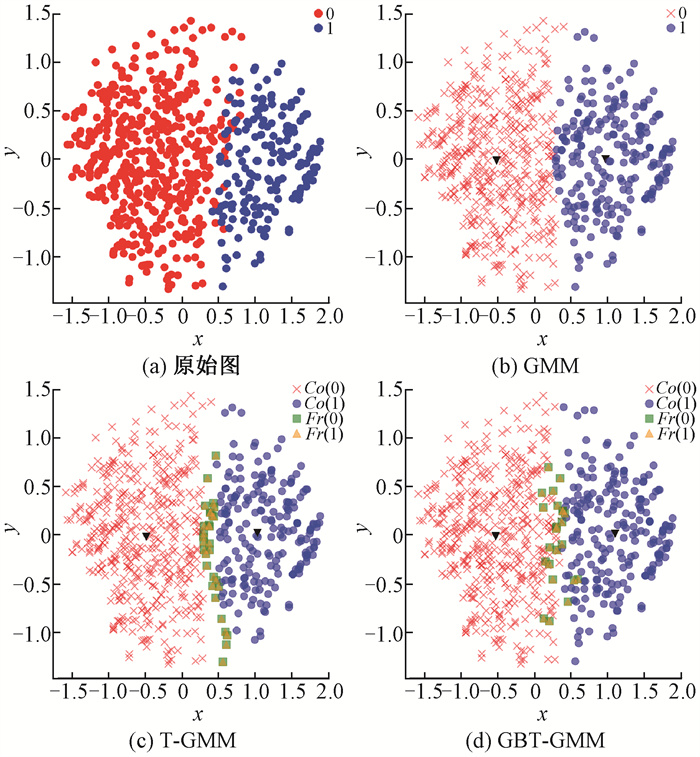

在实验过程中设定λPP=0,λNN=0,λNP=18,λPN=8,λBP=9,λBN=4,根据式(4)计算得到阈值参数为α=0.615,β=0.308。最大迭代次数I设定为100,收敛阈值ε设定为0.001[6],纯度阈值设定为1。图 1~图 7分别给出了7个数据集上GMM[21]、T-GMM[6]与GBT-GMM算法的聚类结果,图中x,y为二维笛卡尔坐标系的坐标轴,Co(i)为类簇i的核心域,Fr(i)为类簇i的边界域,黑色倒三角为类簇中心。

|

图 1 wdbc数据集上不同算法的聚类结果 Fig. 1 Clustering results of different algorithms on wdbc dataset |

|

图 2 housevote数据集上不同算法的聚类结果 Fig. 2 Clustering results of different algorithms on housevote dataset |

|

图 3 tcga数据集上不同算法的聚类结果 Fig. 3 Clustering results of different algorithms on tcga dataset |

|

图 4 wpbc数据集上不同算法的聚类结果 Fig. 4 Clustering results of different algorithms on wpbc dataset |

|

图 5 lansat数据集上不同算法的聚类结果 Fig. 5 Clustering results of different algorithms on lansat dataset |

|

图 6 wine数据集上不同算法的聚类结果 Fig. 6 Clustering results of different algorithms on wine dataset |

|

图 7 autism数据集上不同算法的聚类结果 Fig. 7 Clustering results of different algorithms on autism dataset |

从图 1~图 7可以直观地看出,GBT-GMM在高维空间中对类簇的划分更加接近原始数据的真实分布。为了进一步验证GBT-GMM的聚类质量,对GBT-GMM、T-GMM和GMM在选定的评价指标下进行实验对比,结果见表 2。可以看出,GBT-GMM在这7个数据集上相比其他算法具有更高的SC值和更低的DBI值。同时,除了wine和autism两个数据集,GBT-GMM在其他5个数据集上还具有更高的Acc值。表明在这些数据集上,GBT-GMM的聚类效果总体上优于两种对比算法。在autism数据集上,虽然GBT-GMM的Acc指标略逊于T-GMM,但差值非常小,通常属于正常的误差波动,对聚类效果的影响有限,但GBT-GMM在SC和DBI值上优势明显。对于wine数据集,GBT-GMM在Acc值上略低于对比算法,由图 6可见,类簇之间重叠部分较小,分布较为均匀,很难进一步提升准确率。

|

|

表 2 不同算法的评价指标对比 Tab. 2 Comparison of evaluation indicators of different algorithms |

GBT-GMM具有良好的聚类性能,其属性约简策略起到了重要作用。表 3中展示了GBT-GMM对7个实验数据集的属性约简结果。可以看出,约简后7个数据集的属性数均显著减少,达到了去除不相关或冗余属性的目的,减少了计算处理的消耗。属性约简后,避免了过多无关信息的干扰,模型聚类效果得到提升,进一步验证了属性约简的有效性。

|

|

表 3 属性约简结果 Tab. 3 Results of attribute reduction |

GMM和T-GMM算法的时间复杂度均为O(neK),其中n为样本点的数量,e为数据维度,K为混合成分的数量。使用GBNRS约简的时间复杂度为O(n)[15],设约简后数据维度为e′,则GBT-GMM算法的总体时间复杂度为O(ne′K)。由于e′ < e,因而GBT-GMM比GMM和T-GMM具有更小的时间复杂度。

综上所述,本文提出的GBT-GMM在实验数据集上具有较好的聚类效果,达到了其对高维空间数据属性约简的目的。

4 结语本文在三支高斯混合聚类的基础上,结合GBNRS理论来提升算法在高维空间的聚类质量。所提出的GBT-GMM继承了T-GMM优越的聚类性能,实现了对高维数据的属性约简效果。实验结果表明,本文算法相较于对比算法,整体上具有更高的Acc和SC值以及更低的DBI值,能够有效消除冗余属性对高维聚类的负面影响,保留数据集的关键信息,使类簇之间更加紧凑,对类簇边界部分的刻画也更加准确。由于GMM使用EM算法来估计参数,在未来的工作中,将针对EM算法本身存在的缺陷进行优化,以进一步提高GBT-GMM的聚类效果,并在相关领域进行应用研究。

| [1] |

HUANG H J, LIAO Z P, WEI X X, et al. Combined Gaussian mixture model and pathfinder algorithm for data clustering[J]. Entropy, 2023, 25(6): 946. (  0) 0) |

| [2] |

WANG R R, HAN S Y, ZHOU J, et al. Transfer-learning-based Gaussian mixture model for distributed clustering[J]. IEEE transactions on cybernetics, 2023, 53(11): 7058-7070. (  0) 0) |

| [3] |

ZHANG Y, LI M M, WANG S W, et al. Gaussian mixture model clustering with incomplete data[J]. ACM transactions on multimedia computing, communications, and applications, 2021, 17(1): 1-14. (  0) 0) |

| [4] |

程宏兵, 王本安, 陈友荣, 等. 基于高斯混合模型和自适应簇数的文本聚类[J]. 浙江工业大学学报, 2023, 51(6): 602-609. CHENG H B, WANG B A, CHEN Y R, et al. Text clustering based on Gaussian mixture model and self-adaptive number of clusters[J]. Journal of Zhejiang university of technology, 2023, 51(6): 602-609. (  0) 0) |

| [5] |

陈佳琪, 何玉林, 黄哲学, 等. 基于统计感知策略的高斯混合模型求解方法[J]. 数据采集与处理, 2023, 38(3): 525-538. CHEN J Q, HE Y L, HUANG Z X, et al. Solution method of Gaussian mixture model with statistical aware strategy[J]. Journal of data acquisition and processing, 2023, 38(3): 525-538. (  0) 0) |

| [6] |

万仁霞, 王大庆, 苗夺谦. 基于三支决策的高斯混合聚类研究[J]. 重庆邮电大学学报(自然科学版), 2021, 33(5): 806-815. WAN R X, WANG D Q, MIAO D Q. Gaussian mixture clustering based on three-way decision[J]. Journal of Chongqing university of posts and telecommunications (natural science edition), 2021, 33(5): 806-815. (  0) 0) |

| [7] |

徐晔, 许晴媛, 李进金. 基于集覆盖理论的覆盖信息系统属性约简方法[J]. 郑州大学学报(理学版), 2024, 56(1): 60-67. XU Y, XU Q Y, LI J J. Attribute reduction method for covering information system based on set covering theory[J]. Journal of Zhengzhou university (natural science edition), 2024, 56(1): 60-67. DOI:10.13705/j.issn.1671-6841.2022264 (  0) 0) |

| [8] |

XU J C, YUAN M, MA Y Y. Feature selection using self-information and entropy-based uncertainty measure for fuzzy neighborhood rough set[J]. Complex & intelligent systems, 2022, 8(1): 287-305. (  0) 0) |

| [9] |

HE J L, QU L D, WANG Z H, et al. Attribute reduction in an incomplete categorical decision information system based on fuzzy rough sets[J]. Artificial intelligence review, 2022, 55(7): 5313-5348. (  0) 0) |

| [10] |

季雨瑄, 叶军, 杨震宇, 等. 结合分辨矩阵改进的邻域粗糙集属性约简算法[J]. 山东大学学报(工学版), 2022, 52(4): 99-109. JI Y X, YE J, YANG Z Y, et al. An improved neighborhood rough set attribute reduction algorithm combined with resolution matrix[J]. Journal of Shandong university (engineering science), 2022, 52(4): 99-109. (  0) 0) |

| [11] |

PAWLAK Z. Rough sets[J]. International journal of computer & information sciences, 1982, 11(5): 341-356. (  0) 0) |

| [12] |

DUBOIS D, PRADE H. Rough fuzzy sets and fuzzy rough sets[J]. International journal of general systems, 1990, 17(2/3): 191-209. (  0) 0) |

| [13] |

HU Q H. Numerical attribute reduction based on neighborhood granulation and rough approximation[J]. Journal of software, 2008, 19(3): 640-649. (  0) 0) |

| [14] |

JIA H J, DING S F, MA H, et al. Spectral clustering with neighborhood attribute reduction based on information entropy[J]. Journal of computers, 2014, 9(6): 1316-1324. (  0) 0) |

| [15] |

XIA S Y, ZHANG H, LI W H, et al. GBNRS: a novel rough set algorithm for fast adaptive attribute reduction in classification[J]. IEEE transactions on knowledge and data engineering, 2022, 34(3): 1231-1242. (  0) 0) |

| [16] |

巴婧, 陈妍, 杨习贝. 快速求解粒球粗糙集约简的属性划分方法[J]. 南京理工大学学报(自然科学版), 2021, 45(4): 394-400. BA J, CHEN Y, YANG X B. Attribute partition strategy for quick searching reducts based on granular ball rough sets[J]. Journal of Nanjing university of science and technology, 2021, 45(4): 394-400. (  0) 0) |

| [17] |

XIA S Y, LIU Y S, DING X, et al. Granular ball computing classifiers for efficient, scalable and robust learning[J]. Information sciences, 2019, 483: 136-152. (  0) 0) |

| [18] |

YU H. A framework of three-way cluster analysis[C]//Proceedings of the International Joint Conference on Rough Sets. Cham: Springer International Publishing, 2017: 300-312.

(  0) 0) |

| [19] |

康凯, 胡军. 基于三支聚类的协同过滤推荐方法[J]. 郑州大学学报(理学版), 2022, 54(3): 22-27. KANG K, HU J. Collaborative filtering recommendation method based on three-way clustering[J]. Journal of Zhengzhou university (natural science edition), 2022, 54(3): 22-27. DOI:10.13705/j.issn.1671-6841.2021237 (  0) 0) |

| [20] |

方莲娣, 张燕平, 陈洁, 等. 基于三支决策的非重叠社团划分[J]. 智能系统学报, 2017, 12(3): 293-300. FANG L D, ZHANG Y P, CHEN J, et al. Three-way decision based on non-overlapping community division[J]. CAAI transactions on intelligent systems, 2017, 12(3): 293-300. (  0) 0) |

| [21] |

何明, 冯博琴, 马兆丰, 等. 一种基于高斯混合模型的无监督粗糙聚类方法[J]. 哈尔滨工业大学学报, 2006, 38(2): 256-259. HE M, FENG B Q, MA Z F, et al. An unsupervised rough clustering method based on Gaussian mixture model[J]. Journal of Harbin institute of technology, 2006, 38(2): 256-259. (  0) 0) |

| [22] |

AHMED M, SERAJ R, ISLAM S M S. The k-means algorithm: a comprehensive survey and performance evaluation[J]. Electronics, 2020, 9(8): 1295. (  0) 0) |

| [23] |

罗舒文, 万仁霞, 苗夺谦. 基于簇中心预选策略的三支决策密度峰值聚类算法[J]. 山西大学学报(自然科学版), 2024, 47(1): 30-39. LUO S W, WAN R X, MIAO D Q. Three-way decision-based density peak clustering algorithm with clustering centers preselection[J]. Journal of Shanxi university (natural science edition), 2024, 47(1): 30-39. (  0) 0) |

| [24] |

LAYTON R, WATTERS P, DAZELEY R. Evaluating authorship distance methods using the positive Silhouette coefficient[J]. Natural language engineering, 2013, 19(4): 517-535. (  0) 0) |

2025, Vol. 57

2025, Vol. 57