2. 河北省工业智能感知重点实验室 河北 唐山 063210

2. Hebei Provincial Key Laboratory of Industrial Intelligent Perception, Tangshan 063210, China

显著目标检测(salient object detection, SOD)旨在从视觉场景中准确地检测和分割最具吸引力的物体,在各种计算机视觉研究中, 如视频对象分割、光场图像分割、目标跟踪[1]和实例分割[2]等, 都起着重要作用。然而,目前的SOD方法大多数使用单一的RGB图像进行检测,这使它们易受天气、光照等因素影响,无法获得精确的检测结果。近年来,随着传感器技术的飞速发展,研究者们可以在不同的模态下对物体进行成像。其中,红外传感器可以生成包含物体温度信息的热红外图像,这种图像可以提供更多空间位置线索,能够为提高SOD性能提供重要的信息补充。因此,基于热模态信息与RGB信息的RGB-热成像显著目标检测(RGB-T SOD)越来越受到研究者们的关注。2019年,Tu等[3]使用了多模态多尺度流形排序的方法来处理RGB-T SOD任务中的两种模态特征,并通过中间变量推断最优排序种子进行显著性预测。Zhang等[4]同样使用特征融合的方式来处理RGB-T SOD,他们将融合过程分为三个部分,首先组合相邻的深度特征,然后捕捉跨模态特征,最后通过集成多级融合特征预测显著性图。2023年,Lv等[5]提出一个跨模态注意力增强网络,该网络首先通过交叉注意力单元来增强两个模态的特征,然后使用通道注意力对它们进行动态加权融合。然而,这些方法都侧重通过同层级特征融合的方式来处理两种模态的信息,并没有充分考虑多模态跨层级间的特征互补性。

在RGB-T SOD中,热红外图像能更好地定位空间位置信息,RGB图像则可以更好地展示细节纹理。同时,在神经网络中,较浅层的特征中包含了丰富的细节和纹理信息。随着网络层数的加深,网络则会越来越关注对象整体的语义,这些信息在网络检测物体时分别发挥着重要作用。因此如何充分学习不同模态与不同层级间的互补信息是进行准确RGB-T SOD的关键。其中的一个解决方案是实现多模态信息之间的充分交互,并利用跨层级信息获得更丰富的多尺度特征,而这在很大程度上被当前的方法所忽略。

综合考虑上述问题,本文提出了一种跨层级特征注意力学习网络(CALNet),通过学习跨层级的多模态互补特征,以获得更好的RGB-T SOD性能。它使用编解码体系结构,在编码部分,网络采用两个基于ConvNeXt的编码器对输入的RGB图像与热成像图像进行双流特征编码。在解码部分,网络首先通过所提出的跨层级注意力学习模块(CAL)对编码器中不同模态与不同层级间的特征进行交互。之后,使用全局信息模块(GIM)生成全局指导特征,以引导多交互模块(MIB)对编码器的各层级特征进行逐层解码,并生成最终预测结果。在三个数据集上进行的实验表明,所提出的网络在四个评估指标上优于目前主流的方法。

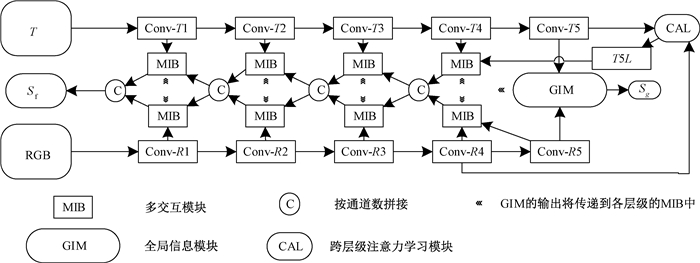

1 跨层级特征注意力学习网络 1.1 总体架构如图 1所示,本文的网络整体采用双流编解码架构。编码阶段,网络使用基于ConvNeXt的双流编码器分别对可见光和热红外图像进行特征提取。在解码阶段,网络首先使用跨层级注意力学习模块(CAL)对不同层级的多模态特征进行交互学习。之后采用与文献[6]类似的架构,使用全局信息模块(GIM)处理编码器输出的最深层特征,以生成能够精确定位显著性区域的全局指导特征。然后通过多交互模块(MIB),在全局指导特征的引导下融合多类型线索,并逐步实现显著性计算。所提出的CALNet总共生成两个预测输出,其中包含一个由GIM生成的深层粗预测Sg和一个最终预测Sf。

|

图 1 CALNet网络框架 Fig. 1 CALNet network architecture |

ConvNeXt是一种卷积神经网络,旨在提高特征提取的能力和模型性能[7]。该网络基于ResNet架构,并从Transformer中借鉴了很多成功的做法。ConvNeXt整体分为4个阶段,其中每个阶段均由数个ConvNeXt Block堆叠而成。每个ConvNeXt Block由一个深度卷积(Depthwise Conv2d)、两个1×1卷积、一个层归一化(Layer Norm)、一个高斯误差线性单元(GeLU)、一个Layer Scale和一个Drop Path组成。其中,与ResNet Block不同的是,它使用了3×3深度卷积,采用了反向瓶颈结构,用GeLU激活函数和层归一化代替了线性整流函数(ReLU)和批量归一化(BN),且减少了激活函数的使用次数。这样的设计确保了ConvNeXt的检测效率和准确率。因此,本文选择ConvNeXt作为骨干网络,以提高任务的性能。

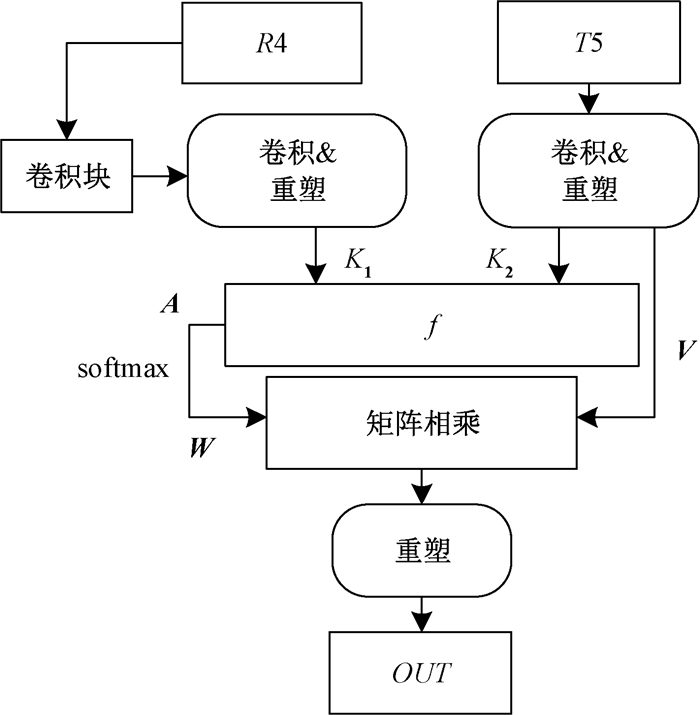

1.3 解码网络 1.3.1 跨层级注意力学习模块本文设计了一个跨层级注意力学习模块(CAL),以实现热模态特征与RGB特征间的跨层级信息交互。CAL基于非局部注意力实现,能够对不同模态与不同层级间特征的长距离空间相关性进行建模。具体来说,该模块接收编码网络产生的不同层次的多模态特征T5和R4作为输入。如图 2所示,输入分别为c×h×w与c′×h′×w′(c是通道数,h和w分别为特征图的高和宽)的双模态特征,由于不同层级的特征存在维度、尺度上的差异,模块首先对RGB特征进行两次卷积处理,以改变其维度与尺度大小,使之与深层的热模态特征相对应。之后,对两个模态的特征分别进行卷积降维和重塑操作以生成键值:K1、K2和V。其中,RGB特征的键K1会被用作热模态特征键值{K2, V }的查询,两组键之间通过相容函数生成注意力矩阵,并通过softmax归一化生成注意力权重。该权重会通过矩阵相乘的方式对热模态特征的值V进行加权,加权的结果会在被重塑c′×h′×w′后进行输出,以得到包含丰富细节信息的热模态特征。以上过程用公式表示为

| $ \begin{gathered} \boldsymbol{A}=f\left(K_1, K_2\right), \\ \boldsymbol{W}=\operatorname{softmax}(\boldsymbol{A}), \\ O U T=\operatorname{Reshape}\left(\boldsymbol{W}^{\mathrm{T}} \boldsymbol{V}\right), \end{gathered} $ |

|

图 2 跨层级注意力学习模块 Fig. 2 Cross-level attention learning module |

其中:K1∈Rn×c; K2∈Rn×c; V∈Rn×c; n=h×w; Reshape(·)代表重塑操作;f(·)是相容函数,它以矩阵相乘的方式实现;A∈Rn×n是注意力矩阵;W∈Rn×n是注意力权重;OUT∈Rh×w×c是CAL的输出特征。这种多模态间的跨层级对象信息学习,能够让具有良好位置信息的深层热模态特征学习浅层RGB特征中的详细细节和边界信息,使网络获得包含更丰富细节表示的高级语义特征。

1.3.2 全局信息模块在跨层级的多模态特征学习后,本文引入全局信息模块(GIM)[6]来生成全局指导特征。GIM接收最高层级的RGB特征R5和红外热特征T5作为输入,并在级联后使用通道注意力来对两种模态的特征进行重组。之后,采用一个卷积块对其进行降维,以得到特征F,

| $ F=Conv(CA(Concat(R 5, T 5))), $ |

其中: Conv(·)表示卷积块; Concat(·)表示级联操作; CA(·)表示通道注意力操作,计算为

| $ X^{\prime}=\operatorname{Sigmoid}\left(C\left(A_1(X)\right)+C\left(M_1(X)\right)\right) X, $ |

其中: C为1×1卷积; A1为全局平均池化; M1为全局最大池化; X与X′分别为通道注意力输入和输出特征。进一步,GIM通过四个不同尺寸的自适应最大池化操作来对F进行处理,并使用四个具有不同尺寸卷积核的卷积块,分别对池化后的特征进行学习,旨在获得更丰富的多尺度特征。最后,四个卷积块的输出特征会在上采样后与F进行级联,并在卷积降维后,作为GIM的输出。该输出将被用于生成网络的深层次预测Sg,并同时被输入到各层级的多交互模块中,以在逐层解码中指导网络更准确地定位图像中的显著区域。

1.3.3 多交互模块参考文献[6]中的解码架构,在全局信息模块后,本文使用多个级联的多交互模块(MIB)对特征进行逐层解码。该模块能够实现双模态信息、细节特征信息和全局信息的充分交互。多交互模块由3个特征分支组成。在第1个特征分支中,MIB使用通道注意力细化后的编码器各层级特征来帮助解码器逐步恢复图像中的空间细节。在第2个特征分支中,更深层的两个多交互模块的输出在级联后被作为输入(其中,第4层MIB分别接收CAL的输出和R5作为输入),这种具有较强像素相关性的高级语义特征会在通道注意力细化后被上采样到与当前层级特征相同的大小。在第3个分支中,MIB接受全局信息模块的输出作为输入,通过全局指导的方式丰富浅层特征中被稀释的语义信息,并抑制背景噪声。最后,MIB使用卷积来对各个分支中特征的通道数进行统一,并采用逐元素相加的方式对它们进行融合,融合得到的特征会在卷积处理后进行输出。

通过多个多交互模块的逐层级解码,所提出的网络能够充分融合不同模态、不同层次的多类型信息,并生成更准确的最终预测Sf。

1.4 损失函数显著目标检测任务中常用的损失函数为二元交叉熵(BCE)损失,计算为

| $ L_{\mathrm{BCE}}(S, Y)=-\sum\limits_{i=1}^T\left(Y_i \log \left(S_i\right)+\left(1-Y_i\right) \log \left(1-S_i\right)\right), $ |

其中:S={Si|i=1, …, T}为网络预测的显著图; Y={Yi i=1, …, T}为真值图; T是图像中的总像素数。此外,受文献[8]的启发,为了获得更清晰的边缘,本文额外引入了平滑度损失LS作为约束,LS通过计算平滑项中显著图的一阶导数得到,其定义与文献[8]中相同。

本文提出的网络共有两个预测输出,其中包含来自全局指导模块的深层预测Sg和网络的最终预测Sf,它们均在上采样后通过真值图进行监督。因此,网络的总损失为

| $ \begin{aligned} & L=L_{\mathrm{BCE}}\left(S_g, Y\right)+L_{\mathrm{BCE}}\left(S_f, Y\right)+ \\ & \beta L_S\left(S_g, Y\right)+\beta L_S\left(S_f, Y\right), \end{aligned} $ |

这里,β=0.5,以平衡平滑度损失的影响。

2 实验细节 2.1 数据集本文在三个公开使用的RGB-T显著目标检测数据集上评估所提出的网络,包括VT821[9]、VT1000[10]和VT5000[11]。VT821包含821个RGB-T图像对,且部分图像添加了噪声以提高数据集的挑战性。VT1000包含1 000个相对简单且对齐良好的RGB-T图像对,而VT5000则收集了5 000个对齐的RGB-T图像对,其场景更为复杂。本文中采用主流的训练与测试方法,使用VT5000中的2 500个不同的RGB-T图像对进行训练,并使用VT5000中的其余图像与VT821和VT1000一起对网络进行测试评估。

2.2 实施细节本文的网络基于Pytorch实现,所有实验均在NVIDIA GeForce RTX 3060(12 GB显存)上运行。训练epoch的数量被设置为100,批量大小被设置为4。初始学习率为1e-3,在训练20个周期后变为1e-4,在50个周期之后变成1e-5。本文采用SGD优化器,权重衰减为5e-4,momentum为0.9。对于RGB-T图像对的输入,本文将所有的图像像素调整为352×352。此外,为了提高网络的鲁棒性并同时减少单一模态图像中可能的污染信息的干扰,本文遵循文献[6]所提出的方法,在训练时应用数据增强策略。具体地,在训练时以10%的概率随机将双模态中的一个输入归零,并以10%的概率随机添加高斯噪声。

2.3 评估指标本文使用加权F度量(Fβ)、结构测度S度量(Sα)、平均增强匹配标准E度量(Eε)[12]和平均绝对误差(MAE)来对所提出的网络进行评估。其中,加权F度量通过查准率(Precision)和召回率(Recall)来评估模型的性能,表示为

| $ \begin{gathered} Precision=\frac{T P}{T P+F P}, Recall =\frac{T P}{T P+F N}, \\ F_\beta=\frac{\left(1+\eta^2\right) \cdot Precision \cdot Recall }{\eta^2 \cdot Precision + Recall }, \end{gathered} $ |

其中:TP、FP和FN分别表示真阳性、假阳性和假阴性,η2被设置为0.3。平均绝对误差的公式表示为

| $ M A E=\frac{1}{T} \sum\limits_{i=1}^T\left|S_i-Y_i\right| 。$ |

S度量用于评估真实显著对象与预测显著对象空间结构的相似性,它结合了区域感知的结构相似性Sr和对象感知的结构相似性So,

| $ S_\alpha=\alpha \cdot S_0+(1-\alpha) \cdot S_r, $ |

本文参考文献[13]设置α为0.5。E度量[12]可以获得真值图与预测图间图像级的统计信息和像素级的匹配信息。评估时Sα、Fβ、Eε越大越好,MAE越小越好。

3 实验结果与分析 3.1 定量对比本文将所提出网络与其他主流RGB-T SOD算法进行了比较,以评估所提出网络的检测效果,最好的结果以加粗形式标出。如表 1所示,本文的网络几乎在所有指标上都取得了良好的性能。其中,与第二优的CAENet相比,在最大的评估数据集VT5000上Sα、Fβ、Eε分别提高了1.8%、3.0%、1.6%,MAE降低了21.1%,验证了所提出模型的有效性。

|

|

表 1 定量对比实验结果 Tab. 1 Quantitative comparison experimental results |

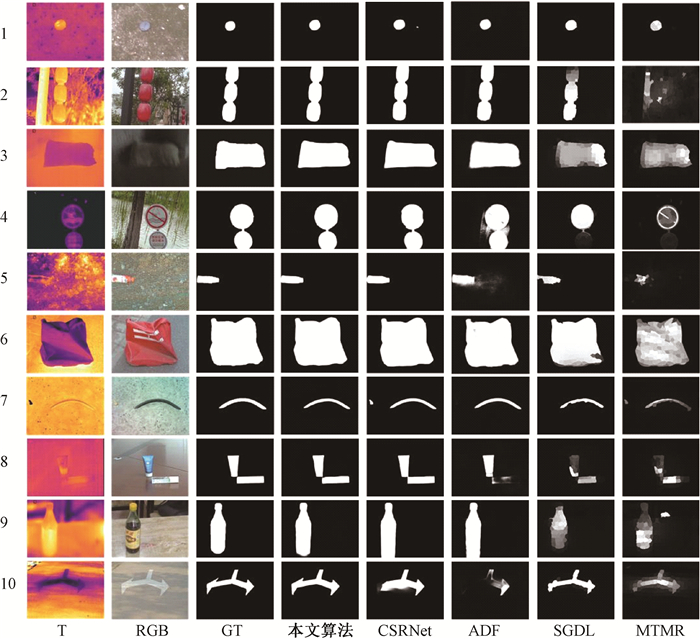

图 3展示了本文网络与相关领域的一些先进模型的定性对比结果,包括在各种具有挑战性的不同场景下的性能比较。例如,多显著对象(行2)、图像杂波(行4)、交叉图像边界(行5)、中心偏移(行10)等,结果表明本文的网络取得了更好的检测效果。其中,T表示红外图; RGB表示可见光图;GT表示真值图。

|

图 3 定性对比实验结果 Fig. 3 Qualitative comparison experimental results |

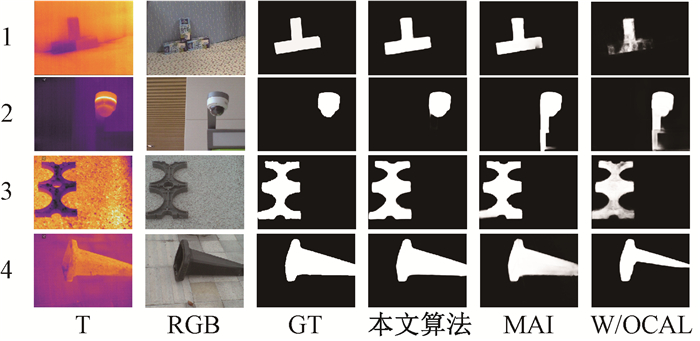

本文首先评估了跨层级注意力学习模块对网络性能的影响。消融实验中,首先从完整的网络中去除CAL模块,之后使用同层级的注意力交互(MAI)来对其进行代替。如表 2所示,相比于完整的跨层级特征注意力学习网络(本文算法),当去除CAL时(W/O CAL),热模态特征无法学习RGB特征中的互补细节信息,造成了检测性能的下降。当使用同层级交互时(MAI),网络无法获得更丰富的多尺度信息,其性能无法达到最优,定性对比结果如图 4所示。这验证了所提出的CAL的有效性。

|

|

表 2 CAL模块消融实验结果 Tab. 2 Ablation experiment results of CAL module |

|

图 4 CAL模块消融实验的定性对比结果 Fig. 4 Qualitative comparison results of the ablation experiment of CAL module |

之后,本文对跨层级注意力学习模块中的特征学习方式进行了评估。如表 3所示,本文共设计了8种不同的跨层级特征学习方式,表中第1列括号内为输入CAL中进行交互学习的编码器特征,其中下划线的特征为交互时进行学习的主体,CAL的输出将代替该特征在多交互模块中进一步解码。定量实验的结果表明,当使用第5层热红外特征T5对第4层RGB特征R4进行注意力学习时,网络性能达到最佳。因此,本文最终采用这种方式。

|

|

表 3 不同学习方式实验结果 Tab. 3 Experimental results of different learning methods |

本文提出了一个跨层级特征注意力学习网络(CALNet),该网络使用编码器-解码器架构,能够进行更准确的RGB-T SOD。为了进行多模态间的跨层级特征交互,CALNet中使用了一个跨层级注意力学习模块,该模块能够实现深层热模态特征与浅层RGB特征间的显著性特征学习,使热模态特征获得对象更多的纹理细节。此外,在解码阶段网络还引入了全局信息模块与多交互模块,以实现全局信息指导下的逐层多信息融合解码。在三个公共数据集上进行的实验表明,CALNet相较主流的先进模型具有更好的RGB-T SOD检测结果。在未来,本文考虑将所提出的网络运用在一些RGB-T SOD的实际应用中,并在更轻量化的网络架构方面进行改进,以实现网络精度与推理速度的平衡。

| [1] |

李文举, 王子杰, 崔柳. 基于多特征融合和改进SIFT的目标跟踪算法[J]. 郑州大学学报(理学版), 2024, 56(1): 40-46. LI W J, WANG Z J, CUI L. Target tracking algorithm based on multi feature fusion and improved SIFT[J]. Journal of Zhengzhou university (natural science edition), 2024, 56(1): 40-46. DOI:10.13705/j.issn.1671-6841.2022268 (  0) 0) |

| [2] |

吴宇鑫, 陈知明, 李建军. 基于半监督深度学习网络的水体分割方法[J]. 郑州大学学报(理学版), 2023, 55(6): 29-34. WU Y X, CHEN Z M, LI J J. Water segmentation method based on semi supervised deep learning network[J]. Journal of Zhengzhou university (natural science edition), 2023, 55(6): 29-34. DOI:10.13705/j.issn.1671-6841.2022175 (  0) 0) |

| [3] |

TU Z Z, XIA T, LI C L, et al. M3S-NIR: multi-modal multi-scale noise-insensitive ranking for RGB-T saliency detection[C]//IEEE Conference on Multimedia Information Processing and Retrieval. Piscataway: IEEE Press, 2019: 141-146.

(  0) 0) |

| [4] |

ZHANG Q, HUANG N C, YAO L, et al. RGB-T salient object detection via fusing multi-level CNN features[J]. IEEE transactions on image processing, 2020, 29: 3321-3335. DOI:10.1109/TIP.2019.2959253 (  0) 0) |

| [5] |

LV C T, WAN B, ZHOU X F, et al. CAE-net: cross-modal attention enhancement network for RGB-T salient object detection[J]. Electronics, 2023, 12(4): 953. DOI:10.3390/electronics12040953 (  0) 0) |

| [6] |

TU Z Z, LI Z, LI C L, et al. Multi-interactive dual-decoder for RGB-thermal salient object detection[J]. IEEE signal processing, 2021, 30: 5678-5691. (  0) 0) |

| [7] |

LIU Z, MAO H Z, WU C Y, et al. A ConvNet for the 2020s[C]//IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE Press, 2022: 11966-11976.

(  0) 0) |

| [8] |

WANG Y, YANG Y, YANG Z H, et al. Occlusion aware unsupervised learning of optical flow[C]//IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE Press, 2018: 4884-4893.

(  0) 0) |

| [9] |

WANG G Z, LI C L, MA Y P, et al. RGB-T saliency detection benchmark: dataset, baselines, analysis and a novel approach[C]//Chinese Conference on Image and Graphics Technologies. Berlin: Springer Press, 2018: 359-369.

(  0) 0) |

| [10] |

TU Z Z, XIA T, LI C L, et al. RGB-T image saliency detection via collaborative graph learning[J]. IEEE transactions on multimedia, 2020, 22(1): 160-173. DOI:10.1109/TMM.2019.2924578 (  0) 0) |

| [11] |

TU Z Z, MA Y, LI Z, et al. RGBT salient object detection: a large-scale dataset and benchmark[J]. IEEE transactions on multimedia, 2023, 25: 4163-4176. DOI:10.1109/TMM.2022.3171688 (  0) 0) |

| [12] |

FAN D P, GONG C, CAO Y, et al. Enhanced-alignment measure for binary foreground map evaluation[EB/OL]. (2018-05-26)[2023-06-01]. http://arxiv.org/abs/1805.10421.pdf.

(  0) 0) |

| [13] |

FAN D P, CHENG M M, LIU Y, et al. Structure-measure: a new way to evaluate foreground maps[C]//IEEE International Conference on Computer Vision. Piscataway: IEEE Press, 2017: 4558-4567.

(  0) 0) |

| [14] |

ZHOU W J, GUO Q L, LEI J S, et al. ECFFNet: effective and consistent feature fusion network for RGB-T salient object detection[J]. IEEE transactions on circuits and systems for video technology, 2022, 32(3): 1224-1235. DOI:10.1109/TCSVT.2021.3077058 (  0) 0) |

| [15] |

GAO W, LIAO G B, MA S W, et al. Unified information fusion network for multi-modal RGB-D and RGB-T salient object detection[J]. IEEE transactions on circuits and systems for video technology, 2022, 32(4): 2091-2106. DOI:10.1109/TCSVT.2021.3082939 (  0) 0) |

| [16] |

HUO F S, ZHU X G, ZHANG L, et al. Efficient context-guided stacked refinement network for RGB-T salient object detection[J]. IEEE transactions on circuits and systems for video technology, 2022, 32(5): 3111-3124. DOI:10.1109/TCSVT.2021.3102268 (  0) 0) |

2025, Vol. 57

2025, Vol. 57