2. 河南日报社 河南 郑州 450014

2. Henan Daily, Zhengzhou 450014, China

随着元宇宙技术的发展,各级媒体从智能化、融合化,逐步向智慧化平台发展[1]。社交媒体可以通过算法和数据分析来推荐和呈现用户感兴趣的内容,但这也可能导致信息过滤和信息孤岛的问题。虚假新闻披着新闻的外衣,利用网络和社交媒体实现了更加广泛与快速的传播[2]。及时检测并阻断虚假新闻,可以有效减慢其扩散速度,预防虚假新闻对公众产生的不良影响,同时也增强了社交媒体平台的可靠性和用户体验[3]。

随着人工智能技术的迅速发展和模型优化的持续进行,对于虚假新闻检测的需求变得更加紧迫[4]。传统方法主要依赖新闻文本进行识别,却忽略了社交网络传播过程中的重要因素。用户的发文和转发行为能够迅速扩大虚假新闻的传播范围,进而对虚假新闻的检测工作产生一定的影响。特别是当用户频繁转发虚假新闻时,他们的信誉度可能会受到损害,从而增加了信息传播的不可靠性。此外,在社交媒体上,用户可能会将真实新闻误标记为虚假新闻,或者将虚假新闻误认为是真实新闻,从而干扰对虚假新闻的检测和过滤。用户的大量转发行为也会加速虚假新闻的传播速度,使得虚假信息更快地扩散到更广泛的受众中,增加了对虚假新闻检测和控制的难度。

为提升对虚假新闻识别的准确性,本研究将聚焦用户转发行为,并以此为基础结合文本内容特征构建了BGMA(BERT-GAT-MultiAttn)模型。BGMA模型首先利用BERT模型的强大文本表征能力,从文本内容中提取丰富的语义特征。其次,将用户行为数据构建为树形结构,通过GAT模型来捕捉用户行为之间的复杂关联和动态变化,从而获取用户行为的深层特征。最后,采用多头注意力机制有效地融合了文本内容特征和用户行为特征,并根据特征重要性加权,以提升模型的识别准确性和鲁棒性。

1 相关研究当前,虚假新闻检测主要侧重于基于内容特征的方法和基于社交上下文特征的方法。基于内容特征的方法主要聚焦于从文本中提炼出各种信息,比如语言特征等,以此来鉴别新闻的真实性。然而,对于那些经过精心伪造、语言流畅且内容看似合理的虚假新闻,这种方法往往难以奏效。而基于社交上下文特征的方法则更加侧重于分析新闻在用户间传播过程中产生的周边信息。这些信息包括但不限于用户特征、社交网络传播特征,以及用户对于新闻或帖子的反馈特征等。通过分析这些信息,BGMA模型能够深入理解新闻在社交网络中的传播规律,以及用户对新闻的真实态度和看法。

基于社交上下文特征的虚假新闻识别方法通过分析社交媒体帖子间的互动关系来预测新闻可信度,不再模拟读者理解文本的过程,而是理解其阅读后的反应。从这些反应信息中提炼影响文本真实性的关键因素,通过逆向推理反推新闻真实性,更贴近实际且有效。在构建传播网络时,可以根据用户发布内容与新闻文本的观点关联性建立网络结构,分析用户评论中的观点冲突、情绪表达及传播网络,进而判断新闻真实性。同时,关注意见领袖在网络结构中的作用,能够更准确地把握新闻传播的动态和影响力。

学者们提出了不同的方法来利用传播网络进行虚假新闻检测。例如,Wu等[5]将新浪微博数据视为传播树构成的森林,结合用户上下文信息和推文文本内容进行分类。Ma等[6]则比较不同传播树的结构相似度,捕捉高阶传播模式以区分虚假新闻。为实现早期检测,Liu等[7]仅利用用户上下文信息构建传播路径,利用CNN和RNN进行处理。尹鹏博等[8]结合CNN和LSTM分别捕获用户特征和文本特征,实现两种模态信息的有效整合。这些方法在降低数据处理复杂度的同时,提高了虚假新闻检测的准确性。

现有研究表明,文本内容和用户行为都是影响虚假新闻检测的重要特征。学者们也积极对两者进行结合[9],但在融合这两种特征时,大多数方法都是采用简单的拼合方式,往往容易忽略其中的差异对虚假新闻检测的影响。本文的创新点在于结合图注意力网络的特征提取方法,能够更准确地捕捉传播网络中的复杂结构和用户行为的动态变化,从而更全面地理解社交上下文特征。采用多头注意力机制对文本内容特征和用户行为特征进行加权融合,则能够动态学习两者之间的重要程度,从而更好地结合文本内容和用户行为的关键信息,有效提升虚假新闻检测的准确性和效果。

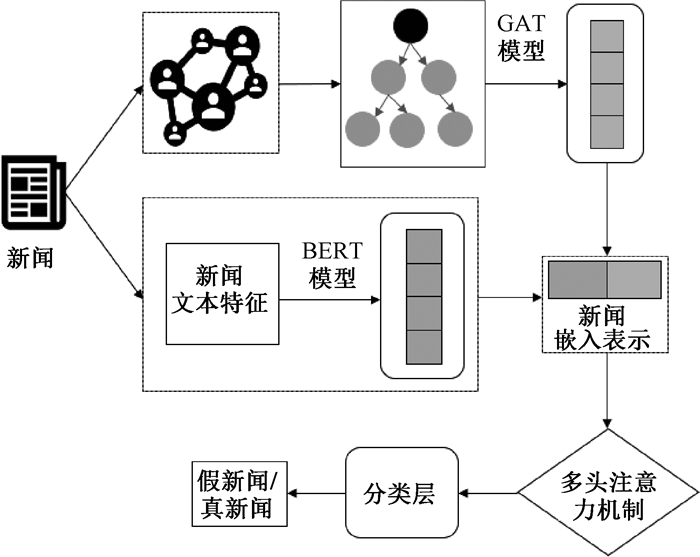

2 模型架构本文结合新闻文本内容和用户转发行为构建了基于BGMA的社交媒体虚假新闻检测模型,结构如图 1所示。该模型通过分析用户在社交媒体上对新闻内容的转发行为以及新闻内容本身的特征来判断该新闻的真假。

|

图 1 模型结构示意图 Fig. 1 Model structure diagram |

模型包含了图注意力层、全局最大池化层、多头注意力机制以及线性层,可以分为文本内容特征表示、用户行为特征表示以及特征融合与分类三个模块。在前向传播过程中,节点特征首先通过图注意力层进行特征聚合和信息传播,然后通过全局最大池化层将每个图的节点特征聚合成图级别的特征表示。在特征融合阶段,多头注意力机制会利用学习到的注意力权重参数对节点特征进行加权融合。最后,经过线性层的变换,特征被映射到与预测类别数相同的维度,再通过输出层进行处理,并应用log_softmax函数将特征转换为预测类别的概率分布,从而得到最终的预测结果。这个模型结合了不同层的功能和特性,能够有效地处理图数据、提取特征并进行分类预测。

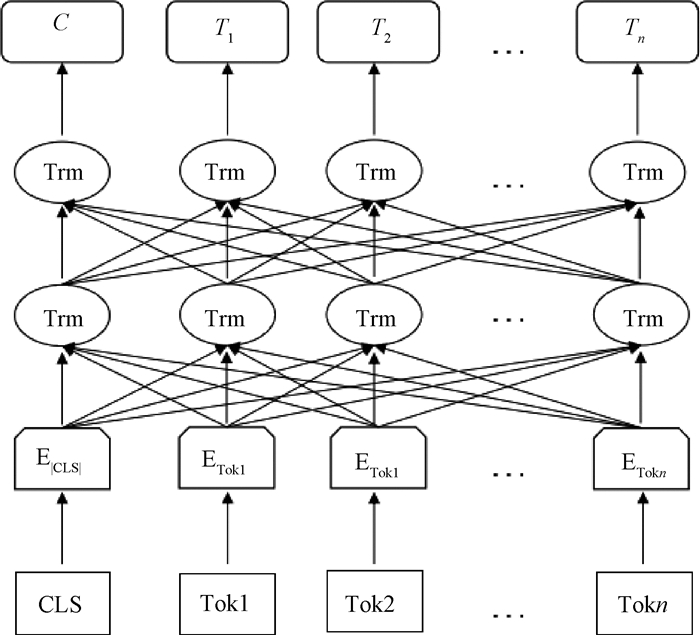

2.1 文本内容特征表示模块在社交媒体中,某一事件的传播往往始于新闻内容的发布。新闻内容所包含的原始信息对于判断该事件是否为虚假新闻至关重要,因此高效利用新闻内容中的隐藏信息可以有效帮助模型辨别新闻真假。为了提取新闻内容的文本特征,本研究选用BERT模型进行处理,模型结构如图 2所示。

|

图 2 BERT模型结构图 Fig. 2 BERT model structure diagram |

BERT模型处理输入序列时,会将文本转换为标记(token)的序列,表示为Tok。对于每个序列,BERT都会在开头添加一个特殊的分类标记[CLS],这个标记在模型处理完整个序列后的隐藏状态(hidden state)会被用作分类任务的聚合表示,记为C。模型通过嵌入层Embeddings layer(E)将Tok转换为向量表示,以便后续处理。然后,多个Transformer模块(Trm)堆叠在一起,通过自注意力机制捕获标记间的依赖关系,并生成每个标记的上下文表示,其中第n个输入标记的隐藏状态记作Tn。

BERT模型的最终输入是由标记嵌入(token embeddings)、段嵌入(segment embeddings)和位置嵌入(position embeddings)三者之和构成的。这样的设计使得BERT能够充分利用文本的语义、位置以及句子间的关系等信息,从而在各种下游任务中有优秀的表现[10]。

在虚假新闻检测任务中,需要利用在大规模语料上预训练的词向量,这些向量已编码了丰富的语义相似性,因此无须在局部语料上进一步训练。为了深入捕捉新闻内容与用户推文之间的语义联系,本研究采用了预训练的BERT嵌入技术。在此过程中,选择表现较好的cased BERT-Large模型,并设定最大输入序列长度为512个token,以确保新闻内容得到全面而细致的编码。然而,BERT对序列长度的限制,导致无法直接将多条推文合并编码。因此,本研究采取了逐条编码的策略,即单独对每条推文进行BERT编码,随后对这些编码结果取平均值,以此作为该组推文的综合语义表示。

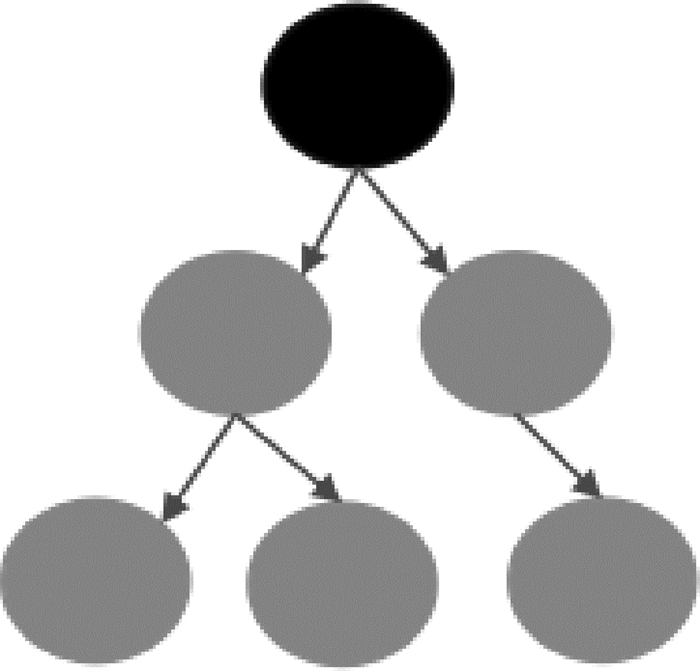

2.2 用户行为特征表示模块 2.2.1 树的构造将用户行为转化为新闻传播图的形式进行表示,这一传播图呈现出树状结构的特点。如图 3所示,其中根节点代表新闻文本内容,其他节点代表转发该新闻的用户。在构建有向树的基础上,本研究将推文与其回应推文之间的关系映射为树中的父子节点关系。具体而言,首先提取文本特征向量,并将其嵌入到相应的节点中。接着,如果两个节点之间存在直接的转发关系,则在它们之间建立连边。最后,通过父节点指向子节点的方向,明确表示节点间的层级关系。

|

图 3 树结构图 Fig. 3 Tree structure diagram |

GAT模型使用邻接矩阵信息来实现节点之间的注意力机制。在GAT中,每个节点通过学习到的注意力权重来聚合其邻居节点的特征表示。这些注意力权重是通过计算节点之间的相似度来确定的,其中邻接矩阵提供了节点之间的连接关系。通过将邻接矩阵信息与学习到的注意力权重相乘,可以实现对邻居节点特征的加权聚合,从而更好地捕捉节点之间的关系和重要性[11]。

基于GAT模型,节点的特征向量通过迭代更新得到全局特征表示。在更新单个节点时,首先根据不同类型的关系路径收集邻居节点的信息,形成邻居节点的向量表示。随后,结合这些邻居节点的信息与自身节点的信息,共同更新该节点的特征表示。最终,新生成的节点信息融合了邻居信息和自身信息,从而全面反映了推文的传播特征。

2.2.3 边特征学习在图 3中,边作为连接节点的桥梁,同样承载着丰富的信息。边特征学习旨在提取边的深层语义表示,以捕捉节点间的复杂关系和相互作用。结合之前的节点更新过程,可以进一步探索边特征学习的方法。

BGMA模型将边视为特殊的实体,并赋予其初始的特征向量。这个特征向量可以根据边的属性或其连接的两个节点的特征进行计算得出。接下来,通过GAT模型的注意力机制,对边特征进行更新。在这个过程中,边的特征将受到其连接的节点特征的影响,从而学习到节点间关系的深层表示。

为了更全面地捕捉边的特征,BGMA模型还考虑了图中可能存在的不同类型的关系路径。通过聚合这些路径上的节点信息,可以进一步丰富边的特征表示,反映节点间不同的交互模式和关系类型。边特征学习与节点特征更新是相辅相成的,通过不断更新节点和边的特征表示,BGMA模型能够捕获到图中更复杂的结构和语义信息,从而实现对图的全面理解。

2.2.4 全局最大池化全局最大池化(global max pooling,GMP)是一种用于聚合节点信息并生成图级别表示的技术。在图中,每个节点经过一系列的特征学习和更新过程后,会获得其对应的特征向量。全局最大池化的目标是将这些节点特征向量聚合成一个单一、紧凑的图级别特征向量,以便进行图级别的任务,如图分类或图级别的预测。

在BGMA模型中,全局最大池化层的作用是将所有节点的特征向量进行聚合,以捕获图的整体信息。具体实现时,全局最大池化层会遍历图中所有节点的特征向量,并在每个特征维度上选择最大值作为该维度的图级别特征向量。通过这种方式,全局最大池化能够保留图中在各个特征维度上最显著的信息,同时降低特征的维度,便于后续的图级别任务处理。

全局最大池化的优势在于它能够有效地提取图中的关键信息,并忽略一些不重要的细节。通过选择每个特征维度上的最大值,全局最大池化能够突出显示图中在该特征上最为突出的节点或结构,从而帮助模型更好地理解和表示整个图。

2.3 特征融合与分类模块 2.3.1 多层注意力模块为了能够更深入地整合用户信息与新闻内容,BGMA模型引入了Vaswani等[12]提出的多头注意力机制。这一机制可以视为单头注意力机制的扩展和升级,其核心理念是将注意力机制操作分组进行,从而允许模型从多个不同的维度和视角提取和整合特征信息。

通过多头注意力机制,模型能够优化全局图表示的精细度。该机制的核心在于计算特征的注意力分数,并根据这些分数对特征进行加权,确保模型能够重点关注那些对任务更为关键的特征维度。

在数据流动方面,多头注意力模块接受全局最大池化后的图表示作为输入,然后输出经过加权处理后的图级别特征表示。这一输出特征表示不仅融合了原始图中的关键信息,还通过多头注意力机制增强了重要特征的影响力,从而提高了模型的表达能力和准确性。

2.3.2 线性层线性层在图表示学习模型中扮演着将经过处理的图表示映射到分类任务输出空间的关键角色。它接收来自前一层的图级别特征向量,并通过一系列线性变换,将这些特征映射到与分类任务输出维度相匹配的空间。这一过程实质上是利用线性层学习到的权重和偏置参数对输入特征进行加权求和,从而生成每个类别的原始预测分数。

随后,为了将BERT编码后的原始分数转化为更易于理解和使用的概率分布形式,使用softmax函数将分数映射到(0, 1)区间内,并确保所有类别的概率之和为1,从而更直观地反映模型对每个类别的置信程度。最后,为了方便计算损失和进行后续的梯度更新,BGMA模型使用log_softmax函数对概率分布进行取对数操作,得到最终的预测结果。融合后的新闻嵌入被送入一个两层的多层感知器(MLP),其中两个输出神经元代表假新闻和真实新闻的预测概率。在模型训练阶段,采用了二进制交叉熵损失函数,并利用随机梯度下降(SGD)法进行参数更新,以确保模型能够有效地学习和优化。

3 模型验证及分析 3.1 数据来源由于本文所构建的模型不仅需要新闻内容的文本信息,还需要结合用户行为,因此选用Shu等[13]提供的公开综合数据集FakeNewsNet进行研究,数据集相关信息如表 1所示。

|

|

表 1 数据集的统计数据 Tab. 1 Statistics of the data set |

在应用文本表示学习方法之前,要清洗数据中的噪声和无关信息。同时,为了弥补因无法访问暂停或删除账户而导致的数据缺失,本研究采用从可访问用户中抽取含有相同新闻的方式,以确保新闻传播分析的准确性。

3.2 研究设计 3.2.1 实验环境本研究使用基于Ubuntu 18.04操作系统的工作站作为开发环境,配备NVIDIA GeForce RTX 3080 Ti GPU和Intel Xeon Silver 4214R CPU,搭载CUDA 11.1进行深度学习模型训练。Python 3.8作为主要开发语言,提供了丰富的科学计算库和深度学习框架支持。该环境具备强大的计算性能和优秀的硬件加速能力,为研究提供了稳定、高效的计算支持。

本研究使用了PyTorch Geometric(PyG)工具包,这是一个基于PyTorch深度学习框架的图神经网络库,由文献[14]于2018年创建。PyG的设计旨在简化图数据的处理和建模过程,并为用户提供丰富的图神经网络模型和工具函数。通过PyG能够更便捷地操作图数据,利用其提供的各种图神经网络模型和工具函数,加快算法设计与优化的过程,并提高图神经网络建模的效率和性能。

3.2.2 参数设置本文模型训练的关键参数有:批量大小(batch_size)为128;学习率(learning_rate)为0.01;训练轮数(epochs)为35;权重衰减(weight_decay)为0.01。选择这些参数,旨在优化模型训练过程,平衡了收敛速度和模型性能之间的关系。通过精心调整这些参数,旨在提高模型在训练集和测试集上的性能表现,从而为社交媒体虚假新闻检测任务提供可靠的解决方案。

3.3 评估标准本文将虚假新闻检测视为二分类任务,通过混淆矩阵计算准确率、精确率、召回率和F1分数等指标,全面评估模型性能。混淆矩阵主要由四个关键参数构成,如表 2所示。这些参数能够直观地反映模型分类的准确性和效果,是评估模型性能不可或缺的参考依据。

|

|

表 2 混淆矩阵 Tab. 2 Confusion matrix |

准确率A是最常用的指标,它衡量模型在所有分类样本中正确分类的比例。准确率关注的是整体的分类准确性,包括了真阳性和真阴性的数量,其计算表达式为

| $ A=(T P+T N) /(T P+T N+F P+F N)。$ | (1) |

多数情况下,准确率确实是评估模型分类效果的关键指标,其数值越高通常意味着模型性能越佳。然而,准确率的计算涵盖了正确和错误的分类情况,若模型存在较多误判,高准确率也可能无法真实反映其性能。因此,仅凭准确率不足以全面评估模型的性能。

为了更全面地评价错误分类的情况,本文还引入了精确率、召回率和F1分数这三个指标。这些指标能够从不同角度反映模型在分类任务中的表现,帮助我们更深入地了解模型的性能特点。

1) 精确率P指被模型正确分类为虚假新闻的样本数TP占所有被模型分类为虚假新闻的样本数的比例。精确率衡量了模型在判断一个样本为虚假新闻时的准确性,其表达式为

| $ P=T P /(T P+F P)。$ | (2) |

2) 召回率R指被模型正确分类为虚假新闻的样本数TP占所有虚假新闻样本数的比例。召回率衡量了模型对虚假新闻的覆盖度,其表达式为

| $ R=T P /(T P+F N) \text { 。} $ | (3) |

3) F1分数是精确率和召回率的调和平均数,可以综合考量模型的准确性和覆盖度。F1分数越高,表示模型在社交媒体虚假新闻检测任务中越好。其表达式为

| $ F 1=(2 P \times R) /(P+R) \text { 。} $ | (4) |

为了全面、深入地评估本文构建模型的有效性,使用以下模型作为对比模型,与本文构建的模型进行比较。

1) TextCNN:结合卷积神经网络与文本处理技巧,通过卷积操作提取文本中的局部特征,并利用全连接层进行特征整合与分类。

2) BERT-LSTM:深度整合了BERT的预训练语言表示与LSTM的时序建模能力,通过捕捉文本中的上下文信息和序列依赖关系,有效提升虚假新闻检测的准确性和效率。

3) BiGCN:BiGCN(bi-directional graph convolutional network)模型对用户特征进行深度挖掘与融合,通过图卷积结构和自顶向下的特征提取机制,结合拼接网络强化特征表示。

4) GCNFC:GCNFC(graph convolutional network with fully connected layer)模型在GCN图卷积神经网络基础上引入全连接层,通过GCN提取深层图特征,全连接层整合并分类,增强特征整合与分类能力,提升虚假新闻检测准确性与效率。

根据表 3和表 4研究结果显示(表中黑体数据为最优结果),基于文本内容的检测模型TextCNN和BERT-LSTM在不同数据集上表现有所差异。TextCNN虽然在文本特征提取方面有一定优势,但其精确率和召回率相对较低,影响了整体性能。BERT-LSTM结合了BERT的预训练语言表示和LSTM的时序建模能力,在PolitiFact数据集上取得了不错的性能,但在GossipCop数据集上则稍显逊色。而基于用户行为的BiGCN和GCNFC模型通过引入图卷积神经网络,能够捕捉用户之间的传播关系,从而在一定程度上提升了虚假新闻检测的准确性。但它们主要依赖于用户行为信息,对于文本内容的利用相对有限,因此,在数据集差异较大或文本内容对检测结果影响更为显著的情况下,BiGCN和GCNFC模型的性能可能会受到一定限制。

|

|

表 3 数据集PolitiFact的研究结果分析 Tab. 3 Data set PolitiFact analysis of experimental results |

|

|

表 4 数据集GossipCop的研究结果分析 Tab. 4 Data set GossipCop analysis of experimental results |

本文构建的基于BGMA的虚假新闻检测模型融合了用户行为特征与新闻内容特征,经过验证,该模型在两个数据集上均展现出优异的表现。与基于内容的模型中表现较好的BERT-LSTM模型相比,在PolitiFact数据集上准确率提升4.06%,在GossipCop数据集上准确率提升19.73%。与基于用户特征的模型中表现较好的GCNFC模型相比,在PolitiFact数据集上准确率提升10.59%,在GossipCop数据集上准确率提升10.47%。

研究结果表明,相较于仅基于新闻内容特征的分析方法,本文采用的结合用户行为特征和新闻内容特征的综合分析策略展现出更为卓越的判别能力。这一结果证明了本文提出的结合用户行为特征与新闻内容进行新闻真实性分析的可行性和有效性。通过深入剖析用户在阅读理解过程中的行为模式,模型能够更加精准地过滤新闻文本中的信息,有效捕捉那些可能引发争议的关键信息点,从而显著提升对新闻真实性的判别精确度。

4 结语在信息传播日益全球化、多样化的背景下,有效应对虚假新闻的严峻挑战成为亟待解决的问题。本文构建了基于BGMA的虚假新闻检测模型,模型的核心在于对用户行为、互动模式以及信息传播路径等信息的深入挖掘与分析,同时紧密结合文本内容特征。细致地分析这些数据,可以更全面地理解虚假信息的传播机制与影响范围,这不仅有助于识别出关键的传播节点和与之紧密关联的群体,更为及时制定并实施针对性的应对策略提供了有力支持。

为验证模型的效果,本文在PolitiFact数据集和GossipCop数据集上进行了详尽的验证。研究结果表明,基于BGMA的社交媒体虚假新闻检测模型在这两个数据集上都展现出优异的性能,充分证明该方法的有效性和可行性。BGMA模型不仅为虚假新闻爆发期提供了一套有效的应对手段,更为深入理解社交网络中信息的传播机制,以及制定更为精准的信息管理策略提供了有益的启示。但因信息传播在现实中的动态性和复杂性,模型仍有较大的提升空间,后续仍会进一步优化提升虚假新闻检测效果。

| [1] |

王军. 基于元宇宙技术集的智慧媒体技术引擎构建研究[J]. 新闻爱好者, 2022(12): 28-31. WANG J. Research on the construction of smart media technology engine based on metauniverse technology set[J]. Journalism lover, 2022(12): 28-31. (  0) 0) |

| [2] |

胡舜邦, 王琳, 刘伍颖. 基于预训练表示和宽度学习的虚假新闻早期检测[J]. 郑州大学学报(理学版), 2025, 57(2): 31-36. HU S B, WANG L, LIU W Y. Early detection of fake news based on pre-training representationand broad learning[J]. Journal of Zhengzhou university (natural science edition), 2025, 57(2): 31-36. (  0) 0) |

| [3] |

冀源蕊, 康海燕, 方铭浩. 基于Attention与Bi-LSTM的谣言识别方法[J]. 郑州大学学报(理学版), 2023, 55(4): 16-22. JI Y R, KANG H Y, FANG M H. Rumor recognition method based on attention and Bi-LSTM[J]. Journal of Zhengzhou university (natural science edition), 2023, 55(4): 16-22. DOI:10.13705/j.issn.1671-6841.2022039 (  0) 0) |

| [4] |

王军, 崔云烨, 张宇航. 世界模型研究综述[J]. 郑州大学学报(理学版), 2024, 56(5): 1-12. WANG J, CUI Y Y, ZHANG Y H. Overview of world models[J]. Journal of Zhengzhou university (natural science edition), 2024, 56(5): 1-12. DOI:10.13705/j.issn.1671-6841.2024078 (  0) 0) |

| [5] |

WU L, SUN P J, HONG R C, et al. SocialGCN: an efficient graph convolutional network based model for social recommendation[EB/OL]. (2018-11-07)[2024-04-25]. http://arxiv.org/abs/1811.02815.

(  0) 0) |

| [6] |

MA J, GAO W, WONG K F. Detect rumors in microblog posts using propagation structure via kernel learning[C]//Proceedings of the 55th Annual Meeting of the Association for Computational Linguistics. Stroudsburg: ACL Press, 2017, 708-717.

(  0) 0) |

| [7] |

LIU Y, WU Y F. Early detection of fake news on social media through propagation path classification with recurrent and convolutional networks[EB/OL]. (2018-04-25)[2024-04-27]. https://ojs.aaai.org/index.php/AAAI/article/view/11268.

(  0) 0) |

| [8] |

尹鹏博, 潘伟民, 彭成, 等. 基于用户特征分析的微博谣言早期检测研究[J]. 情报杂志, 2020, 39(7): 81-86. YIN P B, PAN W M, PENG C, et al. Research on early detection of weibo rumors based on user characteristics analysis[J]. Journal of intelligence, 2020, 39(7): 81-86. (  0) 0) |

| [9] |

DOU Y T, SHU K, XIA C Y, et al. User preference-aware fake news detection[C]//Proceedings of the 44th International ACM SIGIR Conference on Research and Development in Information Retrieval. New York: ACM Press, 2021: 2051-2055.

(  0) 0) |

| [10] |

DEVLIN J, CHANG M W, LEE K, et al. BERT: pre-training of deep bidirectional Transformers for language understanding[EB/OL]. (2018-10-11)[2024-04-27]. https://arxiv.org/pdf/1810.04805v2.

(  0) 0) |

| [11] |

VELIČ KOVIĆ P, CUCURULL G, CASANOVA A, et al. Graph attention networks[EB/OL]. (2017-10-30)[2024-04-27]. https://arxiv.org/pdf/1710.10903.

(  0) 0) |

| [12] |

VASWANI A, SHAZEER N, PARMAR N, et al. Attention is all you need[C]//Proceedings of the 31st International Conference on Neural Information Processing Systems. New York: ACM Press, 2017: 6000-6010.

(  0) 0) |

| [13] |

SHU K, MAHUDESWARAN D, WANG S H, et al. FakeNewsNet: a data repository with news content, social context, and spatiotemporal information for studying fake news on social media[J]. Big data, 2020, 8(3): 171-188. (  0) 0) |

| [14] |

FEY M, LENSSEN J E. Fast graph representation learning with PyTorch geometric[EB/OL]. (2019-03-06)[2024-04-27]. https://arxiv.org/pdf/1903.02428.

(  0) 0) |

2025, Vol. 57

2025, Vol. 57