2. 中国科学院大学电子电气与通信工程学院, 北京 100049;

3. 可持续发展大数据国际研究中心, 北京 100094

2. School of Electronic, Electrical and Communication Engineering, University of Chinese Academy of Sciences, Beijing 100049, China;

3. International Research Center of Big Data for Sustainable Development Goals, Beijing 100094, China

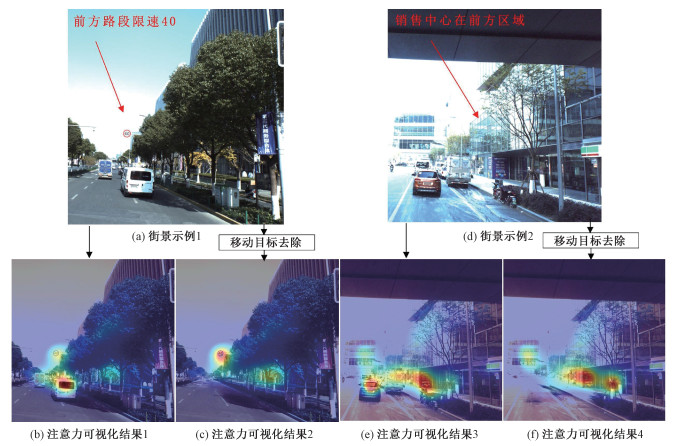

随着城市化的迅速推进与城市规划管理需求,利用信息技术构建高度智能化、高效能的城市环境已经成为当代城市规划和管理中的重要组成部分[1]。其中,数字地图生成与城市实景三维建模是城市数字化的重要环节,通过现实与虚拟的交互使得城市环境变得可量测、可分析、可感知,提高城市规划与管理用户的体验沉浸感[2-3],从而提高城市规划与管理的效率。随着传感器技术和无人驾驶的快速发展,街景图像以行人的视角详细系统记录城市街道的景象,图像中包含的城市基础设施信息丰富,提供了街道层级的人造景观和自然景观,为精确化地图服务[4]和精细化城市环境建模[5]提供重要数据源,大幅提高了城市环境数字化刻画的准确性和完整性。然而,采集街景数据常包含大量移动目标(行人、车辆等),它们不仅遮挡了城市的静态环境结构和纹理信息,还可能对城市环境数字场景的准确性产生负面影响。例如,如图 1(b)和1(e)所示,当用户使用增强现实(augmented reality,AR)导航时,街景图像中不同尺度的行人、车辆等干扰目标会分散其视觉注意力,从而降低用户的寻址体验感。传统的街景图像预处理方法通常采用对移动目标信息进行模糊或替换的方式,以保护隐私。然而,这种处理方式未能兼顾到城市环境建模的局部一致性。因而如何高效地处理街景图像中存在的移动目标,为数字化城市应用提供可靠的数据源,一直是街景图像城市环境应用领域亟需解决的问题。

|

Download:

|

| 图 1 移动目标去除前后街景图像注意力热力图 Fig. 1 Attention heatmaps of street scene images before and after moving object removal | |

图像修复旨在使用合理的视觉内容去填充图像中缺失的区域,从而生成高保真的图像内容,已广泛应用于图像编辑[6]、目标去除[7]以及老照片修复等[8]领域。传统的图像修复算法通常分为基于样本块[9-10](patch-based)和基于扩散[11-12](diffusion-based)2类。前者通过匹配未损坏图像区域的候选块并复制到损坏区域来修复图像,后者则将已知信息通过特定方向扩散到损坏区域。但这2种方法难以理解图像高级语义,对于大面积缺损区域修复效果有限。

近些年来,基于深度学习的图像修复方法通过卷积神经网络[13](convolutional neural network,CNN)和对抗生成网络[14](generative adversarial networks,GAN)学习图像的高层次特征以及分布,生成更符合人类视觉的修复结果。Pathak等[15]首先提出用编解码器学习填充损坏区域的高层特征,而Iizuka等[16]在此基础上,将全局和局部鉴别器进行联合训练,提高了细节修复能力。Yu等[17]引入从粗略到细化的2阶段网络模型对图像进行修复,第1阶段网络进行粗略预测,第2阶段网络将粗修复预测结果作为输入并预测产生更精确修复结果,但忽略了缺失像素和有效像素之间的区别,修复结果会出现部分失真。因此,有学者采用部分卷积[18]、门控卷积[19]、区域归一化连接[20]、快速傅里叶卷积[21](fast Fourier convolution,FFC)和面向图像修复的Transformer[22]让模型更加关注图像的有效信息。但是街景图像不同于自然图像,其通常存在场景复杂、元素遮挡等问题。上述方法缺乏足够的暖色区域的偏移表明人们对静态地标的关注显著提升。先验特征引导,导致生成的结果无法满足自然和语义匹配的要求,易出现边界模糊和结构扭曲。为解决这一问题,相关学者引入其他监督信息以增强图像的上下文一致性。Liao等[23]通过引入精细化标注的语义图作为监督信息,有效地修复边缘和区域信息。Nazeri等[24]通过利用图像的边缘信息作为先验信息设计了2阶段的修复网络,进一步提升图像的结构一致性。但边缘与语义结构之间存在不明确的从属关系易生成错误的边缘结构。Pinto等[25]设计了一种利用语义图和边缘作为先验信息的多阶段修复网络,以增强图像修复的结构一致性。Cao和Fu[26]通过将室内城市场景中的结构细节(如边缘和线条)映射到一个特定的张量空间,成功地还原了人造环境中的结构细节。然而,基于多阶段修复的方法具有明显的局限性,因为修复结果高度依赖于语义图和边缘,容易导致误差累积,使结果出现局部结构不一致和细节还原不准确等问题。此外,这些方法需要大量的人工标注工作来创建语义标签,非常耗时费力。

针对上述问题,本文提出基于多尺度语义先验的街景图像修复算法,利用语义先验网络增强修复算法对图像全局上下文的理解,减轻标注负担。并采用多尺度特征融合策略减少误差积累,增强整体结构纹理。最后在图像编码阶段融入上下文注意力以更好地保持图像要素的细节信息。本文基于Apolloscape数据集对算法的有效性进行分析验证,结果表明相较于现有的方法,该方法能够更好地还原城市的静态环境,生成的图像在语义结构连贯性和细节纹理等方面取得了显著的改进。本文的工作不仅能够显著提高用户对静态地标的关注,而且为行人隐私保护提供了可靠的解决方案,如图 1(c)和1(f)所示。这将有助于提高数字城市化中街景图像的数据质量和一致性,为城市规划与管理、AR导航以及其他领域的应用提供更可靠的数据基础。

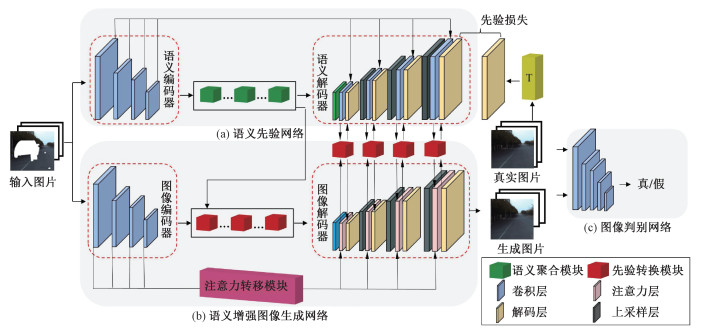

1 多尺度语义先验引导的图像修复算法本节详细介绍基于多尺度语义先验引导的街景图像修复算法的整体架构,如图 2所示。本文提出的算法框架分为3个主体部分:语义先验网络、语义增强图像生成网络以及图像判别网络。首先,输入数据包括RGB图像

|

Download:

|

| 图 2 多尺度语义先验引导的图像修复算法架构 Fig. 2 Architecture of the proposed algorithm | |

图像修复旨在重新生成图像中的破损区域,但是当其破损区域较大时,尤其在处理场景复杂和多目标遮挡的街景图像中,往往生成的结果易出现局部结构扭曲,难以获取全局一致的结果。为解决这一问题,本文提出语义先验网络,它可在预训练模型的监督下学习缺失区域像素的语义信息以及上下文信息,帮助修复算法更加准确地还原出缺失区域的结构特征,使修复结果具有结构上的合理性。语义先验网络采用U-Net[27]架构,如图 2(a)所示,首先将RGB图像Iin以及二值掩码Min送入语义编码器Es中,经过下采样获得不同尺度的语义编码特征,其编码过程可定义为(特征图尺寸为

| $ \boldsymbol{S}_l^{\text {Enco }}=E_{\mathrm{s}}\left(\boldsymbol{I}_{\mathrm{in}} \odot\left(1-\boldsymbol{M}_{\mathrm{in}}\right)\right), $ | (1) |

其中:⊙为哈达玛乘积。

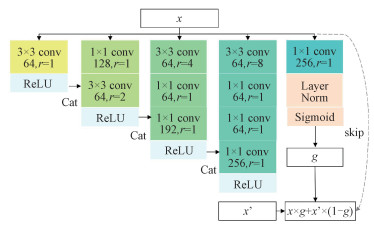

语义先验网络组合了8个语义金字塔聚合模块(semantic pyramidal aggregation module, SPA)去提取不同尺度的特征,其SPA模块结构如图 3所示。一方面可进一步增强图像内容和语义特征之间的映射,以提高语义先验网络的学习能力;另一方面,复杂场景下的城市街景目标拥有不同程度的视角,因此捕捉尽可能丰富的视觉特征模式有助于上下文内容推理。本研究将最后一个降采样的特征送入SPA模块中,SPA模块首先将标准卷积核在通道上划分成4个子卷积核。例如,将输出通道为256的卷积核分成4个子卷积核,每个特征图输出通道为64。再使用空洞卷积核[28]可以获取不同的感受野,较大的空洞卷积核能关注全局特征,而使用较小的空洞卷积核将专注于局部特征模式。但由于使用较大的空洞卷积核会损失信息的连续性,因此将使用较小空洞卷积核得到的特征图逐层在通道上进行叠加,以提高全局与局部信息的一致性。最后,本研究采用门控残差连接机制将输入的特征x和学习到的残差特征x′进行聚合,以缓解普通的残差连接因忽略缺失区域内外像素之间的差异而导致的颜色差异问题[29]。门控残差连接机制首先通过标准卷积和sigmoid运算从x中计算出门限值g,然后SPA块将输入特征x和学习到的残差特征x′与g进行加权运算,既能更新区域内的特征,又保留了区域外的已知特征。即

| $ x_{\mathrm{out}}=x \times g+x^{\prime} \times(1-g) . $ | (2) |

|

Download:

|

| 图 3 SPA结构图 Fig. 3 SPA structure diagram | |

本研究在语义先验网络解码阶段引入跳跃连接,将编码特征注入语义解码器中,得到各级解码语义特征 S lDeco,可有效降低上下文结构信息丢失和避免梯度消失的问题,即

| $ \boldsymbol{S}_l^{\text {Deco }}=\operatorname{Conv}\left(\mathrm{U}\left(\boldsymbol{S}_{l+1}^{\text {Deco }}\right), \boldsymbol{S}_l^{\text {Enco }}\right) . $ | (3) |

其中:Conv表示卷积,U代表上采样。

特定任务下的预训练模型能够提取图像的丰富语义特征信息,可帮助模型理解复杂街景场景下的上下文信息。利用在OpenImage数据集[30]上训练的用于图像分类的预训练模型[31]T为语义先验网络提供监督信息,将更具鉴别性的图像特征知识转移到语义先验网络中。将原始图像Igt输入T中,得到不同尺度的特征图S ldist

| $ \boldsymbol{S}_l^{\text {dist }}=T_{\mathrm{s}}\left(\boldsymbol{I}_{\mathrm{gt}}\right) . $ | (4) |

最后,利用先验损失Lprior监督语义先验网络学习确定的特征内容,计算语义先验网络学习的语义特征与预训练模型提取的图像特征之间的L1损失,即

| $ L_{\text {prior }}=\sum\nolimits_l\left\|\left(\boldsymbol{S}_l^{\text {dist }}-f\left(\boldsymbol{S}_l^{\text {Deco }}\right) \odot\left(1+\alpha \boldsymbol{M}_l\right)\right)\right\|_1 . $ | (5) |

其中:f()将编码后的特征进行通道映射以便进行误差计算;Ml为调整后的掩膜,其大小等于 S distl;α为对掩模区域的附加约束。

1.1.2 语义增强图像生成网络与语义先验网络相似,语义增强图像生成网络先将RGB图像Iin以及二值掩码Min送入图像编码器Em中,如下

| $ \boldsymbol{F}_l^{\text {Enco }}=E_l\left(\boldsymbol{I}_{\mathrm{in}} \odot\left(1-\boldsymbol{M}_{\mathrm{in}}\right)\right) . $ | (6) |

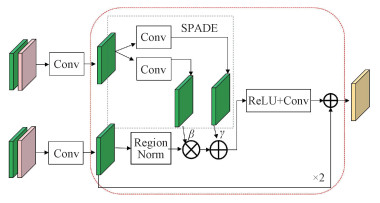

在利用学习语义先验来引导图像恢复时,需要进一步考虑以下问题:图像特征和语义先验特征关注的图像内容不同,仅将其拼接进行特征融合不仅会影响生成图像的纹理,而且会干扰网络的学习。为解决这个问题,受文献[32]的启发,设计LPT用于将学到的先验特征融合到图像生成的特征中,LPT模块的结构如图 4所示。这一设计不仅能够增强模块之间的信息交换,使得生成的图像结构在全局与局部具有良好的一致性,还能使模型根据不同的语义先验的重要性自适应地生成图像。具体而言,本研究将图像编码特征和最高级的语义先验特征输入到8个LPT模块中进行特征融合。LPT模块首先用区域归一化对输入图像特征F lu进行归一化。然后,再利用SPADE[32]从S lDeco中学习2组不同的仿射变换参数[β, γ],并将这些参数应用于图像特征进行仿射变换,如下

| $ [\beta, \gamma]=\operatorname{SPADE}\left(\boldsymbol{S}_l^{\text {Deco }}\right), $ | (7) |

| $ \boldsymbol{F}^{\prime}{ }_l=\beta \cdot \operatorname{RN}\left(\boldsymbol{F}_l^{\mathrm{u}}\right)+\gamma . $ | (8) |

|

Download:

|

| 图 4 LPT结构图 Fig. 4 LPT structure diagram | |

其中:RN代表区域归一化。

为更好地保留图像的低级特征,如纹理和颜色等,以提高图像修复的质量,采用多级注意力转移机制[33]。该机制将高级特征空间的补丁相似性应用于相邻低级特征空间,以精确地重构出具有语义完整性和丰富纹理细节的特征图,并将其应用于图像生成器的所有编码层,从而确保各级解码特征的上下文一致性。具体而言,注意力计算模块先将特征图F lEnco下采样一次得到高级特征,再根据其缺损区域内外提取相同大小的补丁块(3×3)计算其余弦相似度,并使用Softmax函数公式计算各个特征补丁的注意力得分,如下

| $ \boldsymbol{F}_{i j}=\left\langle\frac{f_i}{\left\|f_i\right\|_2}, \frac{f_j}{\left\|f_j\right\|_2}\right\rangle, $ | (9) |

| $ \boldsymbol{F}_{i j}^{\text {soft }}=\frac{\exp \left(\boldsymbol{F}_{i j}\right)}{\sum\limits_{j=1}^N \exp \left(\boldsymbol{F}_{i j}\right)} . $ | (10) |

其中: N表示背景补丁的数量,fi与fj分别对应特征图的第i和第j个提取的补丁。最后利用注意力分数对低级特征图的补丁块进行加权复制,以填充破损区域,即通过提取的补丁根据注意力重构特征图,其公式为

| $ \boldsymbol{F}_l^{\mathrm{Attn}}=\sum\limits_{j=1}^N \boldsymbol{F}_l \cdot \boldsymbol{F}_{i j}^{\mathrm{soft}} . $ | (11) |

多尺度图像解码器会先将融合的高级特征与重构特征图进行特征拼接,将上采样的图像拼接特征与语义先验特征送入单个LPT模块进行特征融合,最终得到修复结果 I p。其过程可定义为

| $ \boldsymbol{F}_l^{\text {Deco }}=\operatorname{LPT}\left(\mathrm{U}\left(\operatorname{Conv}\left(\boldsymbol{F}_l^{\text {Attn }}, \boldsymbol{F}_l^{\text {Deco }}\right)\right), \boldsymbol{S}_l^{\text {Deco }}\right), $ | (12) |

| $ \boldsymbol{I}_{\mathrm{p}}=\operatorname{Conv}\left(F_1^{\text {Deco }}\right) . $ | (13) |

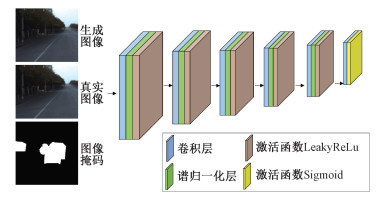

判别网络主要作用是区分生成图像与原始图像,通过与生成器的对抗性训练,有助于改善生成图像的细节纹理和边界伪影,以更精细地捕捉图像中不同区域的细节,从而提升生成图像的质量。本文采用的是基于软掩码的马尔可夫判别网络[29],将图像分割成多个重叠的区块(Patch),并对每个Patch进行判别,最后取平均判别结果的均值输出True或者False,其结构如图 5所示。为进一步让训练更加稳定,在判别网络的卷积层设计中引入谱归一化层[34],让训练添加更多的梯度信息和限制。谱归一化的主要思想在于严格约束每一层网络权重矩阵,使判别网络满足Lipschitz连续性。判别网络可视为多层神经网络的叠加,在不考虑激活函数和偏置的情况下,输入x可得

| $ D_n=\boldsymbol{W}_n \times \boldsymbol{W}_{n-1} \times \cdots \times \boldsymbol{W}_1 \times x . $ | (14) |

|

Download:

|

| 图 5 判别网络结构图 Fig. 5 Structure of discriminator network | |

其中:D表示判别网络中的线性映射函数,W为参数矩阵。对于判别网络中任一层网络,其参数矩阵的谱范数可以定义为

| $ \mathit{\sigma}(\boldsymbol{W})=| \max \left\{\boldsymbol{\mu}\left(\boldsymbol{W} \boldsymbol{W}^{\mathrm{T}}\right)\right\} |_1 . $ | (15) |

其中:σ(W)表示矩阵W的最大奇异值,即矩阵W的谱范数;μ代表矩阵W的最大奇异值对应的特征向量。结合Lipschitz条件和式(14)、式(15),可得

| $ \begin{aligned} \frac{\left|D\left(x_1\right)-D\left(x_2\right)\right|}{\left|x_1-x_2\right|} & \leqslant\left|\boldsymbol{W}_n\right| \times\left|\boldsymbol{W}_{n-1}\right| \times \\ \cdots \times\left|\boldsymbol{W}_1\right| & \leqslant \prod\limits_{i=1}^n \sigma\left(\boldsymbol{W}_i\right) . \end{aligned} $ | (16) |

谱归一化通过让参数矩阵除以参数矩阵的谱范数,从而达到归一化的目的。此时,参数矩阵数值经过一定比例的缩放,满足Lipschitz条件,即

| $ f_{\mathrm{SN}}(\boldsymbol{W})=\frac{\boldsymbol{W}}{\sigma(\boldsymbol{W})} \leqslant L. $ | (17) |

其中:fSN(W)为判别网络参数矩阵W经过谱归一化后的结果,L为常数。总之,谱归一化层的主要任务是将权重矩阵的谱范数限制在一个合理的范围内,从而避免梯度爆炸和梯度消失问题,提高网络的稳定性。最后,判别网络在传统Patch-GAN的基础上引入图像掩码,用于指示生成器应该关注哪些区域,尤其是破损和边界的区域,有助于生成器更加专注于修复破损部分,并减少不必要的伪影。

1.3 损失函数在图像修复模型中,选择适当的损失函数是决定生成结果像素精度和视觉保真度的重要因素。因此,为进一步提高模型的图像生成质量,选择重建损失Lrec、风格损失Lstyle、感知损失Lperc、对抗损失Ladv以及先验损失Lprior组成最终的损失函数。首先,利用重建损失Lrec可确保精确的像素重建,即

| $ L_{\mathrm{rec}}=\left\|\left(\left(\boldsymbol{I}_{\mathrm{p}}-\boldsymbol{I}_{\mathrm{gt}}\right) \odot(1+\alpha \boldsymbol{M})\right)\right\|_1 . $ | (18) |

感知损失本质上是缩小生成结果和真值之间的L1距离,使得生成的图像可以更好地保留原始图像的结构和内容,即

| $ L_{\text {perc }}=\sum\limits_i \frac{\left\|\mathit{Φ}_i(x)-\mathit{Φ}_i(z)\right\|_1}{N_i} . $ | (19) |

其中:Φi(x)是预训练模型(例如VGG19[35])第i层的特征输出,Ni是Φi(x)中的元素数量。而风格损失则是衡量生成图像和原始图像之间的样式差异,通过缩小生成特征和真实特征的Gram矩阵之间的L1距离,来保留图像的纹理和颜色,公式为

| $ L_{\text {style }}=E\left[\left\|\mathit{Φ}_i(x)^{\mathrm{T}} \mathit{Φ}_i(x)-\mathit{Φ}_i(z)^{\mathrm{T}} \mathit{Φ}_i(z)\right\|_1\right] . $ | (20) |

对抗损失LadvD衡量了判别网络对修复图像的评估能力,以及生成器生成的修复图像的真实性。同时,LadvG则鼓励生成器生成更真实的图像纹理和颜色,公式为

| $ \begin{aligned} L_{\text {adv }}^{\mathrm{D}}= & E_{z \sim P_z}\left[(D(z)-\sigma(1-\boldsymbol{M}))^2\right]+ \\ & E_{x \sim P_{\text {data }}}\left[(D(x)-1)^2\right], \end{aligned} $ | (21) |

| $ L_{\mathrm{adv}}^{\mathrm{G}}=E_{z \sim P_z}\left[(D(z)-1)^2 \odot \boldsymbol{M}\right] . $ | (22) |

综上,修复网络将联合上述损失函数来优化训练,其总表达式为

| $ \begin{gathered} L=L_{\text {prior }}+\lambda_{\text {rec }} L_{\text {rec }}+\lambda_{\text {perc }} L_{\text {perc }}+ \\ \lambda_{\text {style }} L_{\text {style }}+\lambda_{\text {adv }} L_{\text {adv }}^D . \end{gathered} $ | (23) |

其中:Lprior的表达式为式(5),并且本文通过实验选用α=1、λrec=1、λperc=0.5、λstyle=250、λadv=0.01对模型进行训练。

2 实验与分析 2.1 数据收集与预处理选择Apolloscape数据集中的20 266张图像,将其按照9∶1的比例划分为训练数据和测试数据。在训练和测试过程中,对图像进行随机裁剪,将其分辨率调整为512像素×512像素。为生成掩码数据,利用语义分割标签文件中的移动目标对象,并随机生成不同破损区域的掩码。然后将这些掩码分为5个破损程度区间,分别为10 % ~20 %,20 % ~30 %,30 % ~40 %,40 % ~50 % 和50 % ~60 %。最终,总共生成2万张分辨率为512像素×512像素的不规则掩码图像,用于模型的训练和测试。生成的掩码数据集示例如图 6所示。为进一步验证模型的泛化性能,采用文献[36]的掩码生成方法,生成共计1 200张分辨率为512像素×512像素的规则掩码用于验证测试。

|

Download:

|

| 图 6 输入掩码数据集示例图 Fig. 6 Examples of input mask datasets | |

实验基于Ubuntu环境下的深度学习框架PyTorch实现,GPU为Tesla V100显卡,批处理大小为4,使用Adam优化器优化目标函数,其优化器参数为β1=0和β2=0.99。最终,设置生成网络与判别网络的初始学习率为1×10-4,且将网络进行了200 K次迭代训练,在180 K次衰减学习率。

2.2 实验分析为更好地对本文算法模型的修复能力进行验证,本文将所提算法分别与AOT[29]、LaMa[21]以及MAT[22] 3种算法进行定性和定量评价。并将上述3种算法重新在Apolloscape数据集上进行训练,使用相同的图像-掩膜对进行测试验证。最后,还对本文的算法模型进行了一定的消融实验,探究每个模块对模型总体性能的影响。

2.2.1 定量比较表 1展示了本文算法与其他算法在Apolloscape数据集上的定量比较结果,表中加粗数字表示最佳结果。采用几个常见的图像修复评价指标,包括峰值信噪比(peak signal-to-noise ratio,PSNR)、结构相似性(structural similarity,SSIM)、绝对误差(mean absolute error,MAE)、均方根误差(root mean square error,RMSE)以及学习感知图像块相似度(learned perceptual image patch similarity,LPIPS)等评估不同算法的性能。PSNR以dB为单位,用于度量2幅图像之间相应像素的误差,数值越大表示失真越小。SSIM用于衡量2张图片之间结构、亮度和对比度的相似程度,数值越接近于1表示2张图片越相似。MAE和RMSE分别测量修复图像像素与原始图像像素之间的绝对误差和均方根误差,数值越低表示差距越小。LPIPS通过深度CNN模拟人类视觉系统的感知方式,提供更准确的图像质量评估和比较方法,用于衡量图像之间的感知差异。从表中数据来看,LaMa和MAT的表现相对较好。因此,将本文算法与这2种算法的客观指标进行比较。相较于LaMa算法,本文算法在不规则掩码上的PSNR平均提高0.14 dB,SSIM平均提高0.31 %,MAE、RMSE以及LPIPS平均降低12.82 %、1.43 % 和2.36 %。与MAT算法相比,本文算法在不规则掩码上的PSNR平均提高0.18 dB,SSIM平均提高了0.45 %,MAE、RMSE以及LPIPS平均降低14.14 %、4.74 % 和9.20 %。另外,本文算法在修复较为简单的规则掩膜下的结果在PSNR和SSIM等指标上依然领先其他3个算法。因此可得出结论:本文算法在结构相似性和低级像素客观指标方面具有明显的竞争优势,表明该算法在处理复杂场景下的街景图像时具有更高的准确性和鲁棒性。

|

|

表 1 Apolloscape数据集上本文算法与其他算法定量比较结果 Table 1 Quantitative comparison results between proposed algorithm and other algorithms on Apolloscape dataset |

在现实场景中,很难获取大规模的动态与静态街景图像对,因此评估移动目标去除的质量变得极其困难。在这种情况下,很难使用客观指标可靠地评估移动物体去除的图像质量,主要依靠人的主观评价。图 7展示了本文算法与AOT、LaMa和MAT算法在移动目标去除效果上的比较。AOT算法充分利用了上下文信息和多种转换方式,在图像细节纹理方面表现不俗,但无法实现结构的全局一致性,例如第1行和第4行修复后的图像出现路肩区域的结构扭曲和模糊不真实的情况。LaMa采用FFC代替传统卷积,能够在浅层网络获得更大的感受野,在重复纹理结构简单的场景下修复效果较好,如第1行和第3行路面区域,但是当干扰目标较大时结果存在明显的结构扭曲,如第2行的路肩区域和第5行道路标志线区域。MAT根据图像修复设计了新的Transformer块,能够利用破损区域周围的信息生成破损区域内的内容,生成的结果虽然能够恢复总体的纹理和结构,但是区域颜色过渡不自然,如第2行的路面存在颜色结构断层。此外,第1行和第4行的结果会重新生成干扰目标。相对于其他算法,本文提出的算法采用语义先验作为引导,可进一步增强图像的上下文信息,从而生成的道路边界和标线更加自然连贯。此外,本文采用多尺度注意力特征、低级图像特征和语义特征逐层融合的策略,使得生成的路面纹理更加清晰自然,深层次地完善了图像的低频信息,更符合人类的视觉感知。

|

Download:

|

| 图 7 在Apolloscape数据集上干扰目标移除结果对比图 Fig. 7 Object removal comparisons with existing methods on Apolloscape dataset | |

为进一步验证本文提出的移动目标去除方法的有效性和性能,本研究展开了用户问卷调研,邀请32位具备图像处理专业知识的参与者参与调研实验,要求其从不同算法生成的结果中选择最佳者。调研问卷共设计30个问题,每个问题都涵盖本文提出的算法以及其他对比算法(AOT、LaMa、MAT)所生成的静态街景结果。参与者事前并不了解所评估的具体图像修复方法,同时为确保评价的客观公平,图像位置在问卷中是随机变化的。共收集到960个有效的投票结果,并对投票结果进行了统计分析。表 2详细列出了本文算法和其他对比方法在调研中的表现。在比较结果中,符号“>”表示本文算法的结果优于对比方法,而“ < ”表示对比方法优于本文算法,“=”表示难以通过肉眼分辨两者的优劣。从表中可以观察到,本文算法取得了较好的表现,支持率均超过70 %。值得注意的是,在与MAT算法结果的对比中,本文算法甚至获得了81.86 % 的高支持率。由此,这一调研结果有力地证实了本文所提方法的有效性和良好性能。

|

|

表 2 用户调研结果汇总表 Table 2 Results of user study |

除与之前的基准修复方法进行比较外,在Apolloscape数据集上进行了消融实验,以分析模型中各个模块对网络最终性能的贡献,如表 3所示。

|

|

表 3 在Apolloscape数据集上不同网络模块对整体模型精度的对比消融实验 Table 3 Comparative ablation experiments of different network modules on overall model accuracy on Apolloscape dataset |

首先,实验B去除了在特定任务下的语义先验监督。对比实验A和实验B的结果,可以明显观察到,去除语义先验监督后,网络性能显著下降。这进一步验证了语义先验在模型理解图像上下文方面的关键作用。同时,该实验也进一步证实采用预训练模型的知识进行迁移学习可以提高在复杂城市场景下的图像处理任务性能。接下来,实验C采取直接移除先验转移模块,并将先验特征和图像特征直接进行通道拼接。在实验C各个评价指标下,模型都出现了显著的性能下降。这表明先验转移模块对于多尺度语义先验和低级特征之间的建模起到了关键作用。此外,实验D还通过去除注意力转移模块来验证其对生成图像细节纹理的影响,从实验D的MAE指标大幅上升可以看出,注意力转移模块能够有效地保留图像的低维特征,特别是远程依赖关系。最后,实验E去除了语义先验网络中的语义聚合模块,这进一步证明丰富的视觉特征模式有助于上下文内容推理。总地来说,这些消融实验结果强有力地支持了本文模型中各个关键模块的重要性,从而为图像修复任务提供了更深入的理解和指导。

3 结论本文结合多尺度语义先验,提出一种基于GAN的街景图像修复算法,重建街景图像中干扰目标(行人、车辆等)所遮挡的静态环境,为数字地图服务和城市实景三维建模等数字化城市应用提供可靠的数据源。该算法利用语义先验网络从预训练模型中学习多尺度的先验特征,以增强网络对图像上下文的理解能力,从而为修复过程提供结构信息的指导。此外,多尺度语义增强图像生成网络包含2个特征处理通道。一方面,它通过多个先验转换模块自适应地将高级语义先验特征与底层图像特征融合,从而使生成的图像具有全局一致的语义结构。另一方面,借助注意力转移模块实现特征重构,进而实现网络的长程依赖建模与精细修复。判别网络通过基于区域全卷积的方式区分生成图像和真实图像之间的差别,从而使得生成网络生成更真实的街景图像。实验结果表明,该算法相较于现有的算法,在移除移动目标后生成的图像结构更具合理性且纹理细节更加真实,可以实现批量去除街景图像中的干扰目标。在算法测试过程中,发现本文算法也需要从以下2个方面着手改进:1)本文提出的算法结果容易受到阴影的干扰,容易产生黑色斑块,后续研究将标注相关数据集以及引入阴影检测模块,减少干扰信息的输入;2)实验中发现当移动目标区域大于图像区域的60 % 时,由于图像可用信息的不足,算法生成的结果可能产生运动伪影。未来的研究工作中,我们将从点云、视频等多源传感器数据融合的角度出发,解决目前以图像为单一数据源的方法存在的不足,从而实现城市街景图像中移动目标去除与静态环境的重建,为大规模实景化城市应用提供更可靠的基础数据。

| [1] |

吴江寿, 王洪深, 张洁. 大数据时代数字化城市管理智慧应用实践[J]. 地理信息世界, 2015, 22(3): 107-110. Doi:10.3969/j.issn.1672-1586.2015.03.020 |

| [2] |

郭华东. 大数据时代的"数字地球"[J]. 中国战略新兴产业, 2016(17): 94. Doi:10.19474/j.cnki.10-1156/f.000054 |

| [3] |

王锋, 潘德吉, 王俊. 城市三维模型海量数据动态组织调度方法[J]. 中国科学院大学学报, 2015, 32(3): 409-415. Doi:10.7523/j.issn.2095-6134.2015.03.018 |

| [4] |

汪淼. 城市三维街景地理信息服务平台设计与应用[J]. 测绘通报, 2016(12): 108-110, 123. Doi:10.13474/j.cnki.11-2246.2016.0413 |

| [5] |

杨伟, 谢维成, 蒋文波, 等. 基于自相似性车载采集城市街景图像的重建[J]. 计算机应用, 2017, 37(3): 817-822. Doi:10.11772/j.issn.1001-9081.2017.03.817 |

| [6] |

胡兵兵, 唐华, 吴幼龙. 基于互信息约束的生成对抗网络分类模型[J]. 中国科学院大学学报, 2022, 39(4): 551-560. Doi:10.7523/j.ucas.2020.0037 |

| [7] |

池凌鸿, 郭立, 郁理, 等. 一种采用自适应机制的分层置信传播算法[J]. 中国科学院研究生院学报, 2011, 28(5): 630-635. Doi:10.7523/j.issn.2095-6134.2011.5.010 |

| [8] |

Elharrouss O, Almaadeed N, Al-Maadeed S, et al. Image inpainting: a review[J]. Neural Processing Letters, 2020, 51(2): 2007-2028. Doi:10.1007/s11063-019-10163-0 |

| [9] |

Barnes C, Shechtman E, Finkelstein A, et al. PatchMatch: a randomized correspondence algorithm for structural image editing[C]//ACM Transactions on Graphics, Proceedings of SIGGRAPH 2009. DOI: 10.1145/1531326.1531330.

|

| [10] |

Ding D, Ram S, Rodríguez J J. Image inpainting using nonlocal texture matching and nonlinear filtering[J]. IEEE Transactions on Image Processing, 2019, 28(4): 1705-1719. Doi:10.1109/TIP.2018.2880681 |

| [11] |

Bertalmio M, Sapiro G, Caselles V, et al. Image inpainting[C]//2000 Proceedings of the 27th Annual Conference on Computer Graphics and Interactive Techniques. New York: ACM, 2000: 417-424. DOI: 10.1145/344779.344972.

|

| [12] |

Liu Z X, Wan W G. Image inpainting algorithm based on KSVD and improved CDD[C]//2018 International Conference on Audio, Language and Image Processing (ICALIP). July 16-17, 2018, Shanghai, China. IEEE, 2018: 413-417. DOI: 10.1109/ICALIP.2018.8455425.

|

| [13] |

Krizhevsky A, Sutskever I, Hinton G E. ImageNet classification with deep convolutional neural networks[J]. Communications of the ACM, 2017, 60(6): 84-90. Doi:10.1145/3065386 |

| [14] |

Goodfellow I, Pouget-Abadie J, Mirza M, et al. Generative adversarial networks[J]. Communications of the ACM, 2020, 63(11): 139-144. Doi:10.1145/3422622 |

| [15] |

Pathak D, Krähenbühl P, Donahue J, et al. Context encoders: feature learning by inpainting[C]//2016 IEEE Conference on Computer Vision and Pattern Recognition(CVPR). June 27-30, 2016, Las Vegas, NV, USA. IEEE, 2016: 2536-2544. DOI: 10.1109/CVPR.2016.278.

|

| [16] |

Iizuka S, Simo-Serra E, Ishikawa H. Globally and locally consistent image completion[J]. ACM Transactions on Graphics, 2017, 36(4): 1-14. Doi:10.1145/3072959.3073659 |

| [17] |

Yu J H, Lin Z, Yang J M, et al. Generative image inpainting with contextual attention[C]//2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City, UT, USA. IEEE, 2018: 5505-5514. DOI: 10.1109/CVPR.2018.00577.

|

| [18] |

Liu G L, Reda F A, Shih K J, et al. Image inpainting for irregular holes using partial convolutions[C]//2018 Computer Vision - ECCV 2018: 15th European Conference. September 8-14, Munich, Germany. New York: ACM, 2018: 89-105. DOI: 10.1007/978-3-030-01252-6_6.

|

| [19] |

Yu J H, Lin Z, Yang J M, et al. Free-form image inpainting with gated convolution[C]//2019 IEEE/CVF International Conference on Computer Vision (ICCV). October 27 - November 2, 2019, Seoul, Korea (South). IEEE, 2020: 4470-4479. DOI: 10.1109/ICCV.2019.00457.

|

| [20] |

Yu T, Guo Z Y, Jin X, et al. Region normalization for image inpainting[J]. Proceedings of the AAAI Conference on Artificial Intelligence, 2020, 34(7): 12733-12740. Doi:10.1609/aaai.v34i07.6967 |

| [21] |

Suvorov R, Logacheva E, Mashikhin A, et al. Resolution-robust large mask inpainting with Fourier convolutions[C]//2022 IEEE/CVF Winter Conference on Applications of Computer Vision (WACV). January 3-8, 2022, Waikoloa, HI, USA. IEEE, 2022: 3172-3182. DOI: 10.1109/WACV51458.2022.00323.

|

| [22] |

Li W B, Lin Z, Zhou K, et al. MAT: mask-aware transformer for large hole image inpainting[C]//2022 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). June 18-24, 2022, New Orleans, LA, USA. IEEE, 2022: 10748-10758. DOI: 10.1109/CVPR52688.2022.01049.

|

| [23] |

Liao L, Xiao J, Wang Z, et al. Guidance and evaluation: semantic-aware image inpainting for mixed scenes[C]//2020 European Conference on Computer Vision. August 23-28, 2020, Glasgow, UK. Cham: Springer, 2022: 683-700. DOI: 10.1007/978-3-030-58583-9_41.

|

| [24] |

Nazeri K, Ng E, Joseph T, et al. EdgeConnect: generative image inpainting with adversarial edge learning[C]//2019 IEEE/ CVF International Conference on Computer Vision Workshop. October 27-28, 2019, Seoul, Korea (South). IEEE, 2019: 10-12. DOI: 10.1109/ICCVW.2019.00408.

|

| [25] |

Pinto F, Romanoni A, Matteucci M, et al. SECI-GAN: semantic and Edge Completion for dynamic objects removal[C]//2020 25th International Conference on Pattern Recognition (ICPR). January 10-15, 2021, Milan, Italy. IEEE, 2021: 10441-10448. DOI: 10.1109/ICPR48806.2021.9413320.

|

| [26] |

Cao C J, Fu Y W. Learning a sketch tensor space for image inpainting of man-made scenes[C]//2021 IEEE/CVF International Conference on Computer Vision (ICCV). October 10-17, 2021, Montreal, QC, Canada. 2022: 14489-14498. DOI: 10.1109/ICCV48922.2021.01424.

|

| [27] |

Ronneberger O, Fischer P, Brox T. U-net: convolutional networks for biomedical image segmentation[C]//2015 International Conference on Medical Image Computing and Computer-Assisted Intervention. Cham: Springer, 2015: 234-241. DOI: 10.1007/978-3-319-24574-4_28.

|

| [28] |

Chen L C, Papandreou G, Kokkinos I, et al. DeepLab: semantic image segmentation with deep convolutional nets, atrous convolution, and fully connected CRFs[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2018, 40(4): 834-848. Doi:10.1109/TPAMI.2017.2699184 |

| [29] |

Zeng Y H, Fu J L, Chao H Y, et al. Aggregated contextual transformations for high-resolution image inpainting[J]. IEEE Transactions on Visualization and Computer Graphics, 2023, 29(7): 3266-3280. Doi:10.1109/TVCG.2022.3156949 |

| [30] |

Kuznetsova A, Rom H, Alldrin N, et al. The open images dataset V4[J]. International Journal of Computer Vision, 2020, 128(7): 1956-1981. Doi:10.1007/s11263-020-01316-z |

| [31] |

Ridnik T, Ben-Baruch E, Zamir N, et al. Asymmetric loss for multi-label classification[C]//2021 IEEE/CVF International Conference on Computer Vision (ICCV). October 10-17, 2021, Montreal, QC, Canada. 2022: 82-91. DOI: 10.1109/ICCV48922.2021.00015.

|

| [32] |

Park T, Liu M Y, Wang T C, et al. Semantic image synthesis with spatially-adaptive normalization[C]//2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). June 15-20, 2019, Long Beach, CA, USA. IEEE: 2332-2341. DOI: 10.1109/CVPR.2019.00244.

|

| [33] |

Yi Z L, Tang Q, Azizi S, et al. Contextual residual aggregation for ultra high-resolution image inpainting[C]//2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). June 13-19, 2020, Seattle, WA, USA. IEEE: 7505-7514. DOI: 10.1109/CVPR42600.2020.00753.

|

| [34] |

Miyato T, Kataoka T, Koyama M, et al. Spectral normalization for generative adversarial networks[EB/OL]. 2018. arXiv: 1802.05957. (2018-02-16)[2023-11-19]. https://arxiv.org/abs/1802.05957.pdf.

|

| [35] |

Simonyan K, Zisserman A. Very deep convolutional networks for large-scale image recognition[EB/OL]. 2014. arXiv: 1409.1556. (2014-11-18)[2023-11-19]. https://arxiv.org/abs/1409.1556.pdf.

|

| [36] |

Zhu M Y, He D L, Li X, et al. Image inpainting by end-to-end cascaded refinement with mask awareness[J]. IEEE Transactions on Image Processing: a Publication of the IEEE, 2021, 30: 4855-4866. Doi:10.1109/TIP.2021.3076310 |

2025, Vol. 42

2025, Vol. 42