2. 中国海洋大学海洋高等研究院,山东 青岛 266100;

3. 山东国兴智能科技股份有限公司,山东 烟台 264006

海参是一种低脂肪、高蛋白食品,海参养殖业在中国存在着巨大的商业价值,但随着海参养殖业发展,人工捕捞成本越来越高,捕捞自动化程度低,捕捞人员很容易患上减压病。因此海参捕捞属于高危行业,市面上急需低人力成本的智能水下采捕机器人来改进捕捞模式、降低捕捞成本,从而提高海参捕捞的自动化水平。

在海参自动捕捞领域,由于移动方式及采捕方式等限制,目前市场上尚未存在成熟的海参捕捞机器人。山东威海未来机器人公司设计的海参捕捞机器人[1]在通过自带的摄像头识别海参后,受人力控制进行海参的抓取,但该机器人单次捕捞数目较少。于敬东等[2]设计了一种履带爬行的海参捕捞机器人,通过吸水泵产生吸力将海参吸入存储仓,受限于水下地形及履带的速度,该机器人采捕效率较低。

随着人工智能的发展,深度学习算法在智能采捕中的水下目标检测领域中得到不断发展及应用。Guo等[3]采用不同配置的深度残差网络对水下海参进行识别,该算法使识别准确率达到89.53%的同时还具备较强的泛化能力。熊海涛等[4]在Faster R-CNN[5]框架的结构上融入了多尺度特征提取层和实例分割功能,提高了算法的自适应特征融合能力,实现了对海参的准确识别,平均精度均值(Mean of Average Precision, mAP)达到了94.47%。Peng等[6]利用短切特征金字塔网络,通过改进现有的多尺度特征融合策略实现对海参的有效识别,最终mAP达到94%。张岚等[7]通过改进单次多框检测器(Single Shot MultiBox Detector,SSD)网络,增加感受野模块(Receptive Field Block,RFB)和注意力机制,对不同的深度特征进行强化,最终海参检测mAP达到了95.63%。然而以上研究仅致力于解决如何在复杂水下环境下检测到海参目标,未能进一步跟吸捕操作结合从而实现海参的自动吸捕的最终目的。

YOLOv3是一种先进的单阶段目标检测框架,YOLOv3-tiny[7-9]是在YOLOv3基础上的轻量级检测网络,YOLOv3-tiny及其改进的网络在精确度和速度之间进行折中,在牺牲一定精确度的基础上大大提高了移动目标的检测速度,在自主移动平台得到了大量的应用。

以上方法解决了快速实时的目标检测问题,还未能实现海参吸捕的最终目的。在计算机视觉领域,端到端特指基于视觉的机器控制,具体表现为机器的输入信号为原始图片,输出信号为可以直接控制机器的控制指令。Levine等[10]利用端到端的方法输入图片,输出控制机械手移动的指令来抓取物品,实现了端到端算法在物体抓取中的应用。Youssef等[11]利用端到端的方法输入图片,输出汽车的姿态角度。

本文在以上方法的应用基础之上,提出了一种基于数据驱动和以目标为中心的改进YOLOv3-tiny的端到端海参自主吸捕方法。在YOLOv3-tiny所改进的网络基础上,通过对特征提取网络进行增强,同时对海参数据集边界框尺寸进行重新聚类,在保证实时性的基础上提高识别的准确性,实现吸捕视角下海参目标的端到端精准实时吸捕,推动了海参采捕的智能化发展。

1 海参吸捕机器人设计本文数据集采集及算法搭载设备为中国海洋大学自主研制的海参采捕机器人。

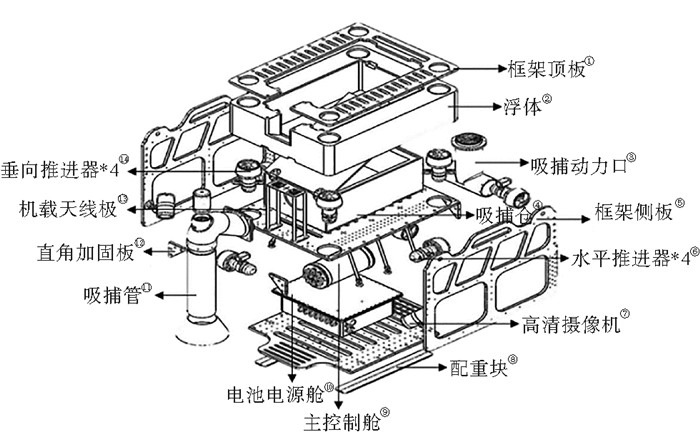

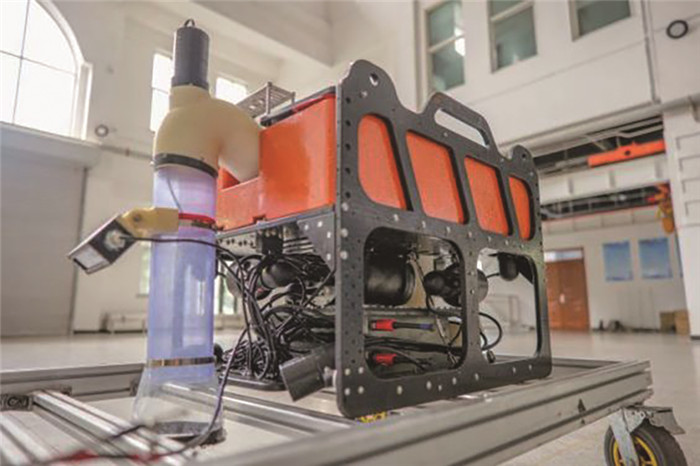

1.1 机器人结构设计水下机器人本体按照执行功能进行分类,主要由机器人框架、浮体、控制耐压舱、电池电源耐压舱、水平推进器、垂向推进器、单目摄像系统、双目识别检测系统和吸捕装置构成。其海参采捕机器人机械结构分布和实物图分别如图 1、2所示。

|

( (①Frame top plate; ②Mega-Float; ③Suction power port; ④Suction capture storage bin;⑤Frame side panel; ⑥Horizontal propeller;⑦High-definition camera;⑧clump weight;⑨Main control room;⑩Battery power compartment;B11 Suction and capture pipeline;B12 Right angle reinforcement plate;B13 Airborne antenna board;B14 Vertical thruster.) ) 图 1 海参吸捕机器人机械结构分布 Fig. 1 Distribution of mechanical structures outside the underwater body |

|

图 2 海参吸捕机器人实物图 Fig. 2 Actual diagram of sea cucumber suction robot |

图像处理器(Graphics processing unit, GPU)输入端为水下摄像系统,其主要由三路单目水下摄像机和双目摄像机构成。其中三路单目水下摄像机主要分别用来观测吸捕管道、吸捕管口和机器人水下运行视野。双目摄像机主要用于海参的识别以及前方水下环境的检测。GPU处理输入端传入的图像信息后对符合吸捕条件的图像给出吸捕信号传输到CPU输出端。

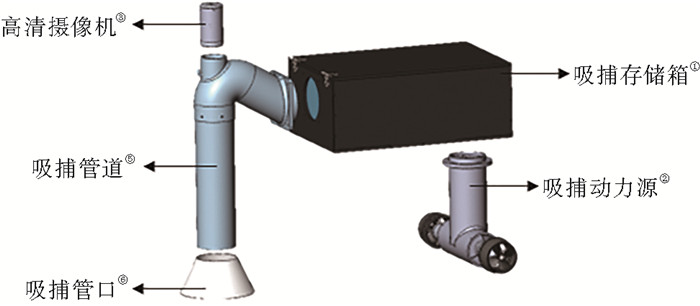

CPU控制的输出端为动力推进系统,其主要由4个十字排布的水平推进器及4个竖向排布的垂向推进器构成,可以实现前进、后退、上浮、下潜、原地拐弯和侧推的功能。吸捕系统主要由吸捕管口、吸捕管道、吸捕舱和吸捕动力推进等部分组成,其中吸捕动力推进装置是采用中轴对称镜向安装的,防止由于吸捕过程中产生对机器人控制姿态不利的影响。CPU可以根据输入端的图像处理结果对以上输出端进行控制。海参吸捕及观测部件如图 4所示。

|

( (①Suction capture storage bin; ②Suction capture power source; ③Suction and capture pipeline; ④Suction and capture pipeline;⑤High-definition camera.) ) 图 3 海参吸捕及观测部件 Fig. 3 Sea cucumber suction and observation components |

|

图 4 改进网络结构图 Fig. 4 Improved network structure diagram |

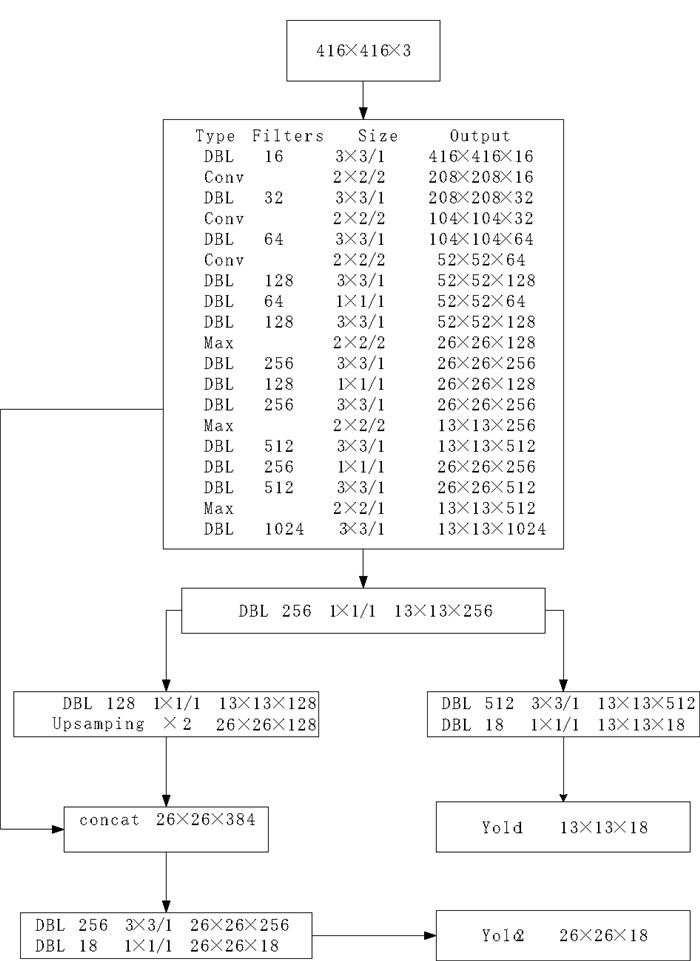

YOLOv3-tiny是YOLOv3目标检测网络的轻量化模型,没有使用残差层,只使用了2种尺度的YOLO输出层,将网络压缩到23层,其中包含5种的网络层:卷积层(Convolutional)13个、池化层(Maxpool)6个、路由层(Route)2个、上采样层(Upsample)1个和输出层(YOLO)2个。YOLOv3-tiny中,共有两个输出(YOLO)层,分别为13×13和26×26,每个网格可以预测3个bounding box。Yolov3-tiny中,除yolo层之前的卷积层外,每个卷积层之后都有BN层, 且每个卷积层之后都有激活函数LEAKY。

在实际的工程应用中,YOLOv3-tiny网络被广泛应用于检测在线的行人、车辆和破损等任务中,在本次吸捕视角下海参检测任务中,该网络可以实现对海参的快速实时检测任务,但需要通过改进网络结构提高其检测的准确率。

2.2 改进YOLOv3-tiny网络结构YOLOv3-tiny网络结构简单,回归运算过程中产生的参数较少,检测速度较高。但因其特征提取网络包含卷积层数目过少导致特征提取能力不强,精确率和召回率等指标不够理想,在检测过程中存在误检、漏检等问题。本文拟通过对YOLOv3-tiny网络结构的改进,降低海参目标检测的误检、漏检的概率,提高检测的精确度。

本网络采用卷积核步长为2的卷积层代替前三层换池化层,卷积+线性整流函数的结构既保证了输入尺寸在相同效率下成比例降低,又可以减少池化所导致特征点流失。同时针对YOLOv3-tiny特征提取网络较浅难以提取高层次的语义特征的问题,在特征提取网络中增加3个1×1和3个3×3的卷积层,在减少网络层数增加带来的运算量和参数量的同时达到加深网络层数、提取更加丰富的图像特征的目的。改进YOLOv3-tiny网络结构图如图 4所示。

2.3 海参边界框尺寸聚类YOLOv3系列算法均借鉴了Faster R-CNN锚点框[12]的思想,初始候选边框选取的优劣对于网络的学习速度影响非常大,随着输出的特征图的数量和尺度的变化,先验框的尺寸也需要相应的调整。由于YOLOv3原始参数中并不含有与海参检测相关的任务数据, 因此使用YOLOv3-tiny原始参数进行训练会对训练时间和训练准确度造成一定影响。因此需要对海参数据集标签重新进行聚类分析, 从而得到针对俯视视角下海参检测更具有代表性的锚点框参数。对于本文吸捕视角下自采海参数据集,海参目标在视野中形态、位置和大小具有多样性,对于本研究自采数据集,参考成熟海参的形态特点,对其先验框进行聚类分析。

基于此,本文使用K-Means方法[13]对海参边界框尺寸进行聚类,由于YOLOv3-tiny检测模型需要在两种尺度上进行预测,每种尺度预测3个目标边框,本文最终的候选边框数量为6,具体的尺寸分别为(37×183)、(37×68)、(91×62)、(84×144)、(92×193)和(248×147)。

3 实验结果与分析 3.1 目标检测平台及数据集为了验证本文算法的可行性,本文以实际拍摄的视频进行了测试验证,本文所采用的训练及计算环境分别为Intel(R)Core(TM)i7-9750H和NVIDIA GeForce RTX 2070,使用的深度学习框架为Keras框架,集成开发环境是Pycharm。

实验数据主要来源于山东省威海荣成市好当家集团海参养殖基地(122°9′50.416″E,36°56′59.227″N)海参采捕机器人于2022年6月1日验收实拍及部分大连理工大学发布的水下物体检测(DUO)数据集[14]。通过对海试视频进行分帧处理,得到海参原始图片746张,其中图像分辨率为416×416。通过对DUO数据集的截取以及通过旋转、缩放、翻转和剪切等方法对自采数据集进行增广,本数据集最终得到4 347张处理后的图片数据。经过数据标注后,其中80%作为训练集,20%作为测试集。

3.2 目标检测评价指标重叠度(Intersection over-union,IOU)是候选框与原标记框的交叠率,即它们的交集与并集的比值。本算法根据海参采捕机器人实际的采捕需求确定采用IOU阈值为0.5的平均精度均值和每秒帧检测速率(FPS)作为评价目标检测方法的性能评价标准。平均精度均值(mAP)是目标检测模型中常用的评价指标,它由精确率(Precision)和召回率(Recall)组成的P-R曲线计算得到。精确率是在被所有预测为正的样本中实际正样本的概率,召回率是在实际正的样本中被预测为正样本的概率。精确率、召回率和平均精度均值计算方法分别为

| $ P=\frac{N_{\mathrm{TP}}}{N_{\mathrm{TP}}+N_{\mathrm{FP}}},$ | (1) |

| $ R=\frac{N_{\mathrm{TP}}}{N_{\mathrm{TP}}+N_{\mathrm{FN}}}, $ | (2) |

| $ N_{\mathrm{mAP}}=\frac{1}{n} \sum_{i=1}^n A_{\mathrm{P}_i} \text { 。} $ | (3) |

式中:NTP为判定为正样本的正样本数量; NFP为判定为正样本的负样本数量; NFN为被判定为负样本的正样本数量; APi是指一个类别的平均精度;n为类别数目。

3.3 目标检测结果与分析为验证改进YOLOv3-tiny模型的有效性,本文将改进的YOLOv3-tiny算法模型的识别结果同未改进的YOLOv3-tiny、典型的一阶段目标检测算法YOLOv3和SDD算法[15]模型的识别效果进行对比试验。以上模型均使用相同的训练集,输入图像尺寸为416×416,同时其他训练参数均保持一致。

参考表 1说明,本文算法在IOU阈值为0.5平均精度均值(mAP50)指标上,比YOLOv3-tiny、YOLOv3、SSD算法分别高3.69%、低1.78%、低1.22%。帧速率(Frames Per Second,FPS)是指每秒钟刷新的图片的帧数(帧/s)。在检测速度方面,本文算法较YOLOv3-tiny、YOLOv3、SSD算法分别低2.3帧/s、高6.9帧/s、高7.7帧/s。在内存占用量方面,本文算法较YOLOv3-tiny、YOLOv3和SSD算法分别高2.2 MB、低202.4 MB、低58 MB,内存占用较少。由表 1可以看出,YOLOv3算法和SSD算法在同样的数据条件下平均精度指标表现较好,但在同样的硬件条件下,YOLOv3和SSD模型搭载在离线端的计算量过大而导致检测帧率较低。在满足快速检测的基础上,改进后的YOLOv3-tiny算法在检测精度上的表现优于未改进的YOLOv3-tiny模型。

|

|

表 1 模型检测结果 Table 1 Model detection results |

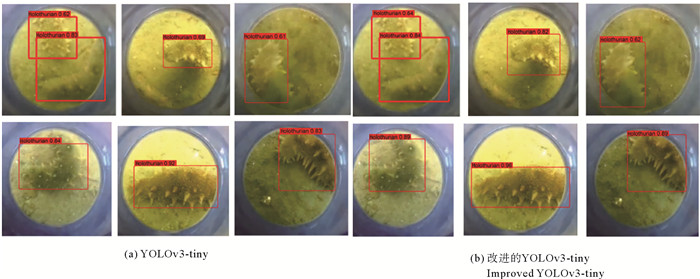

图 5展示了模型更改前后的检测结果对比。由图 5(a)和(b)在6种在视野中不同位置的检测结果分析可知,改进的YOLOv3-tiny模型在各个区域的海参检测置信度均有提高,且在同一图片下相比未改进的模型检测精度更高。本方法通过对网络结构的更改有效地提升了检测网络的性能,达到了更高的检测效果。

|

( (Holothurian x:识别为海参的概率为x。Holothurian x:The probability of identifying sea cucumber is x.) ) 图 5 模型对比结果 Fig. 5 Model comparison results |

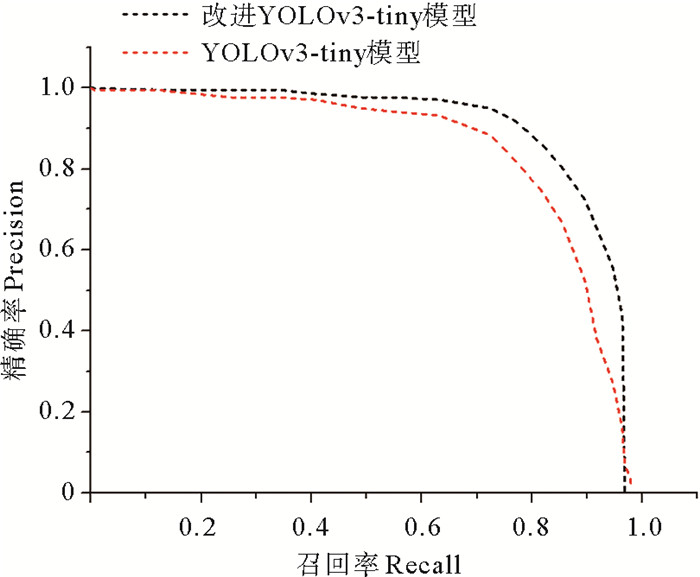

同时如图 6所示,改进的YOLOv3-tiny模型的P-R曲线面积更大,说明改进模型性能高于未改进的YOLOv3-tiny模型。因此主干特征提取网络的改进有利于复杂水下环境下海参特征的提取,改进后的YOLOv3-tiny模型系统性能更佳。

|

图 6 两种PR曲线对比图 Fig. 6 Comparison of two PR curves |

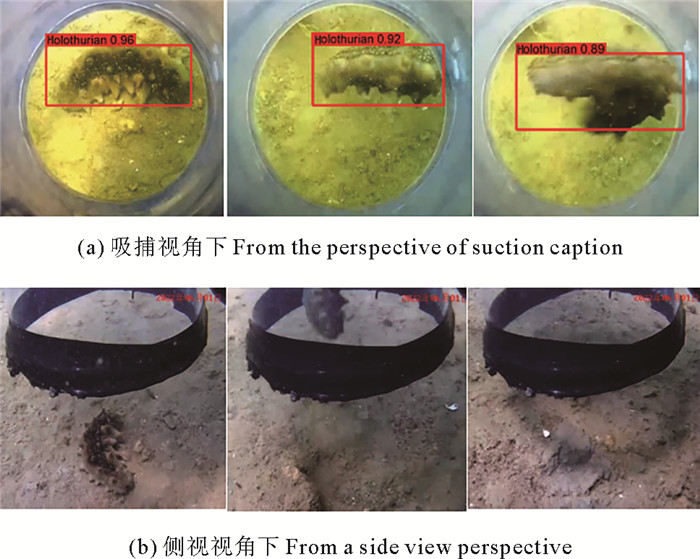

(1) 人工操作采捕模拟实验。将改进YOLOv3-tiny吸捕模型加载在Jetson Xaiver NX图像处理模块中,操作人员在实际操作过程中,摄像机采集的图像传输到NX模块中,模块识别到符合吸捕条件图像后输出采捕信号。图 7是海参的吸捕效果图,在海参的吸捕过程中NX模块连续5帧检测到海参信息后给出吸捕信号,视为响应完成,不能给出吸捕信号视为响应失败,由误检造成的错误的吸捕信号视为误发。通过分析输入图像与输出采捕信号之间的对应关系验证吸捕效果,测试结果如表 2所示。由表 2可知,端到端吸捕模型在NX上保证25帧/s的速度下响应完成率(Response completion rate)为87.4%,误发率(Misoccurrence rate)为5.6%,检测帧率(FPS)为25.2帧/s,可以满足端到端的吸捕要求。

|

( (Holothurian x:识别为海参的概率为x。Holothurian x:The probability of identifying sea cucumber is x.) ) 图 7 海参的吸捕效果图 Fig. 7 Effect of sea cucumber suction |

|

|

表 2 端到端检测结果 Table 2 End-to-end detection results |

(2) 自动采捕实验。在完成人工操作采捕模拟实验后,本文继续进行了自动采捕实验验证端到端吸捕效果。该过程由操作人员通过操作手柄控制吸捕机器人的移动,将机器人移动到海参的上方,由端到端吸捕系统负责吸捕任务,当GPU检测到吸捕视角下出现海参识别框时,便发出吸捕指令完成自动吸捕。经过3次采捕效率实验测试,机器人平均每30 min可捕捞海参净重为5.7 kg。图 7也展示了机器人在吸捕视角下从检测发现海参到完成对海参的吸捕的过程。

4 结语为解决采捕机器人的自动吸捕问题,本文提出了一种基于改进的YOLOv3-Tiny模型的目标检测方法,在保证快速检测的同时,本方法在相同数据集下具备更好的准确度。同时,将改进的YOLOv3-Tiny模型搭载在机器人上并通过实验验证了端到端吸捕的可实施性。本研究为水下生物的识别和采捕提供了新的思路,推动了海参自动化采捕的发展。

| [1] |

葛安亮, 唐昊, 王新宝, 等. 海参捕捞机器人关键部件设计与水动力学分析[J]. 现代电子技术, 2022, 45(24): 123-130. Ge A L, Tang H, Wang X B, et al. Design of key components and hydrodynamic analysis of sea cucumber fishing robot[J]. Modern Electronic Technology, 2022, 45(24): 123-130. (  0) 0) |

| [2] |

于敬东, 王新宝, 綦声波, 等. 一种全方位海参捕捞器: 中国, CN107410232A[P]. 2017-12-01. Yu J D, Wang XB, Qi S S, et al. An omni-directional sea cucumber fishing device: China, CN107410232A[P]. 2017-12-01. (  0) 0) |

| [3] |

Guo X Y, Zhao X H, Liu Y H, et al. Underwater sea cucumber identification via deep residual networks[J]. Information Processing in Agriculture, 2019, 6(3): 307-315. DOI:10.1016/j.inpa.2019.06.004 (  0) 0) |

| [4] |

熊海涛, 林琪, 宣魁, 等. 基于改进Faster R-CNN的海参目标检测算法[J]. 农业机械学报, 2022, 53(S2): 204-209. Xiong H T, Lin Q, Xuan K, et al. Sea cucumber target detection algorithm based on improved Faster R-CNN[J]. Journal of Agricultural Machinery, 2022, 53(S2): 204-209. DOI:10.6041/j.issn.1000-1298.2022.S2.023 (  0) 0) |

| [5] |

Ren S, He K, Girshick R, et al. Faster R-CNN: Towards real-time object detection with region proposal networks[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017, 39(6): 1137-1149. DOI:10.1109/TPAMI.2016.2577031 (  0) 0) |

| [6] |

Fang P, Zheng M, Fei L, et al. S-FPN: A shortcut feature pyramid network for sea cucumber detection in underwater images[J]. Expert Systems with Applications, 2021, 182: 115306. DOI:10.1016/j.eswa.2021.115306 (  0) 0) |

| [7] |

张岚, 邢博闻, 李彩, 等. 采用改进SSD网络的海参目标检测算法[J]. 农业工程学报, 2022, 38(8): 297-303. Zhang L, Xing B W, Li C, et al. Sea cucumber target detection algorithm using improved SSD network[J]. Journal of Agricultural Engineering, 2022, 38(8): 297-303. (  0) 0) |

| [8] |

Fu L, Feng Y, Wu J, et al. Fast and accurate detection of kiwifruit in orchard using improved YOLOv3-Tinymodel[J]. Precision Agriculture, 2020, 22(3): 754-776. (  0) 0) |

| [9] |

Yao Z, Song X, Zhao L, et al. Real-time method for traffic sign detection and recognition based on YOLOv3-Tiny with multiscale feature extraction. Proceedings of the Institution of Mechanical Engineers, Part D[J]. Journal of Automobile Engineering, 2021, 235(7): 1978-1991. DOI:10.1177/0954407020980559 (  0) 0) |

| [10] |

Levine S, Pastor P, Krizhevsky A, et al. Learning hand-eye coordination for robotic grasping with deep learning and large-scale data collection[J]. The International Journal of Robotics Research, 2018, 37(4-5): 421-436. DOI:10.1177/0278364917710318 (  0) 0) |

| [11] |

Youssef F, Houda B. Comparative study of end-to-end deep learning methods for self-driving car[J]. International Journal of Intelligent Systems and Applications(IJISA), 2020, 12(5): 15-27. DOI:10.5815/ijisa.2020.05.02 (  0) 0) |

| [12] |

黄继鹏, 史颖欢, 高阳. 面向小目标的多尺度Faster-RCNN检测算法[J]. 计算机研究与发展, 2019, 56(2): 319-327. Huang J P, Shi Y H, Gao Y. Multi-scale Faster-RCNN detection algorithm for small targets[J]. Computer Research and Development, 2019, 56(2): 319-327. (  0) 0) |

| [13] |

Tian Z W, Huang J, Yang Y, et al. KCFS-YOLOv5: A high-precision detection method for object detection in aerial remote sensing images[J]. Applied Sciences, 2023, 13(1): 649. (  0) 0) |

| [14] |

Liu C W, Li H J, Wang S C, et al. A dataset and benchmark of underwater object detection for robot picking[C]//2021 IEEE International Conference on Multimedia & Expo Workshops, Washington, DC: Institute of Electrical and Electronics Engineers, 2021.

(  0) 0) |

| [15] |

Liu W, Anguelov D, Erhan D, et al. SSD: Single Shot MultiBox Detector[C]// The 14th European Conference on Computer Vision. Cham, Switzerland: Springer, 2016: 21-37.

(  0) 0) |

2. Institute for Advanced Ocean Study, Ocean University of China, Qingdao 266100, China;

3. Shandong Guoxing Intelligent Technology Company Limited, Yantai 264006, China

2023, Vol. 53

2023, Vol. 53