联合国粮农组织在《2020世界渔业和水产养殖状况》中指出,2018年全球的鱼类产量高达1.79亿t,近八十年来世界水产养殖的产量呈不断上升的趋势。渔业配套的捕捞产业也向着现代化的方向飞速发展,系统性的捕捞作业管理不断发展,鱼泵等动力设备的投入使用可以直接带来捕捞效率的提升,驱使渔业向着自动化与精细化发展[1]。鱼泵是一种以水或空气为介质吸送鱼的装置,主要用于从渔网和鱼舱中抽吸和运送出渔获物,其具有极大的潜力和发展空间[2]。鱼泵主要有离心式鱼泵、真空式鱼泵、气力式鱼泵和射流式鱼泵。其中,射流式鱼泵由于其结构简单、成本低和无运动部件的机械特性,适用于不同形态鱼类的连续运输作业场景,且其对鱼类的影响小[3]。前期研究发现鱼类在通过射流式鱼泵喉管时具有逐条通过的特性,其为鱼类的损伤识别创造了良好的识别环境[4]。鱼类的损伤识别与分类研究有助于掌握鱼类健康状况,预防鱼类发生大规模的潜在疾病,从而为养殖策略提供指导,进而提高鱼类捕捞的品质、产量和经济效益[5]。

目前,国内外关于鱼类损伤分类的研究较少,但机器学习在水产养殖领域已经有了一定的进展[6]。张志强等[7]提出了一种基于机器视觉的淡水鱼种识别方法,根据鱼体颜色分量及长短轴之比等特征值建立识别模型,准确率达到了96.67%。吴一全等[8]提出了一种基于蜂群优化多核支持向量机方法识别了4种淡水鱼类,识别精度达到了91.67%以上。杜伟东等[9]提出了一种基于SVM的决策融合的鱼类识别方法,将识别的准确率提高至90%以上。

由于鱼类种类、大小和生长环境的影响,传统的机器学习方法手动提取特征比较困难,深度学习则更适用于这一问题的解决。目前关于图像信息分类识别相关的研究主要是围绕神经网络展开的[10],陈英义等[11]提出了基于FTVGG16卷积神经网络的鱼类识别方法,最终模型的准确率达到了97.66%。Rathi等[12]提出了一种基于卷积神经网络的水下鱼类识别方法,准确率达到了96.29%。李振波等[13]设计了一种基于改进VGG-19卷积神经网络的方法,针对VGG-19网络结构复杂的问题优化了全连接层数量及结构,对冰鲜鲳鱼(Pampus)新鲜度的识别准确率达到了99.79%。张方言等[14]提出了基于ResNet和迁移学习的病鱼检测方法,有效解决了红鳍东方鲀(Takifugu rubripes)鱼样本少和检测准确率低的问题,为病鱼检测提供了新方法。Ismail等[15]使用由AlexNet、GoogLeNet和ResNet组成的卷积神经网络模型进行鱼类图像分类基准测试,结果表明三种模型均取得了不错的分类效果。Rauf等[16]自创鱼类数据集,并在数据集上对比验证当前主流卷积神经网络模型的鱼类识别效果,也得出ResNet和GoogLeNet分类性能较优的结论。这些研究表明了将用于图像的深度学习技术移植到鱼类损伤分类识别领域的可能性,为本研究带来了新思路并为其实现提供了理论依据。

本文基于具有透明喉管和扩散管的射流式鱼泵展开研究,辅以高速摄影拍摄图像,结合计算机视觉技术对鱼类损伤进行识别分类。在VGG16(Visual Geometry Group 16)卷积神经网络模型的良好的图像特征提取功能的基础上,提出了一种基于改进VGG16卷积神经网络模型的方法进行鱼类损伤分类研究。基于射流式鱼泵运输鱼类的场景,自建鱼类损伤数据集训练卷积神经网络模型,并将其分类效果与在ImageNet挑战中表现优异的GoogLeNet和ResNet16模型进行对比。为了进一步提高鱼类损伤分类识别的效率与精度,使用迁移学习对网络初始权重进行预训练,从而为鱼类损伤分类提供了一种新方法。

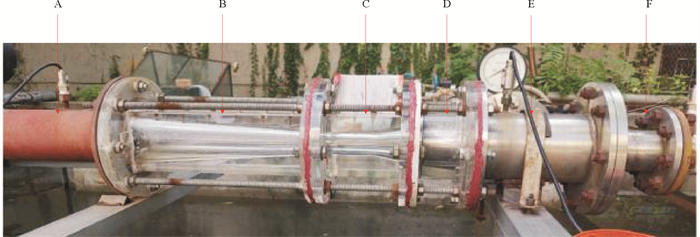

1 鱼类损伤分类实验与方法 1.1 实验设备本研究的试验台为武汉大学水射流实验室的射流式鱼泵试验台。实验设备为高速摄像机和射流式鱼泵(见图 1)。高速摄像机型号为千眼狼X113,射流式鱼泵面积比为1.75,喉管直径60 mm。数据采集系统包括电磁流量计、压力传感器和数据采集卡。其中,电磁流量计和压力传感器的误差不超过0.5%,数据采集卡型号为NIPXI-6238,采集频率为1 000 Hz。实验鱼种为团头鲂(Megalobrama amblycephala),体长范围为8~14 cm。

|

( A:出口管; B:扩散管; C:喉管; D:收缩室; E:工作流体输送管; F:被吸流体输送管。A: Outlet pipe; B: Diffuser pipe; C: Throat pipe; D: Suction chamber; E: Primary flow pipe; F: Secondary flow pipe. ) 图 1 射流泵结构图 Fig. 1 Jet pump structure diagram |

本文涉及的鱼类损伤有鳞片脱落和鳃盖损伤。鱼的鳞片状况可以反应鱼类健康状态和适应环境的信息。若鳞片脱落面积占比较小,表示鱼类健康状况良好;若鳞片脱落面积占比较大,表示鱼类身体状况存在某些问题或受到了一定的外部损伤和压力。本研究将鳞片脱落面积占比分为10%、25%和50%三个类别,分别代表健康、亚健康和不健康。鱼鳃盖是鱼类呼吸系统中非常重要的一部分,若鱼鳃盖损伤面积占比较小,则不会对鱼的健康状况造成影响;若损伤面积占比较大,则会导致鱼类呼吸不畅甚至死亡。本研究将鳃盖损伤面积占比分为25%、50%和80%三个类别,分别代表健康、亚健康和不健康。综上,本文使用鳞片脱落面积比和鳃盖损伤面积占比作为指标,将鱼类损伤分为6类。

实验使用高速摄像机拍摄团头鲂通过射流式鱼泵的过程,高速摄影的拍摄位置为射流式鱼泵的喉管部位。为了方便高速摄像机拍摄,射流式鱼泵的喉管和扩散管为透明材质。高速摄像机的拍摄帧率为1 000 fps,拍摄射流式鱼泵在69.81、80.20和90.51 m3/h流体流量工况下的过鱼照片,三种工况的流量比分别为0.33、0.42和0.45。共拍摄了9组实验鱼图像,共得到65 746张鱼类图像。部分图像中未出现完整的鱼体轮廓,因此需要进行数据集筛选。经过删除轮廓不完全和清晰度不高的实验图像,最终选择了6 278张鱼类损伤图像作为数据集。鱼类损伤类别与对应的数据集数量如表 1所示。

|

|

表 1 鱼类损伤类别与数据集数量 Table 1 Fish damage classifications and number of data sets |

深度学习中对图片进行预处理常用的方法有零均值化和数据归一化。零均值化对训练集的每一张图片减去所有训练集图片的均值,将输入数据的每个维度都中心化到零。该方法可以去除数据中的偏置影响,加速训练过程。数据归一化将所有数据映射到0~1之间。该方法可以防止由于取值范围过大对特征产生影响,使得模型更稳定。

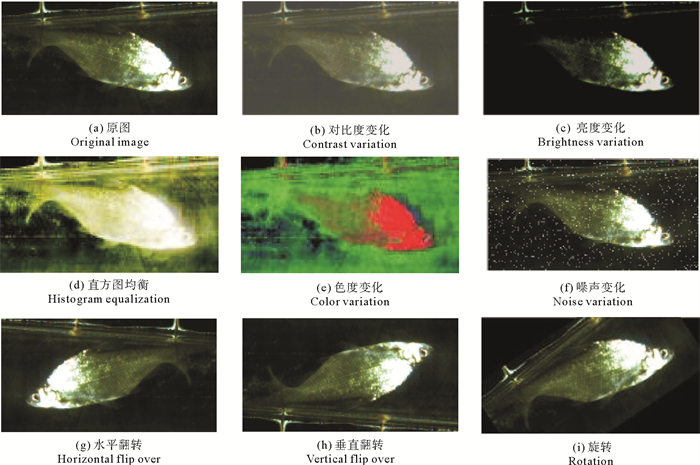

为了解决原始样本不足而导致的模型泛化能力差的问题,通过对有限的原始样本图像进行数据增强的方法来扩充鱼类损伤数据集。对原始样本数据库进行扩增,可以丰富训练数据的分布,使模型的泛化能力更强。本研究用于数据增强的方法有对比度变化、亮度变化、直方图均衡化和色度变化等,数据增强的部分样例见图 2。数据集由最初的6 278张扩增到现在的13 365张,将训练集和测试集的图像比例设置为8∶2,其中训练集图像10 692张,测试集图像2 673张。

|

图 2 数据增强部分样例 Fig. 2 Part of the data enhancement sample |

相比传统基于机器学习的图像分类方法,基于深度学习的图像分类方法可以通过自主学习从原始数据中提取良好的特征,且自主学习加强了图像特征与分类器之间的联系。当前,许多经典的卷积神经网络被应用到图像分类相关的项目中,具有较快的分类速度和较高的分类准确性。

VGG16是一种基础的卷积神经网络模型,分类性能好,且结构规整易修改。较深的网络结构和较小的卷积核与最大池化,使得VGG16在提取更多图像特征的同时减少了参数量,数据集适应能力强,因此, 本文选取VGG16模型进行研究。

VGG16模型由5个卷积块、3个全连接层和1个softmax层构成[17]。每个卷积块由卷积(Convolution, Conv)层、批规范(Batch Normalization, BN)层和池化(Pooling)层组成。其中,每一层卷积层都使用3×3大小的卷积核,浅层卷积层学习低级视觉特征,例如边缘和角落等,深层卷积层则学习更高级别的特征,如物体的形状、纹理和颜色等。卷积层后应用ReLU激活函数以增加网络的非线性表示能力。池化层使用2×2大小的最大池化,以减小特征图的大小。全连接层位于整个网络结构的末端,负责将最后一层卷积层的输出转换成类别的概率分布,通过softmax分类函数输出,且所有概率和为1。

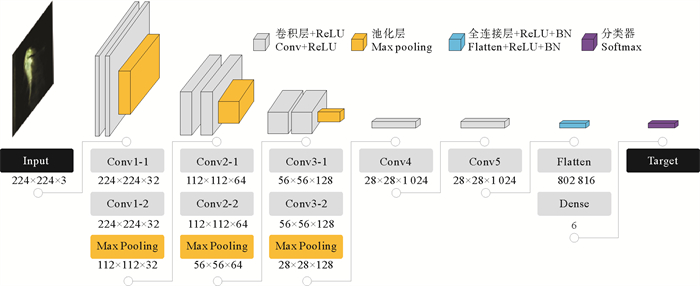

2.1.2 改进的S-VGG网络模型传统的VGG16模型参数量巨大,耗费了大量的计算资源,因此本文提出了具有5个卷积模块和1个全连接模块的S-VGG(Short-VGG)网络模型。改进后的S-VGG共有8个卷积层,网络模型结构如图 3所示。每个卷积块中的卷积层数和卷积核的参数有所区别。例如,在第1个卷积块中,“Conv1-1”和“224×224×32”代表第1个卷积层中有32个卷积核。卷积层均使用3×3的卷积核操作,卷积核步长设置为1,填充像素边界,使模型能够更好地捕捉图像边缘和细节等特征。

|

图 3 S-VGG网络结构 Fig. 3 S-VGG network structure |

传统的VGG16网络中的三个全连接层大小分别为[4 096, 4 096, 1 000],第一个全连接层的参数数量达到了102 764 544,占据VGG16网络参数总量的74.24%。全连接层参数占比过大会造成计算成本的浪费,模型容易发生过拟合的情况,会对模型分类的准确率产生影响。因此,本文对VGG16模型的全连接层进行改进,在降低时间和空间成本的同时保证模型分类的效率和准确率。改进后的S-VGG的结构参数如表 2所示,改进后的全连接层参数减少了96.10%,模型总体参数减少了93.75%。

|

|

表 2 S-VGG结构参数表 Table 2 S-VGG structural parameter list |

由于Adam算法实现简单,计算高效,超参数的解释性较好[18],因此,本研究模型训练主体选择Adam优化算法进行训练。其一阶矩估计的指数衰减率β1设置为0.9,二阶矩估计的指数衰减率β2设置为0.999,ε设置为10-8。

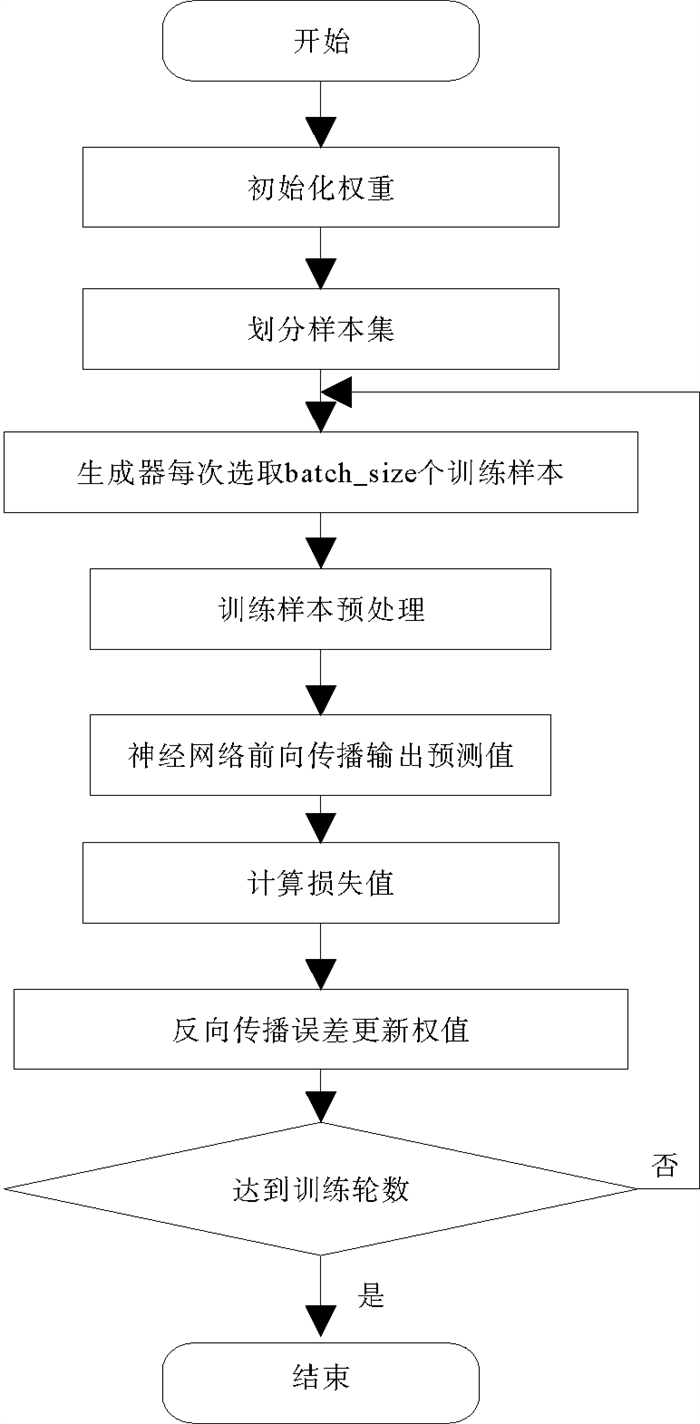

深度学习中超参数的调整对模型的训练至关重要。本研究中,批尺寸(batch_size)设置为64,每次训练神经网络模型时送入网络的样本个数为64;初始学习率(learning_rate)设置为0.000 1;训练轮数Epoch设为50;损失函数为交叉熵损失函数。模型训练过程如图 4所示。

|

图 4 S-VGG训练过程 Fig. 4 S-VGG training process |

为了进一步提升模型性能,本文引入迁移学习,通过预训练和微调的方法将相关任务的可泛化性信息迁移到鱼类损伤分类识别训练任务中,达到在数据样本较少且训练时间较短的情况下提高损伤分类模型的训练精度的目的[19-20]。

迁移学习是一种可以通过相关领域的标注数据或知识结构来改进目标领域学习效果的方法,主要分为实例迁移、特征迁移和共享参数迁移,本文采用共享参数迁移。考虑到进行迁移学习需要大量的源样本数据,因此,选择ImageNet数据集[21]进行迁移学习。虽然ImageNet数据集与团头鲂图像数据集存在一定程度的区别,但由于ImageNet数据集的数量足够庞大,可以通过ImageNet数据集学习对象的形状、颜色和纹理等共有的基本特征。利用ImageNet数据集对S-VGG模型进行预训练,再将在ImageNet数据集上训练得到的权值对S-VGG的权值进行初始化,之后对模型进行微调。得到基于迁移学习的鱼类损伤分类模型,记为S-VGG*。

3 实验与结果分析 3.1 实验环境实验所用系统为Windows 10 X64位操作系统,模型训练框架为TensorFlow 2.6深度学习框架。计算机处理器为11th Gen Intel© CoreTM i5-11400 @2.60 GHz,运行内存16 GB。Python解释器版本为3.10.11。

3.2 模型评价标准在进行卷积神经网络模型训练前,必须明确模型性能是如何进行评价的。本文模型的性能评价指标包括准确率、精确度、召回率和F1分数[22]。表 3为评估指标中的四种定义。

|

|

表 3 模型评估指标相关定义 Table 3 Definitions related to model assessment metrics |

根据四种定义,模型评估指标定义如下:

(1) 准确率(Accuracy):

| $ 准确率=\frac{{\mathrm{TP}}+{\mathrm{FN}}}{{\mathrm{TP}}+{\mathrm{FP}}+{\mathrm{TN}}+{\mathrm{FN}}} 。$ | (1) |

(2) 精确度(Precision):

| $ 精度=\frac{{\mathrm{TP}}}{{\mathrm{TP}}+{\mathrm{FP}}} 。$ | (2) |

(3) 召回率(Recall):

| $ 召回率=\frac{{\mathrm{TP}}}{{\mathrm{TP}}+{\mathrm{FN}}} 。$ | (3) |

(4) F1分数(F1 score):

| $ {\text { F1 分数 }}=\frac{2 \times {\text { Precision } }\times {\text { Recall }}}{{\text { Precision }}+ {\text { Recall }}} 。$ | (4) |

式中:TP表示分类器预测结果为正例,实际也为正例,即正例被正确识别的数量;FP表示分类器预测结果为正例,实际为反例,即误报的反例数量;TN表示分类器预测结果为反例,实际为反例,即反例被正确识别的数量;FN表示分类器预测结果为反例,实际为正例,即漏报的正例数量;准确率(Accuracy)代表预测正确的样本比例;精确度(Precision)代表预测正确的正例的准确度,精确度越高则误检次数越少;召回率(Recall)代表预测正确的正例的覆盖率,召回率越高则漏检次数越少;F1分数(F1 score)是衡量模型精确度的一个指标,其值位于0到1之间,值越大则模型分类效果越好。

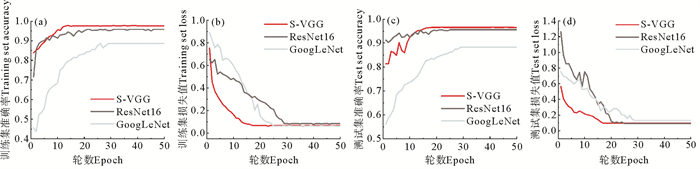

3.3 S-VGG与其他模型的对比为验证本研究提出的对鱼类损伤进行识别分类的方法,使用自建鱼类损伤数据集,在相同的超参数条件下使用随机的初始化网络权重的方法,对改进的S-VGG、ResNet16和GoogLeNet模型进行训练。将三种模型实验所得的识别分类结果进行对比,各模型的准确率和损失值随训练轮数的变化趋势见图 5。

|

图 5 不同模型计算结果 Fig. 5 Calculation results of different models |

由图 5可见,经过50轮训练后三种网络模型全部收敛,且三种网络模型在训练集和测试集上的准确率变化趋势相似。S-VGG模型在训练集和测试集的平均准确率最高,分别为97.60%和96.52%;ResNet16模型准确率略低于S-VGG模型,在训练集和测试集上准确率分别为95.75%和95.56%;GoogLeNet模型在训练集和测试集上的准确率分别为88.56%和88.32%,其准确率明显低于ResNet16模型和S-VGG模型。三种模型的损失值相差不大,但S-VGG模型的表现最优,其在训练集和测试集上的损失值分别为0.068 1和0.096 0。在模型收敛性能方面,S-VGG模型经过约18轮训练趋向于收敛,且收敛速度最快;收敛最慢的网络为GoogLeNet模型,在第30轮训练时趋于收敛。总体来看,三种模型的准确率均高于88%,说明选取的三种模型泛化能力强、鲁棒性较好,对比试验结果可靠。

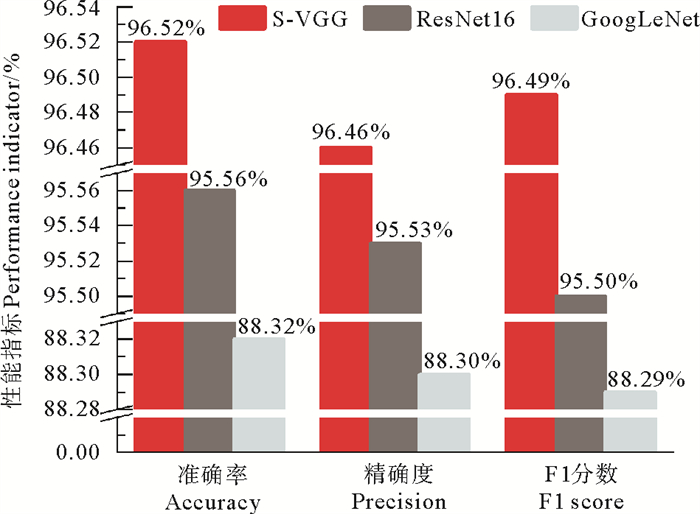

根据鱼类损伤的相关特征选择的模型的评估标准有准确率、精确度和F1分数,三种模型测试集的评估指标值见图 6。由图 6可以看出S-VGG模型的精确度最高,为96.46%,ResNet16略低于S-VGG模型,精确度为95.53%,GoogLeNet模型的精确度最低,为88.32%。S-VGG模型的F1分数为最高,在测试集上F1分数达到了96.49%,分别高于ResNet16和GoogLeNet模型0.99%和8.20%。综合三个评估指标,S-VGG模型的损伤分类效果优于ResNet16和GoogLeNet模型。

|

图 6 三种网络模型性能比较 Fig. 6 Performance comparison of three network models |

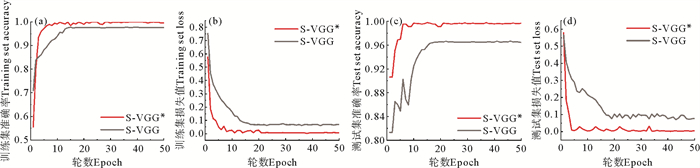

本节通过迁移学习进一步优化S-VGG神经网络的初始权重,并将使用迁移学习前后的模型性能进行对比。由于已经提前在ImageNet数据集上进行了训练,两个模型的训练过程如图 7所示。从图 7的曲线中可以看出,S-VGG*模型的收敛速度明显加快,经过10轮训练,模型已经收敛,其准确率和损失值也趋于稳定,分别为99.70%和0.002。由于S-VGG*模型在训练之前已经获得了较好的权重参数,因此相比S-VGG模型更易获得最优解。

|

图 7 迁移学习前后模型计算结果 Fig. 7 Model calculation results before and after migration learning |

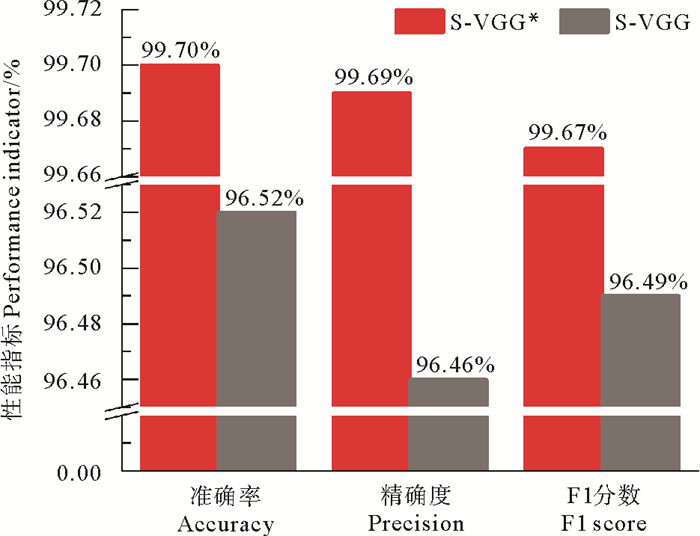

未进行迁移学习的S-VGG*模型与进行迁移学习的S-VGG模型性能比较结果如图 8所示。由于迁移学习对模型进行了预训练,使模型提前学习到了数据集的特征,降低了模型发生过拟合的风险,增强了模型泛化能力,使得模型性能得到提高,其中平均准确率提高了3.18%,精确度和F1分数分别提高了3.23%和3.22%。

|

图 8 迁移学习前后模型性能比较 Fig. 8 Comparison of model performance before and after migration learning |

本文基于具有透明喉管和扩散管的射流式鱼泵展开研究,使用高速摄像机拍摄射流式鱼泵内鱼类的过泵过程,自建鱼类损伤数据集,结合计算机视觉技术对鱼类损伤进行识别分类。在经典VGG16卷积神经网络的基础上改进网络结构,将模型层数减少到9层,模型参数总体上降低了93.75%,节约了模型训练时间。将改进后的S-VGG模型与ResNet16模型和GoogLeNet模型的鱼类损伤分类准确率进行比较,S-VGG模型对于鱼类损伤分类的准确率和精确度最高,分别达到了96.52%和96.46%,模型具有较高的识别精度和鲁棒性。考虑到随机初始化权重的方式仍可以进一步改进,采用迁移学习的方法对模型初始权重进行预训练。训练结果表明基于迁移学习的S-VGG*模型在鱼类损伤分类的平均准确率达到了99.70%,精确度和F1分数分别达到了99.69%和99.67%,与未进行迁移学习的S-VGG模型相比,平均准确率提高了3.18%,精确度提高了3.23%,F1分数提高了3.22%,迁移学习提高了S-VGG模型在鱼类损伤分类任务中的性能。本研究将所提出的图像处理方法与鱼类损伤分类研究相结合,有助于掌握运输过程中鱼类的状态,进而为养殖策略的针对性调整提供依据。

| [1] |

Dos Santos A A, Gonçalves W N. Improving Pantanal fish species recognition through taxonomic ranks in convolutional neural networks[J]. Ecological Informatics, 2019, 53: 100977. DOI:10.1016/j.ecoinf.2019.100977 (  0) 0) |

| [2] |

王志勇, 冯书庆. 网箱养殖鱼类起捕技术现状[J]. 水产养殖, 2021, 42(7): 64-65. Wang Z Y, Feng S Q. Current situation of catching technology of cage culture fish[J]. Journal of Aquaculture, 2021, 42(7): 64-65. (  0) 0) |

| [3] |

吴宁. 亚急性亚硝酸盐及射流式鱼泵胁迫下团头鲂的应激响应[D]. 武汉: 华中农业大学, 2016. Wu N. The Response of Wuchang Bream to the Stress of Subacute Nitrite Exposure and the Jet Fish Pump[D]. Wuhan: Huazhong Agricultural University, 2016. (  0) 0) |

| [4] |

徐茂森. 射流式鱼泵输送性能及鱼类损伤与行为研究[D]. 武汉: 武汉大学, 2018. Xu M S. Investigation on Transportation Performance of Jet Fish Pump and Related Injury and Behavior of Fish[D]. Wuhan: Wuhan University, 2018. (  0) 0) |

| [5] |

俞国燕, 罗樱桐, 王林, 等. 基于改进型YOLOv4的病死金鲳鱼识别方法[J]. 渔业现代化, 2021, 48(6): 80-89. Yu G Y, Luo Y T, Wang L, et al. Recognition method of dead golden pomfrets based on improved YOLOv4[J]. Fishery Modernization, 2021, 48(6): 80-89. (  0) 0) |

| [6] |

Zhao S, Zhang S, Liu J, et al. Application of machine learning in intelligent fish aquaculture: A review[J]. Aquaculture, 2021, 540: 736724. DOI:10.1016/j.aquaculture.2021.736724 (  0) 0) |

| [7] |

张志强, 牛智有, 赵思明. 基于机器视觉技术的淡水鱼品种识别[J]. 农业工程学报, 2011, 27(11): 388-392. Zhang Z Q, Niu Z Y, Zhao S M. Identification of freshwater fish species based on computer vision[J]. Transactions of the Chinese Society of Agricultural Engineering, 2011, 27(11): 388-392. DOI:10.3969/j.issn.1002-6819.2011.11.072 (  0) 0) |

| [8] |

吴一全, 殷骏, 戴一冕, 等. 基于蜂群优化多核支持向量机的淡水鱼种类识别[J]. 农业工程学报, 2014, 30(16): 312-319. Wu Y Q, Yin J, Dai Y M, et al. Identification method of freshwater fish species using multi-kernel supprot vector machine with bee colony optimization[J]. Transactions of the Chinese Society of Agricultural Engineering, 2014, 30(16): 312-319. DOI:10.3969/j.issn.1002-6819.2014.16.040 (  0) 0) |

| [9] |

杜伟东, 李海森, 魏玉阔, 等. 基于SVM的决策融合鱼类识别方法[J]. 哈尔滨工程大学学报, 2015, 36(5): 623-627. Du W D, Li H S, Wei Y K, et al. Decision fusion fish identification using SVM and its experimental study[J]. Journal of Harbin Engineering University, 2015, 36(5): 623-627. (  0) 0) |

| [10] |

姜喜耀. 风力机叶片损伤图像快速分类识别技术研究[D]. 沈阳: 沈阳工业大学, 2021. Jiang X Y. Research on Fast Classification and Recognition Technology of Wind Turbine Blade Damage Image[D]. Shenyang: Shenyang University of Technology, 2021. (  0) 0) |

| [11] |

陈英义, 龚川洋, 刘烨琦, 等. 基于FTVGG16卷积神经网络的鱼类识别方法[J]. 农业机械学报, 2019, 50(5): 223-231. Chen Y Y, Gong C Y, Liu Y Q, et al. Fish identification method based on FTVGG16 convolutional neural network[J]. Transactions of the Chinese Society for Agricultural Machinery, 2019, 50(5): 223-231. (  0) 0) |

| [12] |

Rathi D, Jain S, Indu S. Underwater fish species classification using convolutional neural network and deep learning[C]//Proceedings of the 2017 Ninth International Conference on Advances in Pattern Recognition. Bangalore, India: IEEE, 2017.

(  0) 0) |

| [13] |

李振波, 李萌, 赵远洋, 等. 基于改进VGG-19卷积神经网络的冰鲜鲳鱼新鲜度评估方法[J]. 农业工程学报, 2021, 37(22): 286-294. Li Z B, Li M, Zhao Y Y, et al. Iced pomfret freshness evaluation method based on improved VGG-19 convolutional neural networks[J]. Transactions of the Chinese Society of Agricultural Engineering, 2021, 37(22): 286-294. DOI:10.11975/j.issn.1002-6819.2021.22.033 (  0) 0) |

| [14] |

张方言, 赵梦, 周弈志, 等. 基于ResNet50和迁移学习的红鳍东方鲀病鱼检测方法[J]. 渔业现代化, 2021, 48(4): 51-60. Zhang F Y, Zhao M, Zhou Y Z, et al. Detection of diseased takifugu rubripes based on ResNet50 and transfer learning[J]. Fishery Modernization, 2021, 48(4): 51-60. (  0) 0) |

| [15] |

Ismail H, Ayob A, Muslim A, et al. Convolutional neural network architectures performance evaluation for fish species classification[J]. Journal of Sustainability Science and Management, 2021, 16(5): 124-139. DOI:10.46754/jssm.2021.07.010 (  0) 0) |

| [16] |

Rauf H T, Lali M U, Zahoor S, et al. Visual features based automated identification of fish species using deep convolutional neural networks[J]. Computers and Electronics in Agriculture, 2019, 167: 105075. (  0) 0) |

| [17] |

Simonyan K, Zisserman A. Very deep convolutional networks for large-scale image recognition[DB/OL]. (2015-04-10)[2023-07-06]. https://arxiv.org/abs/1409.1556.

(  0) 0) |

| [18] |

Kingma D P, Ba J. Adam: A method for stochastic optimization[DB/OL]. (2017-01-30)[2023-07-06]. https://arxiv.org/abs/1412.6980.

(  0) 0) |

| [19] |

郑一力, 张露. 基于迁移学习的卷积神经网络植物叶片图像识别方法[J]. 农业机械学报, 2018, 49(S1): 354-359. Zheng Y L, Zhang L. Plant leaf image recognition method based on transer learning with convolutional neural networks[J]. Transactions of the Chinese Society for Agricultural Machinery, 2018, 49(S1): 354-359. (  0) 0) |

| [20] |

Pan S J, Yang Q. A survey on transfer learning[J]. IEEE Transactions on Knowledge Data Engineering, 2010, 22(10): 1345-1359. (  0) 0) |

| [21] |

Deng J, Dong W, Socher R, et al. Imagenet: A large-scale hierarchical image database[C]//Proceedings of the 2009 IEEE Conference on Computer Vision and Pattern Recognition. Miami, USA: IEEE, 2009.

(  0) 0) |

| [22] |

吴志高, 陈明. 基于改进YOLO v7的微藻轻量级检测方法[J]. 大连海洋大学学报, 2023, 38(1): 129-139. Wu Z G, Chen M. Lightweight detection method for microalgae based on improved YOLO v7[J]. Journal of Dalian Ocean University, 2023, 38(1): 129-139. (  0) 0) |

2024, Vol. 54

2024, Vol. 54