2. 北京大学第三医院放疗科, 北京 100089;

3. 东北大学, 辽宁 沈阳 110819;

4. 中国人民解放军总医院放疗科, 北京 100039;

5. 谢菲尔德哈勒姆大学, 英国 谢菲尔德 S11WB;

6. 北京忠诚肿瘤医院肿瘤科, 北京 100161;

7. 北京航空航天大学, 北京 100083

2. Department of Radiotherapy, Peking University Third Hospital, Beijing 100089 China;

3. Northeastern University, Shenyang 110819 China;

4. Department of Radiotherapy, Chinese People’s Liberation Army (PLA) General Hospital, Beijing 100039 China;

5. Biomedical Research Centre, Sheffield Hallam University, Sheffield S11WB UK;

6. Department of radiation oncology, Zhongcheng Cancer center, Beijing 100160 China;

7. Beihang University, Beijing 100083 China

近年来,子宫内膜癌(endometrial carcinoma,EC)的发病率和死亡率逐年持续上升[1]。与体外放射治疗(external beam radiation therapy,EBRT)相比,阴道近距离放射治疗(vaginal brachytherapy,VBT)已成为治疗EC术后的最佳放疗方法[2-3]。使用计算机断层扫描(computed tomography,CT)或磁共振(magnetic resonance,MR)图像在阴道施源器位置处勾画临床靶区(clinical target volumes ,CTV),对剂量分布的准确性及降低患者急性放射反应非常重要。然而,临床医生对指南的理解和经验不同,可能导致操作者之间的差异。此外,手动勾画靶区或器官是一项繁琐费力的工作,通常需要约20 min以上[4]。因此,一些研究者建议将计算机自动分割技术作为一种替代工具,以提高近距离放射治疗(brachytherapy, BT)治疗的效率和可重复性[5]。

目前,临床上常用的器官分割模型包括基于图谱和模型的分割方法[6-7]。然而,这2种方法都受限于图谱或训练数据中存在的特定解剖结构和图像对比度,且需要大量有代表性的图谱或注释训练数据才能达到高精度[8-9]。解决这些问题的替代策略可以使用深度学习(deep learning,DL)技术[10]:如卷积神经网络(CNN),包括U-Net [11-13]、Res U-Net和V-Net框架[14-15]。至今,针对EC术后CTV的自动分割技术非常有限,仅有2篇文章[16-17]。

因此,本研究旨在利用3D U-Net、3D Res U-Net 和V-Net架构对EC高危临床靶区(high-risk clinical target volumes, HR-CTV)进行DL自动分割的可行性评估,为EC术后近距离治疗中使用DL的准确性和可靠性提供有价值的建议。

1 材料与方法 1.1 临床数据获取在得到机构审查委员会批准之后,本研究开展了一项回顾性分析,收集了2021年11月—2022年10月医院306例患者的CT影像。纳入研究的患者均已完成根治性子宫切除手术,并通过CT引导接受了腔内柱状施源器的后装放疗。排除标准:(1)存在阴道残端复发或术后病理检测显示残端阳性的患者;(2)接受了非柱状施源器治疗或进行了组织间插植治疗的患者;(3)CT影像质量不满足研究要求的患者。

图像获取过程中,所有患者均使用了20 French规格的Foley导管,并将膀胱球囊内注入80 mL生理盐水。选择合适的最大尺寸单通道柱状施源器置入,确保施源器能够紧密贴合阴道残端。使用CT大孔径模拟机Brilliance Big Bore(飞利浦医疗,荷兰)进行螺旋扫描,扫描参数设定为管电压140 kV,300 mAs,图像以512 × 512的矩阵和3 mm的厚度进行重建。

采用Eclipse 15.5(瓦里安医疗有限公司,美国)治疗计划系统进行HR-CTV勾画。由3位具有10年以上妇科肿瘤专业经验的资深医师负责。勾画的标准遵循美国放射肿瘤学会(American Brachytherapy Society,ABS)[18]的推荐:从施源器顶端向下延伸3~5 cm的长度(对于术后阴道残端较短的患者,勾画阴道全长的1/3~1/2),并在施源器表面向外扩展5 mm。对于特殊病理类型的患者,如浆液性乳头状癌、透明细胞癌、G3级肿瘤或广泛淋巴脉管侵犯,实施全阴道照射。

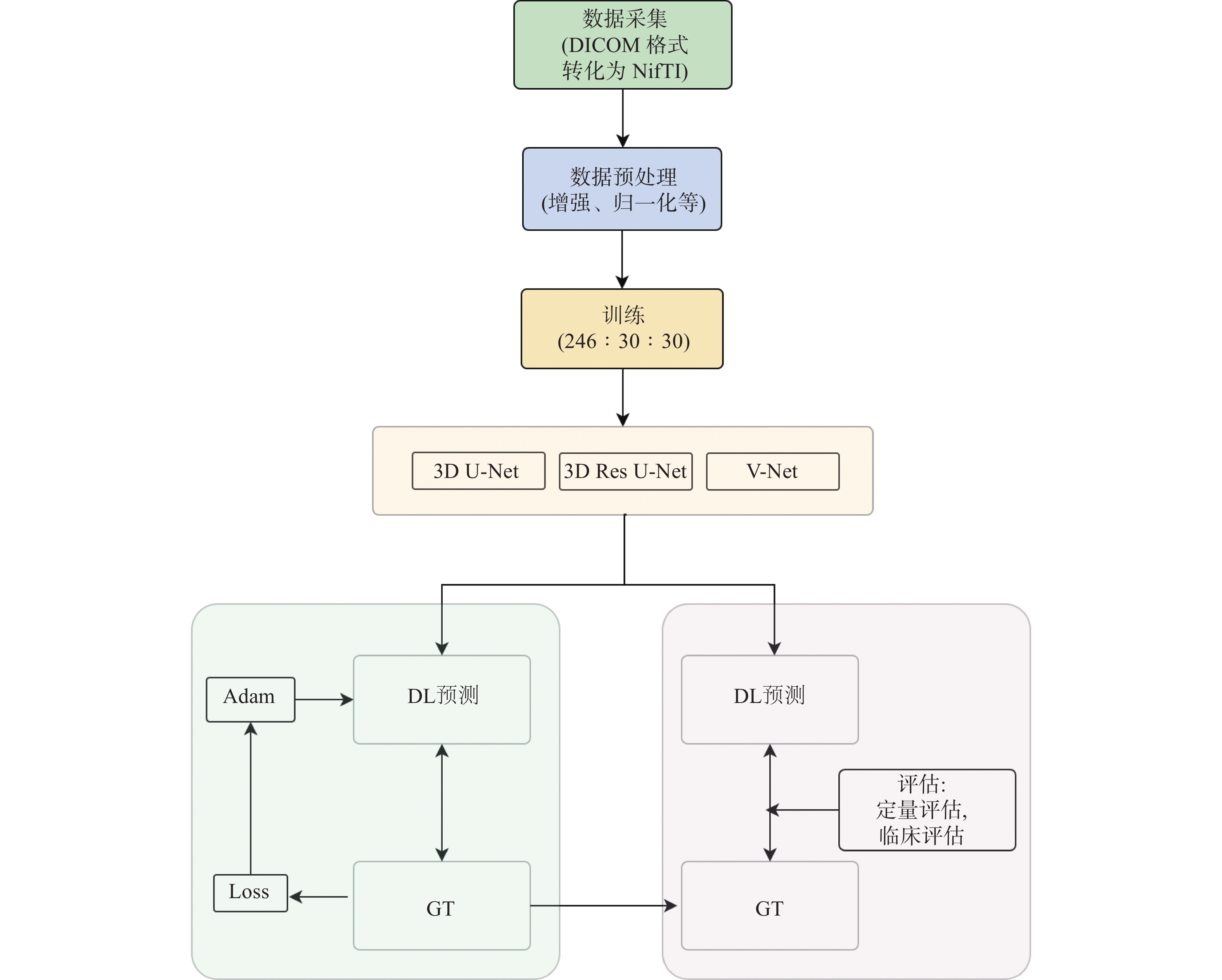

1.2 数据预处理将DICOM格式的CT图像序列转换成NIfTI格式,转换后,在数据中添加通道维度,以确保原始数据遵循“通道优先”的排列方式。CT图像中的CTV被指定标记为1,除此之外的所有区域均被视为背景。为了标准化CT图像的HU值,并减少图像中的伪影,CTV的HU值被限制在[−170,280]。

1.3 DL模型和训练过程本研究主要采用3种DL模型,即3D U-Net、3D Res U-Net 和V-Net架构。

3D U-Net和2D U-Net结构相近但也有所不同:3D U-Net主要针对3D图像分割;两模型的通道数翻倍时刻不同,2D U-Net通道数增倍在下采样后的第一次卷积时,3D U-Net通道数增倍是在下采样或上采样前的卷积中;在反卷积操作中2D U-Net通道数减半,而3D U-Net通道数不变;3D U-Net还应用批量归一化来加速模型的收敛速度,避免网络架构瓶颈。

3D Res U-Net 由基本 U-Net 结构衍生而来,包含残差单元,可有效分割 CTV。其主要特点是将架构每层的2个连续卷积层改进为一个残差单位。V-Net也是U-Net变形,使用数据集主要是3D图像。与U-Net最大的不同是在每个架构层中引入残差块,且在编码路径中,池化层被Stride为2 的卷积层代替,并为转置卷积上采样。

3个DL模型都由 5 层组成,维度被定义为(16、32、64、128、256)。用于DL模型训练、验证和测试随机分配的比例为246∶30∶30。

本实验采用了PyTorch 1.12.0和Python 3.9.7框架来构建并实现神经网络模型。模型训练在装备有NVIDIA RTX A5000 GPU的工作站上执行,该GPU拥有

|

图 1 模型训练流程图 Figure 1 The workflow of model training |

| $ \mathrm{D}\mathrm{i}\mathrm{c}\mathrm{e}\;\mathrm{l}\mathrm{o}\mathrm{s}\mathrm{s}=1-\frac{2\left|X\cap Y\right|}{\left|X\right| + \left|Y\right|} $ |

拉普拉斯平滑(Laplace smoothing,LS):

| $ \mathrm{D}\mathrm{i}\mathrm{c}\mathrm{e}\;\mathrm{l}\mathrm{o}\mathrm{s}\mathrm{s}=1-\frac{2\left|X\cap Y\right| + 1}{\left|X\right| + \left|Y\right| + 1} $ | (1) |

式中Dice loss 是基于戴斯相似性系数(Dice similarity coefficien,DSC)的损失函数,其中 X 和 Y 分别代表人工勾画基准真实值(ground truth,GT)和DL模型分割结果。LS是一个可选的变量,当 |X| 和 |Y| 均为 0 时,避免了分子除以 0 的问题,并减少了过拟合。

1.4 定量评估指标为了全面评估模型的性能,实验使用 DSC、豪斯多夫距离(Hausdorff distance,HD)、豪斯多夫距离第95 百分位数(95th percentile of Hausdorff distance,HD95%)和交并比(Intersection over Union,IoU)(见公式2~4)来评估模型性能,将30例测试患者DL结果与相应的GT值做比较,计算出指标的平均值和标准偏差(SD)值。

| $ \mathrm{D}\mathrm{S}\mathrm{C}=2\times \frac{A\cap B}{\left|A\right| + \left|B\right|} $ | (2) |

将人工勾画轮廓GT和DL分割结果分别定义为 A 和 B 时,DSC 值提供了两者重叠度的衡量标准,范围从 0 到 1,其中 1 表示完全一致。

| $ \mathrm{H}\mathrm{D}\left(\mathrm{A},\mathrm{B}\right)=max\mathit{\mathit{\mathit{ }}}_{a\in A}\left\{min_{b\in B}\left\{d\left(a,b\right)\right\}\right\} $ | (3) |

HD是一种用于度量空间中2组点集合之间相似度的指标,其中,HD95%作为一个统计量,是指95%的HD不超过此数值,单位:mm。在具体应用中,集合a代表实际观测值GT,而集合b代表模型预测值。欧氏距离记为d,是指任意两点间的直线距离,即两点间的最短距离。HD值较小意味着2组点集合在空间上的相似度高,或者它们之间的重叠部分较多。

| $ \mathrm{I}\mathrm{o}\mathrm{U}=\frac{A\cap B}{A\cup B} $ | (4) |

IoU是一种衡量图像中预测边界框与GT重叠程度的指标。在这里,A 代表GT边界框,而 B 代表预测边界框。IoU 的值介于0到1之间,其中0表示没有任何重叠,1则表示完全重叠。通常,IoU的值越高,说明DL预测的准确度越高。

1.5 临床评估另选6名放疗临床医生组成评估小组,被分为初级医生(2 人具有少于 5 年的 BT 经验)、中级医生(2 人具有少于 15 年且大于5年的经验)或高级医生(2 人具有超过 15 年的经验),负责实施临床评估。采用2种评估方法进行评估,每次从 30例临床测试病例中随机抽取 9 例。首先,他们被要求根据4点评分标准来评估DL分割结果:(1)可接受—分割结果达到满意程度,直接用于后续治疗应用;(2)微小修改—虽然分割结果大体满意,但仍需对某些细节进行微调,即便不进行这些修改,也不会对临床治疗产生显著影响;(3)重大修改—分割结果需要对靶区进行重要的修正才能用于进一步治疗,如果不进行必要的修改,结果无法应用;(4)完全拒绝—认为DL分割存在错误,需要重新绘制。其次,选择9例患者,3组6名医生对其进行靶区勾画,初级和中级医生勾画的结果需要经过高级医生复审后再使用。最后将使用 DL 自动分割、3组临床医生最终勾画的靶区与肿瘤专家勾画的GT进行比较,以评估操作者之间的差异,此过程主要应用DSC 和 HD 指标。

1.6 统计学分析统计分析使用 IBM SPSS Statistics 21 软件进行。结果用平均值 ± 标准差(SD)或中位数(最小值、最大值、第一四分位数(Q1)、第三四分位数(Q3))表示。3种 DL 模型之间不同指标值的统计比较采用配对 t 检验,P < 0.05 为具有统计学意义。为识别 HR-CTV 的 DSC、HD、HD95%和 IoU 结果中的异常值,计算了四分位数间距 (IQR)。值大于 IQR 的 1.5倍即为异常值。

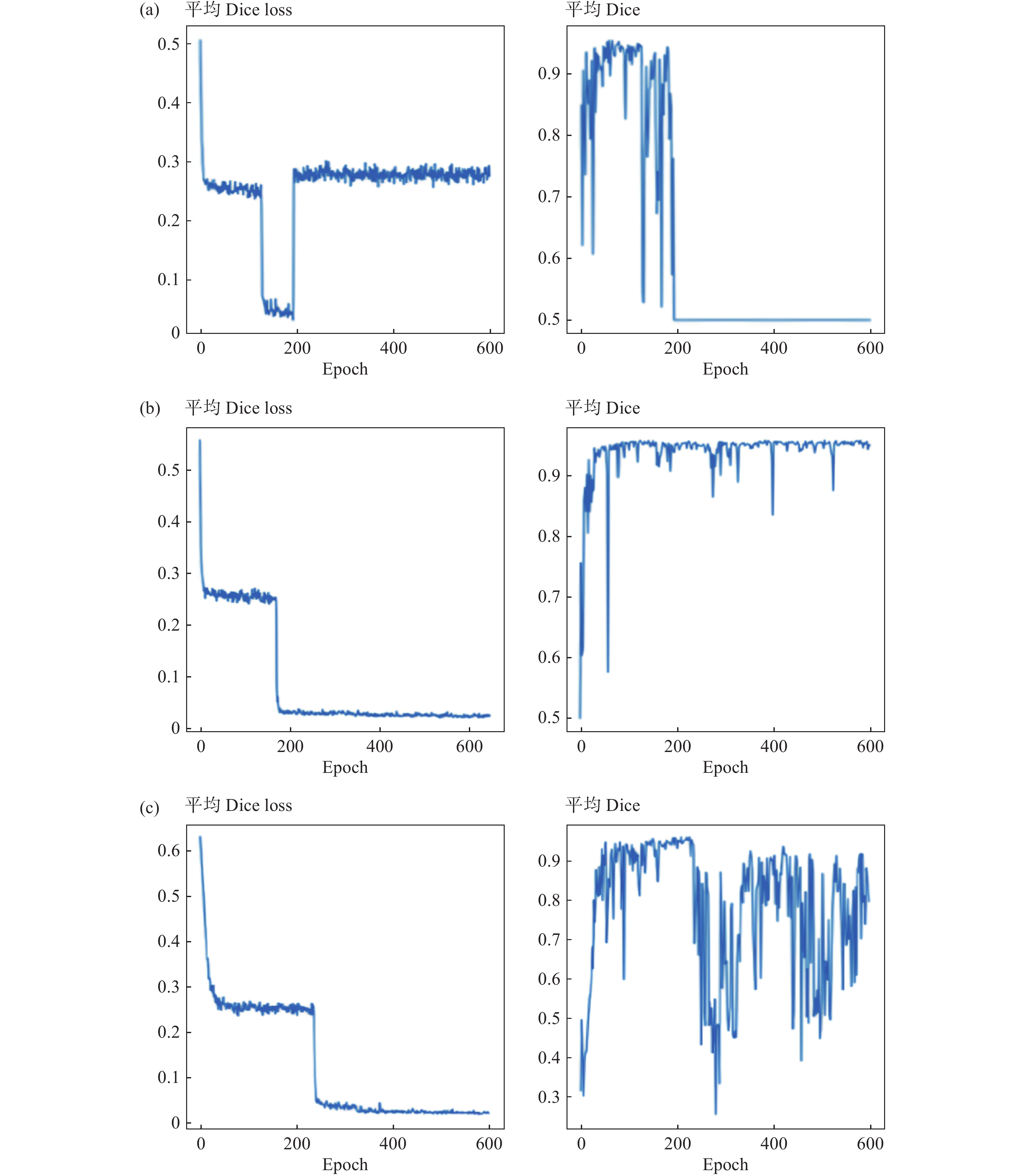

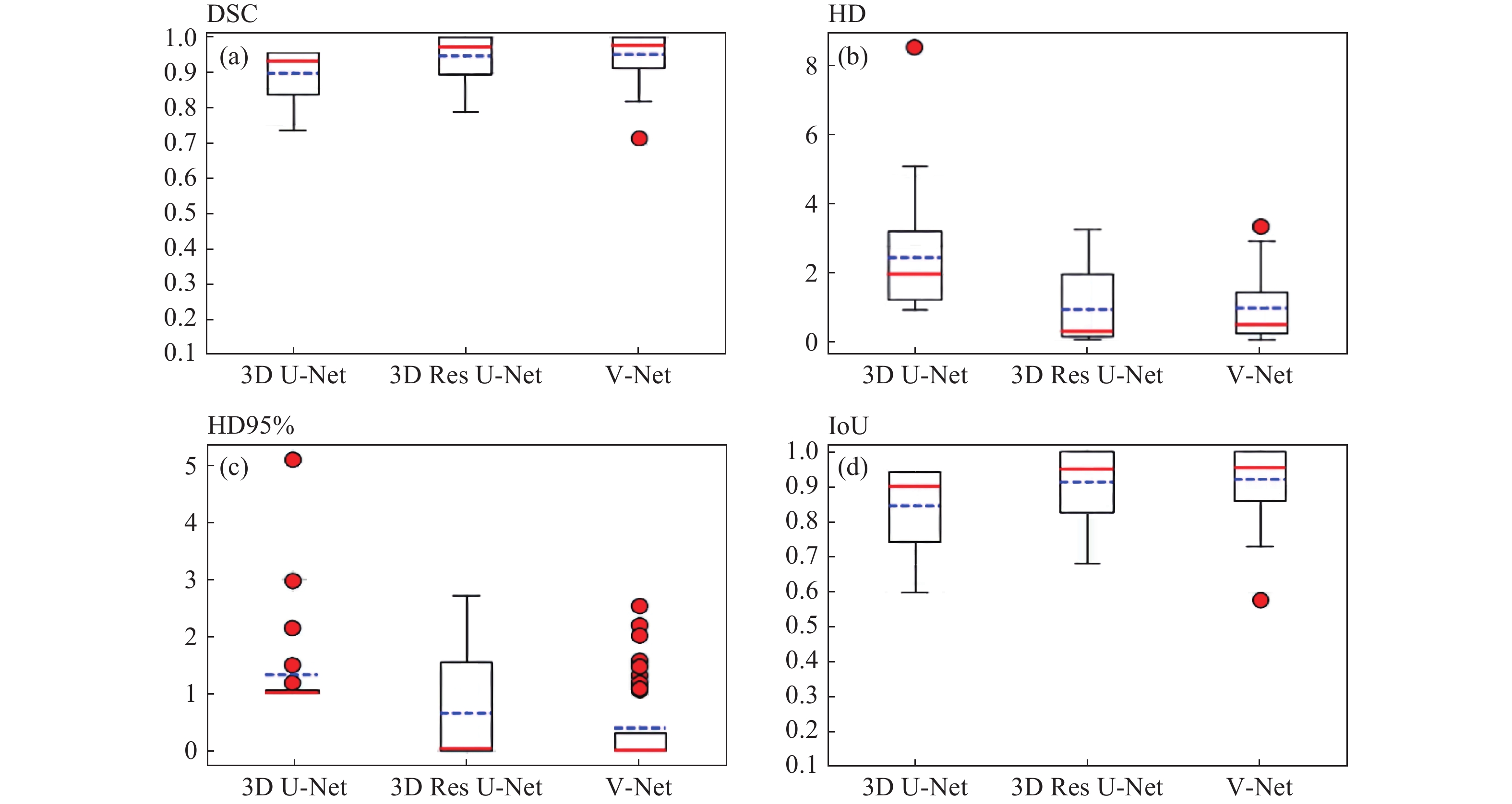

2 结 果 2.1 定量评估指标3D U-Net、3D Res U-Net 和V-Net 3个模型的训练时间接近,约为 10 h,其预测靶区时间分别约为 1.62、2.56和 3.18 s。图2 给出验证数据集在不同epoch时平均Dice loss和DSC值。结果显示,3D U-Net、Res U-Net和 V-Net 模型的最佳平均 DSC值分别为:epoch 60 时 0.95、epoch 506 时 0.96、epoch 210 时 0.96。表1 列出了3种模型在测试集中的评估结果:DSC、HD、HD 95%和 IoU 的平均值(

|

图 2 3种模型验证数据集在不同epoch时平均Dice loss和DSC值 Figure 2 The three models validate the mean Dice loss and DSC values of the datasets at different epochs 注:(a)3D U-Net、(b) Res U-Net、(c) V-Net。 |

|

|

表 1 3种 DL 模型 HR-CTV自动分割的测试集定量评估结果 Table 1 Quantitative evaluation of three deep learning models in automatic segmentation of high-risk clinical target volume with testing dataset |

|

图 3 3个 DL 模型分割HR CTV 测试集定量参数评估直方图 Figure 3 Quantitative parameter evaluation histograms of three deep learning models in automatic segmentation of high-risk clinical target volume with testing dataset 注:(a)DSC,(b)HD,(c)HD95%,(d)IoU。平均值为蓝色虚线,中位数为红色实线,红点为异常值。 |

|

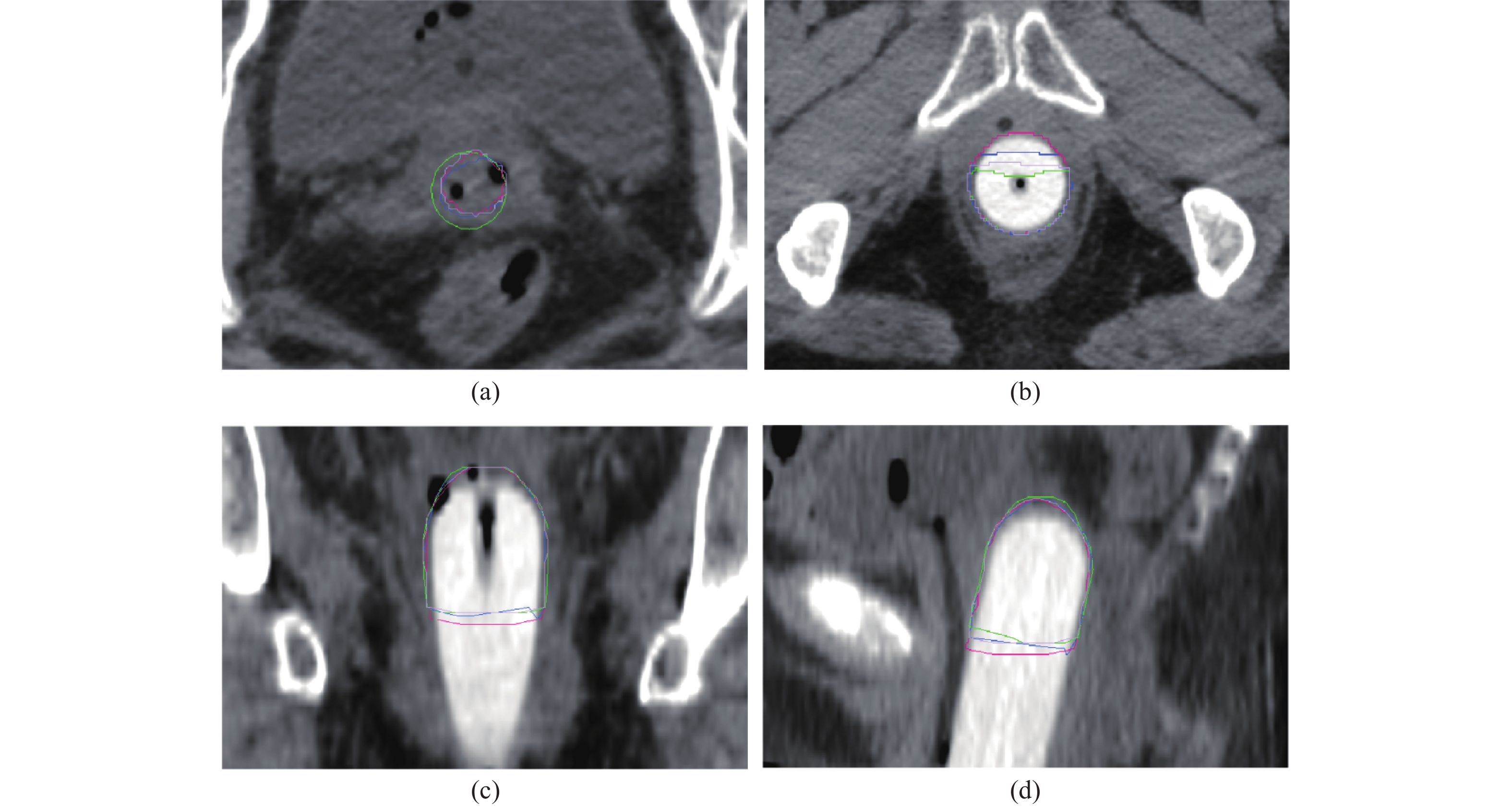

图 4 3组DL模型预测HR-CTV与GT比较 Figure 4 Comparison of the three deep learning models with ground truth in predicting high-risk clinical target volume 注:(a)横截面最上层,(b)横截面下层,(c)冠状面,(d)矢状面。GT:绿色线;3D U-Net:红色线;3D Res U-Net:蓝色线;V-Net:淡紫色线。 |

根据上述4点评分标准,在3种 DL 模型中,基于 DL 的自动分割HR-CTV获得 1、2 和 3 点分的比例如表2 。

|

|

表 2 DL自动分割HR-CTV的四点评分临床结果 Table 2 Four-point clinical scoring of deep learning models in automatic segmentation of high-risk clinical target volume |

为评估DL自动分割技术在临床上的潜在应用价值,对DL生成的HR- CTV和6位临床医生手动绘制的靶区,分别与GT结果比较,见表3。

|

|

表 3 DL自动分割和医生手动勾画结果分别与GT进行定量评估(DSC和HD)比较 Table 3 Comparison of deep learning automatic segmentation and physician manual outlining with ground truth using quantitative assessment (DSC and HD) |

在VBT中,精确地勾画CTV极为关键。然而,手动勾画CTV容易受到不同操作者经验水平影响,导致观察者之间的差异。此外,手动勾画过程不仅耗时,而且效率较低。因此,在VBT中引入自动CTV轮廓分割技术是非常有价值的。它可以有效减少施源器植入和治疗之间的时间间隔,并显著降低手动勾画CTV所带来的变异性。本研究旨在评估和比较3D U-Net、3D Res U-Net和V-Net神经网络架构在VBT中对HR-CTV进行自动分割的能力。研究结果显示,与U-Net模型相比,3D Res U-Net和V-Net模型生成的靶区与经验丰富的放射肿瘤专家手动勾画的轮廓具有高度的一致性,同时显著减少了勾画时间。其中V-Net模型在测试集中定量参数评估和临床评估中表现出更优越的性能。

本研究观察到,在验证数据集上,3D Res U-Net 和 V-Net模型预测HR-CTV的DSC达到了0.96,在测试数据集上为0.95;而U-Net模型的DSC则分别为0.95和0.90。在图2中,我们发现当训练超过大约200个epoch时,损失函数开始表现出一定程度的收敛过拟合。特别是U-Net模型中,平均DSC下降至大约50%。在Res U-Net模型中,平均DSC保持稳定,但在V-Net模型中,DSC在大约300个epoch后开始出现波动。U-Net模型中损失函数过拟合的原因可能与模型参数特性有关,这包括对小目标正样本的识别困难以及部分像素预测的误差。因此,Res U-Net和V-Net模型在损失函数的收敛性方面表现优于U-Net模型,且在多次迭代后,Res U-Net模型的DSC稳定性超过了V-Net模型。但在测试集定量评估参数中V-Net略优于Res U-Net。

目前,仅有2篇论文专注于EC术后的CTV自动分割研究。Yan等[16]采用域适应神经网络(domain-adversarial neural networks, DANN)模型对90例VBT患者的HR-CTV进行了研究,得到中位DSC和HD95%值分别为0.97和3.68 mm。而我们提出Res U-Net和V-Net模型在这些指标上的表现更为优异,分别为0.97~0.98 mm和0.65~0.40 mm。由于数据来自不同医疗中心,很难断言哪种模型的性能更优越。Res U-Net和V-Net模型的较佳结果可能受到任务特殊性、数据集规模和质量,或是计算资源和训练时间等其他因素的影响。Xue等[17]采用3D Prompt –nnUnet对321例EC术后患者进行自动勾画研究,得到HR-CTV的DSC、HD、HD95% 和IoU平均值分别为0.96、2.73 mm、1.66 mm和0.92。本研究模型除了DSC和IoU值略低,其余HD和HD95% 都优于此模型。这可能与模型本身鲁棒性及泛化性相关。

在本研究中,依据异常值数据结果表明,预测轮廓明显误差主要发生在最上或下层中,如图4 。此外,我们从定量和临床多个指标来评估每个模型的性能。分析结果表明,测试集中,V-Net大多数定量指标评估的平均值/中值都优于Res U-Net和U-Net 模型。如表2,与其他模型相比,V-Net模型的直接接受使用率最高。这可能是因为此模型生成的预测结果最优,与人工轮廓最为相似。

该研究比较了不同经验水平的临床医生手动勾画靶区和基于 DL 的 HR-CTV 自动分割的准确性,从而评估操作者间的勾画差距。结果表明,自动分割方法与资深临床医生手动勾画靶区GT相当,而优于其他高级临床医生勾画水平。这可能由于不同医生的临床经验、对勾画的熟练程度、标准理解偏差以及对患者医疗信息的掌握程度不同造成,因此,临床医生可以利用 DL 工具提高轮廓勾画准确和一致性,最大限度地减少修改轮廓所花费的时间。研究显示,基于 DL 的自动分割方法所需的时间低于 3.2 s,而人工勾画所需的时间约为 17~24 min。自动分割算法的优越性显而易见。

尽管深度学习算法在自动勾画HR-CTV方面取得了积极成果,但本研究仍存在一些局限。首先,由于研究在单一中心进行,可能会影响到结果的广泛适用性,因为不同临床环境中的患者特征、治疗习惯和成像技术可能有所差异。其次,施源器的型号和癌症类型的多样性可能会引入变量,使得我们的研究结果难以与其他研究直接比较。此外,尽管剂量学评估在BT中至关重要,但本研究尚未将其纳入自动轮廓划分治疗性能的评估中。尽管存在这些局限,我们的深度学习算法与传统的轮廓划分技术相比,仍然展现出更优的性能。因此,我们认为基于深度学习工具的HR-CTV勾画在临床上具有实际应用价值,能够提升治疗的精确性和效率。本研究证实,Res U-Net和V-Net模型相较于U-Net模型表现更佳,其中V-Net模型在定量指标和临床评估中更胜一筹,为子宫内膜癌的靶区分割提供了最佳的解决方案。

| [1] |

Xia CF, Dong XS, Li H, et al. Cancer statistics in China and United States, 2022: profiles, trends, and determinants[J]. Chin Med J (Engl), 2022, 135(5): 584-590. DOI:10.1097/CM9.0000000000002108 |

| [2] |

Sundar S, Balega J, Crosbie E, et al. BGCS uterine cancer guidelines: Recommendations for practice[J]. Eur J Obstet Gynecol Reprod Biol, 2017, 213: 71-97. DOI:10.1016/j.ejogrb.2017.04.015 |

| [3] |

Wortman BG, Astreinidou E, Laman MS, et al. Brachytherapy quality assurance in the PORTEC-4a trial for molecular-integrated risk profile guided adjuvant treatment of endometrial cancer[J]. Radiother Oncol, 2021, 155: 160-166. DOI:10.1016/j.radonc.2020.10.038 |

| [4] |

Ma CY, Zhou JY, Xu XT, et al. Deep learning-based auto-segmentation of clinical target volumes for radiotherapy treatment of cervical cancer[J]. J Appl Clin Med Phys, 2022, 23(2): e13470. DOI:10.1002/acm2.13470 |

| [5] |

Liu ZK, Liu X, Guan H, et al. Development and validation of a deep learning algorithm for auto-delineation of clinical target volume and organs at risk in cervical cancer radiotherapy[J]. Radiother Oncol, 2020, 153: 172-179. DOI:10.1016/j.radonc.2020.09.060 |

| [6] |

Liang F, Qian PJ, Su KH, et al. Abdominal, multi-organ, auto-contouring method for online adaptive magnetic resonance guided radiotherapy: An intelligent, multi-level fusion approach[J]. Artif Intell Med, 2018, 90: 34-41. DOI:10.1016/j.artmed.2018.07.001 |

| [7] |

Sharp G, Fritscher KD, Pekar V, et al. Vision 20/20: perspectives on automated image segmentation for radiotherapy[J]. Med Phys, 2014, 41(5): 050902. DOI:10.1118/1.4871620 |

| [8] |

Nouranian S, Mahdavi SS, Spadinger I, et al. A multi-atlas-based segmentation framework for prostate brachytherapy[J]. IEEE Trans Med Imaging, 2015, 34(4): 950-961. DOI:10.1109/TMI.2014.2371823 |

| [9] |

Pekar V, Mcnutt TR, Kaus MR. Automated model-based organ delineation for radiotherapy planning in prostatic region[J]. Int J Radiat Oncol Biol Phys, 2004, 60(3): 973-980. DOI:10.1016/j.ijrobp.2004.06.004 |

| [10] |

Cao RF, Pei X, Ge N, et al. Clinical target volume auto-segmentation of esophageal cancer for radiotherapy after radical surgery based on deep learning[J]. Technol Cancer Res Treat, 2021, 20: 15330338211034284. DOI: 10.1177/15330338211034284.

|

| [11] |

陶森. 基于深度学习的肾脏肿瘤分割方法研究[D]. 西安: 西安电子科技大学, 2021. Tao S. Research on segmentation method of kidney tumor based on deep learning[D]. Xi’an: Xidian University, 2021. (in Chinese) |

| [12] |

徐思则, 刘威. 基于UNet网络的乳腺癌肿瘤细胞图像分割[J]. 电子设计工程, 2022, 30(12): 63-66,73. Xu SZ, Liu W. UNet-based image segmentation of breast cancer tumor cells[J]. Electron Des Eng, 2022, 30(12): 63-66,73. DOI:10.14022/j.issn1674-6236.2022.12.013 |

| [13] |

徐旺旺, 许良凤, 李博凯, 等. TransAS-UNet: 融合Swin Transformer和UNet的乳腺癌区域分割[J]. 中国图象图形学报, 2024, 29(3): 741-754. Xu WW, Xu LF, Li BK, et al. TransAS—UNet: regional segmentation of breast cancer Swin Transformer and of UNet algorithm[J]. J Image Graph, 2024, 29(3): 741-754. DOI:10.11834/jig.230130 |

| [14] |

Yu H, Li JQ, Zhang LX, et al. Design of lung nodules segmentation and recognition algorithm based on deep learning[J]. BMC Bioinformatics, 2021, 22(S5): 314. DOI:10.1186/s12859-021-04234-0 |

| [15] |

Zhao C, Shi S, He Z, et al. Spatial-temporal V-Net for automatic segmentation and quantification of right ventricle on gated myocardial perfusion SPECT images[J]. Med Phys, 2023, 50(12): 7415-7426. DOI:10.1002/mp.16805 |

| [16] |

Yan JF, Qin X, Qiao CX, et al. Auto-segmentation of the clinical target volume using a domain-adversarial neural network in patients with gynaecological cancer undergoing postoperative vaginal brachytherapy[J]. Precis Radiat Oncol, 2023, 7(3): 189-196. DOI:10.1002/pro6.1206 |

| [17] |

Xue X, Liang DZ, Wang KY, et al. A deep learning-based 3D Prompt-nnUnet model for automatic segmentation in brachytherapy of postoperative endometrial carcinoma[J]. J Appl Clin Med Phys, 2024: e14371. DOI: 10.1002/acm2.14371.

|

| [18] |

Small W Jr, Beriwal S, Demanes DJ, et al. American Brachytherapy Society consensus guidelines for adjuvant vaginal cuff brachytherapy after hysterectomy[J]. Brachytherapy, 2012, 11(1): 58-67. DOI:10.1016/j.brachy.2011.08.005 |