| 语言差异对跨通道情绪启动效应的影响 |

成功地识别和加工情绪信息是社会交往的关键环节之一,其中,言语和面孔是传递情绪信息的最主要方式,也是个体感知情绪的主要渠道。越来越多的研究发现,现实生活中个体所接收的情绪信息往往不是单一感觉通道传递的,而是多个感觉通道同时传递。个体通常是迅速整合外界各通道感知的情绪信号,调整身心状态以及应对突发事件(De Gelder, Böcker, Tuomainen, Hensen, & Vroomen, 1999)。因此,研究者越来越关注不同通道间(尤其是视觉和听觉)信息加工的相互影响和相互作用关系(Filippi et al., 2017; Logeswaran & Bhattacharya, 2009; Paulmann & Pell, 2010)。

跨通道情绪启动范式常用于研究言语情绪信息与面孔情绪信息加工的相互影响和相互启动效应。较多研究发现,言语情绪信息会对感知同时或相继呈现的面孔情绪信息产生重要的影响,具体表现为,当言语与面孔中的情绪信息具有效价上的一致性时,会对面孔情绪加工产生促进作用,反之,则会产生抑制作用。例如,多项研究发现,当面孔刺激伴随着不协调的语音信息一起出现时,面孔的情绪识别效果会显著降低(Carroll & Young, 2005; Collignon et al., 2008; Ethofer et al., 2006; Pell, 2005),说明言语情绪信息能够影响对面孔情绪的感知和加工。

也有研究发现面孔情绪信息会对加工言语情绪信息产生影响(Paulmann & Pell, 2010),例如,Pourtois,De Gelder,Rossion,Vroomen和Crommelinck(2000)的ERP研究采用Oddball实验范式要求,被试判断在呈现情绪面孔后,言语情绪信息的效价,结果发现,面孔和言语信息包含的情绪效价一致时所诱发的N100比不一致时的更大。随后的研究也进一步证实了这一结论(Pourtois, De Gelder, Bol, & Crommelinck, 2005)。然而,目前不少研究并不支持以上研究结果,例如,Vesker等人(2018)采用跨通道启动范式研究发现,情绪面孔的启动对言语情绪词分类并没有产生影响,相比情绪面孔对言语情绪感知的影响而言,情绪性言语对情绪面孔的影响程度更大。实验范式的变化、刺激材料的差异,以及信息呈现方式的不同都会影响跨通道间信息加工的相互作用关系,言语与面孔的情绪信息能否相互通达和相互作用,尤其是视觉面孔信息能否影响听觉言语信息的加工,尚存在诸多的争议,需要更多实验进行论证。

双语现象越来越普遍,母语和非母语的功能差异逐渐受到研究者的关注,其中一个核心问题就是母语与非母语是否存在情绪和情感功能上的差异。现有研究发现,相比于非母语,母语往往具有更强的情绪连接或情绪启动功能。Segalowitz,Trofimovich,Gatbonton和Sokolovskaya(2008)采用内隐联想测验发现双语者在对一语和二语情感词加工的过程中都会出现效价的自动激活,但一语激活的程度要强于二语。Eilola,Havelka和Sharma(2007)在对比英语本族语者和希腊英语双语者完成情感Stroop任务时发现,英语本族者只有在加工英语情感词汇(尤其是消极词和禁忌词)时,才能较英语中性词汇产生更高的皮电反应水平。但也有少部分研究并不支持差异性的存在(陈俊, 李佳南, 2016; Sutton, Altarriba, Gianico, & Basnight-Brown, 2007)。可见,母语和非母语的情绪连接或情绪启动功能是否存在差异,尚未形成定论。

基于以上论述,本研究将采用跨通道情绪启动范式,对两方面的问题做出重点讨论,首先,进一步验证前人的研究,对言语和面孔情绪信息加工能否相互影响和相互启动进行佐证,实验1将以听觉言语词汇为启动刺激,以视觉面孔刺激为目标刺激,讨论言语词汇中的情绪信息能否影响面孔刺激中情绪信息的加工。实验2将以视觉面孔刺激为启动刺激,以听觉言语为目标刺激,讨论面孔刺激中的情绪信息能否影响言语词汇中情绪信息的加工。其次,本研究试讨论言语和面孔中情绪信息的相互启动和相互影响效应是否受母语和非母语差异的影响。跨通道情绪启动范式本质上探讨的也是启动刺激的情绪连接功能,以及启动刺激与目标刺激之间的情绪连接关系(Chan, Ybarra, & Schwarz, 2006; Fazio, 2001)。言语情绪信息之所以能够对感知面孔情绪信息产生影响,是因为加工言语情绪信息的过程中直接或间接地(通过语义概念)激活了情绪的形象性信息(例如,面孔),进而对加工后续的面孔情绪产生易化效应(Filippi et al., 2017; Vesker et al., 2018)。与之相似,面孔情绪信息之所以能够对感知言语情绪信息产生影响,是因为加工面孔情绪信息过程中激活了情绪语音信息或情绪语义概念,进而对加工后续的言语情绪产生易化效应(Campanella & Belin, 2007; Klasen, Kreifelts, Chen, Seubert, & Mathiak, 2014)。本研究认为,如果母语相比非母语具有更强的情绪连接或情绪激活功能,那么,当其作为启动刺激时(实验1),相比于非母语,可能会对加工后续面孔情绪刺激产生更显著的影响。而当其作为目标刺激时(实验2),相比于非母语,可能会更容易被之前面孔刺激激活,进而在更大程度上受到面孔刺激情绪信息的影响。

2 实验1:言语情绪词对面孔情绪的启动效应 2.1 研究方法 2.1.1 被试选取云南省某两所高校英语专业且通过英语专业八级(TEM-8)的在校大学生(熟练双语者)26名,平均年龄M为23.32岁,标准差SD为2.34岁,其中男生9名,女生17名。被试视力或矫正视力正常,无听力缺陷。由于被试的抑郁或焦虑情绪会对情绪刺激的加工造成一定的影响,被试需要通过SAS(焦虑自评量表)与SDS(抑郁自评量表)测试(汪向东, 王希林, 马弘, 1999),被试在两个量表上的得分转化为标准分后,均低于分界值。其中,SAS量表的分界值为53分,SDS量表的分界值为50分。

2.1.2 实验材料(1)言语情绪词选取。言语刺激为48个汉语情绪词(24个积极情绪词和24个消极情绪词),均从汉语情感词库中选取(王一牛, 周立明, 罗跃嘉, 2008),且都是双字词。然后对选取的汉语情绪词进行录音,录音方法和评价方法参考以往研究(姜帆, 刘永兵, 2015)。英语情绪词选用汉语情绪对等词,即汉语情绪词翻译之后的英语情绪词,由大学英语教师进行录制,录制过程和汉语情绪词录制过程相同。最终确定48个英语情绪词。邀请英语专业与播音与主持专业的在校大学生进行情绪效价(7点评分)和唤醒度(5点评分)的等级评定,具体评定结果如下,汉语言语情绪词中,积极言语情绪词24个(M效价=5.92, SD效价=0.91; M唤醒度=3.92, SD唤醒度=0.97);消极言语情绪词24个(M效价=1.81, SD效价=0.72; M唤醒度=3.78, SD唤醒度=1.10);t效价(46)=45.88,p<0.01,t唤醒度(46)=0.68,p>0.05。英语言语情绪词中,积极言语情绪词24个(M效价=6.01, SD效价=0.98; M唤醒度=3.97, SD唤醒度=0.97);消极言语情绪词24个(M效价=1.76, SD效价=0.81; M唤醒度=3.90, SD唤醒度=1.00);t效价(46)=43.28,p<0.01,t唤醒度(46)=0.68,p>0.05。

(2)情绪面孔实验材料。从中国化情绪面孔图片系统(白露, 马慧, 黄宇霞, 罗跃嘉, 2005)中选取认同度大于等于90、强度大于等于5的图片,其中,消极情绪图片24张,积极情绪图片24张。邀请在校大学生评定效价(7点评分)和唤醒度(5点评分),具体评定结果如下,积极情绪图片24张(M效价=5.45, SD效价=1.01; M唤醒度=3.5, SD唤醒度=0.97);消极情绪图片24张(M效价=2.4, SD效价=0.61; M唤醒度=3.04, SD唤醒度=0.92);t效价(46)=28.15,p<0.01,t唤醒度(46)=0.78,p>0.05。

2.1.3 实验设计采用2(语言类型:汉语、英语)×2(言语情绪类型:积极、消极)×2(一致性:一致、不一致)完全被试内设计。因变量为做出按键判断的反应时和正确率。

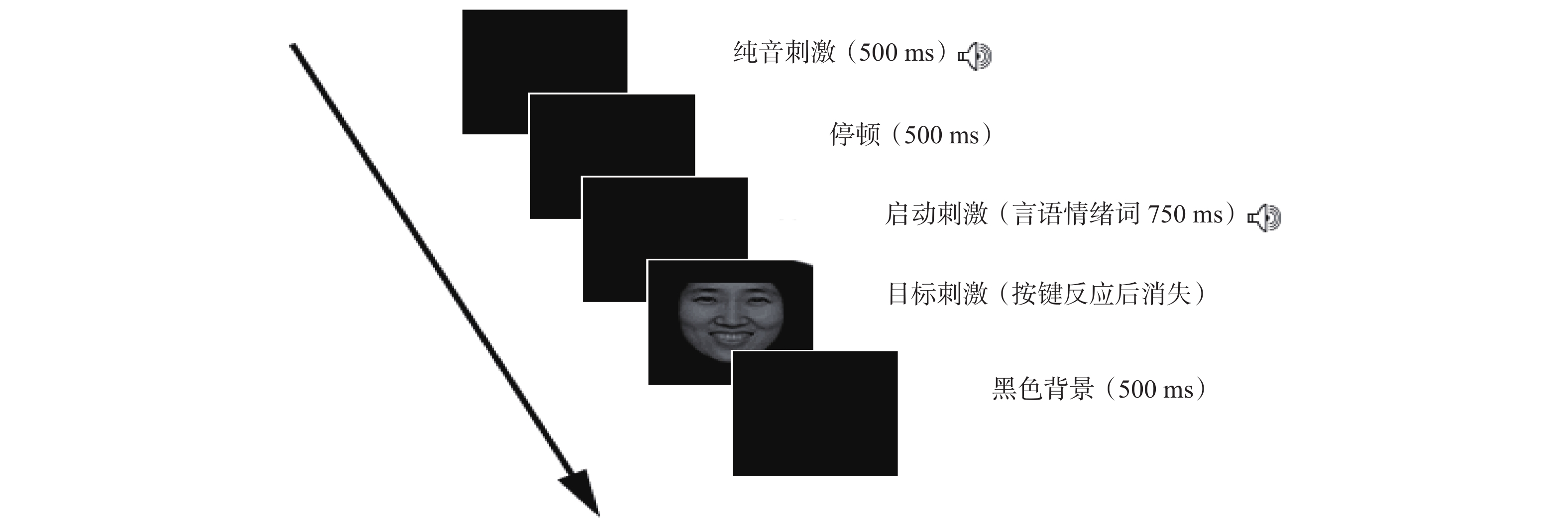

2.1.4 实验程序实验分为两个阶段,第一个阶段中,英语情绪词作为启动刺激,首先呈现言语情绪词(启动刺激),随后呈现面孔情绪(目标刺激),要求被试判断,言语情绪词是否和面孔的情绪类型一致,例如:听到“表彰”,看到积极情绪面孔,则为一致;听到“残酷”,看到积极情绪面孔,则为不一致;若一致,按“F”键,不一致按“J”键。整个阶段共96个试次(48个一致试次,48个不一致试次)。第二个阶段中,汉语情绪词作为启动刺激,其他程序与第一阶段相同。具体流程见图1。在实验开始前,需要进行12个练习试次,被试正确完成11个试次或以上,才能进入正式实验,实验大约需要20分钟。

|

| 图 1 实验1流程图 |

2.2 实验结果

面孔情绪判断的反应时和正确率见表1。以正确率为因变量,重复测量方差分析显示:语言类型主效应显著,F(1, 25)=13.18,p<0.01,η

以反应时为因变量,语言类型主效应显著,F(1, 25)=45.76,p<0.001,η

| 表 1 面孔情绪判断的反应时与正确率 |

3 实验2:面孔情绪对言语情绪词的启动效应 3.1 研究方法 3.1.1 被试

选取云南省某两所高校英语专业且通过英语专业八级(TEM-8)的在校大学生(熟练双语者)23人,平均年龄M为23.13岁,标准差SD为2.43岁,其中男生10名,女生13名。其他筛查标准与实验1相同。

3.1.2 实验材料同实验1。

3.1.3 实验设计采用2(语言条件:汉语、英语)×2(面孔情绪类型:积极、消极)×2(一致性:一致、不一致)完全被试内设计。因变量为进行按键判断时反应时和正确率。

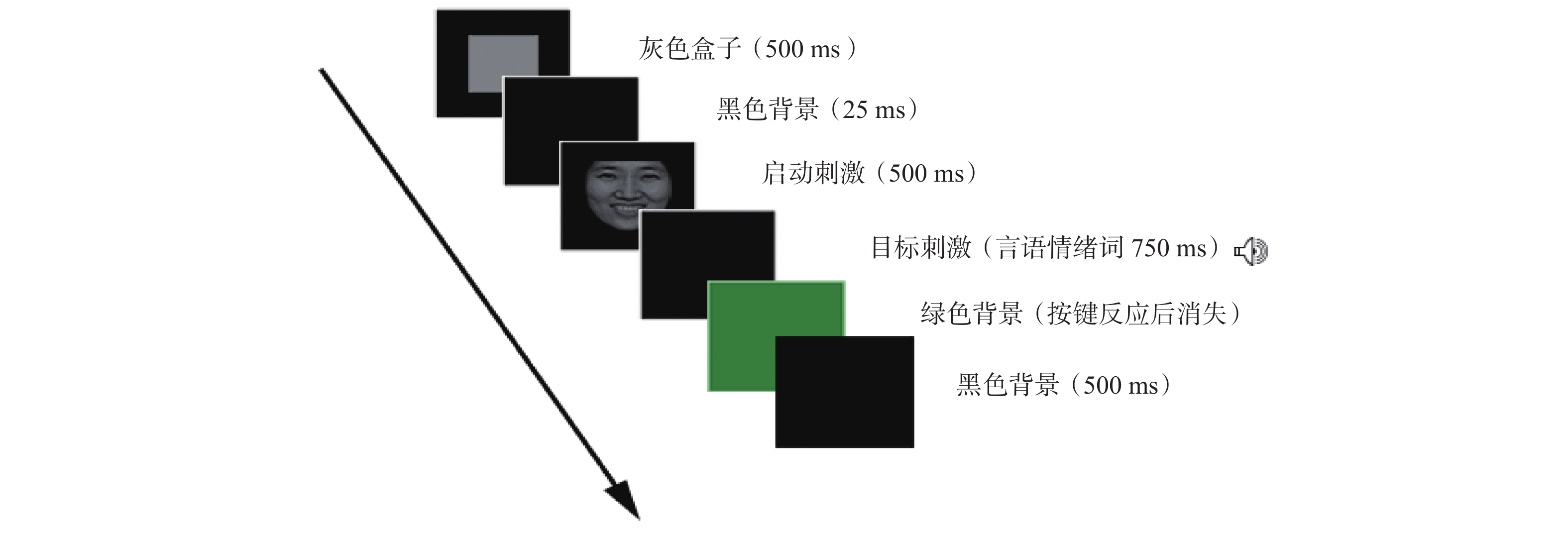

3.1.4 实验程序实验分为两个阶段,第一个阶段中,英语情绪词作为目标刺激,首先呈现面孔情绪(启动刺激),随后呈现言语情绪词(目标刺激),要求被试判断,言语情绪词是否和面孔的情绪类型一致,若一致,按“F”键,不一致按“J”键。整个阶段共96个试次(48个一致试次,48个不一致试次)。第二个阶段中,汉语情绪词作为目标刺激,其他程序和试次与第一阶段相同。具体流程见图2。在实验开始前,需要进行12个练习试次,被试正确完成11个试次或以上,才能进入正式实验,实验大约需要20分钟。

|

| 图 2 实验2流程图 |

3.2 实验结果

言语情绪判断的反应时和正确率可见表2。以正确率为因变量,重复测量方差分析显示:语言类型主效应显著,F(1, 22)=10.55,p<0.01,η

| 表 2 言语情绪判断的反应时与正确率 |

以反应时为因变量,语言类型主效应显著,F(1, 22)=17.73,p<0.001,η

本研究旨在考察言语情绪词与面孔情绪的相互启动效应,以及语言差异(汉语和英语)对情绪跨通道启动效应的影响。

实验1的目的是考察母语(汉语)和非母语(英语)条件下,言语情绪词的启动对情绪面孔分类的影响,实验1的结果发现,语言类型主效应显著,被试在汉语情绪词的启动条件下,对情绪面孔的判断具有更高的正确率和更短的反应时。出现了母语加工优势效应,此结果符合研究假设。推测原因可能是与语言的心理距离相关。本研究选取的被试都是以汉语为母语、英语为非母语的英汉双语者,虽然他们习得英语的平均年龄大约在10年以上,但是日常的交流及生活用语大多数仍然是以汉语(母语)为主,相比起英语,汉语仍然与个体具有更深层和更紧密的关系。母语通常被认为是情绪具身性语言,而非母语可以被描述为情绪距离语言,研究者认为母语在启动情绪过程中可能会有更为直接的通路,从而表现出更自动化的加工特征(Dewaele, 2004; Dewaele & Pavlenko, 2002)。

其次,实验1发现了一致性主效应,被试在一致性条件下的反应时显著短于不一致条件下的反应时,出现了情绪启动效应(Egner & Hirsch, 2005; Zinchenko, Kanske, Obermeier, Schröger, & Kotz, 2015),并且,这种启动效应主要出现在启动刺激为积极情绪的条件下。此结果说明言语情绪的加工对后续面孔情绪的加工具有重要的影响作用,而当言语刺激为积极情绪时,这种影响效应会更为明显。以往较多研究发现言语情绪刺激对面孔情绪刺激能够具有启动效应(Carroll & Young, 2005; Collignon et al., 2008; Pell, 2005),而本研究的结果再一次支持了以往的研究。研究者通常用激活扩散理论来解释情绪启动效应的原理(常翼, 许晶, 史娜, 2010; Fazio, 2001)。言语情绪信息之所以能够对感知面孔情绪信息产生影响,可能是因为加工言语情绪信息的过程中直接或间接地(通过语义概念)激活了情绪的形象性信息(例如,面孔),进而对加工后续的面孔情绪信息产生易化(情绪一致时)或抑制作用(情绪不一致时)(Filippi et al., 2017; Vesker et al., 2018)。但相比以往研究,本研究进一步发现了言语刺激对面孔刺激的影响主要表现在积极情绪条件下,出现积极情绪启动的加工优势。Anooshian和Hertel(1994)研究发现,西班牙语–英语双语者在情绪词的回忆任务中,母语条件下积极情绪词比中性词回忆的成绩更好,出现了积极情绪加工优势。Kissler,Herbert,Winkler和Junghofer(2009)采用电生理和神经成像技术发现对积极词汇的优势效应,同时也在记忆和注意领域出现。情绪词的加工更快是因为情绪效价扮演着重要的角色(Kazanas & Altarriba, 2016),个体对积极情绪面孔的加工更为有效,存在积极加工偏向(Leppänen & Hietanen, 2004)。从言语情绪词与情绪面孔分类的角度分析,本研究结果与以上研究结论是一致的,即在积极情绪词的启动下,对后续面孔刺激中的积极情绪的感知可能会存在更强的促进效应,而对非积极情绪信息的感知反而会存在更强的冲突和抑制效应。

实验2以面孔为启动刺激,探讨面孔情绪对言语情绪的启动效应,以及母语和非母语在其中的差异。实验2发现,首先,语言类型主效应显著,被试在采用汉语条件情绪词作为目标条件时,情绪面孔对其具有更强的影响效应,对言语情绪的判断表现出更高的正确率,以及更短的反应时,此结果再一次证实了母语加工优势效应的稳定存在;其次,在积极情绪面孔启动条件下,对言语情绪词的判断出现了情绪启动的一致性效应,本实验结果说明面孔情绪能够启动言语情绪,但仅出现在积极情绪条件下。实验2的结果能够得到以往研究的支持(刘文娟, 沈曼琼, 李莹, 王瑞明, 2016; 吕勇, 张伟娜, 沈德立, 2010; Vroomen, Driver, & De Gelder, 2001)。同时,实验2在实验1的基础上,再一次说明在积极情绪条件下,词语信息和面孔信息可能具有更强的自动化联结,因而会在相互启动过程中,表现出更强的启动效应。与本研究预期不一致的是,在消极情绪面孔启动条件下,出现了情绪感知的反转效应(reversing effect),即被试对与启动刺激效价相反的目标刺激反应更快(Hermans, Spruyt, & Eelen, 2003)。有研究发现情绪启动的反转效应依赖于刺激材料的可通达性与注意导向,启动字与目标字的反应竞争关系通常会导致情绪启动的反转效应(王若茵, 范宁, 2016),李芳、张海燕、田锐和丁亮(2015)的研究发现情绪一致性前瞻记忆呈现反转效应,即在高兴情绪背景下前瞻记忆负性词成绩比正性词成绩高,在悲伤情绪背景下前瞻记忆正性词成绩比负性词成绩高。也有研究者认为个体对负面情绪刺激的加工更快更准确(Vaish, Grossmann, & Woodward, 2008),消极情绪刺激比积极情绪刺激更能吸引注意力,使得注意力从消极情绪移开的速度慢于积极情绪移开的速度(Fox et al., 2000),从而给其他认知活动带来更大的干扰阻碍(蒋重清, 杨丽珠, 刘颖, 2007; Bach, Schmidt-Daffy, & Dolan, 2014)。这也可能是产生情绪启动反转效应的重要影响因素之一。当前,情绪启动效应与情绪启动反转效应的研究未有定论,本研究的结果为积极情绪下的启动效应和消极情绪启动下的反转效应提供了证据。

实验1与实验2的相同之处在于,都采用跨通道启动范式探讨言语情绪词与情绪面孔之间的相互启动效应,在实验设计与实验程序上基本相同,不同之处在于,实验1以言语情绪词为启动目标,探讨其对加工面孔情绪的情况,实验2则以情绪面孔为启动目标,探讨其对加工言语情绪的影响,从实验结果来看,两个实验中都发现了启动效应,说明个体对言语情绪词与情绪面孔的感知存在相互作用关系和相互影响效应,并且,这种相互作用关系在启动刺激为积极情绪条件时,会表现得更加突出和稳定。此外,实验1和实验2都发现了语言类型的主效应,即不管母语(汉语)是作为启动刺激呈现时使用的语言类型,还是作为目标刺激呈现时使用的语言类型,都能够显著提高被试完成情绪感知任务时的表现,说明母语和非母语在情绪功能上具有差异性,母语体现出加工优势效应。

5 结论在本实验条件下,得到如下结论:相比于英语作为目标刺激条件,在汉语为目标刺激条件下,言语情绪判断具有更好的表现;在积极情绪启动条件下,面孔刺激能够启动言语刺激。研究结果表明,言语情绪与面孔情绪的加工能够相互影响,但这种相互关系主要表现在积极情绪启动条件下。此外,母语和非母语在情绪功能上具有差异性。

白露, 马慧, 黄宇霞, 罗跃嘉. (2005). 中国情绪图片系统的编制——在46名中国大学生中的试用. 中国心理卫生杂志, 19(11): 719-722. DOI:10.3321/j.issn:1000-6729.2005.11.001 |

常翼, 许晶, 史娜. (2010). 卡通表情自动加工的失匹配负波研究. 中华行为医学与脑科学杂志, 19(6): 526-528. DOI:10.3760/cma.j.issn.1674-6554.2010.06.017 |

陈俊, 李佳南. (2016). 汉–英双语者的情感启动: 二语熟练程度对非对称性的影响. 外语教学与研究, 48(3): 396-408. |

蒋重清, 杨丽珠, 刘颖. (2007). 阈下情绪STROOP效应发展特点. 心理学报, 39(2): 242-248. |

姜帆, 刘永兵. (2015). 听觉启动刺激具体性对外语词语音位表征的影响. 现代外语, 38(4): 526-533. |

李芳, 张海燕, 田锐, 丁亮. (2015). 前瞻记忆的情绪一致性反转效应. 心理与行为研究, 13(2): 198-204. DOI:10.3969/j.issn.1672-0628.2015.02.008 |

刘文娟, 沈曼琼, 李莹, 王瑞明. (2016). 情绪概念加工与情绪面孔知觉的相互影响. 心理学报, 48(2): 163-173. |

吕勇, 张伟娜, 沈德立. (2010). 不同愉悦度面孔阈下情绪启动效应: 来自ERP的证据. 心理学报, 42(9): 929-938. |

王若茵, 范宁. (2016). 任务与字频对汉字情绪启动反转效应的影响. 心理科学, 39(3): 559-565. |

汪向东, 王希林, 马弘. (1999). 心理卫生评定量表手册 (增订版). 北京: 中国心理卫生杂志社.

|

王一牛, 周立明, 罗跃嘉. (2008). 汉语情感词系统的初步编制及评定. 中国心理卫生杂志, 22(8): 608-612. DOI:10.3321/j.issn:1000-6729.2008.08.014 |

Anooshian, L. J., & Hertel, P. T. (1994). Emotionality in free recall: Language specificity in bilingual memory. Cognition and Emotion, 8(6): 503-514. DOI:10.1080/02699939408408956 |

Bach, D. R., Schmidt-Daffy, M., & Dolan, R. J. (2014). Facial expression influences face identity recognition during the attentional blink. Emotion, 14(6): 1007-1013. DOI:10.1037/a0037945 |

Campanella, S., & Belin, P. (2007). Integrating face and voice in person perception. Trends in Cognitive Sciences, 11(12): 535-543. DOI:10.1016/j.tics.2007.10.001 |

Carroll, N. C., & Young, A. W. (2005). Priming of emotion recognition. The Quarterly Journal of Experimental Psychology Section A, 58(7): 1173-1197. DOI:10.1080/02724980443000539 |

Chan, E., Ybarra, O., & Schwarz, N. (2006). Reversing the affective congruency effect: The role of target word frequency of occurrence. Journal of Experimental Social Psychology, 42(3): 365-372. DOI:10.1016/j.jesp.2005.04.008 |

Collignon, O., Girard, S., Gosselin, F., Roy, S., Saint-Amour, D., Lassonde, M., & Lepore, F. (2008). Audio-visual integration of emotion expression. Brain Research, 1242: 126-135. DOI:10.1016/j.brainres.2008.04.023 |

De Gelder, B., Böcker, K. B. E., Tuomainen, J., Hensen, M., & Vroomen, J. (1999). The combined perception of emotion from voice and face: Early interaction revealed by human electric brain responses. Neuroscience Letters, 260(2): 133-136. DOI:10.1016/S0304-3940(98)00963-X |

Dewaele, J. M. (2004). The emotional force of swearwords and taboo words in the speech of multilinguals. Journal of Multilingual and Multicultural Development, 25(2–3): 204-222. |

Dewaele, J. M., & Pavlenko, A. (2002). Emotion vocabulary in interlanguage. Language Learning, 52(2): 263-322. DOI:10.1111/0023-8333.00185 |

Egner, T., & Hirsch, J. (2005). Cognitive control mechanisms resolve conflict through cortical amplification of task-relevant information. Nature Neuroscience, 8(12): 1784-1790. DOI:10.1038/nn1594 |

Eilola, T. M., Havelka, J., & Sharma, D. (2007). Emotional activation in the first and second language. Cognition and Emotion, 21(5): 1064-1076. DOI:10.1080/02699930601054109 |

Ethofer, T., Anders, S., Erb, M., Droll, C., Royen, L., Saur, R., … Wildgruber, D. (2006). Impact of voice on emotional judgment of faces: An event-related fMRI study. Human Brain Mapping, 27(9): 707-714. DOI:10.1002/hbm.20212 |

Fazio, R. H. (2001). On the automatic activation of associated evaluations: An overview. Cognition and Emotion, 15(2): 115-141. DOI:10.1080/02699930125908 |

Filippi, P., Ocklenburg, S., Bowling, D. L., Heege, L., Güntürkün, O., Newen, A., & De Boer, B. (2017). More than words (and faces): Evidence for a Stroop effect of prosody in emotion word processing. Cognition and Emotion, 31(5): 879-891. DOI:10.1080/02699931.2016.1177489 |

Fox, E., Lester, V., Russo, R., Bowles, R. J., Pichler, A., & Dutton, K. (2000). Facial expressions of emotion: Are angry faces detected more efficiently?. Cognition and Emotion, 14(1): 61-92. DOI:10.1080/026999300378996 |

Hermans, D., Spruyt, A., & Eelen, P. (2003). Automatic affective priming of recently acquired stimulus valence: Priming at SOA 300 but not at SOA 1000. Cognition and Emotion, 17(1): 83-99. DOI:10.1080/02699930302276 |

Kazanas, S. A., & Altarriba, J. (2016). Emotion word processing: Effects of word type and valence in Spanish-English bilinguals. Journal of Psycholinguistic Research, 45(2): 395-406. DOI:10.1007/s10936-015-9357-3 |

Kissler, J., Herbert, C., Winkler, I., & Junghofer, M. (2009). Emotion and attention in visual word processing—An ERP study. Biological Psychology, 80(1): 75-83. DOI:10.1016/j.biopsycho.2008.03.004 |

Klasen, M., Kreifelts, B., Chen, Y. H., Seubert, J., & Mathiak, K. (2014). Neural processing of emotion in multimodal settings. Frontiers in Human Neuroscience, 8: 822. |

Leppänen, J. M., & Hietanen, J. K. (2004). Positive facial expressions are recognized faster than negative facial expressions, but why?. Psychological Research, 69(1–2): 22-29. |

Logeswaran, N., & Bhattacharya, J. (2009). Crossmodal transfer of emotion by music. Neuroscience Letters, 455(2): 129-133. DOI:10.1016/j.neulet.2009.03.044 |

Paulmann, S., & Pell, M. D. (2010). Contextual influences of emotional speech prosody on face processing: How much is enough?. Cognitive, Affective, & Behavioral Neuroscience, 10(2): 230-242. |

Pell, M. D. (2005). Nonverbal emotion priming: Evidence from the ‘facial affect decision task’. Journal of Nonverbal Behavior, 29(1): 45-73. DOI:10.1007/s10919-004-0889-8 |

Pourtois, G., De Gelder, B., Rossion, B., Vroomen, J., & Crommelinck, M. (2000). The time-course of intermodal binding between seeing and hearing affective information. Neuroreport, 11(6): 1329-1333. DOI:10.1097/00001756-200004270-00036 |

Pourtois, G., De Gelder, B., Bol, A., & Crommelinck, M. (2005). Perception of facial expressions and voices and of their combination in the human brain. Cortex, 41(1): 49-59. DOI:10.1016/S0010-9452(08)70177-1 |

Segalowitz, N., Trofimovich, P., Gatbonton, E., & Sokolovskaya, A. (2008). Feeling affect in a second language: The role of word recognition automaticity. Mental Lexicon, 3(1): 47-71. DOI:10.1075/ml.3.1.05seg |

Sutton, T. M., Altarriba, J., Gianico, J. L., & Basnight-Brown, D. M. (2007). The automatic access of emotion: Emotional Stroop effects in Spanish-English bilingual speakers. Cognition and Emotion, 21(5): 1077-1090. DOI:10.1080/02699930601054133 |

Vaish, A., Grossmann, T., & Woodward, A. (2008). Not all emotions are created equal: The negativity bias in social-emotional development. Psychological Bulletin, 134(3): 383-403. DOI:10.1037/0033-2909.134.3.383 |

Vesker, M., Bahn, D., Kauschke, C., Tschense, M., Degé, F., & Schwarzer, G. (2018). Auditory emotion word primes influence emotional face categorization in children and adults, but not vice versa. Frontiers in Psychology, 9: 618. DOI:10.3389/fpsyg.2018.00618 |

Vroomen, J., Driver, J., & De Gelder, B. (2001). Is cross-modal integration of emotional expressions independent of attentional resources?. Cognitive, Affective, & Behavioral Neuroscience, 1(4): 382-387. |

Zinchenko, A., Kanske, P., Obermeier, C., Schröger, E., & Kotz, S. A. (2015). Emotion and goal-directed behavior: ERP evidence on cognitive and emotional conflict. Social Cognitive and Affective Neuroscience, 10(11): 1577-1587. DOI:10.1093/scan/nsv050 |

2020, Vol. 18

2020, Vol. 18