文章信息

- 张海涛, 王斌君, 王靖亚

- ZHANG Haitao, WANG Binjun, WANG Jingya

- 基于背景重构与边缘相关短文本特征选择方法

- A short text feature selection method based on context reconstruction and marginal relevance

- 武汉大学学报(工学版), 2016, 49(3): 469-475

- Engineering Journal of Wuhan University, 2016, 49(3): 469-475

- http://dx.doi.org/10.14188/j.1671-8844.2016-03-026

-

文章历史

- 收稿日期: 2015-11-29

近年来,随着网络文本形式的数据量猛增,文本分类及深度处理技术成为众多研究领域的热点话题.作为文本处理的基础性处理技术,文本分类是一种为文本自动分配预期类别的技术,是文本处理的首要工作,近年来出现了很多统计分类方法与机器学习方法应用于文本分类研究[1, 2],但文本分类面临的一个重大困难是对象特征的高维性,特别是网络空间中广泛存在短文本对象,由于其实时、短小、稀疏、不规则性等特点,对其进行精确分类或深度处理比较困难.一般的分类算法在处理这些海量的短文本数据时,普遍出现了运算消耗巨大、分类不精确等一系列不适应性问题.

其实短文本信息具有高价值性,是一个迫切需要解决的热点研究课题.基于特征表示模型框架,对单一短文本对象而言,待测特征空间与实际特征空间总是存在不匹配问题,特征不足问题严重,对其进行分类处理或者情感分析等愈加困难,如果通过某种方法减少冗余性特征维度,强化有效特征空间表达能力,则可以提高文本学习算法运行效率,提高处理准确度[3].

针对单一对象特征稀疏、表达不足问题,通过属性扩展来补偿特征空间逐渐成为一种共识.WANG等基于一种KMeans方法通过借用外部关联性特征来充实特征向量空间以解决短文本聚类问题[4].Adams等基于WordNet 中词的上下位关系以扩展特征集,对即时信息进行深入分析[5].类似地,Fan 等为解决短文本信息的弱表达问题,通过增加新特征及修改初始特征权值,并对于特征扩展度进行控制,提高对短文本的分类性能[6].CHEN等提出一种基于KL距离的多粒度主题空间的选择算法,并利用多粒度主题特征模型产生增量特征来解决稀疏问题[7].袁满等人通过词特征间共现与类别关系,计算出相应支持度与置信度,进而抽取出类别属性一致的频繁词特征集,扩充到背景知识库中,增强了短文本语义表达能力[8].对于属性或特征空间增强方法的研究虽然取得了良好的效果,但人工成本过高及算法过程复杂,另外较为依赖于像WordNet、HowNet 这样的知识库,造成系统移植性、兼容性较差.

另一种兼顾性思路是对于与目标领域负相关的维数要约减,对正相关的特征要扩充,文献[9]等遵循此原则,提出一种增量式共现随机网络方法,对短小文本进行词语联想,使用基于最短覆盖路径的属性值扩展算法扩展属性值,增强局部语义特性,同时对冗余属性实施约减.同样地,也有研究者通过利用多语言机器翻译功能来增加特征数目以解决稀疏性问题,同时通过矩阵分解方法对特征空间进行约减[10].

值得一提的是,单纯考虑维数约减与冗余处理问题,学术界引入了针对长文本而设计的多种基于构建特征子空间选择方案,比如互信息(mutual information,MI)、文档频率(document frequency,DF)、信息增益(information gain,IG)、期望交叉熵(expected cross entropy,ECE)等常规的特征降维技术,实际操作中分类准确率可满足一般需求[11].这些方法中,IG是较有效的特征选择方法[12],DF性能相对稍弱,两者强调高频词汇对分类的作用.而MI方法相对较差则是因为特征选择更倾向于罕见词,易致噪声污染[13, 14].IG方法与ECE方法的区别是前者考虑了文本中词语不出现对相应类别的影响,而这一因素虽对文本类别判断有所贡献,但实际操作中发现,类别分布往往与特征值分布呈现不平衡状态,即负性特征倾向性较大,对文本分类造成更大的干扰.文本分类处理过程中,通常是很多不同特征都与分类任务相关,并同时出现在同一文本中,这些特征其实是冗余的,为解决冗余问题,学者们提出了很多复杂的关系模型[15-17].在基于特征空间约减众多方法中,期望交叉熵算法表现较好,它计算训练集中出现的词相对于各个类别的相关权重并求合,即针对所有类别,产生相应特征词集[18, 19].该函数会倾向于选择对类别区分能力强的特征词,但当各类别特征词集分布不平衡时,可能会降低性能.总体上,该算法既考虑词频又强调词的出现与类别的关系,所以应用效果良好.但若存在特征的高度冗余,则需较复杂的关系模型.这里,为进一步解决特征维数约减与冗余问题,既有正向特征增强方法又有负向特征水解处理策略,遵循边缘相关性思路,综合考虑期望交叉熵与冗余性特征度量,既强调特征相关,又通过衡量现有特征与先前已选择过的特征的相关性来度量特征冗余性,这样对文本实施分类时,既考虑了特征的相关性又减少了特征的冗余性.

总之,短文本对象语言特征多义性、空间稀疏性及背景不明确造成其分析处理及深度挖掘困难,针对这些存在的问题,笔者试图通过强调隐含关联关系,重构文本内容背景特征,强化特征语义表达能力,并计算边缘相关性来提升文本特征选择性能.

1 基于背景重构的特征空间增强此节阐述背景重构过程,涉及到特征关联关系、背景关系表达与权重设计、词特征之间相关计算及EM极大似然估计等要点.其中难点是由于短文本结构不统一造成的特征空间与背景关联的语言模型设计问题.

语言学家 Zeling Harris 的研究发现,文档中共现频繁的词呈现围绕主题的相关性统计特征.故通过分析文本集中背景关系可以体现词性特征之间关联性[20].这里,采用基于词矢量的语义量化模型,首先,用在词空间中的目标词与坐标轴词矢量的共现率的统计特征来表示.对于词ti,其矢量表示为

其中:k表示以目标词为中心的背景长度,即在词典中与ti共现率超过阈值的词数目;ωkj为相对权重.

已有研究表明目标词背景内几个特定词能够达到替代背景或上下文全部内容对于词义的辨析作用[21],故可以通过从背景范围内抽取某些特征词语达到判别目标词语义的目的.这里,为了量化目标词背景语义,在词矢量语义模型基础上为其构建背景关系表示方法,词的上下文矢量表达如下:

其中:|D|为集合中不同词的势;|<ti,tj>|为集合中与词对ti、tj共现超过阈值的词数目;n(ti,tj)为集合中出现ti、tj的文档数量.

规范化处理:

归一化后说明,如果特征词ti、tj共现频率越高,则两者所体现的背景相关性越强,反之,如果与ti共现词数量越多,则tj与其所包含的背景相关性越弱.

关于词对间关联关系计算,定义下式:

其中:γ是关于特征词对ti、tj之间距离dis(ti,tj)的影响因子.在某一窗口内,特征词对之间的距离越大,其相互关联性就越弱,本文中窗口限定于一般短文本.

计算候选特征词tj与目标文档d的相关度,提出下式:

其中:d是包含了目标文档中不相同的词的集合.

先前的研究一般只对某几个目标词扩展特征空间,而这里将考虑与整个待测文本的关系计算候选词的相关性,不是单独的几个词之间的关联性度量,通过R(t,d)的关联性计算,可以得到与整个文档相关度较高的候选词作为特征扩展,从而可以量化同一目标词对应的不同背景特征,分别提取不同的特征扩展词,即通过计算目标词与待测文档整体的相关性R(t,d),基于词的背景特征,使得候选词选择过程可以量化表达.

对于短文本而言,特征词在文本中的出现概率一般是稀疏性较强,往往产生零概率事件,这会导致对多个文档的区分困难.解决办法是采用平滑技术,对未现词人为地分配出现率值,并调整其他词的分布率.这里采用Bayes平滑,平滑参数φ可根据经验设为0.4.

其中:P(ei|ωi)为候选扩展词ei与ωi之间的关联性;P(ωi|d)可基于最大似然估计法(MLE)计算PML(ωi|d),此过程中一个特殊情况是隐含数据或不完全数据问题,可通过EM方法来解决.给定不完全观测数据Y,存在隐含数据Z,式 p(θ|Y)为θ的观测后验分布似然密度函数,p(θ|Y,Z)为含有隐含变量Z的基于θ的后验概率分布,p(Z|θ,Y)为基于参数θ和给定数据Y下隐含数据Z的条件概率分布.实际中,此条件概率分布函数常用容易求解的函数p(Y,Z|θi)代替,θi是i+1次迭代中参数估计值.

E-step:在当前参数估计值θi下与不完全观测数据Y计算对数似然函数条件期望值,积掉隐含变量Z,有

M-step:最大化关于θ的Ω函数,在参数空间Θ中选择θi+1使Ω(θ|θi,Y)最大,即

每步迭代θi→θi+1,E-step和M-step交替重复直到收敛为止,即对ε>0使得‖θi+1→θi‖<ε或者‖Ω(θi+1|θi,Y)-Ω(θ|θi,Y)‖在足够小的范围内变化.每一步迭代EM算法,都可使似然函数值递增,迭代计算下去,似然函数将收敛到一个局部最大值.

基于背景重构而达成的特征补偿或属性扩展方法增强了特征空间的语义表达性,为进一步改善表达的紧凑度,下面将通过边缘相关分析方法凝炼特征相关性,最大限度地提高文本分类处理性能.

2 最大边缘相关分析从原始文本特征集中选取的真子集尽量小,而能够最大化地代表原数据集空间特性,其处理过程实质上是一个优化问题,一个良好的特征选取准则可令原始空间在经过特征选择后,特征空间性质不发生大的变化,在提高分类效率的同时,也能达到较高的分类精确度.

2.1 最大边缘相关以搜索引擎的搜索策略为例.对于用户提交的查询请求,查询算法会根据用户查询的相关度返回一系列降序排列的结果列表,对于这些结果,其冗余性问题也需要得到处理,因此,文档的冗余性消除与查询相关计算需要结合在一起进行,即作为满足限定条件的一个线性组合标准,这种方式即为“边缘相关”.换言之,返回的查询结果既满足用户的查询要求,同时与先前结果比较而言具较小冗余性.此时说明查询结果间体现了较高的边缘相关性,即为最大边缘相关方法[22, 23].

对于初始文档集Cd,元素di表示其中的一篇文档,Q表示查询命令集,S=SI(Cd,Q,θ′),代表了对于查询命令Q,系统基于初始文档集Cd及阈值θ′经过计算得出的结果.Sa表示S中已列出的结果文档序列,dj∈Sa;Sb=S-Sa,则表示未被选择的文档序列,di∈Sb.用Sim表示相似度计算公式,di、dj分别位于不同结果集合,两者之间的相似度计算可以用来衡量已选结果与剩余结果序列的冗余性,文档di的最大边缘相关计算公式可定义为

KL距离可以度量某种类别的概率分布与在先决条件下的概率分布之间的差别,可用于交叉熵计算,若交叉熵越大,就越会影响类别分布状况.而期望交叉熵函数,指的是在训练集中出现的每个词,计算出每个词对于各类别的相关权重后,求其和,针对每个文本类别产生对应的特征词集,对于类别区分能力越强的候选特征词,其被选中的几率越大.其公式如下:

期望交叉熵公式强调了词频特性、词的出现与类别的关系,故在应用中效果较好.

用P(ci|t)表示一种概率分布,其特征t作为前提,类别表示为c,其中,c为类别数量,P(ci|t)越大,则代表特征t与类别分布关联越大,若同时有较小的P(ci)值,则最终的期望交叉熵就越大,此时说明特征t对相应类别分布状况的影响较大,体现了该特征具备较高的重要性.

3 基于最大边缘相关的特征选择在阐述相关概念及算法公式之后,本节提出针对特征选择问题的最大边缘相关算法的公式与运算步骤,即综合考虑了期望交叉熵与信息冗余度来设计该方法.

给定初始训练集的类别集合Cd={c1,…,ck,…,cn},令T为候选特征集,ti,tj∈T,Sa代表了被选择的特征集,tj∈S,Sb=T-Sa为候选集T中剩余特征集合,ti∈Sb,ECE(ti)为关于特征ti的期望交叉熵,ECEpair(ti,tj)为特征对ti和tj的期望交叉熵,则关于特征ti的最大边缘相关定义为

式中,MMR(ti)定义如上节中所示;ECEpair(ti,tj)定义如下:

这里:p(ti,tj)代表了ti,tj的共现概率;p(ci|ti,tj)代表以特征ti,tj为前提且属于类ci的分布概率.对于最大边缘相关式MMR,取λ=1,MMR变成单纯计算系列期望交叉熵值;取λ=0,MMR变成单纯计算候选特征集合T中特征之间的相互最大距离系列值;当取λ∈(0,1)时,MMR为上述2个公式的线性组合优化值,让相似性与相关性达到平衡,以求最优.

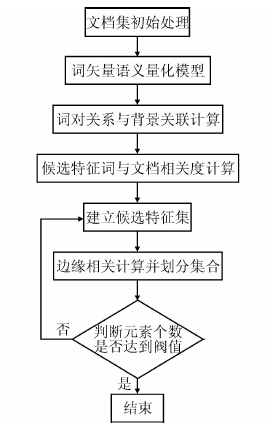

4 特征增强与相关分析的选择框架在1节中,量化了基于背景重构的特征空间强化方法,2节阐述了特征边缘相关性,3节设计了最大边缘相关计算过程,本节在以上工作的基础上,提出特征强化与选择的整体框架,最终提取出的特征集将在下节实验中进行验证.选择流程如图 1所示.

|

| 图 1 特征选择框架流程图 Figure 1 Flowchart of feature selection procedure |

步骤1.构造短文本集的词矢量表示模型ti.

步骤2.通过词的上下文矢量表达Con(ti,tj)、候选特征词tj与目标文档d的相关度R(tj,d)计算等处理,筛选候选特征词.

步骤3.重构特征空间,并初始化:Sb=T,Sa为空; ∀ti∈Sb,由式(10)计算ECE(ti),选择有最大期望熵值的特征,合并入特征集Sa中,集合Sb中同时删除被选中的特征项.

步骤4.对于任意ti∈Sb,任意tj∈Sa,根据式(12)计算ECEpair(ti,tj).

步骤5.由式(11)计算MMR(ti),将最大边缘相关值所对应的特征抽取出,合并入集合Sa中,集合Sb中删除被选中的特征项.

步骤6.若集合Sb为空或者集合Sa中的元素个数达到预定义的值,则算法结束,否则转到步骤4.

5 实例分析实验中对于所提出的背景重构与边缘相关计算(简称为CR-MR)的整体框架方法性能验证,使用传统的DF、IG、MI及ECE特征选择方法,在基准文本数据集Reuters-21578和NewsGroup 语料集上与设计的方法进行比对实验分析,分类阶段采用3种常用分类器:nave Bayes、KNN与C4.5,分别运用不同的特征选择方法进行对比.对于效果评价,实验采用常用的Micro_F1分类性能评价指标,即综合微平均准确率与微平均召回率进行量化评价分析.

5.1 语料集对2个基准数据集Reuters-21578[24]和NewsGroup[25]中文本进行删除停用词、合并同义词等预处理工作.采用通用的十折交叉验证法进行验证,因为新方法第2阶段中的MR计算中参数λ的值需要调整并分析,故在实验中设置了11个λ值(即:0,0.1,0.2,…,1)进行测试,最后从中选出最优λ值.

Reuters-21578标准数据集是一个有21 578篇测试文档的集合,其中包括5个大类与135个子类,类间报道数量不均,本文考虑数据集类内、间数量与分布,从中挑选出5 120篇做为基础训练数据集,测试集为1 637篇,共29类满足实验需求.

NewsGroup标准语料集是互联网用户发贴形成的约两万个新闻文本集合,划分为20类各包含约1 000条新闻文本对应于一个话题,本文选取其中的10组作为实验用例,并考虑类间从属与交叉影响,经处理后,有6 240篇文档作为训练集,3 760篇作为测试集.

5.2 实验结果实验在2个语料集上分别测试不同λ数值时分类器性能表现.固定特征数为400,对于类别分布较均衡的NewsGroup语料集,参数λ设为0.5.而在Reuters21578语料集上参数λ取值为0.6左右.λ取值与所选择的语料集结构有关.经过处理后Retuers21578语料集冗余性小于NewsGroup语料集,因而需要较大的λ值强调相关性.

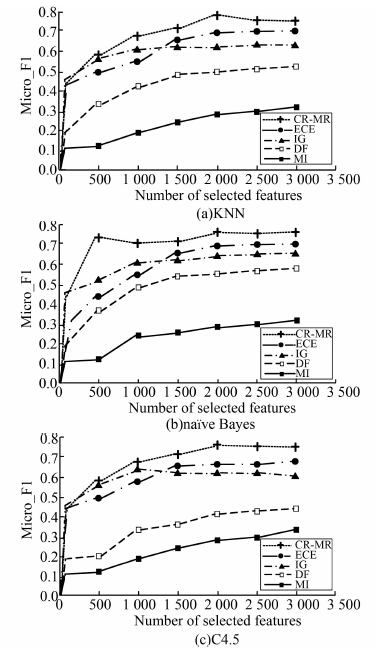

图 2所示为常用方法DF、IG、 MI、ECE及本文提出的CR-MR(λ=0.6)特征选择方法在Reuters-21578数据集分别用naves Bayes、KNN及C4.5分类器的表现,明显看出CR-MR效果最好,其次是IG和ECE,MI效果最差,当特征数目达到一定程度后,CR-MR与ECE有更好的稳定性.CR-MR方法在分类器KNN上的表现在特征数目达到2 000

|

| 图 2 Reuters-21578数据集上3种分类器的平均精确度 Figure 2 Average precision of three classifiers on Reuters-21578 |

时,平均精确度最高达到0.78.另外,特征数量达到1 400时,ECE方法使分类器性能开始超过IG方法,但始终没有超越CR-MR方法达到的水平.

图 3所示为常用方法DF、IG、MI、ECE及本文提出的CR-MR(λ=0.5)特征选择方法在NewsGroup语料集上分别用naves Bayes、KNN及C4.5分类器的运行效果.对于该数据集而言,λ取值为0.5,CR-MR方法仍取得了最好的效果,MI方法在分类器Nave Bayes上的性能最佳.CR-MR方法还表现了较好的稳定性,在特征数量达到2 000时,KNN分类器上的平均精确度达到0.75.整体性能表现基本与图 2中所示一致.

|

| 图 3 NewsGroup数据集上3种分类器的平均精确度 Figure 3 Average precision of three classifiers on NewsGroup |

如何增强特征有效性、相关性的同时减少特征的高维性与冗余性是文本处理的一个重要研究课题,本文基于背景重构与最大边缘相关计算的方法,提出了一种综合性的针对短文本特点的特征选择方法,并在2个标准语料集上,分别用KNN、nave Bayes 及C4.5三种分类器运行几种特征选择方法进行对比实验,实验中,虽然新方法过程稍显复杂使计算开销较大,但总体来说所提出的特征选择方法比其他方法更高效,能够提高分类器的精确分类性能.

| [1] | Ogura H, Amano H, Kondo M. Comparison of metrics for feature selection in imbalanced text classification[J]. Expert System with Applications, 2011, 38(5): 4979–4988. |

| [2] | Li Y H, Dong M, Hua J. Localized feature selection for clustering[J]. Pattern Recognition Letters, 2008, 29(1): 11–17. |

| [3] | Cannas L M, Dessi N, Pes B. Assessing similarity of feature selection techniques in high-dimensional domains[J]. Pattern Recognition Letters, 2013, 34(12): 1446–1453. DOI:10.1016/j.patrec.2013.05.011 |

| [4] | Wang L, Jia Y, Han W. Instant message clustering based on extended vector space model[C]//Proceedings of the 2nd International Symposium an Advances in Computation and Intelligence, Wuhan, China. Springer-Verlag, 2007: 435-443. http://www.oalib.com/references/16885212 |

| [5] | Adams P H, Martell C H. Topic detection and extraction in chat[C]//Proceedings of the IEEE International Conference on Semantic Computing, Santa Clara, USA, IEEE, 2008: 581-588. |

| [6] | Fan X, Hu H. A new model for Chinese short-text classification considering feature extension[C]//Proceedings of the International Conference on Artificial Intelligence and Computation Intelligence, Sanya, China, IEEE, 2010:7-11. http://www.oalib.com/references/16885213 |

| [7] | Chen Mengen, Jin Xiaoming, Shen Dou. Short text classification improved by learning multi-granularity topics[C]// Proceedings of the Twenty-Second International Joint Conference on Artificial Intelligence, Barcelona, Spain, AAAI,2011:1776-1781. http://cn.bing.com/academic/profile?id=27263903&encoded=0&v=paper_preview&mkt=zh-cn |

| [8] |

袁满, 欧阳元新, 熊璋, 等. 东南大学学报(自然科学版),201444(2):256-259[J].

东南大学学报(自然科学版), 2014, 44(2): 256–259.

Yuan Man, Ouyang Yuanxin, Xiong Zhang, et al. Short text feature extension method based on frequent term sets[J]. Journal of Southeast University(Natural Science Edition), 2014, 44(2): 256–259. |

| [9] |

杨锋, 彭鄞科, 徐涛. 基于随机网络的在线评论情绪倾向性分类[J].

自动化学报, 2010, 36(6): 837–844.

Yang Feng, Peng Qinke, Xu Tao. Sentiment classification for online comments based on random network theory[J]. Acta Automatica Sinica, 2010, 36(6): 837–844. DOI:10.3724/SP.J.1004.2010.00837 |

| [10] | Tang Jiliang, Wang Xufei, Gao Huiji, et al. Enriching short text representation in microblog for clustering[J]. Frontiers of Computer Science, 2012, 6(1): 88–101. |

| [11] | Mettu Srinivas, Pujari Supreethi K, Prasad E V, Anitha Kumari S. Efficient text classification using best feature selection and combination of methods [C] // Human-Computer Interaction Processing 2000, San Diego, CA, USA, Town and Country Resort & Convention Center, 2009: 438-445. |

| [12] |

单松巍, 冯是聪, 李晓明. 几种典型特征选取方法在中文网页分类上的效果比较[J].

计算机工程与应用, 2003, 39(22): 146–148.

Shan Songwei, Feng Shicong, Li Xiaoming. A comparative study on several typical feature selection methods for Chinese Web page categorization[J]. Computer Engineering and Applications, 2003, 39(22): 146–148. |

| [13] | Lee J, Lim H, Kim D W. Approximating mutual information for multi-label feature selection[J]. Electronics Letters, 2012, 48(15): 929–930. DOI:10.1049/el.2012.1600 |

| [14] | Lee J, Kim D W. Feature selection for multi-label classification using multivariate mutual information[J]. Pattern Recognition Letters, 2013, 34(3): 349–357. DOI:10.1016/j.patrec.2012.10.005 |

| [15] | Sushmita Mitra, Partha Pratim Kundu, Witold Pedryca. Feature selection using structuralsimilarity[J]. Information Sciences, 2012, 198: 49–60. |

| [16] | Venkatesh Karthik S, Srikant R, Madhu R M. Feature selection & dominant feature selection for product reviews using meta-heuristic algorithms [C]//Proceedings of the 3rd Annual ACM Bangalore Conference. New York: ACM, 2010. http://cn.bing.com/academic/profile?id=2023702817&encoded=0&v=paper_preview&mkt=zh-cn |

| [17] | Gong R, Huang S, Chen Tieming. Robust and efficient rule extraction through data summarization and its application in welding fault diagnosis[J]. IEEE Transactions on Industrial Informatics, 2008, 4(3): 199–205. |

| [18] | Shang Wenqian, Huang Houkuan, Zhu Haibin, et al. A novel feature selection algorithm for text categorization[J]. Expert Systems with Applications, 2007, 33(1): 1–5. DOI:10.1016/j.eswa.2006.04.001 |

| [19] | Pieter-Tjerk De Boer, Dirk P Kroese, Shie Mannor, et al. A tutorial on the cross-entropy method[J]. Annals of Operations Research, 2005, 134(1): 19–67. DOI:10.1007/s10479-005-5724-z |

| [20] | Yoonjung Choi, Youngho Kim, Sung-Hyon Myaeng. Domain-specific sentiment analysis using contextual feature generation[C]//Proceedings of the 1st International CIKM Workshop on Topic-sentiment Analysis for Mass Opinion, Hong Kong, China. ACM, New York, USA, 2009: 37-44. http://cn.bing.com/academic/profile?id=2151262965&encoded=0&v=paper_preview&mkt=zh-cn |

| [21] |

李卫疆, 赵铁军, 王宪刚. 基于上下文的查询扩展[J].

计算机研究与发展, 2010, 47(2): 300–304.

Li Weijiang, Zhao Tiejun, Wang Xiangang. Context-sensitive query expansion[J]. Journal of Computer Research and Development, 2010, 47(2): 300–304. |

| [22] | Yang Lingpeng, Ji Donghong, Leong Munkew. Document reranking by term distribution and maximal marginal relevance for Chinese information retrieval[J]. Information Processing & Management, 2007, 43(2): 315–326. |

| [23] | Guo Shengbo, Scott Sanner. Probabilistic latent maximal marginal relevance[C]//Proceedings of the 33rd international ACM SIGIR Conference on Research and Development in Information Retrieval, ACM, New York, USA, 2010:833-834. http://cn.bing.com/academic/profile?id=2005084129&encoded=0&v=paper_preview&mkt=zh-cn |

| [24] | Reuters21578[EB/OL].http://www.daviddlewis.com/resources /testcollections/reuters21578/. |

| [25] | NewsGroup[EB/OL].http://www.cs.cmu.edu/afs/cs.cmu.edu/project/theo-20/www/data/news20.html |

2016, Vol. 49

2016, Vol. 49