2. 中国石油勘探开发研究院, 北京 100083

2. CNPC Research Institute of Petroleum Exploration and Development, Beijing 100083, China

在我国所有的油气藏类型中, 裂缝型油气藏的产量不仅逐渐上升, 而且在储存油气方面具有更加突出的效果[1]。基于数字露头的地层剖面裂缝发育的自动提取研究, 对于加快石油勘探的地质综合评估、进一步指导勘探选区和部署具有重要的技术支持作用。正确理解裂缝的性质对储层保护和钻井工程控制具有现实意义。目前储层缝洞自动识别的地质方法主要包括岩心观察法、镜下观察法、开发动态分析法和野外露头观察法等[2-4]。其中岩心观察法在张开的裂缝钻井取心过程中易破碎, 从而造成样本的损坏和地质研究的困难; 镜下观察法通常需要依靠先进的电子扫描设备, 因而可靠性相对不易控制; 开发动态分析法则需要拥有大量且连续的石油开发生产资料, 获取难度较大; 相比之下, 野外露头观察法所依据的露头资料更加具有真实性、完整性、精确性和可检验性[5]。传统的地质露头资料的获取手段通常是通过大批地质工作者利用地质工具在野外开展定性研究, 难免会出现人工失误的不准确问题。在数字图像处理技术成为热点的当下, 如何利用该项技术完成裂缝的自动提取成为有现实意义的研究方向。

早在1960年, 数字信号处理技术使图像处理算法真正可以在计算机上实现[6], 这种技术基于图像增强、去除图像噪声、对图像复原和特征的提取等方法广泛应用于各个科学领域。随后国内外学者将传统的图像分割方法应用于裂缝的识别, 包括阈值分割[7-8]、边缘检测[9-10]和区域生长[11-12]等方法。近几年, 随着深度学习算法和人工智能技术的崛起, 卷积神经网络(convolutional neural network, CNN)被应用于图像分割领域, 可以充分利用深层的语义信息实现裂缝精确高效的提取[13-19]。2015年, 全卷积神经网络(fully convolutional networks, FCN)[20]将全连接层替换为卷积层, 可以实现对任意尺度图像的分割[21-22], 但存在边界模糊的问题; 同年U-net[23]被提出, 采用对称的U型网络结构一定程度上影响了后面的分割网络设计, 目前在生物医学影像分割中有广泛应用; 由CHEN等[24-26]提出的一种基于深度卷积神经网络(deep convolutional neural network, DCNN)的DeepLab系列模型, 主要利用空洞卷积的思想扩大感受野从而融合更多的特征信息; 2017年, 在目标检测网络Fast R-CNN[27]的基础上, HE等[28]将FCN与其结合提出了Mask R-CNN, 考虑了多尺度信息的提取, 完成了包括目标检测、图像分割和人体姿态识别等多种计算机视觉任务。随着碳酸盐岩裂缝油气藏勘探的进一步深入, 近几年, 基于深度学习的智能化模型被用于识别裂缝有了极大的发展[29-31]。考虑到复杂的野外环境下裂缝的多尺度性和人工标注的效率较低, 在Mask R-CNN多尺度识别特点的基础上提出一种结合注意力机制的在线增强策略的Mask R-CNN的露头裂缝自动提取方法, 通过样本容错实验、模型消融实验和方法对比实验来验证Mask R-CNN算法改进模型的先进性; 同时以先锋峨边剖面为例, 进行露头裂缝的自动提取和参数统计, 定量分析裂缝发育特征, 为该地区储层裂缝的研究提供依据。

1 结合注意力机制的在线增广Mask R-CNN算法根据裂缝的规模可将裂缝分为大尺度裂缝、中尺度裂缝、小尺度裂缝及微裂缝, 针对裂缝的多尺度性质, 提出能适应裂缝多尺度特点的基于注意力机制的Mask R-CNN算法。在此基础上, 为了适应裂缝所处复杂的地质环境的特点, 避免人工制作大量数据集耗时耗力, 我们对数据集实施了与Mask R-CNN算法相适应的在线增广策略, 从而达到提高裂缝识别精度的目的。

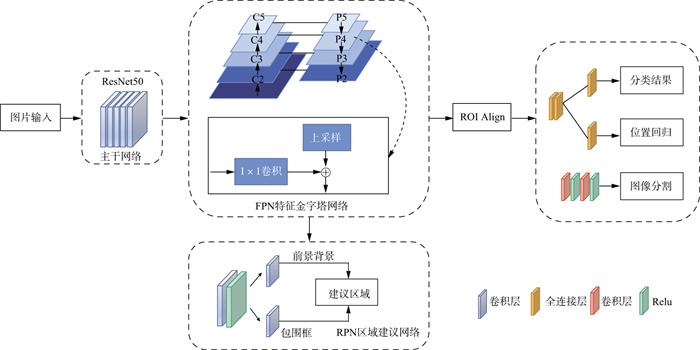

1.1 Mask R-CNN网络模型Mask R-CNN网络模型能够完成多任务的深度学习, 实现像素级别的图像分割预测, 其整体模型框架如图 1所示。当一张图像输入到网络中时, 对特征的提取由ResNet50主干特征提取网络和特征金字塔网络(feature pyramid networks, FPN)[32]实现, 通过主干网络可以获得多个公用特征层即图片上的特征浓缩; 在FPN中对这些特征层的长宽分别压缩两次、三次、四次和五次得到C2, C3, C4, C5来构造特征金字塔, 然后通过上采样和1×1的卷积的侧向连接的融合形成一个自顶向下的有效特征层金字塔; 由特征提取获得的特征层会输入到区域生成网络(region proposal network, RPN)进行建议框的获取, 输出一个包含包围框坐标偏移的定位卷积和包含前景背景分类概率的分类卷积; 网络将FPN和RPN的结果输入ROI Align(region of interesting Align)中实现建议框对特征层的截取; 结果输入到两个分支, 其一是分类回归分支, 它通过全连接层对ROI进行预测输出预测框和类别标签; 其二是掩码mask预测分支, 它通过卷积层对产生前景和背景分类结果即图像分割, 每一类预测物体对应一个mask类别, 减少了类别竞争。在训练的过程中Mask R-CNN网络模型的损失函数由3类函数组成, 分别为分类损失、回归损失和mask分支的损失:

| $ \begin{array}{l} {L_{{\rm{mrcnn }}}} = {L_{{\rm{cls\_rpn}}}}{\rm{ + }}{L_{{\rm{cls\_mrcnn}}}}{\rm{ + }}\left( {{L_{{\rm{reg\_rpn}}}}{\rm{ + }}{L_{{\rm{reg}}\_{\rm{mrcnn }}}}} \right){\rm{ + }}\\ \ \ {L_{{\rm{mask }}}}{\rm{ = }}{L_{{\rm{cls}}}}{\rm{ + }}{L_{{\rm{reg }}}}{\rm{ + }}{L_{{\rm{mask }}}}{\rm{ = }}{\lambda _{{\rm{cls}}}}\frac{{\rm{1}}}{{{N_{{\rm{cls}}}}}} \cdot \\ \ \ \sum\limits_i {{L_{{\rm{cls}}}}} \left( {{p_i}, p_i^*} \right) + {\lambda _{{\rm{box}}}}\frac{1}{{{N_{{\rm{reg}}}}}}\sum\limits_i {p_i^*} {L_{{\rm{reg}}}}\left( {{t_i}, t_i^*} \right) + \\ \ \ {\lambda _{{\rm{mask}}}}\frac{1}{{{N_{{\rm{reg}}}}}}\sum\limits_i {p_i^*} {L_{{\rm{mask}}}}\left( {{y_i}, y_i^*} \right) \end{array} $ | (1) |

|

图 1 Mask R-CNN网络模型框架 |

第1项分类损失Lcls由两部分组成: 其中Lcls_rpn是RPN网络中对建议框中是否含有目标物体的分类损失, Lcls_mrcnn是分类分支中对ROI中目标物体类别的分类损失, Ncls表示每次计算时输入样本的数量, λcls控制该部分损失的比重, pi表示建议区域是否属于检测类别的预测, pi*表示建议区域真实代表的类别; 第2项回归损失Lreg由两部分组成: 其中, Lreg_rpn是RPN网络中建议框和真实框差别的回归损失, Lreg_mrcnn是分类分支位置回归中预测框和真实框的回归损失, Nreg表示建议框数量, λbox控制该部分损失的比重, ti表示目标区域预测框, ti*表示目标所在的真实框, 回归就是要使两者差别尽可能缩小; 第3项Lmask是mask预测分支中网络预测的mask与图像标注的mask的图像分割损失, λmask控制该部分损失的比重, yi表示对每个像元的预测, yi*表示像元的真实值。

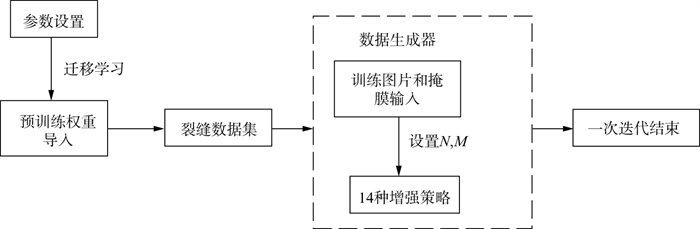

1.2 在线增强策略改进为了达到提高数据样本质量和避免人工标注裂缝样本失误的目的, 数据增强是一种高效的方式, 并且有研究表明深度学习的训练模型在依赖于数据增强方法后性能得到提升[33]。其中无监督的数据增强不需要人工干预数据, 即神经网络模型通过学习的方式去选择合适的数据增强方式, 优化了模型的鲁棒性和泛化能力[34], 这类方法的数据增强方式和神经网络结构搜索类似, 带来了较高的计算成本和模型训练复杂程度。CUBUK等[35]为了减少在线增强造成的参数搜索空间, 设计了RandAugment, 它是以一种简单的格点搜索方法来学习数据增强的策略, 该方法无需在子任务上进行自动搜索, 并且通过实验证明了该方法对模型的提高优于采用单独的子任务搜索的其它方法。为了在保持数据多样性的同时减小参数计算量, 该方法的策略是枚举出常见的包括图像平移、图像旋转、图像曝光和色调分离等14种(K=14)数据增强方式, 根据数据集、模型大小以及硬件条件, 随机选择N种进行模型的训练, 那么潜在的训练策略就包含KN种, 每个增强的方式包含一个用来描述每个图像形变程度的参数M。这就意味着RandAugment只有两个参数, 搜索空间仅为MN, 只需要找到最适合的N和M值, 这样的参数量远小于传统的自动增强方法。提出在基本的Mask R-CNN框架中引入无监督高效数据增强方法, 用于标注后的裂缝训练集在线扩充数据增加多样性, 具体神经网络模型训练的流程如图 2所示。参数在训练前设置完成, 通过迁移学习导入COCO数据集作为预训练模型, 划分裂缝的训练集。RandAugment主要被引入在数据生成器部分, 模型训练阶段中, 在原本直接获得每张图片、真实框和语义分割mask结构的基础上通过设置N和M对图像和mask进行同步增强变换后再输入网络直到一个世代训练结束。该方法在网络训练中通过多种方式增加训练集数量从而提高模型针对不同裂缝的识别能力。

|

图 2 Mask R-CNN网络模型的在线增广策略 |

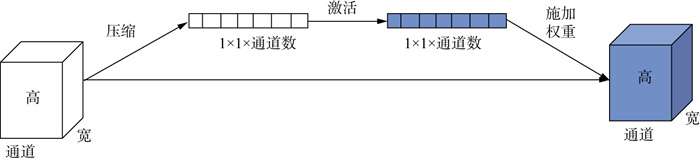

深度学习中的注意力机制的原理类似于人类看照片时会将注意力集中在焦点上。神经网络模型需要处理大量的输入信息, 如果将所有的信息一视同仁, 在计算机算力有限的情况下会产生信息过载的问题。通过引入注意力机制, 在庞大的信息量中关注更需要注意到的关键信息, 降低对无关信息的关注度能提高模型识别的准确性和效率, 在本研究中提高模型对裂缝区域的关注度而降低对背景区域的关注度。注意力机制可以分为通道域注意力机制、空间域注意力机制以及混合域注意力机制。利用通道域注意力机制SENet[36]改善模型, 关注的重点是获得输入的特征层中每一个通道的权重并关注到最重要的通道。图 3为通道域注意力机制SENet的流程。对于输入的特征层采用全局平均池化(GAP), 压缩操作将每个通道上对应的空间信息(宽×高)压缩到对应通道中变为一个通道, 最终维度变为1×1×通道数即一个向量, 此时通过压缩得到了全局描述特征; 将上一步得到的向量输入两个全连接层进行激活操作, 第一个全连接层起到降维作用, 经过ReLu函数激活后再通过一层全连接层恢复到原来的维度得到想要的通道权重; 最后将得到的权重作用到输入特征层的每一个通道上, 也就是对于每个位置上的所有宽×高上的值都乘上对应通道的权值。完成了特征图的重校准, 此时也就构建了每个通道之间的相关性, 从而提高模型的精度。

|

图 3 通道域注意力机制流程 |

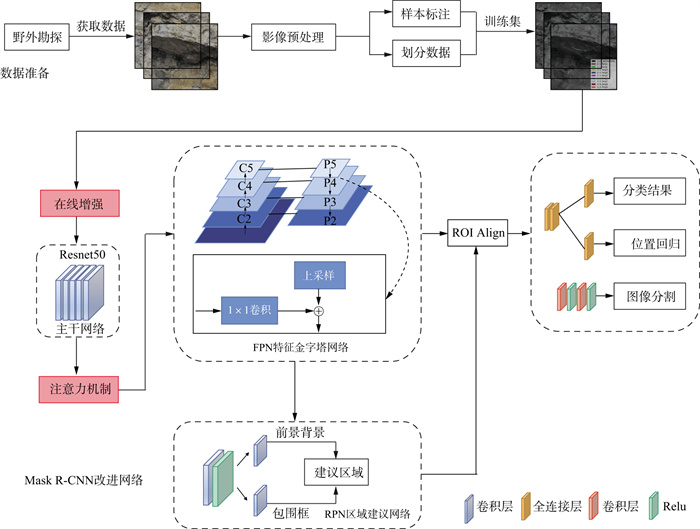

总体检测技术流程如图 4所示, 其中红色填充的区域为在原网络上增加改进的地方。将流程整体分为数据准备和Mask R-CNN改进网络两部分。第一部分数据准备, 通过野外勘探和高精度数码相机获得野外露头剖面数据, 影像经过预处理后将数据集划分并标注形成样本库完成对数据的准备。第二部分将图片输入网络, Mask R-CNN网络的结构已说明, 改进后的网络对于每次输入网络的训练图片数据进行在线增强, 增加训练网络中数据特征多样性以丰富和平衡训练数据并泛化模型。当含有裂缝的图像输入到网络中时, 经过主干网络后将图像的长、宽分别压缩不同的次数来进行金字塔的构建, 此时为了使模型更多的注意到需要识别的裂缝部分, 在此引入注意力机制以捕捉裂缝所在的位置方向和跨通道等信息, 从而更加精确地调整模型对裂缝感兴趣区域的识别。通过位置回归和像素预测达到对裂缝的图像分割。

|

图 4 总体检测技术流程 |

实验数据选用高分辨率数码相机拍摄的先锋峨边灯二段高清相片, 将4张分辨率为7264mm×5440mm的图片分割为大小为800mm×800mm的170张小图作为数据集, 为了避免边界处的漏检, 切割区域设置50%比例的重叠, 因此, 以400mm的步长移动这个矩形框来裁剪原始数据(图 5)。利用图像标注软件Labelme对数据集中裂缝区域进行标注, 并从中选取两个区域进行实验的准确度分析。本实验能够分辨的裂缝宽度大于10mm。

|

图 5 野外露头地层图片切割 |

本实验使用Tensorflow在Windows 10 Pro x64硬件配置中搭建环境。CPU为Intel Core i7, GPU为GTX 1080 Ti, 内存为32G。CUDA和cuDNN版本分别是10.0和7.4, Tensorflow版本是1.13, Python版本是3.6, OpenCV版本是3.4。为了增强网络的泛化性, 避免过拟合, 在本实验中改进了RandAugment(以下简称为RA)数据增强部分, 将实验中的两个超参数即数据增强方式的类别个数N设置为2和每种数据增强方式进行图像扭曲变形的强度M设置为10。在注意力机制部分将SENet的降维超参数r设为16。考虑到裂缝的形态和大小特征, 使用ResNet50作为主干特征提取网络, 训练集和测试集划分比例为9∶1, 非极大值抑制阈值为0.7, 选用Adam优化器优化梯度, 网络训练时学习率为0.0001, 训练批次设置为100, 由于只有一块GPU的算力限制, 为避免计算超载将batchsize设为2。

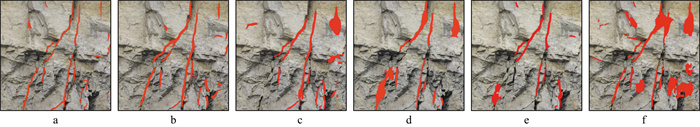

2.3 样本容错实验实验的基础数据是人工手动标注的训练数据, 设计以同一区域为例的对比试验验证模型对于错误标签的容错能力, 实验数据及参数保持与前述数据和参数一致, 裂缝识别结果如图 6所示。分别在错误标签占训练集图片总数量的1%, 5%, 10%、15%和30%的情况下, 验证模型在训练时存在这些错误数据时的容错能力, 其中含有错误标签的图片中, 每个标注的地方都是非裂缝的位置。表 1用精度评价了不同错误标签占比对模型的影响。精度验证方面, 本实验采用了在机器学习性能评估中常见的3种指标, 具体如公式(2)至公式(4)所示。其中, TP代表正样本被判别为正样本; FP代表负样本被判定为正样本; FN代表正样本被判定为负样本。Precision是正确率, 即预测为正的样本中预测正确的比例; Recall是召回率, 即所有正样本中预测为正所占的比例; F1可以对正确率和召回率进行综合预估。

| $ \text { Precision }=\frac{\mathrm{TP}}{\mathrm{TP}+\mathrm{FP}} $ | (2) |

| $ \text { Recall }=\frac{\mathrm{TP}}{\mathrm{TP}+\mathrm{FN}} $ | (3) |

| $ F_1=\frac{2 \mathrm{TP}}{2 \mathrm{TP}+\mathrm{FN}+\mathrm{FP}} $ | (4) |

|

图 6 标签容错能力实验 a人工手动标注的训练数据; b错误标签占比1%; c错误标签占比5%; d错误标签占比10%; e错误标签占比15%; f错误标签占比30% |

| 表 1 错误标签占比对模型的影响 |

可以看出, 在错误标签占比≤10%时对模型影响较小, 正确率、召回率和F1均保持在90%以上; 当错误标签占比达到15%时, 正确率、召回率和F1开始下降到80%。直到错误标签占比达到30%时, 正确率、召回率和F1已经下降到了60%。与表 1对比, 模型的表达能力已经下降到与DeepLabv3+相似的水平, 但是此时错误标签占比已经达到了30%。因此, 可以认为当训练数据中有错误标签时模型已经具有一定程度的容错能力。

2.4 模型消融实验由于引入了基于注意力机制和在线增强两种改进方法, 为了证明它们对实验结果能产生促进作用, 以两个实验区域为例, 实验数据及参数保持不变。分别以是否引入在线增强(RA)和注意力机制(SENet)为变量对裂缝识别精度进行评价, 结果如表 2和表 3所示。从表 2看, 可以得出原始的Mask-RCNN算法的正确率、召回率和F1值分别为90.71%, 91.87%和91.28%;当仅引入在线增强RA时正确率、召回率和F1值分别提高了5.09%, 0.73%和2.80%, 在线增强提高了模型的泛化性; 当仅引入注意力机制SENet时正确率、召回率和F1值分别提高了4.22%, 4.17%、4.18%, SENet增强了模型对重要通道的关注度; 当同时引入RA和SENet时正确率、召回率和F1值分别提高了7.65%, 4.48%, 5.85%, 相对于前两种单一的引入又有了一定程度的提升。从表 3看, 可以得出原始的Mask-RCNN算法的正确率、召回率和F1值分别为94.26%, 93.87%, 94.06%;当仅引入在线增强RA时正确率、召回率和F1值分别提高了2.47%, 0.91%, 1.67%, 在线增强使模型综合能力有所增强; 仅引入注意力机制SENet时正确率、召回率和F1值分别提高了1.43%, 1.52%, 0.93%, SENet同样提高了原始模型的性能; 当同时引入RA和SENet时正确率、召回率和F1值分别提高了3.48%, 1.41%, 2.42%, 显然与前两者相比效果更好。根据实验结果得出, 在线增强方法和注意力机制的引入都能提高模型的性能。

| 表 2 区域一中两种改进方法对模型的影响 |

| 表 3 区域二中两种改进方法对模型的影响 |

为了验证算法精度, 设置了针对两个实验区域的两组对比, 分别将本文提出的算法与传统分割算法、语义分割算法、与传统数据增强技术结合的Mask R-CNN算法进行对比。在传统的分割方法中选择了基于阈值的二值分割的Otsu算法, 这种算法计算过程简单且受图像亮度和对比度影响不大, 将原始图像灰度化后采用Otsu二值化, 经过试验设置阈值为117。其次, 采用串行区域分割的区域生长算法, 事先选择好5个种子点的位置并将种子附近的像素按照相似度进行合并归类最后二值化, 调试得到最优阈值为9;在语义分割算法中选择了两种具有代表性的深度学习算法进行比较。其一是UNet网络, 采用VGG16为主干特征提取网络, 学习率设置为0.0001, 训练批次为100。其二是DeepLabv3+网络, 骨干特征提取网络为MobileNetv2, 学习率为0.0001, 训练批次为100, 参数优化器选用Adam优化器函数; 将Mask R-CNN算法与Python中一种常见的数据增强库imgaug相结合, 通过将8种常见的数据增强变换随机选取3种作用在每次输入的图片上来实现在线数据增广; 最后在本Mask-RCNN+RA+SENet中将RA每次随机选择N设为2种增强方式训练, 其中形变参数M设为10。

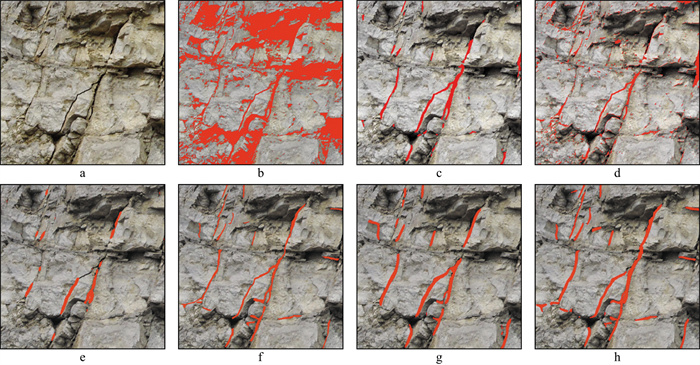

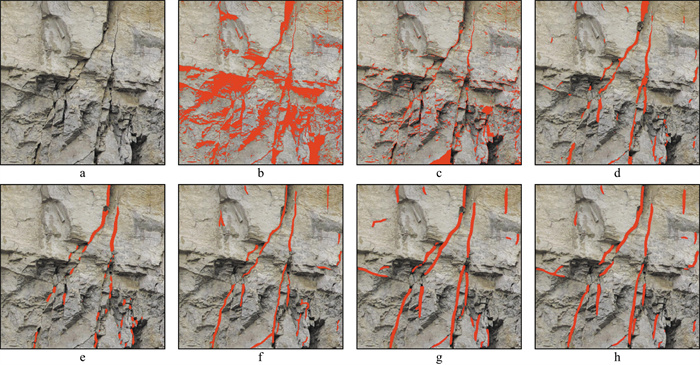

图 7是实验区域一的不同方法裂缝检测结果, 精度评价对应表 4。图 8是实验区域二的不同方法裂缝检测结果, 精度评价对应表 5。可以看出, Otsu相较于其它算法受图像本身的灰度分布影响较大, 很难区别图像中的裂缝、孔洞和阴影部分, 因此4项指标精度都偏低; 区域生长作为传统的图像分割算法在选取5个种子点后对裂缝的识别有明显的好转, 能识别出一些明显的大尺度裂缝; 基于深度学习的两种方法相对于传统的分割方法精度有了进一步提高, 制作的标签输入到网络训练模型, 考虑了裂缝的空间纹理等多种语义特征, 但同时由于数据量的缺乏和模型泛化能力的欠缺而忽略了一些图像中不明显的裂缝; 经过与imgaug数据增强库的结合, Mask R-CNN在精度上有了提高, 模型对数据集的拟合度增加, 检测效果优于前者; 最后是本研究提出的加入注意力机制的SENet结合在线增广RA的Mask R-CNN算法, 通过加入通道注意力以及将源数据在线增强避免模型过拟合, 裂缝检测的正确率、召回率和F1都高于其它算法, 该算法不仅拥有Mask R-CNN模型的像素级检测同时还避免了因为特征维度太多、计算复杂、数据量不够造成的模型过拟合和检测精度低等问题, 最后得出的结果和人工标注的裂缝结果相似度最高。

|

图 7 实验区域一不同方法裂缝检测结果 a原始裂缝; b Otsu; c区域生长; d UNet; e DeepLabv3+; f人工标注; g Mask R-CNN+imgaug; h Mask-RCNN+RA+SENet |

| 表 4 实验区域一裂缝检测结果精度对比 |

|

图 8 实验区域二不同方法裂缝检测结果 a原始裂缝; b Otsu; c区域生长; d UNet; e DeepLabv3+; f人工标注; g Mask R-CNN+imgaug; h Mask-RCNN+RA+SENet |

| 表 5 实验区域二裂缝检测结果精度对比 |

四川盆地是我国油气勘探的主战场之一, 资源潜力巨大, 勘探领域众多, 区内发育20多套含气层系, 目前仍处于大中型油气田发现高峰的勘探早期阶段。研究区位于四川盆地西南部先锋峨边地区, 以避免植物覆盖和风化侵蚀的影响为原则选取, 研究区域内有一条震旦-寒武系地层完全暴露的地质剖面, 地层连续, 层位界线清晰。

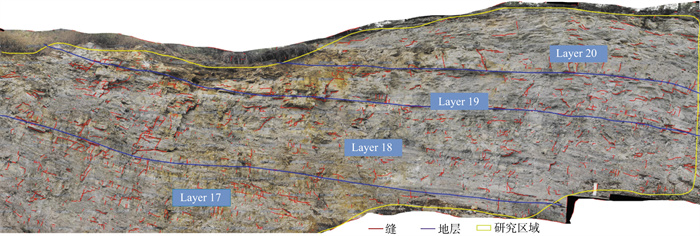

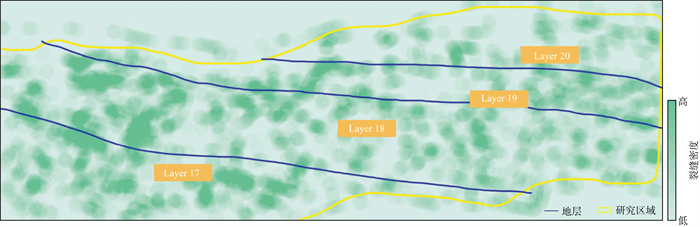

3.2 裂缝发育参数表征利用高分辨率数码相机拍摄的野外露头地质剖面的高精度纹理影像主要用来描述裂缝提取结果, 依据表征参数刻画先锋地质剖面裂缝发育特征。对先锋露头进行裂缝提取(图 9)。其中黄色研究区被划分为17~20共4个小层, 17层为厚层状藻云岩, 藻屑滩; 18层为云坪沉积, 中厚层状藻云岩与灰黑色藻云岩不等厚互层; 19~20层为厚层状藻云岩, 藻屑滩。整个剖面长约45m, 高约10m, 影像的分辨率为2×2(mm)。采用和2.2节一样的实验参数环境, 并将裂缝提取结果以ESRI Shape格式导出, 在ArcMap中进行统计分析, 对裂缝倾向、间距、空间分布模式进行分析。

|

图 9 先锋峨边露头地层剖面裂缝提取结果 |

采用裂缝长度、密度、倾向和间距共4个参数表征裂缝的发育情况。统计了各层裂缝的数量、密度、平均长度和累积长度, 如表 6所示。由表 6可见, 4个地层的裂缝发育存在差异, 第17层的裂缝密度和长度均高于其它层。

| 表 6 裂缝基本情况统计 |

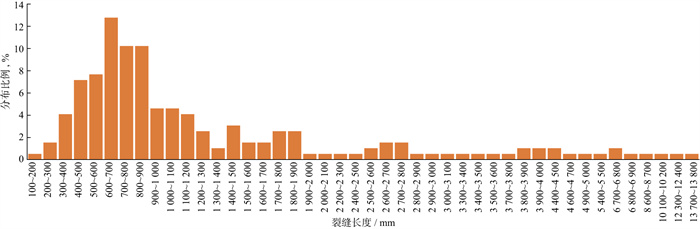

裂缝长度是裂缝的各个方向上的总长度, 可直接由裂缝矢量文件计算得到。通过绘制裂缝长度分布直方图直观显示裂缝长度分布情况, 裂缝长度多为300~2200mm(图 10); 裂缝密度指单位长度或单位面积内裂缝的条数或宽度。本实验中, 裂缝密度系指单位面积内的裂缝条数。露头面积在ArcMap中测量, 裂缝条数在裂缝矢量文件中可直接获取。为了分析裂缝发育可按地层进行裂缝密度计算, 比较各地层差异, 将ArcGIS中的核密度分析工具用于计算裂缝要素在其邻域中的密度, 利用核密度分析方法和线密度分析方法对解译区裂缝空间分布进行了分析(图 11), 可见17和18层的裂缝密度高于其它层。

|

图 10 裂缝长度直方图 |

|

图 11 裂缝空间分布 |

裂缝倾向指裂缝延伸方向在水平面上的投影与正北方向的夹角。将裂缝线矢量文件导入ArcMap后, 使用Linear Directional Mean工具计算裂缝平均线方向。对裂缝总体进行分层走向分析, 以表征裂缝的分层特征。根据现场调查, 裂缝走向总体分成相互正交的两组, 一是水平走向裂缝, 二是垂直走向裂缝, 水平裂缝多为层理缝, 垂直走向多为解理缝。对解理缝进行了总体和分层分析(表 7)。通过数据分析, 裂缝平均走向为17.67°, 圆方差为0.30, 显示较强的方向一致性, 分层存在差异, 较低层位裂缝更竖直, 整体方向一致性较好。

| 表 7 裂缝倾向 |

裂缝间距是指两个相邻裂缝之间的距离, 通过计算每条裂缝与最邻近的裂缝之间的距离得到裂缝间距数据。可进一步计算裂缝平均间距、中位数、标准差、变异系数等统计指标描述裂缝分布与发育情况。在ArcMap中采用近邻分析工具, 计算每条裂缝与最近裂缝距离得到间距数据表。裂缝平均间距27.07cm, 裂缝间距随层位上升而增加。变差系数(CV值)为0.52~0.83, 裂缝间距分布差异较大, 没有表现出明显的一致性特征, 具有随机性特征(表 8)。

| 表 8 裂缝间距分析 |

近几年来在地质野外露头地层剖面裂缝提取研究中, 关于将深度学习算法应用于储层油气资源评价的研究已成为未来发展的重要趋势之一。在露头地层解译中, 针对在野外露头定性研究裂缝时往往出现人工描述比较困难的问题, 借助基于深度学习的图像处理技术, 提出了基于Mask R-CNN的注意力机制和在线增广改进识别算法。

本文实现了露头裂缝的自动化提取, 通过实验证明了模型对错误标签的容错比为30%左右, 模型检测精度优于传统识别方法且精度达到97%左右, 能够在一定程度上替代人工解译, 提高了工作效率。以出露情况较好、植被浮土覆盖较少的四川盆地西南部峨边先锋露头地层为应用区域和高精度数码相机获取的野外露头高分辨率地层剖面数据为基础, 基于提出的深度学习改进算法提取露头裂缝, 根据表征的各项参数刻画裂缝发育特征, 为该区域勘探过程中储层预测提供了依据。

但基于深度学习模型的训练通常对训练数据集的质量要求较高, 为了提高训练模型对各种野外露头裂缝的适用性, 下一步的研究方向应集中在模型训练前期数据集优化策略和模型对狭长目标裂缝的适应性改进上, 同时加强在实际问题上的稳定应用, 从而促进储层预测和地质参数表征的智能化和自动化发展。

| [1] |

张长久, 陈实. 探析裂缝油气藏成因类型与分布规律[J]. 石化技术, 2018, 25(7): 199. ZHANG C J, CHEN S. Analysis of the genetic types and distribution rules of fractured reservoirs[J]. Petrochemical Industry Technology, 2018, 25(7): 199. |

| [2] |

童亨茂. 储层裂缝描述与预测研究进展[J]. 新疆石油学院学报, 2004, 16(2): 9-13. TONG H M. Research progress of reservoir fracture description and prediction[J]. Journal of Xinjiang Petroleum Institute, 2004, 16(2): 9-13. DOI:10.3969/j.issn.1673-2677.2004.02.003 |

| [3] |

蒲静, 秦启荣. 油气储层裂缝预测方法综述[J]. 特种油气藏, 2008, 15(3): 9-13. PU J, QIN Q R. An overview of fracture prediction methods for oil and gas reservoirs[J]. Special Oil & Gas Reservoirs, 2008, 15(3): 9-13. |

| [4] |

张家政, 崔金栋, 杨荣国. 准噶尔盆地红山嘴油田石炭系火山岩裂缝储层特征[J]. 吉林大学学报(地球科学版), 2012, 42(6): 1629-1637. ZHANG J Z, CUI J D, YANG R G. Features of the carboniferous volcanic fracture reservoirs in Hongshanzui Oilfield, Junggar Basin[J]. Journal of Jilin University(Earth Science Edition), 2012, 42(6): 1629-1637. |

| [5] |

刘学锋, 马乙云, 曾齐红, 等. 基于数字露头的地质信息提取与分析——以鄂尔多斯盆地上三叠统延长组杨家沟剖面为例[J]. 岩性油气藏, 2015, 27(5): 13-18. LIU X F, MA Y Y, ZENG Q H, et al. Geological information extraction and analysis based on digital outcrop: A case of Yangjiagou section of the upper triassic Yanchang formation in Ordos Basin[J]. Lithologic Reservoirs, 2015, 27(5): 13-18. |

| [6] |

陈天华. 数字图像处理[M]. 北京: 清华大学出版社, 2007: 100-265. CHEN T H. Digital image processing[M]. Beijing: Tsinghua University Press, 2007: 100-265. |

| [7] |

OLIVEIRA H, CORREIA P L. Automatic road crack segmentation using entropy and image dynamic thresholding[C]//17th European Signal Processing Conference, IEEE, 2009: 622-626

|

| [8] |

马建, 赵祥模, 贺拴海, 等. 路面检测技术综述[J]. 交通运输工程学报, 2017, 17(5): 121-137. MA J, ZHAO X M, HE S H, et al. Review of pavement detection technology[J]. Journal of Traffic and Transportation Engineering, 2017, 17(5): 121-137. |

| [9] |

田金文, 高谦, 杜拥军, 等. 基于井壁成像测井图像的溶洞自动检测方法[J]. 江汉石油学院学报, 1999, 21(2): 29-31. TIAN J W, GAO Q, DU Y J, et al. Automatic detection method of karst cave based on borehole wall imaging logging image[J]. Journal of Jianghan Petroleum Institute, 1999, 21(2): 29-31. |

| [10] |

李雪英, 蔺景龙, 文慧俭. 碳酸盐岩孔洞空间的自动识别[J]. 大庆石油学院学报, 2005, 29(4): 4-6. LI X Y, LIN J L, WEN H J. Automatic recognition of carbonate pore space[J]. Journal of Daqing Petroleum Institute, 2005, 29(4): 4-6. |

| [11] |

LI Q, ZOU Q, ZHANG D, et al. FoSA: F* seed-growing approach for crack-line detection from pavement images[J]. Image and Vision Computing, 2011, 29(12): 861-872. |

| [12] |

ZHOU Y X, WANG F, MEGHANATHAN N, et al. Seed-based approach for automated crack detection from pavement images[J]. Transportation Research Record, 2016, 2589(1): 162-171. |

| [13] |

李良福, 马卫飞, 李丽, 等. 基于深度学习的桥梁裂缝检测算法研究[J]. 自动化学报, 2019, 45(9): 1727-1742. LI L F, MA W F, LI L, et al. Research on detection algorithm for bridge cracks based on deep learning[J]. Acta Automatica Sinica, 2019, 45(9): 1727-1742. |

| [14] |

沈俊凯. 基于计算机视觉的混凝土裂缝检测算法研究[D]. 哈尔滨: 中国地震局工程力学研究所, 2019 SHEN J K. Research on crack detection algorithm of concrete structure based on computer vision[D]. Haerbin: Institute of Engineering Mechanics, China Earthquake Administration, 2019 |

| [15] |

曹锦纲, 杨国田, 杨锡运. 基于注意力机制的深度学习路面裂缝检测[J]. 计算机辅助设计与图形学学报, 2020, 32(8): 1324-1333. CAO J G, YANG G T, YANG X Y. Pavement crack detection with deep learning based on attention mechanism[J]. Journal of Computer-Aided Design & Computer Graphics, 2020, 32(8): 1324-1333. |

| [16] |

王丹, 李琦, 梁栋, 等. 基于多尺度全卷积与CRF的路面裂缝检测算法[J]. 燕山大学学报, 2021, 45(4): 367-376. WANG D, LI Q, LIANG D, et al. Road crack detection algorithms based on multi-scale fully convolution and CRF[J]. Journal of Yanshan University, 2021, 45(4): 367-376. |

| [17] |

吕帅帅, 杨宇, 王彬文, 等. 基于改进Mask-RCNN的飞行器结构裂纹自动检测方法[J]. 振动.测试与诊断, 2021, 41(3): 487-494. LV S S, YANG Y, WANG B W, et al. Automatic crack detection method of aircraft structure based on improved Mask-RCNN[J]. Journal of Vibration, Measurement & Diagnosis, 2021, 41(3): 487-494. |

| [18] |

马丽莎. 基于数字图像处理的路面裂缝识别方法研究[D]. 南京: 东南大学, 2018 MA L S. Research on pavement crack recognition method based on digital image processing[D]. Nanjing: Southeast University, 2018 |

| [19] |

许慧青, 陈斌, 王敬飞, 等. 基于卷积神经网络的细长路面病害检测方法[J]. 计算机应用, 2022, 42(1): 265-272. XU H Q, CHEN B, WANG J F, et al. Elongated pavement distress detection method based on convolutional neural network[J]. Journal of Computer Applications, 2022, 42(1): 265-272. |

| [20] |

LONG J, SHELHAMER E, DARRELL T. Fully convolutional networks for semantic segmentation[C]//Proceedings of the IEEE conference on computer vision and pattern recognition, 2015: 3431-3440

|

| [21] |

黄鹏, 郑淇, 梁超. 图像分割方法综述[J]. 武汉大学学报(理学版), 2020, 66(6): 519-531. HUANG P, ZHENG Q, LIANG C. Overview of image segmentation methods[J]. Journal of Wuhan University(Natural Science Edition), 2020, 66(6): 519-531. |

| [22] |

卢旭, 刘钊. 基于深度学习的图像语义分割技术综述[J]. 软件导刊, 2021, 20(1): 242-244. LU X, LIU Z. A review of image semantic segmentation based on deep learning[J]. Software Guide, 2021, 20(1): 242-244. |

| [23] |

RONNEBERGER O, FISCHER P, BROX T. U-net: Convolutional networks for biomedical image segmentation[C]//International Conference on Medical image computing and computer-assisted intervention. Springer, Cham, 2015: 234-241

|

| [24] |

CHEN L C, PAPANDREOU G, KOKKINOS I, et al. Semantic image segmentation with deep convolutional nets and fully connected crfs[C]//International Conference on Learning Representations, DOI: 10.1080/17476938708814211

|

| [25] |

CHEN L C, PAPANDREOU G, KOKKINOS I, et al. Deeplab: Semantic image segmentation with deep convolutional nets, atrous convolution, and fully connected crfs[J]. IEEE transactions on pattern analysis and machine intelligence, 2017, 40(4): 834-848. |

| [26] |

CHEN L C, ZHU Y, PAPANDREOU G, et al. Encoder-decoder with atrous separable convolution for semantic image segmentation[C]//Proceedings of the European conference on computer vision(ECCV), 2018: 801-818

|

| [27] |

REN S, HE K, GIRSHICK R, et al. Faster R-CNN: Towards real-time object detection with region proposal networks[J]. IEEE Transactions on Pattern Analysis & Machine Intelligence, 2017, 39(6): 1137-1149. |

| [28] |

HE K, GKIOXARI G, DOLLAR P, et al. Mask r-cnn[C]//Proceedings of the IEEE international conference on computer vision, 2017: 2961-2969

|

| [29] |

丁燕, 杜启振, Qamar Yasin, 等. 基于深度学习的裂缝预测在S区潜山碳酸盐岩储层中的应用[J]. 石油物探, 2020, 59(2): 267-275. DING Y, DU Q Z, QAMAR Y, et al. Fracture prediction based on deep learning: Application to a buried hill carbonate reservoir in the S area[J]. Geophysical Prospecting for Petroleum, 2020, 59(2): 267-275. |

| [30] |

蓝茜茜, 张逸伦, 康志宏. 基于样本优化的神经网络方法在储层裂缝识别中的应用[J]. 科学技术与工程, 2020, 20(21): 8530-8536. LAN X X, ZHANG Y L, KANG Z H. Application of neural network based on sample optimization in reservoir fracture identification[J]. Science Technology and Engineering, 2020, 20(21): 8530-8536. |

| [31] |

罗伟, 梁世豪, 姜鑫, 等. 基于深度学习的野外露头区岩石裂缝识别[J]. 计算机与现代化, 2020(5): 56-62. LUO W, LIANG S H, JIANG X, et al. Crack recognition of outcrop area based on deep learning[J]. Computer and Modernization, 2020(5): 56-62. |

| [32] |

LIN T Y, DOLLAR P, GIRSHICK R, et al. Feature pyramid networks for object detection[C]//Proceedings of the IEEE conference on computer vision and pattern recognition, 2017: 2117-2125

|

| [33] |

吴天雨, 许英朝, 晁鹏飞. 一种提高目标图像识别准确率的数据增强技术[J]. 激光杂志, 2020, 41(5): 96-100. WU T Y, XU Y C, CHAO P F. Dataaugmentation technology for improving target image recognition[J]. Laser Journal, 2020, 41(5): 96-100. |

| [34] |

CUBUK E D, ZOPH B, MANE D, et al. AutoAugment: Learning augmentation strategies from data[C]//2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition(CVPR). IEEE, 2019, DOI: 10.1109/CVPR.2019.00020

|

| [35] |

CUBUK E D, ZOPH B, SHLENS J, et al. Randaugment: Practical automated data augmentation with a reduced search space[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition Workshops, 2020: 702-703

|

| [36] |

HU J, SHEN L, SUN G. Squeeze-and-excitation networks[C]//Proceedings of the IEEE conference on computer vision and pattern recognition, 2018: 7132-7141

|