2. 中国科学院月球与深空探测重点实验室, 北京 100012

2. Key Laboratory of Lunar and Deep Space Exploration, National Astronomical Observatories, Chinese Academy of Sciences, Beijing 100012, China

深空探测是21世纪世界航天活动的热点,对小行星、彗星、大行星及其卫星等深空天体的探测是人类认识自己、了解太阳系和宇宙起源的重要途径。我国也顺利实施嫦娥探月工程,分绕、落、回三期对月球展开无人探测活动[1-2]。行星探测车是一种能够在行星表面实现自由漫游的探测工具,它对行星表面的较大面积进行近距离和接触式的考察,因此已成为行星无人探测的最佳手段。

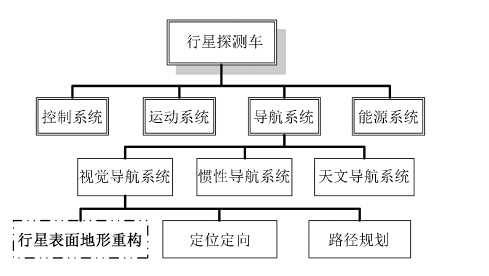

为实现行星无人探测车在未知环境中长时间的安全运行,有效的导航手段是其寻找风险最小的行进路线,避开各种障碍和坑洞,从而成功完成预定科学探测任务的基本保障。根据导航信息获取原理的不同,行星无人探测车的导航技术可分为视觉导航、惯性导航、无线电导航、天文导航(图 1)等等。行星无人探测车的视觉导航系统通过对地外星体表面环境的理解和识别,实现对障碍物或可通行区域的检测与识别,快速准确地为行星无人探测车行进提供可靠的导航信息。相对于其它导航方法,视觉导航具有组成器件均为固定件(通常为CCD 摄像机、工控计算机、图像采集卡等)、技术成熟、结果可靠性和元件可靠性较高等优点,而且能耗相对较低,能一次捕获整个画面,因此视觉导航系统在各种行星探测车导航系统中逐渐成为主流。

|

| 图 1 地形重构是行星无人探测车行进和科学探测的基础 Figure 1 Terrain reconstruction: an essential condition for the navigation of planet rovers |

行星无人探测车视觉导航系统涉及许多关键技术,包括行星表面地形重构、定位定向、路径规划等。行星探测车的地形重构工作旨在查明行星探测车周围较大范围内的环境状况,包括上下坡和石块等障碍物存在与否及其确切的位置和大小,获取环境与障碍物信息,通常数据形式表现为数字高程模型(Digital Elevation Model,DEM)与数字正射影像(Digital Orthophoto Map,DOM)。这些信息结合定位定向系统提供的平移参数与姿态参数,共同提供给路径规划系统(或人机交互系统),为行星无人探测车确定合理的行驶路径,保证行星无人探测车的安全运行。地形重构是行星无人探测车在行星表面行进和科学探测的基础,是行星无人探测车进行路径规划和安全避障的基本保证。

1 行星无人探测车及其地形重构如前文所述,行星表面的地形重构是保证行星无人探测车漫游顺利进行的关键环节。地形重构的基本原理是根据立体视觉的方法,利用立体相机获得的左右图像的重叠关系,对重叠区域的同名特征点进行快速准确提取和密集匹配,获取地面地形的三维点云,再通过插值平滑生成行星表面的三维地形。下面详细介绍各行星无人探测车的地形重构技术方法。

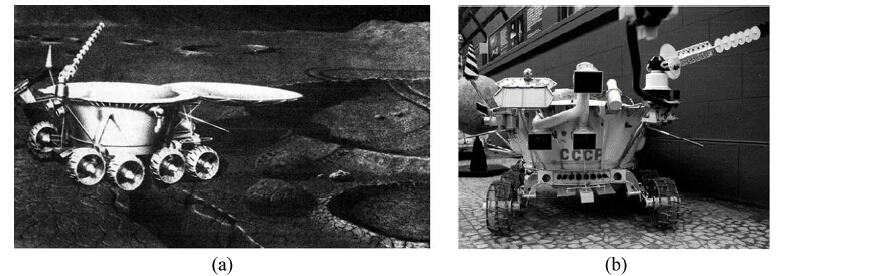

目前共有6个行星车被送上月球,4个行星车被送上火星。除去由宇航员驾驶的月面巡游车阿波罗号系列月球车,在行星表面成功漫游的行星无人探测车包括:Lunokhod 1、Lunokhod 2、玉兔号和4个火星车:旅居者号、勇气号、机遇号、好奇者号。每个探测车的着陆日期和所属任务、机构如表 1。

| 日期 | 行星探测车 | 探测星球 | 行驶距离/km | 所属探测任务 | 机构 | 行星探测车类型 |

| 1970 | Lunokhod 1 | 月球 | 10.5 | 月球步行者 | 前苏联 | 行星无人探测车 |

| 1971 | 阿波罗15 | 月球 | 27.8 | 阿波罗探月 | NASA | 宇航员驾驶 |

| 1972 | 阿波罗16 | 月球 | 27.1 | 阿波罗探月 | NASA | 宇航员驾驶 |

| 1972 | 阿波罗17 | 月球 | 35.7 | 阿波罗探月 | NASA | 宇航员驾驶 |

| 1973 | Lunokhod 2 | 月球 | 39.0 | 月球步行者 | 前苏联 | 行星无人探测车 |

| 1997 | 旅居者号 | 火星 | 0.1 | 火星探路者 | NASA | 行星无人探测车 |

| 2004 | 勇气号 | 火星 | 7.7 | 火星探测漫游者 | NASA | 行星无人探测车 |

| 2004 | 机遇号 | 火星 | 40.2* | 火星探测漫游者 | NASA | 行星无人探测车 |

| 2012 | 好奇号 | 火星 | 8.6* | 火星科学实验室 | NASA | 行星无人探测车 |

| 2013 | 玉兔号 | 月球 | 0.1 | 嫦娥月球探测工程 | CNSA | 行星无人探测车 |

| *注:数据截止至2014年7月28日 *NASA:美国航空航天局;CNSA:中国国家航天局 | ||||||

(1)Lunokhod 1、Lunokhod 2

1970年11月,苏联成功将遥控型行星探测车Lunokhod 1(图 2)发送到月球表面,这是第1个成功登陆月球表面的行星探测车[3]。1973年,同类型月球车Lunokhod 2也被送到月球表面。月球车1号和2号成功实现了两次不载人巡视器月面勘察,以不同摄像头形成的小画幅图像作为参考,通过地面飞控中心的远程控制系统实现月面巡视器沿月表运动的控制,其中障碍物辨别、确定障碍距离、分析道路可穿越性等月面地形分析工作均由地面控制人员目视解译完成,与当前的三维地形重构技术有本质区别。这种完全由地面人员决策的操纵方式的缺点在于信号延误时间较长,且操控效果难以保证。月球是离地球最近的星球,无线电信号传输的时延为1 s左右,而对于火星等距离更远的行星,信号延误时间将大大增长,因此Lunokhod系列月球车之后的行星无人探测车开始广泛使用基于三维重建的地形重构技术,旨在实现行星无人探测车的自主避障与导航。

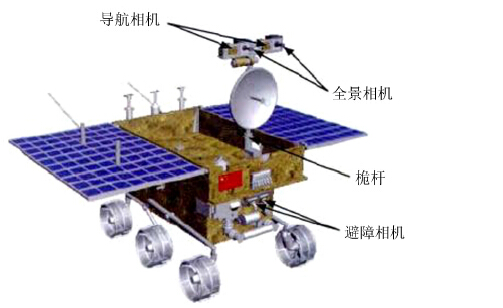

(2)玉兔号

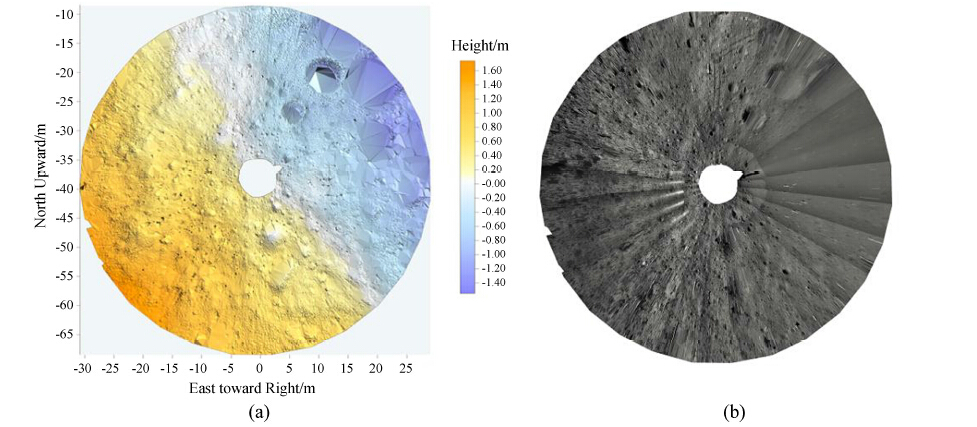

2013年12月14日,嫦娥三号成功将月面着陆器和玉兔号月球车送抵月球。玉兔号携带有3对立体相机,导航相机和全景相机安装于月球车桅杆顶部,避障相机安装于车体前部,如图 3。不同立体相机采集的图像下传至地球后,由遥操作任务系统准实时生成系列制图产品,其处理流程大致相同,包括核线影像、数字高程模型、数字正射影像、坡度图、障碍物分布图等,为任务规划、路径规划、可视化等提供基础地形数据[4]。导航相机作为工程相机,相当于月球车的眼睛,玉兔号每行驶10 m左右停下拍照,用导航相机影像生成 0.02 m分辨率的数字高程模型、数字正射影像,完成月面地形重构。全景相机能够在沿途站点进行360°环拍,生产视野范围更宽广的数字高程模型和数字正射影像。

导航相机在月球车的环境感知、路径规划中发挥主要作用,其生产数字高程模型和数字正射影像(图 4)的技术流程(图 5)如下:(1)坐标系转换:导航相机制图坐标系统为工作区坐标系,月球车位置与姿态由遥测结果和视觉定位方式计算获得;月球车桅杆遥测参数为桅杆结构3个旋角;根据相机旋转角度及相机安置矩阵首先将获取图像的外方位元素转换到工作区坐标系下。(2)特征点提取:相机标定参数由发射前地面检校获取;根据立体相机相对关系生成核线影像,使两幅图像的扫描线对齐,从而将匹配的搜索空间由二维降至一维;利用尺度不变特征变换(Scale-Invariant Feature Transform,SIFT)算子提取核线影像同名点,并用随机抽样一致(Random Sample Consensus,RANSAC)方法剔除粗差点。(3)区域网平差:通过相邻影像间匹配的连接点及初始影像外方位元素进行区域网平差,调整优化影像外方位元素。(4)立体匹配:利用同名点构建三角网约束,进行3 × 3密集点匹配并剔除粗差。(5)三维坐标计算:空间前方交会计算密集匹配点三维坐标。(6)基于三维坐标构建不规则三角网。(7)生成数字高程模型:通过克里金插值方法内插构建数字高程模型。(8)生成数字正射影像:基于数字高程模型、原始影像及影像参数生成数字正射影像。

|

| 图 5 玉兔号月球车导航相机影像生成数字高程模型、数字正射影像流程图 Figure 5 The generation of the DEM and DOM using the data from rover Yutu |

(1)旅居者号

美国航空航天局在1997年的 “火星探路者” 计划(Mars Path Finder,MPF)中研发了第1部被送至火星的行星无人探测车旅居者号。旅居者号利用2台摄像机和5个激光条纹发射器检测地表障碍,判断地形变化[5]。旅居者号火星车的视觉导航系统结合基于激光测距的感知系统和基于立体视觉的感知系统,一方面利用立体视觉绘制大范围的场景信息,另一方面,对于其中一些需要详细观测的较小区域,在立体视觉地形重构基础上采用激光测距仪进行扫描观察,两者结合既可以提高地形数据质量,又不会对处理速度造成很大影响。在此之前卡内基梅隆大学开发的六腿式火星车Ambler也通过一台扫描式激光测距仪为其导航系统获取三维地形信息。但是,激光测距仪的使用存在一些缺点:一方面激光测距仪的二自由度机械扫描装置容易产生机械故障,其可靠性低于立体视觉的感知系统;另一方面激光测距仪对能源消耗量比较高。在随后的火星探测计划中,考虑到这些因素,以及立体视觉算法逐渐被证明能够为火星车的地形重构提供足够的精度、准确度及运行速度,美国航空航天局不再使用携带激光发射器的火星车,而是采用立体视觉感知手段获取火星表面的三维地形。

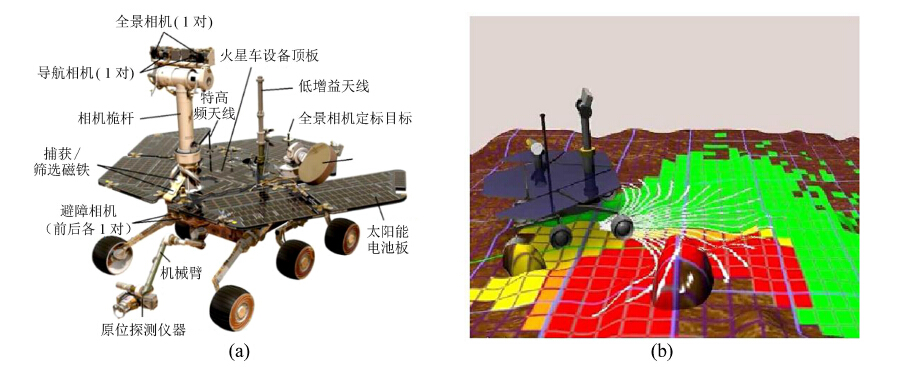

(2)勇气号与机遇号

美国航空航天局于2004年开展的火星漫游车计划包含两辆漫游车(勇气号和机遇号)。两辆火星车的结构与载荷完全相同,分别携带了3对立体相机,利用立体视觉绘制三维地形图,完成火星表面的三维地形重建(图 6)[6]。火星车体的前部和后部的底盘下安装了2对避障相机,车体前部桅杆上安装了1对导航摄像机和1对全景摄像机。避障相机主要用于近距离的障碍检测,并指导机械手的操作和科学仪器的布置;导航摄像机主要用于重建20 m范围内的三维地形,供障碍规避和路径规划使用;全景摄像机设计用途是进行科学观测,但也被用来重建20到100 m范围内的三维地形,供更远距离的任务和路径规划使用。

不同立体相机所获取的影像虽然数据内容与使用目的略有不同,但处理流程基本一致。美国喷气推进实验室的多任务图像处理实验室负责火星车影像的处理和地形重构。地形重构产品包含多种:视差图、数字高度图、距离图、三角网、表面法向量图、可通达图、地表粗糙度图、坡度图、太阳能量图、数字高程模型、数字正射影像、地形面片图、影像镶嵌图[7]等。

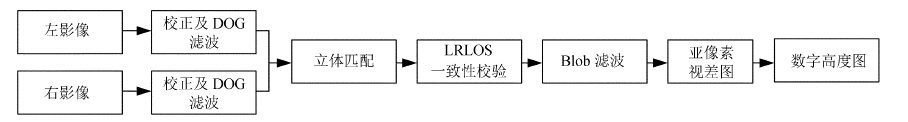

数字高度图记录对应核线影像每个像素位置的物方空间三维坐标,是后续一系列地形产品计算的基础,更是火星车路径规划的基础[9]。数字高度图的生产由火星车的立体视觉软件实现(图 7)。相机采集的图像对首先进行校正,消除光学系统带来的畸变,并进行核线校正及高斯差分(Difference-Of-Gaussian,DOG)滤波,高斯差分滤波是采用两个不同带宽的高斯核函数之差对图像进行卷积 ,用来消除两幅图像因光照条件或相机增益差异带来的灰度偏差。在匹配计算中用邻域像素的灰度值分布表征该像素,在一定的视差搜索范围内计算两幅图像中匹配像素邻域的平方和(Sum-of-Squared-Difference,SSD)值,找到使平方和值最小的整数视差。为了提高匹配的鲁棒性,软件还采用Blob滤波、左右一致性校验(Left-Right-Line-Of-Sight,LRLOS) 等方法消除错误匹配。通过对平方和值的插值将整数视差转变为亚像素视差,最后利用前方交会将每个视差值映射为一个三维坐标( X,Y,Z ),以高度图的形式输出[10]。

|

| 图 7 火星车的立体视觉软件功能框图 Figure 7 The flow chart of MER rovers’ stereo vision software |

(3)好奇者号

好奇者号火星探测器是第1辆采用核动力驱动的火星车,其体积与负荷远超勇气号与机遇号火星车。这辆火星车装备有1台远程微观成像仪和1对桅杆全景相机,工程相机包括2对导航相机和4对避障相机(一半为替补相机应对意外情况)。不同类型相机的任务分工与勇气号和机遇号火星车所携带的相机相似:避障相机与导航相机获得的立体影像共同用于计算距离火星车较近范围内的火星地貌三维信息,帮助科学家和工程师为好奇者号制定勘探路线和目标;远程微观成像仪和桅杆相机为火星车提供远处地形地貌与地质背景信息。在影像的处理与地形重构方法上,好奇者号的设计与火星车相似,核心都是基于区域的立体匹配算法。

2 行星无人探测车地形重构相关研究进展行星无人探测车地形重构的基本原理是运用行星无人探测车携带的立体相机对地面地物进行拍照获得立体图像对,通过立体匹配算法计算出相应像点,得到视差图,然后采用基于三角测量的方法恢复地形三维信息,为判断场景中障碍物、行星无人探测车导航提供有力支持。要恢复地面地形的三维信息,关键的步骤是立体匹配,即实现立体图像对之间同名像点的匹配。因此在移动机器人视觉导航研究领域,虽然有针对前期核线纠正和后期三维重建工作的研究,但目前相关研究以立体匹配算法的研究为主。

根据匹配基元的不同,立体匹配算法可大致分为基于区域的匹配和基于特征的匹配两类,两种匹配方法的特点比对如表 2。

| 基于区域的匹配方法 | 基于特征的匹配方法 | |

| 原理 | 以区域的相似性测度作为匹配基元,对图像对逐像素进行匹配 | 选取图像的过零点、边缘轮廓、线段等特征作为匹配基元,对图像对的特征区域进行匹配 |

| 适用图像类型 | 高纹理性图像 | 特征丰富的图像 |

| 实现难度 | 较易 | 较难 |

| 预处理 | 无需预处理 | 需要特征描述算子提取特征,并且设定特征的匹配记号 |

| 计算时间 | 相关性计算耗时较多 | 较少 |

| 噪声敏感度 | 对照明等因素造成的灰度变化敏感 | 对照明等因素鲁棒性较好 |

| 匹配结果 | 稠密视差图 | 特征的稀疏视差图 |

| 算法策略 | (1)在右图的搜索区域内,利用左图像元处的支持窗口计算相似性测度函数的值;(2)选取相似性测度函数最大时对应的支持窗口(3)该支持窗口对应的中心像素即为匹配点;(4)计算视差 | (1)提取左右两幅图像的特征描述算子 F和F′;(2)对左图特征描述算子F中每一个特征f,计算f与右图特征描述算子F′在搜索区域内所有特征之间的相似度;(3)选择相似度取最大值时对应的特征f为匹配结果;(4)计算f的视差 |

由表 2可看出,基于区域的匹配算法对于行星无人探测车地形重构的技术需求而言,具有明显优势:它可以直接获得稠密的视差图,有利于重建行星无人探测车安全行走所需要的密度较高的地形图。所以目前的行星无人探测车立体视觉匹配算法研究中一般采用基于区域的匹配方法。

基于区域的立体匹配算法中,最传统的方法莫过于归一相关算法,计算待匹配点为中心的滑动窗口内像素点的归一化相关指数 C(x,y,d ),取具有最大相关指数的点作为匹配点。1994年卡内基梅隆大学设计的行星探测车样车 “Ralter” 采用基于立体视觉的环境感知手段,以配置在一个桅杆上的两台CCD摄像机作为立体视觉传感器,用相关方法完成匹配,以出色的速度和精度为行星探测车低速连续行驶绘制所需的地形图。随后由于基于相关的方法对图像对的亮度差异性过于敏感,图像匹配绝对值(Sum of Absolute Difference,SAD)算法逐渐将其取代,在实时运动估计和实时立体视觉领域被广泛应用。美国航空航天局的火星漫游车勇气号、机遇号、好奇者号的立体视觉系统中都采用了以绝对值算法为匹配测度的立体匹配算法。勇气号与机遇号于2004年着陆火星,好奇者号是在此基础上继续研发改进的火星漫游车,于2012年着陆火星。三者在视觉导航的硬件装备、导航模式的设计、立体匹配的算法实现上都基本一致。

传统的区域匹配算法的缺点在于,通过比较图像间一个窗口之中相邻像素的灰度相似性确定窗口的中心点是否匹配这一核心思想带来两大不可避免的问题,即投影形变导致的窗口内的灰度值不能完全对应和影像间逐像素计算耗时较多的问题。许多研究即针对这两个问题展开[11-12]。

Zabih为了进一步解决绝对值算法对相机本身的增益或者是偏置不同导致的像素值差别敏感的缺陷,提出了两种非参数化的匹配开销计算方法:一种是Rank算法,一种是Census算法。这两种算法都是以像素信息为基础,但是以相对信息取代绝对信息,从而试图摆脱增益和偏置的影响,Census和Rank算法都在一定程度上解决了光照的问题,尤其是Census变换将数学运算转换为逻辑运算,非常有利于在现场可编程门阵列等硬件内进行处理,因此在一些硬件实时系统中被广泛采用。另外,由于图像增益和偏置的问题大多影响的是直流量,而对图像的交流量影响不大,因此有算法[13]提出采用拉普拉斯(Laplaeian)算子消除偏置,再使用绝对值算法进行处理,这种方法能够有效地提取图像中的变化量,大大提高双目匹配的成功概率。此外,文[14]提出的自适应窗匹配算法(Adaptive Support Weight,ASW)采用的窗口大小和形状根据灰度的局部变化和当前深度的估计值自适应地变化,一度被认为是匹配效果最佳的匹配算法,但是它的计算复杂度也很大,后有研究在其基础上提出一种HFASW(half ASW)立体匹配算法,并给出了其超大规模集成电路((Very Large Scale Integration,VLSI)架构和现场可编程门阵列实现,实验验证其匹配效果和处理速度均具有较高性能。

文[15]则从深空探测影像的特点出发,提出一种自适应马尔科夫匹配模型。马尔科夫随机场匹配是一种结合空间关系进行灰度匹配的方法,即在一定空间邻域范围内,根据马尔科夫场与吉布斯采样(Gibbs Sampling)具有的等价关系,确定互相作用像素标号的条件分布概率模型。该模型将图像匹配转化为像元视差的标号问题。将传统马尔科夫场直接应用到深空影像匹配时,存在如下问题:由于深空探测影像的纹理十分缺乏,绝对值算法作为数据项会造成误匹配,使该模型匹配精度较低;其次,计算能量函数时,每个像元使用同一视差范围,自适应度较低,从而产生大量计算冗余;并且,迭代计算权重系数为固定值时,对视差连续区域和不连续区域没有进行区分,容易造成图像视差的过平滑和视差突变区域(如石块边界)的误匹配。文[15]的自适应马尔科夫匹配模型首先通过特征匹配自适应确定视差搜索范围,然后利用自适应相关系数进行匹配,为自适应马尔科夫匹配模型提供初始匹配参数,构建边缘函数获得自适应的权重系数,最后使用置信度传播算法迭代求解自适应马尔科夫匹配模型的能量函数,获取密集的匹配结果。

2.2 基于特征的立体匹配基于特征的匹配通常选取图像的角点、边缘轮廓、线段等特征作为匹配基元,对图像对的特征区域进行匹配。这种方法优点在于不会损失图像的重要灰度信息,却能大大减少参与计算的数据量,极大地提高了计算速度,具有很好的实时性,同时所提取的特征还具有旋转不变性和不随光照条件改变而改变的优点,这些对于时刻处于不断变换环境中的行星无人探测车的稳定性来说十分重要,因此基于特征的匹配算法在行星无人探测车地形重构的研究中也常被用到。许多研究考虑了月球车立体视觉匹配结果的用途和月表地形的特点,提出基于点和边缘等特征提取的月球车视觉系统立体匹配方法。文[16]为改善月面地形重建精度,提出了一种基于SIFT特征和边缘特征提取的立体匹配算法,提高了图像间的匹配精度,重构出了包含月面巡视器周围环境概貌和障碍物信息的高精度月面环境地形。文[17]利用forstner角点检测算子提取特征点,通过匹配的特征点构建不规则三角网并进行内插获得视差初始值。

基于特征的匹配算法缺点在于,由于行星表面环境景物特征一般比较稀疏,仅由这些稀疏的特征进行月表三维场景恢复比较困难,容易产生障碍物漏检的现象。因此出现了两种弥补这一缺陷的解决办法。其一是基于区域增长的稠密匹配算法,已表现出良好的性能,将基于区域增长的匹配算法应用于月球车环境重建,并简化能量函数来减小计算量;另一种方法是将基于特征和基于区域的匹配方法相结合,将边缘匹配结果经滤波后用于辅助区域匹配,有效地减少了无特征辅助的区域匹配在无纹理和少纹理区域容易产生的误匹配,能以较高的可靠性得到密集的视差图。嫦娥三号月球车玉兔号在利用导航相机影像生产数字高程模型和数字正射影像过程中,正是采用了这种结合二者优势的匹配算法,首先用SIFT算子提取核线影像同名点,并用RANSAC方法剔除粗差点,然后进行密集匹配并完成三维坐标计算;文[18]在对全景相机环拍图像进行视差纠正的基础上,利用Forstner特征点提取和相关系数匹配方法实现图像匹配,克服了低图像重叠率给图像匹配带来的困难。

3 总 结综合上文所述,可以发现基于立体视觉的三维地形重构技术在行星无人探测车视觉导航领域显示了良好的优越性以及适用性,但由于月球和火星表面都是典型非结构化环境,其环境场景特征复杂,纹理匮乏,且左右立体图像的成像视角、光照条件、噪声干扰等成像条件差别较大,这些因素对地形重构工作中的立体匹配算法提出了更具体的技术要求。可以总结为以下3方面:

(1) 在实时性方面,行星无人探测车进行地形重构的计算能力仍远远低于地球上移动机器人的视觉导航系统。即使是代表最先进水平的火星漫游车好奇者号,大部分行驶路径都需采取间歇停止的方式,行驶速度大大受限。因此行星无人探测车要实现实时导航及行走,还有大量的工作需要进一步深入展开。

(2) 在鲁棒性方面,目前行星探测领域采用的立体匹配算法普遍存在鲁棒性不高的问题,对于质量较差的影像数据,例如纹理较少或稀疏的地表影像,难以实现理想效果的匹配和三维重建。

(3) 在精确性方面,应从需求出发,适当降低匹配精度。现有的匹配算法已达到像素甚至亚像素级别的效果,这种精度对于地形重构在导航系统中的应用需求来说并不是必要的,且过高的数据精度可能影响数据的处理速度及表达效果。因此,如果能够找到更加适合行星表面地形数据的处理方式,地形重构系统的工作效果和效率都有望进一步提高。

随着各国深空探测的不断深入和技术要求的不断提高,基于立体视觉的行星无人探测车地形重构技术还需在以上几方面进一步深入研究,为后续深空探测任务提供有力的支持。

| [1] | 邢丽平, 左维, 李春来. 建立WebGIS的月球三维可视化关键技术[J]. 天文研究与技术,国家天文台台刊 , 2014 , 11 (3) : 299 –304 Xing Liping, Zuo Wei, Li Chunlai. Key technology of a WebGIS-based 3D visualization system for the Moon[J]. Astronomical Research&Technology,Publications of National Astronomical Observatories of China , 2014 , 11 (3) : 299 –304. |

| [2] | 肖媛, 张志强, 吕昌, 等. 嫦娥二号任务地面应用系统实时业务仿真关键技术研究[J]. 天文研究与技术,国家天文台台刊 , 2011 , 8 (1) : 8 –14 Xiao Yuan, Zhang Zhiqiang, Lv Chang, et al. Research on key technologies in simulating real-time operation of the ground segment of the Chang'E-2 mission[J]. Astronomical Research&Technology,Publications of National Astronomical Observatories of China , 2011 , 8 (1) : 8 –14. |

| [3] | Harvey B. Samplers, rovers and orbiters[M]//Soviet and Russian Lunar Exploration. Chichester:Parxis Publishing Ltd, 2007:239-286. |

| [4] | Wang Wenrui, Ren Xin, Wang Fenfei, et al. Terrain reconstruction from Chang'e-3 PCAM images[J]. Research in Astronomy and Astrophysics , 2015 , 15 (7) : 1057 –1067. DOI: 10.1088/1674-4527/15/7/013 |

| [5] | Matthies L, Maimone M, Johnson A, et al. Computer vision on Mars[J]. International Journal of Computer Vision , 2007 , 75 (1) : 67 –92. DOI: 10.1007/s11263-007-0046-z |

| [6] | Matthies L, Balch T, Wilcox B. Fast optical hazard detection for planetary rovers using multiple spot laser triangulation[C]//IEEE International Conference on Robotics and Automation. 1997:859-66. |

| [7] | Matthies L, Shafer S A. Error modeling in stereo navigation[M]//Autonomous Robot Vehicles. New York:Springer New York Incorporated, 1990:135-144. http://cn.bing.com/academic/profile?id=2113560487&encoded=0&v=paper_preview&mkt=zh-cn |

| [8] | Goldberg S B, Maimone M W, Matthies L. Stereo vision and rover navigation software for planetary exploration[C]//IEEE Aerospace Conference Proceedings. 2002. http://citeseerx.ist.psu.edu/showciting?cid=255898 |

| [9] | Maki J N, Litwin T, Schwochert M, et al. Operation and performance of the Mars Exploration Rover imaging system on the Martian surface[C]//IEEE International Conference on Systems, Man and Cybernetics. 2005. |

| [10] | Maki J N, Bell J F, Herkenhoff K E, et al. Mars Exploration Rover engineering cameras[C]//Proceedings of SPIE. 2001. |

| [11] | Vergauwen M, Pollefeys M, Van Gool L. A stereo vision system for support of planetary surface exploration[C]//Computer Vision Systems. Berlin:Springer Berlin Heidelberg, 2001:298-312. http://cn.bing.com/academic/profile?id=1539117105&encoded=0&v=paper_preview&mkt=zh-cn |

| [12] | Zhang Zhengyou. A stereovision system for a planetary rover:calibration, correlation, registration, and fusion[J]. Machine Vision and Applications , 1997 , 10 (1) : 27 –34. DOI: 10.1007/s001380050056 |

| [13] | Perri S, Colonna D, Zicari P, et al. SAD-based stereo matching circuit for FPGAs[C]//13th IEEE International Conference on Electronics, Circuits and Systems. 2006. |

| [14] | Yoon K J, Kweon I S. Adaptive support-weight approach for correspondence search[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence , 2006 , 28 (4) : 650 –656. DOI: 10.1109/TPAMI.2006.70 |

| [15] | Peng M, Kaichang D I, Liu Z Q. Adaptive Markov random field model for dense matching of deep space stereo images[J]. Journal of Remote Sensing , 2014 , 18 (1) : 77 –89. |

| [16] | 曹凤萍, 王荣本. 月球车视觉系统立体匹配算法[J]. 吉林大学学报:工学版 , 2011 , 41 (1) : 24 –28 Cao Fengping, Wang Rongben. Stereo matching algorithm for lunar rover vision system[J]. Journal of Jilin University:Engineering and Technology Edition , 2011 , 41 (1) : 24 –28. |

| [17] | Geiger D, Yuille A. A common framework for image segmentation[J]. International Journal of Computer Vision , 1990 , 6 (3) : 227 –243. |

| [18] | Kaichang D A, Fengliang X A, Jue W A, et al. Mars Exploration Rover mission[J]. Journal of Geophysical Research , 2014 , 108 (E12) : 429 –432. |