2. 中国科学院大学, 北京 100049

2. University of Chinese Academy of Sciences, Beijing 100049, China

在心脏病常规临床检查中,二维实时超声心动图常用于评测心脏的结构和功能。临床超声检查通常主要包括三个步骤:探头扫描不同位置、选取标准切面和对标准切面的测量与诊断[1]。其中,医师总结出来能更好辅助分析心脏功能结构的特定位置和角度的超声心动图称为标准切面,其正确快速选取不仅对临床诊断具有至关重要的意义,也为病例研究提供比较依据。标准切面的自动识别是超声心动图智能分析和测量的基础。与自然图像相比,医学超声成像质量差,存在斑点噪声和伪影;并且各标准切面类内、类间差异大,使得标准切面的识别成为一个非常具有挑战性的问题。

目前的研究主要集中在利用机器学习和图像处理等方法,进行超声心动图的自动识别、检索及切面内组织结构的定位和分割等。针对超声心动图的自动识别,2004年Ebadollahi等[2]首次提出采用马尔可夫随机场设计通用腔室模板检测心脏腔室来辅助三类标准切面识别,但需额外信号来指定处于舒张末期 (End-Diastolic,ED) 的切面。同样利用处于ED的标准切面,Zhou等[3]基于多类别提升算法框架,提取哈尔矩形特征训练弱分类器,同样需要检测心脏腔室的空间位置,辅助四类标准切面识别。基于降低特征维度的两层级联方法,把标准切面分类成心尖和胸骨旁两大类,然后进一步区分四类标准切面[4-5]。在文献[2]工作基础上整合局部和全局模板特征,利用多类逻辑提升分类算法,并指出能扩展到任意标准切面[6]。在对心脏的循环跳动的时空信息进行统计分析的基础上,利用主动外观模型对形状和纹理进行建模,统计追踪一个心动周期并投影到运动空间进行分类[7],该方法处理对象是视频序列, 还可以把不同标准切面视为不同的场景图像,提取低层全局特征来表征不同切面,利用改进核支持向量机进行分类[8]。这些方法可以归纳为两个阶段:首先根据先验人为设计特征来表征图像;然后利用机器学习中不同分类方法对特征向量进行建模分析得到分类器。然而受限于“语义鸿沟”问题,根据特定先验人为设计特征,如大多数方法都针对心动周期的某个特定时刻的切面 (如ED),导致模型性能较差。

近来,深度卷积神经网络 (Convolutional Neural Network, CNN) 在大规模自然图像数据集 (如ImageNet[9]) 上,识别性能远超传统方法[10],主要得益于深度学习利用大量标注数据, 从图像原始像素出发,逐层分级学习中高层的抽象语义特征[11]。

当前实践中由于深度学习需要大量的标注数据,所以仅在少数医学任务中取得有限的成功应用,且对深度模型的鲁棒性和有效性也缺乏详尽分析。文献[1]利用CNN结合领域知识,在胎儿超声心动图标准切面的自动识别问题中取得良好的识别效果[1],但胎儿跟成人超声心动图差异大,具有很大特殊性。文献[13]利用自然图像训练的模型对胸腔X-射线图像进行特征提取并结合全局特征[12]得到最优检测结果,并没有对特定医学数据进行迁移训练,仅是作为特征提取器[13]。文献[14]针对心脏核磁共振图像利用微调技术,迁移从自然图像学习的模型,但没对模型有效性进行分析。

目前深度CNN模型的理论分析工作还不是很完善,能自动学习语义特征的工作机理还是个“黑箱”。对于不同的模型的比较除了准确率之外并没有很好的评价方法,优异的泛化能力从何而来仍是个开放问题。一些工作[15-18]通过可视化各层激活值和卷积核来更好理解深度CNN。对在给定数据集上训练得到的深度CNN模型,文献[17]用反卷积来可视化每个神经元的最大激活值。文献[15]通过对学习到的每层的特征进行反编码,建立每层特征和原图像的映射关系。文献[16]试图通过梯度上升方法迭代寻找使得最大化激活某个或某些特定的神经元。神经元对图像像素的梯度描述了当前像素的怎样改变会影响分类结果的大小。文献的方法均是对已训练的模型进行分析,而类激活映射图 (Class Activation Map, CAM) 方法[18]用全局均值池化层代替全连接层改进训练过程,分类性能虽略有降低,但能指示出特定类别的显著性判别区域,能很好地解释模型的有效性。

本文提出一种基于深度CNN识别超声心动图的方法 (Deep Echocardiogram, Deep-Echo):1) 引入空间金字塔均值池化层代替全连接层,一方面大幅减少模型参数,降低过拟合风险;另一方面网络结构变为全卷积网络,使得不用限制输入图像尺寸大小,这对医学超声图像更为重要。2) 为验证该算法的鲁棒性和有效性,针对数据集进行详尽实验,研究分析了深度学习方法的高识别率和优异泛化能力的原因。

1 卷积神经网络深度CNN是多层前馈神经网络的一种特例。隐藏层的神经元设计成与上一层神经元局部连接,并利用参数共享来减少模型复杂度。针对图像这种结构化数据,由不同卷积核来探测不同空间位置上的局部统计特征。通过堆叠多层的卷积结构,实现从低层到高层语义空间的抽象映射。

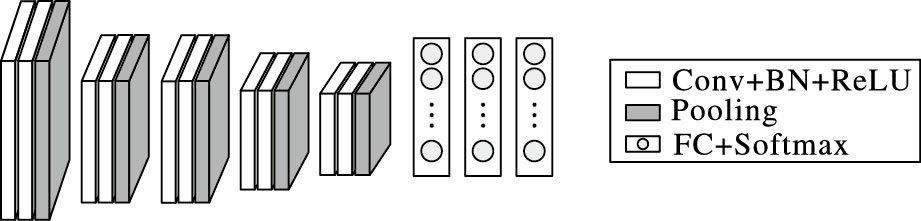

深度CNN的典型结构是在LeNet模型[19]的基础上引入修正线性单元 (Rectified Linear Unit,ReLU) 的激活函数和Dropout等技术[10]进行了改进。图 1为CNN模型的网络结构示意图。定义图像数据为{xi}i=1N,且其类别标签{yi}i=1N,其中i∈{1, 2, …, k},k为类别数,xi作为网络输入,输入层的l=1,即原始图像作为输入,第l层输出cl个大小为hl×wl的特征图。第一层为由cl-1个特征图作为输入的卷积层 (Convolution, Conv),特征图大小为hl-1×wl-1,第l层第i特征图定义为Zil。计算公式为:

| $Z_i^l = \mathit{\boldsymbol{B}}_i^l + \sum\limits_{j = 1}^{{c^{l - 1}}} {K_{i,j}^l*Z_i^{l - 1}} $ | (1) |

其中:Bil为偏置矩阵,Ki, jl为连接第l-1层第j个特征图和第l层第i个特征的卷积核。

模型的激活函数没有采用Sigmoid函数或双曲正切函数,而是选择ReLU函数,目的是引入更多非线性来提高训练收敛速度,解决多层网络反向传播中梯度弥散的问题。其函数表达式为:

| $Z_i^l = \sigma (Z_i^{l - 1})$ | (2) |

| $\sigma (x) = \max \{ 0,x\} $ | (3) |

其中:σ(·) 表示对第l层的激活函数,该层一般嵌入在卷积层后。为了使得每层输入的分布更平稳,一般引入批量归一化层 (Batch Normalization, BN),如图 1中所示。最大池化层进行下采样,有时把“卷积-激活-归一化-池化”统称为卷积层。最后需连接全连接层 (Fully Connected layers, FC),全连接层就不再保存空间信息,是对低层特征的高层抽象,最终输出K维的向量,作为该图像的特征向量送入最终的分类器进行分类评估。

深度CNN模型的分类器与传统方法不同的是:把特征提取过程中的卷积核参数和分类器的参数整合到端到端的模型中。对一个有监督的多分类问题,特征提取过程可表示为得分函数S(xi, W, b)、W、b是各层可学习的参数包括卷积核K、偏置B和全连接层的权值参数。对第i个样本的得分函数分类误差的交叉熵损失函数可定义为:

| ${L_i} = - \log {{\rm{e}}^{{{\rm{S}}_{{y_i}}}}} + \log \sum\nolimits_i {{{\rm{e}}^{{{\rm{S}}_i}}}} $ | (4) |

| $L = \frac{1}{N}\sum\limits_i {{L_i}} + \lambda \sum\limits_k {\sum\limits_l {W_{k,l}^2} } $ | (5) |

通过最小化Softmax函数的非负对数似然 (式 (5)),能带来归一化的概率解释。一般采用L2损失正则化技术提升分类泛化性能。全部N个样本的损失函数L为式 (6) 所示,其中λ表示正则化参数。损失函数最小化方法采用反向传播算法,通过带动量的批随机梯度下降算法不断调整参数使得模型整体误差函数不断降低, 并通过使用权重衰减项和Dropout技术控制过拟合。具体实现详情请参考文献[10]。

|

图 1 卷积网络模型结构示意图 Figure 1 Structure of CNN model |

本章分别从如何构建全卷积网络、全局空间金字塔均值池化层,将类别显著性图纳入可视化过程,如何扩增数据等方面介绍提出的Deep-Echo模型。

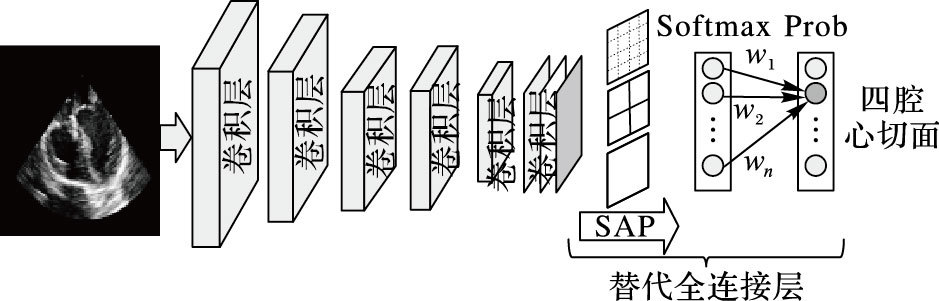

2.1 全卷积的网络与GoogleNet模型[20]、ResNet模型[21]类似,使用多层卷积层 (每层包括ReLU层、BN层和Pooling层),用全局均值池化操作替代全连接层。Deep-Echo模型结构中对最后卷积层输出的特征图,如图 2中所示的金字塔均值池化层 (Spatial Average Pooling, SAP)[22]代替最大化池化层和全连接层。最后一层输出单元数目为类别的数目,由于实验采用的标准切面有7个类别,因此最后一层输出7类相应概率 (图 2中Prob层),依次对应相应的类别,采用交叉熵损失函数加L2正则化。卷积核数目从64开始,每经过一次最大池化层,卷积核数目翻倍,直到512为止。学习率初始化为0. 01。具体实验步骤和参数设置见后文实验部分。整个网络结构如图 2所示。

|

图 2 Deep-Echo模型结构示意图 Figure 2 Structure of Deep-Echo model |

针对深度CNN模型中全连接层的两个缺点:全连接层失去了空间信息,限制了CNN只能接受固定尺度的输入,一般只能通过图像尺度归一化的方法来处理不同尺寸的输入图像,且使得模型可视化变得不可解释;全连接层参数拥有大约90%的模型参数,如AlexNet模型[10]和VGG16模型[23]中全连接层参数占全部参数分别为38 MB/61 MB和103 MB/138 MB,从而导致模型更容易过拟合[20]。

为解决这两个问题,He等[22]提出空间金字塔池化 (Spatial Pyramid Pooling,SPP) 方法。SPP通过使用多个不同大小的池化操作保证固定的特征向量输出,从而允许CNN接受任何尺度的输入,增加了模型的尺度不变性,抑制过拟合。与传统的全连接层不同,对每个特征图一整张图片进行多尺度的空间金字塔均值池化,这样每张特征图都可以得到多个尺度的输出。本文方法跟空间金字塔池化网络类似都是3个尺度的空间金字塔池化 (1×1、2×2和4×4),其差异在于不再接多个全连接层,同时用均值池化代替最大化池化,目的在于方便可视化模型的空间位置信息。

2.3 微调迁移学习利用深度学习进行超声心动图的标准切面识别,仍存在针对小数据量直接训练是否会出现过拟合;能否跨领域进行迁移学习,即在自然图像数据集上训练得到的模型能否微调应用到跨领域的超声心动图上的问题。文献[18]中指出,用全局均值池化代替全连接层直接随机初始化,从头开始训练, 模型收敛困难且分类性能下降,故对现有模型进行改造,即针对在自然图像集上预先训练得到的模型, 如Alexnet模型等,变换最后的输出层为所述金字塔均值池化层,调小学习率后在超声心动图标准切面数据上进行微调迁移学习。

训练时,由于超声心动图的特殊性,人工标注费时费力,对数据集进行扩增能降低人工标注的需求, 但扩增数据需注意不能打乱标准切面图像内在的局部结构,因此对切面数据只进行水平镜像翻转和旋转。通过引入BN归一化层能减轻对Dropout的依赖,提高泛化能力,并且本文直接去掉全连接层,故并未采用Dropout技术。

迁移学习时,由于深度模型中低层的卷积核是跟人类视觉的初级细胞很类似,因此是可以直接迁移复用,高层要针对目标学习判别性信息需进行重新学习[18]。针对超声心动图的实验支持这样的结论,不同模型的分类准确率都很高,具体实验见后文实验部分, 但对于计算机医学辅助诊断而言,模型怎样决策判断比分类准确率更重要, 即需解释模型为什么有效和优异的泛化能力从何而来。

2.4 类别显著激活映射图前文所提模型能高效提取超声心动图标准切面的特征,对超声心动图的单扇形和双扇形标准切面都能很好地识别,甚至对互联网上随意选取的标准切面也能识别。但对模型的有效性和解释性缺乏有力分析,使得对模型决策判断的可信性产生怀疑。

针对超声心动图,采用文献[18]提出可视化分析的方法,将其和空间金字塔均值池化结合。对给定图像,fj(x, y) 表示卷积层 (x,y) 位置上第j个神经元的激活值,对j神经元的均值池化操作结果对给定类别k的得分函数S:

| ${S_k} = \sum\limits_j {w_j^k\sum\nolimits_{x,y} {{f_j}\left( {x,y} \right)} } $ | (6) |

其中wjk是第j个神经元和第k类的连接权重,后接多类多元逻辑损失层,然后由式 (7) 可得定义类别激活映射图[18]Mk:

| ${M_k} = \sum\limits_j {w_j^k{f_j}\left( {x,y} \right)} $ | (7) |

其中Mk表明在空间 (x,y) 的激活值对该类别分类结果影响的重要性。对类别激活映射图直接双线性插值得到与原图大小相等的显著性图, 该图是对图像空间显著性区域的置信度判别,能辅助可视化分析深度模型的决策过程,在一定程度上解释模型可效性。本文将其和多尺度空间金字塔均值池化结合,得到对多个空间尺度的类别显著激活映射图。值得注意的是,对不同的尺度可设置不同的权重,本文采用同等权重进行融合。

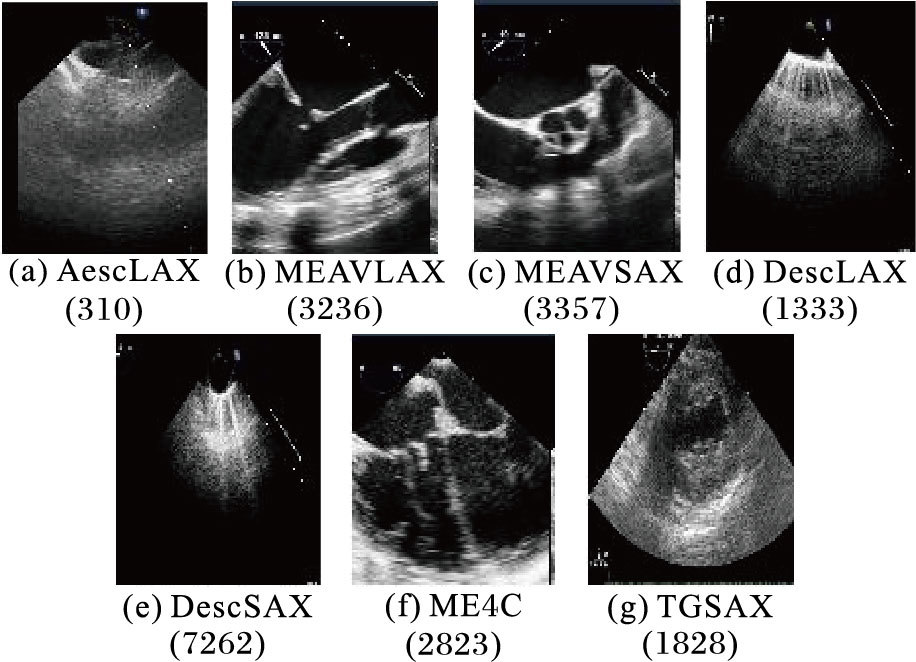

3 实验结果和分析 3.1 实验数据选取和实验方法本文实验数据来自四川大学华西医院,为临床检查中的经食道超声心动图。所选切面视频包含单扇形和多普勒成像的双扇形两种,其中对双扇形的切面视频,仅取不包含彩色多普勒成像的切面 (如图 3所示)。经专业医师标注的标准切面视频中,至少包含2~3个心动周期,并依据医师建议从视频中截取包含一个心动周期的10帧图像,并经医师检验筛选后得到最终数据集。

|

图 3 七类标准切面超声心动图及数量分布 Figure 3 Echocardiography and quantitative distribution of seven classes of standard views |

实验中所用标准切面类别和数量分布如图 3所示。依据探头在食管中段 (ME) 和经胃底 (TG) 的位置和角度不同,在图 3中7类标准切面分别为:(a) 为升主动脉长轴 (AescLAX),(b) 为主动脉瓣长轴 (MEAVLAX),(c) 为主动脉瓣短轴 (MEAVSAX),(d) 为降主动脉长轴 (DescLAX),(e) 为降主动脉短轴 (DescSAX),(f) 为食管中段四腔心 (ME4C),(g) 为经胃底心室短轴 (TGLAX)。其中,(d)、(e)、(g) 为单扇形切面,其余为双扇形中截取的切面。训练集 (17932张) 和测试集 (2217张) 由不同时期采集不同病人对象数据的随机划分。值得注意的是,所有数据都经过裁剪操作以隐去患者信息。

3.2 识别实验结果和分析本文在构建的超声心动图的数据集上测试分类性能。采用Caffe框架[24]实现深度卷积网络结构,预训练模型来自Caffe model zoo。使用具有Intel Core i5 3.2 GHz处理器和12 GB内存的Tian X GPU测量所需的时间,单个切面所需的分类识别时间平均需要10 ms,基本可满足实时识别。

为验证从自然图像训练的模型能迁移到经食道超声心动图上,输入图像归一化为256×256,网络初始学习率设为0.001,迭代一定轮数动态调整学习率大小,其他参数的设置跟原文献中训练网络结构时一致。不同网络结构的深度模型微调前后在同一测试集上的准确率随着迭代次数的增加最后趋于一致,如表 1所示,Scratch表示不经过微调,Finetune表示经过微调。Deep-Echo模型结构跟AlexNet模型类似,是在其结构基础上去掉全连接层,用空间金字塔池化层代替,比VGG16和GoogleNet模型的层数更少,模型结构更简单,而分类准确率却接近,表明所提方法的有效性。针对VGG16模型和GoogleNet模型也可同样设置,本文主要关注点不是得到分类精度最优的分类模型,故并未全部加以实验验证。

| 表 1 不同模型分类精度比较 % Table 1 Camparison of classification accuracy by different models % |

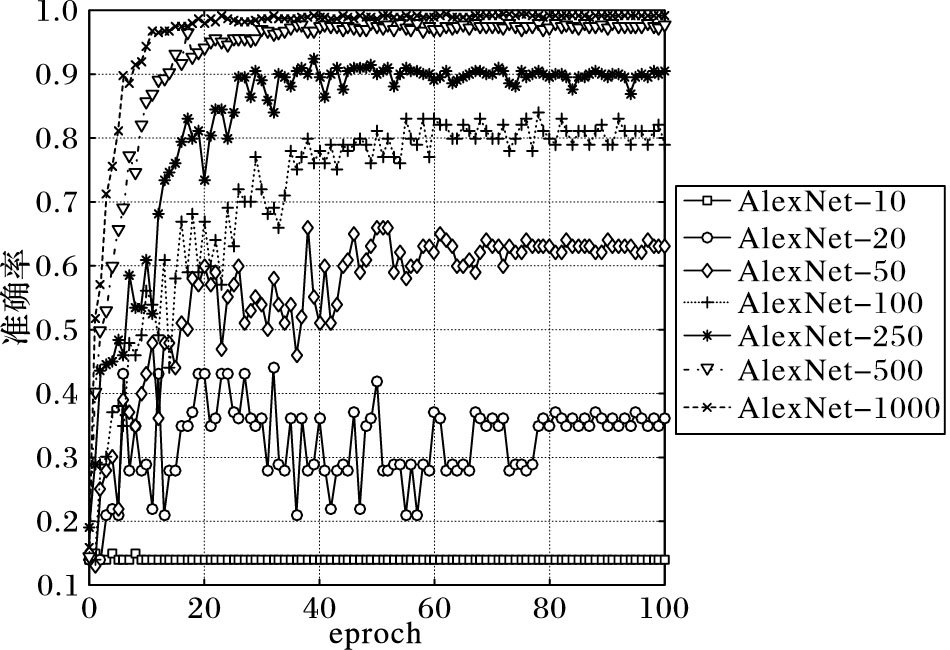

为验证训练集数据量对深度卷积网络的影响。网络结构采用AlexNet模型结合空间金字塔池化层,在不同数据量上微调,平均分类精度 (Mean Average Precision, MAP) 实验结果如图 4所示,数字代表每类至多的数目,随着数据量的增加,模型准确率随之提升,可知针对超声心动图标准切面识别问题,并不用构建很大的数据集进行识别,如图 5中每类至多500达到的平均准确率接近使用全部训练集的结果。可推断采用微调技术,能显著减少深度模型对大数据量的依赖。

|

图 4 AlexNet模型不同数据量的平均分类精度 Figure 4 MAP of different numbers for AlexNet model |

|

图 5 Deep-Echo模型分类的混淆矩阵 Figure 5 Confusion matrix of classification by Deep-Echo model |

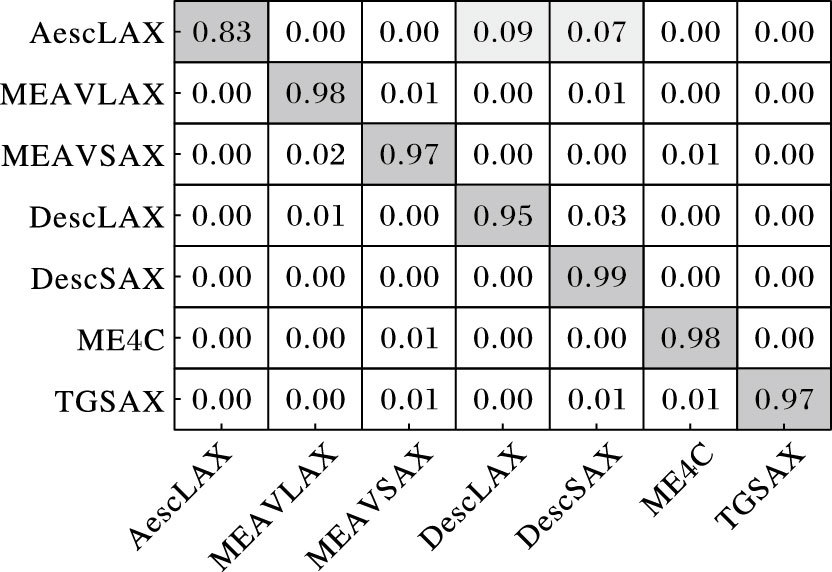

为了验证最优模型在不同类别的分类性能,7分类的混淆矩阵如图 5所示,每行代表实际的类别标签,每列代表预测的标签。最终的平均分类精度为97.49%。分类置信度较低的是升主动脉长轴 (AescLAX),其他各类的准确率都较高。

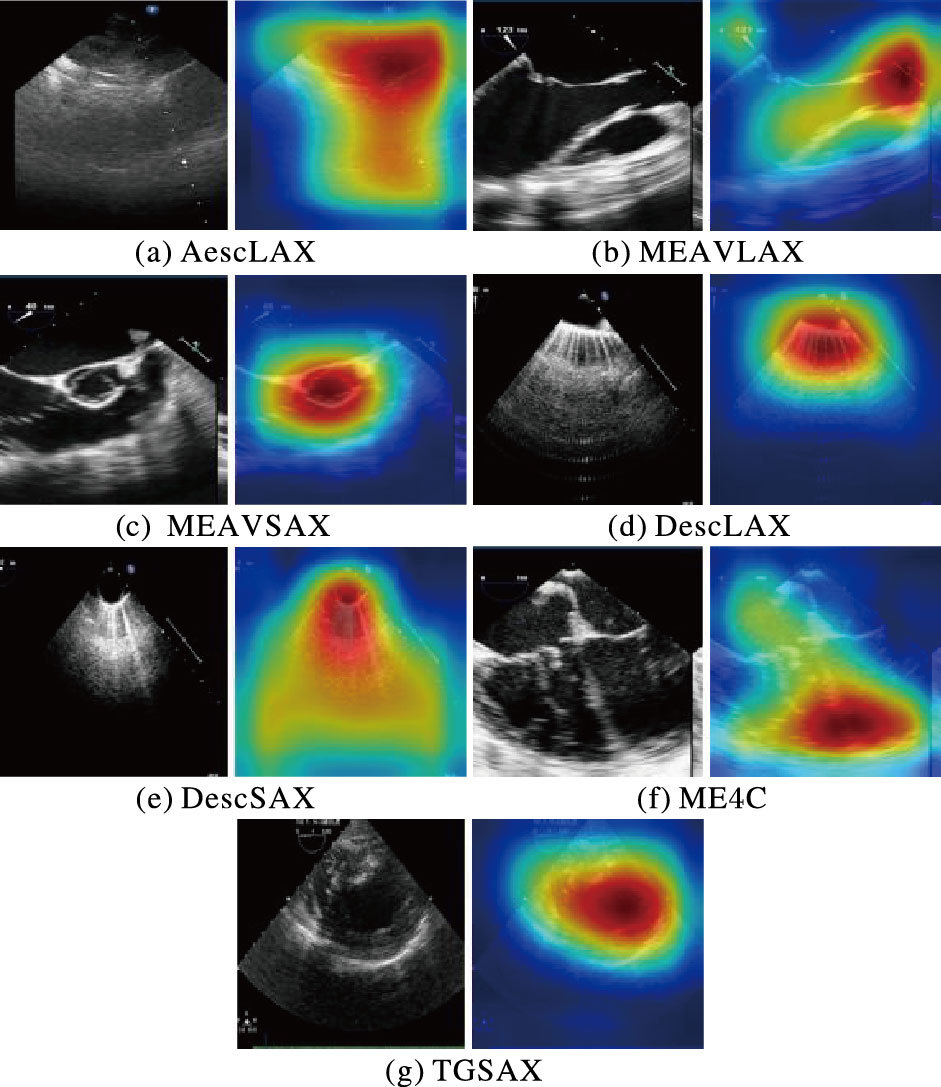

3.3 模型可解释性实验结果分析深度卷积网络能在标准切面识别问题上得到较高的分类精度,但仅从分类准确率上评价模型存在局限性。为分析模型的有效性,采用文中所述可视化方法,对迁移后的Deep-Echo模型进行实验。实验结果如图 6所示,图中为各类切面和对应的类别显著性热力图。

|

图 6 各类切面的原图和显著性热力图 Figure 6 Original maps and class activaion maps for seven classes of views |

图 6类别显著性图中的颜色从蓝到红,表示原图像素中对分类结果影响的重要性是从轻到重。图中结果能很好地解释模型的有效性,并且跟专业医师的判断一致,如图 6(c)中显著性热力图红色区域图定位到图中的圆圈;图 6(d)中定位到的干涉条纹;图 6(f)定位到左心室和右心室的边界等;都跟医师的决策判断依据是一致的。

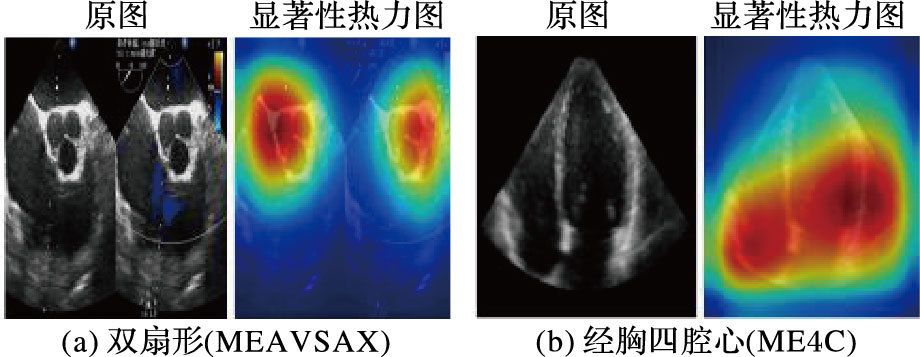

深度模型泛化性能可视化结果如图 7所示,原图像分别是带彩色多普勒的双扇形切面 (图 7(a)) 和经胸的四腔心切面 (图 7(b)),这两个图与数据集中的经食道超声心动图差异较大,说明深度卷积网络模型确实能对标准切面进行语义分类,表明模型确实能提取到高层语义的特征,深度卷积网络泛化能力优异。图 7中可视化结果也能很好地解释模型的有效性,如图 7中显著性热力图红色区域图定位到图中的圆圈,也是医师认定该切面的关键性结构,图 7(b)定位到左心室和右心室的边界等,都跟医师的决策判断依据是一致的。并且该方法也能作为判断学习模型是否有效的根据,不经过微调的模型虽然能得到较高的分类准确度,并不能得到类似的显著性热力图。

|

图 7 深度模型泛化性能可视化分析 Figure 7 Visualization analysis of generalization performance of deep model |

本文提出了一种基于深度卷积神经网络的超声心动图标准切面自动识别方法,利用所述全局空间金字塔均值池化方法进行微调迁移学习,实验结果表明该方法识别准确率高,并实验分析了数据规模对模型分类精度的影响,结果表明基于深度卷积网络的识别方法应成为超声心动图自动识别的基准方法,接下来会探索更精细类别分类问题,如舒张末期和收缩末期标准切面的识别等。通过可视化深度模型的实验,对模型的可解释性和有效性进行了分析,推断深度模型的优异的分类性能和泛化能力的原因以对类别显著性区域进行判别,采用可视化方法增强了对网络模型整体的理解,具体各层特征怎么耦合成语义信息仍需进一步探索。

| [1] | 曹期龄, 姜楞. 经食道超声心动图的标准切面及其临床应用[J]. 中国医学影像技术, 1989, 5(2): 8-11. ( CAO Q L, JIANG L. Standard cross-section of transesophageal echocardiography and its clinical application[J]. Chinese Medical Imaging Technology, 1989, 5(2): 8-11. ) |

| [2] | EBADOLLAHI S, CHANG S F, WU H. Automatic view recognition in echocardiogram videos using parts-based representation[C]//Proceedings of the 2004 IEEE Computer Society Conference on Computer Vision and Pattern Recognition. Washington, DC:IEEE Computer Society, 2004:2-9. |

| [3] | ZHOU K S, PARK J H, GEORGESCU B, et al. Image-based multiclass boosting and echocardiographic view classification[C]//Proceedings of the 2006 IEEE Computer Society Conference on Computer Vision and Pattern Recognition. Washington, DC:IEEE Computer Society, 2006:1559-1565. |

| [4] | OTEY M, BI J, KRISHNA S, et al. Automatic view recognition for cardiac ultrasound images[C]//Proceedings of the 2006 International Workshop on Computer Vision for Intravascular and Intracardiac Imaging. Copenhagen:[s.n.], 2006:187-194. |

| [5] | ROY A, SURAL S, MUKHERJEE J, et al. Modeling of echocardiogram video based on views and states[C]//Proceedings of the 5th Indian Conference on Computer Vision, Graphics and Image Processing. Berlin:Springer, 2006:397-408. |

| [6] | PARK J H, ZHOU S K, SIMOPOULOS C, et al. Automatic cardiac view classification of echocardiogram[C]//Proceedings of the 2007 IEEE 11th International Conference on Computer Vision. Piscataway, NJ:IEEE, 2007:1-8. |

| [7] | BEYMER D, SYEDA-MAHMOOD T, WANG F. Exploiting spatio-temporal information for view recognition in cardiac eCho videos[C]//Proceedings of the 2008 IEEE Conference on Computer Vision and Pattern Recognition Workshops. Washington, DC:IEEE Computer Society, 2008:1-8. |

| [8] | WU H, BOWERS D, HUYNH T, et al. Echocardiogram view classification using low-level features[C]//Proceedings of the 2013 IEEE 10th International Symposium on Biomedical Imaging. Piscataway, NJ:IEEE, 2013:445-448. |

| [9] | RUSSAKOVSKY O, DENG J, SU H, et al. ImageNet large scale visual recognition challenge[J]. International Journal of Computer Vision, 2015, 115(3): 211-252. doi: 10.1007/s11263-015-0816-y |

| [10] | KRIZHEVSKY A, SUTSKEVER I, HINTON G E. ImageNet classification with deep convolutional neural networks[C]//Proceedings of the 25th International Conference on Neural Information Processing Systems. Redhool, NY:Curran Associates Inc., 2012:1097-1105. |

| [11] | RAZAVIAN A S, AZIZPOUR H, SULLIVAN J, et al. CNN features off-the-shelf:an astounding baseline for recognition[C]//Proceedings of the 2014 IEEE Computer Society Conference on Computer Vision and Pattern Recognition Workshops. Piscataway, NJ:IEEE, 2014:512-519. |

| [12] | OLIVA A, TORRALBA A. Modeling the shape of the scene:a holistic representation of the spatial envelope[J]. International Journal of Computer Vision, 2001, 42(3): 145-175. doi: 10.1023/A:1011139631724 |

| [13] | BAR Y, DIAMANT I, WOLF L, et al. Chest pathology detection using deep learning with non-medical training[C]//Proceedings of the 2015 IEEE International Symposium on Biomedical Imaging. Piscataway, NJ:IEEE, 2015:294-297. |

| [14] | MARGETA J, CRIMINISI A, LOZOYA R C, et al. Fine-tuned convolutional neural nets for cardiac MRI acquisition plane recognition[EB/OL].[2016-10-20].https://www.mendeley.com/research-papers/finetuned-convolutional-neural-nets-cardiac-mri-acquisition-plane-recognition/. |

| [15] | MAHENDRAN A, VEDALDI A. Understanding deep image representations by inverting them[C]//Proceedings of the 2015 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, NJ:IEEE, 2015:5188-5196. |

| [16] | SIMONYAN K, VEDALDI A, ZISSERMAN A. Deep inside convolutional networks visualising image classification models and saliency maps[EB/OL].[2016-06-20]. http://www.robots.ox.ac.uk:5000/~vgg/publications/2014/Simonyan14a/simonyan14a.pdf. |

| [17] | ZEILER M D, FERGUS R. Visualizing and understanding convolutional networks[C]//Proceedings of the 13th European Conference on Computer Vision. Berlin:Springer, 2014:818-833. |

| [18] | ZHOU B, KHOSLA A, LAPEDRIZA A, et al. Learning deep features for discriminative localization[C]//Proceedings of the 2016 IEEE Conference on Computer Vision and Pattern Recognition. Washington, DC:IEEE Computer Society, 2015:2921-2929. |

| [19] | JARRETT K, KAVUKCUOGLU K, RANZATO M, et al. What is the best multi-stage architecture for object recognition?[C]//Proceedings of the 2009 IEEE International Conference on Computer Vision. Piscataway, NJ:IEEE, 2009:2146-2153. |

| [20] | SZEGEDY C, LIU W, JIA Y, et al. Going deeper with convolutions[C]//Proceedings of the 2015 IEEE Conference on Computer Vision and Pattern Recognition. Washington, DC:IEEE Computer Society, 2015:1-9. |

| [21] | HE K, ZHANG X, REN S, et al. Deep residual learning for image recognition[C]//Proceedings of the 2016 IEEE Conference on Computer Vision and Pattern Recognition. Washington, DC:IEEE Computer Society, 2016:171-180. |

| [22] | HE K, ZHANG X, REN S, et al. Spatial pyramid pooling in deep convolutional networks for visual recognition[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2015, 37(9): 1904-1916. doi: 10.1109/TPAMI.2015.2389824 |

| [23] | CHATFIELD K, SIMONYAN K, VEDALDI A, et al. Return of the devil in the details:delving deep into convolutional nets[EB/OL].[2016-06-20]. http://web.cs.hacettepe.edu.tr/~aykut/classes/spring2016/bil722/slides/w04-DelvingDeepNets.pdf. |

| [24] | JIA Y, SHELHAMER E, DONAHUE J, et al. Caffe:convolutional architecture for fast feature embedding[C]//Proceedings of the 2014 ACM International Conference on Multimedia. New York:ACM, 2014:675-678. |