2. 华南理工大学 公共管理学院, 广东 广州 510641

2. School of Public Administration, South China University of Technology, Guangzhou 510641, Guangdong, China

随着数据的增长和算力、算法的大幅提升,人们越来越普遍地把人工智能运用于商业部门并为其赋能,如人工智能投资顾问、人工智能辅助诊疗等。人工智能在政府部门的应用尚处于初级阶段,如政务服务、辅助决策等。我国正加速推进人工智能应用场景落地,推动政府治理体系和治理能力现代化。人工智能可以处理海量数据,承担极为复杂的任务,优化行政流程与决策,推动治理结构扁平化,促进多部门协同治理,控制政府规模,优化资源分配,提升政府工作效率和公共服务的有效性。但是,人工智能技术嵌入政府治理也带来了许多风险与挑战,包括数据融合、数据安全、算法歧视、人工智能伦理与透明度、法律责任等[1]。然而,政府部门远未作好应对人工智能所带来的指数级变化挑战的准备。现有政府结构和进程难以适应人工智能时代,迫切需要各国政府进行重新思考[2]。越来越多的人工智能技术将会嵌入政府治理中,如何发挥其在政府治理中最大效用的同时精准识别并规避其风险?现有研究鲜有涉及,本文探究性地将人工智能嵌入政府治理的风险及其规避纳入一个系统性的理论框架中并加以分析,希冀以“善智”促进政府的“善治”。

一、研究框架构建 (一). 价值导向:“善智”与“善治”的前提在处理技术与人类的关系时,有部分学者秉持技术中立原则(technology neutrality)。此原则最先应用于版权纠纷领域,即技术本无善恶之分,技术提供者无法预料或控制某产品或技术被用于合法或非法的用途, “因而无从仅仅因为产品或技术成为侵权工具而使提供者为他人侵权行为负责”[3]。一般认为,“技术中立”包含了功能中立、责任中立、价值中立三种内涵[4],前两种中立观其实指向的都是价值中立观,即技术天然不带个人主观偏见、不含价值判断,奉行客观性至上的价值中立立场。这一原则或许适用于传统计算机技术,却与人工智能技术不适配。人工智能技术与传统计算机技术相比,其工作机制、原理大相径庭。虽然都是通过计算机编程实现功能,但传统计算机技术执行的是简单的“输入—输出”式逻辑思维运算;而人工智能技术以“深度学习”为特征,在大量输入数据并进行学习训练后能够依靠“经验”作出相应决策。人工智能技术始终由设计者创造完成,并服务于特定目的;人工智能如何作出决策、作出何种决策,与设计者的目的、态度和获取的训练数据密切相关。当设计者在开发过程中将自己的价值观植入算法中,或训练数据带有天然偏见时,人工智能技术无法再保持“中立”,这也为技术风险的发生埋下隐患。

既然人工智能技术并非中立,其内在蕴含的价值导向则是决定其行为善恶的根源。对人工智能技术价值导向的探讨早有先例,为了防止机器人失控,阿西莫夫提出了著名的“机器人三定律”,这在当时极具进步意义,但随着人工智能技术的发展与社会经济生活的剧变,人们需要更契合现实的人工智能价值准则。各国政府积极探索人工智能伦理规范,2018年英国上议院人工智能特别委员会发布《英国人工智能发展的计划、能力与志向》,要求人工智能为人类共同利益服务、遵循可解释性与公平性、保护公民数据权利与隐私等[5]。2019年欧盟委员会发布《可信赖人工智能伦理准则》,准则包括七项要素:人的能动性和监督、技术稳健性和安全性、隐私和数据管理、透明度、多样性和非歧视性以及公平性、社会及环境福祉、问责制[6]。我国国家新一代人工智能治理专业委员会于2019年发布《新一代人工智能治理原则——发展负责任的人工智能》,强调人工智能发展应遵循和谐友好、公平公正、包容共享、尊重隐私、安全可控、共担责任、开放协作、敏捷治理八条原则[7]。

人工智能伦理上升到国家治理层面也说明人工智能技术亟须正确的价值导向指引,以实现从“善智”到“善治”。政府的行政行为具有公共性,一旦人工智能嵌入后发生侵权,引发风险的影响是广泛且深远的。所以当人工智能技术被应用到政府治理中时,应遵循一定的价值导向,即政治正义。人工智能技术具有其本身的技术属性与社会属性,在嵌入政府治理后具有了治理属性。相应的,政治正义包含了技术正义、治理正义与伦理正义。

其一,技术正义,包括透明性、可解释性、可控性。首先,由于“人工智能的技术研发环境和应用情境具有一定的隐蔽性、匿名性、不透明性,可能带来安全隐患”[8],所以人工智能技术嵌入政府治理发挥正向功能的前提是具有透明性、可解释性与可控性。互联网的普及为公民行使其知情权带来了前所未有的便利,但在人工智能嵌入政府的决策中,算法所具有的“黑箱”特性则给自动化决策过程蒙上了一层神秘“面纱”,这种不透明性导致决策结果难以预测和解释,引发问责难题,也使得公民对政府决策行为的正当性与合法性产生怀疑。要解决人工智能程序中的不透明问题,仅仅公开算法是不够的,必须构建出能够用来描述或定义人工智能程序内部处理过程的方法。其次,由透明性原则引申,人工智能技术应该具有可解释性,即用户能够知晓算法及其如何作出某种决策。当算法具有可解释性时,政府决策者能够知晓该决策方案的制订过程及优缺点,便于对方案进行风险评估及后续完善;政府工作者能够在公民对自动化决策结果产生异议时出示依据,进行解释说明,这对树立算法可信度至关重要。最后,人工智能技术应该符合可控性原则,即人工智能技术必须符合技术规范与标准,在法律框架中运行,人们能够对其进行有效规制与监督。

其二,治理正义,包括包容性、可追溯性、可问责性。首先,嵌入政府治理中的人工智能技术须具有包容性。《新一代人工智能治理原则——发展负责任的人工智能》提出,包容共享是人工智能治理的重要原则,“应促进包容发展,加强人工智能教育及科普,提升弱势群体适应性,努力消除数字鸿沟”[7]。但随着人工智能技术嵌入政府治理程度不断加深,技术天然追求效率的特性使得数字鸿沟、福利差距有进一步扩大的趋势。政府所提供的公共服务具有普惠性,那么在设计承担具体行政行为的智能系统、技术时应融入包容性,关注少数、弱势群体的需求。其次,政务人工智能技术应是可追溯的,可追溯性原则要求人工智能决策有迹可循。人工智能系统在决策过程中收集、标记的数据以及使用的算法应以工作日志的方式记录储存下来,以实现可追溯性,以便在人工智能决策错误时可以查找原因。最后,政务人工智能技术应是可问责的。一项人工智能设计运用到政府治理中,涉及各个相关主体,如人工智能技术设计者、生产者、运营者、使用者等,这就造成人工智能责任界定十分复杂。在治理场景中,人工智能失误的情况时有发生,如果主体责任界定模糊,那么有效问责将无从谈起。因此可问责原则实现的关键是确立一个清晰的责任界定框架,明确主体责任范围,而过往的决策信息则为人工智能行为的问责提供了依据。

其三,伦理正义,包括公平正义性、合法性。首先,公平正义是政府执政过程中永恒的价值追求。即使人工智能嵌入政府治理领域参与甚至代替人独立进行行政实践时,公平与正义依然是行政行为要遵循的价值导向,这就要求人工智能技术同样具有公平正义性。算法的价值倾向性受训练数据与设计者自身价值观的影响;因此,要发展公平正义的人工智能技术,就要在算法的设计与训练过程中着重消除由数据与设计者带来的偏见。其次,在我国依法治国与依法行政的背景下,人工智能技术在政府治理中的运用应符合法律规范。目前,人工智能行为较为突出的合法性问题之一即是对公民隐私的处理。在实际治理场景中,公民隐私数据常在未经授权的情况下被随意采集应用,给公民信息安全带来巨大威胁。当人工智能技术驱动的行政行为对公民隐私进行收集时,其收集意图、收集范围、应用方式等都应受到法律的规制。人工智能技术设计、开发、应用的全过程应在法律框架规制下进行。

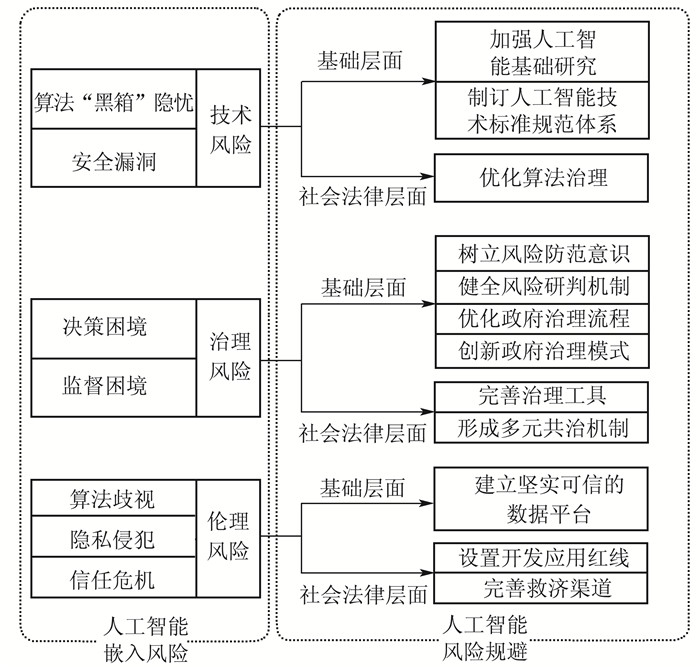

(二). 嵌入风险:人工智能嵌入政府治理的风险三重属性对于人工智能技术嵌入政府治理,一部分学者分析了人工智能所带来的积极影响。人工智能嵌入政府治理有助于解决传统政府治理中的弊端,包括人力资源缺乏、行政流程漫长、决策精准度不高、政府—公民交互渠道不畅、公民个性化服务针对性不够等[9]。例如,在新型冠状病毒肺炎疫情防控中,大量人工智能技术的运用对我国科学精准防控和有效遏制疫情发挥了重要作用,包括疫情监控、病区管理、风险预警、社区防控、同行查询等。同时,许多学者也表达了对人工智能技术发展风险的担忧。霍金在2017年全球移动互联网大会上就提出过“人工智能将成为人类文明史的终结”的论断①。中国信息通信研究院发布的《人工智能安全白皮书(2018年)》将人工智能安全风险划分为六大类:网络安全风险、数据安全风险、算法安全风险、信息安全风险、社会安全风险与国家安全风险[10]。在政府治理领域,Boyd等[11]研究发现人工智能在公共部门中的应用可能带来算法歧视、技术性失业等风险。政府运用人工智能治理的风险还表现为:科层制结构与人工智能发展之间的冲突;法律法规体系对以算法和数据为主体的应用环境适应性不足;人工智能将引发新的社会议题,而针对这些新领域的治理体系和治理工具仍处于空白状态等[12-13]。Wirtz等[14]将人工智能嵌入政府治理后带来的挑战与风险归为技术、法律、伦理和社会四大类。在以往研究成果的基础上,本文结合人工智能的“善智”前提,将嵌入政府治理的风险分为三类:一是技术风险。当人工智能违反技术正义,缺乏透明性、可解释性与可控性时,人工智能技术的风险表现为安全漏洞风险与算法“黑箱”隐忧。二是治理风险。当人工智能技术违反治理正义,缺乏包容性、可追溯性、可问责性时,人工智能嵌入政府治理会引发决策困境与监督困境。三是伦理风险。当缺乏伦理社会正义价值引导的人工智能技术嵌入政府治理并运用到社会环境中时,引发的隐私侵犯风险、算法歧视风险与信任风险可能会使人类社会原本的价值体系陷入岌岌可危的境地,甚至危及国家政治权威。

① 2017年4月27日,斯蒂芬·霍金在全球移动互联网大会上发表演讲,指出人工智能的发展有可能是人类文明史的终结。参见:人民网. 2017GMIC全球移动互联网大会霍金谈“人工智能威胁论” [EB/OL]. (2017-04-28) [2020-22-26]. http://media.people.com.cn/n1/2017/0428/c40606-29241880.html.

(三). 规避路径:基础层面与社会法律层面措施共同发力人工智能是把双刃剑,在实际应用过程中,公共行政人员通过规划和界定其风险领域,评估潜在的灾难性事件,以确定最恰当的干预和补救措施[15]。2016年,美国、欧盟和英国分别发布了有关如何使社会为广泛运用人工智能作好准备的报告,均将透明度、问责制以及对经济和社会的积极影响作为“善人工智能社会”的核心价值观之一[16]。我国公共政策选择应重视算法与数据的基础地位、社会治理制度的创新、构建起人工智能全球治理机制[6]。学者们也研究了如何在发挥其长处的同时尽量减轻消极影响。如人工智能设计之初应该考虑人工智能的道德行动者地位及“道德嵌入”的合理性问题,关注正义与公平,强调责任意识[17]。学者们或聚焦算法优化,明确算法责任主体、监管主体、监管方式等[13],或从安全属性、责任机制、应用环境的多主体共治几方面构建人工智能风险善治体系[8]。

现有研究对规避人工智能风险进行了广泛探索,但鲜有学者将人工智能风险与规避路径纳入系统性框架进行研究。层级模型是将复杂问题降维、达到直观清晰效果的重要工具[18]。Clark[19]提出了网络空间结构分层模型,该模型揭示了网络空间的本质与基本构成。Gasser等[20]认为使用分层模型便于决策者厘清人工智能系统中存在的异质性、风险的复杂性,据此也能对政策、法律和监管进行新的思考。他按照时间序列构建了人工智能层级治理模型,从底部到顶部将人工智能风险治理路径划分为技术基础层、伦理层与社会法律层,认为技术路径是规避人工智能风险的基础。短期而言,风险规避应关注数据治理、算法治理、人工智能技术标准与规范制定;中期而言,在技术基础层之上,决策者可以继续构建伦理道德路径,关注伦理准则制定;长期而言,社会和法律层位于顶层,要将人工智能与人类的关系纳入完善的法律框架之中。不同层级间的政策工具配合使用、层层递进,共同发挥标准、政策、法律等治理措施的效用,形成日渐完善的人工智能治理体系。

综上,为了促进人工智能技术与政府治理的良性结合,本研究借鉴Wirtz等[14]关于人工智能嵌入政府治理所引发风险的分类以及Gasser等[20]对人工智能风险治理构建的层级模型,构建了人工智能嵌入政府治理的风险规避路径框架,如图 1所示。从基础层面与社会法律层面构建人工智能嵌入政府治理的风险规避路径,基础层面对应短期措施,社会法律层面对应长期措施。本文将人工智能技术嵌入政府治理引发的风险归为三类:技术风险、治理风险与伦理风险。针对技术风险,在基础层面加强人工智能技术基础研究和制订人工智能技术标准规范体系,从社会法律层面优化算法治理;针对治理风险,在基础层面树立风险防范意识,健全风险研判机制,优化政府治理流程和创新政府治理模式,在社会法律层面完善治理工具与形成多元共治机制;针对伦理风险,在基础层面着眼于建立坚实可信的数据平台,在社会法律层面设置开发应用红线和完善救济渠道。

|

图 1 人工智能嵌入政府治理的风险规避路径框架 |

人工智能嵌入政府治理促进了治理工具和手段的多样化,但是将算法技术作为治理工具时强化了政府工具理性,政府容易陷入片面追求技术效率的漩涡,忽视安全、公平、正义、负责任等价值理性,引发一系列风险问题。本文分别从技术风险、治理风险与伦理风险对人工智能嵌入政府治理存在的风险进行探讨。

(一). 技术风险 1. 算法“黑箱”隐忧人工智能主要通过深度学习来发挥其强大功能,但在输入和输出之间存在人们无法知悉的“隐层”——也称为“黑箱”,深度学习就其本质而言是“黑箱”。人工智能将经历三个阶段:弱人工智能、强人工智能与超人工智能阶段。在弱人工智能阶段,人工智能在具体领域内发挥作用,如信息检索、科学计算、自动化控制等,协助但无法全面替代人类智慧,此阶段的算法更多被设计成遵循从数据输入到既定结果输出的过程。在弱人工智能阶段,算法指令相对简单,结果指向也较为明确。若发觉程序运行出现失误,设计者可回溯指令,找出程序漏洞并修复。在强人工智能阶段,人工智能获得更强的自主学习能力,逐渐接近人类智慧,它们被编程去学习如何解决问题。学习能力使算法具有某种程度上的自主权,进而使得即使是算法的设计者也难以对算法运行过程及输出结果进行阐释[21]。麻省理工学院Jaakkola教授认为:“如果是一个非常小的神经网络,你也许能够理解它。但是,一旦它变得庞大,(结构)可能达到数百层,并且每层有数千个单位,那么它就变得相当难以理解。”①当前人工智能发展正由弱人工智能向强人工智能过渡,算法逐渐具有自主性、复杂性与不可解释性,增加了预测与解释输出结果的难度。即使能够知悉其工作原理,也不一定清楚其实施方案的实际机制,因而仍无法预测与解释其应用后果,这就造成了对政府行政行为监督和问责的困境。2016年,特朗普竞选团队通过剑桥分析公司非法获取网络用户个人数据,对选民有针对性地投放广告,影响了当年大选②。法国总统马克龙也曾通过数据分析公司对选民进行“政治画像”,从而便于其有针对性地优化施政方针,获得选民支持③。由于存在算法“黑箱”,即使大众已知自己信息泄露,陷入政治精准营销漩涡,但对算法干预过程一无所知,无法收集有效证据用于申诉,政府操纵选情、舆论造假的行为便肆无忌惮、愈演愈烈[22]。另外,当具有“黑箱”特性的人工智能嵌入政府治理场景时,一旦发生失误,不仅会阻碍政府部门的正常运作,还会将公民和社会置于重大风险中,引发社会伦理问题与争议[23]。

① 麻省理工学院Tommi Jaakkola教授接受英国《每日邮报》采访时表示,神经网络的复杂化使人们无法理解深度学习算法。参见:DAILY MAIL. Has humanity already lost control of artificial intelligence?Scientists admit that computers are learning too quickly for humans to keep up[EB/OL]. (2017-04-11) [2020-11-26]. https://www.dailymail.co.uk/sciencetech/article-4401836/Has-humanity-lost-control-artificial-intelligence.html.

② 参见How Trump consultants exploited the Facebook data of millions[EB/OL]. (2018-03-17) [2020-11-26]. https://www.nytimes.com/2018/03/17/us/politics/cambridge-analytica-trump-campaign.html.

③ 参见5 000万脸书用户信息被盗探访这场舆论风暴中的“剑桥分析”[EB/OL]. (2018-04-04) [2020-11-26]. https://world.huanqiu.com/article/9CaKrnK7ndP.

2. 安全漏洞人工智能技术发展仍处于弱人工智能阶段,技术在不断地完善与升级过程中。如人工智能广泛依赖图像、音像、雷达等各类传感器,传感器被干扰就会出现识别和决策失误。人工智能系统存在一些安全漏洞易受攻击,主要有以下三方面原因:机器学习能力须通过反复“学习”一些统计学上的关联而获得,而这些统计特性有时是不可靠的,因此人工智能习得的工作模式也容易被干扰;人工智能功能的发挥依赖于提供的数据,输入数据的干扰会扰乱人工智能系统[24];当前人工智能技术研发仍处于初级阶段,所基于的学习框架和组件等有待进行安全测试与完善,可能存在漏洞。由清华大学人工智能研究院孵化的Real AI公司曾做过相关研究:人工智能系统的算法漏洞可生成对抗样本的“噪音”,恶意误导人工智能算法输出非预期结果,诱导识别系统出错④。Eykholt等[25]在“闪避攻击”实验中发现,可以对路标做一些涂改,使人工智能路标识别算法将“禁止通行”的路标识别成为“限速45km”。统计数据显示,2020年,国家互联网应急中心(CNCERT)共监测发现我国境内被植入后门的政府网站数量为276个,2019年则为1 045个[26]。运用于政府治理的人工智能系统遭受攻击可能会产生更为严重的后果。例如,政府治理中常采用基于人工智能的内容过滤系统,保护互联网平台健康安全,一旦系统遭受恶意攻击,内容过滤机制无法发挥作用,不法分子就会在网络平台上散布虚假消息和干扰国家执法活动。人工智能攻击有别于传统意义上的网络安全,传统网络安全漏洞可能是由于指令错误,可通过修改指令修复漏洞;而人工智能漏洞在于自身算法或依赖的数据,利用这样的漏洞来破坏人工智能系统甚至无须侵入目标系统。

④ 参见堵住AI安全漏洞,法规之外更需技术制衡[EB/OL].(2020-01-14) [2020-11-26]. http://www.xinhuanet.com/finance/2020-01/14/c_1125458306.htm.

(二). 治理风险 1. 决策困境人工智能参与决策是其嵌入政府治理中发挥效用的重要途径。在发展初期,人工智能参与决策的优势明显,可提高行政治理效率。人工智能通过算法模型进行决策,实现决策过程中的客观性,避免决策者因受到自身经验、情感倾向、人情关系的制约而影响决策的公正性。但随着人工智能技术在政府治理过程中嵌入程度不断加深,其引以为傲的优势也成为其隐患。如何在人工智能决策中寻求效率与公平的平衡?提高效率是技术设计的意图,人工智能通过内置算法对数据进行精确计算后往往可以快速得到“最优解”,然而,“最优的”是否就是“最合适的”?在处理类似“有轨电车困境”[27]的情况时,人工智能甚至会选择为了实现多数人的福祉而牺牲少数人利益[28]。人工智能的决策困境逐渐显露。政府作为公共服务的提供者与公共利益的维护者,作出的决策必须受到社会公平与正义价值导向的指引,若一味追求工具理性而忽视了价值理性,则会让政府治理行为蒙上功利主义的阴影,进一步加剧马太效应,埋下社会失序隐忧。

2. 监督困境“深度学习”是人工智能的最大特征,设计者设定算法学习规则,算法基于此进行大规模数据输入训练后便可以自主工作。“深度学习”使得算法并非机械模仿人类行为,而是赋予其一定的自主性进行学习与决策。既然人工智能不再是某种完全“没有意识”的被动工具,是否可以视其为拥有某种自主意识的智能主体和拥有法律意义上的独立主体资格?这关系到能否对其行为进行有效监督与问责。人工智能运用于政府治理中,给政府治理带来的风险成因包括使用者操作不当、黑客恶意入侵操纵、人工智能系统算法漏洞等。复杂的风险成因导致很难认定人工智能产品侵权责任,尤其是人工智能算法的“黑箱”属性,导致即使是设计者也无法完全准确地预测其自主性的行为后果。当人工智能服务或产品在应用过程中出现偏差与失误,甚至引发侵权或犯罪行为时,将责任完全归于设计者是不公平的,但若要归于人工智能本身,如何问责机器又成了一个难题。

现有法律制度和法制体系主要是围绕规范人的行为制定,着眼点通常是人类行为之间的因果关系。对人工智能相关行为法律责任的认定和承担问题,当前学术界、产业界、决策部门也在探索治理之道。例如,我国首个人工智能安全发展的导则《人工智能安全与法治导则(2019)》第五点“人工智能产品法律责任问题”中提到,在弱人工智能时代,人工智能产品定位仍是“工具”,应由人工智能设计者、生产者、运营者与使用者共同承担法律责任[29]。但是,此类探索大多仍停留在建议与倡导层面,目前依然缺乏对人工智能产品侵权行为进行明确责任认定与追责的法律与政策治理工具。为促进人工智能技术良性发展,现代法律体系建设必须未雨绸缪,尽快填补治理工具的空白以规避人工智能技术带来的新问题,“在人工智能时代继续维持秩序与变革、守护与创新、价值与事实之间的动态平衡”[30]。

(三). 伦理风险 1. 算法歧视人工智能算法嵌入政府治理后,对政府行为的影响日益加深。例如,决策者基于算法大量收集公民特征“数据集”,识别公民需求,提供差异化、个性化服务;在刑事判决中评估犯罪风险时可能依据算法提供的数据判断其刑罚。虽然人工智能在一定程度上可以模拟甚至超越人类智慧,但是人类除了智慧,仍具有复杂的生理特质,如情感、情绪、性格等,这些是现阶段人工智能无法与人类比拟的。那么在决策者同意人工智能分担一部分决策行为时,人工智能能够作出合理公正的决策吗?

算法通过内置的排序、分类、关联、过滤等规则与程序处理采集到的海量数据进行决策[16],但算法决策有可能暗藏“歧视”,导致决策不合理、不公平。首先,人类社会具有不确定性与复杂性,算法采集到的数据在客观性、全面性、代表性等方面可能存在不足,使用这些数据进行自动化决策的过程中造成歧视。芝加哥法院使用Northpointe公司开发的犯罪风险评估算法COMPAS时,由于数据库中拥有更全面的白人资料,导致黑人被错误标记为具有高犯罪风险的概率是白人的两倍[31]。二是算法设计目的及数据运用等植入了设计者价值取向,即算法能动性要通过设计者主观价值判断来实现。人工智能机器设计者的偏见或社会偏见嵌入用于训练机器的数据中,人工智能从存在偏见的数据中获得知识,就会使这种倾向制度化[2]。有研究指出,黑人会更频繁收到“查询被逮捕记录”的广告[32]。即使设计者在算法设计中尽可能保持客观,但其仍会将自身的专业知识、社会文化、道德准则、价值判断甚至固有偏见注入算法中。例如,算法可能会为使用者显示最优选择与决策,这不仅需要设计者事先设定满意阈值,而且为了有效实现预期目标,设计者会依据自身判断或过去用户的数据训练算法,通过算法学习获得“最优解”。

公平是政府决策时重要的价值导向,然而算法歧视对公平的损害不易为人察觉。如少数群体可能会因为“数据鸿沟”造成的数据缺失,被排除在算法社会之外;公民被算法内置排序分类规则赋予“算法身份”,即“算法自动确定了个体的性别、阶级、种族等身份特征”后,算法再根据这些特征识别公民偏好,推送相应服务,这可能会导致公民陷入“信息茧房”[21]。随着进入政府决策过程中数据驱动信息系统数量迅速增加,偏差或不透明性问题将变得更加严重[33]。

2. 隐私侵犯人工智能嵌入政府治理后存在泄露隐私风险。人工智能应用以采集与处理海量个人数据为前提;随着更复杂的数据分析算法的发展,数据存储能力、计算能力的提高,人工智能技术能够收集和分析更多数据集,提取潜在的有用信息,但这势必会涉及个人数据信息安全与隐私保护问题[34]。在数字化空间中,个人行为皆可以被转化为数据记录下来,如个人身份、偏好、网络浏览轨迹、出行记录等,人工智能通过采集公民数据,凭借强大的数据整合与处理能力对个人进行“精准画像”,将相关信息运用到决策中去。虽然这有利于科学决策与精准识别公民需求,但过度数据采集行为对公民的财产和人身安全行为造成了威胁,存在隐私泄露风险。同时,数据采集行为常在公民不知情、未授权的情况下进行,或者公民即使知情但没有自由选择授权的范围和类型而被动授权,公民正逐渐丧失了对信息的控制权,面临着边沁所说的“环形监狱”困境,即知道自己被监视,但是看不见监视者①。2019年,杭州野生动物园就因强制启用人脸识别技术,收集用户生物识别敏感信息,危害用户人身和财产安全而被起诉②。人脸、指纹、声纹等基于用户生物信息发挥作用的识别技术在政府治理领域中也面临同样问题。这些技术在安检、治安管理、个人账户登录管理等场景中发挥了极大作用,但都面临监管难题。个体的生物信息属于个体高度敏感信息,并且伴随个体一生,一旦泄露或滥用,几乎无法救济。

① 环形监狱又称圆形监狱,是英国哲学家边沁于1785年提出的一种监狱形态的设想。在这种监狱中,囚犯们被关押在一个环形建筑中,环形建筑的中心是一座瞭望塔。瞭望塔上有一圈窗户,与环形建筑牢房上的窗户相对,且装有百叶窗等防窥装置,囚犯在囚室中看不到监视者,但监视者在瞭望塔上可以监视囚犯的所有行为,使囚犯长期处于被监视的压力下。现常被用来隐喻互联网中的安全和隐私问题。参见BENTHAM J, BOZOVIC M.The panopticon writings[M].London Verso, 1995:29-95.//刘永谋, 吴林海.极权与民主: 物联网的偏好与风险——以圆形监狱为视角[J].自然辩证法研究, 2012, 28(5): 77-81.

② 参见中国人脸识别第一案:杭州一动物园因启用人脸识别技术被起诉[EB/OL].(2019-11-04) [2020-11-16]. http://www.chinapeace.gov.cn/chinapeace/c54219/2019-11/04/content_12299517.shtml.

各国政府也在探究保护公民隐私之道。中国电子技术标准化研究院发布了《人工智能标准化白皮书(2018)》,指出“对个人数据管理应该采取延伸式保护”,保护公众隐私[35]。2020年公布的《中华人民共和国个人信息保护法(草案)》在法律层面上对使用个人信息进行自动化决策作了相应探索。但是,我国对于公民信息安全保护的相关法律法规仍不够完善,尚未形成完善的人工智能数据安全法律法规体系。美国出台了《网络安全信息共享法案》,制定了针对不同行业的公民信息安全保护细则[36]。欧盟发布了《通用数据保护条例》保护公民数据与隐私权[37]。总而言之,政府在使用公民个人信息时,应遵循正当合法的价值导向,收集信息之前应征得公民同意,并明确隐私信息收集目的、方式、种类等,尊重公民隐私。

3. 信任危机在行政伦理中,人是权力行使和决策行为主体,即“从未有非人类的主体能够裁决人类的行为”[3]。人的决策除了数据处理和运算外,还涉及价值与事实的平衡,会涉及情感、价值选择、伦理判断等。虽然人工智能在采集数据与计算方面远优于人类,但是其并不具备完全自主意识与类人情感,人工智能只是作为行政行为的辅助,由人作出最终决策。随着人工智能技术的发展,人工智能将越来越深入地参与决策进程中和独立作出行政行为。弱人工智能阶段,人工智能帮助人类实现数据的计算与整合;强人工智能阶段,人工智能可以为决策者提供权力行使方案;超人工智能阶段,人工智能则可能摆脱人类管控独立作出决策。随着人类对人工智能系统的控制权逐步减少,方案的制定中越来越多地体现机器意志,人类社会的传统行政伦理将逐渐崩塌。若最终决策权由人工智能掌握,政府行政行为是否还具有权威性和合法性?当机器拥有了越来越大的决策权,而人工智能技术规范体系缺位,民众的恐慌与怀疑情绪会愈来愈盛,政府将丧失公信力而陷入“塔西佗陷阱”。

此外,人工智能的频现失误也使人们对其可靠性与安全性产生担忧。据统计,截至2020年12月,我国共有政府网站14 444个,国家互联网应急中心检测发现2020年我国境内被篡改的政府网站达1 030个,较2019年同期(787个)增长30.9%[26]。不法分子利用政府网站安全防火墙的漏洞乘虚而入,在政府官方网站上发布虚假消息,或将本要键入官方网站的用户定向到虚假链接,导致用户关键信息泄露。虽然能够进行事后修复,但此类行为已切实危害公共安全,甚至逐渐瓦解公众心中的信任体系。

三、人工智能在政府应用中的风险规避路径选择为规避人工智能嵌入政府治理中的风险,针对以上三类风险,在遵循“善智”的技术正义、治理正义、伦理正义的价值导向下,短期而言,应加强基础层面的措施;长期而言,应在社会法律层面采取以下相应措施,达到人工智能在政府治理中的“善治”。

(一). 增强技术稳定性与算法安全性以规避技术风险 1. 基础层面措施:技术升级与规范(1) 加强人工智能技术基础研究。人工智能产业链结构分为基础研究层、技术开发层与应用层。人工智能产业的基石为基础研究层,包括芯片、计算平台和数据等。技术开发层是产业链的核心部分,人工智能应用能够最终落地倚靠技术层,包括算法、开发平台与通用技术等。我国人工智能产业呈“倒三角”结构,研究领域聚焦于相关应用的落地,相对忽视了基础研究层与技术开发层的发展。人工智能全产业链环环相扣,基础研究更是重中之重,只有在基础研究领域补齐短板,人工智能才能可持续健康发展。基础研究不确定性大、周期长、风险高,因此,政策布局应向基础研究倾斜,在智能芯片、基础算法、计算平台等方面持续稳定加大投入,实施重大技术攻关,提高自主创新能力,突破我国人工智能关键核心技术瓶颈。只有我国人工智能核心技术整体得到提升,嵌入政府治理中的人工智能技术才具有可靠性、稳定性。政府的行政行为涉及国家机密,因此关键核心技术应保证是我国具有自主知识产权的,避免受制于人,遭到不法分子与邪恶势力的干扰与攻击。

(2) 制订人工智能技术标准规范体系。人工智能技术本身存在的漏洞有可能被不法分子利用并引发风险。例如,不法分子恶意攻击警方使用的人工智能人脸识别系统,削弱系统识别的准确性,严重影响国家安全与社会稳定。因此,要尽快构建相应的技术标准规范体系和规范操作流程,为人工智能技术的规范研发、使用提供指导。发达国家高度重视人工智能技术规范体系的设立,如美国发布的《国家人工智能研究与发展战略规划》[38]、欧盟发布的“人脑计划”[39]等均提出建设人工智能技术的标准规范。我国《新一代人工智能发展规划》中提出要“加强人工智能标准框架体系研究”[40]。应注意的是,嵌入政府治理中的人工智能技术适用普适性准则,但也要根据政府的特点制订具有针对性的技术标准。例如,需要重点探索保障系统可控性、可靠性、透明性、保密性与可追溯性等技术标准的设置。不同政府部门可根据实际需要制订相应的人工智能技术规范操作流程,以免因操作失误造成不可预测的风险。

2. 社会法律层面措施:优化算法治理算法的“黑箱”属性、安全漏洞等是人工智能应用风险的主要来源之一。要破解算法的安全风险,使人工智能技术安全可控,除了不断提升人工智能技术,还须从伦理、法律上对算法进行规制,构建算法治理框架。国外政策与法规已将算法纳入监管重点,美国数据创新中心在2018年发布《政策制定者如何推动算法问责》的报告中提出,要构建算法问责框架[41]。算法治理有几个基本要点:一是在算法设计过程中结合正确的伦理与价值取向,“将算法的使用情景与设计结合起来”[23],开发合乎伦理、公平公正的算法。这也要求为算法领域的科研人员设计相关伦理道德规范。二是应注重算法的解释性与透明性的建设,算法的解释性与透明性是算法可控、可审计的重要保障。三是应建立相应的算法问责机制,明确开发者、使用者等相关主体的权利与责任,防止利用算法漏洞进行非法活动。《新一代人工智能治理原则——发展负责任的人工智能》中提出人工智能发展应遵循“公平公正、安全可控、共担责任”等原则[7],未来可结合发展中的实际情况对原则内容进一步细化,促进算法开发与应用在完善的伦理法律框架中进行。

(二). 提高政府治理能力与完善治理体系以规避治理风险 1. 基础层面措施:政府治理变革人工智能嵌入政府治理后,政府治理面临着全新环境,意味政府治理必须突破现有模式,在治理理念、治理流程、组织结构等各方面进行深刻变革,从而适应“智能政府”的发展要求,积极面对人工智能赋能政府治理可能带来的一系列挑战。

(1) 树立风险防范意识,健全风险研判机制。树立风险防范意识是建立人工智能风险治理路径的起点。在国家安全领域,人工智能风险防范是一个新议题,不能照搬过去的治理经验。人工智能带来的风险具有复杂性、不确定性、动态性等特点,这使得政府对技术风险的感知具有一定的滞后性,容易错失风险控制先机而陷入被动。政府部门要将防患于未然根植于治理理念中,提高对风险的敏感度,及时干预风险。针对重点领域与行业,凡是涉及国家政治安全、经济安全、信息安全等,须将树立风险意识作为制度性工作来建设。在树立起风险意识的基础上,要建立健全风险研判机制。习近平同志提出:“领导干部对潜在风险要有科学预判。”参见习近平在2019年秋季学期中央党校(国家行政学院)中青年干部培训班开班式上的讲话(2019年9月3日)。《新一代人工智能发展规划》在关于人工智能技术风险的安全监管的相关措施的论述中提出,要“构建人工智能安全监测预警机制”[40]。政府应逐渐建立起对人工智能技术发展趋势的预测、研判和跟踪研究,更准确地把握技术发展的两面性,在获得发展红利的同时防患于未然。政府除了要制订尽可能详尽的风险预案外,还要提高算法或计算模型的透明性与可解释性,降低人工智能系统行为的不可预知性和不确定性,提高对人工智能所引发的复杂风险的掌控度。欧盟出台的《通用数据保护条例》中也提出,要增强算法的可解释性,降低算法参与自动决策时由于“黑箱”效应带来的风险[37]。

(2) 优化政府治理流程,创新政府治理模式。面对人工智能时代海量政务信息流通、整合的要求,要精简优化治理流程,打破政府内部不同层级与不同部门之间的信息壁垒,从而形成完整的数据体系,为智能治理提供坚实数据基础。例如,政府可通过智能电子政务系统精简治理流程,提升行政效率。构建内部统一的数据共享平台,方便政府各部门、各级政府间信息的公开与流通。在此基础上推进组织结构的扁平化与去中心化,适应人工智能嵌入后对组织敏捷性、灵活性的要求。另外,政府可探索设立新的职能部门,对嵌入政府治理的人工智能技术进行安全测试、推广应用、监督与审查等,这对人工智能技术顺利嵌入政府治理具有积极意义。

2. 社会与法律层面措施:构建人工智能善治体系(1) 完善治理工具。构建人工智能时代的安全防火墙根本上还是应该从法律与伦理道德层面着手。《新一代人工智能发展规划》提出:“加强人工智能相关法律、伦理和社会问题研究,建立保障人工智能健康发展的法律法规和伦理道德框架。”[40]法律与道德的双重约束是人工智能善治体系的重要组成部分。通过加强人工智能技术法律规范与道德规范的双重建设,可降低人工智能技术产生的风险,推动其与政府治理的有效融合,实现“善智”与“善治”的相互作用。首先,要根据人工智能产业发展态势,有序推动人工智能相关立法及逐步完善相关法律责任认定,建立相应的追溯与问责制度,明确责任与义务的划分。修订现有法律法规和增加解释,围绕算法决策、个人信息保护、新技术安全管理规范、人机交互等重点风险领域加以完善,使人工智能应用有法可依。其次,需推动人工智能伦理问题研究,建立多层次伦理框架,涵盖开发设计人员道德规范与行为守则、行业伦理安全准则等,将正确价值导向与规范嵌入人工智能技术开发中,实现人工智能技术与人类社会和谐友好共生。再次,为有效规制算法歧视,建立专门的算法稽核机构并让用户参与监督小组中,监督算法模型的多元社会福利效应。建立智能工具治理流程,审视算法模型训练过程、算法模型及模型输出是否存在歧视或偏见,适度增加模型设计和输出过程的透明性,有效规避和改进模型。最后,对于因政府应用人工智能系统而产生的歧视或个人隐私侵犯等,应制定合理的补救或申诉程序。

(2) 形成多元共治机制。人工智能技术嵌入政府治理的风险极为复杂。政府虽然拥有海量数据,但是政府限于自身技术能力、财力、人力等条件,无法独自应对人工智能嵌入风险。针对此困境,寻求多元主体的协同共治是出路之一。《新一代人工智能治理原则——发展负责任的人工智能》指出要开放协作,“鼓励跨学科、跨领域、跨地区、跨国界的交流合作,推动国际组织、政府部门、科研机构、教育机构、企业、社会组织、公众在人工智能发展与治理中的协调互动”[7]。美国政府利用竞赛方式激励公民、企业家、高校研究团队等主体参与人工智能发明和风险解决,帮助政府化解人工智能危机与挑战。在构建多元共治体系中,要结合不同主体的独特优势,如政府具有数据权力的合法性和权威性,企业具有独特的技术优势与工作效率,高校等研究机构具有基础研究的优势,公民反应敏捷。建立多层次、全方位的治理格局,共同规避人工智能嵌入政府治理的风险。Mehr[42]建议各国政府可以利用技术专家小组的方式规避风险,尽量让多学科专家、不同团队发挥各自长处,共同参与人工智能风险治理。此外,除了在国内构建共治平台,政府也可积极寻求国际合作,搭建国际交流合作平台,在对话与交互中寻求风险治理的最优解。

(三). 增强平台建设与制度兜底以规避伦理风险 1. 基础层面措施:建立坚实可信的数据平台大数据时代,互联网成为人们生活中不可或缺的一部分。2021年2月,中国互联网络信息中心(CNNIC)正式发布的第47次《中国互联网络发展状况统计报告》显示:截至2020年12月,我国网民规模达9.89亿,互联网普及率达70.4%。我国在线政务服务用户规模达8.43亿,占网民整体的85.3%[26]。庞大的网民规模每日产生巨大的数据体量,海量的社会信息随着政府的执政行为汇集起来,形成统计图表、研究报告等,为政府决策提供依据。人工智能算法的“深度学习”靠输入大量的数据实现,而训练数据的质量也会反过来影响算法决策的准确性与合理性。政府可依托其在数据获取方面的优势,建立起一个坚实可信的数据平台,对数据进行统一收集、整理、挖掘。政府作为平台建设发起者,不仅可以对内部横向和纵向层级中储存的数据进行整合,也可以鼓励企业、社会组织、研发机构等主体进行数据和平台共建共享,使数据资源进一步丰富与融合。政府不仅是数据平台的建设者,也应承担起主要的维护责任,设立数据使用守则,在收集用户数据后,要对其进行清洗,隐去其中敏感信息,确保用户隐私安全。

2. 社会与法律层面措施:“底线”约束与保障的双重作用(1) 设置开发应用红线。人工智能技术因其应用范围、领域不同,带来的风险危害程度有轻重之分。政府可根据人工智能技术成熟程度、应用领域等要素进行相应评估,分领域、分级别制订风险防范措施。具体来说,可围绕人工智能产品、技术复杂性、风险性、潜在影响等方面量化人工智能的智能等级,从而限制人工智能的研究领域以及应用范围。德勤会计师事务所在一份研究报告中对人工智能技术参与政府治理的领域和必要性做了具体划分,根据人工智能实际效用,其在政府治理领域中的嵌入可分为“可行性”“价值性”“必要性”三个等级,可根据等级评估结果限定人工智能在治理不同领域的嵌入程度[43]。针对可能引发不可控风险的人工智能技术领域设立开发红区,研发限制,并进行应用限定。例如,《英国人工智能发展的计划、能力与志向》就规定了避免在特定领域采用“黑箱”算法,在该算法能为决策提供令人满意的解释之前禁止将其应用于特定重大领域[5]。从算法设计、产品研发到成果应用进行全流程监管,必要时可开发人工智能“自我终结”机制,从底层构筑安全防火墙。对发展较成熟、风险较小的技术适当放宽限制。对成熟且应用广泛的人工智能技术,可通过安全认证放开开发限制。将人工智能技术按风险等级分类后,针对不同的风险等级对症治理,节约管理成本,也能够有效避免因忽视和误判引起的次生风险。

(2) 完善救济渠道。《中国人工智能发展报告2018》通过对今日头条用户进行关于人工智能认知的问卷调查,发现国民对于人工智能的发展关注度最高的问题为“人工智能失控会造成哪些社会危机”[44]。这表明了人工智能嵌入带来的剧烈变革会影响使用者、相关部门并波及整个社会,而其中的负面影响给公众造成了一定的恐慌情绪与不信任心理。例如,人工智能在政府领域的嵌入有可能导致公民隐私泄露,从而使公民的人身安全与财产安全受到威胁与损害;或者在行政决策过程中由于算法歧视的发生,公民可能因为种族、性别或其他个人属性的影响使得应有的福利、公共服务受到影响。对这些因人工智能而受到不公平待遇的个人,政策上应有相应的保障措施、补救或申诉程序[23]。首先,要健全事后追责与监督渠道,如设立投诉制度、信息公开制度、相应的行政复议、行政申诉制度、司法救济制度等,当公民认为遭受了公共服务中的算法歧视、侵权等不公待遇时,能够通过以上渠道维护自己的合法权益。其次,要出台人工智能社会政策。人工智能政策议程除了关注技术政策、产业政策,也要关注相关的社会政策。政府可借助社会政策调控作用,修复和控制人工智能引发的社会风险。例如,当政府利用人工智能技术提供公共服务时,应考虑到运用智能技术困难人群的需求,这一部分人群或许对智能技术运用不熟练、不习惯,甚至根本无法接触到智能技术。这就需要政府在制定施政方针时向其适度倾斜,依靠公共政策的调节作用填补信息鸿沟、福利鸿沟,使技术红利惠及全体公民。

四、结语人工智能作为新兴技术,其“头雁效应”已经引领了一系列科技革命和产业革命,同时对现代社会治理领域产生了巨大影响。越来越多的人工智能技术将逐渐嵌入政府治理中,这一趋势将对政府治理产生极其深远的影响并催生治理的变革。若应用得当,人工智能强大的数据处理能力和自主学习能力能够优化政府治理流程,提高政府公共服务的质量与效率,推动政府治理智能化与政府治理能力现代化。需要注意的是,人工智能技术并不适用“价值中立”原则,人工智能技术若要嵌入政府治理场景,必须遵循政治正义,包括技术正义、治理正义与社会伦理正义。如果违背政治正义,人工智能技术的“双刃剑”效应就会给政府治理带来风险与挑战,如算法“黑箱”隐忧、问责监督难题、算法歧视、隐私侵犯等。历史表明,任何先进技术的发展过程中都伴随着大量的风险与不确定性,但随着技术不断成熟,其最终会为人类发展作出巨大贡献。现阶段,推进国家治理体系和治理能力现代化是我国治理变革的主要目标,以科技创新赋能治理是国家治理现代化实现的重要途径。因此,我们应以开放包容的心态面对人工智能的发展,力求在人工智能技术发展与政府治理实现的有效性、安全性与智能性之间寻求平衡。政府部门需要主动适应“智能政府”的发展要求,针对不同属性的人工智能嵌入风险,积极从基础层面与社会法律层面规避风险,短期措施与长期措施相配合,最大限度地降低人工智能可能带来的安全风险,促进人工智能时代政府的“善智”与“善治”。

| [1] |

WEST D M, ALLEN J R. How artificial intelligence is transforming the world[EB/OL]. (2018-04-24)[2020-11-26]. https://www.brookings.edu/research/how-artificial-intelligence-is-transforming-the-world/.

|

| [2] |

AGARWAL P. Public administration challenges in the world of AI and Bots[J]. Public Administration review., 2018, 78(6): 917-921. DOI:10.1111/puar.12979 |

| [3] |

张今. 版权法上"技术中立"的反思与评析[J]. 知识产权, 2008(1): 72-76. DOI:10.3969/j.issn.1003-0476.2008.01.012 |

| [4] |

吴梓源, 游钟豪. AI侵权的理论逻辑与解决路径——基于对"技术中立"的廓清[J]. 福建师范大学学报(哲学社会科学版), 2018, 212(5): 69-80, 173. |

| [5] |

HOUSE OF LORDS. AI in the UK: ready, willing and able?[EB/OL]. (2018-04-16)[2020-11-26]. https://publications.parliament.uk/pa/ld201719/ldselect/ldai/100/100.pdf.

|

| [6] |

THE EUROPEAN COMMISSION. Ethics guidelines for trustworthy AI[EB/OL]. (2019-04-08)[2020-11-26]. https://digital-strategy.ec.europa.eu/en/library/ethics-guidelines-trustworthy-ai.

|

| [7] |

国家新一代人工智能治理专业委员会. 新一代人工智能治理原则——发展负责任的人工智能[EB/OL]. (2019-06-07)[2020-11-26]. http://www.most.gov.cn/kjbgz/201906/t20190617_147107.htm.

|

| [8] |

唐钧. 人工智能的风险善治研究[J]. 中国行政管理, 2019, 35(4): 46-52. |

| [9] |

何哲. 人工智能时代的政府适应与转型[J]. 行政管理改革, 2016(8): 54-60. |

| [10] |

中国信息通信研究院. 人工智能安全白皮书(2018年)[R/OL]. (2018-09-18)[2020-11-26]. http://www.199it.com/archives/774218.html.

|

| [11] |

BOYD M, WILSON N. Rapid developments in artificial intelligence: how might the New Zealand Government respond?[J]. Policy quarterly, 2017, 13(4): 36-44. |

| [12] |

王小芳, 王磊. "技术利维坦": 人工智能嵌入社会治理的潜在风险与政府应对[J]. 电子政务, 2019, 197(5): 94-101. |

| [13] |

贾开, 蒋余浩. 人工智能治理的三个基本问题: 技术逻辑、风险挑战与公共政策选择[J]. 中国行政管理, 2017(10): 42-47. |

| [14] |

WIRTZ B, WEYERER J, GEYER C. Artificial intelligence and the public sector-applications and challenges[J]. International journal of public administration, 2019, 42(7): 596-615. DOI:10.1080/01900692.2018.1498103 |

| [15] |

ADORNI G. "DESIREE: Decision support system for inundation risk evaluation and emergencies management" in International conference on high-performance computing and networking[C]. Berlin: Springer, 2000: 555-557.

|

| [16] |

CATH C, WACHTER S, MITTELSTADT B, et al. Artificial intelligence and the "Good Society": the US, EU, and UK approach[J]. Science and engineering ethics, 2018, 24(2): 505-528. |

| [17] |

闫坤如. 人工智能设计的风险及其规避[J]. 理论探索, 2018(5): 22-26. DOI:10.3969/j.issn.1004-4175.2018.05.003 |

| [18] |

YOO C S. Protocol layering and internet policy[J]. Social science electronic publishing, 2013, 161(6): 1707-1771. |

| [19] |

CLARK D. Characterizing cyberspace: past, present, and future[EB/OL]. (2010-03-12)[2020-11-26]. https://ecir.mit.edu/sites/default/files/documents/%5BClark%5D%20Characterizing%20Cyberspace-%20Past%2C%20Present%20and%20Future.pdf.

|

| [20] |

GASSER U, ALMEIDA V A F. A layered model for AI governance[J]. IEEE internet computing, 2017, 21(6): 58-62. DOI:10.1109/MIC.2017.4180835 |

| [21] |

刘培, 池忠军. 算法的伦理问题及其解决进路[J]. 东北大学学报(社会科学版), 2019, 21(2): 118-125. |

| [22] |

穆琳. "剑桥分析"事件"算法黑箱"问题浅析[J]. 中国信息安全, 2018, 9(4): 92-94. |

| [23] |

贾开. 人工智能与算法治理研究[J]. 中国行政管理, 2019, 35(1): 17-22. |

| [24] |

康米特, 黄紫斐. 人工智能攻击: 人工智能安全漏洞以及应对策略[J]. 信息安全与通信保密, 2019(10): 72-81. |

| [25] |

EYKHOLT K, EVTIMOV I, FERNANDES E, et al. Robust physical-world attacks on deep learning models[EB/OL]. (2018-06-22)[2020-11-26]. https://openaccess.thecvf.com/content_cvpr_2018/papers/Eykholt_Robust_Physical-World_Attacks_CVPR_2018_paper.pdf.

|

| [26] |

中共中央网络安全和信息化委员会办公室, 中华人民共和国互联网信息办公室, 中国互联网络信息中心. 第47次中国互联网络发展状况统计报告[R/OL]. (2021-02-03)[2021-03-06]. http://www.cac.gov.cn/2021-02/03/c_1613923423079314.htm.

|

| [27] |

赵汀阳. 有轨电车的道德分叉[J]. 哲学研究, 2015(5): 96-102, 129. |

| [28] |

柳亦博. "湖心岛"隐喻: 人工智能时代的算法伦理入侵[J]. 行政论坛, 2019, 26(6): 121-128. |

| [29] |

光明网. 国内首个人工智能安全与法治导则发布[EB/OL]. (2019-08-30)[2020-11-26]. https://tech.gmw.cn/2019-08/30/content_33123802.htm.

|

| [30] |

左卫民. 关于法律人工智能在中国运用前景的若干思考[J]. 清华法学, 2018, 12(2): 108-124. |

| [31] |

江溯. 自动化决策、刑事司法与算法规制——由卢米斯案引发的思考[J]. 东方法学, 2020, 13(3): 76-88. |

| [32] |

蔡斐. 算法也有公平正义[N]. 深圳特区报, 2018-07-31(B11).

|

| [33] |

VEALE M, KLEEK M V, BINNS R. Fairness and accountability design needs for algorithmic support in high-stakes public sector decisionmaking. [EB/OL]. (2018-04-26)[2020-11-26]. https://dl.acm.org/doi/epdf/10.1145/3173574.3174014.

|

| [34] |

SHARK A, REGAN P, SHRUM K, et al. AI and its impact on public administration[EB/OL]. (2019-04-08)[2020-11-16]. https://www.napawash.org/studies/academy-studies/ai-and-its-impact-on-public-administration.

|

| [35] |

中国电子技术标准化研究院. 人工智能标准化白皮书(2018版)[EB/OL]. (2018-01-24)[2020-11-26]. http://www.cesi.cn/201801/3545.html.

|

| [36] |

THE UNITED STATES CONGRESS. Cybersecurity information sharing act[EB/OL]. (2015-10-27)[2020-11-26]. https://www.congress.gov/bill/114th-congress/senate-bill/754.

|

| [37] |

THE EUROPEAN COMMISSION. General data protection regulation[EB/OL]. (2018-05-25)[2020-11-26]. https://gdpr-info.eu/.

|

| [38] |

NATIONAL SCIENCE AND TECHNOLOGY COUNCIL. The national artificial intelligence research and development strategic plan[EB/OL]. (2016-10-13)[2020-11-26]. https://www.nitrd.gov/PUBS/national_ai_rd_strategic_plan.pdf.

|

| [39] |

杨婕, 姚财福. 人工智能各国战略解读: 欧盟人脑计划[J]. 电信网技术, 2017(2): 50-51. |

| [40] |

国务院. 新一代人工智能发展规划[EB/OL]. (2017-07-08)[2020-11-26]. http://www.gov.cn/zhengce/content/2017-07/20/content_5211996.htm.

|

| [41] |

CENTER FOR DATA INNOVATION. How policymakers can foster algorithmic accountability[EB/OL]. (2018-05-21)[2020-11-26]. https://www2.datainnovation.org/2018-algorithmic-accountability.pdf.

|

| [42] |

MEHR H. Artificial intelligence for citizen services and government[EB/OL]. (2017-08-25)[2020-11-26]. https://ash.harvard.edu/files/ash/files/artificial_intelligence_for_citizen_services.pdf.

|

| [43] |

EGGERS W D, SCHATSKY D, VIECHNICKI P. AI-augmented government: using cognitive technologies to redesign public sector work[EB/OL]. (2017-04-26)[2020-11-26]. https://www2.deloitte.com/us/en/insights/focus/cognitive-technologies/artificial-intelligence-government.html.

|

| [44] |

清华大学中国科技政策研究中心. 中国人工智能发展报告2018[R/OL]. (2018-07-13)[2020-11-26]. https://ai.ucas.ac.cn/index.php/zh-cn/xsdt/6019-2018.

|

2021, Vol. 23

2021, Vol. 23