扩展功能

文章信息

- 王雪, 隋立春, 李顶萌, 李丽

- WANG Xue, SUI Li-chun, LI Ding-meng, LI Li

- 区域卷积神经网络用于遥感影像车辆检测

- Regional Convolutional Neural Network for Vehicle Detection in Remote Sensing Images

- 公路交通科技, 2018, 35(3): 103-108

- Journal of Highway and Transportation Research and Denelopment, 2018, 35(3): 103-108

- 10.3969/j.issn.1002-0268.2018.03.014

-

文章历史

- 收稿日期: 2017-10-24

2. 地理国情监测国家测绘地理信息局工程技术研究中心, 陕西 西安 710054;

3. 西安国际港务区规划局, 陕西 西安 710026

2. Geographical Conditions Monitoring Engineering Research Center, National Administration of Surveying, Mapping and Geoinformation, Xi'an Shaanxi 710054, China;

3. Planning Bureau of Xi'an International Trade and Logistics Park, Xi'an Shaanxi 710026, China

随着经济水平的提升,汽车保有量也在日益增长,因此引发了各类问题,如交通安全、环境污染、交通堵塞等。通过智能交通建设缓减交通压力也成为研究热点。在民用和军用监视中,车辆检测是不可缺少的部分。掌握大范围、全路域的车辆数量及分布特征是优化智能交通及交通规划的基本要求。

车辆检测方法比较多,目前主要基于地面传感器来实现车辆检测与计数,一种是主动式传感器,如基于激光的传感器[1]、基于无线电探测的传感器[2-3]等;另外一种是被动传感器,如摄像头之类的光学传感器。此类设备成本高,安装复杂,且不易移动,主要应用于大中城市主干道的交通监控[4],不适于大范围车辆数据调查。而利用航天或航空平台搭载传感器能获取较大范围的遥感影像数据,如高分辨率卫星影像、航空影像、无人机影像等,这些数据的空间信息更丰富,在更小空间尺度上具有对地表目标检测的能力,借此辅助车辆检测,用于交通管理和交通规划,可以极大弥补地面传统测量设备覆盖范围小、数据获取受限等不足。

笔者利用高分辨率卫星影像数据,研究基于特征信息的车辆检测算法。遥感影像自动车辆检测在鲁棒性和可靠性上面临很多挑战,主要由于车辆外观的多样化和光照的影响。另外,遥感影像中目标较小和背景比自然场景更复杂增加了检测的困难。基于特征的车辆检测算法主要是结合机器学习理论的车辆检测方法,首先通过对大量车辆目标样本的学习获取特征,然后针对车辆目标训练出分类器,最后使用分类器从图像中检测出车辆目标。传统主要的特征提取算法有基于梯度方向直方图(HOG)[5]、基于Haar-like[6]、基于尺度不变特征变换(SIFT)[7]和局部二值模式(LBP)[8]等算法提取出车辆特征信息,再训练出分类器进行车辆检测。这些传统的方法需要人工设计特征,计算量较大,没有高层语义上的抽象能力。随着近几年深度学习的发展,卷积神经网络(Convolutional Neural Networks,CNN)[9]已在图像识别[10-11]、语音识别[12-13]等领域取得卓越的成绩。卷积神经网络的多层结构能自动学习多个层次的特征。这些特征在语义抽象能力方面有着巨大的提升。

但特征发展的另一个特点是特征的复杂度提高和抽取的时间增加。对于任何一种特征而言,将特征、分类器与滑动窗口定位策略进行结合的检测框架往往要求大量的计算。如何设计高效的检测框架,减少检测系统整体的计算代价并提高检测性能是物体检测发展中的主要问题之一。本研究提出区域卷积神经网络[14-16]用于遥感影像车辆检测,能将特征、检测窗口、分类器有效地结合。

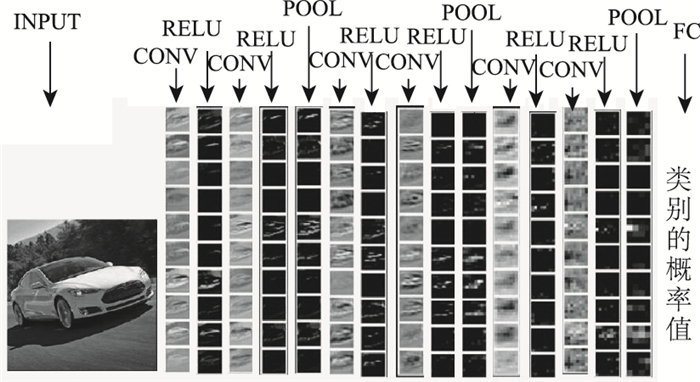

1 区域卷积神经网络基本原理 1.1 卷积神经网络(CNN)卷积神经网络模型是包含卷积层的深度神经网络模型,主要用于提取特征。卷积神经网络与其他神经网络的主要区别是卷积神经网络在神经网络的输入层前面加了卷积运算。图 1表示的是卷积神经网络的层级结构。

|

| 图 1 卷积神经网络的一个层级结构 Fig. 1 A hierarchical structure of convolution neural network |

| |

如图 1所示,卷积神经网络的基本网络结构分为数据输入层(INPUT)、卷积层(CONV)、全连接层(FC)、输出层。输入层原始输入图像数据,即图像的像素值。卷积层一般是卷积计算层(CONV)、激励层(RELU)两者的组合,或者是卷积计算层(CONV)、激励层(RELU)、池化层(POOL)3者的组合。卷积计算层也叫特征提取层,每个不同的卷积核提取输入数据的特征都不相同,卷积层的卷积核数量越多,就能提取越多输入数据的特征。激励层把卷积层输出的结果做非线性映射,使得收敛速度快,求梯度更简单。池化层也叫下采样层,目的是在保留有用信息的基础上减少数据处理量,加快训练网络的速度。全连接层可以包含多个连接层,通常后面层的神经节点都和前一层的每个神经节点相连。输出层神经节点的数目根据具体应用任务来设定,假如是分类任务,卷积神经网络输出层通常是个分类器。

CNN训练中包含两个阶段:正向传播和反向传播。

正向传播:神经网络将许多神经节点连接在一起,一个神经元的输入由前面网络层的神经元输出的线性组合得到,最终得到实际的输出。

反向传播:计算神经网络最终输出值与实际样本值之间的差距,通过反向传播算法逐层传播误差,并更新各层权值,直到二者的差距即损失函数达到要求的阈值。

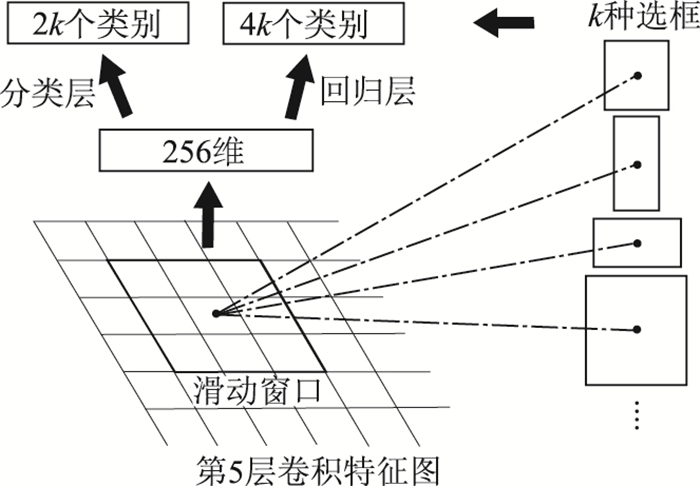

1.2 区域建议网络(RPN)传统的滑动窗口方法搜索目标速度比较慢,为了解决这一问题,Girshick等提出了区域建议网络框架检测算法[16]。区域建议网络是在提取好的特征图上,对所有可能的参考框进行判别,由于后续还有位置精修,所以参考框比较稀疏。该算法没有重复,大大提高了运行速度。

区域建议网络是一种全卷积网络,结构如图 2所示。在这个网络中,输入是Conv5的特征图,参考框选用9种,如图 3(a)所示,即3种尺度(128,256,512),3种宽高比(1:1,1:2,2:1),这样共9种参考框。在每个卷积核的中心位置考虑这9种参考框,如图 3(b)所示。由于Conv5是对原图下采样后的特征图,图像变小,这样每张图片只需要计算300个左右的参考框,大大减少了搜索的数量。

|

| 图 2 区域建议网络 Fig. 2 Region proposal network |

| |

|

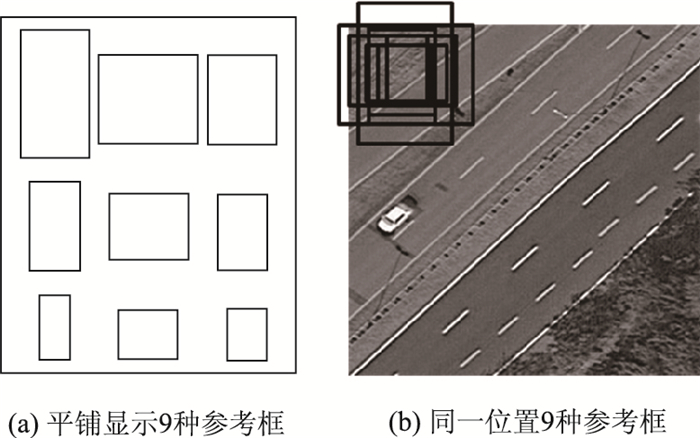

| 图 3 参考框 Fig. 3 Reference frame |

| |

区域建议网络包含两层,第1层是3×3卷积运算,256维的输出通道;第2层是两个1×1的卷积,两个分支。一个分支的输出通道是4k,即区域建议矩形框的偏差;另一个分支的输出通道是2k,即目标和非目标两类的概率值。另外在RPN网络后接一个感兴趣区域池化层(RoI池化层),将RPN提取的参考框的卷积特征拆分成固定大小的网格。

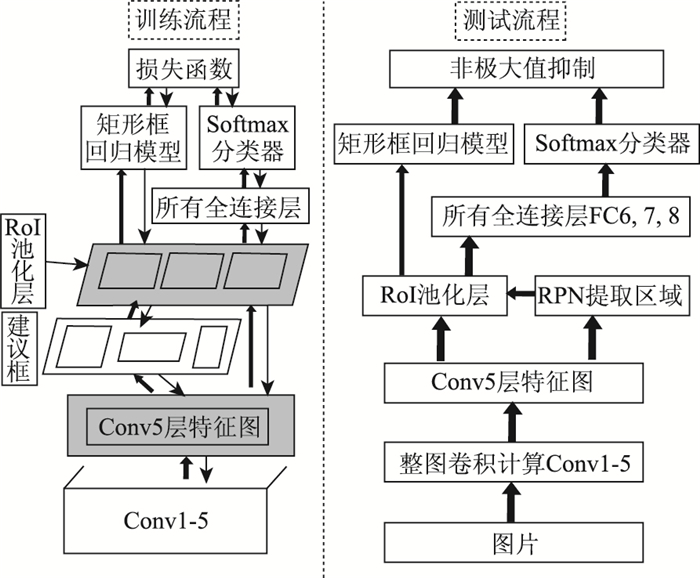

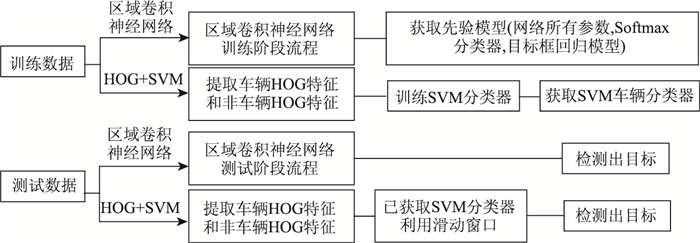

2 区域卷积神经网络目标检测的流程区域卷积神经网络集成了卷积神经网络和区域建议网络。该模型用于目标检测首先需要训练获取先验模型,然后再对测试影像进行目标检测。本研究选用ZF[17]模型为基本卷积神经网络模型。通过图 4训练流程获取先验模型,再通过测试流程检测出目标。

|

| 图 4 网络训练和测试流程 Fig. 4 Training process and testing process of network |

| |

2.1 训练流程

对于区域卷积神经网络的训练,首先需要获取ImageNet[8]模型参数做为初始训练模型参数进行预训练,这样会大大缩短训练的时间,具体流程见图 4。

(1) 训练RPN网络,由ImageNet上的Conv5特征预训练RPN网络。

(2) 训练CNN网络,由ImageNet对CNN参数进行预训练。

(3) 调优RPN网络,由第2步训练的卷积层参数,固定卷积层,微调(即再训练)剩余层。

(4) 调优CNN网络,固定卷积层(Conv1-5)微调剩余层,区域建议由第3步的RPN生成。

通过该模型进行正向传播和反向传播,计算出网络的所有参数,并最终获取分类器Softmax模型和矩形目标框回归模型。

2.2 测试流程对于一幅测试影像,测试流程如图 4所示。

(1) 整图Conv1-5卷积层计算,提取Conv5层特征图。

(2) 由RPN提取的目标区域进行RoI池化。

(3) RoI池化分两支进行,一支送入目标框回归模型,另外一支进行全连接层FC6-FC8,最后利用Softmax分类器进行分类。

(4) 把第(3)步的结果进行非极大值抑制[18],通过迭代、遍历,消除冗余的框。最后根据参考框置信度识别出目标并框出目标的位置。

3 试验及结果分析 3.1 数据集本研究数据是从遥感影像地图上获取的,搜集裁剪出184幅大小约为500×500像素,空间分辨率为0.27 m的含有车辆目标的影像。对这些影像中的车辆目标进行手工矩形标注,矩形框内是车辆,框外是背景。从中选取标注的120张影像包含有482辆车辆,作为训练集进行训练。剩余的64张影像包含359辆车辆数据,作为测试影像。

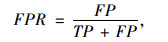

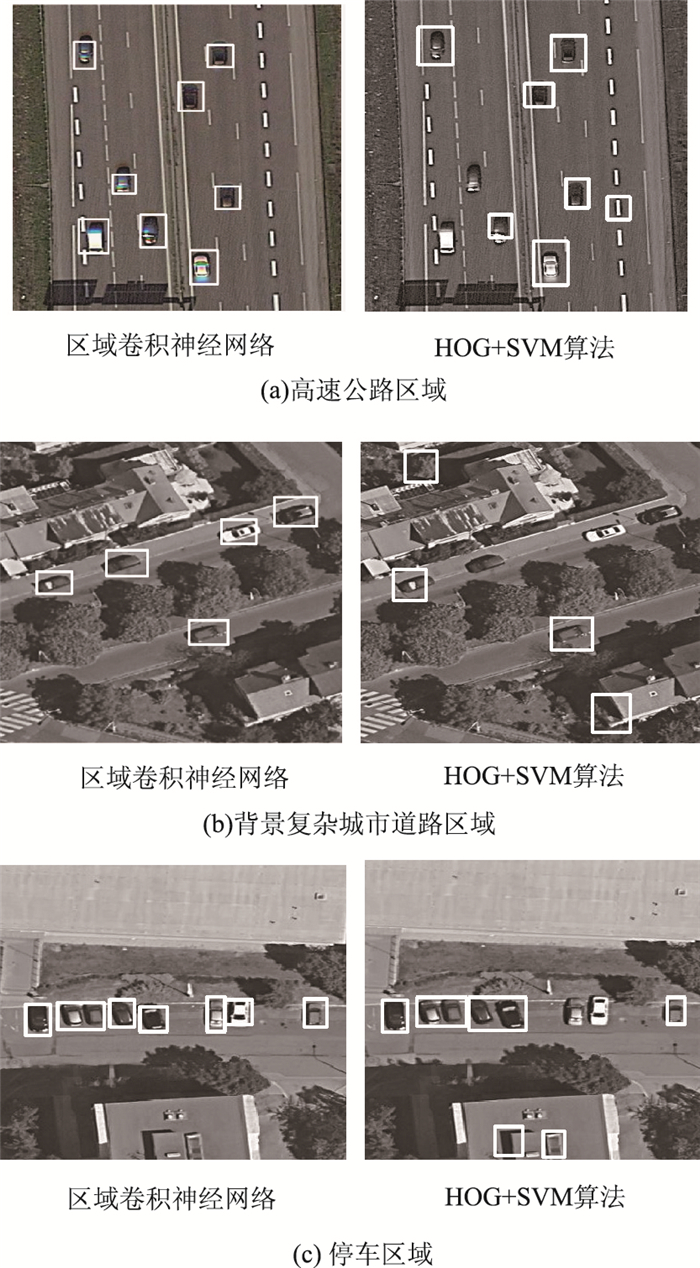

3.2 试验过程本研究选择传统的HOG+SVM算法与区域卷积神经网络模型算法进行比较,具体试验的过程如图 5所示。

|

| 图 5 试验流程 Fig. 5 Process of experimental |

| |

区域卷积神经网络参数设置基本参照Faster R-CNN[16]的设置,将所有网络层的权重学习率设置为1,偏差学习率设置为2,全连接层参数使用高斯分布初始化,标准差为0.01;全局的学习率设置为0.000 1;冲量设置为0.9,权重衰减因子设置为0.000 5。根据反复试验,非极大值抑制的阈值设置为0.3;参考框的置信度设置为0.85。在ImageNet模型参数的基础上进行参数微调,迭代次数50 000次。

HOG+SVM算法按照文献[5]的方法进行试验。

3.3 结果分析对含有359辆车辆数据的64张测试图片进行测试,分别从检测率(DR)、误检率(FPR)和单片平均检测时间3个方面进行评价,评价结果如表 1所示。DR和FPR计算公式为:

| 对比算法 | DR/% | FPR/% | 检测时间/s |

| 区域卷积神经网络 | 88 | 1 | 0.05 |

| HOG+SVM | 70 | 10 | 40 |

|

(1) |

|

(2) |

式中,TP为正确检测出的车辆个数;MP为漏掉的车辆个数;FP为检测错误的车辆个数。

图 6展示了3个不同区域检测结果,其中图 6(a)为高速公路区域,图 6(b)为背景较复杂的城市区域,图 6(c)为停车区域。

|

| 图 6 检测结果 Fig. 6 Detection result |

| |

通过试验,在特征提取方面,区域卷积神经网络每层均能自动提取大量特征,而HOG只能提取出梯度的几个方向的统计特征。由表 1的统计结果,在检测率方面,区域卷积神经网络算法检测率明显高于HOG+SVM算法;在误检率方面,区域卷积神经网络检测明显小于HOG+ SVM算法;在检测的时间方面,同样的一张图像,区域卷积神经网络平均只需要0.05 s,而HOG+SVM却需要40 s,速度提升了800倍。另外,由图 6可以看出, 区域卷积神经网络在3个区域都具有很好的检测效果。

4 结论本研究提出了基于区域的卷积神经网络应用于遥感影像车辆检测,介绍了区域卷积神经网络的基本原理。通过对搜集的数据进行试验,与传统的基于方向梯度直方图(HOG)和支持向量机(SVM)的车辆检测算法进行了比较。结果表明,该算法在检测率、误检率、时间方面,检测效果都远远优于传统的HOG+SVM算法,具有较强的鲁棒性和可靠性。由于时间和精力关系,本研究搜集的数据量较少,缺乏多样性。总之,随着大数据时代的到来,区域卷积神经网络在目标检测方面将具有较好的应用前景。

| [1] |

WANG C C, TTORPE C, SUPPE A. LADAR-based Detection and Tracking of Moving Objects from a Ground Vehicle at High Speeds[C]//Proceedings of IEEE Intelligent Vehicles Symposium, 2003. Columbus, US:IEEE, 2003:416-421.

|

| [2] |

SANG J P, KIM T Y, KANG S M, et al. A Novel Signal Processing Technique for Vehicle Detection Radar[C]//IEEE MTT-S International Microwave Symposium 2003. Philadelphia:IEEE, 2003:607-610.

|

| [3] |

杨正理, 黄其新. 小波变换在行驶车辆检测器中的应用[J]. 公路交通科技, 2013, 30(2): 104-108. YANG Zheng-li, HUANG Qi-xin. Application of Wavelet Transform in Running-vehicle Detectors[J]. Journal of Highway and Transportation Research and Development, 2013, 30(2): 104-108. |

| [4] |

万智萍. 概率匹配和状态预测的不连续空间车辆识别跟踪算法[J]. 公路交通科技, 2014, 31(6): 127-132. WAN Zhi-ping. An Algorithm for Discontinuous Space Vehicle Identification and Tracking Based on Probability Matching and State Prediction[J]. Journal of Highway and Transportation Research and Development, 2014, 31(6): 127-132. |

| [5] |

CAO X, WU C, YAN P, et al. Linear SVM Classification Using Boosting HOG Features for Vehicle Detection in Low-altitude Airborne Videos[C]//201118th IEEE International Conference on Image Processing (ICIP). Brussels:IEEE, 2011:2421-2424.

|

| [6] |

HAN S, HAN Y, HAHN H. Vehicle Detection Method Using Haar-like Feature on Real Time System[J]. World Academy of Science, Engineering and Technology, 2009, 59: 455-459. |

| [7] |

LOWE D G. Object Recognition from Local Scale-invariant Features[C]//Proceedings of the Seventh IEEE International Conference on Computer Vision. Kerkyra, Greece:IEEE, 1999:1150.

|

| [8] |

HE D C, WANG L. Texture Unit, Texture Spectrum and Texture Analysis[J]. IEEE Transactions on Geoscience & Remote Sensing, 1990, 28(4): 509-512. |

| [9] |

吴岸城. 神经网络与深度学习[M]. 北京: 电子工业出版社, 2016. WU An-cheng. Neural Network and Deep Learning[M]. Beijing: Publishing House of Electronics Industry, 2016. |

| [10] |

KRIZHEVSKY A, SUTSKEVER I, HINTON G E. ImageNet Classification with Deep Convolutional Neural Networks[C]//Proceedings of the 25th International Conference on Neural Information Processing Systems. Lake Tahoe, US:NIPS, 2012:1097-1105.

|

| [11] |

TAIGMAN Y, YANG M, RANZATO M, et al. DeepFace:Closing the Gap to Human-level Performance in Face Verification[C]//2014 IEEE Conference on Vision and Pattern Recognition (CVPR). Columbus, US:IEEE, 2014:1701-1708.

|

| [12] |

DENG L, ABDEL-HAMID O, YU D. A Deep Convolutional Neural Network Using Heterogeneous Pooling for Trading Acoustic Invariance with Phonetic Confusion[C]//2013 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP). Vancouver:IEEE, 2013:6669-6673.

|

| [13] |

ZHANG Y, CHAN W, JAITLY N. Very Deep Convolutional Networks for End-to-end Speech Recognition[C]//2017 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP):New Orleans:IEEE, 2017:4845-4849.

|

| [14] |

GITSHICK R, DONAHUE J, DARRELL T, et al. Rich Feature Hierarchies for Accurate Object Detection and Semantic Segmentation[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition[S. l.]:IEEE, 2014:580-587.

|

| [15] |

GIRSHICK R. Fast R-CNN[C]//Proceedings of the IEEE International Conference on Computer Vision. Santiago, Chile:IEEE, 2015:1440-1448.

|

| [16] |

REN S, HE K, GIRSHICK R, et al. Faster R-CNN:Towards Real-time Object Detection with Region Proposal Networks[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2015, 39(6): 1137-1149. |

| [17] |

ZEILER M D, FERGUS R. Visualizing and Understanding Convolutional Networks[M]. Cham: Springer, 2014.

|

| [18] |

NEUBECK A, GOOL L V. Efficient Non-Maximum Suppression[C]//18th International Conference on Pattern Recognition, 2006.Hong Kong:IEEE, 2006:850-855.

|

2018, Vol. 35

2018, Vol. 35