2. 维多利亚大学 应用信息中心, 维多利亚州 墨尔本 VIC 3011

2. Centre for Applied Informatics, Victoria University, Melbourne VIC 3011, Australia

在许多现实应用场景中, 数据样本的维度总是很高. 比如人脸识别[1]、手写字符识别[2]、生物信息学分析[3]、视觉跟踪[4]等[5-7]. 然而高维数据数据量大, 且通常含有大量冗余、噪声, 因此会降低学习算法的性能[8]. 为了解决这些问题, 人们通常采用降维方法对数据进行预处理.

近些年提出了许多降维方法, 可分为特征选择[9]和特征提取[10]两大类. 特征提取通过将数据投影到低维子空间来减少数据维度. 由于低维子空间与原数据样本空间没有直接联系, 提取特征难以对应数据原有特征. 特征选择通过直接选择原数据特征的子集作为降维后的特征. 这能保持数据原有特征, 降维后的数据具有很好的解析性. 这在许多应用中是很重要的, 例如基因分类[11]、文本分类[12]等.

从利用标签信息的角度来看, 特征选择算法可以分为监督学习[13]、半监督学习[14]和无监督学习[15]. 监督学习和半监督学习在某种程度上依赖于标签信息, 通过标签信息评估结果来选择特征. 然而, 许多实际应用是在没有标签的情况下收集大规模数据. 标记这些无标签数据非常昂贵且耗时[16]. 因此, 无监督特征选择对于许多实际应用更具普遍性和挑战性.

Cai等[17]提出了多簇特征选择(MCFS), 通过谱分析捕获局部流形结构, 然后选择能够最好地保留聚类结构的特征. Nie等[18]提出了灵活流形嵌入(FME), FME作为降维的一般框架, 被许多特征选择方法所采用. Hou等[19]基于FME和

因此本文通过结合低秩子空间学习和自适应图嵌入方法, 提出了一个联合低秩表示与图嵌入的无监督特征选择方法. 本文主要贡献在于: (1)提出了一种保留选择特征局部结构方法, 同时考虑到选择特征的低秩子空间, 使其选择特征后数据具有低秩性质, 从而提高方法的鲁棒性; (2)选择特征的局部结构自适应学习, 无需预先计算, 从而选择最合适模型的局部结构.

1 相关工作 1.1 低秩子空间学习低秩表示假设原始数据可分解成多个独立子空间来近似表示, 从而发现数据本质结构中, 其子空间最低秩的表示[24]. 给定数据集

| $\mathop {\min }\limits_{{Z}} \begin{array}{*{20}{c}} {} \end{array}{\rm{rank}} ({{{\rm Z}}})\begin{array}{*{20}{c}} {}&{} \end{array}{\rm{s} .\rm{t}.}\begin{array}{*{20}{c}} {}&{{{X}} = {{DZ}}}. \end{array}$ | (1) |

上述问题是NP难问题, 难以直接求解. Candès等[25]通过使用核范数来代替低秩约束, 可转换为如下凸优化问题:

| $\mathop {\min }\limits_{{Z}} \begin{array}{*{20}{c}} {} \end{array}||{{Z}}|{|_*}\begin{array}{*{20}{c}} {}&{} \end{array}{\rm{s} .\rm{t}.}\begin{array}{*{20}{c}} {}&{{{{X}} = {{DZ}}}} . \end{array}$ | (2) |

其中

| $\mathop {\min }\limits_{{Z}} \sum\limits_i^n {||{{{x}}_i} - {{X}}{{{z}}_i}|{|^2} + \alpha ||{{Z}}|{|_*}}, $ | (3) |

其中

随着谱分析和流形学习的发展, 许多无监督特征选择方法通过保留样本间的局部流形结构均取得较好的结果. 这表明局部结构在特征选择过程中具有重要作用. 本文利用自适应过程来确定保持局部关系的相似矩阵. 给定数据集

| $\mathop {\min }\limits_{{{p}}_i^{\rm{T}}{{{\textit{1}}}_n} = 1,0 \leqslant {p_{ij}} \leqslant 1} \sum\limits_{ij} {(||{{{x}}_i} - {{{x}}_j}|{|^2}{p_{ij}} + \mu p_{ij}^2{\rm{)}}}, $ | (4) |

其中

此处, 给出本文使用的符号. 矩阵

根据上述子空间学习方法和自适应局部结构学习方法, 由式(3)和式(4)可得:

| $\left\{\begin{aligned} &\mathop {\min }\limits_{{{Z}},{{P}}} \sum\limits_i^n {||{{{x}}_i} - {{X}}{{{z}}_i}|{|^2} + \alpha ||{{Z}}|{|_*}} +\\ &\quad\beta \sum\limits_{ij}^n {||{{{x}}_i} - {{{x}}_j}|{|^2}{P_{ij}} + \mu {P_{ij}^2}}. \\ &{\rm{s} .\rm{t}.}\qquad{{P}}{{{\textit{1}}}_n} = {{{\textit{1}}}_n},{{P}} > 0. \end{aligned} \right.$ | (5) |

式(5)中, 第一部分为低秩子空间学习,

根据式(5), 本文提出一种联合低秩表示与图嵌入的无监督特征选择学习, 如式(6)所示:

| $\left\{\begin{split} &\mathop {\min }\limits_{{{W}},{{Z}},{{P}}} \sum\limits_i^n {||{{{W}}^{\rm{T}}}{{{x}}_i} - {{{W}}^{\rm{T}}}{{X}}{{{z}}_i}|{|^2} + \alpha ||{{Z}}|{|_*}} + \\ &\beta \sum\limits_{ij}^n {||{{{W}}^{\rm{T}}}{{{x}}_i} - {{{W}}^{\rm{T}}}{{{x}}_j}|{|^2}{P_{ij}} + \mu {P_{ij}}^2} + \gamma ||{{W}}|{|_{2,1}}. \\ &{\rm{s} .\rm{t}.}\qquad{{P}}{{{\textit{1}}}_n} = {{{\textit{1}}}_n},{{P}} > 0,{{{W}}^{\rm{T}}}{{X}}{{{X}}^{\rm{T}}}{{W}} = {{I}}. \end{split} \right.$ | (6) |

其中

式(6)中

| $\left\{\begin{split} &\Gamma ({{W}}{\rm{,}}{{S}}{\rm{,}}{{P}}{\rm{,}}{{Q}}{\rm{,}}{{T}}{\rm{,}}{{{Y}}_1}{\rm{,}}{{{Y}}_2}{\rm{,}}{{{Y}}_3}{\rm{,}}{\mu _1}) = ||{{{W}}^{\rm{T}}}{{X}} - {{{W}}^{\rm{T}}}{{XZ}}||_{\rm{F}}^2 + \\ &\alpha ||{{T}}|{|_*} + \beta \sum\limits_{ij}^n {||{{{W}}^{\rm{T}}}{{{x}}_i} - {{{W}}^{\rm{T}}}{{{x}}_j}|{|^2}{P_{ij}} + \mu {P_{ij}}^2} + \\ & \gamma ||{{W}}|{|_{2,1}} + < {{{Y}}_1},{{P}}{{{\textit{1}}}_n} - {{{\textit{1}}}_n} > + < {{{Y}}_2},{{P}} - {{Q}} > + \\ &< {{{Y}}_3},{{Z}} - {{T}} > + \frac{{{\mu _1}}}{2}(||{{P}}{{{\textit{1}}}_n} - {{{\textit{1}}}_n}||_{\rm{F}}^2 + ||{{P}} - {{Q}}||_{\rm{F}}^2 + ||{{Z}} - {{T}}||_{\rm{F}}^2).\\ & {\rm{s} .\rm{t}.}\qquad{{{W}}^{\rm{T}}}{{X}}{{{X}}^{\rm{T}}}{{W}} = {{I}},{{Q}} > 0. \end{split} \right.$ | (7) |

其中

IALM在求解最小值过程中, 在每一步中更新一个变量, 同时固定其他变量不变. 并依次迭代更新所有变量直到收敛. 主要的求解步骤如下:

1) 更新

| $\frac{{{{({{X}}{{{X}}^{\rm{T}}})}^{ - 1}}({{{G}}^{\rm{T}}} + {{G}})}}{2}{{W}} = {{\varLambda W}},$ | (8) |

其中

| ${D_{{W_{ii}}}} = \frac{1}{{2||{{{W}}_i}|{|_2}}},$ | (9) |

2) 更新

| ${{{Z}}^*} = {({{F}} + {\mu _1}{{I}})^{ - 1}}{{F}} - {{T}}{\mu _1} - {{{Y}}_3},$ | (10) |

其中

3) 更新

| ${{{P}}^*} = \frac{{{E}}}{{2\mu + {\mu _1}}}{\left({{I}} + \frac{{{\mu _1}}}{{2\mu + {\mu _1}}}{{{\textit{1}}}_n}{{\textit{1}}}_n^{\rm{T}}\right)^{ - 1}},$ | (11) |

其中

| $\begin{split}&{{E}} = ({\mu _1}{{{\textit{1}}}_n}{{\textit{1}}}_n^{\rm{T}} + {\mu _1}{{Q}} - \beta {{B}} - {{{Y}}_1}{{\textit{1}}}_n^{\rm{T}} - {{{Y}}_2}),\\ &{B_{ij}} = ||{{{W}}^{\rm{T}}}{{{x}}_i} - {{{W}}^T}{{{x}}_j}|{|^2}.\end{split} $ |

4) 更新

| ${{{T}}^*} = {\upsilon _{1/{\mu _1}}}\left({{Z}} + \frac{{{{{Y}}_3}}}{{{\mu _1}}}\right),$ | (12) |

其中

5) 更新

| ${{Q}}{\rm{*}} = \max \left({{P}} + \frac{{{{{Y}}_2}}}{{{\mu _1}}},0\right).$ | (13) |

6) 最后更新拉格朗日乘子和惩罚参数:

| ${{{Y}}_1} = {{{Y}}_1} + {\mu _1}({{P}}{{{\textit{1}}}_n} - {{{\textit{1}}}_n}).$ | (14) |

| ${{{Y}}_2} = {{{Y}}_2} + {\mu _1}({{P}} - {{Q}}).$ | (15) |

| ${{{Y}}_3} = {{{Y}}_3} + {\mu _1}({{Z}} - {{T}}).$ | (16) |

| ${\mu _1} = \min ({\mu _{\max }},\rho {\mu _1}).$ | (17) |

其中

上述优化过程中时间复杂度分析如下: 第1步为特征值分解问题, 其运算矩阵的大小

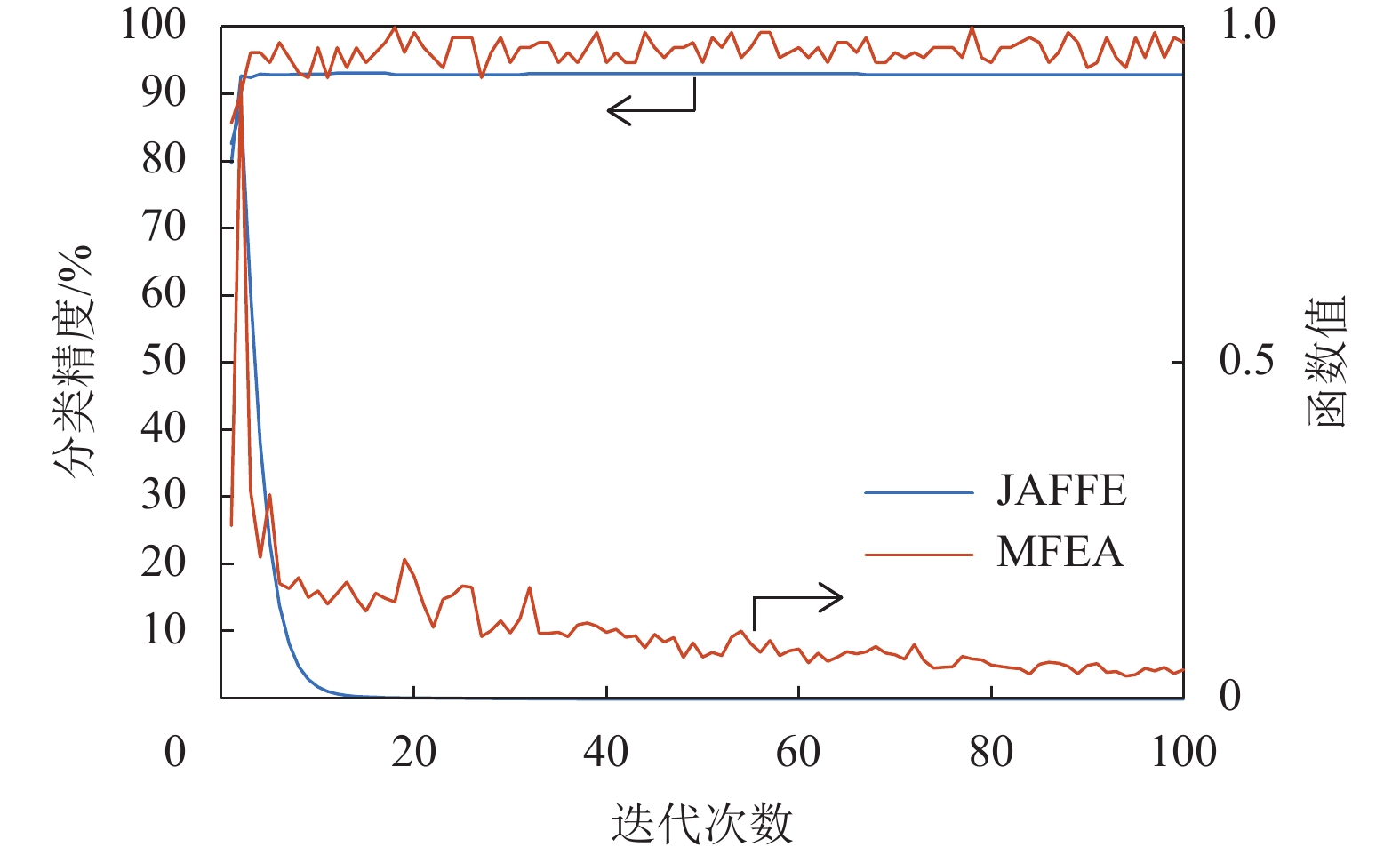

在本节中, 将JLRRGE运行1-最近邻分类器(NN). 在2个数据集上运行本文所提方法, 以显示其收敛性质, 包括JAFFE 和MFEA数据集. 当所有变量和分类准确率都稳定, 则该算法趋于收敛. 在上述优化过程中, 使用变量

| ${\rm{obj}} = {\rm{||}}{{P}} - {{Q}}{\rm{|}}{{\rm{|}}_{\rm{F}}} + ||{{Z}} - {{T}}|{|_{\rm{F}}}.$ | (18) |

在上述两个数据集上运行本文所提方法并进行100次迭代, 并在图1中显示了目标函数值、分类精度和迭代之间的关系.

|

图 1 数据集JAFFE和MFEA收敛性实验 Figure 1 Convergence experiments on JAFFE and MFEA datasets |

由图1可知, 随着迭代次数的增加, 目标函数整体上不断减少且分类准确率整体上不断升高, 并在一定迭代次数后趋于稳定. 在JAFFE数据集中目标函数值先上升后下降, 可能是由于在优化过程中, 随机初值所造成的影响. 总体而言, 由目标函数值和分类准确率曲线可知本文提出的方法具有较强的鲁棒性, 能够快速逼近局部最优解, 并具有良好的收敛性.

3 实验本文所提出的JLRRGE将与4种具有代表性的特征选择算法如拉普拉斯评分的特征选择(Laplacian Score, LS)、多类簇特征选择(MCFS)、无监督判别特征选择(UDFS)和最优结构图的特征选择(SOGFS)进行详细对比.

3.1 实验数据集本文使用以下5个常用数据集, 如表1所示.

| 表 1 数据集信息 Table 1 Summary of the benchmark data sets |

COIL数据集包含20个对象, 每个对象有72个样本, 共1 440个样本. 样本以5度为间隔从同方向进行捕获, 所有图像被调整为1 024个像素.

ORL数据集包含40个对象, 每个对象拍摄10幅图片, 共400张图. 每个对象在不同的时间、光照、面部表情(睁/闭眼、微笑/不微笑)和面部细节(是否戴眼镜)下拍摄, 所有图像被调整为

JAFFE数据集包含213张7种面部表情的图像, 包括6种基本面部表情和1种中性表情.

UMIST数据集包含575张20人的图像. 每个人从侧面到正面都摆出一系列姿势, 而且他们来自不同的种族. 这些文件都是PGM格式, 灰度为256个阴影.

MFEA数据集包含一系列的手写数字(0~9), 这些数字是从一组荷兰实用地图中提取的. 一幅图像的大小为15×16像素.

3.2 参数设置与评价指标本文实验对每个数据集做4组对比实验. 每组实验在每一类中分别随机抽取10%、20%、30%和40%作为训练样本, 其余作为测试样本. 在训练过程中, 每组实验选取特征数目分别为c = {10, 20, 30, 40, 50, 60, 70, 80, 90, 100}. 最终结果运行在1-最近邻分类器(NN)中验证本文算法的性能.

对于LS和MCFS算法生成的近邻矩阵时, 参数k统一设置为5. LS热核计算权重矩阵

此外, 算法的鲁棒性也是需要考虑的范畴. 由算法目标函数可知, 参数

|

图 2 各数据集的参数敏感实验 Figure 2 Parameter sensitivity on different datasets |

由表2可知, JLRRGE在随机抽取20%的训练样本的实验中, 比MCFS的分类效果略差. 其余情况均取得较好的分类结果, 且整体分类效果比其他对比算法好.

| 表 2 不同算法在COIL数据集上的分类准确率 Table 2 Aggregated classification results measured by accuracy of the compared methods on COIL % |

由图2(a)可知, 当

由表3可知, 除了在抽取20%作为训练样本的情况, JLRRGE均取得最好的分类结果.

由图2(b)可知, 当

| 表 3 不同算法在ORL数据集上的分类准确率 Table 3 Aggregated classification results measured by accuracy of the compared methods on ORL % |

由表4可得, JLLRGE在JAFFE数据集上, 对于不同百分比的训练样本, 均取得较好的效果.

| 表 4 不同算法在JAFFE数据集上的分类准确率 Table 4 Aggregated classification results measured by accuracy of the compared methods on JAFFE % |

由图2(c)可得, 当

由表5可知, JLRRGE的整体分类性能略差于MCFS, 仅在随机抽取10%训练样本的情况下取得较好的分类结果.

| 表 5 不同算法在UMIST数据集上的分类准确率 Table 5 Aggregated classification results measured by accuracy of the compared methods on UMIST % |

由图2(d)可得, 当

由表6可得, JLRRGE在各情况下均取得较好的分类结果.

| 表 6 不同算法在MFEA数据集上的分类准确率 Table 6 Aggregated classification results measured by Accuracy of the compared methods on MFEA % |

由图2(e)可得, 当

本文提出了一种新颖的无监督特征选择方法. 通过低秩表示选择具有低秩结构的特征, 使选择的特征更具鲁棒性. 同时结合图嵌入方法, 自适应学习数据的局部相似性矩阵, 使数据降维后仍保留其局部流形结构. 实验表明, 本文所提的方法比其他对比方法在绝大部分情况下均取得更好的分类结果, 并且该方法具有良好的鲁棒性. 在未来将尝试优化模型的复杂度, 减少模型的训练时间.

| [1] |

XU Y, FANG X Z, LI X L, et al. Data uncertainty in face recognition[J].

IEEE Transactions on Cybernetics, 2014, 44(10): 1950-1961.

DOI: 10.1109/TCYB.2014.2300175. |

| [2] |

YAO C, CHENG G. Approximative bayes optimality linear discriminant analysis for Chinese handwriting character recognition[J].

Neuro-computing, 2016, 207: 346-353.

|

| [3] |

FEI L K, ZHANG B, ZHANG W, et al. Local apparent and latent direction extraction for palm-print recognition[J].

Information Sciences, 2019, 473: 59-72.

DOI: 10.1016/j.ins.2018.09.032. |

| [4] |

LAN X, MA A J, YUEN P C, et al. Joint sparse representation and robust feature-level fusion for multicue visual tracking[J].

IEEE Transactions on Image Processing, 2015, 24(12): 5826-5841.

DOI: 10.1109/TIP.2015.2481325. |

| [5] |

FANG X Z, HAN N, WU J G, et al. Approximate low-rank projection learning for feature extraction[J].

IEEE Transactions on Neural Networks and Learning Systems, 2018, 29(11): 5228-5241.

DOI: 10.1109/TNNLS.2018.2796133. |

| [6] |

滕少华, 郑明, 刘冬宁. 面向音乐推荐的全变差图非负矩阵分解方法[J].

计算机应用研究, 2018, 35(4): 1010-1013.

TENG S H, ZHENG M, LIU D L. Facing music recommended total variation non-negative matrix decomposition method[J]. Application Research of Computers, 2018, 35(4): 1010-1013. DOI: 10.3969/j.issn.1001-3695.2018.04.011. |

| [7] |

滕少华, 宋欢, 霍颖翔, 等. 一种增量式学习的语音字典构造方法[J].

广东工业大学学报, 2018, 35(3): 29-36.

TENG S H, SONG H, HUO Y X, et al. An incremental learning approach in voice compression via sparse dictionary learning[J]. Journal of Guangdong University of Technology, 2018, 35(3): 29-36. DOI: 10.12052/gdutxb.180043. |

| [8] |

JA IN, DU IN, MAO J. Statistical pattern recognition: a review[J].

IEEE Transactions on Pattern Analysis & Machine Intelligence, 2002, 27(11): 1502-1502.

|

| [9] |

FANG X Z, XU Y, LI X L, et al. Locality and similarity preserving embedding for feature selection[J].

Neurocomputing, 2014, 128: 304-315.

DOI: 10.1016/j.neucom.2013.08.040. |

| [10] |

滕少华, 卢东略, 霍颖翔, 等. 基于正交投影的降维分类方法研究[J].

广东工业大学学报, 2017, 34(3): 1-7.

TENG S H, LU D L, HUO Y X, et al. Classification method based on dimension reduction[J]. Journal of Guangdong University of Technology, 2017, 34(3): 1-7. DOI: 10.12052/gdutxb.170008. |

| [11] |

IMOTO S, MIVANO S. A top-r feature selection algorithm for microarray gene expression data[J].

IEEE/ACM Transactions on Computational Bi-ology and Bioinformatics, 2012, 9(3): 754-764.

DOI: 10.1109/TCBB.2011.151. |

| [12] |

SHANG C, LI M, FENG S, et al. Feature selection via maximizing global information gain for text classification[J].

Knowledge-Based Systems, 2013, 54: 298-309.

DOI: 10.1016/j.knosys.2013.09.019. |

| [13] |

NIE F P, HUANG H, CAI X, et al. Efficient and robust feature selection via joint ℓ2, 1-norms minimization[C]//Advances in Neural Information Processing Systems 23: 24th Annual Conference on Neural Information Processing Systems 2010. Proceedings of a meeting held 6-9 December 2010, Vancouver, British Columbia, Canada. Curran Associates Inc. 2010.

|

| [14] |

FANG X Z, XU Y, LI X, et al. Robust semi-supervised subspace clustering via non-negative low-rank representation[J].

IEEE Transactions on Cybernetics, 2016, 46(8): 1828-1838.

DOI: 10.1109/TCYB.2015.2454521. |

| [15] |

ZHU X F, LI X L, et al. Robust joint graph sparse coding for unsupervised spectral feature selection[J].

IEEE Transactions on Neural Networks and Learning Systems, 2017, 6(28): 1263-1275.

|

| [16] |

CHENG Q, ZHOU H, CHENG J. The fisher-markov selector: fast selecting maximally separable feature subset for multiclass classification with applications to high-dimensional data[J].

IEEE Transactions on Software Engineering, 2011, 33(6): 1217-1233.

|

| [17] |

CAI D, ZHANG C, HE X. Unsupervised feature selection for multi-cluster data[C]//ACM SIGKDD International Conference on Knowledge Discovery & Data Mining. USA, Washington, DC: ACM, 2010.

|

| [18] |

NIE F P, XU D, TSANG W H, et al. Flexible manifold embedding: a framework for semi-supervised and unsupervised dimension reduction[J].

IEEE Transactions on Image Processing, 2010, 19(7): 1921-1932.

DOI: 10.1109/TIP.2010.2044958. |

| [19] |

HOU C P, NIE F P, LI X L, et al. Joint embedding learning and sparse regression: a framework for unsupervised feature selection[J].

IEEE Transactions on Cybernetics, 2013, 44(6): 793-804.

|

| [20] |

LI Z, YANG Y, LIU J, et al. Unsupervised feature selection using nonnegative spectral analysis [C]∥Proceedings of 26th AAAI Conference on Artificial Intelligence. Toronto: AAAI Press, 2012: 1026-1032.

|

| [21] |

QIAN M, ZHAI C. Robust unsupervised feature selection[C]//International Joint Conference on Artificial Intelligence. China, Beijing: ACM, 2013.

|

| [22] |

SHI L, DU L, SHEN Y D. Robust spectral learning for unsupervised feature selection[C]//IEEE International Conference on Data Mining. China, Shenzhen: IEEE, 2015.

|

| [23] |

NIE F P, ZHU W, Li X L. Unsupervised feature selection with structured graph optimization[C]//Thirtieth Aaai Conference on Artificial Intelligence. USA, Phoenix: AAAI Press, 2016.

|

| [24] |

WEN J, HAN N, FANG X Z, et al. Low-rank preserving projection Via graph regularized reconstruction[J].

IEEE Transactions on Cybernetics, 2018: 1-13.

|

| [25] |

CANDES E J, RECHT B. Exact matrix completion via convex optimization[J].

Foundations of Computational Mathematics, 2009, 9(6): 717.

DOI: 10.1007/s10208-009-9045-5. |

2019, Vol. 36

2019, Vol. 36