2. 东莞理工学院 电子工程与智能化学院,广东 东莞 523808;

3. 西藏民族大学 信息工程学院,陕西 咸阳 712082

2. School of Electrical Engineering & Intelligentization, Dongguan University of Technology, Dongguan, 523808, China;

3. School of Information Engineering, Xizang Minzu University, Xianyang, 712082, China

艺术字体的商业化应用,对纹理细节及清晰度都有较高要求。由于字体渲染风格的多样性,以及纹理的复杂性,目前的艺术字体的特效渲染技术难以将源字体的特效风格有效渲染到目标字体上。起初,艺术字体的渲染均是通过人工逐字设计完成的,不仅设计成本高,而且耗时长。Yang等[1]提出了基于统计学的字体特效渲染方法,该方法将文字的骨架与渲染风格的空间分布作为目标函数的约束条件[2-3],来指导特效的纹理合成。该方法在某些具有平面特效的艺术字渲染上能达到不错的效果,但是由于特效纹理受到文字骨架的限制,当需要生成立体及阴影效果或是与骨架无关的渲染特效时,目标函数无法有效提取纹理风格的特征,使得渲染生成的艺术字体效果差强人意。除此之外,该方法生成特效字需要进行逐字迭代渲染,其效率也不高。

目前艺术字体渲染所存在的问题主要体现在以下两点:一是部分纹理特效复杂,运用统计学方法难以有效合成;二是依靠单一深度学习神经网络生成的字体特效渲染图片由于欠缺清晰化的约束条件,存在输出模糊的问题。

生成式对抗网络(Generative Adversarial Networks,GAN)[4]能通过对输入图片样本分布的学习,生成与样本分布相似的图片。由于GAN网络具有强大的图片特征学习能力[5],许多改进GAN网络被相继提出用于图片转换与生成。深度卷积生成式对抗网络(Deep Convolutional Generative Adversarial Networks,DCGAN)在无监督学习中提取特征时具有优良的特性,但其不提供图像输出模板,使得模型只能生成杂乱的图片[6]。现有的图像翻译网络,例如条件生成式对抗网络(Conditional Generative Adversarial Networks,CGAN)[7]和CycleGAN(Cycle-Consistent Adversarial Networks)[8],iGAN(interactive image Generative Adversarial Networks)[9]等,其网络结构能借助损失函数来约束模型的训练,学习输入图像与输出图像间的映射关系[10]。相比于DCGAN,图像翻译网络由无监督学习转向半监督学习,以成对的图像数据集作为输入以便进行图像翻译。

但图像翻译网络生成的图像较为模糊,目前主要有6种方法提升图片清晰度。Li等[11]通过改进归一化方法以及Johnson等[12-13]提出的基于高频卷积信息的损失函数等手段来加快模型的收敛,从而可以更好地提取和判断特征,使得生成的图像更加为人眼视觉所接受。He等[14]在神经网络结构的基础上提出了残差网络(Resnet),该结构允许将前一层信息直接传输到后面的层中,实验表明残差结构极大地加快了网络的训练。Google提出的inception结构,通过使用不同大小卷积核来获取不同的感受野,实验表明该结构对判别网络有较大提升[15-16]。以上改进方法使得图像翻译网络可以更好地提取特征、加快模型的收敛,但依旧没有解决图片模糊的问题。

本文将图像翻译网络应用于艺术字体的特效渲染中。借助CGAN网络的图像翻译优势,本文提出了二阶段式的艺术字体渲染处理方法。首先,风格化网络能对多样化的字体输入进行处理,生成各种不同特效的渲染字体图;然后,清晰化网络则可对生成的特效字体图进行清晰化处理。

实验结果表明,与单一的CGAN网络相比,本文方法不仅可生成不同2D(火焰,霓虹等)或3D(冰与阴影等)特效的艺术字体,纹理细节较为丰富,不受限于文字骨架,而且字体清晰度也得到较大提升,从而克服单一图像翻译网络生成图模糊的缺陷。

而CycleGAN在艺术字体的渲染过程中,使用非配对的数据集训练得到一个循环结构,虽可同时生成由原文字图片到渲染文字图片间的映射模型以及由渲染文字图片到原文字图片间的映射模型[9],但该网络收敛缓慢,训练效率低,特征提取不够充分,导致生成的特效视觉效果较差。

本文方法对字体的特效渲染批量化处理效率也明显提高,具有较强实用价值。

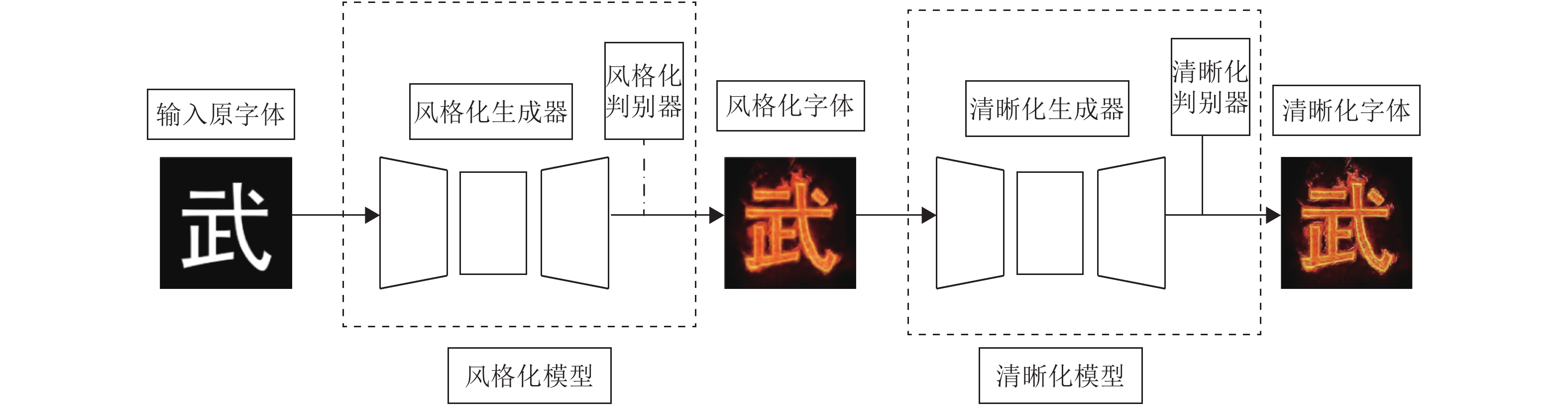

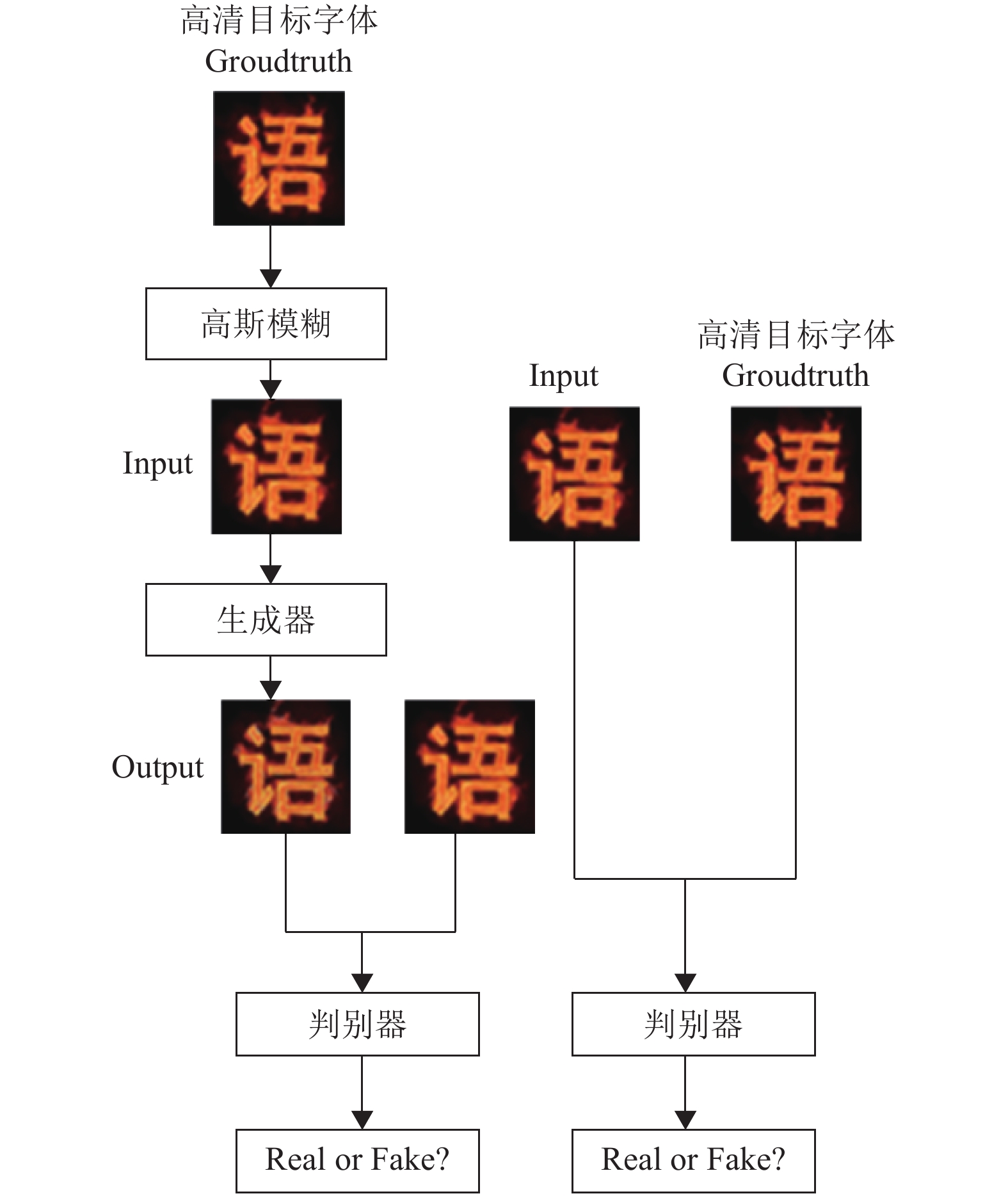

1 艺术字体渲染Two-stage CGAN网络模型 1.1 Two-stage CGAN模型建立艺术字体渲染的原理是利用CGAN网络图像翻译的特性,实现由原字体到艺术字体的风格化映射以及由模糊字体到清晰字体的映射。具体实现方法如图1所示,这是本文提出的基于Two-stage CGAN的艺术字体渲染模型。首先将待渲染字体输入至训练好的风格化CGAN网络模型中;获取通过风格化模型渲染处理后的渲染字体。然后将渲染字体输入至训练好的清晰化CGAN网络模型中;获取通过清晰化模型对渲染字体进行清晰化处理后得到的渲染字体。艺术字渲染模型见图1.

|

图 1 艺术字体渲染模型 Figure 1 Model of font-special-effect-rendering |

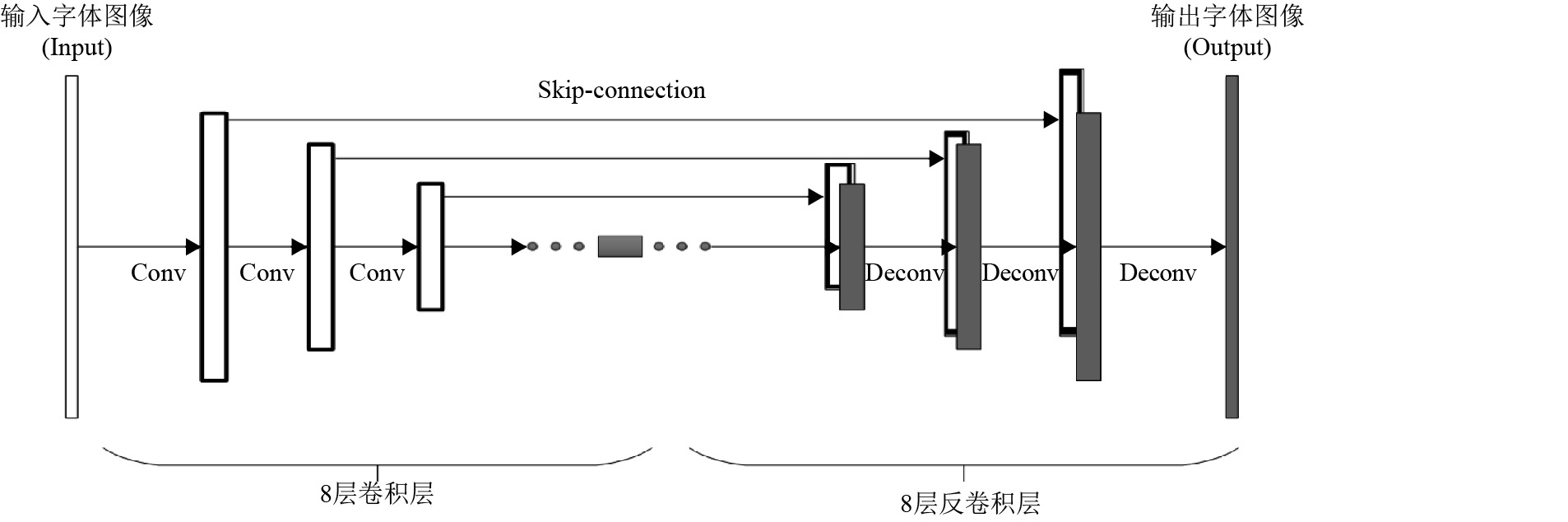

生成器G的网络结构如图2所示,使用了Encoder-decoder结构。首先经过一系列卷积层不断对输入图像提取特征,再通过一系列反卷积层放大至原图大小。生成器G的每一层神经网络由卷积层或反卷积层、归一化层与激活函数层组成。卷积核大小均为4×4,考虑到神经网络在提取特征的过程中随着网络的加深,会逐步丢失一些信息,故生成器加入了U-net结构,相同大小的卷积层与反卷积层直接相连,极大程度减小了信息的损失的同时还可以加快损失函数的收敛。令n为生成器网络层数,网络中增加了第i层与第n-i层之间的跳跃连接(Skip-connection)。本方法中生成器共有8层卷积层与8层反卷积层。

|

图 2 生成器模型 Figure 2 Structure of Generator |

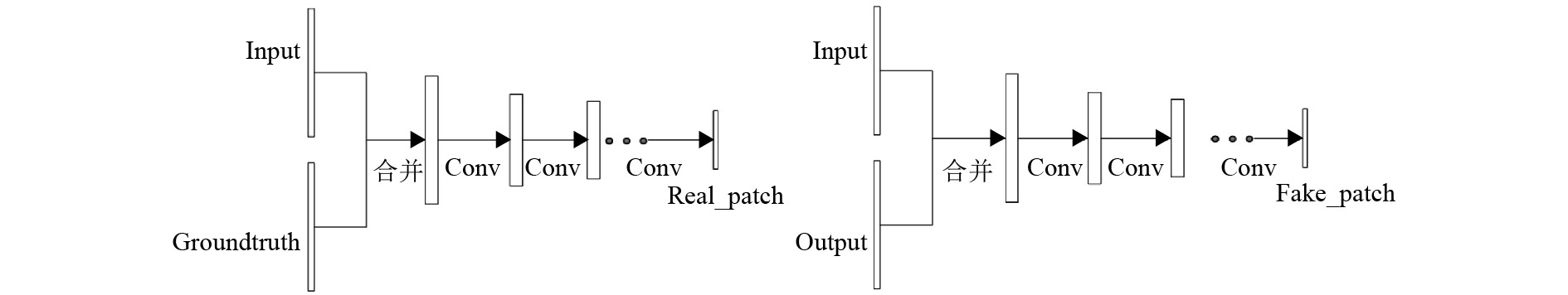

借助L1正则化损失函数,判别器可以很精确地捕获低频信息[7],因此在生成器之外无需再建立一个模拟低频信息的模型。为了模拟Groundtruth的高频信息,判别器网络使用了基于特征图块大小(Feature Map Patch)的5层全卷积网络结构。每一层网络包含一个4×4大小卷积核的卷积层、归一化层与激活层。判别器通过对输入图像不断提取特征,最后输出一张图像块(Patch)。先将生成器生成的图像(Output)与输入图像(Input)合并输入到判别器中得到Fake Patch,再将Groundtruth与Input合并输入到判别器中得到Real Patch。判别器直接对Patch进行判别处理,相比于对原图进行处理的判别器,包含更少的参数,运行更快。在归一化层将Batch Size设为1,每次对单幅图像做归一化操作,减少了参数同时加快模型收敛。当判别器D判别出样本是来自Groundtruth则输出标签为1,而如果判别出样本是来自生成模型生成的图像Output则输出标签为0。判别器结构如图3所示。

|

图 3 判别器结构 Figure 3 Structure of Discriminator |

为了兼顾纹理边缘等高频信息与图像整体内容,风格化网络与清晰化网络均使用基于原始CGAN网络的交叉熵损失函数,以及基于L1距离(L1 distance)的损失函数。Two-stage CGAN网络框架是分开训练的。虽然风格化与清晰化网络均使用交叉熵损失函数。但二者学习目标不同。风格化网络使用交叉熵损失函数衡量复杂的纹理,目的是为了生成具有较好纹理的风格化字体。而清晰化网络使用交叉熵损失函数衡量图像的边缘细节以及清晰度,目标在于生成高清晰度的艺术字。所述基于原始CGAN网络的损失函数表述为

| $ \begin{split} &{L_{{\rm{cGAN}}}}\left( {G,D} \right) = {E_{x,y\sim {\rm Pdata}(x,y)}}[\ln (D(x,y)+{\rm EPS})] + \\ &{E_{x,y\sim {\rm Pdata}(x,y),z\sim {p_z}(z)}}[\ln (1 - D(x,G(x,z))+{\rm EPS})]. \end{split} $ | (1) |

其中,x表示输入生成器的原文字图片;y表示训练字体样本集中的原文字图片对应的渲染特效文字图片;z表示噪声。生成器G要最小化该目标函数。与之相反,判别器D要最大化该目标函数。最终目的是为了训练好的模型能够生成符合样本分布的新数据。为了使得生成器生成图像能更接近Groundtruth,添加一项较为传统的L1正则化损失函数来约束图像的生成,表述为:

| $ {L_{L{\rm{_1}}}}(G) = {E_{x,y\sim {\rm pdata}(x,y),z\sim {p_z}(z)}}[||y - G(x,z)||]. $ | (2) |

综上所述CGAN网络损失函数为:

| $ {G^*} = {\rm{arg }}\mathop {{\rm{min}}}\limits_{{G}} \mathop {\max }\limits_{D} {L_{c \rm GAN}}(G,D) + \lambda {L_{L_1}}(G). $ | (3) |

本文基于CGAN网络构建了艺术字体渲染的风格化与清晰化模型。现提供一种风格化与清晰化二阶段模型的训练方法,包括如下步骤。

步骤1:制作渲染的特效字体样本集。风格化字体样本集包括普通字体图片与普通字体对应的渲染字体图片,为了防止欠拟合导致渲染视觉效果不佳,训练字体样本集中的字体应具有多样性,即尽量选取笔画不重复的字体。本文手工制作并提供3D阴影字体样本集与冰字体样本集。火焰与霓虹字体样本集由传统统计方法制作并提供。CGAN网络结构要求成对的字体样本集A和B。将普通字体样本集记为数据集A,即Input,将渲染的特效字体样本集记为数据集B,即Groundtruth。本文所使用数据集像素大小均为256×256。在网络训练过程中,以A/B配对的方式输入训练集。

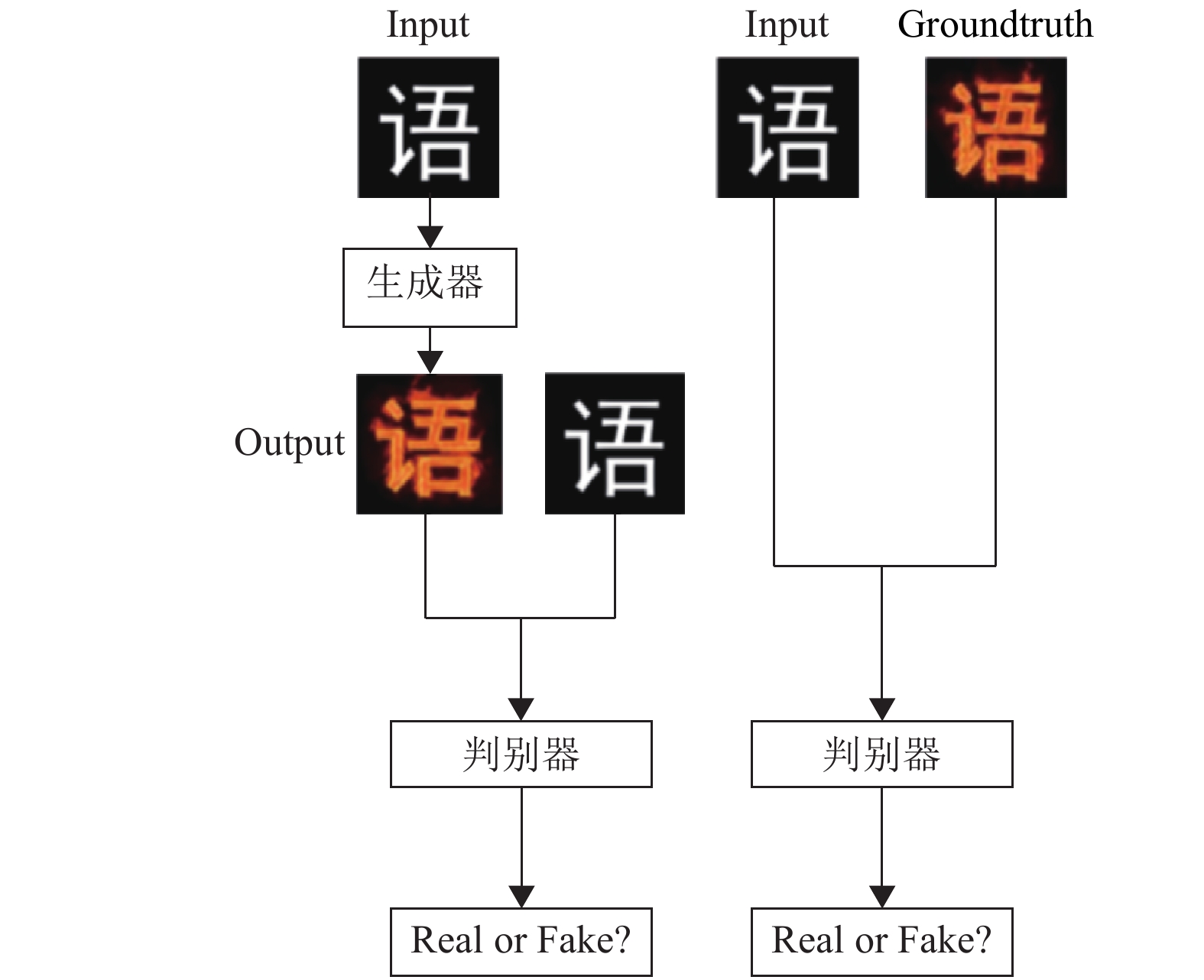

步骤2:一阶段CGAN的训练如图4所示,先输入风格化训练字体样本集至初始CGAN网络模型中进行训练。初始CGAN网络模型中的生成器用于生成普通字体对应的的渲染字体,判别器用于判别生成器生成的普通字体的渲染字体与训练字体样本集中普通字体对应的渲染字体是否一致。在训练过程中,首先判断初始CGAN网络模型的模型训练完成度的值是否在预设范围内,若否,则调整生成器与判别器的网络权重,更新生成器与判别器的损失函数。重复判断初始CGAN网络模型的模型训练完成度的值是否在预设范围内的步骤直至最大迭代次数。若是,则确定初始CGAN网络模型为训练好的风格化CGAN网络模型。

|

图 4 训练风格化网络模型 Figure 4 Training stylized network model |

步骤3:制作清晰化字体样本集。首先制作输出的高清艺术字体图,然后通过高斯模糊算法处理,生成对应的模糊艺术字体图作为输入。与步骤2中描述的CGAN网络训练类似,以模糊艺术字体图作为数据集A,即Input,将数据集A通过对应的高清字体样本集作为目标输出B,即Groundtruth。

步骤4:输入清晰化训练字体样本集至初始CGAN网络模型中进行训练,过程如图5所示。依照步骤2中方法进行判断模型是否训练完成。

|

图 5 训练清晰化网络模型 Figure 5 Training sharpness network model |

二阶段式网络模型由风格化网络模型与清晰化网络模型组成。二者通过不同的数据集分别训练得到。第一阶段CGAN网络主要完成对艺术字进行复杂特效渲染的风格化任务。通过原文字图像与渲染字体图像的图片对作为训练输入,训练完成得到风格化模型。第二阶段CGAN网络完成渲染字体的清晰化。通过高斯模糊算法与高清目标字体配对得到的样本集作为网络的输入,训练好后得到清晰化模型。基于CGAN的单一图像翻译网络在艺术字渲染领域上能够实现复杂纹理的渲染,但是存在无法克服的输出模糊和纹理不够清晰的问题。实验结果表明二阶段式网络模型是必要的。

2.2 艺术字体渲染模型的改进方案 2.2.1 对单一风格化CGAN网络做出的改进对单一风格化CGAN网络以及对二阶段CGAN网络做出改进,并通过实验证明了本文二阶段CGAN网络的有效性,和说明了对CGAN改进的可能性。

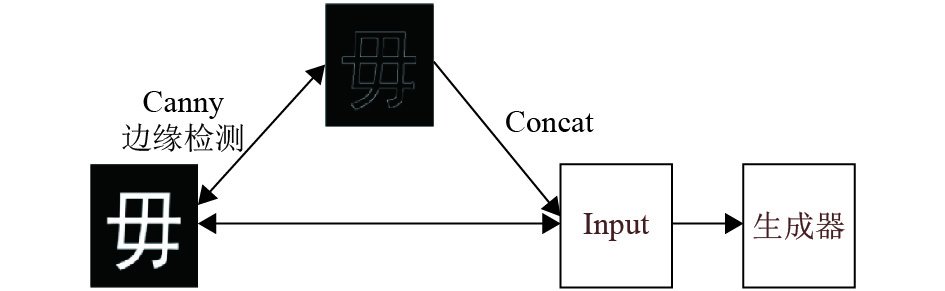

如图6所示,通过Canny边缘检测算子对输入做卷积,得到边缘轮廓,将边缘轮廓与输入(Input)在图像通道上叠加作为生成器的输入。改进后的CGAN网络记为CGAN_add_edge。

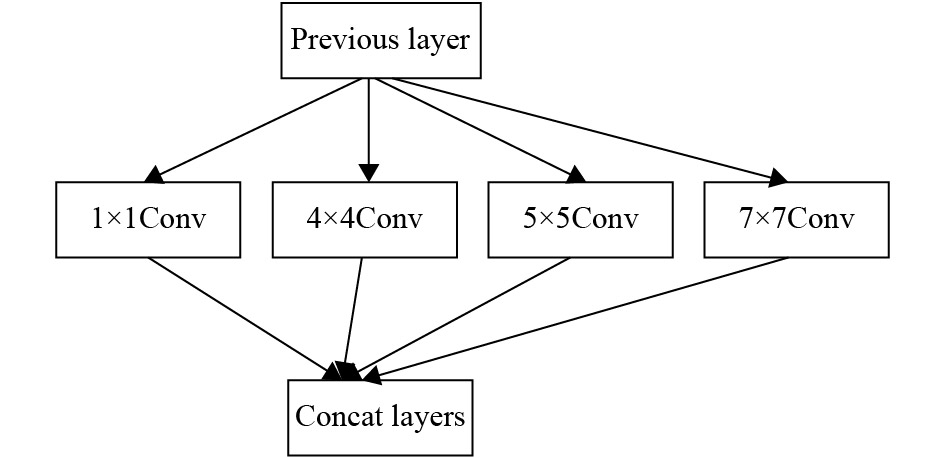

用于构建风格化模型的一般CGAN网络,是由8层卷积层与8层反卷积层组成,每一层的卷积核大小均为4×4。本文提出了一种改进的风格化CGAN网络,记为multi-conv CGAN。该网络可以应用不同大小的卷积核,增强卷积网络的特征学习能力。具体地说,multi-conv CGAN网络的卷积层描述如下。

将卷积层中的第4层、第5层的每一个由原来固定大小的4×4改为由4个大小不同的卷积核(1×1,4×4,5×5,7×7)构成。图7描述了改进后的第4层、第5层网络结构。从图7可以清晰地看到,改进网络中的第4层或第5层都由1×1,4×4,5×5,7×7的4个大小不同的卷积核来构成。

|

图 6 边缘提取模块 Figure 6 Edge extraction module |

|

图 7 风格化网络多卷积结构 Figure 7 Structure of stylized network multi-convolution |

对二阶段CGAN网络的清晰化网络做出改进,只保留清晰化CGAN网络生成器的8层卷积层,去掉高层卷积特征提取,避免因网络层数过深导致参数难以传递,加快了模型收敛。改进的清晰化网络记为Short Two-stage CGAN。

3 实验结果与分析 3.1 实验准备 3.1.1 数据集本文所用到的数据集有火焰、霓虹等2D平面效果的字体样本集,以及冰与阴影等3D立体效果的字体样本集。火焰与霓虹特效数据集,一共由775张普通字体样本与特效字体样本组成,选取550张普通字体样本与火焰字体样本通过预处理得到合并的字体对作为训练样本集。而冰与阴影字体样本集,一共由300张普通字体样本与特效字体样本组成,本文选取200张普通字体样本与火焰字体样本通过预处理得到合并的字体对作为训练样本集。

3.1.2 实验的评价标准 1) 标准a人眼视觉在信息传播和宣传中,特效字更注重的是人眼视觉的效果,而人眼视觉的评判尚未有一个客观量化的标准,因此仅能从主观上判断生成的特效字效果是否模糊、纹理是否清晰以及观感如何。

2) 标准b平均梯度描述一幅图像的梯度图上所有点的均值。它反映了图像中的微小细节反差和纹理变化特征,同时也能反映出图像的清晰度。一般来说平均梯度越大,图像也就越清晰。本文把平均梯度作为模糊程度的评价标准之一,用于评价生成图的视觉效果。

3) 标准c时间效率时效和性能在实际应用及工业需求上是至关重要的,它涉及到字体渲染的成本问题。在比较字体特效渲染的不同方法时,通过计算平均生成单张渲染字体所需的时间来衡量不同方法的时间效率。

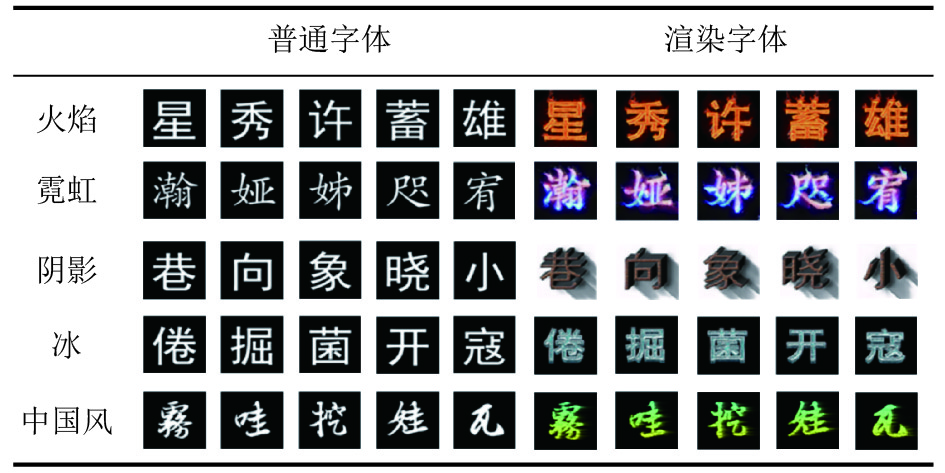

3.2 实验结果图8展示的是普通字体通过本文二阶段式风格化模型与清晰化模型得到的最终结果。通过输入不同的训练集,可以得到不同的风格化与清晰化模型,进而渲染出不同的艺术字体,应用于艺术设计、杂志排版、宣传海报等商业活动中。

|

图 8 艺术字体的特效渲染 Figure 8 Font special effect rendering |

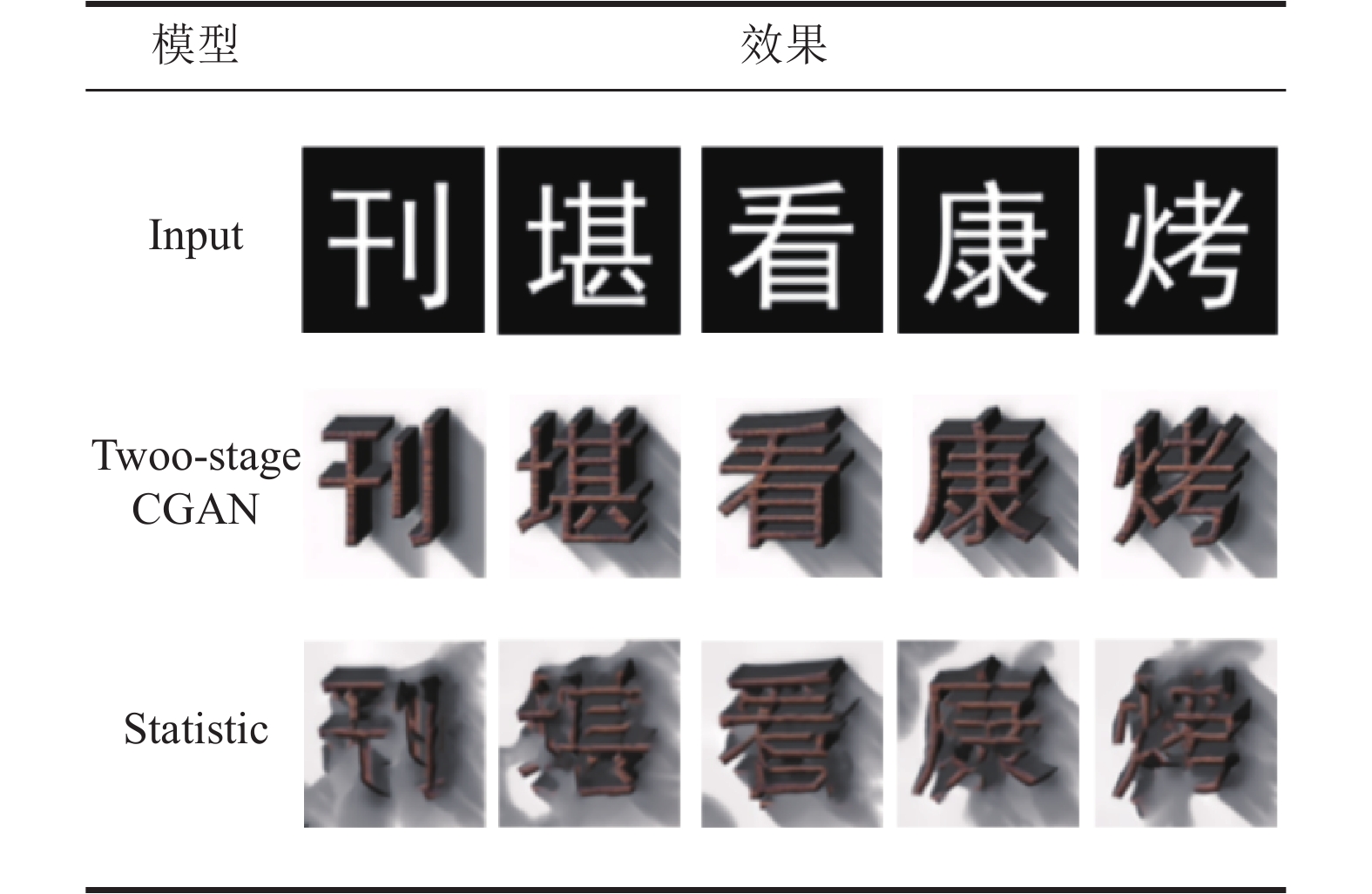

单一的风格化模型会生成模糊的渲染字体,在风格化模型的基础上,通过清晰化数据集训练得到清晰化模型,构建了二阶段式字体渲染网络模型,实现了丰富纹理与高清晰度的效果。本文首先对比5种字体不同方法的视觉效果,然后给出火焰字体与阴影字体的时效性以及平均梯度值的比较,并在文末给出全部字体的综合对比。

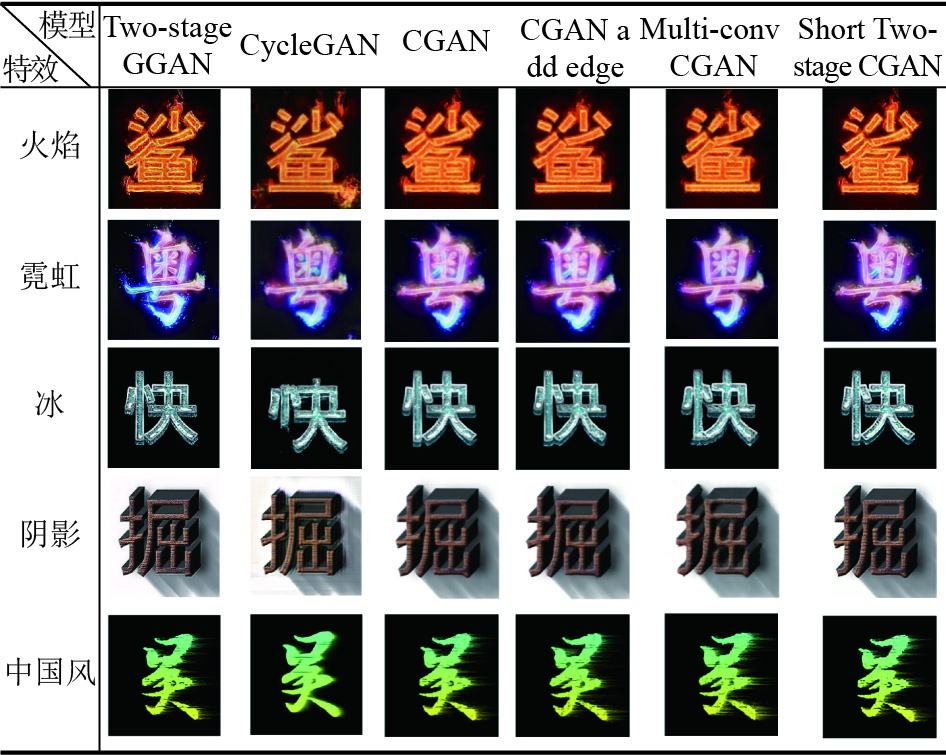

图9对不同模型生成的渲染字体进行比较。通过视觉对比可以看出CycleGAN视觉效果偏暗,纹理效果有待提升,同时整体效果模糊,冰体字的渲染上甚至出现文字框架损坏的结果。一阶CGAN网络[7]纹理较好,但整体来看存在着一定程度的模糊,难以达到实际应用的预期标准。前文所提及基于单一CGAN网络的两种改进方法,包括增加边缘提取信息的CGAN_add_edge以及使用不同大小卷积核的Multi-conv CGAN。这两种改进与一阶CGAN网络相比,均无明显提升。通过对清晰化网络做出改进的二阶段字体渲染网络Short Two-stage CGAN相比本文的Two-stage CGAN方法则稍显模糊。本文提出的二阶段式字体渲染网络输出结果,无论在纹理细节还是整体清晰度方面,相比于其他方法有较大的提升。

|

图 9 二阶段模型与不同风格化模型对比 Figure 9 Two-stage model compared with different stylized model |

实验表明无论是对原CGAN网络结构上的改进或是叠加对输入图像的边缘提取,与原CGAN网络的视觉效果基本相同,依然存在输出模糊与纹理不够清晰的问题。而二阶段的CGAN网络则能较好解决字体模糊的问题。因此,在单一网络的基础上进行第二阶段的清晰化网络的清晰化处理十分必要。经过二阶段式网络处理后,输出的图像不仅具有丰富的特效纹理,而且清晰度也得到较大提高,从而使输出的特效字体达到艺术设计及相关产业的使用标准.

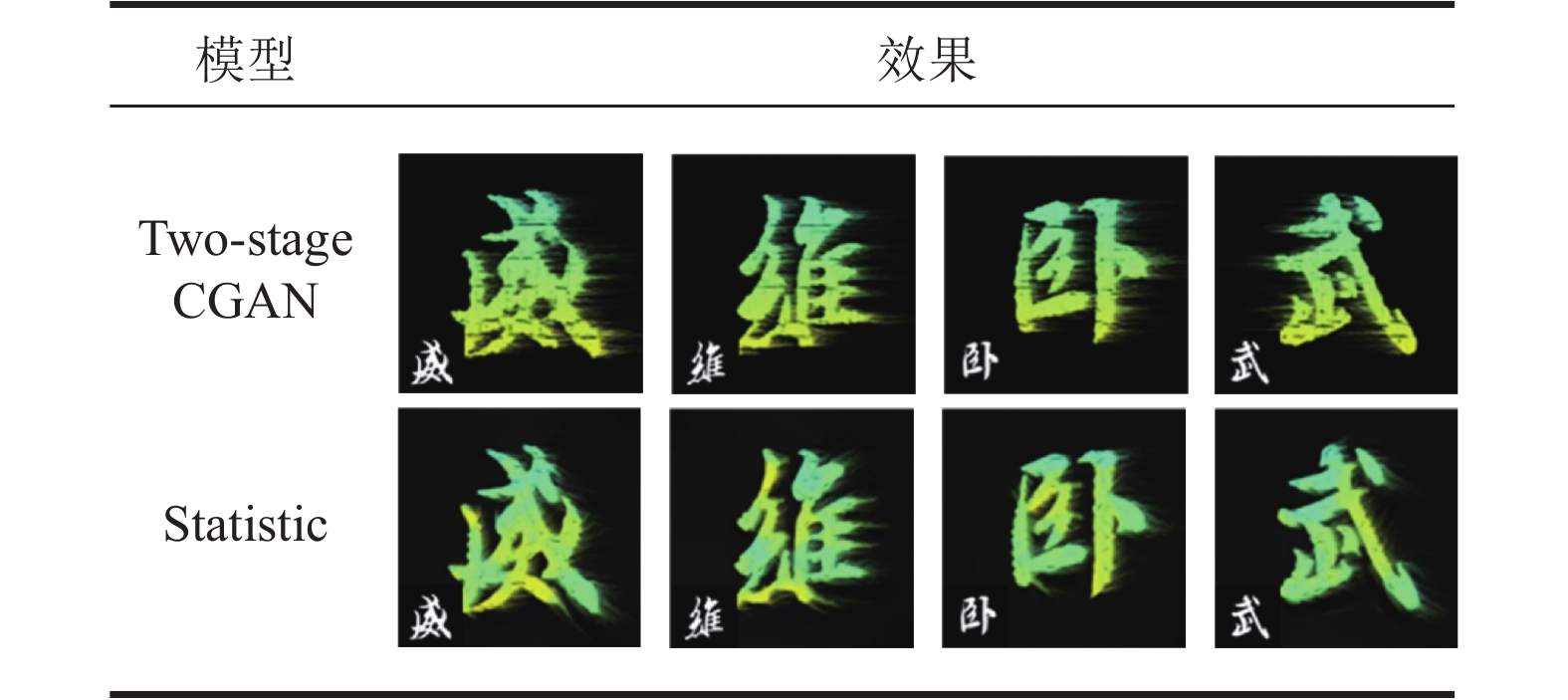

3.4 与统计学方法相比的结果通过对数据集分类,来与Yang等[1]提出的统计学方法做对比。统计学方法提供有火焰、霓虹等2D效果的艺术字体数据集。此外,本文还提供冰、阴影等3D效果与中国风水墨效果等艺术字体数据集。

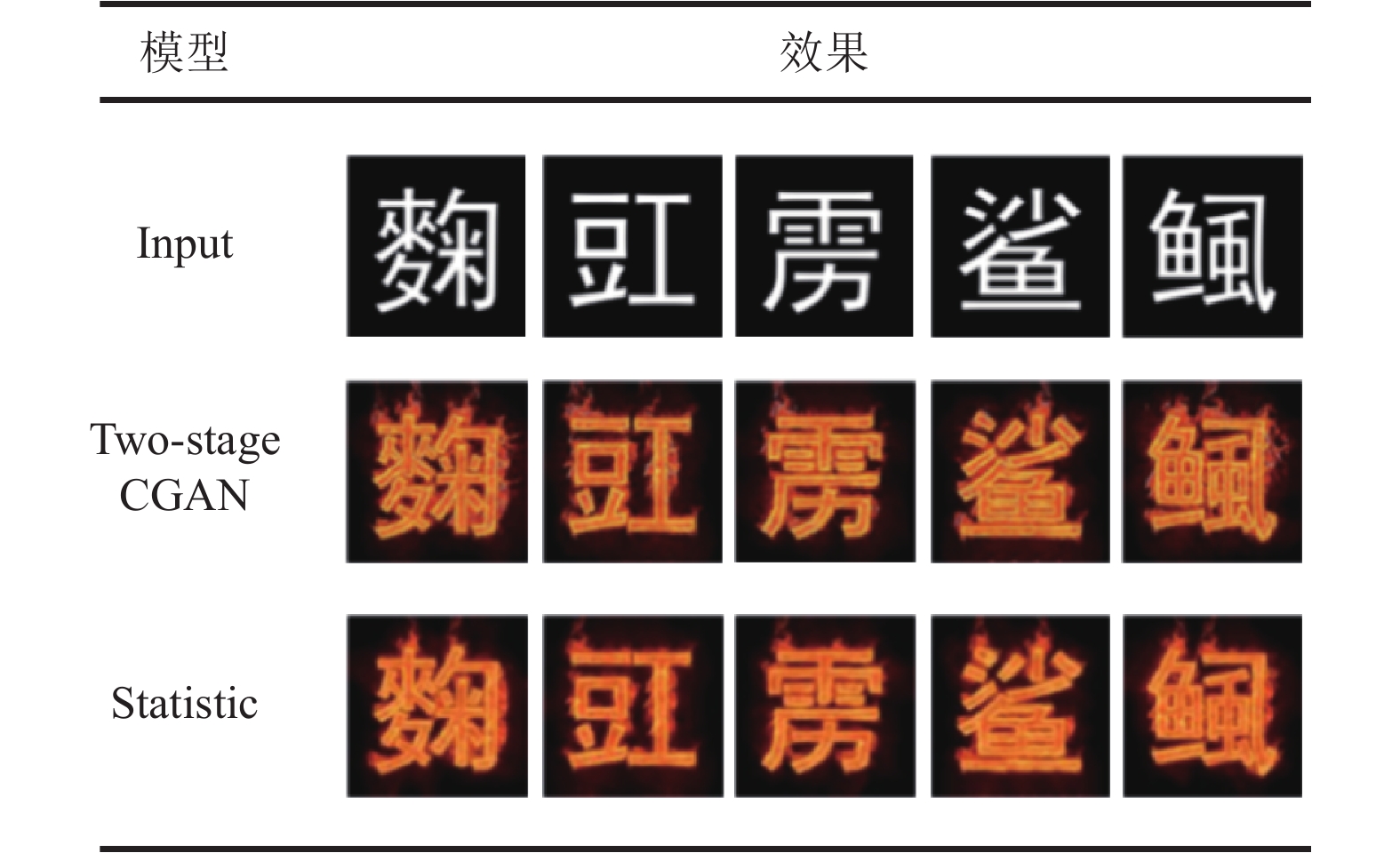

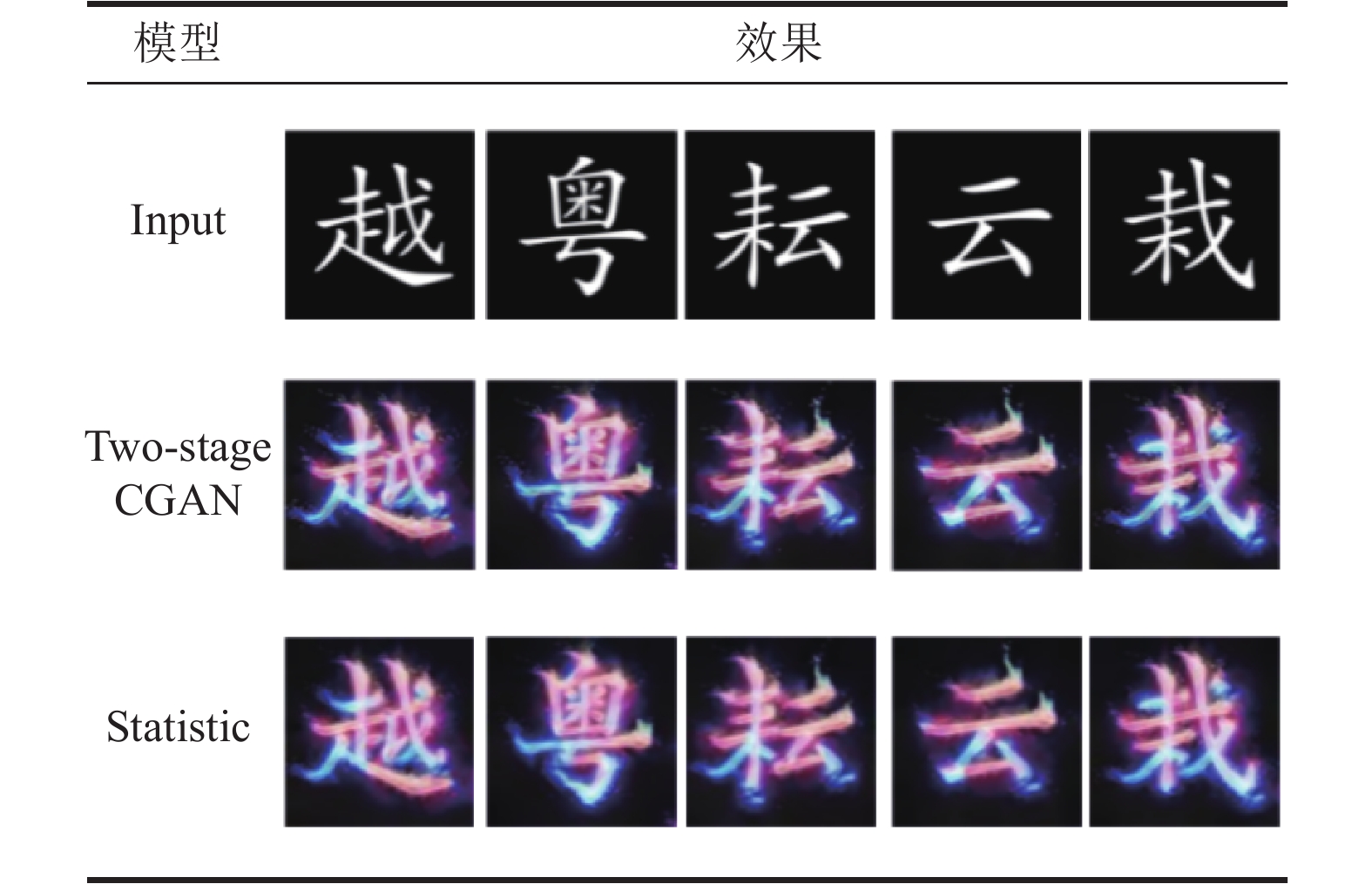

3.4.1 人眼视觉对比火焰、霓虹字体本文方法将原文字图片输入到统计学方法和二阶段式文字渲染网络后得到图10和图11所示结果。对于统计学方法表现较好的火焰、霓虹等2D字体特效渲染上,二阶段式的字体渲染网络也能达到不输于统计学方法的效果。

|

图 10 火焰字体对比 Figure 10 Flame font contrast |

|

图 11 霓虹字体对比 Figure 11 Neon font contrast |

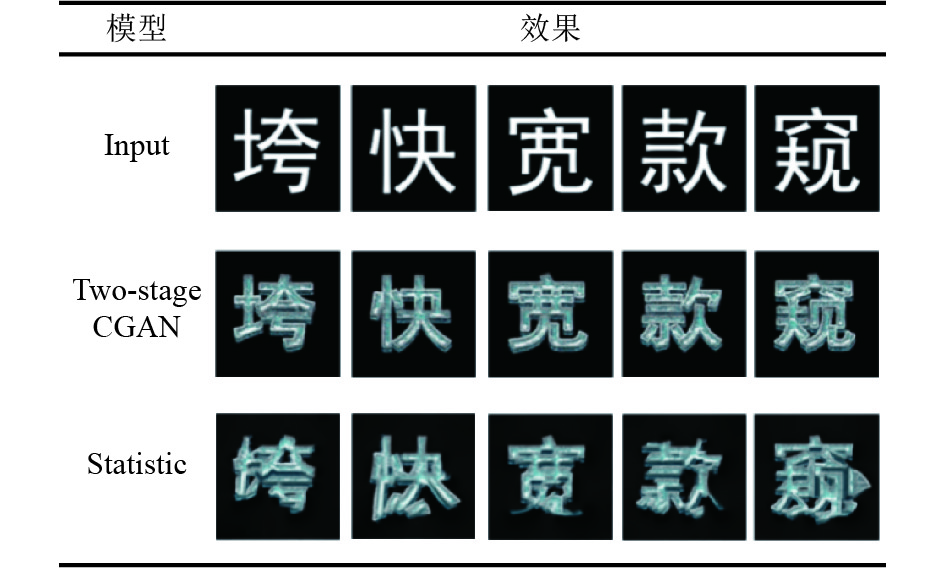

如图12、图13,当基于统计学的方法用于生成冰、阴影效果等艺术字时,该方法难以有效获取3D效果的文字骨架,使得生成字体的渲染特效失真严重。对于特效条纹具有特定方向性的中国风字体,统计学方法因特征提取受到文字骨架的限制,使得生成字体的渲染效果因字而异、杂乱无章(见图14)。通过与统计学方法的对比,可以看出二阶段式文字渲染网络能渲染出具有丰富纹理、高清的艺术字体。

|

图 12 冰字体对比 Figure 12 Ice font contrast |

|

图 13 阴影字体对比 Figure 13 Shadow font contrast |

|

图 14 中国风字体对比 Figure 14 Chinese character font contrast |

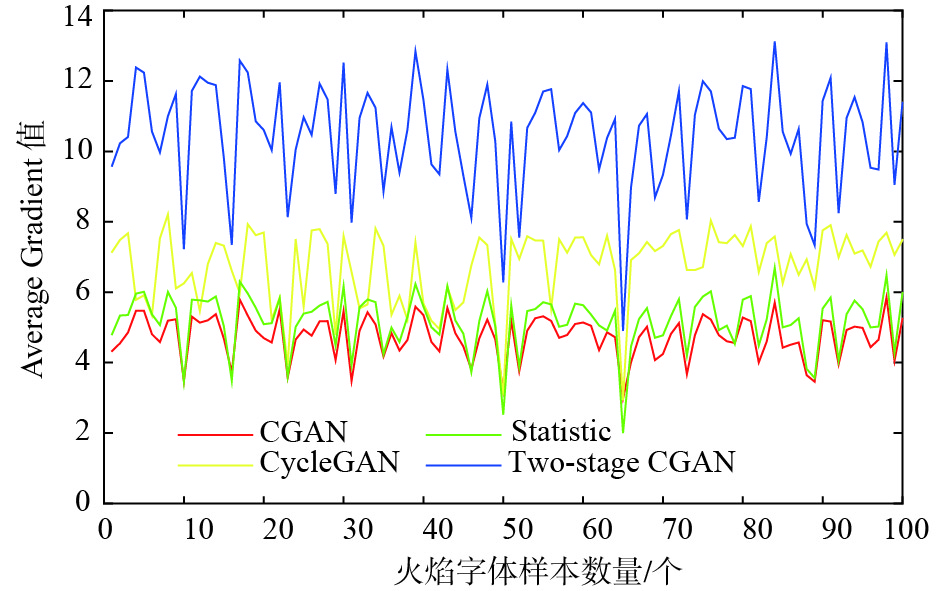

本文对4种方法(Two-stage CGAN、CGAN、传统统计学方法和CycleGAN)所生成的火焰与阴影两种字体的平均梯度以及时效性进行比较。如图15所示,Two-stage CGAN生成火焰字体的平均梯度曲线在整体上高于其他方法,该模型生成的火焰字体相比其他方法更加清晰,而统计学方法虽然存在个别字体的平均梯度值高于Two-stage CGAN,但整体波动幅度较大,同时视觉效果不尽人意,难以达到日常使用的标准。

|

图 15 不同模型火焰字体的平均梯度比较 Figure 15 Average gradient comparison of flame fonts for different models |

通过表1的对比可以看出CGAN模型生成单个火焰字体时效性较好,仅为0.072 s。而Two-stage CGAN所需时间虽然比CGAN多出约0.07 s,但相比于CycleGAN,依然高出约10倍的效率。统计学方法由于逐字迭代过程繁琐,所需时间达到101.206 s。

| 表 1 不同方法生成火焰字体时效性对比 Table 1 Comparison of time effectiveness for different methods generating flame fonts |

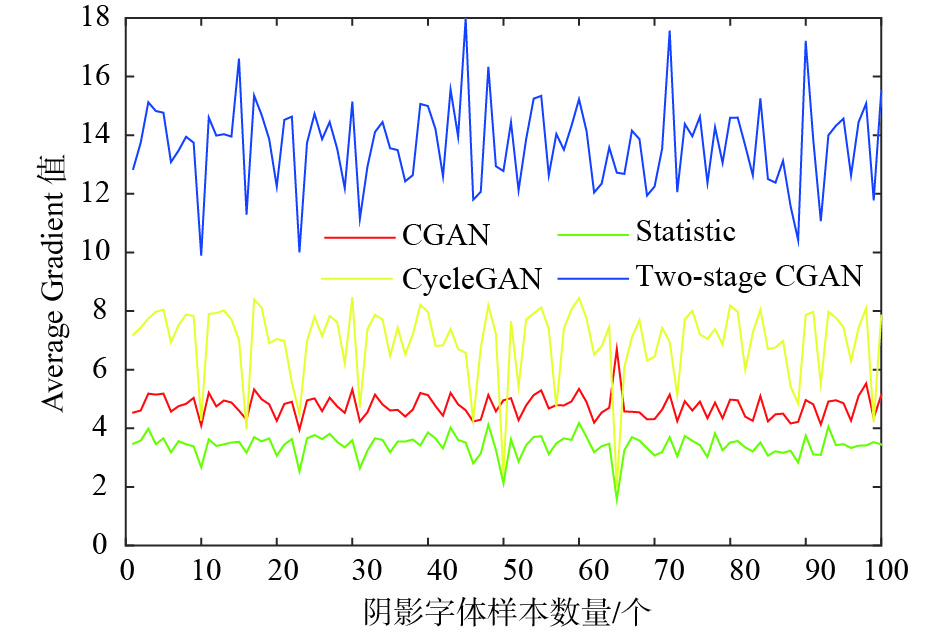

如图16所示,Two-stage CGAN阴影字体的平均梯度曲线值相对其他深度学习方法较高,波动较稳定,不会因文字与特效的不同而出现大幅度波动,生成的艺术字体特效更加清晰,质量较好。虽然统计学方法的平均梯度值局部优于Two-stage CGAN,但整体波动较大,同时通过图17可以看出统计学方法生成字体的渲染效果杂乱无章,不具有实用性。而通过表2可以看出Two-stage CGAN与CGAN时效性较好,但CGAN阴影字体视觉效果不够清晰,实用性较差。虽然Two-stage CGAN时效性略低于CGAN,但纹理较好,同时足够清晰,实用价值较高。

|

图 16 不同模型阴影字体的平均梯度比较 Figure 16 Average gradient comparison of shadow fonts for different models |

| 表 2 不同方法生成阴影字体时效性对比 Table 2 Comparison of time effectiveness for different methods generating shadow fonts |

|

图 17 渲染字体综合对比 Figure 17 Comprehensive comparison of rendering fonts |

从图17(a)~(e)中可以看出,无论是如火焰、霓虹等2D平面特效还是冰、阴影等3D立体特效,本文方法均达到了高质量的视觉效果,兼具丰富多彩的纹理与高清晰度的效果,能满足文字媒体排版的需求以及多样化的商业用途。

4 总结针对现有艺术字体渲染方法存在的艺术字体纹理受限、清晰度不佳等问题,本文基于CGAN神经网络,提出一种二阶段式的艺术字体渲染方法。本论文中实验结果表明,在艺术字渲染方面,本文方法能很好地完成各种艺术字体的特效渲染任务,尤其是一些不基于文字骨架的特效,如冰体字这样的3D特效或带阴影的字体特效渲染上,相比于统计学方法具有巨大的优势。而相比于现存的图像翻译网络如CGAN和CycleGAN,二阶段式字体渲染网络在纹理和清晰度上有较大的提升,能达到日常使用的标准。综合来看,二阶段式字体特效渲染网络更具通用性和实用性,在未来商业化使用方面有较好的前景。但本文方法属于半自动艺术字体渲染,仍需基于手工设计的少量艺术字体数据集才能完成大量艺术字体的设计. 未来应考虑进一步改进,减小手工制作环节所需的工作量,真正实现艺术字体设计的全自动化,进而推动相关产业的发展。

| [1] |

YANG S, LIU J, LIAN Z, et al. Awesome typography: statistics-based text effects transfer[J].

IEEE Computer Vision and Pattern Recognition, 2017: 7464-7473.

|

| [2] |

BARNES C, SHECHTMAN E, GOLDMAN D B, et al. The generalized patchmatch correspondence algorithm[C]// European Conference on Computer Vision. Berlin, Heidelberg: Springer, 2010: 29-43.

|

| [3] |

BARNES C, SHECHTMAN E, FINKELSTEIN A, et al. PatchMatch: a randomized correspondence algorithm for structural image editing[J]. ACM Transactions on Graphics (ToG), 2009, 28(3): 24.

|

| [4] |

GOODFELLOW I J, POUGET-ABADIE J, MIRZA M, et al. Generative adversarial nets[C]//International Conference on Neural Information Processing Systems. Canada, Montreal: MIT Press, 2014: 2672-2680.

|

| [5] |

ARJOVSKY M, CHINTALA S, BOTTOU L. Wasserstein generative adversarial networks [C]//International Conference on Machine Learning. Sydney,Australia:ICML,2017: 214-223

|

| [6] |

CHANG J, SCHERER S. Learning representations of emotional speech with deep convolutional generative adversarial networks[C]//2017 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP). New Orleans: IEEE, 2017: 2746-2750.

|

| [7] |

ISOLA P, ZHU J Y, ZHOU T, et al. Image-to-image translation with conditional adversarial networks[C]//Proceedings of the IEEE conference on computer vision and pattern recognition. Honolulu, Hawaii: IEEE, 2017: 1125-1134.

|

| [8] |

ZHU J Y, PARK T, ISOLA P, et al. Unpaired image-to-image translation using cycle-consistent adversarial networks[C]//Proceedings of the IEEE International Conference on Computer Vision. Italy, Venice: IEEE, 2017: 2223-2232.

|

| [9] |

ZHU J Y, KRÄHENBÜHL, PHILIPP, SHECHTMAN E, et al. Generative visual manipulation on the natural image manifold[J].

Journal of Zhejiang University-Science C(Computers & Electronics), 2016, 15(4): 312-320.

|

| [10] |

曾碧, 任万灵, 陈云华. 基于CycleGAN的非配对人脸图片光照归一化方法[J].

广东工业大学学报, 2018, 35(5): 11-19.

ZENG B, REN W L, CHEN Y H. An unpaired face illumination normalization method based on cycleGAN[J]. Journal of Guangdong University of Technology, 2018, 35(5): 11-19. |

| [11] |

LI Y, FANG C, YANG J, et al. Universal style transfer via feature transforms[C]// Conference and Workshop on Neural Information Processing Systems. Long Beach: NIPS, 2017: 386-396.

|

| [12] |

JOHNSON J, ALAHI A, FEI-FEI L. Perceptual losses for real-time style transfer and super-resolution[C]// European conference on computer vision. Amsterdam: Springer, 2016: 694-711.

|

| [13] |

GATYS L A, ECKER A S, BETHGE M. Image style transfer using convolutional neural networks[C]// Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas: IEEE, 2016: 2414-2423.

|

| [14] |

HE K, ZHANG X, REN S, et al. Deep residual learning for image recognition[C]//Proceedings of the IEEE conference on computer vision and pattern recognition. Boston, Massachusetts: IEEE, 2016: 770-778.

|

| [15] |

SZEGEDY C, VANHOUCKE V, IOFFE S, et al. Rethinking the inception architecture for computer vision[C]//Proceedings of the IEEE conference on computer vision and pattern recognition. Las Vegas: IEEE, 2016: 2818-2826.

|

| [16] |

SZEGEDY C, IOFFE S, VANHOUCKE V, et al. Inception-v4, inception-resnet and the impact of residual connections on learning[C]//Thirty-First AAAI Conference on Artificial Intelligence. San Francisco, California: AAAI, 2017: 4278-4284.

|

2019, Vol. 36

2019, Vol. 36