图文匹配(Image-Text Matching, ITM) [1-2]是多模态或跨模态领域的前沿技术。图文匹配指的是以给定的文本或图像作为查询,检索在语义信息上最为相似的另一个模态的对象[3-4]。从技术上讲,图文匹配需要将图像和文本特征等信息映射到相同的语义空间,然后通过相似度来判断匹配程度[5]。

近年来,深度语义学习网络[6-8]在视觉语义嵌入方面取得了很大的进展[9]。Li等[2]利用图卷积网络(Graph Convolutional Networks, GCN) 方法来推断图像中物体之间的关系,从而提高图文匹配的性能。然而,视觉语义嵌入方法的局限性在于只能从图像模态中发掘语义概念,无法挖掘文本模态中词语之间潜在的密切关系。例如{"沙滩""大海"和"船"},这3个词之间有很强的内在联系,当1个词出现时,另外2个词很有可能一起出现。这种共识性概念可以使用协同文本相关网络模型来获得更高的相似性[10]。

此外,现有的视觉语义图文匹配方法都是基于三元组损失函数来衡量跨模态相似性的[11-12]。它们通常采用小批量的锚点样本进行训练。其中,可以匹配的样本对称为正对,反之则称为负对。在嵌入空间中,三元组损失函数迫使正对聚集,负对分离。然而,三元组损失函数选出的负对仍然不够准确,锚点的负对排名通常很低[13]。该模型区分正对和负对的能力对于复杂图像和文本信息来说是不够的。此外,三元组损失只能局限于自身的样本,在训练过程中无法引入其他样本的正负对作为指导。这一缺陷必然导致模型的泛化能力较弱[14]。最后,三元组损失函数的另一个缺点是其边界是固定的,这不符合当前大数据信息检索的发展趋势。

为了应对这些挑战,本文选择了基于共识学习(Common-sense Learning) 的共识感知视觉语义嵌入(Consensus-aware Visual-Semantic Embedding, CVSE) 方法[15]作为骨干框架。受到主动学习[16-17]思想的启发,进一步在原始图像和文本中添加了预测性候选实例,以帮助模型训练。此外,还提出了基于共识图像描述评估(Consensus-based Image Description Evaluation, CIDER) 指标[18]的自适应分层强化损失(Adaptive Hierarchical Reinforcement Loss, AHRL) ,以自适应地学习最佳图像−文本对。最后,提出了一个新颖的网络模型,即针对图文匹配任务的样本对语义主动挖掘模型(Active Mining Sample Pair Semantics Image-text Matching Model, AMSPS) 。本文的主要贡献如下:

(1) 引入了2种预测性候选实例,并建立了相应的惩罚机制,以更好地指导模型如何分离负对。此外,还增加了样本多样性来弥补三元组损失函数泛化能力弱的问题。

(2) 提出了一种基于CIDER指标的AHRL损失函数,它不仅能更好地学习难分的样本对的语义,还能很好地捕获非真实标签样本的相关语义,大大提高了模型的性能和泛化能力。

(3) 在2个公共基准数据集上进行大量实验证明,AMSPS的性能优于之前的工作。相应的消融实验证明了AMSPS中每个组件的合理性和有效性。

1 相关工作 1.1 图文匹配方法全局和局部嵌入技术是图文匹配任务中非常重要且常用的方法。全局对齐技术[19]一般是将整个图像或完整的句子嵌入到公共的空间中以计算其相似度。Matsubara等[19]提出了一种面向目标的变形网络,它可以调整全局图像−文本对的相似度。因为全局对齐技术无法准确捕捉跨模态样本的细节,所以大多数研究者关注局部对齐技术[12]。

局部对齐方法可以探索图像−文本对之间的细粒度关系。Karpathy等[12]提出了一种结构,可以推断文本词语与图像区域之间的潜在对齐关系,并通过一个公共的嵌入空间将图像特征与文本特征连接起来。然而,这些图文匹配方法仅限于使用图像−文本对进行全局和局部对齐学习,跨模态语义概念只能从特定图像中检测出来。

另一方面,全局和局部对齐技术难以处理长尾和遮挡概念。因此,有研究者提出了一种先进的方法,即共识学习。该方法利用模型中经常出现的共现概念来指导模型,从而更好地学习视觉语义。Wang等[15]使用语料库进行外部嵌入,通过计算语料库中语义概念之间的相关性,构建概念相关图,然后获得共识表示并嵌入模型。虽然这些方法可以学习图像和文本之间的跨模态相关性,但对于一些复杂的图像−文本对来说,存在难分的负对。

1.2 图文匹配损失函数相似性损失度量也是优化图文匹配模型的一个重要方向。早期的图文匹配模型训练主要基于三元组损失函数。三元组损失函数能很好地激发模型,缩小锚点与正实例对之间的距离。最近,Liu等[20]提出了一种邻居感知排序损失(Neighbor-aware Sorting Loss) 方法,该方法关注属于不同语义的邻居,并能有效区分不同语义。此外,Liu等[21]提出了Hubness-aware损失,它考虑了所有样本,并使用局部和全局统计数据来扩展Hub的权重。

与上述工作不同,本文重点挖掘模态间和模态内样本的深度语义,提出一种AHRL损失函数。通过挖掘难分的负对,提高模型区分负对的能力。通过自适应学习非真实标签样本的语义信息,提高模型的匹配性能和泛化能力。

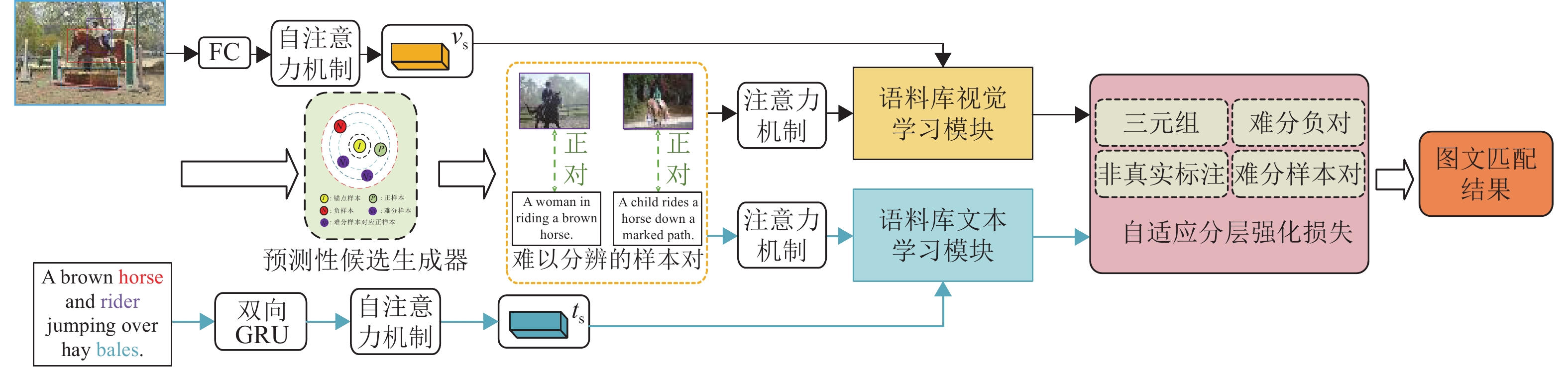

2 算法介绍本节将介绍本文提出的图文匹配框AMSPS和损失函数AHRL,如图1所示。

|

图 1 基于样本对语义主动挖掘的图文匹配模型框架 Figure 1 Active mining sample pair semantics image-text matching model framework |

为了处理内容复杂的图像,引入了图像实例候选。通过这种方式,可以获得更多的语义信息和图像中物体之间的相关性。首先,使用预训练好的自下而上的注意力机制(Pre-trained Bottom-up Attention Mechanism) [22]和Faster R-CNN[23]模型来处理图像。具体来说,给定一幅图像

| $ {{\boldsymbol{v}}_o} = W{{\boldsymbol{f}}_o} + b $ | (1) |

式中:

给定一个包含

| $ \overrightarrow {{\boldsymbol{h}}_j^{{\rm{fr}}}} = \overrightarrow {{\rm{GR}}{{\rm{U}}^{{\rm{fr}}}}} ({{\boldsymbol{e}}_j} + {\boldsymbol{h}}_{j - 1}^{{\rm{fr}}}) ;\overleftarrow {{\boldsymbol{h}}_j^{{\rm{ba}}}} = \overleftarrow {{\rm{GR}}{{\rm{U}}^{{\rm{ba}}}}} ({{\boldsymbol{e}}_j} + {\boldsymbol{h}}_{j - 1}^{{\rm{ba}}}) $ | (2) |

式中:

现有的图文匹配嵌入模型大多只考虑使用自己的模型来训练候选实例。然而,当模型处理较难区分的样本对(即难分的负对)时,效果就会大打折扣。为了增强图像和文本之间的跨模态全局和局部相关性,受到主动学习思想的启发,尝试将从其他语义网络中提取的预测性候选实例[11]加入主候选实例的训练中。具体来说,通过其他模型第一轮的预测提取小批量

| $ {{\boldsymbol{M}}_{{\boldsymbol{vs}}}} = \{ {{\boldsymbol{c}}_{{{\boldsymbol{v}}_1}}},\cdots,{{\boldsymbol{c}}_{{{\boldsymbol{v}}_a}}}\} ;{{\boldsymbol{M}}_{{\boldsymbol{sv}}}} = \{ {{\boldsymbol{c}}_{{{\boldsymbol{s}}_1}}},\cdots,{{\boldsymbol{c}}_{{{\boldsymbol{s}}_j}}}\} $ | (3) |

集合

| $ {{\boldsymbol{P}}_{{\boldsymbol{vs}}}} = \{ U_{{{\boldsymbol{v}}_1}}^k,\cdots,U_{{{\boldsymbol{v}}_a}}^k\} ;{{\boldsymbol{P}}_{{\boldsymbol{sv}}}} = \{ U_{{{\boldsymbol{s}}_1}}^x,\cdots,U_{{{\boldsymbol{s}}_j}}^x\} $ | (4) |

式中:

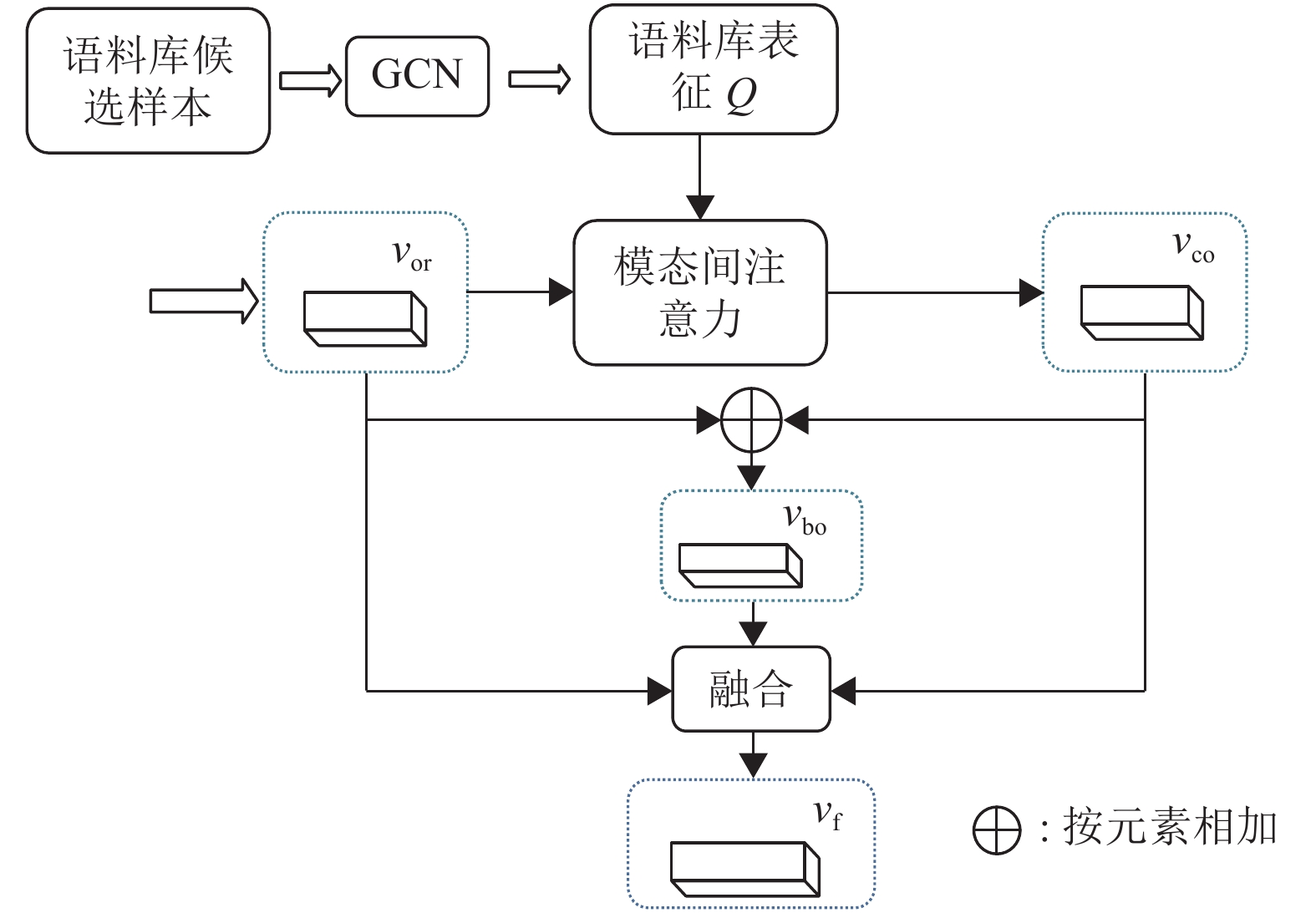

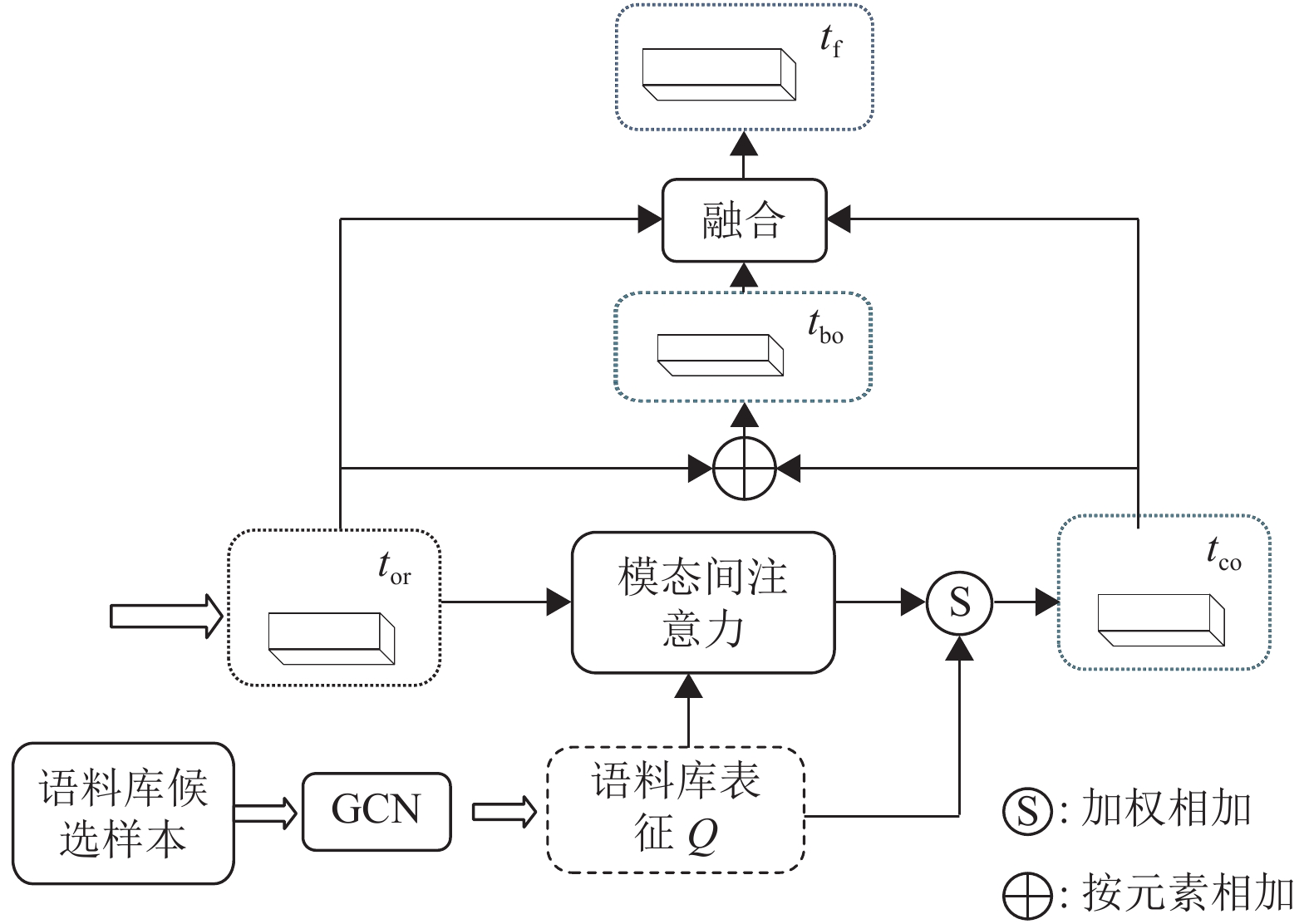

本节将重点介绍语料库视觉学习模块(Corpus Visual Learning Module, CVLM) 和语料库文本学习模块(Corpus Textual Learning Module, CTLM),如图2和图3所示。对于局部区域视觉特征

|

图 2 CVLM结构图 Figure 2 The architecture of CVLM |

|

图 3 CTLM结构图 Figure 3 The architecture of CTLM |

| $ \begin{split} {{\boldsymbol{v}}_{{\rm{co}}}} = & {\boldsymbol{Q}}[g_{{\rm{mo}}}^{\boldsymbol{v}}({{\boldsymbol{v}}_{{\rm{or}}}},{\boldsymbol{Q}}) ] = \displaystyle\mathop \sum \nolimits_{i = 1}^z [g_{{\rm{mo}}}^{\boldsymbol{v}}({{\boldsymbol{v}}_{{\rm{or}}}},{\boldsymbol{Q}}) ]{{\boldsymbol{q}}_i}, \\ & {g_{{\rm{mo}}}^{\boldsymbol{v}}({{\boldsymbol{v}}_{{\rm{or}}}},{\boldsymbol{Q}}) = \frac{{{\text{Exp}}(\lambda \hat c_i^{\boldsymbol{v}}) }}{{\displaystyle\mathop \sum \nolimits_{i = 1}^z {\text{Exp}}(\lambda \hat c_i^{\boldsymbol{v}}) }}} \end{split} $ | (5) |

式中:

类似地,全局文本表征

| $ \begin{split} {{\boldsymbol{t}}_{{\rm{co}}}} =& {\boldsymbol{Q}}[g_{\rm{mo}}^{\boldsymbol{t}}({{\boldsymbol{t}}_{{\rm{or}}}},{\boldsymbol{Q}}) ] = \displaystyle\mathop \sum \nolimits_{j = 1}^z [g_{\rm{mo}}^{\boldsymbol{t}}({{\boldsymbol{t}}_{{\rm{or}}}},{\boldsymbol{Q}}) ]{{\boldsymbol{q}}_j}, \\ g_{\rm{mo}}^{\boldsymbol{t}}({{\boldsymbol{t}}_{{\rm{or}}}},{\boldsymbol{Q}}) =& (1 - \eta ) \frac{{{\text{Exp}}(\lambda \hat c_j^{\boldsymbol{t}}) }}{{\displaystyle\mathop \sum \nolimits_{j = 1}^z {\text{Exp}}(\lambda \hat c_j^{\boldsymbol{t}}) }} + \eta \frac{{{\text{Exp}}(\lambda {{\boldsymbol{L}}_j}) }}{{\displaystyle\mathop \sum \nolimits_{j = 1}^z {\text{Exp}}(\lambda {{\boldsymbol{L}}_j}) }} \end{split} $ | (6) |

式中:

本文提出的自适应分层强化损失AHRL能够以多样化的方式学习其他样本对之间的额外语义判别信息。训练分为2个阶段,每个阶段都有不同的损失函数。

2.3.1 分层强化损失在第一阶段,为了提高语义模型的性能,探索图像−文本对中的细粒度关系,三元组损失函数[13,26]是最直接、最常用的方法。其定义为

| $ \begin{split} {L_{{\text{trip}}}}({\boldsymbol{B}},{\boldsymbol{A}}) =& {{[{\varDelta _1} - G({\boldsymbol{B}},{\boldsymbol{A}}) + G({\boldsymbol{B}},{{\boldsymbol{A}}^ - }) ]}_ + } + \\ &{{{[{\varDelta _1} - G({\boldsymbol{B}},{\boldsymbol{A}}) + G({{\boldsymbol{B}}^ - },{\boldsymbol{A}}) ]}_ + }} \end{split} $ | (7) |

式中:

虽然

| $ \begin{split} {L_1} =& {{[{\varDelta _1} - G({\boldsymbol{B}},{\boldsymbol{A}}) + {G}({{({\boldsymbol{B}},{\boldsymbol{A}}) }^ - }) ]}_ + } +\\ & {{[{\varDelta _2} - G({\boldsymbol{B}},{\boldsymbol{A}}) + G(({\boldsymbol{B}},{\boldsymbol{A}}) _{\rm{f}}^ - ) ]}_ + } + \\ & {{{[{\varDelta _2} - G({\boldsymbol{B}},{\boldsymbol{A}}) + G({\boldsymbol{B}}_{\rm{f}}^ - ,{\boldsymbol{A}}_{\rm{f}}^ - ) ]}_ + }} \end{split} $ | (8) |

| $ \begin{split} {L_2} = &{{[{\varDelta _1} - G({\boldsymbol{B}},{\boldsymbol{A}}) + G({{\boldsymbol{B}}^ - },{\boldsymbol{A}}) ]}_ + } + \\ &{{[{\varDelta _2} - G({\boldsymbol{B}},{\boldsymbol{A}}) + G({\boldsymbol{B}}_{\rm{f}}^ - ,{\boldsymbol{A}}) ]}_ + } + \\ & {{{[{\varDelta _2} - G({\boldsymbol{B}},{\boldsymbol{A}}) + G({\boldsymbol{B}}_{\rm{f}}^ = ,{\boldsymbol{A}}_{\rm{f}}^ = ) ]}_ + }} \end{split} $ | (9) |

式中:

此外,本文还参照文献[27],增加了一些惩罚机制,使其他高质量模型提取的难分负对可以更好地与本文的模型结合起来进行训练,定义如下:

| $ \begin{split} &{\omega _1} = \tau - \frac{{G({\boldsymbol{B}},{\boldsymbol{A}}_{\rm{f}}^ - ) - G({\boldsymbol{B}},{{\boldsymbol{A}}^ - }) }}{\mu };\\ &{\omega _2} = \tau - \frac{{G({\boldsymbol{B}}_{\rm{f}}^ - ,{\boldsymbol{A}}) - G({{\boldsymbol{B}}^ - },{\boldsymbol{A}}) }}{\mu } \end{split} $ | (10) |

式中:

CIDER[18]度量是一种自动化评估指标,已经被广泛用于人工智能的各个领域如机器翻译、文本统计等。与 Recall@k 度量指标硬性的判别不同的是,CIDER[18]度量会更倾向于让AI自动化判断哪个候选标题(非真实对应标题)更接近图片的意思。

假设给定图像集合

| $ {\boldsymbol{w}} ({\boldsymbol{Y}}) = \frac{{ T ({\boldsymbol{Y}}) }}{{{\displaystyle\sum}_{ N_\rho } { T_N ({\boldsymbol{Y}}) } }}\log \left(\frac{I}{{{\displaystyle\sum}_{ I_\rho \in I} {\min (1,{\displaystyle\sum}_{I_\rho} { T ({\boldsymbol{Y}}) } ) } }}\right) $ | (11) |

式中:ρ是所有n-gram 的集合,然后对长度为N的n-gram的

| $ {{\rm{CIDER}}}_N ({\boldsymbol{C}},{\boldsymbol{Y}}) = \frac{1}{m}{\displaystyle\sum} {\frac{{ {\boldsymbol{w}}^{\rm{n}} ({\boldsymbol{Y}}) \cdot {\boldsymbol{w}}^{\rm{n}} ({\boldsymbol{C}}) }}{{\parallel {\boldsymbol{w}}^{\rm{n}} ({\boldsymbol{Y}}) \parallel \cdot \parallel {\boldsymbol{w}}^{\rm{n}} ({\boldsymbol{C}}) \parallel }}} $ | (12) |

式中:

Flickr30k[29]和MSCOCO[30]这2个权威数据集最初是为图像标题任务而设计的, 并设定一幅图像只有5个正确的标题, 并用召回率(实质上是二进制的形式) 评估图像和标题是否对应相关, 这样单一的对应相关本质上削弱了图文匹配模型的评估能力。对于目标图像

虽然分层强化损失

给定图像

| $ \begin{split} &{\varDelta _{\boldsymbol{B}}} = \frac{{\varPhi ({{\boldsymbol{G}}_{{\rm{ture}}}},{\boldsymbol{A}}) - \varPhi ({{\boldsymbol{G}}_{{\rm{ture}}}},\bar {\boldsymbol{A}}) }}{R};\\ &{\varDelta _{\boldsymbol{A}}} = \frac{{\varPhi ({{\boldsymbol{G}}_{{\rm{ture}}}},{\boldsymbol{A}}) - \varPhi ({{\boldsymbol{G}}_{{\rm{ture}}}},{\bar {\bar {\boldsymbol{A}}}}) }}{R} \end{split} $ | (13) |

式中:

总的来说,如果负样本标题

用

| $ \begin{split} {L_3} =& {{[{\varDelta _{\boldsymbol{B}}} - G({\boldsymbol{B}},{\boldsymbol{A}}) + G({\boldsymbol{B}},{{\boldsymbol{A}}^ - }) ]}_ + } +\\ &{{[{\varDelta _2} - G({\boldsymbol{B}},{\boldsymbol{A}}) + G({\boldsymbol{B}},{\boldsymbol{A}}_{\rm{f}}^ - ) ]}_ + } + \\ &{{{[{\varDelta _2} - G({\boldsymbol{B}},{\boldsymbol{A}}) + G({\boldsymbol{B}}_{\rm{f}}^ - ,{\boldsymbol{A}}_{\rm{f}}^ - ) ]}_ + }} \end{split} $ | (14) |

| $ \begin{split} {L_4} = &{{[{{{\varDelta }}_{\boldsymbol{A}}} - G({\boldsymbol{B}},{\boldsymbol{A}}) + G({{\boldsymbol{B}}^ - },{\boldsymbol{A}}) ]}_ + } +\\ &{{[{{{\varDelta }}_2} - G({\boldsymbol{B}},{\boldsymbol{A}}) + G({\boldsymbol{B}}_{\rm{f}}^ - ,{\boldsymbol{A}}) ]}_ + } + \\ &{{{[{{{\varDelta }}_2} - G({\boldsymbol{B}},{\boldsymbol{A}}) + {G_c}({\boldsymbol{B}}_{\rm{f}}^ = ,{\boldsymbol{A}}_{\rm{f}}^ = ) ]}_ + }} \end{split} $ | (15) |

最终,提出的AHRL可用式(16) 表示。

| $ {L_{{\text{AHRL}}}} = {\omega _1}{L_3} + {\omega _2}{L_4} $ | (16) |

总的来说,本文的自适应分层强化损失不仅能更好地自适应挖掘模型中难分的样本,还能为每个样本添加自适应边距,从而更好地学习与查询相关的非真实标签项的语义。自适应分层强化损失使模型无论在大规模数据集上还是在仅有小批量训练数据的情况下,都能很好地区分正负对和捕捉语义连续性。

3 实验结果及讨论本节不仅在2个基准数据集上验证了模型的优越性,还详细阐述了更多训练和实验细节。

3.1 数据集和评估指标 3.1.1 数据集实验围绕2个大型图文匹配数据集展开:Flickr30k和MSCOCO。Flickr30k包含31 783 张图像,每张图像都有5个独立的注释句子。按照文献[9]和文献[12]的策略,将Flickr30k数据集划分为1 000张测试图像的测试集、1 000张验证图像的验证集和其余样本构成的训练集。类似地,MSCOCO包含123 287张图像,每张图像有5个注释句子,其中 5 000张图像用作测试集,5 000张图像用作验证集,其余的作为训练集。

3.1.2 评估指标模型使用图像和文本检索任务中最常用的评估指标召回率来评估结果,即

本节介绍AMSPS模型的实验细节。对于每幅图像,需要提取的区域为

将AMSPS模型与几种常用方法进行比较,证明本文的模型在Flickr30k和MSCOCO数据集上的优越性和有效性。

MSCOCO:如表1所示,在MSCOCO数据集上,AMSPS模型优于现有的对比方法。更具体地,在图像检索方面获得了最佳的R@1 = 61.4%,在总体上获得了最佳的R@sum = 517.4%。值得注意的是,模型是基于CVSE改进的,实验结果表明本文方法在各项指标上都有一定的提高,尤其是在图像检索方面。

| 表 1 在MSCOCO上的实验结果1) Table 1 Results on MSCOCO |

Flickr30k:表2显示了Flickr30k数据集上的结果。与MSCOCO数据集相比,本文模型在Flickr30k上有更大的改进,图像检索上获得了最佳的R@5 = 82.0%和总体上最佳的R@sum = 487.6%。通过比较和验证,发现本文的模型在相对较小的数据集上可能有更显著的效果。

| 表 2 在Flickr30k上的实验结果1) Table 2 Results on Flickr30k |

本节将基于Flickr30k数据集进行几组消融实验,讨论目标函数的不同设置带来的不同结果,以及局部模块对整体模型的影响。

3.4.1 损失函数的不同配置表3展示了不同配置的难分样本对的最佳候选索引列表大小的不同结果,δ1和δ2分别是难分负对的图像列表和文本列表的大小(一幅图像有5个描述,因此δ1的大小是δ2的5倍)。从表中可以看出,当δ1为200~500之间,δ2为40~100之间时,检索效果较好。本文最终选择了δ1=300,δ2=60,因为它的检索分数最高。当δ1=1 000和δ2=200时,提取样本的难分程度降低,但模型的效果并没有降低多少,这说明难分样本的加入提高了模型的泛化能力。

| 表 3 难分的样本对的最佳候选索引列表大小的影响 Table 3 The influence of top list size of the intractable samples |

表4显示了通过配置损失函数的不同惩罚因子(见式(10) )得到的结果。从表4中可以看出,它对损失函数有积极影响。

| 表 4 不同惩罚因子的影响 Table 4 The influence of different penalty factors |

表5直观地显示了不同局部模块对整体模型的影响。值得注意的是,虽然分布式损失(Distributed Loss, DL) 方法可以帮助模型提高识别难分负对的能力,但本文发现句子检索的效果不如图像检索。因此,本文选择在测试阶段将混合检索方法添加到重新排序中,仅应用于句子检索,以提高模型的I2T分数。

| 表 5 局部模块对整体模型的影响 Table 5 The influence of local modules on the overall model |

为了验证非真实标签样本中隐藏语义的有效性和可靠性,在2个数据集上分别进行了召回率实验。其中,分层强化损失(Hierarchical Reinforcement Loss, HRL)是固定边距方法,是以共识学习模型CVSE[15]为基础改进的,自适应强化边距(Adaptive Margins Reinforcement, AMR)则是在分层强化损失(HRL)的基础上改进的。Flickr30k 数据集上的对比见表6,MSCOCO 数据集上的对比见表7。从表中可以发现,自适应强化边距在Flickr30k数据集和MSCOCO数据集上都取得了一定的提升。

| 表 6 Flickr30k上的召回率对比 Table 6 Comparison of recall results shown on Flickr30k |

| 表 7 MSCOCO上的召回率对比 Table 7 Comparison of recall results shown on MSCOCO |

为了更好地对比自适应强化边距方法,在Flickr30和MSCOCO数据集上比较使用和不使用自适应强化边距在最先进模型上的召回率。结果如表8和表9所示。

| 表 8 最先进模型在Flickr30k上的召回率对比 Table 8 Comparison of experimental results of state-of-the-art models on Flickr30k |

| 表 9 最先进模型在MSCOCO上的召回率对比 Table 9 Comparison of experimental results of state-of-the-art models on MSCOCO |

从表8中可以发现使用自适应强化边距后在 Flickr30k上基本所有指标都优于基线方法,其中在 CVSE[15] 上的提升最大,对比原模型单个指标最高提升 3.5%,R@sum 提升了 12.9%,对比最先进的 SAM[35]损失函数加强方法,自适应强化边距凭借着更高的分数实现了超越,R@sum提升了5.6%。

从表9中可以发现使用自适应强化边距后在 MSCOCO上对比基线方法指标提升不明显,因为 Flickr30k的文本标题多为描述人类活动场景,它较MSCOCO 来说描述更加详尽,标题长度也更长,这也是本文模型在Flickr30k上文字检索图像时召回率提升明显的原因。

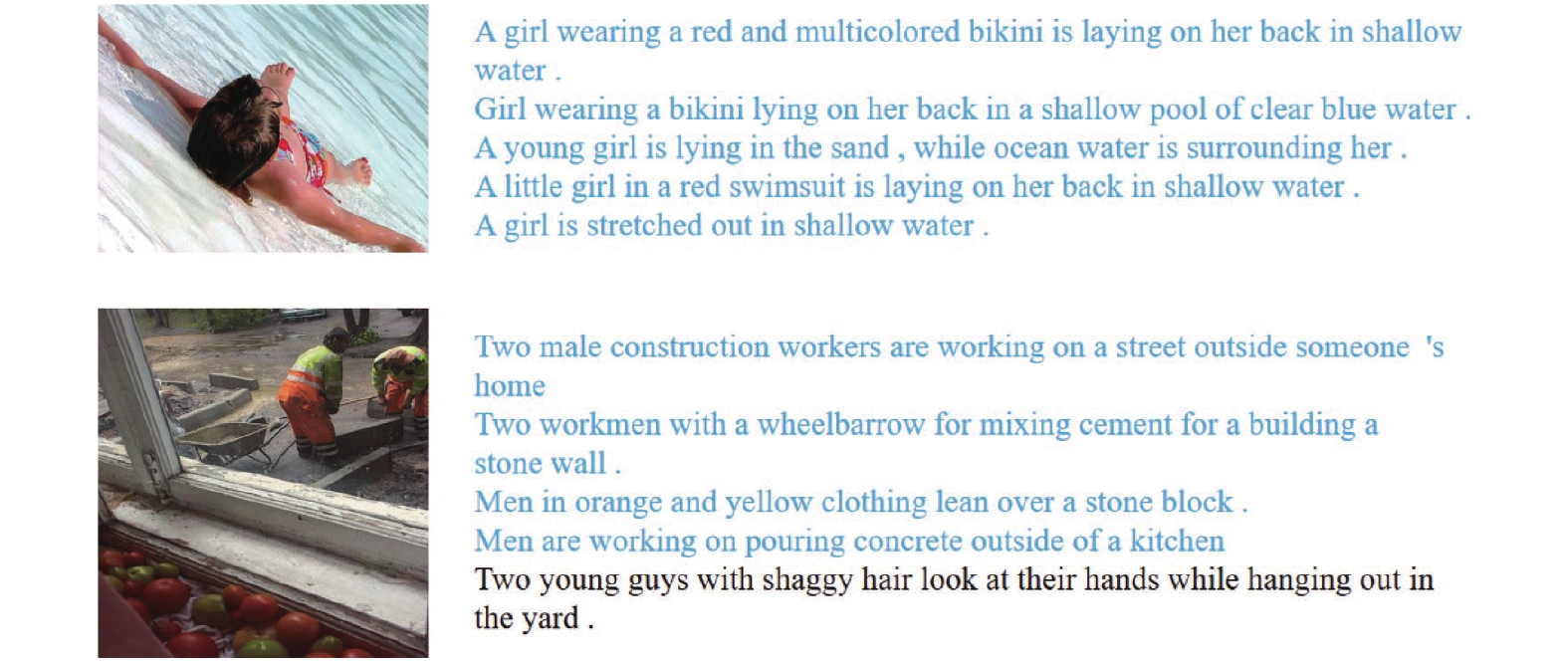

3.5 可视化及分析为了更直观、清晰地展示本文模型的性能,在图4和图5中分别展示了图像和文本检索的可视化示例。值得注意的是,一幅图像有5个对应的描述,而一个描述只有一个对应的图像。从图4可以看出,模型在句子检索方面具有很高的准确率。几乎所有与查询匹配的句子都能被检索到。例如,第一个例子中的关键词 "girl""red"和 "water"与查询图片的语义非常相似。图5中检索到的第一张图片也与句子查询相对应。直观地说,其余图像的语义也非常接近。在检索到的前4张图片中,模型可以匹配到身穿白色衣服、手持网球拍的女孩的图片,在语义上非常相似。由此可见,本文模型能够很好地识别图像和文本的语义,从而确保查询检索到的实例具有很高的相似性。

|

图 4 AMSPS通过图像实例检索到的前5个文本的示例 Figure 4 The examples of the top five texts retrieved by AMSPS through an image instance |

|

图 5 AMSPS通过文本实例检索到的前5张图像的示例 Figure 5 The examples of the top five images retrieved by AMSPS through a text instance |

现有的大多数基于三元组损失的共识学习模型在训练阶段区分正负对的能力不强。此外,在测试阶段,排序分数不高,泛化能力较差。本文提出了一种AMSPS模型,它将训练分为两个阶段,并引入了预测性候选实例,以增强模型区分正负对的能力。此外,还设计了一个自适应分层强化损失函数,使模型更加关注难分的负样本,并自适应地从非真实标签样本中挖掘出隐藏的相关语义,从而提高判别能力。基准数据集下的实验表明,与其他模型相比,本文模型具有优异的图文匹配性能和较强的泛化能力。

| [1] |

LEE K H, CHEN X, HUA G, et al. Stacked cross attention for image-text matching[C]//Proceedings of the European Conference on Computer Vision (ECCV) . Munich: Springer International Publishing, 2018: 201-216.

|

| [2] |

LI K, ZHANG Y, LI K, etal. Visual Semantic Reasoning for Image-Text Matching[C]//2019 IEEE/CVF International Conference on Computer Vision (ICCV) . Seoul, Korea (South) : IEEE, 2019: . 4653-4661.

|

| [3] |

李濛. 结合知识的图文匹配算法研究与实现[D]. 成都: 电子科技大学, 2022.

|

| [4] |

任思宇. 基于语义推理的图文匹配方法的研究[D]. 天津: 天津工业大学, 2021.

|

| [5] |

SZEGEDY C, VANHOUCKE V, IOFFE S, et al. Rethinking the inception architecture for computer vision[C]//2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR) , Las Vegas: IEEE, 2016: 2818-2826.

|

| [6] |

林哲煌, 李东. 语义引导下自适应拓扑推理图卷积网络的人体动作识别[J].

广东工业大学学报, 2023, 40(4): 45-52.

LIN Z H, LI D. Semantics-guided adaptive topology inference graph convolutional networks for skeleton-based action recognition.[J]. Journal of Guangdong University of Technology, 2023, 40(4): 45-52. |

| [7] |

LU R T, YANG X G, JING X, et al. Infrared small target detection based on local hypergraph dissimilarity measure[J].

IEEE Geoscience and Remote Sensing Letters, 2020, 19: 1-5.

|

| [8] |

SUN J H, QING C M, TAN J P, et al. Superpoint transformer for 3d scene instance segmentation[C]//Proceedings of the AAAI Conference on Artificial Intelligence. Washington: AAAI, 2023, 37(2) : 2393-2401.

|

| [9] |

FAGHRI F, FLEET D J, KIROS J R, et al. Improving visual-semantic embeddings with hard negatives[J]. arXiv: 1707.05612(2017-12-12) [2022-05-12]. https://arxiv.org/pdf/1707.05612.pdf.

|

| [10] |

林志刚. 基于多任务和注意力机制的图文匹配技术研究[D]. 天津: 天津大学, 2020.

|

| [11] |

EISENSCHTAT A, WOLF L. Linking image and text with 2-way nets[C]//2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR) . Honolulu: IEEE, 2017: 1855-1865.

|

| [12] |

KARPATHY A , LI F. Deep visual-semantic alignments for generating image descriptions[C]//2015 IEEE Conference on Computer Vision and Pattern Recognition (CVPR) . Boston: IEEE, 2015: 3128-3137.

|

| [13] |

WANG J, ZHOU F, WEN S, et al. Deep metric learning with angular loss[C]//2017 IEEE International Conference on Computer Vision (ICCV) . Venice: IEEE, 2017: 2612-2620.

|

| [14] |

TAN J P, YANG Z J, REN J C, et al. A novel robust low-rank multi-view diversity optimization model with adaptive-weighting based manifold learning[J].

Pattern Recognition, 2022, 122: 108298.

DOI: 10.1016/j.patcog.2021.108298. |

| [15] |

WANG H R, ZHANG Y, JI Z, et al. Consensus-aware visual-semantic embedding for image-text matching[C]//Computer Vision—ECCV 2020: 16th European Conference. Glasgow: Springer International Publishing, 2020: 18-34.

|

| [16] |

BOUKTHIR K, QAHTANI A M, ALMUTIRY O, et al. Reduced annotation based on deep active learning for arabic text detection in natural scene images[J].

Pattern Recognition Letters, 2022, 157: 42-48.

DOI: 10.1016/j.patrec.2022.03.016. |

| [17] |

DU P, CHEN H, ZHAO S Y, et al. Contrastive active learning under class distribution mismatch[J].

IEEE Transactions on Pattern Analysis and Machine Intelligence, 2022, 45(4): 4260-4273.

|

| [18] |

VEDANTAM R, ZITNICK C L, PARIKH D. CIDEr: consensus-based image description evaluation[C]// 2015 IEEE Conference on Computer Vision and Pattern Recognition (CVPR) . Boston: IEEE, 2015: 4566-4575.

|

| [19] |

MATSUBARA T. Target-oriented deformation of visual-semantic embedding space[J].

IEICE Transactions on Information and Systems, 2021, 104(1): 24-33.

|

| [20] |

LIU C, MAO Z, ZANG W, et al. A neighbor-aware approach for image-text matching[C]//ICASSP 2019—2019 IEEE International Conference on Acoustics. Brighton: IEEE, 2019: 3970-3974.

|

| [21] |

LIU F Y, YE R T, WANG X, et al. Hal: improved text-image matching by mitigating visual semantic hubs[C]//Proceedings of the AAAI Conference on Artificial Intelligence. New York: IEEE 2020, 34(7) : 11563-11571.

|

| [22] |

ANDERSON P, HE X D, BUEHLER C, et al. Bottom-up and top-down attention for image captioning and visual question answering[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Salt Lake City: IEEE, 2018: 6077-6086.

|

| [23] |

REN S Q, HE K M, GIRSHICK R, et al. Faster R-CNN: towards real-time object detection with region proposal networks[J].

Advances in Neural Information Processing Systems, 2015, 28: 91-99.

|

| [24] |

SCHUSTER M, PALIWAL K K. Bidirectional recurrent neural networks[J].

IEEE Transactions on Signal Processing, 1997, 45(11): 2673-2681.

DOI: 10.1109/78.650093. |

| [25] |

VASWANI A, SHAZEER N, PARMAR N, et al. Attention is all you need[J].

Advances in Neural Information Processing Systems, 2017, 30: 6000-6010.

|

| [26] |

NAM H, HA J W, KIM J. Dual attention networks for multimodal reasoning and matching[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Hawaii: IEEE, 2017: 299-307.

|

| [27] |

CHEN T L, DENG J J, LUO J B. Adaptive offline quintuplet loss for image-text matching[C]//Computer Vision-ECCV 2020: 16th European Conference. Glasgow: Springer International Publishing, 2020: 549-565.

|

| [28] |

DENKOWSKI M, LAVIE A. Meteor universal: language specific translation evaluation for any target language[C]//Proceedings of the Ninth Workshop on Statistical Machine Translation. Baltimore: ACL, 2014: 376-380.

|

| [29] |

PlUMMER B A, WANG L, CERVANTES C M, et al. Flickr30k entities: collecting region-to-phrase correspondences for richer image-to-sentence models[C]//2015 IEEE International Conference on Computer Vision (ICCV) . Santiago, Chile: IEEE, 2015: 2641-2649.

|

| [30] |

LIN T Y, MAIRE M, BELONGIE S, et al. Microsoft coco: common objects in context[C]//Computer Vision-ECCV 2014: 13th European Conference. Zurich, Switzerland: Springer International Publishing, 2014: 740-755.

|

| [31] |

BITEN A F, MAFLA A, GOMEZ L, et al. Is an image worth five sentences? A New look into semantics for image-text matching[C]//2022 IEEE/CVF Winter Conference on Applications of Computer Vision (WACV) . Waikoloa: IEEE, 2022: 2483-2492.

|

| [32] |

HUANG Y, WU Q, SONG C, et al. Learning semantic concepts and order for image and sentence matching[C]//2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City: IEEE, 2018: 6163-6171.

|

| [33] |

WANG Z. CAMP: cross-modal adaptive message passing for text-Image retrieval[C] //2019 IEEE/CVF International Conference on Computer Vision (ICCV) . Seoul, Korea (South) : IEEE, 2019: 5763-5772.

|

| [34] |

LIU C X, MAO Z D, LIU A A, et al. Focus your attention: A bidirectional focal attention network for image-text matching[C]//Proceedings of the 27th ACM International Conference on Multimedia. France: ACM, 2019: 3-11.

|

| [35] |

LIU C, MAO Z, ZHANG T, et al. Graph structured network for image-text matching[C]//2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR) . Seattle: IEEE, 2020: 10918-10927.

|

| [36] |

DIAO H, ZHANG Y, MA L, et al. Similarity reasoning and filtration for image-text matching[C]//Proceedings of the AAAI Conference on Artificial Intelligence. Internet: AAAI, 2021, 35(2) : 1218-1226.

|

2024, Vol. 41

2024, Vol. 41