2. 广东工业大学 物联网信息技术广东省重点实验室,广东 广州 510006;

3. 智能检测与制造物联教育部重点实验室, 广东 广州 510006

2. Guangdong Key Laboratory of IoT Information Technology, Guangdong University of Technology, Guangzhou 510006, China;

3. Key Laboratory of Intelligent Detection and the Internet of Things in Manufacturing, Ministry of Education, Guangzhou 510006, China

由于无人机具有移动性可控、灵活部署以及视距通信等特点,无人机可为物联网边缘应用提供服务[1-3],例如无人机可以作为空中基站(Base Station, BS) 或者中继节点,实现地面智能终端无处不在的连接。因此,无人机网络通过协调多个无人机通信,可以实现自主的空中网络,已受到学术界和工业界广泛关注。然而,随着无人机网络中地面智能终端设备激增、多场景多业务动态叠加、网络规模持续扩大以及无人机快速移动等特征,无人机网络优化和管理越来越复杂。数字孪生采用建模工具构建无人机网络中地面BS、地面智能终端、空中无人机以及无线传输信道等物理实体的高保真数字模型(即数字孪生体) 。在未来6G无人机网络时代,大量无人机网络数字孪生体将被部署在网络边缘服务器上,通过虚实交互,保持无人机网络物理实体和数字孪生体状态同步更新和协同演化,最终形成无人机数字孪生边缘网络,并采用分布式智能算法,为无人机网络优化和管理提供智能化决策,更加高效地应对无人机网络复杂挑战[4-6]。

然而,无人机数字孪生边缘网络在协同边缘服务器上的数字孪生体进行智能化决策时,边缘服务器需要获取海量异构数据,这些数据涉及智能终端敏感信息,例如生物特征识别信息、车辆自动驾驶控制信息等。多个互不信任的数字孪生体协同计算,容易泄露智能终端敏感信息,导致无人机数字孪生边缘网络安全问题。联邦学习作为一种新兴的分布式机器学习架构,智能终端在本地训练机器学习模型,并将训练好的本地模型参数上传到中心云服务器聚合,而不用上传原始数据,从而可有效保护智能终端数据安全和隐私[7]。目前,联邦学习已经应用于计算机视觉、自然语言处理、汽车自动驾驶、智能家居等领域[8]。当前联邦学习应用于无人机数字孪生边缘网络,仍面临严峻挑战。无人机有限的计算资源、存储能力、能量资源、高速移动性,以及动态时变的无线传输环境,将导致联邦学习模型参数传输出错的概率增大,进而使联邦学习性能下降[9]。Song 等[10]提出基于非正交多接入技术的无人机网络联邦学习架构,通过联合优化上行非正交多接入传输时延、下行广播时延以及无人机的计算时延,实现最小化联邦学习时延的目标。Cheng 等[11]研究无人机网络多任务联邦学习激励机制,提出使用拍卖博弈算法激励无人机和智能终端参与联邦学习模型训练。Sun等[12]提出采用数字孪生辅助无人机网络联邦学习激励机制和斯塔克伯格算法,激励地面智能终端贡献资源参与联邦学习模型训练,提高联邦学习准确率。

考虑无人机数字孪生边缘网络动态时变的无线传输环境,当前大部分研究将深度强化学习(Deep Reinforcement Learning, DRL)算法和无人机网络的孪生网络模型结合,DRL算法可以从孪生网络模型中获取反映真实无人机网络状态的信息,并利用这些状态信息进行模型训练。同时,孪生网络模型实时获取真实无人机网络状态变化信息,且连续地更新模型参数,以对真实无人机网络的性能优化做出最优决策。Li等 [13]提出采用数字孪生辅助无人机网络边缘计算任务卸载,将数字孪生和双层深度Q网络(Double Deep Q-Network,DDQN)算法结合,求解智能终端最优关联和无人机最优飞行轨迹,实现最小化无人机网络边缘计算能耗的目标。Chen等 [14]提出无人机网络智能终端任务卸载调度策略,将数字孪生和DRL算法结合,在构建的孪生网络模型中训练智能终端任务卸载调度决策模型,实现最大化无人机网络地面智能终端平均效用的目标。这些工作聚焦于无人机数字孪生边缘网络中计算任务卸载策略设计,然而在无人机数字孪生边缘网络的联邦学习中,如何应对复杂变化的网络环境,并协同多个无人机提升联邦学习性能仍存在极大挑战。与现有工作不同,本文在无人机数字孪生边缘网络中,设计无人机多智能体协作调度策略,以降低联邦学习时延,同时保证学习准确率和损失的优越性。因此本文主要贡献如下:

(1) 提出基于无人机数字孪生边缘网络的联邦学习资源调度策略。首先,采用数字孪生技术在地面BS构建无人机网络的孪生网络模型,对无人机网络运行状态进行模拟和仿真。考虑多个无人机作为联邦学习模型参数的聚合器,对地面智能终端训练的本地模型参数进行聚合,在保护地面智能终端原始数据安全的前提下提供分布式机器学习服务。

(2) 进一步将无人机数字孪生边缘网络联邦学习资源分配问题建模为马尔科夫决策过程,建立联合无人机飞行距离、飞行角度以及无线网络频谱资源分配的自适应资源优化模型,实现最小化联邦学习时延的目标。提出基于孪生网络模型的多智能体深度确定性策略梯度(Multi-Agent Deep Deterministic Policy Gradient,MA-DDPG) 的资源分配优化算法,求解自适应资源优化模型。

(3) 仿真结果表明,本文算法具有良好的收敛性。与其他算法对比,本文算法可显著降低联邦学习时延性能,同时保证了联邦学习训练损失和准确率性的优越性。

1 系统模型本文构建的无人机数字孪生边缘网络联邦学习架构如图1所示,由真实无人机网络模型和孪生网络模型组成。真实无人机网络模型中,

|

图 1 无人机数字孪生边缘网络联邦学习架构 Figure 1 Federated learning architecture for drone digital twin edge networks |

在时刻

在本文提出的系统模型中,无人机充当联邦学习的聚合器,聚合维护具体计算任务的全局模型参数。地面智能终端从服务区域的无人机获得全局模型参数,在全局模型的基础上使用本地数据训练本地模型;然后智能终端通过上行信道将训练后的本地模型参数上传到服务区域的无人机,由无人机对智能终端本地模型参数进行聚合以更新全局模型参数。

1.1 联邦学习模型用

| $ {f}_{n}\left({w}_{m}\right) =\frac{1}{{D}_{n}}{\sum }_{i\in {\mathcal{D}}_{n}}f({w}_{m},{x}_{n,i},{y}_{n,i}) $ | (1) |

第

| $ f\left({w}_{m}\right) =\frac{1}{{D}_{m}}{\sum }_{n\in {\mathcal{N}}_{m}}{\sum }_{i\in {\mathcal{D}}_{n}}f({w}_{m},{x}_{n,i},{y}_{n,i}) $ | (2) |

第

| $ {w}_{m}^{*}={\mathrm{a}\mathrm{r}\mathrm{g}\mathrm{m}\mathrm{i}\mathrm{n}}_{{w}_{n}}f\left({w}_{m}\right) $ | (3) |

每一轮联邦学习训练过程中,考虑智能终端采用正交频分多址接入技术,通过上行信道将训练的本地模型参数上传到服务区域的无人机。区域

| $ {\mathrm{S}\mathrm{I}\mathrm{N}\mathrm{R}}_{n,m,k}^{m}=\frac{{P}_{n,k}^{\mathrm{u}\mathrm{p}}{g}_{n,m}}{\sum _{{n}'\in \mathcal{N},{n}'\ne n}{P}_{{n}',k}^{{\rm{up}}}{g}_{{n}',m}+{\sigma }^{2}} $ | (4) |

式中:

| $ {g}_{n,m}\left(t\right) =\frac{\beta }{{d}_{n,m}^{2}\left(t\right) +{H}^{2}} $ | (5) |

式中:

| $ {R}_{n,m}\left(t\right) =B{\sum }_{k=1}^{K}{\phi }_{n,m,k}\left(t\right) {\mathrm{l}\mathrm{o}\mathrm{g}}_{2}(1+\mathrm{S}\mathrm{I}\mathrm{N}{\mathrm{R}}_{n,m,k}^{m}) $ | (6) |

式中:

在联邦学习训练过程中,地面智能终端

| $ {T}_{n,\mathrm{l}\mathrm{o}\mathrm{c}}=\frac{{D}_{n}{c}_{n}}{{f}_{n}^{\mathrm{c}}} \text{,} \forall n\in \mathcal{N} $ | (7) |

本地模型参数训练完成后,智能终端将本地模型参数无线传输到服务区域的无人机,本地模型参数上传时延表示为

| $ {T}_{n,m,\mathrm{u}\mathrm{p}}\left(t\right) =\frac{\left|{w}_{m}\right|}{{R}_{n,m}\left(t\right) } \text{,} \forall n\in \mathcal{N} $ | (8) |

式中:

每轮联邦学习训练总时延由本地模型训练时延、本地模型上传时延、全局模型聚合时延和全局模型广播时延组成。考虑无人机配备的边缘服务器有充足的计算资源,且无人机使用专门的信道进行全局模型参数广播。与本地模型训练和上传时延相比,无人机全局模型聚合时延和全局模型广播时延较小。因此,第

| $ {T}_{n}\left(t\right) ={T}_{n,\mathrm{l}\mathrm{o}\mathrm{c}}+{T}_{n,m,\mathrm{u}\mathrm{p}}\left(t\right) \text{,} \forall n\in \mathcal{N} $ | (10) |

每轮联邦学习训练总时延由所有终端参与此轮联邦学习的最大时延决定,表示为

| $ {T}_{m}\left(t\right) =\mathrm{max}{T}_{n}\left(t\right) ,\forall n\in \mathcal{N},m\in \mathcal{M} $ | (11) |

为此,通过优化无人机的飞行距离、飞行角度、子信道分配,设计式(11)最小化无人机数字孪生边缘网络联邦学习时延的优化问题

| $ \underset{\alpha ,d,\phi ,}{\mathrm{min}}\frac{1}{T}\sum _{t=1}^{T}{T}_{m}\left(t\right) ,\forall m\in \mathcal{M} $ |

| $ {\rm{s}}.{\rm{t}}.\left\{ \begin{array}{l} {\rm{C}}1: 0\le {X}_{m}\left(t\right) \le {X}_{\mathrm{m}\mathrm{a}\mathrm{x}} ,\; 0\le {Y}_{m}\left(t\right) \le {Y}_{\mathrm{m}\mathrm{a}\mathrm{x}},\\ \qquad\quad \forall m\in \mathcal{M} , \\ {\rm{C}}2: 0\le {d}_{m}\left(t\right) \le {d}_{m}^{\mathrm{m}\mathrm{a}\mathrm{x}} ,\; 0\le {\varphi }_{m}\left(t\right) \le \text{2π},\forall m\in \mathcal{M} ,\\ {\rm{C}}3: {d}_{m,{m}'}\left(t\right) \ge {d}_{\mathrm{m}\mathrm{i}\mathrm{n}},\;\forall m\in \mathcal{M}, \\ {\rm{C}}4: {d}_{n,m}\left(t\right) \le {R}_{\mathrm{m}\mathrm{a}\mathrm{x}},\;\forall n\in \mathcal{N},\;\forall m\in \mathcal{M} ,\\ {\rm{C}}5: \sum _{n\in {N}_{m}}\sum _{k\in K}{\phi }_{n,m,k}\left(t\right) \le K,{\phi }_{n,m,k}\left(t\right) \in \left\{\mathrm{0,1}\right\},\\ \qquad\quad \forall n\in \mathcal{N},\;\forall m\in \mathcal{M} \end{array} \right.$ | (12) |

式中:C1表示无人机不能飞出服务区域

由于无人机数字孪生边缘网络无线传输环境的随机性,以及网络边缘计算、通信等资源的动态时变性,用传统的优化方法较难求解优化问题(11)。MA-DDPG中每个智能体结合全部智能体的策略进行参数更新,从而更适合用于处理多个智能体的复杂协作问题,并具有较高鲁棒性。此外,MA-DDPG采用中心化训练、去中心化执行框架,允许智能体使用其他智能体的策略信息来增强自身的训练效果,而在实际应用或测试时不需要全局信息也能做出有效决策。Ryan等[15]通过与已有算法在协作和竞争场景下的比较,证明了MA-DDPG算法性能优越性。

本文设计基于孪生网络模型的MA-DDPG优化算法,以求解无人机数字孪生边缘网络联邦学习时延优化问题(11)。如图2所示,在设计的优化算法中,MA-DDPG算法的运行环境由本地BS维护的孪生网络模型组成,包括无人机、地面智能终端以及无线传输信道的孪生模型。本文所提模型的具体流程如下:

|

图 2 基于孪生网络模型的MA-DDPG算法 Figure 2 MA-DDPG algorithm based on twin network model |

步骤1:无人机网络中的地面智能终端和无人机将状态更新信息上传给本地BS维护的孪生网络模型,保持虚实同步更新。

步骤2:本地BS从孪生网络模型中观测无人机和地面智能终端的状态以及系统返回的即时报酬。

步骤3:将步骤2新观测到的状态输入MA-DDPG决策模型求解优化问题(11) ,获得输出决策。该决策会与状态和报酬等信息一起保存到MA-DDPG的经验缓存池中。当经验缓存池内的经验数据达到一定数量后,MA-DDPG开始迭代训练更新自身的网络参数。

步骤4:将MA-DDPG输出的决策应用到孪生网络模型中进行测试,孪生网络模型更新自身状态并计算即时报酬。

步骤5:将经过测试的优化决策反馈给无人机和地面智能终端的物理实体执行。

相比传统MA-DDPG算法,本文设计的基于孪生网络模型的MA-DDPG算法,本地BS 从孪生网络模型中获取状态信息,可减少MA-DDPG算法训练过程中无人机和地面智能终端交互的资源开销。

2.1 基于孪生网络模型的MA-DDPG优化算法本文提出的基于孪生网络模型的MA-DDPG优化算法中,将决策问题构造成马尔可夫决策过程,其中,状态空间、动作空间和报酬函数分别定义如下。

(1) 状态空间。在决策时刻

| $ {S}_{m,t}=\left\{{\psi }_{m}\left(t\right) ,{d}_{m,{m}'}\left(t\right) ,{\omega }_{n}\left(t\right) ,{w}_{n}\left(t\right) ,{g}_{n,m}\left(t\right) \right\} $ | (13) |

(2) 动作空间。为了最小化无人机数字孪生边缘网络联邦学习时延,需要调整决策变量以适应网络环境的动态时变性。本地BS需要调整的决策变量包括:无人机在第

| $ {A}_{m,t}=\left\{{d}_{m}\right(t) ,{\varphi }_{m}(t) ,{\phi }_{n,m,k}\left(t\right) \} $ | (14) |

(3) 报酬函数。考虑到强化学习以最大化长期平均报酬为目标,而本文需要最小化联邦学习的训练时延,因此设计如下即时报酬函数

| $ {r}_{m,t}=\frac{l}{{T}_{m}\left(t\right) } $ | (15) |

式中:

| $ \mathcal{R}=\mathrm{m}\mathrm{a}\mathrm{x}\mathbb{E}\left[{\sum }_{t=0}^{T-1}{\sum }_{m=1}^{M}\gamma \cdot {r}_{m,t}({S}_{m,t},{A}_{m,t}) \right] $ | (16) |

式中:

DDPG采取确定性策略,以第

MA-DDPG的基本思想是中心化训练、去中心化执行。每个无人机智能体可利用全局信息,包括其他无人机智能体所处的环境状态及对应的策略动作等信息。对Critic进行训练,但在其进行决策时只需局部信息(该智能体自身所处的环境状态),就可得到确定性策略。第

价值网络Critic采用基于TD-error的梯度下降更新方法,该网络需要结合环境的真实收益

| $ \begin{split} {L}_{m}^{\mathrm{C}\mathrm{r}\mathrm{i}\mathrm{t}\mathrm{i}\mathrm{c}}\left({\theta }_{m}^{{\rm{Critic}}}\right) =&\mathrm{M}\mathrm{S}\mathrm{E}\left({Q}_{m}\right({S}_{t},{A}_{m,t}) , \frac{1}{M}{\sum }_{m=1}^{M}{r}_{m,t}+\\ &\gamma {Q}_{m}^{\mathrm{T}\mathrm{a}\mathrm{r}\mathrm{g}\mathrm{e}\mathrm{t}}({S}_{t+1},{A'}_{m,t+1}) ) \end{split} $ | (17) |

策略网络Actor的目标是找到当前环境状态下的最优策略动作,优化策略网络Actor就需要最大化价值网络输出

| $ {L}_{m}^{\mathrm{A}\mathrm{c}\mathrm{t}\mathrm{o}\mathrm{r}}=-{Q}_{m}({S}_{t},{A}_{m,t}) $ | (18) |

第m个无人机智能体的累计期望报酬

| $ J\left({\theta }_{m}^{\mathrm{Actor}}\right) ={E}_{{S}_{m,t},{A}_{m,t} \sim {\mu }_{{\theta }_{m}^{{\rm{Actor}}}}}\left[{\sum }_{t=0}^{\infty }\gamma \cdot \frac{1}{M}{\sum }_{m=1}^{M}{r}_{m,t}\right] $ | (19) |

对应第

| $ {{\nabla }_{{\theta }_{m}^{\mathrm{Actor}}}J\left({\mu }_{{\theta }_{m}^{\mathrm{Actor}}}\right) = {E}_{{S}_{m,t},{A}_{m,t} \sim D}\left[{\nabla }_{{\theta }_{m}^{\mathrm{Actor}}}{\mu }_{{\theta }_{m}^{\mathrm{Actor}}}\left({S}_{m,t}\right) {\nabla }_{{A}_{m,t}}{Q}_{m}\left({S}_{t},{A}_{m,t}\right) \right] }$ | (20) |

式中:D为元素

Target Actor的网络参数

| $ {\theta '}_{m}^{\mathrm{Actor}}=\tau {\theta }_{m}^{\mathrm{Actor}}+(1-\tau ) {\theta '}_{m}^{\mathrm{Actor}} $ | (21) |

| $ {\theta '}_{m}^{\mathrm{Critic}}=\tau {\theta }_{m}^{\mathrm{Critic}}+(1-\tau ) {\theta '}_{m}^{\mathrm{Critic}} $ | (22) |

其中

算法1 MA-DDPG算法原理

输入 状态

输出 对应时刻t所有无人机代理的决策

(1) 当episode=1,2,···,循环1:

(2) 对于t=1,2,···,T,循环2:

(3) M个无人机分别从孪生网络模型中获取当前时刻t的状态

(4) M个无人机分别在各自的孪生网络模型中执行决策,并得到各自的实时报酬及下一时刻的状态

(5) 存储

(6) 对于代理=1,2,···,

(7) 从经验回放池中随机采样一个minibatch大小的经验

(8) 根据式(17)、(19)分别更新参数

(9) 根据式(20)、(21)分别更新参数

(10) 结束循环3

(11) 结束循环2

(12) 结束循环1

3 仿真结果本节通过实验验证提出的基于孪生模型的MA-DDPG优化算法的性能。利用Pytorch神经网络框架搭建MA-DDPG优化算法。考虑在长和宽均为500 m的正方形区域

图3对比了不同算法下无人机智能体的平均报酬。从图中可以看出,随着训练次数增加,不同算法下无人机智能体的平均报酬均能上升并趋于收敛。由于MA-DDQN算法适合处理离散变量,而本文研究场景中表征无人机移动的飞行距离和飞行角度属于连续变量,因此,MA-DDQN算法需先对这些连续变量进行离散化处理后再执行迭代训练,而这限制了获得的无人机飞行距离和飞行角度的准确性。尽管MA-DDQN算法最终也能收敛至一个稳定区间,但其在报酬优化和收敛方面都逊于本文方案算法。这一结果充分证明了本文方案算法在提出的无人机数字孪生边缘网络中的优势。

|

图 3 不同算法下的联邦学习训练时延对比 Figure 3 Comparison of federated learning training delay under different algorithm |

图4对比了不同学习率下无人机智能体的平均报酬。从图中可以看出,随着训练次数增加,不同学习率下无人机智能体的平均报酬都能增加并收敛至稳定值,证明了提出的基于孪生网络模型的MA-DDPG优化算法可以通过探索不同的动作策略,如无人机

|

图 4 不同学习率下的无人机平均报酬对比 Figure 4 Comparison of UAV average reward under different learning rates |

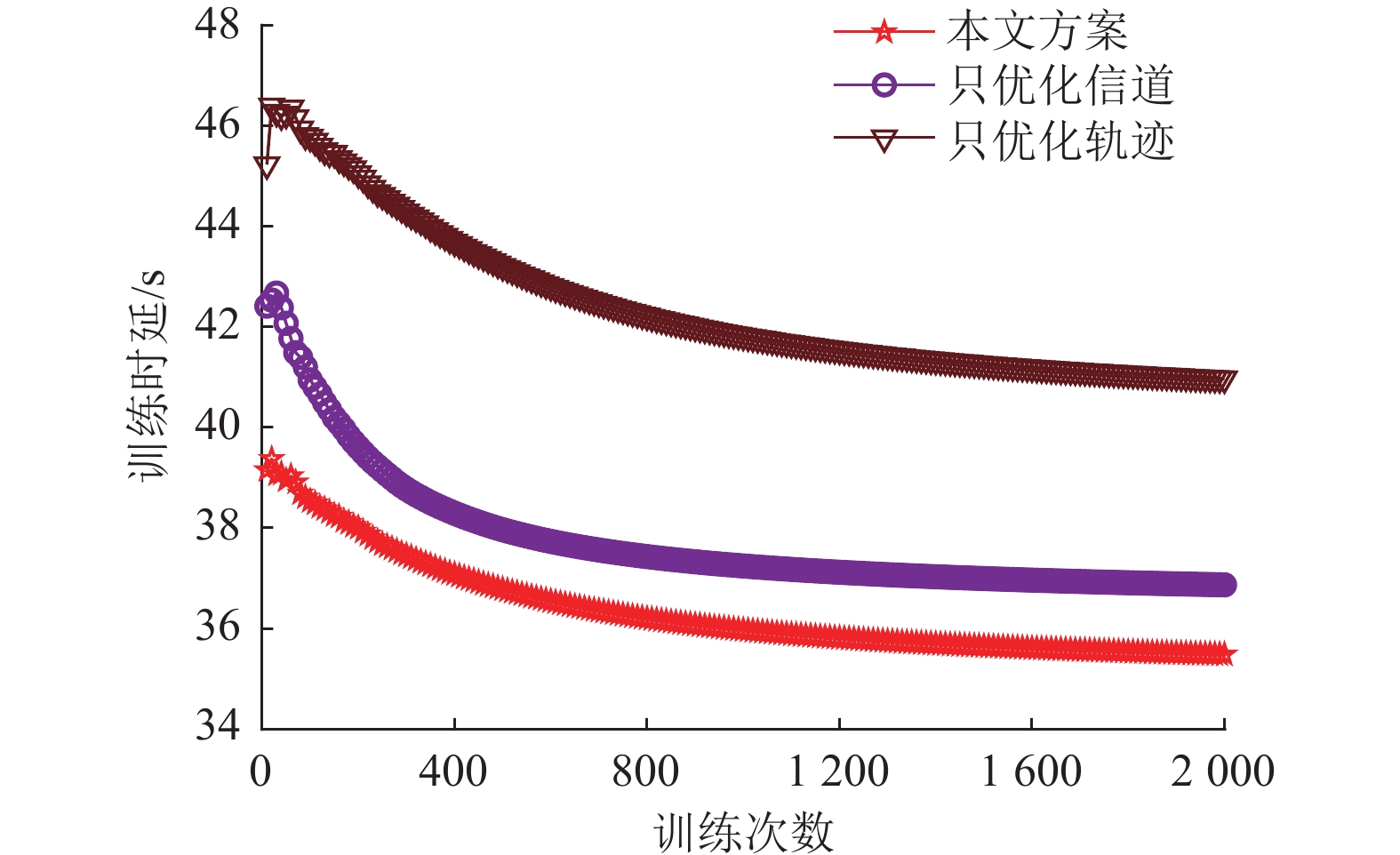

图5展示了本文提出的方案与只优化信道和只优化轨迹的两种方案在联邦学习训练延迟方面的对比。根据报酬函数(见式(14)),联邦学习的训练延迟是计算报酬时的一个关键因素,其最小化是实现报酬最大化的必要条件,这与本文旨在最小化联邦学习训练延迟的目标相吻合。从图中可以观察到,随着训练迭代次数的增加,3种优化方案的训练延迟都有所下降,并最终趋于稳定。本文提出的方案在降低联邦学习训练延迟方面表现出了最佳的性能,这一优势源自于对无人机的飞行距离、飞行角度以及子信道分配3个关键变量的综合优化。当且仅当这3个变量同时得到优化时,才能取得最佳效果。仿真结果证实了,相较于其他对照方案,本文提出的方案更有效地降低了联邦学习的训练延迟。

|

图 5 不同优化方案下的联邦学习训练时延对比 Figure 5 Comparison of federated learning training delay under different optimization schemes |

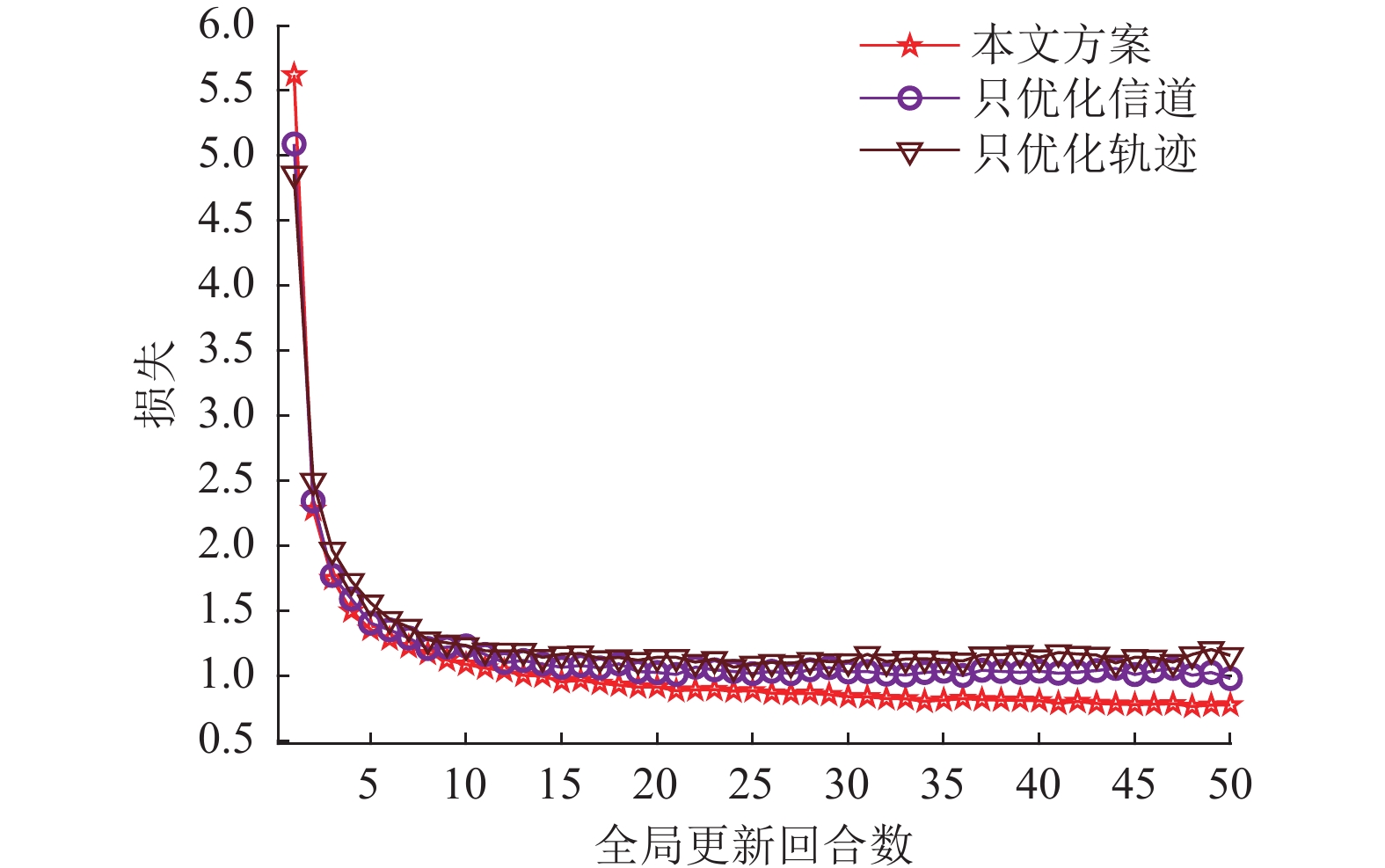

图6对比了3种优化方案实现的无人机数字孪生边缘网络联邦学习训练损失。从图中可以看出,随着联邦学习全局训练回合数增加,3种优化方案的联邦学习训练损失都能逐渐减小并趋于稳定值。其次,本文方案可以获得最小的联邦学习训练损失。这是因为提出的方案通过联合优化无人机飞行距离、无人机飞行角度和子信道分配3个优化变量,无人机可以聚合更多地面智能终端的本地模型参数,从而使全局模型参数训练损失快速降低。而在只优化子信道分配的优化方案中,无人机悬停于固定位置,无法采集服务区域内所有地面智能终端的本地模型参数,因而该方案的损失比本文方案大。在只优化无人机轨迹的优化方案中,子信道随机分配给地面智能终端,无法保证所有地面智能终端被分配足够子信道传输本地模型参数,因而该方案的损失最大。

|

图 6 不同优化方案下的联邦学习训练损失 Figure 6 Federated learning training losses under different optimization schemes |

图7对比了3种优化方案实现的无人机数字孪生边缘网络联邦学习训练准确率。从图中可以看出,随着联邦学习全局训练回合数增加,3种优化方案的联邦学习训练准确率都能逐渐增加并趋于稳定值。其次,本文方案可以获得最大的全局模型准确率。与图6的分析一致,只优化子信道分配的方案中全局模型的准确率低于本文方案,而只优化无人机轨迹的方案中全局模型的准确率最低。

|

图 7 不同优化方案下的联邦学习训练准确率 Figure 7 Federated learning training accuracy under different optimization schemes |

本文采用联邦学习,提出基于无人机数字孪生边缘网络的联邦学习资源调度机制。考虑无人机数字孪生边缘网络环境的动态时变性,建立联合无人机飞行距离、飞行角度以及无线网络子信道分配的联邦学习自适应资源优化模型,实现最小化无人机数字孪生边缘网络联邦学习时延的目标。提出基于孪生网络模型的MA-DDPG算法,求解联邦学习自适应资源优化模型。仿真结果表明,本文方案可显著降低联邦学习时延性能,同时保证联邦学习损失函数和准确率的优越性。下一步工作将研究无人机数字孪生边缘网络中集成联邦学习与现有隐私保护技术,例如差分隐私技术,并将设计新的隐私保护框架和资源优化机制。

| [1] |

GERACI G, RODRIGUEZ A, AZARI M, et al. What will the future of UAV cellular communications be? A flight from 5G to 6G[J].

IEEE Communications Survey & Tutorials, 2022, 24(3): 1304-1335.

|

| [2] |

JIANG L, CHEN B, XIE S L, et al. Incentivizing resource cooperation for blockchain empowered wireless power transfer in UAV networks[J].

IEEE Transactions on Vehicular Technologies, 2020, 69(12): 15828-15841.

DOI: 10.1109/TVT.2020.3036056. |

| [3] |

HAZRA K, SHAH V K, ROY S, et al. Exploring biological robustness for reliable multi-UAV networks[J].

IEEE Transactions on Network and Service Management, 2021, 18(3): 2776-2788.

DOI: 10.1109/TNSM.2021.3077544. |

| [4] |

TRIPATHY A, TRIPATHY K, MOHAPATRA G, et al. WeDoShare: a ridesharing framework in transportation cyber-physical system for sustainable mobility in smart cities[J].

IEEE Consumer Electronics Magazine, 2020, 9(4): 41-48.

DOI: 10.1109/MCE.2020.2978373. |

| [5] |

HU C H, FAN W C, ZENG E, et al. Digital twin-assisted real-time traffic data prediction method for 5G-enabled Internet of Vehicles[J].

IEEE Transactions on Industrial Informatics, 2022, 18(4): 2811-2819.

DOI: 10.1109/TII.2021.3083596. |

| [6] |

WANG Z R, GUPTA R, HAN K, et al. Mobility digital twin: concept, architecture, case study, and future challenges[J].

IEEE Internet of Things Journal, 2022, 9(18): 17452-17467.

DOI: 10.1109/JIOT.2022.3156028. |

| [7] |

KONECNY J, MCMAHAN H B, RAMAGE D. Federated optimization: distributed machine learning for on-device intelligence[J]. arXiv: 1610.02527(2016-10-8) [2023-10-11]. https://arxiv.org/abs/1610.02527.

|

| [8] |

KHAN L U, SAAD W, HAN Z, et al. Federated learning for Internet of things: recent advances, taxonomy, and open challenges[J].

IEEE Communications Surveys & Tutorials, 2021, 23(3): 1759-1799.

|

| [9] |

蒋丽, 谢胜利, 张彦. 面向6G网络的联邦学习资源协作激励机制设计[J].

广东工业大学学报, 2021, 38(6): 47-52,83.

JIANG L, XIE S L, ZHANG Y. Incentivizing resource cooperation for federated learning in 6G networks[J]. Journal of Guangdong University of Technology, 2021, 38(6): 47-52,83. DOI: 10.12052/gdutxb.210114. |

| [10] |

SONG Y, WANG T, WU Y, et al. Non-orthogonal multiple access assisted federated learning for UAV swarms: an approach of latency minimization[C]//2021 International Wireless Communications and Mobile Computing (IWCMC). Harbin, China: IEEE, 2021: 1123-1128.

|

| [11] |

CHENG Z, XIA X, MIN M, et al. Auction-promoted trading for multiple federated learning services in UAV-aided networks[J].

IEEE Transactions on Vehicular Technology, 2022, 70(10): 10960-10974.

|

| [12] |

SUN W, XU N, WANG L, et al. Dynamic digital twin and federated learning with incentives for air-ground network[J].

IEEE Transactions on Network Science and Engineering, 2022, 9(1): 321-333.

DOI: 10.1109/TNSE.2020.3048137. |

| [13] |

LI B, LIU Y F, TAN L, et al. Digital twin assisted task offloading for aerial edge computing and networks[J].

IEEE Transactions on Vehicular Technology, 2022, 71(10): 10863-10877.

DOI: 10.1109/TVT.2022.3182647. |

| [14] |

CHEN X , CHEN T, ZHAO Z , et al. Resource awareness in unmanned aerial vehicle-assisted mobile-edge computing system[C]//2020 IEEE 91st Vehicular Technology Conference (VTC2020-Spring). Antwerp, Belgium: IEEE, 2020.

|

| [15] |

RYAN L, YI W, AVIV T, et al. Multi-agent actor-critic for mixed cooperative- competitive environments[J]. arXiv: 1706.02275(2017-6-7) [2023-10-12]. https://arxiv.org/abs/1706.02275.

|

| [16] |

KRIZHEVSKY A, HINTON G. Learning multiple layers of features from tiny images[EB/OL]. (2009-04-08)[2023-12-28]. http://www.cs.toronto.edu/~kriz/learning-features-2009-TR.pdf.

|

2024, Vol. 41

2024, Vol. 41