2. 汕头大学 理学院, 广东 汕头 515063

2. College of Science, Shantou University, Shantou 515063, China

鸡尾酒会问题[1]是指提出的语音处理方法具有如人类般能在嘈杂环境和多说话人场景中准确识别单一说话人声音的能力。得益于深度学习技术提升,前期大量基于单通道语音分离研究方法[2-10]在解决鸡尾酒会问题上取得了一定的效果。近来,为了更好地解决鸡尾酒会问题,提出了目标说话人提取(Target Speaker Extraction) 任务[11],目标是:给定目标说话人注册音频作为辅助信息,自动地将目标说话人音频从混合音频中提取出来。主流的研究方法一般包含提取网络和辅助网络来解决目标说话人提取。辅助网络(或称说话人编码器)是通过输入目标说话人注册音频编码得到说话人嵌入[12]。提取网络则利用说话人嵌入从混合音频中提取目标说话人音频。

当前主流研究工作的重点一是在如何提出更好辅助网络学习编码说话人嵌入。VoiceFilter[13]、SpEx[14]、SpEx+[15]将辅助网络从简单的前馈神经网络与循环神经网络的组合替换为带残差结构的卷积神经网络,以提高辅助网络对说话人嵌入的表达能力。近两年来,辅助网络的研究重点转变为提高复杂场景下说话人嵌入的性能。例如,SpEx++[16] 使用语音段级别和帧级别的参考信号来进行多阶段的学习以提高注册音频过短导致的提取性能下降。类似的利用多阶段提取增强说话人嵌入的思路也被DPRNN-Spe[17]用于增强模型在处理未知说话人或注册音频与目标音频声纹信息不匹配的情况下的鲁棒性。

另外,也有研究工作关注如何将目标说话人提取与其他语音相关任务相结合。例如,WASE[18]结合注意力机制利用说话人嵌入预测目标说话人的语音活动检测(Voice Activity Detection,VAD)标签,引导模型进行细粒度的提取。TEA-PSE[19-20]等方法则是将目标说话人提取纳入个性化语音增强的框架中,利用语音增强的技术增强目标语音,抑制非目标语音以及噪声。此外还有一些工作着力于修改目标说话人提取的训练框架。如文献[21]提出的说话人感知混合物训练(Speaker-aware Mixture of Mixtures Training,SAMoM)使用包含相同目标说话人的2个混合信号作为模型输入,利用目标源之间说话人身份的一致性完成对目标说话人的识别和提取。文献 [22]则是将混合信号中出现的第一个说话人作为目标说话人,通过对语音开头部分进行建模,在不借助注册音频的情况下提取目标说话人语音。

当前主流研究工作的重点二是在提取网络如何利用说话人嵌入对混合音频进行目标说话人语音的提取。VoiceFilter、SpEx、SpEx+、SpEx++等方法均是将说话人嵌入以偏置的形式添加到混合音频的语义嵌入中。SpeakerBeam [23]则是利用多分支网络,将说话人嵌入以加权的方式混合音频的语义嵌入组合起来。尽管SpEx(SC) [24]利用注意力机制[25],通过考虑说话人嵌入与混合音频的相关性有针对性地进行特征的融合,但是过程说话人嵌入不参与更新。

现有的目标说话人提取方法尽管已经取得了显著的提升,但是在困难样本上依然存在严重的说话人混淆问题[26]。现有方法在提取网络中缺乏了基于混合音频的语义嵌入对说话人嵌入的反馈更新机制。同样地,对于辅助网络来说,现有的工作都仅是基于注册音频学习说话人嵌入,没有有效利用混合音频进行辅助学习。提取网络和辅助网络交互机制的缺失,导致了当混合音频中的目标音频与注册音频中包含的声音特性存在较大差异时,辅助网络无法仅基于注册音频学习有效的说话人嵌入,后续提取网络的分离也缺乏相应的机制更新该说话人嵌入,从而导致后续提取网络的分离性能下降。

为了解决上述问题,本文提出说话人感知的交叉注意力说话人提取网络(Speaker-aware Cross Attention Extraction Network , SACAN) 。SACAN在提取说话人嵌入的过程,设计了基于注意力的说话人聚合模块,使得注册音频中的关键信息能够聚合到说话人嵌入当中,并以获得的说话人嵌入作为线索,利用混合音频的帧级说话人嵌入序列通过交叉注意力机制的更新以获得适配程度更高的说话人嵌入。SACAN在提取网络中提出基于交叉注意力构建交互机制,实现了混合音频的语义嵌入与说话人嵌入的直接交互,并且建立了由语义嵌入对说话人嵌入的反馈机制,增强了提取网络说话人感知能力。最后,本文在优化目标中添加了针对提取网络提取结果在说话人声音特性上面的监督。

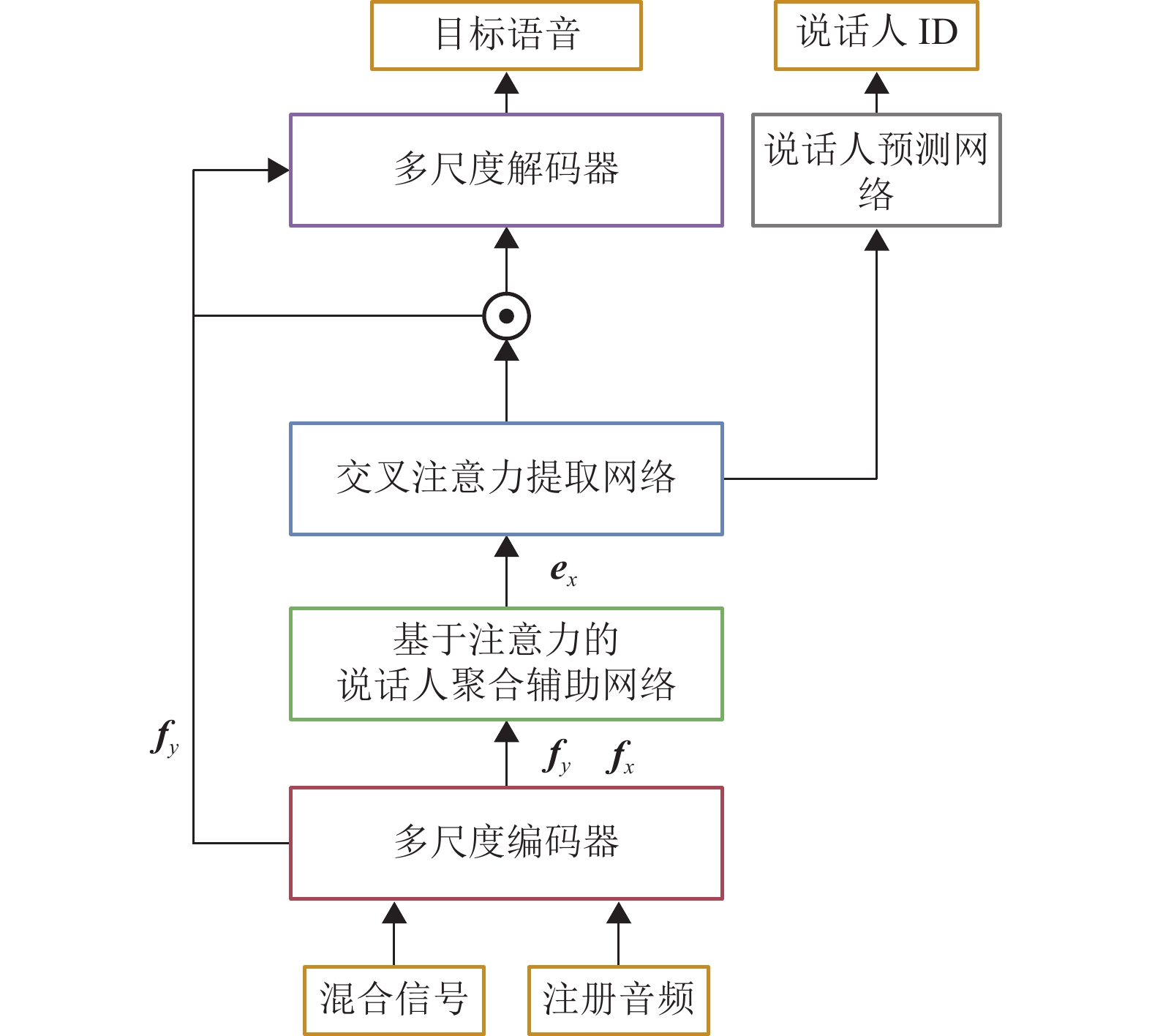

1 方法介绍本章节将详细介绍说话人感知的交叉注意力说话人提取网络。图1展示了模型的整体结构,其中,(1) 多尺度编码器:利用不同尺度的分析窗口将时域信号投影到特征空间。(2) 基于注意力的说话人聚合辅助网络:通过注意力机制,将注册音频和混合音频中有利于说话人提取的关键信息聚合到说话人嵌入。(3) 交叉注意力提取网络:利用两阶段的注意力机制构建混合音频的语义嵌入与说话人嵌入之间双向的交互方式,逐步分离目标说话人,再通过掩码预测网络获得提取目标说话人的掩码。并将最后一个交叉注意力提取模块的输出聚合成类说话人表示,作为提取网络在说话人声音特性层面的提取结果。(4) 语音信号重构与损失函数:解码网络利掩码提取后的特征进行语音信号重构,随后使用SI-SDR度量重构信号的损失,同时将说话人嵌入和类说话人嵌入送入说话人分类器进行说话人识别任务,其中使用多分类交叉熵作为损失函数进行度量。

|

图 1 模型整体结构 Figure 1 Overall structure of the model |

本文首先对目标说话人提取任务进行公式定义。令混合音频由一条目标说话人语音

| $ {{\boldsymbol{y}}} = {{\boldsymbol{s}}} + \sum\limits_{i = 1}^I {{{{\boldsymbol{z}}}_i}} $ | (1) |

式中:

| $ {\hat {\boldsymbol{s}}} = {{\boldsymbol{\varGamma }}}({{\boldsymbol{y}}},{{\boldsymbol{x}}}) $ | (2) |

式中:

现阶段,使用一维卷积作为可学习编码器已成为语音分离任务的主流。这是因为在语音重构损失函数的监督下,可学习编码器会主动适配语音分离任务,使得不同说话人在特征空间上更容易被掩码分开。因此,本文沿用了SpEx+中的多尺度编码器。该编码器通过使用多个大小不同的一维卷积在混合音频

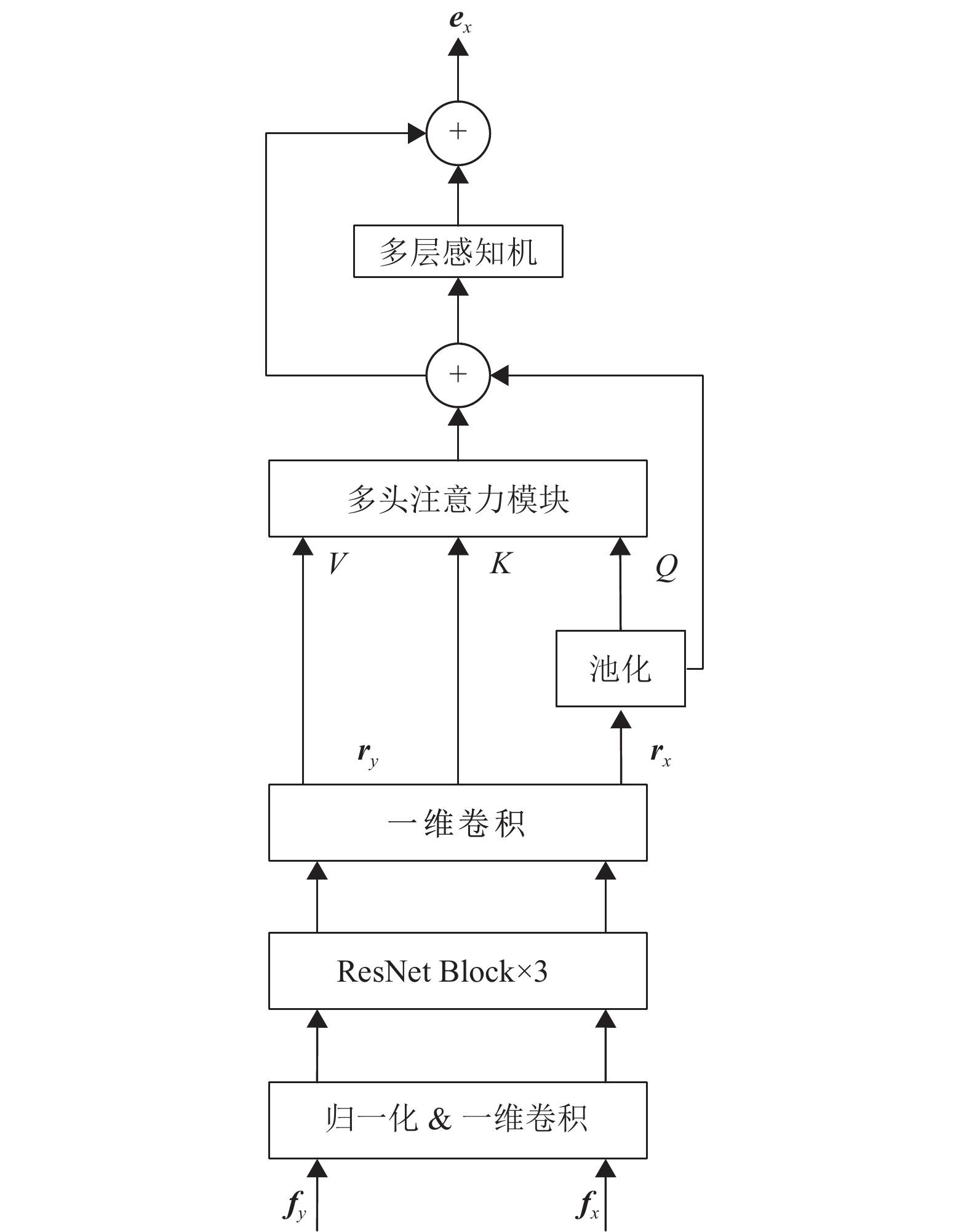

在经过多尺度编码器处理混合音频和注册音频得到语义嵌入序列

|

图 2 模型整体结构 Figure 2 Overall structure of the model |

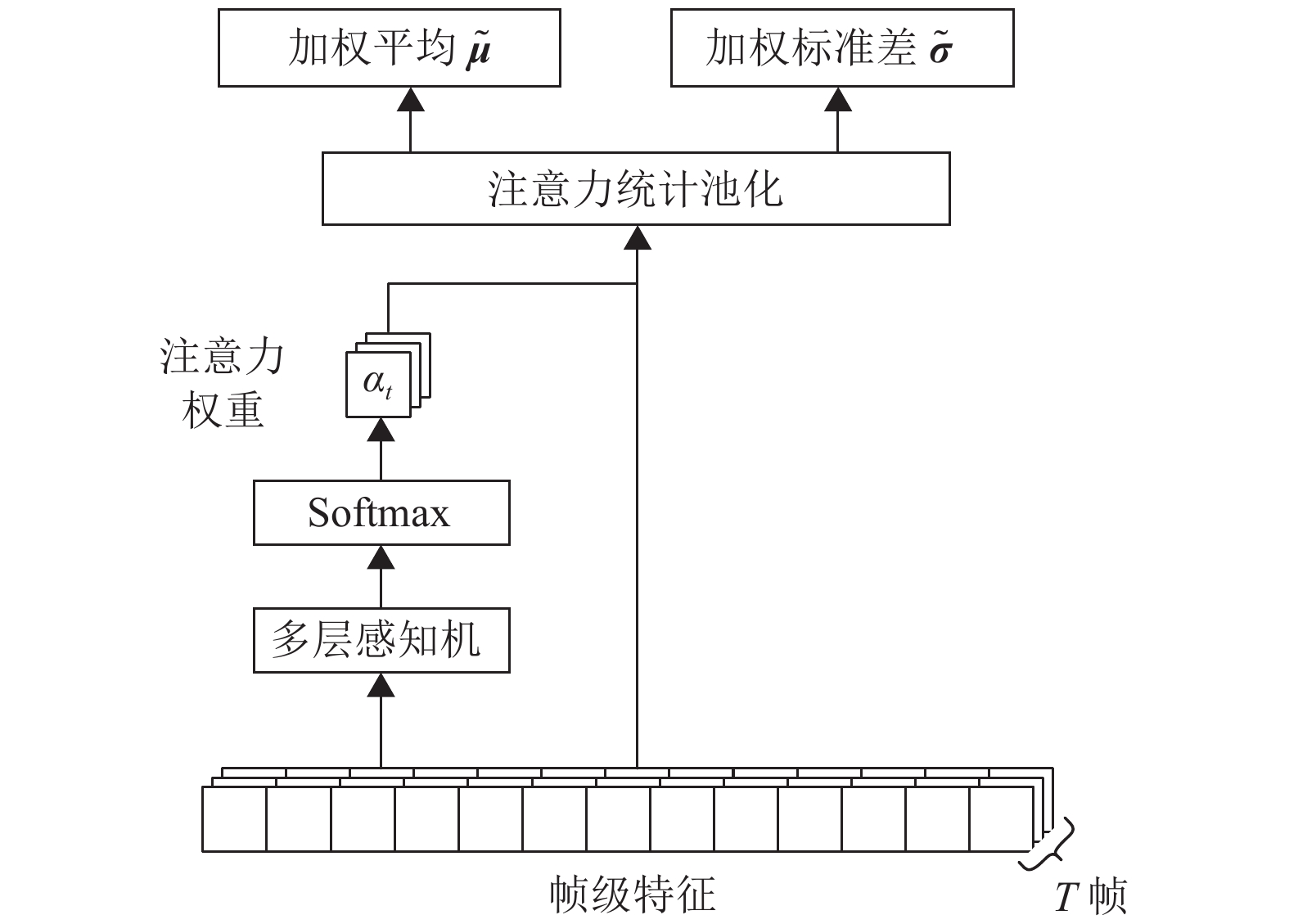

在对注册音频的帧级说话人嵌入序列

| $ {\tilde {\boldsymbol{\mu }}} = \frac{1}{N}\sum\limits_{n = 1}^N {{\alpha _n}{{\boldsymbol{r}}}_x^n} $ | (3) |

| $ {\tilde {\boldsymbol{\sigma }}} = \sqrt {\sum\limits_{n = 1}^N {{\alpha _n}{{\boldsymbol{r}}}_x^n \cdot {{\boldsymbol{r}}}_x^n - {\tilde {\boldsymbol{\mu }}}} \cdot {\tilde {\boldsymbol{\mu }}}} $ | (4) |

| $ {{\boldsymbol{e}}} = \left[ {{\tilde {\boldsymbol{\mu }}},{\tilde {\boldsymbol{\sigma }}}} \right] $ | (5) |

式中:

|

图 3 注意力统计池化 Figure 3 Attentive statistics pooling |

与全局平均池化相比,注意力统计池化考虑了不同帧中所蕴涵的说话人声音特性的多少,因此能将包含目标说话人声音特性的关键帧聚合到说话人嵌入中,而说话人的长期变化可以以标准差的形式聚合到说话者嵌入中。因此,注意力统计池化聚合的说话人嵌入有更强大的表达能力,并且能有效聚合注册音频中的关键信息。

虽然使用注意力统计池化可以提高注册音频的说话人嵌入的可识别性,但是当注册音频与目标音频的声音存在一定差距时,只通过注册音频计算得到的说话人嵌入仍存在有偏差的可能。并且由于混合音频中的目标音频会被干扰说话人所掩蔽,直接对混合音频提取说话人嵌入并不能得到准确的目标语音对应的声音特性。因此本文提出了使用交叉注意力机制将从注册音频中提取的说话人嵌入

在模型得到混合音频的语义嵌入

| $ {{{\boldsymbol{o}}}_1}\left( t \right) = {{\boldsymbol{W}}}_y^1{{{\boldsymbol{f}}}_y}\left( t \right) + {{\boldsymbol{W}}}_e^1{{{\boldsymbol{e}}}_x} + {{{\boldsymbol{b}}}_1} $ | (6) |

| $\begin{split} {{{\boldsymbol{o}}}_2}\left( t \right) =& \displaystyle\sum\limits_{k = \left\lceil {K/2} \right\rceil }^K {} {{\boldsymbol{W}}}_{}^2{{{\boldsymbol{o}}}_1}\left( {t - k} \right) + {{{\boldsymbol{b}}}_2} =\displaystyle\sum\limits_{k = \left\lceil {K/2} \right\rceil }^K {} {{\boldsymbol{W}}}_y^2{{\boldsymbol{W}}}_y^1{{{\boldsymbol{f}}}_y}(t - k) + \\ &K{{\boldsymbol{W}}}_e^2{{\boldsymbol{W}}}_e^1{{{\boldsymbol{e}}}_x} + (7) K{{\boldsymbol{W}}}_{}^2{{{\boldsymbol{b}}}_1} + {{{\boldsymbol{b}}}_2}\\[-10pt]\end{split} $ | (7) |

式中:

通过分析可以发现,以上仿射变换只是学习了两种特征的加权,没有让两种特征直接交互,并且由于拼接到每一帧的说话人嵌入是相同的,因此对于说话人嵌入来说,使用卷积网络的作用与使用全连接网络的作用是等价的。在SpEx+的后续改进中,SpEx(SC) 提出在混合语义嵌入

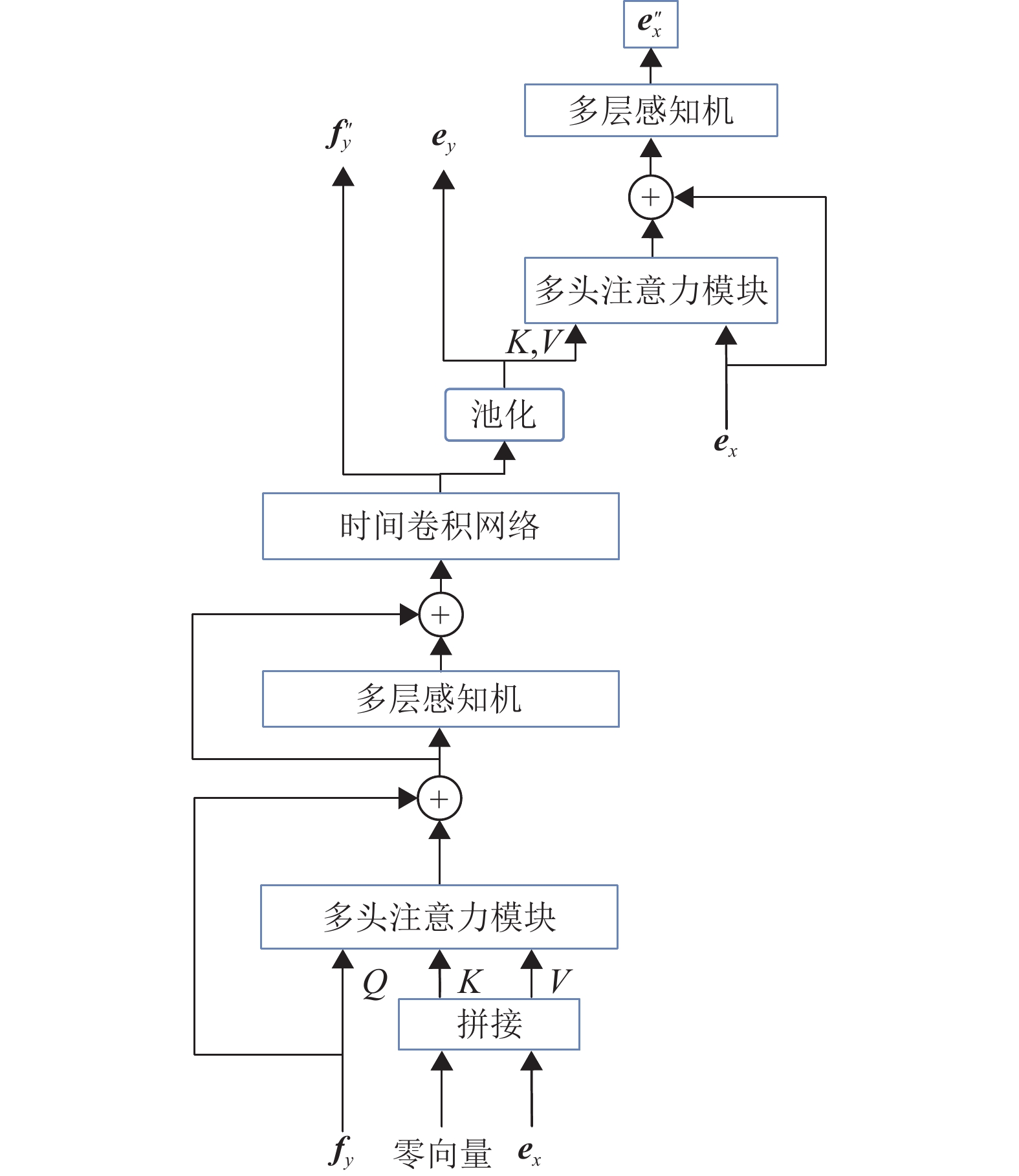

基于以上分析,本文提出的交叉注意力提取模块有着以下特点:(1) 避免在长序列之间使用注意力机制,以节省引入巨额的计算开销;(2) 使说话人嵌入

|

图 4 交叉注意力提取模块 Figure 4 Cross attention extraction module |

首先,将

| $ {{{\boldsymbol{f}}'_y}} = {{{\boldsymbol{f}}}_y} + {{{\boldsymbol{F}}}_{{\text{MHA}}}}({{{\boldsymbol{f}}}_y},{{{\boldsymbol{e}}}_x},{{{\boldsymbol{e}}}_x}) $ | (8) |

| $ {{{\boldsymbol{f}}''_y}} = {{{\boldsymbol{F}}}_{{\text{MLP}}}}({{{\boldsymbol{f}}'_y}}) + {{{\boldsymbol{f}}'_y}} $ | (9) |

式中:

随后,语义嵌入

随着语义嵌入的不断更新,最初的说话人嵌入

| $ {{{\boldsymbol{e}}}_y} = {{{\boldsymbol{F}}}_{{\text{ASP}}}}({{{\boldsymbol{f}}'''_y}}) $ | (10) |

| $ {{{\boldsymbol{e}}'_x}} = {{{\boldsymbol{e}}}_x} + {{{\boldsymbol{F}}}_{{\text{MHA}}}}({{{\boldsymbol{e}}}_x}, {{{\boldsymbol{e}}}_y},{{{\boldsymbol{e}}}_y}) $ | (11) |

| $ {{{\boldsymbol{e}}''_x}} = {{{\boldsymbol{F}}}_{{\text{MLP}}}}({{{\boldsymbol{e}}'_x}}) + {{{\boldsymbol{e}}'_x}} $ | (12) |

式中:

经过交叉注意力提取网络处理后,网络输出的特征有:(1) 最后一层的语义嵌入

在获得只包含目标说话人的语义嵌入

| $ {\hat {\boldsymbol{s}}} = {{{\boldsymbol{F}}}_{{\text{dec}}}}({{{\boldsymbol{f}}}_s}) $ | (13) |

式中:

| $ {{{\boldsymbol{s}}}_{{t}}} = \frac{{\left\langle {{\hat {\boldsymbol{s}}},{{\boldsymbol{s}}}} \right\rangle {{\boldsymbol{s}}}}}{{{{\left\| {{\boldsymbol{s}}} \right\|}^2}}} $ | (14) |

| $ {{{\boldsymbol{e}}}_{{n}}} = {\hat {\boldsymbol{s}}} - {{{\boldsymbol{s}}}_{{t}}} $ | (15) |

| $ {\text{SI-SDR}}\left( {{\hat {\boldsymbol{s}}},{{\boldsymbol{s}}}} \right) = 10{\lg }\frac{{{{\left\| {{{{\boldsymbol{s}}}_{{t}}}} \right\|}^2}}}{{{{\left\| {{{{\boldsymbol{e}}}_{{n}}}} \right\|}^2}}} $ | (16) |

因此音频重构的损失函数LR可以表示为

| $ \begin{gathered} {L_{\rm{R}}} = - [(1 - \alpha - \beta ) {\text{SI-SDR}}({{{\hat {\boldsymbol{s}}}}_1},{{\boldsymbol{s}}}) + \\ \begin{array}{*{20}{c}} {}&{} \end{array}\alpha {\text{SI-SDR}}{(_{}}{{{\hat {\boldsymbol{s}}}}_2},{{\boldsymbol{s}}}) + \beta {\text{SI-SDR}}({{{\hat {\boldsymbol{s}}}}_3},{{\boldsymbol{s}}}) ] \\ \end{gathered} $ | (17) |

式中:

对于说话人嵌入

| $ {L_{\rm{S}}} = {L_{{\text{CE}}}}({{\hat {\boldsymbol{p}}}_x},{{\boldsymbol{p}}}) + {L_{{\text{CE}}}}({{\hat {\boldsymbol{p}}}_y},{{\boldsymbol{p}}}) $ | (18) |

式中:

| $ L = {L_{\rm{R}}} + \lambda {L_{\rm{S}}} $ | (19) |

式中:

Libri2Mix[30]是基于LibriSpeech[31]数据集生成的语音分离数据集,该数据集由train-360、train-100、dev、test 4个子集组成,每个子集中包含混合音频、1号说话人(Spk1) 音频、2号说话人(Spk2) 音频组成。本文使用train-360和test子集,并以8 kHz的采样率进行实验。由于dev子集与train-360的说话人集合并没有交集,模型的说话人分类器无法预测验证集中的说话人,无法使用模型在验证集上的说话人分类损失评估辅助网络的收敛情况。因此,本文从train-360中随机选出3000个音频作为验证集。实验数据集概览如表1所示。在训练和测试过程中,本文将混合音频中的第1个说话人(Spk1) 作为目标说话人,第2个说话人(Spk2) 作为干扰说话人,并且在目标说话人的所有语音中随机挑选除目标音频以外的音频作为注册音频。

| 表 1 训练集、验证集、测试集概览 Table 1 Overview of the train, validation and test sets |

针对语音提取质量,本文将采用SI-SDRi、SDRi和短时目标可懂度[32](Short-time objective intelligibility, STOI) 进行评估。SI-SDRi被定义为分离后语音和混合音频相对目标音频SI-SDR的差值,计算公式为

| $ {\text{SI-SDRi}} = {\text{SI-SDR}}\left( {{\hat {\boldsymbol{s}}},{{\boldsymbol{s}}}} \right) - {\text{SI-SDR}}\left( {{{\boldsymbol{y}}},{{\boldsymbol{s}}}} \right) $ | (20) |

这个指标比起SI-SDR更好地考虑了混合音频本身的源干扰比(Source-to-interference Ratio, SIR) ,从而更客观地评估模型的表现。SDRi的定义基于SDR(Signal-to-distortion Ratio) ,其作用与SI-SDRi类似,本文也会给出该指标作为参考。

2.3 基线模型本文选取了Conv-TasNet模型、VoiceFilter、TD-SpeakerBeam[33]、SpEx+模型以及SpEx+的改进模型SpEx(SC) 作为对比方法。

Conv-TasNet模型是语音分离中的经典模型,其主要结构是其编码器和解码器为一维卷积,其提取网络结构主要是时域卷积网络。该模型由于结构上与SpEx+的提取网络相似,因此用来比较现阶段目标说话提取任务与语音分离任务之间的性能差距。

VoiceFilter和TD-SpeakerBeam是单通道目标说话人提取领域中公认的经典模型。其中VoiceFilter利用BiLSTM将预训练模型导出的说话人嵌入dvector与混合音频的语义嵌入进行融合并预测提取目标语音的幅度谱掩码,最后利用混合信号的相位与模型估计的幅度谱重构目标语音。而TD-SpeakerBeam是一个时域目标说话人提取模型,该模型使用利用多分支网络的方式融合说话人嵌入与混合信号的语义嵌入,以此分离目标说话人的语音。上述模型在基于WSJ0生成的模拟数据WSJ2Mix上取得不错的分离效果。而SpEx+是目前已开源的单通道目标说话人提取模型中性能表现最好的模型。它的结构是本文提出SACAN的雏形。由于VoiceFilter、TD-SpeakerBeam以及SpEx+的相关论文中只报告了在WSJ2Mix的测试结果,因此本文将根据论文提供的开源代码在Libri2Mix的train-360数据集上对模型结果进行复现。

SpEx(SC) 模型则是基于SpEx+的改进,在SpEx+中,提取网络的后两层被发现没有充分利用说话人嵌入。因此SpEx(SC) 修改了提取网络后两层特征融合的方式,将说话人嵌入拼接到语义嵌入尾部,并利用自注意力的方式将说话人嵌入添加到语义嵌入中。随后,说话人嵌入会从语义嵌入尾部移除以保证说话人嵌入不会更新。

2.4 实验设置在本文的实验中,所有目标说话人提取系统均使用Pytorch框架实现。所有系统以4 s音频片段作为模型的输入,大部分系统以初始学习率0.001训练,在训练集上迭代最多100轮,SpEx+(SC) 则是按照原论文0.00001的学习率进行训练。学习率将会在连续2次验证集效果无提升的情况下衰减一半,并且模型连续6次在验证集效果无提升的情况下提前终止训练。为了节省计算资源和实验周期,所有的实验上均采用混合精度的方式进行训练。

在SACAN、SpEx+和SpEx+(SC) 中,本文均采用相同的多尺度编码器设置,3个编码器的分析窗口分别为2.5,10,20 ms。在说话人编码网络中,ResNet Block的数量设为3,SpEx+说话人嵌入的维度被设置为256维,由于SACAN使用了注意力统计池化,所以SACAN的说话人嵌入维度为512。对于音频重构损失,本文设置

语音分离任务与目标说话人提取任务在模型输出方面存在差异。为了能够比较这两类任务的模型性能,对于每条测试音频,目标说话人提取模型会把混合音频中的2个说话人提取出来,分别计算SI-SDRi再取平均作为该测试音频的测试结果。

所有模型的结果如表2所示,其中指标STOI、SI-SDRi、SDRi均是分数越高代表模型效果越好,并且最优分数会以加粗标识。

| 表 2 Libri2Mix测试结果 Table 2 Test results on the Libri2Mix |

由表2可知,SpEx+的效果略逊色于网络结构相似的Conv-TasNet,这说明SpEx+中存在没有充分利用注册音频中的先验信息的情况,以至于提取模型在借助辅助信息的情况下,提取模型的提取表现仍不如Conv-TasNet这一语音分离模型。这一结果佐证了与文献[26]中指出的目前部分网络结构相似的目标说话人提取模型的性能不如语音分离模型的论断。而SpEx(SC) 通过在提取网络的后两层使用交叉注意力替代原本的拼接融合,结果才得以反超Conv-TasNet。这一改进表明,可以利用注意力机制更有效地利用辅助信息,从而提高对目标说话人提取性能。

表2中VoiceFilter与其他模型在性能上有一定差距,这是因为VoiceFilter只估计目标语音的幅度谱,并借助混合音频的相位信息重构音频,该做法会导致幅度谱与相位谱不匹配,从而降低了模型的提取质量。

与其他基线模型相比,本文提出的SACAN模型在STOI和SI-SDRi上均有较为明显的提升,其中SACAN相比SpEx+的STOI和SI-SDRi分别提升了0.0133和1.0695。相比SpEx(SC) ,SACAN在STOI和SI-SDRi也有0.0125和0.5167的提升。这足以说明SACAN的有效性。

本文还发现了SACAN的SDRi比其余2个模型要低。这是因为SDR在计算上会考虑预测结果和目标音频在音量大小上的差异。由此可见,SACAN输出的结果在音量大小上与目标语音是不一致的。但是音量大小的差异对于语音分离任务来说是可接受的,因为这并不代表提取结果丢失了语义层面的信息,并且输出音量与目标语音不一致的问题可以被音频响度归一化的后处理手段所解决。

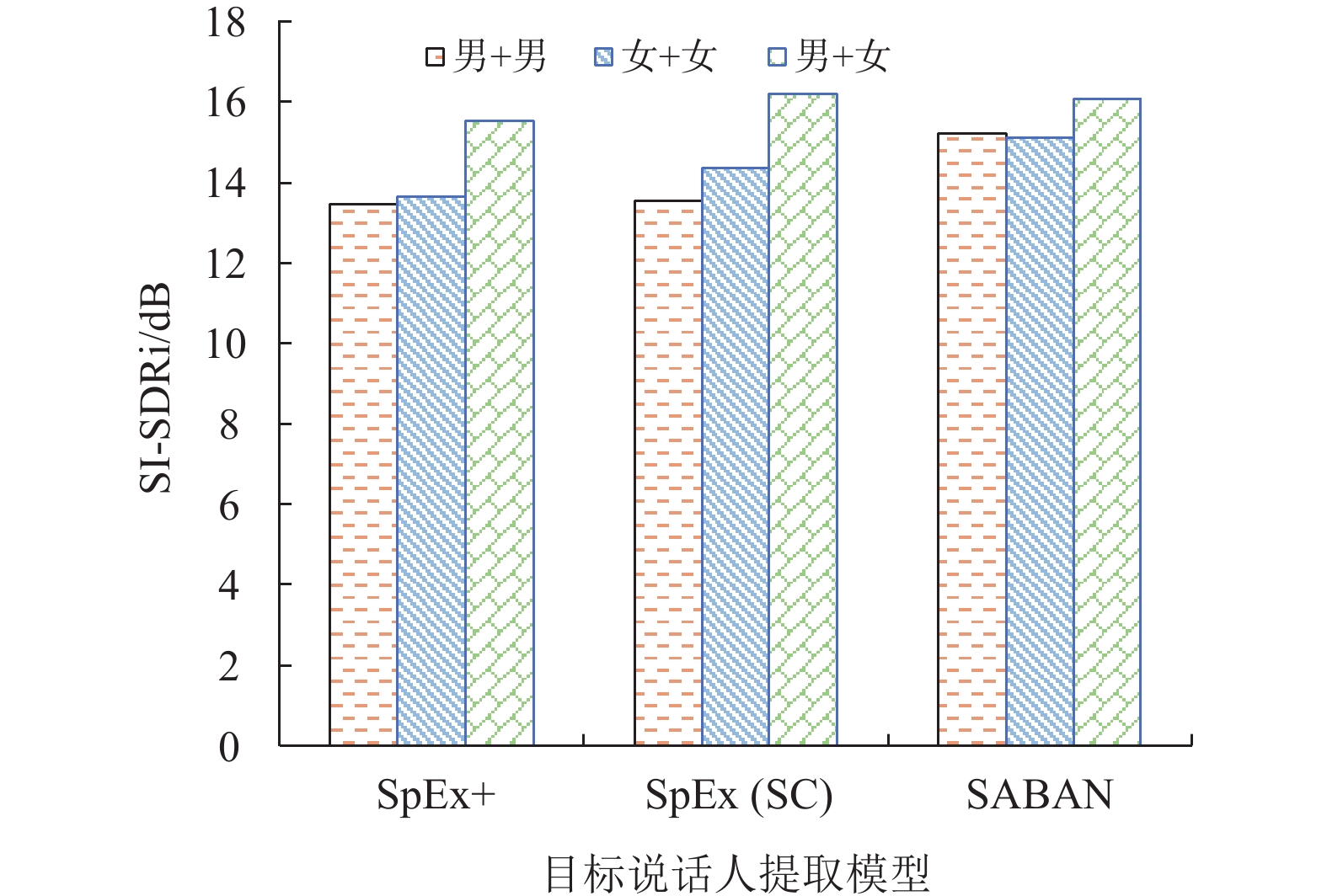

3.2 性别对提取结果的影响本文还评估了混合音频中出现的性别组合对模型提取结果的影响。一般而言,同性的说话人之间声音更有可能相似,因此目标说话人提取在处理由同性说话人构成的混合音频时会更容易发生混淆,进而导致提取性能下降。本文将测试结果根据性别组成进行分组,揭示不同模型提取的说话人嵌入是否依赖与于男女性别差异带来的声音特征差异。结果如图5所示。

|

图 5 不同性别分组下模型性能表现 Figure 5 Model performance under different gender groups |

图5给出了测试集的混合音频中出现的3种性别组合男+男、女+女、男+女的分数情况。其中,男+女的分组SI-SDRi会比其他性别组合的分数要高,这一结果符合性别构成不同的混合音频更容易进行提取的直观判断。对比图5中SpEx+模型以及SpEx(SC) 模型在男+男、女+女和男+女的设置下的分数,可以发现这两个模型在性别相同的分组分数远低于性别不同分组的分数,这说明这两个模型在目标说话人声音特性相近的情况下处于劣势。并且SpEx(SC) 在女+女的设置中明显高于男+男的分数,这揭示了该模型在对不同女声时有着更高的辨识度。与之相比,本文提出的SACAN的男+男和女+女组合的分数并没有与男+女的组合拉开太大的差距,而且模型在男+男和女+女的设置下表现也十分相近。这说明SACAN的交互学习机制有助于模型学习与建模不依赖性别的特征表示,使其在各种性别组合设置下能够提取更有区分度的说话人嵌入。

3.3 说话人混淆度评估针对说话人混淆的评估,由于测试集中的说话人并未出现在训练集中,因此无法通过说话人识别的正确率评估说话人混淆。并且由于不同模型提取的说话人嵌入存在巨大差异,难以通过说话人嵌入的距离度量判断说话人是否发生混淆。因此,在本文的实验中,会以提取结果的SI-SDRi作为判断是否发生说话人混淆的依据。

首先,本文分别将Spk1、Spk2作为目标说话人,从混合音频中提取相应的目标说话人语音并计算其SI-SDRi,结果见表3。

| 表 3 不同模型提取不同目标说话人结果 Table 3 Results of extracting different target speakers by different models |

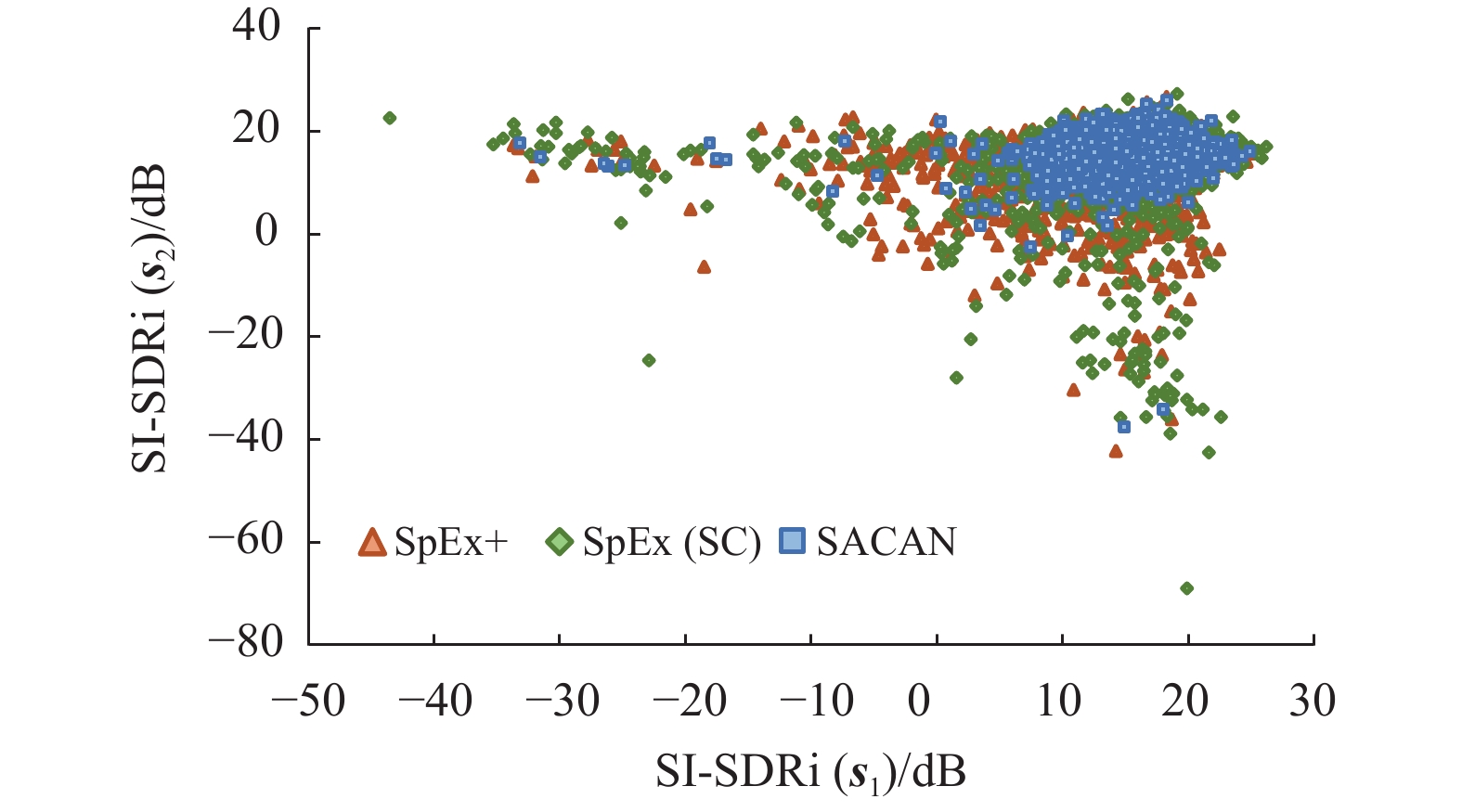

表3中,不同模型提取不同说话人的整体结果差异并不大,并不能反映出模型是否因为说话人混淆导致了提取性能的差异。为了进一步发掘模型提取结果的差异,本文使用了散点图表示不同模型在提取不同说话人时结果的分布,如图6所示。其中横坐标SI-SDRi(

|

图 6 提取不同说话人的SI-SDRi分布 Figure 6 SI-SDRi distribution of extracting different speakers |

在图6中,SpEx+和SpEx(SC) 预测的样本分布较为分散,而SACAN的样本大部分聚集在散点图的右上部分。据统计SpEx+和SpEx(SC) 分布与其对应的中心坐标的标准差为(5.5695,5.417) 和(6.8626,7.2959) ,均高于SACAN的(3.6168,3.1016) 。由此可见,SACAN提取目标说话人的性能比起其他模型更为稳定。并且图6中Spex+和Spex(SC) 有不少的样本点的横坐标或纵坐标小于0。这说明了模型在利用注册音频提取目标语音时,不仅没有提取出目标语音,反而降低了目标语音相对干扰语音的信噪比。

为了进一步量化模型说话人混淆程度,本文根据实践上的经验设定阈值,以此判断说话人是否发生混淆的情况。在本实验中,本文着重分析Spk1为目标说话人的测试结果。具体规则如下:

(1) 如果Spk1对应的语音与模型提取结果SI-SDRi大于等于10 dB,则认为模型提取结果为目标说话人,不存在混淆。这里并不需要考虑Spk1和Spk2对应的语音与模型提取结果均大于10 dB的情况。因为当这种情况发生时,两者的语音几乎是一样的,但该测试集中不存在这种情况。

(2) 如果Spk1对应的语音与模型提取结果SI-SDRi 在(−10,10) 范围内,且Spk2对应的语音与模型提取结果SI-SDRi小于10 dB,则可以认为模型受到一定程度上的混淆,以至于无法将目标音频较为干净地分离出来。

(3) 如果Spk1对应的语音与模型提取结果SI-SDRi 小于−10 dB,且Spk2对应的语音与模型提取结果SI-SDRi大于等于10 dB,则认为模型完全混淆了说话人,即给定目标说话人的注册音频实际提取确实干扰说话人。

根据以上规则,本文统计了3000条的测试数据的分布,结果如表4所示。SpEx+中存在较多的混淆情况,与之相比,SpEx(SC) 整体无混淆上优于SpEx+,但是SpEx(SC) 发生完全混淆的样本个数是将近SpEx+的两倍。该结果可能的解释是SpEx(SC) 的特征融合是建立在混合语义嵌入与说话人嵌入拼接序列的自注意力计算之上的,混合语义嵌入与说话人嵌入特征长度上的巨大差异,使得自注意力机制更容易捕获混合语义嵌入的上下文关系而不是说话人嵌入与混合语义嵌入之间的关系。这也可以解释SpEx(SC) 对语音提取质量的提升以及完全混淆样本变多的原因。SACAN中也发生了类似的混淆现象,但是整体的说话人混淆的情况比起其他模型少很多。这很大程度上归功于SACAN中基于注意力的说话人聚合模块捕捉到了提取目标说话人的关键信息。并且SACAN中存在语义嵌入对说话人嵌入的反馈机制,使得说话人嵌入始终可以适应不停变化的语义嵌入,从而避免了说话人的混淆,实现更好的提取效果。

| 表 4 说话人混淆情况统计 Table 4 Statistics of speaker confusion |

为了研究各个模块在提取中具体的效果,本文逐步拆解模型的各个部分进行消融实验,结果如表5所示。这里基线模型指的是SpEx+,A表示基于注意力的说话人聚合模块,B表示交叉注意力提取模块,C表示对使用交叉注意力模块提取出来的类说话人嵌入表示进行说话人识别的监督。

| 表 5 消融实验结果 Table 5 Results of ablation experiment |

在基线模型加入模块后A,模型获得了0.122的提升。这是符合直觉的,因为SpEx+中提取说话人嵌入的方式仅仅只是将说话人嵌入序列按照长度取平均。由于注册音频里也会存在非人声片段,因此用粗暴取平均的方式获得的说话人嵌入中,目标说话人的声音特性会在平均的作用下难以凸显。而A中ASP通过注意力机制可以更灵活地控制保留在说话人嵌入里的信息,避免非人声片段的干扰。并且在利用注意力机制更新说话人嵌入一定程度上能够提升说话人嵌入对提取任务的适配程度。

随后在基线模型+A+B的实验中,交叉注意力提取网络的引入给模型进一步带来0.8212的提升。这是因为基线模型原本的特征融合方式为拼接融合,这种方式过于简单粗暴,并没有直接引导模型利用说话人嵌入辨别目标说话人。而交叉注意力模型在与混合音频的语义嵌入融合时进行了直接的交互,使得融合更加高效。并且利用更新后的语义嵌入反过来更新说话人嵌入的做法,可以给予说话人嵌入一定的灵活性,从而避免说话人嵌入与语义嵌入之间的失配。

最终对由交叉注意力模块提取出来的类说话人嵌入进行监督,使模型在考虑提取结果与目标说话人在声音特性相似度的情况下进行提取。该改进给模型进一步带来了0.1263的提升。

4 结论本文提出了说话人感知的交叉注意力说话人提取网络SACAN。其核心在于在辅助网络和提取网络中引入说话人嵌入和混合音频语义嵌入的交互学习机制。在辅助网络中,通过设计基于注意力的说话人聚合模块,利用混合音频中目标语音的声音特性,优化说话人嵌入学习过程。在提取网络中,提出基于交叉注意力构建交互机制,实现了混合音频的语义嵌入与说话人嵌入的直接交互,增强说话人感知能力。在本文实验中,SACAN的语音提取质量相比基线模型均有明显的提升。同时针对模型的说话人混淆评估可知,模型在处理声音相似的说话人时有着更好的表现,且相比其他模型SACAN的说话人混淆程度大大降低。在后续的研究中,会进一步探讨表现更好的特征融合方式以及解决SACAN中输出音频和原始音频部分差异问题。

| [1] |

CHERRY E C. Some experiments on the recognition of speech, with one and with two ears[J].

The Journal of the Acoustical Society of America, 1953, 25(5): 975-979.

DOI: 10.1121/1.1907229. |

| [2] |

HERSHEY J R, CHEN Z, LE ROUX J, et al. Deep clustering: discriminative embeddings for segmentation and separation[C]//2016 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP) . Shanghai: IEEE, 2016: 31-35.

|

| [3] |

YU D, KOLBæK M, TAN Z H, et al. Permutation invariant training of deep models for speaker-independent multi-talker speech separation[C]//2017 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP). New Orleans: IEEE, 2017: 241-245.

|

| [4] |

CHEN Z, LUO Y, MESGARANI N. Deep attractor network for single-microphone speaker separation[C]//2017 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP) . New Orleans: IEEE, 2017: 246-250.

|

| [5] |

LUO Y, MESGARANI N. Conv-tasnet: surpassing ideal time–frequency magnitude masking for speech separation[J].

IEEE/ACM Transactions on Audio, Speech, and Language Processing, 2019, 27(8): 1256-1266.

DOI: 10.1109/TASLP.2019.2915167. |

| [6] |

LUO Y, CHEN Z, YOSHIOKA T. Dual-path RNN: efficient long sequence modeling for time-domain single-channel speech separation[C]//ICASSP 2020-2020 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP) . Online: IEEE, 2020: 46-50.

|

| [7] |

CHEN J, MAO Q, LIU D. Dual-path transformer network: direct context-aware modeling for end-to-end monaural speech separation[C]//Conference of the International Speech Communication Association. Online: ISCA, 2020: 2642-2646.

|

| [8] |

ZEGHIDOUR N, GRANGIER D. Wavesplit: end-to-end speech separation by speaker clustering[J].

IEEE/ACM Transactions on Audio, Speech, and Language Processing, 2021, 29: 2840-2849.

DOI: 10.1109/TASLP.2021.3099291. |

| [9] |

LAM M W Y, WANG J, SU D, et al. Sandglasset: a light multi-granularity self-attentive network for time-domain speech separation[C]//ICASSP 2021-2021 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP) . Online: IEEE, 2021: 5759-5763.

|

| [10] |

SUBAKAN C, RAVANELLI M, CORNELL S, et al. Attention is all you need in speech separation[C]//ICASSP 2021-2021 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP) . Online: IEEE, 2021: 21-25.

|

| [11] |

DELCROIX M, ZMOLIKOVA K, KINOSHITA K, et al. Single channel target speaker extraction and recognition with speaker beam[C]//2018 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP) . Calgary: IEEE, 2018: 5554-5558.

|

| [12] |

WAN L, WANG Q, PAPIR A, et al. Generalized end-to-end loss for speaker verification[C]//2018 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP) . Calgary: IEEE, 2018: 4879-4883.

|

| [13] |

WANG Q, MUCKENHIRN H, WILSON K, et al. VoiceFilter: targeted voice separation by speaker-conditioned spectrogram masking [C]//Conference of the International Speech Communication Association. Graz: ISCA, 2019: 2728-2732.

|

| [14] |

XU C, RAO W, CHNG E S, et al. Spex: multi-scale time domain speaker extraction network[J].

IEEE/ACM Transactions on Audio, Speech, and Language Processing, 2020, 28: 1370-1384.

DOI: 10.1109/TASLP.2020.2987429. |

| [15] |

GE M, XU C, WANG L, et al. SpEx+: a complete time domain speaker extraction network[C]//Conference of the International Speech Communication Association. Online: ISCA, 2020: 1406-1410.

|

| [16] |

GE M, XU C, WANG L, et al. Multi-stage speaker extraction with utterance and frame-level reference signals[C]//ICASSP 2021-2021 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP). Online: IEEE, 2021: 6109-6113.

|

| [17] |

DENG C, MA S, SHA Y, et al. Robust speaker extraction network based on iterative refined adaptation. [C]// Conference of the International Speech Communication Association. Online: 2021, 3530-3534.

|

| [18] |

HAO Y, XU J, ZHANG P, et al. Wase: learning when to attend for speaker extraction in cocktail party environments[C]//ICASSP 2021-2021 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP) . Online: IEEE, 2021: 6104-6108.

|

| [19] |

JI X, YU M, ZHANG C, et al. Speaker-aware target speaker enhancement by jointly learning with speaker embedding extraction[C]//ICASSP 2020-2020 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP). Online: IEEE, 2020: 7294-7298.

|

| [20] |

JU Y, RAO W, YAN X, et al. TEA-PSE: tencent-ethereal-audio-lab personalized speech enhancement system for ICASSP 2022 DNS CHALLENGE[C]//ICASSP 2022-2022 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP) . Singapore: IEEE, 2022: 9291-9295.

|

| [21] |

ZHAO Z, GU R, YANG D, et al. Speaker-aware mixture of mixtures training for weakly supervised speaker extraction [C]//Conference of the International Speech Communication Association. Incheon: ISCA, 2022, 5318-5322.

|

| [22] |

PANDEY A, WANG D L. Attentive training: a new training framework for talker-independent speaker extraction. [C]//Conference of the International Speech Communication Association. Incheon: ISCA, 2022, 201-205

|

| [23] |

DELCROIX M, ZMOLIKOVA K, KINOSHITA K, et al. Single channel target speaker extraction and recognition with speaker beam[C]//2018 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP) . Calgary Alberta: IEEE, 2018: 5554-5558.

|

| [24] |

WANG W, XU C, GE M, et al. Neural speaker extraction with speaker-speech cross-attention network[C]// Conference of the International Speech Communication Association. Online: 2021: 3535-3539.

|

| [25] |

VASWANI A, SHAZEER N, PARMAR N, et al. Attention is all you need[J].

Advances in Neural Information Processing Systems, 2017, 30: 5998-6008.

|

| [26] |

ZHAO Z, YANG D, GU R, et al. Target confusion in end-to-end speaker extraction: analysis and approaches. [C]//Conference of the International Speech Communication Association. Incheon: ISCA, 2022: 5333-5337.

|

| [27] |

OKABE K, KOSHINAKA T, SHINODA K. Attentive statistics pooling for deep speaker embedding[C]//Conference of the International Speech Communication Association. Hyderabad: ISCA, 2018: 2252-2256.

|

| [28] |

CHEN L C, PAPANDREOU G, KOKKINOS I, et al. DeepLab: semantic image segmentation with deep convolutional nets, atrous convolution, and fully connected CRFs[J].

IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017, 40(4): 834-848.

|

| [29] |

LE ROUX J, WISDOM S, ERDOGAN H, et al. SDR–half-baked or well done?[C]//ICASSP 2019-2019 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP) . Brighton: IEEE, 2019: 626-630.

|

| [30] |

COSENTINO J, PARIENTE M, CORNELL S, et al. Librimix: an open-source dataset for generalizable speech separation[EB/OL]. (2020-5-22) [2023-3-27].https://arxiv.org/abs/2005.11262.

|

| [31] |

PANAYOTOV V, CHEN G, POVEY D, et al. Librispeech: an ASR corpus based on public domain audio books[C]//2015 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP) . Brisbane: IEEE, 2015: 5206-5210.

|

| [32] |

TAAL C H, HENDRIKS R C, HEUSDENS R, et al. A short-time objective intelligibility measure for time-frequency weighted noisy speech[C]//2010 IEEE International Conference on Acoustics, Speech and Signal Processing. Dallas: IEEE, 2010: 4214-4217.

|

| [33] |

DELCROIX M, OCHIAI T, ZMOLIKOVA K, et al. Improving speaker discrimination of target speech extraction with time-domain speakerbeam[C]//ICASSP 2020-2020 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP) . Online: IEEE, 2020: 691-695.

|

2024, Vol. 41

2024, Vol. 41