验证码[1]的全称为全自动区分计算机和人类的图灵测试(Completely Automated Public Turing test to tell Computers and Humans Apart, CAPTCHA),是目前大多数网站或应用程序注册和登录的安全机制。随着技术的进步,各式各样的验证码被提出并实现,包括基于文本识别任务[2]、图像标注任务[3]、音频交互任务[4]、游戏交互[5]任务等。与其他类型验证码相比,基于文本的验证码,即字符型验证码,在设计上考虑到了人类的视觉特点,非常适合人类用户的阅读和填写,因其具有易于理解的特性和对用户友好的特点,被广泛应用于当前的互联网人机交互验证中。

一个好的验证码方案的特点很简单:人类容易识别,而机器无法识别[6]。如何在增强验证码方案安全性的同时提高用户友好性,是本文研究的重点,也是当前验证码安全方案研究领域的重大挑战。

在第1类研究中,研究人员往往是通过添加遮挡线、添加噪声、扭曲字符等方式来增加文本验证码的安全性。通过字符变形扭曲来提高文本验证码的安全性最早可以追溯到2003年的一篇由Luis等合著的文献中[1],该文提出了使用“填字游戏”作为验证码的想法,并通过对字符进行扭曲和变形来提高其安全性,以防止自动化攻击和垃圾邮件的泛滥,这篇论文被认为是验证码技术的开山之作。在此之后,陆续有更多的研究者使用此类方法为提高文本验证码的安全性做出了贡献。例如,Bursztein等[7]在对7种不同类型的传统文本验证码进行攻击测试后提出通过增加扰动、颜色、旋转、变形等方式来对验证码的安全性做出改进。由于起源较早,可以将此类方法生成的文本验证码称为传统的文本验证码。图1(a) 展示了一些传统文本验证码的样例,从图中可以观察到这些传统文本验证码中过多的遮挡线和过于严重的字符变形在提高了安全性的同时也给人类用户制造了难题,对用户体验产生负面影响,可能将人类拒之门外,这违背了验证码设计的初衷。为了设计出既满足安全性又充分友好的文本验证码,研究人员提出了第2类对文本验证码安全性的探究,即对抗性文本验证码。

|

图 1 不同的文本验证码示例 Figure 1 Examples of different text-based CAPTCHAs |

在第2类研究中,研究人员基于原始的验证码图像,通过引入对抗因子对图像添加对抗扰动[8],以生成对抗性文本验证码。对抗扰动不同于背景噪声,它是一种人为生成的微小扰动向量[9],能够欺骗深度学习攻击模型,使得识别模型产生错误的分类结果,由此来提高文本验证码的安全性。2015年Goodfellow等[9]首次将对抗样本引入到机器学习领域,但其主要的研究方向并不是文本验证码,而是将对抗学习应用于图像分类任务中。他们提出了一种新的对抗学习方法用以生成对抗性样本,并揭示了深度学习模型的漏洞和脆弱性。此外,该方法展示了即使只加入微小的扰动,也能够使得深度学习模型的准确率显著下降,这种成功应用在图像领域的对抗学习方法,启示了学者在文本验证码领域的探索和改进。随后,Shi等[10]和Kwon等[11]基于先进的扰动算法提出了对抗性验证码生成框架,包括基于快速梯度符号算法(Fast Gradient Sign Method, FGSM)[9]、迭代的快速梯度符号算法(Iterative FGSM, I-FGSM)[12]和基于雅可比矩阵的显著性图攻击算法(Jacobian-based Saliency Map Attack, JSMA)[13]等。他们通过对验证码图像添加对抗扰动来愚弄攻击模型,且生成的验证码图像与传统的文本验证码相比,有着更高的安全性。图1(b)展示了一些先前工作生成的对抗性文本验证码样例,从中可以发现,由于引入的扰动因子没有得到充分的控制,所生成的验证码图像同样会对人类用户识别造成额外的干扰。由此可见,控制好扰动因子是生成安全且易用的对抗性文本验证码的关键。Zheng等[14]在使用扰动算法的基础上对用户行为进行了分析,加入了合理的概率模型,根据概率选择将普通的或者强度高的验证码传递给用户,但由于模型依赖于特定的扰动算法进行训练,生成的图像容易被先进的攻击者模型识别。

为了解决上述问题,本文提出了一种带随机化策略的扰动优化框架,用以生成文本验证码图像(Perturbation Optimization Network with Randomization for Text-based CAPTCHAs Generation, PORG)。该方法生成的文本验证码图像可以较好地平衡安全性和用户友好性。具体来说,本文从两个方面入手,首先,本文设计了一个带有随机策略的扰动生成网络(Perturbation Generation Network, PGN),利用先进的扰动算法创建更为丰富多样的扰动因子,使得攻击模型难以摸清图像规律,有效防止生成的验证码图像被特定的攻击方法成功识别。其次,本文设计了一种扰动优化网络(Perturbation Optimization Network, PON) 来改善引入的扰动因子,综合考虑了验证码图像在粗粒度的全局特征和在细粒度的底层特征,使得优化后的文本验证码图像能够在有效抵御攻击者模型的同时保持高度的用户友好性。图1(c)展示了该方法生成的部分样例,从中可以看到所生成的验证码图像与原始验证码图像高度相似,且对人类用户比较友好。

本文的主要贡献总结如下:

(1) 设计了一个扰动生成网络(PGN),基于多种先进的扰动方法构建丰富的扰动因子,采用随机化策略生成具有强鲁棒性的扰动验证码图像。

(2) 提出了一个扰动优化网络(PON),通过扩展图像在特征级别的差距和缩小全局级别的距离来优化生成的文本验证码,使得生成的文本验证码在有效防御攻击者模型的同时保持用户友好性。

(3) 在8个真实世界的数据集上进行了大量的定量和定性实验,证明了所提出方法在文本验证码生成任务上的有效性和优越性。此外,还为8个网站提供了优化后的验证码生成解决方案。

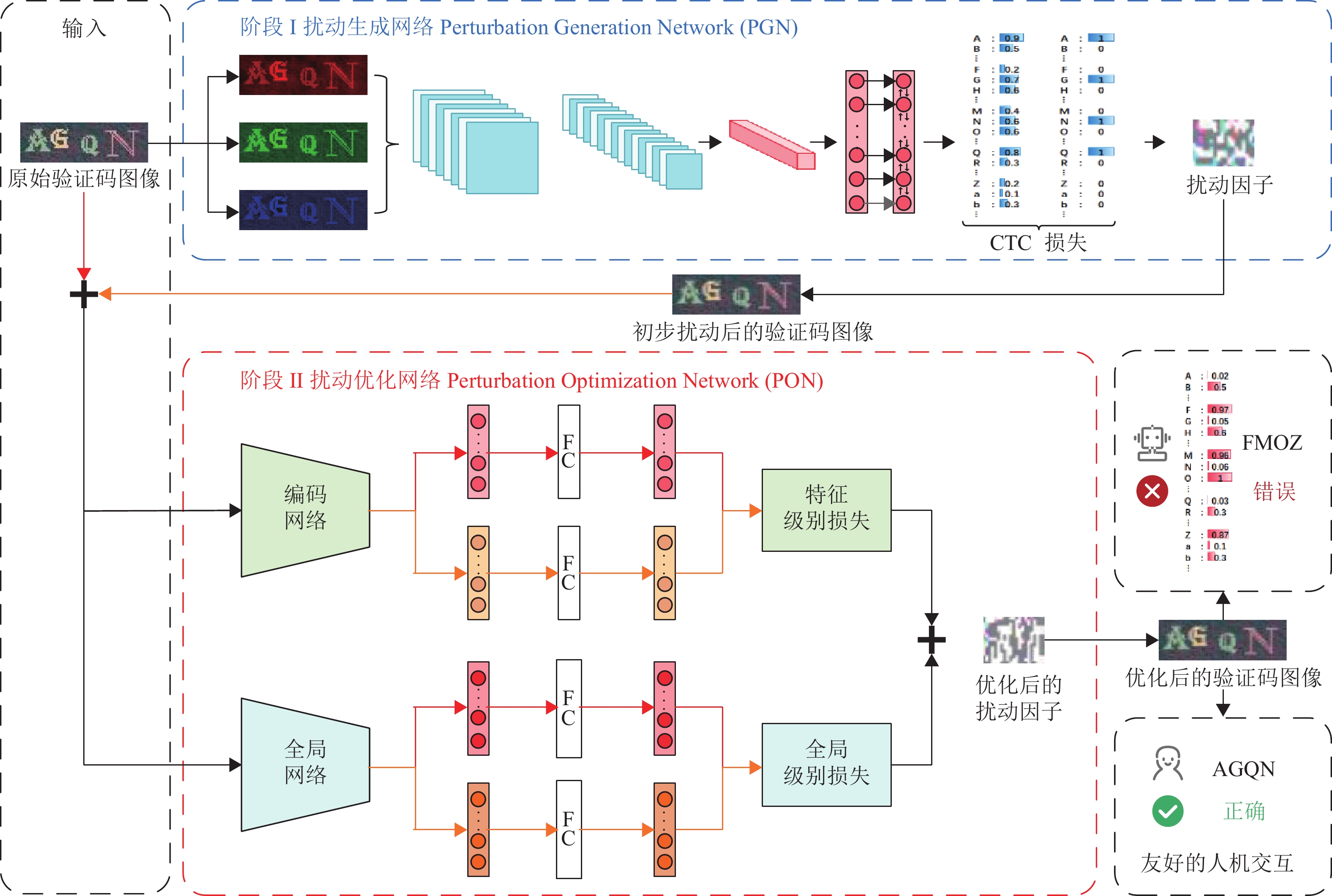

1 方法介绍 1.1 框架概述本文提出的PORG框架如图2所示,主要由扰动生成网络(PGN)和扰动优化网络(PON)组成。其中,PGN引入多种高级扰动方法以构建丰富的扰动因子,并设计随机化策略以生成多样化的扰动图像。此外,PON模块负责提取图像全局特征和底层特征以优化PGN模块生成的扰动图像,帮助所生成的图像有效抵御攻击者模型,同时保持用户友好性。

|

图 2 模型整体架构 Figure 2 Overview of the proposed PORG |

现有的对抗性验证码生成方法通常使用特定的方法生成验证码图像,这些图像很容易被高级攻击者模型识别。为了解决这个问题,PGN采用了基于高级扰动方法的随机化策略来生成丰富的扰动验证码,具体网络细节如图3所示。本文将PGN分为2个子模块,即通用生成网络和随机化策略。

|

图 3 扰动生成网络(PGN)的结构 Figure 3 Structure of perturbation generation network (PGN) |

通用生成网络总结了一种验证码图像的扰动生成策略。给定原始图像

| $ \boldsymbol{C}=\sigma ({\boldsymbol{W}}_{\mathrm{c}}\cdot \mathrm{C}\mathrm{N}\mathrm{N}({\boldsymbol{I}}_{\mathrm{o}}\left) \right) $ | (1) |

式中:

随后,将原始特征

| $ {\boldsymbol{F}}_{\mathrm{s}}={\mathrm{L}\mathrm{S}\mathrm{T}\mathrm{M}}_{\mathrm{b}}\left(\boldsymbol{C}\right) $ | (2) |

| $ {\boldsymbol{F}}_{\mathrm{t}}=\sigma ({\boldsymbol{W}}_{\mathrm{s}}\cdot {\boldsymbol{F}}_{\mathrm{s}}) $ | (3) |

式中:

最后,通过解码

| $ {\boldsymbol{F}}_{\mathrm{o}}=\mathrm{d}\mathrm{e}\mathrm{c}\mathrm{o}\mathrm{d}\mathrm{e}\left({\boldsymbol{L}}_{\mathrm{o}}\right) $ | (4) |

| $ {\boldsymbol{P}}_{\mathrm{p}}={\nabla }_{{\boldsymbol{I}}_{\mathrm{o}}}{\mathrm{L}\mathrm{o}\mathrm{s}\mathrm{s}}_{\mathrm{c}}({\boldsymbol{F}}_{\mathrm{o}},{\boldsymbol{F}}_{\mathrm{t}}) $ | (5) |

式中:

随机化策略旨在确保所生成的图像扰动因子

| $ {\boldsymbol{P}}_{\mathrm{r}}=\underset{i\in n}{\mathrm{max}}\mathrm{R}\mathrm{a}\mathrm{n}\mathrm{d}\mathrm{o}\mathrm{m}({\mathrm{C}\mathrm{G}\mathrm{N}(M}_{i},{\boldsymbol{I}}_{\mathrm{o}},{\boldsymbol{L}}_{\mathrm{o}}) ) $ | (6) |

| $ {\boldsymbol{I}}_{\mathrm{p}}={\boldsymbol{I}}_{\mathrm{o}}+{\boldsymbol{P}}_{\mathrm{r}} $ | (7) |

式中:

所提出的扰动生成网络(PGN)模块的过程如算法1所示。

算法1 扰动生成网络(PGN)模块算法

1) 输入:原始图像

2) 初始化;

(a)

(b)

(c) for number of training iterations do

(d) for

(e)

(f)

(g) end for

(h)

(i)

(j) end for

3) 输出:扰动图像

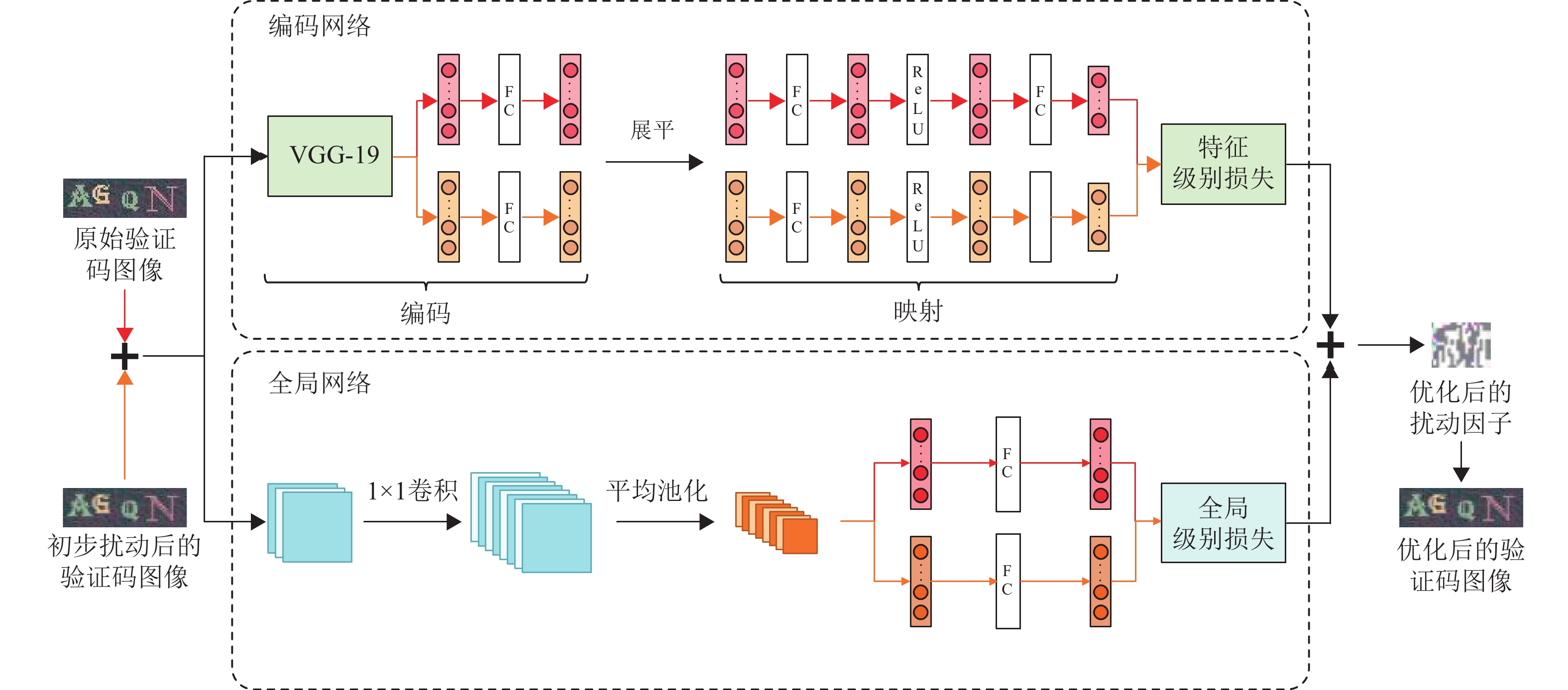

现有方法所生成的验证码图像在有效提高安全性的同时也带来了模糊及噪声过多等干扰问题,这些干扰项对于人眼的识别十分不友好。因此,本文设计了扰动优化网络(PON)模块,通过在特征级别上扩大间距并在全局级别上缩小距离的方式来优化生成的验证码图像,使生成的验证码图像既可以保持人类友好性,又可以有效地对抗攻击者模型。PON模块可以划分为编码网络和全局网络两个子模块,具体的结构如图4所示。

|

图 4 扰动优化网络(PON)的结构 Figure 4 Details of Perturbation Optimization Network (PON) |

编码网络模块旨在提取原始图像

| $ {\boldsymbol{V}}_{\mathrm{o}}=\sigma ({\boldsymbol{W}}_{\mathrm{v}}\cdot \mathrm{V}\mathrm{G}\mathrm{G}({\boldsymbol{I}}_{\mathrm{o}}\left) \right) $ | (8) |

式中:

随后,为了进一步对齐图像之间的特征级别差异,本文使用共享参数的投影结构将提取的视觉特征投影到共享特征空间中。

最终原始图像的底层特征

| $ {\boldsymbol{O}}_{\mathrm{f}}={\boldsymbol{W}}_{2}\cdot \sigma ({\boldsymbol{W}}_{1}\cdot {\boldsymbol{V}}_{\mathrm{o}}) $ | (9) |

式中:

相应地,扰动图像的视觉特征

| $ {\boldsymbol{V}}_{\mathrm{p}}=\sigma ({\boldsymbol{W}}_{\mathrm{v}}\cdot \mathrm{V}\mathrm{G}\mathrm{G}({\boldsymbol{I}}_{\mathrm{p}}\left) \right) $ | (10) |

| $ {\boldsymbol{P}}_{\mathrm{f}}={\boldsymbol{W}}_{2}\cdot \sigma ({\boldsymbol{W}}_{1}\cdot {\boldsymbol{V}}_{\mathrm{p}}) $ | (11) |

给定原始图像

以原始图像

| $ {\boldsymbol{P}}_{\mathrm{g}}=\sigma ({\boldsymbol{W}}_{\mathrm{g}}\cdot \mathrm{A}\mathrm{v}\mathrm{g}\mathrm{P}\mathrm{o}\mathrm{o}\mathrm{l}({\mathrm{C}\mathrm{N}\mathrm{N}}_{1*1}\left({\boldsymbol{I}}_{\mathrm{p}}\right) \left) \right) $ | (13) |

最后,扰动生成优化网络(PON)模块利用两种图像的底层特征

基于特征级别和全局级别的损失差异结果在扰动图像

| $ \boldsymbol{P}={\nabla }_{{\boldsymbol{I}}_{\mathrm{p}}}\left({\mathrm{L}\mathrm{o}\mathrm{s}\mathrm{s}}_{\mathrm{f}}\right({\boldsymbol{O}}_{\mathrm{f}},{\boldsymbol{P}}_{\mathrm{f}}) +{\mathrm{L}\mathrm{o}\mathrm{s}\mathrm{s}}_{\mathrm{g}}({\boldsymbol{O}}_{\mathrm{g}},{\boldsymbol{P}}_{\mathrm{g}},{\boldsymbol{I}}_{\mathrm{o}},{\boldsymbol{I}}_{\mathrm{p}}) ) $ | (14) |

| $ {\boldsymbol{I}}_{\mathrm{t}}={\boldsymbol{I}}_{\mathrm{o}}+\boldsymbol{P} $ | (15) |

式中:

在损失函数方面,本文利用Connectionist Temporal Classification (CTC)损失函数生成初步的扰动图像,并设计了特征级别的损失函数和全局级别的损失函数以优化所生成的图像。

1.4.1 Connectionist Temporal Classification (CTC)CTC[17]是一种用于序列分类问题的神经网络技术,在本文中被应用于扰动图像的生成,它可以处理连续空间中的标签序列,计算连续原始序列和目标序列之间的差异,进而产生可微分的损失值。

1.4.2 特征损失函数特征损失函数旨在最大化原始图像和生成图像之间在特征级别上的差距,从而保证攻击者模型无法有效识别验证码的标签内容。

给定两种图像的底层特征

| $ {\mathrm{L}\mathrm{o}\mathrm{s}\mathrm{s}}_{\mathrm{f}}({\boldsymbol{O}}_{\mathrm{f}},{\boldsymbol{P}}_{\mathrm{f}}) =\mathrm{c}\mathrm{l}\mathrm{a}\mathrm{m}\mathrm{p}\left({\mathrm{c}\mathrm{o}\mathrm{s}}_{{\rm{s}}}\right({\boldsymbol{O}}_{\mathrm{f}},{\boldsymbol{P}}_{\mathrm{f}}) ,\alpha ) $ | (16) |

式中:

全局损失函数旨在最小化原始图像和生成图像在全局级别上的距离,确保人眼可以有效地识别出文本验证码内容,保证所生成图像的用户友好性。

全局损失函数

| $ {\mathrm{L}\mathrm{o}\mathrm{s}\mathrm{s}}_{\mathrm{f}}=\mathrm{M}\mathrm{S}\mathrm{E}({\boldsymbol{O}}_{\mathrm{g}},{\boldsymbol{P}}_{\mathrm{g}}) $ | (17) |

| $ {\mathrm{L}\mathrm{o}\mathrm{s}\mathrm{s}}_{\mathrm{c}}={‖{\boldsymbol{I}}_{\mathrm{o}}-{\boldsymbol{I}}_{\mathrm{p}}‖}_{\mathrm{F}}^{2}*\beta $ | (18) |

| $ {\mathrm{L}\mathrm{o}\mathrm{s}\mathrm{s}}_{\mathrm{s}}=\mathrm{M}\mathrm{S}\mathrm{E}\left(\mathrm{G}\mathrm{r}\mathrm{a}\mathrm{m}\right({\boldsymbol{I}}_{\mathrm{o}}) -\mathrm{G}\mathrm{r}\mathrm{a}\mathrm{m}({\boldsymbol{I}}_{\mathrm{p}}\left) \right) $ | (19) |

| $ \begin{split} {\mathrm{L}\mathrm{o}\mathrm{s}\mathrm{s}}_{\mathrm{g}} \left({\boldsymbol{O}}_{\mathrm{g}},{\boldsymbol{P}}_{\mathrm{g}},{\boldsymbol{I}}_{\mathrm{o}},{\boldsymbol{I}}_{\mathrm{p}}\right) =&{\mathrm{L}\mathrm{o}\mathrm{s}\mathrm{s}}_{\mathrm{f}}\left({\boldsymbol{O}}_{\mathrm{g}},{\boldsymbol{P}}_{\mathrm{g}}\right) + {\mathrm{L}\mathrm{o}\mathrm{s}\mathrm{s}}_{\mathrm{c}}\left({\boldsymbol{I}}_{\mathrm{o}},{\boldsymbol{I}}_{\mathrm{p}}\right) + \\ &{\mathrm{L}\mathrm{o}\mathrm{s}\mathrm{s}}_{\mathrm{s}}({\boldsymbol{I}}_{\mathrm{o}},{\boldsymbol{I}}_{\mathrm{p}}) \end{split} $ | (20) |

式中:

为了验证所提出方法(PORG)的有效性,本文在8个真实世界数据集上进行了一系列实验,并从验证码识别准确率以及人眼视觉效果两方面对所提出方法(PORG)以及基线方法进行了全面的评估。本章主要介绍实验的相关细节。

2.1 数据集本文从8个访问量较大的真实世界网站中收集了2595张验证码图像作为数据集,包括CET、CNKI、Gdgov、Gohimall、Jxfw、NRA、NSFC和Weibo。

(1) CET验证码数据集采集自全国大学英语考试系统,共包含104张验证码图像,数据样本由大小写字母组成,较为简单容易识别。

(2) CNKI数据集采集自中国知网,共计510 张验证码图像。该数据集由字母或数字组成,其中包含了一些常见的验证码干扰处理方法,如字符粘附、线性噪声等。

(3) Gdgov数据集采集自广东省身份认证平台,共包含108张验证码图像。该数据集使用的验证码采用字符比例变化法。

(4) Gohimall数据集采集自大型购物网站,包含100张验证码图像,具有点噪声和局部失真的特点。

(5) Jxfw数据集采集自广东工业大学教务系统,验证码图像具备字符扭曲的特点,在本实验中共计采集了585张图像。

(6) NRA数据集采集自国家铁路局网站,包含109 张验证码图像。数据集图像内容主要由数字字符组成,图像处理方法主要包括干扰背景和变换字符颜色的方法。

(7) NSFC数据集采集自国家自然科学基金系统,共计102张验证码图像。该数据集背景干净,且字符颜色单一。

(8) Weibo数据集收集自微博在线网站。该数据集具有适度失真或黏附的特征,在本实验中采集超过了 977 张图像。

2.2 评价指标研究文本验证码的生成任务需要遵循验证码方案的设计初衷,故在评估模型生成的文本验证码图像时,除了评价安全性,还需要对用户友好性进行评估。为了更全面地评估所提出方法的有效性和优越性,本文采用了定量评估和定性评估两种方法。

在衡量安全性方面,本文使用了定量评估的方法,主要采用攻击模型的识别准确率作为评价指标,即文本验证码图像被攻击模型正确识别的比例,在相同的实验条件下这个数值越大,说明文本验证码图像被攻击模型成功破解的概率越高,相应的安全性也就越差。本文使用两个先进的攻击模型对原始验证码图像和生成的验证码图像分别进行攻击,得到原始图像的攻击准确率

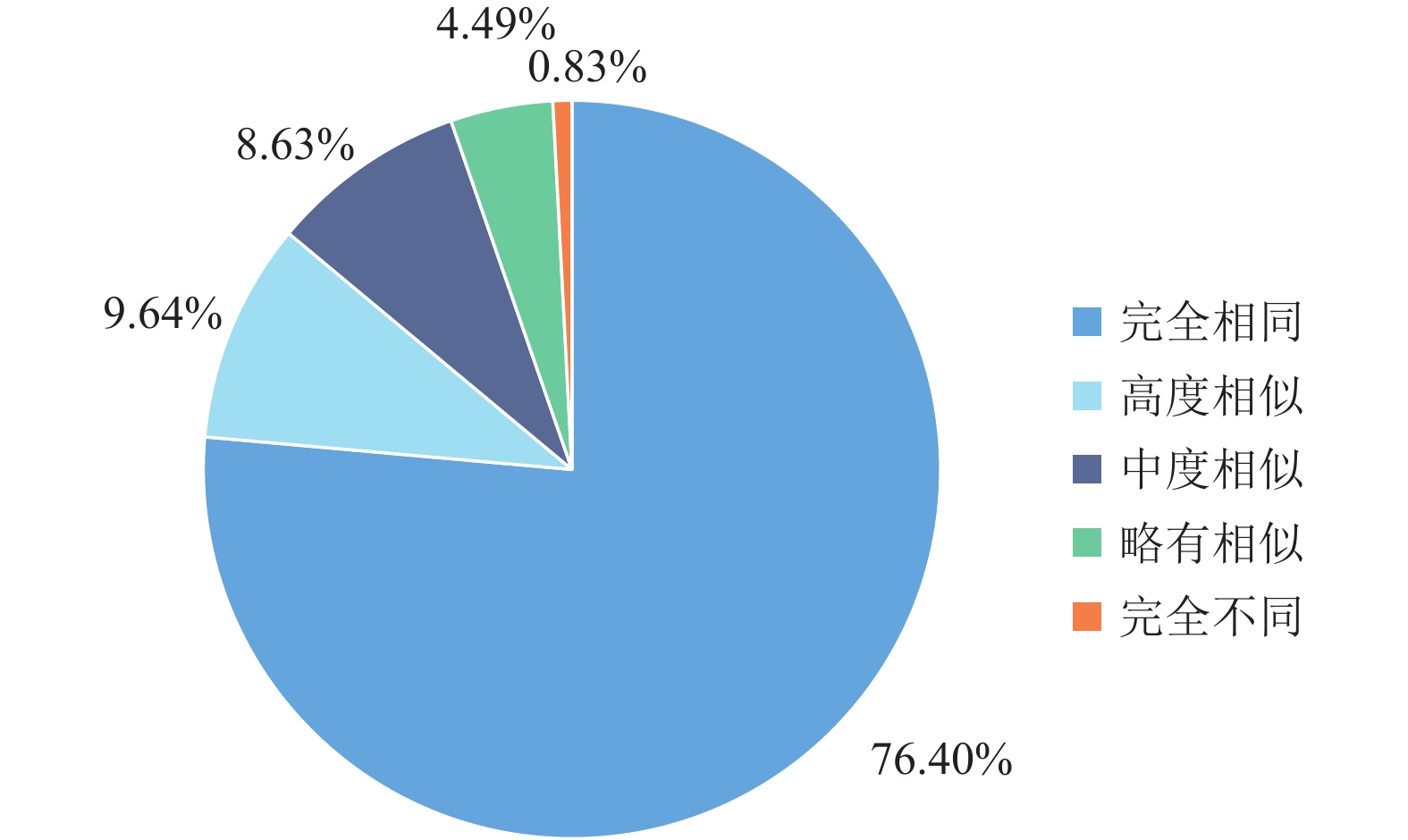

在评估友好性方面,本文同时使用了定量评估和定性评估的方法。在定量评估中主要采用人类用户对验证码图像的识别准确率作为评价指标,即文本验证码图像被人类用户正确识别的比例,在相同的实验条件下这个数值越大,说明文本验证码图像被人类正确处理的可能性越高。在定性评估中主要采用人类用户对生成验证码图像与原始验证码图像的相似度评价作为指标,该实验在亚马逊众包平台(Amazon Mechanical Turk, AMT) 邀请了600名志愿者,每位志愿者都将收到特定组数的图像相似度对比问卷。通过该实验可以得到志愿者们对PORG生成的文本验证码的友好性评价数据,进而分析所生成图像的用户友好性。

2.3 基线方法模型本文使用先进的识别模型CTC (Connectionist Temporal Classification) [17]和ResNet (Residual Network) [19]作为攻击者,并选取了6种先进的扰动算法模型进行对比实验,包括GDM[20]、FGM[21]、FGSM[9]、I-FGSM[12]、MI-FGSM[22]和JSMA[13]。

GDM (Gradient Descent Method) [20]是一种针对深度神经网络的攻击方法。该方法通过反向传播算法获取输入图像的梯度,并根据梯度生成扰动向量,以此来欺骗模型进行错误分类。

FGM (Fast Gradient Method) [21]是一种基于梯度的对抗攻击方法。该方法通过计算损失函数关于输入图像的梯度,来生成扰动向量以欺骗模型。

FGSM (Fast Gradient Sign Method) [9]设计了一种更加简单有效的对抗攻击方式,通过计算模型对输入图像的梯度,使用符号函数得到其特定的梯度方向,并乘以一个步长,最后将得到的扰动向量添加到原始输入上,生成对抗样本。

I-FGSM (Iterative FGSM) [12]是在FGSM方法的基础上改进的一种迭代式对抗攻击方法,它可以利用小步长多次应用FGSM的步骤,在每个步骤之后裁剪中间结果的像素值以确保它们在原始图像的邻域内,从而生成更具迁移性的对抗样本。

MI-FGSM (Momentum-based Iterative FGSM) [22]在I-FGSM方法的基础上,引入了动量项,使得攻击过程中更新的方向更稳定,同时避免陷入局部极值点,从而生成更具迁移性的对抗样本。

JSMA (Jacobian-based Saliency Map Attack) [13]是一种基于深度神经网络输入输出映射的对抗攻击方法,通过限制扰动向量的范数来生成对抗样本,以此来快速干扰模型的分类行为。

2.4 实验设置本文提出的文本验证码生成模型基于Pytorch框架实现,同时为提高模型训练的效率和速度,实验依托的服务器资源为NVIDIA RTX 3090 GPU(24 GB内存)。在模型训练过程中,将学习率设置为

表1总结了所提出的PORG方法在8个数据集上的性能,从中可以得出以下观察结果:(1) 与原始图像相比,PORG生成的验证码图像的识别准确率均有所下降。虽然不同的数据集在不同的识别模型中准确率不同,但准确率的降幅都超过50%。(2) 本文所提出的PORG方法获得了良好的性能,这主要归功于扰动生成网络(PGN)利用随机化策略生成了多样化的扰动因子,以及扰动优化网络(PON)通过扩大图像在特征级别上的差距且缩小图像在全局级别上的距离有效优化了所生成的扰动图像。

| 表 1 PORG模型性能表现 Table 1 The performance of proposed PORG |

为了评估扰动优化网络(PON)模块对验证码图像的优化效果,该实验将每种基线方法的原始性能同经过PON模块优化后的性能结果进行比较。从表2中可以看出,经过PON模块处理后,扰动方法对比原始处理均有了更低的识别准确率,这说明提出的扰动优化网络模块可以扩大验证码图像在特征级别上的差距,有效地增加了识别模型的攻击难度。

| 表 2 扰动优化网络(PON)性能表现 Table 2 The performance of the approaches with CTC |

为了对比PORG与基线方法在不同数据集上的视觉效果,图5汇总了基线方法和本文提出的PORG方法在8个实验数据集上的验证码生成示例,从中可以观察到:(1) 基线对抗方法所生成的图像有明显的噪声,并且在视觉效果上与原始图像的差异较大。例如,在NSFC和Weibo数据集中,FGM[21]方法生成图像的颜色由于扰动而发生改变,严重影响了人类的识别。(2) PORG生成的验证码图像在视觉上看起来与原始图像非常相似,同原始验证码图像一样容易被人类用户识别,保证了用户友好。

|

图 5 PORG与基线方法生成的验证码图像示例对比 Figure 5 Example CAPTCHAs generated by PORG compared to baseline methods |

为了评估本研究提出的PORG框架生成的文本验证码图像的视觉效果,在搜集到的8个现实世界数据集中随机选择了168组文本验证码图像,并从亚马逊众包平台(Amazon Mechanical Turk,AMT)招募了600名志愿者对每组图像的视觉相似性和识别结果进行评估。图6和表3分别总结了相似性分布和人类识别的准确率,从中可以发现:(1) 86.04%的志愿者认为本文提出的PORG框架生成的扰动文本验证码图像与原始图像高度相似。(2) 原始图像和生成的图像之间的识别准确率差异很小。(3) 实验结果表明,PORG生成的验证码与原始验证码高度相似,对人类具有很高的用户友好性,能够被人类用户成功识别。

|

图 6 生成图像与原始图像的视觉相似性比较结果 Figure 6 The similarity comparison results of AMT between generated and original images |

| 表 3 人类用户识别准确率对比结果 Table 3 Human recognition accuracy of AMT |

本文所提出的PORG框架由PGN和PON两个模块组成,为了研究各个模块在框架中所带来的提升,本文逐步拆解框架的各个部分进行消融实验。这里将不包含PON模块的PORG表示为PORG_PON,将不包含任何模块的PORG表示为PORG_CLEAN,表4总结了 PORG 不同变体的性能,从中有以下观察结果。(1) 包含所有组件的PORG在所有数据集上均获得了最佳性能,证明了每个模块的重要性。(2)与PORG_CLEAN相比,PORG_PON的攻击成功率有所降低。原因在于PGN模块不仅采用对抗方式增加了图像的扰动,而且采用随机化策略丰富了扰动因子,大大增加了攻击模型的识别难度,提高了安全性。

| 表 4 消融实验结果 Table 4 The results of ablation study |

本文提出了一种带有随机化策略的扰动优化框架PORG,用于生成文本型验证码,较好地平衡了生成验证码的安全性和用户友好性。该框架设计了一种扰动生成网络(PGN),结合先进的扰动方法和随机化策略以生成了多样化的扰动因子,有效地防御识别模型的攻击。同时,本文设计了一种扰动优化模块(PON),分别从特征级别和全局级别对所生成成的图像进行优化处理,使其所生成的图像扰动因子更不易被人类察觉。本文在8个验证码数据集进行了充分的实验评估,所生成的文本型验证码相较之前的工作在提升用户友好性的同时表现出更低的识别准确率,证明了所提出的框架模型的优越性。

| [1] |

AHN L V, BLUM M, HOPPER N J, et al. CAPTCHA: using hard AI problems for security[C]// 2003 International Conference on the Theory and Application of Cryptographic Techniques (Eurocrypt) . Heidelberg: Springer, 2003: 294-311.

|

| [2] |

JIA X, XIAO J, WU C. TICS: text–image-based semantic CAPTCHA synthesis via multi-condition adversarial learning[J].

The Visual Computer, 2022, 38(3): 963-975.

DOI: 10.1007/s00371-021-02061-1. |

| [3] |

SHI C, JI S, LIU Q, et al. Text CAPTCHA is dead? a large scale deployment and empirical study[C]// LIGATTI J, OU X, KATZ J, et al. 2020 ACM Conference on Computer and Communications Security (CCS) . USA: ACM, 2020: 1391-1406.

|

| [4] |

HOSSEN I, HEI X. aaeCAPTCHA: the design and implementation of audio adversarial CAPTCHA[C]// 2022 IEEE 7th European Symposium on Security and Privacy (EuroS&P) . Genoa: IEEE, 2022: 430-447.

|

| [5] |

GAO S, MOHAMED M, SAXENA N, et al. Gaming the game: Defeating a game CAPTCHA with efficient and robust hybrid attacks[C]// 2014 IEEE International Conference on Multimedia and Expo (ICME) . Chengdu: IEEE Computer Society, 2014: 1-6.

|

| [6] |

SHAO R, SHI Z, YI J, et al. Robust text CAPTCHAs using adversarial examples[C]// 2022 IEEE International Conference on Big Data (Big Data) . Osaka: IEEE, 2022: 1495-1504.

|

| [7] |

BURSZTEIN E, MARTIN M, MITCHELL J. Text-based CAPTCHA strengths and weaknesses[C]// 2011 the 18th ACM Conference on Computer and Communications Security (CCS) . Chicago: ACM, 2011: 125-138.

|

| [8] |

沈言玉, 张三峰, 曹玖新. 一种基于对抗样本的验证码安全性增强方法[J].

网络空间安全, 2020, 11(8): 81-85.

SHEN Y Y, ZHANG S F, CAO J X. A security enhancement method of CAPTCHA based on adversarial samples[J]. Cyberspace Security, 2020, 11(8): 81-85. DOI: 10.3969/j.issn.1674-9456.2020.08.015. |

| [9] |

GOODFELLOW I J, SHLENS J, SZEGEDY C. Explaining and harnessing adversarial examples[EB/OL]. arXiv: 1412.6572(2015-03-20) [2023-01-02]. https://arxiv.org/abs/1412.6572v1.

|

| [10] |

SHI C, XU X, JI S, et al. Adversarial CAPTCHAs[J].

IEEE Transactions on Cybernetics, 2022, 52(7): 6095-6108.

DOI: 10.1109/TCYB.2021.3071395. |

| [11] |

KWON H, YOON H, PARK K W. Robust CAPTCHA image generation enhanced with adversarial example methods[J].

IEICE Transactions on Information and Systems, 2020, 103-D(4): 879-882.

|

| [12] |

KURAKIN A, GOODFELLOW I J, BENGIO S. Adversarial examples in the physical world[EB/OL]. arXiv: 1607.02533(2017-02-11) [2023-01-02]. https://arxiv.org/abs/1607.02533v3.

|

| [13] |

PAPERNOT N, MCDANIEL P, JHA S, et al. The limitations of deep learning in adversarial settings[C]// 2016 IEEE European Symposium on Security and Privacy (EuroS&P) . Saarbrucken: IEEE, 2016: 372-387.

|

| [14] |

ZHENG W, WANG W, REN W, et al. A user behavior-based random distribution scheme for adversarial example generated CAPTCHA[C]// 2021 IEEE Intl Conf on Parallel & Distributed Processing with Applications, Big Data & Cloud Computing, Sustainable Computing & Communications, Social Computing & Networking (ISPA/BDCloud/SocialCom/SustainCom) . New York: IEEE, 2021: 1215-1221.

|

| [15] |

HUANG Z, XU W, YU K. Bidirectional LSTM-CRF models for sequence tagging[EB/OL]. (2015-08-09) [2023-01-02]. https://arxiv.org/pdf/1508.01991.

|

| [16] |

KAREN S, ANDREW Z. Very deep convolutional networks for large-scale image recognition[EB/OL]. (2015-04-10) [2023-01-02]. https://arxiv.org/pdf/1409.1556.

|

| [17] |

GRAVES A, FERNÁNDEZ S, GOMEZ F, et al. Connectionist temporal classification: labelling unsegmented sequence data with recurrent neural networks[C]// 2006 23rd International Conference on Machine Learning (ICML) . Pittsburgh: ACM, 2006: 369-376.

|

| [18] |

GATYS L A, ECKER A S, BETHGE M. Image style transfer using convolutional neural networks[C]// 2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR) . Las Vegas: IEEE Computer Society, 2016: 2414-2423.

|

| [19] |

HE K, ZHANG X, REN S, et al. Deep residual learning for image recognition[C]// 2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR) . Las Vegas: IEEE Computer Society, 2016: 770-778.

|

| [20] |

AKHTAR N, MIAN A. Threat of adversarial attacks on deep learning in computer vision: a survey[J].

IEEE Access, 2018, 6: 14410-14430.

DOI: 10.1109/ACCESS.2018.2807385. |

| [21] |

MIYATO T, DAI A M, GOODFELLOW I. Adversarial training methods for semi-supervised text classification[EB/OL]. arXiv: 1605.07725(2021-11-16) [2023-01-02]. https://arxiv.org/abs/1605.07725.

|

| [22] |

DONG Y, LIAO F, PANG T, et al. Boosting adversarial attacks with momentum[C]// 2018 IEEE Conference on Computer Vision and Pattern Recognition (CVPR) . Salt Lake City: IEEE Computer Society, 2018: 9185-9193.

|

2024, Vol. 41

2024, Vol. 41