近年来,深度学习在图像分类[1]、目标检测[2]以及图像分割[3]等计算机视觉领域都取得了巨大的进展,甚至在某些图像识别任务上超过了人类的正常识别水平。但是,这些成果不仅取决于一个设计良好、稳健性强的神经网络模型或算法,而且在很大程度上依赖大量的标注数据用于网络模型的训练,而在小样本条件下这些模型很容易出现过拟合。此外,这些训练好的模型很难迁移到对新类别的识别上,当有新类增加或识别的类别发生改变时,需要重新训练模型,以适应新的类别。相反,人类仅通过观察一个或几个样本就能区分不同的事物,并且可以利用以往学习到的知识应用到新的领域或任务上。受此启发,小样本学习(Few-shot Learning, FSL) 的概念[4]被提出来,并且在近几年受到了广泛的关注。

小样本学习的目的是通过少量的标注数据便可快速学习到一个能够适应到新类的模型。小样本图像分类是当前小样本学习中的一个热门应用,主要包括基于元学习的方法和基于度量学习的方法。基于元学习的方法通过训练一个元学习器(Meta-learner) 让模型学会在少量的标注样本下快速适应新的任务,或者能够从以往的训练任务中获得有用的知识并迁移到新的任务上。基于度量学习的方法通过学习一个嵌入函数来生成样本图像的特征表示,并根据样本的特征表示在同一特征空间上的相似度来判定图像的类别。其中,后者由于实施方式简单以及有卓越的性能表现受到了众多研究者的关注。

在基于度量学习的小样本图像分类中,一个良好的特征表示可以有效区分不同类之间的差异,被认为是提高模型分类准确性的重要因素[5]。在这类方法中,原型网络[6]、匹配网络[7]和关系网络[8]等方法将全局特征作为当前类别的特征表示,虽然保持了图像的整体信息内容,但却很大程度上抑制了部分重要局部信息的表达,无法生成该类的代表性特征。相反,DN4[9]、CAN[10]和DeepEMD[11]等方法认为局部特征可以在跨类别中提供更好的区分性和更多的可迁移信息,通过建模局部特征之间的相似性来对图像进行分类。尽管使用更具代表性的局部特征作为图像的特征表示实现了更好的分类效果,但这些方法却忽视了同一个类别的局部信息在不同尺度下可能表现出很大的差异,而不同类之间也可能存在相似的局部特征。此外,由于低数据的问题导致小样本图像分类在大模型上存在过拟合的风险,而小模型难以充分提取到图像的重要局部特征。因此,在局部细节信息难以充分获取以及缺乏全局上下文信息的引导下,基于局部特征的相似性度量可能会出现偏差,从而误判图像的类别。

基于以上分析,本文提出了一种基于局部正交特征融合的小样本图像分类方法,通过融合全局特征正交空间上更具代表性的局部特征来增强图像的特征表示。针对小模型难以充分提取重要特征信息以及同类物体在不同尺度下特征差距过大的问题,本文提出结合通道注意力模块(Channel Attention Module, CAM) 和多尺度特征自适应融合模块(Muti-scale Feature Adaptive Fusion Module, MSFAFM) 学习浅层特征中的重要通道和尺度信息;为了充分利用局部特征与全局特征之间的互补关系,提出一个局部正交特征融合模块(Local Orthogonal Feature Fusion Module, LOFFM) 聚合图像的全局信息和正交局部信息,以生成更具代表性的特征表示,从而有效拉开不同类别的特征表示之间的距离。

1 相关工作 1.1 小样本学习在小样本学习中,基于元学习的方法从算法优化的角度出发让模型能够从任务中学习到可迁移的知识,并利用该知识去指导模型在新任务上快速迭代训练。Ravi等[12]提出一个基于长短期记忆网络(Long Short Term Memory, LSTM) [13]的元学习器来学习模型的优化过程,使模型在新任务上利用少量样本就可快速收敛。Finn等[14]提出一个模型无关的元学习方法,该方法通过学习寻找出一组良好的初始化参数,使模型能够快速地泛化和适应新的任务。相似地,Li等[15]提出通过同时对初始化参数、学习率和更新方向进行学习,让模型快速适应新的任务。

基于度量学习的方法从特征表示的角度出发,利用卷积神经网络等模型来生成每个类别的特征表示,并根据特征之间的相似度来进行分类。匹配网络结合LSTM和卷积神经网络来生成图像的特征表示,并根据图像特征表示间的余弦相似度来进行分类。原型网络支持集构建每个类的原型中心,并通过计算查询集特征和支持集原型之间的距离来对查询集进行分类。关系网络通过一个非线性的神经网络来学习计算图像特征之间的相似度。与这些以全局特征作为图像的特征表示的方法不同,Li等[9]认为局部特征更具区分性,因此提出利用最近邻算法获得更能代表图像类别的重要局部特征,并根据这部分的局部特征来建模图像之间的相似度。Hou等[10]为了生成更具代表性的特征表示,提出利用交叉参考机制来突出查询集和支持集之间的重要局部特征。DeepEMD通过生成2个图像局部区域之间的最佳匹配流来计算2张图像之间的距离,进而对查询集进行分类。

1.2 注意力机制注意力机制通过模仿人的视觉注意力机制,让模型去关注图像中更重要的特征信息,并弱化无关信息的表达。Hu等[16]提出SE通道注意力来学习通道的相关性,通过对通道加权来突出重要的通道特征,并抑制不重要的通道特征。Woo等[17]提出同时在通道和空间维度上执行注意力机制来对特征进行自适应加权。Wang等[18]通过使用一维卷积替换(Squeeze-and-Excitation, SE) 模块中的全连接层,实现了一个轻量级通道注意模块。对于多尺度特征,Zhang 等[19]提出一个高效的金字塔分割注意力模块在更细粒度层次上有效地提取多尺度空间信息并实现远程通道依赖。Dai等[20]提出一个注意力特征融合模块来自适应融合2个不同层次的特征。

1.3 全局和局部特征全局和局部特征在计算机视觉中通常具有不同的作用,全局特征代表图像的整体信息内容,局部特征保留更突出的细节信息。结合全局和局部特征以提高模型的判别能力在许多视觉任务中被证明是有效的。Liu等[21]通过分析感受野在图像分割网络上的影响,提出将全局上下文集成到全卷积网络[22]中以提高网络的性能。Lin等[23]提出一种新颖的全局和局部特征提取和融合框架,在步态识别上生成更具判别性的特征表示。Yang等[24]提出一个正交局部和全局信息融合框架用于端到端图像检索。而Song等[25]采用最近流行的Transform[26]结构对局部和全局特征进行建模,从而生成更具代表性的特征。

2 本文方法 2.1 问题定义在小样本学习中,通常会借助一个基类数据集

本文提出基于局部正交特征融合的小样本图像分类模型的总体结构如图1所示。首先,对输入的支持集和查询集图像,通过特征提取网络最后两层输出图像的浅层特征

|

图 1 模型的总体结构 Figure 1 Overall structure of the model |

通过融合不同尺度的特征可以有效利用目标物体的特征信息,从而减少小样本图像分类中的类内差距。因此,本文提出一个多尺度特征自适应融合模块(MSFAFM),如图2所示。该模块通过从浅层特征

|

图 2 多尺度特征自适应融合模块 Figure 2 Multi-scale feature adaptive fusion module |

在进行多尺度特征提取和融合前,本文首先通过1个通道注意力模块(CAM) 来学习浅层特征

| $ F_1^\prime = {F_1} \otimes \sigma ({\text{Con}}{{\text{v}}_{\text{2}}}(\delta ({\text{Con}}{{\text{v}}_{\text{1}}}({\text{GAP}}({F_1}) ) ) ) ) $ | (1) |

式中:

经过初步通道增强的特征

为了让模型在多个尺度特征中关注到更重要的尺度特征信息,以及在不同尺度特征间建立更长距离的通道依赖关系,本文借鉴文献[19]中对多尺度特征的处理方式来实现多尺度特征的自适应融合。首先,对于每个尺度特征

| $ _{ } {{\boldsymbol{w}}_i} = \sigma ({{\boldsymbol{W}}_2}(\delta ({{\boldsymbol{W}}_1}({\text{GAP}}({F_i}) ) ) ) ) _{ } $ | (2) |

式中:

进一步地,使用softmax函数作为软注意力自适应校准每个尺度特征的内部通道权重,校准公式为

| $ _{ } {\boldsymbol{w}}_i^\prime = {\text{softmax}}({{\boldsymbol{w}}_i}) = \frac{{{\text{exp}}({{\boldsymbol{w}}_i}) }}{{\displaystyle\sum\nolimits_{i = 1}^{k + 1} {{\text{exp}}} ({{\boldsymbol{w}}_i}) }} _{ } $ | (3) |

式中:

随后,将重新校准的通道注意力权重与相应尺度的特征进行相乘,公式为

| $ _{ } F_i^{\prime \prime } = {F_i} \otimes {\boldsymbol{w}}_i^\prime ,\;\; i = 1,2,\cdots,k + 1 _{ } $ | (4) |

式中:

| $ _{ } F = {\text{Cat}}([F_1^{\prime \prime },F_2^{\prime \prime },\cdots,F_{k + 1}^{\prime \prime }]) _{ } $ | (5) |

式中:

为了充分利用深层特征的全局信息和浅层特征的局部细节信息,本文受文献[24]和[25]的启发,提出利用1个局部正交融合模块(LOFFM) 对全局特征正交分量上更显著的局部特征进行提取和注意力融合,使得生成每个类别的特征表示更具区分性,该模块如图3所示。

|

图 3 局部正交特征融合模块 Figure 3 Local orthogonal feature fusion module |

在进行局部正交特征融合之前,首先对上一节得到的多尺度局部特征

随后,将

| $ \boldsymbol f_{\text{proj}}^{(i,j)}=\frac{\boldsymbol f_{{\rm{l}}}^{(i,j)}\times {{\boldsymbol f}_{{\rm{g}}}}}{\|{{\boldsymbol f}_{{\rm{g}}}}\|\times \|{{\boldsymbol f}_{{\rm{g}}}}\|}\times {{\boldsymbol f}_{{\rm{g}}}} $ | (6) |

式中:

如图4所示,根据特征向量在二维空间上的关系,进一步计算全局特征在正交分量上的特征向量,计算公式为

|

图 4 特征向量的投影关系 Figure 4 Projection relationship of eigenvectors |

| $ \boldsymbol{f}_{\text{orth}}^{(i,j)}=\boldsymbol{f}_{{\rm{l}}}^{(i,j)}-\boldsymbol{f}_{\text{proj}}^{(i,j)} $ | (7) |

式中:

通过公式(6) 和(7) ,可以得到在每个空间位置上的局部特征向量都与全局特征向量正交的特征图

为了充分地将

| $ _{ } {X^\prime } = X \otimes M(X) = \sigma (L(X) \oplus g(X) ) _{ } $ | (8) |

| $ _{ } L(X) = B({\text{Con}}{{\text{v}}_{\text{2}}}(\delta (B({\text{Con}}{{\text{v}}_{\text{1}}}(X) ) ) ) ) _{ } $ | (9) |

| $ g(X) = B({\text{Con}}{{\text{v}}_{\text{2}}}(\delta (B({\text{Con}}{{\text{v}}_{\text{1}}}({\text{GAP}}(X) ) ) ) ) ) _{ } $ | (10) |

式中:

进一步地,对于正交特征

| $ Z = {F_{{\text{orth}}}} \otimes M(X) + (1 - M(X) ) \otimes {F_2} _{ } $ | (11) |

式中:

最后,对于融合低层局部正交特征信息与深层全局语义信息的特征

| $ {{\boldsymbol{I}}^{\rm{q}}} = {\text{GAP}}({Z^{\rm{q}}}) $ | (12) |

式中:

对于支持集图像,本文采用原型网络相同的做法,通过平均同一个类别的图像特征表示来生成该类的类原型向量,公式为

| $ {\boldsymbol{I}}_n^{\rm{s}} = \frac{1}{{|K|}}\sum\limits_{i = 1}^K {{\text{GAP}}} (Z_i^n) ,\;\; n = 1,2,\cdots,N $ | (13) |

式中:

为了提高特征提取网络的表征能力,本文采用与文献[10]相同的方式,同时利用全局分类损失和小样本分类损失来联合训练模型。全局分类损失与普通图像分类的交叉熵损失一样,通过1个全连接层输出查询图像在基类数据集

| $ {L_{{\text{global}}}} = - \ln \frac{{\exp ({\boldsymbol{w}}_c^{\rm{T}}{{\boldsymbol{I}}^{\rm{q}}} + {{\boldsymbol{b}}_c}) }}{{\displaystyle\sum\nolimits_{k = 1}^{|{C_{{\text{base}}}}|} {\exp } ({\boldsymbol{w}}_k^{\rm{T}}{{\boldsymbol{I}}^{\rm{q}}} + {{\boldsymbol{b}}_k}) }} $ | (14) |

式中:

小样本分类损失根据查询集图像的特征向量与支持集图像的类原型向量之间的余弦相似度计算得到,计算公式为

| $ {L_{{\text{fsl}}}} = - \ln \frac{{\exp ({\text{sim}}({\boldsymbol{I}}_n^{\rm{s}},{{\boldsymbol{I}}^{\rm{q}}}) /\tau ) }}{{\displaystyle\sum\nolimits_{i = 1}^N {\exp } ({\text{sim}}({\boldsymbol{I}}_i^{\rm{s}},{{\boldsymbol{I}}^{\rm{q}}}) /\tau ) }} $ | (15) |

式中:

最终,模型训练的总损失函数计算公式为

| $ L = \lambda {L_{{\text{fsl}}}} + {L_{{\text{global}}}} $ | (16) |

式中:

本文在miniImageNet、tieredImageNet和CUB-200~2011(简称CUB) 3个常用的小样本图像分类数据集上对提出的模型进行实验验证并与其他相关的先进方法进行对比。同时,通过消融实验来验证各个模块在模型中的有效性。

3.1 数据集介绍3个数据集的统计和划分如表1所示。其中miniImageNet和tieredImageNet是大规模图像数据集ImageNet的2个子数据集。miniImageNet总共有100个类,每个类有600个样本,训练集、验证集和测试集分别有64、16和20个类别。tieredImageNet相比miniImageNet拥有更多的类别和更大的样本数量,该数据集一共有779 165张图像,并且平均每个类别有1 281张图像,训练集、验证集和测试集的类别数分别为351、97、160。CUB-200-2011最初是用于细粒度图像分类的鸟类数据集,该数据集一共11 788张图像,包含200种不同的鸟类,其中100个类别被划分为训练集,而验证集和测试集各被划分成50个类别。

| 表 1 数据集统计 Table 1 Details of datasets |

本文与主流方法使用的任务场景一样,分别采用5way-1shot和5way-5shot两个场景进行分类实验。与文献[10-11]等方法一样,本文选取ResNet12作为特征提取网络,该网络由4个残差块组成,每个残差块包括3个卷积层,每个卷积层由1个3×3的卷积、1个批量正则化和1个ReLU函数组成,并在最后一个卷积层后利用1个最大池化层进行下采样。对于输入的图像,将其放缩为84×84的大小,并设置特征提取网络4个残差块中的卷积核通道数分别为64、160、320、640,最终网络输出的浅层特征

在训练阶段上,采用含动量(Momentum) 的SGD作为优化器,初始学习率设为0.025,并将该优化器的动量和权重衰减系数分别设置为0.9和0.000 5。在miniImageNet、tieredImageNet和CUB-200~2011三个数据集上分别训练80、100、60个迭代周期,每个迭代周期分别在训练集和验证集上随机采样600个episode用于训练和验证,并分别在第45、70和30个epoch后将学习率减少为初始学习率的0.05。对于温度系数

在测试阶段,对测试数据集随机采样2 000个episode进行测试,并使用Top-1平均准确率来衡量模型的性能。

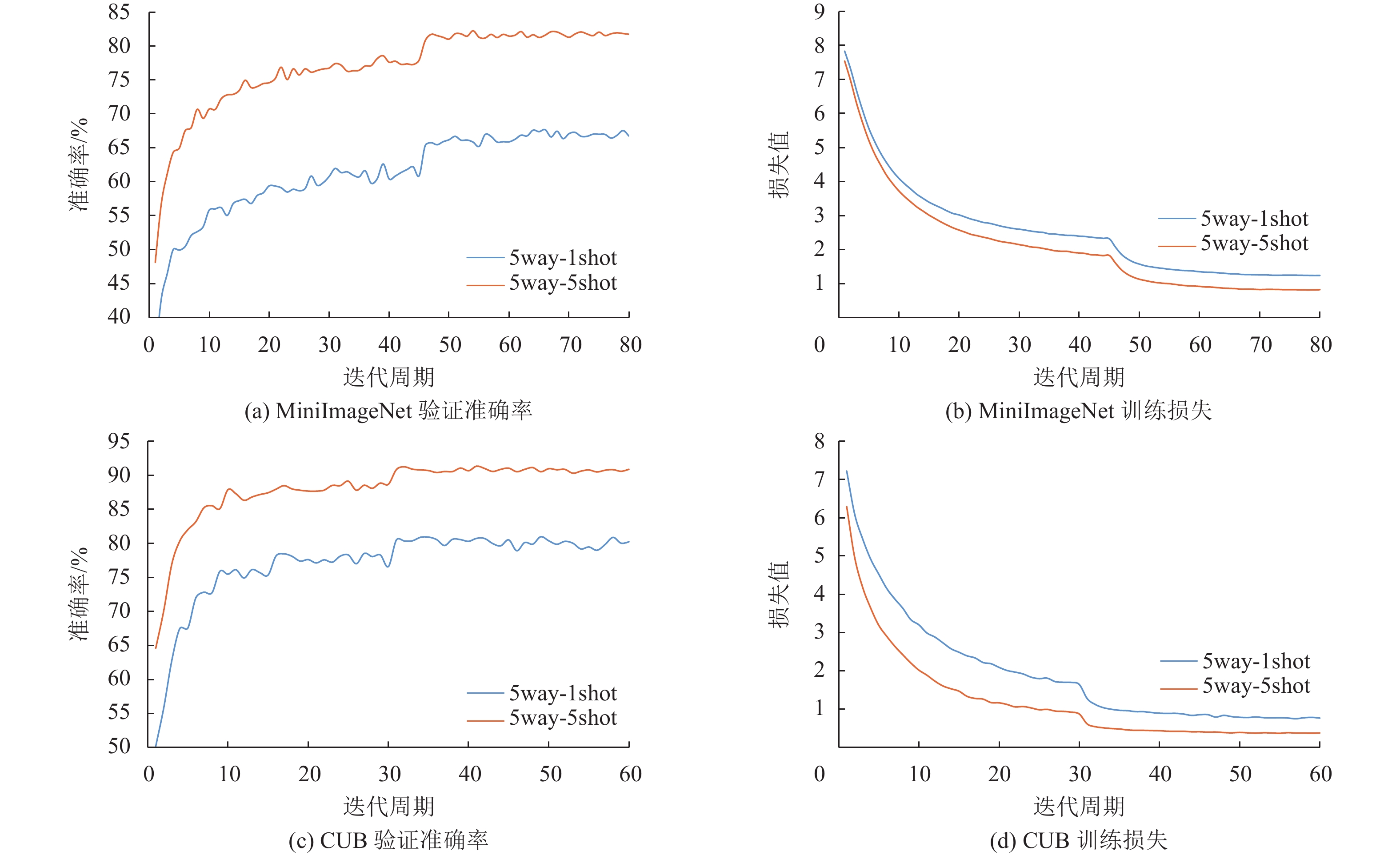

3.3 实验结果和分析为了更直观地了解本文方法在5way-1shot和5way-5shot两个任务上的表现,本文统计了在miniImageNet和CUB两个数据集上训练的平均验证准确率和训练损失值。图5展示了在两个数据集上的训练过程,其中图5(a)和图5(b)分别为miniImageNet数据集的验证准确率和训练损失趋势,图5(c)和图5(d)分别为CUB数据集的验证准确率和训练损失趋势。从验证准确率和训练损失的趋势看,本模型在对2个数据集分别训练了80和60个迭代周期之后,损失值基本降到了最低值,并且验证的平均准确率也趋于平稳,证明本模型达到了收敛。

|

图 5 miniImageNet 和 CUB 数据集的训练过程曲线图 Figure 5 Training curves of miniImageNet and CUB datasets |

为了更好地评估本文提出的模型的性能,分别在常规图像小样本分类和细粒度图像小样本分类场景上与先进模型的结果进行比较,实验结果如表2和表3所示。由于本文的方法可以当作原型网络的一个改进模型,因此本文在同样实验设置下复现了原型网络的结果,作为本文方法的baseline。

| 表 2 在miniImageNe和tieredImageNet上的实验结果 Table 2 The experimental results on miniImageNe and tieredImageNet |

| 表 3 在CUB上的实验结果 Table 3 The experimental results on CUB |

由表2可看出,本文提出的模型在miniImageNet和tieredImageNet两个常规小样本图像分类数据集上的性能表现均优于表上的其他先进方法。其中在miniImageNet数据集的测试结果中,本模型在5way-1shot和5way-5shot任务上的准确率分别达到了66.73%和81.69%,相比baseline模型分别提高了6.26%和5.23%。而在tieredImageNet数据集上,2个任务的测试准确率分别为70.46%和85.36%,相比baseline模型分别提高了4.34%和3.19%。在众多方法中,ProtoNet和MatchingNet将全局特征信息作为图像的类原型,而DN4和CAN通过建模支持集图像和查询集图像局部特征之间的关系来突出重要的局部特征,并根据这些局部特征之间的相似度进行分类,这类方法在仅利用全局或局部的特征信息用于分类时,可能容易受到图像背景和类内差异的影响,因此更可能造成分类错误。而本文关注对图像重要局部特征和重要尺度特征的学习,并充分融合局部和全局信息来增强图像的特征表示,实现了更好的性能。MetaOptNet[28]、Neg-Cosine[29]、DSN-MR[30]这些方法希望利用更优秀的分类器进一步拉开不同类别在特征空间上的距离来提高类间的区分性,但却忽略了小样本下模型难以提取到具有代表性的特征的问题,使模型应用在新的分类器上受到了很大的限制,这可能是这些方法提升有限的原因之一。

由表3可看出,在细粒度图像数据集CUB上,由于跨类别间存在很多相同的特征属性,类间的差异性较小,仅利用目标类别的全局信息作为判别依据很难有效拉开不同类别在特征空间上的距离,因此难以实现较高的分类准确率。而本文通过利用各个空间位置上更具有区分性的正交局部信息与原有的全局信息进行注意力融合,让模型在关注到目标类别的全局信息的同时,也关注到类别专有的局部属性信息。因此,本文的模型比baseline模型实现了更好的分类效果,在5way-1shot和5way-5shot的测试平均准确率分别为77.86%和89.78%,相比baseline分别提升了6.21%和5.99%。

为了进一步验证模型的泛化性,本文对跨域场景进行了实验测试。实验结果如表4所示,在目标域与源域不同的场景下,相比baseline模型,本文提出的模型在5way-1shot和5way-5shot任务上的性能分别提升了9.31%和10.46%,说明本模型具有更好的泛化性。

| 表 4 在跨域场景miniImageNet → CUB上的实验结果 Table 4 Experimental results on cross-domain scenarios miniImageNet → CUB |

此外,本文的模型与baseline模型是利用在miniImageNet训练集上训练得到的模型直接对CUB数据集的测试集进行测试。而其他方法则是将整个miniImageNet数据集作为训练集,而将CUB数据集的验证集和测试集分别作为跨域场景下的验证集和测试集。这可能是本文复现的baseline模型ProtoNet在跨域场景上性能比文献[11]中复现的ProtoNet结果差的原因。但在利用更少的数据集的条件下,本文实现的结果优于除DeepEMD以外的其他方法,说明本文提出的模型能够在跨域上提供更多的可迁移信息,从而实现更好的泛化能力。

3.4 消融实验为了探究本文提出的方法中各个模块对模型的影响,本文针对模型中使用到的通道注意力模块(CAM) 、多尺度特征自适应融合模块(MSFAFM) 以及局部正交特征融合模块(LOFFM) 3个部分,在miniImageNet数据集上进行了消融实验。实验结果如表5所示,其中baseline+方法表示对浅层特征进行下采样,然后与深层特征相加进行简单融合。

| 表 5 在minImageNet上的消融实验 Table 5 Ablation experiments on minImageNet |

从表5中的实验结果可以看出,baseline+方法通过将浅层特征中的局部细节信息与深层特征中的全局信息简单进行聚合,就能相较baseline分别实现1.64%和1.92%的性能提升,证明局部特征和全局特征都能为区分类间的差异提供有用的信息,并且结合两者的信息有利于增强模型的表征能力。在baseline+方法的基础上,分别利用CAM和MSFAFM两个模块进一步增强模型对局部特征的重要通道和重要尺度的学习,结果表明相比baseline有了更显著的提升,在5way-1shot任务上分别提升了2.58%和2.98%,而在5way-5shot任务上分别提升了2.29%和2.90%,证明了这两个模块的有效性。而2个任务在使用CAM+MSFAFM的模型上,性能比baseline分别提升了3.36%和3.50%,说明同时从通道维度和空间尺度上关注图像的重要特征能够有效促进模型学习到更丰富且更具代表性的类别信息,实现更好的分类效果。相比baseline+方法直接使用相加的方式来融合两个特征,使用LOFFM的模型获得更高的分类准确率,在5way-1shot和5way-5shot两个任务上分别比baseline方法提高了4.28%和3.90%,说明局部正交特征能够提供更具区分性的类别属性特征,同时证明了结合局部−全局通道注意力模块(LG-CAM) 对正交局部特征与深层特征进行注意力融合的方法能够充分融合局部和全局上下文信息,进而为目标类别生成更准确的特征表示。

为了进一步探究不同层次上对局部特征和全局特征进行融合的效果,本文在miniImageNet数据集上对跨层次的局部全局特征融合以及多层次的局部全局特征融合方式进行了实验。实验结果如表6所示,其中B2+B4方法表示将第二个残差块的输出特征与最后一个残差块的输出特征进行融合;(B2+B3) +B4表示先将残差块B2的输出特征与残差块B3的输出特征进行融合,再将融合的特征与B4的输出特征进行融合。从结果上看,直接在最后两层进行特征融合的效果最好,本文分析可能是网络在最后两层中提取的是与类别更相关的特征信息,因此融合这两层的特征能够生成目标类别更具代表性的特征表示。而在更浅层的网络上提取到的更多是通用的纹理以及边缘等细节信息,这些特征信息可能无法很好地代表该类别的特征,因此融合这些特征无法为目标类别生成更具区分性的特征表示。同时,从(B2+B3) +B4方法的结果上看,更早地进行特征融合并没有提高模型的表征能力,反而可能影响了模型对目标类别特征的学习,导致更差的分类性能。

| 表 6 不同融合方式的效果 Table 6 The results of different fusion methods |

为了进一步评估本文方法的作用,在5way-1shot任务上,利用Grad-CAM[34]对本文方法和baseline模型进行了特征可视化。结果如图6所示,相较于baseline模型,本文的模型能够有效地将目标与背景区分开,并且能关注到目标类别的重要局部特征,因此最终生成的特征更具代表性,从而更容易在特征空间上拉大类间的距离,实现更好的分类效果。

|

图 6 在本文模型和baseline上的特征可视化结果 Figure 6 Feature visualization results on our model and baseline |

本文提出了一种基于局部正交特征融合的小样本图像分类方法,该方法通过将浅层特征的局部信息与深层特征的全局信息进行充分融合来丰富目标类别的特征表示。其中,浅层局部特征与深层全局特征分别由特征提取网络的最后两层输出得到。对于浅层局部特征,分别通过一个通道注意力模块(CAM) 和一个多尺度特征自适应融合模块(MSFAFM) 来学习通道上的重要特征,以及融合多个重要尺度的特征信息来适应目标物体的尺度变化。随后,提出一个局部正交特征融合模块(LOFFM) ,该模块首先在全局特征信息的引导下,提取出正交分量上更显著的局部特征,然后利用一个局部−全局通道注意力模块(LG-CAM) ,对正交局部特征与深层全局特征之间的局部上下文和全局上下文信息进行注意力融合。在3个公开数据集上的实验结果表明,本文方法可以显著提升baseline模型的性能,并且通过消融实验验证了各个模块的有效性。

| [1] |

HE K M, ZHANG X Y, REN S Q, et al. Deep residual learning for image recognition[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas: IEEE, 2016: 770-778.

|

| [2] |

REN S Q, HE K M, GIRSHICK R, et al. Faster R-CNN: towards real-time object detection with region proposal networks[J].

IEEE Transactions on Pattern Analysis and Machine Intelligence, 2016, 39(6): 1137-1149.

|

| [3] |

HE K M, GKIOXARI G, DOLLÁR P, et al. Mask r-cnn[C]//Proceedings of the IEEE International Conference on Computer Vision. Venice: IEEE, 2017: 2961-2969.

|

| [4] |

LI F F, FERGUS R, PERONA P. One-shot learning of object categories[J].

IEEE Transactions on Pattern Analysis and Machine Intelligence, 2006, 28(4): 594-611.

DOI: 10.1109/TPAMI.2006.79. |

| [5] |

TIAN Y L, WANG Y, KRISHNAN D, et al. Rethinking few-shot image classification: a good embedding is all you need?[C]//European Conference on Computer Vision. Glasgow: Springer, 2020: 266-282.

|

| [6] |

SNELL J, SWERSKY K, ZEMEL R. Prototypical networks for few-shot learning[C]//Proceedings of the 31st International Conference on Neural Information Processing Systems. Long Beach: MIT Press , 2017: 4080-4090.

|

| [7] |

VINYALS O, BLUNDELL C, LILLICRAP T, et al. Matching networks for one shot learning[C]//Proceedings of the 30th International Conference on Neural Information Processing Systems. Barcelona : MIT Press, 2016: 3637-3645.

|

| [8] |

SUNG F, YANG Y X, ZhANG L, et al. Learning to compare: relation network for few-shot learning[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Salt Lake City: IEEE, 2018: 1199-1208.

|

| [9] |

LI W B, WANG L, XU J L, et al. Revisiting local descriptor based image-to-class measure for few-shot learning[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. Long Beach: IEEE, 2019: 7260-7268.

|

| [10] |

HOU R B, CHANG H, MA B P, et al. Cross attention network for few-shot classification[C]//Proceedings of the 33rd International Conference on Neural Information Processing Systems. Vancouver : MIT Press, 2019: 4003-4014.

|

| [11] |

ZHANG C, CAI Y J, LIN G S, et al. DeepEMD: Differentiable earth mover's distance for few-shot learning[J].

IEEE Transactions on Pattern Analysis and Machine Intelligence, 2022(1): 1-17.

|

| [12] |

RAVI S, LAROCHELLE H. Optimization as a model for few-shot learning[C]//Proceedings of the IEEE Conference on Learning Representations. Toulon : OpenReview. net, 2017: 2332-2343.

|

| [13] |

HOCHREITER S, SCHMIDHUBER J. Long short-term memory[J].

Neural Computation, 1997, 9(8): 1735-1780.

DOI: 10.1162/neco.1997.9.8.1735. |

| [14] |

FINN C, ABBEEL P, LEVINE S. Model-agnostic meta-learning for fast adaptation of deep networks[C]//International Conference on Machine Learning. Sydney: ACM, 2017: 1126-1135.

|

| [15] |

LI Z G, ZHOU F W, CHEN F, et al. Meta-sgd: learning to learn quickly for few-shot learning[EB/OL]. arxiv: 1707.09835(2017-09-28) [2023-04-02]. https://arxiv.org/abs/1707.09835.

|

| [16] |

HU J, SHEN L, SUN G. Squeeze-and-excitation networks[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Salt Lake City: IEEE, 2018: 7132-7141.

|

| [17] |

WOO S, PARK J, LEE J Y, et al. CBAM: convolutional block attention module[C]//Proceedings of the European Conference on Computer Vision. Munich: Springer, 2018: 3-19.

|

| [18] |

WANG Q L, WU B G, ZHU P F, et al. ECA-Net: efficient channel attention for deep convolutional neural networks[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. Seattle: IEEE, 2020: 11534-11542.

|

| [19] |

ZHANG H, ZU K K, LU J, et al. EPSANet: an efficient pyramid split attention block on convolutional neural network[EB/OL]. arxiv: 2105.14447(2021-07-22) [2023-04-02] .https://arxiv.org/abs/2105.14447

|

| [20] |

DAI Y M, GIESEKE F, OEHMCKE S, et al. Attentional feature fusion[C]//Proceedings of the IEEE/CVF Winter Conference on Applications of Computer Vision. Waikoloa: IEEE, 2021: 3560-3569.

|

| [21] |

LIU W, RABINOVICH A, BERG A C. Parsenet: looking wider to see better[EB/OL]. arxiv: 1506.04579v2(2021-11-19) [2023-04-02].https://arxiv.org/abs/1506.04579v2.

|

| [22] |

LONG J, SHELHAMER E, DARREKK T. Fully convolutional networks for semantic segmentation[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Boston: IEEE, 2015: 3431-3440.

|

| [23] |

LIN B B, ZHANG S L, YU X. Gait recognition via effective global-local feature representation and local temporal aggregation[C]//Proceedings of the IEEE/CVF International Conference on Computer Vision. Vancouver: IEEE, 2021: 14648-14656.

|

| [24] |

YANG M, HE D L, FAN M, et al. DOLG: single-stage image retrieval with deep orthogonal fusion of local and global features[C]//Proceedings of the IEEE/CVF International Conference on Computer Vision. Vancouver: IEEE, 2021: 11772-11781.

|

| [25] |

SONG Y X, ZHU R L, YANG M, et al. DALG: deep attentive local and global modeling for image retrieval[EB/OL]. arxiv: 2207.00287(2022-07-01) [2023-04-02] .https://arxiv.org/abs/2207.00287 .

|

| [26] |

VASWANI A, SHAZEER N, PARMAR N, et al. Attention is all you need[C]//Proceedings of the 31st International Conference on Neural Information Processing Systems. Long Beach: MIT Press , 2017: 6000-6010.

|

| [27] |

CHEN L C, PAPANDREOU G, SCHROFF F, et al. Rethinking atrous convolution for semantic image segmentation[EB/OL]. arxiv: 1706.05587v3(2017-12-05) [2023-04-02].https://arxiv.org/abs/1706.05587v3 .

|

| [28] |

LEE K, MAJI S, RAVICHANDRAN A, et al. Meta-learning with differentiable convex optimization[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. Long Beach: IEEE, 2019: 10657-10665.

|

| [29] |

LIU B, CAO Y, LIN Y T, et al. Negative margin matters: understanding margin in few-shot classification[C]//European Conference on Computer Vision. Edinburgh: Springer, 2020: 438-455.

|

| [30] |

SIMON C, KONIUSZ P, NOUK R, et al. Adaptive subspaces for few-shot learning[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. Seattle: IEEE, 2020: 4136-4145.

|

| [31] |

CHEN W Y, LIU Y C, KIRA Z, et al. A Closer look at few-shot classification[C]//International Conference on Learning Representations. New Orleans: OpenReview. net, 2019: 4212-4223.

|

| [32] |

ORESHKIN B N, RODRIGUE P, LACOSTE A. TADAM: task dependent adaptive metric for improved few-shot learning[C]//Proceedings of the 32nd International Conference on Neural Information Processing Systems. Montréal : MIT Press , 2018: 719-729.

|

| [33] |

CHEN Y B, LIU Z, XU H J, et al. Meta-baseline: exploring simple meta-learning for few-shot learning[C]//Proceedings of the IEEE/CVF International Conference on Computer Vision. Montréal : IEEE, 2021: 9062-9071.

|

| [34] |

SELVARAJU R R, COGSWELL M, DAS A, et al. Grad-cam: visual explanations from deep networks via gradient-based localization[C]//Proceedings of the IEEE International Conference on Computer Vision. Honolulu: IEEE, 2017: 618-626.

|

2024, Vol. 41

2024, Vol. 41