近年来,由于无人机的高机动性、自主性和灵活性,无人机得到了广泛的关注,并已应用在生活中许多领域。例如,通过无人机观察实时路况,从而控制城市交通,以及使用无人机进行地震后的搜救工作[1-2]。文献[3]研究通过无人机来实现图像采集以及高分辨率的地形探测。除此之外,由于无人机可以通过安装小型通信设备,作为中继节点为地面用户提供通信服务,或者作为移动基站采集地面无线传感网络的数据,通过优化无人机轨迹来最大化地对地面设备进行数据收集。目前无人机辅助无线通信已经成为研究热点,跨越了多个方向,如缓存网络[4]、无线传感器网络[5]、异构蜂窝网络[6]、大规模多输入多输出[7]、设备到设备通信[8]和灾难通信[9-10]。

对于单无人机辅助数据收集的问题,前人进行了诸多研究。文献[11]考虑了一种无人机对多个地面用户进行数据收集的场景,通过对无人机轨迹和数据采集时间等进行联合优化,最大化最小数据量。文献[12]在无人机支持的无线传感器网络中对节能数据收集进行了研究,通过联合优化无人机轨迹和传感器节点唤醒时间以最小化所有传感器节点的最大能耗,同时确保能可靠地收集数据。文献[13]考虑一个无人机支持的无线传感器网络,其中无人机用于从多个传感器节点收集数据,研究联合优化无人机轨迹和通信调度,最大化所有传感器节点的最小平均数据收集率。已有研究表明,用无人机辅助无线通信对地面用户或传感器节点进行数据收集具有可行性和高效性。

尽管与无人机路径和数据收集相关的优化问题可以通过数学优化方法来解决[11-13],但是计算复杂度较高,计算量较大。由于强化学习可以提供低复杂度的解决方案,目前被用作一种新型工具来解决以上问题。例如,文献[14]研究了无人机作为一个移动基站服务多个用户时的最优轨迹问题,利用Q-learning算法优化轨迹,最大限度地提高了传输速率。文献[15]研究了无人机数据采集场景下的轨迹优化问题,利用DQN(Deep Q-network)算法通过优化无人机轨迹采集所需数据。事实证明,利用强化学习方法可以大大减少计算量,降低计算复杂度[14-15]。

但是面对用户分布广阔且分散的情况,单无人机则显得力不从心,难以很好地完成数据收集任务,因此有必要研究使用多架无人机辅助数据收集。文献[16]研究了在分布式物联网环境下利用多无人机进行数据收集时的路径规划问题,在飞行时间和避碰约束的条件下,引入了一种基于DDQN(Double DQN)的强化学习方法解决了以上轨迹优化问题,同时最大限度地收集了物联网节点的数据。文献[17]研究通过规划多个无人机的轨迹对物联网节点的数据进行采集,为了在避免碰撞和通信干扰等约束下最小化任务时间,提出了一种三步式方法来求解这个问题,包括基于任务分配的K-means算法以及基于深度强化学习的分布式和集中式轨迹设计方法。

然而,无人机机载能量是有限的,它决定了无人机的飞行时间,而无人机的飞行时间直接影响数据采集的性能。现有的研究大多忽略了实际应用中无人机严格的飞行时间限制。同时,通常假设地面用户为静止状态且环境已知。实际上,用户往往具有移动性,且移动目的无法精确预测。传统的优化决策方法一般用来解决静态规划问题,如旅行商问题[18]。为了解决这些难题,本文使用一种新型深度强化学习算法——Dueling-DDQN来优化多无人机路径,最大化收集数据。强化学习算法相比传统优化决策方法可以更好地解决无模型动态规划问题,同时此算法既结合了DDQN将TD(Temporal-Difference)目标的动作选择和动作评估分别用不同的值函数来实现的优点,又采用了Dueling网络架构,使估算的函数值更准确,很好地解决了传统DQN算法的过估计问题[19]。

本文主要贡献:(1) 本文在吞吐量的获取、无人机轨迹和无人机成功到达终点之间取得了良好的权衡,解决了严格的飞行时间限制下无人机的路径规划问题。(2) 目前关于动态用户的研究较少,在系统模型中本文考虑用户随机分布,同时遵循随机游走模型移动,在实际应用中具有较大的适用范围。(3) 本文考虑无人机起点和终点约束、边界碰撞约束、无人机防碰撞约束、通信距离约束以及用户通信约束,为了使无人机在最短时间内到达终点,同时最大化采集地面用户数据,本文提出了基于Dueling-DDQN的多无人机辅助数据收集系统智能路径规划算法。该算法既结合了DDQN的优点,同时又采用了独特的对抗式架构,具有良好的学习能力、收敛速度以及稳定性。(4) 仿真结果表明,所提算法可以很好地完成本文研究目标,相比两个基准算法具有最优的收敛性和鲁棒性。

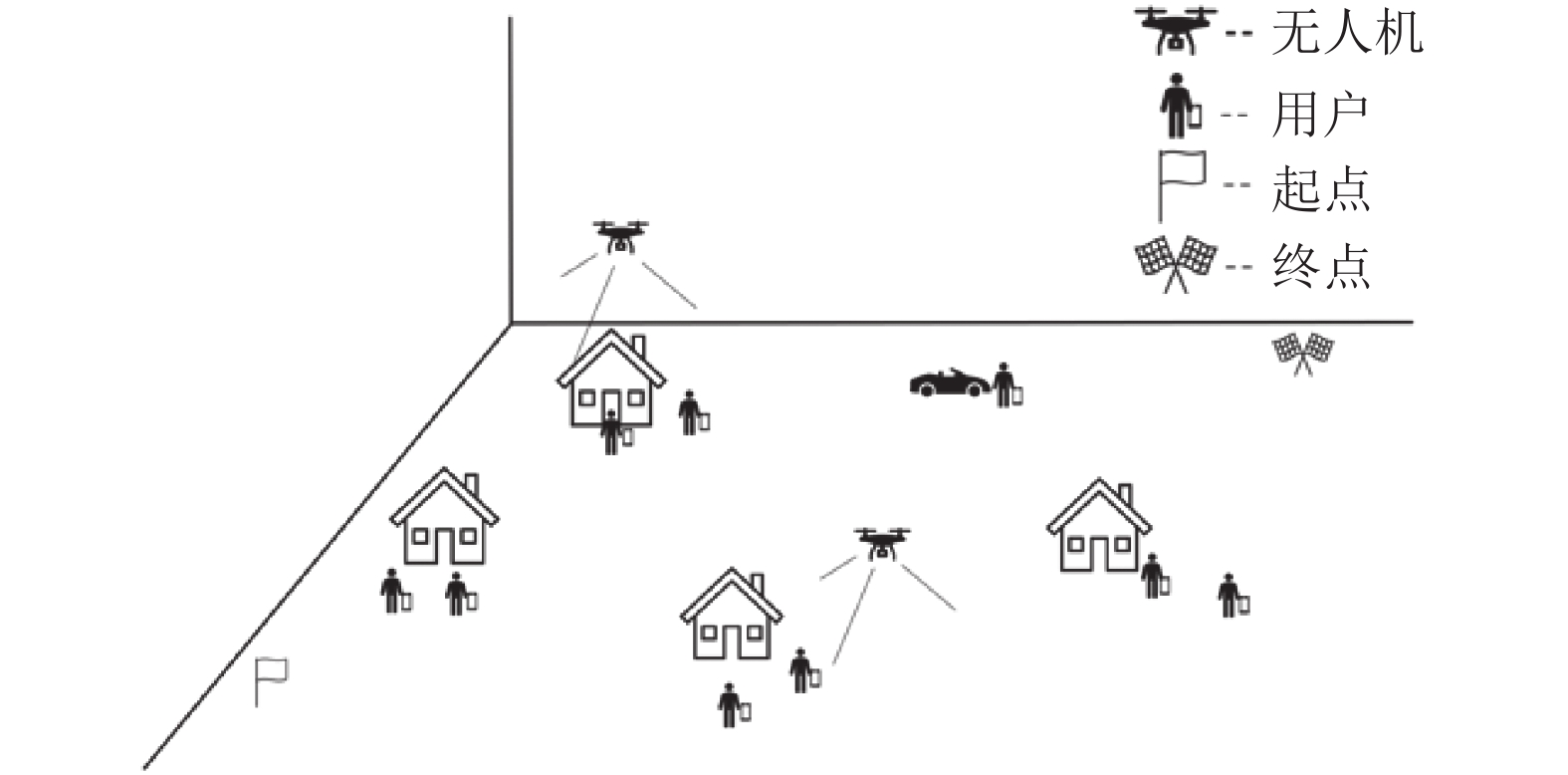

1 系统模型如图1所示,本文考虑一个多无人机辅助数据收集系统,

|

图 1 多无人机辅助数据收集系统模型 Figure 1 Model of a multi-UAV-assisted data collection system |

由于尺寸限制,考虑无人机和用户都具有单天线,所有无人机起点和终点位置的水平坐标分别为(

| $ {d}_{i,j}^{t}=\sqrt{{({x}_{i}^{t}-{x}_{j}^{t}) }^{2}+{({y}_{i}^{t}-{y}_{j}^{t}) }^{2}} $ | (1) |

式中:

在第

| $ {d}_{m,k,i}^{t}=\sqrt{{({x}_{i}^{t}-{x}_{m,k}^{t}) }^{2}+{({y}_{i}^{t}-{y}_{m,k}^{t}) }^{2}+{H}^{2}} $ | (2) |

由于无人机与用户之间的通信信道由视线链路主导,在第

| $ {h}_{m,k,i}^{t}={\beta }_{0}{{d}_{m,k,i}^{t}}^{-2}=\frac{{\beta }_{0}}{{({x}_{i}^{t}-{x}_{m,k}^{t}) }^{2}+{({y}_{i}^{t}-{y}_{m,k}^{t}) }^{2}+{H}^{2}} $ | (3) |

式中:

当用户处于无人机覆盖范围内,即满足通信距离约束时,第

| $ {R}_{m,k,i}^{t} = B{\mathrm{l}\mathrm{o}\mathrm{g}}_{2}\Biggr(1+\frac{{p}_{m,k}^{t}{h}_{m,k,i}^{t}}{\displaystyle\sum _{a\ne m}^{M}\displaystyle\sum _{b}^{K}{p}_{a,b}^{t}{h}_{a,b}^{t}+\displaystyle\sum _{c\ne k}^{K}{p}_{m,c}^{t}{h}_{m,c}^{t}+{\alpha }^{2}}\Biggr) ,\forall m,k $ | (4) |

式中:

| $ {R}_{m,k}^{t}={\displaystyle{\sum }}_{i=1}^{N}{R}_{m,k,i}^{t} $ | (5) |

若仅被无人机

| $ {R}_{m,k}={{\displaystyle\sum }}_{t=1}^{t}{R}_{m,k}^{t},\forall m,k $ | (6) |

本文考虑用户通信约束

| $ {T}_{\mathrm{a}\mathrm{v}\mathrm{e}\mathrm{r}\mathrm{a}\mathrm{g}\mathrm{e}}=\frac{{{\displaystyle\sum }}_{m}^{M}{{\displaystyle\sum }}_{k}^{K}P\left(m,k\right) {R}_{m,k}}{MK},P\left(m,k\right) =\left\{\mathrm{0,1}\right\} $ | (7) |

为了最大化用户平均吞吐量,保证无人机的最短飞行时间,本文在所有无人机的飞行起点和终点约束、边界碰撞约束、无人机防碰撞约束、通信距离约束以及用户通信约束下,研究了多无人机路径规划问题,优化问题可以表述为

| $ \mathrm{max}\;\;{T}_{\mathrm{a}\mathrm{v}\mathrm{e}\mathrm{r}\mathrm{a}\mathrm{g}\mathrm{e}}\qquad\qquad $ | (8) |

| $ \qquad\qquad\qquad\qquad {\rm{s}}.{\rm{t}}.\left\{ \begin{array}{l} {X}_{i}^{\mathrm{u}\mathrm{a}\mathrm{v}\mathrm{f}}={X}_{\mathrm{f}}\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;(9)\\ {Y}_{i}^{\mathrm{u}\mathrm{a}\mathrm{v}\mathrm{f}}={Y}_{\mathrm{f}}\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\,(10)\\ 0\le {X}_{i}\left(t\right) \le {X}_{\mathrm{b}\mathrm{o}\mathrm{u}\mathrm{n}\mathrm{d}}\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\,(11)\\ 0\le {Y}_{i}\left(t\right) \le {Y}_{\mathrm{b}\mathrm{o}\mathrm{u}\mathrm{n}\mathrm{d}}\,\,\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\,(12)\\ {d}_{i,j}^{t}\ge L\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;(13)\\ {d}_{m,k,i}^{t}\le {d}_{\mathrm{c}\mathrm{o}\mathrm{n}\mathrm{s}}\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\,(14)\\ {R}_{m,k}\ge {r}_{\mathrm{m}\mathrm{i}\mathrm{n}}\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\,(15)\\ P\left(m,k\right) =\left\{\mathrm{0,1}\right\}\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\,(16) \end{array} \right.$ |

式中:

问题(8)~(16) 是一个非凸的优化问题,使用传统的优化决策方法需要进行复杂的数学分析和数学推导,随着无人机数量的增加,计算成本也可能会增加,且不能保证求得最优解。深度强化学习作为机器学习的一个重要分支,可为复杂系统的感知和决策问题提供低复杂度的解决方案,具有强大的数据处理能力[20-21]。

3 基于深度强化学习的多无人机路径规划本文提出使用Dueling-DDQN算法设计多无人机轨迹,解决上述优化问题。Dueling-DDQN算法采用Dueling网络架构,同时结合了DDQN算法的优势,有效避免了因过大估计

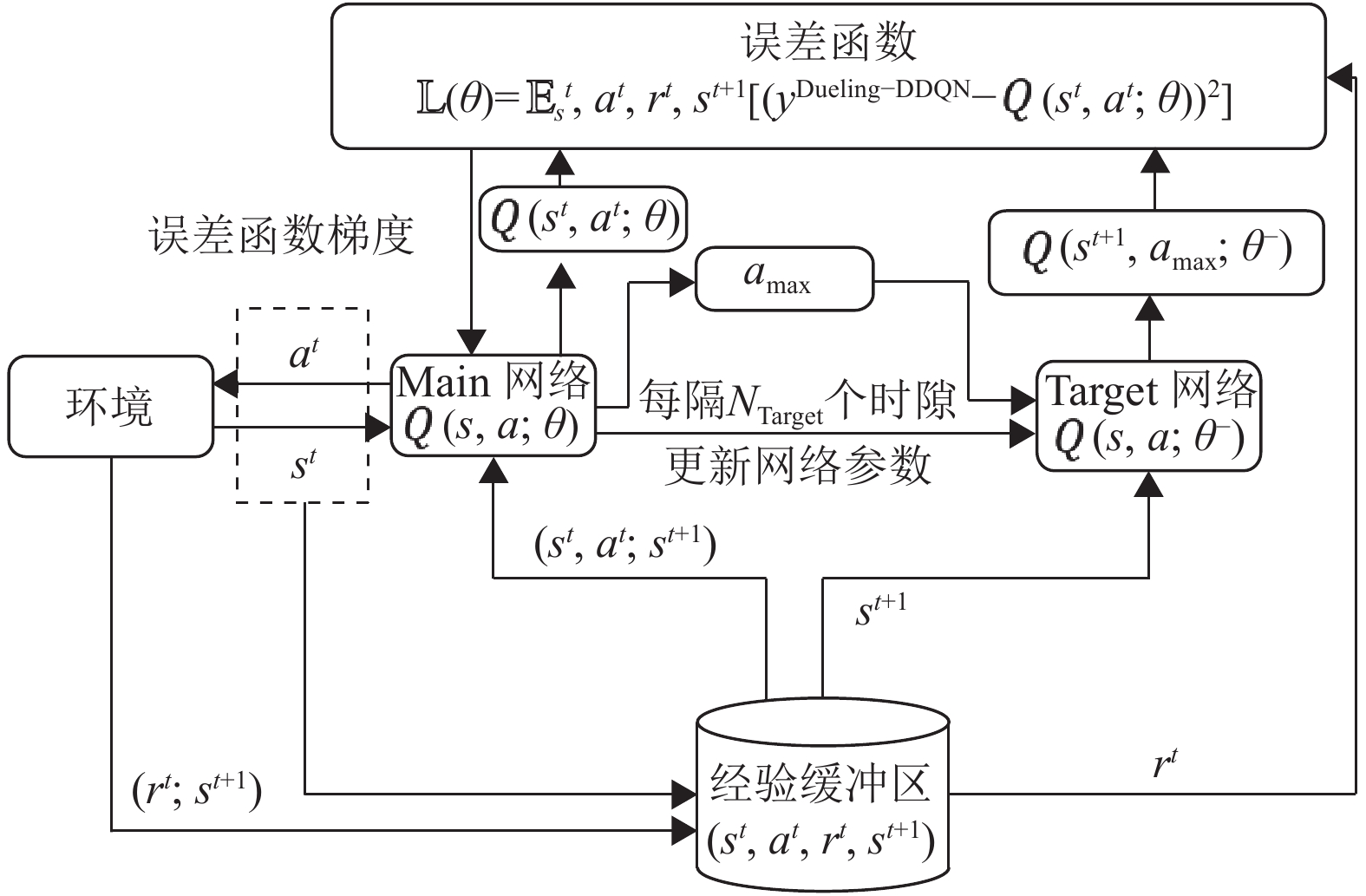

Dueling-DDQN算法的框架如图2所示,它主要由Main网络、Target网络、环境和经验缓冲区组成,在第t时隙,智能体通过与环境交互观察到状态

|

图 2 Dueling-DDQN算法框架图 Figure 2 Framework of the Dueling-DDQN algorithm |

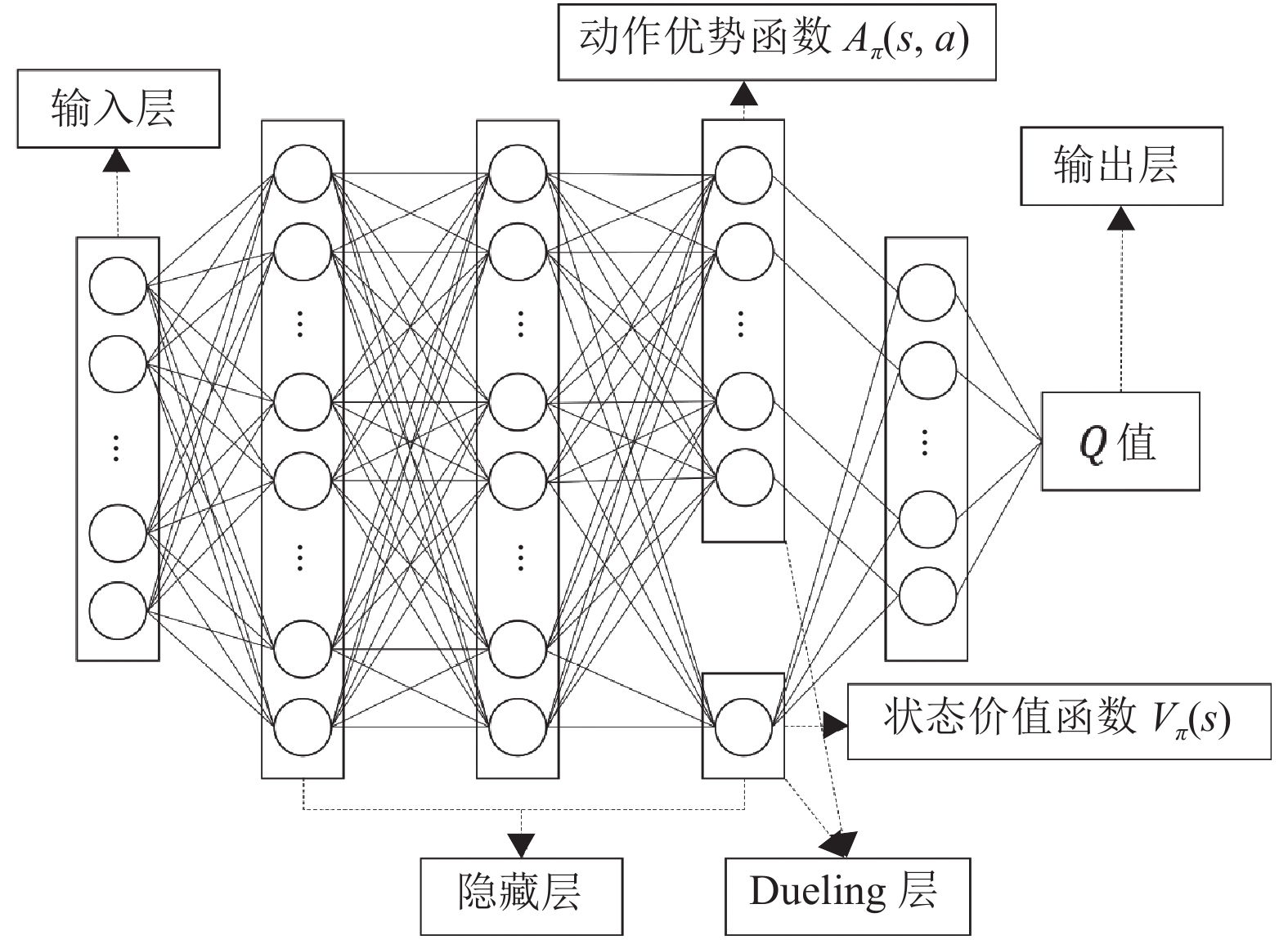

Dueling-DDQN算法采用双网络结构,包括参数为

|

图 3 Main网络(Target网络) 神经网络图 Figure 3 Neural network chart of Main network (Target network) |

Dueling-DDQN是一种迭代求解贝尔曼方程的无模型强化学习算法,其状态动作价值函数定义为

| $ {Q}_{\pi }({s}^{t},{a}^{t}) ={r}^{t}+\gamma \sum _{{s}^{t+1}\in S}{P}_{{s}^{t}{s}^{t+1}}^{{a}^{t}}\Bigg[\sum _{{a}^{t+1}\in A}\pi ({a}^{t+1}|{s}^{t+1}) {Q}_{\pi }({s}^{t+1},{a}^{t+1}) \Bigg] $ | (17) |

式中:

| $ \left\{ \begin{aligned} & {a}_{\mathrm{m}\mathrm{a}\mathrm{x}}=\mathrm{arg}\;\underset{a}{\mathrm{m}\mathrm{a}\mathrm{x}}Q\left({s}^{t+1},a;\theta \right) \\& {y}^{\mathrm{D}\mathrm{u}\mathrm{e}\mathrm{l}\mathrm{i}\mathrm{n}\mathrm{g}-\mathrm{D}\mathrm{D}\mathrm{Q}\mathrm{N}}={r}^{t}+\gamma Q({s}^{t+1},{a}_{\mathrm{m}\mathrm{a}\mathrm{x}};{\theta }^-) \end{aligned}\right. $ | (18) |

同时,此算法把动作价值函数

| $ {Q}_{\pi }\left(s,a;\theta ,\alpha ,\beta \right) ={V}_{\pi }\left(s;\theta ,\alpha \right) +{A}_{\pi }(s,a;\theta ,\beta ) $ | (19) |

式中:

Dueling-DDQN算法设置了经验缓冲区,将经验

为了实现用户平均吞吐量最大化,本文依次对智能体、状态、动作和奖励进行定义。

智能体:多无人机整体充当一个智能体,通过不断与环境进行交互寻找最优策略。

状态

动作

| $ A=\{\mathrm{l}\mathrm{e}\mathrm{f}\mathrm{t},\mathrm{r}\mathrm{i}\mathrm{g}\mathrm{h}\mathrm{t},\mathrm{f}\mathrm{o}\mathrm{r}\mathrm{w}\mathrm{a}\mathrm{r}\mathrm{d},\mathrm{b}\mathrm{a}\mathrm{c}\mathrm{k}\mathrm{w}\mathrm{a}\mathrm{r}\mathrm{d}\} $ | (20) |

式中:

| $ {a}^{t}=\{\mathrm{f}\mathrm{o}\mathrm{r}\mathrm{w}\mathrm{a}\mathrm{r}\mathrm{d},\mathrm{r}\mathrm{i}\mathrm{g}\mathrm{h}\mathrm{t}\} $ | (21) |

表示无人机1向前移动,同时无人机2向右移动。

奖励

| $ {R}_{\mathrm{f}\mathrm{i}\mathrm{n}\mathrm{a}\mathrm{l}}=\left\{ \begin{aligned} & 2\;000\text{,}{X}_{i}\left(t\right) ={X}_{\mathrm{f}}\;{\rm{and}}\;{Y}_{i}\left(t\right) ={Y}_{\mathrm{f}}\\& 0\text{,}{\rm{otherwise}} \end{aligned}\right. $ | (22) |

无人机飞行轨迹越长,整条路径上获得的步数惩罚

因此,在第

| $ {r}^{t}={T}_{\mathrm{a}\mathrm{v}\mathrm{e}\mathrm{r}\mathrm{a}\mathrm{g}\mathrm{e}}+{R}_{\mathrm{s}\mathrm{p}}+{R}_{\mathrm{b}\mathrm{p}}+{R}_{\mathrm{c}\mathrm{p}}+{R}_{\mathrm{f}\mathrm{i}\mathrm{n}\mathrm{a}\mathrm{l}} $ | (23) |

当

| $ {y}^{\mathrm{D}\mathrm{u}\mathrm{l}\mathrm{i}\mathrm{n}\mathrm{g}-\mathrm{D}\mathrm{D}\mathrm{Q}\mathrm{N}}{=r}^{t} $ | (24) |

当

| $ {y}^{\mathrm{D}\mathrm{u}\mathrm{l}\mathrm{i}\mathrm{n}\mathrm{g}-\mathrm{D}\mathrm{D}\mathrm{Q}\mathrm{N}}=\begin{array}{c}\\ {r}^{t}+\gamma Q({s}^{t+1},{\rm{arg}}\,\underset{a}{\mathrm{m}\mathrm{a}\mathrm{x}}Q({s}^{t+1},a;\theta ) ,{\theta }^-) \end{array} $ | (25) |

本文所提的基于Dueling-DDQN的多无人机辅助数据收集系统智能路径规划的完整算法见算法1。

算法1 基于Dueling-DDQN的多无人机辅助数据收集系统智能路径规划算法

1. 初始化:Main网络的参数

2. 对于每一个episode:

3. 初始化多无人机坐标以及系统状态;

4. 在当前系统状态

| $ {{a}^{t}=\left\{\begin{aligned} & {\rm{random\;action}},\varepsilon \\& {\rm{arg}}\;\;\underset{a}{\mathrm{m}\mathrm{a}\mathrm{x}}Q({s}^{t},a) ,1-\varepsilon \end{aligned} \right.} $ |

5. 执行动作

6. 获得下一个环境状态

7. 将元组

8. 如果经验回放池R储存经验数量大于容量阈值

9. 随机从经验回放池中抽取

10. 用梯度下降法更新网络参数,使损失最小化:

| $ {\mathbb{L}(\theta ) ={\mathbb{E}}_{{s}^{t},{a}^{t},{r}^{t},{s}^{t+1}}[{({y}^{\mathrm{D}\mathrm{u}\mathrm{e}\mathrm{l}\mathrm{i}\mathrm{n}\mathrm{g}-\mathrm{D}\mathrm{D}\mathrm{Q}\mathrm{N}}-Q({s}^{t},{a}^{t};\theta ) ) }^{2}] \text{,} }$ |

梯度更新为:

| $ {\qquad\quad {\nabla }_{\theta }\mathbb{L}(\theta ) ={\mathbb{E}}_{{s}^{t},{a}^{t},{r}^{t},{s}^{t+1}}[({y}^{\mathrm{D}\mathrm{u}\mathrm{e}\mathrm{l}\mathrm{i}\mathrm{n}\mathrm{g}-\mathrm{D}\mathrm{D}\mathrm{Q}\mathrm{N}}-Q({s}^{t},{a}^{t};\theta ) ) {\nabla }_{\theta }Q({s}^{t},{a}^{t};\theta ) ] \text{,}} $ |

11. 更新状态

12. 每隔一定步数更新Target网络参数

13. 如果所有无人机均到达终点,进入下一个episode, 返回3;如果所有的episode都已经执行完,则训练过程 结束;否则返回4。

4 仿真结果本文设定无人机在

| 表 1 仿真参数 Table 1 Simulation parameters |

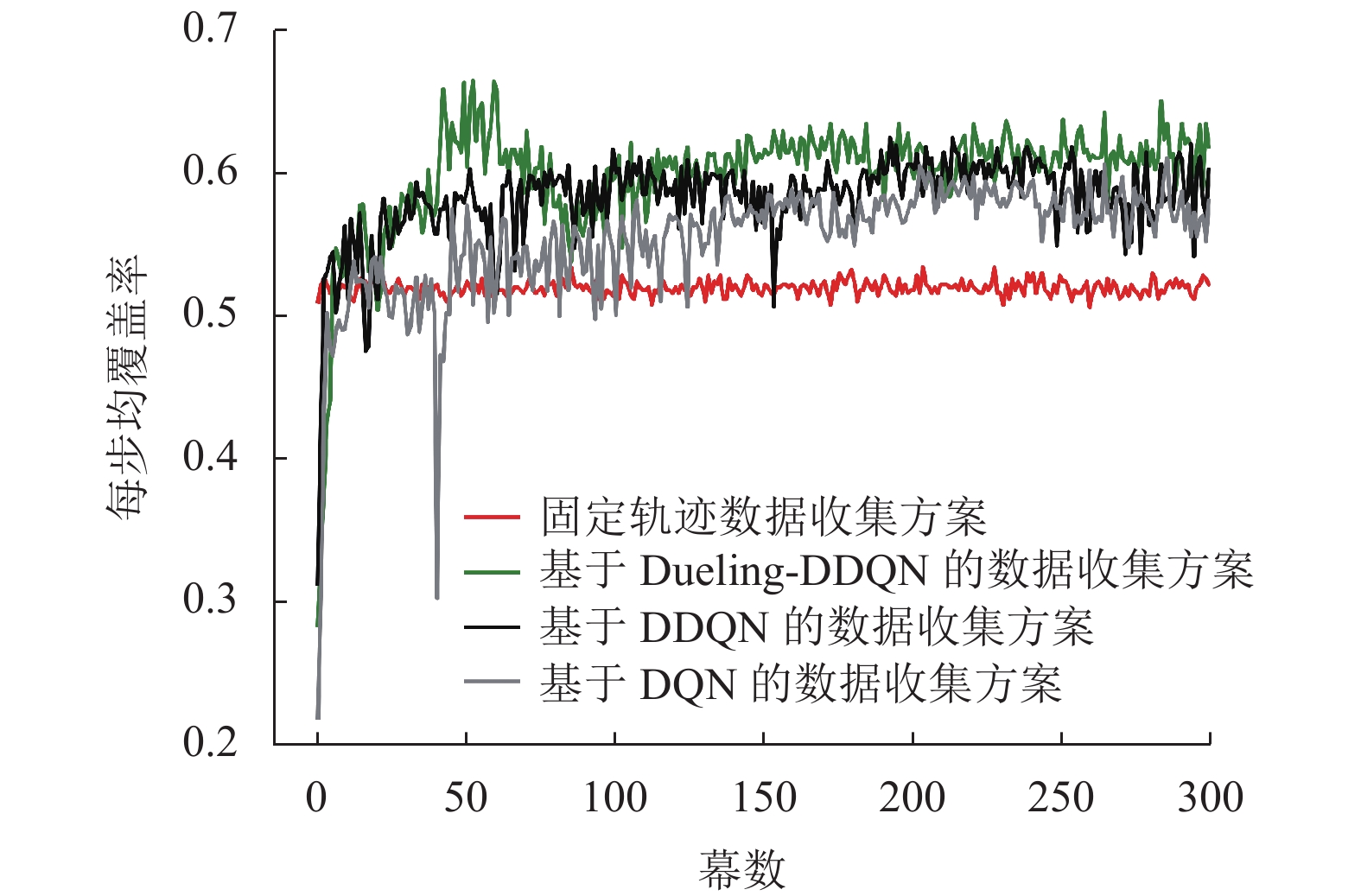

仿真考虑两个场景——“单无人机场景”与“两无人机场景”。在两个场景下将本文所提方案简称为“基于Dueling-DDQN的数据收集方案”。为进行比较,在两个场景中将DQN和DDQN算法辅助数据收集作为对比方案。这两种对比方案的状态、动作和奖励等的定义与“基于Dueling-DDQN的数据收集方案”一致。DDQN和DQN算法同样采用双网络结构,不同之处在于DDQN算法通过解耦目标

由于当用户总吞吐量

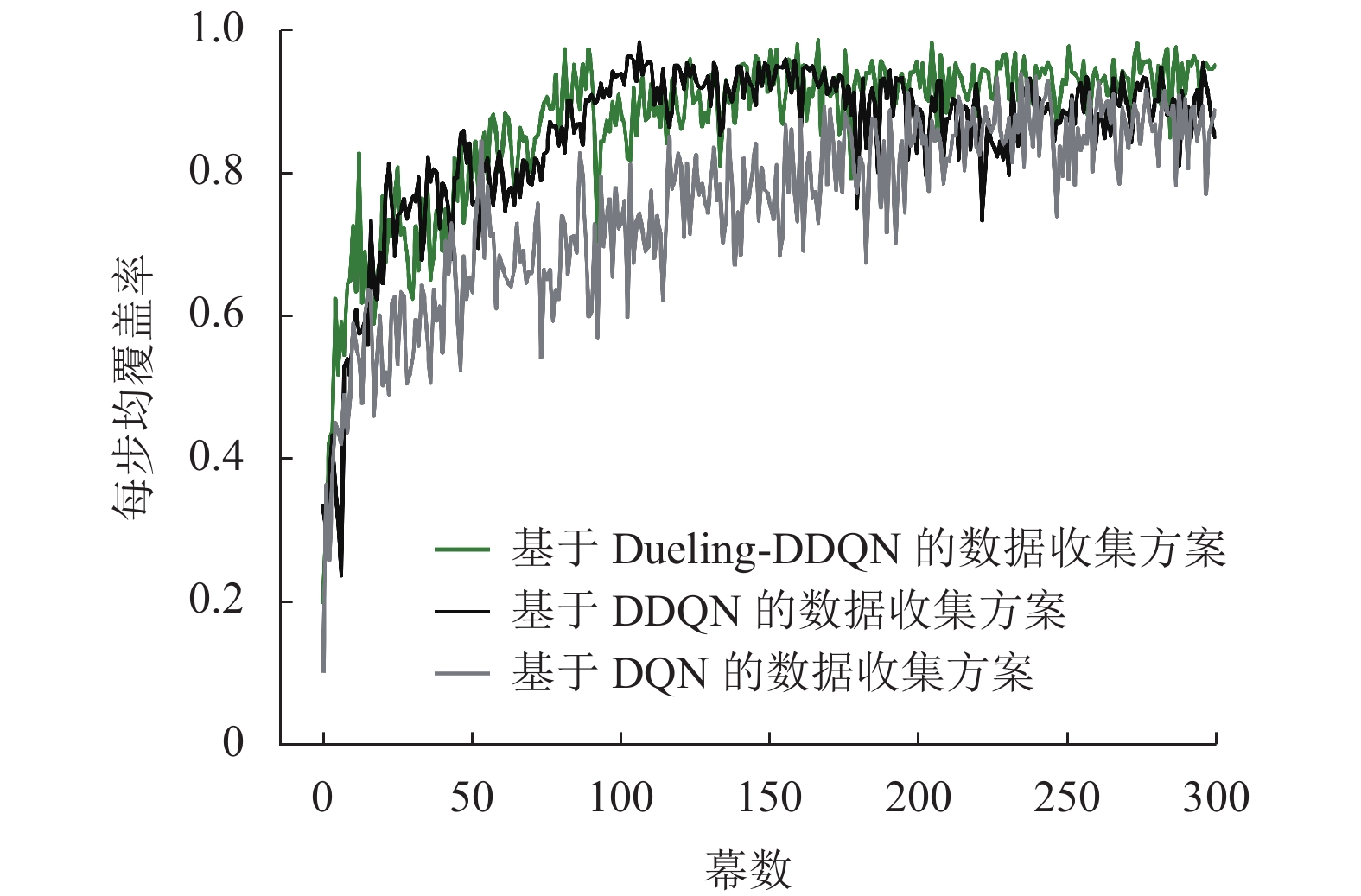

图4给出了“单无人机场景”下不同方案的无人机每步均覆盖率对比图。可以看出,“固定轨迹数据收集方案”无人机每步均覆盖率基本保持不变且低于其他3种方案,这是因为在每一幕中无人机飞行的轨迹相同,所服务的地面用户基本固定不变。这说明强化学习算法具备自主学习的能力,在训练时会通过与环境交互最大化本文优化目标。在“基于DQN的数据收集方案”中,无人机每步均覆盖率在50幕之前较低,这是由于DQN算法在网络训练初期对

|

图 4 “单无人机场景”下基于不同方案的无人机每步均覆盖率对比图 Figure 4 Comparison of average per-step coverage ratios of different schemes in the single-UAV scenario |

图5给出了“两无人机场景”下不同方案的无人机每步均覆盖率对比图。从图中可以观察到,“基于DQN的数据收集方案”在训练初期依旧存在过估计问题,同时训练过程波动较大,在200幕左右开始收敛。“基于DDQN的数据收集方案”虽然解决了DQN方案训练初期的过估计问题,但是由于存在网络训练波动较大的问题,在150~230幕之间无人机每步均覆盖率下滑严重,最终在230幕之后开始收敛。本文所提方案在训练初期每步均覆盖率增长迅速,在第123幕之后开始收敛,且相比上述两种基准方案具有更佳的收敛值。经计算,上述3种方案在训练后期(200~300幕)的覆盖率方差分别为1.7×10−3、1.4×10−3、8×10−4,可以发现本文所提方案方差最小,具有更加稳定的性能。综合图4和图5分析得出,本文所提算法优于两种基准算法,既能很好地解决DQN算法的过估计问题,又能克服两种对比算法波动较大的问题,具有更好的学习能力、收敛速度和鲁棒性,更适合用于解决无人机路径规划和数据收集问题。

|

图 5 “两无人机场景”下基于不同方案的无人机每步均覆盖率对比图 Figure 5 Comparison of average per-step coverage ratios of different schemes in the dual-UAV scenario |

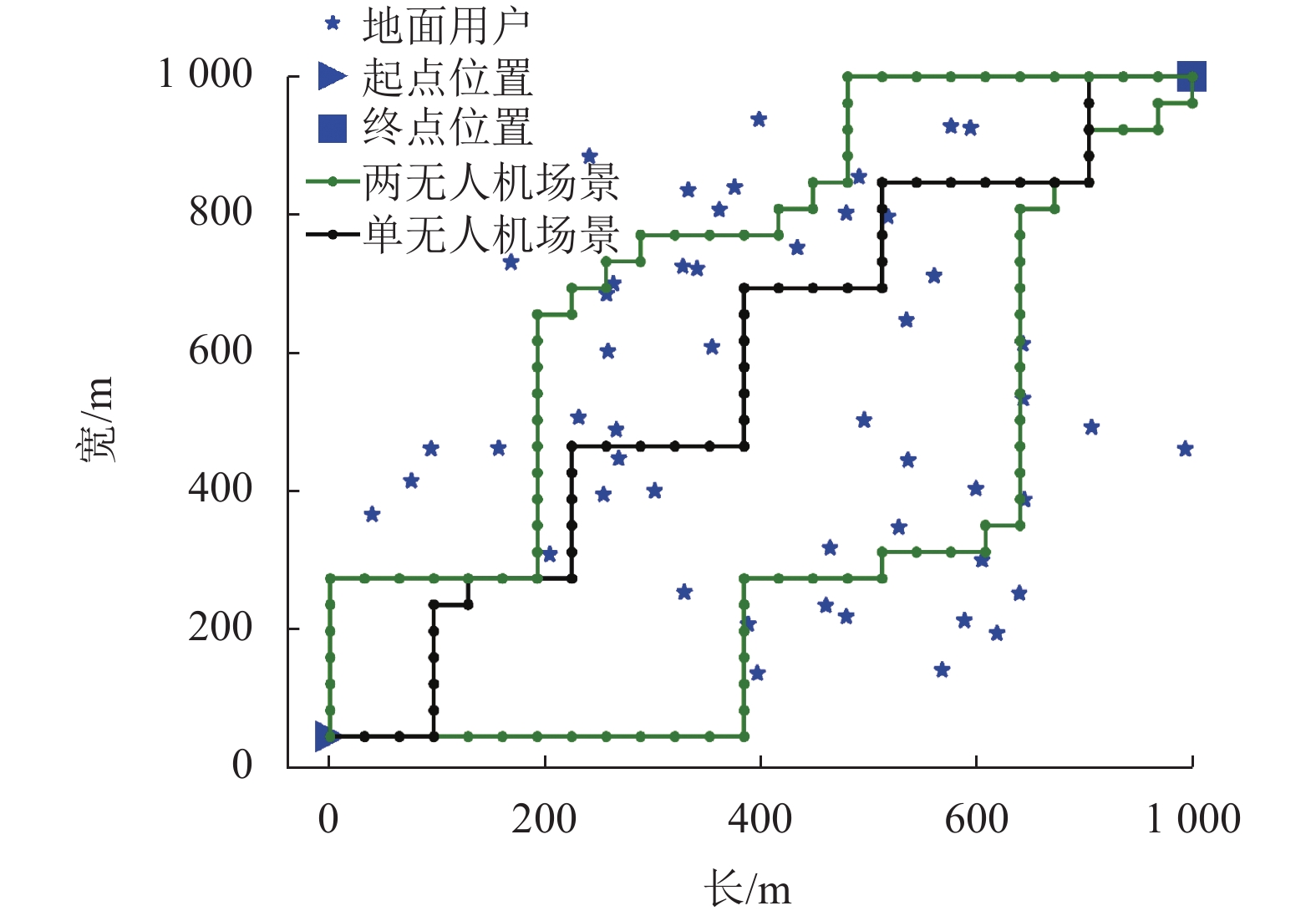

图6为本文所提算法在“单无人机场景”和“两无人机场景”下的无人机二维飞行轨迹对比图。可以观察到,在这两种场景下无人机都能在最短时间内到达终点。在“单无人机场景”下无人机轨迹分布居中呈“之”字型,这样可以充分利用单个无人机的覆盖范围最大化数据收集。“两无人机场景”下无人机路径未出现重合现象,能够很好地避免无人机之间产生碰撞。同时轨迹分散在两侧,这样能扩大无人机对用户的覆盖范围,充分利用无人机的数量优势最大化收集数据。

|

图 6 基于Dueling-DDQN的算法在不同场景下的无人机轨迹对比图 Figure 6 Comparison of UAV trajectories in different scenarios based on the Dueling-DDQN scheme |

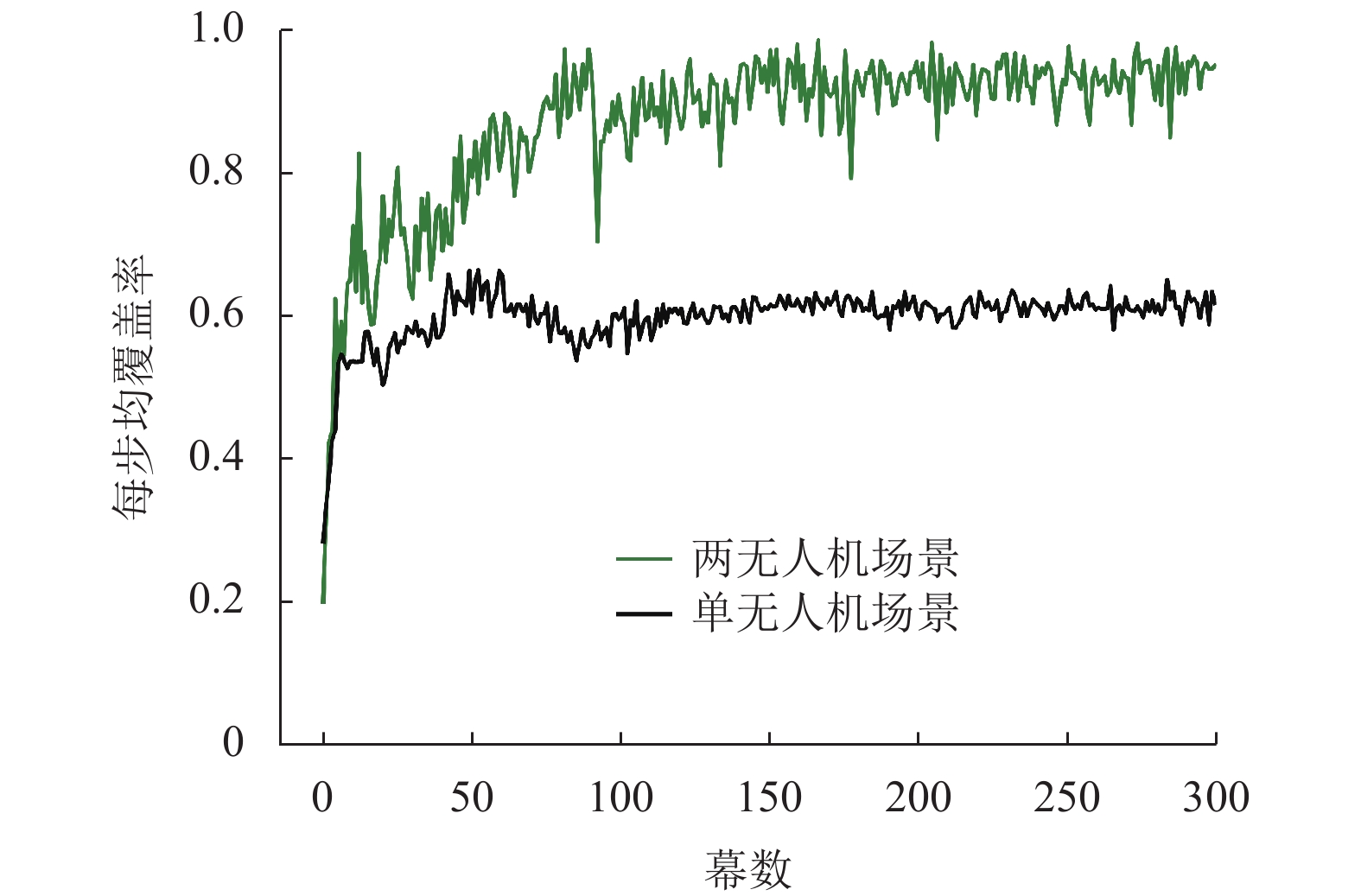

图7给出了本文所提算法在不同场景下的无人机每步均覆盖率对比图。可以发现,在“两无人机场景”无人机每步均覆盖率的值接近1.0,而“单无人机场景”下每步均覆盖率在0.6左右,远低于前者。结合图6无人机轨迹可以发现,本文所提算法在两种场景下都能使无人机在最短时间内到达终点。经简单计算可以得出,在“两无人机场景”下无人机可以覆盖约50个用户,接近饱和,而“单无人机场景”下在训练收敛以后无人机覆盖用户数约为30。分析得出,本文所提算法可以很好地完成研究目标,能够使无人机在最短时间内从起点飞往终点,并在此过程中最大化收集用户平均吞吐量。同时,在本文所考虑的系统模型中两无人机辅助数据收集相比单无人机性能提升明显,基本可以实现用户全覆盖,解决了单无人机在用户分布分散且具备移动能力时覆盖不全的问题,体现了研究多无人机辅助数据收集的有效性和必要性。

|

图 7 基于Dueling-DDQN的算法在不同场景下的无人机每步均覆盖率对比图 Figure 7 Comparison of average per-step coverage ratios in different scenarios based on the Dueling-DDQN scheme |

本文研究了一种多无人机辅助数据收集系统的智能路径规划算法,无人机作为移动基站为地面用户提供通信服务。本文的研究目标是通过规划多架无人机的轨迹,使无人机在最短时间内到达终点的同时最大化收集数据。考虑到飞行时间限制、用户分布分散等问题,本文提出了基于Dueling-DDQN的多无人机辅助数据收集系统智能路径规划算法。仿真结果表明,所提算法可以实现本文研究目标,在本文所考虑的系统模型中解决了单无人机辅助数据收集时用户覆盖不全的问题。同时,所提算法与两种基准算法相比具有更好的收敛性、鲁棒性和学习能力。

| [1] |

ZHAO N, LU W D, SHENG M, et al. UAV-assisted emergency networks in disasters[J].

IEEE Wireless Communications, 2019, 26(1): 45-51.

DOI: 10.1109/MWC.2018.1800160. |

| [2] |

ZENG Y, ZHANG R, LIM T J. Wireless communications with unmanned aerial vehicles: opportunities and challenges[J].

IEEE Communications Magazine, 2016, 54(5): 36-42.

DOI: 10.1109/MCOM.2016.7470933. |

| [3] |

GAO M, XU X, KLINGER Y, et al. High-resolution mapping based on an unmanned aerial vehicle (UAV) to capture paleoseismic offsets along the Altyn-Tagh fault, China[J].

Sci Rep, 2017, 7(1): 1-11.

DOI: 10.1038/s41598-016-0028-x. |

| [4] |

ZHONG C, GURSOY M C, VELIPASALAR S. Deep reinforcement learning-based edge caching in wireless networks[J].

IEEE Transactions on Cognitive Communications and Networking, 2020, 6(1): 48-61.

DOI: 10.1109/TCCN.2020.2968326. |

| [5] |

GONG J, CHANG T, SHEN C, et al. Flight time minimization of UAV for data collection over wireless sensor networks[J].

IEEE Journal on Selected Areas in Communications, 2018, 36(9): 1942-1954.

DOI: 10.1109/JSAC.2018.2864420. |

| [6] |

WU H, WEI Z, HOU Y, et al. Cell-edge user offloading via flying UAV in non-uniform heterogeneous cellular networks[J].

IEEE Transactions on Wireless Communications, 2020, 19(4): 2411-2426.

DOI: 10.1109/TWC.2020.2964656. |

| [7] |

HUANG H, YANG Y, WANG H, et al. Deep reinforcement learning for UAV navigation through massive MIMO technique[J].

IEEE Transactions on Vehicular Technology, 2020, 69(1): 1117-1121.

DOI: 10.1109/TVT.2019.2952549. |

| [8] |

MOZAFFARI F, SAAD W, BENNIS M, et al. Unmanned aerial vehicle with underlaid device-to-device communications: performance and tradeoffs[J].

IEEE Transactions on Wireless Communications, 2016, 15(6): 3949-3963.

DOI: 10.1109/TWC.2016.2531652. |

| [9] |

DUONG T Q, NGUYEN L D, TUAN H D, et al. Learning-aided realtime performance optimisation of cognitive UAV-assisted disaster communication[C]//2019 IEEE Global Communications Conference (GLOBECOM) . Waikoloa: IEEE, 2019: 1-6.

|

| [10] |

DUONG T Q, NGUYEN L D, NGUYEN L K, et al. Practical optimization of path planning and completion time of data collection for UAV-enabled disaster communications[C]// 2019 15th International Wireless Communications & Mobile Computing Conference (IWCMC) . Tangier: IEEE, 2019: 372-377.

|

| [11] |

WANG K, TANG, LIU P, et al. UAV-based and energy-constrained data collection system with trajectory, time, and collection scheduling optimization[C]// International Conference on Communications in China (ICCC) . Xiamen: IEEE, 2021: 893-898.

|

| [12] |

ZHAN C, ZENG Y, ZHANG R. Energy-efficient data collection in UAV enabled wireless sensor network[J].

IEEE Wireless Communications Letters, 2018, 7(3): 328-331.

DOI: 10.1109/LWC.2017.2776922. |

| [13] |

YOU C, ZHANG R. 3D trajectory optimization in Rician fading for UAV-enabled data harvesting[J].

IEEE Transactions on Wireless Communications, 2019, 18(6): 3192-3207.

DOI: 10.1109/TWC.2019.2911939. |

| [14] |

BAYERLEIN H, DE KERRET P, GESBERT D. Trajectory optimization for autonomous flying base station via reinforcement learning[C]// 2018 IEEE 19th International Workshop on Signal Processing Advances in Wireless Communications (SPAWC) . Kalamata: IEEE, 2018: 1-5.

|

| [15] |

ZHANG B, LIU C H, TANG J, et al. Learning-based energy-efficient data collection by unmanned vehicles in smart cities[J].

IEEE Transactions on Industrial Informatics, 2018, 14(4): 1666-1676.

DOI: 10.1109/TII.2017.2783439. |

| [16] |

BAYERLEIN H, THEILE M, CACCAMO, et al. Multi-UAV path planning for wireless data harvesting with deep reinforcement learning[J].

IEEE Open Journal of the Communications Society, 2021, 2: 1171-1187.

DOI: 10.1109/OJCOMS.2021.3081996. |

| [17] |

XU S, ZHANG X, LI C, et al. Deep reinforcement learning approach for joint trajectory design in multi-UAV IoT networks[J].

IEEE Transactions on Vehicular Technology, 2022, 71(3): 3389-3394.

DOI: 10.1109/TVT.2022.3144277. |

| [18] |

MA J, ZHANG Y, ZHANG J, et al. Solution to traveling agent problem based on improved ant colony algorithm[C]// 2008 ISECS International Colloquium on Computing, Communication, Control, and Management. Guangzhou: IEEE, 2008: 57-60.

|

| [19] |

HUANG Z, LIN H, ZHANG G. The USV path planning based on an improved DQN algorithm[C]// 2021 International Conference on Networking, Communications and Information Technology (NetCIT) . Manchester: IEEE, 2021: 162-166.

|

| [20] |

XU W, CHEN L, YANG H. A comprehensive discussion on deep reinforcement earning[C]// 2021 International Conference on Communications, Information System and Computer Engineering (CISCE) . Beijing: IEEE, 2021: 697-702.

|

| [21] |

TEJA K V S S R, LEE M. Efficient practice for deep reinforcement learning[C]// 2019 IEEE Symposium Series on Computational Intelligence (SSCI) . Xiamen: IEEE, 2019: 77-84.

|

2023, Vol. 40

2023, Vol. 40