基于深度学习的点云处理研究是计算机视觉领域中的一个热点内容。根据深度学习网络中点云输入表征形式的不同,可以将其划分为体素法、投影法和逐点法。其中,逐点法将点云坐标、法向量等特征直接输入到网络中,网络结构简单轻量,是点云处理研究中的热点话题。PointNet[1]是逐点法的开山之作,它先通过多层感知机 (Multi-layer Perceptron, MLP) 提取点云的语义特征,再利用对称聚合操作,如最大池化,获得点云的全局特征,最后通过全连接层 (Fully Connected Layer, FC) 输出最终的预测。但是,直接使用MLP层学习点云特征的方式会遗失点云邻域信息。PointNet++[2]提出了集合抽象模块方法来提取点云邻域信息。集合抽象模块、PointNet[1]中的MLP层和对称聚合操作组成一个特征学习阶段。多个特征学习阶段的串联叠加构成点云数据的深度学习网络。但PointNet++[2]并不能从根本上解决逐点法中的邻域信息提取不足的问题。因此,不少研究者通过设计精妙的局部特征提取模块来提高网络对几何邻域特征的提取能力[3-6]。点卷积是这一方向的经典改进策略,一直以来都是逐点法研究的热门内容。点卷积的核心内容是设计一个核变换矩阵将点云邻域信息映射成一个二维矩阵,并采用二维卷积操作提取更为丰富的几何邻域信息。然而,这些研究在点云网络性能上已经到达了瓶颈[7]。图像处理中ViT[8]为逐点法的研究开拓了新视角,基于自注意力机制的点云处理算法的研究得到了人们的关注。自注意力机制能够提取到长距离依赖信息,能够有效地扩大点云网络的感受野,在点云网络性能上取得了新的高度[9-10],但自注意力机制中计算复杂和难收敛的缺点有待进一步克服。最近的研究成果PointMLP[11]引入了一个新的研究范式,将点云网络的MLP改进为残差MLP结构,并以此为点云网络的基础模块构建全新的点云处理网络。这种改进思路在点云分类数据集取得了优异的成绩。

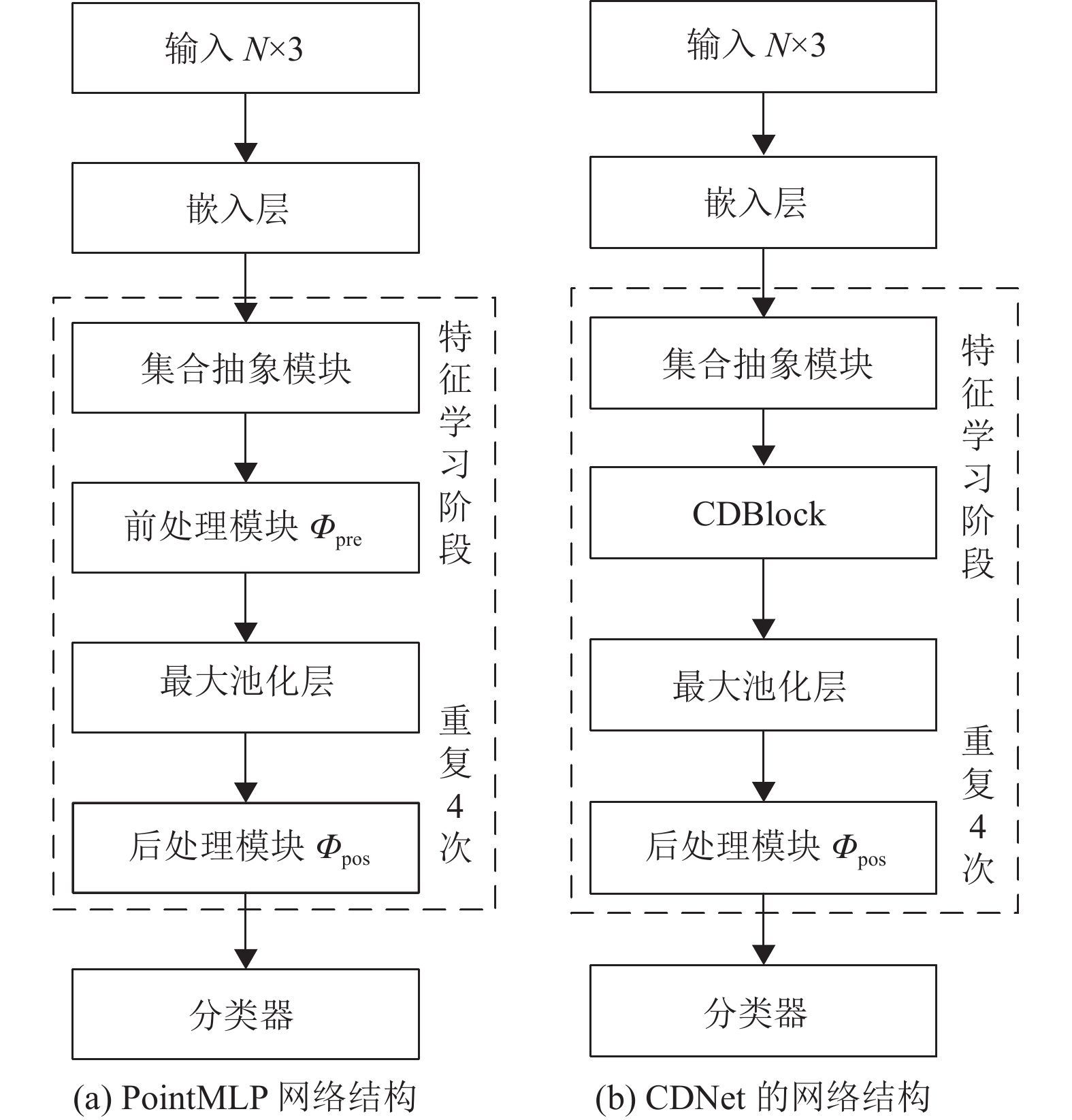

本文方法则在PointMLP[11]的基础上引入了通道分离的思想,设计了基于通道分离机制的双分支网络模块,即CDBlock (Channel-splited based Dual-branch Block) 。本文提出的CDBlock将会替换PointMLP[11]骨架网络 (见图1(a)) 的前处理模块,形成新的点云处理网络,称之为CDNet,它的网络结构如图1(b)所示。首先,CDBlock将点云局部特征在通道维度上切分成两组特征,然后将这两组特征分别输入到双分支网络模块中。双分支网络模块包括轻量网络分支和深层网络分支。其中,轻量网络分支由残差结构组成,它负责提取浅层特征信息;深层网络分支由瓶颈网络结构组成,它负责提取深层语义信息。实验证明,CDBlock的引入有效地提高了网络对点云数据的特征提取能力、学习能力和模型的鲁棒性。

|

图 1 网络结构 Figure 1 Network architecture |

本文的基线网络PointMLP[11]的网络结构如图1(a)所示,输入数据维度为

本文方法在PointMLP[11]的基础上引入了通道分离的思想,将PointMLP[11]中的前处理模块

| $ g={\varPhi}_{\rm{pos}}\left(A\right(\mathrm{C}\mathrm{D}\mathrm{B}\mathrm{l}\mathrm{o}\mathrm{c}\mathrm{k}\left(f\right) \left) \right) $ | (1) |

式中:

CDBlock主要借鉴了图像处理中多分支网络的设计思想。例如,ResNeSt[12]结合多路径[13]和特征图注意力的网络设计思想,将输入特征沿着特征通道维度进行切分,并为每个分离特征设计独立的特征提取模块。

与ResNeSt[12]方法类似,本文提出的CDBlock在特征通道进行切分,具体结构如图2所示。通过控制通道分离因子

|

图 2 CDBlock的结构实现 Figure 2 Structure implementation of the CDBlock |

轻量网络分支

| $ {{f}{\text{′}}}^{\gamma }={\varPhi}_{\text{L}}\left({f}^{\gamma }\right) $ | (2) |

由于轻量网络分支

深层网络分支

| $ {{f}{\text{′}}}^{\mu }={\varPhi}_{\text{H}}\left({f}^{\mu }\right) $ | (3) |

由于深层网络分支

为融合两个网络分支输出的点云特征,对特征

| $ {f}_{\mathrm{o}\mathrm{u}\mathrm{t}}=\mathrm{c}\mathrm{a}\mathrm{t}\left({{f}{\text{′}}}^{\gamma },{{f}{\text{′}}}^{\mu }\right) $ | (4) |

式中:

|

图 3 残差MLP结构和瓶颈结构 Figure 3 Structures of residual MLP and bottleneck |

本部分首先介绍实验使用的数据集、评价指标和实验设置细节;然后,将本文方法与其他点云处理网络进行比较;最后,通过消融实验证明本文提出的CDBlock的有效性,并分析了通道分离因子

本文在点云分类数据集ScanObjectNN[15]和点云分割数据集ShapeNetPart[16]上验证CDBlock的有效性。具体地,ScanObjectNN数据集包含15个类别,总计约有15 000个物体。ShapeNetPart[16]数据集则包含16个语义类别,总计有57 386个语义实例。在实验过程中,为保证实验结果公平,分类数据集和分割数据集的训练集和验证集的划分方式与PointMLP[11]保持一致。

3.2 评估指标本文在分类数据集上采用的性能指标包括总精度OA (Overall Accuracy) 和类平均精度mAcc (mean Accuracy) 。它们是评估点云分类网络算法性能的常用指标,分别统计了模型预测的总体准确率和召回率的平均值,总精度OA用于评估模型的整体性能,而类平均精度mAcc用于评估模型在数据不均衡情况下的性能表现。而在分割数据集上采用平均交并比的指标mIoU (mean Intersection over Union) ,包括类平均交并比Cls.mIoU (Class mIoU) 和实例平均交并比Inst.mIoU (Instance mIoU) ,它们分别表示所有类别交并比和的平均值以及各实例交并比和的平均值。

3.3 实验过程本文的实验在Ubuntu18.04 LTS操作系统中部署。编程语言是Python3.7,深度学习框架为Pytorch1.7.1。使用GPU加速工具CUDA 11.1。硬件配置主要包括:CPU×1,型号为Intel(R) Core(TM) i7-9800X CPU @3.80 GHz;GPU×1,型号为3090 32 GB。在训练设置方面,分类数据集采用了Adam优化器,初始学习率为0.01,L2正则化因子采用0.000 01,学习率优化策略则采用了余弦衰减策略。网络一共训练300个轮次。在分割数据集上学习率则采用0.003,总共序列500个轮次,其余训练设置则与训练分类数据集采用的保持一致。同时,根据消融实验结果,通道分离因子

(1) 分类实验结果。本文提出的算法在点云数据集ScanObjectNN[15]上实验论证,并与其他有代表性且性能表现领先的点云分类算法进行了比较。输入到点云分类网络中的点云数量

| 表 1 在数据集ScanObjectNN上的实验结果 Table 1 Experimental results on the ScanObjectNN dataset |

(2) 分割实验结果。本文提出的CDNet在分割数据集ShapeNetPart[16]上也展现出良好的竞争力。为保证实验结果的公平性,输入到点云分割网络中的点云数量

为了验证通道分离机制的有效性,本文对1.2所述的基于通道分离机制的双分支网络模块进行了消融实验。具体的实验结果如表3所示,当不采用基于通道分离的多分支结构时,分类指标总体精度OA只能取得83.6%,而类平均精度mAcc则更低,为81%。它们均低于采用通道分离机制的双分支网络。原因在于基于通道分离机制的双分支网络模块能够提取到多层次的点云特征,网络学习到的点云语义信息具备更加丰富的表征。

| 表 2 在ShapeNetPart上的实验结果 Table 2 Experimental results on the ShapeNetPart dataset |

| 表 3 通道分离机制的消融实验 Table 3 Ablation studies of the Channel-splited method |

以上的实验证明了通道分离机制的有效性。同时,本文进一步探索通道分离因子

|

表 4 通道分离因子

|

本文在逐点法PointMLP[11]的基础上引入了通道分离思想,提出了基于通道分离机制的双分支网络处理模块(CDBlock) 。CDBlock将输入特征在通道层级上切分成两组特征,并将它们输入到双分支网络模块中的不同网络分支上。具体地,双分支网络模块包括:轻量网络分支,它由残差MLP结构组成,负责提取浅层特征信息;深层网络分支,它由瓶颈网络结构组成,负责提取深层语义信息。这种模块结构设计能够提取到多层次的点云语义信息,提升了网络对点云数据特征的提取能力和学习能力,有效地提高了模型的鲁棒性。在点云分类数据集ScanObjectNN[15]上进行验证,总体精度OA和类别平均精度mAcc分别为86.2%和84.97%,优于PointMLP[11]。同时,在点云分割数据集ShapeNetPart[16]上也表现良好。相比于PointMLP,本文方法在更少参数量和计算量的情况下取得了更优异的结果。此外,通过消融实验证明了CDBlock的有效性;通道分离因子的消融实验结果表明,当

| [1] |

QI C R, SU H, MO K, et al. Pointnet: deep learning on point sets for 3D classification and segmentation[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Honolulu, HI: IEEE, 2017: 652-660.

|

| [2] |

QI C R, YI L, SU H, et al.. Pointnet++: deep hierarchical feature learning on point sets in a metric space[J].

Advances in Neural Information Processing Systems, 2017, 30: 5099-5108.

|

| [3] |

THOMAS H, QI C R, DESCHAUD J E, et al. Kpconv: flexible and deformable convolution for point clouds[C]//Proceedings of the IEEE/CVF International Conference on Computer Vision. Long Beach: IEEE, 2019: 6411-6420.

|

| [4] |

WU W, QI Z, FUXIN L. Pointconv: deep convolutional networks on 3D point clouds[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. Seoul: IEEE, 2019: 9621-9630.

|

| [5] |

XU M, DING R, ZHAO H, et al. Paconv: position adaptive convolution with dynamic kernel assembling on point clouds[C]//Proceedings of the IEEE/ CVF Conference on Computer Vision and Pattern Recognition. New York: IEEE, 2021: 3173-3182.

|

| [6] |

RAN H, LIU J, WANG C. Surface representation for point clouds[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. New Orleans: IEEE, 2022: 18942-18952.

|

| [7] |

LIU Z, HU H, CAO Y, et al. A closer look at local aggregation operators in point cloud analysis[C]// European Conference on Computer Vision. Glasgow: ECCV, 2020: 326-342.

|

| [8] |

DOSOVITSKIY A, BEYER L, KOLESNIKOV A, et al. An image is worth 16×16 words: transformers for image recognition at scale[C]//International Conference on Learning Representations. Cambridge: ICLR, 2021: 1-6.

|

| [9] |

ZHAO H, JIANG L, JIA J, et al. Point transformer[C]//Proceedings of the IEEE/CVF International Conference on Computer Vision. Montreal: IEEE, 2021: 16259-16268.

|

| [10] |

GUO M H, CAI J X, LIU Z N, et al. Pct: point cloud transformer[J].

Computational Visual Media, 2021, 7(2): 187-199.

DOI: 10.1007/s41095-021-0229-5. |

| [11] |

XU MA, CAN Q, HAOXUAN Y, et al. Rethinking network design and local geometry in point cloud: a simple residual MLP framework[C]//International Conference on Learning Representations. Kigali: ICLR, 2022: 1-9.

|

| [12] |

ZHANG H, WU C, ZHANG Z, et al. Resnest: split-attention networks[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. New Orleans: IEEE, 2022: 2736-2746.

|

| [13] |

SZEGEDY C, LIU W, JIA Y, et al. Going deeper with convolutions[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Boston: IEEE, 2015: 1-9.

|

| [14] |

HE K, ZHANG X, REN S, et al. Deep residual learning for image recognition[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas: IEEE, 2016: 770-778.

|

| [15] |

UY M A, PHAM Q H, HUA B S, et al. Revisiting point cloud classification: a new benchmark dataset and classification model on real-world data[C]//Proceedings of the IEEE/CVF International Conference on Computer Vision. Seoul: IEEE, 2019: 1588-1597.

|

| [16] |

YI L, KIM V G, CEYLAN D, et al. A scalable active framework for region annotation in 3D shape collections[J].

ACM Transactions on Graphics(ToG), 2016, 35(6): 1.

|

| [17] |

LI Y, BU R, SUN M, et al. Pointcnn: convolution on x-transformed points

[J].

Advances in Neural Information Processing Systems, 2018, 31: 1-11.

|

2023, Vol. 40

2023, Vol. 40