2. 鹏城实验室 网络空间安全研究中心, 广东 深圳 518066

2. Cyberspace Security Research Center, Peng Cheng Laboratory, Shenzhen 518066, China

营销效果的量化评估是营销过程中的重要环节之一。准确的量化评估能为后续营销方案优化、营销费用分配等方面提供重要参考依据,有助于提升企业的运营效率。其以市场营销为背景,以人工智能等为技术吸引了多个学科的学者进行研究,是具有重要研究价值的多学科交叉问题[1-2]。营销效果评估由于其应用驱动性质,具有复杂多样性,需根据问题特性设计,本文主要从人工智能算法设计的角度进行研究。

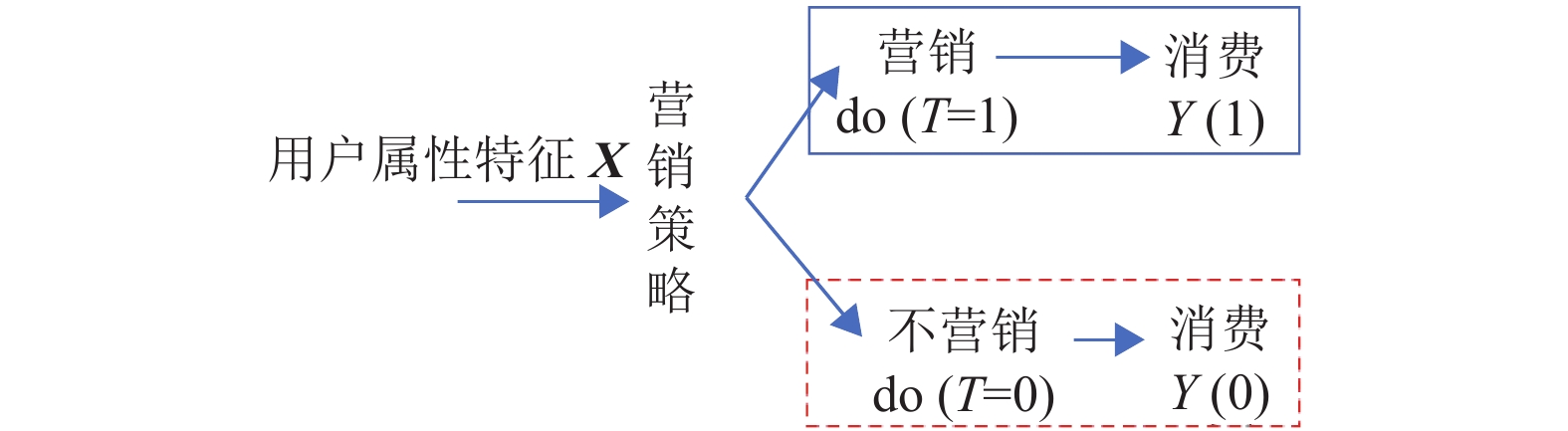

图1是一个典型的营销效果评估过程图。在一个营销系统里,系统先依据用户的属性特征X确定营销对象(如广告曝光、产品推送对象),再对营销后的消费提升进行定量评估。现实场景中,若营销系统对用户进行了营销(图1中蓝色分支),则用户在未营销时的情况是未知的(图1中红色分支),即无法同时观测到用户的两种状态值,这也是营销效果评估的难点。针对这一难点,解决的思路是从未营销的对照组用户中选择与营销组用户属性特征相似的对照样本,用于推断营销组用户在假设未被营销时的“反事实”[3]状态值。因此,营销效果的量化评估问题本质上是基于“反事实”进行因果效应估计[4]。

|

图 1 营销效果评估示意图 Figure 1 Diagram of marketing effect evaluation |

上述因果效应估计问题的解决方法主要包括3类:基于随机干预实验的方法、基于辅助变量的方法和基于因果效应的方法[5]。其中,基于随机干预实验的方法是解决这类问题的基准方法,其使用随机分组的方式,随机地将研究对象分配至营销组或对照组,可以剔除其他因素的影响,如好友、价格等影响[6]。典型的随机干预方法有A/B测试[7-8],其易于理解,但有时随机实验代价巨大,甚至造成负面的用户体验[7,9]。不同于随机干预实验,后两类方法则从观察数据出发对因果效应进行估计。其中,基于辅助变量的方法一般需结合场景先验知识对潜在的混杂因子进行建模[10],如基于深度学习和工具变量实现建模的DeepIV[11],基于变分贝叶斯和隐变量的CEVAE[12]。在缺乏足够的先验知识场景下,基于因果效应的方法则更为适用,典型思想包括倾向得分逆概率加权(Inverse Probability Weighted Estimator,IPWE)[4,13]、混杂因子平衡(Confounder Balancing)的方法[14-15]及基于深度学习和其他方面的扩展[16-18]。基于因果效应的方法,本质上都需要根据用户的属性特征判断用户进入营销组或对照组的倾向性。

然而,现有的因果效应评估方法主要是基于群体的平均因果效应评估[16-17,19],对于实际应用中需要细化评估用户个体的因果效应需求难以进行有效支撑。将现有基于群体的平均因果效应评估方法推广到细粒度用户个体的因果效应评估时,面临着用户属性特征建模难的问题。核心的原因是现有方法多是针对低维样本特征、小观察样本的场景设计[19](即观察的对照样本量较小),难以适用于实际营销场景中复杂的用户属性特征、海量的对照组样本。具体包括以下3方面:(1) 实际营销场景中,用户一般包括许多的时序特征,如用户在过去某段时间内的消费序列等,其可能比静态属性特征更能刻画用户。现有的因果效应评估方法虽然已留意到特征表示学习[20-21],但用户时序特征的描述问题还有待解决。(2) 实际营销场景中,用户属性特征往往高维且呈现非线性关系。传统的基于线性回归的方法较难有效地学习样本权重,容易存在过拟合问题[16-17],虽然部分研究考虑了非线性用户特征的加权问题,但多是针对分组等特定场景而设计。(3) 实际营销场景中,存在大量的对照组样本,若直接使用样本权重估计的方法,因需要学习的样本权重维度高,容易导致结果不稳定、算法不收敛[14]等问题。

针对实际营销中,用户存在时序非时序属性特征混合、海量对照组样本的现状,本文结合深度学习的建模方法和因果推断的思想,提出了以用户为单位的细粒度混杂平衡的营销效果评估方法。主要贡献包括:(1) 引入深度学习中的长短记忆神经网络对用户的时序特征进行建模,并使用稀疏多层神经网络从用户的时序和非时序属性特征中学习样本统一表示;(2) 引入K近邻方法确定营销组用户的对照组样本,即为每个营销组样本挑选最为相近的对照组用户,避免了样本引入的干扰,从而实现了以用户为单位的细粒度营销效果评估。

1 问题定义本文以合作公司的线上会员营销为研究背景,研究目标是定量评估营销的效果,包括用户成为会员后一定时期内在平台内的消费提升程度。典型的营销场景包括在线游戏特权卡营销、电商的会员卡营销等。

在本文中,符号定义如下:

在上述定义下,营销效果评估实际为估计干预样本的平均因果效应

| $ \mathrm{A}\mathrm{T}\mathrm{T}=\frac{1}{|{{T}}_{i}=1|}\sum\limits _{{T}_{i}=1}\left({Y}_{i}\left(1\right)-{Y}_{i}\left(0\right)\right) $ | (1) |

即通过对比营销组用户在营销情况下的消费

解决该问题的核心困难是,在实际场景中,只能获取到营销组(

| $ \mathrm{C}\mathrm{A}\mathrm{T}\mathrm{T}=\frac{1}{|{{T}}_{{i}}=1|}\sum\limits _{{T}_{i}=1}\left({Y}_{i}\left(1\right)-{Y}_{i}\left(0\right)|{\boldsymbol{X}}_{i}\right) $ | (2) |

综上,营销效果的量化评估问题可形式化定义为:给定一批观察样本

本节提出了基于用户细粒度混杂平衡的营销效果评估方法,主要包括2个方面:细粒度混杂平衡目标设计、混杂权重函数学习。

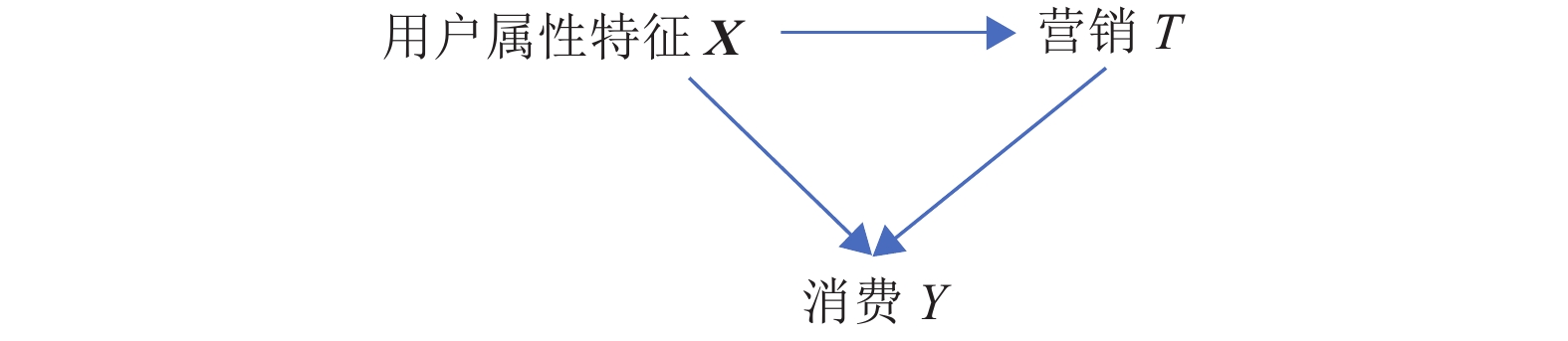

2.1 细粒度混杂平衡目标设计对营销数据进行因果机制建模是解决式(2)中条件干预样本平均因果效应评估的核心。从图1所示的营销过程图可知,用户属性特征

|

图 2 营销过程的因果关系模型 Figure 2 The causal relationship model of the marketing process |

在实际中,一般很难直接采用图2的因果图建模,因为用户属性特征

| $ \mathrm{C}\mathrm{A}\mathrm{T}\mathrm{T}=\frac{1}{|{{T}}_{{i}}=1|}\sum\limits _{{T}_{i}=1,{{T}_{j}=0,\boldsymbol{X}}_{j}={\boldsymbol{X}}_{i}}\left({Y}_{i}\left(1\right)-{Y}_{j}\left(0\right)|{\boldsymbol{X}}_{i}\right) $ | (3) |

然而,实际场景中一般很难找到与

| $ \mathrm{C}\mathrm{A}\mathrm{T}\mathrm{T}=\frac{1}{|{{T}}_{{i}}=1|}\sum\limits _{{T}_{i}=1}\left({Y}_{i}\left(1\right)-\sum\nolimits _{{T}_{j}=0}W\left({\boldsymbol{X}}_{j}\right){Y}_{j}\left(0\right)|{\boldsymbol{X}}_{i}\right) $ |

| $ {\rm{s.t.}} \left\{\begin{array}{c}d\left({\boldsymbol{X}}_{i},{\boldsymbol{X}}^{\prime}\right)=0\\ {\boldsymbol{X}}^{\prime}= \displaystyle \sum\limits _{{T}_{j}=0}W\left({\boldsymbol{X}}_{j}\right){\boldsymbol{X}}_{j}\end{array}\right. \;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;$ | (4) |

式中:

| $ \mathrm{arg} \, {{{\rm{min}}}} _W\sum\limits _{{T}_{i}=1}d\left({\boldsymbol{X}}_{i},\sum\limits _{{T}_{j}=0,{\boldsymbol{X}}_{j}\in {\rm{KNN}}\left({\boldsymbol{X}}_{i}\right)}W\left({\boldsymbol{X}}_{j}\right){\boldsymbol{X}}_{j}\right) $ | (5) |

式中:

相比于传统方法,该目标函数结合了倾向值倒数加权和混杂变量平衡的思想。而且通过引入K近邻对照样本,实现了细粒度匹配,避免了干扰样本的引入,一定程度保证了大样本数据学习的稳定性。

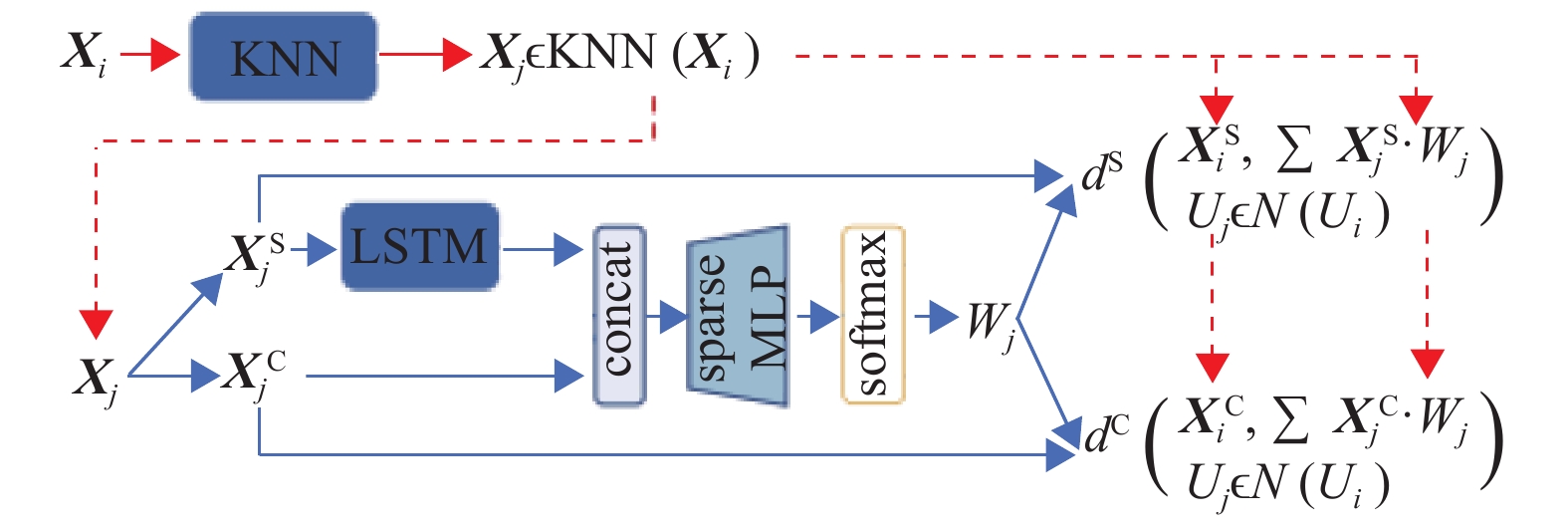

2.2 混杂权重函数学习求解式(5)中

在设计距离度量函数方面,针对时序特征和非时序属性特征混合的场景,先单独按属性类型计算K近邻,最后再取交集确定

在构建权重函数表示方面,确定

具体流程如图3所示,主要包含以下3个步骤:

|

图 3 基于稀疏深度混合网络的权重函数学习 Figure 3 Weight function learning based on sparse deep hybrid network |

(1) 为每个营销组用户

(2) 针对

(3) 上一步骤计算得到的权重,最后通过时序特征及属性特征上的分布对齐作为标准进行评估。上述步骤中时序特征

令

| $ \begin{split} & \mathrm{arg} \, \underset{{\phi }_{m},{\phi }_{l}}{{{\rm{min}}}} \, {d}^{{\rm{S}}}\left({\boldsymbol{X}}_{i},\sum\limits _{{\boldsymbol{X}}_{j}\in {\rm{KNN}}({\boldsymbol{X}}_{i})}{\boldsymbol{X}}_{j}^{{\rm{S}}} \cdot {\phi }_{m}({\phi }_{l}({\boldsymbol{X}}_{j}^{{\rm{S}}});{\boldsymbol{X}}_{j}^{{\rm{C}}})\right)+ \\ &{d}^{{\rm{C}}}\left({\boldsymbol{X}}_{i},\sum\limits _{{\boldsymbol{X}}_{j}\in {\rm{KNN}}\left({\boldsymbol{X}}_{i}\right)}{\boldsymbol{X}}_{j}^{{\rm{C}}} \cdot {\phi }_{m}({\phi }_{l}({\boldsymbol{X}}_{j}^{{\rm{S}}});{\boldsymbol{X}}_{j}^{{\rm{C}}})\right) \end{split}$ | (6) |

式中:

训练过程中,LSTM和稀疏多层神经网络通过式(6)中目标函数的误差反向传播方式进行学习。同时,考虑到式(6)中两个目标函数有不同取值范围,先对两个目标函数单独训练,再以单独训练后的相对损失作为归一化因子归一,最后采取联合微调的方法学习权重网络

根据前面算法流程的描述,本文提出的FGCB(Fine Grained Confounder Balancing)算法伪代码可总结为算法1所示。

算法1 FGCB算法

输入:观察样本

输出:因果效应CATT

(1) 对每个营销组(

(2) 基于

(3) 基于训练后的权重网络

需注意的是,本算法通过拟合用户权重网络来实现营销组和对照组在属性特征空间(

实验场景:以合作的某公司线上会员营销和用户实际的消费数据为例,使用文中算法定量评估会员营销对消费的提升程度,最后与实际的A/B测试数据对比,证明评估算法的有效性。考虑到商业秘密,此处不列出公司具体的名称,并对消费数据进行了脱敏处理。在对数据进行了基本的统计分析后,从总体用户中随机抽样1 000个营销组用户,10000个对照组用户。其中,营销组用户定义为在此次营销活动期内被营销过的用户,对照组用户定义为至统计期在此次营销活动中从未被营销过的用户。并选取了以下用户特征用于评估:(1) 用户的时序特征选取了每个用户被营销前60天(以天为单位)的序列数据,包括:日消费额序列、日在网时长序列、日获取积分序列、特别关注的关键行为日参与次数序列;(2) 用户的属性特征包括:性别、地域、年龄、收入水平、教育程度、累计消费金额、累计在网时长、累计营销次数、VIP等级、在网时长偏好等。此外,为了方便后续的处理,对用户属性特征

性能指标:为评估FGCB算法的性能,基于估计的CATT,本文使用偏差(Bias)和均方根误差(RMSE)进行性能评估,定义如下

| $ \mathrm{B}\mathrm{i}\mathrm{a}\mathrm{s}=\left|\frac{1}{K}{\sum }_{k=0}^{K}\left({\rm{CAT}}{{\rm{T}}}_{k}-{\rm{CATT}}\right)\right| $ | (7) |

| $ \mathrm{R}\mathrm{M}\mathrm{S}\mathrm{E}=\sqrt{\frac{1}{K}{\sum }_{k=0}^{K}{\left({\rm{CAT}}{{\rm{T}}}_{k}-{\rm{CATT}}\right)}^{2}} $ | (8) |

式中:

基准算法:选取了比较经典和比较新的一些研究工作作为对比。其中,由于基准方法均未对时序数据做特殊设计,输入时将时序数据展开为特征向量的形式。基准算法的实验结果均基于原论文的开源实现,AIPW基于R包的官方实现(具体请见:

AIPW[4]:经典的基于倾向性得分的因果效应评估方法,倾向性得分使用标准逻辑回归进行估计。

GANITE[17]:一种基于对抗产生式网络进行反事实分布推断的因果效应评估方法。

DCB[18]:一种对混杂变量区别对待的平衡因子的因果效应评估方法。因未找到官方源码,该方法的实验结果为本文作者对该方法的重现。

SITE[21]:一种基于深度表示学习的因果效应评估方法。

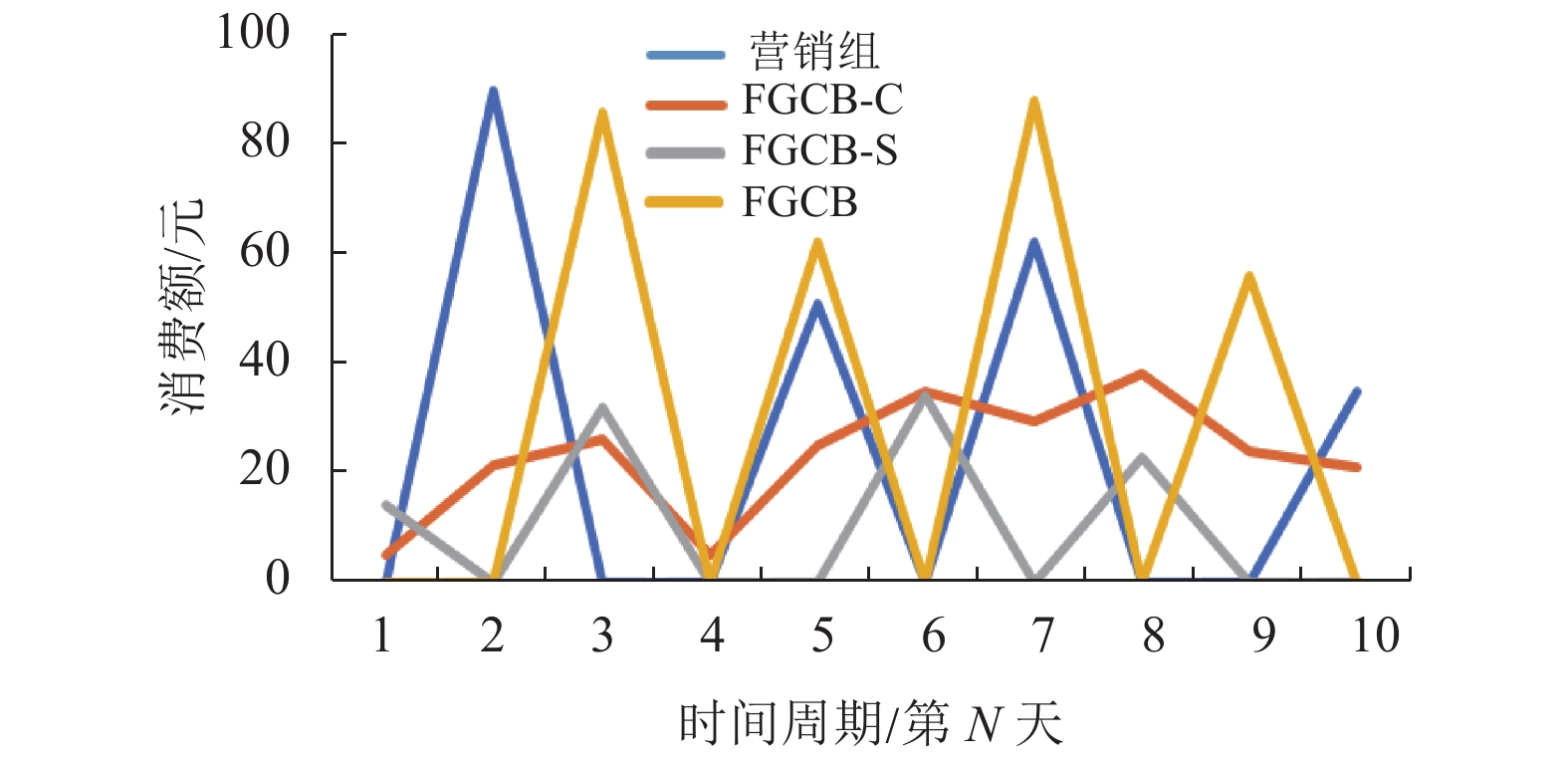

FGCB(FGCB-C, FGCB-S, FGCB-G):本文中提出的FGCB方法及其变体。其中,FGCB为标准模型,FGCB-C只包括用户静态属性特征,FGCB-S只包括用户时序特征,FGCB-G使用全对照组,而不使用K近邻。FGCB方法的主要参数是近邻数K,实验中默认值为5。其余参数设置如下:隐藏层数量设置为输入层维度的2倍,稀疏多层神经网设置为3层全连接网络结合Dropout方式实现。其他参数采用3-折交叉验证的方式进行调整。实现均基于Pytorch1.71版本。

3.2 结果及分析与基准算法的对比分析:结果如表1所示,本文提出的FGCB在RMSE和Bias两项指标的结果都最好,其中RMSE明显优于其他基准方法。与FGCB结果最为接近的是SITE算法,可能的原因是FGCB和SITE都基于细粒度特征表示进行因果效应评估。上述实验结果有效验证了本文提出的局部样本匹配思想和基于细粒度特征建模的有效性。

| 表 1 与基准算法的对比分析实验结果 Table 1 Experimental results of comparative analysis with benchmark algorithms |

剔除实验分析:表2为FGCB及其变种算法的实验结果。通过分别剔除序列信息(即只用属性信息的FGCB-C)和剔除属性信息(即只用序列信息的FGCB-S)模型,可以发现剔除信息后的2种模型结果都有所变差,说明用户的时序信息和静态属性信息都对因果效应的评估具有明显作用。表2的数据结果也验证了使用时序数据建模是FGCB算法结果较优的关键。此外,对比FGCB-G和FGCB的结果可以发现,K近邻局部匹配的思想虽然对Bias的降低不明显,但有助于降低RMSE这一项指标。

| 表 2 模型组件剔除实验结果 Table 2 Experimental results of model component removal |

近邻参数敏感性分析:FGCB算法中,K近邻的参数K是重要参数之一。为了测试算法对于参数K的敏感性,将K取值

|

图 4 近邻敏感性分析实验结果 Figure 4 Experimental results of neighbor sensitivity analysis |

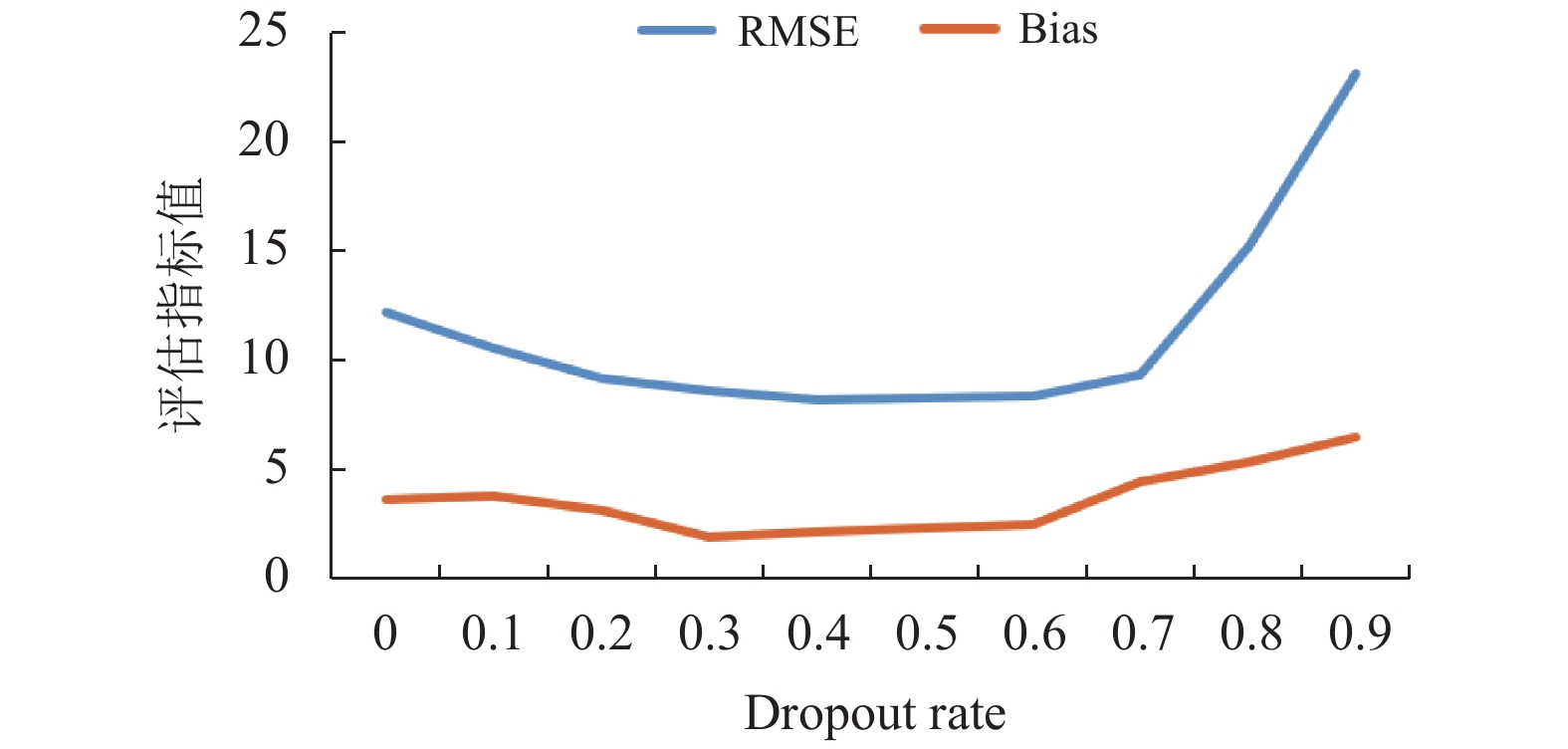

稀疏参数敏感性分析:FGCB算法中,稀疏多层神经网络采取3层全连接网络结合Dropout方式实现,其中剔除率(dropout rate)是稀疏性的重要参数之一。dropout rate对算法性能的影响结果如图5所示。其中,横坐标刻度点为dropout rate值。dropout rate为0.5的时候,模型效果好于全连接网络(dropout rate为0),说明稀疏策略有效。此外,发现模型性能在最优参数附近对于dropout值不敏感,说明模型在实际应用中的性能得到保证。

|

图 5 稀疏参数敏感性分析实验结果 Figure 5 Experimental results of sparsity sensitivity analysis |

典型案例分析:为了更直观地认识FGCB算法的有效性,选取了几个典型的用户,对FGCB算法及几种变体的结果进行分析。图6为某个营销组用户及其权重最大的近邻用户的消费序列。需说明的是,由于FGCB-G方法在多次实验中结果不稳定,难选择到合适的代表案例,本图未给出FGCB-G的结果。如图6所示,FGCB方法获得的最大权重样本,与营销组样本的周期性和全局性最相似,FGCB-S只使用时序数据,其在筛选对照组样本时,保持了较好的样本周期性特征,而仅使用用户静态属性的FGCB-C则未能很好地刻画周期属性。但是,通过FGCB-S和FGCB的对比分析,发现若忽略了用户静态属性,可能会引入整体的偏差。

|

图 6 典型营销组样本及其对照组样本的消费情况可视化分析 Figure 6 Visual analysis of consumption of the typical marketing group sample and its control group sample |

本文使用因果效应评估方法对营销效果的量化评估问题进行了建模,针对用户时序非时序特征混合等问题特性提出了细粒度混杂平衡模型,结合了倾向性得分和混杂平衡方法的思想,设计了K近邻选择、时序特征和静态属性分别建模等细粒度策略,实现了稳定的营销效果评估。未来研究包括时序特征对齐和静态特征对齐的优化融合方法、将对抗学习思想引入到样本相似性度量中以进一步提升算法的可靠性等。

| [1] |

HAIR J J F, SARSTEDT M. Data, measurement, and causal inferences in machine learning: opportunities and challenges for marketing[J].

Journal of Marketing Theory and Practice, 2021, 29(1): 1-13.

DOI: 10.1080/10696679.2020.1860689. |

| [2] |

VARIAN H R. Causal inference in economics and marketing[J].

Proceedings of the National Academy of Sciences, 2016, 113(27): 7310-7315.

DOI: 10.1073/pnas.1510479113. |

| [3] |

PEARL J, MACKENZIE D. The book of why: the new science of cause and effect[M]. New York: Basic Books, 2018.

|

| [4] |

RUBIN D B, WATERMAN R P. Estimating the causal effects of marketing interventions using propensity score methodology[J].

Statistical Science, 2006, 21(2): 206-222.

|

| [5] |

苗旺, 刘春辰, 耿直. 因果推断的统计方法[J].

中国科学:数学, 2018, 48(12): 1753-1778.

MIAO W, LIU C C, GENG Z. Statistical approaches for causal inference[J]. Sci Sin Math, 2018, 48(12): 1753-1778. DOI: 10.1360/N012018-00055. |

| [6] |

郝志峰, 黎伊婷, 蔡瑞初, 等. 基于因果模型的社交网络用户购物行为研究[J].

广东工业大学学报, 2020, 37(3): 1-8.

HAO Z F, LI Y T, CAI R C, et al. A research on users’ shopping behaviors in social network based on causal model[J]. Journal of Guangdong University of Technology, 2020, 37(3): 1-8. DOI: 10.12052/gdutxb.190147. |

| [7] |

KOHAVI R, LONGBOTHAM R. Online controlled experiments and A/B testing[J].

Encyclopedia of Machine Learning and Data Mining, 2017, 7(8): 922-929.

|

| [8] |

SAJONS G B. Estimating the causal effect of measured endogenous variables: a tutorial on experimentally randomized instrumental variables[J].

The Leadership Quarterly, 2020, 31(5): 101348.

DOI: 10.1016/j.leaqua.2019.101348. |

| [9] |

VARNALI K. Online behavioral advertising: an integrative review[J].

Journal of Marketing Communications, 2021, 27(1): 93-114.

DOI: 10.1080/13527266.2019.1630664. |

| [10] |

JOHANSSON F, SHALIT U, SONTAG D. Learning representations for counterfactual inference[C]// International Conference on Machine Learning. Cambridge MA: PMLR, 2016: 3020-3029.

|

| [11] |

HARTFORD J, LEWIS G, LEYTON-BROWN K, et al. Deep IV: a flexible approach for counterfactual prediction[C]//International Conference on Machine Learning. Cambridge MA: PMLR, 2017: 1414-1423.

|

| [12] |

LOUIZOS C, SHALIT U, MOOIJ J, et al. Causal effect inference with deep latent-variable models[C]// Proceedings of the 31st International Conference on Neural Information Processing Systems. New York: NeurIPS, 2017: 6449-6459.

|

| [13] |

TAN Z. Regularized calibrated estimation of propensity scores with model misspecification and high-dimensional data[J].

Biometrika, 2020, 107(1): 137-158.

DOI: 10.1093/biomet/asz059. |

| [14] |

ZHAO Q. Covariate balancing propensity score by tailored loss functions[J].

Annals of Statistics, 2019, 47(2): 965-993.

|

| [15] |

IMAI K, RATKOVIC M. Covariate balancing propensity score[J].

Journal of the Royal Statistical Society, 2014, 76(1): 243-263.

DOI: 10.1111/rssb.12027. |

| [16] |

KALLUS N. Deepmatch: balancing deep covariate representations for causal inference using adversarial training[C]//International Conference on Machine Learning. Cambridge MA: PMLR, 2020: 5067-5077.

|

| [17] |

YOON J, JORDON J, VAN DER SCHAAR M. GANITE: Estimation of individualized treatment effects using generative adversarial nets[C]//International Conference on Learning Representations. Vancouver: ICLR, 2018.

|

| [18] |

KUANG K, CUI P, LI B, et al. Treatment effect estimation via differentiated confounder balancing and regression[J].

ACM Transactions on Knowledge Discovery from Data (TKDD), 2019, 14(1): 1-25.

|

| [19] |

FAN Q, HSU Y C, LIELI R P, et al. Estimation of conditional average treatment effects with high-dimensional data (2019-05-06) [2020-08-15]. http://ideas.repec.org/p/arx/papers/1908.02399.html

|

| [20] |

LI S, FU Y. Matching on balanced nonlinear representations for treatment effects estimation[J].

Advances in Neural Information Processing Systems, 2017, 30: 929-939.

|

| [21] |

YAO L, LI S, LI Y, et al. Representation learning for treatment effect estimation from observational data[J].

Advances in Neural Information Processing Systems, Montreal:NeurIPS, 2018(14): 31-40.

|

| [22] |

HAN Y, LAM J C K, LI V O K. A Bayesian LSTM model to evaluate the effects of air pollution control regulations in China[C]//2018 IEEE International Conference on Big Data (Big Data). Piscataway: IEEE, 2018: 4465-4468.

|

| [23] |

SILVA D F, GIUSTI R, KEOGH E, et al. Speeding up similarity search under dynamic time warping by pruning unpromising alignments[J].

Data Mining and Knowledge Discovery, 2018, 32(4): 988-1016.

DOI: 10.1007/s10618-018-0557-y. |

2022, Vol. 39

2022, Vol. 39