Hilbert变换是信号分析与处理中的重要理论工具。由于复值Cauchy核在原点的奇异性,所以关于实部的Hilbert变换的计算是一项艰巨的任务[1-2]。计算Hilbert变换最常用的方法是快速傅里叶变换(Fast Fourier Transform, FFT)。最近,在文献[1-2]中给出了一些计算Hilbert变换的新方法。对于

近年来,稀疏贝叶斯学习方法成为机器学习中的一个研究热点,它是贝叶斯优化中十分重要的一类,是在贝叶斯理论的基础上发展而来,改进后的贝叶斯理论在文献[4]中也有提到。建立在稀疏贝叶斯学习基础上的学习机器称为相关向量机(Relevance Vector Machine, RVM),由Tipping[5]在2000年提出。它能够利用数据自身的特性对信号和图像实现最优的稀疏表示,已应用到智能检索、数据挖掘等领域。大多数基于稀疏贝叶斯的算法处理的是实值数据,然而在实际应用中还有许多复值信号需要处理。在文献[6]中利用同一信号实部与虚部具有相同的稀疏形式提出了复值贝叶斯压缩感知算法。本文将提出基于Szegö核的复值稀疏贝叶斯学习算法(Complex Relevance Vector Machine, CRVM),构造基于Szegö核的稀疏贝叶斯学习的Hilbert变换计算方法。基于Szegö核的稀疏贝叶斯学习算法,可以得到稀疏的有理逼近。事实上,由于TM系可通过对Szegö核做Gram-Schmidt正交化过程得到,因而基于Szegö核的稀疏贝叶斯学习算法也可以看成自适应傅里叶分解的一种,相比于AFD, 它的优势在于不需要穷尽单位开圆盘所有点去选择参数,并且最终所得到的模型是稀疏的。

对于给定能量有限信号

| $ \mathop {\lim }\limits_{y \to {0^ + }} Cs(x + {\rm{i}}y) = \frac{1}{{2{\rm{{\text{π}} i}}}}\int_{ - \infty }^\infty {\frac{{s(t)}}{{t - (x + {\rm{i}}y)}}{\rm{d}}t} =\frac{1}{2}s(t) + \frac{1}{2}{\rm{i}}Hs(t) $ |

其中,

如果

| $ \begin{split} & s = 2{\rm{Re}} {s^ + } \\& Hs = 2{\rm{Im}} {s^ + } \end{split}$ |

解析信号形成

对于周期信号,也有类似的理论。对于一个有限能量的周期信号

| ${s^ + }({{\rm{e}}^{{\rm{i}}t}}) = \sum\limits_{k = - \infty }^\infty {{c_k}} {{\rm{e}}^{{\rm{i}}kt}},\sum\limits_{k = - \infty }^\infty {{{\left| {{c_k}} \right|}^2}} < \infty $ |

相应的解析信号可以表示为

| ${s^ + }(z) = \displaystyle \sum\limits_{k = 0}^\infty {{c_k}{z^k} = \dfrac{1}{{2{\rm{{\text{π}} i}}}}\displaystyle \int_0^{2{\rm{{\text{π}} }}} {\dfrac{{s({{\rm{e}}^{{\rm{i}}u}})}}{{{{\rm{e}}^{{\rm{i}}u}} - z}}{\rm{d}}{{\rm{e}}^{{\rm{i}}u}}} } $ |

其边界极限为

| ${s^ + }({{\rm{e}}^{{\rm{i}}t}}) = \frac{1}{2}s({{\rm{e}}^{{\rm{i}}t}}) + \frac{1}{2}\tilde Hs({{\rm{e}}^{{\rm{i}}t}}) + \frac{{{c_0}}}{2}$ |

其中

| $ \begin{split} & \tilde Hs({{\rm{e}}^{{\rm{i}}t}}) = \sum\limits_{k \ne 0} {( - {\rm{i}}{\rm{sgn}} (k)){c_k}{{\rm{e}}^{{\rm{i}}kt}}} =\\& \;\;\;\;\;\;\;\; \frac{1}{{2{\rm{{\text{π}} }}}}{\rm{p}}{\rm{.v}}{\rm{.}}\int_0^{2{\rm{{\text{π}} }}} {\cot \left(\frac{{t - s}}{2}\right)} s({{\rm{e}}^{{\rm{i}}s}}){\rm{d}}s \end{split}$ |

如果

| $ \left\{ \begin{aligned} & {s = 2{\rm{Re}}{s^ + } - {c_0}}\\& {Hs = 2{\rm{Im}}{s^ + }} \end{aligned}\right.$ | (1) |

有限能量的周期解析信号构成了

有理正交系,也称为TM系,在自适应傅里叶分解中起了十分重要的作用,在单位开圆盘空间

| $ \begin{split} & {B_k}(z) = \frac{{\sqrt {1 - {{\left| {{a_k}} \right|}^2}} }}{{1 - {{\bar a}_k}z}}{\varPhi _{k - 1}}(z)\\& {\varPhi _k}(z) = \prod\limits_{j = 1}^k {\frac{{z - {a_j}}}{{1 - {{\bar a}_j}z}}} \end{split}$ |

其中

CRVM将基于贝叶斯公式进行推导,它研究的是将一个函数运用贝叶斯模型概率表示为多个基本函数的线性叠加。稀疏贝叶斯学习与支持向量机都具有共同的核函数形式,然而稀疏贝叶斯学习可通过迭代优化删除大量的训练样本和核函数且不需要进行参数控制,仅根据训练样本自动调整,它能够充分挖掘和利用数据的先验信息,不仅可以减少异常值的影响,而且可以“剔除”大量不必要的基。

令

| ${s^ + }(z) = \sum\limits_{m = 1}^M {{w_m}} K(z,{a_m}) + v$ |

其向量形式为

| ${{{s}}^ + } = {{\varPhi w}} + {{v}}$ | (2) |

其中,

| $ {{\varPhi}} = \left[ {\begin{array}{*{20}{c}} {K({z_1},{a_1})}& \cdots &{K({z_1},{a_M})} \\ \vdots & \; & \vdots \\ {K({z_N},{a_1})}& \cdots &{K({z_N},{a_M})} \end{array}} \right] \in {C^{N \times M}} $ |

| ${{S}} = {{\varPsi W}} + {{V}}$ | (3) |

其中,

| $ \begin{split} & {{S}} = \left[ {\begin{array}{*{20}{c}} {{\rm{Re}} ({{{s}}^ + })} \\ {{\rm{Im}} ({{{s}}^ + })} \end{array}} \right],{{W}} = \left[ {\begin{array}{*{20}{c}} {{\rm{Re}} ({{w}})} \\ {{\rm{Im}} ({{w}})} \end{array}} \right],{{V}}{\rm{ = }}\left[ {\begin{array}{*{20}{c}} {{\rm{Re}} ({{v}})} \\ {{\rm{Im}} ({{v}})} \end{array}} \right],\\& {{\varPsi}} = \left[ {\begin{array}{*{20}{c}} {{\rm{Re}} ({{\varPhi}} )}&{ - {\rm{Im}} ({{\varPhi}} )} \\ {{\rm{Im}} ({{\varPhi}} )}&{{\rm{Re}} ({{\varPhi}} )} \end{array}} \right] \end{split} $ |

假设

假设噪声

| $ {{V}} \sim N({{{\textit{0}}}_{2N}},{\delta ^2}{{{I}}_{2N}}) $ |

| $p({{S}}|{{W}},{\delta ^2}) = N({{S}}|{{\varPsi W}},{\delta ^2}{I_{2N}}) $ | (4) |

为了推导的方便,此处省去了先验信息

| $ p({{W}}|{{S}},{{\alpha}} ,{\delta ^{\rm{2}}}){\rm{ = }}\frac{{p({{S}}|{{W}},{\delta ^2})p({{W}}|{{\alpha}} )}}{{p({{S}}|{{\alpha}} ,{\delta ^2})}} $ |

其后验分布属于多变量的高斯分布,即

| $p({{W}}|{{S}},{{\alpha}} ,{\delta ^{\rm{2}}})= N({{\mu}} ,{{\varSigma}} ) $ | (5) |

其中,

| ${{\varSigma}} = {({\delta ^{ - 2}}{{{\varPsi}} ^{\rm{T}}}{{\varPsi}} + {{A}})^{ - 1}} $ | (6) |

| ${{\mu}} {\rm{ = }}{\delta ^{{\rm{ - 2}}}}{{\varSigma}} {{{\varPsi}} ^{\rm{T}}}{{S}} $ | (7) |

训练目标值的似然分布通过对权值变量进行积分,即

| $p({{S}}|{{\alpha}} ,{\delta ^2}){\rm{ = }}\int {p({{S}}|{{W}},{\delta ^2})} p({{W}}|{{\alpha}} ){\rm{d}}{{W}} $ |

从而求得超参数的边缘似然函数分布为

| $p({{S}}|{{\alpha}} ,{\delta ^2}) = N({{{\textit{0}}}_{2N}},{\delta ^2}{{{I}}_{2N}} + {{\varPsi}} {{{A}}^{ - 1}}{{{\varPsi}} ^{\rm{T}}}) $ |

超参数

在此框架下,

| $ {s^ + }(z) \approx \sum\limits_{m = 1}^p {{w_m}} K(z,{z_m}),{\text{其中}},p \ll M。$ |

由式(1),对于单位圆的情况,可以得到实值信号

| $ s \approx 2{\rm{Re}} \left\{ {\sum\limits_{m = 1}^p {{w_m}K(z,{z_m})} } \right\} - {c_0}= \sum\limits_{m = 1}^p {{\rho _m}(t)\cos {\theta _m}\left( t \right)} - {c_0} $ |

其Hilbert变换为

| $ Hs \approx 2{\rm{Im}} \left\{ {\sum\limits_{m = 1}^p {{w_m}K(z,{z_m})} } \right\}= \sum\limits_{m = 1}^p {{\rho _m}(t)\sin {\theta _m}\left( t \right)} $ |

其中,

基于Szegö核的稀疏贝叶斯学习采用最大期望算法(EM算法)或第二类最大似然估计进行参数的迭代,由算法的性质可以保证每次迭代都降低成本函数,直到达到一个稳定点。因而基于Szegö核的稀疏贝叶斯算法是全局收敛的。

3 实验下面将以一个例子来说明该方法的有效性。本文研究了文献[3]中的单位圆盘内的奇异函数:

| ${s^ + }(z) = \frac{{1 + 2{z^2}}}{{(z - 2)(z - 3)}} - \frac{1}{{(z + 2)(z + 3)}}{{\rm{e}}^{\tfrac{{z + 1}}{{z - 1}} + \tfrac{{z + {\rm{i}}}}{{z - {\rm{i}}}} + \tfrac{{z - {\rm{i}}}}{{z + {\rm{i}}}}}} $ |

显然

|

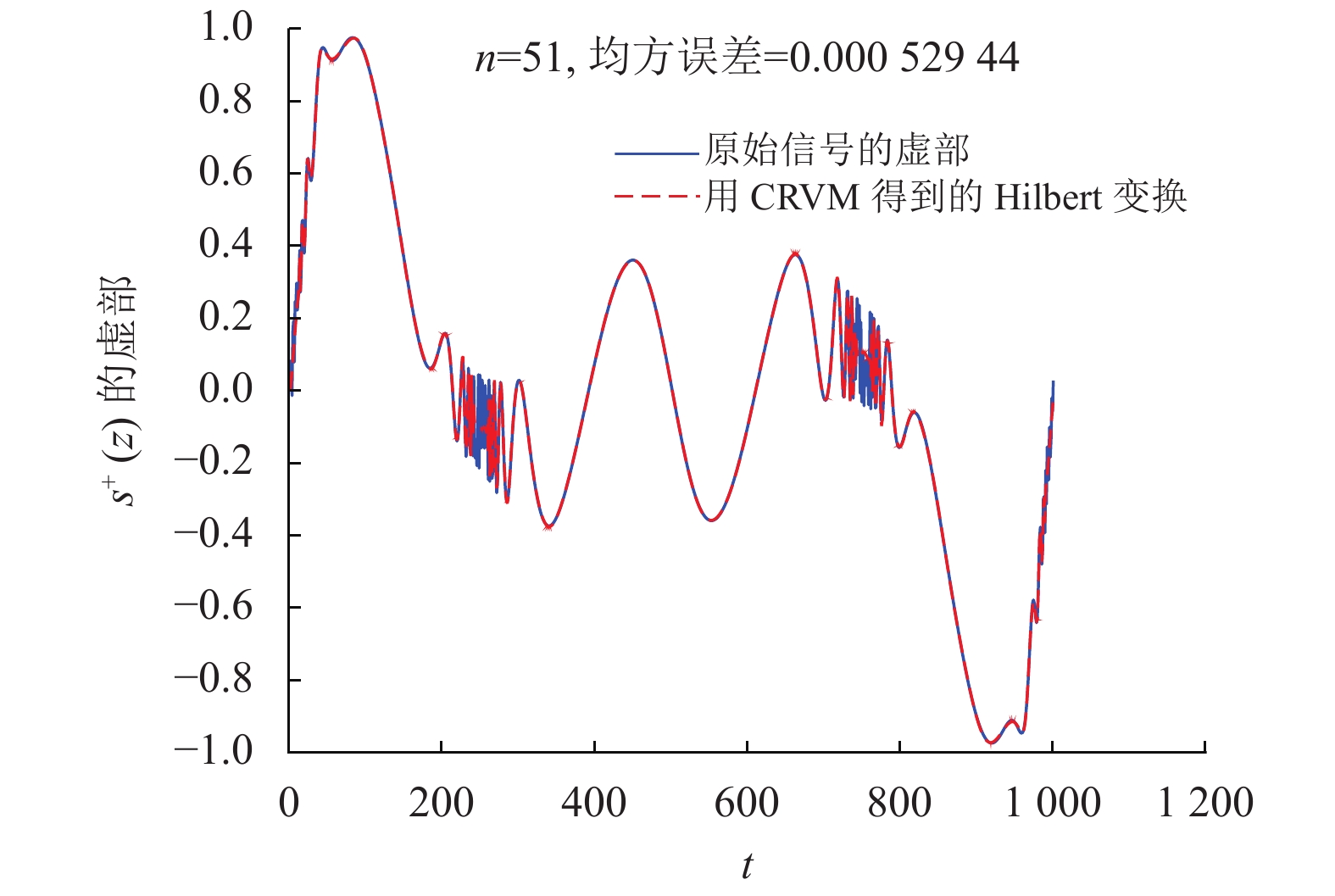

图 1 |

|

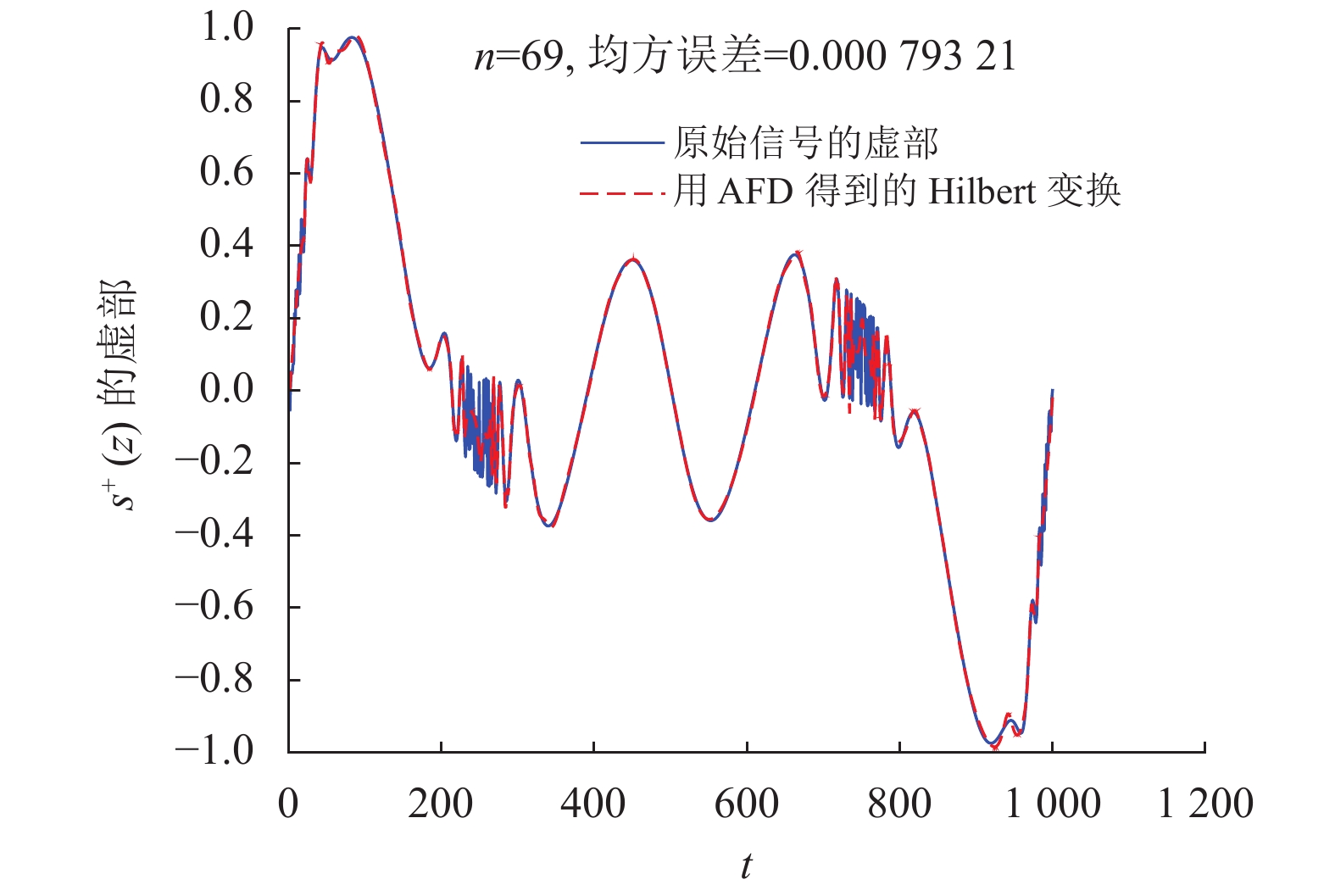

图 2 |

近似结果显示,所提方法CRVM效果优于AFD和FFT。在解析信号

|

图 3 |

本文提出了基于复值稀疏贝叶斯定理近似计算Hilbert变换的方法。该方法是一种复解析方法,适用于所有能量有限的信号,能够在计算Hilbert变换的同时给出解析信号的稀疏有理逼近。与AFD方法相比,所提方法不需要穷尽单位圆盘的点去寻找参数,运算速度快且具有稀疏性。实验结果验证了所提方法的有效性。

| [1] |

ZHOU C, YANG L, LIU Y, et al. A novel method for computing the Hilbert transform with Haar multiresolution approximation[J].

Journal of Computational and Applied Mathematics, 2009, 223: 585-579.

DOI: 10.1016/j.cam.2008.02.006. |

| [2] |

MICCHELLI C A, XU Y S, YU B. On computing with the Hilbert spline transform[J].

Advances in Computational Mathematics, 2013, 38(3): 623-646.

DOI: 10.1007/s10444-011-9252-x. |

| [3] |

MO Y, QIAN T, MAI W X, et al. The AFD methods to compute Hilbert transform[J].

Applied Mathematics Letters, 2015, 45: 18-24.

DOI: 10.1016/j.aml.2014.12.017. |

| [4] |

杨婷, 滕少华. 改进的贝叶斯分类方法在电信客户流失中的研究与应用[J].

广东工业大学学报, 2015, 32(3): 67-72.

YANG T, TENG S H. Research and application of improved Bayes algorithm for the telecommunication customer churn[J]. Journal of Guangdong University of Technology, 2015, 32(3): 67-72. DOI: 10.3969/j.issn.1007-7162.2015.03.013. |

| [5] |

TIPPING M E. The relevance vector machine[C]//Advances in Neural Information Processing Systems. MIT: DBLP, 2000: 652-658.

|

| [6] |

WU Q S, ZHANG Y D, AMIN M G, et al. Complex multitask Bayesian compressive sensing[C]//IEEE International Conference on Acoustics. Florence: SSP, 2014: 3375-3379.

|

| [7] |

GARNETT J B. Bounded analytic functions[M]. New York: Academic Press, 1981: 27-45.

|

2021, Vol. 38

2021, Vol. 38