2. 广东技术师范大学 广东省知识产权大数据重点实验室,广东 广州 510665

2. Guangdong Key Laboratory of Intellectual Property Big Data, Guangdong Polytechnic Normal University, Guangzhou 510665, China

商标是一种重要的知识产权。随着商品经济的快速发展和知识产权保护意识的增强,无论是商标注册的申请量、商标注册审查量还是有效注册商标量的数目都在不断增加。截至2019年上半年,我国的有效注册商标量已达到2 274万件,近五年来,商标申请量多达2 643万件,而且每年以约500多万件的速度在增长。如何从海量的商标库中快速有效地查找感兴趣的商标是开展商标应用和保护的基础和关键。目前,主要的商标检索系统均采用关键字(文本)检索,但由于商标的主要信息载体是图像,简单的文字难以完整地描述商标图像,并且通过文本描述图像的过程中极易受到主观因素的影响,因此,基于关键字(文本)的商标检索效果并不理想。近年来,随着图像检索技术的发展,基于图像内容的商标检索方式也得到广泛关注。图像内容的特征表达是影响图像检索的关键,早期表达商标图像的特征主要基于颜色直方图(Color Histogram,CH)[1-2]、局部二值模式(Local Binary Patterns,LBP)[3-4]、通用搜索树(Generalized Search Trees,GST)[5],视觉词袋(Bag of Visual Words,BOVW)[6],尺度不变特征变换(Scale Invariant Feature Transform,SIFT)[7],形状上下文(Shape Context,SC)[8]等。随着深度学习技术的发展,基于深度特征的图像检索正在被越来越多的学者研究,并且取得了较传统特征更好的效果[9]。Tursun[10]首次把深度神经网络运用于商标特征提取方法上,实验表明其效果明显优于传统的方法。在文献[10]的基础上,Perez等[11]通过两个神经网络分别学习商标的视觉和语义特征,取得了显著优于单神经网络模型的结果,实验也表明基于神经网络的特征提取效果优于传统的特征提取方法。

然而,目前大部分基于深度神经网络的商标特征提取方法都是使用有监督方法[10-11]。有监督的特征学习方法对数据要求过于严苛,数据必须带有标注,对于大规模的商标数据而言,标注数据是一项非常耗时的任务,甚至是一项无法完成的工作。因此,有监督的特征提取方法并不适合大规模商标检索。最近,Wu等[12]提出了一种无监督特征学习算法−实例区分,它能够自动学习类别间的视觉相似性,而不依赖数据标注信息,该方法已成功应用于无监督特征学习方面[12]。同时,商标图像中包含的内容并不一定具有同等重要性,例如以人脸为主体的商标,通常面部区域会得到更多关注;对于含有复杂背景的商标,则前景的信息更容易被关注。然而,大部分的商标特征提取方法在处理商标图像时,无法有区分性地关注一些重要信息。Bahdanau等[13]曾在机器翻译领域提出注意力机制,引起研究者的大量关注,最近,Woo等[14]以此为基础提出了通道和空间混合的注意力模型−卷积块注意力模型,并通过实验验证了卷积块注意力模型不仅能够增强训练网络的空间特征表达能力,而且能够区别出不同位置的重要性关系。

针对现有商标特征提取方法无法有效捕捉重点区域的关键信息和图像标注成本过高的问题,本文提出一种基于注意力机制的无监督商标图像检索方法。该方法基于实例区分算法,将注意力模块同时运用在神经网络的特征映射层的空间维度和通道维度上,通过对各个通道进行权重的分配以及对空间变换参数的学习,增强了无监督网络的特征表达能力,同时,使用噪声对比估计[15]逼近非参数softmax函数,该方法能够大大降低计算量,提高算法的学习速度[12]。实验表明本文提出的商标检索方法要优于基于传统设计特征的商标检索方法,甚至优于一些基于监督学习的商标检索方法。

本文的主要工作包括:(1) 将实例区分方法运用在商标检索,解决了商标大数据特征学习时商标数据标注难的问题,节省了标注需要的资源和时间;(2) 将注意力机制融入实例区分算法,提高商标特征无监督学习网络的特征表达能力,解决了商标特征无区分性的问题。

1 注意力机制注意力机制是模仿人类视觉机制的一种机器学习策略。在认知科学中,由于信息处理的瓶颈,人类会选择性地关注所见信息的一部分,同时忽略其他可见的信息。2014年,Bahdanau等[13]提出了注意力机制,并成功应用于机器翻译领域,目前注意力机制已经广泛地应用在自然语言处理[16]、推荐系统[17]、语音[18]和计算机视觉[19-20]等领域。按照原理来区分,注意力机制主要分为3种模型:通道注意力模型、空间注意力模型、通道和空间混合的注意力模型。通道注意力模型关注“什么”是有意义的,它通过建模各个特征通道的重要程度,使模型能够针对不同的任务增强或者抑制不同的通道。Hu等[21]基于此观点提出了压缩和激励网络(Squeeze-and-Excitation Networks,SENet),建立了特征通道之间的相互依赖关系,使得网络能够从全局特征中选择更大价值的特征通道并屏蔽无用的通道。不同于无差别地考虑每一个图像区域,空间注意力模型更侧重于相关信息的位置,它通过学习空间变换参数,使输入信息在执行空间变换后依旧保留着关键部分。Laskar等[22]提出了一种针对实例检索任务的空间注意力模型,解决了对关键部分权重分配的问题,让模型注意力更集中于重要部分的内容。Max等[23]提出一个空间变换网络(Spatial Transformer Networks,STN),该网络具有空间不变性,通过对特征映射层进行空间转换,能够把输入图像转换成理想的图像,是一种典型的空间注意力模型。空间和通道混合的注意力模型由Woo等[14]提出,在空间和通道上同时使用了全局池化和最大池化操作提升了注意力模型的效果,实现了注意力模块与卷积神经网络架构的无缝集成。

通道注意力使每个通道拥有不同的权重,但忽略了空间层面的变换;空间注意力解决了信息的空间变换问题,但无法区分各个通道的贡献大小。通道和空间混合的注意力模型不仅增强空间特征的表达能力,而且能够区别出不同位置的重要性关系,告诉网络关注“什么”和关注“哪里”[24],综合了通道注意力模型和空间注意力模型的特点,本文所采用的卷积块注意力模型正是一种最具代表性的通道和空间混合的注意力模型。该注意力模型将通道、空间两个维度的注意力模块以先通道域后空间域的顺序进行组合,再与无监督网络融合,让网络根据损失函数自主地学习特征的权重,聚焦图像的关键特征,解决了传统商标特征提取方法在对图像进行处理时,捕捉重点区域的关键信息能力不足的问题,同时,在不显著增加计算量和参数量的前提下,该网络能够重点关注更有区分能力的特征,提高特征的表达能力。

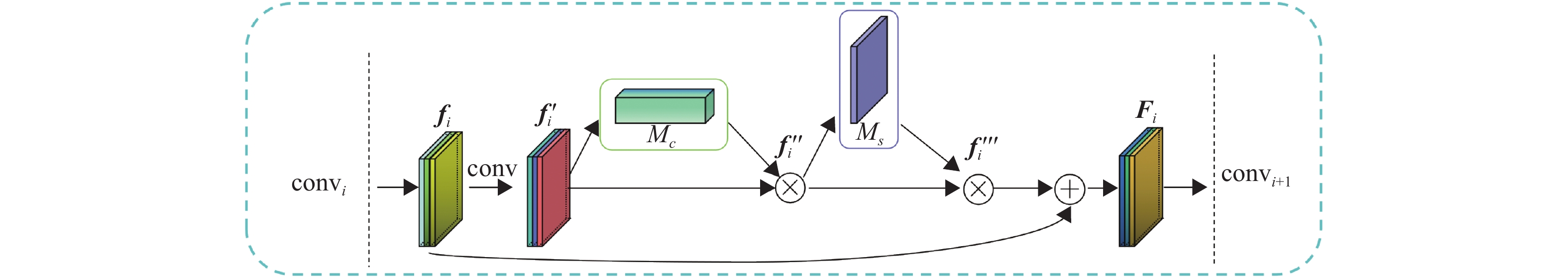

通道和空间混合的注意力模型如图1所示[14],对于通道注意力模块

| ${M_c}({{f}}') = {\rm{\delta }}({\rm{MLP}}({\rm{AvgPool}}({{f}}')) + {\rm{MLP}}({\rm{MaxPool}}({{f}}'))),$ | (1) |

其中,

|

图 1 通道和空间混合的注意力模块 Figure 1 Channel and spatial mixed attention module |

同理,对于空间注意力模块

| ${M_s}({f'}) = {\delta }({{f}^{n \times n}}([{\rm{AvgPool}}({f'});{\rm{MaxPool}}({f'})])),$ | (2) |

其中,

| ${f''} = {M_c}({f'}) \otimes {f'},$ | (3) |

| ${f'''} = {M_s}({f''}) \otimes {f''}$ | (4) |

其中,

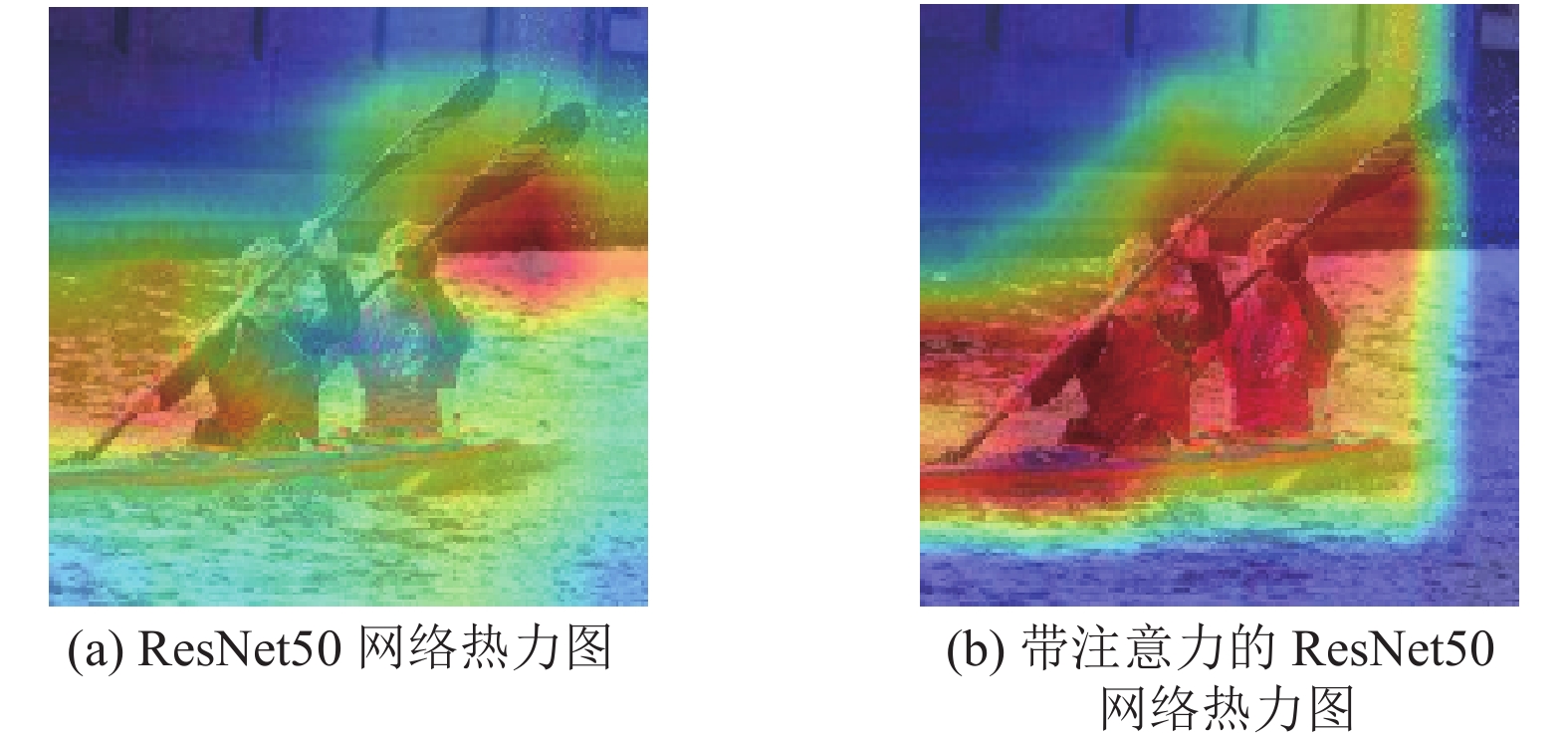

Woo等[14]通过实验表明卷积块注意力模型比单通道注意力模块或者单空间注意力模块体现出更好的捕捉关键特征能力,同时,也验证了通道注意力模块或者空间注意力模块同时使用平均和最大的并行池化比单一平均池化操作丢失信息更少,效果更有优越性。图2显示了卷积块注意力模型的优点[14],图2(a)为ResNet50的热力效果图,图2(b)为加入了注意力模块的ResNet50热力效果图,在热力图中,模型越感兴趣的区域,显示的温度越高,即红色的比重越大,对于不关注的区域,则显示的温度越低,即颜色向浅蓝色靠近,显然,图2(a)只对船桨部分进行了重点关注,图2(b)的网络则关注了物体更多的关键信息,如人物、河水、船只等。鉴于卷积块注意力模型在捕捉关键特征能力上的优势,本文将这种卷积块注意力模型运用于商标特征训练学习中。

|

图 2 注意力机制效果示意图 Figure 2 Attention mechanism schematic diagram |

为了解决传统无监督商标特征提取过程中对商标图像关键特征获取能力不足的问题,本文将注意力机制引入到实例区分算法,提出了一种基于注意力机制的无监督商标检索方法。该方法把注意力机制同时运用在神经网络特征映射层的空间维度和通道维度上,使网络学习到更多关键元素,聚焦于更多关键的特征,从而提高神经网络对商标特征的表达能力。此外,该方法不需要标注数据,同时解决了商标检索中的标注难题。实验结果表明,该方法的特征提取效果优于常用的商标特征提取方法,甚至优于一些有监督的特征提取方法。

2.1 实例区分实例区分是一种无监督特征学习方法。它的学习任务和思想是通过在所有数据下最大化实例本身的后验概率,间接地训练神经网络的特征提取能力。具体地说,实例区分算法将每个图像的实例作为一个独立的类来处理,并训练一个分类器来区分不同的实例类,这种方法不需要任何标签信息,文献[12]在ImageNet的分类结果上通过实验表明了实例区分算法能够自动学习类别间的视觉相似性,而不依赖数据标注信息,该方法在无监督特征学习方面取得了成功应用。

实例区分算法的目标是学习一个无监督的嵌入函数

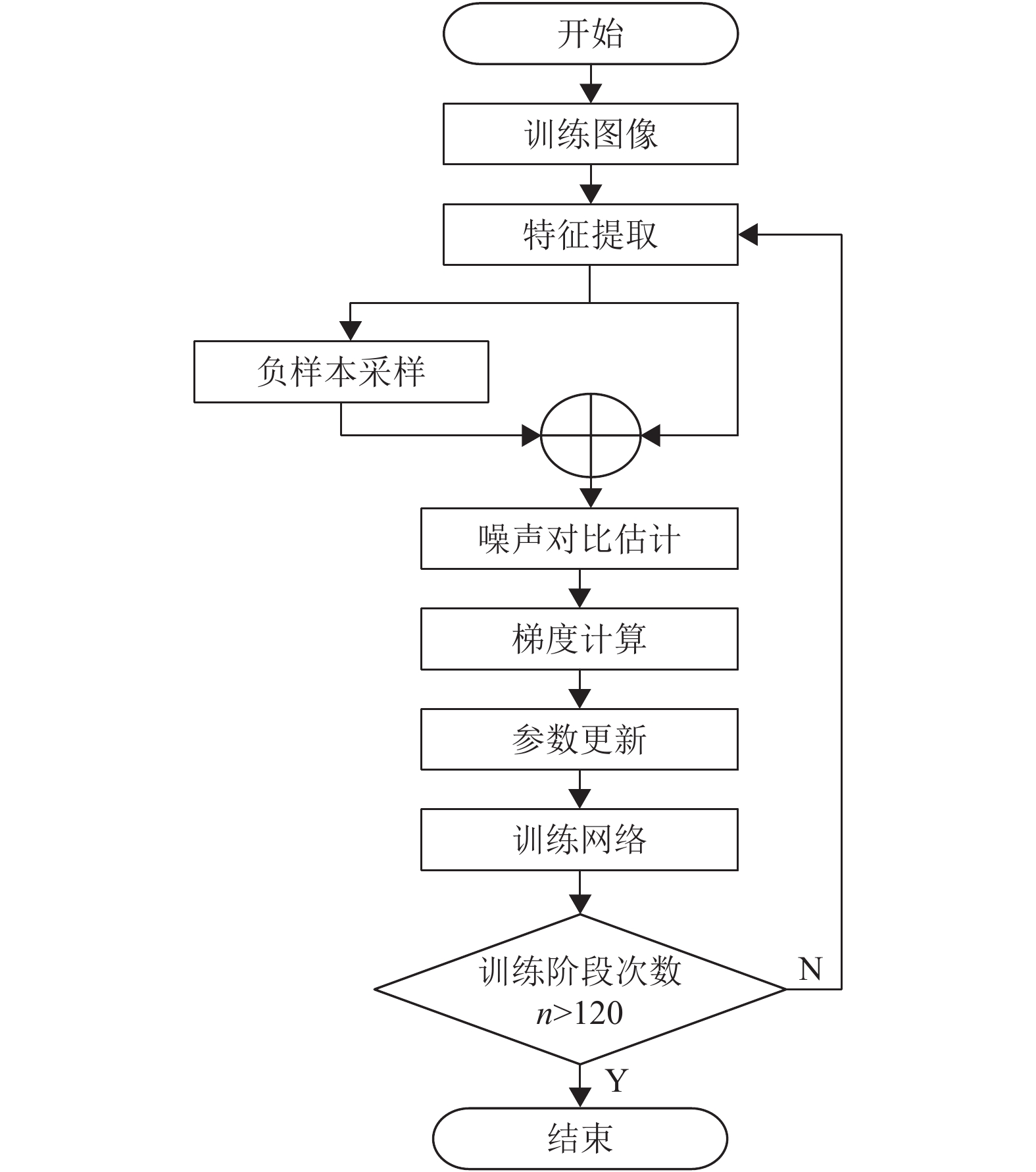

实例区分算法主要流程如图3所示,具体步骤为:

|

图 3 实例区分方法主要流程图 Figure 3 Main flow chart of Instance discrimination |

(1) 选取

(2) 对无监督网络进行向前计算,提取图像特征

(3) 在特征内存记忆模块进行负样本采样,得到负样本

(4) 使用对比噪声估计的方法对实例和负样本进行计算近似损失值;

(5) 根据步骤(4)计算的损失值进行反向传播,更新参数;

(6) 当训练阶段次数n > 120时,停止训练网络,否则返回步骤(2)。

步骤(4)的损失函数是最小化数据和噪声样本的负对数后验分布,具体如式(5)所示。

| ${J_N}\left( {\theta } \right) = - {E_{{P_{\rm{d}}}}}[\log h(i,{v})] - s{E_{{P_{\rm{k}}}}}[\log (1 - h(i,{v'}))]$ | (5) |

其中,

| $h(i,{v}) = P(D = 1|i,{v}) = \frac{{P(i|{v})}}{{P(i|{v}) + s{P_{\rm{k}}}(i)}},$ | (6) |

| $h(i,{v'}) = P(D = 1|i,{v'}) = \frac{{P(i|{v'})}}{{P(i|{v'}) + s{P_{\rm{k}}}(i)}},$ | (7) |

式(6)和(7)中的

| $P(i|{v}) = \frac{{\exp ({{v}^{\rm{T}}}{{v}_i}/\tau ))}}{{{Z_i}}},$ | (8) |

| ${Z_i} = \sum\limits_{j = {\rm{1}}}^n {\exp ({{v}_j^{\rm{T}}}{{v}_i}/\tau } ),$ | (9) |

| ${Z_i} \cong k{E_j}[{\rm{exp}}({{v}_j}^{\rm{T}}{{v}_i}/\tau )] = \frac{k}{s}\sum\limits_{g = {\rm{1}}}^s {{\rm{exp}}({v}_{jg}^{\rm{T}}{{v}_i}/\tau )} )$ | (10) |

其中,

实例区分算法还面临一个巨大的挑战,即类别数量就是整个数据集的大小,对于本文实验商标数据集而言,类别数量高达90多万,显然,简单地将无参数分类器扩展更多类是不可取的。为了解决这个挑战,Wu[12] 通过使用对比噪声估计模块[15]来近似计算在softmax分类器下的交叉熵损失大小,并采用近端正则化方法来达到一个稳定的训练过程[26],避免了在计算损失时,对商标数据库的全体数据进行遍历。同时,实例区分算法在噪声对比估计框架下,通过采样恒定的负样本的数量,避免了在大数据环境下计算量的爆炸性增长,实现了针对大规模数据集的快速检索功能,而其他的非监督方法难以解决大数据背景下的计算量问题,并且无法保证检索的精度。噪声对比估计在不降低表现的情况下将计算复杂度从O(n)降低到O(1),使实例区分算法能够应用在大型商标的数据集上。

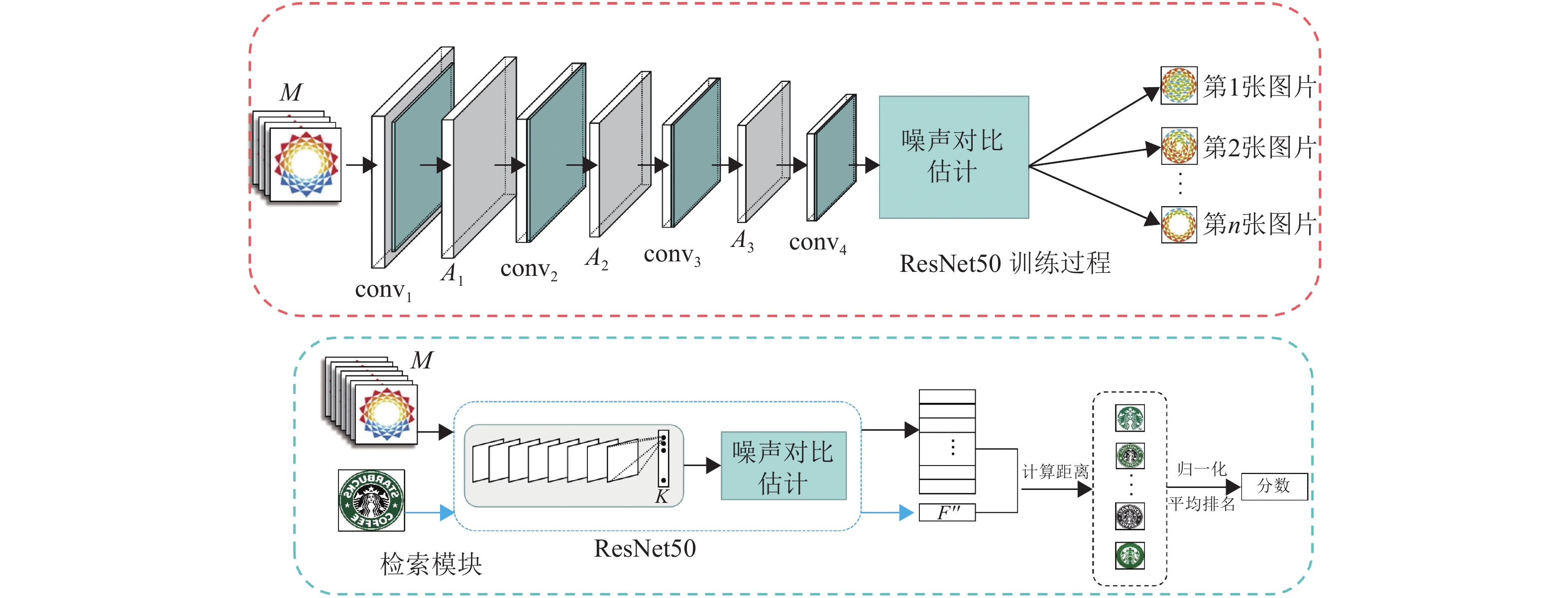

2.2 基于注意力机制的无监督商标检索方法实例区分方法可以实现商标图像特征的无监督学习,在不需要任何标签信息的情况下,可学习得到图像显著的视觉相似性。然而实例区分方法无法有效地捕捉重点区域的关键信息,针对这个问题,本文提出了一种基于注意力机制的无监督商标检索方法。该方法在实例区分算法的基础上,引入基于卷积块的注意力模块,通过对各个通道进行加权处理以及对空间变换参数的学习,增强了无监督网络的特征表达能力,同时解决了商标图像关键信息获取和图像标注问题。该方法的流程如图4所示,整个方法包含3个关键模块,分别为注意力模块、无监督网络的训练模块和商标检索模块。注意力模块主要用于提高网络对输入图像关键信息的捕捉能力。以第1层卷积块和第2层卷积块为例,如图1所示。商标图像

|

图 4 基于注意力机制的商标检索框架图 Figure 4 Framework of trademark retrieval method based on attention mechanism |

算法1基于注意力机制的无监督商标检索方法

输入:检索图片

输出: 商标数据库中与

Step1:训练基于注意力的特征提取网络

for i = 1 to 120 do

(1) 从商标数据集

(2) 商标图像

(3) 由

(4) 不断迭代更新商标特征

end for

Step2: 特征提取与检索

(1)利用Step1训练好的ResNet50网络提取商标数据集

(2)计算检索图像特征

为了验证本文提出方法的有效性,本文在目前最大的公开商标数据集——METU商标数据集进行对比实验[10]。

3.1 数据集METU商标数据集包含923 343张商标图像,其中包含1个含有417张商标图像的测试集,该测试集分为35组,每组包含10~15张商标。在本文实验中,商标的训练集和测试集均缩小至

本文使用归一化平均排名(Normalized Average Rank,NAR)[10]作为评测指标。该指标是一种衡量检索效果优劣的常用指标,其计算公式为

| ${\rm{NAR}} = \frac{{\rm{1}}}{{N{N_{{\rm{rel}}}}}}\left(\sum\limits_{i = 1}^{{N_{{\rm{rel}}}}} {{R_i} - \frac{{{N_{{\rm{rel}}}}({N_{{\rm{rel}}}} + {\rm{1}})}}{{\rm{2}}}} \right)$ | (11) |

其中,

本文使用实例区分作为无监督特征学习的算法,选取网络层数相对适中的ResNet50作为无监督学习网络[27],ResNet引入残差结构,解决了深层网络梯度消失的问题,便于研究注意力机制与不同深度的残差网络结合的检索效果。在实验中,为了与文献[10]形成公平的对比,实验参数保持与文献[10]相同,学习率

为了验证提出方法的有效性,本文将提出的检索方法与目前常用的几种商标检索方法进行了对比实验,同时也研究了注意力机制对特征提取网络的影响。在对比实验中,加入注意力模块的实例区分方法为本文的方法,未加入注意力模块的实例区分方法记为ResNet50(RS)。

(1) 与基于传统特征提取的检索方法对比。与文献[10]类似,本文选取了颜色直方图(CH)[28]、局部二值模式(LBP)[4],通用搜索树(GIST)[29]、形状上下文(SC)[30]、尺度不变特征变换(SIFT)[7]、快速鲁棒特征(Speeded Up Robust Features,SURF)[31]、梯度方向直方图(Histogram of Oriented Gradient,HOG)[32],方向限制尺度不变特征变换(Orientation-Restricted SIFT,OR-SIFT)等常用的特征进行对比检索[33]。这些方法在METU商标数据集上的测试结果来源于文献[10],为了公平起见,本文方法所使用的验证数据集和评测指标与文献[10]保持一致。实验结果如表1所示。表1中NAR均值和标准差是通过35组实验中的NAR计算得来。由表1可以看出,本文所提出的方法对比传统的特征设计方法体现出更好的优越性,NAR均值为0.101,因为传统的特征提取方法缺少了对商标图像特性的考虑,对所有图像提取方法均一致,没有分配关键特征权重,而本文的方法在实例区分算法的基础上,引入注意力模块,能有效地捕捉商标图像中重点区域的关键信息,检索效果明显提升。

| 表 1 与无监督商标检索方法对比结果 Table 1 Comparison with unsupervised trademark retrieval methods |

(2) 与基于深度特征的商标检索方法对比。实验选取文献[10]和文献[34]中的有监督特征提取方法进行对比实验,其中包括在ImagNet上的预训练模型AlexNet[35]、GoogLeNet[36]、VggNet16[37]和ResNet[27]等主流的深度神经网络。此外,还选取文献[38]中VggNet16(Conv5)和ResNet50(Pool4)的有监督特征提取方法,该方法将NPU商标数据集作为训练集,通过对图像变换整体的学习,来增强网络的特征不变性。实验中,AlexNet(FC7)表示使用AlexNet的FC7进行提取特征,其他网络同理。对比实验结果如表2所示。从表2中可以看出,尽管本文的方法稍逊色于VggNet16(Pool5)、VggNet16(FC7)和ResNet50(Pool5)等有监督检索方法,但是本文的方法优于AlexNet(FC7)、GoogLeNet(77S1)、VggNet16(FC8)、ResNet50(FC1000)等有监督方法,并且优于未加入注意力模块的实例区分方法ResNet50(RS)。对比于AlexNet和GoogLeNet[37],表明VggNet具有更广泛的感受野,捕获了更多的上下文信息,因此VggNet的检索效果比AlexNet和GoogLeNet更优,此外。本文的方法与残差网络(ResNet)的另外几种有监督方法对比,实验结果表明了使用同样的残差网络,本文无监督方法效果优于大部分的有监督方法。众所周知,无监督方法在前期工作中节省了大量人力和时间,不用标注即可训练网络。有监督方法对数据要求太苛刻,需要标注信息,对于具有庞大数据量的商标数据集来说,人工标注数据是一件困难的事,甚至可能是一项几乎无法完成的工作。因此,综合标注成本和检索效果来看,本文提出的方法整体上仍具有明显优势。

| 表 2 与有监督商标检索方法对比结果 Table 2 Comparison with supervised trademark retrieval methods |

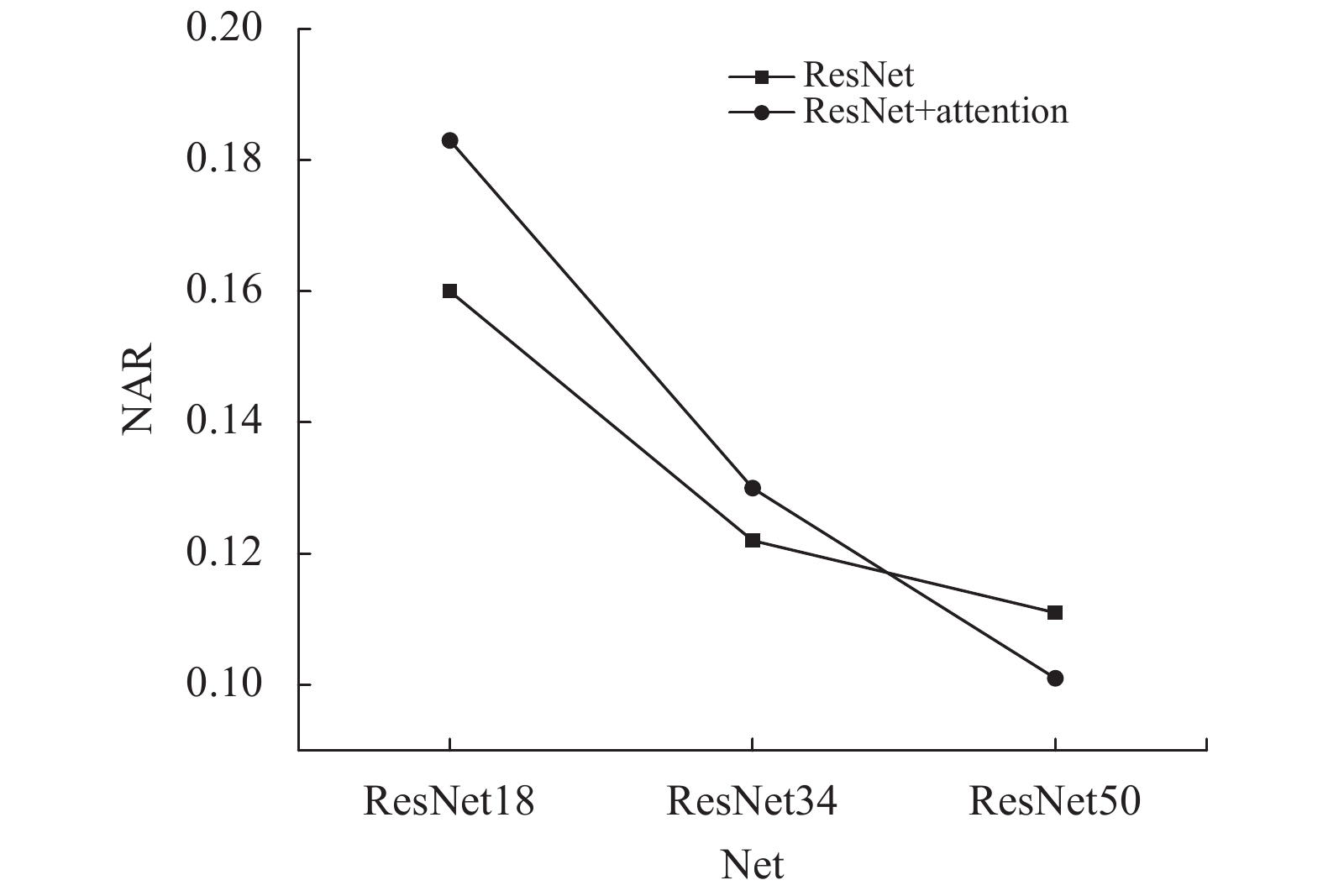

(3) 注意力机制对残差网络的影响。为了研究注意力机制的有效性,本文使用了ResNet18、ResNet34和ResNet50 3种不同深度的残差网络进行实验,如图5所示。商标图像的分辨率为

|

图 5 注意力机制对残差网络的影响 Figure 5 Impact of attention mechanism on ResNet |

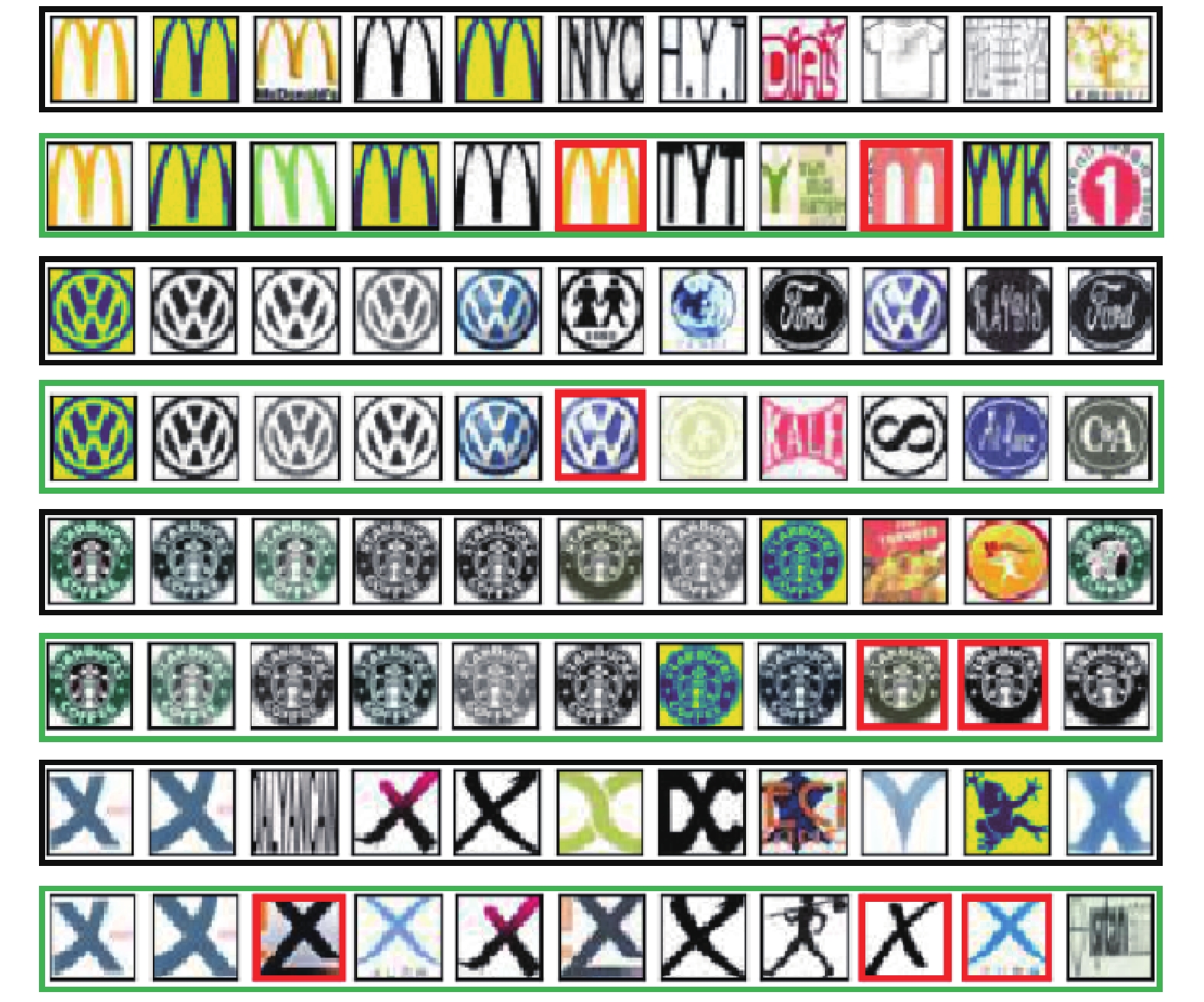

此外,为了具体证实注意力机制对商标检索的提升效果,本文也给出了4个待检索样本在METU商标数据集上检索到的前10个结果。如图6所示,每一行的第1张商标均为检索图像,第2张至第11张为商标检索排序结果,其中,第1、3、5、7行表示无注意力机制的无监督ResNet50模型的检索结果,第2、4、6、8行表示有注意力机制的无监督ResNet50模型的检索结果,其中红色框标识的商标图像是在无注意力机制时没有出现在前10个检索结果中。通过图6可以直观地看到,注意力机制能够有效地提升商标的检索结果。

|

图 6 部分样本的商标检索结果 Figure 6 Retrieval results of some trademark samples |

本文将注意力机制引入到实例区分算法,实现了利用深度神经网络进行商标特征无监督学习,提出了一种基于注意力机制的无监督商标检索方法,试图解决海量商标检索中当前存在的数据标注成本大和商标重点区域特征信息难提取的问题。该方法通过对各个通道进行权重的分配以及对空间变换参数的学习,增强了网络的特征表达能力。在公开的商标数据集上的对比实验表明本文的方法优于传统的商标检索方法,甚至超越一些有监督学习的商标检索方法,验证了提出方法的有效性。未来,我们将会考虑通过少量标注信息提升商标检索效果,研究注意力机制与弱监督学习结合的商标检索方法。

| [1] |

PHAN R, ANDROUTSOS D. Content-based retrieval of logo and trademarks in unconstrained color image databases using color edge gradient co-occurrence histograms[J].

Computer Vision and Image Understanding, 2010, 114(1): 66-84.

DOI: 10.1016/j.cviu.2009.07.004. |

| [2] |

LAM C, WU J, MEHTRE B. STAR−A system for trademark archival and retrieval[J].

World Patent Information, 1996, 4(18): 249-249.

|

| [3] |

OJALA T, PIETIKÄINEN M, MÄENPÄÄ T. A generalized local binary pattern operator for multiresolution gray scale and rotation invariant texture classification[C]//Proceedings of the International Conference on Advances in Pattern Recognition. Brazil: Springer, 2001: 399-408.

|

| [4] |

OJALA T, PIETIKAINEN M, MAENPAA T. Multiresolution gray-scale and rotation invariant texture classification with local binary patterns[J].

IEEE Transactions on Pattern Analysis and Machine Intelligence, 2002, 24(7): 971-987.

DOI: 10.1109/TPAMI.2002.1017623. |

| [5] |

OLIVA A, TORRALBA A. Modeling the shape of the scene: a holistic representation of the spatial envelope[J].

International Journal of Computer Vision, 2001, 42(3): 145-175.

DOI: 10.1023/A:1011139631724. |

| [6] |

SIVIC J, ZISSERMAN A. Video Google: A text retrieval approach to object matching in videos[C]// Ninth IEEE International Conference on Computer Vision. France: IEEE, 2003: 1470-1477.

|

| [7] |

LOWE D G. Distinctive image features from scale-invariant keypoints[J].

International Journal of Computer Vision, 2004, 60(2): 91-110.

DOI: 10.1023/B:VISI.0000029664.99615.94. |

| [8] |

HER I, MOSTAFA K, HUNG H K. A hybrid trademark retrieval system using four-gray-level zernike moments and image compactness indices[J].

International Journal of Image Processing (IJIP), 2011, 4(6): 631-646.

|

| [9] |

张皓, 吴建鑫. 基于深度特征的无监督图像检索研究综述[J].

计算机研究与发展, 2018, 55(9): 1829-1842.

ZHANG H, WU J X. A survey on unsupervised image retrieval using deep features[J]. Journal of Computer Research and Development, 2018, 55(9): 1829-1842. |

| [10] |

TURSUN O, AKER C, KALKAN S. A large-scale dataset and benchmark for similar trademark retrieval[J]. arXiv preprint arXiv: 170105766, 2017.

|

| [11] |

PEREZ C A, ESTÉVEZ P A, GALDAMES F J, et al. Trademark image retrieval using a combination of deep convolutional neural networks[C]// Proceedings of the 2018 International Joint Conference on Neural Networks (IJCNN). Rio de Janeiro: IEEE, 2018: 1-7.

|

| [12] |

WU Z, XIONG Y, YU S X, et al. Unsupervised feature learning via non-parametric instance discrimination[C]// Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Salt Lake City: IEEE, 2018: 3733-3742.

|

| [13] |

BAHDANAU D, CHO K, BENGIO Y. Neural machine translation by jointly learning to align and translate[J]. arXiv preprint arXiv: 14090473, 2014.

|

| [14] |

WOO S, PARK J, LEE J-Y, et al. Cbam: convolutional block attention module[C]// Proceedings of the Proceedings of the European Conference on Computer Vision. Munich: ECCV, 2018: 13-19.

|

| [15] | |

| [16] |

YANG Z, YANG D, DYER C, et al. Hierarchical attention networks for document classification[C]// Proceedings of the Association for Computational Linguistics. North American: human language technologies, 2016: 1480-1489.

|

| [17] |

ZHOU G, ZHU X, SONG C, et al. Deep interest network for click-through rate prediction[C]// Proceedings of the 24th ACM SIGKDD International Conference on Knowledge Discovery & Data Mining. London: ACM, 2018: 1059-1068.

|

| [18] |

KIM S, HORI T, WATANABE S. Joint CTC-attention based end-to-end speech recognition using multi-task learning[C]// Proceedings of the 2017 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP). New Orleans, LA: IEEE, 2017: 4835-4839.

|

| [19] | |

| [20] |

FU J, ZHENG H, MEI T. Look closer to see better: recurrent attention convolutional neural network for fine-grained image recognition[C]// IEEE Conference on Computer Vision & Pattern Recognition. Honolulu, HI: IEEE, 2017: 4438-4446.

|

| [21] |

HU J, SHEN L, SUN G. Squeeze-and-excitation networks[C]// Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Salt Lake City: IEEE, 2018: 7132-7141.

|

| [22] |

LASKAR Z, KANNALA J. Context aware query image representation for particular object retrieval[C]//Proceedings of the Scandinavian Conference on Image Analysis. Scandinavian: Springer, 2017: 88-99.

|

| [23] |

JADERBERG M, SIMONYAN K, ZISSERMAN A. Spatial transformer networks[C]// Proceedings of the Advances in Neural Information Processing Systems. Lake tahoe Nevada: NIPS, 2015: 2017-2025.

|

| [24] |

CHEN L, ZHANG H, XIAO J, et al. SCA-CNN: Spatial and channel-wise attention in convolutional networks for image captioning[C]// Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Honolulu, HI: IEEE, 2017: 5659-5667.

|

| [25] |

WANG F, XIANG X, CHENG J, et al. Normface: L2 hypersphere embedding for face verification[C]// Proceedings of International Conference on Multimedia. Multimedia: ACM, 2017: 1041-1049.

|

| [26] |

PARIKH N, BOYD S. Proximal algorithms[J].

Foundations and Trends® in Optimization, 2014, 1(3): 127-239.

DOI: 10.1561/2400000003. |

| [27] |

HE K, ZHANG X, REN S, et al. Deep residual learning for image recognition[C]// Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. USA: IEEE, 2016: 770-778.

|

| [28] |

LEI Z, FUZONG L, BO Z. A CBIR method based on color-spatial feature[C]//Proceedings of IEEE Region 10 Conference. Cheju Island: IEEE, 1999: 166-169.

|

| [29] |

DOUZE M, JÉGOU H, SANDHAWALIA H, et al. Evaluation of gist descriptors for web-scale image search[C]// Proceedings of the ACM International Conference on Image and Video. Retrieval. Santorini Island: ACM, 2009: 1-8.

|

| [30] |

RUSIÑOL M, LLADÓS J. Efficient logo retrieval through hashing shape context descriptors[C]//Proceedings of the 9th IAPR International Workshop on Document Analysis Systems. Boston: ACM, 2010: 215-222.

|

| [31] |

BAY H, ESS A, TUYTELAARS T, et al. Speeded-up robust features (SURF)[J].

Computer Vision and Image Understanding, 2008, 110(3): 346-359.

DOI: 10.1016/j.cviu.2007.09.014. |

| [32] |

DALAL N, TRIGGS B. Histograms of oriented gradients for human detection[C]//proceedings of Conference on Computer Vision and Pattern Recognition. California: IEEE, 2005: 886-893.

|

| [33] |

VURAL M F, YARDIMCI Y, TEMIZEI A. Registration of multispectral satellite images with orientation-restricted SIFT[C]//Proceedings of IEEE International Geoscience and Remote Sensing Symposium. Cape Town: IEEE, 2009: 243-246.

|

| [34] |

AKER C, TURSUN O, KALKAN S. Analyzing deep features for trademark retrieval[C]//Signal Processing and Communications Applications Conference. Antalya: IEEE, 2017: 1-4.

|

| [35] |

KRIZHEVSKY A, SUTSKEVER I, HINTON G E. Imagenet classification with deep convolutional neural networks[C]// Proceedings of the Advances in neural information processing systems. Curran Associates Inc: NIPS, 2012: 1097-1105.

|

| [36] |

SZEGEDY C, LIU W, JIA Y, et al. Going deeper with convolutions[C]// Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Boston, MA: IEEE, 2015: 1-9.

|

| [37] |

SIMONYAN K, ZISSERMAN A. Very deep convolutional networks for large-scale image recognition[J]. arXiv Preprint arXiv: 14091556, 2014.

|

| [38] |

TURSUN O, DENMAN S, SRIDHARAN S, et al. Enhancing feature invariance with learned image transformations for image retrieval[J]. arXiv Preprint arXiv: 200201642, 2020.

|

2020, Vol. 37

2020, Vol. 37