2. 广州医科大学附属第一医院,广东 广州 510120;

3. 广东工业大学 机电工程学院,广东 广州 510006

2. Department of Hepatobiliary Surgery, the First Affiliated Hospital of Guangzhou Medical University, Guangzhou 510120, China;

3. School of Electromechanical Engineering, Guangdong University of Technology, Guangzhou 510006, China

磁共振(Magnetic Resonance, MR)成像是一种功能强大,灵活且无创的成像技术,可以提供体内器官和结构的高质量截面图像,被广泛应用于医疗诊断。尤其是,高分辨率(High-Resolution, HR)可以给医生提供更加清晰的图像,以便于他们更加精准地分析人体组织结构和病灶区,给出精准诊断建议[1]。因此,MR图像超分辨率(Super Resolution, SR)研究开始受到学者的广泛关注[2]。

由于卷积神经网络(Convolutional Neural Network, CNN)拥有着强大的自学习性能,在机器视觉领域得到了广泛的应用[3-8],越来越多的研究者将CNN引入MR图像超分辨率重建研究,主要采用预先放大和单上采样两种策略进行图像超分辨率重建。

基于预先放大策略[9]的MR图像超分辨率重建一般在网络学习前先采用双三次插值或者反卷积方法,将输入的低分辨率图像进行预先放大后,再输入到卷积神经网络中实现高分辨率图像重建。Pham等[10]将超分辨率卷积神经网络[11-12]应用于大脑MR图像超分辨率重建,其在网络学习之前采用双三次插值进行预先放大。Oktav等[13-14]设计了一种基于残差卷积神经网络的心脏MR图像超分辨率方法,其在网络学习前采用反卷积进行预先放大。但是,该网络与VDSR[15]高度相似。因此网络越深,网络参数越多,所需存储空间越大,这将可能限制实际医学应用。Shi等[16]设计了具有固定跳跃式连接的渐进宽残差网络重建大脑高分辨率MR图像,其在网络学习前也是采用双三次插值进行预先放大。这些预先放大策略意味着超分辨率重建实际上是在高分辨率图像空间中实现的,而不是直接从低分辨率图像中学习到的,因此超分辨率重建效果不一定是最佳的,而且这也会增加计算复杂度。

基于单上采样策略的MR图像超分辨率重建无需预先放大,图像放大操作在网络结构末端通过反卷积或像素洗牌(Pixel Shuffle)实现,超分辨率重建工作在图像低分辨率空间完成,其计算复杂度将大幅度降低。McDonagh等[17]扩展了快速超分辨率卷积神经网络(FSRCNN)[18],实现了低分辨率胎儿MR图像超分辨率重建,在网络末端采用反卷积操作进行图像放大。Tanno等[19]将有效亚像素卷积网络(Efficient Sub-Pixel Convolutional Neural Network, ESPCN)[20]应用于扩散加权磁共振成像(Diffusion Magnetic Resonance Imaging, dMRI)超分辨率重建,在网络末端的有效亚像素卷积层中实现像素洗牌。虽然这些方法能够加快网络速度,但是其采用的网络逐层级联方式将导致当前层损失信息无法传输到下一层。

为了解决以上问题,本文设计了一种基于深度残差网络的MR超分辨率重建网络[21],并应用于MR图像超分辨率重建。网络拥有多个跳跃式连接残差单元,可以逐层提取不同分辨率的图像特征图;通过一个反卷积层将多个残差单元输出的不同分辨率特征图分别与低分辨率(Low Resolution, LR)MR图像进行多分辨率上采样融合,以最大限度地避免网络传输过程中的信息损失;最后,对多分辨率上采样融合特征图进行多分辨率学习,自适应学习确定各分辨率上采样融合特征图对磁共振图像超分辨重建的贡献度,最终实现MR图像的超分辨率重建。

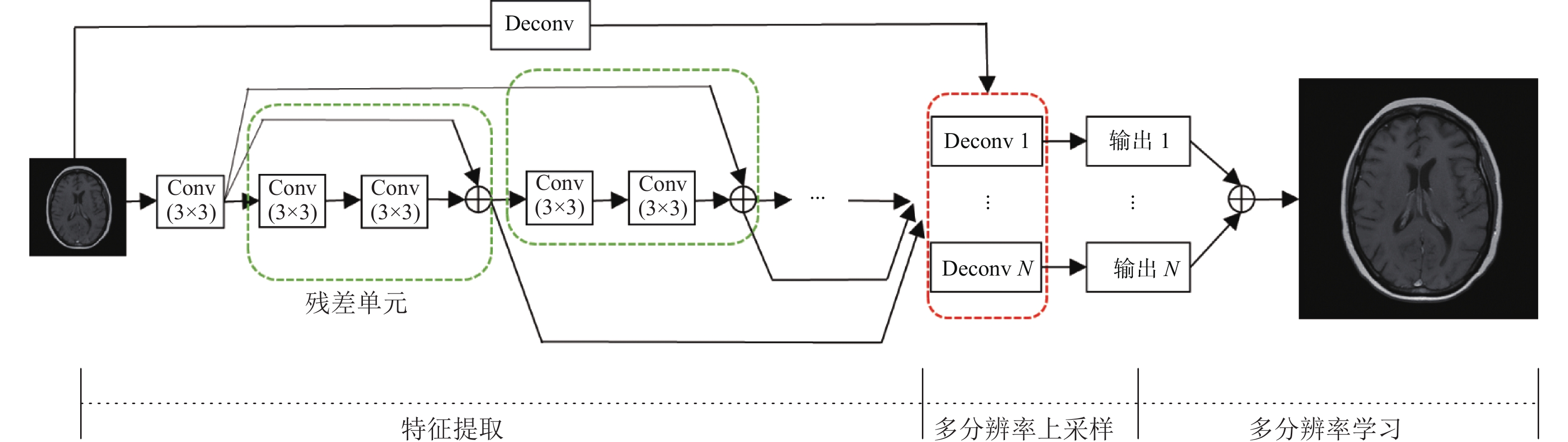

1 多分辨率学习卷积神经网络 1.1 网络架构本文设计的多分辨率学习卷积神经网络如图1所示,包含了3个阶段:特征提取、多分辨率上采样和多分辨率学习。网络输入是低分辨率的MR图像,输出是高分辨率的MR图像,整个超分辨率重建过程是一个端到端学习过程。

|

图 1 提出的网络架构 Figure 1 The architecture of the proposed network |

在特征提取阶段,低分辨率MR图像先经过第一个卷积层用于获得粗特征图,之后级联几个残差单元逐层实现由粗到精的特征提取。为了避免信息损失,第一个卷积层提取的粗特征图叠加到每个残差单元的输出端,作为残差单元的输出并输入到下一个残差单元,同时也传递到多分辨率上采样反卷积层。每个残差单元拥有2个卷积层,包括第一层卷积层在内的所有卷积层每一层有128个卷积核,卷积核大小为3×3。

在多分辨率上采样反卷积层,对每个残差单元输出的叠加特征图进行反卷积操作,得到各残差单元的上采样特征图,之后再分别与低分辨率MR图像的上采样特征图进行融合,实现多分辨率上采样。融合后的上采样特征图输入到多分辨率学习层,通过自适应学习确定各分辨率的融合上采样特征图对重建的高分辨率MR图像的贡献度,最终加权融合实现MR图像超分辨率重建。

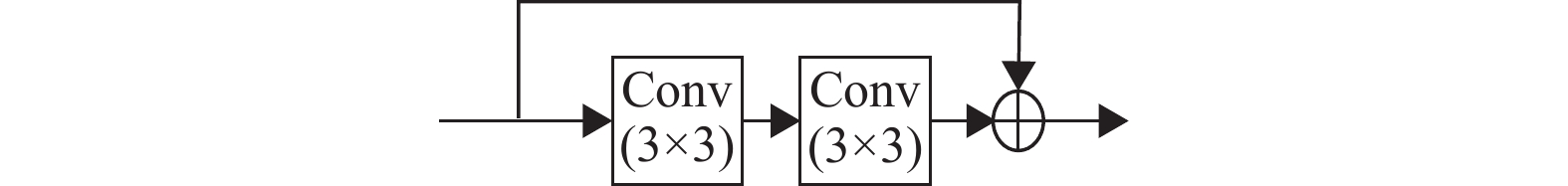

1.2 残差单元对于深度网络,级联多个卷积层将会提升特征提取效果,但是也会导致网络收敛越来越难。为了提升网络优化速度,残差单元已经在深度网络中被广泛地应用[22]。因此,论文也采用残差策略构建了残差单元,并将多个残差单元级联以提升特征提取效果并获得不同分辨率的特征图。每个残差单元结构如图2所示,拥有2个卷积层,每一层有128个卷积核,卷积核大小为3×3。

|

图 2 残差单元 Figure 2 Residual unit |

假设输入的低分辨率MR图像为x,通过网络的第一个卷积层可以获得128个粗特征图

| $ {U}_{0}={f}_{{\rm{conv}}}\left({x}\right) $ | (1) |

然后传递到每个残差单元。因此,每个残差单元的输出为

| $ {U}_{i}={U}_{0}+{f}_{{\rm{conv}}}\left({f}_{{\rm{conv}}}\left({U}_{i-1}\right)\right) $ | (2) |

其中,

残差单元在网络级联传递中将不可避免遇到信息损失,其造成的信息损失随着网络深度的增加将累积越来越大,最终影响后续细节信息的高分辨率重建。为了避免网络级联传输中的信息损失和加速网络,本文设计了一种多分辨率上采样方案,实现了多个残差单元的输出特征图信息融合,以最大限度地保留细节信息。

为了最大限度地保留低分辨率图像中的细节信息,将低分辨率MR图像的上采样特征图与各残差单元的输出特征图分别融合,因此反卷积层的输入是N+1个特征图,输出是N个融合上采样特征图

| $ {\hat{{y}}}_{{i}}={f}_{{\rm{dec}}}\left({{x}}\right)+{f}_{{\rm{dec}}}\left({U}_{i}\right),\;i = 1,2, \cdots ,N $ | (3) |

其中,

显然,反卷积层输出的融合上采样特征图蕴含着不同分辨率图像信息,对最终的高分辨率MR图像的贡献度也必然不同。因此,提出一种多分辨率学习策略,自适应学习加权融合各分辨率的融合上采样特征图

| $ {{\hat y}} = \sum\limits_{i = 1}^N {{w_i}{{{{\hat y}}}_i}} $ | (4) |

其中,wi表示融合上采样特征图

| $L=\sum\limits_{i=1}^{N}{L}_{i}+{L}_{{\rm{sum}}} $ | (5) |

| $ {L_i} = \frac{1}{2}{\left\| {{{y}} - {{\hat {{y}}}_i}} \right\|^2}$ | (6) |

| $ {L_{{\rm{sum}}}} = \frac{1}{2}{\left\| {{{y}} - \hat {{y}}} \right\|^2} $ | (7) |

其中,y代表真实高分辨率图像。采用随机梯度下降法优化网络,采用梯度裁剪提升收敛性能并抑制梯度爆炸。

2 实验结果与讨论 2.1 数据集与预处理本文实验数据选自癌症医学图像公共数据集(

对于训练集,将真实LR图像裁剪为多个m×m大小的LR图像块。由于反卷积的内在特性[18],对应真实HR图像被裁剪为多个[(m–1)×n+1]×[(m–1)×n+1]大小的HR图像块(n为放大倍数)。本文中,讨论了放大倍数为2、3和4的超分辨率重建。因此,对于×2,×3和×4,训练集中的LR/HR图像块大小分别为142/272, 102/282, 82/292像素;裁剪LR图像的步长分别为11、7和6像素;因此,最终大约有175 000个训练样本。

图像超分辨率通常采用峰值信噪比(Peak Signal-To-Noise Ratio, PSNR)和结构相似性指标(Structural Similarity Index, SSIM)[23]评价重建效果。PSNR通常评价重建图像和真实图像的差异性。SSIM是衡量重建图像与真实图像相似程度的指标。PSNR和SSIM值越大,表示图像重建效果越好。

2.2 网络参数配置及硬件实现采用文献[24]方法初始化权重,权重衰减设置为0.0001,动量为0.9,最小批量为128,epoch为100。初始学习率设置为0.1,每经过20个epoch再衰减10倍。采用PyTorch软件包训练和测试所有的深度学习模型。除非另有说明,否则所有网络模型均在Intel®Core™i5-9600KCPU@3.40 GHz×6和Nvidia GTX2080Ti GPU的电脑上进行训练。所有测试任务均在Intel Xeon E5-2360 v3 CPU2.40 GHz×16且没有GPU的电脑上实现。

2.3 多分辨率上采样的讨论在此讨论多分辨率上采样策略对网络重建效果的影响,将网络中的残差单元数量固定为9个。除了文献[18]中的单上采样策略,本文额外定义了一种双上采样策略以说明低分辨率的MR图像信息的融合对于超分辨率重建也是具有一定作用的。所谓的双上采样是在文献[18]基础上,将低分辨率的MR图像进行上采样后叠加到单采样网络输出,实现融合后的高分辨率MR图像的超分辨率重建。同样,这里放大倍数仅考虑2的情况。

单采样策略网络模型仅仅通过级联残差单元实现由粗到精的特征提取捕获高维特征,因此在低分辨率MR图像的一些细节信息可能会在级联传递过程中逐层损失,影响最终的高分辨率MR图像重建。如表1所示,单采样策略网络模型确实获得了最差的超分辨率重建效果。因为双上采样策略网络模型融合了初始的低分辨率MR图像信息,因此获得了比单采样策略网络模型更高的PSNR和SSIM数值。而本文的多分辨率上采样策略网络则将所有残差单元输出的特征图都传递到多分辨率上采样层,而且分别融合初始的低分辨率MR图像信息,因此获得了最佳的高分辨率MR图像超分辨率重建结果。

| 表 1 网络模型在不同上采样策略下的MR图像超分辨率重建效果(放大倍数为2) Table 1 MR Image SR performance of the proposed network models with different upsampling strategies (Scale factor=2). |

经过以上讨论,将提出的网络模型中的残差单元固定9个,与一些最新的MR图像超分辨率深度学习网络(SRCNN[10],de-CNN[13- 14],FSCWN[16]FSRCNN[17]和ESPCN[19])进行对比。如表2所示,深度学习方法都获得了远优于双三次插值方法的图像超分辨率效果。

| 表 2 MR图像超分辨率重建方法对比 Table 2 MR Image SR performance of various image SR methods |

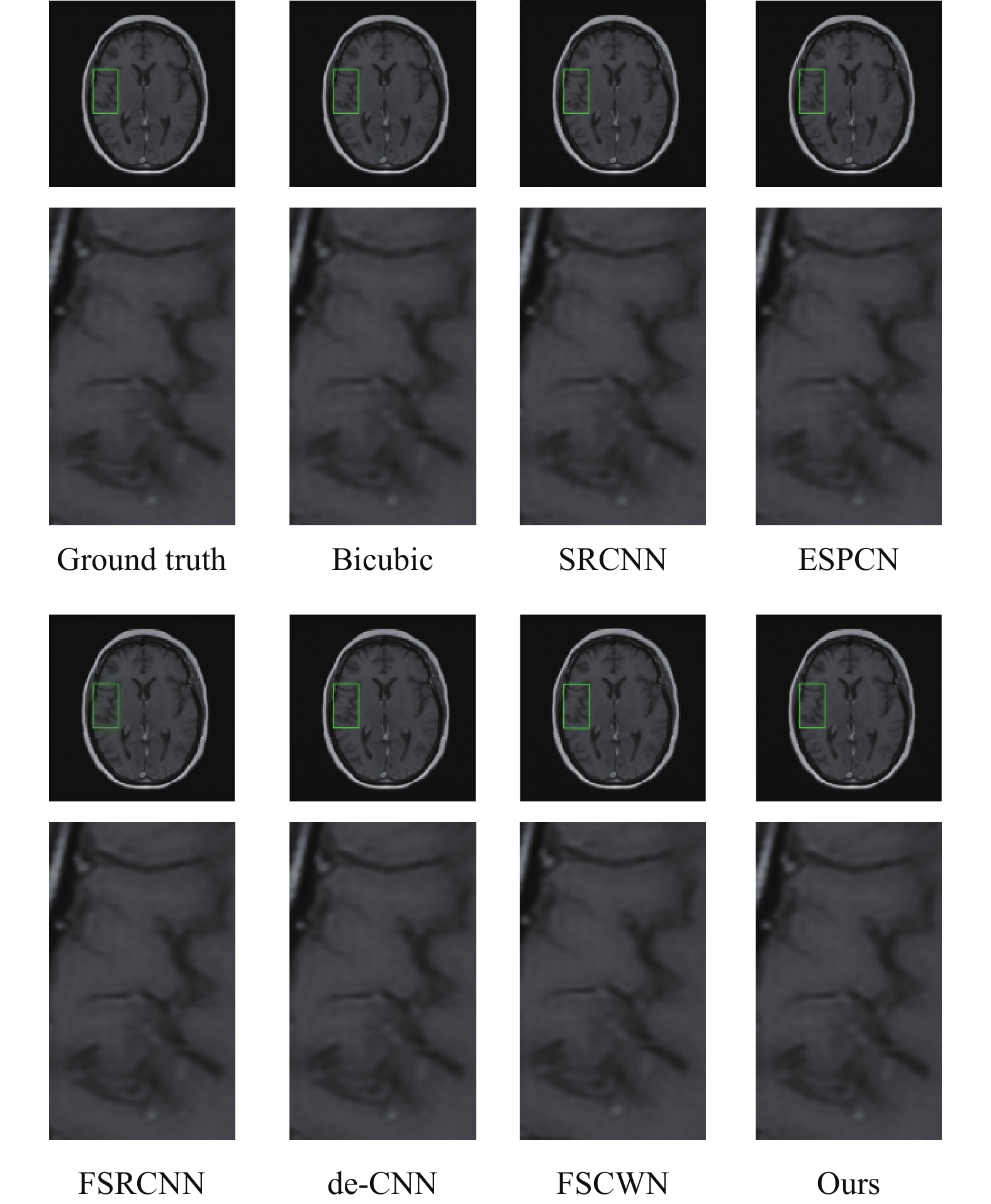

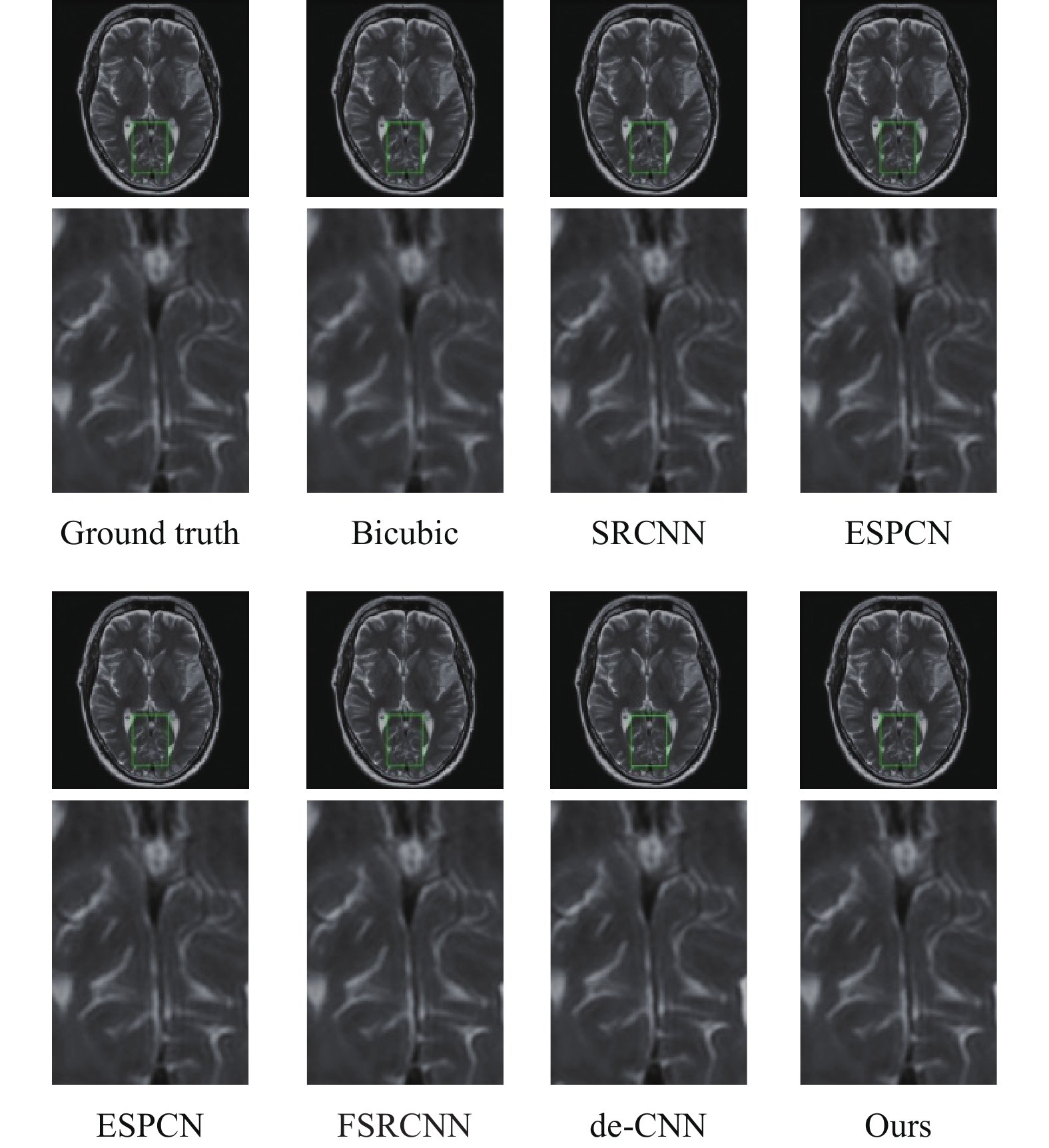

具体评估各深度学习方法,则各有优劣。SRCNN在网络学习之前采用的预先放大策略可能引入一些伪影并丢失一些先验信息,而且该网络仅有3个卷积层,因此SRCNN在所有的深度学习方法中超分辨率重建性能最差。ESPCN和FSRCNN采用两种不同的单上采样策略进行超分辨率重建,可以直接从LR图像中学习LR图像到HR图像之间的非线性映射关系,因此虽然他们的网络深度与SRCNN相差不大,但是获得了优于SRCNN的重建效果。虽然de-CNN和FSCWN采用预先放大策略,但是他们利用残差学习合理地深度级联网络,其网络深度远大于前3个网络模型,因此这两个因素导致de-CNN和FSCWN比ESPCN和FSRCNN获得更高的PSNR和SSIM数值。需要注意的是,由于FSCWN在池化层采用2×2池化缩小图像降低计算量,网络只能直接实现2倍的超分辨率重建。而本文的网络采用了多个残差单元捕获低分辨率MR图像在不同分辨率下的高维特征图,采用多分辨率上采样实现高维特征图和低维特征图(由低分辨率MR图像获取)的融合,避免了图像细节在残差单元级联传递中的信息损失,同时多分辨率学习策略自适应地平衡各分辨率特征图对重建高分辨率MR图像的影响。因此,本文的网络获得了最优的高分辨率MR图像超分辨率重建效果。图3和图4给出了2个超分辨率重建的视觉示例对比(放大倍数为2),其结果与表2展示的客观数据对比是一致的。

|

图 3 MR图像超分辨率重建结果1 Figure 3 Results of the reconstructed No.1 MR images with different algorithms |

|

图 4 MR图像超分辨率重建结果2 Figure 4 Results of the reconstructed No.2 MR images with different algorithms |

尽管训练时间对于深度学习来说是一个重要问题,但是测试时间尤其是在CPU中的测试时间对于实际应用更加至关重要。如表3所示,预先放大策略在HR图像空间进行超分辨率重建,而单上采样策略在LR图像空间进行超分辨率重建,因此当两者网络深度相差不是特别大的时候,前者网络(SRCNN,de-CNN和FSCWN)比后者网络(FSRCNN和ESPCN)花费更多的时间。譬如,SRCNN仅具有9-1-5卷积的3层,其重建耗时就较少。而本文的网络也是一种多分辨率上采样策略,也是在LR图像空间进行超分辨率重建,因此,在网络深度差不多的情况下,本文的网络比预先放大策略网络de-CNN和FSCWN花费更少的时间。可是,与两个单上采样网络FSRCNN(7个卷积层和1个反卷积层,不超过56个卷积核)和ESPCN(3个卷积层和1个像素洗牌层,每个卷积层中不超过64个卷积核)相比,本文的网络具有更多的层(19个卷积层和1个反卷积层)和更多的卷积核(每个卷积层有128个卷积核),因此本文的网络将耗费略多的重建时间。

| 表 3 不同超分辨率重建方法的CPU测试时间 Table 3 Running time for testing via different methods |

MR图像超分辨率对于辅助医学诊断具有重要的研究和显示意义。本文提出了一种基于多分辨率学习卷积神经网络的MR图像超分辨率方法。网络输入是低分辨率MR图像,通过多个残差单元在LR图像空间里进行信息传递,通过多分辨率上采样和多分辨率学习在不同分辨率下充分捕获图像细节,直接实现高分辨率MR图像重建的输出。实验结果表明,对于不同放大倍数(×2,×3和×4),本文的网络可以将PSNR/SSIM值分别提升到45.46 / 0.9914、37.65 / 0.9689、34.09 / 0.9397且CPU测试耗时较少,超分辨率重建效果优于一些最新的MR图像深度学习方法。

由于马尔可夫随机场可以发现HR/LR图像之间的关联性,可以考虑引入马尔可夫随机场减少卷积核数目以进一步加速本文提出的网络。

| [1] |

SHI F, CHENG J, WANG L, et al. LRTV: MR image super-resolution with low-rank and total variation regularizations[J].

IEEE Transactions on Medical Imaging, 2015, 34(12): 2459-2466.

DOI: 10.1109/TMI.2015.2437894. |

| [2] |

PLENGE E, POOT D H J, BERNSEN M, et al. Super-resolution methods in MRI: Can they improve the trade-off between resolution, signal-to-noise ratio, and acquisition time?[J].

Magnetic Resonance in Medicine, 2012, 68(6): 1983-1993.

DOI: 10.1002/mrm.24187. |

| [3] |

WU J, CAI N, LI F, et al. Automatic detonator code recognition via deep neural network[J].

Expert Systems with Applications, 2020, 145: 113121.

DOI: 10.1016/j.eswa.2019.113121. |

| [4] |

FU X, CAI N, HUANG K, et al. M-net: a novel u-net with multi-stream feature fusion and multi-scale dilated convolutions for bile ducts and hepatolith segmentation[J].

IEEE Access, 2019, 7: 148645-148657.

DOI: 10.1109/ACCESS.2019.2946582. |

| [5] |

WU J, CAI N, CHEN W, et al. Automatic detection of hardhats worn by construction personnel: a deep learning approach and benchmark dataset[J].

Automation in Construction, 2019, 106: 102894.

DOI: 10.1016/j.autcon.2019.102894. |

| [6] |

翁韶伟, 彭一航, 危博, 等. 基于Inception-V3网络的双阶段数字视频篡改检测算法[J].

广东工业大学学报, 2019, 36(6): 16-23.

WENG S W, PENG Y H, WEI B, et al. A two-stage-video forgery based on inception-v3 network[J]. Journal of Guangdong University of Technology, 2019, 36(6): 16-23. DOI: 10.12052/gdutxb.190046. |

| [7] |

高俊艳, 刘文印, 杨振国. 结合注意力与特征融合的目标跟踪[J].

广东工业大学学报, 2019, 36(4): 18-23.

GAO J Y, LIU W Y, YANG Z G. Object tracking combined with attention and feature fusion[J]. Journal of Guangdong University of Technology, 2019, 36(4): 18-23. DOI: 10.12052/gdutxb.190039. |

| [8] |

叶武剑, 高海健, 翁韶伟, 等. 基于CGAN网络的二阶段式艺术字体渲染方法[J].

广东工业大学学报, 2019, 36(3): 47-55.

YE W J, GAO H J, WENG S W, et al. A two-stage effect rendering method for art font based on CGAN network[J]. Journal of Guangdong University of Technology, 2019, 36(3): 47-55. DOI: 10.12052/gdutxb.180162. |

| [9] |

HARIS M, SHAKHNAROVICH G, UKITA N. Deep back-projection networks for super-resolution[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Salt Lake City: IEEE, 2018: 1664-1673.

|

| [10] |

PHAM C H, DUCOURNAU A, FABLET R, et al. Brain MRI super-resolution using deep 3D convolutional networks[C]//2017 IEEE 14th International Symposium on Biomedical Imaging. Melbourne: IEEE, 2017: 197-200.

|

| [11] |

DONG C, LOY C C, HE K, et al. Learning a deep convolutional network for image super-resolution[C]//European Conference on Computer Vision. Amsterdam: Springer, Cham, 2014: 184-199.

|

| [12] |

DONG C, LOY CC, HE K, et al. Image super-resolution using deep convolutional networks[J].

IEEE Transactions on Pattern Analysis and Machine Intelligence, 2015, 38(2): 295-307.

|

| [13] |

OKTAY O, BAI W, LEE M, et al. Multi-input cardiac image super-resolution using convolutional neural networks[C]//International Conference on Medical Image Computing and Computer-assisted Intervention. Istanbul: Springer, Cham, 2016: 246-254.

|

| [14] |

GIANNAKIDIS A, OKTAY A O, KEEGAN J. Super-resolution reconstruction of late gadolinium cardiovascular magnetic resonance images using a residual convolutional neural network 25th Scientific Meeting of the Int[C]//International Society for Magnetic Resonance in Medicine. Hawaii: [s.n.], 2017.

|

| [15] |

KIM J, KWON LEE J, MU LEE K. Accurate image super-resolution using very deep convolutional networks[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas: IEEE, 2016: 1646-1654.

|

| [16] |

SHI J, LI Z, YING S, et al. MR image super-resolution via wide residual networks with fixed skip connection[J].

IEEE Journal of Biomedical and Health Informatics, 2018, 23(3): 1129-1140.

|

| [17] |

MCDONAGH S, HOU B, ALANSARY A, et al. Context-sensitive super-resolution for fast fetal magnetic resonance imaging[C]//Molecular Imaging, Reconstruction and Analysis of Moving Body Organs, and Stroke Imaging and Treatment. Canada: Springer, Cham, 2017: 116-126.

|

| [18] |

DONG C, LOY C C, TANG X. Accelerating the super-resolution convolutional neural network[C]//European Conference on Computer Vision. Amsterdam: Springer, Cham, 2016: 391-407.

|

| [19] |

TANNO R, WORRALL D E, GHOSH A, et al. Bayesian image quality transfer with CNNs: exploring uncertainty in dMRI super-resolution[C]//International Conference on Medical Image Computing and Computer-Assisted Intervention. Istanbul: Springer, Cham, 2017: 611-619.

|

| [20] |

SHI W, CABALLERO J, HUSZÁR F, et al. Real-time single image and video super-resolution using an efficient sub-pixel convolutional neural network[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas: IEEE, 2016: 1874-1883.

|

| [21] |

TAI Y, YANG J, LIU X. Image super-resolution via deep recursive residual network[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Hawaii: IEEE, 2017: 3147-3155.

|

| [22] |

HE K, ZHANG X, REN S, et al. Deep residual learning for image recognition[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas: IEEE, 2016: 770-778.

|

| [23] |

WANG Z, BOVIK A C, SHEIKH H R, et al. Image quality assessment: from error visibility to structural similarity[J].

IEEE Transactions on Image Processing, 2004, 13(4): 600-612.

DOI: 10.1109/TIP.2003.819861. |

| [24] |

HE K, ZHANG X, REN S, et al. Delving deep into rectifiers: Surpassing human-level performance on image net classification[C]//Proceedings of the IEEE International Conference on Computer Vision. Boston: IEEE, 2015: 1026-1034.

|

2020, Vol. 37

2020, Vol. 37