| 带洞型U-Net++网络在遥感影像中建筑物的提取方法 |

2. 中煤航测遥感集团有限公司,陕西 西安,710054

2. China Coal Aerial Survey and Remote Sensing Group Co., Ltd., Xi'an 710054, China

建筑物是遥感影像反映地理信息的重要地物目标,利用遥感影像提取建筑物对地表覆盖分类、城市规划、地理信息数据库更新等具有重要意义。传统的监督分类提取大小、色彩、形状各不相同的建筑物,很难得到满意的结果,随着深度学习技术的快速发展,利用语义分割来提取遥感影像中的建筑物成为十分有效的方法[1]。Long等[2]在卷积神经网络(convolutional neural network,CNN)内部使用下采样和上采样结合的方式提出了全卷积网络(fully convolutional networks,FCN)网络,成功实现了图像的语义分割。随后SegNet[3]、U-Net[4]、PSPNet[5]、U-Net++[6]等神经网络相继出现。季顺平等[7]利用改进的U-Net网络在自己构建的大范围和高精度WHU数据集上提取建筑物,但该方法不适用于在少量样本数据上提取建筑物;范荣双等[8]利用CNN结合主成分变换和纹理特征提取的方法在遥感影像上提取建筑物,但该方法精度较低且操作计算繁琐;贺浩等[9]利用Encoder-Decoder结构的网络在Massachusetts数据集中提取道路,但建筑物的纹理和形态比道路要复杂得多。在遥感影像中,建筑物的多尺度多形态等因素会影响建筑物的局部特征与全局特征的提取精度。

本文顾及建筑物的多尺度特征和细节特征,提出了使用少量样本数据的建筑物分割方法,U-Net++网络和扩张卷积相结合,扩大感受野,获取了联系上下文的特征信息。针对少量样本,为避免过拟合和学习出更稳定的模型,本文使用了Dropout结构[10],采用动态缩放的损失函数Focal Loss以解决样本不平衡的情况。该方法适用于少量样本的建筑物提取,优于经典的U-Net和U-Net++网络,增强了遥感影像建筑物分割场景下的泛化能力。

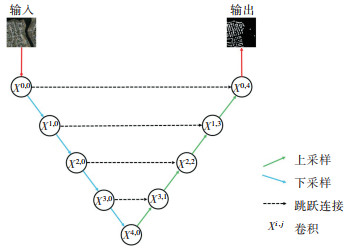

1 带洞型U-Net++网络 1.1 U-Net网络U-Net网络是基于FCN改进的一种全卷积网络,最初应用于医学影像语义分割,其结构形似U,故称U-Net[4],其结构如图 1所示。该网络结构对称清晰,由编码器、解码器和跳跃连接组成,编码器具有提取图像浅层的、低级的、细粒度等特征的功能,解码器用于还原各层的特征图,跳跃连接用于结合来自解码器的高级语义特征图和来自编码器的相应尺度的低级语义特征图。编码器下采样经过两次卷积后再次下采样,解码器上采样中使用反卷积并与对应大小的下采样特征跳跃连接,然后经过两次卷积后再反卷积。该网络具有所需样本数据少、收敛快、分割精度高的特点[10],是经典的语义分割算法。

|

| 图 1 U-Net网络结构 Fig.1 Network Structure of U-Net |

1.2 U-Net++

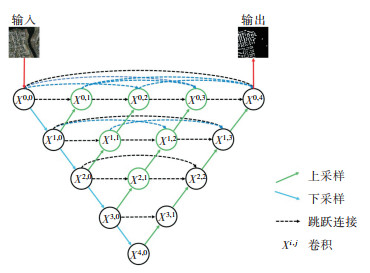

U-Net++在U-Net网络的基础上通过引入嵌套的和密集的跳跃连接进一步减少编码器和解码器之间的语义差距。相对于U-Net网络,U-Net++把不同网络层跳跃连接起来,将深层特征进行上采样引入浅层特征,或者将浅层特征进行下采样引入深层特征,以此弥补编码器与解码器之间的语义丢失,提升模型性能。U-Net++在图像语义分割中表现出良好的性能,但仍无法从遥感影像中多尺度提取足够信息。在遥感影像语义分割中,不同尺度的特征图展示着不同的信息。低层次特征图捕捉丰富的空间信息,能够突出地物的边界;而高级语义特征图则体现了地物所在位置的信息。

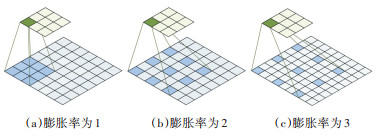

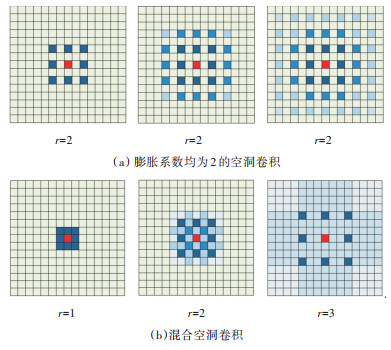

1.3 空洞卷积一个卷积层若要扩大感受野,获取更多的上下文特征信息,一般可以通过3种方式实现:①增加卷积核的大小;②增加层数,比如两层3×3的卷积可以接近一层5×5的卷积效果;③卷积之前进行汇聚操作。前两种方法会增加参数数量,而第3种会丢失一些信息[11]。空洞卷积是一种不增加参数数量同时能扩大单元感受野的方法。如图 2所示,用一个更大的稀疏矩阵来替代传统的卷积核,从而增加卷积的感受野,在保证相同参数量的前提下,空洞卷积能够包含更大的信息范围,从而加强上下文的语义联系。

|

| 图 2 空洞卷积 Fig.2 Dilated Convolution |

与正常卷积相比,空洞卷积多了一个超参数膨胀率,即卷积核卷积时各值的间距。图 2(a)膨胀率为1,卷积后的感受野为3;图 2(b)膨胀率为2,卷积后的感受野为5;图 2(c)膨胀率为3,卷积后的感受野为7。同样一个3×3的卷积,却可以起到5×5、7×7的效果。空洞卷积在不增加参数量的情况扩大感受野,也可以认为普通的正常卷积是一种特殊的空洞卷积。

1.4 带洞型U-Net++针对U-Net++无法从遥感影像中多尺度提取足够信息的问题,本文在FCN中使用空洞卷积,其网络结构如图 3所示。本文利用更大的稀疏矩阵来代替传统的卷积核,以增加卷积的感受野,有效联系图像上下文的特征信息,避免出现局部信息与全局信息利用率失衡导致的图像分割结果粗糙、边界不连续问题。

|

| 图 3 U-Net++网络结构 Fig.3 Network Structure of U-Net++ |

将U-Net++网络特征中编码器特征与下一层编码器上采样特征进行融合,融合后的特征与下一层的上采样特征继续融合,形成迭代,直到下一层没有上采样模块。每一模块的输出结果如下:

| $ {x^{i, j}} = \left\{ {\begin{array}{*{20}{l}} {c\left( {{x^{i - 1, j}}} \right), \;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;j = 0}\\ {\left[ {{x^{i, j - 1}}, u\left( {{x^{i + 1, j - 1}}} \right)} \right], \;\;\;\;\;\;j > 0} \end{array}} \right. $ | (1) |

式中,xi, j表示特征提取模块输出,其中,i表示编码器下采样的层序,j表示同一层模块的序号,j=0表示编码器特征提取模块;c(·)表示卷积操作;u(·)表示上采样;[·]表示特征通道连接[12]。

针对少量样本,本文使用了Dropout策略以避免过拟合和学习出更稳定的模型,即在每个卷积层之后添加Dropout层,训练时让神经网络中的每一个中间层神经元以一定的概率置为0,即不会参与前向传播和反向回传。每当一张图片输入时,网络随机采样出一个新的特征图,有效提升了不同训练间的独立性,从而避免出现过拟合现象,因此训练出的模型也更稳定,提高了遥感影像分割性能。

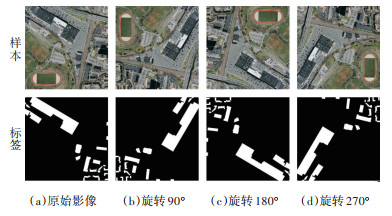

2 实验及结果分析 2.1 实验数据集实验数据为Massachusetts建筑物数据集[13],该数据集含有151张航拍RGB三通道的影像图和单通道的标签构成,像素为1 500×1 500,分辨率为1 m,每张覆盖了2.25 km2,总的覆盖面积达340 km2,是经典的建筑物分割的数据集。本实验从中选出了90张图片,将每张图片滑动窗口剪裁成9张分辨率为512×512的图片,为了扩充样本量,按照90°、180°、270°顺时针旋转。如图 4所示,标签中白色部分为建筑物,黑色为背景,总计构成3 240张样本,其中80%用于训练,20%作为测试集。

|

| 图 4 数据样本增强和标签 Fig.4 Enhancement and Labeling of Data Sample |

针对建筑物和背景的分布不平衡易造成过拟合的情况,本文使用Focal Loss作为损失函数,该损失函数降低了大量简单负样本在训练中所占的权重,使得分割精度有效提升。其公式为:

| $ F = \left\{ {\begin{array}{*{20}{l}} { - \alpha {{\left( {1 - y'} \right)}^\gamma }\ln y', \;\;\;\;\;\;\;\;\;\;y = 1}\\ { - {{\left( {1 - \alpha } \right)}^\gamma }\ln \left( {1 - y'} \right), \;\;\;\;\;y = 0} \end{array}} \right. $ | (2) |

式中,y表示标签;y′表示预测此样本正确的概率为p。引入两个因子,其中γ>0,用于减少易分类样本的损失,使得模型更关注困难、错分的样本;α因子用于平衡正负样本本身的数量比例不平衡的情况。

在下采样过程中使用固定的膨胀系数,会出现形似“筛子”状的卷积来提取影像特征,导致信息丢失。当膨胀系数过小时,采样的数据太密集,会丢失整体信息;过大时,采样的数据太稀疏,会丢失局部信息。

本文引入混合空洞卷积(hybrid dilated convolution,HDC)[14]策略用于减轻扩张卷积产生的这种影响,扩大感受野聚合全局信息。本文采用的数据集影像分辨率为1 m,为了更精确地反映建筑物轮廓的局部细节构造,混合空洞卷积的一组膨胀系数最小值取为1 m,即膨胀系数选取为1、2、3,保持三层连续的混合空洞卷积方法,在保持接受野大小不变的情况下提高信息利用率,同时满足不同尺度建筑物的分割,混合空洞卷积和普通空洞卷积感受野和信息利用率见图 5。

|

| 图 5 混合空洞卷积 Fig.5 Hybrid Dilated Convolution |

2.2 实验结果与分析

在3 240张数据中将80%的作为训练集,另外20%作为测试集,分别对U-Net、带洞型U-Net、U-Net++和带洞型U-Net++进行对比。实验采用TensorFlow1.9和Python3.6在Win10 16 GB内存配置1050 Ti独立显卡实现,训练批尺寸batch_size为4,每次迭代的步长为810,迭代次数为70,损失函数因子α为0.25、γ为2,优化器选择adam。

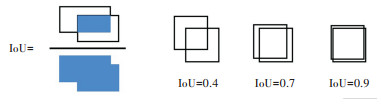

为了准确评判实验结果,采用准确率和交并比(intersection over union,IoU)作为评判标准,其中IoU即真实值和预测值的交集和并集的比,其示意图见图 6。

|

| 图 6 IoU示意图 Fig.6 Diagram of IoU |

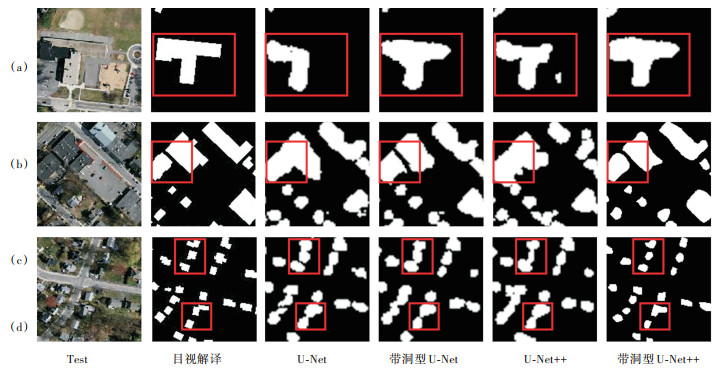

基于实验训练4种模型在验证集上的结果,见图 7,以目视解译为真值,对比结果可以发现:

|

| 图 7 验证集上4种模型分割结果对比 Fig.7 Comparison of the Segmentation Results of Four Models on Validation Set |

1)图 7(a)中,带洞型U-Net++的结果与目视解译结果最为接近,说明带洞型U-Net++对于存在层高落差、有阴影的建筑物具有更加明显的分割效果。

2)图 7(b)中,对于纹理不规则、排列紧密的建筑物,U-Net++明显优于U-Net网络,说明引入嵌套的和密集的跳跃连接能进一步减少编码器和解码器之间的语义差距。

3)图 7(c)、图 7(d)中,对于排列不规则的小型建筑物,U-Net和U-Net++有明显的破碎噪点,加入空洞卷积后,更大的稀疏矩阵确实具有增加卷积的感受野,更广泛地联系图像上下文的特征信息的效果,避免出现局部信息与全局信息利用率失衡导致的图像分割结果粗糙、边界粘连的现象。

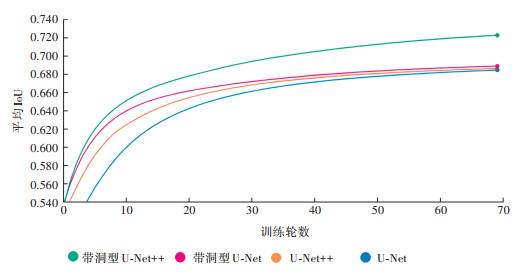

同时,在验证集上比对平均IoU可以看出,带洞型U-Net++远优于U-Net++模型,训练轮数和平均IoU结果如图 8所示。

|

| 图 8 模型训练结果 Fig.8 Model Training Result |

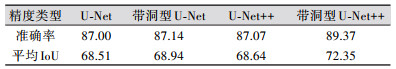

从表 1可以看出:①相较于U-Net,U-Net++结构能更好地提取影像建筑物语义特征,其准确率可达87%,比U-Net高0.07%,平均IoU提高了0.13%。②同一网络下,带洞型网络能够有效提高模型的泛化能力,与U-Net相比,带洞型U-Net准确率提升了0.14%,平均IoU提升了0.43%;带洞型U-Net++的准确率高达89%,较U-Net++相比准确率提升了2.30%,带洞型U-Net++平均IoU高达72.35%,较U-Net++提升了3.71%。

| 表 1 不同分类方法精度统计/% Tab.1 Accuracy Statistics of Different Classification Methods/% |

|

综上所述,带洞型U-Net++在略有遮挡物、建筑物纹理不规则、排列紧密的建筑物分割方面具有很高的精度,明显优于经典的U-Net和U-Net++网络,这说明空洞卷积和Dropout能够明显改善建筑物在高分辨率遥感影像的语义分割精度。

3 结束语深度学习在图像处理中的是热门的研究领域,本文将U-Net++网络和空洞卷积结合起来扩大感受野,获取了联系上下文的特征信息,利用Focal Loss损失函数解决样本不平衡的问题。该方法适用于少量样本的建筑物提取,与经典的U型网络相比,其准确率和平均IoU都有提高。本文在训练模型提取特征时只关注了纹理特征,后续工作考虑将遥感影像丰富的光谱信息和数字表面模型等影响因素引入特征提取环节,以训练更优良的模型,达到更好的分割精度。

| [1] |

Yao Y, Jiang Z G, Zhang H P, et al. Chimney and Condensing Tower Detection Based on Faster R-CNN in High Resolution Remote Sensing Images[C]. 2017 IEEE International Geoscience and Remote Sensing Symposium (IGARSS), SanDiego, California, USA, 2017

|

| [2] |

Long J, Shelhamer E, Darrell T. Fully Convolutional Networks for Semantic Segmentation[C]. 2015 IEEE Confe-rence on Computer Vision and Pattern Recognition (CVPR), Boston, MA, USA, 2015

|

| [3] |

Badrinarayanan V, Kendall A, Cipolla R. SegNet: A Deep Convolutional Encoder-Decoder Architecture for Image Segmentation[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017, 39(12): 2 481-2 495. DOI:10.1109/TPAMI.2016.2644615 |

| [4] |

Ronneberger O, Fischer P, Brox T. U-Net: Convolutio-nal Networks for Biomedical Image Segmentation[C]. Medical Image Computing and Computer-Assisted Intervention - MICCAI 2015, Munich, Germany, 2015

|

| [5] |

Zhao H S, Shi J P, Qi X J, et al. Pyramid Scene Parsing Network[C]. 2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), Honolulu, HI, USA, 2017

|

| [6] |

Zhou Z W, Siddiquee R M M, Tajbakhsh N, et al. UNet++: A Nested U-Net Architecture for Medical Image Segmentation[C]. International Workshop on Deep Learning in Medical Image Analysis, Granada, Spain, 2018

|

| [7] |

季顺平, 魏世清. 遥感影像建筑物提取的卷积神经元网络与开源数据集方法[J]. 测绘学报, 2019, 48(4): 448-459. |

| [8] |

范荣双, 陈洋, 徐启恒, 等. 基于深度学习的高分辨率遥感影像建筑物提取方法[J]. 测绘学报, 2019, 48(1): 34-41. |

| [9] |

贺浩, 王仕成, 杨东方, 等. 基于Encoder-Decoder网络的遥感影像道路提取方法[J]. 测绘学报, 2019, 48(3): 330-338. |

| [10] |

魏溪含, 涂铭, 张修鹏. 深度学习与图像识别: 原理与实践[M]. 北京: 机械工业出版社, 2019.

|

| [11] |

邱锡鹏. 神经网络与深度学习[M]. 北京: 机械工业出版社, 2020.

|

| [12] |

邢妍妍, 杨丰, 唐宇姣, 等. 融合型UNet++网络的超声胎儿头部边缘检测[J]. 中国图象图形学报, 2020, 25(2): 366-377. |

| [13] |

Mnih V. Machine Learning for Aerial Image Labeling[D]. Toronto: University of Toronto, 2013

|

| [14] |

Wang P Q, Chen P F, Yuan Y, et al. Understanding Convolution for Semantic Segmentation[C]. 2018 IEEE Winter Conference on Applications of Computer Vision (WACV), Lake Tahoe, NV, USA, 2018

|

2021, Vol. 46

2021, Vol. 46