| 基于稀疏表示理论的优化算法综述 | [PDF全文] |

2. 深圳大学信息工程学院,广东 深圳,518060

2. College of Information Engineering, Shenzhen University, Shenzhen 518060, China

稀疏表示理论的含义来源于对视神经系统的研究,最早可追溯到1959年[1],之后,Field[2]提出在视觉皮层V1区的简单细胞感受野适合用于图像结构的学习。文献[3]提出字典学习的概念,即将稀疏模型应用于二维图像时,学习到的基于哺乳动物视觉系统主视皮层V1区内神经元的反馈特性相似,并证明了字典学习比传统的基字典表述更准确,自适应性更强。基字典第一次成功地模拟了V1区神经元细胞具有局部性的空间域、具有方向性和选择性的时域和频域的响应特点。而每个神经元对这些响应的表述均满足稀疏表示理论,将图像在边界、线方向等特性以稀疏模型的形式进行描绘。

2006年,文献[4]第一次阐述了压缩感知概念:如果一个信号具有可压缩性,则可以通过很少的观测值去重构原始信号,打破了香农抽样定理要求信号采样率高于信号带宽两倍的局限,为稀疏表示奠定了理论基础。之后,Candes等[5]从数学的角度证明了压缩感知原理,为压缩感知的深入研究奠定了理论基础。稀疏表示理论[6-8]做为压缩感知首个基本要素,它的出现解决了传统信号处理中的多个问题,如就绝大多数信号的稀疏表示可提供一种全新的采样形式,即对采样信号的带宽不作要求,由稀疏性约束取代,从而主信号空间减小,大大减少了采样时间和采样储存空间。

目前,稀疏表示在各个工程应用中都有较好的表现,尤其在模式识别,计算机视觉和图像处理领域中尤为突出。近年来,该理论在测绘遥感领域内也有了较大的突破,如张良培等[9]用稀疏表示理论对高光谱图像做了展望; 刘帆等[10]则将字典学习技术和遥感图像融合相结合; 李丽等[11]在对遥感图像做超分辨率重建过程中利用了非参数下的贝叶斯字典学习。未来,稀疏表示理论还会在更多的领域中崭露头角。

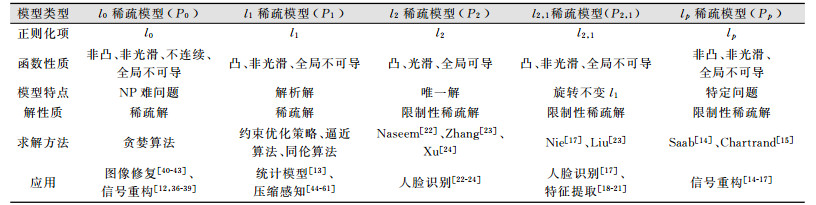

1 稀疏表示模型稀疏表示的基本框架利用原子的线性组合来表示信号,并计算稀疏解,即原子的表示系数,再利用计算出的稀疏解重构信号。根据不同范数正则化的表达形式,稀疏表示可以被严格地分为5种形式:l0范数最小化[12]、l1范数最小化[13]、lp范数(0 < p < 1)最小化[14-16]、l2, 1范数最小化[17-21]和l2范数最小化[22-24]。

1.1 l0范数下的稀疏表示模型假设有一个信号x∈Rm,一观测矩阵或字典D∈Rm×n,D=[d1, d2, …, dn],若m < n,即字典D中的行数小于字典D的原子数,称D为一过完备字典。信号x和字典D可表示为:

| $ \boldsymbol{x}=\boldsymbol{d}_{1} \alpha_{1}+\boldsymbol{d}_{2} \alpha_{2}+\cdots+\boldsymbol{d}_{n} \alpha_{n} $ | (1) |

式中,αi(i=1, 2, …, n)就是原子di的系数,也称为解系数,α∈Rn,式(1)可简写成:

| $ \boldsymbol{x}=\boldsymbol{D \alpha} $ | (2) |

式中,解系数α=[α1, α2, …, αn]T。

因为D为一过完备字典,即式(2)为欠定线性系统,若对于稀疏解α没有任何约束条件或先验知识,式(2)会变为病态问题,无唯一解。按照稀疏表示理论的要求,解系数α必须是稀疏的,所谓稀疏性指的是α中只有有限个非零元素,而其他元素均等于或接近等于零。

对于式(2)可以通过l0范数最小化约束[25]求得稀疏解α,则式(2)会变为优化问题(P0):

| $ \left(P_{0}\right) : \hat{\boldsymbol{\alpha}}=\operatorname{argmin}\|\boldsymbol{\alpha}\|_{0}使得\boldsymbol{x}=\boldsymbol{D \alpha} $ | (3) |

式中,‖·‖0表示向量中非零元素的个数,也称为稀疏性度量,如果D中只有k(k < n)个原子用来线性表示信号x,式(3)等同于如下优化问题:

| $ \boldsymbol{x}=\boldsymbol{D \alpha}使得\|\boldsymbol{a}\|_{0} \leqslant k $ | (4) |

式(4)称为k稀疏估计问题,若加上噪声,则式(2)变为:

| $ \boldsymbol{x=D \alpha+\eta} $ | (5) |

式中,η∈Rm为上界‖η‖2≤ε的噪声,则式(3)和式(4)变为:

| $ \hat{\boldsymbol{\alpha}}=\operatorname{argmin}\|\boldsymbol{x}-\boldsymbol{D} \boldsymbol{\alpha}\|_{2}^{2}使得\|\boldsymbol{\alpha}\|_{0} \leqslant \varepsilon $ | (6) |

根据拉格朗日乘子法,取一合适的拉格朗日乘子λ,可以将式(6)变为无约束优化问题:

| $ \hat{\boldsymbol{\alpha}}=L(\boldsymbol{\alpha}, \lambda)=\operatorname{argmin}\|\boldsymbol{x}-\boldsymbol{D} \boldsymbol{\alpha}\|_{2}^{2}+\lambda\|\boldsymbol{\alpha}\|_{0} $ | (7) |

解l0范数最小化问题可以得到字典D下的稀疏解α,但该问题属多项式复杂程度的非确定性(non-deterministic polynomial, NP)问题,难以得到准确解[26]。不过,2003年,Donoho[27]证明了稀疏解的唯一性,随后Candès等[28, 29]进一步证明了对于一个k稀疏信号x,字典D必须满足约束等距条件,则l0范数最小化问题和l1范数最小化问题等价。

此外,l1范数最小化问题在多项式的时间里有解析解。可以看出,l1范数最小化问题的提出丰富了稀疏表示的内容。同样,和(P0)一样,(P1)记为:

| $ \left(P_{1}\right) : \operatorname{argmin}\|\boldsymbol{x-D \alpha}\|_{2}^{2}使得\|\boldsymbol{\alpha}\|_{1} \leqslant \varepsilon $ | (8) |

| $ \hat{\boldsymbol{\alpha}}=L(\boldsymbol{\alpha}, \lambda)=\arg \min _{\boldsymbol{\alpha}} \frac{1}{2}\|\boldsymbol{x}-\boldsymbol{D} \boldsymbol{\alpha}\|_{2}^{2}+\lambda\|\boldsymbol{\alpha}\|_{1} $ | (9) |

式中,λ∈[0, 1];ε取较小的正数。本文λ和ε取值要求相同。

1.3 lp范数(0 < p < 1)下的稀疏表示模型一般的稀疏表示方法是为了解lp范数最小化问题,除了(P0)和(P1),一些专家试着去求解当p=0.1、0.5、0.9时, lp范数最小化(0 < p < 1)[30],与(P0)和(P1)一样,Pp记为:

| $ \begin{array}{c}{\left(P_{p}\right) : \hat{\boldsymbol{\alpha}}=L(\boldsymbol{\alpha}, \lambda)=} \\ {\arg \min\limits_{\boldsymbol{\alpha}}\|\boldsymbol{x}-\boldsymbol{D} \boldsymbol{\alpha}\|_{2}^{2}+\lambda\|\boldsymbol{\alpha}\|_{p}^{p}}\end{array} $ | (10) |

尽管(Pp)在建立稀疏表示模型时并不常用,但同样也对稀疏表示理论的发展作出重要影响。

1.4 l2范数和l2, 1范数下的稀疏表示模型解l2范数最小化下的稀疏表示模型,得到的稀疏解在严格意义上并不稀疏,仅是有限稀疏,没能达到充分稀疏[31],(P2)记为:

| $ \left(P_{2}\right) : \operatorname{argmin}\|\boldsymbol{\alpha}\|_{2}^{2}使得\|\boldsymbol{x-D \alpha}\|_{2}^{2} \leqslant \varepsilon $ | (11) |

| $ \hat{\boldsymbol{\alpha}}=L(\boldsymbol{\alpha}, \lambda)=\arg \min\limits_{\boldsymbol{\alpha}}\|\boldsymbol{x}-\boldsymbol{D} \boldsymbol{\alpha}\|_{2}^{2}+\lambda\|\boldsymbol{\alpha}\|_{2}^{2} $ | (12) |

l2, 1范数又被称作旋转不变的l1范数,它的提出克服了离散值对于模型鲁棒性的影响。基于l2, 1范数稀疏表示模型的目标方程为:

| $ \left(P_{2, 1}\right) ; \operatorname{argmin}\|\boldsymbol{X}-\boldsymbol{D} \boldsymbol{A}\|_{2, 1}+\mu\|\boldsymbol{A}\|_{2, 1} $ | (13) |

式中,X=[x1, x2, …, xn]为样本组成的矩阵,A=[a1, a2, …, an]为字典D的系数矩阵;μ∈[0, 1]为较小的正数。

2 基于稀疏表示模型的优化算法优化稀疏表示模型的算法可以分为贪婪算法、约束优化策略、逼近算法以及同伦算法4种。

2.1 贪婪算法贪婪算法[32]的核心思想:确定样本和原子之间的位置关系,用最小二乘法去估计幅值。之前笔者提到(P0)本身是一个NP难问题,需要转化成(P1)问题去求解。在针对(P0)时,贪婪算法提供了一种思路,虽然不能直接求解(P0)问题,但可以找到(P0)问题的近似解。

早期经典的贪婪算法包括Mallat等提出的匹配追踪算法[33]和Pati等提出的正交匹配追踪算法[34]。匹配追踪的基本思想是在每次迭代中从D中选出最匹配的原子,并计算信号残差,继续选择与信号残差最匹配的原子再计算信号残差,反复迭代,由于得出的每个信号残差都比之前的残差小,故算法收敛。而正交匹配追踪是匹配追踪的改进版,即在分解的每一步对所选择的全部原子进行正交化处理,在精度要求相同的情况下,使算法的收敛速度更快。更多基于上述算法的改进方法被提出:Donoho等[35]提出了分阶式正交匹配追踪;Dai等[36]提出了子空间追踪;Do等[37]结合了最大期望(expectation-maximization algorithm, EM)算法,提出了一种稀疏自适应匹配追踪算法分别估计稀疏度和支撑集;Jost等[38]在高度冗余的字典里对相同的原子进行分类时,提出了一种树形匹配追踪算法;La等[39]基于上述算法提出了树形正交匹配追踪算法,该算法将稀疏树形表示作为先验知识,使用很少部分的样本估计出线性逆系统;近年来,稀疏表示理论在图像修复领域又有了较大发展,提出了后向追踪算法[40]、块结构稀疏[41]、颜色梯度的块结构稀疏[42]、多方向颜色梯度的块结构稀疏[43]等新理论。

贪婪算法是通过每一步贪心选择得到问题的一个最优解,虽然每一步都要保证能获得局部最优解,但由此产生的全局解有时不一定是最优的,或只是对全局解的一个近似解。

2.2 约束优化策略约束优化策略[44-48]是为了解l1范数最小化稀疏表示模型,如式(9)所示,该策略的核心思想是将无约束不可导问题变为光滑约束可导的优化问题,通过约束优化方法的快速收敛得到模型的稀疏解。下面分别介绍约束优化策略的梯度投影稀疏重建法[44]和交替方向乘子法[47]两种经典算法。

1) 梯度投影稀疏重建法。梯度投影稀疏表示的核心思想是沿着梯度下降的方向找到稀疏解,最关键的步骤为任意的α值都可由正项系数α+和负项系数α-组成:

| $ \boldsymbol{\alpha}=\boldsymbol{\alpha}_{+}-\boldsymbol{\alpha}_{-}, \boldsymbol{a}_{+} \geqslant 0, \boldsymbol{\alpha}_{-} \geqslant \bf{0} $ | (14) |

式中, 算子(·)+表示取正项部分,即(x)+={0, x}max。‖α‖1=1dTα++1dTα-,1dT=

| $ \begin{array}{c} \arg \min L(\boldsymbol{\alpha})=\arg \min \frac{1}{2}\left\|\boldsymbol{x}-\boldsymbol{D}\left[\boldsymbol{\alpha}_{+}-\boldsymbol{\alpha}_{-}\right]\right\|_{2}^{2}+\\ \lambda\left(\bf{1}_{d}^{\mathrm{T}} \boldsymbol{a}_{+}+\bf{1}_{d}^{\mathrm{T}} \boldsymbol{\alpha}_{-}\right)使得\boldsymbol{a}_{+} \geqslant \bf{0}, \boldsymbol{\alpha}_{-} \geqslant \bf{0} \end{array} $ | (15) |

或

| $ \begin{array}{c}{\arg \min L(\boldsymbol{\alpha})=} \\ {\arg \min \frac{1}{2}\left\|x-\left[\boldsymbol{D}_{+}-\boldsymbol{D}_{-}\right]\left[\boldsymbol{\alpha}_{+}-\boldsymbol{\alpha}_{-}\right]\right\|_{2}^{2}+}\\ \lambda\left(\bf{1}_{d}^{\mathrm{T}} \boldsymbol{\alpha}_{+}+\bf{1}_{d}^{\mathrm{T}} \boldsymbol{\alpha}_{-}\right)使得\boldsymbol{\alpha}_{+} \geqslant \bf{0}, \boldsymbol{\alpha}_{-} \geqslant \bf{0}\end{array} $ | (16) |

式(16)可重写为:

| $ \arg \min G(\boldsymbol{z})=\boldsymbol{c}^{\mathrm{T}} \boldsymbol{z}+\frac{1}{2} \boldsymbol{z}^{\mathrm{T}} \boldsymbol{A z}使得\boldsymbol{z }\geqslant \boldsymbol{0} $ | (17) |

式中,

该算法运用梯度下降和标准线搜索方法[45]求解式(17)。z值可通过迭代获得:

| $ \operatorname{argmin} \boldsymbol{z}^{t+1}=z^{t}-\sigma \nabla G\left(\boldsymbol{z}^{t}\right) $ | (18) |

梯度

| $ \sigma^{t}=\arg \min\limits_{\sigma} G\left(z^{t}-\sigma \boldsymbol{g}^{t}\right) $ | (19) |

gt被定义为:

| $ \boldsymbol{g}_{i}^{t}=\left\{ \begin{array}{l} {\left( {\nabla G\left( {{\mathit{\boldsymbol{z}}^t}} \right)} \right)_i}, \mathit{\boldsymbol{z}}_i^t > 0或{\left( {\nabla G\left( {{\mathit{\boldsymbol{z}}^t}} \right)} \right)_i} < 0\\ 0, 其他 \end{array} \right. $ | (20) |

式(19)可写成封闭解形式:

| $ \sigma^{t}=\frac{\left(\boldsymbol{g}^{t}\right)^{\mathrm{T}}\left(\boldsymbol{g}^{t}\right)}{\left(\boldsymbol{g}^{t}\right)^{\mathrm{T}} \boldsymbol{A}\left(\boldsymbol{g}^{t}\right)} $ | (21) |

梯度投影稀疏重建采用回溯线搜索方法[45]确保在每一次迭代中,梯度下降步长为最优值,该回溯线搜索方法的停止条件必须满足:

| $ \begin{array}{*{20}{c}} {G{{\left( {{\mathit{\boldsymbol{z}}^t} - {\sigma ^t}\nabla G\left( {{\mathit{\boldsymbol{z}}^t}} \right)} \right)}_ + } > G\left( {{\mathit{\boldsymbol{z}}^t}} \right) - \beta \nabla G{{\left( {{\mathit{\boldsymbol{z}}^t}} \right)}^{\rm{T}}}X}\\ {\left( {{\mathit{\boldsymbol{z}}^t} - \left( {{\mathit{\boldsymbol{z}}^t} - {\sigma ^t}\nabla G\left( {{\mathit{\boldsymbol{z}}^t}} \right)} \right)_+ } \right)} \end{array} $ | (22) |

式中,β取一较小常量。

2) 交替方向乘子法。交替方向乘子法的核心思想为在求解l1范数最小化稀疏表示模型时,通过引入辅助变量s∈Rd,将式(12)转换为如下形式的约束问题:

| $ \arg \min\limits_{\alpha \cdot s} \frac{1}{2 \xi}\|\boldsymbol{s}\|_{2}^{2}+\|\boldsymbol{\alpha}\|_{1}使得\boldsymbol{s=x-D \alpha} $ | (23) |

将式(23)变为增广拉格朗日方程:

| $ \begin{aligned} \arg \min\limits_{\boldsymbol{\alpha}, \boldsymbol{s}, \boldsymbol{\omega}}(\boldsymbol{\alpha}, \boldsymbol{s}, \boldsymbol{\omega}) &=\frac{1}{2 \xi}\|\boldsymbol{s}\|_{2}^{2}+\|\boldsymbol{\alpha}\|_{1}-\\\langle\boldsymbol{\omega}, \boldsymbol{s}+\boldsymbol{D} \boldsymbol{\alpha}-\boldsymbol{x}\rangle &+\frac{\mu}{2}\|\boldsymbol{s}+\boldsymbol{D} \boldsymbol{\alpha}-\boldsymbol{x}\|_{2}^{2} \end{aligned} $ | (24) |

式中,ξ为逼近参数;ω∈Rd代表拉格朗日乘子向量;μ为惩罚参数。其通用框架为:

| $ \left\{\begin{array}{l}{\boldsymbol{s}^{t+1}=\arg \min L\left(\boldsymbol{s}, \boldsymbol{\alpha}^{t}, \boldsymbol{\omega}^{t}\right)} \\ {\boldsymbol{\alpha}^{t+1}=\arg \min L\left(\boldsymbol{s}^{t+1}, \boldsymbol{\alpha}, \boldsymbol{\omega}^{t}\right)} \\ {\boldsymbol{\omega}^{t+1}=\boldsymbol{\omega}^{t}-\mu\left(\boldsymbol{s}^{t+1}+\boldsymbol{D} \boldsymbol{\alpha}^{t+1}-\boldsymbol{x}\right)}\end{array}\right. $ | (25) |

首先,对于式(25)中第一个公式,有:

| $ \begin{array}{l}{\arg \min L\left(\boldsymbol{s}, \boldsymbol{\alpha}^{t}, \boldsymbol{\omega}^{t}\right)=\frac{1}{2 \xi}\|\boldsymbol{s}\|_{2}^{2}+\left\|\boldsymbol{\alpha}^{t}\right\|_{1}-} \\ {\left(\boldsymbol{\omega}^{t}\right)^{\mathrm{T}} \times\left(\boldsymbol{s}+\boldsymbol{D} \boldsymbol{\alpha}^{t}-\boldsymbol{x}\right)+\frac{\mu}{2}\left\|\boldsymbol{s}+\boldsymbol{D} \boldsymbol{\alpha}^{t}-\boldsymbol{x}\right\|_{2}^{2}=} \\ {\frac{1}{2 \xi}\|\boldsymbol{s}\|_{2}^{2}-\left(\boldsymbol{\omega}^{t}\right)^{\mathrm{T}} \boldsymbol{s}+\frac{\mu}{2}\left\|\boldsymbol{s}+\boldsymbol{D} \boldsymbol{\alpha}^{t}-\boldsymbol{x}\right\|_{2}^{2}+} \\ {\left\|\boldsymbol{\alpha}^{t}\right\|_{1}-\left(\boldsymbol{\omega}^{t}\right)^{\mathrm{T}}\left(\boldsymbol{D} \boldsymbol{\alpha}^{t}-\boldsymbol{x}\right)}\end{array} $ | (26) |

式(26)关于s的解为:

| $ \boldsymbol{s}^{t+1}=\frac{\xi}{1+\mu \xi}\left(\boldsymbol{\omega}^{t}-\mu\left(\boldsymbol{x-D \alpha}^{t}\right)\right) $ | (27) |

再者,对于式(25)中第二个公式,有:

| $ \begin{array}{c}{\arg \min L\left(\boldsymbol{s}^{t+1}, \boldsymbol{\alpha}, \boldsymbol{\omega}^{t}\right)=\frac{1}{2 \xi}\left\|\boldsymbol{s}^{t+1}\right\|_{2}+} \\ {\|\boldsymbol{\alpha}\|_{1}-(\boldsymbol{\omega})^{\mathrm{T}} \times\left(\boldsymbol{s}^{t+1}+\boldsymbol{D} \boldsymbol{\alpha}-\boldsymbol{x}\right)+} \\ {\frac{\mu}{2}\left\|\boldsymbol{s}^{t+1}+\boldsymbol{D} \boldsymbol{\alpha}-\boldsymbol{x}\right\|_{2}^{2}}\end{array} $ | (28) |

等价于:

| $ \begin{array}{l}{\arg \min \left\{\|\boldsymbol{\alpha}\|_{1}-\left(\boldsymbol{\omega}^{t}\right)^{\mathrm{T}}\left(\boldsymbol{s}^{+1}+\boldsymbol{D} \boldsymbol{\alpha}-\boldsymbol{x}\right)+\right.} \\ {\frac{\mu}{2}\left\|\boldsymbol{s}^{t+1}+\boldsymbol{D} \boldsymbol{\alpha}-\boldsymbol{x}\right\|_{2}^{2} \}=\|\boldsymbol{\alpha}\|_{1}+} \\ {\frac{\mu}{2}\left\|\boldsymbol{s}^{t+1}+\boldsymbol{D} \boldsymbol{\alpha}-\boldsymbol{x}-\boldsymbol{\omega}^{t} / \mu\right\|_{2}^{2}=} \\ {\|\boldsymbol{\alpha}\|_{1}+f(\boldsymbol{\alpha})}\end{array} $ | (29) |

式中,

| $ \begin{aligned} \arg \min \{ &\|\boldsymbol{\alpha}\|_{1}-\left(\boldsymbol{\alpha}-\boldsymbol{\alpha}^{\mathrm{T}}\right) \boldsymbol{X}^{\mathrm{T}}\left(\boldsymbol{s}^{t+1}+\boldsymbol{D} \boldsymbol{\alpha}-\right.\\ & \boldsymbol{x}-\boldsymbol{\omega}^{t} / \mu )+\frac{1}{2 \xi}\left\|\boldsymbol{\alpha}-\boldsymbol{\alpha}^{\mathrm{T}}\right\|_2^2 \} \end{aligned} $ | (30) |

式(30)的解可通过软阈值算子得到:

| $ \boldsymbol{\alpha}^{t+1}=\operatorname{soft}\left\{\boldsymbol{\alpha}^{t}-\xi \boldsymbol{X}^{\mathrm{T}}\left(\boldsymbol{s}^{t+1}+\boldsymbol{D} \boldsymbol{\alpha}-\boldsymbol{x}-\boldsymbol{\omega}^{t} / \mu\right), \frac{\xi}{\mu}\right\} $ | (31) |

为了求解非光滑约束凸优化逼近算法提出了[49-55],用式(9)求解l1范数最小化稀疏表示模型。该算法的核心思想是将大规模分布式的、非光滑的约束优化问题分解简单子问题的组合,利用逼近算子分别去求解这些子问题,提高运算效率。

经典的逼近算法包括软阈值或收缩算子、迭代收缩阈值算法[49]、快速迭代收缩阈值算法[50]、l1/2范数正则化稀疏重建[51]、可分近似稀疏重建以及增广拉格朗日乘子法等。下面分别介绍比较常用的软阈值和快速收缩阈值算法。

1) 软阈值或收缩算子。首先,式(9)有封闭解:

| $ \boldsymbol{\alpha}^{*}=\min\limits_{\boldsymbol{\alpha}} h(\boldsymbol{\alpha})=\lambda\|\boldsymbol{\alpha}\|_{1}+\frac{1}{2}\|\boldsymbol{\alpha}-\boldsymbol{s}\|^{2}=\\~~~~~~~~\sum\limits_{j=1}^{n} \lambda\left|\boldsymbol{\alpha}_{j}\right|+\sum\limits_{j=1}^{n} \frac{1}{2}\left(\boldsymbol{\alpha}_{j}-\boldsymbol{s}_{j}\right)^{2} $ | (32) |

式中,α*是式(32)的最优解;h(α)为式(9)的简单形式;s∈Rd为辅助向量;λ>0为阈值。得出以下结论:①

式(32)的解为:

| $ \boldsymbol{\alpha}_{j}^{*}=\left\{\begin{array}{cc}{\boldsymbol{s}_{j}-\lambda, } & {\boldsymbol{s}_{j}>\lambda} \\ {\boldsymbol{s}_{j}+\lambda, } & {\boldsymbol{s}_{j}<-\lambda} \\ {0, } & {其他}\end{array}\right. $ | (33) |

综上所述,解α*=shrink(s, λ),shrink(s, λ)j=sign(sj)max{|sj|-λ, 0},shrink(·)可看成逼近算子。

2) 快速迭代收缩阈值算法。该算法是迭代收缩阈值算法的改进版,不仅提升了效率,还在求解过程中全局收敛。该算法中,将汉森矩阵由标量取代,并使用了梯度∇f(α)的最小里普利茨常数去估计汉森矩阵F,即L(f)=2λmax(DTD),则目标方程可变为:

| $ \begin{aligned} f(\boldsymbol{\alpha}) \approx \frac{1}{2}\left\|\boldsymbol{D} \boldsymbol{\alpha}^{t}-\boldsymbol{x}\right\|_{2}^{2}+\left(\boldsymbol{\alpha}-\boldsymbol{\alpha}^{t}\right)^{\mathrm{T}} \boldsymbol{D}^{\mathrm{T}}\left(\boldsymbol{D} \boldsymbol{\alpha}^{t}-\boldsymbol{x}\right)+& \\ \frac{L}{2}\left(\boldsymbol{\alpha}-\boldsymbol{\alpha}^{t}\right)^{\mathrm{T}}\left(\boldsymbol{\alpha}-\boldsymbol{\alpha}^{t}\right)=P_{t}\left(\boldsymbol{\alpha}, \boldsymbol{\alpha}^{t}\right) \end{aligned} $ | (34) |

方程的解为:

| $ \boldsymbol{\alpha}^{t+1}=\arg \min \frac{L}{2}\left\|\boldsymbol{\alpha}-\theta\left(\boldsymbol{\alpha}^{t}\right)\right\|_{2}^{2}+l\|\boldsymbol{\alpha}\|_{1} $ | (35) |

为了加速算法的收敛速度,算法改进了迭代点序列,取代了之前使用两个点{αt, αt-1}的线性组合,改进的表达式为:

| $ \boldsymbol{\alpha}^{t}=\boldsymbol{\alpha}^{t}+\frac{\mu^{t}-1}{\mu^{t+1}}\left(\boldsymbol{\alpha}^{t}-\boldsymbol{\alpha}^{t-1}\right) $ | (36) |

式中,μt为正向序列,需满足μt≥ t+1 /2。

根据上述4种算法可知,这些算法是为了提高优化逼近算法的效率而提出的。如Elad等[52]提出了一种平行坐标下降迭代算法,该算法求解了线性最小平方非二次正则化问题。Donoho等[53]受置信传播算法的启发,改进了迭代阈值算法,提出了一种估计消息传播算法,将稀疏下采样问题等价于凸优化问题去求解。Becker等[54]在Nesterov一阶光滑框架下提出了一种广义的Nesterov算法,增加了求解模型的效率和灵活性。随后,Becker等[55]又在此基础上重新构建了另一广义凸锥模型的求解模板,该模板采用最优一阶方法,解决了原优化问题二次曲线公式的对偶问题,即解决了相关类型的大规模压缩传感重建问题。

2.4 同伦算法同伦算法[56-61]的核心思想起源于拓扑学,主要求解非线性方程组问题,该算法通过跟踪路径从而求得复杂方程组的解,是一种大范围的收敛算法。对于稀疏表示问题,同伦算法的提出是求解带有l1范数的最小二乘问题[56],近年来,相继提出基于卷积稀疏表示的同伦算法,如最小角度回归[57]、正交匹配追踪和多面型脸追踪[58]等算法。对比最小角度回归和正交匹配追踪两种算法,同伦算法通过从有效集中加上或减去元素,有效连续地更新稀疏解,目前,基于同伦思想的l1范数最小化稀疏表示模型的求解算法主要有拉索同伦法[59]、基追踪去噪同伦法[57]和范数迭代重加权同伦法[61]3种。

拉索同伦算法是为了求解(P1), (P1)为:

| $ \left(P_{1}\right) : \operatorname{argmin}\|\boldsymbol{\alpha}\|_{1} 使得\boldsymbol{x=D \alpha} $ | (37) |

| $ \hat{\boldsymbol{\alpha}}=\arg \min _{\boldsymbol{\alpha}} \lambda\|\boldsymbol{\alpha}\|_{1}使得\|\boldsymbol{x-D \alpha}\|_{2}^{2} \leqslant \varepsilon $ | (38) |

通过在参数l2, 1大范围下降的情形下,跟踪所有同伦解路径。在选取合适的参数值的条件下式(9)等价于式(37),通过改变λ值,式(9)的解收敛到式(37)的解。

根据凸优化基本思想可知,零向量必须是子梯度的解。在给定任意λ值的条件下,可以得到关于α的式(9)的子梯度:

| $ \frac{\partial L}{\partial \boldsymbol{\alpha}}=-\boldsymbol{D}^{\mathrm{T}}(\boldsymbol{x}-\boldsymbol{D} \boldsymbol{\alpha})+\lambda \partial\|\boldsymbol{\alpha}\|_{1} $ | (39) |

式中,第一项DT(x-Dα)叫做残差向量;λ为一参数;子梯度∂‖ α ‖1为:

| $ \partial\|\boldsymbol{\alpha}\|_{1}=\left\{\theta \in R^{N} | \begin{array}{l}{\theta_{i}=\operatorname{sgn}\left(\boldsymbol{\alpha}_{i}\right), \boldsymbol{\alpha}_{i} \neq 0} \\ {\theta_{i} \in[-1, 1], \boldsymbol{\alpha}_{i}=0}\end{array}\right\} $ | (40) |

定义Λ和u分别为α的支撑集和α在支撑集Λ上的符号序列,考虑到式(14)需满足KKT(Karush- Kuhn-Tucker)条件,得到式(9)的两个相等价的条件:

| $ \left\{ {\begin{array}{*{20}{l}} {\mathit{\boldsymbol{D}}_\mathit{\Lambda }^{\rm{T}}(\mathit{\boldsymbol{x}} - \mathit{\boldsymbol{D\alpha }}) = \lambda \mathit{\boldsymbol{u}}}\\ {{{\left\| {\mathit{\boldsymbol{D}}_{{\mathit{\Lambda }^c}}^{\rm{T}}(\mathit{\boldsymbol{x}} - \mathit{\boldsymbol{D\alpha }})} \right\|}_\infty } \le \lambda } \end{array}} \right. $ | (41) |

式中,Λc为支撑集Λ的补集。当减小λ的值到λ-τ时,τ为步长并取较小值,须满足下式:

| $ \begin{array}{l}{\boldsymbol{D}_{\mathit{\Lambda }}^{\mathrm{T}}(\boldsymbol{x}-\boldsymbol{D} \boldsymbol{\alpha})+\tau \boldsymbol{D}_{\mathit{\Lambda }}^{\mathrm{T}} \boldsymbol{D} \boldsymbol{\delta}=(\lambda-\tau) \boldsymbol{u}} \\ {\|\boldsymbol{p}+\tau \boldsymbol{q}\|_{\infty} \leqslant \lambda-\tau}\end{array} $ | (42) |

式中,

| $ \boldsymbol{\delta}_{l}=\left\{\begin{array}{l}{\boldsymbol{D}_{\mathit{\Lambda }}^{\mathrm{T}} \boldsymbol{D}_{\mathit{\Lambda }} \boldsymbol{\delta}_{l}} \\ {\boldsymbol{0}}\end{array}\right. $ | (43) |

同论算法通过跟踪同伦解的路径计算步长τ,得到临界点。可以通过计算τl*=min(τl+, τl-)得到临界点的最小步长,τl+和τl-为:

| $ \tau _l^ + = {\min\limits_{i \in {\mathit{\Lambda }^c}}}{\left( {\frac{{\lambda - {\mathit{\boldsymbol{p}}_i}}}{{1 - \mathit{\boldsymbol{x}}_i^{\rm{T}}{\mathit{\boldsymbol{X}}_\mathit{\Lambda }}{\mathit{\boldsymbol{\delta }}_l}}}, \frac{{\lambda + {\mathit{\boldsymbol{p}}_i}}}{{{\bf{1}} + \mathit{\boldsymbol{x}}_i^{\rm{T}}{\mathit{\boldsymbol{X}}_\mathit{\Lambda }}{\mathit{\boldsymbol{\delta }}_l}}}} \right)_ + } $ | (44) |

| $ \tau _l^ - = \mathop {\min }\limits_{i \in \mathit{\Lambda }} {\left( {\frac{{ - \mathit{\boldsymbol{\alpha }}_l^i}}{{\mathit{\boldsymbol{\delta }}_l^i}}} \right)_ + } $ | (45) |

式中,

稀疏解通过下式更新:

| $ \boldsymbol{\alpha}_{l+1}=\boldsymbol{\alpha}_{l}+\tau_{l}^{*} \boldsymbol{\delta} $ | (46) |

同伦算法通过反复计算步长τ和更新方向δ更新同伦解以及相关的支撑集和符号序列,直到满足条件‖p‖∞=0,式(37)得到解。

3 讨论综上所述,笔者介绍了5种主流的稀疏表示模型和4种比较常用的求解稀疏模型的优化算法如表 1所示。从压缩感知中引出最早的稀疏表示理论,其核心作用是降维,即用最少的数据去线性表示庞大的原始数据。要想得到稀疏解,该模型必须是在l0正则化项下才能求出,否则模型就失去最初的意义。由于l0范数下的模型非凸且全局不可导,所以贪婪算法在求解上述模型时只能得到一个全局近似解,且算法收敛较慢,这导致了上述模型的局限性,阻碍了稀疏表示理论在工程技术上的发展。随着后续专家们在数学理论上的突破,即证明了l1范数下的稀疏模型只要满足约束等距条件,就可以和l0正则化项下的稀疏模型等价,这加速了稀疏表示理论在各应用上的发展,尤其是在模式识别、计算机视觉和图像处理领域中的突破,也为研究人员开辟了另一条解决问题的思路。不过大多数稀疏表示和字典学习算法仍着重于使用l0范数或l1范数正则化来获得稀疏解,对基于lp、l2和l2, 1范数正则化的稀疏模型研究略少,间接导致了稀疏表示理论在某一段时间的沉寂。或许,只有当所有的稀疏表示模型被研究透彻时,其他应用研究可能才会到达另一高度。

| 表 1 不同范数下稀疏表示模型特征与应用的总结 Tab.1 Summary of Feature and Application of Sparse Model with Different Norm |

|

4 结束语

近年来,稀疏表示已经成为一种基本工具,嵌入到各种学习系统中,应用范围也广泛地扩展到机器学习和计算机视觉领域,并且取得了巨大的进步和前所未有的成就。本文总结和介绍了各种稀疏表示模型以及相对应的求解算法,从理论上分析了它们之间的关系,对稀疏表示理论前景的发展总结如下。

1) 稀疏表示方法的有效性和效率并不能完全满足实际应用的需要。特别是稀疏表示的复杂性极大地影响了大规模问题的求解,这也是近些年来,稀疏表示理论在其他工程领域中应用缓慢的根本原因。因此,为稀疏表示开发出一种高效且快速的优化求解算法仍然是主要挑战,这不仅有助于性能改进,同时也极大地扩展了稀疏表示理论在其他领域的应用范围。

2) 单一的模型建立以及复杂的求解算法同样也成为阻碍稀疏表示理论的发展,这是因为针对各个领域中的不同问题,文中总结的5种不同范数正则化下的模型几乎无法满足现实需求,所以相对应的优化求解算法也就失去了意义,因此,如何更深层次地挖掘稀疏表示理论,完善稀疏表示模型,是今后值得继续研究的问题。

3) 基于深度学习的研究成为计算机视觉领域压倒性的趋势。当前深度学习技术的主要局限性是昂贵的训练成本,在基于稀疏表示的研究并未完全转移到学习框架的情况下,如何将成熟的稀疏表示方法全面引入深度学习框架同样值得研究。

从应用角度来看,稀疏表示理论主要应用在计算机视觉和图像处理等工程领域,尤其在图像去噪、特征提取、异常检测和人脸识别等领域表现出色。在遥感领域中,依然停留在简单的应用上,如遥感图像融合和遥感图像分类两大研究方向,在遥感图像中异常检测和目标分割等方向研究较少,如何将稀疏表示理论与更多的遥感应用相结合,是今后重点研究的方向。本文提出的评论和分析可以帮助和激励更多的研究人员提出并完善稀疏表示理论和方法。

| [1] |

Hubel D H, Wiesel T N. Receptive Fields of Single Neurons in the Cat's Striate Cortex[J]. The Journal of Physiology, 1959, 148(3): 574-591. DOI:10.1113/jphysiol.1959.sp006308 |

| [2] |

Field D J. Relations Between the Statistics of Natural Images and the Response Properties of Cortical Cells[J]. Journal of the Optical Society of America (A, Optics and Image Science), 1987, 4(12): 2379-2394. DOI:10.1364/JOSAA.4.002379 |

| [3] |

Olshausen B A, Field D J. Emergence of Simple-Cell Receptive Field Properties by Learning a Sparse Code for Natural Images[J]. Nature, 1996, 381(6583): 607-609. DOI:10.1038/381607a0 |

| [4] |

Donoho D L. Compressed Sensing[J]. IEEE Transactions on Information Theory, 2006, 52(4): 1289-1306. DOI:10.1109/TIT.2006.871582 |

| [5] |

Candès E J, Romberg J, Tao T. Robust Uncertainty Principles: Exact Signal Reconstruction from Highly Incomplete Frequency Information[J]. IEEE Transactions on Information Theory, 2006, 52(2): 489-509. DOI:10.1109/TIT.2005.862083 |

| [6] |

Elad M. Sparse and Redundant Representations: From Theory to Applications in Signal and Image Processing[M]. New York, USA: Springer, 2010.

|

| [7] |

Wright J, Ma Y, Mairal J, et al. Sparse Representation for Computer Vision and Pattern Recognition[J]. Proceedings of the IEEE, 2010, 98(6): 1031-1044. DOI:10.1109/JPROC.2010.2044470 |

| [8] |

Elad M, Figueiredo M A T, Ma Y. On the Role of Sparse and Redundant Representations in Image Processing[J]. Proceedings of the IEEE, 2010, 98(6): 972-982. DOI:10.1109/JPROC.2009.2037655 |

| [9] |

张良培, 李家艺. 高光谱图像稀疏信息处理综述与展望[J]. 遥感学报, 2016, 20(5): 1091-1101. |

| [10] |

刘帆, 裴晓鹏, 张静, 等. 基于优化字典学习的遥感图像融合方法[J]. 电子与信息学报, 2018, 40(12): 2804-2811. |

| [11] |

李丽, 隋立春, 康军梅, 等. 非参数贝叶斯字典学习的遥感影像超分辨率重建[J]. 测绘通报, 2018(7): 5-8. |

| [12] |

Tropp J A, Gilbert A C. Signal Recovery from Random Measurements via Orthogonal Matching Pursuit[J]. IEEE Transactions on Information Theory, 2007, 53(12): 4655-4666. DOI:10.1109/TIT.2007.909108 |

| [13] |

Tibshirani R. Regression Shrinkage and Selection via the Lasso[J]. Journal of the Royal Statistical Society (Series B): Methodological, 1996, 58(1): 267-288. |

| [14] |

Saab R, Chartrand R, Yilmaz O. Stable Sparse Approximations via Nonconvex Optimization[C]. 2008 IEEE International Conferenceon Acoustics, Speech and Signal Processing, Las Vegas, USA, 2008 https://www.researchgate.net/publication/220731892_Stable_sparse_approximations_via_nonconvex_optimization

|

| [15] |

Chartrand R. Exact Reconstruction of Sparse Signals via Nonconvex Minimization[J]. IEEE Signal Processing Letters, 2007, 14(10): 707-710. DOI:10.1109/LSP.2007.898300 |

| [16] |

Xu Zongben. Data Modeling: Visual Psychology Approach and l2, 1 Regularization Theory[C]. International Congress of Mathematicians, Hyderabad, India, 2010

|

| [17] |

Shi Xiaoshuang, Yang Yujiu, Guo Zhenhua, et al. Face Recognition by Sparse Discriminant Analysis via Joint l2, 1-Norm Minimization[J]. Pattern Recognition, 2014, 47(7): 2447-2453. DOI:10.1016/j.patcog.2014.01.007 |

| [18] |

Nie Feiping, Huang Heng, Cai Xiao, et al. Efficient and Robust Feature Selection via Joint l2, 1-Norms Minimization[C].Advances in Neural Information Processing Systems, Vancouver, Canada, 2010 https://www.researchgate.net/publication/221618060_Efficient_and_Robust_Feature_Selection_via_Joint_l2_1-Norms_Minimization

|

| [19] |

Yang Yi, Shen Hengtao, Ma Zhigang, et al. l2, 1-Norm Regularized Discriminative Feature Selection for Unsupervised Learning[C]. The Twenty-Second International Joint Conference on Artificial Intelligence, Barcelona, Spain, 2011 https://www.researchgate.net/publication/262238040_L21-norm_regularized_discriminative_feature_selection_for_unsupervised_learning

|

| [20] |

Liu Jun, Ji Shuiwang, Ye Jieping. Multi-task Feature Learning via Efficient l2, 1-Norm Minimization [C]. The Twenty-Fifth Conference on Uncertainty in Artificial Intelligence, Montreal, Canada, 2009

|

| [21] |

Hou Chenping, Nie Feiping, Li Xuelong, et al. Joint Embedding Learning and Sparse Regression: A Framework for Unsupervised Feature Selection[J]. IEEE Transactions on Cybernetics, 2014, 44(6): 793-804. DOI:10.1109/TCYB.2013.2272642 |

| [22] |

Naseem I, Togneri R, Bennamoun M. Linear Regression for Face Recognition[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2010, 32(11): 2106-2112. DOI:10.1109/TPAMI.2010.128 |

| [23] |

Zhang Lei, Yang Meng, Feng Xiangchu. Sparse Representation or Collaborative Representation: Which Helps Face Recognition[C]. 2011 IEEE International Conference on Computer Vision, Barcelona, Spain, 2011 https://www.researchgate.net/publication/221111435_Sparse_Representation_or_Collaborative_Representation_Which_Helps_Face_Recognition

|

| [24] |

Xu Y, Zhang D, Yang J, et al. A Two-Phase Test Sample Sparse Representation Method for Use with Face Recognition[J]. IEEE Transactions on Circuits and Systems for Video Technology, 2011, 21(9): 1255-1262. DOI:10.1109/TCSVT.2011.2138790 |

| [25] |

Donoho D L, Elad M. Optimally Sparse Representation in General (Non-orthogonal) Dictionaries via l1 Minimization[J]. Proceedings of the National Academy of Sciences, 2003, 100(5): 2197-2202. DOI:10.1073/pnas.0437847100 |

| [26] |

Amaldi E, Kann V. On the Approximability of Minimizing Nonzero Variables or Unsatisfied Relations in Linear Systems[J]. Theoretical Computer Science, 1998, 209(1/2): 237-260. |

| [27] |

Donoho D L. For Most Large Underdetermined Systems of Equations, the Minimal l1-Norm Near-Solution Approximates the Sparsest Near-Solution[J]. Communications on Pure and Applied Mathematics, 2006, 59(6): 907-934. |

| [28] |

Candès E J, Romberg J K, Tao T. Stable Signal Re covery from Incomplete and Inaccurate Measurements[J]. Communications on Pure and Applied Mathematics, 2006, 59(8): 1207-1223. DOI:10.1002/cpa.20124 |

| [29] |

Candès E J, Tao T. Near-Optimal Signal Recovery from Random Projections: Universal Encoding Strategies[J]. IEEE Transactions on Information Theory, 2006, 52(12): 5406-5425. DOI:10.1109/TIT.2006.885507 |

| [30] |

Lyu Qin, Lin Zhouchen, She Yiyuan, et al. A Comparison of Typical lp Minimization Algorithms[J]. Neurocomputing, 2013, 119: 413-424. DOI:10.1016/j.neucom.2013.03.017 |

| [31] |

Zhang Zheng, Wang Long, Zhu Qi, et al. Noise Mode- ling and Representation Based Classification Methods for Face Recognition[J]. Neurocomputing, 2015, 148: 420-429. DOI:10.1016/j.neucom.2014.07.058 |

| [32] |

Tropp J A, Gilbert A C, Strauss M J. Algorithms for Simultaneous Sparse Approximation (Part Ⅰ: Greedy Pursuit)[J]. IEEE Transactions on Signal Processing, 2006, 86(3): 572-588. |

| [33] |

Mallat S G, Zhang Z. Matching Pursuits with Time-Frequency Dictionaries[J]. IEEE Transactions on Signal Processing, 1993, 41(12): 3397-3415. DOI:10.1109/78.258082 |

| [34] |

Pati Y C, Rezaiifar R, Krishnaprasad P S. Orthogonal Matching Pursuit: Recursive Function Approximation with Applications to Wavelet Decomposition[C].The 27th Asilomar Conference on Signals, Systems and Computers, Pacific Grove, CA, USA, 1993

|

| [35] |

Donoho D L, Tsaig Y, Drori I, et al. Sparse Solution of Underdetermined Systems of Linear Equations by Stagewise Orthogonal Matching Pursuit[J]. IEEE Transactions on Information Theory, 2012, 58(2): 1094-1121. DOI:10.1109/TIT.2011.2173241 |

| [36] |

Dai W, Milenkovic O. Subspace Pursuit for Compressive Sensing Signal Reconstruction[J]. IEEE Transactions on Information Theory, 2009, 55(5): 2230-2249. DOI:10.1109/TIT.2009.2016006 |

| [37] |

Do T T, Gan L, Nguyen N, et al. Sparsity Adaptive Matching Pursuit Algorithm for Practical Compressed Sensing[C]. Asilomar Conference on Signals, Systems and Computers, Pacific Grove, CA, USA, 2008 https://www.researchgate.net/publication/224505496_Sparsity_adaptive_matching_pursuit_algorithm_for_practical_compressed_sensing

|

| [38] |

Jost P, Vandergheynst P, Frossard P. Tree-Based Pursuit: Algorithm and Properties[J]. IEEE Transactions on Signal Processing, 2006, 54(12): 4685-4697. DOI:10.1109/TSP.2006.882080 |

| [39] |

La C, Do M N. Tree-Based Orthogonal Matching Pursuit Algorithm for Signal Reconstruction[C]. 2006 International Conference on Image Processing, Atlanta, USA, 2006 https://www.researchgate.net/publication/224057564_Tree-Based_Orthogonal_Matching_Pursuit_Algorithm_for_Signal_Reconstruction

|

| [40] |

Fadili M J, Starck J L, Murtagh F. Inpainting and Zooming Using Sparse Representations[J]. The Computer Journal, 2009, 52(1): 64-79. |

| [41] |

Xu Zongben, Sun Jian. Image Inpainting by Patch Propagation Using Patch Sparsity[J]. IEEE Transactions on Image Processing, 2010, 19(5): 1153-1165. DOI:10.1109/TIP.2010.2042098 |

| [42] |

Li Zhidan, He Hongjie, Yin Zhongke, et al. A Color-Gradient Patch Sparsity Based Image Inpainting Algorithm with Structure Coherence and Neighborhood Consistency[J]. IEEE Transactions on Signal Processing, 2014, 99(6): 116-128. |

| [43] |

Li Zhidan, He Hongjie, Tai Hengming, et al. Color-Direction Patch-Sparsity-Based Image Inpainting Using Multidirection Features[J]. IEEE Transactions on Image Processing, 2015, 24(3): 1138-1152. DOI:10.1109/TIP.2014.2383322 |

| [44] |

Figueiredo M A T, Nowak R D, Wright S J. Gradient Projection for Sparse Reconstruction: Application to Compressed Sensing and Other Inverse Problems[J]. IEEE Journal of Selected Topics in Signal Processing, 2007, 1(4): 586-597. DOI:10.1109/JSTSP.2007.910281 |

| [45] |

Boyd S, Vandenberghe L, Faybusovich L. Convex Optimization[J]. IEEE Transactions on Automatic Control, 2006, 51(11): 1859-1859. DOI:10.1109/TAC.2006.884922 |

| [46] |

Boyd S, Parikh N, Chu E, et al. Distributed Optimization and Statistical Learning via the Alternating Direction Method of Multipliers[M]. Oxford, England: Oxford University Press, 2011.

|

| [47] |

Portugal L F, Resende M G C, Veiga G, et al. A Truncated Primal-Infeasible Dual-Feasible Network Interior Point Method[J]. Networks, 2000, 35(2): 91-108. |

| [48] |

Koh K, Kim S J, Boyd S. An Interior-Point Method for Large-Scale l1-Regularized Logistic Regression[J]. Journal of Machine Learning Research, 2007, 8: 1519-1555. |

| [49] |

Figueiredo M A T, Nowak R D. A Bound Optimization Approach to Wavelet-Based Image Deconvolution[C]. IEEE International Conference on Image Processing, Genova, Italy, 2005 https://www.researchgate.net/publication/221121404_A_bound_optimization_approach_to_wavelet-based_image_deconvolution

|

| [50] |

Beck A, Teboulle M. A Fast Iterative Shrinkage- Thresholding Algorithm for Linear Inverse Problems[J]. SIAM Journal on Imaging Sciences, 2009, 2(1): 183-202. DOI:10.1137/080716542 |

| [51] |

Zeng Jinshan, Lin Shaobo, Wang Yao, et al. l1/2 Regularization: Convergence of Iterative Half Thresholding Algorithm[J]. IEEE Transactions on Signal Processing, 2014, 62(9): 2317-2329. DOI:10.1109/TSP.2014.2309076 |

| [52] |

Elad M, Matalon B, Zibulevsky M. Coordinate and Subspace Optimization Methods for Linear Least Squares with Non-Quadratic Regularization[J]. Applied and Computational Harmonic Analysis, 2007, 23(3): 346-367. DOI:10.1016/j.acha.2007.02.002 |

| [53] |

Donoho D L, Maleki A, Montanari A. Message-Passing Algorithms for Compressed Sensing[J]. Proceedings of the National Academy of Sciences of the United States of America, 2009, 106(45): 18914-18919. DOI:10.1073/pnas.0909892106 |

| [54] |

Becker S R, Bobin J, Candès E J. NESTA: A Fast and Accurate First-Order Method for Sparse Recovery[J]. SIAM Journal on Imaging Sciences, 2011, 4(1): 1-39. DOI:10.1137/090756855 |

| [55] |

Becker S, Candès E J, Grant M C. Templates for Convex Cone Problems with Applications to Sparse Signal Recovery[J]. Mathematical Programming Computation, 2011, 3(3): 165-218. DOI:10.1007/s12532-011-0029-5 |

| [56] |

Osborne M R, Presnell B, Turlach B A. A New Approach to Variable Selection in Least Squares Problems[J]. IMA Journal of Numerical Analysis, 2000, 20(3): 389-403. DOI:10.1093/imanum/20.3.389 |

| [57] |

Yang Junfeng, Zhang Yin. Alternating Direction Algorithms for l1-Problems in Compressive Sensing[J]. SIAM Journal on Scientific Computing, 2011, 33(1): 250-278. |

| [58] |

Plumbley M D. Recovery of Sparse Representations by Polytope Faces Pursuit[C]. The 6th International Conference on Independent Component Analysis and Blind Signal Separation, Berlin, Germany, 2006 https://link.springer.com/chapter/10.1007/11679363_26

|

| [59] |

Donoho D L, Tsaig Y. Fast Solution of l1-Norm Minimization Problems when the Solution May Be Sparse[J]. IEEE Transactions on Information Theory, 2008, 54(11): 4789-4812. DOI:10.1109/TIT.2008.929958 |

| [60] |

Efron B, Hastie T, Johnstone I, et al. Least Angle Regression[J]. The Annals of Statistics, 2004, 32(2): 407-499. DOI:10.1214/009053604000000067 |

| [61] |

Asif M S, Romberg J. Fast and Accurate Algorithms for Re-Weighted l1-Norm Minimization[J]. IEEE Transactions on Signal Processing, 2012, 61(23): 5905-5916. |

2019, Vol. 44

2019, Vol. 44