| 利用无人机影像数据进行油菜长势监测 |

2. 广东开放大学人工智能学院,广东 广州,510091;

3. 中国农业科学院油料作物研究所,湖北 武汉 430062

2. School of Artificial Intelligence, The Open University of Guangdong, Guangzhou 510091, China;

3. Oil Crops Research Institute of the Chinese Academy of Agricultural Sciences, Wuhan 430062, China

油菜是中国第一大油料作物,长江中下游是油菜的高产区[1, 2]。从20世纪90年代开始,农业遥感监测的重点从遥感估产监测转向农业生产过程监测,因此作物生长过程监测成为农业遥感研究的重要内容。及时监测作物生长能够帮助管理人员及时了解作物生长情况,针对长势较差的作物采取相应措施,同时也能对作物品种的生长能力有所判断。以油菜为例,快速准确地对油菜长势进行监测,对田间管理、材料育种、产量评估等具有重要意义,同时也直接关系到国家油料产品的贸易与油料产业的发展。

传统的作物长势监测方法中,需要对区域作物进行抽样,然后测量作物的生理指标、形态指标、生物/非生物斜坡指标和产量指标[3],进而对作物长势做出较准确的评估判断。这种监测方法效率低下、成本高,而且结果准确性低,极大地限制了现代农业科学的发展[4]。遥感影像覆盖面积广,其所包含的光谱信息能够很好地反映农作物生长情况。归一化植被指数(normalized difference vegetation index,NDVI)的应用最为广泛,已成为检测植被覆盖情况和生长情况的最佳遥感指数[5]。Becker-Reshef等[6]提出了一种基于NDVI对小麦产量进行估算的方法,并在乌克兰地区实现提前预测;Gitelson等[7]基于小麦冠层的光谱特性,研究了不同NDVI与植被覆盖率的关系;Viña等[8]提出了一种利用NDVI对玉米与大豆的叶面积指数进行估算的方法;刘雅婷等[9]则利用无人机拍摄的油菜遥感数据,提出了一种新型的基于多时相混合光谱分析的油菜长势监测方法;陶言祺等[10]利用油菜冠层的多光谱信息,用机器学习的方法对油菜关键生长发育期进行识别。在此类方法中,卫星遥感影像无法获取局部地区的信息,而且易受天气等条件影响。多光谱无人机则精准度较低,通常需要专业的校准才能得到较准确的影像,而且成本相对也较高。综上,计算NDVI所需的各种光谱信息的获取难度和成本都较高,存在较大局限性。

近年来,随着精准农业的发展,普通无人机(unmanned aerial vehicle,UAV)凭借其低成本、效率高、机动灵活等优势,能够无破坏性地获取大规模区域的田间信息[11]。考虑到实践中的图像识别与分类计数,分析空中图像通常是精准农业的关键组成部分。许多学者探索了深度学习在精准农业中的应用,Yang等[12]提出了一种基于无人机图像的实时水稻表型检测方法;Mohanty等[13]将AlexNet与GoogLeNet进行对比研究,发现GoogLeNet在检测农作物疾病方面比AlexNet更有效。

目前深度学习技术与油菜种植相结合的研究相对较少,所以设计一种快速准确监测油菜长势的方案很有必要。这样就可以在需要针对性地整治作物时通知管理者,同时还可以有效降低人工成本。因此,本文研究低成本、高效的油菜长势监测方法,利用无人机获取试验田油菜的图像,然后选择表现优秀的神经网络模型进行优化测试。此外,本文还建立了幼苗期油菜的图像数据集,为油菜的其他相关研究提供了基础。

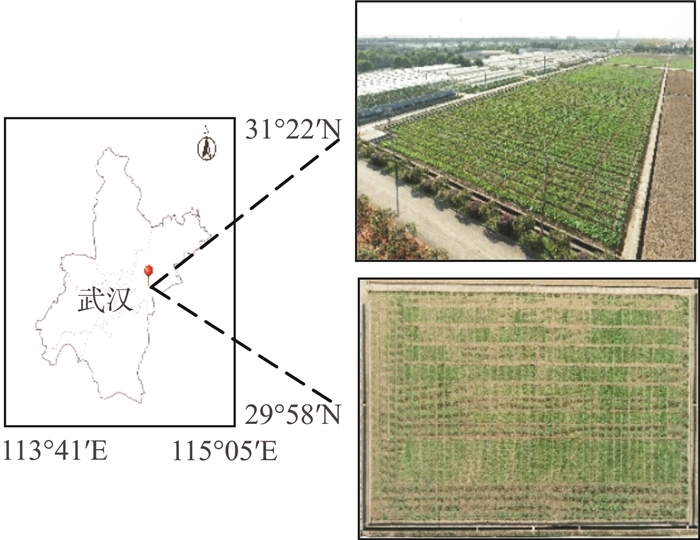

1 数据来源与数据集制作1)研究区域与数据采集。本文选取湖北省武汉市新洲区中国农业科学院油料研究所阳逻基地的油菜种植区域为研究区域。如图 1所示,该区域海拔约24 m,气候类型为亚热带季风气候。研究区域中包含30个不同品种,共分为369个小区,小区的规模分别为2 m×4 m和2 m×3 m,采集图像时,油菜处于幼苗期,生长约45 d。数据采集使用的设备为大疆精灵Phantom 4 Pro V2.0型号无人机。

|

| 图 1 研究区域基本信息 Fig.1 Basic Information of the Study Area |

2)数据集的制作。无人机采集到的数据往往无法直接使用,需要对数据进行处理,本文将无人机数据按照以下流程处理得到最终的实验数据集:①用无人机对研究区域进行自动航拍;②利用PhotoScan软件将航拍影像进行处理,获取研究区域的正射影像,然后利用Photoshop软件将正射影像按照2 m×1 m的实际地面尺寸进行裁剪;③综合作物地上生物量、植株高度、叶绿素含量、缺失情况等人工测量结果,由4名农学专家现场为图片所对应的区域内油菜进行测量评估,然后根据评估结果对步骤②中得到的裁剪图像进行标注;④将裁剪后的数据进行数据增强,得到最终的网络训练和测试所需要的数据集。

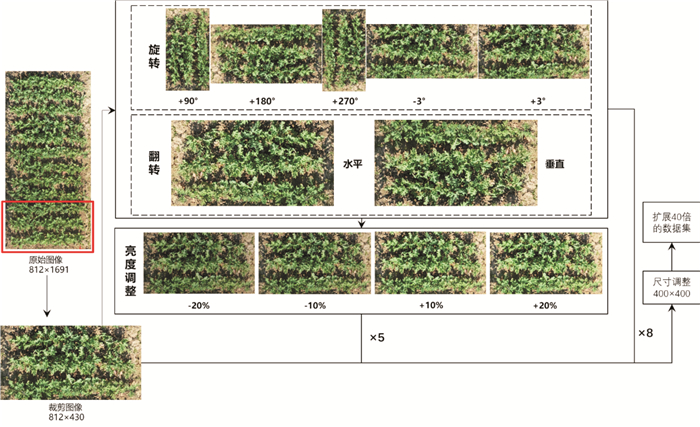

图 2所示的数据增强部分是将图片顺时针旋转90°、180°、270°、3°和-3°,以及对图片进行水平翻转和垂直翻转。为了让网络模型对自然场景中的亮度变化更加鲁棒,数据扩展时也对亮度进行了操作。将图像从RGB色彩空间转变到HSV色彩空间并进行了调整。最终得到的数据集共包含37 080张图像,数据集中每个图像都与现实中油菜的长势情况关联,长势由4位农学专家根据油菜的株高、叶宽等人工测量数据综合评估,然后将评估结果进行误差消除后,将其作为实验数据的最终标签。最终将长势划分为3种:优秀、一般、较差,在网络模型中对应的类别编号分别为2、1、0。其中,长势优秀表示油菜长势良好,符合预期甚至超出预期;一般则表示部分植株长势低于预期,或者存在植株已经死亡并且被清除的迹象;长势较差则表示整体生长情况远低于预期或出现大面积植株死亡,需要针对性地进行治理。

|

| 图 2 数据增强流程 Fig.2 Scheme of Data Augmentation |

2 卷积神经网络模型

1)网络模型介绍。ResNet[14]使用了一种短路跳跃连接的残差结构,可以同时提升网络深度及性能。神经网络随着网络深度的不断增加会出现非训练过拟合导致的网络退化问题。为解决这种问题,ResNet使用了跳跃连接的结构,使网络具有更强的独立映射能力,从而拓展了网络深度。ResNeXt[15]为ResNet网络的升级版,其对残差单元做出了修改,将分组卷积的思想应用在残差单元中,这是一种介于普通卷积和深度可分离卷积的策略,并且将这种拓扑结构应用在每一个分支单元,通过控制分组的数量来达到两种策略的平衡。

DenseNet[16]使用了一种密集连接机制,即每一层的特征输入与所有前面层的特征关联,加强了特征在深层网络中的传递,使得较早的特征信息也可以被最终的分类层所监督,能够更好地利用特征信息。这样的设计在能够获得图像中更多样信息的同时,还有效地减少了参数,使得模型更加简洁,且效果得以提升。

ShuffleNet v2[17]网络使用可分离的卷积操作,有效地减少了计算量,同时从特征通道数、分组卷积、网络碎片化程度和元素级操作4个方面对网络运算速度进行优化,使得网络在保持较高性能的同时提升运算速度。这种轻量网络模型便于部署在移动设备中,从而更好地完成相关自动化任务。

EfficientNet[18]则从网络深度、网络宽度和图像分辨率3个角度同时进行优化调整,然后使用复合模型扩张方法结合神经结构搜索技术,获得了一种使三者达到平衡状态网络结构,能够有效提升性能。

虽然在大型公开数据集中上述网络模型均取得了不错成绩,但是并没有实验证明其能在小数据集上取得相同效果。

2)损失函数。在训练模型的过程中,采用的损失数均为交叉熵函数,在多分类任务场景中,交叉熵函数的具体形式为:

| $ L = \frac{1}{N}\sum {{L_i}} = \frac{1}{N}\sum {\left( { - \sum\limits_{c = 1}^M {{y_{ic}}} \ln {p_{ic}}} \right)} $ | (1) |

式中,N表示数据样本的数量;M表示样本中所包含的类别数;c表示当前具体类别;yic为指示变量,如果该类别与样本i的类别相同则为1,否则为0;pic表示观测样本i为类别c的预测概率。

3 实验结果与分析本文将数据集按照8∶2的比例划分为训练集和测试集,其中训练集29 560张图像,测试集7 520张图像,训练和测试过程中输入图像的尺寸均为400×400。实验过程所用的硬件服务器内存为128 G,GPU为NVIDIA GTX 1080Ti。

本文使用准确率、微观F1(Micro F1)、宏观F1(Macro F1)及Kappa系数来评估各网络模型的性能。

| $ {\mathop{\rm Macro}\nolimits} F1 = \frac{{\sum F {1_i}}}{n} $ | (2) |

式中,F1i指第i类的F1值;n为类别数。

| $ {\rm{ Micro }}F1 = \frac{{2 \times {A_P} \times {A_R}}}{{{A_P} + {A_R}}} $ | (3) |

式中,AP为整体精度;AR为整体召回率。

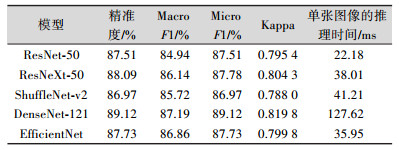

利用本文构建的数据集进行网络模型训练,得到的测试结果如表 1所示。从表 1可以看出,5种网络模型的测试精度都大于86%,DenseNet在所有的模型中取得了最好的结果,识别精度达到了89.12%,Macro F1和Micro F1也分别达到了87.19%和89.12%,而且Kappa大于0.8,与现实有较好的一致性,但是可以看出,DenseNet-121在测试时耗时比较严重,相比于耗时最少的ResNet-50,其单张图像的测试耗时是ResNet-50的近6倍,但在实际应用当中127 ms的用时也比人工判断长势的方式快很多。此外,结构相似的ResNeXt和ResNet的各项测试结果都比较相近,但是ResNeXt的单张图像测试时间比ResNet长近70%。

| 表 1 各模型的油菜长势识别结果 Tab.1 Results of Rapeseed Growth Identification by |

|

而ShuffleNet-v2和在公开数据集上表现最好的EfficientNet在本文任务场景下,不论是从检测精度还是测试时间上来看,表现都不出色,这两种网络在进一步针对此类场景进行优化后可能会取得较好效果。综合所有实验结果,ResNet-50在本文任务中更胜一筹,在实际应用场景中也推荐使用ResNet网络模型系列。

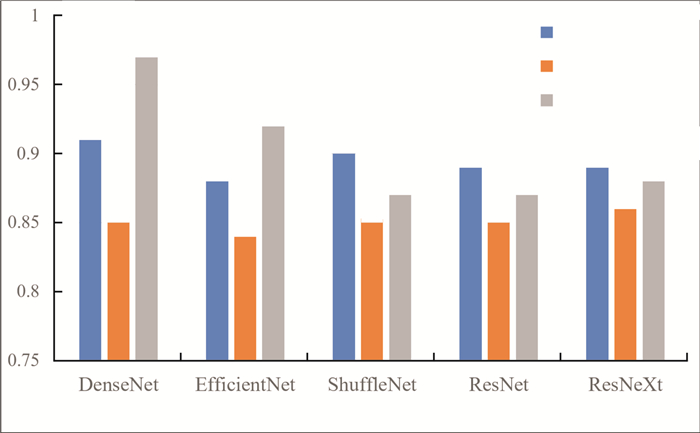

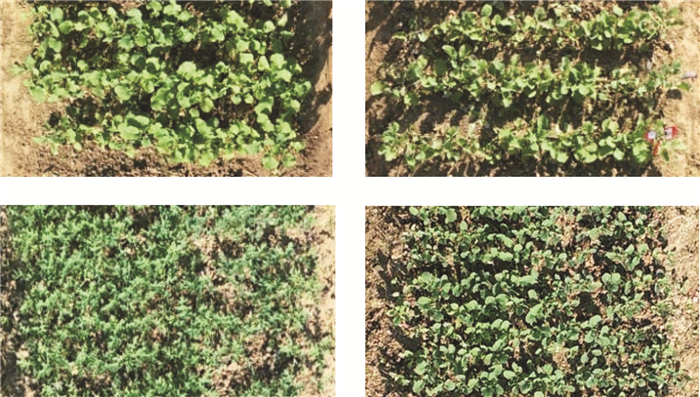

另外,从图 3的各子类识别精度发现,相对而言,各网络模型对长势一般样本的检测效果较差。本文对实际样本进行分析,发现此类样本检测错误的原因主要在于在数据集中存在部分艰难样本,油菜本身长势属于优秀,但是某些因素导致其在生长过程中死亡,或者处于个别区域的部分植株长势异常,使得样本图片中植株缺失较多或部分区域植株长势极差,根据专家的长势评估方法,这类样本属于长势一般的一类,但是由于这类样本中存在长势极好的植株,所以对于网络模型来说容易判断错误。图 4展示了数据集中属于这一类型的长势一般的样本。在采集实验数据的过程中还存在诸多局限性,所以能够采集到的样本在数量和丰富度方面还有很大的优化空间,后期本研究团队也会逐步完善数据集。

|

| 图 3 子类别的识别精度 Fig.3 Accuracy of Subcategories |

|

| 图 4 错误分类的样例 Fig.4 Examples of Incorrect Classification |

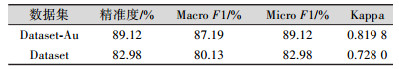

本文还对数据扩展和网络模型的输入图像尺寸进行了探究,并为此将包含188张图像的原始数据集作为公共测试集,并选择另一部分包含739张原始图像的数据集作为训练集重新训练DensetNet,最终实验结果如表 2所示,在该场景中使用数据增强的方式可以有效提升网络模型性能。同时,本文还研究了在这种场景下改变网络输入数据尺寸对网络性能的影响。

| 表 2 DenseNet在增强数据上的实验结果 Tab.2 Results of DenseNet Using Augmented Data |

|

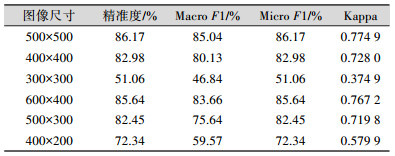

原始数据的尺寸约为800×400,且大小不统一,难以直接输入网络模型使用。故本文对输入图像进行了统一调整,并探究了不同尺寸的输入图像对网络性能的影响。表 3表明,适当地调整图像尺寸能够让网络性能更好。网络的输入图像尺寸在合理范围内变大时,网络能够获得更多有效信息,从而提取到更好的图像特征。结果还表明,使用正方形的图像训练得到的模型性能更优,相对而言,网络在提取正方形图像的特征时更能均衡横向和纵向的信息,从而获得更好的特征用于分类。在不同的任务中,需要根据实际情况,选择一种能够充分发挥网络性能的输入图像尺寸。

| 表 3 DenseNet在不同尺寸图像的实验结果 Tab.3 Results of DenseNet with Different Images |

|

4 结束语

本文利用无人机影像,结合深度学习算法,实现了油菜长势识别任务。首先构建了幼苗期油菜的无人机影像数据集,然后选择表现优秀的5种经典网络模型对图像中的油菜植株长势进行检测,并进行实验。实验结果表明,在该任务场景下,DenseNet是最佳选择,而在硬件条件有限的情况下,应选择ResNet网络来完成任务。相比于传统的人工取样监测方法,本文方法能够实现低成本、快速的油菜作物长势监测。在实际应用中可以有效降低田间管理成本,从而实现大规模的油菜长势监测,推动油菜种植的自动化和规模化发展。本文方法还能够进一步优化,在后续的工作当中可以进一步完善关于油菜不同长势的数据集,同时还可以建立一种基于本文研究场景的油菜长势识别模型,达到更好的识别效果。此外本文建立的高分辨率的幼苗期油菜的图像数据集包含了丰富的油菜作物信息,能为其他油菜相关科学研究提供基础。

| [1] |

王汉中. 我国油菜产需形势分析及产业发展对策[J]. 中国油料作物学报, 2007, 29(1): 101-105. DOI:10.3321/j.issn:1007-9084.2007.01.022 |

| [2] |

Hu Q, Hua W, Yin Y, et al. Rapeseed Research and Production in China[J]. The Crop Journal, 2017, 5(2): 127-135. DOI:10.1016/j.cj.2016.06.005 |

| [3] |

刘建刚, 赵春江, 杨贵军, 等. 无人机遥感解析田间作物表型信息研究进展[J]. 农业工程学报, 2016, 32(24): 98-106. DOI:10.11975/j.issn.1002-6819.2016.24.013 |

| [4] |

Pajares G. Overview and Current Status of Remote Sensing Applications Based on Unmanned Aerial Vehicles (UAVs)[J]. Photogrammetric Engineering & Remote Sensing, 2015, 81(4): 281-329. |

| [5] |

Carlson T N, Ripley D A. On the Relation Between NDVI, Fractional Vegetation Cover, and Leaf Area Index[J]. Remote Sensing of Environment, 1997, 62(3): 241-252. DOI:10.1016/S0034-4257(97)00104-1 |

| [6] |

Becker-Reshef I, Vermote E, Lindeman M, et al. A Ge-neralized Regression-Based Model for Forecasting Winter Wheat Yields in Kansas and Ukraine Using MODIS Data[J]. Remote Sensing of Environment, 2010, 114(6): 1 312-1 323. DOI:10.1016/j.rse.2010.01.010 |

| [7] |

Gitelson A A, Kaufman Y J, Stark R, et al. Novel Algorithms for Remote Estimation of Vegetation Fraction[J]. Remote Sensing of Environment, 2002, 80(1): 76-87. DOI:10.1016/S0034-4257(01)00289-9 |

| [8] |

Viña A, Gitelson A A, Nguy-Robertson A L, et al. Comparison of Different Vegetation Indices for the Remote Assessment of Green Leaf Area Index of Crops[J]. Remote Sensing of Environment, 2011, 115(12): 3 468-3 478. DOI:10.1016/j.rse.2011.08.010 |

| [9] |

刘雅婷, 龚龑, 段博, 等. 多时相NDVI与丰度综合分析的油菜无人机遥感长势监测[J]. 武汉大学学报·信息科学版, 2020, 45(2): 265-272. |

| [10] |

陶言祺, 彭漪, 蒋琦, 等. 利用植被光谱数据和Stacking算法识别油菜关键生长发育期[J]. 测绘地理信息, 2019, 44(5): 20-23. |

| [11] |

Herwitz S R, Johnson L F, Dunagan S E, et al. Imaging from an Unmanned Aerial Vehicle: Agricultural Surveillance and Decision Support[J]. Computers and Electro-nics in Agriculture, 2004, 44(1): 49-61. DOI:10.1016/j.compag.2004.02.006 |

| [12] |

Yang Q, Shi L S, Han J Y, et al. A Near Real-Time Deep Learning Approach for Detecting Rice Phenology Based on UAV Images[J]. Agricultural and Forest Meteorology, 2020, 287: 107938. DOI:10.1016/j.agrformet.2020.107938 |

| [13] |

Mohanty S P, Hughes D P, Salathé M. Using Deep Lear-ning for Image-Based Plant Disease Detection[J]. Frontiers in Plant Science, 2016, 7: 1 419. DOI:10.3389/fpls.2016.01419 |

| [14] |

He K M, Zhang X Y, Ren S Q, et al. Deep Residual Learning for Image Recognition[C]. 2016 IEEE Confe-rence on Computer Vision and Pattern Recognition(CVPR), Las Vegas, NV, USA, 2016

|

| [15] |

Xie S N, Girshick R, Dollár P, et al. Aggregated Resi-dual Transformations for Deep Neural Networks[C]. 2017 IEEE Conference on Computer Vision and Pattern Recognition(CVPR), Honolulu, HI, USA, 2017

|

| [16] |

Huang G, Liu Z, van der Maaten L, et al. Densely Connected Convolutional Networks[C]. 2017 IEEE Confe-rence on Computer Vision and Pattern Recognition(CVPR), Honolulu, HI, USA, 2017

|

| [17] |

Ma N N, Zhang X Y, Zheng H T, et al. ShuffleNet V2: Practical Guidelines for Efficient CNN Architecture Design[C]. 2018 European Conference on Computer Vision, Munich, Germany, 2018

|

| [18] |

Tan M X, Le Q V. EfficientNet: Rethinking Model Sca-ling for Convolutional Neural Networks[C]. Proceedings of the 36th International Conference on Machine Learning, Long Beach, California, USA, 2019

|

2021, Vol. 46

2021, Vol. 46