| 一种顾及细粒度信息与残差网络的高分辨率遥感影像场景分类法 |

卫星传感技术的不断进步使得遥感影像的空间分辨率有了很大提升。获取高分辨率遥感影像后,需要经过一系列复杂处理,才能提取有价值信息,而遥感影像的场景分类就是其中一项很重要的处理方法,它在资源勘测、灾害监测、城市规划等领域都有广泛应用[1]。

在高分辨率遥感影像中,场景可以看作多个对象的组合,这些对象具有不同的形状、大小和纹理信息,它们以不同的空间排列方式,形成不同的场景类别,并由人工预先定义为不同的语义类别,而高分辨率影像场景分类目的就在于准确提取高分影像中的高层次抽象特征并进行区分。

对于一般遥感影像场景分类,传统上一般提取手工设计的低层次视觉特征,或是使用将低层次特征加工后得到的中层次特征,但这些特征对场景图像的描述能力有限,而且缺乏灵活性和自适应性,对高分辨率遥感影像的复杂场景区分能力有限,已经无法满足现有需求[2]。

卷积神经网络已经在自然图像目标识别、分类等任务上取得了重大突破,且性能远超传统方法,展现了强大的特征表达能力。一些学者利用卷积神经网络强大的层次化特征学习能力以及良好的迁移性,将在大规模自然图像数据集上训练的深度卷积神经网络迁移到遥感场景数据集中,获得了突出的分类性能。Penatti等[3]首次利用卷积神经网络来解决高分辨率遥感场景分类;Marmanis等[4]使用在ImageNet[5]数据集上预训练好的网络进行场景分类,解决有限的标记数据导致大量过拟合的问题。为了提取额外的场景信息,Li等[6]将多尺度信息引入场景分类,融合不同卷积层和全连接层提取的深层特征,提出一种能够最大化每个网络层提取特征的方法。然而,该方法只是粗糙地利用了各卷积层特征,并没有很好地对其进行处理,所以,还是没有很好地解决影像场景地类内差异和类间相似问题。

基于上述分析,本文提出一种顾及细粒度信息与残差网络(residual network,ResNet)的遥感影像场景分类方法,结合场景多尺度特征和细粒度特征,通过注意力机制增强特征并融合,统一相同类别场景的类内差异特征,加大相似类别场景的可区分性,进而整体提高遥感影像场景的分类精度。

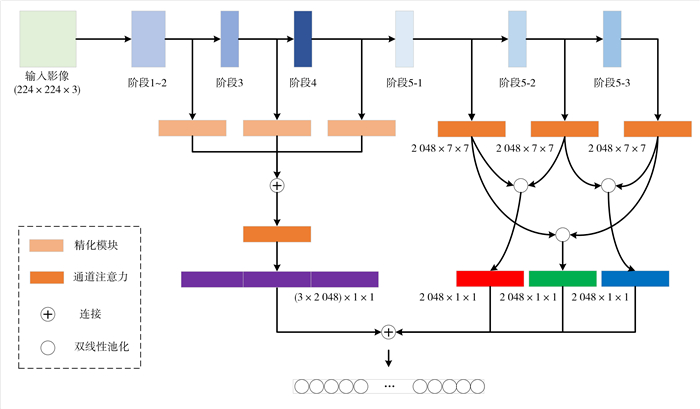

1 方法和原理本文提出的顾及细粒度信息的ResNet的遥感影像场景分类方法整体网络结构如图 1所示。该方法特征提取分为两部分:①通过ResNet各阶段提取多尺度特征,通过优化残差模块进行特征图优化,增强每一阶段的识别能力;②对网络高层特征进行双线性池化特征融合,通过特征外积的方式获取遥感场景二阶信息,提升细粒度分类效果。

|

| 图 1 本文方法网络结构图 Fig.1 Network Structure Diagram of the Proposed Method |

1.1 多尺度特征提取

本文基础骨架网络使用的是在ImageNet数据集上预训练好的ResNet50[7],该网络包含49个卷积层和1个完全连接层,其中49个卷积层可分为5个阶段。第1阶段仅包含一个卷积层,其卷积核数为64,卷积核大小为7×7,步长为2。第2~5阶段是重复的单元结构,每个阶段的区别仅在于单元中的卷积核数量,在每一阶段中,第一个卷积层的核大小为1×1,第二个卷积层的核大小为3×3,第三个卷积层的核大小为1×1。

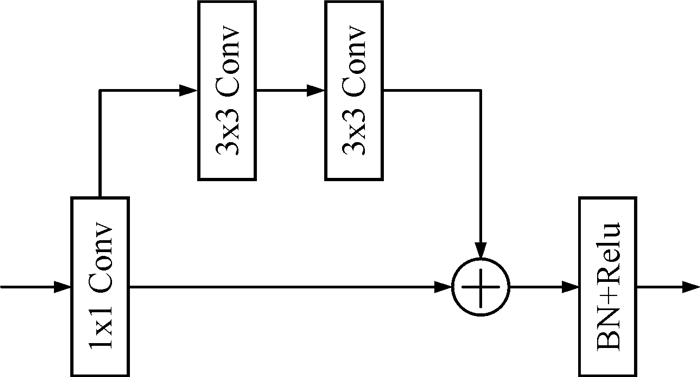

通常多尺度特征使用的是ResNet每阶段的输出特征向量,本文选取第2~4阶段的特征作为影像的多尺度特征,并使用残差精化模块来优化特征图,精化模块如图 2所示。ResNet第2~4阶段输出的特征图全都经过残差精化模块,该模块的第一个组件是一个1×1的卷积层,其作用是统一通道数量,同时整合所有通道信息,然后是一个基本残差块,用于优化特征图,强化每一阶段特征的识别能力。

|

| 图 2 残差精化模块 Fig.2 Residual Refinement Module |

1.2 双线性池化

遥感影像场景多尺度特征使用的是ResNet第2~4阶段的从底层到高层特征映射,可以较好地对场景的不同尺度特征做出反应,但对于场景的细微差别无法较好表示。ResNet第5阶段特征属于高层特征,由3个单元组成,分别是阶段5-1、阶段5-2和阶段5-3,为了充分利用不同层次的特征,本文使用双线性池化对阶段5-1、阶段5-2和阶段5-3的特征进行增强和融合,对影像场景的细粒度特征进行更好的表达。

双线性池化的核心思想是利用两个卷积神经网络来获取同一图像的特征A和特征B,并对这两个特征通过外积进行融合,以生成新的特征,该特征向量包含丰富的细粒度特征信息,可以实现相似场景的有效区分。

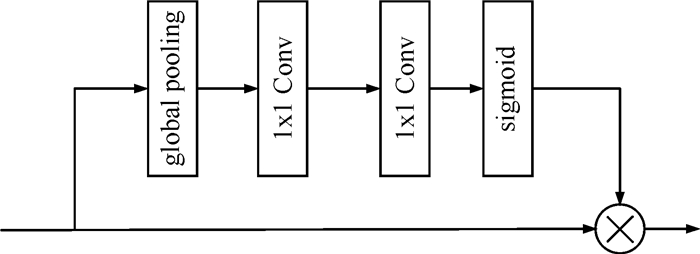

1.3 通道注意力对于卷积神经网络提取的图像特征,在以往的分类工作中都是同等对待的,但在处理特定的问题时,需要相关性更强的特征。注意力机制可以较好地抑制与当前任务相关性较弱的特征,增强相关性强的特征,快速准确定位所需特征。

在SENet[8]模型中,有学者提出一种新的结构单元,通过关注特征通道关系,实现特征重标定。如图 3所示,该模块主要包括压缩、激发两种操作,实现特征图的重新标定,并对特征通道进行重新加权。在该模块中,输入特征通过全局池化进行特征压缩,得到通道级的全局特征,然后通过1×1的卷积层进行激发操作,学习各通道之间的关系,得到不同通道的权重,最后将权重乘以原来的特征图即可得到最终特征。

|

| 图 3 通道注意力机制 Fig.3 Mechanism of Channel Attention |

本文在提取精化多尺度特征后和进行特征双线性池化融合前使用了通道注意力机制模块,前者可以加强多尺度特征中类内的一致性特征,后者可以增强细粒度特征中的关键区域,更有效地区分相似易混淆类别。

2 实验结果与分析 2.1 实验数据本文选取AID[9]和NWPU-RESISC45[10]这两个公用遥感影像数据集进行场景分类。

1) AID数据集是大范围航空影像数据集,影像主要从谷歌地球影像中获取,包含30种场景类别和10 000张遥感影像,每个场景类别约有220~420幅影像,像素大小为600×600,空间分辨率为0.5~8 m。

2) NWPU-RESISC45数据集由西北工业大学提供,主要用于遥感影像场景分类,包含45种场景类别和31 500张遥感影像,每个场景类别包含700幅影像,像素大小为256×256,空间分辨率为0.2~30 m。

为了便于将该方法与其他方法进行比较,在实验中,本文采用的是文献[9]中设置数据集的方式,对于AID数据集,随机选取20%和50%的样本作为训练集,其余样本为测试集;对于NWPU-RESISC45数据集,随机选取10%和20%的样本作为训练集,其余样本为测试集。

2.2 实验环境和评价指标本文的场景分类算法搭建在Pytorch深度学习框架下,主机环境为Ubuntu操作系统,GPU配置为NVIDIA RTX2080。

实验使用Nesterov加速梯度下降法[11]进行优化,初始参数学习率设置为0.005,动量设置为0.9,权重衰减设置为1×10-4。模型每次训练周期设置为100次,训练批次大小为24。学习率随着训练逐步调整,每20个周期调整为上次的1/10。

本文使用总体精度(overall accuracy,OA)作为定量指标来评价分类方法的性能,其定义为测试样本中被正确分类的样本个数与测试样本总数的比值,即[OA=Nc/Nt]。为了降低实验随机性的影响,本文对不同数据集不同样本的实验分别重复10次,统计每次得到的精度,在对比中使用每次精度结果的平均值和标准差。

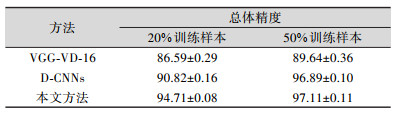

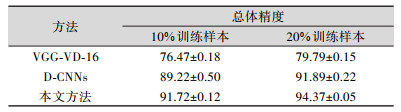

2.3 实验结果与分析为了检验本文框架用于场景分类的可行性和有效性,本文对比了使用不同数据集时本文方法、VGG-VD-16[9, 10]和D-CNNs[12]方法的总体精度,结果见表 1、表 2。

| 表 1 AID数据集不同方法总体精度/% Tab.1 Overall Accuracy of Different Methods on AID Dataset/% |

|

| 表 2 NWPU-RESISC45数据集不同方法总体精度/% Tab.2 Overall Accuracy of Different Methods on NWPU-RESISC45 Dataset/% |

|

从表 1可以看出,训练样本占总样本比例分别为20%和50%时,本文方法分别达到94.71%和97.11%的最佳精度。从表 2可以看出,训练样本占总样本比例分别为10%和20%时,本文提出的方法分别达到91.72%和94.37%的最佳精度。这说明本文方法针对高分辨率遥感影像场景分类具有较好的精度和稳定性。

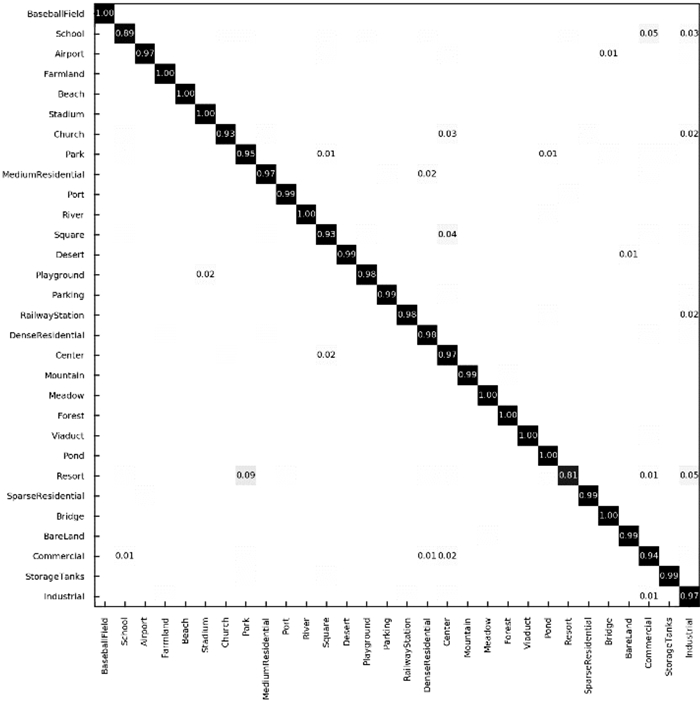

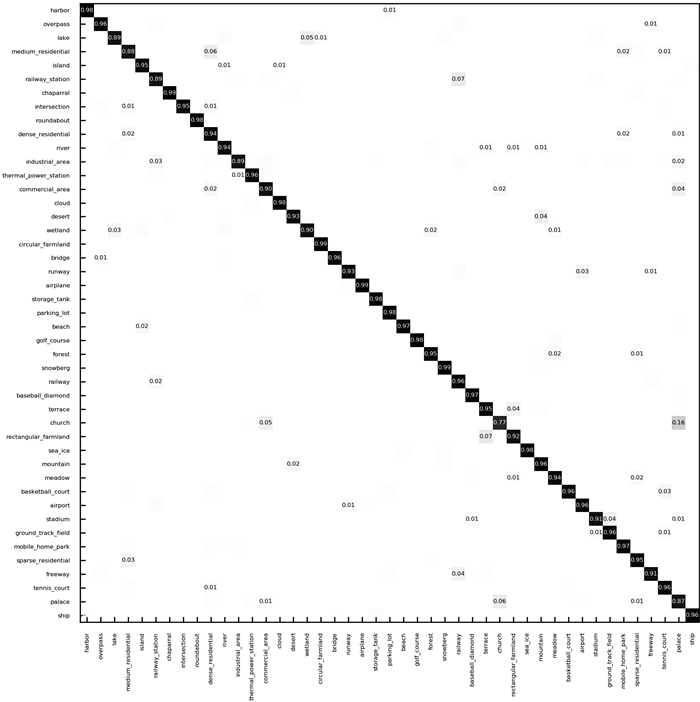

为了更清楚地观察每种场景类别中被正确分类和错误分类的样本,分析场景类别混淆情况,本文使用实验中精度最高的模型来计算混淆矩阵,图 4和图 5分别为AID数据集训练样本比例为50%和NWPU-RESISC45数据集训练样比例为20%时的混淆矩阵。

|

| 图 4 50%训练样本的AID数据集混淆矩阵 Fig.4 Confusion Matrix of AID Dataset Under the Training Ratio of 50% |

|

| 图 5 20%训练样本的NWPU-RESISC45数据集混淆矩阵 Fig.5 Confusion Matrix of NWPU-RESISC45 Dataset Under the Training Ratio of 20% |

由图 4可知,大多数场景分类准确率至少达到90%,甚至有1/3的场景分类准确率达到100%,这些场景主要包括棒球场、农田、海滩、河流等。从图 5可以看出,NWPU-RESISC45数据集比AID数据集复杂,但该数据集的实验结果也获得了良好的精度分布,大多数场景的分类准确率仍在90%以上,有几个类别的分类准确率在99%及以上。

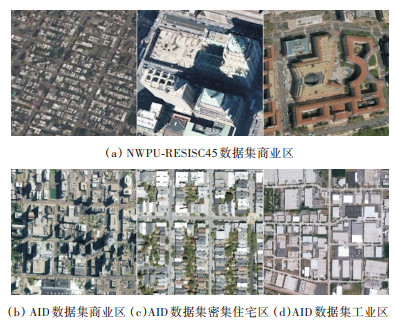

在这两个数据集中,一些容易混淆的类别的分类效果也得到了较大提升。图 6(a)是NWPU-RESISC45数据集中的商业区类别,其场景建筑物在形状、规模、颜色等方面有明显的视觉差异,显示了同一类别场景的类内差异性;图 6(b)~图 6(d)是AID数据集的中商业区、密集住宅区和工业区类别,这些场景都包含相似的对象(如建筑物、道路、植被等),也具有相似的空间排列,显示了不同场景类别的类间相似性,这些场景类别在分类过程中极易出现混淆。由图 4和图 5可知,通过本文方法能够较好区分这些类内差异大和类间相似强的场景,极易出现混淆的商业区、密集住宅区、工业区类别在AID[9]数据集上的相互错分率均在1%以下,在数据量更大、场景更复杂的NWPU-RESISC45数据集上的互错分率也在2%以下。

|

| 图 6 场景的类内差异和类间相似 Fig.6 Intra-Class Differences and Inter-Class Similarities of Scenes |

以上结果表明,本文提出的端到端模型具有更强的特征描述能力,而且对于相似易混淆类别也有较强的区分能力,网络简洁明了,也不需要增加复杂的约束条件。

本文场景分类结果中也有一些典型的误分类样本,如旅游胜地、公园、教堂、宫殿等类别。这些类别都具有极其相似的特性,场景语义信息比较模糊,其中有些场景甚至人工都无法赋予准确的语义类别。因此,如何提取更加细粒的特征来针对这些场景进行分类是后续研究中需要关注的重点。

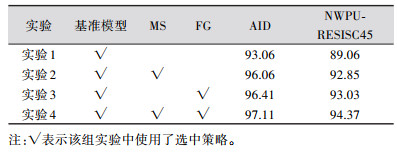

同时本文进行了消融实验来进一步分析提出的网络结构中多尺度特征(multi-scale features,MS)和细粒度特征(fine-grained features,FG)的有效性。

从AID数据集随机选取50%的样本作为训练集,其余样本作为测试集;从NWPU-RESISC45数据集随机选取20%的样本作为训练集,其余样本作为测试集。

根据表 3计算得出,与仅使用基准模型(实验1)相比,使用基准模型+MS策略(实验2)时,AID和NWPU-RESIC45数据集的分类精度分别提高了3%和3.79%;使用基准模型+FG策略(实验3)时,AID和NWPU-RESIC45数据集的分类精度分别提高了3.35%和3.97%;同时使用基准模型+MS策略+FG策略(实验4)时,网络模型分类性能更好,AID和NWPU-RESISC45数据集的分类精度分别提高了4.05%和5.31%。

| 表 3 消融实验总体精度对比/% Tab.3 Overall Accuracy Comparison on Ablation Experiments/% |

|

从以上结果可以看出,在仅使用MS或FG策略进行实验时,其在数据集上的分类精度与仅使用基准模型相比均有显著提升,而同时使用MS和FG两种策略进行实验时,网络模型能得到比前3组实验更好的分类精度,验证了本文网络结构中多尺度特征和细粒度特征的有效性。

3 结束语本文提出的顾及细粒度信息与残差网络的高分辨率遥感影像场景分类方法可以较好地解决高分辨率遥感影像场景分类中的类内差异和类间相似问题。该方法将多尺度信息和细粒度信息结合起来,利用注意力机制进行特征增强并融合,实现影像场景的有效分类。通过与VGG-VD-16和D-CNNs方法的对比,证实了本文方法可以有效提高分类精度,并对相似易混淆类别场景有更强的区分效果,整体提升了高分辨率遥感影像场景分类的分类性能。

| [1] |

马长辉, 黄登山. 纹理与几何特征信息在高空间分辨率遥感影像分类中的应用[J]. 测绘地理信息, 2019, 44(6): 66-70. |

| [2] |

张通, 潘励. 一种高分辨率遥感影像建筑物自动检测方法[J]. 测绘地理信息, 2020, 45(2): 101-105. |

| [3] |

Penatti O A B, Nogueira K, dos Santos J A. Do Deep Features Generalize from Everyday Objects to Remote Sen-sing and Aerial Scenes Domains? [C]. 2015 IEEE Confe-rence on Computer Vision and Pattern Recognition Workshops (CVPRW), Boston, MA, USA, 2015

|

| [4] |

Marmanis D, Datcu M, Esch T, et al. Deep Learning Earth Observation Classification Using ImageNet Pretrained Networks[J]. IEEE Geoscience and Remote Sen-sing Letters, 2016, 13(1): 105-109. DOI:10.1109/LGRS.2015.2499239 |

| [5] |

Krizhevsky A, Sutskever I, Hinton G E. ImageNet Classification with Deep Convolutional Neural Networks[J]. Communications of the ACM, 2017, 60(6): 84-90. DOI:10.1145/3065386 |

| [6] |

Li E Z, Xia J S, Du P J, et al. Integrating Multilayer Features of Convolutional Neural Networks for Remote Sen-sing Scene Classification[J]. IEEE Transactions on Geoscience and Remote Sensing, 2017, 55(10): 5 653-5 665. DOI:10.1109/TGRS.2017.2711275 |

| [7] |

He K M, Zhang X Y, Ren S Q, et al. Deep Residual Learning for Image Recognition[C]. Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, Boston, MA, USA, 2015

|

| [8] |

Hu J, Shen L, Sun G. Squeeze-and-Excitation Networks[C]. Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, Salt Lake City, Utah, USA, 2018

|

| [9] |

Xia G S, Hu J W, Hu F, et al. AID: A Benchmark Data Set for Performance Evaluation of Aerial Scene Classification[J]. IEEE Transactions on Geoscience and Remote Sensing, 2017, 55(7): 3 965-3 981. DOI:10.1109/TGRS.2017.2685945 |

| [10] |

Cheng G, Han J W, Lu X Q. Remote Sensing Image Scene Classification: Benchmark and State of the Art[J]. Proceedings of the IEEE, 2017, 105(10): 1 865-1 883. DOI:10.1109/JPROC.2017.2675998 |

| [11] |

Nesterov Y. A Method for Solving the Convex Programming Problem with Convergence Rate O(1/K.2)[J]. Doklady Akademii Nauk Sssr, 1983, 269(3): 543-547. |

| [12] |

Cheng G, Yang C Y, YaoX W, et al. When Deep Lear-ning Meets Metric Learning: Remote Sensing Image Scene Classification via Learning Discriminative CNNS[J]. IEEE Transactions on Geoscience and Remote Sensing, 2018, 56(5): 2 811-2 821. DOI:10.1109/TGRS.2017.2783902 |

2021, Vol. 46

2021, Vol. 46