2. 浙江省气象台, 杭州 310017

2. Zhejiang Meteorological Observatory, Hangzhou 310017

在强对流风暴中,由于降水导致的下沉气流将环境较干的空气夹卷进去,使得降水粒子因蒸发或升华剧烈降温,进而导致雷暴内下沉气流温度远低于环境温度,落地时形成冷池,冷池向外强烈流出与周边较暖气团交接形成局地边界结构,称为阵风锋。阵风锋由于其形成机理及结构等特征(张涛等,2013;席宝珠等,2015),具备强烈冷性出流和冷暖交汇的特点,此两个特征表明了阵风锋不管在指示局地雷雨大风的发生还是作为重要的边界层辐合线在激发新生风暴或加强已有风暴中都扮演着重要角色(黄荣等,2012;王艳春等,2014),因此,对阵风锋的准确自动识别和实时报警在日常气象防灾减灾业务中具有重要意义。

关于阵风锋自动识别算法的研究由来已久,基本都集中于对雷达回波特征的提取与识别。由于阵风锋所在的位置为中小尺度的辐合带,大气折射、昆虫和鸟的回波(席宝珠等,2015)等原因,使得在多普勒雷达强度图上有较明显的拥有速度辐合的窄带弱回波特征,几乎所有的识别算法都是对此特征进行识别。Hiroshi Uyeda等(1986)就提出了基于速度辐合线的AGFA(自动识别阵风锋)算法。Troxel等(1994)提出了MIGFA(机器智能识别阵风锋算法),其通过融合气象机理、时空分布等特征,设计了函数统计模版对阵风锋引发的雷达窄带弱回波进行提取,将识别准确率提高到了75% (TDWR雷达)和88% (ASR-9雷达)。MIGFA算法具有阵风锋识别史上里程碑的意义,第一次将函数模版相关(FTC)方法系统化地引入了阵风锋识别,Kwon(1994)利用基于像素点的融合技术对其进行了改进,虽然改进后针对于同一批数据准确率有所提高,但相比原算法文献,准确率其实是出现了较大的下降,平均的准确率由81.5%下降到68%,从侧面可以反映出基于人工函数模版算法的数据依赖性,泛化能力有限。此后虽然国内外学者继续提出了很多算法,但其基本都是建立在MIGFA算法思想基础之上,本质为立足于雷达回波特征统计提取,人工设定预定义模板阈值进行识别的方法(郑佳锋等,2013),也有学者在此基础上改进引入了其他一些图像处理技术,如程浩(2011)引入了熵函式模板,冷亮(2016)引入了数学形态学。Hwang等(2017)在MIGFA基础上将神经模糊理论应用于S波段雷达的阵风锋识别算法,提出了NFGDA(神经模糊阵风锋检测算法),将识别准确率提升到了93%。在忽略样本之间的差异的前提下,上述部分识别算法的准确率如表 1所示,虽然由于样本存在差异,实际准确率对比会有所不同,但通过文献准确率对比,还是能够较明显的发现识别算法效果在近年来有所提升。

|

|

表 1 各类阵风锋识别方法准确率 Table 1 Performance of 7 GF detection algorithm (percent correct) |

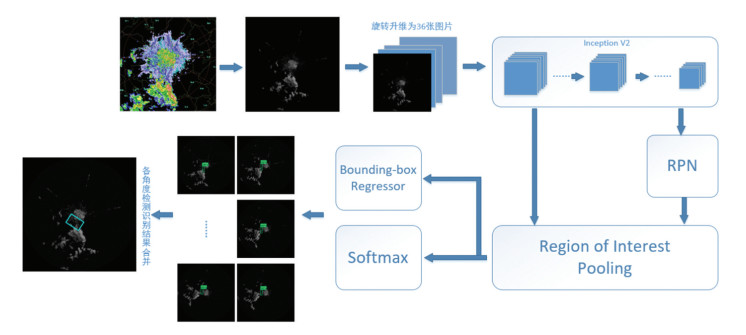

通过对雷达窄带回波进行阵风锋识别,本质上是计算机视觉中的物体检测和识别问题。基于传统的特征模板的识别方法弊端明显:很难找到有限的模板能够匹配所有存在大小形态差异的窄带回波,算法的泛化能力有限,实际业务化困难。为了弥补传统阵风锋识别的缺陷,提升对复杂回波中阵风锋引起的窄带弱回波的自动识别能力以及识别算法泛化性能,本文将Faster RCNN(超快区域卷积神经网络)和Inception V2模型的深度卷积神经网络引入阵风锋识别。将0.5°仰角的S波段多普勒雷达强度产品转化为灰度图像,载入到网络模型中,利用Inception V2模型替代了传统的卷积神经网络,提供了更丰富的图像特征参数。在多层卷积后得到的特征图基础上引入RPN(区域生成网络),并将特征图及待选区域同时送入特征图框池化层后进行分类和回归,在此文中,分类用以识别是否为阵风锋,回归得到正确的包含阵风锋候选框。最后,对多个角度图像的检测和识别结果进行合并,在原始数据中定位和识别出阵风锋的位置和范围。

接下来的文章中包含以下内容:第二部分简要介绍Faster RCNN及数据接入;第三部分将详细阐述改进的基于卷积神经网络的阵风锋识别算法实现细节;第四部分利用已有的数据对训练收敛的模型进行验证分析并利用独立的阵风锋过程对算法的泛化能力进行评估;最后对所做的工作做简单的小结。

1 深度卷积神经网络及数据接入为了更好地理解改进的深度卷积神经网络是如何检测和识别阵风锋的,在这个部分简要回顾了本文所采用的Faster RCNN算法的发展历程。

Faster RCNN由CNN(卷积神经网络)、RCNN(区域卷积神经网络)、Fast RCNN(快速卷积神经网络)发展而来。应用于图像识别分类的卷积神经网络最早由LeCun等(1998)提出并应用在手写字体识别上,在近年来模式识别系统的设计中扮演了越来越重要的角色,其通过卷积层提取多维的图像特征、池化层降低计算维度、全连接层接入流行的分类模型进行分类计算,借助大数据进行网络训练,利用基于梯度下降的后向传播算法得到复杂的超参数网络,对输入图像进行识别分类,是端到端的图像分类网络,LeCun(2014)有比较全面的阐述。在CNN基础上,Girshick等(2014)年提出了RCNN,对通过独立的选择性搜索模型得到的候选框进行CNN计算,得到特征图,然后利用对应的分类器判断分类,最后将分类的结果来修正候选框的位置。RCNN更像一个分类器,没有将候选框的计算与卷积计算紧密结合,由于候选框可能重合,所以就会存在重复的卷积计算,效率低下,无法满足实时业务要求。Girshick(2015)在原先的RCNN基础上结合空间金字塔池化方法(He et al., 2014)发展了Fast RCNN,共享卷积特征图,加入了ROI Pooling层,固定了全连接层输入的尺寸,实现了任意尺寸输入和候选框对卷积特征图的共享,解决了RCNN的计算瓶颈。Ren等(2017)将RPN引入Fast RCNN提出了Faster RCNN,将候选框的生成算法融入到了整体的网络中,解决了一直以来存在的候选框生成上的性能瓶颈问题,将端到端的检测速度提升到了0.2 s,并进一步提升了检测识别的精度。

数据的接入分为两个方面,分别为训练数据集的准备和已训练模型识别数据的接入。训练数据集的准备首先将雷达资料转化为图片集,然后通过LabelImg软件对图片集进行人工标记,得到含有标记信息的XML(可扩展标记语言)文件,将雷达数据转化为灰度图,和XML文件中真实的标记信息组合成tf.train. Example协议内存块,将协议内存块序列化为一个字符串,并且通过tf.python_io.TFRecordWriter写入到TFRecords文件,接入到模型中进行训练。

2 基于Faster RCNN的阵风锋识别算法本节详细介绍如何基于Faster RCNN算法和Inception V2网络模型设计深度卷积神经网络算法对雷达强度窄带回波进行识别。整体框架结构中分为四部分:数据旋转输入、Inception V2卷积网络、基于垂直矩形的候选框预测网络、结果合并输出,具体算法结构如图 1所示。

|

图 1 基于深度卷积神经网络的阵风锋识别算法框架图 Fig. 1 Flowchart of the d-CNNGFDA including data preprocessing, Inception V2, RPN, ROI pooling, and data postprocessing |

在将数据送入到卷积神经网络之前,需要对数据进行旋转处理,这可以使得模型只需要识别竖直走向的阵风锋,在训练数据量较小的情况下能够得到收敛的结果。为了增加算法的鲁棒性,使其能在复杂背景下进行模式识别,在业务化的PUP数据已有质量控制基础上,模型直接利用雷达PUP数据作为其输入。阵风锋在雷达上表现为窄带弱回波,由于地形、风暴母体、边界层环境等影响,窄带弱回波的长短、强弱、走向等变化多端,无规律性可循,但其有两个简单的变换特征稳定存在:(1)窄带回波具有绕雷达中心旋转不变性,即绕雷达旋转,窄带回波的性质保持不变;(2)不管窄带的走向如何,在旋转的过程中,总会出现一个角度,使得其部分区域走向垂直。根据这两个特征,在将数据直接输入到卷积神经网络之前,将0.5°仰角的雷达强度数据转换为灰度图像,作为原始数据,然后绕雷达中心每隔10°旋转一次,共得到36个灰度图片组成的图片集,对其中窄带弱回波的垂直部分进行识别。由于将识别形态、走向复杂的窄带弱回波问题简化为识别单一的垂直走向的窄带弱回波问题,并且每隔10°绕雷达中心旋转得到了原数据量36倍的样本数据。数据旋转输入相比于数据直接输入在增加样本量的同时,降低了学习复杂度,使得神经网络的训练能够有效收敛。

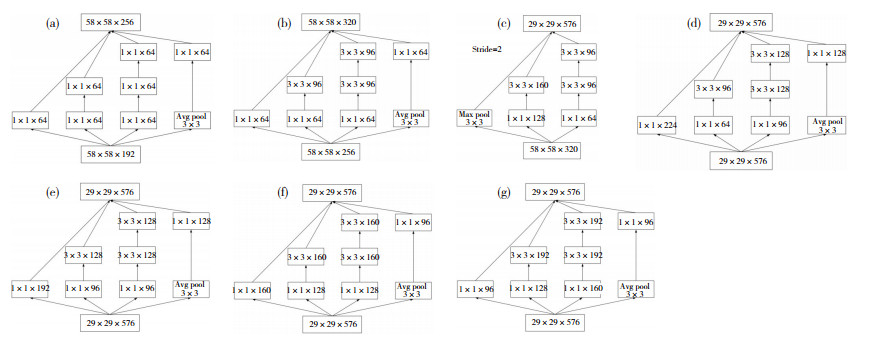

2.2 Inception V2卷积网络本算法直接采用Inception V2卷积网络作为阵风锋特征的提取网络。相对于传统卷积神经网络中卷积层的简单堆叠,Inception卷积神经网络提出了Inception卷积模块叠加的形式构造网络,将大的卷积核分解为1×1或者3×3的Inception卷积核,形成一个近似稀疏的结构(Lecun et al., 2014),增加了网络的宽度和对尺度的适应性,提高了神经网络计算的性能。Ioffe和Szegedy (2015)将批标准化层引入Inception v1网络,使得每一层输出都标准化到N(0,1)的高斯分布(计算方法如公式1所示),降低了不同层之间特征值的分布变化,使得Inception V2允许更大的学习速率,提升了动态收敛后分类的准确性,并对网络的初始化要求更低(Szegedy et al., 2016)。本文所用卷积模型的Inception V2结构图如表 2所示,其中的Inception卷积模块结构如图 2所示,将雷达图原始460×460的尺寸卷积采样至29×29,但深度扩展到了576个,共有卷积参数32 384个。

| $ \hat{x}=\frac{x-E(x)}{\sqrt{\operatorname{var}(x)+∈}} $ | (1) |

其中x为上一层输出值,$\operatorname{Var}(x)=\frac{m}{m-1} \cdot E \sigma^{2}$为方差的无偏估计,σ2为样本方差。针对卷积神经网络,因为权重共享,故均值和方差是相对整个特征图的。

|

|

表 2 Inception V2分层结构 Table 2 The outline of the Inception V2 network architecture |

|

图 2 卷积神经网络模型中所应用的3×Inception层结构图 Fig. 2 3×Inception structure diagrams applied in the convolutional neural network model |

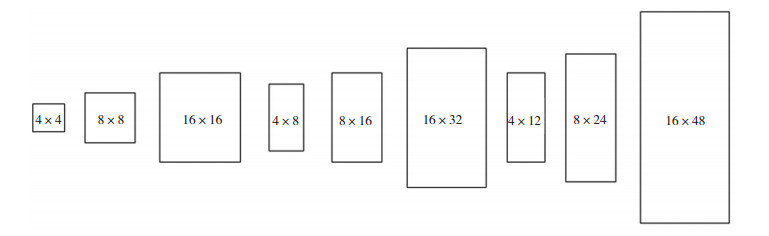

候选框预测网络是集成于Faster RCNN中的子网络,主要作用是检测阵风锋所在的区域外框,其共享了卷积神经网络提取的特征图,并且通过非极大值抑制(NMS)算法将用于分类和回归的候选框由2 000个压缩到256个,大大提高了神经网络运行的速度。候选框中的一个重要概念是Anchor boxes,本文在原有网络的基础上,对其进行了修改配置,使之适应检测区域为主要雷达图旋转后垂直方向的窄带弱回波,即为垂直方向为长边的矩形,RPN网络的Anchor boxes的参数设置为大小16×16,变形参数为[0.25, 0.5, 1.0],纵横比为[1.0, 2.0, 3.0],具体结构如图 3所示。候选框预测网络共享Inception V2输出的特征图,由于Inception V2网络共有42层,卷积神经网络在原始图片的基础上降维了37倍(299×299到8×8)左右,anchor box边框最长为16时,还原到原始图片时,边长为592,能够覆盖整个图像。由于RPN具有大量的重叠,所以引入了基于分类识别分数的非极大值抑制算法消除候选框冗余。非极大值抑制有两个阈值,其一是分类阈值,达到了该阈值才认定为候选框,其二是重叠度(IoU),默认为0.7,即当候选框与正确区域重叠大于0.7时,才认定为候选框,最后取得分最高的256个候选框进行回归和分类操作,在训练完成后的实际预测街道,用300个候选框作为分类评分范围。

|

图 3 适合检测垂直方向阵风锋窄带回波的Anchor boxes Fig. 3 Anchor boxes that detect vertical narrow-band echo |

如前所述,相对于传统的Faster RCNN模型,为了将识别方向和形态各异的阵风锋窄带回波转化为识别特征较为简单的竖直方向窄带回波的集合,本算法在输入端对原始数据每隔10°进行旋转,1个数据转换为36个数据后分别进入模型训练和识别,在输出端,需要将原本旋转后单独检测识别出的矩形框进行合并,求得矩形框最大外包矩形作为最终的检测识别结果,定位阵风锋的位置。如图 4所示,左图为2010年8月4日13时20分南京雷达探测到的雷达原始图片,可以看到在弓形强回波(颜色越亮强度越强)的前沿有明显的窄带弱回波,即阵风锋;经过36个角度旋转后,在本文的识别算法下共有7个角度检测到了阵风锋,分别是50°、60°、180°、210°、220°、230°、260°,每个角度都只检测到了整条弱回波的部分回波段,绿色直立矩形即识别出来的旋转后走向垂直的回波段,其上方为卷积神经网络全连接层的分类概率,在85%到99%之间,识别性能优秀;经过反向旋转相应角度后,右上角绿色倾斜矩形为前述检测框中原图中的集合,经合并分析后得到右下角的阵风锋检测识别结果。

|

图 4 旋转后分段的检测识别结果经合并得到最终的检测识别结果 Fig. 4 Schematic diagram for merging the detection and recognition results |

本文的卷积神经网络的实现基于Tensorflow深度学习框架,网络模型利用预训练的Faster RCNN和Inception V2网络参数进行初始化处理,识别类型修改为1类,输入图像大小为460×460 pixel,卷积阶段步长为16 pixel,Anchor boxes参数如上文所述,最大候选框数量为300,非极大值压制的分类阈值为0.3,IoU阈值设置为0.7,初始训练速率设为0.000 2,10万至15万步训练速率为0.000 02,15万至20万步训练速率为0.000 002。所使用的数据为2007年至2011年南京雷达探测到有阵风锋窄带弱回波的28个体扫回波数据,经旋转后,取带有垂直走向的窄带弱回波共282个数据,随机分为211个训练数据,71个测试数据,由于经过算法改进后,识别目标转化为单一垂直走向的窄带弱回波,该数据量能够使得神经网络收敛。图 5a、b、c分别给出了预测框内分类损失函数值随训练步数的演变、预测框的损失函数值随训练步数的演变、总损失函数值随演练步数的演变。从图中可以看出,分类损失在3万步之前的波动较大,3万步之后开始稳定收敛,而预测框则比较平滑地收敛, 训练结束时总体函数损失降到了0.003,模型训练取得了较好的拟合效果。

|

图 5 预测框内分类损失函数值(a)、预测框的损失函数值(b)、总损失函数值(c)随训练步数演变图 Fig. 5 (a)Losses of classification, (b)bounding box regression and (c)total loss changes with the number of training steps |

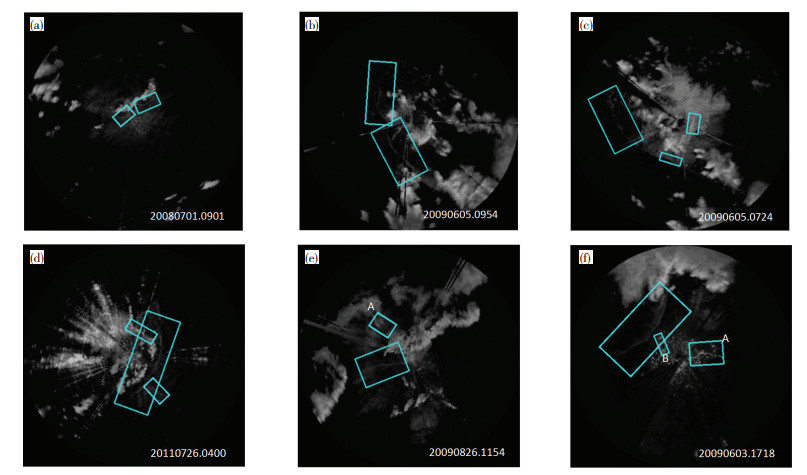

利用训练好的模型对训练集的28个阵风锋个例进行识别,无论窄带回波强弱,走向和纹理是否多变,全部都能够正确检测识别出来,模型的拟合识别率达到了100%。由图 6可知,很多雷达回波图像的杂波较多,都有细条直线干扰回波,但都未被误识别为阵风锋,卷积神经网络的超参数特性增强了其鲁棒性,其端到端的检测识别能力避免了传统识别算法中因为前期滤波平滑等预处理导致的回波信息丢失。另外比较好的性能还在于以下两方面:其一,在20080701.0901、20090605.0954等相邻阵风锋的识别中,本文的算法能够较好地区分不同的阵风锋主体,表现了较好的智能性;其二,对一些存在于降水回波中的窄带回波也表现出了一定的识别能力,比如20090606.0724、20110726.0400两个个例中,这类回波很有可能是风暴复合体内复杂作用的结果,对判断风暴的发展还是消散有重要意义,而传统的识别算法对于降水回波中的线性回波基本没有识别能力。卷积神经网络在识别中也存在一定的误识别,比如20090826.1154的A、20090603.1718的A和B等。针对于此28个个例,共有阵风锋窄带弱回波40条,识别出40条,误识别6条,漏识别0条。按照公式2-4计算,识别准确率(N1)为87%,误识别率(N2)为13%,漏识别率(N3)为0%,所以只要在误识别中加入速度修正,识别准确率还可以再提高。

| $ N_{1}=a /(a+b+c) $ | (2) |

| $ N_{2}=b /(a+b) $ | (3) |

| $ N_{3}=c /(a+c) $ | (4) |

|

图 6 d-CNNGFDA对2007—2011年的南京雷达探测到的6个阵风锋个例数据进行识别的结果 Fig. 6 28 examples of d-CNNGFDA results using the radar reflectivity data from 2007 to 2011 from Nanjing radar station. In the picture, blue boxes denote the gust front |

式(2)、式(3)、式(4)中,a、b、c分别为识别正确数、误识别数、漏识别数。

3.3 泛化能力评估由于在训练阶段,出现了识别准确率100%的结果,为了评估模型是否出现了过拟合问题以及模型的泛化能力,本文进行了模型的泛化能力评估,识别模型算法的泛化能力是其能否满足业务化应用需求的前提。关于阵风锋识别算法的研究很多,除了少数文献(Troxel et al., 1994; Kwon et al., 1994; Yuan Y, 2018)在验证阶段提到过将算法应用到分析资料之外的数据,其他大部分阵风锋自动识别算法文献并未对其泛化能力进行验证。本部分选取2009年6月5日合肥地区雷达监测到的一次阵风锋天气过程进行跟踪反演,将本文的识别算法对此次过程的实际监测和识别能力作为其泛化能力的一个评估依据,此次过程雷达资料未纳入神经网络模型的训练,具有检验的独立性。

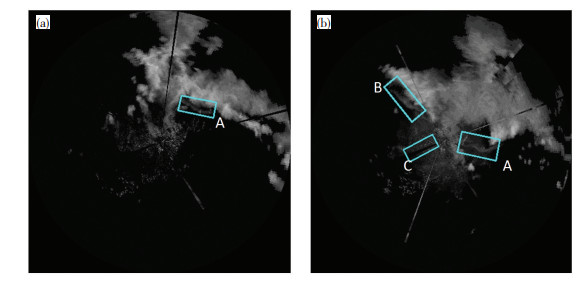

2009年6月5日午后至上半夜,安徽省出现大范围的雷雨大风、冰雹等强对流天气,全省有43个县市、228个乡镇出现8级以上大风,其中淮南20:53(北京时,下同)最大瞬时风速为36 m·s-1,创造了安徽省最大风速记录。此次过程,从雷达图上看,这是一次非常强烈的、影响范围广的阵风锋天气过程。一条长度达300 km的阵风锋自东北向西南方向移动,横扫大半个安徽,给所经之地带来严重的大风灾害,农业损失尤为严重。本文算法对此次过程共32个体扫的雷达资料进行了反演,从雷达回波上看,位于强回波前沿的阵风锋的窄带回波出现在18:39,并且持续了15个体扫,本文算法从18:45监测识别出阵风锋(图 7a中的A框),并且在接下来的13个体扫中跟踪准确,识别率为93%。在19:45,多单体风暴的西北侧又出现一条阵风锋(图 7b中的B框),持续17个体扫,本算法及时识别定位,且在15个体扫中全部识别准确,1个体扫中部分识别准确,识别率为91%。在全部的回波反演中,也出现了一些误识别的现象,如图 7中的C框,对弱的线性杂波出现了误判。从18:39至21:44,共32个体扫,共识别出42个阵风锋结果,其中正确33个,误识别9个,漏识别3个,识别率92%,识别正确率73.3%,误识别率21.4%,漏识别率8.3%。从总体的识别数据和过程反演追踪的情况来看,本算法的泛化能力能够满足业务化要求,对误识别的控制还需进一步提高。

|

图 7 d-CNNGFDA对合肥雷达2009年6月5日(a. 18:45;b. 19:45)阵风锋天气过程的识别结果 Fig. 7 Identification of the gust front based on Hefei radar at (a) 18:45 and (b) 19:45 BT on 5 June 2009 by d-CNNGFDA |

本文通过雷达回波绕雷达中心旋转不变性以及所有不同走向的窄带弱回波都能在某个旋转角度转化为垂直走向这两大特点,基于Faster RCNN和Inception V2,提出了改进的深度卷积网络阵风锋识别算法(d-CNNGFDA),将已有数据进行360°每间隔10°进行旋转,并且只对垂直走向的窄带弱回波进行标记,实现了数据量的扩充,降低了窄带雷达回波的识别复杂度,通过2007—2011年南京雷达数据进行训练得到了深度卷积神经网络模型,并通过合肥雷达探测到的2009年6月5日的阵风锋过程进行了泛化评估。文章的结论如下:

(1) 通过引入深度卷积神经网络,设计的d-CNNGFDA算法跳出了1993年以来几乎所有的阵风锋识别算法都依赖的MIGFA算法思想,避免了人工选取模版参数造成的数据依赖瓶颈,且通过巧妙利用窄带弱回波的绕雷达中心旋转不变性的特性实现了在小数据量的情况下,大型深度神经网络的收敛,得到可以检测识别阵风锋的深度神经网络模型。

(2) 算法对训练数据识别率达到了100%,识别准确率87%,误识别率13%,漏识别为0%。利用独立资料对算法进行泛化能力进行评估,得到总体识别率为91.7%,识别正确率为73.3%,通过评估可得模型并没有过拟合,泛化能力良好,可以应用到业务中对阵风锋进行实时监测报警。

(3) 由于数据标记和数据量的原因,在本文的算法训练和评估过程中,仍然存在着有的资料部分识别阵风锋的问题,但由于深度学习可以通过在线学习不断迭代模型参数,在以后的工作中,将通过人工对新发现的阵风锋进行人工修正后继续加入到学习库中,不断提升模型的检测识别能力。

致谢:感谢江苏省气象局气科所徐芬研究员和安徽省气象台李劲高工为本研究提供雷达资料。

程浩, 刘国庆. 2011. 基于熵函式模板的阵风锋自动识别与实现[J]. 计算机工程与设计, 32(6): 2 173-2 175. |

葛润生. 1986. 阵风锋的雷达探测和研究[J]. 应用气象学报, (2): 113-122. |

黄旋旋, 何彩芬, 徐迪峰, 等. 2008. 5.6阵风锋过程形成机制探讨[J]. 气象, 34(7): 20-26. |

黄荣, 王迎春, 张文龙. 2012. 复杂地形下北京一次局地雷暴新生和增强机制初探[J]. 暴雨灾害, 31(3): 232-241. |

冷亮, 肖艳姣, 吴涛. 2016. 基于数学形态学的阵风锋识别算法[J]. 气象科技, 44(1): 1-6. |

王艳春, 王红艳, 刘黎平. 2014. 华南一次强飑线过程的三维变分风场反演效果分析[J]. 暴雨灾害, 33(4): 305-312. DOI:10.3969/j.issn.1004-9045.2014.04.001 |

席宝珠, 俞小鼎, 孙力, 等. 2015. 我国阵风锋类型与产生机制分析及其主观识别方法[J]. 气象, 41(2): 133-142. |

徐芬, 杨吉, 夏文梅, 等. 2015. 雷达强度数据中的阵风锋特征统计和自动识别[J]. 高原气象, 34(2): 586-595. |

徐芬, 杨吉, 郑媛媛, 等. 2016. MIGFA阵风锋识别算法改进与检验[J]. 气象, 42(1): 44-53. |

张涛, 李柏, 杨洪平, 等. 2013. 三次雷暴导致的阵风锋过程分析[J]. 气象, 39(10): 1275-1283. DOI:10.7519/j.issn.1000-0526.2013.10.005 |

郑佳锋, 张杰, 朱克云, 等. 2013. 阵风锋自动识别与预警[J]. 应用气象学报, 24(1): 117-125. DOI:10.3969/j.issn.1001-7313.2013.01.012 |

Girshick R, Donahue J, Darrell T, et al. 2014. Rich feature hierarchies for accurate object detection and semantic segmentation[C]. Proceedings of the IEEE conference on computer vision and pattern recognition.580-587

|

Girshick R. 2015. Fast r-cnn[C].Proceedings of the IEEE international conference on computer vision. 1440-1448

|

He K, Zhang X, Ren S, et al. 2014. Spatial pyramid pooling in deep convolutional networks for visual recognition[C].European conference on computer vision. Springer, Cham: 346-361

|

Hiroshi Uyeda, Dusan S Zrnic. 1986. Automatic Detection of Gust Fronts[J]. J Atmos Oceanic Technol, 3: 36-50. DOI:10.1175/1520-0426(1986)003<0036:ADOGF>2.0.CO;2 |

Huang Y, Yu T Y, Lakshmanan V, et al. 2017. Neuro-Fuzzy Gust Front Detection Algorithm With S-Band Polarimetric Radar[J]. IEEE Transactions on Geoscience & Remote Sensing, 55(99): 1-11. |

Ioffe S, Szegedy C.2015. Batch normalization: accelerating deep network training by reducing internal covariate shift[C].International Conference on International Conference on Machine Learning.448-456

|

Kwon S M. 1994. Pixel-level data fusion techniques applied to the detection of gust fonts[D]. Boston: Massachusetts Institute of Technology

|

Lecun Y, Bottou L, Bengio Y, et al. 1998. Gradient-based learning applied to document recognition[J]. Proceedings of the IEEE, 86(11): 2 278-2324. DOI:10.1109/5.726791 |

Lecun Y, Boser B E, Denker J S, et al. 2014. Backpropagation Applied to Handwritten Zip Code Recognition[J]. Neural Computation, 1(4): 541-551. |

Ren S, He K, Girshick R, et al. 2017. Faster R-CNN:Towards Real-Time Object Detection with Region Proposal Networks[J]. IEEE Transactions on Pattern Analysis & Machine Intelligence, 39(6): 1 137-1 149. |

Szegedy C, Liu W, Jia Y, et al. 2015. Going deeper with convolutions[C]. Proceedings of the IEEE conference on computer vision and pattern recognition. 1-9

|

Szegedy C, Vanhoucke V, Ioffe S, et al. 2016. Rethinking the inception architecture for computer vision[C]. In ICVV, Proceedings of the IEEE conference on computer vision and pattern recognition: 2 818-28 26

|

Troxel A S W, Delanoy R L. 1994. Machine-intelligent approach to automated gust-front detection for Doppler weather radars[C]. Sensing, Imaging, and Vision for Control and Guidance of Aerospace Vehicles. International Society for Optics and Photonics: 182-193

|

Yuan Y, Wang P, Wang D, et al. 2018. An Algorithm for Automated Identification of Gust Fronts from Doppler Radar Data[J]. Journal of Meteorological Research, 32(3): 444-455. DOI:10.1007/s13351-018-7089-7 |

2020, Vol. 39

2020, Vol. 39