2. 南京航空航天大学 计算机科学与技术学院,江苏 南京 211106

2. College of Computer Science and Technology, Nanjing University of Aeronautics and Astronautics, Nanjing 211106, China

随着自动驾驶技术的发展,基于视觉的道路检测算法在全球范围内得到了广泛应用。这些方法的主要目的是提供将像素点划分为属于或不属于道路区域的能力。鉴于自动驾驶汽车的场景限制,算法多使用柏油马路为主的车道公开数据集进行实验,在具有不同特征的室外人行道上少有研究。对于数量众多的盲人群体来说,检测出人行道能在一定程度上解决出行的问题。因此本文在已有车道检测算法的基础上对人行道的区域分割进行研究。

单目相机依靠成本低廉、校准使用简单、包含图像信息丰富等优势,逐渐成为道路检测的主流设备。单目视觉主要有基于区域和基于纹理2种方法。其中,基于区域的方法[1]是指在图像中寻找颜色、纹理等属性,从背景中将道路区域分割出来。当路面与周围环境明显不同时,这种策略是成功的。然而当道路具有非均匀表面和复杂特征时,任务变得困难起来。基于纹理的方法[2]利用Gabor滤波器的纹理输出进行投票寻找消失点来实现道路区域分割。Gabor滤波器存在大量的方向导致该方法计算量大,难以实时使用。后续研究采用道路先验[3]、上下文信息[4]和最优局部优势定位(optimal local dominant orientation method, OLDOM)[5]等方法对这两种方法进行改善。虽然在一定程度上起到提高检测精度和缩短运行时间的作用,但是单目视觉算法仍然存在三维信息丢失导致的模糊问题。

已有学者开始尝试利用三维的深度线索来探测路面。通过将问题限制在平面道路上,文献[6]的工作发现V视差图中道路的纵断面被投影成对角线直线,利用U视差图去除部分垂直障碍物,再通过曲线拟合技术对直线进行提取,映射出道路区域。文献[7]则在U-V视差图法的基础上采用RANSAC对随机采样的视差斑块进行道路平面参数的计算,通过引入道路平面坡度约束,去除不可靠的斑块。但是双目视觉系统的基线和图像分辨率限制了测量精度,直接使用深度等三维信息可能产生不可靠的结果。

道路检测的另一种思路侧重于融合和分类。随着机器学习应用越来越受到重视,研究者开始对道路提取到的信息进行融合。除了颜色信息之外,Gabor特征[8]、多尺度特征[9]以及位置先验特征[10]也逐渐被使用。然而简单地将上述二维特征信息进行融合,对于一些复杂的人行道场景,比如树木阴影、背景特征相似性干扰等,检测结果存在一定程度的误差。

分析上述问题,本文提出了一种改进的多特征融合人行道检测算法。考虑到像素级图像操作会增加后续处理复杂度和噪声干扰,因此通过比较不同的超像素算法,选取效果最佳的方法将人行道数据集图像分割成区域级图像,并研究超像素参数对检测精度的影响。为了解决Gabor滤波器存在大量方向导致的高时间复杂度问题,根据人行道的纹理特点提出一种改进算法来加速特征的提取。由于背景特征相似性带来相应的干扰,所以融合了三维特征和常用的二维特征,并提出了基于PCA的光照不变空间特征(简称PCA-II)来减少强光和阴影带来的影响。超像素参数非自适应性会导致道路边缘出现凹凸的现象,因此利用马尔可夫随机场(Markov random field, MRF)对分割结果进行细化。

1 多特征融合的人行道检测算法本文提出的人行道检测算法主要由3部分组成,如图1所示。第1部分采用超像素算法将RGB图像分割成超像素图,并进行立体匹配[11]和PCA-II转换得到视差图和PCA-II图;第2部分提取各超像素块的RGB、HSV颜色特征、位置特征、PCA-II特征以及三维深度梯度特征,利用改进的Gabor滤波器加速算法对纹理特征进行提取;第3部分选用Adaboost分类器对多特征进行融合,并通过MRF对分割结果进行细化。

|

Download:

|

| 图 1 人行道检测算法流程 | |

本文在文献[12]提出的基于机器学习的车道检测算法基础上,将PCA-II特征和三维深度信息用于人行道检测,以减少光照变化和背景特征相似性干扰的影响。为了更好地反映二维和三维特征的协同作用,遵循文献[13]的思想,在早期阶段对提取的特征进行融合。将从二维和三维信息中提取的特征向量组合成机器学习分类器的输入,即

| ${v_{{\rm{fusion}}}} = \left( {{v_{{\rm{2D}}}},{v_{{\rm{3D}}}}} \right)$ |

在二维特征的选择上,首先考虑图像检索中应用最广泛的颜色特征,RGB和HSV空间作为最常用的颜色空间,能够很大程度上提供与色彩相关的有效信息,同时验证不同色彩空间对于检测精度的影响。观察数据集图像时发现,人行道区域由两条相交于地平线处的道路特征线包围且多位于图像的正下方,因此选择位置特征信息以排除图像正上方的背景干扰块。由于现实生活中大部分人行道具有独特的花纹和线条方向差异,选择基于时间局部化的Gabor变换提取图像边缘的多方向和多尺度特征作为纹理特征,可以有效地定位目标区域。梯度值表示图像中某个邻域内的灰度变化,典型的梯度特征描述子(gradient kernel descriptor, GKDES)为方向梯度直方图(histogram of oriented gradients, HOG)特征,结合SVM分类器被广泛用于行人检测中。鉴于人行道区域的边缘丰富,因此选择GKDES作为人行道检测的候选特征。在基于相机的视觉系统中,光照的变化会产生不需要的伪像,从而显著影响实验程序的结果,所以引入PCA-II特征实现图像对光的分离效果。

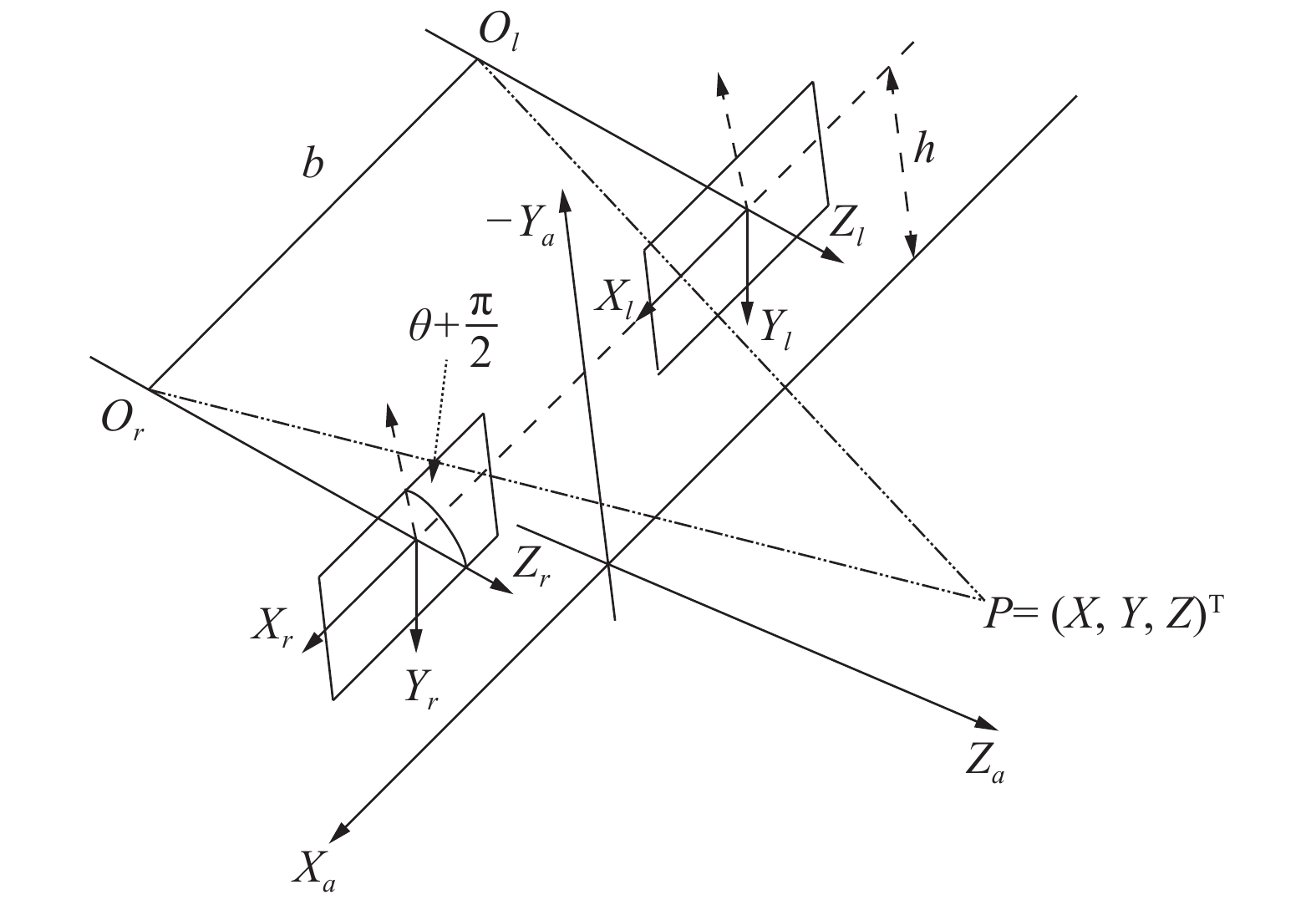

在三维特征的选择上,本文实验的设备为双目摄像头,能够在运动或静止状态下对目标进行深度估计,原理如图2所示。假设将现实中的目标点

| $\left\{ \begin{array}{l}\!\!{u_i} = {u_0} + \dfrac{{fX - {\varepsilon _i}\dfrac{b}{2}f}}{{(Y + h)\sin \theta + Z\cos \theta }}\\ \!\!v = {v_0} - f\tan \theta + \dfrac{{f(Y + h)}}{{\cos \theta [(Y + h)\sin \theta + Z\cos \theta ]}}\end{array} \right.$ | (1) |

式中:

| $\varDelta = \frac{{fb}}{{(Y + h)\sin \theta + Z\cos \theta }}$ | (2) |

联立式(1)、(2)可知

| $Y = \frac{{b(v\cos \theta - {v_0}\cos \theta + f\sin \theta )}}{\varDelta } - h$ |

因为路面的深度从近到远呈现近似线性增加,不会产生较大的数值波动,因此选择深度梯度特征子(depth gradient kernel descriptor, DGKDES)作为三维融合特征可以获取水平面的大致区域,剔除视差突变区域以及无视差区域。

选择合适的交叉特征融合策略,首先独立评估二维和三维特征的检测精度,然后有选择地对二维和三维特征进行组合进行效果评估。特征选择和组合的细节将在实验部分中展示。

|

Download:

|

| 图 2 双目视觉原理 | |

基于文献[5]的道路检测方法以及考虑人行道纹理的特殊性,本文为图像卷积定义了32个Gabor滤波器:4个频率8个方向,在超像素块上进行像素平均操作后得到32维向量作为分类器输入。但是由于使用的样本数据集图像规模在千张数量级,提取32维的Gabor纹理特征将会耗费大量时间,因此需要对该算法进行改进以加速纹理特征的提取。

首先,定义8个Gabor能量对应方向值为

| $ {g_{\phi ,{\omega _0}}}(x,y) = \frac{{{\omega _0}}}{{\sqrt {2{{\text{π}}}} c}}{{\rm{e}}^{ - {\omega _0}^2(4{a^2} + {b^2})/8{c^2}}}({{\rm{e}}^{ia{w_0}}} - {{\rm{e}}^{ - {c^2}/2}}) $ |

式中:

| ${I_{\phi ,{\omega _0}}}(p) = I(p) \otimes {g_{\phi ,{\omega _0}}}(p)$ |

因此像素

| ${E_{\phi ,{\omega _0}}}(p) = \sqrt {\operatorname{Re} {{\left( {{I_{\phi ,{\omega _0}}}\left( p \right)} \right)}^2} + \operatorname{Im} {{\left( {{I_{\phi ,{\omega _0}}}\left( p \right)} \right)}^2}} $ | (3) |

当数据集输入图像像素为

| $\begin{split} & {E^1}_{\phi ,{\omega _0}}\left( k \right) > {E^2}_{\phi ,{\omega _0}}\left( k \right) > {E^3}_{\phi ,{\omega _0}}\left( k \right) > {E^4}_{\phi ,{\omega _0}}\left( k \right) > \\ & {E^5}_{\phi ,{\omega _0}}\left( k \right) > {E^6}_{\phi ,{\omega _0}}\left( k \right) > {E^7}_{\phi ,{\omega _0}}\left( k \right) > {E^8}_{\phi ,{\omega _0}}\left( k \right) \end{split} $ |

式中最大值

| ${\rm{Conf}}\left( k \right) = \left\{ \begin{array}{l} \!\!{1 - \dfrac{{{E^8}_{\phi ,{\omega _0}}\left( k \right)}}{{{E^1}_{\phi ,{\omega _0}}\left( k \right)}},\quad {E^1}_{\phi ,{\omega _0}}\left( k \right) > {E_{{\rm{th}}}}}\\ \!\!{0,\quad {E^1}_{\phi ,{\omega _0}}\left( k \right) \leqslant {E_{{\rm{th}}}}} \end{array} \right.$ |

式中

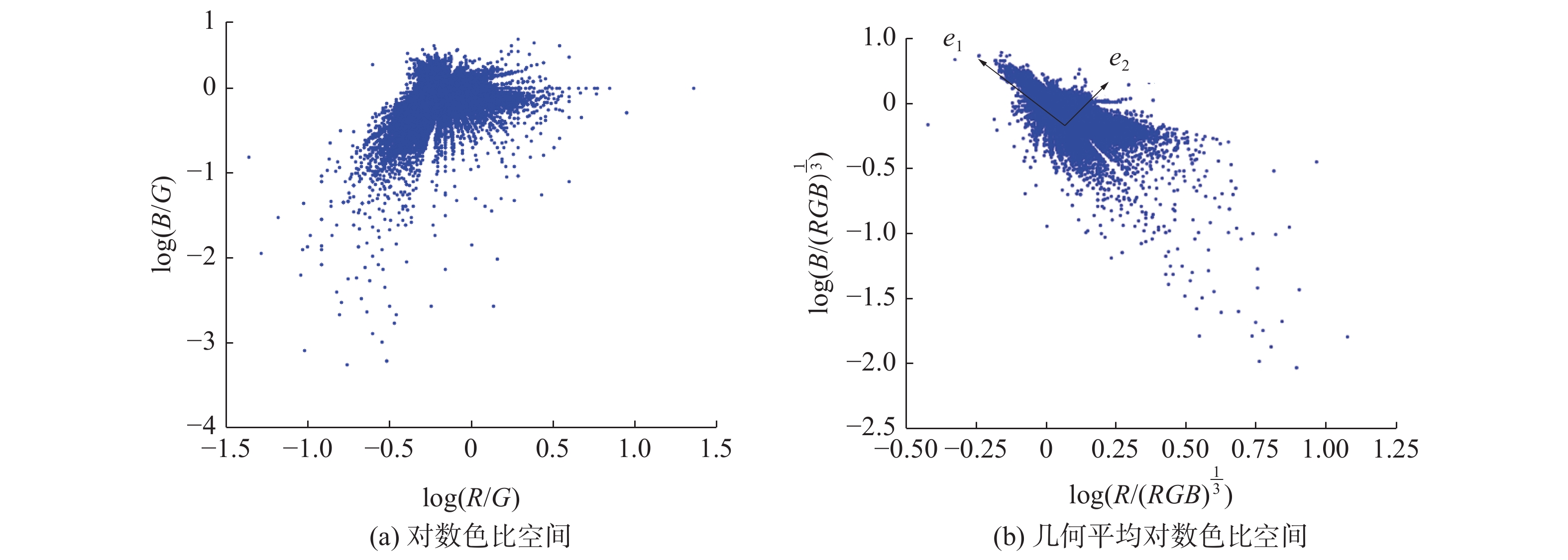

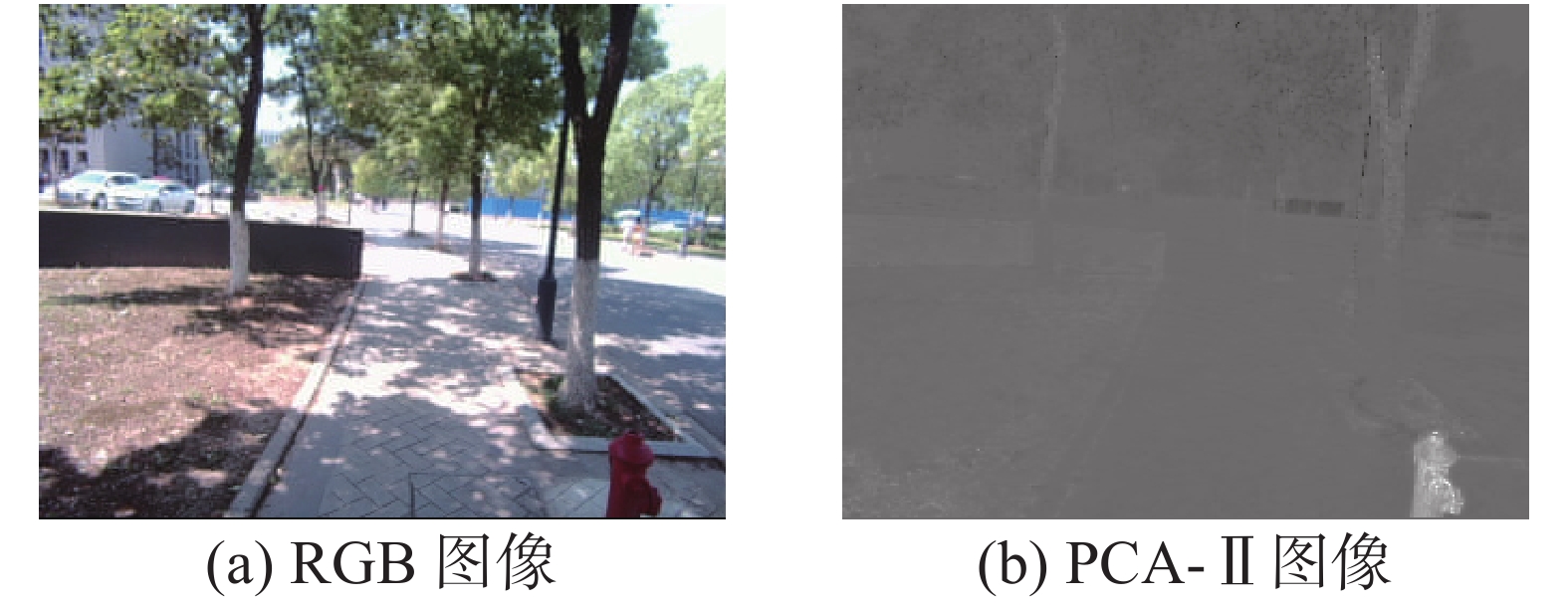

光照不变空间的原理如图3所示,具有不同强度相同色度的RGB颜色被映射到色比空间的同一虚线上,与所有虚线正交的实线

|

Download:

|

| 图 3 光照不变空间原理 | |

首先介绍2种二维色比空间。第1种计算每个像素的对数颜色比率,即

| $\left\{ \begin{array}{l} \!\!r = \log \left( {\dfrac{R}{G}} \right) \\ \!\!b = \log \left( {\dfrac{B}{G}} \right) \end{array} \right.$ |

该方法利用

| $\left\{ \begin{array}{l} \!\!r = \log \left( {\dfrac{R}{{{{\left( {RGB} \right)}^{1/3}}}}} \right) \\ \!\!b = \log \left( {\dfrac{B}{{{{\left( {RGB} \right)}^{1/3}}}}} \right) \end{array} \right.$ |

确定合适的色比空间映射函数是计算高质量光照不变空间的关键,因此利用创建的人行道数据集对2种映射函数进行检验,部分结果如图4所示。

|

Download:

|

| 图 4 色比空间像素散点图 | |

对比图4(a)和(b)发现,人行道数据集图像更适合几何平均对数色比空间,因为点与点之间更密集且扁平,同时二维色比空间内的像素投影到一维色度投影线

本文发现散点图分布近似于椭圆形,适用于PCA的最大方差理论,即将最大方差的主方向作为色度投影的方向。因此利用PCA作为全局方法标识出具有最大方差的半主轴。将所有像素的

| ${{C}} = {{X}}{{{X}}^{\rm{T}}} = \left[ {\begin{array}{*{20}{c}} {{{{e}}_1}}&{{{{e}}_2}} \end{array}} \right]\left[ {\begin{array}{*{20}{c}} {{\lambda _1}}&0 \\ 0&{{\lambda _2}} \end{array}} \right]\left[ {\begin{array}{*{20}{c}} {{{{e}}_1}^{\rm{T}}} \\ {{{{e}}_2}^{\rm{T}}} \end{array}} \right]$ |

图4(b)中

|

Download:

|

| 图 5 PCA-II转换特征图 | |

本文所使用的人行道数据集均由高清USB双目摄像头采集,可支持的分辨最高可达2 560 pix×960 pix,对应帧数可稳定保持在60 F/s,水平70°视角无畸变,基线长度为59.5 mm。数据集图像在强光照和阴暗天气下分别以行人视角进行拍摄,观察实际环境发现拍摄场景大致分为2类:第1种是仅包含人行道的非机动车区域场景,第2种指柏油马路机动车道和人行道同时出现的路边街道场景。实验共收集2 000组双目图像,训练集和测试集各分配1 000组图像数据。为了缩短训练时间,数据集图像分辨率选择为320 pix×240 pix。人行道区域标注部分使用开源图像标注工具Labelme,人工选取道路覆盖区域生成json文件,利用cmd指令转换成相应的Mask数据用于本文算法的训练和预测。

2.2 超像素算法评估目前超像素算法主要分为2类,即SL、GraphCut等基于图论的方法和VCells、TurboPixels、SLIC等基于聚类的方法。本文在人行道数据集上对上述超像素算法性能进行评估,评估指标包括欠分割错误率(under-segmentation error, UE)、边界响应率(boundary recall, BR)、可实现分割精度(achievable segmentation accuracy, ASA)以及运行时间表现(runtime performance, RF),实验结果如图6、7所示。

|

Download:

|

| 图 6 不同超像素算法性能 | |

|

Download:

|

| 图 7 不同超像素算法分割效果图 | |

根据图6(a)和(b)可以看出,Vcells和SLIC在欠分割错误率和边界响应率上都具有较优的表现。欠分割错误率低说明在地面真值附近的超像素紧密;边界响应率高体现切割出的边缘尽可能多地是图像自然边缘,能很好地保持地面真值分割的边界。尽管SL在边界响应率上有最好的表现,但是在其他指标上的表现使其难以应用。图6(d)可以很明显地看出SLIC在运行时间表现上远优于Vcells,约比Vcells快20倍。综合以上的分析,本文在人行道检测上选择SLIC作为图像预处理的超像素算法。

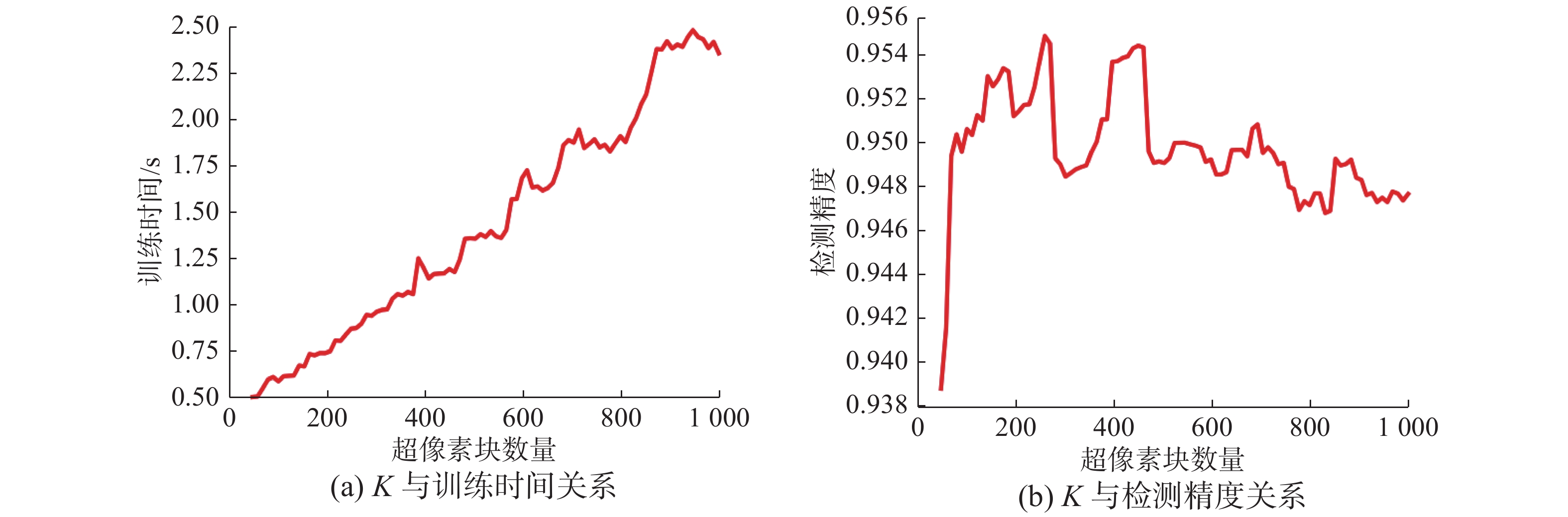

SLIC具有唯一参数超像素块数K,为了验证该参数对人行道检测精度的影响,该实验基于RGB+POS+HSV特征组合,K从100~1 000间隔为10地选取数值,对每张图像训练时间和超像素块检测精度进行统计,如图8所示。

|

Download:

|

| 图 8 SLIC参数K评估 | |

根据实验数据可知,由于以超像素块为基准进行特征提取,随着

首先在保证检测精度受影响较小的前提下选取改进算法的阈值

|

|

表 1 Gabor滤波器纹理提取加速效果 |

结合实验结果可知,当置信度阈值

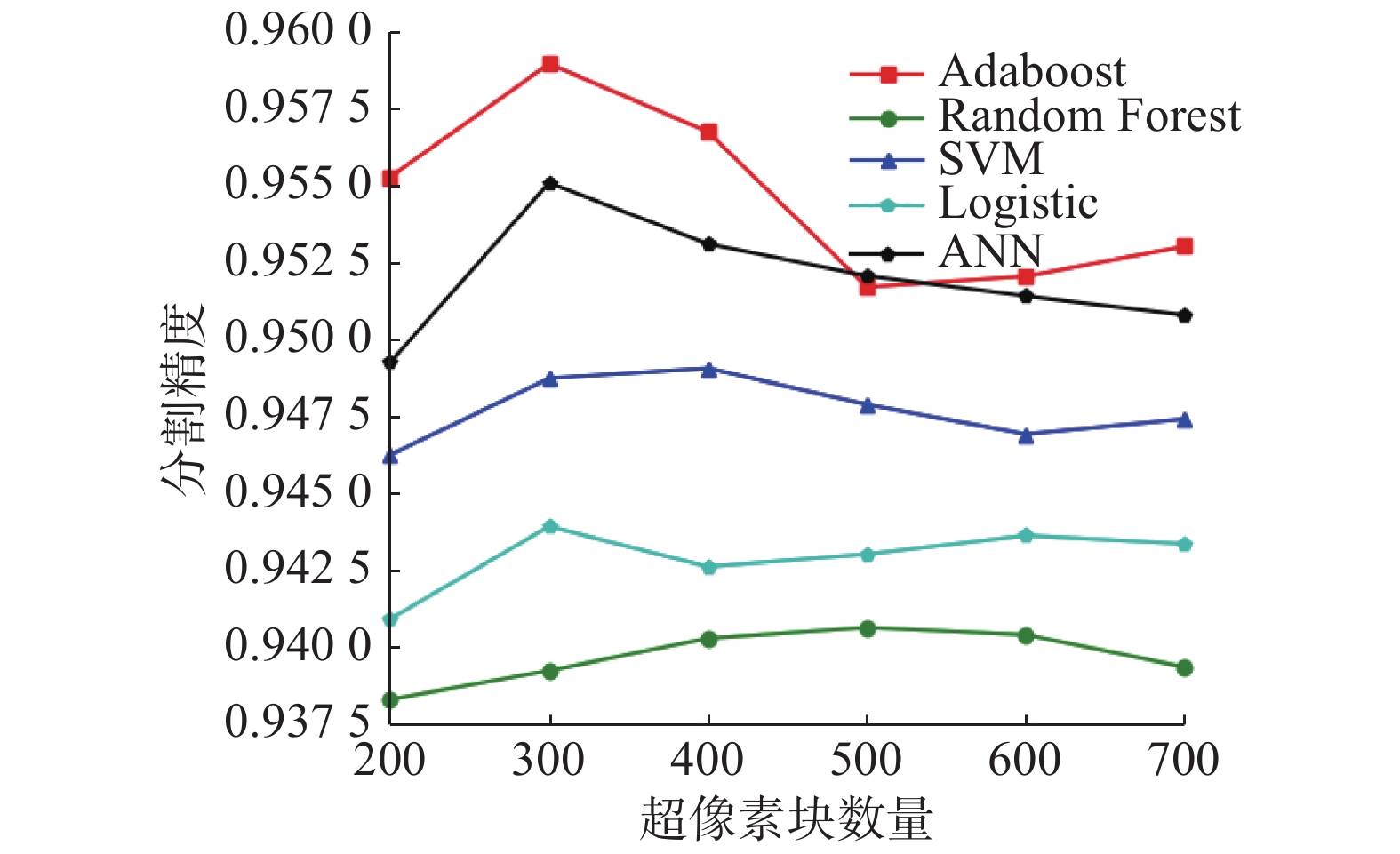

首选通过对比实验观察不同分类器对人行道检测精度的影响。使用的特征组合是“RGB+Gabor+POS”,待验证的机器学习算法包括:Adaboost、Random Forest、SVM、ANN和Logistic。图9展示了不同分类器的检测精度,可以发现Adaboost在本数据集中的表现明显优于其他算法。

|

Download:

|

| 图 9 不同分类器的分割精度 | |

根据路面真实情况和算法的检测结果,将测试样本中的超像素块标记为4种情况:TP、TN、FP、FN。采用4种指标来描述检测性能:质量(Q),检出率(P),检测精度(R)以及有效性(F)。

分别对每种特征进行评估,然后有选择地融合,得到最佳的特征组合。表2展示了每种特征在Adaboost分类器下单独评估时的结果。

|

|

表 2 道路特征单独评估结果 |

比较它们之间的表达能力,发现纹理特征对人行道的识别力最强,梯度描述子的识别力最弱。这是因为人行道多数是由砖块铺设而成,存在着多个方向的明显纹理,而背景中较多像素在X、Y方向上的梯度变化较大,这与人行道的梯度数值基本相同,起到干扰的作用。

RGB和HSV表示的是颜色信息,RGB比HSV识别道路的能力更好,Gabor提供的是纹理信息,POS表达的是位置信息,GKDES的检测结果最差,PCA-II和DGKDES是新加入的特征,因此首先选择4种组合方式:“RGB+Gabor”、“HSV+POS”、“HSV+Gabor”和“RGB+Gabor+POS”。根据表3的评估结果说明“RGB+Gabor+POS”组合的表现最好。

|

|

表 3 基本道路特征组合评估结果 |

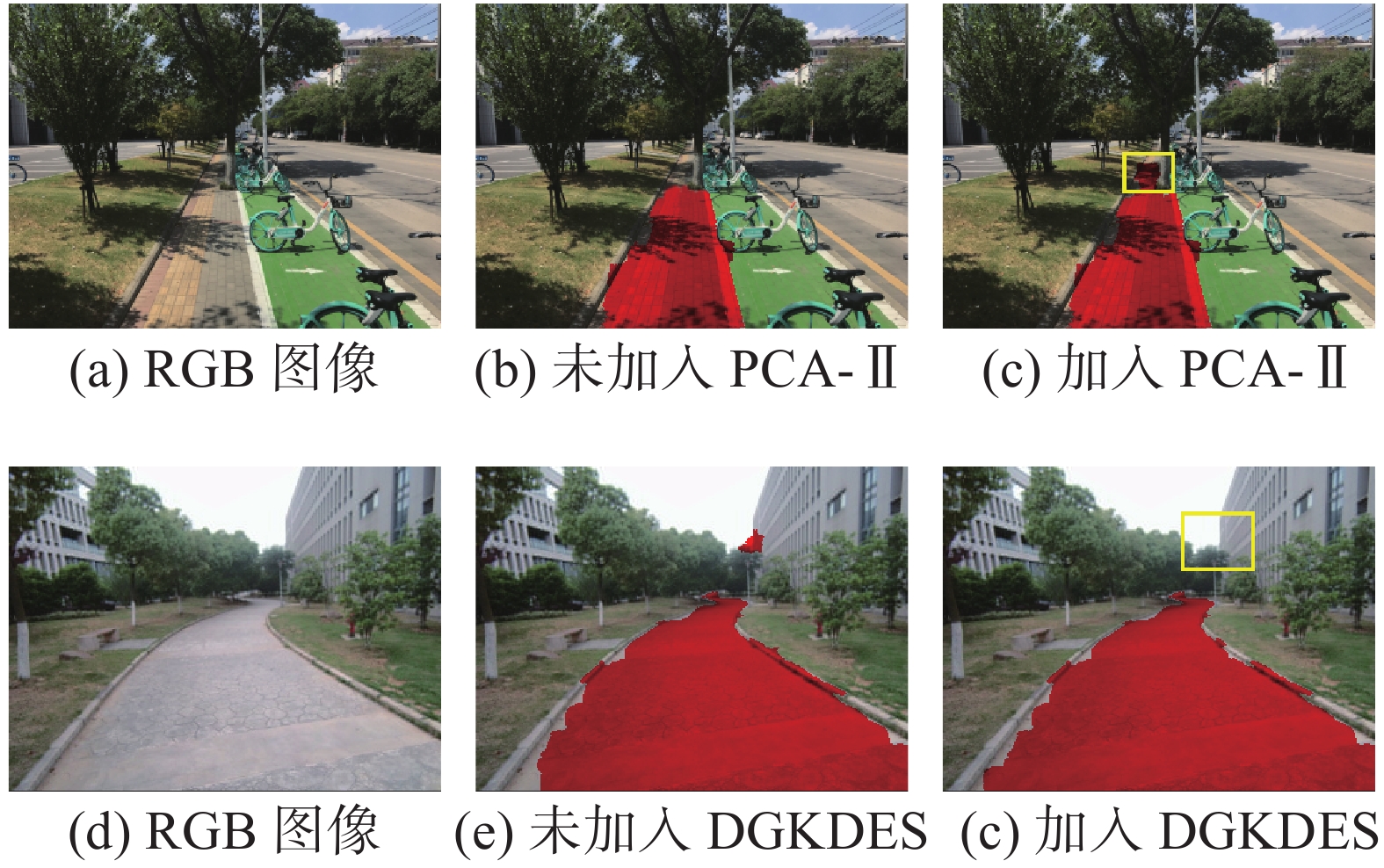

在特征框架“RGB+Gabor+POS”(简称“RGP”)的基础上,对新加入的PCA-II和DGKDES特征分别验证其效果,结果如图10所示。

|

Download:

|

| 图 10 PCA-II和DGKDES特征改进效果 | |

根据图9的检测效果可发现,PCA-II特征弥补了原有特征组合无法检测部分阴影区域的缺点,DGKDES特征能够消除部分不在人行道同一平面的误判超像素块,从而使检测效果更接近地面真实值,精度提高效果如表4所示。

|

|

表 4 PCA-II和DGKDES新特征评估结果 |

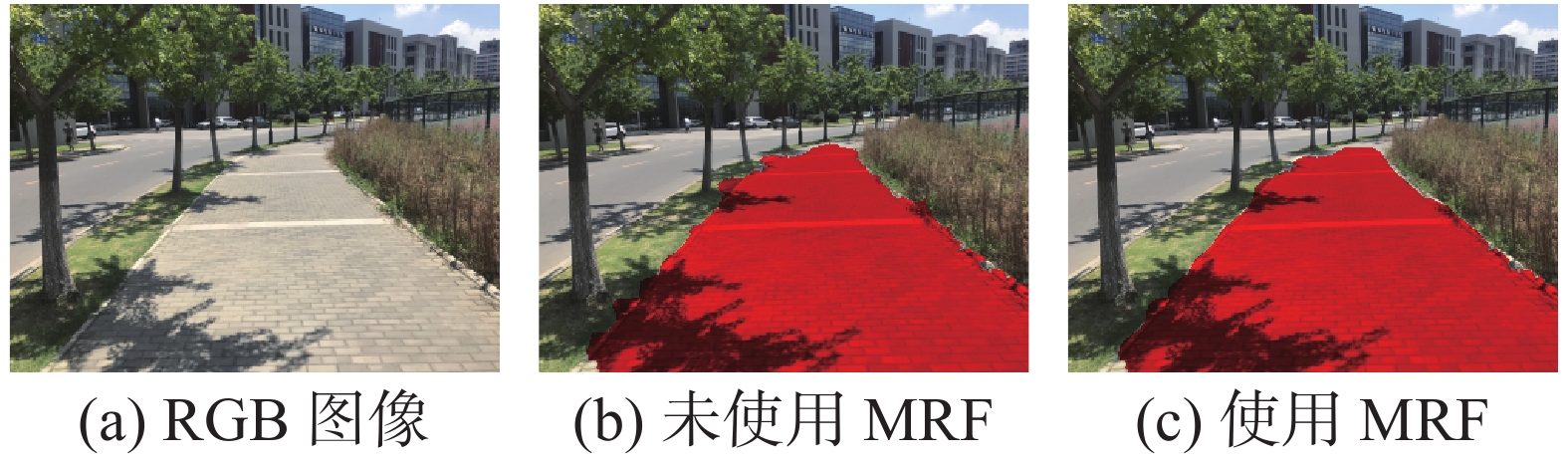

为了验证MRF后处理技术的重要性,本文将未经过MRF处理和经过MRF处理的检测结果进行比较,如图11所示。通过MRF分割优化后,可以发现在不影响检测精度的同时,检测出的人行道边缘与真实地面的轮廓更拟合,道路区域和非道路区域分界线的凹凸现象得到改善,补偿了SLIC超像素块进行预处理时

|

Download:

|

| 图 11 MRF算法优化效果 | |

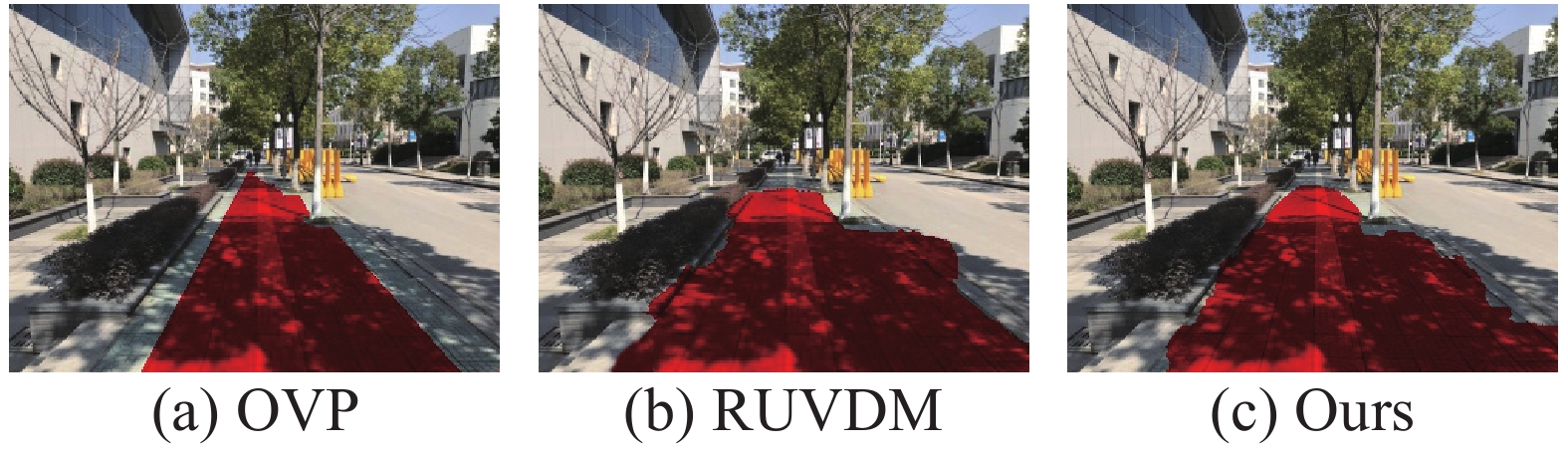

本文将提出的算法与其他道路检测方法的检测效果进行了对比,将利用OLDOM完善的消失点法(OLDOM vanishing point, OVP)[5]和利用RANSAC改善的U-V视差图法(RANSAC U-V disparity map, RUVDM)[7]在本文创建的人行道数据集上进行测试,检测结果如表5所示。根据结果可知,本文提出的人行道检测算法的有效性比OVP提高了1.425%,比RUVDM提高了0.585%。观察图12的检测效果,OVP虽然有很高的检出像素准确度,但是两侧存在许多漏检区域;RUVDM在检测地平面时由于人行道和车道之间的深度差异小导致部分车道区域被误检,相比之下本文提出的算法具有一定的优势。

|

|

表 5 3种人行道检测算法的结果比较 |

|

Download:

|

| 图 12 3种人行道检测算法效果 | |

在盲人出行等问题上,通常需要将人行道路面检测作为起始步骤,以提供几何约束方便后续处理。

1)在本文中,我们提出了一种改进的多特征人行道检测算法,在原有基础特征上加入PCA-II特征和深度梯度特征来克服光照条件和背景非地平面干扰超像素块的影响。

2)与此同时,使用一种基于8个方向Gabor滤波器能量值关系的改进算法对纹理提取进行加速。实验在手工拍摄标注的人行道数据集上进行,证明了该算法能够适用于大部分情况下的路面。

然而,本算法只是在小样本的数据集上进行测试,今后将逐步扩大数据集的样本数量和类型,以验证方法的有效性和普适性。

| [1] |

李迎春, 付兴建, 薛琴. 基于RGB熵的非结构化道路分割方法[J]. 计算机工程与设计, 2017, 38(6): 1571-1574. ( 0) 0)

|

| [2] |

傅重添, 杨健, 路飞飞. 基于纹理的复杂环境下道路消失点检测算法[J]. 计算机应用与软件, 2014, 31(6): 292-294, 314. DOI:10.3969/j.issn.1000-386x.2014.06.079 ( 0) 0)

|

| [3] |

SHINZATO P Y, GRASSI V, OSORIO F S, et al. Fast visual road recognition and horizon detection using multiple artificial neural networks[C]//Proceedings of 2012 IEEE Intelligent Vehicles Symposium. Alcala de Henares, Spain, 2012: 1090–1095.

( 0) 0)

|

| [4] |

WANG Qi, FANG Jianwu, YUAN Yuan. Adaptive road detection via context-aware label transfer[J]. Neurocomputing, 2015, 158: 174-183. DOI:10.1016/j.neucom.2015.01.054 ( 0) 0)

|

| [5] |

VALENTE M, STANCIULESCU B. Real-time method for general road segmentation[C]//Proceedings of 2017 IEEE Intelligent Vehicles Symposium. Los Angeles, USA, 2017: 443–447.

( 0) 0)

|

| [6] |

WU Meiqing, LAM S K, SRIKANTHAN T. Nonparametric technique based high-speed road surface detection[J]. IEEE transactions on intelligent transportation systems, 2015, 16(2): 874-884. ( 0) 0)

|

| [7] |

YANG Qingqing, FAN Shengli, WANG Lang, et al. Road detection by RANSAC on randomly sampled patches with slanted plane prior[C]//Proceedings of the IEEE 13th International Conference on Signal Processing (ICSP). Chengdu, China, 2016: 929–933.

( 0) 0)

|

| [8] |

GAO Qi, FENG Yan, WANG Li. A real-time lane detection and tracking algorithm[C]//Proceedings of the IEEE 2nd Information Technology, Networking, Electronic and Automation Control Conference (ITNEC). Chengdu, China, 2017: 1230–1234.

( 0) 0)

|

| [9] |

陈飞, 章东平. 基于多尺度特征融合的Faster-RCNN道路目标检测[J]. 中国计量大学学报, 2018, 29(4): 394-397. ( 0) 0)

|

| [10] |

KANG Yousun, YAMAGUCHI K, NAITO K, et al. Road image segmentation and recognition using hierarchical Bag-of-Textons method[C]//Proceedings of the 5th Pacific Rim Symposium on Advances in Image and Video Technology. Gwangju, South Korea, 2011: 248–256.

( 0) 0)

|

| [11] |

YUE Xinyu, WANG Fangrong, GUO Baicang, et al. Disparity map optimization based on edge detection[C]//Proceedings of 2018 Chinese Control and Decision Conference (CCDC). Shenyang, China, 2018: 3311–3315.

( 0) 0)

|

| [12] |

CHACRA D A, ZELEK J. Road segmentation in street view images using texture information[C]//Proceedings of the 13th Conference on Computer and Robot Vision (CRV). Victoria, Canada, 2016: 424–431.

( 0) 0)

|

| [13] |

NGUYEN T T, SPEHR J, ZUG S, et al. Multisource fusion for robust road detection using online estimated reliabilities[J]. IEEE transactions on industrial informatics, 2018, 14(11): 4927-4939. DOI:10.1109/TII.2018.2865582 ( 0) 0)

|

| [14] |

ALVAREZ J M A, LOPEZ A M. Road detection based on illuminant invariance[J]. IEEE transactions on intelligent transportation systems, 2011, 12(1): 184-193. DOI:10.1109/TITS.2010.2076349 ( 0) 0)

|

2020, Vol. 47

2020, Vol. 47