|

收稿日期: 2016-09-06; 修改日期: 2016-11-25; 优先数字出版日期: 2016-12-02

基金项目: 中国科学院太空应用重点实验室基金项目(编号:CXJJ-15S092)

第一作者简介: 李盛阳(1976— ),男,研究员,研究方向为航天地面数据系统技术,遥感信息处理技术与方法。E-mail:

shyli@csu.ac.cn

中图分类号: TP391

文献标识码: A

|

摘要

本文面向多源高分辨率遥感影像自动化融合的应用需求,探索按需应用的智能化融合方法,充分利用不同分辨率和不同时相的高分辨率多源遥感影像数据资源与特性,研究了影像融合数据源选取的决策树算法,建立了遥感影像融合规则知识库,并自动化选取适合的融合算法,提出了Curvelet_HCS算法,对低频和高频系数选用不同的融合规则,改善了HCS算法的光谱失真问题,可同时融合多光谱影像的多个谱段,并保持更丰富的空间细节信息。根据融合评价结果对遥感影像融合规则知识库进行更新,实验验证表明了该套方法的有效性,为开展大规模智能化的多源遥感影像融合应用提供了重要的方法和技术支撑。

关键词

高分辨率, 遥感影像, 智能融合, 决策树, 融合算法, 规则知识

Abstract

Intelligent fusion of multi-source high resolution remote sensing images is attracting more attention due to its extensive applications. To satisfy application requirements of multi-source high resolution remote sensing image fusion, this paper studies " on-demand” intelligent fusion of multi-source remote sensing images. Particularly, this study focuses on intelligent fusion of different temporal high-resolution remote sensing images at different resolutions. This paper presents a novel intelligent fusion approach to achieve automatic image source selection as well as fusion method recommendation. This research applies the decision tree algorithm to high resolution remote sensing image fusion. The decision tree is trained to build the knowledge base of fusion rules, which is off-line updated. Each training sample consists of remote sensing images, fusion methods, and the evaluation results. Besides, to solve the problem of spectral distortion cause by hyperspherical color space transform, this paper proposes a fusion method renamed as Curvelet-HCS based on the second generation Curvelet transform and hyperspherical color space transform. The main idea of Curvelet-HCS is as follows. Curvelet-HCS decompose the image into low and high frequency components and employ different fusion rules for these two components. In detail, for the low frequency component, low frequency coefficients are computed as a weighted sum of low frequency coefficients of two fusing images, where weights are defined as functions of regional standard deviation and the local direction information entropy. Similarly, for the high frequency component, the high frequency coefficients are determined by the maximum. This research experiment the Curvelet-HCS method with different sources of satellite images, including the GF-1 and GF-2 satellite multispectral and panchromatic images. To evaluate the fusion performance of the proposed approach objectively, the fused images are quantitatively analyzed based on the mean, the standard deviation, the correlation coefficient, the information entropy and the average gradient. The results show that the image has a better visual effect after fusion, and the proposed fusion method achieves better performance compared to other fusion methods including Principal Component Analysis, Gramm-Schmidt, and Hyperspherical Color Sharpening. This thesis presents an intelligent fusion method by studying the relationship among the remote sensing images, the fusion methods and the evaluation results. This fusion approach improves the level of automation and intelligence of multi-resource high resolution remote sensing image fusion. It is a beneficial exploration for researching the intelligent on-demand service pattern. Also, this paper proposes a Curvelet-HCS fusion method which can fuse more than three bands of MS image at one time. The experimental results demonstrate that the proposed method is an effective method for fusing multispectral image and panchromatic image, and obtains good fused images.

Key words

high resolution, remote sensing image, intelligent fusion, decision tree, fusion method, fusion rules

1 引 言

随着多平台、多时相、多光谱及多分辨率遥感卫星系统的大量涌现,可见近红外、短波红外、热红外、微波等多源遥感数据资源愈加丰富,尤其是高分辨率遥感影像数据在土地利用、农业监测、生态环境监测、灾害监测等众多领域发挥了巨大作用(吴田军 等,2016;Ranchin和Wald,2000;Alparone 等,2001;Garzelli,2002)。而综合运用不同数据源的各自优势,在高空间分辨率的光学与光学、光学与微波数据之间进行融合,提高遥感影像的空间分辨力和清晰度,能够增强图像解译和动态监测能力,有效提高遥感影像数据的利用率(Eckhorn 等,1990;Li 等,2006;牛忠恩 等,2016)。

在高分辨率多源遥感影像数据融合应用过程中,可进行影像融合处理的数据资源类别与融合算法类别众多(Aharon 等,2006;Maruthi,2010;肖化超 等,2016),遥感影像融合方案面临多种选择。针对遥感数据源的多样性、融合算法的复杂性、融合效果的差异性,本文提出一种面向应用需求的多源遥感影像数据融合方法,实现智能化的数据源选取和融合算法推荐,为解决多源高分辨率遥感影像融合过程中的决策问题提供科学、客观的方法。

Hyperspherical Color Sharpening(HCS)算法(Guo 等,2015)融合后的影像能较好地保持细节信息,同时融合多个波段,但是会出现光谱扭曲现象。Curvelet变换是在小波变换基础上发展起来的一种新的多尺度变换,该变换不仅继承了小波变换的优良特性,还具有多方向和各向异性的特征,在给定相同的重构精度下可以近乎最优地表示影像中具有方向性的直线及曲线等奇异性特征。将Curvelet变换应用到光学遥感影像融合中,能够更好地提取原始影像的特征,为融合影像提供更多的信息(Starck 等,2002)。为改善HCS算法的光谱失真问题,本文提出一种基于Curvelet和HCS的全色影像与多光谱影像融合方法,并通过实验分析了方法的有效性。

2 基于决策树的多源遥感数据集自动选取

高分辨率遥感影像的融合受到应用目的、遥感数据源时间与空间分辨率差异、融合算法等多种因素影响,这些因素使融合过程中数据源和融合算法的智能选择成为亟待解决的问题,利用遥感数据源融合的先验知识构建高分辨率遥感影像融合规则知识库,从已知数据集中自动选取出最优的影像数据,从算法库中自动选出预期融合效果最好的算法资源,是实现智能融合的重要前提。

2.1 基于决策树的遥感影像融合规则知识库

2.1.1 遥感影像融合规则知识库构建

遥感影像融合的先验知识通常是较为零散的信息。在遥感影像融合规则知识库构建过程中,不同数据源的影像融合可按照光学影像之间、光学影像与微波影像之间的融合进行分类,并按照光谱范围与空间分辨率细分类,融合先验知识依据影像分类进行划分。

(1) 多源遥感数据融合分类

遥感数据源种类多样,光学遥感影像之间的融合可根据不同分辨率分为多种组合,而且还存在光学与微波的不同成像机理数据融合,需要首先对遥感数据融合类别进行区分。

(2) 遥感数据与算法信息入库

区分不同类别的遥感数据融合后,分别针对不同数据的特征建立元数据遥感影像信息库、遥感影像数据库和融合算法库,同时针对数据融合结果建立质量评价算法库。

(3) 遥感影像融合规则更新

根据已经构建的遥感影像数据库、融合算法库、融合质量评价库进行多源遥感数据融合实验,结合融合后的数据质量变化,对融合规则进行更新。

在构建遥感影像融合规则知识库过程中,基于决策树(decision tree)算法对遥感影像融合规则进行分类,将遥感影像空间分辨率作为分类器,按照全色遥感数据的分辨率在Ⅰ(1—2 m)、Ⅱ(2—4 m)、Ⅲ(>4 m)的范围作为决策分类器,对每种类别的融合规则分别提取数据空间分辨率、光谱范围等元数据信息,构建遥感影像数据库与信息库。光学与微波等不同成像机理的遥感数据同样可以采用这种分类器进行决策分类。

每种融合类别中包含多种数据融合方案的先验知识,而决策树具有规则清晰、检索效率高等特点(张雪红,2016),因此,通过决策树算法按照不同分类进行融合规则划分在融合阶段的遥感影像融合规则知识库查询时能够实现高效率。

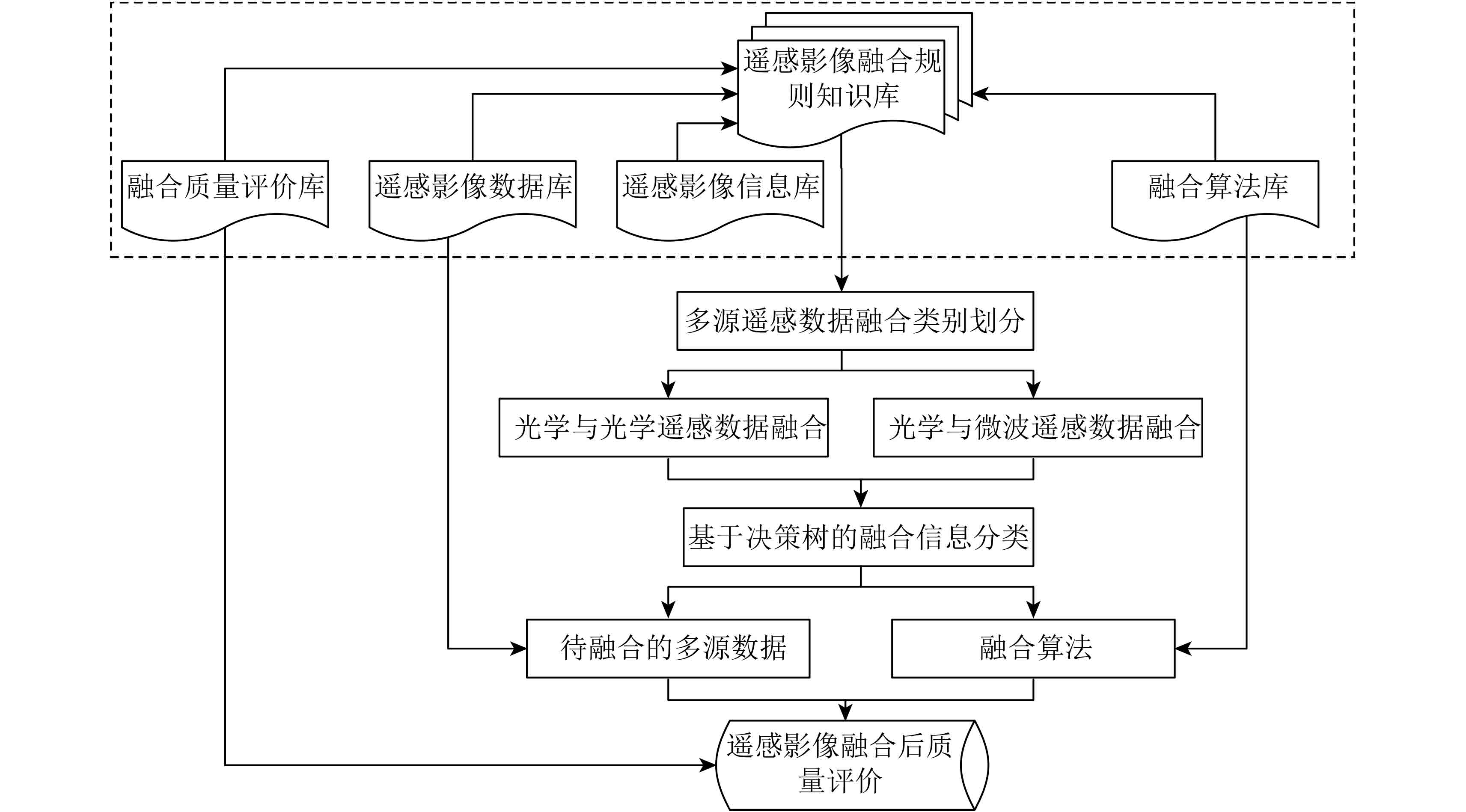

多源遥感数据融合划分类别后可根据多源遥感数据集之间的融合关系,以及融合算法、融合评价指标等建立初始的遥感影像融合规则知识库作为融合先验知识,影像融合流程如图1所示。

2.1.2 遥感影像融合规则知识库更新

遥感影像融合规则知识库可通过离线训练方式进行更新,根据决策知识选择数据库中多源遥感数据及融合算法,同时根据融合产品的特点选择评价算法对融合结果质量进行分析与评价,生成质量分析报告,如图2所示。

2.2 多源遥感数据集自动选取

按照不同遥感影像的成像特性、影像信息、融合算法特性、融合质量评价指标特性等设计遥感影像融合规则知识库,依据“数据源—融合算法—融合评价结果”、“融合数据结果—数据源—融合算法”等不同模式构建推理过程,将先验知识作为光学、微波等类型遥感数据源融合产品分类的基本依据,确定每类融合产品所需的数据源,实现遥感数据源的智能筛选。

研究中集成了多源高分辨率光学遥感影像数据和高分辨率SAR影像数据,在遥感数据集管理与自动选取过程中针对不同数据构建相应的数据表空间,并建立用于快速查询的索引,以地理坐标范围和时间范围作为输入条件,对多个数据表进行联合查询,实现多源遥感影像数据的自动选取,如图3所示。

通过遥感影像融合规则知识库的构建,按照不同分类器得到的遥感数据源会存储于不同的数据表中,通过在遥感数据集选取的交互界面框选出ROI(Region of Interest),Web界面将以左上经纬度(Long1,Lat1)、右下经纬度(Long2,Lat2)的形式记录此范围以及选定的时间区间范围,传递到服务器端,通过数据集自动检索引擎,在多个遥感数据表中实现联合查询,获取位于该ROI中的数据集列表(DataList)。同时,利用前述建立的遥感影像融合规则知识库中的融合关系表,从DataList中筛选出满足融合规则的不同影像融合方案。

其中,对于DataList中存在多种融合组合方式的情况,将分别记录,可选择其中的全色数据集后,由数据自动检索引擎给出另外的一种或者多种可选方案。

2.3 影像预处理

本研究通过精确配准方法,将高分辨率全色影像作为基准,在待校正的影像选取地面控制点GCP (Ground Control Point)进行几何校正,用多项式来近似描述遥感图像的几何畸变过程,并利用控制点求得这个几何畸变模型,然后利用此模型进行几何校正,这种校正不考虑畸变的具体形成原因,而只考虑如何利用畸变模型来校正图像,实现了对多源影像数据较高精度、相对统一的几何校正处理。

3 高分辨率影像智能融合算法研究

3.1 遥感影像融合规则知识库研究

利用天宫一号(TG-1)、高分一号(GF-1)、高分二号(GF-2)、Radarsat-2等多源高分辨率遥感影像以及Principal Component Analysis(PCA) (Shettigara,1992)、Gram-Schmidt(GS)(Laben和Brower,2000)、HCS、Curvelet(Candes和Donoho,2000)等多种融合算法,构建适用于光学、微波等数据资源的初始遥感影像融合规则知识库。

3.2 融合算法智能选择

影像融合算法各有利弊,根据输入数据源类型的不同,选择的融合算法也会有所差别。针对不同类型的待融合影像数据,如何选取最优的融合算法关系到最终融合数据产品的质量问题,是本研究重点解决的问题。

融合算法智能选择的另一个重要基础是融合产品质量评分数据库,对于遥感影像融合规则知识库中的规则信息,每次融合的实验结果都会基于质量分析的评价指标进行评分。在选择融合算法时,基于Ⅰ(1—2 m)、Ⅱ(2—4 m)、Ⅲ(>4 m)类数据决策分类规则,根据融合算法库中HCS、PCA、Curvelet等算法针对数据集进行融合的评分进行自动筛选,选择出评分最高的融合算法,算法的评分也会随着每次实验结果的变化而更新。

依据输入的待融合遥感影像数据类型和特点,利用决策树优化算法选取适合的融合算法,并基于该算法实现数据融合。在多源遥感数据集合确定的情况下,可基于多源遥感数据融合算法知识自动推荐出适用于当前数据组合的算法,并根据多个融合算法在融合处理时多次训练得到的评分进行排序,同时提供多种插值方法供选择,以更好的保证融合精度。

3.3 高分辨率影像融合算法优化

为使融合图像包含更丰富的光谱特征与空间细节信息,同时改善HCS算法的光谱失真问题,本文结合Curvelet变换和HCS变换的优势,在HCS空间提出一种基于Curvelet变换融合全色影像与多光谱影像的方法,命名为Curvelet_HCS方法,该方法还可以融合多光谱的多个波段,充分利用光谱信息。

3.3.1 融合算法

本文采用基于Wrap算法(Candès等,2006)对遥感影像进行Curvelet变换。算法流程如图4所示,具体步骤如下。

(1)对n波段多光谱影像进行插值,得到与高分辨率全色影像 PAN 图像具有相同像元尺寸的高分辨率多光谱 MS 图像。

(2)对插值后的 MS 影像进行HCS变换,形成 I 分量和n–1个角度分量。

(3)对 PAN 图像进行灰度拉伸,得到 PAN *。公式为

| ${{PAN}}_{ij}^{*2} = \frac{{{\sigma _0}}}{{{\sigma _1}}}({{PAN}}_{ij}^2 - {\mu _1} + {\sigma _1}) + {\mu _0} - {\sigma _0}$ | (1) |

式中,μ1,σ1分别为 PAN 2的均值和标准差,μ0,σ0分别为I2的均值和标准差。

(4)对 I和 PAN *分别进行Curvelet变换得到低频和高频系数。针对变换后的低频和高频系数选用不同的融合规则,得到新的Curvelet变换系数。

(5)将得到的Curvelet变换系数进行Curvelet逆变换,从而得到新的 I*分量。

(6)将 I*和(2)中变换得到的角度分量进行HCS反变换,形成融合后影像。

3.3.2 融合规则

对于低频系数,本文提出了以区域标准差和局部方向信息熵为主要判断依据的低频系数自适应融合规则,更好地选择全色影像与I分量的低频信息进行融合。 R 表示以(k1,k2)为中心选取的局部区域,其大小为m×n。局部方向信息熵(Lewis 等,2007)定义为

| $SR({k_1},{k_2}) = \frac{1}{{m \times n}}\sum\limits_{C(i,j) \in {R}} {{{\left| {C(i,j)} \right|}^2}{{\log }_2}{{\left| {C(i,j)} \right|}^2}} $ | (2) |

式中,

融合规则如下:

如果

| $\begin{aligned}C_0^F({k_1},{k_2}) = & {x_1}({k_1},{k_2}) \times C_0^{PAN}({k_1},{k_2}) + \\& {x_2}({k_1},{k_2}) \times C_0^I({k_1},{k_2})\end{aligned}$ | (3) |

否则,

| $\begin{aligned}C_0^F({k_1},{k_2}) = & {x_2}({k_1},{k_2}) \times C_0^{PAN}({k_1},{k_2}) + \\ &{x_1}({k_1},{k_2}) \times C_0^I({k_1},{k_2})\end{aligned}$ | (4) |

式中,

| ${x_1}({k_1},{k_2}) = \frac{{\max \{ {\sigma ^{PAN}}({k_1},{k_2}),{\sigma ^I}({k_1},{k_2})\} }}{{\sqrt {{\sigma ^{PAN}}{{({k_1},{k_2})}^2} + {\sigma ^I}{{({k_1},{k_2})}^2}} }}$ | (5) |

| ${x_2}({k_1},{k_2}) = \frac{{\min \{ {\sigma ^{PAN}}({k_1},{k_2}),{\sigma ^I}({k_1},{k_2})\} }}{{\sqrt {{\sigma ^{PAN}}{{({k_1},{k_2})}^2} + {\sigma ^I}{{({k_1},{k_2})}^2}} }}$ | (6) |

对于不同尺度及方向下的高频系数,其中包含了图像的细节特征,本文采用绝对值取大的融合规则以尽可能的保留高频信息。

| $C_{j,l}^F({k_1},{k_2}) = \left\{ \begin{array}{l}\!\!\! C_{j,l}^{PAN}({k_1},{k_2}),\left| {C_{j,l}^{PAN}({k_1},{k_2})} \right| > \left| {C_{j,l}^I({k_1},{k_2})} \right|\\\!\!\! C_{j,l}^I({k_1},{k_2}),\left| {C_{j,l}^{PAN}({k_1},{k_2})} \right| \leqslant \left| {C_{j,l}^I({k_1},{k_2})} \right|\end{array} \right.$ | (7) |

式中,

3.3.3 实验结果

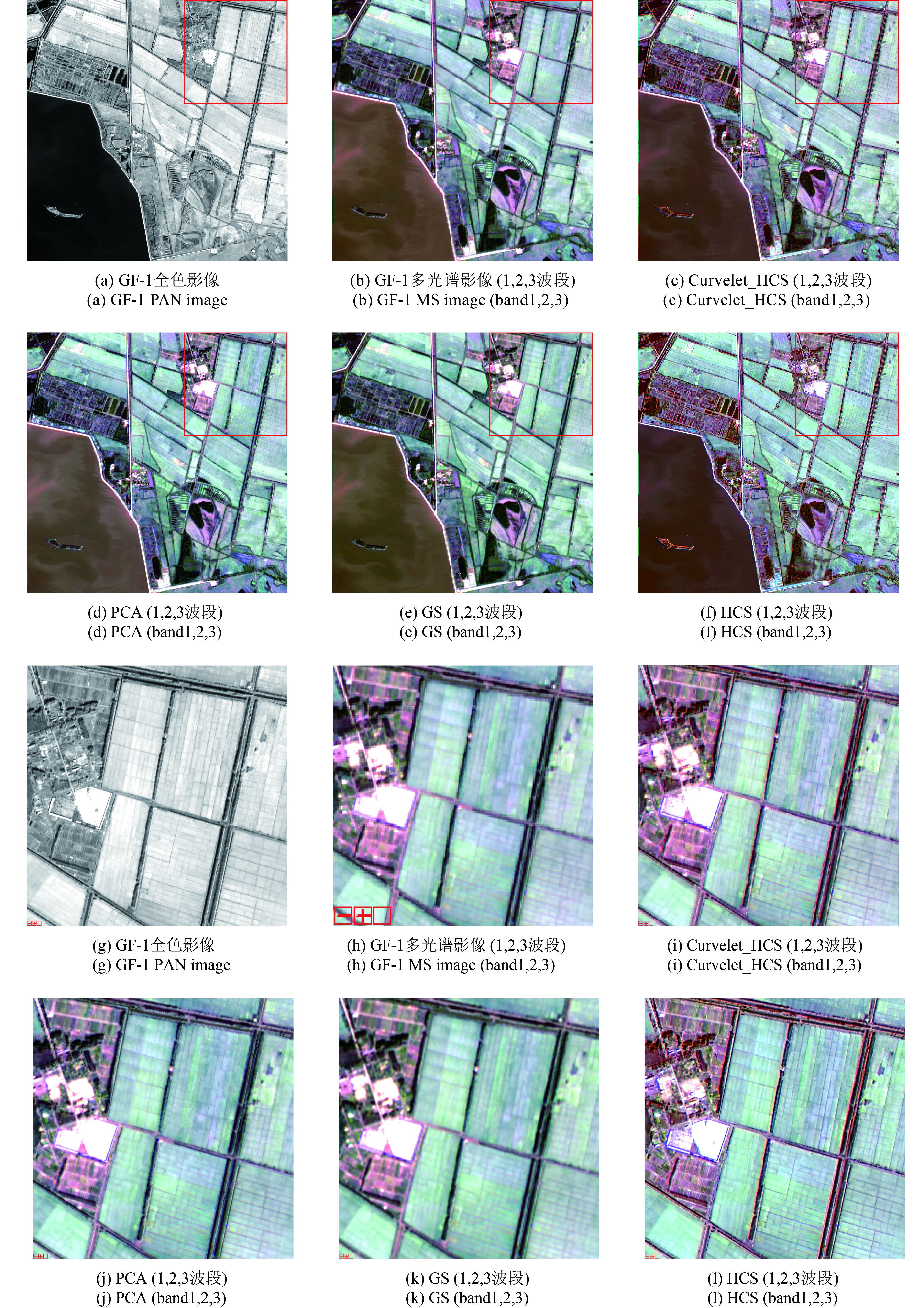

本文以GF-1卫星的2 m全色影像和8 m多光谱影像、GF-2卫星的4 m多光谱影像作为实验数据。为验证算法的有效性,选择地物丰富、特征多样的影像作为数据源,并且GF-1和GF-2多光谱影像的4个波段都参与融合。

图5(a)为GF-1全色图像,像素大小为2000×2000,图5(b)为GF-1多光谱图像,像素大小为500×500。图5(c)为本文算法得到的融合结果。图5(d)、(e)、(f)分别为PCA、GS、HCS算法得到的融合结果。图5中(g)、(h)、(i)、(j)、(k)、(l)对应中(a)、(b)、(c)、(d)、(e)、(f)的局部放大图。

图6(a)为GF-1全色图像,像素大小为2000×2000,图6(b)为GF-2多光谱图像,像素大小为1000×1000。图6(c)为本文算法得到的融合结果。图6(d)、(e)、(f)分别为PCA、GS、HCS算法得到的融合结果。图6中(g)、(h)、(i)、(j)、(k)、(l)对应中(a)、(b)、(c)、(d)、(e)、(f)的局部放大图。

从融合结果可以看出,GS算法能够有效地保留光谱信息,但细节较为模糊。由图5(j)可以看出,PCA融合后的影像细节较为模糊,图6(d)中出现严重的颜色失真问题。HCS算法融合后的影像具有较好的细节信息,但是出现光谱扭曲现象。通过本文方法得到的多光谱图像具有较高的空间分辨率,较好地保留了原始多光谱图像的光谱信息,有效地改善了HCS的光谱扭曲问题,而且整体对比度高、纹理清晰、边缘信息丰富。

4 融合影像质量分析与评价

针对高分辨率全色与多光谱影像融合,本文建立了光学影像之间融合的评价指标,包括:均值、标准差、相关系数、信息熵、平均梯度、相对偏差等。以期较为全面客观地分析评价融合影像的质量与效果。本文使用PCA、HCS、GS和Curvelet_HCS对不同影像数据进行融合,并对融合结果进行评价,各指标取融合后影像所有波段(4个波段)的平均值。表1是GF-1的2 m全色影像和8 m多光谱影像融合结果,表2是GF-1的2 m全色影像和GF-2的4 m多光谱影像融合结果。

表 1 质量评价结果

Table 1 Quantitative evaluation of fusion methods

| 方法 | 均值 | 标准差 | 信息熵 | 平均梯度 | 相关系数 | 相对偏差 |

| 多光谱影像 | 178.46 | 46.26 | 6.73 | 1.45 | 1 | 0 |

| PCA | 178.23 | 47.21 | 6.80 | 3.32 | 0.98 | 0.04 |

| HCS | 177.89 | 47.16 | 6.71 | 3.51 | 0.91 | 0.05 |

| GS | 178.21 | 46.97 | 6.75 | 1.67 | 0.99 | 0.003 |

| Curvelet_HCS | 249.22 | 64.96 | 7.20 | 3.76 | 0.96 | 0.39 |

表 2 质量评价结果

Table 2 Quantitative evaluation of fusion methods

| 方法 | 均值 | 标准差 | 信息熵 | 平均梯度 | 相关系数 | 相对偏差 |

| 多光谱影像 | 186.27 | 41.69 | 7.28 | 2.39 | 1 | 0 |

| PCA | 208.80 | 43.52 | 7.37 | 10.92 | 0.61 | 0.35 |

| HCS | 208.70 | 43.53 | 7.36 | 10.19 | 0.59 | 0.35 |

| GS | 208.64 | 44.02 | 7.42 | 6.18 | 0.59 | 0.35 |

| Curvelet_HCS | 292.20 | 58.34 | 7.82 | 10.96 | 0.59 | 0.72 |

均值反映了影像的平均亮度,标准差反映了影像灰度相对于均值的离散情况,标准差越大,说明影像灰度级分布分散,图像的反差大,能够反映出更多的信息。评价结果表明,通过改进方法得到的融合影像亮度均值和标准差有明显的提高,较其他算法相比,数值均最大。

信息熵是衡量影像信息丰富程度的一个重要指标,熵值的大小表示影像所包含的平均信息量的多少。由表1、2数据可以看出,改进方法融合的影像信息熵最大,说明图像包含的信息更丰富。

平均梯度可以敏感地反映影像对微小细节反差表达的能力,可用来评价影像的清晰程度,同时反映出影像中微小细节反差和纹理变换特征,平均梯度越大越有利于影像的目视解译。评价结果表明,改进方法融合的影像性能较好,数值最大。

相关系数和相对偏差反映了融合影像的光谱特征保持能力,相对偏差越小,融合影像相对于原始影像的差异越小,相关系数越大,保持光谱能力越强。评价结果表明,在相关系数指标上,GS算法性能较好,改进方法较HCS方法有所提高。在相对偏差指标上,GS算法性能较好。

5 结 论

传统的多源高分辨率遥感影像融合过程中需要人为选择融合数据、融合方案等,自动化程度较低。本文提出了一种面向应用需求的智能化多源影像选取与自适应融合方法,利用决策树算法在多源遥感影像融合规则知识库中进行数据源遴选,并通过融合后影像质量的定量分析与评价结果对决策树算法的分类依据进行动态迭代更新,实现了多源遥感数据集的自动筛选与算法的自动化选择,解决了融合过程中的决策问题。

此外,本文针对HCS算法在融合高分辨率全色影像与多光谱影像时出现的光谱扭曲问题,提出了一种基于HCS和Curvelet的融合方法,对于高频和低频分量采用不同的融合策略,并使用GF-1、GF-2影像数据进行实验,实验结果表明,直观视觉上,该方法可以得到较好的融合影像,有效改善了HCS的颜色失真问题。质量评价融合效果上,与其他方法相比,在均值、标准差、相关系数、信息熵、平均梯度、相对偏差等指标取得了较好的结果。

本文开展的多源高分辨率遥感影像智能融合研究,为开展大规模智能化的遥感应用提供了重要的方法与技术支撑,也为开展面向应用需求的数据融合进行了有益的探索与尝试。在后续工作中将进一步研究遥感影像融合规则的提取方法,同时对该套方法体系内的高分辨率光学与成像微波影像之间的融合问题开展重点研究。

参考文献(References)

-

Aharon M, Elad M and Bruckstein A. 2006. rmK-SVD: an algorithm for designing overcomplete dictionaries for sparse representation . IEEE Transactions on Signal Processing, 54 (11): 4311–4322. [DOI: 10.1109/tsp.2006.881199]

-

Alparone L, Baronti S and Garzelli A. 2001. Assessment of image fusion algorithms based on noncritically-decimated pyramids and wavelets // Proceedings of IEEE 2001 International Geoscience and Remote Sensing Symposium. Sydney, NSW: IEEE, 2 : 852–854. [DOI: 10.1109/igarss.2001.976658]

-

Candes E J and Donoho D L. 2000. Curvelets: A Surprisingly Effective Nonadaptive Representation for Objects with Edges. California: Stanford University California Deptartment of Statistics

-

Candès E, Demanet L, Donoho D and Ying L X. 2006. Fast discrete curvelet transforms. Multiscale Modeling & Simulation, 5 (3): 861–899. [DOI: 10.1137/05064182x]

-

Eckhorn R, Reitboeck H J, Arndt M and Dicke P. 1990. Feature linking via synchronization among distributed assemblies: simulations of results from cat visual cortex. Neural Computation, 2 (3): 293–307. [DOI: 10.1162/neco.1990.2.3.293]

-

Garzelli A. 2002. Possibilities and limitations of the use of wavelets in image fusion // Proceedings of 2002 IEEE International Geoscience and Remote Sensing Symposium. Toronto, Ontario, Canada: IEEE, 1 : 66–68. [DOI: 10.1109/igarss.2002.1024943]

-

Guo Q, Wang Q, Ehlers M and Zhang H Q. 2015. Quality studies for N-band image fusion // Proceedings of 2015 International Conference on Fuzzy Theory and Its Applications. Yilan: IEEE: 6–11

-

Laben C A and Brower B V. 2000. Process for enhancing the spatial resolution of multispectral imagery using pan-sharpening. U.S., 6011875

-

Lewis J J, O’Callaghan R J, Nikolov S G, Bull D R and Canagarajah N. 2007. Pixel- and region-based image fusion with complex wavelets. Information Fusion, 8 (2): 119–130. [DOI: 10.1016/j.inffus.2005.09.006]

-

Li M, Cai W and Tan Z. 2006. A region-based multi-sensor image fusion scheme using pulse-coupled neural network. Pattern Recognition Letters, 27 (16): 1948–1956. [DOI: 10.1016/j.patrec.2006.05.004]

-

Maruthi R. 2010. Multi focus image fusion technique in spatial domain using an image variance as a focus measure. Journal on Future Engineering and Technology, 5 (3): 24–31.

-

Niu Z E, Yan H M, Huang M, Hu Y F and Chen J Q. 2016. Agricultural productivity estimation with MODIS-OLI fusion data. Journal of Natural Resources, 31 (5): 875–885. [DOI: 10.11849/zrzyxb.20150632] ( 牛忠恩, 闫慧敏, 黄玫, 胡云锋, 陈静清. 2016. 基于MODIS-OLI遥感数据融合技术的农田生产力估算. 自然资源学报, 31 (5): 875–885. [DOI: 10.11849/zrzyxb.20150632] )

-

Ranchin T and Wald L. 2000. Fusion of high spatial and spectral resolution images: the ARSIS concept and its implementation. Photogrammetric Engineering and Remote Sensing, 66 (1): 49–61.

-

Shettigara V K. 1992. A generalized component substitution technique for spatial enhancement of multispectral images using a higher resolution data set. Photogrammetric Engineering and Remote Sensing, 58 (5): 561–567.

-

Starck J L, Candès E J and Donoho D L. 2002. The curvelet transform for image denoising. IEEE Transactions on Image Processing, 11 (6): 670–684. [DOI: 10.1109/TIP.2002.1014998]

-

Wu T J, Luo J C, Shen Z F, Xia L G and Xu N. 2016. Application of land cover classification techniques in poverty-stricken areas using high resolution remote sensing: a case study of Qianjiang district of Chongqing city. Journal of Geo-information Science, 18 (3): 353–361. [DOI: 10.3724/SP.J.1047.2016.00353] ( 吴田军, 骆剑承, 沈占锋, 夏列钢, 徐楠. 2016. 高分辨率遥感土地覆盖分类技术的应用研究——以重庆市黔江贫困区为例. 地球信息科学学报, 18 (3): 353–361. [DOI: 10.3724/SP.J.1047.2016.00353] )

-

Xiao H C, Zhou Q and Zheng X S. 2016. A fusion method of satellite remote sensing image based on IHS transform and Curvelet transform. Journal of South China University of Technology (Natural Science Edition), 44 (1): 58–64. [DOI: 10.3969/j.issn.1000-565X.2016.01.009] ( 肖化超, 周诠, 郑小松. 2016. 基于IHS变换和Curvelet变换的卫星遥感图像融合方法. 华南理工大学学报(自然科学版), 44 (1): 58–64. [DOI: 10.3969/j.issn.1000-565X.2016.01.009] )

-

Zhang X H. 2016. Decision tree algorithm of automatically extracting mangrove forests information from Landsat 8 OLI imagery. Remote Sensing for Land & Resources, 28 (2): 182–187. [DOI: 10.6046/gtzyyg.2016.02.28] ( 张雪红. 2016. 基于决策树方法的Landsat 8 OLI影像红树林信息自动提取. 国土资源遥感, 28 (2): 182–187. [DOI: 10.6046/gtzyyg.2016.02.28] )