| 高光谱-LiDAR多级融合城区地表覆盖分类 |

收稿日期: 2017-12-07

2. Collaborative Innovation Center of Geospatial Technology, Wuhan University, Wuhan 430079, China

3. College of Computer Science, China University of Geosciences, Wuhan 430074, China

4. Department of Geography and Resource Management, The Chinese University of Hong Kong, Hong Kong, China

遥感作为一种重要的技术手段(Zhong 等,2018),已被广泛应用于城区地表覆盖分类研究中。并且随着对地观测技术的不断发展,出现了多种可以获取不同种类信息的遥感传感器(Momeni 等,2016)。例如,通过获取光谱特性的多光谱和高光谱传感器,能够获得准确3维信息的LiDAR传感器,以及能够获取振幅和相位信息的SAR传感器等。这些传感器获取的影像在城市地表覆盖分类应用中具有不同的优势。但在仅使用单源影像进行地表覆盖分类时又存在弊端,如:高光谱影像具有丰富的光谱信息,可以很好的表征地物的光谱特性及结构信息(Benediktsson 等,2005),十分适用于城市地区的地表覆盖分类(Fauvel 等,2008;Chen 等,2011)。但其对于具有相似光谱特性不同高程信息的地物难以区分(Lahat 等,2015),例如均由混凝土制成的屋顶和道路;与高光谱影像不同,LiDAR数据具有较为准确的3维空间信息(Zhang 等,2013),可以依靠高度来对地物进行分类。但由于缺少物体的语义信息,LiDAR数据对于具有相同高程不同光谱信息的地物分辨能力较差,例如分别由沥青和混凝土制成的具有相同高程的道路。因此,若将二者进行融合,能够大大提高解译精度和可信度,改善分类的效果(Zhong 等,2017a;Chen 等,2017a)。

数据融合层次分为像素级融合、特征级融合和决策级融合。但高光谱影像和LiDAR数据作为异构数据,更适合进行特征级、决策级的融合(张良培和沈焕锋,2016),因而目前的研究多集中于这两个级别的融合,并逐渐形成了一种“特征提取—特征融合—影像分类—决策融合—分类后处理”的融合流程。

在特征提取方面,主要有以下几种方法:(1)基于分割方法的特征提取。检测高光谱影像中光谱值突变的边缘部分,将其作为各个区域划分的边界,达到对高光谱影像分割的目的。同理在LiDAR图像的梯度图上设置阈值进行平坦度的计算,然后在平坦度图上进行分割,得到分割结果。然后利用二者分割的结果作为一种特征来表征空间信息,并进行分类(Merentitis 等,2014),实现二者的融合分类。(2)基于形态学操作的特征提取。对高光谱影像经过主成分分析(PCA)后的第一主成分及LiDAR数据的DSM分别进行形态学操作,得到两幅图像的空间特征(Ghamisi 等,2014)。(3)基于深度学习的特征提取。分别对高光谱影像和LiDAR数据利用CNN进行深度特征提取,然后使用分类器进行分类,得到融合分类结果(Chen 等,2017b)。

在特征融合方面,目前研究大多采用叠加融合和模型融合的方式。模型融合主要有:(1)基于图模型的融合。将提取到的高光谱影像和LiDAR数据的特征通过构建图模型来得到融合特征(Liao 等,2015)。(2)在特征融合中加入约束条件进行优化。将提取的特征利用全变分分量分析(Rasti 等,2017a)、稀疏低秩方法(Rasti 等,2017b)进行特征降维及融合,然后对得到的特征影像进行分类。

在决策融合方面,目前研究中主要用到的方法有:(1)多数投票法。首先对高光谱影像及DSM数据进行特征提取,然后对提取后的特征进行融合,接着将各个不同特征分别利用支持向量机进行分类,最后将不同分类结果进行投票,得到决策级融合之后的分类结果(Liao 等,2017);(2)基于模型的决策级融合。首先通过多分类器系统对高光谱影像和LiDAR数据进行分类,然后采用基于对数选项池的决策融合系统对分类结果进行融合(Wu和Prasad,2013)。

在分类后处理方面,面向对象的方法作为一种可以较为准确的实现地表覆盖分类的手段,与像素级分类器进行结合,改善了高光谱和LiDAR数据的融合分类的效果(Man 等,2015)。

特征级融合能够根据影像不同特点提取对解译有效的不同特征,决策级融合主要解决不同数据产生结果的不一致性,获取更可靠的知识,具有灵活性高,鲁棒性强的优势(童庆禧 等,2006)。但目前这些研究大多只对高光谱影像和LiDAR影像进行了一种级别的融合,不能很好的兼顾特征级和决策级融合的不同优势。因此,本文将LiDAR数据的高程信息与高光谱影像的光谱信息进行多级的融合,即特征级和决策级,主要的实现方法如下:(1)针对高光谱和LiDAR数据各自的特点,提取了光谱、空间及高程信息,实现特征级融合。(2)为了改善城区地表覆盖分类中道路与建筑物等地物混淆,而造成建筑物轮廓不清晰,道路分类不准确的问题,本文利用LiDAR点云数据对建筑物类别进行约束。即先对特征影像进行多分类器分类,然后利用LiDAR点云数据提取出的建筑物掩膜,将非建筑物部分单独进行分类,与之前得到的分类结果进行融合,再次实现特征级融合。(3)对得到的多幅分类结果进行投票,并对投票结果进行分类后处理,实现高光谱和LiDAR数据的决策级融合。该方法已成功应用在2013年数据融合大赛数据集中,并取得了良好的效果。

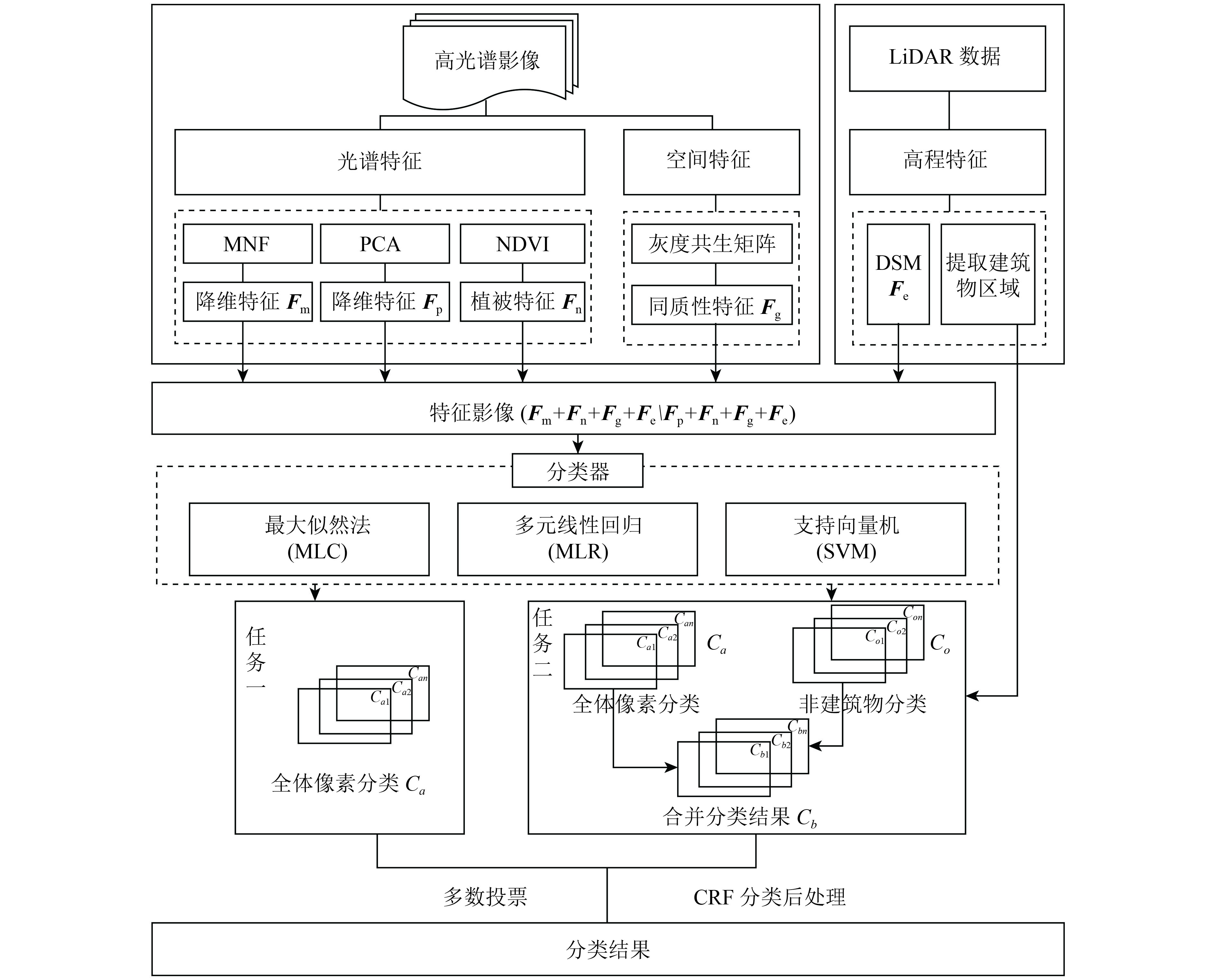

2、基于高光谱和LiDAR数据多级融合的城区地表覆盖分类流程本文提出了一种基于高光谱与LiDAR数据融合的城市地区地表覆盖分类方法,主要流程如图1所示。首先分别对高光谱影像和LiDAR数据进行特征提取,获取研究区地物的光谱、空间及高程信息,同时利用LiDAR点云数据进行建筑物区域的提取。然后对提取的特征影像分成两个任务进行分类。任务一(图1中左半部分)将所有的像素点直接利用多分类器进行分类,得到分类结果

|

| 图 1 本文方法流程示意图 Figure 1 Framework of the proposed methodology |

为了提高类别的可分性,本文提取了高光谱影像的光谱特征和空间特征,及LiDAR数据的高程特征。

(1)光谱特征提取。由于高光谱数据维数较高,而且各个波段间的相关性较高,通常会因维数的过度增加而导致解译精度有所下降。为了减小计算的复杂性,使用特征提取算法对光谱特征进行降维。本文采取的方法为最小噪声分离法(MNF)与主成分分析法(PCA),分别生成特征

(2)空间特征提取。在影像分类任务中,遥感图像的空间信息是非常重要的(Zhao 等,2016)。灰度共生矩阵是通过计算灰度图像得到它的共生矩阵,然后通过计算共生矩阵的部分特征值,来分别代表图像的某些空间纹理特征。另外同质性,可以度量图像纹理局部变化的多少。其值大则说明图像纹理的不同区域间缺少变化,局部非常均匀。因此,为了增加类别的可分性,利用灰度共生矩阵的同质性特征来提取高光谱影像的空间纹理特征。本文提取的空间特征

(3)高程特征提取。为了度量不同地物在高度上的差异,本文将LiDAR点云数据产生的数据表面模型(DSM)作为高程特征

将提取后的特征进行归一化操作后以层叠的方式进行组合,得到特征影像。为了增加特征的多样性,来提升分类精度,本文使用两组不同的特征影像

| $ {{{F}}_{\rm{1}}} = \left\{ {{{{F}}_{\rm{m}}},{{{F}}_{\rm{n}}},{{{F}}_{\rm{g}}},{{{F}}_{\rm{e}}}} \right\} $ | (1) |

| $ {{{F}}_{\rm{2}}} = \left\{ {{{{F}}_{\rm{p}}},{{{F}}_{\rm{n}}},{{{F}}_{\rm{g}}},{{{F}}_{\rm{e}}}} \right\} $ | (2) |

在城区地表覆盖分类中,存在建筑物、道路及停车场的混淆问题。三者由于光谱信息高度相似,单纯的将DSM作为一维特征加入分类,难以充分利用高程信息,无法对这些类别进行一个较好的区分。因此,本文提出了双任务多分类器分类方法。

(1)所有像素点共同参与分类。之前提取出的融合了光谱、植被、纹理及高程信息的两组特征影像

(2)采用建筑物掩膜进行分类。利用之前提取出的建筑物掩膜,将影像分为建筑物区域

| $ {C_b} = {C_o} \cap {Z_o}{\rm{ + }}{C_a} \cap {Z_b} $ | (3) |

即

每个分类器都存在一定的错误率,但不同的分类器之间的错误具有一定的差异性,即一个分类器的正确分类可以弥补另一个分类器的错误分类结果(Kim 等,2003)。对这些分类器进行集成可以综合利用其各自的优势,提高分类精度,增加分类模型的泛化能力(Kittler 等,1998;Galar 等,2012),因此采用多分类器集成方法进行分类。

支持向量机(SVM)是一种建立在统计学习理论基础上的机器学习方法(Cortes和Vapnik,1995)。由于其具有学习效率高且自适应的优势,并且可以很好的处理高维特征数据,使其在遥感影像分类领域被广泛应用(Chen 等,2017c)。其主要思想是针对两类分类问题,在高维空间中寻找一个超平面作为两类的分割,以保证最小的分类错误率,且支持向量机分类器首先从原始空间中提取特征,将原始空间中的样本映射为高维特征空间中的一个向量,以解决空间中线性不可分的情况。支持向量机在解决小样本、非线性和高维模式识别方面有着独特的优势。

最大似然法分类(MLC)是经典的分类算法(Akaike,1998),它利用遥感数据的统计特征,假定各类的分布函数为正态分布,在多变量空间中形成椭圆或椭球分布,也就是和各方向上散步情况不同按正态分布规律用最大似然判别规则进行裁决。在进行分类时,MLC不仅考虑了样本到类中心的距离,而且考虑了分布特征。

MLR是分类问题的一种特殊解决方案(Li 等,2011),它假定观察到的特征和一些特定于问题的参数的线性组合可以用来确定因变量的每一个特定结果的概率。给定问题的参数的最佳值通常由训练数据确定。

以上3种算法均具有很强的鲁棒性,能够充分利用样本的先验信息,适合于城市区域的分类。因此本文使用这3种分类器来对两个任务中的两组分类影像进行分类。上述的

(1)对分类结果图的决策级融合。决策级融合通过制定决策规则来融合不同分支得到的结果,能够更好的对目标进行解译(Ghassemian,2016),即对之前融合特征得到的多个分类结果进行融合,会进一步提高分类精度。因此在结束分类之后,对任务一和任务二得到的12幅分类结果图,使用决策级融合进行处理,得到一个更加精确的结果图,本文采用的是投票法。不同分类器得到的结果有所差异,各个分类器在对不同类别进行分类时具有的优势也不同。采用投票的方式可以综合利用各个分类器间的互补性,得到更加准确的分类效果。因此,将之前不同分类器分类得到的分类结果图进行投票。对同一个像元不同分类器的分类结果不同,我们认为被多数分类器分为的类别为可信度最大的类别。即:

| $ {L_{ij}} = Majority\left\{ {L_{ij}^1,L_{ij}^2,\cdots L_{ij}^k} \right\} $ | (4) |

式中,

(2)对部分类别的决策级融合。由于在城区中高架桥(属于高速公路类)与位于建筑物顶部的停车场具有相似的光谱特性,且均具有较高的高程特性,因此难以区分。尽管采用建筑物与非建筑物区分的方式进行改善,但由于停车场同时存在于建筑物区域及地面点区域,因此存在高架桥被分为停车场的情况。本文利用区域生长算法在DSM数据上进行高架桥的提取。以地物中心点为生长起始点,选取合适的阈值,对分错的高架桥进行提取,并利用提取的结果对分类图进行修正。即利用提取出的高架桥部分生成分类掩膜,将分类图中的高架桥区域纠正为高速公路类别,以面向对象的方式,改善分类效果。

(3)分类后处理。如果不考虑相邻像素间相关性会导致分类地图中存在噪声点。作为一种改进的马尔可夫随机场模型(MRF),条件随机场(CRF)具有同时在标签和观测图像数据中考虑空间上下文信息的能力(Zhong 等,2017b)。为了同时考虑空间的上下文信息,并保存影像本身的空间细节信息,本文采用基于细节保持的CRF(Zhao 等,2015)对分类影像进行平滑处理得到最终分类图。

条件随机场模型作为判别式的概率模型,直接建模给定观测数据条件下的后验概率分布为Gibbs分布,并通过最大化后验概率分布来获得最终分类结果。目前应用较广的为成对条件随机场模型,可以写成一元势能与二元势能之和,表达式如下表示

| $ {{E}}(x|y) = \sum\limits_{i \in {{V}}} {{\psi _i}({x_i},y) + {\textit{λ}} \sum\limits_{i \in {{V}},j \in {{{N}}_i}} {{\psi _{ij}}({x_i},{x_j},y)} } $ | (5) |

式中,E为能量函数,像元位置

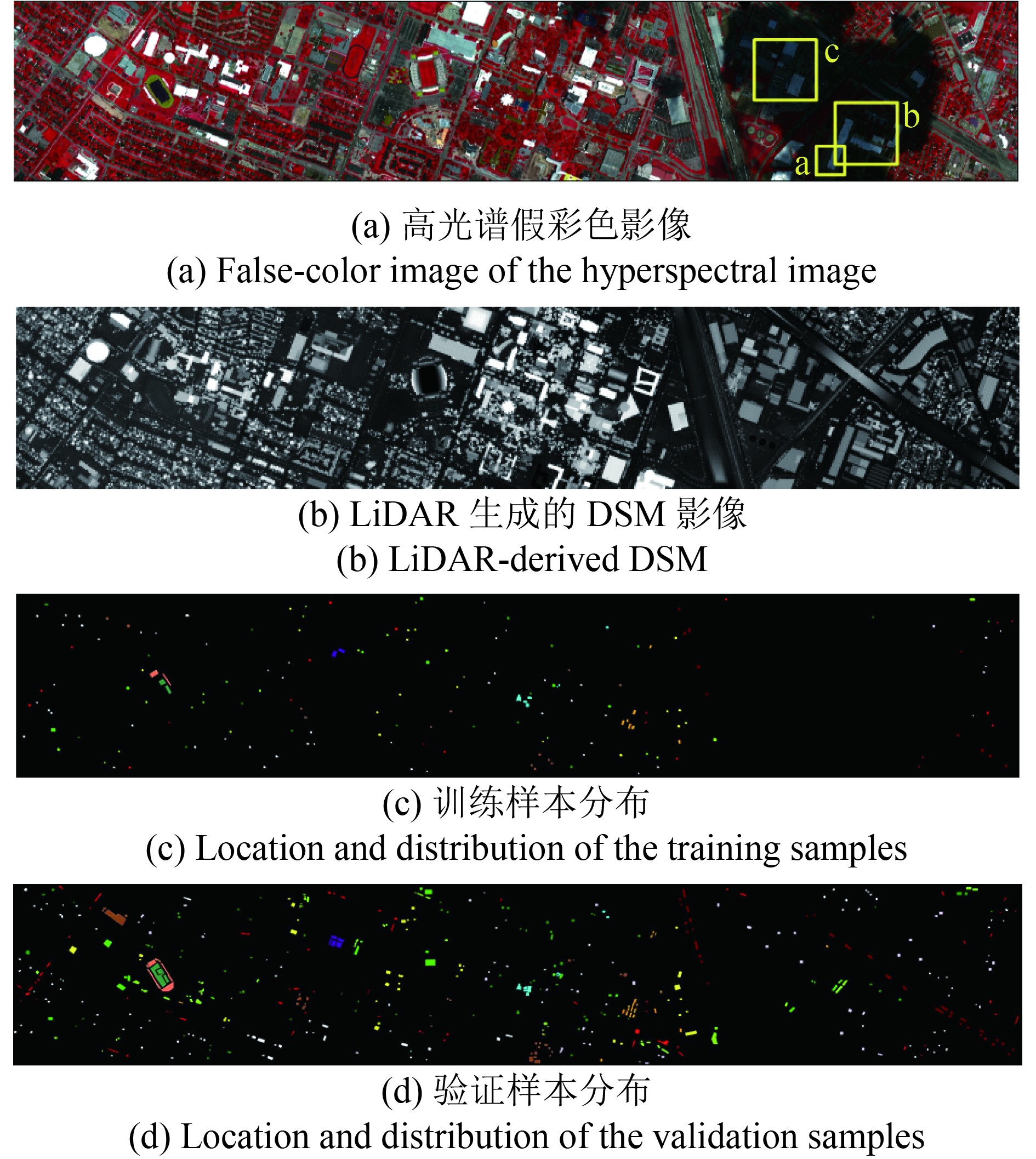

本次实验所用的高光谱和LiDAR数据为2013年数据融合大赛的数据。高光谱影像数据的获取时间为2012年6月23日,17:37:10—17:39:50 UTC (Universial Time coordinated)。传感器为CASI (Compact Spectrographic Imager),采用的空间坐标系为NAD8_UTM_Zone_15N。空间分辨率为2.5 m,影像大小为1905×349,波段数为144,波谱范围为380—1050 nm。LiDAR数据获取时间为:2012年6月22日,14:37:55到15:38:10 UTC(Universal Time Coordinated)之间。LiDAR数据由NSF资助中心提供NCALM(NSF-flmded Center for Airborne Laser Mapping)。影像尺度为1905×349,空间分辨率为2.5 m(图2)。

|

| 图 2 实验数据 Figure 2 Experimental data |

实验数据中共有15种地物类别,分别为健康草地,受损草地,合成草地,树木,裸土,水体,居民区、商业区、道路、高速公路、铁路、停车场1(有车停车场),停车场2(无车停车场)、网球场和跑道(表1)。参与训练及验证精度的样本位置和分布如图2(c)和(d)所示(满其霞,2015)。

|

|

表 1 训练及验证样本数量 Table 1 Number of training and validation samples |

本次实验中涉及的参数设置及实现方法如表2所示。

|

|

表 2 实验设计参数 Table 2 Parameters of the experiment |

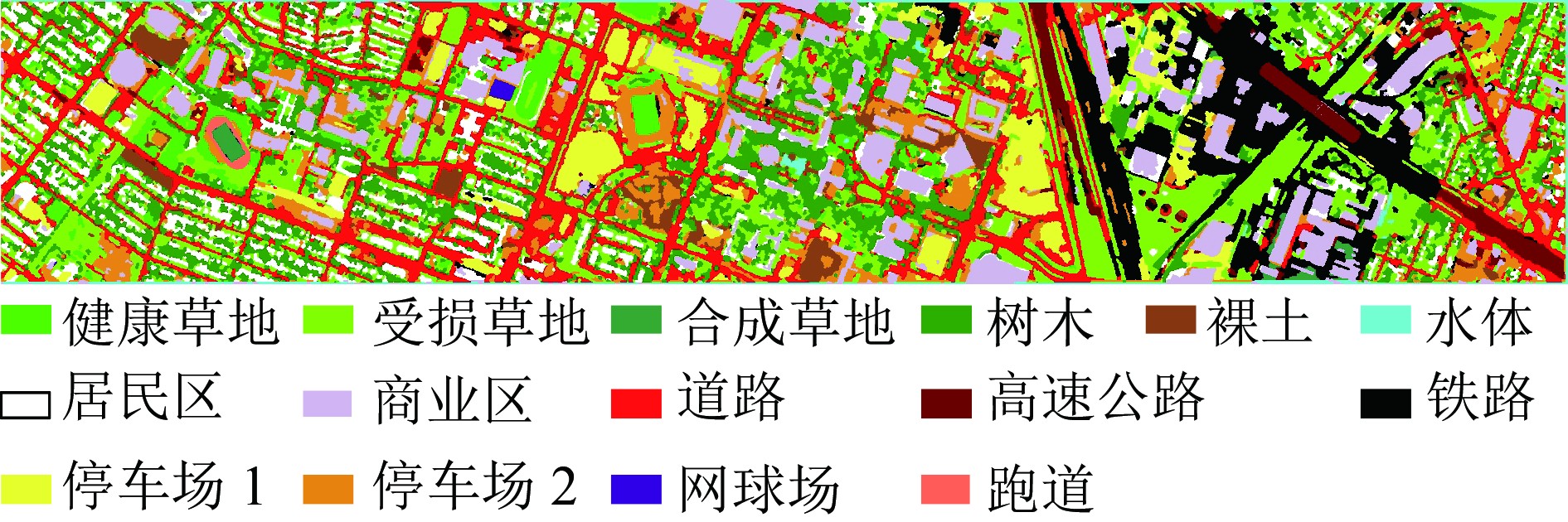

本文的方法在2013年数据融合大赛数据集上,最终得到的分类精度OA(总体分类精度)为93.22%,Kappa系数为0.93(图3)。

|

| 图 3 分类结果图 Figure 3 Final classification map |

采用不同特征、不同分类方法及本文方法进行分类精度对比(表3),其中“投票”指使用多分类器分类并进行投票操作;“建筑物”代表进行了建筑物掩膜操作;“高架桥”代表进行了高速公路类别的纠正。本文提出的方法总体分类精度最佳,在各个类别上也获得了比较高的准确率,大部分类别精度均在90%以上,合成草地、裸土、网球场及跑道的分类精度达到了100%。对比第1列和第3列的分类方法,由于建筑物和道路具有高度上的差异,LiDAR数据的加入使得居民区、商业区及道路、铁路的分类精度有了明显提升,表明高程信息的加入可以增加这些类别的可分性。对比第1列和第5列的结果,虽然总体精度没有提升,但是空间信息和植被信息的加入改善了商业区、道路、高速公路、停车场等类别的分类效果。采用多分类投票得到的分类结果,由于综合了不同分类器间的差异性和互补性,取得了比单一分类器更好的效果。另外,对比第8列和第9列的结果,本文提出的采用建筑物掩膜来进行分类的方法改善了建筑物、道路及停车场之间混淆的情况。居民区、道路、铁路、停车场1及停车场2的分类精度均有提升。但由于建筑物提取准确率不够,部分商业区建筑没有提取出来,导致分类精度有所下降。而对比最后两列的结果可以明显看出分类后处理及高架桥的纠正措施均对分类有一定的改善作用。

|

|

表 3 不同方法分类精度 Table 3 Classification Accuracy of different algorithm |

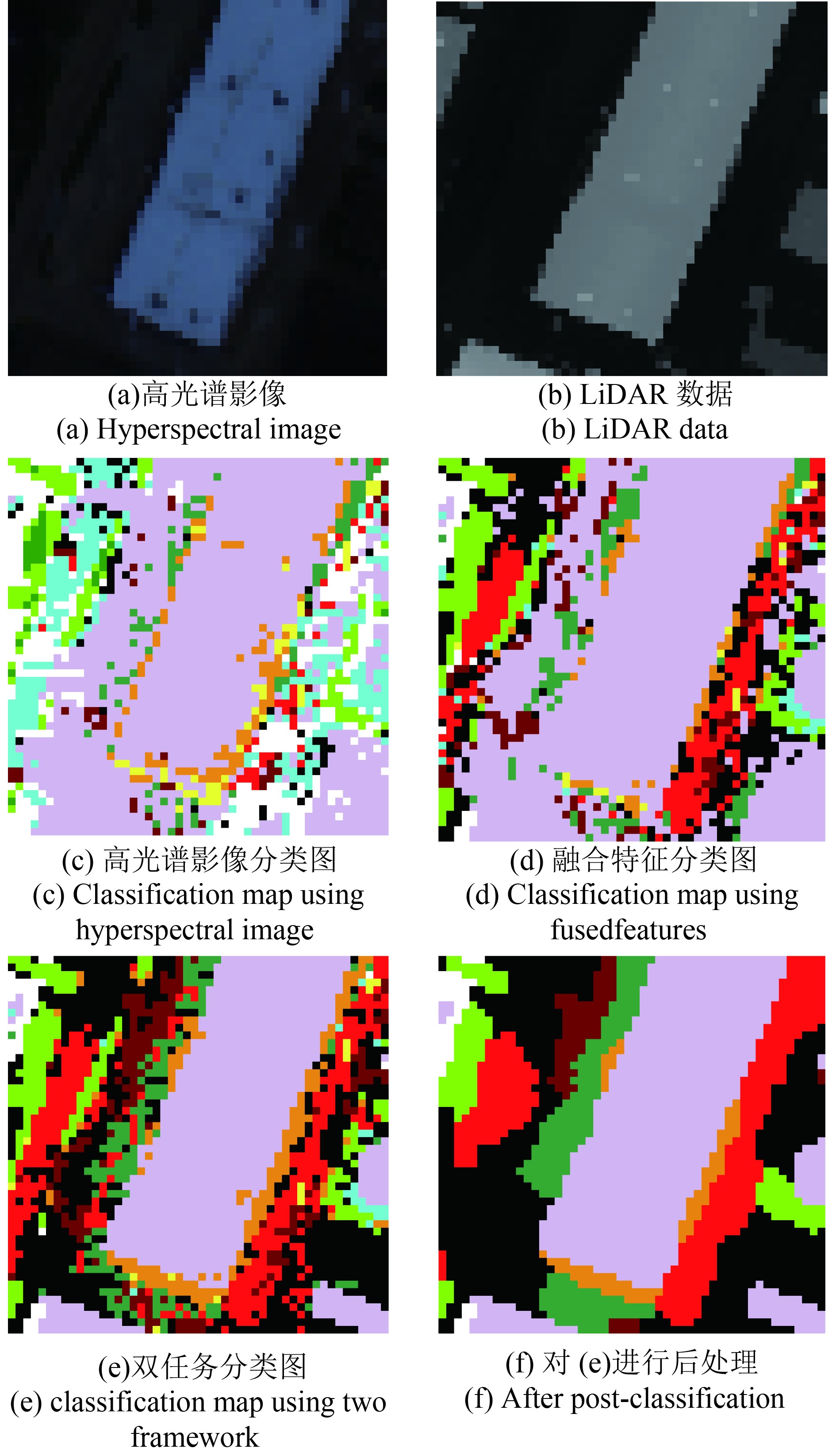

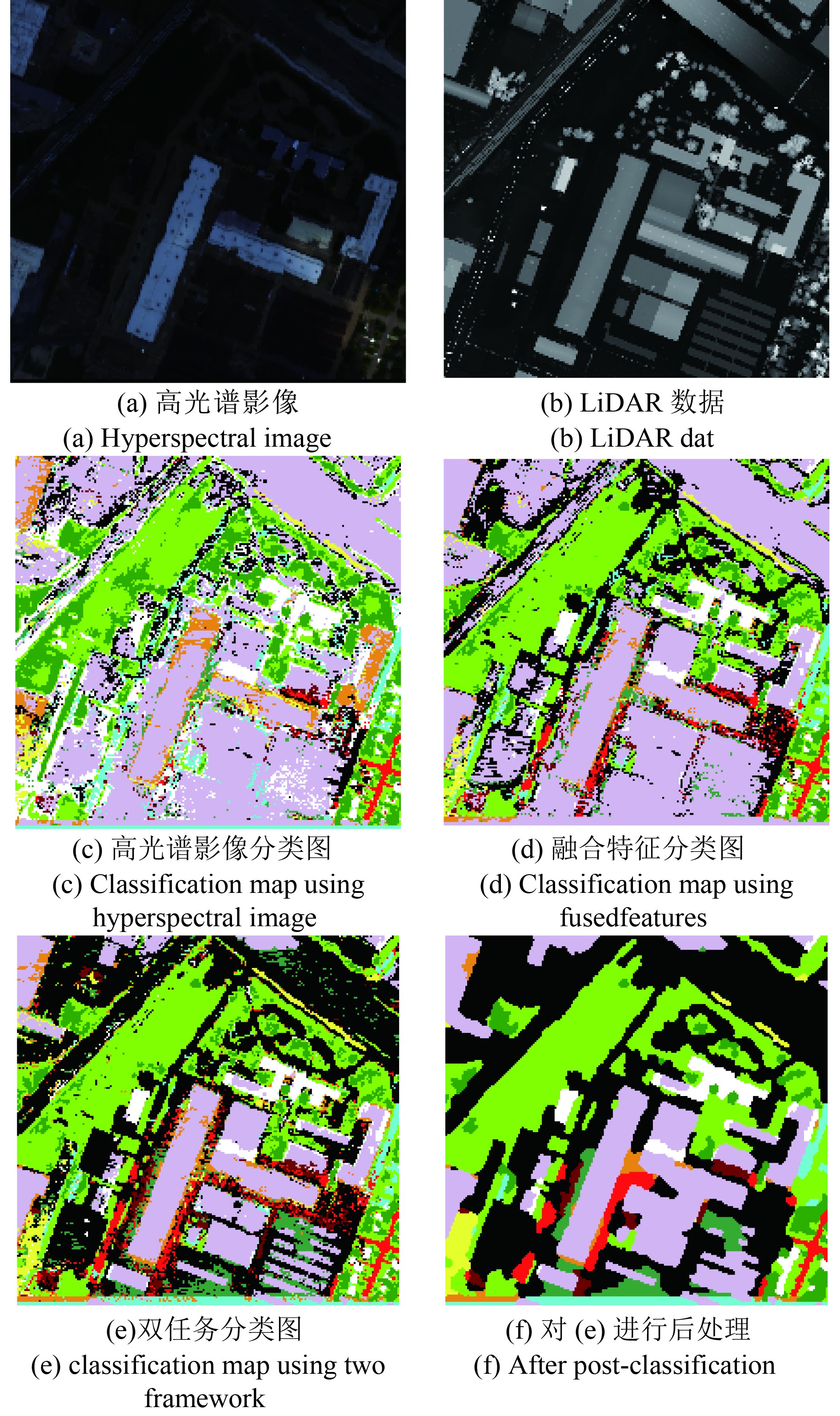

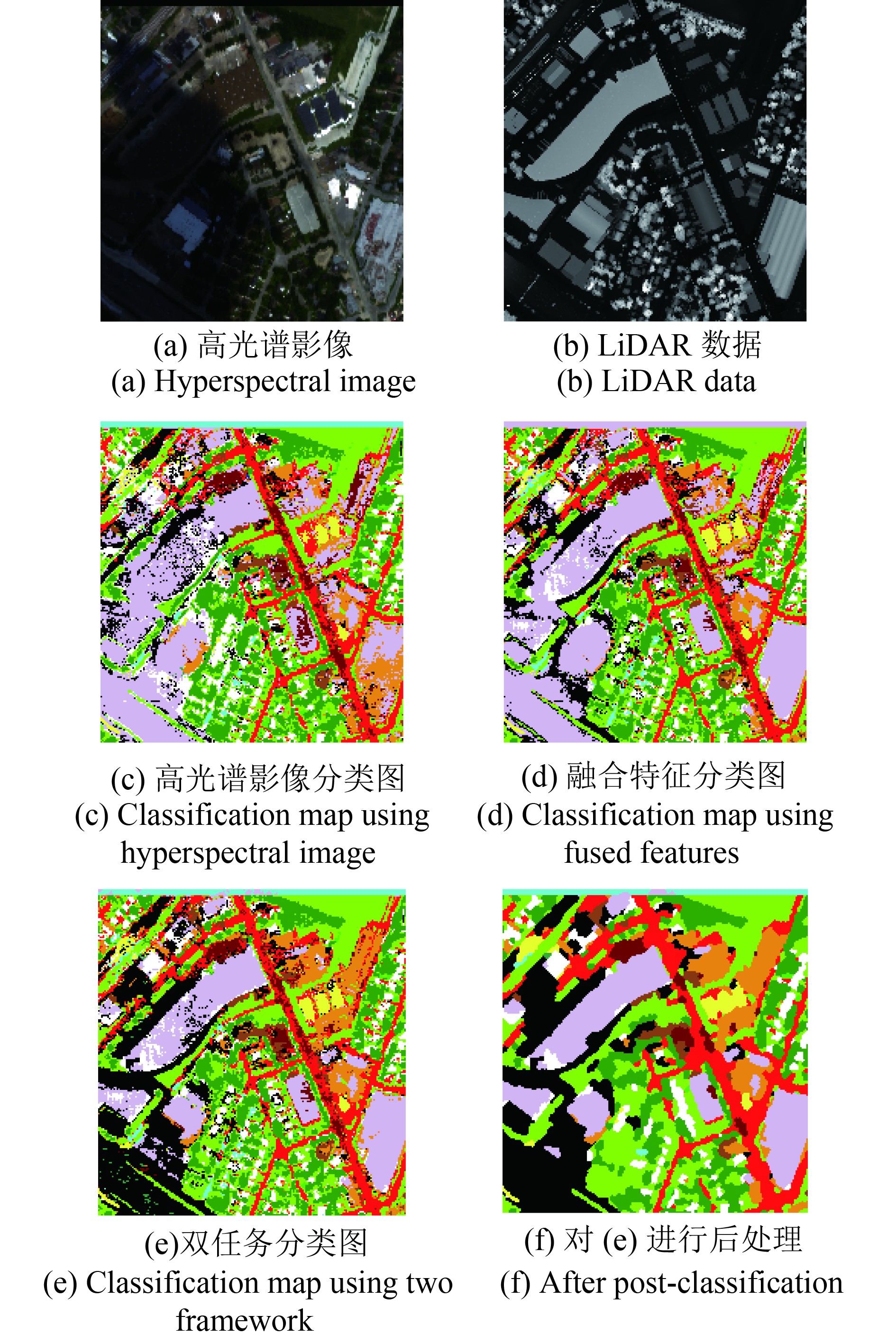

本文提出的方法利用LiDAR点云数据提取出的建筑物掩膜,将非建筑物区域单独分类,充分利用了高程信息,排除了建筑物对于非建筑物区域中道路、停车场等地物的干扰,改善了道路、建筑物及停车场的分类效果。如图4所示为不同方法对道路分类的对比图(图2区域a),具体分别为高光谱影像、LiDAR的DSM数据,单独使用高光谱影像(光谱特征及空间特征)进行多分类器分类的结果,使用高光谱与LiDAR融合特征(光谱特征、空间特征及高程特征)进行多分类器分类结果,利用建筑物掩膜的双任务分类图,对分类图进行后处理后的分类影像。

|

| 图 4 道路分类对比图 Figure 4 Comparison of the classification of road |

单独使用高光谱影像特征进行分类时,由于道路和商业区光谱信息的相似,道路被完全分为了商业区。加入LiDAR数据的高程信息后分类效果有所改善,使用本文提出的建筑物掩膜的分类结果大部分道路被正确分类。采用双任务分类的流程,不仅可以改善道路的分类效果,建筑物的分类效果也有所提升,可以清晰的提取出建筑物的边界信息。

如图5所示为不同方法得到的建筑物部分(图2区域b)的对比分类图,其中涉及的分类方法与图4中相同。单独使用高光谱影像特征分类时,建筑物与道路的混淆严重,加入LiDAR数据的高程信息时有一定的改善。由于建筑物与周围道路在高程上存在较为明显的差异,因此在DSM数据上建筑物轮廓清晰。本文利用LiDAR点云数据对建筑物进行提取作为分类掩膜,充分利用LiDAR数据的高程信息,采用该方式的分类结果,房屋边界清晰,细节信息保持良好。

|

| 图 5 建筑物分类对比图 Figure 5 Comparison of the classification of building |

像素分类中,由于空间信息考虑不足,分类结果中常存在噪声点。本文利用CRF综合考虑像素的空间领域信息,对分类影像进行平滑操作。对比情况如图6所示(图2区域c),其中涉及的分类方法与图4中相同。如图所示,建筑及道路部分存在很多细小的噪声点,CRF的平滑操作不仅能够去除像素分类导致的噪声点问题,还能够较好的保持原始影像中的一些空间细节部分,不会产生过平滑的现象。

|

| 图 6 CRF对比图 Figure 6 Comparison of the CRF |

本文提出的方法与其他融合方法的对比结果如表4所示。其中级联CNN为利用级联卷积神经网络来对两种数据进行特征提取并分类;GBFFCNN为首先对二者提取形态学特征,然后使用基于图的方式进行融合,最后使用卷积神经网络进行分类;Deep Fusion为利用3D卷积神经网络进行特征提取及分类;OTVCA为利用全变分分析法来实现特征的融合,并进行分类;基于图的方法为使用形态学算法进行特征提取,然后使用基于图的方式进行融合,最后使用支持向量机进行分类。如表所示,本文提出的方法在总体精度和Kappa值上都处于较高的水平。相比于其他的融合算法,该算法更能够在基于高光谱与LiDAR数据融合的城区地表覆盖分类问题上获得比较好的效果。

|

|

表 4 不同融合方法对比 Table 4 Comparison of different fusion method |

本文将高光谱影像与LiDAR数据进行融合应用到城市地区土地利用分类的研究。采用了同时结合特征级和决策级两个级别的融合方式,并取得了较好的效果。本文的重点主要有以下3个方面:

(1)在特征影像的组成时,采用经过降维之后的高光谱特征来表征地物的光谱信息,并加入了辨别植物的归一化植被指数,表示纹理特征的灰度共生矩阵,以及表征空间高程信息的DSM。实现了高光谱与LiDAR数据的特征级融合,增加了类别可分性,实验结果发现,本文提出的多特征融合方式能够有效融合高光谱影像的光谱特征、空间特征及LiDAR数据的高程特征,有效改善城区地表覆盖分类结果;

(2)分类时采用了两个任务进行操作。利用提取的建筑物掩膜,将非建筑物区域进行单独分类,再与全体像素分类结果结合。缓解了道路、建筑物及停车场区域因光谱信息相似而产生的错分,充分利用了LiDAR数据的高程信息。再次实现特征级融合,增加分类的精度。实验结果表明:本文提出的双任务分类方法,能够再次利用LiDAR数据的高程信息,有效改善分类结果,且得到的分类图中建筑物边缘清晰,目视效果较好;

(3)在分类时采用多种分类器,得到多幅影像,并采用投票的方式得到新的分类图。为提高部分类别的分类精度,对错分的建筑物及高架桥进行提取,并对建筑物与高速公路类别进行纠正。利用决策级融合对分类结果进行多次的修正;并在最后采用了采用分类后处理的方式,利用条件随机场对分类结果进行修正,增加了分类的精度,得到了最后的分类结果图。实验结果表现:投票方式能够综合利用各个不同基础分类结果的优势,得到更具有竞争力的结果。基于条件随机场的分类后处理方式,能够在消除分类结果中的噪声点的同时,保持细节信息,得到较好的城区地表覆盖分类图。

在未来的工作中,将会考虑以下几个问题。(1)增加建筑物提取的精度,来提高特征级融合的效果;(2)在进行特征级融合时,考虑加入LiDAR点云数据的强度等信息;(3)在使用多分类器分类时,增加分类器的数量及差异性。

志 谢 感谢休士顿大学高光谱图像分析小组、NSF机载激光测绘投资中心(NCALM)以及2013年IEEE数据融合大赛组委会提供研究中所使用的数据集。

| [1] | Akaike H. 1998. Information theory and an extension of the maximum likelihood principle//Parzen E, Tanabe K and Kitagawa G, eds. Selected Papers of Hirotugu Akaike. New York: Springer: 199-213 [DOI: 10.1007/978-1-4612-1694-0_15] |

| [2] | Benediktsson J A, Palmason J A and Sveinsson J R. Classification of hyperspectral data from urban areas based on extended morphological profiles[J]. IEEE Transactions on Geoscience and Remote Sensing, 2005, 43 (3) : 480 –491. DOI: 10.1109/tgrs.2004.842478 |

| [3] | Chen B, Huang B and Xu B. Multi-source remotely sensed data fusion for improving land cover classification[J]. ISPRS Journal of Photogrammetry and Remote Sensing, 2017a, 124 : 27 –39. DOI: 10.1016/j.isprsjprs.2016.12.008 |

| [4] | Chen B W, Shi S, Gong W, Zhang Q J, Yang J, Du L, Sun J, Zhang Z B and Song S L. Multispectral LiDAR point cloud classification: a two-step approach[J]. Remote Sensing, 2017c, 9 (4) : 373 . DOI: 10.3390/rs9040373 |

| [5] | Chen Y, Nasrabadi N M and Tran T D. Hyperspectral image classification using dictionary-based sparse representation[J]. IEEE Transactions on Geoscience and Remote Sensing, 2011, 49 (10) : 3973 –3985. DOI: 10.1109/TGRS.2011.2129595 |

| [6] | Chen Y S, Li C Y, Ghamisi P, Jia X P and Gu Y F. Deep fusion of remote sensing data for accurate classification[J]. IEEE Geoscience and Remote Sensing Letters, 2017b, 14 (8) : 1253 –1257. DOI: 10.1109/lgrs.2017.2704625 |

| [7] | Cortes C and Vapnik V. Support-vector networks[J]. Machine Learning, 1995, 20 (3) : 273 –297. DOI: 10.1007/BF00994018 |

| [8] | Fauvel M, Benediktsson J A, Chanussot J and Sveinsson J R. Spectral and spatial classification of hyperspectral data using svms and morphological profiles[J]. IEEE Transactions on Geoscience and Remote Sensing, 2008, 46 (11) : 3804 –3814. DOI: 10.1109/TGRS.2008.922034 |

| [9] | Galar M, Fernandez A, Barrenechea E, Bustince H and Herrera F. A review on ensembles for the class imbalance problem: bagging-, boosting-, and hybrid-based approaches[J]. IEEE Transactions on Systems, Man, and Cybernetics, Part C (Applications and Reviews), 2012, 42 (4) : 463 –484. DOI: 10.1109/TSMCC.2011.2161285 |

| [10] | Ghamisi P, Benediktsson J A and Phinn S. 2014. Fusion of hyperspectral and LiDAR data in classification of urban areas//Proceedings of 2014 IEEE Geoscience and Remote Sensing Symposium. Quebec City, Canada: IEEE: 181-184 [DOI: 10.1109/IGARSS.2014.6946386] |

| [11] | Pedram G, Höfle B and Zhu X X. Hyperspectral and LiDAR data fusion using extinction profiles and deep convolutional neural network[J]. IEEE Journal of Selected Topics in Applied Earth Observations and Remote Sensing, 2017, 10 (6) : 3011 –3024. DOI: 10.1109/JSTARS.2016.2634863 |

| [12] | Ghassemian H. A review of remote sensing image fusion methods[J]. Information Fusion, 2016, 32 : 75 –89. DOI: 10.1016/j.inffus.2016.03.003 |

| [13] | Kim H C, Pang S N, Je H M, Kim D and Bang S Y. Constructing support vector machine ensemble[J]. Pattern Recognition, 2003, 36 (12) : 2757 –2767. DOI: 10.1016/S0031-3203(03)00175-4 |

| [14] | Kittler J, Hatef M, Duin R P W and Matas J. On combining classifiers[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 1998, 20 (3) : 226 –239. DOI: 10.1109/34.667881 |

| [15] | Lahat D, Adali T and Jutten C. Multimodal data fusion: an overview of methods, challenges, and prospects[J]. Proceedings of the IEEE, 2015, 103 (9) : 1449 –1477. DOI: 10.1109/JPROC.2015.2460697 |

| [16] | Li J, Bioucas-Dias J M and Plaza A. Hyperspectral image segmentation using a new bayesian approach with active learning[J]. IEEE Transactions on Geoscience and Remote Sensing, 2011, 49 (10) : 3947 –3960. DOI: 10.1109/tgrs.2011.2128330 |

| [17] | Liao W Z, Bellens R, Pižurica A, Gautama S and Philips W. 2017. Combining feature fusion and decision fusion for classification of hyperspectral and LiDAR data//Proceedings of 2014 IEEE Geoscience and Remote Sensing Symposium. Quebec City, Canada: IEEE: 1241-1244 [DOI: 10.1109/IGARSS.2014.6946657] |

| [18] | Liao W Z, Pižurica A, Bellens R, Gautama S and Philips W. Generalized graph-based fusion of hyperspectral and LiDAR data using morphological features[J]. IEEE Geoscience and Remote Sensing Letters, 2015, 12 (3) : 552 –556. DOI: 10.1109/lgrs.2014.2350263 |

| [19] | 满其霞. 2015. 激光雷达和高光谱数据融合的城市土地利用分类方法研究. 上海: 华东师范大学 Man Q X. 2015. Fusion of Hyperspectral and LiDAR Data for Urban Land Use Classification. Shanghai: East China Normal University. |

| [20] | Man Q X, Dong P L and Guo H D. Pixel- and feature-level fusion of hyperspectral and lidar data for urban land-use classification[J]. International Journal of Remote Sensing, 2015, 36 (6) : 1618 –1644. DOI: 10.1080/01431161.2015.1015657 |

| [21] | Merentitis A, Debes C, Heremans R and Frangiadakis N. 2014. Automatic fusion and classification of hyperspectral and LiDAR data using random forests//Proceedings of 2014 IEEE Geoscience and Remote Sensing Symposium. Quebec City, Canada: IEEE: 1245-1248 [DOI: 10.1109/IGARSS.2014.6946658] |

| [22] | Momeni R, Aplin P and Boyd D. Mapping complex urban land cover from spaceborne imagery: the influence of spatial resolution, spectral band set and classification approach[J]. Remote Sensing, 2016, 8 (2) : 88 . DOI: 10.3390/rs8020088 |

| [23] | Rasti B, Ghamisi P and Gloaguen R. Hyperspectral and LiDAR fusion using extinction profiles and total variation component analysis[J]. IEEE Transactions on Geoscience and Remote Sensing, 2017a, 55 (7) : 3997 –4007. DOI: 10.1109/tgrs.2017.2686450 |

| [24] | Rasti B, Ghamisi P, Plaza J and Plaza A. Fusion of hyperspectral and LiDAR data using sparse and low-rank component analysis[J]. IEEE Transactions on Geoscience and Remote Sensing, 2017b, 55 (11) : 6354 –6365. DOI: 10.1109/tgrs.2017.2726901 |

| [25] | 童庆禧, 张兵, 郑兰芬. 2006. 高光谱遥感. 北京: 高等教育出版社 Tong Q X, Zhang B and Zheng L F. 2006. Hyperspectral Remote Sensing. Beijing: Higher Education Press |

| [26] | Wu H and Prasad S. 2013. Infinite Gaussian mixture models for robust decision fusion of hyperspectral imagery and full waveform LiDAR data//Proceedings of 2013 IEEE Global Conference on Signal and Information Processing. Austin, USA: IEEE: 1025-1028 [DOI: 10.1109/GlobalSIP.2013.6737068] |

| [27] | Xu X D, Li W, Ran Q, Du Q, Gao L R and Zhang B. Multisource remote sensing data classification based on convolutional neural network[J]. IEEE Transactions on Geoscience and Remote Sensing, 2018, 56 (2) : 937 –949. DOI: 10.1109/TGRS.2017.2756851 |

| [28] | Zhang J X, Lin X G and Ning X G. SVM-based classification of segmented airborne LiDAR point clouds in urban areas[J]. Remote Sensing, 2013, 5 (8) : 3749 –3775. DOI: 10.3390/rs5083749 |

| [29] | 张良培, 沈焕锋. 遥感数据融合的进展与前瞻[J]. 遥感学报, 2016, 20 (5) : 1050 –1061. Zhang L P and Shen H F. Progress and future of remote sensing data fusion[J]. Journal of Remote Sensing, 2016, 20 (5) : 1050 –1061. DOI: 10.11834/jrs.20166243 |

| [30] | 赵济. 2017. 面向高分辨率遥感影像分类的条件随机场模型研究. 武汉: 武汉大学 Zhao J. 2017. Conditional Random Fields for High Resolution Remote Sensing Image Classification. Wuhan: Wuhan University |

| [31] | Zhao J, Zhong Y F, Shu H and Zhang L P. High-resolution image classification integrating spectral-spatial-location cues by conditional random fields[J]. IEEE Transactions on Image Processing, 2016, 25 (9) : 4033 –4045. DOI: 10.1109/tip.2016.2577886 |

| [32] | Zhao J, Zhong Y F and Zhang L P. Detail-preserving smoothing classifier based on conditional random fields for high spatial resolution remote sensing imagery[J]. IEEE Transactions on Geoscience and Remote Sensing, 2015, 53 (5) : 2440 –2452. DOI: 10.1109/TGRS.2014.2360100 |

| [33] | Zhong Y F, Cao Q, Zhao J, Ma A L, Zhao B and Zhang L P. Optimal decision fusion for urban land-use/land-cover classification based on adaptive differential evolution using hyperspectral and LiDAR data[J]. Remote Sensing, 2017a, 9 (8) : 868 . DOI: 10.3390/rs9080868 |

| [34] | Zhong Y F, Jia T Y, Zhao J, Wang X Y and Jin S Y. Spatial-spectral-emissivity land-cover classification fusing visible and thermal infrared hyperspectral imagery[J]. Remote Sensing, 2017b, 9 (9) : 910 . DOI: 10.3390/rs9090910 |

| [35] | Zhong Y F, Ma A L, Ong Y S, Zhu Z X and Zhang L P. Computational intelligence in optical remote sensing image processing[J]. Applied Soft Computing, 2018, 64 : 75 –93. DOI: 10.1016/j.asoc.2017.11.045 |