2. 北京化工大学 理学院, 北京 100029

2. School of Science, Beijing University of Chemical Technology, Beijing 100029, China

0 引言

危化品运输相对于其他货物的运输, 最大的区别在于其事故后果的严重性. 例如, 2005年3月29日发生在京沪高速公路淮安路段的槽罐车液氯泄露事故, 致使29人死亡, 近一万人紧急疏散, 大片农田被污染; 2008年2月18日发生在京珠高速湖南耒宜段的槽罐车液笨泄漏起火爆炸事故, 引发连环交通事故, 致使15人死亡, 2人失踪, 18人受伤; 2014年3月1日发生在晋济高速岩后隧道内的槽罐车甲醇泄漏起火爆炸事故, 引发连环交通事故, 致使31人死亡, 9人失踪.

危化品运输安全问题一直是我国政府关注的重点问题之一,为此, 国家出台了相应的法律法规和相关政策以加强对危化品运输的行政监管, 如国务院令第591号《危险化学品安全管理条例》(2011年12月1日起施行), 中华人民共和国交通运输部令2013年第2号《道路危险品货物运输管理规定》(2013年7月1日起施行)等. 除了对危化品运输公司行政监管, 各国还通过在道路收费方面采取相应措施来影响危化品运输决策. 例如, 我国为避免重复收费,针对交通运输企业征收的税费由营业税改为增值税; 希腊利用新道路税征收系统对新道路进行征税,该政策既节省时间, 又减少费用,同时也大幅度减少了不能按时交税的车主数量. 在路径税收政策下危化品运输企业如何选择运输路径成为危化品运输中亟需解决的问题之一.

危化品运输问题不仅得到国家相关部门高度关注, 而且也是学术界研究的热点内容之一, 已有大量相关研究成果. 本文将从危化品运输风险、路径税收政策以及研究方法三方面对已有文献进行回顾.

部分学者针对危化品安全运输中的各风险因素进行了研究. 吴宗之[1]、 李健[2] 分别对2006--2010年和2011--2013年危化品事故进行了统计分析, 沈小燕[3]} $对2004年1月--2011年12月发生的886起危险品罐式车辆道路运输事故进行了分析. 从危险品事故的统计分析可以看出, 在保证车辆行驶过程中始终保持正常安全状态, 且危化品载体不存在安全隐患的情况下,存在以下几种风险因素: 人员因素、气候因素、道路及交通环境因素. Akgun[4]在危化品运输网络中寻找最短路径时, 将天气系统作为一个风险因素, 得到天气变化引起的车速变化及事故率. 基于以上文献, 可以得到天气、地形及人为因素是影响危化品安全运输的重要因素. 而以往文献, 大部分只是定性考虑这三个方面的因素, 较少有定量化分析. 本文将这三方面因素进行定量化, 以费用的方式引入到模型中, 进而更加深入地研究这三方面因素的影响.

部分学者针对政府的运输道路收税问题进行了研究. Marcotte[5]在危化品运输网络中,为使整个运输网络风险最小, 结合人口暴露和运输者费用的不同权重,确定税收定价, 运输者选择费用最小的路径. Bianco[6]考虑到Marcotte[5]模型中的缺陷, 即运输者可能选择同一条费用小的路径,虽然整个运输网络的风险最小, 但是某一条路径风险将会很大,对税收重新定价, 使得各路径及整个运输网络风险同时最小. Tan[7]认为现有交通网可分为免费、公有及私有三种所有权机制, 在现有机制条件下,添加一条新的收费道路, 进而针对新收费道路税收定价、新网络对整个网络社会效应的影响, 以及政府开发新道路对刺激投资三个方面进行了讨论. 基于以上文献, 可以得出政府对运输道路进行收税可以影响到运输公司对运输道路的选择. 本文将该思想引入到模型中, 假定政府在对危化品运输公司进行行政监管的同时, 通过对部分运输路径进行征税,并利用这部分税收维护该路段, 以提高其安全性,进而刺激运输企业选择费用最少且风险最小的路径.

针对危化品运输路径选择问题, 部分学者应用双层规划模型分析法进行了研究,如代文强[8]、 沈小燕[9]等,建立风险和费用的双层次规划模型. 但该方法难以获得全局最优解. 对此, 李昌兵[10]设计了层次粒子群算法,使得各方利益均达到最大化. 但危化品运输企业选择运输道路并非是一次性决策, 而是随时间发展不断调整的过程, 同时危化品运输企业是一个能够自主学习的个体, 常常因受到其他运输企业的影响而改变自己最初的选择. 上述方法不考虑时间变化和其他危化品运输企业的影响, 并不完全适用于现实情况. 博弈论是一种能够使得决策各方根据对方的策略做出对自己最优策略选择的决策方法, 演化博弈则主要研究群体策略如何随时间变化达到一个稳定状态, 将演化博弈中决策者的策略选择随时间变化的特性与决策个体具有自主学习的特性相结合则成为基于强化学习的演化博弈理论. 可以发现, 基于强化学习的演化博弈理论适用于分析路径税收政策下危化品运输路径选择的问题.

多位学者针对强化学习相关理论及实际应用进行了研究. 刘伟民[11, 12]将Q-强化学习算法引入到演化博弈中, 得到单代理人Q-学习决策模型和多代理人Q-学习决策模型, 并通过仿真算例证明了Q-学习决策模型对于决策者做出最优决策具有指导意义, 且多代理人Q-学习决策方法优于单代理人Q-学习决策方法. 黄彬彬[13]利用基于Q-学习的演化博弈理论对农田水利设施管理问题进行研究, 将原博弈模型与新博弈模型进行仿真对比, 证实新管理模式中农民更易选择"合作策略", 更利于解决农田水利设施管理问题. 段勇[14]将概率神经网络与强化学习方法结合, 构成新的多智能体强化学习算法, 利用该方法有效解决了足球机器人在与环境交互学习情况下的协作问题. 赵晗萍[15]将强化学习与遗传算法相结合, 设计出新的生产商学习机制, 为研究复杂供应链主从博弈的协调问题提供新思路. 杨智[16]为研究多成品率衰变设备预防维修问题, 建立了隐马氏决策过程模型,并利用强化学习方法确定最优维修策略, 通过算例分析, 验证了基于强化学习的预防维修策略优于传统的固有周期维修策略. 在运输路径选择方面. Zolfpour-Arokhlo[17]综合考虑了运输路网中各环境因素及其权重, 将Q值动态规划与Boltzmann概率分布法相结合, 设计了一种新的多代理强化学习路径选择系统模型,以解决车辆延误问题. 基于以上文献回顾,可以得出基于Q-学习的强化学习决策方法已较成熟, 可被用于各研究领域. 但是, 对于风险大、事故后果严重的危化品运输路径选择问题, 运用Q-学习的强化学习演化博弈理论进行研究的文献较少.

基于以上考虑, 本文运用Q-学习的强化学习决策方法研究路径税收政策下危化品运输路径选择演化博弈问题. 首先,建立了路径税收政策下危化品运输路径选择的博弈模型. 该模型中, 综合考虑了天气、地形及人为风险, 并将风险以费用的方式引入到博弈模型中; 政府在保证行政监管行为不变的情况下,对部分路段进行收税, 并利用该部分资金维护、改善道路,以提高道路安全性. 接着, 本文对强化学习进行了介绍,包括Q-学习算法及策略迭代. 再次, 通过仿真算例,对路径税收政策下危化品运输路径选择问题进行研究. 最后,得出相应结论及展望. 1 博弈模型 1.1 博弈方

危化品运输公司在承接运输任务的时候, 会从危化品运输委托方获取部分信息, 包括运输物品类型、运输目的地等. 危化品运输公司根据委托方给出的信息, 确定运输路径, 并确定运输委托费. 目前, 市场中, 存在很多危化品运输公司, 委托方在综合比较各公司给出的费用、信用、安全性等因素后, 从众多危化品运输公司中选择一家,委托其运输危化品. 因此, 各危化品运输企业之间存在着竞争关系. 本文选取的博弈方为同一城市的两家运输公司, 即运输公司1和运输公司2. 同时, 假设两家公司承接的运输任务相同, 即两家公司以相同的价格、相同的成本将相同的危化品运输到同一城市. 1.2 策略

国家对危化品运输企业进行监管时, 行政监管行为不变, 对不同路径上的运输企业进行征税, 该部分税收主要用于该路段的维护、改善, 以提高其运输安全性. 由于国家并非对所有运输路径进行征税, 故存在部分路段没有设定税收, 运输公司在运输过程中不需要缴税的现象. 因此, 在本模型中, 两家危化品运输公司的策略集均为(收税路段,免税路段). 1.3 参数设定

1)运输企业的运输收入$R$.

2)运输企业的运输成本$C$.

3)政府对收税路段上的运输企业征税$C_{T}$.

4) $P_{i}$为运输企业在不同路径上发生风险的概率. $P_{1}$为运输企业在收税路段上出现风险的概率; $P_{2}$为运输企业在免税路段上出现风险的概率. $P_{1}\neq P_{2}$.

5) $C_{w}$为天气因素存在的风险损失; $C_{g}$为收费路段上地形因素存在的风险损失; $C_{g}'$为免费路段上地形因素存在的风险损失; $C_{p}$为运输者存在的潜在的风险损失.

6)若两家公司同时选择收税路段, 收税路段的安全性会因税收的增加而得到提高, 安全性的提高会降低运输企业的风险损失, 即增加收益$A$; 同样, 若两家公司同时选择免税路段, 免税路段的安全性会因路段负荷量增加且得不到很好的维护而降低, 安全性的降低会增加企业的运输风险, 即增加风险成本$B$; 若两家公司一家选择收税路段, 一家选择免税路段, 则风险成本不发生变化.

7)设$C_{T}+P_{1}C_{g}>P_{2}C_{g}'+B>C_{T}+P_{1}C_{g}-A>P_{2}C_{g}'$. 1.4 收益矩阵

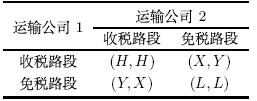

该博弈中双方的收益矩阵如表 1所示.

其中,$H=R-C-C_{T}-{P_{1}}({C_{w}+C_{g}+C_{p}})+A$, $X=R-C-C_{T}-{P_{1}}({C_{w}+C_{g}+C_{p}})$, $Y=R-C-{P_{2}}({C_{w}+C_{g}'+C_{p}})$, $L=R-C-{P_{2}}({C_{w}+C_{g}'+C_{p}})-B$. 2 强化学习

针对政府对部分危化品运输路径进行征税的现象, 运输企业会采取相应的对策, 而企业的策略会对危化品运输路径的道路情况等环境因素造成影响, 而这些环境因素会反作用于运输企业, 影响运输企业的下一次策略选择. 在与环境相互影响的过程中, 运输企业自主地选择自己的策略, 具有自主学习的能力. 因此, 本文选择运用强化学习来研究路径税收政策下危化品运输路径的选择问题.

Q-学习算法是强化学习的主要算法之一, 也是各学者研究实际问题主要应用的算法之一. 刘伟民[11, 12]和黄彬彬[13]等在应用Q-学习算法解决实际问题时, 对Q-学习相关的理论知识进行了详细的介绍. 在演化博弈中, 博弈参与方的主要目标是追求自身利益最大化,即期望折扣收益最大, 而期望折扣收益可以通过Q值来表示:

其中, $s_{i}$为博弈方$i$当前的状态, $s'_{i}$为博弈方$i$新的状态, $a^{i}$为博弈方$i$当前的策略选择, 且$a^{i}\in A$, $\gamma\in(0,1)$ 为折扣因子, $p(s'_{i}|s_{i},a^{i})$为博弈方$i$由当前状态转移到新状态的转移概率, 而博弈方$i$由当前状态转移到新状态的转移概率为:

| \begin{eqnarray} p(a^{i})=\frac{{\rm e}^{\frac{Q(s_{i},a^{i})}{\lambda}}} {\sum\limits_{a \in A}{\rm e}^{\frac{Q(s_{i},a)}{\lambda }}} \end{eqnarray} | (2) |

随着时间及环境的变化,Q值不断进行更新变化:

| \begin{eqnarray} Q_{t+1}(s_{i},a^{i})=(1-a^{i}_{t})Q_{t}(s_{i},a^{i})+ \alpha_{t} [r_{t}+ \gamma\max\limits_{b}{Q_{t}(s'_{i},b)}] \end{eqnarray} | (3) |

强化学习是博弈方不断学习, 不断改变自身策略选择的过程. 在已知了博弈方期望折扣收益、转移概率等表示方法及其变化过程后, 基于强化学习的两人演化博弈模型的策略迭代算法流程可表示为:

Step 1 令$t=0$及$Q=0$, 且博弈方$i$随机做出前两次的策略选择.

Step 2 确定博弈方$i$当前的状态$S_{i}$, 并分别计算出当前状态下, 危化品运输企业选择在收税路段和免税路段上进行运输的概率, 根据该概率做出下一次的策略选择.

Step 3 对Q值进行更新.

Step 4 转到Step 2, 令$t=t+1$, 继续迭代, 直到状态搜索完为止. 3 模型理论分析

本节将从理论上对路径税收政策下危化品运输路径选择问题进行分析, 给出危化品运输公司在路径税收政策下运输路径的最优策略选择.

危化品运输公司在对危化品运输路径选择时, 存在两种选择, 即"收税路段"和"免税路段". 不同路段上, 危化品运输公司在运输过程中发生风险的概率不同, 潜在的风险损失不同, 且得到的收益也不同. 两家危化品运输公司存在相互竞争关系, 任何一方都不知道对方会做出什么样的选择. 对于运输公司而言, 选择"免税路段"是"上策". 但是, "收税路段"是该博弈的纳什均衡解. 这样, 对于运输公司而言, 存在类似于"囚徒困境"的选择困境.

两家运输公司在均不知道对方策略选择的情况下, 随机进行两阶段的策略选择. 假设运输公司1选择"收税路段", 运输公司2选择"收税路段". 此时, 两公司均存在侥幸心理, 对方会选择"免税路段", 若自己继续选择"收税路段", 则自己的收益将会减小, 对方的收益会增加, 故会在第3阶段选择"免税路段". 若对方在第3阶段, 选择"免税路段", 则自己的收益比选择"收税路段"时要小, 故会在第4阶段选择"收税路段"; 若对方在第3阶段, 选择"收税路段", 则自己的收益比选择"收税路段"时要大, 故会在第4阶段选择"免税路段". 如此往复, 在接下来的各阶段, 运输公司将根据自己当前的策略及对方的策略, 以及自己获得的收益和, 做出下一步的策略选择.

对于运输公司而言,"收税路段"是该博弈的纳什均衡解, 在不断进行的策略选择过程中,选择"收税路段"对于危化品运输公司而言, 其总的期望折扣收益将会最大, 且两运输公司的策略选择将会快速收敛于"收税路段". 因此, 对于危化品运输公司而言,在路径税收政策下, "收税路段"是危化品运输路径选择演化博弈的进化稳定策略. 4 模型仿真实验

本节将以基于强化学习的演化博弈模型为分析框架, 通过算例来说明选择"收税路径"是危化品运输公司在路径税收政策下运输路径的最优选择策略. 本文建立的模型类似于囚徒困境博弈, 两博弈方的策略均为: 收税路段和免税路段. 根据给出的参数设定及参数范围, 可得到表 2, 表 2给出了路径税收政策下危化品运输路径选择的收益矩阵.

由收益矩阵可以看出: 选择免税路段进行运输, 对于危化品运输企业而言是占优策略, 也是该博弈的纳什均衡解. 但是, 当两家危化品运输企业同时选择收税路段时, 将会得到更多的收益. 同样, 政府也期望危化品运输企业能够同时选择在收税路段上进行运输. 政府对部分运输路段进行收税, 并应用这些税收维护、改善收税路段的道路安全状况, 进而提高危化品运输企业在收税路段进行运输时的收益, 其主要目的就在于, 提高危化品运输安全性, 降低国家因危化品运输出现风险而造成的损失. 本文针对路径税收政策下危化品运输路径选择问题, 多次重复博弈方的状态、策略等, 使得博弈双方之间相互沟通、影响, 最终能够共同选择在收税路段上进行运输, 以满足政府期望的最低事故率及运输公司期望的最多收益的目标.

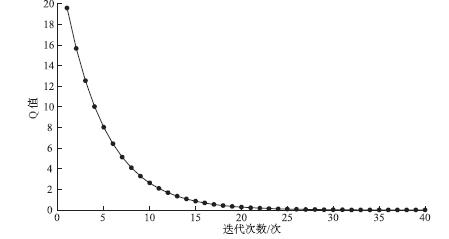

基于以上描述,根据之前给出的策略迭代过程,对Q值不断进行更新, 得到基于强化学习的危化品运输路径选择演化博弈模型的Q值迭代曲线, 如图 1所示.

|

| 图 1 Q学习博弈模型中Q值迭代图 |

本模型取$\gamma=0.8$,重复300次博弈, 其中博弈方选择策略"收税路段"出现了258次,占半数以上, 且最后策略稳定于"收税路段",不再选择"免税路段". 由此可知, 在路径税收政策下, 危化品运输企业在选择运输路径时会彼此相互沟通、影响, 最终均选择在收税路段上进行运输. 5 结论及展望

危化品运输安全问题一直是国家关注的重点问题, 并通过采取不同措施来降低危化品运输安全事故发生风险. 本文基于强化学习的演化博弈理论分析了路径收税政策下危化品运输路径选择的问题. 文中假设政府在不同运输路段上进行收税, 并应用这部分税收对该运输路段进行维护、改造, 提高运输路径的安全性. 本文考虑了危化品运输企业具有学习能力, 以强化学习为分析框架, 对路径税收政策下危化品运输公司的策略选择行为进行了仿真分析. 由仿真结果可以发现, 强化学习下, 危化品运输企业快速多次地选择了在收税路段上进行运输. 本文的研究方法为危化品运输路径选择问题提供了新的思路.

本文只是针对部分运输路段进行定税, 而运输公司的运输任务不仅仅局限于某一目的地, 对危化品运输路网选择进行研究是未来的重要研究方向.

| [1] | Frieze M, Galbiati G, Maffioli F. On the worst-case performance of some algorithms for the asymmetric traveling salesman problem[J]. Networks, 1982, 12(1): 23-39. |

| [2] | Bläser M. A new approximation algorithm for the asymmetric TSP with triangle inequality[C]// Proceedings of the 14th annual ACM-SIAM symposium on discrete algorithms. PA, USA: Society for Industrial and Applied Mathematics Philadelphia, 2003: 638-645. |

| [3] | Kaplan H, Lewenstein M, Shafrir N, et al. Approximation algorithms for asymmetric TSP by decomposing directed regular multigraphs[C]// Proceedings of the 44th Annual IEEE Symposium on Foundations of Computer Science. Washington, DC, USA: IEEE Computer Society, 2003: 56. |

| [4] | Ausiello G, Feuerstein E, Leonardi S, et al. Algorithms for the on-line travelling salesman[J]. Algorithmica, 2001, 29(4): 560-581. |

| [5] | Lipmann M. The online traveling salesman problem on the line[D]. Amsterdam, Netherlands: University of Amsterdam, 1999. |

| [6] | Blom M, Krumke S O, De-Paepe W E, et al. The online-TSP against fair adversaries[J]. Informs Journal on Computing, 2001, 13(2): 138-148. |

| [7] | Jaillet P, Wagner M. Generalized online routing: New competitive ratios, resource augmentation and asymptotic analyses[J]. Operations Research, 2008, 56(3): 745-757. |

| [8] | Jaillet P, Wagner M. Online routing problems: Value of advanced information as improved competitive ratios[J]. Transportation Science, 2006, 40(2): 200-210. |

| [9] | Allulli L, Ausiello G, Bonifaci V, et al. On the power of lookahead in on-line server routing problems[J]. Theoretical Computer Science, 2008, 408(2): 116-128. |

| [10] | 温新刚,徐寅峰,丁黎黎. 基于预知信息的占线Nomadic TSP问题[J]. 系统工程理论与实践, 2013, 33(1): 1-7. Wen Xingang, Xu Yinfeng, Ding Lili. Online nomadic TSP based on the advanced information[J]. Systems Engineering —— Theory & Practice, 2013, 33(1): 1-7. |

| [11] | Wen X G, Xu Y F, Zhang H L. Online traveling salesman problem with deadline and advanced information[J]. Computers & Industrial Engineering, 2012, 63(4): 1048-1053. |

| [12] | Ausiello G, Bonifaci V, Laura L. The on-line asymmetric traveling salesman problem[J]. Journal of Discrete Algorithms, 2008, 6(2): 290-298. |

| [13] | Borodin A, El-Yaniv R. Online computation and competitive analysis[M]. Cambridge: Cambridge University Press, 1998. |