Palmprint and palm vein recognition method based on modal information evaluation strategy

-

摘要: 多模态生物特征识别技术凭借其出色的识别效果和稳健的可靠性引起了业界的广泛关注。然而,传统多模态生物特征识别方法通常直接在特征层或决策层进行融合,很少考虑模态样本质量不同导致的融合效果差异。此外,由于缺乏大规模公开多模态生物特征数据库,多模态生物特征识别方法的研究受到一定程度上的限制。因此,设计了一款手部多模态数据采集设备,并自建了手部多模态数据库,用于多模态生物特征识别方法的验证与评估;提出了一种基于模态信息度评估策略的掌纹掌静脉特征识别方法,利用样本标签对应的类别置信度来评估每个模态特征的信息度,从而使模型在融合过程中根据不同模态对身份识别的贡献率进行自适应的权重分配。实验表明该方法在2个公开的数据库以及自建数据库上均取得了最高识别率。Abstract: Multimodal biometric recognition has gained widespread attention in the industry due to its excellent performance and robust reliability. However, traditional multimodal biometric recognition methods usually fuse directly at the feature or matching layer and rarely consider the differences in fusion effects caused by the quality of modal samples. Moreover, research on multimodal biometric recognition methods is restricted by the absence of large-scale publicly available multimodal biometric databases. Therefore, first, a hand multimodal data acquisition device is designed, and a hand multimodal database is created for the validation and evaluation of multimodal biometric recognition methods. Second, a palmprint and palm vein fusion recognition method is proposed based on a modal information evaluation strategy. It uses the category confidence level corresponding to ground truth sample labels to assess the information level of each modal feature. Thus, the model adaptively assigns weights according to the contribution rates of different modes during the identity recognition fusion process. This method outperforms other recognition methods by achieving the highest recognition rate on two public databases and one self-built multimodal biometric database.

-

在日常生活中,个人信息已成为每个人宝贵的资产。一旦身份信息被泄露,可能会导致不可估量的负面后果。在诸多身份鉴别的解决方案中,生物特征识别技术被认为是最有效的方案之一[1-2]。尽管人脸[3]、指纹[4]、掌纹[5]和静脉[6]等单模态身份识别技术已经取得了显著的进展,并且在多个领域得到了广泛的应用。但是单模态生物特征识别方法在不同程度上均受到以下问题的影响:1)传感器噪声:例如,在掌纹采集过程中,采集仪器上的灰尘可能会影响掌纹图像的质量,而不理想的光照条件也可能会降低识别的准确性;2)非普遍适用性:例如,用户自身因素可能导致静脉信息在图像中丢失,造成图像对比度较差,影响身份识别的准确性;3)安全性:例如,利用伪造掌纹可能会骗过基于掌纹的生物特征识别系统;4)用户设备和时间变化:由于用户使用不同的图像采集设备,以及随着时间的推移,用户的生物特征可能会发生部分变化,这可能导致属于同一类别的样本之间存在显著差异,从而对身份认证产生影响,进而影响识别性能[7]。

近年来,为了进一步提升身份识别技术的准确性和防伪性,多模态生物特征识别技术得到了广泛的关注。例如,Jani等[8]提出了一种基于匹配分数加权的融合方法,该方法融合指纹和静脉的匹配分数,取得了较高的准确率。周晨怡等[9]提出了一种基于特征距离信息引导的决策级融合,对虹膜、掌静脉和手指静脉3个模态进行融合识别。Kabir等[10]提出了一种基于哈希编码的两阶段融合方法,首先,融合多模态生物特征系统中的单特征编码器的编码特征,并将其称为第一阶段融合(first-stage fusion, FSF)。接下来,将多模态系统中性能最佳的单模态系统和所提出的FSF进行另一次融合,称为第二阶段融合(second-stage fusion, SST)。

虽然上述多模态生物特征识别方法取得了不错的识别效果,但是这些方法都忽略了不同模态和不同质量的样本对模型性能的影响。在真实场景中,随着非接触式采集设施的普及,图像的过曝、模糊、失真和噪声等因素往往会难以避免[11-12],进而导致采集的同一个人的不同模态图像质量可能存在不同或者不同人的同一模态图像质量也可能会存在差异[13-14]。此外,目前已公开的手部多模态图像数据库较少,不利于识别模型的有效测试与评估[15-16]。为解决上述问题,本文构建了包含掌纹、掌静脉、手背静脉3种模态信息的手部多模态数据库(CUMT hand multimodal database, CUMT-HMD),同时以掌纹和掌静脉图像为研究对象,设计了一种基于模态信息度评估策略的掌纹掌静脉特征识别方法。

本文的主要贡献总结如下:

1)为了推动生物特征识别技术的进步,本文构建了一个手部多模态数据库CUMT-HMD。与现有的公开数据库相比,该数据库不仅拥有更丰富的样本,还同时涵盖手部的3种模态数据,对提升生物特征识别模型的泛化能力以及进一步优化识别性能具有积极意义。现已将此数据库公开发布,可通过以下链接访问:https://pan.baidu.com/s/1nYbp_SqlUzmD4WJPEzb8bA?

2)本文提出了一种动态融合策略,通过评估不同模态不同样本的信息度,自适应地融合不同模态的生物特征信息。该策略能够有效降低模态特征中的噪声影响,并增强模型对模态特征质量动态变化的鲁棒性,从而达到双模态生物特征的高效、自适应融合。

3)针对多模态融合过程中存在不可靠性这一问题,设计了信息度评估模块,核心思路是利用各模态样本的真实标签所对应的类别置信度,作为该模态样本的信息度,从而衡量不同类别与模态之间生物特征的相对重要性。

1. 相关工作

1.1 掌纹识别

掌纹是指手指根部到手腕之间的皮肤纹理,具有较大的信息捕获区域,含有丰富的特征,可用于辨识身份[17]。1985年,Matsumoto[18]首次提出将掌纹作为个体特征,用于个人身份识别。目前,掌纹识别方法主要分为2类:基于传统特征提取方法和基于深度学习方法。

在传统的掌纹识别方面,国内外许多学者深入研究如何高效地进行掌纹特征识别,例如,Wang等[19]在比较多种去模糊化算法的基础上,采用手掌图像非局部集中稀疏表示对手掌图像进行重构,提高了掌纹图像的识别精度。Yang等[20]提出了一种基于局部稀疏表示法的掌纹识别方法,局部稀疏编码首先找到

$ n $ 个与测试样本相似的样本,然后将$n$ 个样本应用于测试样本的稀疏表示。Păvăloi等[21]利用SURF(speeded up robust features)关键点对掌纹识别问题进行了研究。然而,传统的掌纹识别方法无法应对更复杂的应用需求,例如非控制环境下、跨域等掌纹识别问题。随着深度学习的发展,基于卷积神经网络(convolutional neural network, CNN)的方法为解决这些难题提供了可能。在深度特征表示方面,Liu等[22]采用ImageNet预训练的AlexNet提取掌纹图像的深度特征。Zhong等[23]提出了一种端到端的掌纹识别方法,首先使用2个参数共享的VGG16网络来提取图像的卷积特征,然后将2张掌纹图片分别输入到孪生网络,输出特征的相似度来完成身份验证任务。基于卷积神经网络的特征学习方法往往需要大量训练数据,为此,Wang等[24]利用生成对抗学习,生成高质量掌纹图像,在小规模数据库上取得了更高的识别精度。尽管一般的深度掌纹识别算法通常较为复杂,无法满足嵌入式系统的实时需求,但Shao等[25]构造了一种新的蒸馏损失函数,用于对深度模型进行压缩,进一步提高网络的特征提取效率。

1.2 掌静脉识别

静脉识别因其体内分布、活体识别等独特特性在身份认证领域被广泛应用。1991年,掌静脉识别技术首次被提出[26]。目前,掌静脉识别方法可以归纳为2类:基于传统特征表示方法和基于深度学习方法。在基于传统特征表示方法的掌静脉识别领域,研究人员主要设计手工特征表示方法获取掌静脉图像的结构信息或纹理信息,然后利用传统机器学习方法进行身份识别。例如,Wang等[27]研究了手掌距离与手掌静脉识别性能之间的关系,从低分辨率感兴趣区域图像的清晰度、图像结构差异以及图像匹配结果等方面进行了探讨。此外,Sun等[28]提出了一种基于邻域保持嵌入(neighborhood preserving embedding, NPE)和核极限学习机(kernel extreme learning machine, KELM)的手掌静脉识别算法,该算法保留了嵌入降维特征的邻域信息,并最终使用核极限学习机进行分类和识别。此外,基于深度学习的方法也在掌静脉识别领域取得了显著进展。袁丽莎等[29]提出了2种掌静脉识别方法,一种是基于双通道卷积神经网络,另一种是采用迁移学习和随机森林进行识别。Jia等[30]对比了多种常用深度卷积神经网络在手掌静脉图像上的识别效果,并通过实验证明了ResNet18网络具有较好识别性能。此外,Du等[31]提出了基于一种基于端到端卷积神经网络的掌静脉识别方法。Wang等[32]通过CycleGAN网络模型扩充了静脉图像样本集,并提出了一个由约束CNN和CycleGAN组成的分层生成对抗网络用于数据增强。

1.3 掌纹掌静脉融合识别

掌纹与掌静脉融合识别技术虽然在生物识别技术领域起步较晚,但近年来受到越来越多的关注。掌纹与掌静脉融合识别技术具有广泛的应用前景和研究价值,相对于单一模态的识别技术,从互补性入手融合掌纹和掌静脉模态,可以提高生物特征识别的准确性和鲁棒性。

在传统方法和深度学习方法中,研究者们采用不同的策略来融合掌纹和掌静脉信息,以实现更好的识别性能。例如,Zhang等[33]提出一种融合掌纹和掌静脉信息的在线个人身份认证系统,并通过实验证明了掌纹和掌静脉信息之间的互补性。Luo等[34]提出了一种双向竞争编码,用于提取掌纹和掌静脉特征,该方法能在较高匹配速度的情况下获得较高的识别率。随着深度学习技术的不断发展,越来越多的研究者开始探索深度学习在掌纹与掌静脉融合识别领域的应用。例如,许学斌等[35]提出了一种结合注意力机制的残差网络,对融合后的掌纹与掌静脉图像进行分类。李俊林等[36]采用小波分解法提取掌纹与掌静脉的特征,并根据固定权值、图像质量以及图像相似性系数等3种不同的权值进行特征融合。Wu等[37]采用深度哈希网络提取二进制模板,用于掌纹和掌静脉的身份信息验证,并通过空间变压器网络解决了旋转和位置错误的问题。

2. 图像采集

如表1和表2所示,众多研究者在验证他们的算法时,主要依赖自行采集的单一模态和规模较小的数据库。现有公开的手部多模态图像数据库相对较为有限,多数仅包含多光谱采集的手掌图像,未充分考虑手背静脉、掌纹和掌静脉等情况。为此,本文提出建立一个手部多模态数据库(CUMT hand multimodal database, CUMT-HMD)。该数据库包含了8 700张图像,涵盖了来自290名志愿者的数据。与已公开的数据库相比,本数据库不仅包含更多的志愿者数据,而且同时涵盖手部的3种模态数据,这有望提高生物特征识别模型的泛化能力,进一步提升识别性能。

2.1 采集原理

手背、手掌和手指等位置的静脉血管信息可以在近红外波长光照下成像,血管的分布具有个体独特性,并且不受年龄变化的影响,因此具高度可区分性和长期分布稳定性的特征,这使静脉血管信息可被用于身份认证。

人体骨骼和肌肉组织具有对光照的吸收和通透特性,在波长范围为720~1 000 nm的近红外光中,部分光线能够透过人体的手部皮下组织,且光的波长越长,它在皮下组织中的穿透深度越大。血管中的血红蛋白在一定程度上吸收可见光波段的近红外光,但较低波段的近红外光在穿透手部皮肤方面效果较差,难以有效透过;然而,当光源波长大于1 000 nm时,手部血红蛋白的吸收能力相对较低。根据静脉图像评价模型FDR[46]的研究结果,使用850 nm红外光拍摄的静脉图像展现出最高的对比度,对比度计算公式为

$$ {R_{{\text{FDR}}(vt)}} = \frac{{{{({\mu _t} + {\mu _v})}^2}}}{{\sigma _t^2 + \sigma _v^2}} $$ 式中:v表示静脉信息,t表示周围组织信息,

$ {R_{{\text{FDR}}(vt)}} $ 表示手背静脉像素点集合与其周围其他生物组织成像像素点集合之间的FDR值,$ {\mu _v} $ 和$ {\mu _t} $ 分别表示静脉血管和静脉血管周围组织像素的灰度平均值,$ \sigma _v^2 $ 表示静脉信息灰度值分布总体方差信息,$ \sigma _t^2 $ 表示周围组织灰度方差信息。根据FDR模型,用于判断手背静脉图像质量的标准是:$ {R_{{\text{FDR}}(vt)}} $ 值越大,表示图像对比度越高;反之,$ {R_{{\text{FDR}}(vt)}} $ 值越小,表示图像对比度越低。在自建数据库中,静脉图像的采集采用了波长为850 nm的红外光源进行照射。尽管常规的红外摄像机通常具备发射红外光的功能,但由于实际拍摄过程中可能存在光线反射等因素,其拍摄效果可能不够理想。因此,为了确保静脉图像的质量,本研究特别增加了额外的红外光源进行补光,以获得更好的静脉图像。

人体的掌纹属于体表特征,可以在可见光环境下进行采集。为了采集掌纹图像,本文使用一款支持手动焦距调整的200万像素高帧率摄像机,能够确保所获得的图像具备清晰和细致的特性,从而更好地用于生物特征识别研究。

2.2 采集设备

基于上述采集原理,本文设计了手部多模态数据采集装置,如图1所示。图1(a)给出了装置的模型设计图,而图1(b)则给出了装置的实物图。装置内部从上而下依次包括:摄像头固定架、红外摄像头、手部放置平台、红外摄像头、可见光摄像头、补充光源、底座、光强调节器等组件。红外摄像装置采用了带宽为840~860 nm的滤波片,而手掌下方则放置了均匀发散的红外光光源,可见光镜头采用了带宽为400~700 nm的滤波片,可见光光源放置在可见光镜头的同一侧,光强调节器可以调整红外光和可见光的发光强度,以便采集到更清晰的图像。图1(c)则是数据采集显示界面,在数据采集工程中,本文通过USB端口将摄像头与控制主机相连接。采集对象将手放置在手部放置平台上,并打开各光源,通过上位机界面观察采集到的图片质量,可通过光强调节旋钮进行调整,以获取高质量的手部多模态数据图像。

2.3 图像预处理

2.3.1 原始图像

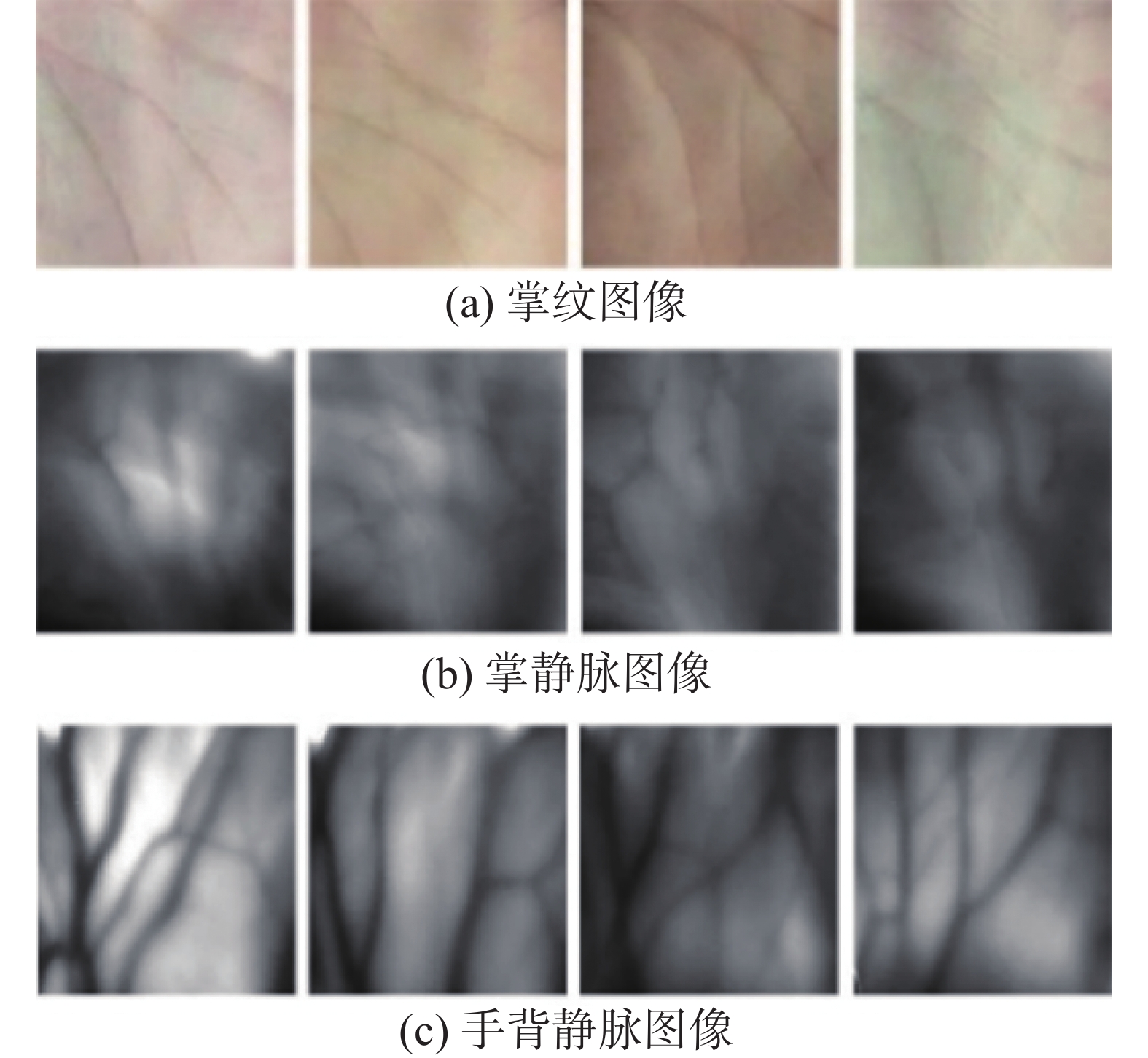

本数据库采集了290名志愿者的右手掌纹、手掌静脉和手背静脉图像,其中男女比例约为3∶1,每位志愿者各提供了10张掌纹图像、10张掌静脉图像和10张手背静脉图像,总计包含8 700张图像。本数据库的所有样本均在2个特定的时间段内采集,且间隔时间超过10天。每个类别在每次采集中各包含5个样本。静脉图像采集时的红外波长被设置为850 nm。本数据库的部分原始图像如图2所示。

2.3.2 图像感兴趣区域提取

在手部多模态图像采集的过程中,由于手部的位置摆放等原因可能引入一些非线性影响因素,如旋转、平移和扭曲等。为了降低非线性因素的影响,减少不必要的噪声干扰,本文对采集得到的多模态图像进行了预处理,提取图像的中心有效区域,即感兴趣区域(region of interest, ROI)。这一预处理步骤有助于降低后续工作的复杂性。

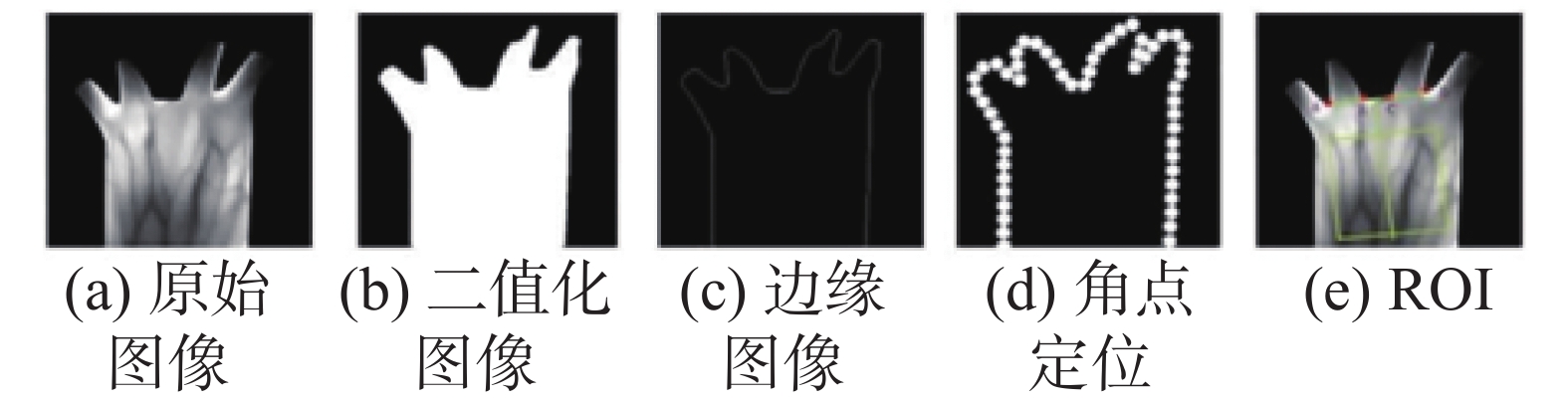

感兴趣区域提取过程如下:首先,采用非线性中值滤波对图像进行预处理,去除图像中的噪音信息;其次,本文综合选择对所有样本分割效果最佳的阈值作为全局阈值,利用固定阈值方法将原始图像转换为二值图像,然后使用Sobel算子[47]来提取边缘信息,以便进行后续的定位操作;再次,将当前轮廓的手指边缘和手掌边缘均视为直线,并基于此假设查找外切圆的位置,然后结合外接圆和边缘交点的数量,来确定角度点的位置;最后,通过角度点的中垂线,计算中垂线的斜率比,然后利用其对原始图像进行旋转校正,进而得到感兴趣区域图像。以手背静脉图像为例,提取过程如图3所示,其中图3(a) 为原始手背静脉图像,图3(b) 为二值化图像,图3(c) 为边缘图像,图3(d) 为角点定位图像,图3(e) 为ROI区域图像。利用上述方法,本文分别对自建的手部多模态数据库中掌纹、掌静脉和手背静脉图像进行感兴趣区域提取。部分手部多模态样本的ROI图像如图4所示。

3. 基于模态信息度评估策略的动态融合算法

目前,现有的多模态生物特征融合研究通常假设各模态的质量和任务的相关性是稳定的。但以掌纹掌静脉识别技术为例,实际应用中不可避免地面临着图像曝光、模糊、失真和噪声等问题。因此,同一模态不同类别样本和不同模态同类别样本的信息量可能会随着质量的变化而发生变化,进而影响多模态生物特征识别模型的性能。

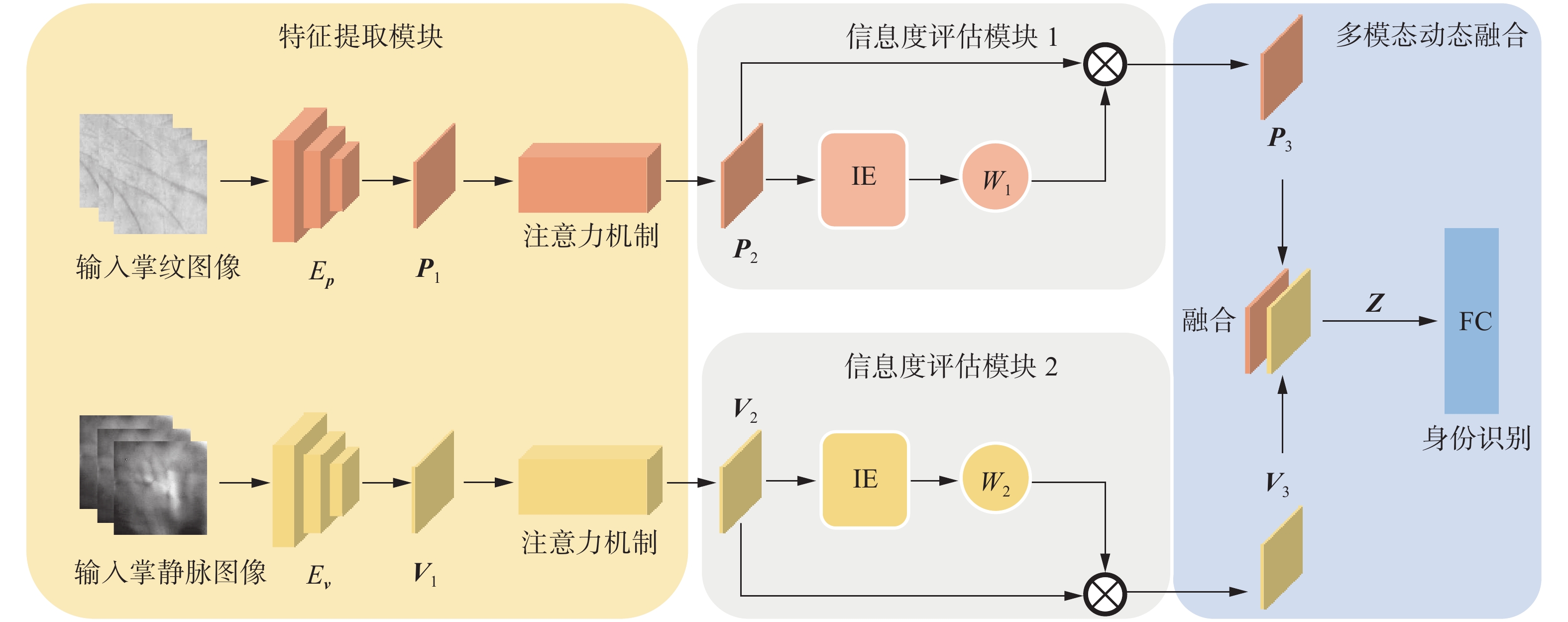

为解决上述问题,本文提出了基于模态信息度评估策略的掌纹掌静脉特征识别方法。该方法通过计算模态特征在身份识别任务中提供的有用信息量,从而度量每个模态信息在多模态融合过程中的重要性,进而实现不同模态特征信息的自适应融合。本文所提方法的总体框架如图5所示,主要包括3个模块:特征提取模块、信息度评估模块和特征融合模块。各模块详细内容如下所述。

3.1 掌纹掌静脉特征提取

针对传统特征提取方法中存在人的主观因素影响和泛用性较差的问题,本文针对掌纹和掌静脉2个模态,采取以下步骤以获得高判别性的深度卷积特征。

首先,利用预训练在ImageNet数据库上的不含全连接层的VGG16网络作为特征提取器,分别获得2个模态的深度卷积特征

${{{\boldsymbol{P}}}_{\text{1}}}$ 和${{{\boldsymbol{V}}}_{\text{1}}}$ :$$ {{{\boldsymbol{P}}}_{\text{1}}}{ { = }}{E_{\text{1}}}({{\boldsymbol{I}}_{\boldsymbol{p}}};{{{\boldsymbol{\theta}} }_{_1}}) $$ $$ {{{\boldsymbol{V}}}_{\text{1}}}{\text{ = }}{E_{\text{2}}}({{\boldsymbol{I}}_{\boldsymbol{v}}};{{{\boldsymbol{\theta}} }_{_2}}) $$ 式中:

${E_{\text{1}}}$ 和${E_{\text{2}}}$ 分别为掌纹和掌静脉2个模态的特征提取器,$ {{\boldsymbol{I}}_{\boldsymbol{p}}} $ 是输入的掌纹图像,$ {{\boldsymbol{I}}_{\boldsymbol{v}}} $ 是输入的掌静脉图像,${{{\boldsymbol{\theta}} }_1}$ 和${{{\boldsymbol{\theta}} }_2}$ 分别是2个特征提取器的权重参数,2个模态的特征提取器参数不共享,因此每个模态特征不受其他模态的影响。该步骤有助于提取具有高度判别性的深度特征,为后续的掌纹掌静脉特征融合和识别任务奠定了基础。其次,由于预先训练VGG16网络提取的卷积特征图中可能包含噪声和干扰信息,直接将卷积特征图作为特征表示用于身份识别,并不能获得良好的性能。为此,本文引入了CBAM (convolutional block attention module)来进行特征增强。CBAM的具体过程如下:1)对输入的特征分别使用最大池化和平均池化操作聚合空间信息,得到2个

$ C $ 维的特征图,然后经过包含1个共享参数的多层感知机输出2个$ 1 \times 1 \times C $ 的通道注意力图,再将2个注意力图相加激活,得到最终的通道注意力图:$$ M_{\mathrm{c}}(\boldsymbol{F})=\partial(\text{MLP}(\text{Avgpool}(\boldsymbol{F}))+\text{MLP}(\text{Maxpool}(\boldsymbol{F}))) $$ 式中:

$ \partial (\cdot) $ 表示Sigmoid激活函数,$ {{\boldsymbol{F}}} $ 表示输入的特征图。2)在通道维度对输入的特征图进行最大池化和平均池化操作,再将2张生成的特征图进行维度拼接,最后利用大小为$ 7 \times 7 $ 的卷积核生成空间注意力图:$$ M_{\text{s}}(\boldsymbol{F})=\partial(f^{7\times7}([\text{Avgpool}(\boldsymbol{F}\text{)};\text{Maxpool}(\boldsymbol{F})])) $$ 式中:

$ {f^{7 \times 7}} $ 表示一个滤波器大小为$ 7 \times 7 $ 的卷积运算。最后,将空间注意力图和通道注意力图与原始卷积特征进行相乘,得到增强之后的特征图:

$$ {{{\boldsymbol{F}}}_{\text{o}}} = {{\boldsymbol{F}}} \otimes {M_{\text{c}}}{\text{(}}{{\boldsymbol{F}}}{\text{)}} \otimes {M_{\text{s}}}{\text{(}}{{\boldsymbol{F}}}{\text{)}} $$ 式中

$ \otimes $ 表示元素乘法。本文将掌纹图像的卷积特征图

${{{\boldsymbol{P}}}_{\text{1}}}$ 掌静脉图像的卷积特征图${{{\boldsymbol{V}}}_{\text{1}}}$ 分别输入到CBAM中进行特征增强,得到增强的掌纹的卷积特征图${{{\boldsymbol{P}}}_{\text{2}}}$ 和掌静脉的卷积特征图${{{\boldsymbol{V}}}_2}$ 。3.2 模态信息度评估

在实际应用中,鉴于不同样本和不同模态的质量是动态变化的,本文采用真实类别对应的概率来量化不同模态的类别置信度,并将其定义为模态的信息度。当某一模态的类别置信度较低时,对应的模态信息度也较低,则表示该模态能够为身份信息识别提供的有用信息量较少。反之,当模态的类别置信度较高时,其信息度也较高。

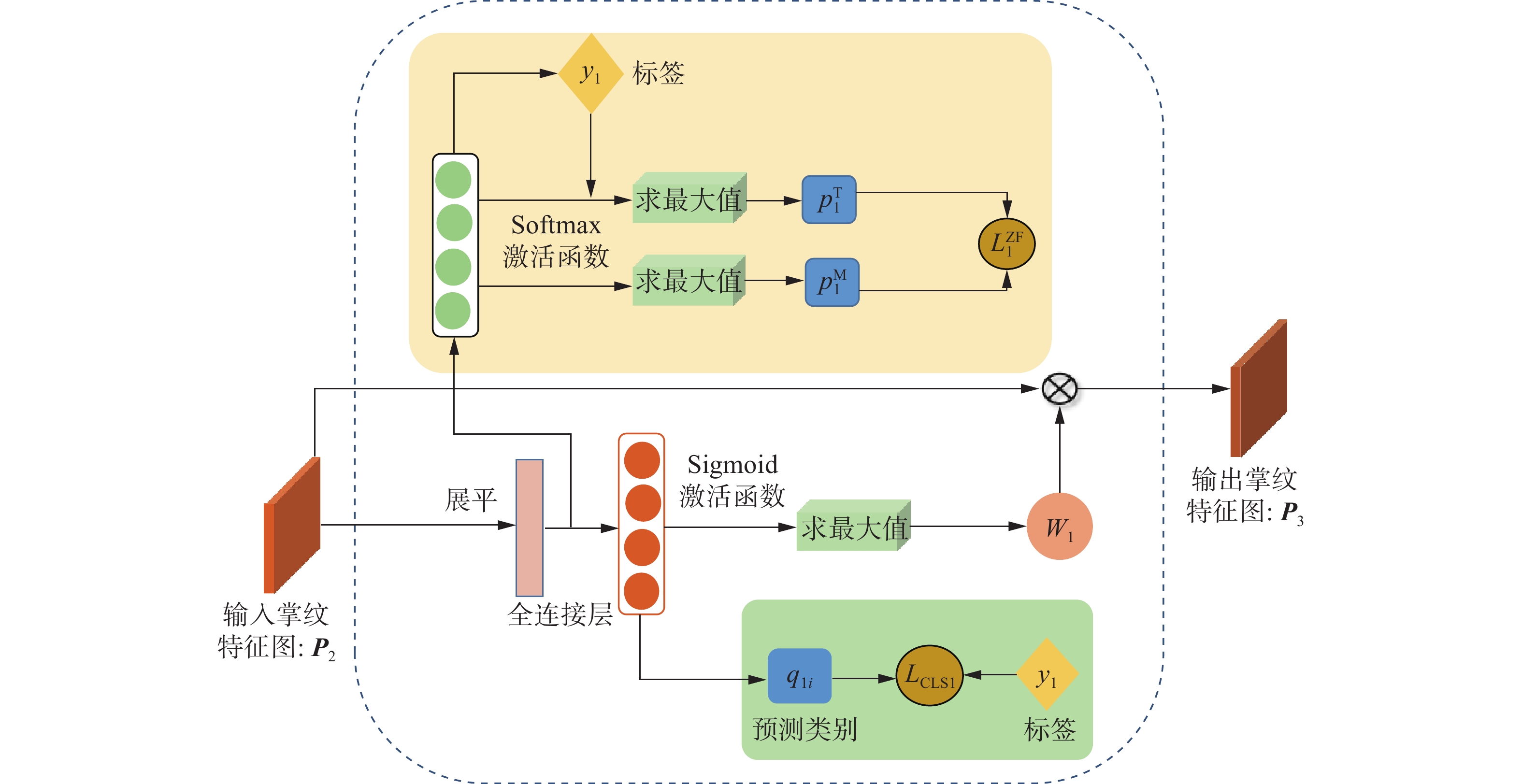

本文设计的信息度评估模块包含掌纹模态的信息度评估模块1和掌静脉模态的信息度评估模块2,图6给出了掌纹模态信息度评估模块的结构框图,掌静脉信息度评估模块的结构与之类似。具体过程如下:

首先,将得到的掌纹图像的卷积特征图

${{{\boldsymbol{P}}}_{\text{2}}}$ 和掌静脉图像的卷积特征图${{{\boldsymbol{V}}}_2}$ 分别输入到信息度评估模块1和信息度评估模块2中,分别输出掌纹图像的卷积特征图${{{\boldsymbol{P}}}_{\text{2}}}$ 的最大类预测概率${W_{\text{1}}}$ 和掌静脉图像的卷积特征图${{{\boldsymbol{V}}}_2}$ 的最大类预测概率${W_{\text{2}}}$ :$$ {W_{\text{1}}} = \max {(\partial ({\text{ML}}{{\text{P}}_{\text{1}}}({{{\boldsymbol{P}}}_{2i}})))_{}} $$ $$ {W_{\text{2}}} = \max {(\partial ({\text{ML}}{{\text{P}}_{\text{2}}}({{{\boldsymbol{V}}}_{2i}})))_{}} $$ 式中:

$ {W_{\text{1}}} \in (0,1) $ ,$ {W_{\text{2}}} \in (0,1) $ ,$ \partial ( \cdot ) $ 是Sigmoid激活函数。其次,利用交叉熵损失函数训练网络模型,将输出模态特征的最大类预测概率作为类别置信度,损失函数的计算公式为

$$ {L_{{{\mathrm{CLS}}} 1}} = - \sum\limits_{i = 1}^k {{{{{y}}}_{1i}}} \cdot \log ({{{q}}}{'_{1i}}) $$ $$ {L_{{\mathrm{CLS}}2}} = - \sum\limits_{i = 1}^k {{{{{y}}}_{2i}}} \cdot \log ({{{q}}}{'_{2i}}) $$ $$ {L_1} = {L_{{{\mathrm{CLS}}1}}} + {L_{{{\mathrm{CLS}}2}}} $$ 式中:

$ {{{q}}}{'_{1i}} $ 代表掌纹图像的卷积特征图${{{\boldsymbol{P}}}_{\text{2}}}$ 的预测类别分布,$ {{{q}}}{'_{2i}} $ 代表掌静脉图像的卷积特征图${{{\boldsymbol{V}}}_2}$ 的预测类别分布,$ {{{{y}}}_{1i}} $ 代表掌纹图像的卷积特征图${{{\boldsymbol{P}}}_{\text{2}}}$ 真实类别分布,$ {{{{y}}}_{2i}} $ 代表掌静脉图像的卷积特征图${{{\boldsymbol{V}}}_2}$ 的真实类别分布,$k$ 代表类别数,$i$ 代表类别。通过上述步骤,可以量化不同模态的类别置信度,帮助模型更好地理解和评估特征的信息度,从而更可靠地进行多模态融合。但是,利用模态信息度评估模型来预测样本的类别分布时,对于预测正确的样本,最大类预测概率

${W_{\text{1}}}$ 和${W_{\text{2}}}$ 等同于真实类别对应的概率,这可以有效地反映模态类别置信度。然而,在错误预测的情况下,最大类预测概率则反映了模型过度自信,导致错误的预测。因此,真实类别对应的概率相对于最大类别预测概率更可靠地反映了模态类别的置信度。采用真实类别对应的概率可以获得更可靠的模态类别置信度,用以衡量不同类别和不同模态生物特征的重要性。尽管真实类别对应的概率具有可靠性,但由于测试阶段无法直接获取标签信息,因此无法直接使用此概率。为解决上述问题,本文设计了置信度一致性损失函数。其主要思路是使得信息度评估模块输出的类别最大概率和真实类别对应概率保持一致。损失函数计算公式为

$$ {L_M^{{{\mathrm{ZF}}} }} = \sum\limits_{m = 1}^2 {{{{y}}_{2i}}} {({{{Z}}^m} - {{{F}}^m})^2} $$ $$ {{{Z}}^m} = \sum\limits_{m = 1}^2 {\sum\limits_{k = 1}^K {{{{y}}_m}} } \cdot {{p}_{m}^{\mathrm{T}}} $$ $$ {{{F}}^m} = \sum\limits_{m = 1}^2 {\sum\limits_{k = 1}^K {{{{y}}_m}} } \cdot {{p}_m^{\rm{M}}} $$ $$ {{p}_ m^{{{\mathrm{M}}}}} = \max (\varphi ({{{\mathrm{MLP}}} _m}({{{\boldsymbol{V}}}_{2i}}))) $$ 式中:

$ \varphi (\cdot) $ 是Softmax激活函数,$k$ 是类别数,$m$ 代表模态数。${{p}_m^{{\mathrm{T}}}}$ 表示为第$m$ 个模态的真实类别对应的概率,$ {y_m} $ 表示为第$ m $ 个模态的标签信息,${{p}_m^{{{\mathrm{M}}} }}$ 表示为第$m$ 个模态的最大类别对应的预测概率。通过最小化$ {L_M^{{{\mathrm{ZF}}} }} $ ,使信息度评估网络能够更准确地估计不同模态样本的信息度,从而提高多模态融合的可靠性。3.3 掌纹掌静脉特征融合

在获得掌纹和掌静脉2个模态特征的信息度

${W_{\text{1}}}$ 和${W_{\text{2}}}$ ,将${W_{\text{1}}}$ 作为样本权重与掌纹图像的卷积特征图${{{\boldsymbol{P}}}_{\text{2}}}$ 相乘得到${{{\boldsymbol{P}}}_{\text{3}}}$ ,将${W_{\text{2}}}$ 作为样本权重与掌静脉图像的卷积特征图${{{\boldsymbol{V}}}_2}$ 相乘得到${{{\boldsymbol{V}}}_3}$ ,其过程的表达式为$$ {{{\boldsymbol{P}}}_3} = {W_1} \cdot {{{\boldsymbol{P}}}_2} $$ $$ {{{\boldsymbol{V}}}_3} = {W_2} \cdot {{{\boldsymbol{V}}}_2} $$ 通过动态自适应融合方式,模型可以更好地应对不同模态和样本质量的变化,从而获得更稳定的融合特征表示。随后,将掌纹图像的卷积特征图

${{{\boldsymbol{P}}}_{\text{3}}}$ 和掌静脉图像的卷积特征图进行${{{\boldsymbol{V}}}_3}$ 级联,获得最终的卷积特征图$ {\boldsymbol{Z}} $ ,公式表示为$$ {{\boldsymbol{Z}}} = {{\mathrm{Concate}}} [{{\boldsymbol{P}}_3},{{\boldsymbol{V}}_3}] $$ 式中

$ {\text{Concate}}( \cdot ) $ 表示特征级联操作。最后,将卷积特征图$ {\boldsymbol{Z}} $ 输入到全连接层,用于身份识别。网络损失函数采用交叉熵损失,计算公式为$$ {L_{{{\mathrm{CLS}}} }} = - \sum\limits_{{{i}} = 1}^k {{{{{y}}}_i}} \cdot \log ({{{q}}}{'_i}) $$ 式中:

${{{q}}}$ 是卷积特征图$ {\boldsymbol{Z}} $ 输入到全连接层后输出的分类结果,${{{y}}}$ 是多模态卷积特征图$ {\boldsymbol{Z}} $ 的标签。网络框架的总体损失函数

$ L $ 计算公式为$$ L = {\lambda _1} \cdot {L_1} + {\lambda _2} \cdot {L_m^{{{\mathrm{ZF}}} }} + {\lambda _3} \cdot {L_{{{\mathrm{CLS}}} }} $$ 式中

$ {\lambda _1} $ 、${\lambda _2}$ 、${\lambda _3}$ 是平衡各损失函数的超参数。4. 实验与分析

4.1 数据库

1)中科院自动化研究所的多光谱数据库(CASIA-Multi-Spectral-PalmprintV1 dataset, CASIA)是由中国科学院自动化研究院采集而成,共包括100位志愿者的200个手掌样本,使用电荷藕合器件相机在2个时期采集而成,2个时期相隔超过1个月。在每个采集时期中,分别使用460、630、700、850、940 nm以及白光6个不同的波段进行采集,每个波段下每个手掌采集3张图像,总共采集到7 200张掌静脉图像。在本实验中,本文选择了460 nm和850 nm波长下采集的掌纹图像和掌静脉图像作为数据库。感兴趣区域图像是利用参考文献[48]中的感兴趣区域提取算法进行处理的,该算法包括轮廓追踪、凸包点检测、谷点定位等。部分样本的感兴趣区域图像如图7(a)所示。

2)同济大学的非接触式掌纹掌静脉数据库(Tongji contactless palmprint&palmvein dataset, Tongji)包括了600位志愿者的600个手掌样本。样本分2个时期进行采集,每一时期每个类别采集10张图像。感兴趣区域图像是利用参考文献[42]中的感兴趣区域提取算法进行处理的。部分样本的感兴趣区域图像如图7(b)所示。

3)中国矿业大学的掌纹掌静脉数据库(CUMT hand multimodal database, CUMT-HMD),共采集290个志愿者的右手掌纹、掌静脉和手背静脉3个模态信息。每个志愿者每种模态信息采集10张图像,分为2个阶段采集完成,2个时间段之间间隔了超过10天。每个阶段分别采集290个志愿者的5张掌纹、掌静脉和手背静脉图像。本文采用自建的手部多模态数据库中的掌纹和掌静脉2种模态数据来评估所提出方法的有效性。感兴趣区域提取方法是利用参考文献[24]中的算法。部分样本的感兴趣区域图像如图7(c)所示。

4.2 实验设置

本文实验采用PyTorch深度学习框架,并利用NVIDIA GeForce GTX 1050 Ti GPU显卡进行加速计算,网络模型的初始学习率设置为0.001,权重衰减设置为0.005,优化器为SGD,批次大小设置为4,输入图像的尺寸归一化为224像素×224像素,

$ {\lambda _1} $ 、${\lambda _2}$ 、${\lambda _3}$ 为平衡各个损失函数的超参数,分别设置为0.5、0.5、1。实验中将3个掌纹掌静脉数据库均按照1∶1的比例划分训练集和测试集,实验数据分布如表3所示。在本文开展的实验中,采用正确识别率(correct recognition rate, CRR)和等错误率(equal error rate, EER)作为主要评价指标,来评估模型的效果。表 3 实验数据分布Table 3 Distribution of experimental data数据库名称 类别 训练集数量/张 测试集数量/张 CASIA 200 1 200 1 200 CUMT-HMD 290 2 900 2 900 Tongji 600 12 000 12 000 4.3 CUMT-HMD数据库的验证与评估

4.3.1 单模态实验验证

为了验证所构建手部多模态数据库的有效性,本文采用多个经典的深度学习模型进行单模态实验验证,其中包括:VGG16、ResNet18和MobileNet。身份识别结果如表4所示。

表 4 单模态数据库识别结果(CRR)Table 4 Identification result (CRR) of single modality dataset% 方法 掌纹 掌静脉 手背静脉 VGG16 98.55 99.11 99.31 ResNet18 99.40 99.45 99.86 MobileNet 97.80 98.97 99.10 由表4可知,在3个单模态数据库上,各模型识别率均在98%以上。其中基于ResNet18的身份识别模型在3个单模态数据库上取得最高识别结果,分别为99.40%、99.45%和99.86%;基于MobileNet的身份识别模型取得了最低的识别结果,分别为97.80%、98.97%和99.10%。

4.3.2 双模态实验验证

为了验证双模态特征对生物特征识别方法的增强效果,本文选取了近几年以VGG16作为基础网络的6种双模态融合生物特征识别算法来进行实验验证,不同融合方法的描述如表5所示。

表 5 不同融合方法的描述Table 5 Description of different modal fusion methods本文对6种不同的双模态特征融合方法进行了测试,实验结果如表6所示,识别率均可达99%以上。此外,在融合3个模态数据的情况下,3个多模态生物特征识别模型的识别精度达到了100%。

4.4 基于模态信息度评估策略算法的验证与评估

4.4.1 模态信息度评估模块的效果评估

为了全面有效的验证所提出信息度评估(information evaluation, IE)模块的效果,本文在2个公开的数据库以及自建数据库上进行了识别实验。具体实验过程阐述如下:首先,在本文设计的框架中,通过添加或去除IE模块,来验证该模块的有效性;其次,本文选用了特征级联(concat)和特征相加(add) 2种经典的融合方法作为基本融合模块,通过添加或去除IE模块,来评估其对掌纹掌静脉特征识别模型的效果。

在3个数据库上的实验结果如表7所示。由表7可知,在3个数据库上,添加了IE模块的掌纹掌静脉特征识别模型的正确识别率均优于未使用IE模块的掌纹掌静脉特征识别模型的正确识别率。上述结果表明,本文提出的IE模块可以有效地提升掌纹掌静脉特征识别模型的性能。

表 7 在3个数据库上模态信息度评估模块的评估结果(CRR)Table 7 Evaluation results (CRR) of the modal information evaluation module on three databases% 方法 CASIA CUMT-HMD Tongji Concat 78.83 99.45 99.78 Concat + IE 84.00 99.93 99.90 Add 92.70 99.45 99.60 Add + IE 96.80 100.00 99.98 Attention 94.50 100.00 99.92 Attention + IE 99.00 100.00 99.97 4.4.2 与主流的多模态生物特征识别方法对比

为了验证所提方法的有效性,本文选取了近几年比较主流的基于卷积神经网络的多模态生物特征识别算法作为对比模型。不同多模态生物特征识别模型在2个公开的数据库和自建的数据库上的身份识别结果如表8所示。

表 8 在3个数据库上不同方法的对比实验结果(CRR)Table 8 Experimental results (CRR) of different methods on three databases% 从表8中可以看出,本文所提出的方法在3个数据库上均取得了最高的身份识别率,分别达到了99.00%、100.00%、99.97%。这表明该算法能够有效地融合多模态生物特征信息,提升模型的身份识别精度。

此外,为了更全面地评估所提出方法的效果,本文还进行了身份匹配实验。不同对比算法的等错误率(EER)和ROC (receiver operating characteristic)曲线如表9和图8~10所示。

表 9 在3个数据库上不同方法的对比实验结果(EER)Table 9 Experimental results (EER) of different methods on three databases% 由表9和图8~10可以看出,与其他方法相比,本文提出的识别模型在3个数据库中都取得了较低的EER值,分别为1.34%、0.09%和0.26%。相比在其他2个样本质量相对较高的数据库上,在样本质量相对较低的CASIA数据库上,本文所提出方法的效果更为明显。

上述结果表明,本文提出的模型对模态特征的质量动态变化具有较强的鲁棒性。其主要原因在于所提出的方法通过真实类概率来评估不同模态上的信息量,通过动态融合机制减少了无关信息的影响,进而取得了最优的实验结果。

5. 结束语

本文构建了一个手部多模态数据库。在自建多模态数据库上,单一模态的最高识别精度达到了99.86%,通过融合双模态数据,识别精度进一步提高,在融合3个模态数据的情况下,3个多模态生物特征识别模型的识别精度达到了100%。此外,本文还针对掌纹掌静脉特征识别方法中模态信息融合不充分的问题,提出了基于模态信息度的掌纹掌静脉特征识别模型。该模型实现了对不同模态信息的自适应融合,增强了模型对于模态特征质量动态变化的鲁棒性。在3个数据库上进行了充分的对比实验,证明了本文所提方法的有效性。未来,将继续探索不同模态之间的关联特性和互补特性对多模态生物特征识别方法的影响。在三模态生物特征识别方法的研究中,也将提升多模态生物特征识别的性能和鲁棒性。这些工作将有助于推动多模态生物特征识别的进一步发展和应用。

-

表 1 公开掌纹数据库

Table 1 Public palmprint dataset

表 2 公开静脉数据库

Table 2 Public vein dataset

表 3 实验数据分布

Table 3 Distribution of experimental data

数据库名称 类别 训练集数量/张 测试集数量/张 CASIA 200 1 200 1 200 CUMT-HMD 290 2 900 2 900 Tongji 600 12 000 12 000 表 4 单模态数据库识别结果(CRR)

Table 4 Identification result (CRR) of single modality dataset

% 方法 掌纹 掌静脉 手背静脉 VGG16 98.55 99.11 99.31 ResNet18 99.40 99.45 99.86 MobileNet 97.80 98.97 99.10 表 5 不同融合方法的描述

Table 5 Description of different modal fusion methods

表 6 双模态数据库验证结果

Table 6 Multimodal dataset validation results

% 表 7 在3个数据库上模态信息度评估模块的评估结果(CRR)

Table 7 Evaluation results (CRR) of the modal information evaluation module on three databases

% 方法 CASIA CUMT-HMD Tongji Concat 78.83 99.45 99.78 Concat + IE 84.00 99.93 99.90 Add 92.70 99.45 99.60 Add + IE 96.80 100.00 99.98 Attention 94.50 100.00 99.92 Attention + IE 99.00 100.00 99.97 表 8 在3个数据库上不同方法的对比实验结果(CRR)

Table 8 Experimental results (CRR) of different methods on three databases

% 表 9 在3个数据库上不同方法的对比实验结果(EER)

Table 9 Experimental results (EER) of different methods on three databases

% -

[1] HUANG Zhe, GUO Chengan. Toward cross-dataset finger vein recognition with single-source data[J]. IEEE transactions on instrumentation and measurement, 2024, 73: 2506012. [2] PAN Zaiyu, WANG Jun, WANG Guoqing, et al. Multi-scale deep representation aggregation for vein recognition[J]. IEEE transactions on information forensics and security, 2020, 16: 1−15. [3] 马晓, 张番栋, 封举富. 基于深度学习特征的稀疏表示的人脸识别方法[J]. 智能系统学报, 2016, 11(3): 279−286. doi: 10.11992/tis.201603026 MA Xiao, ZHANG Fandong, FENG Jufu. Sparse representation via deep learning features based face recognition method[J]. CAAI transactions on intelligent systems, 2016, 11(3): 279−286. doi: 10.11992/tis.201603026 [4] GUO Xinxin, PENG Jianfeng. Optimization design and implementation of web fingerprint identification[C]//2023 IEEE 12th International Conference on Communication Systems and Network Technologies. Bhopal: IEEE, 2023: 569−573. [5] 颜廷秦, 周昌雄. 二维EMD分解提高PCA掌纹识别率[J]. 智能系统学报, 2013, 8(4): 377−380. doi: 10.3969/j.issn.1673-4785.201211002 YAN Tingqin, ZHOU Changxiong. The research of improving PCA recognition rate of palmprints with BEMD[J]. CAAI transactions on intelligent systems, 2013, 8(4): 377−380. doi: 10.3969/j.issn.1673-4785.201211002 [6] CHEN Liukui, WANG Xiaoxing, JIANG Haiyang, et al. Design of palm vein platform and pattern enhancement model based on Raspberry Pi[C]//2021 IEEE International Conference on Emergency Science and Information Technology. Chongqing: IEEE, 2021: 495−498. [7] PAN Zaiyu, WANG Jun, SHEN Zhengwen, et al. Disentangled representation and enhancement network for vein recognition[J]. IEEE transactions on circuits and systems for video technology, 2023, 33(8): 4164−4176. doi: 10.1109/TCSVT.2023.3241054 [8] JANI R, AGRAWAL N. A proposed framework for enhancing security in fingerprint and finger-vein multimodal biometric recognition[C]//2013 International Conference on Machine Intelligence and Research Advancement. Katra: IEEE, 2013: 440−444. [9] 周晨怡, 黄靖, 杨丰, 等. 利用特征距离信息引导决策融合的多模态生物特征识别方法[J]. 科学技术与工程, 2020, 20(10): 4036−4042. doi: 10.3969/j.issn.1671-1815.2020.10.036 ZHOU Chenyi, HUANG Jing, YANG Feng, et al. Multimodal biometric recognition on decision-level fusion guided by feature distance information[J]. Science technology and engineering, 2020, 20(10): 4036−4042. doi: 10.3969/j.issn.1671-1815.2020.10.036 [10] KABIR W, AHMAD M O, SWAMY M N S. A two-stage scheme for fusion of hash-encoded features in a multimodal biometric system[C]//2018 16th IEEE International New Circuits and Systems Conference. Montreal: IEEE, 2018: 340−343. [11] KANG Wenxiong, LU Yuting, LI Dejian, et al. From noise to feature: exploiting intensity distribution as a novel soft biometric trait for finger vein recognition[J]. IEEE transactions on information forensics and security, 2019, 14(4): 858−869. doi: 10.1109/TIFS.2018.2866330 [12] ZHAO Pengyang, ZHAO Shuping, XUE Jinghao, et al. The neglected background cues can facilitate finger vein recognition[J]. Pattern recognition, 2023, 136: 109199. doi: 10.1016/j.patcog.2022.109199 [13] 王志强. 基于图像质量评价的掌纹识别算法研究[D]. 北京: 北京交通大学, 2016: 2−67. WANG Zhiqiang. Research on palmprint recognition algorithm based on image quality evaluation[D]. Beijing: Beijing Jiaotong University, 2016: 2−67. [14] 李苋兰, 张顶, 黄晞. 基于BP-AdaBoost神经网络的多参数掌静脉图像质量评价法[J]. 计算机系统应用, 2020, 29(3): 20−28. LI Xianlan, ZHANG Ding, HUANG Xi. Multi-parameter palm vein image quality evaluation method based on BP-AdaBoost neural network[J]. Computer systems & applications, 2020, 29(3): 20−28. [15] LI Shuyi, ZHANG B. Joint discriminative sparse coding for robust hand-based multimodal recognition[J]. IEEE transactions on information forensics and security, 2021, 16: 3186−3198. doi: 10.1109/TIFS.2021.3074315 [16] SINGH M, SINGH R, ROSS A. A comprehensive overview of biometric fusion[J]. Information fusion, 2019, 52: 187−205. doi: 10.1016/j.inffus.2018.12.003 [17] 钟德星, 朱劲松, 杜学峰. 掌纹识别研究进展综述[J]. 模式识别与人工智能, 2019, 32(5): 436−445. ZHONG Dexing, ZHU Jinsong, DU Xuefeng. Progress of palmprint recognition: a review[J]. Pattern recognition and artificial intelligence, 2019, 32(5): 436−445. [18] MATSUMOTO K. Palm-recognition systems: an ideal means of restricting access to high-security areas[J]. Mitsubishi electric advance, 1985, 31: 31−32. [19] WANG Xiyu, LI Hengjian, YU Changzhi, et al. An improved palmprint image recognition algorithm via image restoration[C]//2018 2nd IEEE Advanced Information Management, Communicates, Electronic and Automation Control Conference. Xi’an: IEEE, 2018: 2687−2691. [20] YANG Dongliang, SONG C, GAO F, et al. A 3D palm- print recognition method based on local sparse representation and weighted shape index feature[C]//2019 Chinese Automation Congress. Hangzhou: IEEE, 2019: 4537−4540. [21] PĂVĂLOI I, IGNAT A, LAZĂR L C, et al. Palmprint recognition with fixed number of SURF keypoints[C]//2021 International Conference on e-Health and Bioengineering. Iasi: IEEE, 2021: 1−4. [22] LIU Dian, SUN Dongmei. Contactless palmprint recognition based on convolutional neural network[C]//2016 IEEE 13th International Conference on Signal Processing. Chengdu: IEEE, 2016: 1363−1367. [23] ZHONG Dexing, YANG Yuan, DU Xuefeng. Palmprint recognition using Siamese network[C]//Biometric Recognition. Cham: Springer, 2018: 48−55. [24] WANG Gengxing, KANG Wenxiong, WU Qiuxia, et al. Generative adversarial network (GAN) based data augmentation for palmprint recognition[C]//2018 Digital Image Computing: Techniques and Applications. Canberra: IEEE, 2018: 1−7. [25] SHAO Huikai, ZHONG Dexing, DU Xuefeng. Deep distillation hashing for unconstrained palmprint recognition[J]. IEEE transactions on instrumentation and measurement, 2021, 70: 2505613. [26] Shimizu K. Optical trans-body imaging-Feasibility of optical CT and functional imaging of living body[J]. Medicinal philosophica, 1992, 11: 620−629. [27] WANG Jiaqiang, YU Ming, QU Hanbing, et al. Analysis of palm vein image quality and recognition with different distance[C]//2013 Fourth International Conference on Digital Manufacturing & Automation. Shinan: IEEE, 2013: 215−218. [28] SUN Saisai, CONG Xiaoyan, ZHANG Ping, et al. Palm vein recognition based on NPE and KELM[J]. IEEE access, 2021, 9: 71778−71783. doi: 10.1109/ACCESS.2021.3079458 [29] 袁丽莎. 基于深度学习的手掌静脉识别[D]. 广州: 南方医科大学, 2019: 55−88. YUAN Lisha. Palm vein recognition based on deep learning[D]. Guangzhou: Southern Medical University, 2019: 55−88. [30] JIA Wei, GAO Jiao, XIA Wei, et al. A performance evaluation of classic convolutional neural networks for 2D and 3D palmprint and palm vein recognition[J]. International journal of automation and computing, 2021, 18(1): 18−44. [31] DU Dongyang, LU Lijun, FU Ruiyang, et al. Palm vein recognition based on end-to-end convolutional neural network[J]. Journal of southern medical university, 2019, 39(2): 207−214. [32] WANG Guoqing, SUN Changming, SOWMYA A. Learning a compact vein discrimination model with GANerated samples[J]. IEEE transactions on information forensics and security, 2020, 15: 635−650. doi: 10.1109/TIFS.2019.2924553 [33] ZHANG D, GUO Zhenhua, LU Guangming, et al. Online joint palmprint and palmvein verification[J]. Expert systems with applications, 2011, 38(3): 2621−2631. doi: 10.1016/j.eswa.2010.08.052 [34] LUO Nan, GUO Zhenhua, WU Gang, et al. Joint palmprint and palmvein verification by Dual Competitive Coding[C]//2011 3rd International Conference on Advanced Computer Control. Harbin: IEEE, 2011: 538−542. [35] 许学斌, 邢潇敏, 安美娟, 等. 基于多光谱图像融合的掌纹识别方法[J]. 光谱学与光谱分析, 2022, 42(11): 3615−3625. XU Xuebin, XING Xiaomin, AN Meijuan, et al. Palmprint recognition method based on multispectral image fusion[J]. Spectroscopy and spectral analysis, 2022, 42(11): 3615−3625. [36] 李俊林, 王华彬, 陶亮. 单幅近红外手掌图像掌静脉和掌纹多特征识别[J]. 计算机工程与应用, 2018, 54(9): 156−164,236. doi: 10.3778/j.issn.1002-8331.1612-0068 LI Junlin, WANG Huabin, TAO Liang. Palm vein and palmprint fusion recognition with those two features existing in same near-infrared palm image[J]. Computer engineering and applications, 2018, 54(9): 156−164,236. doi: 10.3778/j.issn.1002-8331.1612-0068 [37] WU Tengfei, LENG Lu, KHAN M K, et al. Palmprint-palmvein fusion recognition based on deep hashing network[J]. IEEE access, 2021, 9: 135816−135827. doi: 10.1109/ACCESS.2021.3112513 [38] ZHANG D, KONG W K, YOU J, et al. Online palmprint identification[J]. IEEE transactions on pattern analysis and machine intelligence, 2003, 25(9): 1041−1050. doi: 10.1109/TPAMI.2003.1227981 [39] ZHANG D, GUO Zhenhua, LU Guangming, et al. An online system of multispectral palmprint verification[J]. IEEE transactions on instrumentation and measurement, 2010, 59(2): 480−490. doi: 10.1109/TIM.2009.2028772 [40] JIA Wei, ZHANG B, LU Jingting, et al. Palmprint recognition based on complete direction representation[J]. IEEE transactions on image processing, 2017, 26(9): 4483−4498. doi: 10.1109/TIP.2017.2705424 [41] JIA Wei, HU Rongxiang, GUI Jie, et al. Palmprint recognition across different devices[J]. Sensors, 2012, 12(6): 7938−7964. doi: 10.3390/s120607938 [42] ZHANG Lin, LI Lida, YANG Anqi, et al. Towards contactless palmprint recognition: a novel device, a new benchmark, and a collaborative representation based identification approach[J]. Pattern recognition, 2017, 69: 199−212. doi: 10.1016/j.patcog.2017.04.016 [43] SUN Zhenan, TAN Tieniu, WANG Yunhong, et al. Ordinal palmprint represention for personal identification [represention read representation][C]//2005 IEEE Computer Society Conference on Computer Vision and Pattern Recognition. San Diego: IEEE, 2005: 279−284 [44] KABACIŃSKI R, KOWALSKI M. Vein pattern database and benchmark results[J]. Electronics letters, 2011, 47(20): 1127. doi: 10.1049/el.2011.1441 [45] TOME P, MARCEL S. On the vulnerability of palm vein recognition to spoofing attacks[C]//2015 International Conference on Biometrics. Phuket: IEEE, 2015: 319−325. [46] 吕佩卓, 赖声礼, 陈佳阳, 等. 一种自适应的手背静脉区域定位算法[J]. 微计算机信息, 2008, 24(4): 208−209, 296. LYU Peizhuo, LAI Shengli, CHEN Jiayang, et al. An adaptive locating algorithm of palm-dorsal vein image[J]. Microcomputer information, 2008, 24(4): 208−209, 296. [47] MIURA N, NAGASAKA A, MIYATAKE T. Feature extraction of finger vein patterns based on iterative line tracking and its application to personal identification[J]. Systems and computers in Japan, 2004, 35(7): 61−71. doi: 10.1002/scj.10596 [48] 尚丽, 苏品刚, 淮文军. 一种新的掌纹ROI图像定位方法[J]. 激光与红外, 2012, 42(7): 815−820. doi: 10.3969/j.issn.1001-5078.2012.07.021 SHANG Li, SU Pingang, HUAI Wenjun. New location method of palmprint ROI images[J]. Laser & infrared, 2012, 42(7): 815−820. doi: 10.3969/j.issn.1001-5078.2012.07.021 [49] REN Hengyi, SUN Lijuan, GUO Jian, et al. A dataset and benchmark for multimodal biometric recognition based on fingerprint and finger vein[J]. IEEE transactions on information forensics and security, 2022, 17: 2030−2043. doi: 10.1109/TIFS.2022.3175599 [50] GUO Jian, TU Jiaxiang, HENGYI REN, et al. Finger multimodal feature fusion and recognition based on channel spatial attention[EB/OL]. (2022−09−06) [2023−10−07]. https://arxiv.org/abs/2209.02368. [51] 李小敏, 陈英. 基于分数层融合的多生物特征融合识别[J]. 长江信息通信, 2021, 34(10): 7−11. doi: 10.3969/j.issn.1673-1131.2021.10.003 LI Xiaomin, CHEN Ying. Multi-biometric feature fusion recognition based on fractional layer fusion[J]. Changjiang information & communications, 2021, 34(10): 7−11. doi: 10.3969/j.issn.1673-1131.2021.10.003 [52] 周卫斌, 王阳, 吉书林. 基于特征融合的双模态生物识别方法[J]. 天津科技大学学报, 2022, 37(4): 44−48, 54. ZHOU Weibin, WANG Yang, JI Shulin. Bimodal biological recognition method based on feature fusion[J]. Journal of Tianjin University of Science & Technology, 2022, 37(4): 44−48, 54. [53] ZHOU Qing, JIA Wei, YU Ye. Multi-stream convolutional neural networks fusion for palmprint recognition[C]//Biometric Recognition. Cham: Springer, 2022: 72−81. [54] YANG Weili, HUANG Junduan, CHEN Zhuoming, et al. Multi-view finger vein recognition using attention-based MVCNN[C]//Biometric Recognition. Cham: Springer, 2022: 82−91.

下载:

下载: