Using palmprint lines for data enhancement of palmprint recognition based on deep learning

-

摘要: 近年来掌纹识别技术受到越来越多的关注,然而在掌纹识别的过程中,复杂的应用场景为识别带来了困难。在基于深度学习的掌纹识别算法中,数据增强操作具有较大的作用。由于掌纹的独特性,其所包含的特征信息几乎全部处于掌纹线之中,因此传统的全局数据增强方法收效甚微。本文提出了一种基于掌纹线的数据增强方法。该方法首先基于传统的图像处理方法,提出了多阶段的掌纹线提取算法。然后,基于提取的掌纹线,设计了一种掌纹识别的数据增强方案。通过实验表明,应用该数据增强方式对掌纹图像进行增强之后,在4个广泛应用的深度学习模型上都取得了更好的效果。该数据增强方法简单高效,能够在实际应用中发挥作用。Abstract: In recent years, palmprint recognition technology has attracted growing attention. However, complex application scenarios bring difficulties in the process of palmprint recognition. Data enhancement plays an important role in palmprint recognition algorithms based on deep learning. Owing to the uniqueness of palmprint, nearly all the feature data it contains lie within the palmprint lines. As a result, traditional global data enhancement methods have little effect in this case. In this study, a data enhancement method based on palmprint lines is proposed. In the method, a multi-stage palmprint line extraction algorithm is first proposed on the basis of the traditional image processing method. Subsequently, a data enhancement scheme on palmprint recognition is designed on the basis of the extracted palmprint lines. Experiments demonstrate that applying this data enhancement method to improve palmprint images has achieved better results than four widely used deep-learning models. The data enhancement method is simple and efficient and can play a role in actual applications.

-

随着整个社会的数字化和智能化程度不断加深,越来越多的场合需要对个人的身份进行有效验证,使用密码和身份证等传统身份验证方式已不能很好地满足应用需求。最近20年,作为最有效的身份验证方式之一,生物特征识别技术[1]受到了广泛关注并被大量应用。总体而言,人脸识别、虹膜识别、指纹识别、声纹识别、指静脉识别、掌静脉识别和掌纹识别等是被应用最多的生物特征识别技术。人脸识别[2]使用非常方便,但由于人脸图像可以在用户不知情的情况下被采集,用户对人脸识别可能带来的隐私泄露越来越担忧。对于掌纹识别,一般需要用户配合才能采集到掌纹图像,因此,相比人脸识别,掌纹识别是一种具有更好的隐私保护特性的生物特征识别技术[3]。虹膜识别[4]虽然精确度高,但是虹膜识别系统的成本也较高,限制了该技术的广泛应用。指纹一般是接触式采集,出于卫生方面的考虑,指纹识别系统难以用于公共场合的身份认证。除了具有较好的隐私保护特性之外,掌纹识别还具有图像易于采集、非接触式采集、特征稳定性好、识别精度高等特点。因此,掌纹识别是非常有前景的生物特征识别技术之一[5]。

掌纹最重要的特征是掌纹线特征[6],主线是掌纹中最稳定最清晰的几条特征线,在低分辨率和低质量的图片中仍能清晰地分辨出。本文主要介绍掌纹图像的主纹线特征提取方法以及基于提取的主纹线特征图像提出一种增强策略,这是一种基于滤波器的数据增强方式,相比于基本的数据增强, 更符合掌纹的线条特点。本文将其在深度学习模型上进行应用,并对实验结果进行分析和总结。

本文的主要贡献如下:

1)总结了基于主线特征的掌纹识别方法的发展,使读者对基于主线特征的掌纹识别方法有更深入、更全面的了解。

2)详细分析了掌纹线的定义,提出了一种两阶段掌纹线提取方法。

3)提出了一种新的基于掌纹线特征的增强策略 (palmprint line data enhancement, PLE),深入分析和比较了传统掌纹识别方法与基于深度学习的掌纹识别算法之间的差异,并探讨如何更好地将深度学习应用于掌纹识别任务上。

4) PLE在使用和设计上非常简单和高效,本文将其应用到4个经典的深度模型中,并在3个公共掌纹数据库上进行了实验,结果显示PLE能有效提升识别性能。

1. 相关工作

1.1 掌纹主线提取研究进展

Huang等[7]提出了一种基于主线的掌纹验证方法,用改进的有限Radon变换(modified finite Radon transform, MFRAT) 来提取掌纹主线,实验结果证明主线具有很强的可区分性。Jia 等[8]提出了一种基于主线的掌纹检索方法,检测出3条主线上的大量关键点,并采用这些关键点进行检索。Li等[9]根据掌纹主线边缘的特征,先使用灰度调整和中值滤波来增强掌纹图像的质量,再基于多样性和对比度来检测掌纹线,通过改进的Hilditch算法进行细化,最后使用边缘跟踪方法得到单像素的掌纹主线图像。Yuan等[10]在研究中根据主线的特定方向及其山谷型边缘的特征,只使用一个基于局部最小灰度值的45°方向模板来分割掌纹,并设计了另一种断线连接算法。该方案可以将主线检测限制在较小的区域内,并在一定的方向上跟踪主线,从而增强鲁棒性。Rotinwa-Akinbil等[11]认为手掌纹路的检测基本上是一个边缘识别问题,并提出利用离散傅里叶变换 (discrete Fourier transform, DFT) 技术计算出端点到端点的距离和截获点到端点的距离,将其变换到频域并匹配。Biradar等[12]提出了Canny边缘检测操作来提取主线特征。Wang等[13]提出了一种利用图像数据场和脉冲耦合神经网络快速提取掌纹的方法,该方法大大提高了掌纹提取的速度。Bruno等[14]通过归一化、中值滤波、沿4个前缀方向的平均滤波、灰度底帽滤波、二值化和后处理6个步骤提出掌纹主线。Raut等[15]运用图像处理技术,通过图像增强、形态学处理和边缘检测技术获取掌纹主线。Liu等[16]采用卷积神经网络提取显著的掌纹特征,如主线、皱纹和脊线。Oldal等[17]通过一系列图像处理操作(灰度缩放、对比度拉伸、平滑、消除低强度像素、阈值化和噪声去除)提取掌纹线。Fan等[18]提出第一个基于深度神经网络的掌纹主线提取模型,利用整体嵌套边缘检测网络搭建该模型。

1.2 基于深度学习的掌纹识别技术

近年来,深度学习[19]也在不断应用于掌纹识别中。Zhang等[20]提出了一种基于深度卷积神经网络的掌纹识别方法,即PalmRCNN,该方法是Inception_Resnet_v1的改进版本。Michele等[21]使用MobileNet_v2来提取掌纹特征,然后探索支持向量机 (support vector machines, SVM) 进行分类。Genovese等[22]提出了PalmNet 进行无监督掌纹识别,它包括卷积神经网络 (convolutional neural networks, CNN)、Gabor滤波器和主成分分析 (principal component analysis, PCA)。Zhong等[23]提出了一种端到端的掌纹识别方法,该方法应用了CNN的一种新的损失函数,以增强掌纹特征的内类紧凑性。Matkowski等[24]提出了掌纹识别网络 EE-PRnet,该网络由2个主要网络组成,即感兴趣区域(region of interest, ROI)定位与比对网络和特征提取与识别网络,可以解决不可控、非协作环境下的掌纹识别问题。Zhao等[25]提出了一种用于掌纹识别的通用框架,即深度判别表示方法。通过学习判别式深度卷积网络来表示多场景掌纹识别的高级判别特征,并使用分类器进行识别。Zhao等[26]利用深度卷积神经网络学习完整和有区别的卷积特征,并提出了一种联合约束最小二乘回归框架,该框架联合深度局部卷积特征解决了掌纹识别中的欠采样分类问题。Zhao等[27]提出了一种联合深卷积特征表示方法,应用于高光谱掌纹图像的特征提取。Jia等[28]对MobileNet-V3进行了改进,提出轻量级卷积神经网络EEPNet(efficient and effective palmprint recognition network)用于掌纹识别,并提出了2个新的损失函数。针对3D掌纹识别的应用中,深度学习也有了新的进展。Samai等[29]提出使用DCTNet进行3D掌纹识别。Chaa等[30]首先使用单尺度视网膜算法来增强3D掌纹的深度图像,然后使用PCANet进行识别。

1.3 深度学习中图像数据增强技术

数据增强在深度学习中具有重要作用,在图像领域得到广泛使用。

目前常见的数据增强[31]方式有:1)几何变换:几何变换可以有效地克服训练数据中存在的位置偏差,许多图像处理库都包含这个功能。2)颜色变换:图片在输入计算机之前,通常会被编码为张量,所以可以在色彩通道空间进行数据增强,比如将某种颜色通道关闭,或者改变亮度值。3)旋转/反射变换:选择一个角度,左右旋转图像,可以改变图像内容朝向,适宜的角度是1°~20°。4)随机擦除:随机擦除是随机选取图片中的一部分,将这部分图片删除。确保网络关注整个图像,而不只是其中的一部分。5)缩放变换:图像按照一定的比例进行放大和缩小并不改变图像中的内容,可以增加模型的泛化性能。6)位移:向左、向右、向上或向下移动图像可以避免数据中的位置偏差,可以避免可能出现的位置偏差导致的错误。7)翻转变换:水平或者竖直的轴进行图像翻转操作。8)裁剪:如果输入数据集合的大小是变化的,裁剪可以作为数据预处理的一个手段,通过裁剪图像的中央色块,可以得到新的数据。9)核滤波器:核滤波器是在图像处理中一种非常流行的技术,比如锐化和模糊。将特定功能的核滤波器与图像进行卷积操作,就可以得到增强后的数据。直观上,数据增强生成的图像可能会使得模型面对相应类型的图像具有更高的鲁棒性。

本文使用滤波器进行掌纹主线数据增强,并结合其他数据增强方式取得了良好的识别效果。

1.4 传统掌纹识别方法与基于深度学习的掌纹识别的差异

深度学习是近几年来研究的热点之一。深度学习的成功一方面是大数据的驱动,另一方面则是更多优异的网络模型被提出。随着深度学习的快速发展,多种卷积神经网络技术被应用到掌纹识别领域。然而目前研究者们似乎都专注于如何更好地将深度学习中最新的相关研究应用到掌纹识别任务或相关任务中去,而可能忽略了基于CNN的掌纹图像识别和通用图像分类之间的差异。深入分析传统掌纹识别算法的研究以及 CNN 的工作模式[32],可以总结出2点差异:

1)用于分类的特征差异:传统掌纹识别算法中提取到的特征是低级纹理特征,因为掌纹是一种富含纹理的图像,所以这些算法取得了较好的识别性能。而对于 CNN,大家普遍熟知的是 CNN 在提取特征时是分阶段、逐步深入,并且特征的语义信息逐渐增强。换句话说,CNN 分类时在浅层提取低级语义特征,高层获得高级语义特征并最终以此分类[33]。

2)用于分类的数据问题:在观察通用图像分类数据集和掌纹数据集后,可以发现在通用图像分类数据集中,不论是类内还是类间,数据变化都很大。而在掌纹数据集中,相同类别之间的数据差异较小,尤其是同一阶段内数据的差异。

这是由于对掌纹预处理任务的相关研究取得的进步,但这个数据特点是否对深度神经网络的学习过程产生了影响?网络的训练需要数据,在极端情况下,假如每一类的数据都一模一样,就会导致数据对于网络学习来说,价值不高,容易使得网络产生过拟合问题。而目前没有真正发生过拟合的原因在于训练和测试数据非常相似。因此,如果在这种情况下进行分类网络的研究,最终拟合的结果,其实很大程度上只是两阶段采集环境之间的差异(如光照、旋转等)。

1.5 研究动机

掌纹的识别过程中,在掌纹数据集中两阶段采集的数据具有高度的相似性,以一种意外的方式缓解了过拟合问题。但是,掌纹数据集中,同阶段采集的数据非常相似,使得对于CNN的网络来说,无法学习到更多富有价值的信息,从而影响了识别性能的进一步提升。如何能够既保持掌纹预处理的优点,又能避免给网络训练带来影响?掌线是一个关键桥梁。在掌纹ROI中,掌纹区域的变异比较小,总体来说比较稳,在这种情况下,掌线特征则更加明显和鲁棒[34]。根据注意力机制相关理论的研究[35-36],如果能够让网络重点关注掌线,那么就能让网络获得更加鲁棒的且具有判别力的特征。

Zhao等[37]的研究给本文带来启发,在使用CNN进行掌纹识别时,其对在训练时获得的特征进行了可视化,从而发现了掌线是 CNN 提取特征的关键信息。基于此,Zhao等合成了数十万数据用于训练阶段的数据增强。这些合成的数据中只有类似掌线的线,没有真实的掌纹纹理,但带来的高效训练效果却如此真实有效且引人深思。

以上的分析和研究说明了掌线主线特征在基于深度学习的掌纹识别算法中起着非常重要的作用。若深度神经网络能够对掌纹主线进行重点关注,则能够提高网络对于关键位置的表征能力。而掌纹本身就是一种富含纹理的图像,注意力位置完全可以由掌纹自身提供,因此本文提出利用一种简单且高效的借助掌纹线进行数据增强的方式,通过掌纹线,显式地增大关键位置与非关键位置的视觉差异,进而提高网络在掌纹线位置的注意力。

2. 两阶段掌纹线提取算法及数据增强策略

2.1 掌纹线概念

首先对本文中所涉及的掌纹线名词进行说明。此处掌纹线指的是比较明显的掌纹线,如图1所示。通常认为掌纹主线即为掌纹中的明显线,一般包含3条主线。这样的定义是不准确的,也不利于分析、研究和使用。通过观察掌纹 ROI 图像可以发现,如图2所示,有一些掌纹线也非常的明显。对于那些突出但不符合传统主线定义的掌纹线,保留它们是必要的,因为掌纹线的分布非常复杂,且主线的数量和分布缺乏统一的标准。此外,由于采集设备的影响,即使是传统定义的主线特征的掌纹线也可能出现缺失或部分缺失的情况。考虑到明显的掌纹线具有相对稳定的特点,可以作为识别身份的有效特征。因此,本文中提到的掌纹线规定为明显的掌纹线,不限定为主线。

2.2 掌纹线提取算法设计

掌纹线的提取同计算机视觉中语义分割任务具有一致性,且随着深度神经网络的发展,现有的语义分割模型能够达到非常高的精度。然而有监督的深度神经网络需要大量的标签数据进行训练。标注掌纹线是一个非常繁琐且耗时的工作,成本高,且现有的掌纹数据集相对于应用在语义分割模型上的数据集要小很多,这使得在其上训练出来的模型性能不好,缺乏泛化能力。经过上述考虑,本文设计了一个基于传统方法的多阶段掌纹线提取算法。

RLOC[34](robust line orientation code) 是2008年提出的一种鲁棒的用于掌纹验证的线方向码,设计了具有一定宽度的 MFART 方向模板,该模板能够很好地匹配主线的特征。因此本文以RLOC 为基础,提出一个方向更加细致的方法,用于第一阶段粗略抑制。LLDP[38](local line directional pattern) 是2016年提出的一种用于掌纹识别的局部描述子,称为局部线方向模式,使用MFRAT或Gabor滤波器计算邻域中12个不同方向的线响应,对方向的划分更加细致。因此借鉴LLDP算法,完成Gabor响应提取过程,获得第二步的掌线能量图,且由于工作在前一步的输出上,Gabor提取方向响应的效果更好,能够进一步去除一些位置的能量值,排除响应不稳定现象。最后利用最大类间方差法完成二值化。

2.2.1 提取第一阶段:基于MFRAT的掌线提取

方向响应提取过程同RLOC特征提取过程类似,算法首先使用多个方向的MFRAT模板进行掌纹提取,MFRAT的定义为:对于Zp={0,1,···,p−1},Zp是一个非负整数集合,其中p是奇数,对于任意一个p,可以形成一个p2大小的正方形网格

$ {\boldsymbol{Z}}_p^2 $ ,MFRAT为过$ {\boldsymbol{Z}}_p^2 $ 中心点的k条直线Lk的像素值的加权累加和r[k],公式为$$ r[k] = \frac{1}{C}\sum\limits_{(i,j) \in {L_k}} {f[i,j]} $$ 式中:1/C是加权因子,Lk定义为过Z2p中心点的一条直线,公式为

$$ {L_k} = \left\{ {(i,j):j = k(i - {i_0}) + {j_0},i \in {{\boldsymbol{Z}}_p}} \right\} $$ 实际上,MFRAT就是过

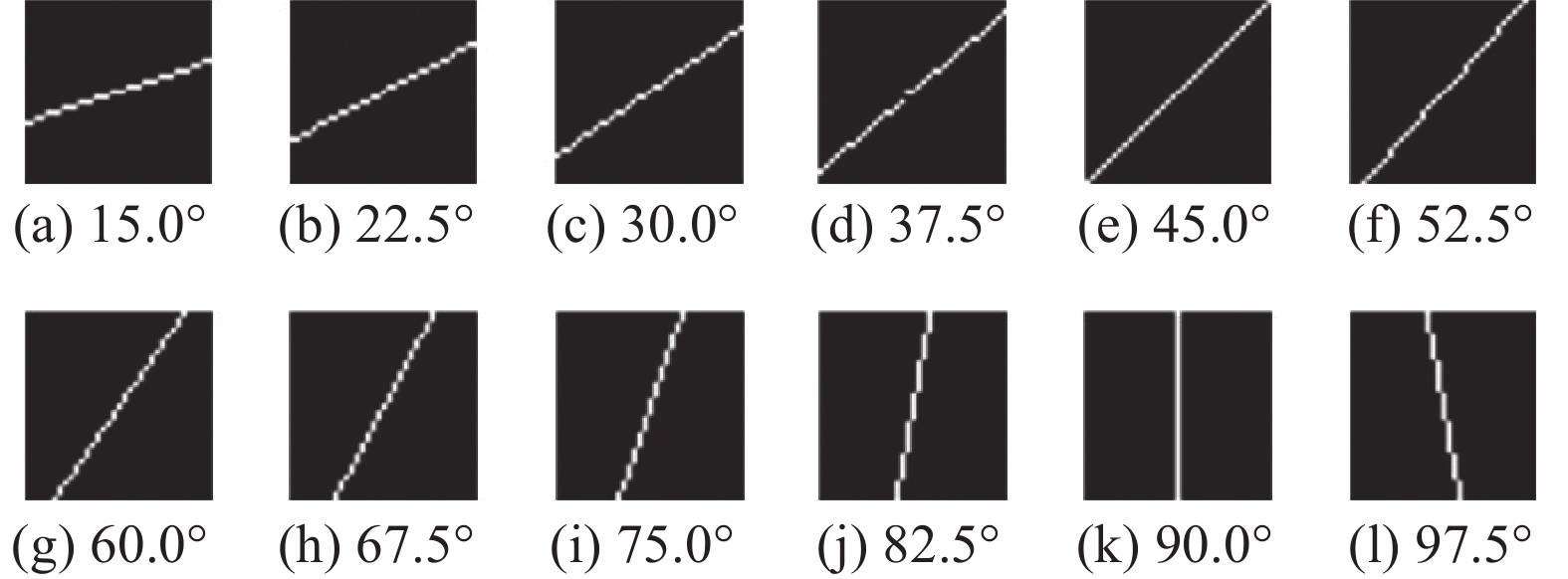

$ {\boldsymbol{Z}}_p^2 $ 中心点,形成了不同方向的线的模板,不同的方向可以由角度θ来表示。在本文中,对于左右手不同的掌纹,使用不同的 MFRAT 模板。针对左手掌纹图像,采用的 MFRAT 模板方向范围为82.5°~165.0°,如图3所示,其中每个方向之间相隔7.5°,因此共有 12 个方向。在掌纹识别中,采用12个方向作为滤波器的方向数量是一种较为理想的方案,既不会因为滤波器过少而遗漏主线,也不会由于滤波器过多而造成细线对主线提取的干扰,计算公式为$$ \theta = {82.5^ \circ } + {7.5^ \circ } \times I,0 \leqslant I \leqslant 11 $$ 针对右手掌纹图像,采用的 MFRAT 模板方向范围为15.0°~97.5°,如图4所示,其中每个方向之间同样相隔7.5°,因此总共有12个方向,计算公式为

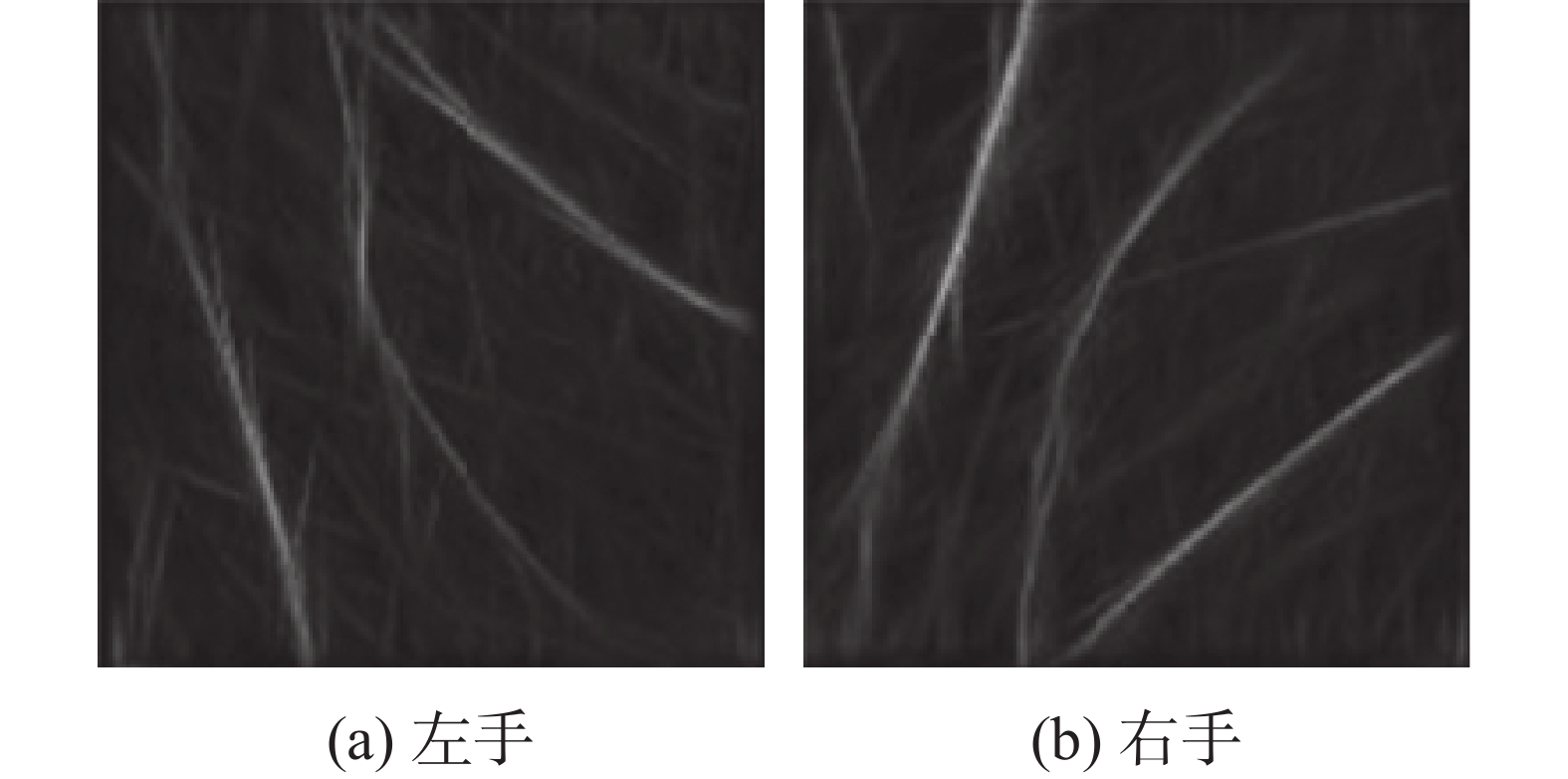

$$ \theta=15.0^{\circ}+75.0^{\circ}\times i,0\leqslant i\leqslant11 $$ 当方向响应提取完成后,按照竞争编码[39]中的“winner-take-all” 规则,选取12个方向响应中最大响应的绝对值的 1/C作为能量图相应位置的值,C为经验值,在本文中选取5,得到掌线的能量图(energy map, EM),如图5所示。

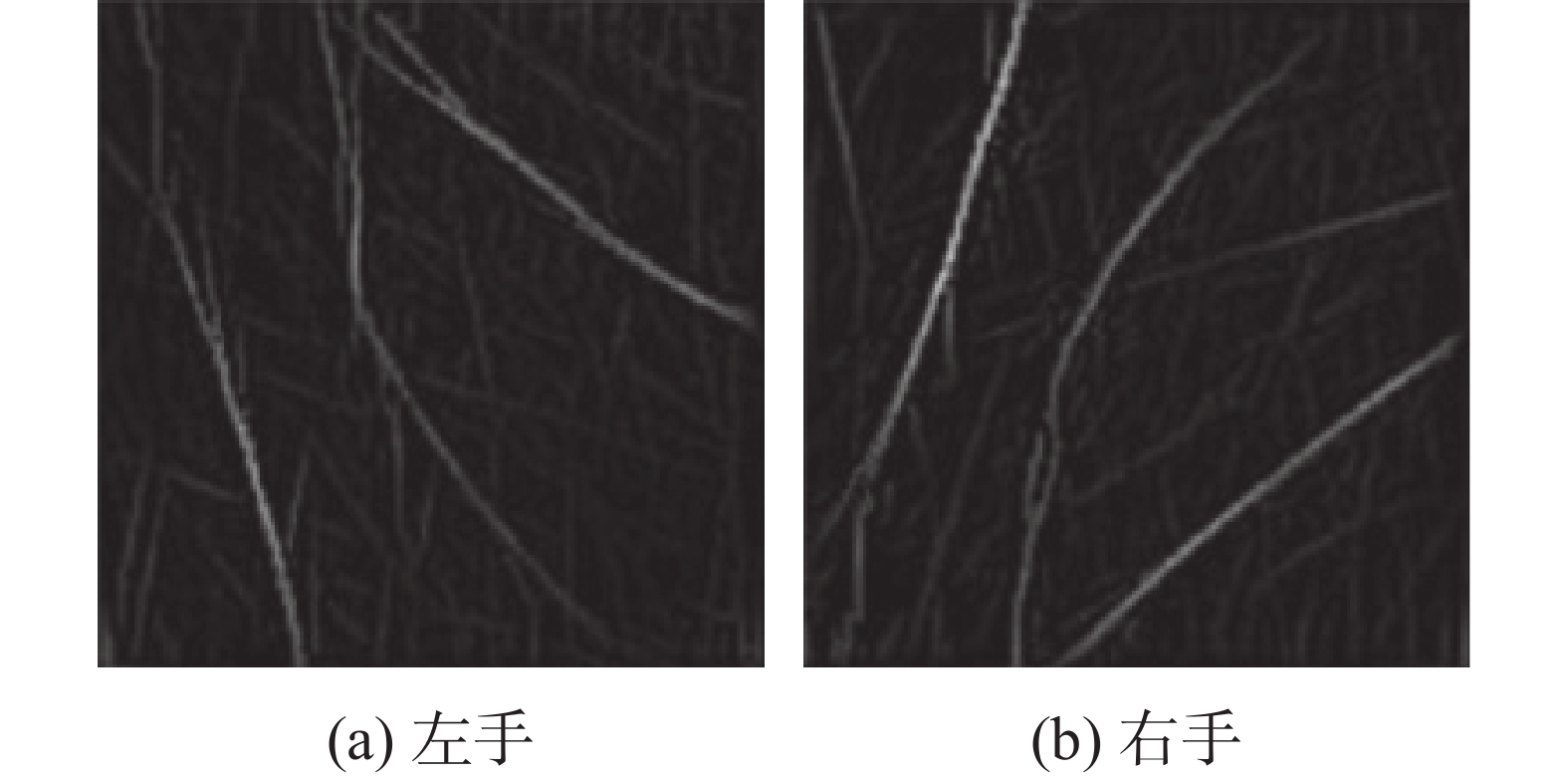

当获得能量图 EM 后,按照响应抑制策略算法对EM 每个位置的响应进行强度判断,若强度不足则加以抑制,最终得到响应抑制能量图 EMO,如图6所示。

算法 1 响应抑制策略算法

输入 EM, EMO is a 0 matrix, x, y

输出 EMO

1) If EM(x, y) is bigger than EM(x, y−2) and EM(x, y+2): EMO(x, y) = EM(x, y)

2) If EM(x, y) is bigger than EM(x−2, x−2) and EM(x+2, y+2): EMO(x, y) = EM(x, y)

3) If EM(x, y) is bigger than EM(x−2, y+2) and EM(x+2, y-2): EMO(x, y) = EM(x, y)

值得注意的是,任意一张 ROI 图像输入到第一阶段提取算法之前,首先需要将分辨率缩放为128像素×128像素,然后以四周的像素值进行扩充得到162像素×162像素,因此 EM和 EMO 的大小都为162像素×162像素。

2.2.2 提取第二阶段:基于Gabor滤波器的掌线提取

在第一阶段使用MFRAT提取的掌纹线中,根据12个方向提取颜色较深一点的线段,其中包括主线和一些其他的短线,由MFRAT提取到的图像通常包含一些细纹和噪声。为了能够获得较为纯净的主线部分,本文提出在第二阶段采用Gabor滤波器组进行第二次滤波。Gabor滤波器同时具有频率选择性和方向选择性,因此,使用Gabor滤波器作为带通滤波器以消除噪声。2维圆形Gabor滤波器公式为

$$ \begin{gathered} G(x,y,\theta ,\mu ,\sigma ) = \\ \frac{{\exp \left\{ { - \dfrac{{{x^2} + {y^2}}}{{2{\sigma ^2}}}} \right\}\exp \{ 2{\text{π }}i(\mu x\cos \theta + \mu y\sin \theta )\} }}{{2{\text{π }}{\sigma ^2}}} \end{gathered} $$ 式中:

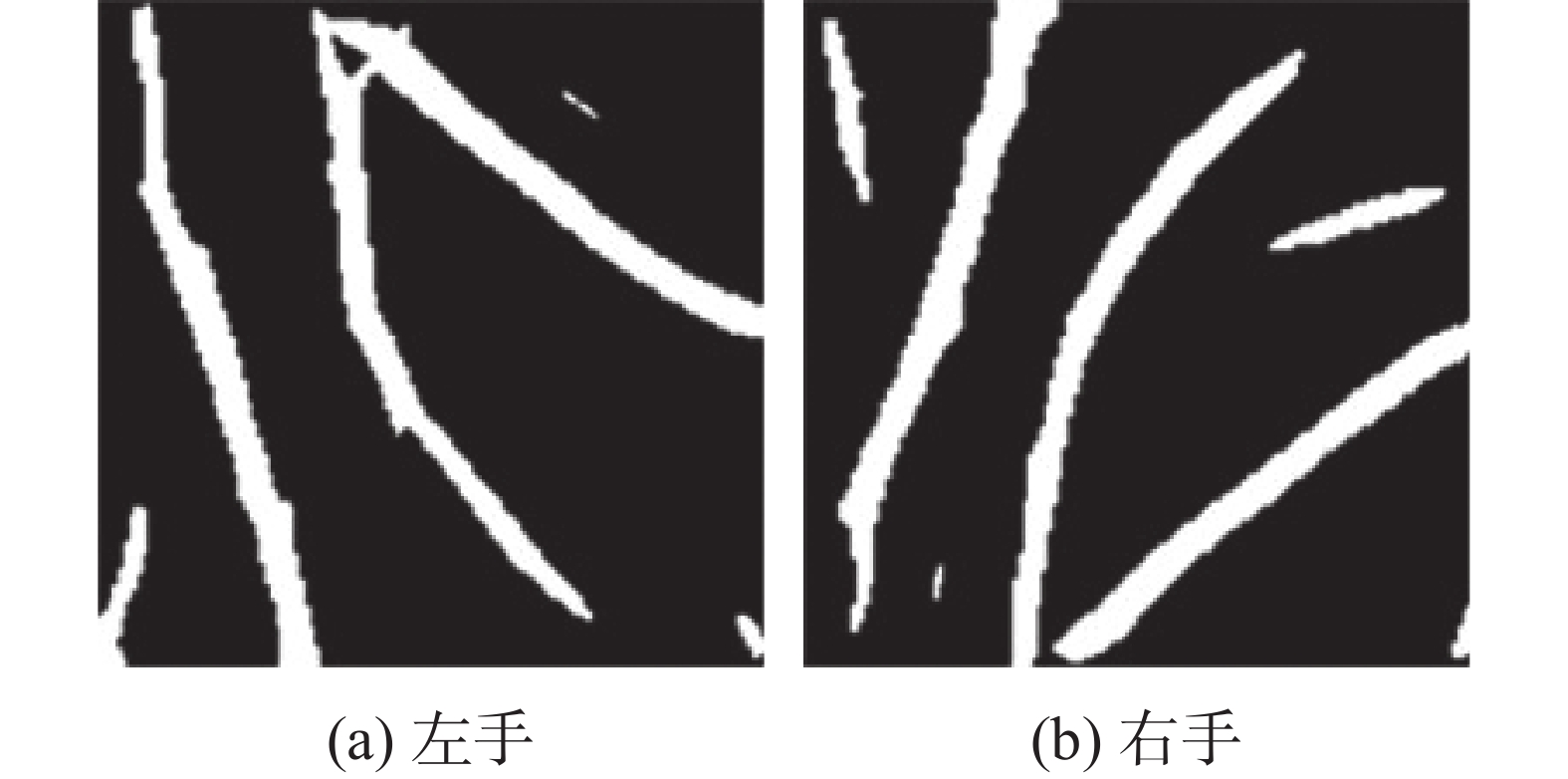

$ i=\sqrt{-1} $ , μ是正弦波频率,θ控制函数的方向,σ是高斯包络的标准偏差。基于该Gabor函数,可以创建具有一个尺度和多个方向的Gabor滤波器组。对第一阶段能量图EMO进行 12 个方向的Gabor滤波器卷积操作,区别在于此处保留的是方向响应,即按照 “winner-take-all” 规则获取最大响应值作为每一点的值,从而获得第二阶段 Gabor能量图 E,如图7所示。当获得了第二阶段的能量图 E 以后,首先计算 E 的最大值的1⁄K,即 EK(此处 K 为参数),作为第一次划分的阈值。即对于 E 中的任何一个点的值,若大于 EK,则其值变为原来的 K 倍,若其值小于等于 EK,则其值变为 0,具体公式为

$$ {{\boldsymbol{E}}_K} = \frac{{\max ({\boldsymbol{E}})}}{k} $$ $$ \boldsymbol{E}(x,y)=\left\{\begin{array}{*{20}{l}}\boldsymbol{E}(x,y)\times k,\text{ }\boldsymbol{E}(x,y) > \boldsymbol{E}_K \\ 0,\qquad\qquad\text{其他}\end{array}\right. $$ 然后采用最大类间方差法获得最终分割的阈值 T,按照 T对

$ {\boldsymbol{E}} $ 作终分割,得到 EB。分割结果的例子如图8所示。2.3 掌纹线数据增强策略

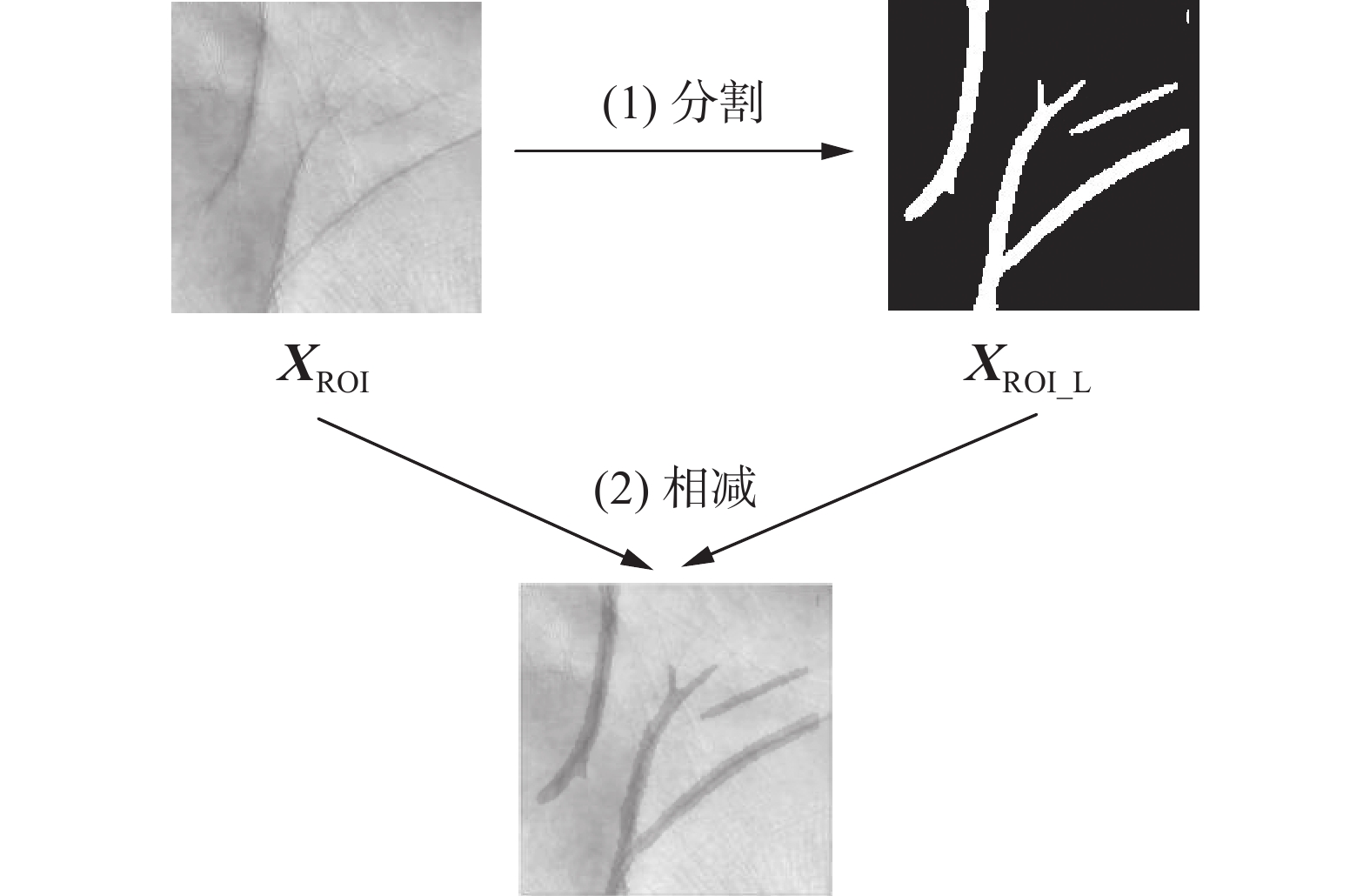

对于一幅掌纹 ROI 图像来说,掌纹线相比于皱纹线来说是更加稳定的,则位于其上的特征也成为起到分类作用的主力特征[40]。当获取了这些掌纹线的分割图后,这些图像能够指导CNN聚焦于图像中的重要区域。因此,一个直接的想法是借助掌纹线分割图对这些位置进行一次视觉增强,增大与其他不明显线条之间的视觉差异,从而有利于网络增加对这些位置的关注。本文设计了一种简单的利用掌纹线分割图的方式:

$$ {\boldsymbol{X}} = {{\boldsymbol{X}}_{{\text{ROI}}}} - {{\boldsymbol{X}}_{{\text{ROI\_L}}}} $$ (1) 图9中

$ {{\boldsymbol{X}}_{{\text{ROI}}}} $ 为输入ROI图像,$ {{\boldsymbol{X}}_{{\text{ROI\_L}}}} $ 为掌纹线分割图。在将$ {{\boldsymbol{X}}_{{\text{ROI}}}} $ 输入到网络之前,首先获得其对应的掌纹线分割$ {{\boldsymbol{X}}_{{\text{ROI\_L}}}} $ ,从文献[36]中获得的启发,直接将二者进行相减作为网络的实际输入。式 (1) 中的数据增强方式既没有引入额外的参数,也没有增加计算复杂度,并且其使用方式简单,不需要以改变网络结构为代价使用。鉴于其高效性,这种方法在实践中非常实用。此外,还有一种操作值得考虑,即将$ {{\boldsymbol{X}}_{{\text{ROI}}}} $ 与$ {{\boldsymbol{X}}_{{\text{ROI\_L}}}} $ 相加,本文在在实验与讨论部分进一步探讨这2种方法的效果和差异。3. 实验结果及分析

3.1 掌纹数据集

本文实验所用的掌纹数据集包括3个2D掌纹数据集:PolyU II[41]、TJU[42]和 HFUT[40]。表1列出了相关数据集的详细信息。

表 1 3个掌纹数据集的详细信息Table 1 Details of three palmprint databases数据库 是否

接触采集

人数手掌数 阶段数 采集

间隔/天图像

总数PolyU II 是 193 386 2 60 7752 HFUT 是 400 800 2 10 16000 TJU 否 300 600 2 61 12000 3.2 实验参数设置

本文使用ResNet-18[43]、DenseNet-121[44]、MobileNetV3-small [45]以及 SE-ResNet-50[36]4个经典的深度学习模型对提取的掌纹线进行了系统地评估。

这里需要指出的是,在验证实验中,所有图像首先被调整为 256像素×256 像素的大小,然后从中心裁剪出 224像素×224 像素大小的区域作为网络的输入。第一阶段采集的数据作为训练集,第二阶段采集的数据作为测试集。由于网络需要 3 通道的图像输入,而一般掌纹数据集为单通道灰度图,因此,对于灰度 ROI 图像,首先将 ROI 重复拼接 3 次作为网络输入,即

$ {{\boldsymbol{X}}_{{\text{ROI}}}} $ : = [$ {{\boldsymbol{X}}_{{\text{ROI\_R}}}} $ ;$ {{\boldsymbol{X}}_{{\text{ROI\_R}}}} $ ;$ {{\boldsymbol{X}}_{{\text{ROI\_R}}}} $ ]。本文采用了文献[46]中提出的 RandAugment。在数据归一化设置上,使用 mean = [0.485,0.485,0.485] 与 std = [0.225,0.225,0.225] 作为设定参数。采用Label Smoothing[47]正则化技术对标签进行平滑,防止模型过拟合,超参数设置为0.1。在优化器上,使用了Adamw[48]。初始学习率为0.01,采用余弦衰减[49]的调整策略,热身阶段学习率从10−6开始,共持续5个Epoch。模型总共训练500个Epoch,Batchsize由模型实际占用的运行内存决定。对于ResNet-18、DenseNet-121、MobileNetV3-small 以及 SE-ResNet-50,Batchsize分别设置为128、32、32、32。3.3 PLE实验结果与分析

将提出的策略应用到 ResNet-18、DenseNet-12、MobileNetV3-small和SE-ResNet-50 上,并在PolyU II、TJU和HFUT数据集上评估Top-1识别率。

首先评估 ResNet-18 在 PolyU II 上的表现,然后评估使用 PLE 后的表现,表2给出了 ResNet-18 与 ResNet-18+PLE 在 PolyU II、TJU 以及 HFUT上的 Top-1 识别率。

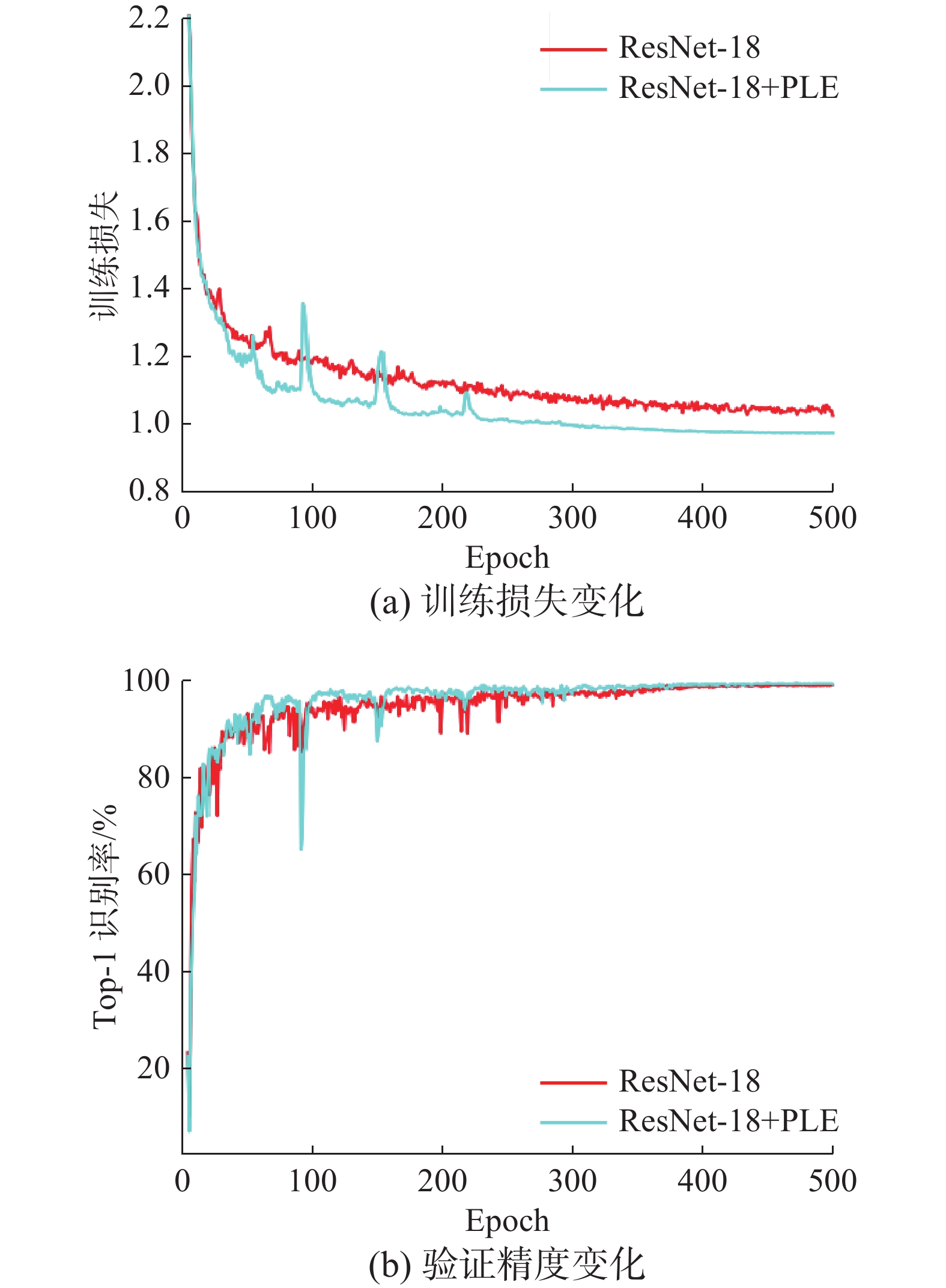

表 2 ResNet-18 与 ResNet-18+PLE 的评估结果Table 2 Evaluation results of ResNet-18 and ResNet-18+PLE% 模型 PolyU II TJU HFUT ResNet-18 99.79 99.31 99.65 ResNet-18+PLE 100.00 99.62 100.00 从表2中的结果可以发现,当使用了 PLE后,ResNet-18后能够得到更高的Top-1识别率,相对于基线模型,本文在PolyU II、TJU和 HFUT数据集上分别提升了0.21百分点、0.31百分点以及 0.35百分点。为了更深入地了解训练过程中的误差变化情况,在图10~12中比较了应用PLE增强策略前后ResNet-18 在整个训练过程中的训练损失和验证精度变化。从图中可以清晰地看到,将PLE策略应用到ResNet-18 网络后,训练损失比原网络下降得更快,并且花费更少的迭代次数就达到了原网络能够获得的最佳识别率。

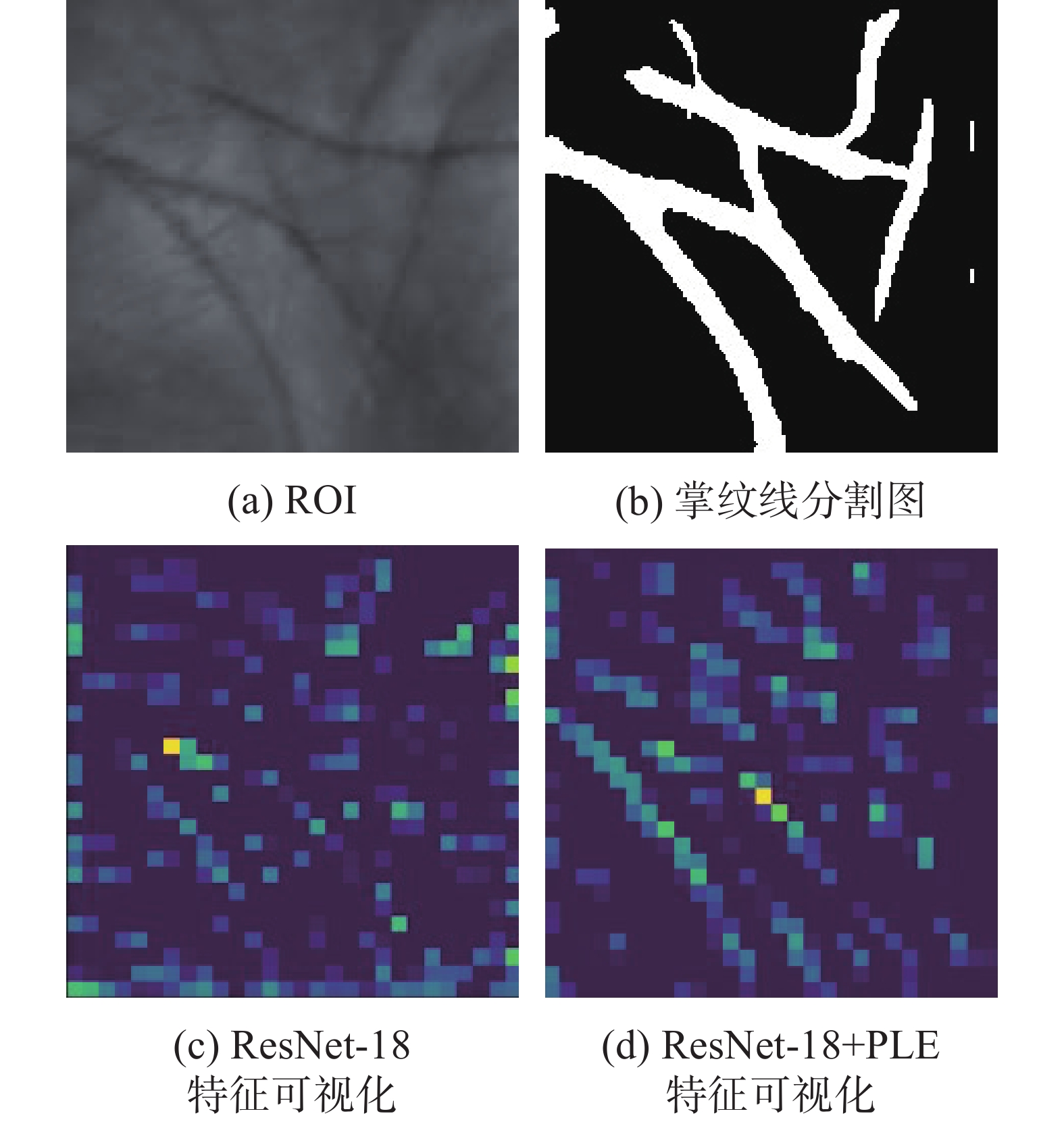

本文推测网络在应用 PLE 策略后,可能特别地注意了特征图中某些位置的特征,为此本文对训练完成后的2个模型中的 Layer2 层输出的特征图进行可视化,如图13~15所示。

从特征可视化后的结果对比中可以看到,在使用 PLE 后,更多的处于掌纹线附近的特征被激活,被分配了更多的权重,并且从实验结果中可以看到,在对这些位置分配更多的权重后,识别性能也在提高,说明位于掌纹线附近的特征值得受到更多的关注。在不同阶段相似掌纹数据对网络学习带来的影响下,寻找到更加鲁棒的位置特征对于提高网络的性能有显著的帮助。表3给出了DenseNet-121、mobileNetV3-small 以及SE-ResNet-50在PolyU II、TJU和HFUT验证Top-1 识别率的结果。在应用 PLE 后,模型在 3 个数据集上评估的结果都优于对应的基线模型,从而验证了本文提出的方法的有效性。

表 3 3 个 CNN 和对应的 PLE 版本的评估结果Table 3 Evaluation results of 3 CNN and corresponding PLE versions% 模型 PolyU II TJU HFUT DenseNet-121 99.92 99.80 99.80 DenseNet-121+PLE 100.00 100.00 99.91 mobileNetV3-small 98.47 98.48 96.43 mobileNetV3-small+PLE 99.66 99.16 99.16 SE-ResNet-50 99.69 99.50 98.79 SE-ResNet-50+PLE 100.00 99.60 100.00 3.4 RPLE实验结果与分析

PLE首先将

$ {{\boldsymbol{X}}_{{\text{ROI}}}} $ 与$ {{\boldsymbol{X}}_{{\text{ROI\_L}}}} $ 进行相减,用于加强掌纹线与皱纹线等不明显线条之间的差异。为了验证$ {{\boldsymbol{X}}_{{\text{ROI}}}} $ 与$ {{\boldsymbol{X}}_{{\text{ROI\_L}}}} $ 进行相加(将ROI图像反转,与$ {{\boldsymbol{X}}_{{\text{ROI\_L}}}} $ 相加)的效果,本文对此进行了实验,并将此操作命名为 RPLE,表4 中记录了 ResNet-18 在 TJU 上评估 Top-1 识别率的结果。表 4 PLE 和 RPLE 在 ResNet-18 上的评估结果Table 4 Evaluation results of PLE and RPLE on ResNet-18模型 识别率/% ResNet-18+PLE 99.62 ResNet-18+RPLE 99.48 从表4 的结果来看,二者的识别率比较接近,为了进一步分析,图16中比较了在训练过程的训练和验证误差变化。

从训练损失的变化来看,二者相差不大,但验证精度的来看,PLE 在更少的Epoch 上取得了更好的识别性能。

掌纹预处理环节中,观察到分阶段采集的数据产生了以下结果:第一阶段的数据之间非常相似,第二阶段的数据非常相似。这导致网络实际上只是在学习不同阶段采集环境(灰度、角度、平移变化)之间的差异。为了验证这一现象,本文使用 ResNet-18进行了试验,将每个阶段的前 5 张图像混合在一起作为训练集,每个阶段剩余的 5 张图像作为测试集,并在PolyU II、TJU 以及 HFUT 数据集上评估 Top-1 识别率。

从表5 中可以看到,在混合了两个阶段的数据后,识别任务对于网络来说变得异常容易。这说明了同一阶段采集的掌纹数据之间的相似性非常高。这也说明了直接使用两阶段的数据进行识别,对于网络来说,主要面临的学习难点在于不同阶段采集的环境差异,而这种差异是否能使网络平稳学习,或是否会引发过拟合问题,这些问题值得我们对掌纹数据本身进行更深入地研究。

表 5 混合第一阶段与第二阶段数据后的评估结果Table 5 Evaluation results after mixing stage 1 and stage 2 data% PolyU II TJU HFUT ResNet-18 100 100 100 3.5 与其他数据增强方法对比实验

本文使用几个图像处理领域常见的滤波器进行数据增强,包括Gaussian滤波器、Sobel滤波器和Prewitt滤波器,实验结果如表6所示。由表6可知,经过Gaussian滤波器增强后的识别结果通常优于Sobel滤波器和Prewitt滤波器,这是因为Gaussian滤波器更注重于图像的平滑和噪声的减少,因此在数据增强中所带来的效果可能表现为图像更加柔和、纹理更平滑。Sobel滤波器效果最差,甚至在一些模型中的识别结果比基线结果更差,这是因为Sobel使用的卷积核为中心点赋予了更高的权重,这可能导致它对噪声更敏感。相比之下,Prewitt的卷积核权重更均匀,更容易应对噪声的影响。

表 6 各种数据增强的评估结果Table 6 Evaluation results of various data augmentation% 模型 PolyU II TJU HFUT ResNet-18 99.79 99.31 99.65 ResNet-18+Gaussian 99.85 99.38 99.73 ResNet-18+Sobel 99.73 99.13 99.51 ResNet-18+Prewitt 99.82 99.44 99.68 ResNet-18+PLE 100.00 99.62 100.00 DenseNet-121 99.92 99.80 99.80 DenseNet-121+Gaussian 99.98 99.88 99.91 DenseNet-121+Sobel 99.76 99.76 99.82 DenseNet-121+Prewitt 99.93 99.84 99.87 DenseNet-121+PLE 100.00 100.00 99.91 mobileNetV3-small 98.47 98.48 96.43 mobileNetV3-small+Gaussian 98.73 98.80 97.92 mobileNetV3-small+Sobel 98.55 98.39 97.21 mobileNetV3-small+Prewitt 98.68) 98.62 97.44 mobileNetV3-small+PLE 99.66 99.16 99.16 SE-ResNet-50 99.69 99.50 98.79 SE-ResNet-50+Gaussian 99.88 99.55 99.12 SE-ResNet-50+Sobel 99.57 99.37 98.85 SE-ResNet-50+Prewitt 99.72 99.52 98.94 SE-ResNet-50+PLE 100.00 99.60 100.00 4. 结束语

本文设计了一个传统多阶段算法对掌纹线进行提取,并基于提取的掌纹线采用一种简单而高效的数据增强方法,能够提升卷积神经网络在掌纹识别任务上的性能,本文将这该方法应用于 ResNet-18、DenseNet-121、mobileNetV3-small以及SE-ResNet-50模型,并在PolyU II、HFUT、TJU 数据集上进行了评估,验证了本文提出方法的有效性。

-

表 1 3个掌纹数据集的详细信息

Table 1 Details of three palmprint databases

数据库 是否

接触采集

人数手掌数 阶段数 采集

间隔/天图像

总数PolyU II 是 193 386 2 60 7752 HFUT 是 400 800 2 10 16000 TJU 否 300 600 2 61 12000 表 2 ResNet-18 与 ResNet-18+PLE 的评估结果

Table 2 Evaluation results of ResNet-18 and ResNet-18+PLE

% 模型 PolyU II TJU HFUT ResNet-18 99.79 99.31 99.65 ResNet-18+PLE 100.00 99.62 100.00 表 3 3 个 CNN 和对应的 PLE 版本的评估结果

Table 3 Evaluation results of 3 CNN and corresponding PLE versions

% 模型 PolyU II TJU HFUT DenseNet-121 99.92 99.80 99.80 DenseNet-121+PLE 100.00 100.00 99.91 mobileNetV3-small 98.47 98.48 96.43 mobileNetV3-small+PLE 99.66 99.16 99.16 SE-ResNet-50 99.69 99.50 98.79 SE-ResNet-50+PLE 100.00 99.60 100.00 表 4 PLE 和 RPLE 在 ResNet-18 上的评估结果

Table 4 Evaluation results of PLE and RPLE on ResNet-18

模型 识别率/% ResNet-18+PLE 99.62 ResNet-18+RPLE 99.48 表 5 混合第一阶段与第二阶段数据后的评估结果

Table 5 Evaluation results after mixing stage 1 and stage 2 data

% PolyU II TJU HFUT ResNet-18 100 100 100 表 6 各种数据增强的评估结果

Table 6 Evaluation results of various data augmentation

% 模型 PolyU II TJU HFUT ResNet-18 99.79 99.31 99.65 ResNet-18+Gaussian 99.85 99.38 99.73 ResNet-18+Sobel 99.73 99.13 99.51 ResNet-18+Prewitt 99.82 99.44 99.68 ResNet-18+PLE 100.00 99.62 100.00 DenseNet-121 99.92 99.80 99.80 DenseNet-121+Gaussian 99.98 99.88 99.91 DenseNet-121+Sobel 99.76 99.76 99.82 DenseNet-121+Prewitt 99.93 99.84 99.87 DenseNet-121+PLE 100.00 100.00 99.91 mobileNetV3-small 98.47 98.48 96.43 mobileNetV3-small+Gaussian 98.73 98.80 97.92 mobileNetV3-small+Sobel 98.55 98.39 97.21 mobileNetV3-small+Prewitt 98.68) 98.62 97.44 mobileNetV3-small+PLE 99.66 99.16 99.16 SE-ResNet-50 99.69 99.50 98.79 SE-ResNet-50+Gaussian 99.88 99.55 99.12 SE-ResNet-50+Sobel 99.57 99.37 98.85 SE-ResNet-50+Prewitt 99.72 99.52 98.94 SE-ResNet-50+PLE 100.00 99.60 100.00 -

[1] 刘琦, 于汉超, 蔡剑成, 等. 大数据生物特征识别技术研究进展[J]. 科技导报, 2021, 39(19): 74−82. LIU Qi, YU Hanchao, CAI Jiancheng, et al. Research progress and trend of big-data based biometrics[J]. Science & technology review, 2021, 39(19): 74−82. [2] 李志远. 人脸识别技术研究现状综述[J]. 电子技术与软件工程, 2020(13): 106−107. LI Zhiyuan. Summary of the research status of face recognition technology[J]. Electronic technology & software engineering, 2020(13): 106−107. [3] 钟德星, 朱劲松, 杜学峰. 掌纹识别研究进展综述[J]. 模式识别与人工智能, 2019, 32(5): 436−445. ZHONG Dexing, ZHU Jinsong, DU Xuefeng. Progress of palmprint recognition: a review[J]. Pattern recognition and artificial intelligence, 2019, 32(5): 436−445. [4] 孙哲南, 谭铁牛. 虹膜识别研究与应用综述[J]. 自动化博览, 2005, 22(2): 25−26. doi: 10.3969/j.issn.1003-0492.2005.02.013 SUN Zhenan, TAN Tieniu. Research and applications overview of iris recognition[J]. Automation panorama, 2005, 22(2): 25−26. doi: 10.3969/j.issn.1003-0492.2005.02.013 [5] 岳峰, 左旺孟, 张大鹏. 掌纹识别算法综述[J]. 自动化学报, 2010, 36(3): 353−365. doi: 10.3724/SP.J.1004.2010.00353 YUE Feng, ZUO Wangmeng, ZHANG Dapeng. Survey of palmprint recognition algorithms[J]. Acta automatica sinica, 2010, 36(3): 353−365. doi: 10.3724/SP.J.1004.2010.00353 [6] 陈晓蔓, 贾伟, 李书杰, 等. 融合全局和局部方向特征的掌纹识别方法[J]. 图学学报, 2019, 40(4): 671−680. CHEN Xiaoman, JIA Wei, LI Shujie, et al. Palmprint recognition based on fusing global and local directional features[J]. Journal of graphics, 2019, 40(4): 671−680. [7] HUANG Deshuang, JIA Wei, ZHANG D. Palmprint verification based on principal lines[J]. Pattern recognition, 2008, 41(4): 1316−1328. doi: 10.1016/j.patcog.2007.08.016 [8] JIA Wei, ZHU Yihai, LIU Lingfeng, et al. Fast palmprint retrieval using principal lines[C]//2009 IEEE International Conference on Systems, Man and Cybernetics. San Antonio: IEEE, 2009: 4118−4123. [9] LI Cong, LIU Fu, ZHANG Yongzhong. A principal palm-line extraction method for palmprint images based on diversity and contrast[C]//2010 3rd International Congress on Image and Signal Processing. Yantai: IEEE, 2010: 1772−1777. [10] YUAN Weiqi, LIN Sen, TONG Haibin, et al. A detection method of palmprint principal lines based on local minimum gray value and line following[C]//2011 International Conference on Hand-Based Biometrics. Hong Kong: IEEE, 2011: 1−5. [11] ROTINWA-AKINBILE M O, AIBINU A M, SALAMI M J E. Palmprint recognition using principal lines characterization[C]//2011 First International Conference on Informatics and Computational Intelligence. Bandung: IEEE, 2011: 278−282. [12] BIRADAR S. Personal identification using palmprint biometrics based on principal line approach[J]. International journal of advanced research in computer engineering & technology, 2013, 14(2): 750−754. [13] WANG Yanxia, ZHAO Jianmin, SUN Guanghua, et al. Palm lines extraction using PCNN and image data field[C]//2013 First International Symposium on Future Information and Communication Technologies for Ubiquitous HealthCare. Jinhua: IEEE, 2013: 1−5. [14] BRUNO A, CARMINETTI P, GENTILE V, et al. Palmprint principal lines extraction[C]//2014 IEEE Workshop on Biometric Measurements and Systems for Security and Medical Applications. Rome: IEEE, 2014: 50−56. [15] RAUT S D, HUMBE V T. An approach to boundary extraction of palm lines and vein pattern[J]. International journal of image, graphics and signal processing, 2014, 6(12): 47−52. doi: 10.5815/ijigsp.2014.12.07 [16] LIU Dian, SUN Dongmei. Contactless palmprint recognition based on convolutional neural network[C]//2016 IEEE 13th International Conference on Signal Processing. Chengdu: IEEE, 2016: 1363−1367. [17] OLDAL L G, KOVáCS A. Biometric authentication system based on hand geometry and palmprint features[C]//Proceedings of the International Conference on Image Processing and Vision Engineering. Virtual: SCITE, 2021: 58−65. [18] FAN Yu, LI Jinxi, SONG Shaoying, et al. Palmprint phenotype feature extraction and classification based on deep learning[J]. Phenomics, 2022, 2(4): 219−229. doi: 10.1007/s43657-022-00063-0 [19] 胡越, 罗东阳, 花奎, 等. 关于深度学习的综述与讨论[J]. 智能系统学报, 2019, 14(1): 1−19. doi: 10.11992/tis.201808019 HU Yue, LUO Dongyang, HUA Kui, et al. Overview on deep learning[J]. CAAI transactions on intelligent systems, 2019, 14(1): 1−19. doi: 10.11992/tis.201808019 [20] ZHANG Lin, CHENG Zaixi, SHEN Ying, et al. Palmprint and palmvein recognition based on DCNN and a new large-scale contactless palmvein dataset[J]. Symmetry, 2018, 10(4): 78. doi: 10.3390/sym10040078 [21] MICHELE A, COLIN V, SANTIKA D D. MobileNet convolutional neural networks and support vector machines for palmprint recognition[J]. Procedia computer science, 2019, 157: 110−117. doi: 10.1016/j.procs.2019.08.147 [22] GENOVESE A, PIURI V, PLATANIOTIS K N, et al. PalmNet: Gabor-PCA convolutional networks for touchless palmprint recognition[J]. IEEE transactions on information forensics and security, 2019, 14(12): 3160−3174. doi: 10.1109/TIFS.2019.2911165 [23] ZHONG Dexing, ZHU Jinsong. Centralized large margin cosine loss for open-set deep palmprint recognition[J]. IEEE transactions on circuits and systems for video technology, 2020, 30(6): 1559−1568. doi: 10.1109/TCSVT.2019.2904283 [24] MATKOWSKI W M, CHAI Tingting, KONG A W K. Palmprint recognition in uncontrolled and uncooperative environment[J]. IEEE transactions on information forensics and security, 2019, 15: 1601−1615. [25] ZHAO Shuping, ZHANG B. Deep discriminative representation for generic palmprint recognition[J]. Pattern recognition, 2020, 98: 107071. doi: 10.1016/j.patcog.2019.107071 [26] ZHAO Shuping, ZHANG B. Joint constrained least-square regression with deep convolutional feature for palmprint recognition[J]. IEEE transactions on systems, man, and cybernetics: systems, 2022, 52(1): 511−522. doi: 10.1109/TSMC.2020.3003021 [27] ZHAO Shuping, ZHANG B, PHILIP CHEN C L. Joint deep convolutional feature representation for hyperspectral palmprint recognition[J]. Information sciences, 2019, 489: 167−181. doi: 10.1016/j.ins.2019.03.027 [28] JIA Wei, REN Qiang, ZHAO Yang, et al. EEPNet: an efficient and effective convolutional neural network for palmprint recognition[J]. Pattern recognition letters, 2022, 159: 140−149. doi: 10.1016/j.patrec.2022.05.015 [29] SAMAI D, BENSID K, MERAOUMIA A, et al. 2D and 3D palmprint recognition using deep learning method[C]//2018 3rd International Conference on Pattern Analysis and Intelligent Systems. Tebessa: IEEE, 2018: 1−6. [30] CHAA M, AKHTAR Z, ATTIA A. 3D palmprint recognition using unsupervised convolutional deep learning network and SVM classifier[J]. IET image processing, 2019, 13(5): 736−745. doi: 10.1049/iet-ipr.2018.5642 [31] 冯晓硕, 沈樾, 王冬琦. 基于图像的数据增强方法发展现状综述[J]. 计算机科学与应用, 2021, 11(2): 370−382. doi: 10.12677/CSA.2021.112037 FENG Xiaoshuo, SHEN Yue, WANG Dongqi. A Survey on the Development of Image Data Augmentation[J]. Computer science and application, 2021, 11(2): 370−382. doi: 10.12677/CSA.2021.112037 [32] 王海纶, 李书杰, 贾伟, 等. 卷积神经网络在掌纹识别中的性能评估[J]. 中国图象图形学报, 2019, 24(8): 1231−1248. doi: 10.11834/jig.180605 WANG Hailun, LI Shujie, JIA Wei, et al. Performance evaluation of convolutional neural network in palmprint recognition[J]. Journal of image and graphics, 2019, 24(8): 1231−1248. doi: 10.11834/jig.180605 [33] 周飞燕, 金林鹏, 董军. 卷积神经网络研究综述[J]. 计算机学报, 2017, 40(6): 1229−1251. doi: 10.11897/SP.J.1016.2017.01229 ZHOU Feiyan, JIN Linpeng, DONG Jun. Review of convolutional neural network[J]. Chinese journal of computers, 2017, 40(6): 1229−1251. doi: 10.11897/SP.J.1016.2017.01229 [34] JIA Wei, HUANG Deshuang, ZHANG D. Palmprint verification based on robust line orientation code[J]. Pattern recognition, 2008, 41(5): 1504−1513. doi: 10.1016/j.patcog.2007.10.011 [35] ZHONG Zilong, LI Ying, MA Lingfei, et al. Spectral–spatial transformer network for hyperspectral image classification: a factorized architecture search framework[J]. IEEE transactions on geoscience and remote sensing, 2022, 60: 5514715. [36] HU Jie, SHEN Li, SUN Gang. Squeeze-and-excitation networks[C]//2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City: IEEE, 2018: 7132−7141. [37] ZHAO Kai, SHEN Lei, ZHANG Yingyi, et al. BézierPalm: A free lunch for palmprint recognition[C]//Lecture Notes in Computer Science. Cham: Springer, 2022: 19−36. [38] LUO Yuetong, ZHAO Lanying, ZHANG B, et al. Local line directional pattern for palmprint recognition[J]. Pattern recognition, 2016, 50: 26−44. doi: 10.1016/j.patcog.2015.08.025 [39] KONG A W K, ZHANG D. Competitive coding scheme for palmprint verification[C]//Proceedings of the 17th International Conference on Pattern Recognition. Cambridge: IEEE, 2004: 520−523. [40] LI Mengwen, WANG Huabin, LIU Huaiyu, et al. Palmprint recognition based on the line feature local tri-directional patterns[J]. IET biometrics, 2022, 11(6): 570−580. doi: 10.1049/bme2.12085 [41] ZHANG D, KONG W K, YOU J, et al. Online palmprint identification[J]. IEEE transactions on pattern analysis and machine intelligence, 2003, 25(9): 1041−1050. doi: 10.1109/TPAMI.2003.1227981 [42] ZHANG Lin, LI Lida, YANG Anqi, et al. Towards contactless palmprint recognition: a novel device, a new benchmark, and a collaborative representation based identification approach[J]. Pattern recognition, 2017, 69: 199−212. doi: 10.1016/j.patcog.2017.04.016 [43] HE Kaiming, ZHANG Xiangyu, REN Shaoqing, et al. Deep residual learning for image recognition[C]//2016 IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas: IEEE, 2016: 770−778. [44] HUANG Gao, LIU Zhuang, VAN DER MAATEN L, et al. Densely connected convolutional networks[C]//2017 IEEE Conference on Computer Vision and Pattern Recognition. Honolulu: IEEE, 2017: 2261−2269. [45] HOWARD A, SANDLER M, CHEN Bo, et al. Searching for MobileNetV3[C]//2019 IEEE/CVF International Conference on Computer Vision. Seoul: IEEE, 2019: 1314−1324. [46] CUBUK E D, ZOPH B, SHLENS J, et al. Randaugment: practical automated data augmentation with a reduced search space[C]//2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition Workshops. Seattle: IEEE, 2020: 3008−3017. [47] ZHANG Changbin, JIANG Pengtao, HOU Qibin, et al. Delving deep into label smoothing[J]. IEEE transactions on image processing, 2021, 30: 5984−5996. doi: 10.1109/TIP.2021.3089942 [48] ZHUANG Zhenxun, LIU Mingrui, CUTKOSKV A, et al. Understanding adamw through proximal methods and scale-freeness[J]. Transactions on machine learning research, 2022: 1−29. [49] HE Tong, ZHANG Zhi, ZHANG Hang, et al. Bag of tricks for image classification with convolutional neural networks[C]//2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Long Beach: IEEE, 2019: 558−567.

下载:

下载: