TEDS underbody fault location algorithm in virtue of weak texture matching

-

摘要: 针对当前动车组运行故障动态图像检测系统(trouble of moving EMU detection system, TEDS)故障识别准确率低的问题,本文提出一种借助弱纹理匹配的动车底部潜在故障区域定位方法。首先,采用拓扑交叉数检测大量弱纹理区域特征点;然后,以特征点为中心的环形区域内各像素点的拓扑交叉数值筛选特征点,构建相应特征向量进行弱纹理特征匹配;最后,对配准后的图像进行比对定位潜在故障区域。实验结果表明,该算法保证了匹配精度,能检测出大部分潜在故障区域,弱纹理区域的特征匹配准确率超过80%且所有图像对均存在特征匹配对,为以后的精准故障分类提供了有利条件。Abstract: Fault recognition accuracy in the trouble of moving EMU detection system (TEDS) is suboptimal. Thus, a method for locating potential fault areas at the bottom of EMU by means of weak texture matching is proposed. First, a large number of feature points in the weak texture areas are detected using the topological crossover number. Second, feature points are selected on the basis of the topological crossover number of each pixel within a specified ring area centered on the feature points. This approach aims to construct corresponding feature vectors to achieve the matching of weak texture features. Finally, the registered image is compared to locate the potential fault areas. Experimental results show that the algorithm ensures matching accuracy; it can also detect most potential fault areas. The matching accuracy of weak texture areas is more than 80%, with feature matching pairs in all image pairs. Such a result provides favorable conditions for accurate fault classification in the future.

-

理想的动车组运行故障动态图像检测系统(trouble of moving EMU detection system, TEDS)通过采集动车组运行的车底和侧部图像进行识别与异常分析,自动判定出可能存在故障的区域并将对应信息实时传输给工作人员进行人工核查,及时排除故障隐患,来保障动车运行安全。我国动车组保有量在2020年就达到3 600标准组,动车运行故障检测工作任务繁重,虽然TEDS已在高速铁路上应用,但目前使用的TEDS绝大多数都不具备自动判定的功能,少数存在该功能的系统其故障预警准确率也极低,当前动车运行故障动态图像检测仍然是靠列检人员花费大量时间进行人工检查[1-3]。

目前,TEDS中故障定位算法可以分为传统算法和深度学习方法两类。基于深度学习的方法应用在真实场景下TEDS的故障定位中主要存在两个问题:一是动车组的真实典型故障图像数据过少,且不同机构生产的TEDS输出的图像格式不统一,缺乏标准的故障图像数据库[4-5];二是应用深度学习方法需要更高的硬件设备要求,存在重要的实时性问题。相较于深度学习方法,目前的传统算法所需要的TEDS故障图像少,硬件要求低,算法复杂度低,实时性更优,便于集成到实际的TEDS中。图像配准是基于传统方法的TEDS中重要的处理模块,其处理结果的好坏会直接影响最终潜在故障区域定位识别的准确率[6-7]。

近些年来,基于特征的图像配准算法成为图像配准技术中的主流方向。TEDS图像一般为灰度图像,使用基于特征的图像匹配方法会有更好的效果。常用的特征点检测及描述算法包括SURF(speeded up robust features)算法[8]、SIFT(scale invariant feature transform)算法[9]、ORB(oriented fast and rotated brief)算法[10]、FAST(features from accelerated segments test)算法[11]和BRIEF(binary robust independent elementary features)算法[12]等。这些传统特征提取匹配算法都能充分利用图像的纹理信息,但在算法实时性、匹配准确率和鲁棒性等方面都存在提升空间。为了提升匹配精度,有研究工作利用图像中的信息和特征计算方式来改进经典算法,但引入了其他信息,增加了特征点数量,整体算法的耗时变长[13-16]。为了保证匹配精度时提升算法的速度,文献[17]在传统SURF基础上分割圆形区域提取描述符,提升了匹配速度和精度,但该方法特征点分布集中,数量过少。文献[18]应用四叉树、K-D树(K-Dimensional Tree)方法,提升算法实时性和匹配精度。但算法构建的描述子稳定性较低,不易区分。文献[19]利用Haar小波(Haar wavelets)提取图像低频成分,使用BRISK(binary robust invariant scalable keypoints)算法[20]提取特征点,减少了后续匹配用时。章盛等[21]提出了融入曲率尺度空间算法的改进SURF,提升了算法实时性,但匹配准确度未改善。为了提取优质特征点,增强特征描述符的表达能力,有研究通过融合不同方法实现特征匹配,文献[22]融合SURF算法和MESR(maximally stable external regions)算法实现较好的目标识别和分类效果。陈伟等[23]使用FAST和SURF算法进行图像匹配,但对于图像中的尺度变化及图像拼接处的“鬼影”问题,不能有效解决。文献[24]划分图像网格区域,设置不同局部阈值,提升光照变化下的特征检测能力。但特征点的数量是随着图像纹理信息变丰富而增加,不适用弱纹理图像。

这些主流的特征点算法及它们的改进算法在纹理丰富的图像上已有较成熟的应用。算法检测到的大都是一些十分突出、不会因光照、仿射变换和噪音等因素而变化的点,如角点、边缘点、暗区的亮点及亮区的暗点等,这些特征点基本存在于纹理丰富的图像中。由于动车车底有大量的车底盖板,其图像灰度变化小且同灰度区域分布广,大部分区域都没有足够丰富的纹理,使用上述主流的特征点算法只能提取到少量的特征点,不利于进行精准图像匹配。

为了处理弱纹理场景的问题,文献[25]利用弱纹理区域的局部自相似性提出一种基于稀疏表示的弱纹理图像特征点匹配方法。文献[26]提出一种跳过噪声点的区域增长自适应窗口匹配算法来匹配图像弱纹理区域。文献[27]提出多邻域结构张量特征算法,但特征点数量受邻域起始半径和邻域间隔像素影响较大。上述方法中,算法提取的特征点数量不稳定,影响因素多,复杂度高,相同实验条件下仍有常用的经典算法可以取得好的效果。

为了处理TEDS弱纹理图像的特征点提取匹配问题,本文提出基于拓扑交叉数的弱纹理特征提取算法(weak texture feature extraction algorithm based on topological intersection number, WTFE-TIN),算法通过计算图像中各像素点的拓扑交叉数[28],利用了区域的结构信息,可在弱纹理区域提取出大量特征点;之后根据特征点自身的拓扑性质,结合Mean-Shift思想,提出特征点筛选机制,减少特征点数量,获取优质特征点;最后结合邻域交叉数值构建描述子,提出基于区域相似度和归一化相关系数的弱纹理特征匹配方法,实现图像匹配。相同实验条件下,本文方法能稳定提取到丰富数量的有效特征点,实现所有弱纹理图像的正确匹配。

1. WTFE-TIN算法原理

常用的经典算法及其改进算法难以在TEDS弱纹理图像中提取到有效特征点,而现有的适用于弱纹理图像的特征点提取算法所提取的特征点数量不稳定,难以应用到TEDS弱纹理图像中,针对上述问题,本文提出WTFE-TIN算法,利用图像区域的结构信息,实现弱纹理图像的特征点提取及匹配。

1.1 基于拓扑交叉数的特征点检测

拓扑参数通过表达区域内部各部分的相互作用来描述整个区域的结构,能够更好地反映图像的结构信息,其中拓扑交叉数表示像素点8邻域像素内4连通组元的数目。像素点的交叉数计算以二值图像为基础,从像素点的任意一个4邻域的位置起始,绕顺时针方向排列8个邻域像素值,计算公式为

$$ {S_4}(I) = \prod\limits_{i = 0}^7 {{p_i}} + \frac{1}{2}\left(\sum\limits_{i = 0}^6 {\left| {{p_{i + 1}} - {p_i}} \right|} + \left| {{p_0} - {p_7}} \right|\right) $$ (1) 式中:

$ {S_4}(I) $ 为拓扑交叉数,$ {p_i} = 0 $ 或$ {p_i} = 1 $ 。根据$ {S_4}(I) $ 的值,可以区分在一个4连通组元中各个像素:若

$ {S_4}(I) = 0 $ ,则$ I $ 是孤立点;若

$ {S_4}(I) = 1 $ ,则$ I $ 是边界点或中间点;若

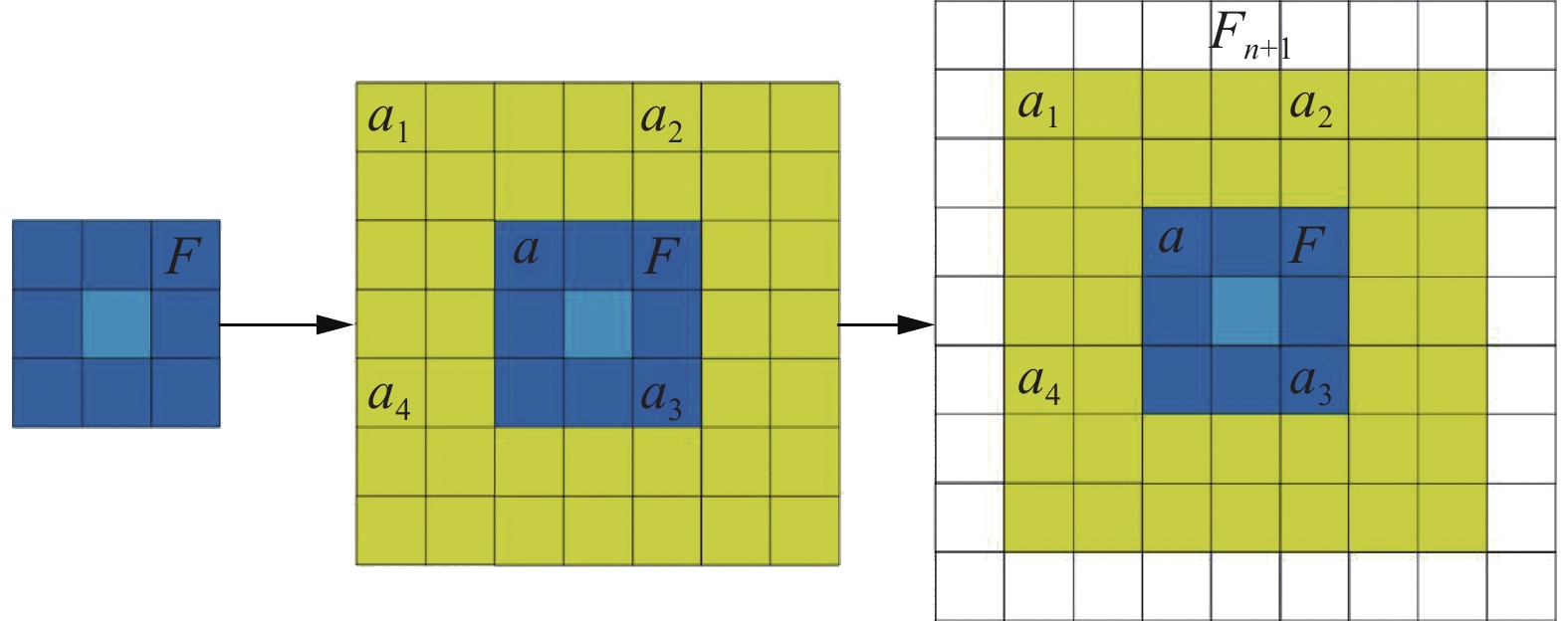

$ {S_4}(I) = 2 $ ,则$ I $ 是连通组元保持4连通必不可少的点。特征点的检测是以拓扑交叉数值来确定。计算像素点交叉数需要获取其8邻域二值化后的值,并且考虑后续使用特征点为中心,边长为

$ 2 \times n + 1 $ 的方形区域构建特征描述子,所以需要预先将图像$ F $ 扩充$ n + 1 $ 圈像素为$ {F_{n + 1}} $ ,进行全局自适应二值化处理,计算$ {F_{n + 1}} $ 除最外圈外各像素点的交叉数值,最终在$ {F_{n + 1}} $ 中筛选出$ F $ 的范围内$ {S_4}(I) = 2 $ 的点,因为这类点是4连通组元中不可缺少的点且数量丰富。以图1为例,蓝色区域是图像$ F $ ,浅蓝色为中心点,若$ a $ 点为特征点,以$ a $ 点为中心$ 5 \times 5 $ 的范围(即$ {a_1} $ 、$ {a_2} $ 、$ {a_3} $ 、$ {a_4} $ 构成的方形区域)构建特征描述子,则需要将$ F $ 扩充两圈,而求$ {a_1} $ 点拓扑交叉数又需要再次扩充一圈才能获得$ {a_1} $ 点8邻域。故新图像$ {F_{n + 1}} $ 是在$ F $ 基础上扩充3圈得到,保证了图像$ F $ 上所有点均进行过特征点检测。1.2 结合特征点拓扑性质和Mean-Shift的特征点筛选

特征点位置确定后,以各特征点为中心,取其边长范围为

$ 2 \times n + 1 $ 的方形区域$ A $ 共$ n $ 圈像素点,当各圈像素均有交叉数值为1的点时,保留该特征点:$$ p=\left\{\begin{array}{l}\text{true}, \quad 存在\text{ }{I}_{i}=1(i=8\times N,N=1,2,\cdots ,n)\\ \text{false},\quad 其他\end{array}\right. $$ (2) 式中:

$ p $ 为当前特征点,$ {I_i} $ 为以$ p $ 点为中心的第$ N $ 圈像素中第$ i $ 个像素点的拓扑交叉数值,$ {\text{true}} $ 为保留特征点,$ {\text{false}} $ 为删除该特征点。确定特征点后,将

$ A $ 中交叉数非1的点的交叉数值全置为0。交叉数为1的点是构成连通组元的边界点或中间点,它和交叉数为2的点构成拓扑结构的连接符,表达了连通组元的拓扑性质,故选择此两种点构建特征。将其余点交叉数置为0是为了便于后续二进制特征描述。由于使用拓扑交叉数可以检测到大量弱纹理特征点,如果直接进行特征点描述和匹配处理会消耗大量计算资源和时间。故引入Mean-Shift聚类思想进行特征点分类,根据特征强度筛选各类特征点。

1.3 弱纹理特征点描述

然后,计算各圈中交叉数值为1像素点的梯度值,以梯度强度最大的点和特征点构成向量,求各圈像素向量和,以此向量的方向作为特征点的主方向,表达式如下:

$$ {{\boldsymbol{v}}_N} = \max ({\text{sobel}}({I_i} = 1)) - {I_p},{\text{ (}}i = 8 \times N,N = 1,2, \cdots ,n) $$ (3) $$ {\boldsymbol{V}} = \sum\limits_{N = 1}^n {{{\boldsymbol{v}}_N}} $$ (4) 式中:

${{\boldsymbol{v}}_N}$ 为第$ N $ 圈的向量;$ {\text{sobel}} $ 是以sobel算子求梯度;${\boldsymbol{V}}$ 为$ n $ 圈向量和,${\boldsymbol{V}}$ 的方向即为特征点的方向。特征向量的构建则是图像像素位置顺序排序

$ A $ 内交叉数值。特征点的强度值$ {R_{{\text{response}}}} $ 计算是根据FAST算法的非极大值方式改写。$$ {R_{{\text{response}}}} = \sum\limits_{i = 0}^{{{(2 \times n + 1)}^2}} {\left| {{I_i} - {I_{{\text{keypoint}}}}} \right|} $$ (5) 式中:

$ n $ 为前述扩充图像时的参数,$ {I_i} $ 是$ A $ 区域像素灰度值,$ {I_{{\text{keypoint}}}} $ 是特征点灰度值。1.4 基于区域相似度和归一化相关系数的特征匹配

为了获取更精确的匹配对,本算法根据匹配点的区域灰度相似程度和区域归一化相关系数(NCC)初步筛选出多对匹配点对。计算灰度相似程度就是比较匹配点在相同区域内灰度均值差异,差异值越小说明越匹配。区域归一化相关系数反映匹配点固定范围内图像的相似程度,所得结果在

$ \left[ { - 1,1} \right] $ 区间,值越大说明越匹配,计算公式为$$ \begin{array}{c} \rho \left( {x,y} \right) = \\ \dfrac{{\dfrac{1}{{mn}}\displaystyle\sum\limits_{i = 1}^m {\displaystyle\sum\limits_{j = 1}^n {\left( {S\left( {i,j} \right) - \overline S } \right)\left( {g\left( {i,j} \right) - \overline g } \right)} } }}{{\sqrt {\dfrac{1}{{mn}}\displaystyle\sum\limits_{i = 1}^m {\displaystyle\sum\limits_{j = 1}^n {{{\left( {S\left( {i,j} \right) - \overline S } \right)}^2}} } } \sqrt {\dfrac{1}{{mn}}\displaystyle\sum\limits_{i = 1}^m {\displaystyle\sum\limits_{j = 1}^n {{{\left( {g\left( {i,j} \right) - \overline g } \right)}^2}} } } }} \end{array}$$ (6) 式中:

$ S\left( {i,j} \right) $ 和$ g\left( {i,j} \right) $ 分别为两个同尺寸的图像区域,$ \overline S $ 与$ \overline g $ 为对应的图像灰度均值,$ m $ 、$ n $ 为图像的行列数,$ \,\rho \left( {x,y} \right) $ 为归一化相关系数值。为了同时使用灰度均值差异和NCC值,先将灰度均值差异归一化到

$ \left[ {0,1} \right] $ 区间,用$ {w_1} $ 表示。然后将NCC值反向映射到$ \left[ {0,1} \right] $ 区间,使其值越小表示越匹配,用$ {w_2} $ 表示,再使用不同权重求和归一化后的灰度均值差异和NCC值。$$ w = \alpha {w_1} + \beta {w_2} $$ (7) 式中:

$ w $ 为最终计算的匹配值,$ \alpha $ 和$ \beta $ 为权重值。本文根据以往经验值及多次实验结果确定

$ {w_1} $ 和$ {w_2} $ 权重占比为$ 1:9 $ ,最终选取$ w $ 值小的多对匹配对,求对应特征向量的欧氏距离,保留欧氏距离值最小的匹配对。为了便于计算,求$ {w_1} $ 和$ {w_2} $ 时选取的区域和构建特征向量时的区域范围一致。2. TEDS车底图像配准

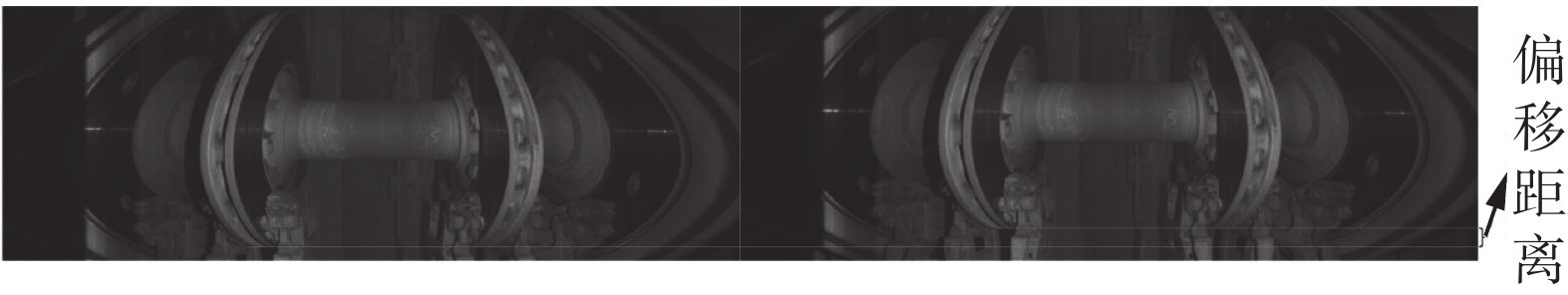

经过图像几何畸变等预处理流程后,图像在垂直方向还存在着一定的偏移,需要进行图像配准处理。几何畸变处理后的图像如图2所示。

2.1 特征点检测

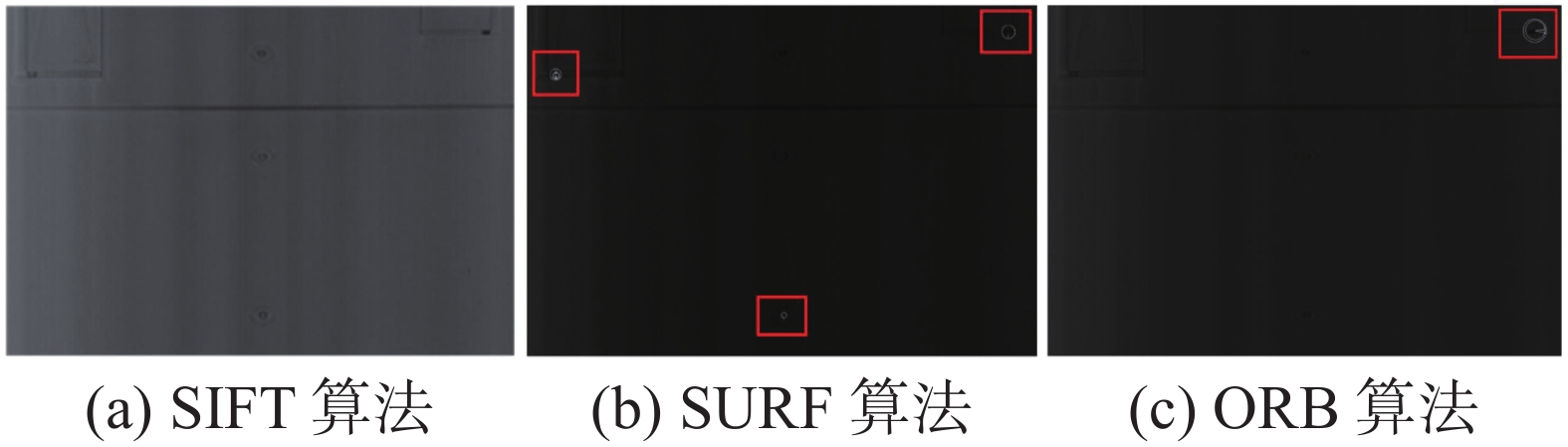

由于车底图像弱纹理区域较多,使用常用特征点提取算法只能检测到少量甚至检测不到特征点,严重影响匹配精度,如图3所示是几种常用主流的特征点算法在TEDS车底图像上的特征点提取效果,(a)图未检测到特征点,(b)、(c)为便于观察调整了图像对比度,白色为特征点,(b)和(c)中存在极少量特征点用红框标出。

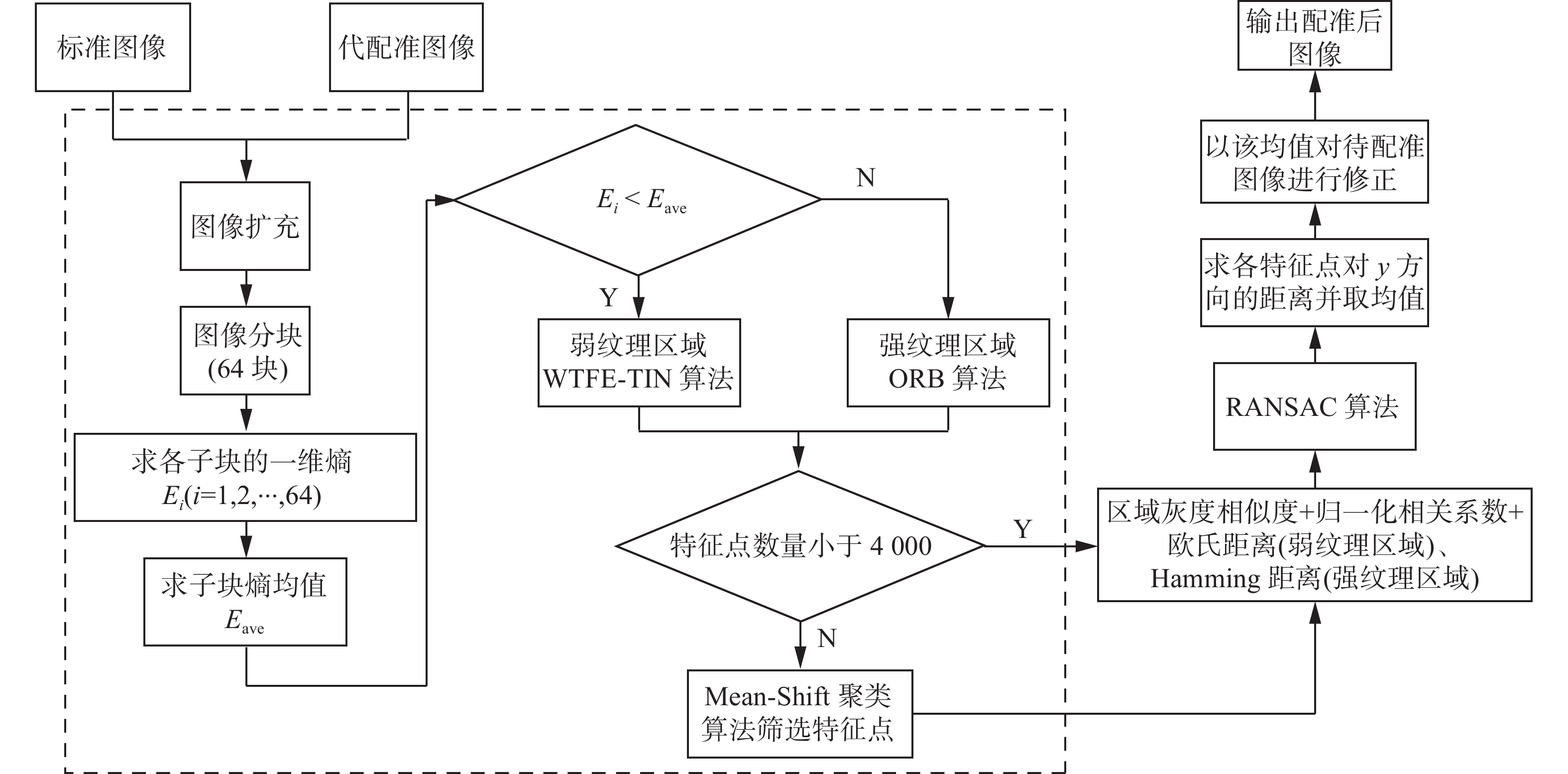

为了提取充分利用图像纹理和结构信息,本文提出弱纹理特征提取算法,设计出图4所示的流程。首先使用对称法将原始图像

$ {I_{{\text{src}}}} $ 扩充得到图像$ {I_{{\text{res}}}} $ ,将$ {I_{{\text{src}}}} $ 和$ {I_{{\text{res}}}} $ 分块,本文一幅图像分割成64个子块。计算原始图像各个子块的一维图像熵信息,求所有子块熵值的均值,子块熵值大于均值判定为纹理丰富的子图像,使用速度快的ORB算法提取图像特征点。子块熵值小于均值的判定为弱纹理图像,使用WTFE-TIN算法提取图像特征点。两种方法相结合可以分别利用图像的纹理和结构信息检测到大量弱纹理特征点和少量强纹理特征点,利于实现精确图像配准。由于WTFE-TIN算法会提取大量特征点,直接进行特征点匹配会影响匹配算法的运行速度,故引入Mean-Shift聚类思想进行特征点分类,根据特征强度筛选各类特征点。2.2 特征点筛选

在提取到所有特征点后,若特征点数量过多,会加剧特征匹配耗时,故需要在保证不影响匹配效果的情况下只保留一定数量的特征点。为此,算法借助Mean-Shift聚类思想进行特征筛选,具体步骤为

1)设定圆形区域的半径,本文根据所要处理的图像尺寸选取的半径为300像素,选取第一个特征点作为初始中心点;

2)求出中心点到圆形区域内各特征点的向量,将各向量相加求均值向量;

3)将中心点移至均值向量末端,如此迭代,寻找到该特征区域内特征点密度最大的区域,记录此时中心点信息,此过程中圆形区域每次移动寻找到的每个特征点判定为该类的次数加1,本实验设置的漂移距离小于0.1时停止迭代;

4)重新选择未被分类的点作为中心,重复2、3步骤,直到所有的特征点都被分类;

5)最后根据每个点所属类的频数确定各点类别。

完成特征点分类后,本文根据实验测试的特征匹配用时最终设定需要进行筛选的特征点数量阈值为4 000,即只在提取特征点数量大于4 000时才进行Mean-Shift聚类筛选。筛选特征点的方式是求阈值与特征点总数的比例,各类特征点在乘此比例值确定要保留的特征点数量,将各类特征点按照特征强度由大到小排序,并据此顺序筛选出对应数量的特征点。至此,完成整个特征点的选取工作,这些特征点源自全图各类别中特征强度大的特征点,具有代表性。整个工作可以根据初始特征点数量筛选出大量可以代表图像纹理或结构的特征点,既保证能够实现精确匹配,又确保后续特征匹配的用时在可接受范围内。

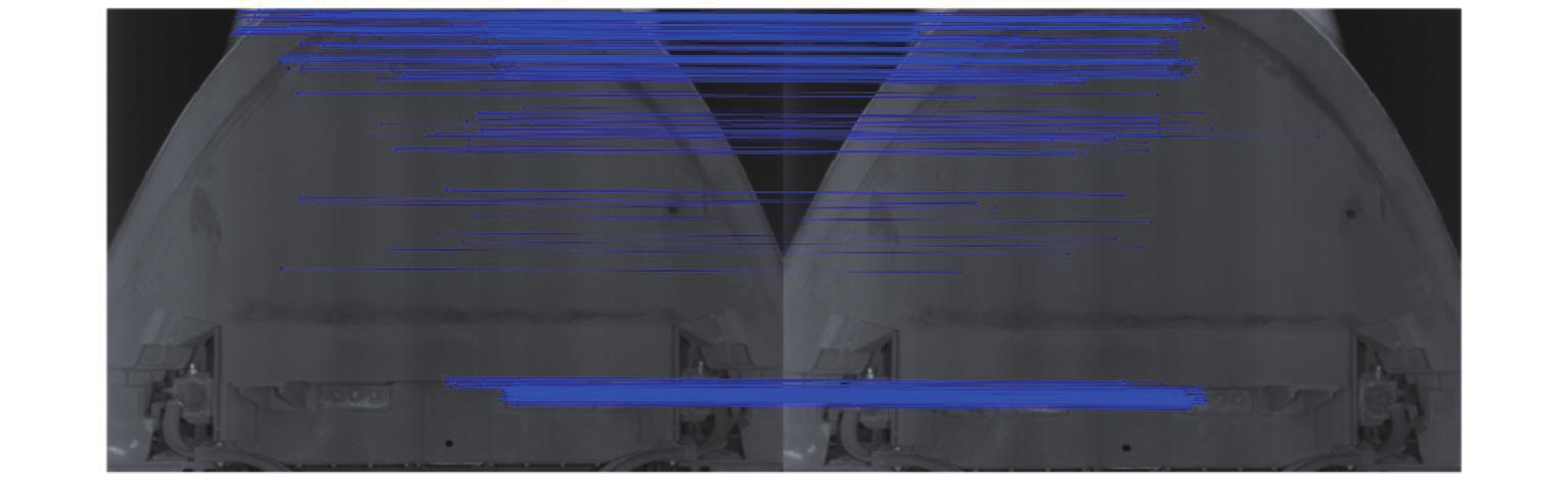

2.3 特征匹配及故障标记

完成特征点筛选后,构建特征向量,本文WTFE-TIN算法选取特征点为中心的区域构建80维特征向量,然后对两种不同的特征点采用不同的匹配方法。ORB算法提取出的特征点采用Hamming 距离计算特征向量间的距离,取距离最小的为最佳匹配对。WTFE-TIN算法采用特征点固定区域灰度均值差异、NCC值和欧氏距离实现特征匹配。再分别对两种匹配对使用RANSAC算法滤除误匹配对,然后通过求取所有匹配对特征点间垂直方向的距离,排序后取中位数,对与中位数相差超过5像素的点对进行滤除来减少误差。对剩下的点对距离取均值后,重新拼接待配准图像及其前后两张图像,根据偏移的均值来切割图像,完成配准操作。图5即为图像最终的匹配效果示例,所有匹配点连线近乎平行。

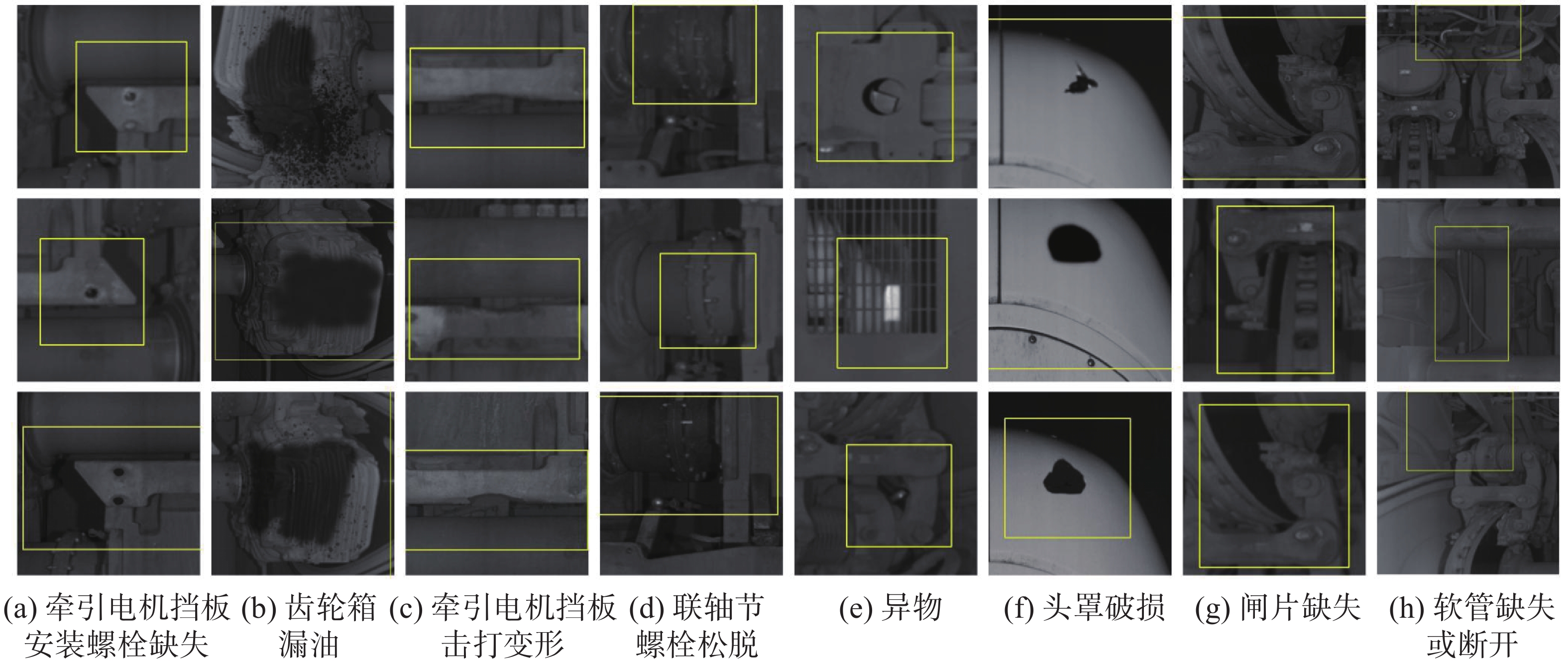

将配准后的图与标准图像作差,进行二值化,再通过形态学开运算滤除图中微小白色区域,之后寻找图中白色区域轮廓,通过轮廓长度和轮廓面积筛选出潜在故障区域,求出各轮廓区域的外接矩形,本文滤除轮廓长度小于10大于4000像素单位和轮廓面积小于10像素单位面积的轮廓。对于矩形有交叉的区域合并为一个潜在故障区域,因为实际故障中存在车体上有大量油污的故障,若不进行区域合并会标记出大量的同类故障,不利于后续故障的分类识别工作。图6为一些关键故障的定位结果,黄框内为定位的每个故障区域,由于真实故障图像少且难以获得,这些故障均是在咨询相关人员,了解故障特性后人工添加。

3. 实验结果分析

本实验使用的是Windows10操作系统,Visual C++为平台,搭载OpenCV3.4.10+contrib-3.4.10扩展库。PC机CPU为AMD R7 4800H、16 GB内存。

3.1 实验数据

本实验有两组CRH380B动车底部故障图像,每组包含475张图像,共计950张图像,图像分辨率均为

$ 2\,048 \times 1\,400 $ 。第一组为该车型1车(动车)车底图像,共分25个小组(每组19张图像 ),实际故障总数为40个;第二组为该车型2车(拖车)车底图像,共分25个小组(每组19张图像),实际故障总数为35个。其中动车车底相较于拖车车底情况更为复杂,零部件更多。3.2 特征点提取对比实验

为验证WTFE-TIN算法能够提取动车底部图像大量弱纹理区域的特征点,选择一组车底图像进行经典SIFT、SURF、ORB和WTFE-TIN算法对比实验,每次实验所使用的图像均相同这些经典算法发展成熟,应用范围广,其许多改进算法多是单一改进且不适用弱纹理图像,故只与经典算法进行对比。结果如表1所示,SIFT、SURF和ORB算法均是直接对每一组图像提取特征点,使用K近邻匹配。

表 1 不同特征提取方法对比实验结果Table 1 Experimental results of different feature extraction methods特征提取方法 平均每张

标准图像

特征点

数/个平均每张

待配准图

像特征点

数/个匹配准确

率均值/%未存在匹

配对的图

像对数/对WTFE-TIN 11 608 11 610 86.00 0 SIFT 90 92 83.11 3 SURF 189 195 92.74 1 ORB 85 91 69.86 5 分别计算图像特征向量与另一幅待匹配图像各特征向量之间的距离,由小到大排序后选取距离小的K个匹配对,一般K取2,然后计算最近邻与次近邻距离之比,当比值小于设定的阈值时,保留该特征向量的最近邻匹配对,反之,则滤除该向量的各匹配对。其中,SIFT和SURF算法使用的是欧氏距离度量,ORB算法使用的是Hamming距离度量。WTFE-TIN算法则是进行图像分块后根据子块图像熵值区分出弱纹理区域提取特征点,再根据前述的特定方法进行匹配。

由表1可知,SIFT、SURF和ORB平均每张图像提取的特征点数量均不超过200,且都存在有图像对未提取到匹配对的情况,观察实验结果图像可以看出此3种传统算法在弱纹理区域多的图像上很难提取出特征点,无法进行特征匹配,而WTFE-TIN算法能够在同样的弱纹理区域检测到大量特征点并能成功匹配部分特征点。根据每对图像匹配准确率均值(未存在匹配对的图像对匹配准确率置为0)也可看出WTFE-TIN算法在TEDS车底图像的配准方面也有较好的匹配准确率,尽管准确率低于SURF算法,但SURF算法只能在纹理丰富的图像中达到此效果。

3.3 Mean-Shift算法对WTFE-TIN算法匹配准确率的影响

由于WTFE-TIN算法可以提取大量特征点,保证特征点匹配准确率的同时如何减少匹配耗时也成为了一个重点问题。本文引入了Mean-Shift算法来筛选特征点,表2为自定义的特征点数量阈值参数对WTFE-TIN算法特征匹配准确率的影响结果。

表 2 特征点数量阈值参数变化的实验结果Table 2 Experimental results of threshold parameter changes of number of feature points特征点数量阈值/个 匹配准确率均值/% 耗时/s 500 44.26 11.4 1 000 62.13 11.9 1 500 76.96 13.1 2 000 77.25 16.1 2 500 80.81 17.9 3 000 81.04 22.1 3 500 82.64 24.4 4 000 82.24 27.8 4 500 82.09 30.4 5 000 82.89 32.7 特征点数量阈值参数是用于限定特征点数量,通过Mean-Shift聚类思想对特征点分类,按照特征强度筛选特征点,将数量控制在该阈值参数左右,提升WTFE-TIN算法的运行效率。表2是对一组(19对)图像的实验结果,可以看出随着特征点数量阈值增大,匹配时长增加,匹配准确率在阈值为3 500~4 000处会有较大的结果。在所有图像中,原始特征点数量最小的图也有3 000左右的特征点,平均一组图像中特征点数低于5 000的有8张。结合表1可以看到,在不滤除特征点时,特征点匹配准确率能达到86%,进行聚类筛选后,匹配准确率会下降,这是由于Mean-Shift聚类思想只是依据特征点强度筛选特征点,容易将部分能成功匹配的有效特征点滤除,导致准确率下降。所以根据特征点数量分布,本文将特征点数量阈值定为4 000,既保证有较好的准确率,也缩短了算法耗时。

3.4 动车组故障检测实验

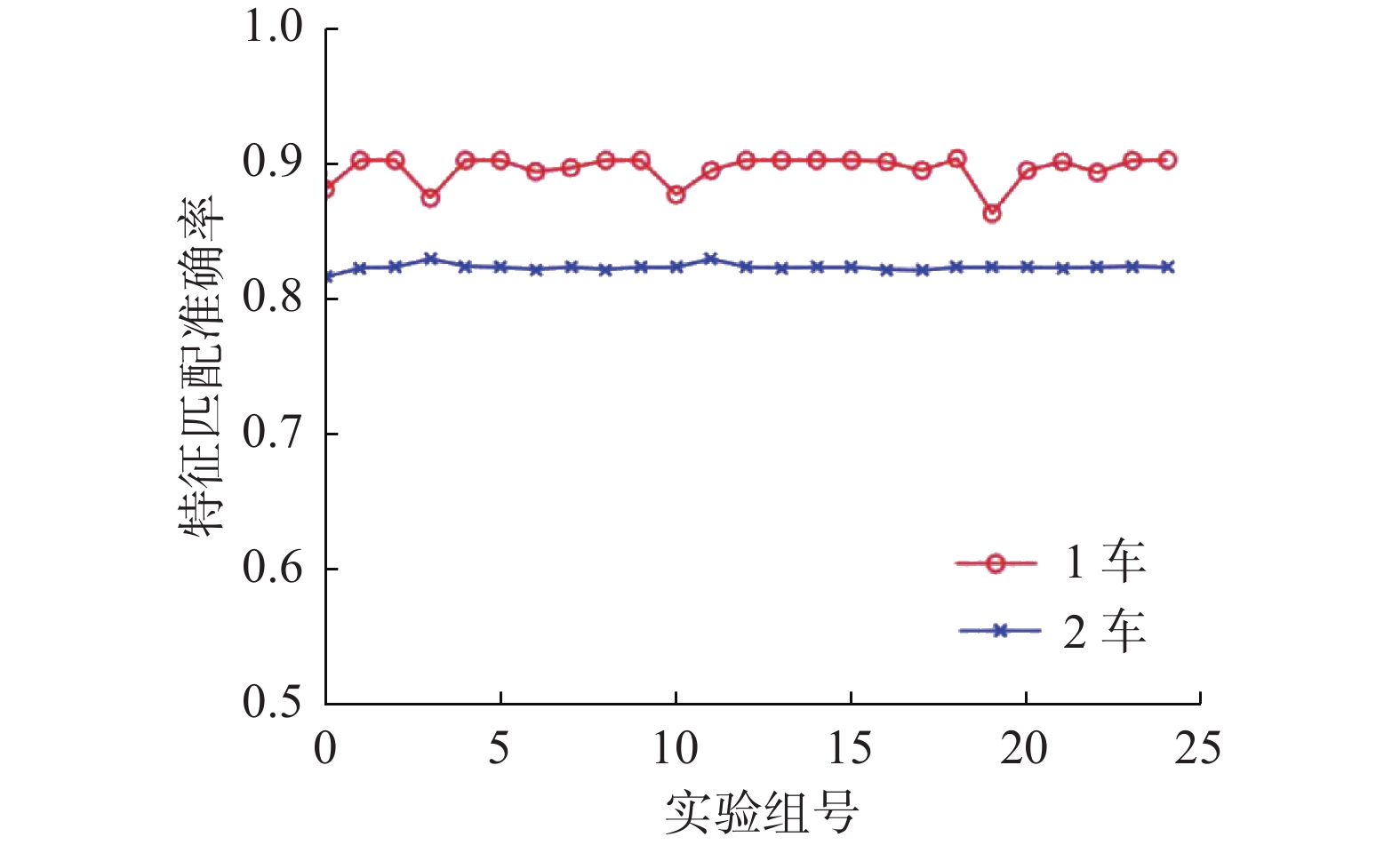

为了验证算法对动车车底故障的检测能力,对CRH380B两种车型共50小组图像本实验开展实验,所有实验组使用的高斯滤波模板尺寸、二值化阈值、开运算卷积核尺寸都是统一的,实验结果如图7和表3所示。

表 3 动车组故障检测实验Table 3 Fault detection experiment of EMU车组 特征匹配

准确率/%识别出故

障区域数实际故

障数量漏检故障

区域数量算法平

均耗时/s1车 89.58 258 40 4 370 2车 82.32 247 35 3 375 表3中,特征匹配准确率为本文所述系统框架下两种车型各25实验小组的WTFE-TIN特征点和ORB特征点的平均匹配准确率,图7中两种车型的匹配准确率均大于80%,实验中所有图像对均存在特征匹配对,较SIFT、SURF和ORB算法更适用于弱纹理区域。TEDS的实际应用中,首要追求的目标是故障不漏检,并未对误检率有明确规定。另外,动车组车底有许多螺栓等微小零件,为了检查到这些小零件区域出现的像素变化,本实验设置的二值化阈值和轮廓滤除阈值较小,容易将其他因为微小噪声产生的变化区域误检测出来。根据表3数据,可以看到在1车和2车分别误检出了218和212个故障区域,分析这些误检测区域的图像发现,这些虚假故障较多发生在动车车轮和车头及其边缘区域,这些区域的车体结构较为简单,引起故障的原因一般是污渍和光照问题,一般不会影响精细故障分类。在实验中,存在少量漏检故障区域,经过查看原始图像数据,发现漏检故障分别为车辆车轴联轴节螺栓松脱、制动夹钳左侧闸片托开口销折叶打开和定子温度传感器线断开,螺栓松脱及开口销折叶区域像素占比很小,定子温度传感器线灰度和开口销折叶灰度与车体底板灰度相近,故障发生前后故障区域像素变化值小于所设定的二值化阈值,且系统将微小轮廓作为噪声滤除,故无法在二值化图中读取到该3种故障区域。由于本文算法提取的特征点数量大,进行特征匹配需要消耗大量计算资源,且根据特征向量特点使用本文匹配方式提高匹配准确率,但此方式会增加算法耗时,尽管增加了Mean-Shift算法减少特征点数量,算法仍有较长的耗时。

4. 结束语

本文针对TEDS故障识别准确率低的问题,提出了适用于弱纹理区域的WTFE-TIN图像配准算法,通过Mean-Shift聚类思想缩减WTFE-TIN特征点数量并设计基于灰度差异和归一化相关系数的匹配方式实现WTFE-TIN特征点匹配。实验表明,WTFE-TIN算法提取的特征点匹配准确率高于80%且所有图像对均存在正确特征匹配对,能适用于TEDS的弱纹理图像。在故障定位上,全部23类故障中,除车辆车轴联轴节螺栓松脱等3种故障未准确定位,对螺栓丢失、车轮闸片丢失、零部件受异物击打变形和存在异物等典型的关键故障有较好的定位效果,对于TEDS的故障识别算法改进有参考价值。后续将研究改进预处理方法,探索新的WTFE-TIN特征描述方式和匹配方法,还将结合图像金字塔方法研究该算法的尺度及旋转不变性以适应更多图像配准场景。

-

表 1 不同特征提取方法对比实验结果

Table 1 Experimental results of different feature extraction methods

特征提取方法 平均每张

标准图像

特征点

数/个平均每张

待配准图

像特征点

数/个匹配准确

率均值/%未存在匹

配对的图

像对数/对WTFE-TIN 11 608 11 610 86.00 0 SIFT 90 92 83.11 3 SURF 189 195 92.74 1 ORB 85 91 69.86 5 表 2 特征点数量阈值参数变化的实验结果

Table 2 Experimental results of threshold parameter changes of number of feature points

特征点数量阈值/个 匹配准确率均值/% 耗时/s 500 44.26 11.4 1 000 62.13 11.9 1 500 76.96 13.1 2 000 77.25 16.1 2 500 80.81 17.9 3 000 81.04 22.1 3 500 82.64 24.4 4 000 82.24 27.8 4 500 82.09 30.4 5 000 82.89 32.7 表 3 动车组故障检测实验

Table 3 Fault detection experiment of EMU

车组 特征匹配

准确率/%识别出故

障区域数实际故

障数量漏检故障

区域数量算法平

均耗时/s1车 89.58 258 40 4 370 2车 82.32 247 35 3 375 -

[1] 刘洋. 关于提升TEDS故障预警准确率的研究[J]. 轨道交通装备与技术, 2019(3): 18–19. LIU Yang. Improving the accuracy of fault early warning for TEDS system[J]. Rail transportation equipment and technology, 2019(3): 18–19. [2] 刘彬. 动车组运行故障图像检测系统(TEDS)运用研究与思考[J]. 中国铁路, 2017(12): 61–65. LIU Bin. Research and thought on trouble of moving EMU detection system(TEDS)[J]. China railway, 2017(12): 61–65. [3] 陈伯施. 科技赋能轨道交通移动装备发展[J]. 铁道车辆, 2021, 59(1): 1–6. CHEN Boshi. Development of rail transit mobile equipment empowered by technology[J]. Rolling stock, 2021, 59(1): 1–6. [4] 杨凯. TEDS动车组故障图像数据库建立技术研究[J]. 铁道机车车辆, 2020, 40(6): 38–42,81. YANG Kai. TEDS EMU fault image database[J]. Railway locomotive & car, 2020, 40(6): 38–42,81. [5] 王锐. 浅谈动车组运行故障动态图像检测系统(TEDS)实践与故障应急处理办法[J]. 工业设计, 2015(8): 80–81. WANG Rui. Discussion on TEDS practice and fault emergency treatment methods[J]. Industrial design, 2015(8): 80–81. [6] 彭丹, 周航. 基于轨边图像SURF特征的动车底部件异常检测算法[J]. 信息系统工程, 2016(2): 127–128. PENG Dan, ZHOU Hang. Anomaly detection algorithm of moving car bottom parts based on SURF feature of rail edge image[J]. China CIO news, 2016(2): 127–128. [7] 彭丹. 基于轨边图像SURF特征的动车底部部件异常检测算法[D]. 北京: 北京交通大学, 2016. PENG Dan. An abnormal detection algorithm of the EMU bottom based on the SURF features of the track-side image[D]. Beijing: Beijing Jiaotong University, 2016. [8] BAY H, TUYTELAARS T, VAN GOOL L. SURF: speeded up robust features[M]//Computer Vision – ECCV 2006. Berlin: Springer Berlin Heidelberg, 2006: 404-417. [9] LOWE D G. Distinctive image features from scale-invariant keypoints[J]. International journal of computer vision, 2004, 60(2): 91–110. doi: 10.1023/B:VISI.0000029664.99615.94 [10] RUBLEE E, RABAUD V, KONOLIGE K, et al. ORB: an efficient alternative to SIFT or SURF[C]//2011 International Conference on Computer Vision. Barcelona: IEEE, 2011: 2564−2571. [11] ROSTEN E, DRUMMOND T. Machine learning for high-speed corner detection[M]//Computer Vision -ECCV 2006. Berlin: Springer Berlin Heidelberg, 2006: 430–443. [12] CALONDER M, LEPETIT V, STRECHA C, et al. BRIEF: binary robust independent elementary features[C]//European Conference on Computer Vision. Berlin: Springer, 2010: 778–792. [13] 丁国绅, 乔延利, 易维宁, 等. 基于光谱图像空间的改进SIFT特征提取与匹配[J]. 北京理工大学学报, 2022, 42(2): 192–199. DING Guoshen, QIAO Yanli, YI Weining, et al. Improved SIFT feature extraction and matching based on spectral image space[J]. Transactions of Beijing institute of technology, 2022, 42(2): 192–199. [14] 胡旻涛, 彭勇, 徐赟. 基于改进SURF的快速图像配准算法[J]. 传感器与微系统, 2017, 36(11): 151–153. HU Mintao, PENG Yong, XU Yun. Fast image matching algorithm based on improved SURF[J]. Transducer and microsystem technologies, 2017, 36(11): 151–153. [15] WEI Yanhui, YANG Pengfei, XU Lixue, et al. An improved SURF algorithm based on gradient and amplitude pre-computation[C]//2019 IEEE International Conference on Mechatronics and Automation. Tianjin: IEEE, 2019: 456–462. [16] HAN Leng, SUN Xia, WANG Jiawei, et al. Research on SURF feature matching algorithm based on lab color space[C]//2020 3rd International Conference on Robotics, Control and Automation Engineering. Chongqing: IEEE, 2020: 116–121. [17] 洪鹏程, 唐垚, 任重. 基于SURF分割圆形区域的图像拼接[J]. 电讯技术, 2021, 61(11): 1424–1430. HONG Pengcheng, TANG Yao, REN Zhong. Image stitching based on SURF segmentation of circular regions[J]. Telecommunication engineering, 2021, 61(11): 1424–1430. [18] 张学峰, 马行, 穆春阳. 基于四叉树的SIFT与K-D树融合的图像匹配研究[J]. 电子测量技术, 2021, 44(22): 121–127. ZHANG Xuefeng, MA Xing, MU Chunyang. Research on image matching based on quadtree fusion of SIFT and K-D tree[J]. Electronic measurement technology, 2021, 44(22): 121–127. [19] WANG Shuoshi, LI Lin. Urban street image matching method based on improved SURF algorithm[C]//Proceedings of 2018 Chinese Intelligent Systems Conference. Singapore: Springer, 2019: 135–144. [20] LEUTENEGGER S, CHLI M, SIEGWART R Y. BRISK: binary robust invariant scalable keypoints[C]//2011 International Conference on Computer Vision. Barcelona: IEEE, 2011: 2548–2555. [21] 章盛, 李培华, 钱名思, 等. 融入曲率尺度空间算法的图像配准方法[J]. 激光与红外, 2021, 51(3): 379–387. ZHANG Sheng, LI Peihua, QIAN Mingsi, et al. Image registration method based on curvature scale space algorithm[J]. Laser & infrared, 2021, 51(3): 379–387. [22] RAMYA P P, AJAY J. Object recognition and classification based on improved bag of features using surf and mser local feature extraction[C]//2019 1st International Conference on Innovations in Information and Communication Technology. Chennai: IEEE, 2019: 1–4. [23] 陈伟, 刘宇, 王亚伟, 等. 基于改进的FAST-SURF快速图像拼接算法[J]. 应用光学, 2021, 42(4): 636–642. doi: 10.5768/JAO202142.0402001 CHEN Wei, LIU Yu, WANG Yawei, et al. Fast image stitching algorithm based on improved FAST-SURF[J]. Journal of applied optics, 2021, 42(4): 636–642. doi: 10.5768/JAO202142.0402001 [24] 李国竣, 徐延海, 段杰文, 等. 利用局部自适应阈值方法提取ORB-SLAM特征点[J]. 测绘通报, 2021(9): 32–36,48. LI Guojun, XU Yanhai, DUAN Jiewen, et al. ORB-SLAM method based on local adaptive threshold extraction feature points[J]. Bulletin of surveying and mapping, 2021(9): 32–36,48. [25] 毛敏. 基于宽基线的弱纹理特征点提取与描述方法研究[D]. 上海: 东华大学, 2014. MAO Min. Research on Point Detector and Descriptor for Textureless Object Surface Based on Wide Baseline Stereo[D]. Shanghai: Donghua University, 2014. [26] 马东岭, 毛力波, 吴鼎辉, 等. 一种顾及纹理特征的自适应密集匹配方法[J]. 测绘科学, 2022, 47(2): 70–78,101. MA Dongling, MAO Libo, WU Dinghui, et al. An adaptive dense matching method considering texture features[J]. Science of surveying and mapping, 2022, 47(2): 70–78,101. [27] 程鹏飞, 周修庄, 唐玲, 等. 一种面向弱纹理图像的特征点描述子[J]. 北京邮电大学学报, 2021, 44(6): 13–19. CHENG Pengfei, ZHOU Xiuzhuang, TANG Ling, et al. A feature point descriptor for texture-less images[J]. Journal of Beijing University of Posts and Telecommunications, 2021, 44(6): 13–19. [28] 章毓晋. 图像工程[M]. 4版. 北京: 清华大学出版社, 2018: 257-258.

下载:

下载: