Cooperative tracking of unmanned surface vessels at sea inspired by a multi-resolution mechanism of raptor vision

-

摘要: 针对海上无人艇跟踪过程中大场景与高分辨间的矛盾问题,本文提出一种仿猛禽视觉多分辨率机制的海上目标无人艇协同跟踪方法。模拟猛禽双中央凹多分辨率成像规律,构建目标无人艇跟踪大小场景;在大场景中,模拟猛禽视顶盖−峡核通路中视觉刺激的竞争选择机制进行海上无人艇显著性检测,用于纠正核相关滤波目标跟踪的结果;在小场景中,建立仿猛禽色彩分辨空间,并采用颜色显著性检测方法提取无人艇上的合作靶标;建立大场景纠正及小场景引导协同跟踪策略,实现对海上目标无人艇的协同跟踪。对比实验结果表明,本文方法的跟踪成功率高于对比方法,且有最高的平均重叠率和最低的平均像素误差,适于无人机完成对海上目标无人艇的跟踪任务。Abstract: In this paper, a cooperative tracking method of unmanned surface vessel (USV) at sea inspired by a multi-resolution mechanism of raptor vision is proposed to solve the contradiction between large scene and high resolution at sea. The large and small scenes of the target USV tracking are built based on the multi-resolution imaging rules of dual fovea of raptor vision. In the large scene, the competitive selection mechanism in the optic tectum- nucleus isthmi pathway of raptor is employed to detect the saliency target of USV. The detection results are applied to correct the tracking position of kernel correlation filter. In the small scene, the color resolution space imitating raptor is built, and the cooperative target on the USV is obtained by the color saliency detection method. The cooperative tracking strategy with large scene correction and small scene guiding is established to achieve cooperative tracking of USV at sea. The comparison experiment results show that the tracking success rate of the proposed method is higher than that of the comparison method. Besides, the proposed method has the highest average overlap rate and the lowest average pixel error. The proposed method is suitable for unmanned aerial vehicle(UAV) to track the USV at sea.

-

智能化无人系统逐渐成为未来战争和科技发展的中坚力量,多元化、立体化、异构化、跨域化逐渐成为无人系统发展的重要方向[1]。自2017年美国海军水面舰艇协会年会公布了由一艘无人艇(unmanned surface vessel,USV)携带多架无人机(unmanned aerial vehicle,UAV)在海上执行作战任务的空海协同系统概念图[2]以来,无人机/无人艇跨域异构系统引起世界各个国家的广泛关注。无人机/无人艇跨域异构系统既能弥补无人机续航能力差的问题,又能克服无人艇搜索距离受限的缺点,从而有效地提高整个异构系统的作业水平和效率。

无人机对海上合作无人艇的准确识别及稳定跟踪是无人机/无人艇跨域异构系统的关键技术[2]。但受实际场景中光照条件、鱼鳞光、海面波光、海浪遮挡等外界环境因素及无人艇的运动方向、运动速度、尺寸形变等自身因素的影响,使得无人机在对海上运动无人艇进行跟踪时,极易造成目标无人艇的丢失。此外,准确提取无人艇上合作靶标的特征,对无人机在大范围内追踪目标无人艇提出了挑战。因此,解决大视场和高分辨率的矛盾成为海上无人机追踪目标无人艇的最大难题。

视觉目标跟踪一直是计算机视觉领域的一大研究热点[3]。基于相关滤波(correlation filter,CF)和深度学习的目标跟踪方法成为运动目标跟踪的主流。核相关滤波(kernel correlation filter,KCF)作为经典的目标跟踪算法通过循环矩阵和傅里叶空间等手段[4-6],极大提升了运算速度。采用核相关滤波的目标跟踪算法还包括循环矩阵检测跟踪滤波器(circulant structure of tracking-by-detection with kernels,CSK)[7]、时空正则化相关滤波器(spatial-temporal regularized correlation filters,STRCF)[8]、尺度分辨空间跟踪器(discriminative scale space tracker,DSST)[9]和快速尺度分辨空间跟踪器(fast discriminative scale space tracker,fDSST)[10]等方法,但现有的目标跟踪方法大多是基于单分辨率成像条件下实现跟踪的,对于场景的适应能力不高,且无法辨别其所跟踪的目标是否是其合作的对象。

深度学习作为计算机视觉领域的重要分支,涌现出多种鲁棒性较强的运动目标跟踪方法,分为基于卷积神经网络和其他跟踪方式的目标跟踪方法和基于端到端神经网络的目标跟踪方法。最早基于深度学习的目标跟踪方法是由Wang等[11]提出的深度学习跟踪器(deep learning tracker, DLT)目标跟踪方法。其他比较典型的目标跟踪网络包括由Nam[12]提出的基于多域网络(multi-domain network, MDNet)目标跟踪方法和Wang等[13]提出的基于全卷积网络的目标跟踪方法(fully convolutional networks tracking, FCNT)等。SiamMask目标跟踪方法[14]和SiamRPN++目标跟踪方法[15]的性能超过了传统目标跟踪方法。虽然深度学习方法跟踪精度高,但是它依赖训练数据集和图像处理器,检测速度受限,对处理器性能要求较高,增加了算法移植到机载处理器的难度。因此,面对复杂多变的海面环境时,无人机机载视觉系统利用现有方法很难适应各种作业环境并实时准确地跟踪到目标无人艇,且无法通过其他场景探测到所跟踪无人艇的细节信息。

仿生视觉技术的发展为计算机视觉信息处理提供了新的技术手段[16]。猛禽作为鸟类六大类之一,具有最敏锐的视觉[17]。猛禽视网膜上有2个中央凹,即正中央凹和侧中央凹,分别在高空巡游和正面抓捕2种情况下起着重要的作用[18]。猛禽视野宽广[19],能在大场景内迅速探测并跟踪猎物,当出现猎物在猛禽视野中丢失再出现时,猛禽能迅速重新锁定猎物。此外,猛禽视网膜神经节细胞呈非均匀分布[20],能以多种分辨率轻松捕获猎物的细节特征。因此,猛禽视觉系统兼顾了大场景搜索跟踪与小场景细节特征提取的优势[21],较好地解决传统光学系统的大视场与高分辨率之间的矛盾,也为本文研究提供了较好的解决思路。

本文在上述猛禽视觉多分辨率机制分析基础上,采用短焦相机(大场景)和长焦相机(小场景)构建仿猛禽视觉多分辨率机制的大小场景,其中短焦相机具备大视场,长焦相机具备高分辨率。假设2相机共光轴,那么当目标无人艇位于其中一个相机的视野中央时,目标无人艇也一定会处于另一个相机的视野中央。在大场景中,构建仿猛禽视觉的大场景无人艇显著性检测方法,并用于纠正KCF算法的跟踪结果,实现对大场景中无人艇目标的实时跟踪。在小场景中,建立仿猛禽视觉的色彩分辨空间,采用颜色显著性检测方法提取无人艇上合作目标的细节特征。同时,设计大场景对小场景的纠正策略和小场景对大场景的引导策略,兼容了大场景搜索跟踪与小场景细节特征提取功能,共同实现对海上目标无人艇的协同跟踪。

1. 仿猛禽视觉大场景无人艇跟踪

面对复杂的捕食环境,猛禽能够快速排除背景中的干扰信息且精准锁定猎物,这与猛禽视觉系统中的视觉注意机制密切相关。猛禽视觉信息处理主要由离顶盖通路、离丘脑通路、离中枢通路和副视通路四大通路组成[22],视觉注意主要发生在离顶盖通路中。猛禽的视觉注意过程存在视觉刺激之间的竞争选择现象,当多个刺激共同作用时,竞争力更强的视觉刺激才能进一步被大脑处理。

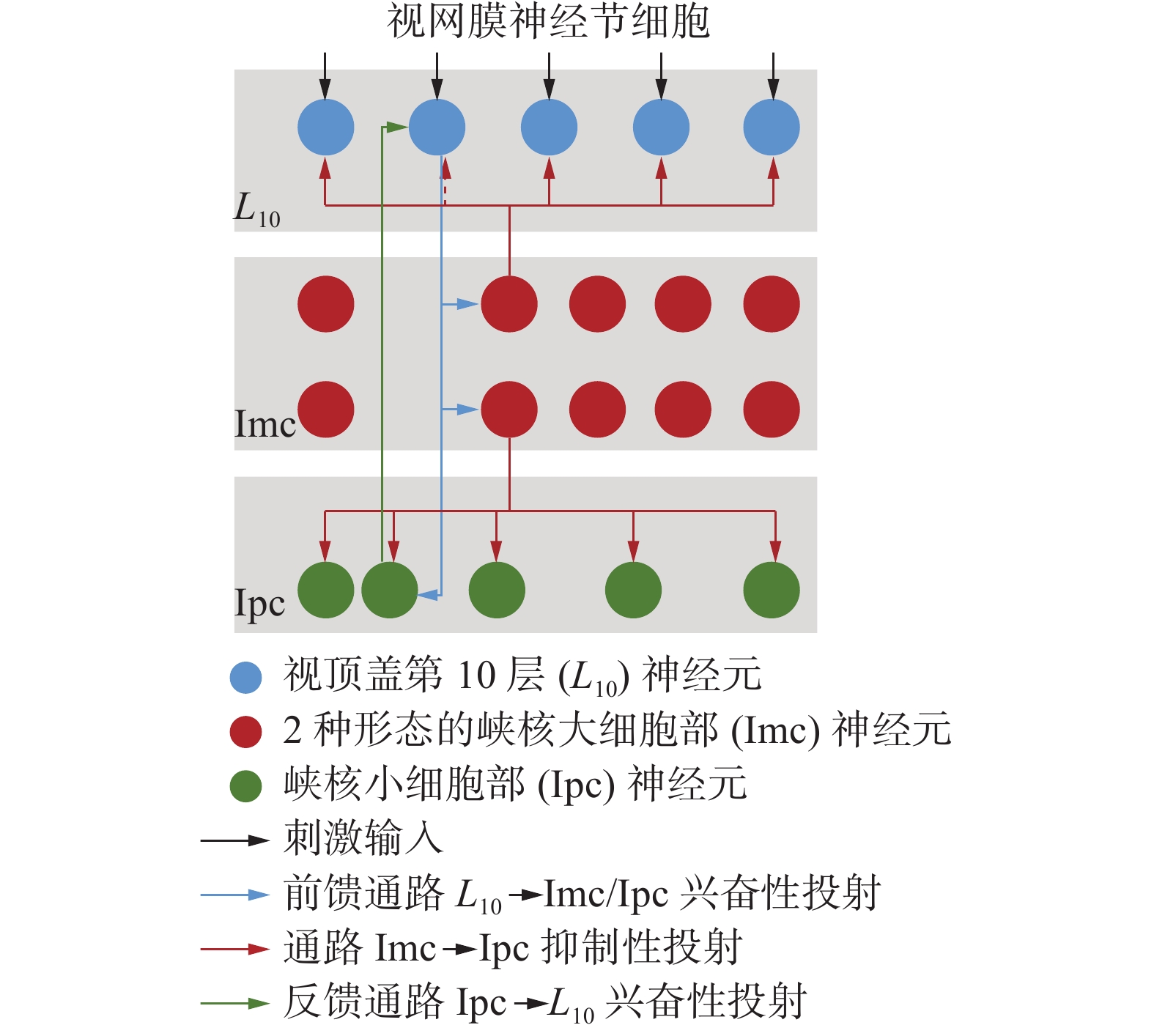

视顶盖−峡核通路是离顶盖通路的一个主要侧支,由视顶盖(optic tectum, OT)第10层神经元(

$L_{10}$ )、峡核大细胞部(nucleus isthmi pars magnocellularis,Imc)和峡核小细胞部(nucleus isthmi pars parvocellularis,Ipc)组成[23],如图1所示,三者共同参与猛禽视觉刺激的竞争选择,具有强竞争力的视觉刺激被逐级筛选,成为猛禽视觉系统的视觉注意对象。此外,猛禽视野宽广,能利用上述机制在大场景内迅速探测并跟踪猎物,且当出现猎物在猛禽视野中丢失再出现时,猛禽也能迅速重新锁定猎物。受猛禽捕猎行为中视觉处理方式的启发,采用猛禽视顶盖−峡核通路刺激的竞争选择机制获取复杂未知海面环境中的无人艇目标。由视觉的布尔图理论可知[24],猛禽视觉在某一时刻仅能捕获单维度的特征,多个特征融合才能形成最终的视觉选择结果。在海上无人艇目标的检测过程中,目标易受亮度、波光及海浪等信息的影响。色彩的色度、饱和度和明度(hue, saturation, value, HSV)颜色空间中的H通道能够有效抑制海面鱼鳞光及耀光对显著性检测的影响。颜色−对立(lab color space, Lab)空间中的L通道在消除海面异常颜色方面有比较显著的作用。此外,猛禽视网膜上的光感受器在捕猎时发挥着极其重要的作用,将其归纳为明视觉通道和暗视觉通道。因此,本文将从L通道、H通道、明视觉通道和暗视觉通道4个特征通道中提取图像的特征,更全面地模拟猛禽视觉系统所感受的视觉特征。

对输入图像

${\boldsymbol{ I}} $ ,仿猛禽视觉的明视觉通道表示为$$ B = \mathop {\max }\limits_{p \in \varOmega } \left( {\mathop {\max }\limits_{{{c}} \in \left\{ {r,g,b} \right\}} {I_{{{c}}}}\left( p \right)} \right) $$ (1) 式中:

$ p = \left( {x,y} \right) $ 为图像中的像素点;$ \varOmega $ 为以$ p $ 为中心的图像块;${I_{{{c}}}}$ 为输入图像$ {\boldsymbol{I}} $ 的${{c}}$ 颜色通道;$\left\{ {r,g,b} \right\}$ 分别为图像$ {\boldsymbol{I}} $ 的红色、绿色、蓝色通道。同理,仿猛禽视觉的暗视觉通道表示为

$$ D = \mathop {\min }\limits_{p \in \varOmega } \left( {\mathop {\min }\limits_{{{c}} \in \left\{ {r,g,b} \right\}} {I_{{{c}}}}\left( p \right)} \right) $$ (2) 考虑充分利用图像的细节信息,分别在图像的L、H、B和D通道生成一系列布尔特征图,即通过在每个通道上分别取不同阈值

$ \theta $ 下的二值图,可表示为$$ {B_{{{C}}}} = {\rm{ThreVal}}\left( {{{C}},\theta } \right),{{C}} \in \left\{ {L,H,B,D} \right\} $$ (3) 式中:

${{C}}$ 为图像的特征通道,阈值$ \theta $ 的取值呈均匀分布。生成布尔特征图的阈值分割函数表示为$$ {\rm{ThreVal}}\left( {a,\theta } \right) = \left\{ {\begin{array}{*{20}{c}} 1,&{a \geqslant \theta } \\ 0,&{{\rm{其他}}} \end{array}} \right. $$ (4) 式中

$ a $ 为图像$ {\boldsymbol{I}} $ 中像素的像素值。不同特征通道生成的布尔特征图像序列表示为

$$ {B_{{{C}}}} = \left\{ {{B_{{{{C}}_1}}},{B_{{{{C}}_2}}}, \cdots ,{B_{{{{C}}_i}}}, \cdots ,{B_{{{{C}}_N}}}} \right\} $$ (5) 式中:

$ N $ 为图像$ {\boldsymbol{I}} $ 在${{C}}$ 特征通道所生成的布尔特征个数;${B_{{{{C}}_i}}}$ 为分割阈值为${\theta _i} \sim U\left( {0,255} \right)$ 时的布尔特征图。利用基于布尔映射的显著性(Boolean map based saliency,BMS)模型[25]对上述布尔特征图进行处理,对应布尔特征图${B_{{{{C}}_i}}}$ 的初级视觉注意图为$$ {A_{{{{C}}_i}}}\left( {{B_{{{{C}}_i}}}} \right) = \frac{{{A^ + }\left( {{B_{{{{C}}_i}}}} \right)}}{{{{\left\| {{A^ + }\left( {{B_{{{{C}}_i}}}} \right)} \right\|}_2}}} + \frac{{{A^ - }\left( {{B_{{{{C}}_i}}}} \right)}}{{{{\left\| {{A^ - }\left( {{B_{{{{C}}_i}}}} \right)} \right\|}_2}}} $$ (6) 式中:

${A^ + }\left( {{B_{{{{C}}_i}}}} \right)$ 和${A^ - }\left( {{B_{{{{C}}_i}}}} \right)$ 分别为子激活图[25]的视觉响应图;$ {\left\| \cdot \right\|_2} $ 为二范数。将各通道所有布尔特征图形成的视觉响应加权求和结果用于生成输入到猛禽视觉系统的刺激,即所生成的猛禽视觉刺激为$$ {S _j} = {S_{{{C}}}} = \sum\limits_{i = 1}^N {{A_{{{{C}}_i}}}\left( {{B_{{{{C}}_i}}}} \right)p\left( {{B_{{{{C}}_i}}}|{I_{{{C}}}}} \right)} ,j = 1,2,3,4 $$ (7) 式中

$p\left( {{B_{{{{C}}_i}}}|{I_{{{C}}}}} \right)$ 为布尔特征分布权重,表示为$$ p\left( {{B_{{{{C}}_i}}}|{I_{{{C}}}}} \right) = \frac{1}{N} $$ (8) 采用信息熵衡量输入猛禽视觉系统中各个视觉刺激的强度为

$$ H\left( {{S _j}} \right) = - \sum\limits_{i = 1}^M {{p_i}\log {p_i}} $$ (9) 式中:

$ {p_i} $ 为显著值$ i $ 占显著图中所有显著值的比例,$ M $ 为显著图中的最大显著值。在猛禽的视顶盖−峡核通络中,采用

$ {\omega _{ij}} $ 描述神经元$ i $ 和神经元$ j $ 间的刺激竞争关系。采用不同神经元之间信息熵间的关系,重构不同刺激之间的竞争选择关系矩阵为$${\omega _{ij}} = - \frac{{1/1H\left( {{S _j}} \right) - 1/H\left( {{S _i}} \right)}}{{1\bigg/\displaystyle\sum\limits_{i = 1}^4 {H\left( {{S _i}} \right)} }},i \ne j $$ (10) 当

$ {\omega _{ij}} < 0 $ 时,新刺激${S _j}$ 比原刺激${S _i}$ 的信息量更大,原视觉刺激在一定程度上被抑制。反之,原刺激保持或增强。任选刺激

${S _i},i = 1,2,3,4$ 作为输入到猛禽视网膜的初始刺激,其余刺激${S _j},j = 1,2,3,4$ 且$ j \ne i $ 被分配为竞争刺激,与${S _i}$ 之间形成竞争,仿猛禽视觉刺激竞争选择机制的显著性检测结果为$$ S = {S _i} + \sum\limits_{j = 1,j \ne i}^4 {{\omega _{ij}} \cdot {S _j}} $$ (11) 对

$ S $ 进行自适应阈值分割,获取最大连通域的正外接矩形,即仿猛禽视觉刺激竞争选择的显著性检测方法获得的无人艇目标位置为$$ {P_{{\rm{eagle}}}} = \left[ {{x_e},{y_e},{w_e},{h_e}} \right] $$ (12) 式中:

$ \left( {{x_e},{y_e}} \right) $ 为海上无人艇目标框左上角坐标位置,$ {w_e} $ 为目标框的宽度,$ {h_e} $ 为目标框的高度。采用仿猛禽视觉显著性检测结果纠正KCF跟踪结果,最终仿猛禽视觉大场景无人艇跟踪结果为

$$ P = {\omega _1} {P_{{\rm{KCF}}}} + {\omega _2}{P_{{\rm{eagle}}}} ,{\omega _1} + {\omega _2} = 1 $$ (13) 式中:

$ {P_{{\rm{KCF}}}} $ 为KCF跟踪结果,$ {\omega _1} $ 和$ {\omega _2} $ 分别为KCF跟踪结果与仿猛禽视觉显著性检测结果的权重。2. 仿猛禽视觉小场景靶标提取

猛禽具有高时间分辨率和高空间分辨率,能够清晰地捕获快速移动猎物的轨迹和细节特征,且能有效避免猎物因高速运动而产生的图像模糊[26]。颜色是大脑产生的感觉,昼行性猛禽的视网膜中分布着4种类型的视锥细胞,每个视锥细胞中含有油滴,使猛禽拥有红、绿、蓝和紫外4色视觉。除此之外,猛禽的视锥细胞间呈高度有序分布,称为“超齐构体”。这种分布特点使得猛禽在拥有四色颜色机制的同时,还增加了色彩分辨的稳定性。无人机跟踪正确的目标无人艇是提高异构平台工作效率的前提,为了在小场景内获取准确的无人艇合作靶标,利用猛禽对颜色敏感的特性提取无人艇上合作靶标的信息。

常用图像的编码形式大多为RGB (red, green, blue)图像,为了更接近猛禽视觉的生理特性,模拟猛禽视觉的四色机制,构建仿猛禽色彩分辨空间(long, medium and short, LMS),即

$$ \left\{ \begin{aligned} L &= \max \left( {0,\min \left( {r - g,r - b} \right)} \right) \\ M &= \max \left( {0,\min \left( {g - r,g - b} \right)} \right) \\ S &= \max \left( {0,\min \left( {b - r,b - g} \right)} \right) \\ U &= {{\left( {r + g + b} \right)} \mathord{\left/ {\vphantom {{\left( {r + g + b} \right)} 3}} \right. } 3} \\ \end{aligned} \right. $$ (14) 式中:R、G、B分别为RGB颜色空间的红、绿、蓝通道;L、M、S、U分别为猛禽色彩分辨空间的长波、中波、短波和紫外通路图像。

在仿猛禽视觉的色彩分辨空间中,定义图像中像素

$ {p_i} $ 的颜色显著值为$$ S\left( {{p_i}} \right) = \sum\limits_{j = 1}^m {d\left( {{p_i},{p_j}} \right)} ,i \ne j $$ (15) 式中:

$ m $ 为图像中像素的个数;$ d\left( \cdot \right) $ 为2像素的颜色距离,表示为$$ d\left( {{p_i},{p_j}} \right) = \sqrt {{{\left( {{L_i} - {L_j}} \right)}^2} + {{\left( {{M_i} - {M_j}} \right)}^2} + {{\left( {{S_i} - {S_j}} \right)}^2} + {{\left( {{U_i} - {U_j}} \right)}^2}} $$ (16) 相同颜色像素的颜色显著值相同,则目标颜色

$ {c_i} $ 的显著图可表示为$$ S\left( {{c_i}} \right) = \frac{{{m_{{c_i}}}}}{m}\sum\limits_{j = 1}^m {d\left( {{p_i},{p_j}} \right)} ,i \ne j $$ (17) 式中

$ {m_{{c_i}}} $ 为图像中出现颜色$ {c_i} $ 的个数。将

$ S\left( {{c_i}} \right) $ 二值化,最大连通域即为小场景中的目标所在区域。3. 多分辨率大小场景协同策略

猛禽视网膜神经节细胞呈非均匀分布,存在多种分辨率,在中央凹处密度最大,分辨率最高。猛禽中央凹在处理图像放大、聚焦平面和运动检测等视觉信息起着重要的作用,能够在跟踪猎物的同时也捕获猎物的细节特征[27]。因此,猛禽视觉系统兼顾了大场景(短焦相机,焦距为3.6 mm)搜索跟踪与小场景(长焦相机,焦距为12 mm)细节特征提取的优势,较好地解决传统光学系统在的大视场与高分辨率之间的矛盾。

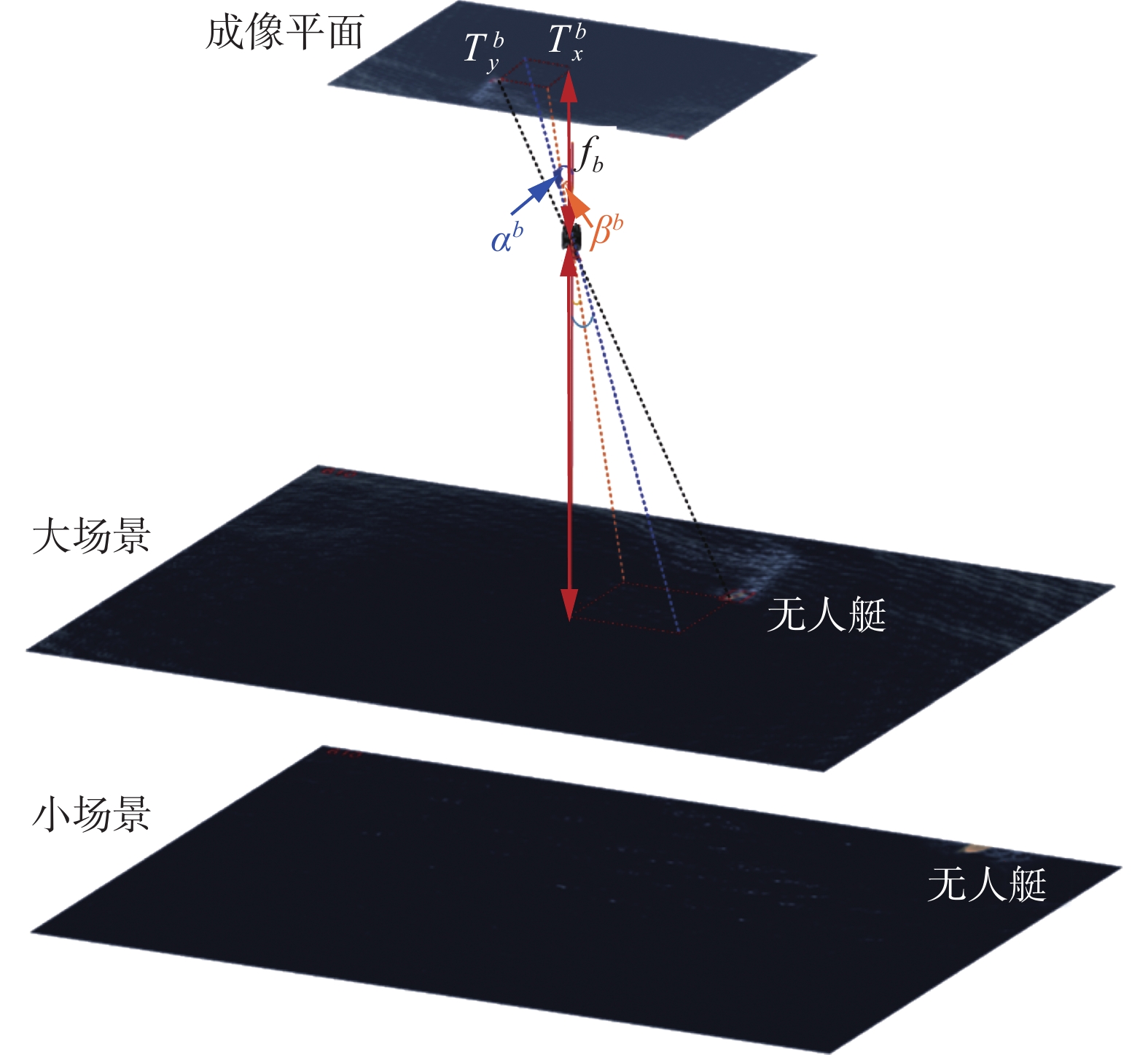

3.1 大场景对小场景的纠正策略

长焦相机(小场景)由于视场小,无人艇更容易移出相机视野,而短焦相机(大场景)视场较大,由于2场景共光轴,此时无人艇可能还在大场景中,通过缩小大场景中相机与目标无人艇间的夹角,使得无人艇靠近大场景的图像中心,由此无人艇就可重新出现在小场景中,进而获取更多的无人艇合作靶标的细节信息。大场景对小场景的纠正作用的示意图如图2所示。

在大场景中,无人艇偏离图像中心的角度为

$$ \left\{ \begin{gathered} {\alpha ^b} = {\rm{arctan}} \frac{{T_x^b \cdot \Delta u}}{{{f_b}}} \\ {\beta ^b} = {\rm{arctan}} \frac{{T_y^b \cdot \Delta v}}{{{f_b}}} \\ \end{gathered} \right. $$ (18) 式中:

$ {f_b} $ 为短焦相机的焦距;$ {f_s} $ 为短焦相机的焦距;$ {\alpha ^b} $ ($ x $ 方向)和$ {\beta ^b} $ ($ y $ 方向)为大场景中无人艇偏离图像中心的角度;$ T_x^b $ ($ x $ 方向)和$ T_y^b $ ($ y $ 方向)为图像中无人艇偏离中心点的像素个数;$ \Delta u $ ($ x $ 方向)和$ \Delta v $ ($ y $ 方向)为相机的成像平面的像元尺寸(相机固有参数,假设长焦相机和短焦相机的像元尺寸相同)。通过缩小大场景中无人艇的偏离角

$ {\alpha ^b} $ 和$ {\beta ^b} $ ,使得无人艇靠近图像中心,由于大小场景共光轴,无人艇也将重新回到小场景中,并靠近小场景图像的中心位置。3.2 小场景对大场景的引导策略

短焦相机(大场景)由于视场大,视野中更容易出现非目标无人艇等其他干扰船只或漂浮物的影响。小场景能够利用其远距离探测能力获得目标无人艇上合作靶标的细节信息,进而剔除大场景中的干扰目标。小场景对大场景的引导作用的示意图如图3所示。

在小场景中,可根据仿猛禽颜色显著性检测确定唯一的目标无人艇,小场景引导大场景策略可以表示为

$$ \left\{ \begin{gathered} \alpha _1^s = \alpha _i^b \\ \beta _1^s = \beta _i^b \\ \end{gathered} \right.,i = 1,2, \cdots ,{N_{{\rm{usv}}}} $$ (19) 式中:

$ \alpha _1^s $ ($ x $ 方向)和$ \beta _1^s $ ($ y $ 方向)为合作目标无人艇在小场景中的偏离角(其计算方式与式(18)相同),$ \alpha _i^b $ ($ x $ 方向)和$ \beta _i^b $ ($ y $ 方向)为大场景中不同无人艇的偏离角,$ {N_{{\rm{usv}}}} $ 为大场景中无人艇的个数。3.3 目标无人艇的协同跟踪

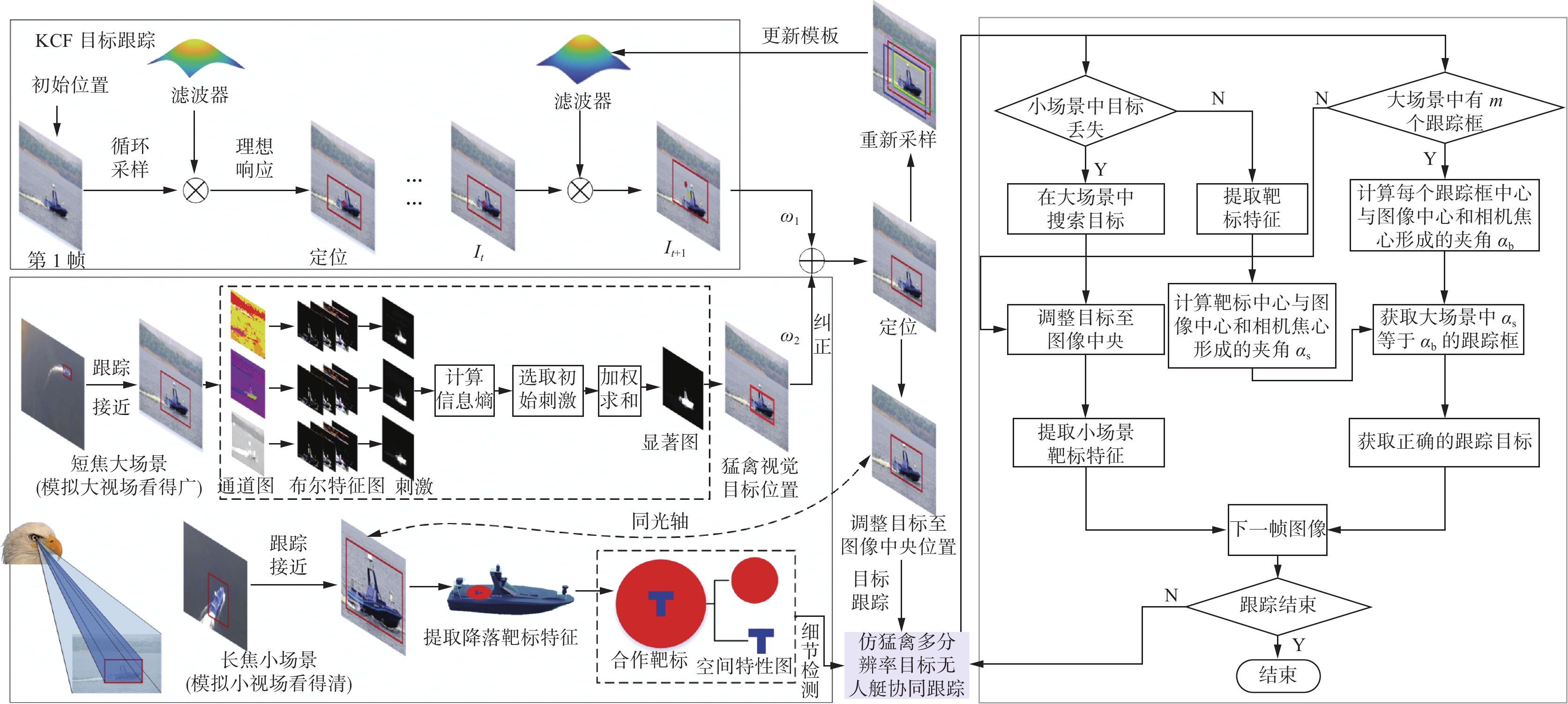

综上所述,仿猛禽视觉多分辨率的海上无人艇协同跟踪方法流程如图4所示。

具体步骤如下:

1)选取特征通道及其布尔特征。获取图像的L通道、H通道、亮通道和暗通道作为仿猛禽视觉显著性检测的特征图像通道,利用式(3)和式(5)获取各通道的布尔特征序列。

2)生成仿猛禽视觉刺激。利用式(7)获取输入到猛禽视顶盖−峡核通路的视觉刺激。

3)计算视觉刺激的强度。通过式(9)信息熵计算步骤2)中输入到猛禽视网膜中视觉刺激的竞争强度。

4)重建刺激竞争−选择关系矩阵。通过式(10)重构神经元

$ i $ 和神经元$ j $ 之间的刺激竞争选择关系矩阵$ {{\boldsymbol{\omega}} _{ij}} $ 。5)获取仿猛禽视觉显著性检测结果。利用式(11)生成仿猛禽视觉刺激竞争选择机制的显著性检测结果

$ S $ 和其最小外接矩形${P_{{\rm{eagle}}}}$ 。6)生成初级目标跟踪结果。采用KCF跟踪算法,获得目标跟踪结果

${P_{{\rm{KCF}}}}$ 。7)计算无人艇修正结果。将步骤5)、6)的结果进行加权求和,获取仿猛禽视觉大视场的无人艇跟踪结果

$ P $ 。8)构建仿猛禽色彩分辨空间。根据式(14)构建仿猛禽色彩分辨空间。

9)提取靶标。设置颜色分割阈值,根据式(17)精确分辨小场景中合作靶标的所在区域。

10)计算大场景中无人艇的偏离角。根据式(18)计算大场景中所有检测到的无人艇偏离相机中心的夹角。

11)计算小场景中无人艇的偏离角。采用与步骤10)相同的方法计算小场景中无人艇合作靶标偏离相机中心的角度。

12)多分辨率无人艇协同跟踪。当小场景中的目标无人艇丢失时,利用大场景的纠正策略迅速将无人艇拉回至视野中央,以纠正小场景中的无人艇跟踪位置。当大场景中出现其他干扰目标时,利用小场景的引导策略为大场景提供正确的引导信息。通过大小场景的相互协同策略,共同实现无人机对目标无人艇及合作靶标的跟踪与检测。

4. 结果分析

4.1 参数敏感性分析

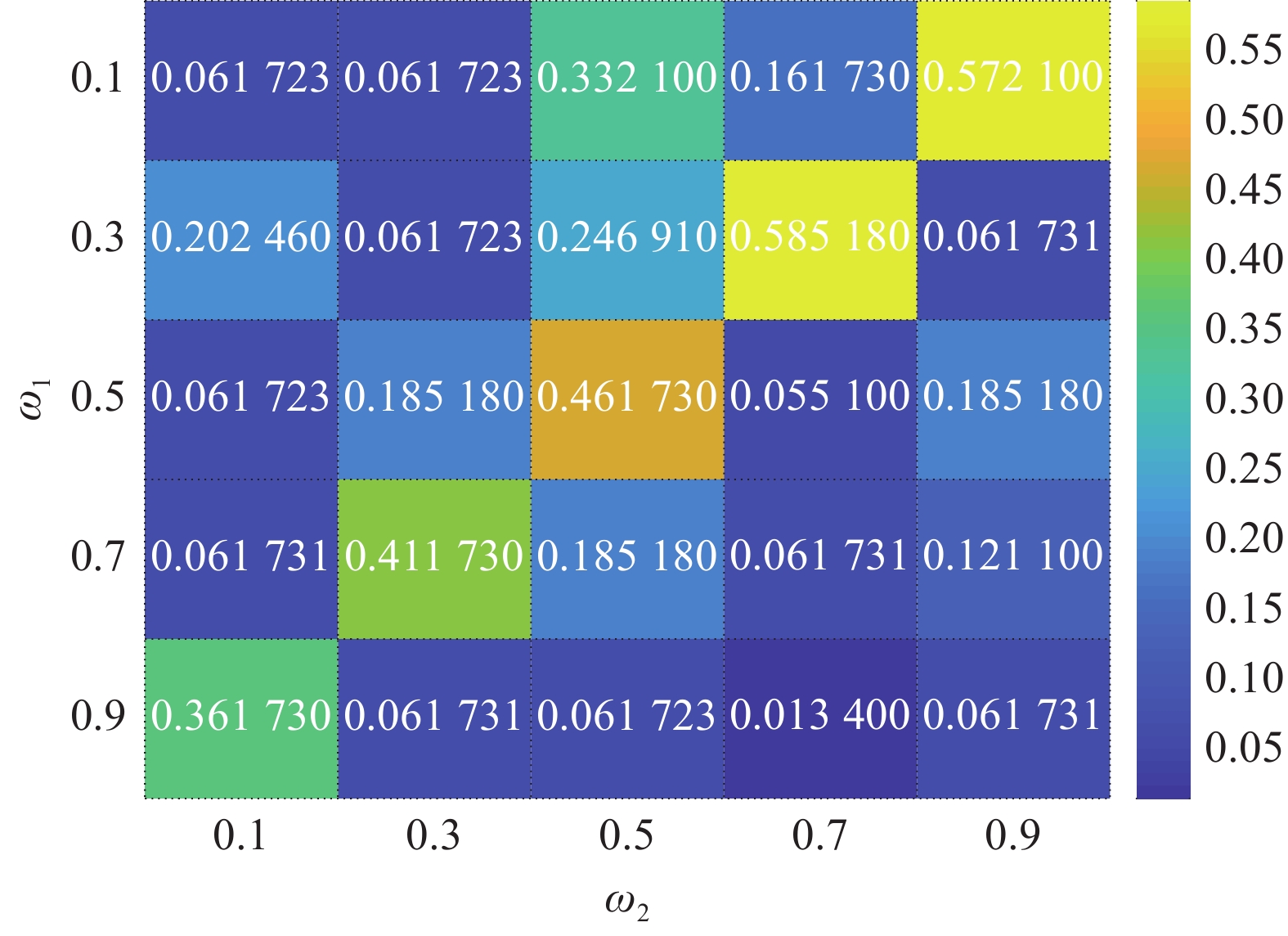

$ {\omega _1} $ 和$ {\omega _2} $ 是本文方法的2个重要参数,以算法预测跟踪框和真实跟踪框的平均重叠率为评价指标,$ {\omega _1} $ 和$ {\omega _2} $ 的参数敏感度分析结果如图5所示,$ {\omega _2} $ 的取值对跟踪算法的性能影响较大。当$ {\omega _1} = 1 $ 时,算法退化为KCF目标跟踪方法,当$ {\omega _2} = 1 $ 时,算法退化为仿猛禽视觉刺激竞争选择机制的显著性检测方法。本文方法中$ {\omega _1} $ 和$ {\omega _2} $ 分别取0.7和0.3。4.2 Unity3D仿真场景

在Unity3D仿真场景对仿猛禽视觉多分辨率的海上无人艇协同跟踪方法进行验证。图6(a)为仅在小场景中对海上无人艇目标进行跟踪的结果,目标极易丢失,且丢失后很难再跟踪。如图6(b)、(c)所示,采用大小场景进行海上目标无人艇跟踪时,如第275帧所示,虽然无人艇在小场景中丢失,但在大场景中仍可以准确追踪到,通过缩小大场景中无人艇的偏离角,使目标无人艇趋近大场景中心,同时小场景会重新准确捕获到目标无人艇,如664帧所示。

如图7(a)所示,当仅在大场景中采用本文第2节所提出的目标跟踪方法跟踪无人艇时,由于引入仿猛禽视觉显著性检测结果,使得跟踪结果出现多个目标框,但是无法判断唯一的目标无人艇。首先,通过小场景的远视能力探测无人艇的细节特征,从而确定小场景中的目标无人艇位置。如图7(b)所示,通过在小场景中检测无人艇上的红色嵌套靶标,确定唯一目标无人艇。根据无人艇的偏离角确定并引导大场景跟踪目标无人艇。如图7(c)所示,仅带有合作目标的无人艇被选择且被稳定跟踪。大小场景相互纠正导引,实现了大场景中对目标无人艇的准确跟踪及小场景内对艇上合作靶标的精准锁定。

4.3 真实验证场景

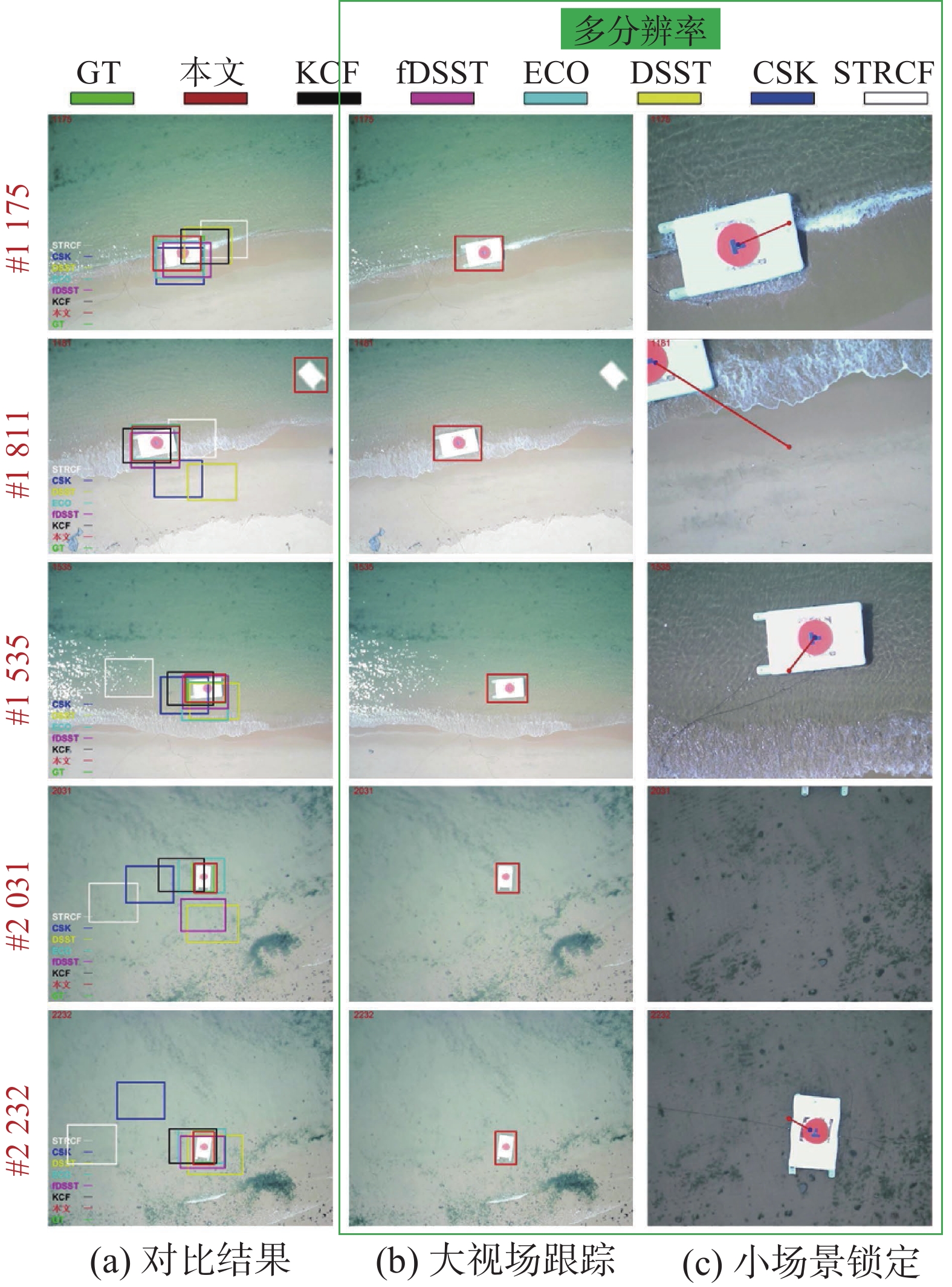

为进一步验证算法在实际作业环境中对目标无人艇的跟踪性能,分别采用外场无人机实际飞行中采集的水面和海面无人艇图像序列(下视场景为主)对本文所提出的方法进行验证。2组图像序列分别为无人机机腹处平行安装(假设共光轴)的长焦相机(焦距为12 mm)和短焦相机(焦距为3.6 mm)共同工作时捕获的。此外,采用多种方法与其对比(采用短焦相机捕获的图像),主要包括:CSK、STRCF、基于卷积算子的跟踪器(efficient convolution operators for tracking,ECO)[28]、DSST、fDSST和KCF。

在水面验证场景中,当无人艇始终处于相机视野中央时,各算法的跟踪性能基本相似,跟踪精度略有差异。3877帧之后出现无人艇目标丢失情况,3913帧时大场景中出现干扰船只,若仅引入仿猛禽视觉显著性检测的结果,图8(a)中本文方法出现误检测。由于引入小场景的引导作用,本文算法在大场景中准确筛选出了目标无人艇,如图8(b)所示,并迅速重新锁定目标无人艇,实现再跟踪。而各个对比方法在出现目标丢失情况后,跟踪框偏离无人艇目标,ECO算法和STRCF算法开始跟踪河岸上的杂草,而无法再次跟踪准确的无人艇目标。

小场景因其视野小,更容易丢失目标无人艇,且很难实现再跟踪。3935帧时,目标无人艇在小场景中丢失,但由于大小场景共光轴,此时目标无人艇仍在大场景中,通过缩小大场景中无人艇偏离图像中心的角度,将无人艇重新拉回大场景中央,同时也可实现对小场景内目标无人艇的再跟踪再锁定。4275帧时,即使发生背景及无人艇尺寸变化,本文方法仍能保持对目标无人艇的稳定跟踪。fDSST、DSST和CSK算法的跟踪框从3913帧丢失后又开始逐渐靠近无人艇目标。4339帧时DSST算法基本重新跟踪到目标,但还有一定的偏差。综上所述,对比方法对作业场景的适应能力较弱,更容易受到场景中干扰因素的影响。

相比于水面场景,海面验证场景中存在更多的不确定的动态干扰因素,如鱼鳞光、阳光反射、海浪、海风等,被跟踪无人艇更容易出现变形、被遮挡、丢失等情况,极大增加了图像处理和无人艇跟踪的难度,从而造成跟踪失败、误检、漏检等。1 175帧时,大部分方法跟踪框位于目标无人艇附近,但STRCF等跟踪算法已开始将跟踪重点转向与无人艇特征相似的条状海浪处。1 181帧时,出现非目标无人艇(即没有安装合作靶标的无人艇)干扰,若仅依靠本文算法大场景中的仿猛禽显著性检测的纠正作用,则出现跟踪错误的情况,如图9(a)所示。引入小场景导引策略后,通过在小场景锁定目标无人艇上的合作靶标,计算目标无人艇在小场景中偏离角,导引大场景跟踪唯一目标无人艇,跟踪结果如图9(b)所示。同理,2 031帧时,若仅采用小场景对靶标进行检测,一旦靶标丢失,受小场景视野的限制很难将目标重新拉回至视野中央。由于引入大场景的纠正作用,2 232帧时无人艇重新被拉回小场景的视野中央,使得2场景均实现对目标无人艇的再跟踪和再锁定。目标丢失再出现及目标尺寸变化对各个对比方法的影响较大,从1 565帧开始,STRCF算法丢失无人艇目标开始跟踪海面耀光。ECO、fDSST和DSST算法能够大致跟踪无人艇,但是其跟踪精度略差,且一旦出现目标长时间丢失时,即使目标无人艇再出现,也很难重新锁定,这对无人机和无人艇异构平台的协同作业是非常不利的。

4.4 评价指标

本节分别采用成功率曲线、平均重叠率和像素误差从跟踪算法的准确度、精度方面对本文提出的方法及各种对比方法进行评价。

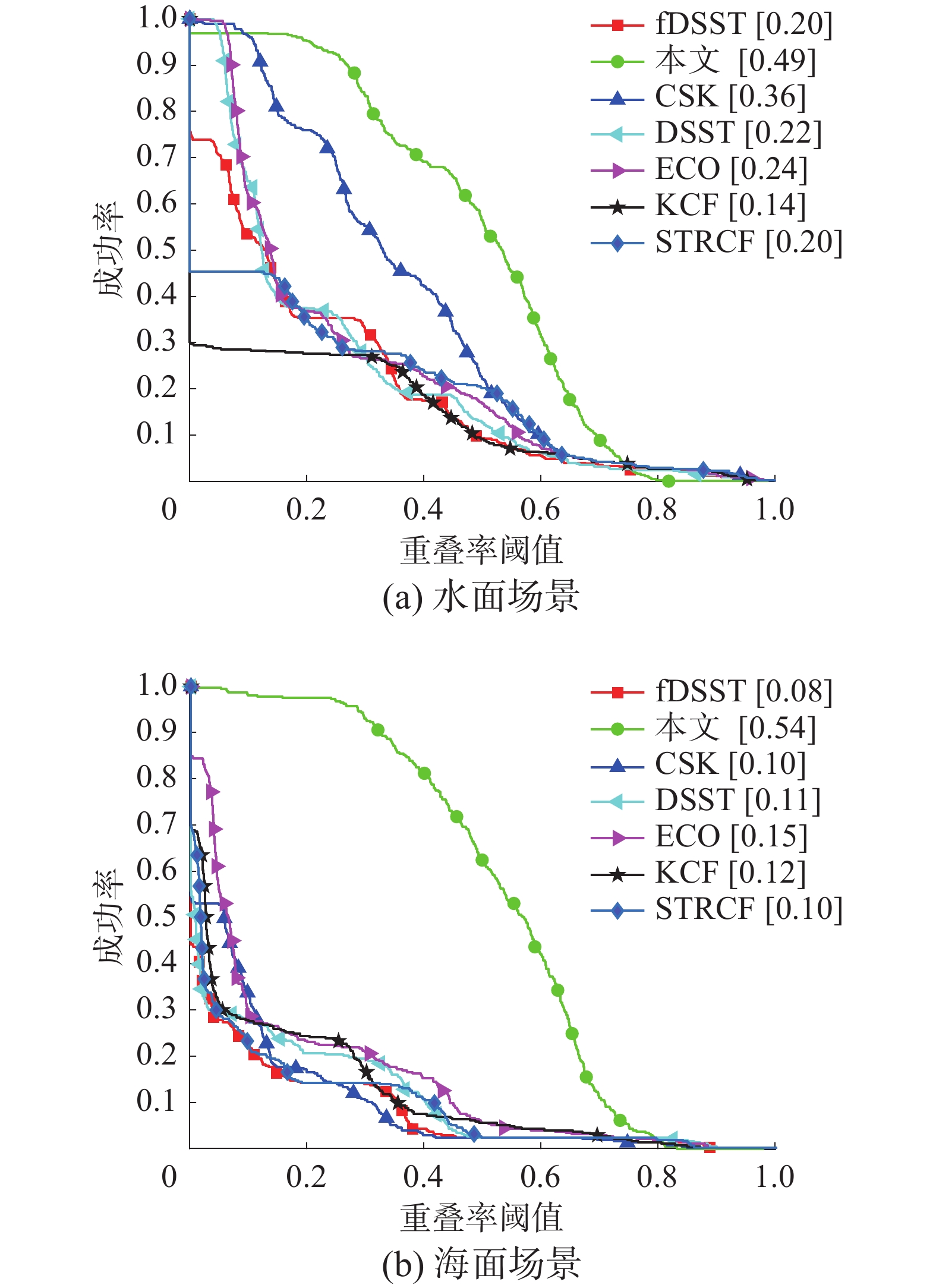

一次性评估(one pass evaluation, OPE)是根据视频序列第1帧给出的目标位置初始化跟踪算法,然后对目标的位置和大小进行预测,从而得到跟踪算法的精度或成功率。图10为2种验证场景跟踪图像序列的成功率曲线。

如图10所示,在2种验证场景中,本文方法的成功率曲线最高,表明本文方法能够有效排除场景中的干扰信息,且能适应不同动态场景的变化,即使出现目标无人艇丢失再出现的情况,本文算法也能再次锁定目标,跟踪效果比其他对比方法更稳定。CSK方法优于其他对比方法,其他各对比方法的跟踪性能相似,对动态背景的变化比较敏感。

平均重叠率(average overlap rate,AOR)是指算法预测的目标跟踪区域与真实的目标跟踪区域的重叠面积。AOR越高,算法跟踪性能越好。反之,算法的跟踪性能越差。平均重叠率AOR可表示为

$$ {A_{{\rm{AOR}}}} = \frac{{\left| {{A_M} \cap {A_{{\rm{GT}}}}} \right|}}{{\left| {{A_M} \cup {A_{{\rm{GT}}}}} \right|}} $$ (20) 式中:

${A_M}$ 为算法预测的目标区域,${A_{{\rm{GT}}}}$ 为真实的目标区域,$\left| \cdot \right|$ 为该区域内的像素个数。水面验证场景和海面验证场景的AOR图分别如图11(a)、(b)所示。如图11所示,本文方法获得了最高的平均重叠率,说明本文方法预测的无人艇目标区域与真实的无人艇所在区域最相近。在水面验证场景中,本文算法的平均重叠率为0.49,性能第2好的CSK跟踪方法的平均重叠率为0.36,跟踪性能提升了13%。在海面验证场景中,本文方法的平均重叠率达到0.54,ECO跟踪方法的平均重叠率为0.15,本文方法比ECO性能提升39%。综上所述,本文仿猛禽视觉多分辨率的目标无人艇跟踪方法对目标丢失再出现情况的鲁棒性较强,能够适应动态环境的变化,准确锁定并跟踪与无人机合作的目标无人艇,适用于复杂的工作环境。

平均像素误差(average pixel error,APE)是指跟踪算法预测的目标中心位置与真实目标中心位置之间的距离。APE越小,跟踪算法的性能越好,APE可通过像素距离计算为

$$ {P_{{\rm{APE}}}} = \sqrt {{{\left( {{x_M} - {x_{{\rm{GT}}}}} \right)}^2} + {{\left( {{y_M} - {y_{{\rm{GT}}}}} \right)}^2}} $$ (21) 式中:

$ \left( {{x_M},{y_M}} \right) $ 为算法预测的无人艇的中心位置,$ \left( {{x_{{\rm{GT}}}},{y_{{\rm{GT}}}}} \right) $ 为真实的无人艇的中心位置。2种验证场景的平均像素误差如图12所示,其中红色横线表示误差均值,蓝色横线表示误差的上下四分位数,红色+表示跟踪异常点。在水面验证场景中,本文方法得到的平均像素误差最低,算法在跟踪过程中所估计的目标无人艇的中心位置最接近真实无人艇中心位置;CSK和DSST方法的平均像素误差相似,但DSST跟踪算法的跟踪速度远不及CSK方法;KCF和STRCF方法的平均像素误差较大,仅能大致跟踪目标无人艇的位置,在近距跟踪过程中不占优势。在海面验证场景中,本文方法也获得最低的平均像素误差。CSK跟踪方法出现较高的上四分位数,个别帧检测误差增大是海面动态背景干扰造成的。在2种验证场景中,本文方法均出现跟踪异常点,其原因在于仿猛禽显著性检测结果的纠正作用,但不影响整个任务过程对目标无人艇的协同跟踪。

5. 结束语

在海上无人机/无人艇异构平台协同作业场景中,针对无人机对大小场景中无人艇的跟踪及检测需求,提出了仿猛禽视觉多分辨率机制的海上目标无人艇协同跟踪方法。Unity3D仿真场景和2种真实场景的验证结果表明,本文方法比其他对比方法的跟踪成功率提升约8%,有较好的跟踪检测性能和场景适应能力。本文算法不仅适用于无人机在复杂的海面环境下对无人艇的检测与跟踪,而且能够判断所跟踪的目标是否准确,有效提升了无人机搜索并靠近无人艇的效率。

-

-

[1] LI Huiyan, LI Xiang. Distributed consensus of heterogeneous linear time-varying systems on UAVs–USVs coordination[J]. IEEE transactions on circuits and systems II:express briefs, 2020, 67(7): 1264–1268. doi: 10.1109/TCSII.2019.2928870 [2] HUANG Dapeng, LI Huiyan, LI Xiang. Formation of generic UAVs-USVs system under distributed model predictive control scheme[J]. IEEE transactions on circuits and systems II:express briefs, 2020, 67(12): 3123–3127. doi: 10.1109/TCSII.2020.2983096 [3] YANG Jiachen, WANG Chenguang, JIANG Bin, et al. Visual perception enabled industry intelligence: state of the art, challenges and prospects[J]. IEEE transactions on industrial informatics, 2021, 17(3): 2204–2219. doi: 10.1109/TII.2020.2998818 [4] 林淑彬, 吴贵山, 姚文勇, 等. 基于光照自适应动态一致性的无人机目标跟踪[J]. 智能系统学报, 2022, 17(6): 1093–1103. LIN Shubin, WU Guishan, YAO Wenyong, et al. Based on illumination adaptive dynamic consistent tracker for unmanned aerial vehicle[J]. CAAI transactions on intelligent systems, 2022, 17(6): 1093–1103. [5] 林椹尠, 郑兴宁, 吴成茂. 结合模糊特征检测的鲁棒核相关滤波跟踪法[J]. 智能系统学报, 2021, 16(2): 323–329. LIN Zhenzian, ZHENG Xingning, WU Chengmao. Robust KCF tracking algorithm combined with fuzzy feature detection[J]. CAAI transactions on intelligent systems, 2021, 16(2): 323–329. [6] 宁欣, 李卫军, 田伟娟, 等. 一种自适应模板更新的判别式KCF跟踪方法[J]. 智能系统学报, 2019, 14(1): 121–126. doi: 10.11992/tis.201806038 NING Xin, LI Weijun, TIAN Weijuan, et al. Adaptive template update of discriminant KCF for visual tracking[J]. CAAI transactions on intelligent systems, 2019, 14(1): 121–126. doi: 10.11992/tis.201806038 [7] HENRIQUES J F, CASEIRO R, MARTINS P, et al. Exploiting the circulant structure of tracking-by-detection with kernels[C]//Proceedings of the 12th European conference on Computer Vision - Volume Part IV. New York: ACM, 2012: 702−715. [8] LI Feng, TIAN Cheng, ZUO Wangmeng, et al. Learning spatial-temporal regularized correlation filters for visual tracking[C]//2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE, 2018: 4904−4913. [9] DANELLJAN M, HÄGER G, SHAHBAZ KHAN F, et al. Accurate scale estimation for robust visual tracking[C]//Proceedings of the British Machine Vision Conference. Columbus: British Machine Vision Association, 2014: 109613. [10] DANELLJAN M, HÄGER G, KHAN F S, et al. Discriminative scale space tracking[J]. IEEE transactions on pattern analysis and machine intelligence, 2017, 39(8): 1561–1575. doi: 10.1109/TPAMI.2016.2609928 [11] WANG Naiyan, YEUNG D Y. Learning a deep compact image representation for visual tracking[C]//Proceedings of the 26th International Conference on Neural Information Processing Systems-Volume 1. New York: ACM, 2013: 809−817. [12] NAM H, HAN B. Learning multi-domain convolutional neural networks for visual tracking[C]//2016 IEEE Conference on Computer Vision and Pattern Recognition . Piscataway: IEEE, 2016: 4293−4302. [13] WANG Lijun, OUYANG Wanli, WANG Xiaogang, et al. Visual tracking with fully convolutional networks[C]//2015 IEEE International Conference on Computer Vision. Piscataway: IEEE, 2015: 3119−3127. [14] WANG Qiang, ZHANG Li, BERTINETTO L, et al. Fast online object tracking and segmentation: a unifying approach[C]//2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE, 2019: 1328−1338. [15] LI Bo, WU Wei, WANG Qiang, et al. SiamRPN: evolution of Siamese visual tracking with very deep networks[C]//2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition . Piscataway: IEEE, 2019: 4277−4286. [16] DOMINONI D M, HALFWERK W, BAIRD E, et al. Why conservation biology can benefit from sensory ecology[J]. Nature ecology & evolution, 2020, 4(4): 502–511. [17] 段海滨, 邓亦敏, 王晓华. 仿鹰眼视觉及应用[M]. 北京: 科学出版社, 2021. DUAN Haibin, DENG Yimin, WANG Xiaohua. Biological eagle-eye vision and its application[M]. Beijing: Science Press, 2021. [18] 赵国治, 段海滨. 仿鹰眼视觉技术研究进展[J]. 中国科学:技术科学, 2017, 47(5): 514–523. doi: 10.1360/N092016-00304 ZHAO Guozhi, DUAN Haibin. Progresses in biological eagle-eye vision technology[J]. Scientia sinica technologica, 2017, 47(5): 514–523. doi: 10.1360/N092016-00304 [19] PECORA R A, WATANABE S S, BRITO GUIMARÃES M, et al. Applicability of optical coherence tomography in blue-fronted parrots (Amazona aestiva)[J]. Veterinary ophthalmology, 2020, 23(2): 358–367. doi: 10.1111/vop.12733 [20] POTIER S. Visual adaptations in predatory and scavenging diurnal raptors[J]. Diversity, 2020, 12(10): 400. doi: 10.3390/d12100400 [21] POTIER S, LIEUVIN M, PFAFF M, et al. How fast can raptors see?[J]. Journal of experimental biology, 2019, 223(Pt 1): jeb209031. [22] HERMANN, WAGNER, et al. Neuroethology of prey capture in the barn owl (Tyto alba L. )[J]. Journal of physiology-Paris, 2013, 107(1/2): 51–61. [23] LAI Dihui, BRANDT S, LUKSCH H, et al. Recurrent antitopographic inhibition mediates competitive stimulus selection in an attention network[J]. Journal of neurophysiology, 2011, 105(2): 793–805. doi: 10.1152/jn.00673.2010 [24] HUANG Liqiang, PASHLER H. A Boolean map theory of visual attention[J]. Psychological review, 2007, 114(3): 599–631. doi: 10.1037/0033-295X.114.3.599 [25] ZHANG Jianming, SCLAROFF S. Exploiting surroundedness for saliency detection: a Boolean map approach[J]. IEEE transactions on pattern analysis and machine intelligence, 2016, 38(5): 889–902. doi: 10.1109/TPAMI.2015.2473844 [26] KEVIN, HEALY. Metabolic rate and body size are linked with perception of temporal information[J]. Animal behaviour, 2013, 86(4): 685–696. doi: 10.1016/j.anbehav.2013.06.018 [27] DUTTA A, WAGNER H, GUTFREUND Y. Responses to pop-out stimuli in the barn owl’s optic tectum can emerge through stimulus-specific adaptation[J]. The journal of neuroscience:the official journal of the society for neuroscience, 2016, 36(17): 4876–4887. doi: 10.1523/JNEUROSCI.3339-15.2016 [28] DANELLJAN M, BHAT G, KHAN F S, et al. ECO: efficient convolution operators for tracking[C]// IEEE Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE, 2017: 6931−6939.

下载:

下载: