Detection and spatial location of wind turbine blades based on lightweight YOLOv5

-

摘要: 应用无人机对风力发电机进行自主巡检时,需对其桨叶叶尖进行精准定位,同时因机载计算板的计算能力有限,常规目标检测算法检测效率低下。为此提出了一种基于轻量型YOLOv5的风机桨叶检测与空间定位方法,首先对YOLOv5目标检测算法进行轻量化改进,将ShuffleNetv2作为特征提取主干网络;然后利用该算法对风机全景图像中的风机轮毂和桨叶进行检测,以得到轮毂和桨叶叶尖的像素坐标;最后利用无人机位姿信息和空间平面的几何关系,对风机桨叶进行精准定位。实验表明,所改进的目标检测算法以1.536×106的参数量在大疆MANIFOLD2-C上的检测速度提升47%,可达29.4 f/s,所设计的定位方法可对风机桨叶叶尖进行精准定位,水平和高度定位误差均为±5 cm,三维整体定位误差为±10 cm。Abstract: The application of unmanned aerial vehicles (UAVs) for autonomous inspection of wind turbines requires precise positioning of the paddle blade tips, but the detection efficiency of conventional target detection algorithms is low due to the limited computing power of the onboard computer. Therefore, a method of the blade and spatial location detection of wind turbines based on lightweight YOLOv5 is proposed. Initially, the YOLOv5 target detection algorithm is lightly improved using ShuffleNetv2 as the feature extraction backbone network. The algorithm is then used to detect the hub and blades of the turbine in the panoramic image to obtain the pixel coordinates of the hub and blade tips. Finally, the UAV positional information and geometric relationship between the spatial planes are used to accurately locate the wind turbine blades. The tests show that the improved target detection algorithm with 1.536 × 106 parameters on the DJI MANIFOLD2-C improves detection speed by 47%, up to 29.4 f/s. The designed positioning method can accurately locate the tips of wind turbine blades with both horizontal and height positioning errors of ±5 cm and a three-dimensional overall positioning error of ±10 cm.

-

Keywords:

- wind turbine /

- unmanned aerial vehicle /

- object detection /

- YOLOv5 /

- lightweight /

- deep learning /

- blade tip /

- accurate positioning

-

2021年3月,十三届全国人大四次会议通过的“十四五”规划和2035年远景目标纲要中提出“要制定 2030 年前碳达峰行动方案,努力争取 2060年前实现碳中和”[1]。实现以风电为代表的可再生能源高质量和规模化发展,是构建新型电力系统、加速能源转型进程、实现“双碳”目标的关键所在[2]。

因风电机组主要分布在比较偏远且环境恶劣的地区,在迅速发展的同时,风机叶片表面结冰、断裂、剥落等一系列故障问题也相应而生,此类故障不仅严重影响机组的正常使用寿命,同时还带来高额的维护成本[3]。传统风机叶片检测方法费时费力无法满足大面积检测要求,采用无人机检测可实现风机叶片低强度、快速化、低成本、少停机式巡检,尽早发现叶片表面损伤并及时进行处理。风力发电机停机后其桨叶位置不确定,应用无人机对其自主巡视时,无法采用固定巡检路线,故需使用无人机对风机的全景拍摄,并运用目标检测算法对桨叶、轮毂进行实时检测,进而对桨叶叶尖精准定位。

传统的目标检测方法已不能适应日益复杂的应用环境[4]。而深度学习由于其强大的特征提取能力,在目标检测任务中展现出强大的优势。然而,随着网络层数的加深,所包含的参数量信息也随之增大,深度网络密集复杂的计算对硬件要求非常高,导致难以将其部署在普通硬件设备上[5-6]。由于机载计算板的计算能力有限,需对目标检测算法进行改进,以达到轻量化的目的。

近年来,一些研究人员通过模型量化[7-8]、参数剪枝[9]、知识蒸馏[10]和设计轻量型架构单元等技术来达到网络模型储存量和计算量降低的目=的[11]。相比上述几种技术,手工设计的轻量型架构单元具有迁移快速、即插即用等优点,早已成为轻量型网络架构设计的主流,并在下游任务目标检测和图像分割任务上表现出优异性能。MobileNetv2[12] 采用了深度可分离卷积和倒残差块,减少了模型的计算浮点数,同时大大提高了计算效率。ShuffleNetv2[13]利用分组卷积和通道改组操作减少了网络结构不必要的开销。ShiftNet[14]提出用交错的移位运算和逐点卷积来取代昂贵的空间卷积。GhostNet[15]提出了一种新的Ghost模块,通过低成本的线性变换生成能够揭示内在特征信息的特征图,从而提高模型的整体性能。

在风机桨叶定位领域一些相关专家和学者也进行了一定的研究,潘佳捷[16]提出一种基于已知风机结构的桨叶定位方法,首先通过手动操控使无人机正对风机后对风机进行全景图像采集,利用人工的方式检测图像中的桨叶信息,再通过视觉测量算法解算桨叶的空间位置坐标,但该方法仍需人工参与,操作难度较大,对操作员的要求较高。朱凯华[17]提出一种基于ED-Lines算法的桨叶定位方法,该方法首先使无人机飞行至正对风机位置进行图像采集,然后提取图像中桨叶的边缘直线解算桨叶角度,最后通过风机的实际物理参数对桨叶进行三维空间定位,但此方法需使无人机正对风机,定位精度依赖无人机正对效果。勾月凯等[18]提出一种风电机组叶片智能巡检策略,其包含对风机桨叶定位的方法,此方法将无人机所采集到的风机整体图像远程传输至地面站,再利用图像解析模块获取风机的航向角以及桨叶的相位角,从而对桨叶进行精确定位,但该策略中另需部署一套完整的图像传输系统,成本较高且较为复杂。Kanellakis等[19]使用超带宽技术对巡检无人机进行定位,然后利用无人机对风力发电机进行水平切片图像采集,进而对风机桨叶角度进行解算并根据已知的风机尺寸信息对其精准定位,但此算法依赖超宽带技术的定位精度,需在每个风机周围布置多个锚点,实际部署成本较高,难度较大。Guo等[20]提出一种基于Mask R-CNN深度学习的风机桨叶定位方法,获取风机全景图后利用深度学习算法提取图像中的风机信息,最后通过无人机的位置信息以及机组基础信息对桨叶叶尖的空间坐标进行计算,以实现风机桨叶的精确定位,但该方法中所采用的深度学习算法对机载计算机的性能有较高的要求。MOOLAN-FEROZE等[21]利用卷积神经网络对风机各部位进行检测,通过风机模型的结构信息和无人机的位姿信息对风机桨叶进行三维重建,从而对桨叶叶尖进行定位,此方法中所使用的卷积神经网络检测速度较慢,同样难以对风机进行实时目标检测。

本文提出了一种基于轻量型YOLOv5的风机桨叶检测与空间定位方法,在已知风力发电机模型参数、风机塔筒精确位置坐标的基础上,令无人机对风力发电机进行全景图像采集;并使用目标检测算法检测出全景图中的风机轮毂和桨叶,进而得到全景图像中风机轮毂以及桨叶叶尖的像素坐标;考虑到无人机机载计算板的计算能力有限,为提高检测效率,减轻机载计算板的运行负担,故对YOLOv5目标检测器进行轻量化设计;最后利用无人机当前的位姿状态以及提取到的特征信息解算风机的精确航向角,同时根据成像平面与桨叶平面的空间几何关系,进一步对桨叶角度进行计算,从而对风机桨叶进行精准定位。

1. Shuffle-YOLOv5轻量化设计

文献[12,14-15]虽然考虑到模型的计算复杂度和参数量,减少网络前向推理的理论耗时,但是计算复杂度和参数量只是衡量目标检测器的实际推理耗时的间接指标。内存访问成本、模型并行程度、组卷积操作数量以及元素级操作同样是影响实际推理耗时的重要因素。

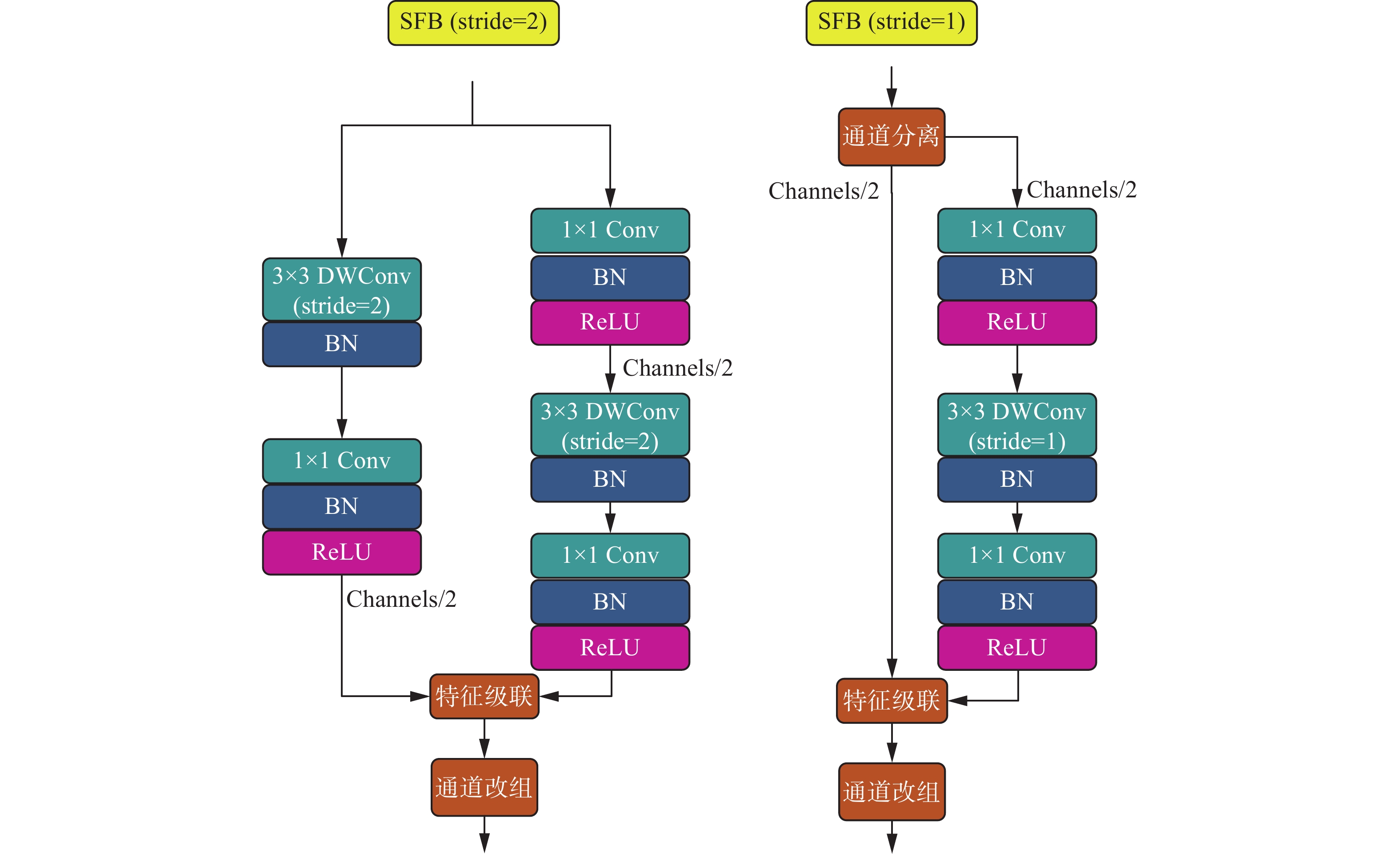

受ShuffleNetv2的启发,以分组数量为2的通道改组(channel shuffle)以及缩小分组数量的深度分组卷积(depthwise convolution, DWConv)操作能最大限度地降低存储器访问成本以及计算复杂度。本文以YOLOv5s作为基础目标检测器,由于YOLOv5s的初始层Focus模块在本文实验开展的边缘设备ARM平台上执行效率低下,故将其替换为Stem层,将YOLOv5s的初始Focus层替换为Stem层,ShuffleNetv2中的基础模块ShuffleBlock(SFB)替换YOLOv5s的Darknet53[22]主干网络,为充分发挥SFB特征提取潜能,保证特征提取网络的简洁精干,剔除SPP层[23],并保持YOLOv5s原来的PANet颈部网络[24]融合多尺度特征和预测头部,形成新的目标检测器Shuffle-YOLOv5。相比于原YOLOv5目标检测器,新的目标检测器Shuffle-YOLOv5能够在允许的精度误差范围内大幅度提升检测速度。图1给出了Shuffle-YOLOv5检测器整体网络架构,其中BN代表Batchnorm2d,ReLU代表非线性激活函数。

为充分提取图像的深层语义信息,设计了步长(stride)分别为1和2的两种SFB结构,其中步长为1的SFB结构不会降低特征图的尺寸大小,步长为2的SFB结构会将特征图的尺寸大小减半,图2展示了两种SFB结构。

在相同的计算复杂度的情况下,输入通道数和输出通道数接近1∶1时,模型并行程度最高,内存访问成本最小而且模型的计算速度最快[13]。在SFB结构中使用卷积操作、通道分离(channel split)、特征图级联(concat)保持输入和输出相同的通道数;在计算复杂度一定的情况下,过多的分组数的DWConv操作会造成内存访问成本过高,特征图元素相加操作(Add)同时会降低网络模型的计算速度,所以在进行DWConv操作前我们尽量将通道数减半,不使用Add操作,取而代之的是Concat操作,并在最后引入通道改组操作,实现不同通道信息组之间的信息通信以提高特征重复利用率。

2. 桨叶叶尖空间定位方法设计

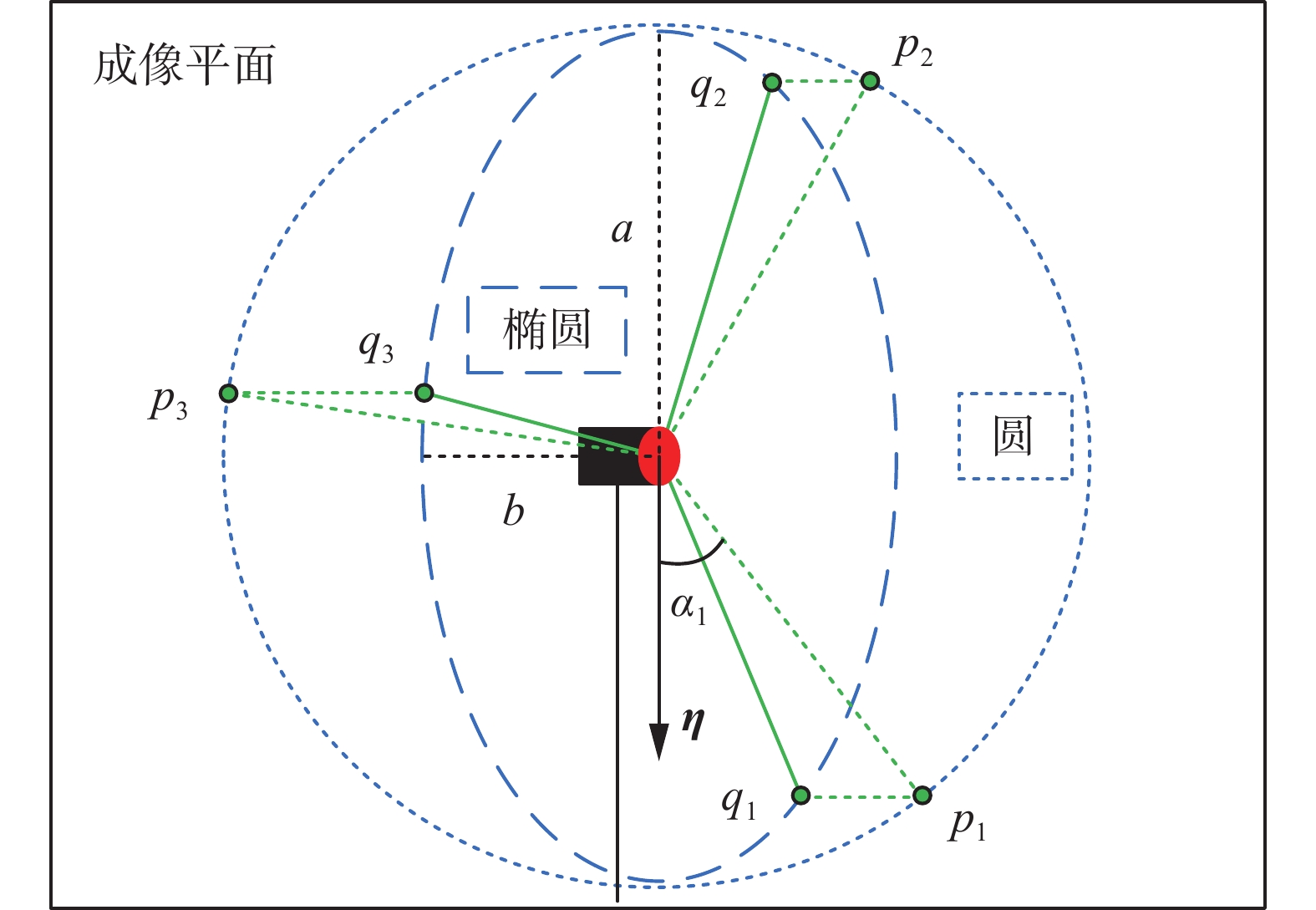

利用本文所设计的轻量化YOLOv5目标检测算法对风力发电机进行检测,并提取风机桨叶和轮毂信息,可得到像素坐标系下的风力发电机3个桨叶叶尖坐标和轮毂中心坐标,再利用最小二乘法拟合椭圆,其中轮毂中心为椭圆圆心,叶尖为椭圆上的点。

椭圆方程为

$$ \frac{{{{(u - {u_0})}^2}}}{{{a^2}}} + \frac{{{{(v - {v_0})}^2}}}{{{b^2}}} = 1 $$ (1) 式中:

$ a、b $ 为椭圆的两个轴长;$({u_0},{v_0})$ 为轮毂中心的像素坐标。将3个叶尖坐标代入式(1)可得:$$ \left\{ \begin{gathered} \frac{1}{{{a^2}}}{({u_1} - {u_0})^2} + \frac{1}{{{b^2}}}{({v_1} - {v_0})^2} = 1 \\ \frac{1}{{{a^2}}}{({u_2} - {u_0})^2} + \frac{1}{{{b^2}}}{({v_2} - {v_0})^2} = 1 \\ \frac{1}{{{a^2}}}{({u_3} - {u_0})^2} + \frac{1}{{{b^2}}}{({v_3} - {v_0})^2} = 1 \\ \end{gathered} \right. $$ (2) 式中

$({u_i},{v_i}),i = 1,2,3$ 为桨叶叶尖的像素坐标。利用最小二乘法对式(2)进行求解,即可解得椭圆的轴长$ a、b $ 。因无人机对风力发电机进行全景图拍摄时,基本保持在与轮毂同高度处,由几何关系可知

$a \geqslant b$ ,即像素坐标系下椭圆在$u$ 方向上的轴长大于$v$ 方向上的轴长,如图3所示。无人机所搭载摄像头的成像平面与风力发电机桨叶平面均与地平面垂直,由几何关系可得

$$ \theta = \arccos \left(\frac{b}{a}\right) $$ (3) 式中

$\theta $ 为两平面之间的平面夹角。根据式(3)中的

$\theta $ 与无人机此时的偏航角,即可计算出风力发电机的航向角。由于桨叶平面与地平面垂直,从而可得风机桨叶平面的法向量,进一步可解得桨叶平面所在方程,此方程可表示为$$ {c_1}x + {c_2}y = 1 $$ (4) 因无人机在对风力发电机的全景进行图像采集时,高度与轮毂相同,故在桨叶平面会形成1个以轮毂为中心,以椭圆长轴为半径的圆,3个桨叶叶尖均处于此圆上。

将成像平面内椭圆上的叶尖坐标点

$ {q_i}(i = 1,2,3) $ 投影至圆上,投影点记为${p_i}(i = 1,2,3)$ ,如图4所示。令起点为轮毂中心,方向垂直向下的单位向量为${\boldsymbol{\eta }}$ ,任意取风机的一个桨叶作为基准桨叶,并以轮毂中心为起点,以此基准桨叶的投影点${p_i}$ 为终点形成的向量作为桨叶基准向量,则桨叶基准向量与${\boldsymbol{\eta }}$ 之间的夹角即为所在基准桨叶的桨叶角度,再利用风力发电机3个桨叶间的角度关系,即可得到所有桨叶的桨叶角度,如式(5)所示:$$ {\alpha _i} = {\alpha _1} + \frac{{2(i - 1)}}{3}{\text{π }},\quad i = 2,3 $$ (5) 式中:

${\alpha _1}$ 为基准桨叶的桨叶角度;${\alpha _i},i = 2,3$ 为其余2个桨叶的桨叶角度。通过式(5)计算出所有桨叶的角度后,可根据风力发电机的桨叶长度,解算桨叶叶尖的三维空间位置坐标。

轮毂的三维空间坐标已知,桨叶平面方程如式(4)所示,每个桨叶叶尖与轮毂之间的距离固定,利用计算出来的桨叶角度

${\alpha _i}$ ,将桨叶叶尖投影至地平面,可得方程:$$ \left\{ \begin{gathered} {c_1}{x_i} + {c_2}{y_i} = 1 \\ {({x_i} - {x_0})^2} + {({y_i} - {y_0})^2} = {(R\sin {\alpha _i})^2} \\ \end{gathered} \right. $$ (6) 式中:

$ ({x_0},{y_0},{z_0}) $ 为轮毂的三维空间坐标;$R$ 为桨叶长度,即桨叶叶尖与轮毂之间的实际物理距离;$({x_i},{y_i},{z_i}),i = 1,2,3$ 为桨叶叶尖的三维空间坐标。由式(6)即可解得桨叶叶尖的地平面坐标

$ ({x}_{i},{y}_{i}) $ ,再由几何关系可得叶尖高度与桨叶角度之间的关系,如式(7)所示,即可解得桨叶叶尖的高度坐标${z_i}$ 。解算示意图如图5所示。$$ \frac{{{z_i} - {z_0}}}{R} = \cos {\alpha _i} $$ (7) 3. 实验验证及结果分析

无人机采用大疆经纬M210,所搭载的机载计算机为大疆MANIFOLD2-C 256GB,CPU模块的型号参数为Inter®Corei7-8550U,内存为8 GB,所搭载的摄像头型号为大疆禅思Z30云台相机,配备30倍光学变焦镜头与6倍数码变焦,采用Type1/28 CMOS传感器,分辨率为1920×1080,如图6所示。

为更加贴合实际,将测试环境设置在学校较为空旷的操场上,测试环境中的风力发电机为缩略模型如图7所示,其参数如表1所示。

表 1 风力发电机参数Table 1 Wind turbine parameterscm 参数 尺寸 风机最高高度 293.0 轮毂直径 15.0 轮毂高度 230.0 桨叶长度 63.0 桨叶叶根宽度 14.5 桨叶叶尖宽度 3.5 3.1 Shuffle-YOLOv5风机检测及模型对比

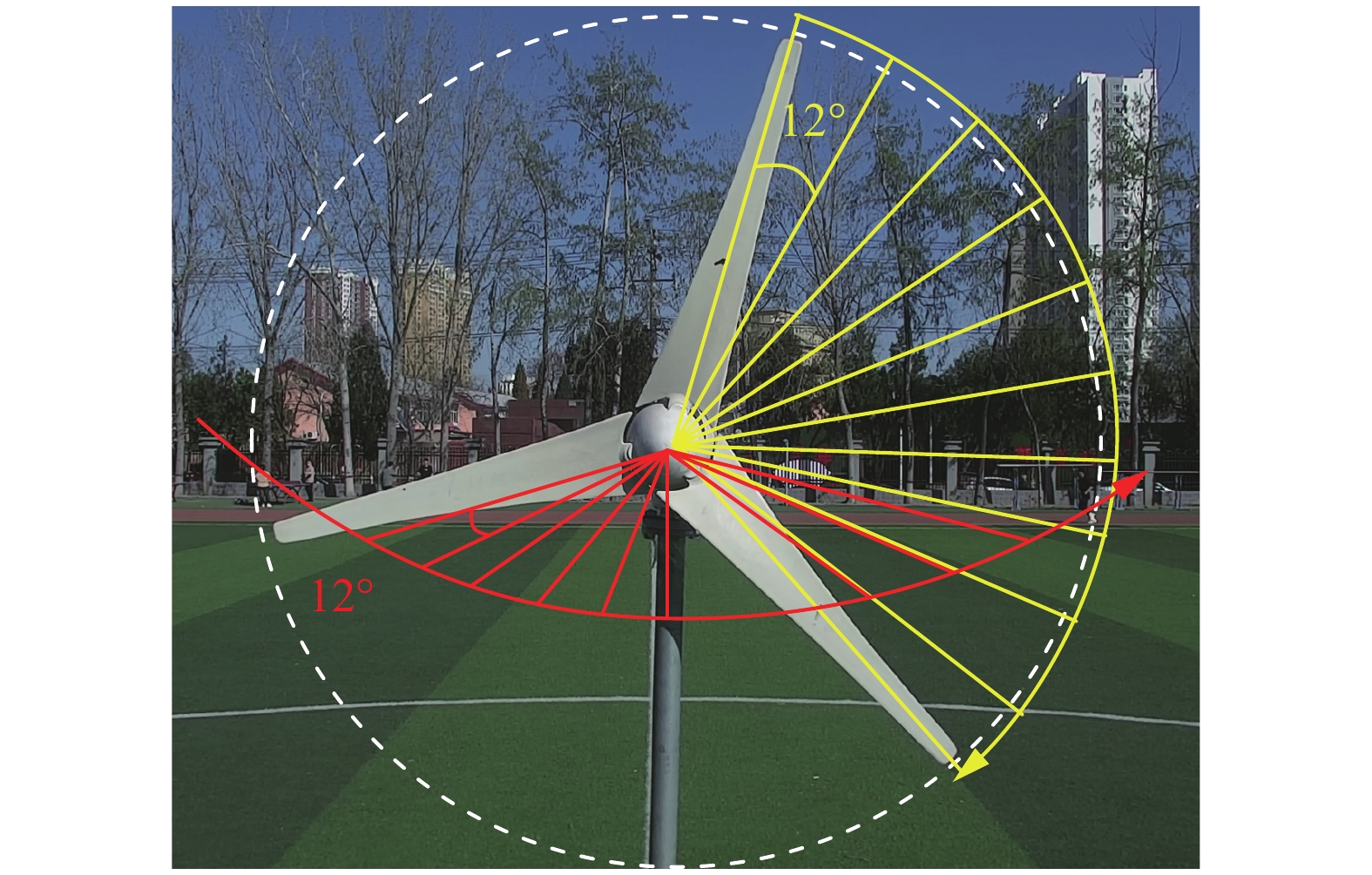

在无人机位于与风机轮毂同高度处,风机轮毂位于图像中心,且所有桨叶可完整呈现在图像的前提下,无人机可对不同桨叶角度和航向角度的风力发电机进行全景图采集。风力发电机的航向角在−60°~60°每隔12°取点,如图8中的红色线所示,同时桨叶角度在−60°~60°每隔12°再次取点,如图8中的黄色线所示。在所有点位可采集121张风机全景图,将此121张全景图按照7∶3的比例划分作为轻量型YOLOv5神经网络模型的训练集与验证集,即85张全景图作为训练集,36张全景图作为验证集。

为准确定位像素坐标系下轮毂中心坐标和桨叶坐标,本文设计了3种检测标注框,即风机、叶尖、轮毂,标注框数量比为1∶3∶1。图9给出了标注示例。

本文采用目标检测模型中常用的评价指标平均精度均值(mean average precision, mAP)对模型进行评估,通过度量目标检测框与真值框间的交并比(intersection over union, IoU)计算各类目标平均精度(average precision, AP),以所有类目标的AP平均值作为目标检测模型的最终评价指标。考虑到检测器边界框定位坐标的准确性,列出IoU阈值为0.5时的mAP50和10个IoU(范围为0.5~0.95)阈值的平均值mAP50:95的情况。

在NVIDIA RTX3090图形处理器上以Pytorch1.7.1环境实现了Shuffle-YOLOv5。在训练阶段,使用了YOLOv5s中PANet部分的预训练模型。共训练300个Epochs,前3个Epoch用于热身训练,模型训练和测试的图像尺寸最长边保持在640像素,batchsize设置为16,使用SGD优化器进行训练,以0.001作为余弦退火学习率调度的初始学习速率,使用数据增强技术提高模型的泛化能力,例如:左右翻转、尺寸变化和马赛克增强等。

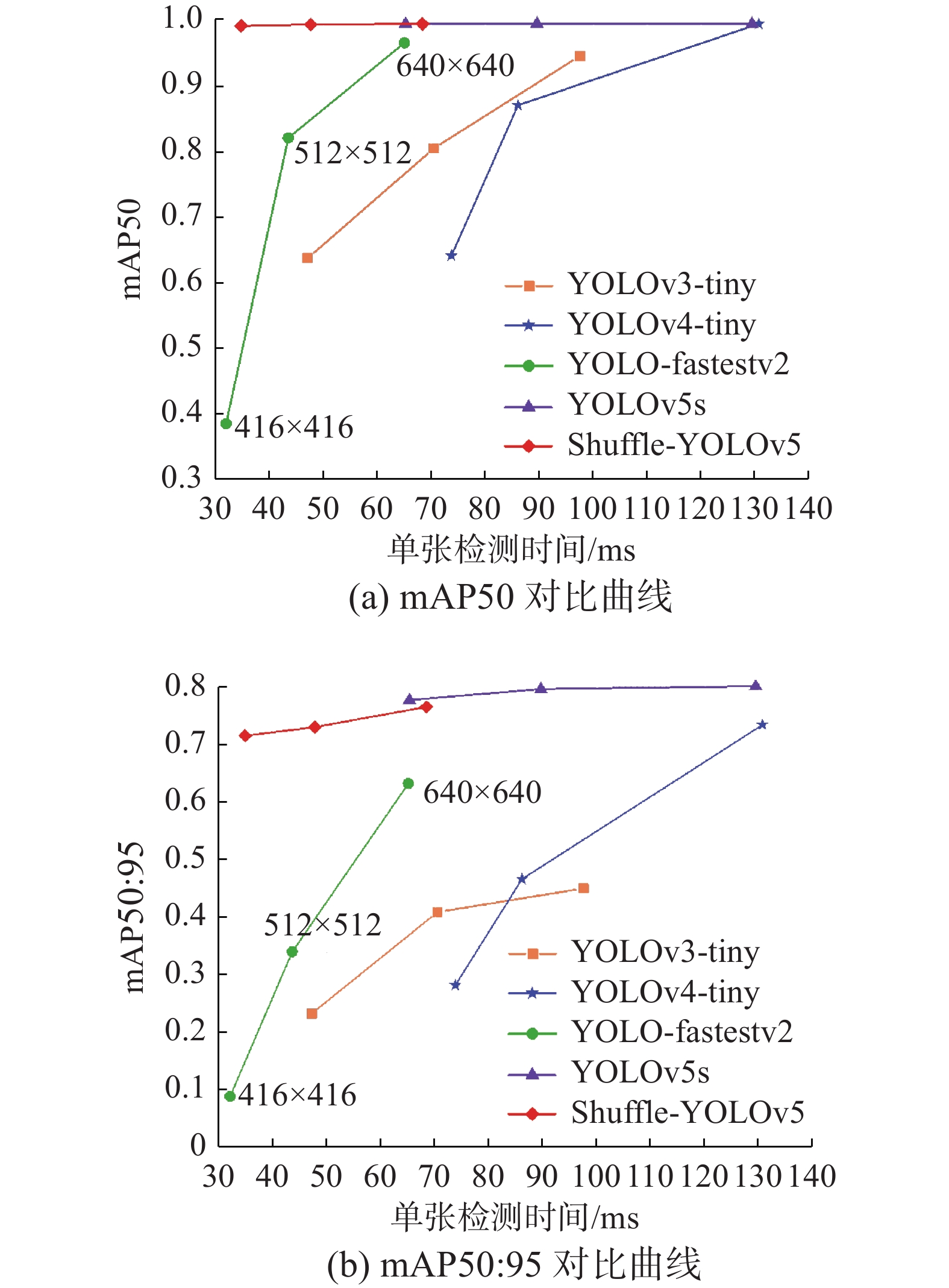

为证明Shuffle-YOLOv5的有效性,从mAP50、mAP50:95、参数量、10亿次浮点运算(GFLOPs)和单张检测时间5个角度来和其他轻量型目标检测器作对比,并保持同样的输入尺寸640×640,所有目标检测器所依赖的硬件设备为大疆MANIFOLD2-C 256GB,CPU模块为Inter®Corei7-8550U,内存为8 GB,表2给出了对比效果。

表 2 输入图像尺寸640×640像素轻量型目标检测器对比结果Table 2 Comparison of results based on an input image size of 640×640 for lightweight target detection与原YOLOv5s相比,Shuffle-YOLOv5在mAP50指标上相同,牺牲了0.036的mAP50:95的精度,换取了47.29%的速度提升以及78%的参数量的下降,这对于以CPU为后端的硬件设备的框架是非常友好的。和主干网络同为ShuffleNetv2的YOLO-fastestv2相比mAP50:95提升20%并且检测速度相差不大;与其他轻量型目标检测器YOLOv4-tiny和YOLOv3-tiny对比结果来看,Shuffle-YOLOv5在各个方面都是最优的。

为确保Shuffle-YOLOv5通用性和泛化性,以充分体现其应对不同CPU硬件设备的灵活性,本文将图像尺寸不等间距进行调整为512×512像素和416×416像素,分别与上述其他模型进行对比,以纵轴为mAP50和mAP50:95,横轴为单张图像检测时间绘制曲线图,如图10所示。

在图10中,每一条曲线代表一种目标检测器,从曲线图中可以看出,曲线越靠近左上方,检测性能越优,Shuffle-YOLOv5在检测速度和mAP指标上都强于其他轻量型目标检测器。图像尺寸从640×640像素降低到416×416像素,Shuffle-YOLOv5mAP相较于其他模型没有明显下降,单张检测时间从68 ms降低到34 ms,说明Shuffle-YOLOv5可以在任意图像尺寸下调整,以适应不同的硬件资源设备来满足不同的应用场景。

3.2 风机桨叶叶尖定位测试

考虑到在使用轻量型YOLOv5对风力发电机进行检测并提取其各部分的像素坐标时存在一定的误差,故选取桨叶角度所对应的桨叶斜率的绝对值与1最为接近的桨叶作为基准桨叶。以风力发电机塔筒底端为原点建立东北天三维空间坐标系,根据风力发电机的尺寸参数,可得风机轮毂的空间坐标为(0, 0, 2.27 m),为验证所设计定位算法的有效性,多次选取不同桨叶角度以及航向角度的风力发电机,同时令无人机飞至坐标(2.5 m, 0, 2.2 m)处,此位置与风机轮毂的水平距离为2.5 m,对风机进行桨叶叶尖定位测试。

选取其中1次的定位结果进行展示,采集到的全景图如图11所示,此风力发电机桨叶叶尖的实际坐标如表3所示,定位坐标如表4所示。

将表3和表4进行对比,此风力发电机3个桨叶叶尖定位的x方向平均定位误差为1.4 cm;y方向定位误差为3.3 cm,即水平误差为3.6 cm;z方向定位误差,即高度误差为3.7 cm;整体三维误差为5.2 cm。多次定位试验表明,桨叶叶尖的高度误差仅小于5 cm,水平误差仅小于5 cm,整体三维误差仅小于10 cm。该定位方法可通过无人机的简易运动实现实时、快速、精确地得到风力发电机桨叶叶尖的定位结果。

表 3 桨叶叶尖实际坐标Table 3 Actual coordinates of the paddle blade tipcm 桨叶编号 x y z 1 −11.5 35.5 173.5 2 −8.5 26.5 289.0 3 17.5 -53.5 221.0 表 4 桨叶叶尖定位坐标Table 4 Paddle blade tip positioning coordinatescm 桨叶编号 x y z 1 −9.0 32.5 175.0 2 −7.6 27.2 282.2 3 16.6 −59.7 223.8 4. 结束语

为解决无人机机载计算板能力有限,普通目标检测器内存开销大与检测速度慢的问题,本文提出了以YOLOv5为基础的轻量型Shuffle-YOLOv5目标检测器。对比实验表明,Shuffle-YOLOv5在精确度降低很少的情况下,参数量缩减78%,检测速度提升47%,并在416×416像素输入图像尺寸下可达29.4 f/s的实时检测速度,并优于现阶段其他轻量型目标检测器。风机桨叶叶尖定位测试结果表明,所提出的定位方法可对风机桨叶叶尖进行精准定位,定位的高度误差仅在5 cm以内,水平误差仅在5 cm以内,整体三维误差仅在10 cm以内。

综上所述,在风力发电机模型参数以及塔筒精确位置坐标已知的基础上,所提出的基于轻量型YOLOv5的风机桨叶检测与空间定位方法可根据无人机所采集到的风机全景图对风力发电机进行快速且准确的检测,并对桨叶叶尖进行精准定位,同时所提方法无需过多硬件设备,仅需一个较为通用的挂载机载计算机和高清摄像头的巡检无人机即可完成对风力发电机桨叶的定位,成本较低且在实际场景中易于部署和实现,给边缘设备目标检测器轻量化改进提供了新思路,为后续的对大型风力发电机桨叶巡检的路径规划研究提供理论依据和便利条件。

-

表 1 风力发电机参数

Table 1 Wind turbine parameters

cm 参数 尺寸 风机最高高度 293.0 轮毂直径 15.0 轮毂高度 230.0 桨叶长度 63.0 桨叶叶根宽度 14.5 桨叶叶尖宽度 3.5 表 2 输入图像尺寸640×640像素轻量型目标检测器对比结果

Table 2 Comparison of results based on an input image size of 640×640 for lightweight target detection

表 3 桨叶叶尖实际坐标

Table 3 Actual coordinates of the paddle blade tip

cm 桨叶编号 x y z 1 −11.5 35.5 173.5 2 −8.5 26.5 289.0 3 17.5 -53.5 221.0 表 4 桨叶叶尖定位坐标

Table 4 Paddle blade tip positioning coordinates

cm 桨叶编号 x y z 1 −9.0 32.5 175.0 2 −7.6 27.2 282.2 3 16.6 −59.7 223.8 -

[1] 陈诗一, 许璐. “双碳”目标下全球绿色价值链发展的路径研究[J]. 北京大学学报(哲学社会科学版), 2022, 59(2): 5–12. CHEN Shiyi, XU Lu. A study on the development path of global green value chain to achieve the targets of carbon peaking and carbon neutrality[J]. Journal of Peking University (philosophy and social sciences edition), 2022, 59(2): 5–12. [2] 蒋元锐. 武钢委员: “双碳”目标呼唤风电赋能[N]. 中华工商时报, 2022−03−11(2). JIANG Yuanrui. Member WU Gang: The targets of carbon peaking and carbon neutrality call for wind power energization[N]. China bussiness times, 2022−03−11(2). [3] CHATTERJEE J, DETHLEFS N. Scientometric review of artificial intelligence for operations & maintenance of wind turbines: the past, present and future[J]. Renewable and sustainable energy reviews, 2021, 144: 111051. doi: 10.1016/j.rser.2021.111051 [4] 田枫, 白欣宇, 刘芳, 等. 一种轻量化油田危险区域入侵检测算法[J]. 智能系统学报, 2022, 17(3): 634–642. doi: 10.11992/tis.202107033 TIAN Feng, BAI Xinyu, LIU Fang, et al. A lightweight intrusion detection algorithm for hazardous areas in oilfields[J]. CAAI transactions on intelligent systems, 2022, 17(3): 634–642. doi: 10.11992/tis.202107033 [5] ZHOU Yan, CHEN Shaochang, WANG Yiming, et al. Review of research on lightweight convolutional neural networks[C]//2020 IEEE 5th Information Technology and Mechatronics Engineering Conference. Chongqing: IEEE, 2020: 1713−1720. [6] 何锐波, 狄岚, 梁久祯. 一种改进的深度学习的道路交通标识识别算法[J]. 智能系统学报, 2020, 15(6): 1121–1130. doi: 10.11992/tis.201811009 HE Ruibo, DI Lan, LIANG Jiuzhen. An improved deep learning algorithm for road traffic identification[J]. CAAI transactions on intelligent systems, 2020, 15(6): 1121–1130. doi: 10.11992/tis.201811009 [7] JACOB B, KLIGYS S, CHEN Bo, et al. Quantization and training of neural networks for efficient integer-arithmetic-only inference[C]//2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City: IEEE, 2018: 2704−2713. [8] KRISHNAMOORTHI R. Quantizing deep convolutional networks for efficient inference: a whitepaper[EB/OL]. (2018−06−21)[2022−04−11].https://arxiv.org/abs/1806.08342. [9] LUO JIAN-HAO, WU JIANXIN. An entropy-based pruning method for CNN compression[EB/OL]. (2017−06−19)[2022−04−11].https://arxiv.org/abs/1706.05791. [10] HINTON G, VINYALS O, DEAN J. Distilling the knowledge in a neural network[EB/OL]. (2015−03−09)[2022−04−11].https://arxiv.org/abs/1503.02531. [11] LI Yahui, LIU Jun, WANG Lilin. Lightweight network research based on deep learning: a review[C]//2018 37th Chinese Control Conference (CCC). Wuhan: IEEE, 2018: 9021−9026. [12] SANDLER M, HOWARD A, ZHU Menglong, et al. MobileNetV2: inverted residuals and linear bottlenecks[C]//2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City: IEEE, 2018: 4510−4520. [13] MA Ningning, ZHANG Xiangyu, ZHENG Haitao, et al. ShuffleNet V2: practical guidelines for efficient CNN architecture design[C]//European Conference on Computer Vision. Cham: Springer, 2018: 122−138. [14] WU Bichen, WAN A, YUE Xiangyu, et al. Shift: a zero FLOP, zero parameter alternative to spatial convolutions[C]//2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City: IEEE, 2018: 9127−9135. [15] HAN Kai, WANG Yunhe, TIAN Qi, et al. GhostNet: more features from cheap operations[C]//2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). Seattle: IEEE, 2020: 1577−1586. [16] 潘佳捷. 风机叶片的无人机自主巡检系统[D]. 成都: 电子科技大学, 2020. PAN Jiajie. An autonomous inspection system for wind turbine blade based on unmanned aerial vehicle[D]. Chengdu: University of Electronic Science and Technology of China, 2020. [17] 朱凯华. 面向风机叶片巡检的无人机自动航迹线规划研究[D]. 北京: 北京交通大学, 2021. ZHU Kaihua. Research on automatic path planning of UAV for wind turbine blade inspection[D]. Beijing: Beijing Jiaotong University, 2021. [18] 勾月凯, 代海涛, 董健, 等. 风力发电机组叶片智能巡检系统研究[C]//第五届中国风电后市场专题研讨会. 上海: [出版者不详], 2018: 203−208. GOU Yuekai, DAI Haitao, DONG Jian, et al. Research on intelligent inspection system of wind turbine blades[C]//Proceedings of the 5th China Wind Power Post Market Symposium. Shanghai: [s,n.], 2018: 203−208. [19] KANELLAKIS C, FRESK E, MANSOURI S S, et al. Towards visual inspection of wind turbines: a case of visual data acquisition using autonomous aerial robots[J]. IEEE access, 2020, 8: 181650–181661. doi: 10.1109/ACCESS.2020.3028195 [20] GUO Haowen, CUI Qiangqiang, WANG Jinwang, et al. Detecting and positioning of wind turbine blade tips for UAV-based automatic inspection[C]//IGARSS 2019—2019 IEEE International Geoscience and Remote Sensing Symposium. Yokohama: IEEE, 2019: 1374−1377. [21] MOOLAN-FEROZE O, KARACHALIOS K, NIKOLAIDIS D N, et al. Simultaneous drone localisation and wind turbine model fitting during autonomous surface inspection[C]//2019 IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS). Macao: IEEE, 2019: 2014−2021. [22] REDMON J, FARHADI A. YOLOv3: an incremental improvement[EB/OL]. (2018−04−08)[2022−04−11].https://arxiv.org/abs/1804.02767. [23] HE Kaiming, ZHANG Xiangyu, REN Shaoqing, et al. Spatial pyramid pooling in deep convolutional networks for visual recognition[C]//European Conference on Computer Vision. Cham: Springer, 2014: 346−361. [24] LIU Shu, QI Lu, QIN Haifang, et al. Path aggregation network for instance segmentation[C]//2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City: IEEE, 2018: 8759−8768. [25] WANG C Y, BOCHKOVSKIY A, LIAO H Y M. Scaled-YOLOv4: scaling cross stage partial network[C]//2021 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). Nashville: IEEE, 2021: 13024−13033.

下载:

下载: