A multi-category fitting detection method with embedded visual relation masks

-

摘要: 在对输电线路金具进行检测的过程中,由于受到复杂背景的影响,一些互相遮挡或者特征不明显的金具会隐匿在复杂环境难以精确检测。针对这一问题,提出了基于视觉关系掩码的多类别金具检测模型,通过挖掘和提取输电线路金具之间包含空间信息的视觉关系先验知识,构建视觉关系掩码和视觉关系检测网络,并将先验知识作为辅助信息融入视觉关系模块中,最终实现多类别金具的精确定位与识别。对具有14类金具的数据集进行多种定性和定量实验,结果表明,改进后的模型平均检测精度能提高到76.25%,检测效果也优于其他先进目标检测模型。Abstract: In the process of detecting power transmission line fittings, due to the influence of complex backgrounds, some fittings with mutual obscuration or inconspicuous features will be hidden in complex environments and it is hard to detect them accurately. In response to this problem, this paper proposes a multi-category hardware detection model based on visual relationship masks. By mining and extracting the prior knowledge of visual relationships between power transmission line fittings that contain spatial information, the visual relationship mask(VRM), and visual relationship detection network(VRDN) are constructed, and the prior knowledge is integrated into the visual relationship module as auxiliary information, realizing the precise positioning and recognition of multi-category fittings. A variety of qualitative and quantitative experiments have been performed on a data set with 14 types of hardware. The results show that the average detection accuracy of the improved model can be increased to 76.25%, and the detection effect is better than other advanced target detection models.

-

近年来,随着电网高速发展与全面覆盖,长距离输电线路日渐增多,输电线路作为电力传输中的核心系统,其稳定运行对电网的安全有着至关重要的影响[1-2]。目前,输电线路金具的缺陷日益增多,运行维护需求量增长与巡检人员数量之间的矛盾逐渐凸显,对自动化与智能化检测技术的需求越来越迫切,而如何精确定位输电线路金具仍是亟待解决的关键问题[3-4]。输电线路金具主要起到支持、固定、防护和接续线路各个部件以及维持整个线路稳定的作用,如间隔棒、防震锤、均压环等[5]。当前输电线路金具检测主要依靠无人机航拍获得的金具图像,以计算机视觉和图像处理技术为支撑,实现对金具目标的精确定位和识别[6-7]。无人机采集的海量图像,人工逐张确认有无缺陷并不现实,而准确定位金具给判断有无缺陷带来便利,因此,如何对金具精确定位和识别具有极高的研究意义。

输电线路金具检测大致可以分为两类方法,第1种是基于传统图像处理算法,依靠人工设计特征提取器来定位金具,并结合机器学习算法进行分类识别[8];第2种是依靠深度学习模型,自主提取多层次多角度的特征,依托强大的学习能力和表达能力对目标进行定位,由于其鲁棒性高、泛化性强,相比与传统图像处理算法更适用于复杂多变的现实环境[9]。汤踊等[10]采用Faster R-CNN网络结构,研究了不同网络主干对检测精度和检测速度的影响,并探究了网络第一层的卷积核大小对召回率的影响,发现较大的卷积核一定程度上能够提高检测精度。高强等[11]基于YOLOv3框架,考虑目标间的遮挡问题,提出可聚合度的概念,将属于同一整体的目标检测框进行聚合,可以通过目标部分元素确定改目标的存在。赵振兵等[12]针对目标互相遮挡的问题,设计一种带有注意力机制的遮挡关系模块,嵌入到单阶段多框检测器(single shot multibox detector, SSD)目标检测模型中,较原模型提升了4.46%。戚银城等[13]对金具图像进行不同角度的旋转和固定尺寸的自适应裁剪进行样本扩充,并使用改进的IoU(intersection over union)替换原损失计算方式,一定程度上提高了检测精度。Wan等[14]在基于区域的全卷积网络基础上引入可变形卷积和挤压激励模块,有效提取输电线路金具之间细粒度特征和融合上下文信息。赵振兵等[15]针对金具与金具之间、金具与背景之间相互干扰的问题,提出了一种结合KL(kullback-leibler)散度[16]和形状约束的Faster R-CNN金具检测方法,使用KL散度替代原有的SmoothL1损失函数[17],同时将不同目标的形状特征作为约束加入损失函数中对模型训练进行优化,以提高模型检测精度。

然而上述的研究工作并未充分考虑金具之间的视觉关系,只是针对目标框重叠的情况做分析,金具间的视觉关系没有得以充分利用,并且在金具图像背景复杂和重叠框数量较多的情况下,单单考虑目标框重叠信息是不够的,一些重叠区域较小的目标容易“淹没”在背景复杂的图像中,不容易被模型发现。针对以上问题,本文通过挖掘输电线路金具之间的空间信息和视觉关系,引入一种视觉关系掩码(visual relationship mask, VRM)的概念,并构建了一种视觉关系检测网络(visual relationship detection network, VRDN),融合上下文信息来学习目标框之间的视觉关系,辅助原模型对目标框的定位效果,从而提高检测精度,为输电线路的金具智能化巡检提供了新思路。

1. 总体框架

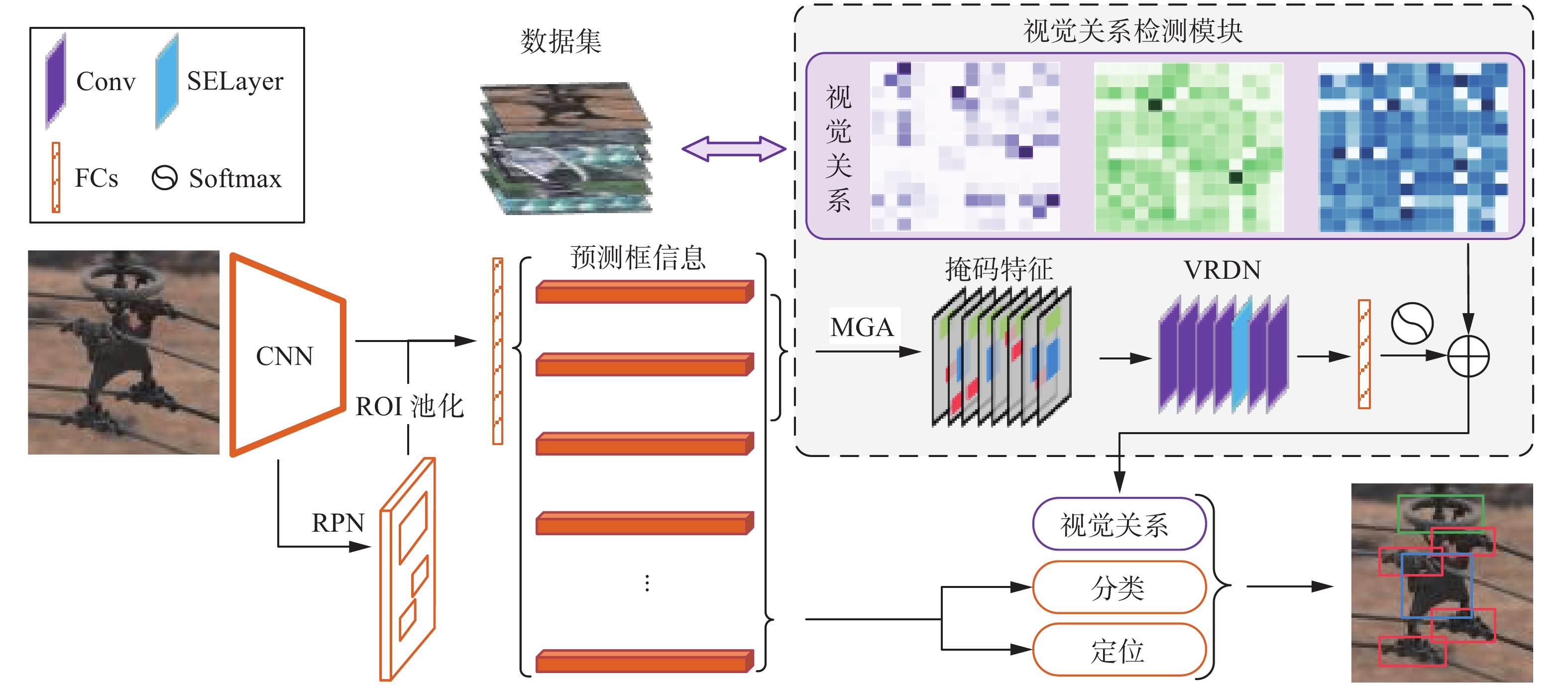

本文总体结构如图1所示,首先通过分析输电线路金具航拍图像之间的空间信息和视觉关系,提取金具之间视觉关系先验知识,然后将金具航拍图像作为输入,通过卷积神经网络获取高层特征,在经区域提议网络(regional proposal network, RPN)网络[18]进行感兴趣区域框筛选,并进行感兴趣区域(region of interest, ROI)池化将每个区域框整合为同一尺度的区域向量,在经过全连接层进行预测框坐标和类别预测。从所有的预测信息中筛选128个预测框进行目标的分类和定位损失的计算;同时从128个预测框中32个正样本中筛选N个预测框,通过掩码生成算法(mask generation algorithm, MGA)构建视觉关系掩码,并生成掩码特征,再输送到VRDN中进行掩码特征的高层语义信息提取,最后将视觉关系先验知识融入到网络输出端进行视觉关系损失计算。最终,由视觉关系检测器辅助分类、定位检测器对多类别金具进行精确检测。

2. 视觉关系先验知识提取

2.1 视觉关系规则制定

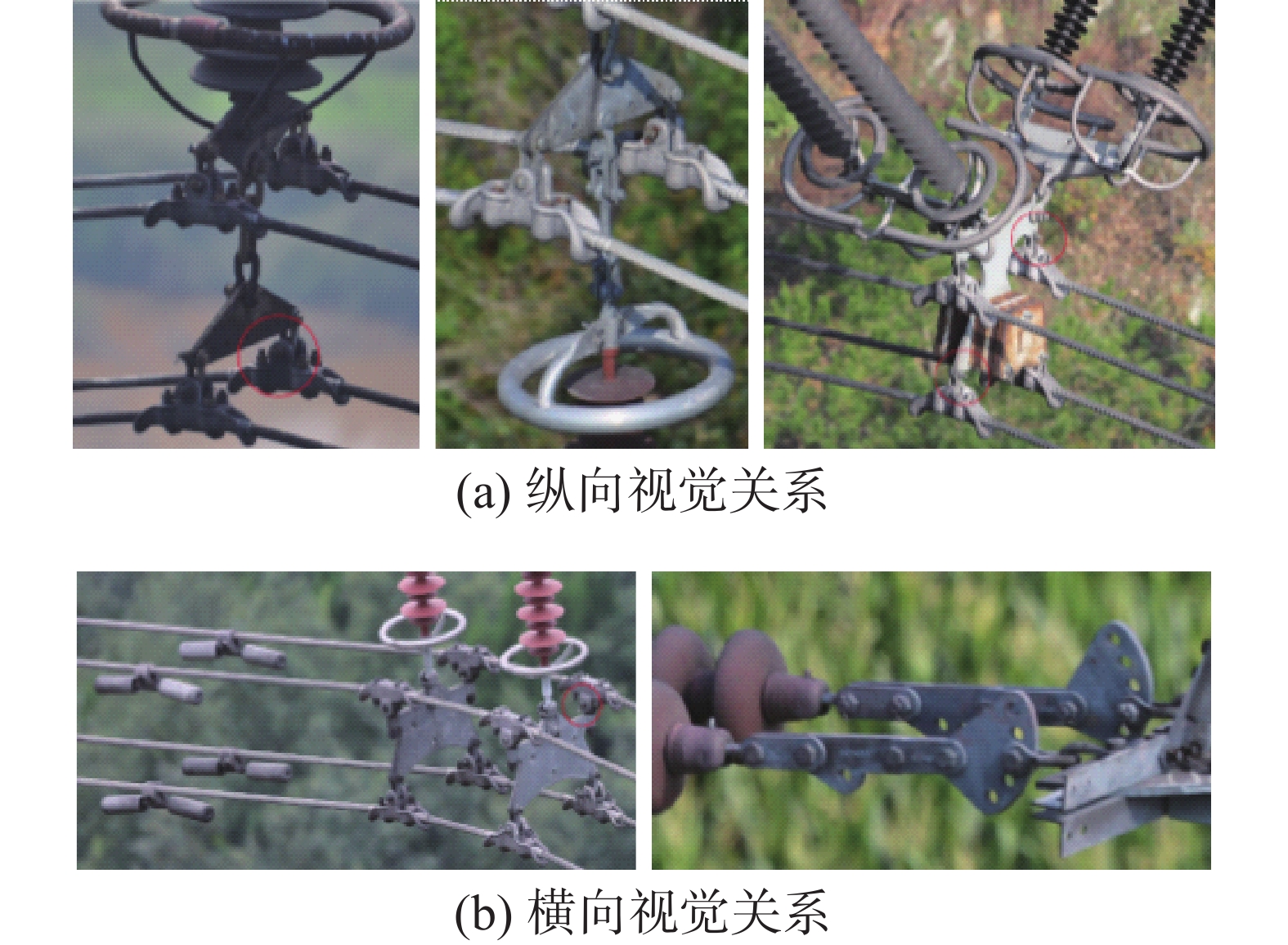

在架空输电线路的设计和建造过程中,为了达到标准的电气要求和安装规范,输电线路金具之间往往具有较为固定的组合规则和结构[19],区别于场景复杂、多类目标共有的上下文信息较少的单一目标检测模型,融合金具之间的视觉关系先验知识有助于更好地实现金具检测。由于无人机采集金具图像时相机视线相对平行于地面,并且金具的组装连接呈现出结构化、固定化的特点,所以金具各类别呈现在图像上会出现强烈的空间视觉关系,如纵向视觉关系和横向视觉关系。如图2,均压环、屏蔽环通常存在于整个组合结构的上端或者下端,和悬垂线夹、联板、重锤等存在明显纵向视觉关系;成对的联板和重锤出现的时候会存在横向视觉关系,防震锤作为减轻输电线路受微风影响的防护金具,通常出现在整个组合结构的周围,并构成横向视觉关系,调整板和U型挂环往往同时出现,并存在横向视觉关系。

除了上述2种视觉关系外,金具数据集中标注框之间的视觉重叠关系不可忽略,标注框之间的重叠区域影响模型对单个目标的识别度,尤其出现目标尺寸较小重叠区域较大的情况(如图3a),而且有部分重叠区域是单个目标的关键特征部分(如图3b),由于部分金具之间的固定组合结构,金具之间毗邻连接,标注框同样会出现重叠部分(如图3c),这样的视觉重叠关系可以帮助本文判断金具之间的连接关系,提高检测精度。

基于以上3种视觉关系,本文从数据集标注框的相对位置以及相对空间角度出发,制定了提取3种视觉关系的具体规则。

对于一个关系对(S,O),本文使用bs和bo来表示对应目标边界框归一化后的左上角坐标和右下角坐标。其中

$$ \left\{ {\begin{array}{*{20}{c}} {{b_o} = ({x_{1o}},{y_{1o}},{x_{2o}},{y_{2o}})} \\ {{b_s} = ({x_{1s}},{y_{1s}},{x_{2s}},{y_{2s}})} \end{array}} \right. $$ (1) 1)视觉重叠关系

$$ \nabla = {\left[ {\min ({x_{2i}}) - \max ({x_{1i}})} \right]_ + } \times \\ {\left[ {\min ({y_{2i}}) - \max ({y_{1i}})} \right]_ + }$$ (2) 使用式(2)计算2个对象框是否存在重叠区域,其中

$ i \in \{ s,o\} $ ,${[\cdot]}_{+}=\mathrm{max}(0,\cdot)$ 表示仅保留输入为正数的部分,$ \nabla $ 代表重叠值,如果计算重叠值大于0,那么就认为关系对(S,O)之间存在视觉重叠关系。2)纵向视觉关系和横向视觉关系

将关系对(S,O)的边界框坐标进行相应的转化得到边界框的中心坐标

${b_s'} = ({x_s},{y_s})$ 和${b_o'} = ({x_o},{y_o})$ ,样,2个坐标中心对$({b_s'} ,{b_o'} )$ 在二维平面可以确定一个向量lso,设向右为正方向水平向量为l,计算两向量的夹角$ \theta $ ,那么空间关系RS可以为$$ R_{\rm{S}}=\left\{\begin{split} &1\text{,} {45}^{ \circ } < \theta \leqslant {135}^{ \circ }\\ &0\text{,}其他\end{split} \right.$$ (3) 如果RS为1,认为是纵向视觉关系,否则是横向视觉关系。图4在二维平面中形象显示了这两种空间关系。以图像中心的重锤为观察对象,黄色阴影部分为横向视觉关系,蓝色阴影部分为纵向视觉关系,2个黑色圆弧夹角表示θ的大小,红色框内的均压环和重锤为纵向视觉关系,绿色框内的联板和重锤为横向视觉关系。

2.2 先验知识提取

根据既定规则,本文通过数据驱动的方式构建视觉关系概率矩阵,即通过挖掘标签在数据集中的视觉关系来定义标签之间的相关性。首先,假设单张图片中含有的标注信息为

$$ I = \{ ({c_1},{b_1}),({c_2},{b_2}),\cdots,({c_k},{b_k})\} $$ (4) 式中:k为标注框个数,c表示类别信息,b表示位置信息,然后从k个标注框中无重复的挑选2个标注框

$ {I_i} = ({c_i},{b_i}) $ 和$ {I_j} = ({c_j},{b_j}) $ 做关系构建,当满足任意一种关系时,两个标注框类别相对应的关系计数加1,即$$ {\Delta ^R}{({c_i},{c_j})^n} = {\Delta ^R}{({c_i},{c_j})^{n - 1}} + 1 $$ (5) 式中:

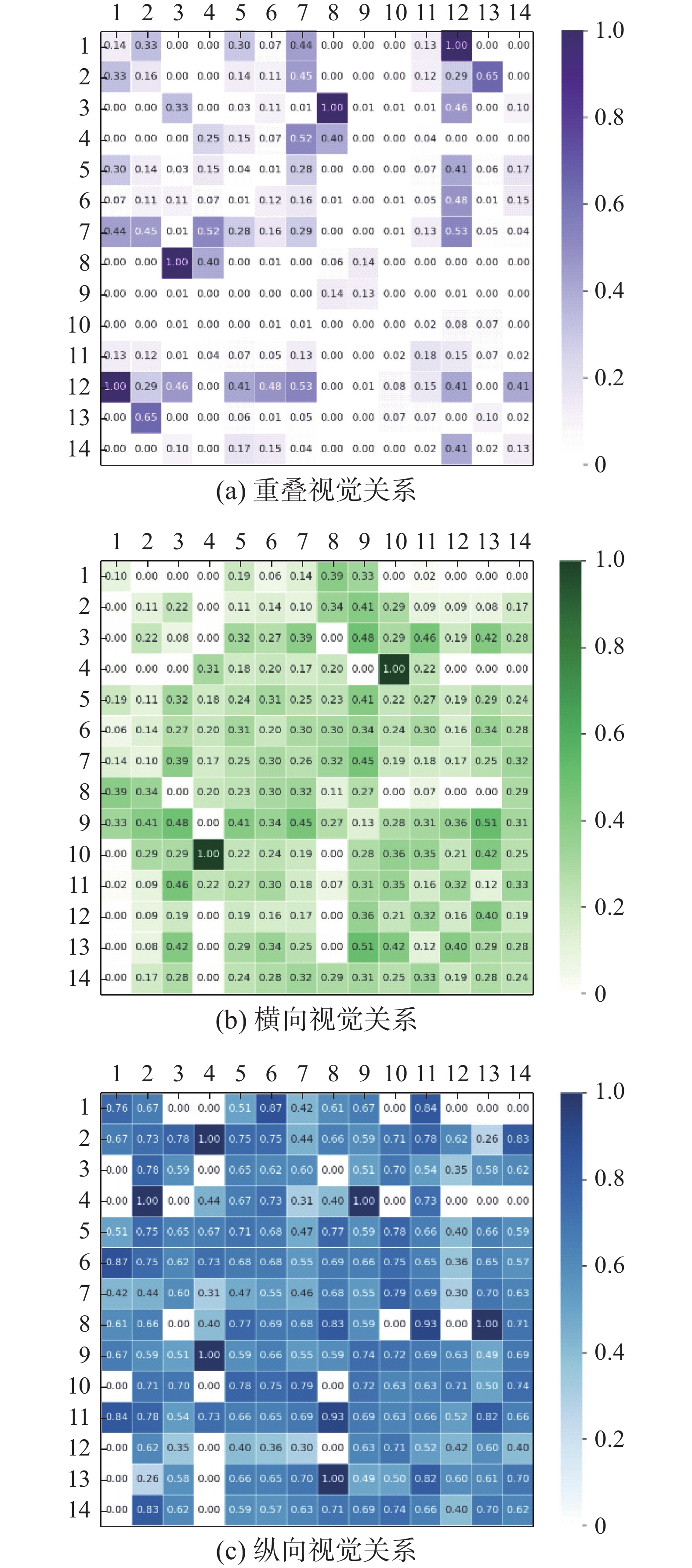

$ i \leqslant j \leqslant k $ ,$ {\Delta ^R}({c_i},{c_j}) $ 表示$ ({c_i},{c_j}) $ 属于某种关系。基于2.1节讨论,本文优先考虑视觉重叠关系,如果是视觉重叠关系,则忽略其余2种关系,最终统计单张图像所有的关系组合应为$ {\text{C}}_k^2 $ 个。统计数据集中所有关系组合,按3种关系归一化概率和为1的方式进行矩阵归一化,即$$ \sum {P({\Delta ^R}({c_i},{c_j}))} = 1 $$ (6) 对于本文数据集,共有14种类别,3种视觉关系,对应的关系组合为142×3=588种,如图5,将每种关系的概率得分以热力图的方式呈现,从左到右依次是重叠、横向、纵向视觉关系,热力图中横纵坐标序号对应的类别名称如表1所示。

表 1 序号和类别名称对应关系Table 1 Correspondence between serial number and category name序号 类别名称 序号 类别名称 1 预绞式悬垂线夹 8 并沟线夹 2 提包式悬垂线夹 9 防震锤 3 压缩型耐张线夹 10 间隔棒 4 锲型耐张线夹 11 均压环 5 挂板 12 屏蔽环 6 U型挂环 13 重锤 7 联板 14 调整板 3. 视觉关系表达

3.1 视觉关系掩码

为了更好地融合视觉关系知识,本文引入一种VRM的概念,下面本文将详细介绍MGA。

给定2个归一化后的目标框的位置信息为

$ {b_s} = ({x_{1s}},{y_{1s}},{x_{2s}},{y_{2s}}) $ 和$ {b_o} = ({x_{1o}},{y_{1o}},{x_{2o}},{y_{2o}}) $ 。1)初始化一个64×64像素大小的全零矩阵,作为背景;

2)把位置信息映射到背景上,得到新的位置信息

$ {M_{{{bs}}}} $ 和$ {M_{{{bo}}}} $ ;3)将新的边界框信息

$ {M_{{{bs}}}} $ 和$ {M_{{{bo}}}} $ 内部元素置为1,得到新的掩码M;4)最终的掩码M为视觉关系掩码。

假设一张图像中有k个预测框,则会出现

$ {\text{C}}_k^2 $ 个视觉关系掩码M,$ {\text{C}}_k^2 $ 个视觉关系掩码M共同决定了所有对象之间的视觉关系,将$ {\text{C}}_k^2 $ 个掩码拼接在一起,用$ \left[ M \right] $ 表示,称做掩码特征。掩码特征能够反应多个对象之间相互作用的视觉关系,而视觉特征描述的是单个对象的高层语义信息,因此本文认为视觉关系掩码和视觉特征可以共同促进对图像的整体理解。3.2 视觉关系检测

为了有效地利用掩码特征

$ \left[ M \right] $ ,本文构建了一种VRDN。在VRDN之前,输入图像经过卷积神经网络提取高层语义信息,经过RPN和ROI池化得到固定尺度的特征图,在经过全连接层得到最终的预测框信息,在这些预测框信息中,挑选128个预测框进行分类损失$ {\mathcal{L}_c} $ 和定位损失$ {\mathcal{L}_l} $ 计算,其中正负样本数量按1∶3划分。为了和模型的预测阶段有效的联系起来,本文采用和预测阶段相同的操作,取这些正样本中置信度大于0.05的预测框,并进行阈值为0.5的非极大值抑制,在过滤完的预测框中按置信度排序,挑选前N个预测框构建掩码特征

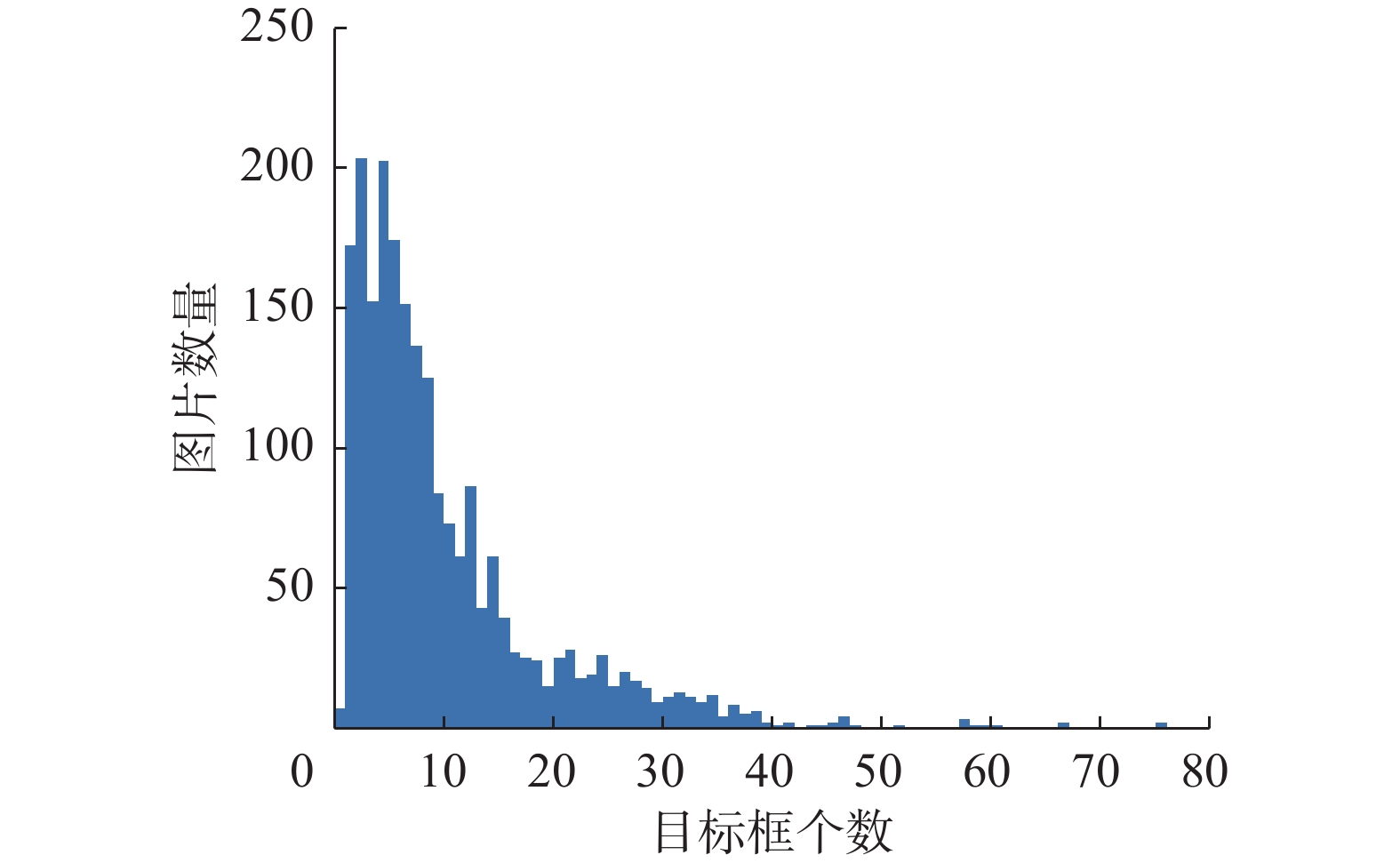

$ \left[ M \right] $ ,然后送入视觉关系检测网络中。对于N的选取,本文统计了数据集中每张图像标注的目标框个数,并以横轴为每张图片上目标框数量,纵轴为对应的图像数量做直方图,如图6是目标框数量直方图,并选取N为{8,16,32}进行实验对比,实验结果将会在4.1节给出。VRDN由6个卷积层、一个注意力模块和全连接层组成。由于较大的卷积核尺寸在增大感受野的同时能获得图像更多的全局特征,为了提高网络的表征能力,本文将前4个卷积层的卷积核尺寸大小设置为5;后2个卷积层卷积核尺寸大小设置为1,主要起到降维的作用;全连接层的最后一个节点个数设置为3,对应3种视觉关系。为了让网络能够关注局部特征信息,受Hu等[20]的启发,本文引入了一个注意力模块(squeeze and excitation layer, SELayer),该模块能够让网络重新校准学习特征,有选择的强调有用信息,抑制无用信息,这对于学习图像中局部目标框之间的相对空间位置是非常有用的。

通过融入视觉关系先验知识,本文设计了一个损失函数

$ {\mathcal{L}_R} $ 用于拉近对象之间的视觉关系与真实世界的距离。函数设计为$$ {\mathcal{L}_R} = \min \left(\sum\limits_{k = 1}^N {\mathcal{L}_M^k} \right) $$ (7) 式中:N为

$ \left[ M \right] $ 中M的个数,$ \mathcal{L}_M^k $ 表示第k个M的计算损失,每一个M的计算损失$ {\mathcal{L}_M} $ 为$$ {\mathcal{L}_M} = \psi \{ \phi [\phi [{O^R}({c_i},{c_j})] + P({\Delta ^R}({c_i},{c_j}))],{G^R}({c_i},{c_j})\} $$ (8) 其中:

$\psi \{\cdot,\cdot\}$ 表示$\{\cdot,\cdot\}$ 做交叉熵损失,$\varphi [\cdot]$ 表示经softmax归一化处理,$ {O^R}({c_i},{c_j}) $ 表示M经过VRDN后的输出,$ P({\Delta ^R}({c_i},{c_j})) $ 表示M中2个预测框的先验概率,$ {G^R}({c_i},{c_j}) $ 表示两目标类别的真实视觉关系。通过视觉先验知识进行辅助校正VRDN的预测输出,增强对应类别的预测得分,最大化的促进对象之间不同关系的共生。最终,将视觉关系损失

$ {\mathcal{L}_R} $ 、分类损失$ {\mathcal{L}_c} $ 和定位损失$ {\mathcal{L}_l} $ 累加,作为金具检测模型的总体损失,3种损失在反向传播的过程中共享主干网络和RPN网络参数,通过外加的VRDN提高原模型检测精度,此外,VRDN将训练阶段和预测阶段有效地联系起来,提高模型的准确率。4. 实验结果及分析

本文的实验数据集为5760像素×3840像素和4288像素×2848像素的高分辨图像,选取14类金具作为实验对象,共包含20 804个实例对象,其中训练集和验证集按4∶1划分。本文所述模型采用NVIDIA 1080Ti 专业加速卡进行训练与测试;采用的操作系统为Ubuntu16.04.6 LTS,利用CUDA10.0 加速训练;使用的计算机语言为Python3.6,网络开发框架为Pytorch。在训练阶段,将批处理大小设为2,使用了随机梯度下降[21] (SGD)算法,初始学习率设为0.004,每经过3个epoch,学习率下降为原来的33%,最多迭代训练16个epoch。

采用目前目标检测模型中常用的评价指标平均精度均值(mean average precision, mAP) 对模型进行评估,通过度量目标检测框与真值框间的IoU 计算各类目标平均精度(average precision, AP),以所有类目标的AP平均值(mAP)作为目标检测模型的最终评价指标。由于金具目标尺度的多样性,本文以Faster R-CNN[22]加特征金字塔结构[23](feature pyramid network, FPN)进行多尺度检测,并作为基础框架加以改进,以此来验证视觉关系检测模块的有效性。

4.1 消融实验

为了提高基线模型的检测精度,首先使用在COCO[24]数据集上预训练的Faster R-CNN+FPN模型参数进行训练,将训练完毕后的模型再次作为预训练权重进行加载,以此来提升基线模型的检测精度。为保证视觉先验知识的有效性,训练阶段并没有使用任何图像增强技术,因为一些图像增强技术(如:旋转、平移、翻转等)会破坏金具之间的视觉关系。表2为14类金具的AP50测试结果对比,表3为N为不同值时的金具的mAP50以及mAP50:95的测试结果对比。

表 2 14类金具测试结果Table 2 Test results of 14 types of fittings% 模型 预绞式悬垂线夹 提包式悬垂线夹 并沟线夹 防震锤 U型挂环 挂板 联板 Baselinecoco 70.59 90.98 32.20 88.16 53.11 62.25 72.00 Baselineours 80.91 91.94 39.27 87.05 55.77 65.40 75.99 Ours-8 77.80 93.37 43.06 87.15 56.45 66.36 77.51 Ours-16 78.58 92.63 46.21 86.85 60.11 68.33 76.66 Ours-32 77.29 92.40 40.65 87.50 58.88 66.48 76.20 模型 压缩型耐张线夹 锲型耐张线夹 间隔棒 均压环 屏蔽环 重锤 调整板 Baselinecoco 52.97 32.48 82.02 89.25 68.73 98.33 78.66 Baselineours 52.51 54.79 87.78 88.62 67.24 99.57 79.42 Ours-8 57.25 66.27 86.33 90.53 70.28 99.04 80.92 Ours-16 59.71 69.99 88.67 90.52 69.41 97.52 82.44 Ours-32 58.98 74.57 85.16 89.97 68.31 99.19 82.77 表 3不同N值的检测结果 Table 3 Detection results for different N values% 模型 mAP50 mAP50:95 Baselinecoco 69.41 37.10 Baselineours 73.30 40.96 本文-8 75.17 41.35 本文-16 76.25 42.50 本文-32 75.60 42.26 其中,

${\rm{ Baselin{e_{coco}} }}$ 表示使用COCO的预训练权重,${\rm{Baselin{e_{ours}}}}$ 表示加载使用COCO权重训练一次的预训练权重,Ours-K中的K代表计算掩码特征时筛选前K个正样本。从表2可以看出,本文模型对于绝大多数金具的检测效果都有一定的提升,其中对于锲型耐张线夹、压缩型耐张线夹、并沟线夹、U型挂环以及挂板的检测效果有显著的提升。由于并沟线夹目标体积小,传统模型没有考虑视觉关系,并沟线夹容易“淹没”在复杂背景中,本文考虑并沟线夹和其他金具的视觉关系,提升了对并沟线夹的检测;U型挂环和挂板由于目标体积小,目标框重叠部分区域较大,容易重复学习相同特征,从而造成传统模型的误判;锲型耐张线夹和压缩型耐张线夹形状及纹理特征和导线相似,且锲型耐张线夹在数据集中出现次数较少,传统模型没有得到充分学习。本文的方法充分考虑了数据集中金具之间的视觉关系,较传统模型有了较大的提升,从锲型耐张线夹案例还可以看出本文的模型对样本数量分布不均有一定的适应能力。从表3可以看出,将在COCO数据集上将训练完毕后的模型参数再次作为新的预训练权重能有效提高金具的检测精度,给一些检测精度较低的模型提供了新的方法。加入视觉关系检测模块后能够提高模型的检测准确率,与基线模型相比,mAP50和mAP50:95分别提高了2.95%、1.54%;N的大小一定程度上决定了VRDN的效果,N过大容易包含过多的负样本,干扰VRDN对视觉关系的判断;N过小不能包含较多的正样本,很多预测正确的目标框没有得以利用,VRDN的性能不能得以体现。其中N为16时模型的检测精度最高,这说明N值过大或者过小都会影响检测精度。

4.2 模型检测结果可视化对比实验

为了定性地分析本文模型的检测效果,图7显示了本文所述模型与基线模型的分析对比,第1行为基线检测结果,第2行为改进后模型检测结果。由于锲型耐张线夹纹理特征较其他金具不明显,在图7(a)中基线模型出现了漏判的情况,在图7(b)中出现了误判的情况,考虑金具之间的视觉关系后,使用本文算法进行检测后提高了锲型耐张线夹的检测置信度和检测精度;图7(c)显示的是对具有遮挡关系的小目标的检测对比,基线模型出现了误判的情况,错将调整板识别为挂板,本文算法准确识别出了各类金具;图7(d)中出现了联板多检测的情况,说明基线模型在检测的过程中对金具目标定位不准,本文算法在考虑视觉关系后,能优化基线模型对目标的定位效果。

4.3 与先进模型对比实验

为了验证本文模型的先进性,本文在金具数据集上实现了多种目标检测模型,分别与SSD[25]、YOLOv3以及YOLOv3-SPP[26]进行比较。

表4显示了所有模型mAP50、mAP50:95以及部分金具AP50的检测结果的检测结果,为了保证实验的可靠性,在与其他模型做对比的过程中,同样没有采用数据增强技术。

表 4 所有模型的检测结果对比Table 4 Comparison of test results of all models模型 图像尺寸/像素 金具类别/% mAP50/% mAP50:95/% 锲型耐张线夹 挂板 并沟线夹 U型挂环 间隔棒 Baselinecoco 608×608 32.48 62.25 32.20 53.11 82.02 69.41 37.10 Baselineours 600×800 54.79 65.40 39.27 55.77 87.78 73.30 40.96 SSD 600×600 56.20 61.14 43.88 59.80 71.49 72.33 40.74 YOLOv3 608×608 59.55 55.87 29.15 50.08 80.04 64.96 35.86 YOLOv3-SPP 608×608 61.42 65.93 35.53 56.46 83.80 72.55 41.17 本文-16 600×800 69.99 68.33 46.21 60.11 88.67 76.25 42.50 从表4中可以看出,本文模型相比于现阶段主流模型的mAP50指标有较大的提升,在部分金具检测结果上同样有较大提升,尤其对密集遮挡小目标U型挂环、刮板之类的金具提升较大,这说明加入视觉关系检测模块同样能够应对目标的密集遮挡问题;由于数据集中锲型耐张线夹、并沟线夹目标特征不明显,其他的主流模型没有充分考虑到视觉关系,本文加入视觉关系检测模块后,能有效提高检测精度,一定程度上说明了本文算法的泛化能力优于其他主流模型。

5. 结束语

本文提出了一种基于视觉关系掩码的多类别金具检测模型,实现了金具的精确定位与识别,通过对比实验分析,得到如下结论:

1)针对输电线路金具图像背景复杂和目标特征不明显及相互重叠的问题,本文通过挖掘金具之间的视觉关系先验知识,将其作为辅助信息融入视觉关系模块中,实现了多类别金具的精确识别。

2)在定性对比实验中,针对基线模型和改进模型的检测效果进行可视化对比,改进模型对小目标漏判、错判、多判以及互相遮挡问题均有改善。

3)在定量对比实验中,本文改进后的模型相较于基线模型mAP50指标提高了2.95%,较其他先进模型mAP50和mAP50:95指标均有一定的提升,并在部分金具检测效果上提升明显。

本文使用金具之间视觉关系和先验知识来改善金具的检测效果,为输电线路设备部件智能巡检技术提供了新的思路。未来工作拟深入研究视觉关系知识与模型的融合,使用知识推理的方法使视觉关系知识得到更有效的表达,从而实现更准确的多类别金具检测。

-

表 1 序号和类别名称对应关系

Table 1 Correspondence between serial number and category name

序号 类别名称 序号 类别名称 1 预绞式悬垂线夹 8 并沟线夹 2 提包式悬垂线夹 9 防震锤 3 压缩型耐张线夹 10 间隔棒 4 锲型耐张线夹 11 均压环 5 挂板 12 屏蔽环 6 U型挂环 13 重锤 7 联板 14 调整板 表 2 14类金具测试结果

Table 2 Test results of 14 types of fittings

% 模型 预绞式悬垂线夹 提包式悬垂线夹 并沟线夹 防震锤 U型挂环 挂板 联板 Baselinecoco 70.59 90.98 32.20 88.16 53.11 62.25 72.00 Baselineours 80.91 91.94 39.27 87.05 55.77 65.40 75.99 Ours-8 77.80 93.37 43.06 87.15 56.45 66.36 77.51 Ours-16 78.58 92.63 46.21 86.85 60.11 68.33 76.66 Ours-32 77.29 92.40 40.65 87.50 58.88 66.48 76.20 模型 压缩型耐张线夹 锲型耐张线夹 间隔棒 均压环 屏蔽环 重锤 调整板 Baselinecoco 52.97 32.48 82.02 89.25 68.73 98.33 78.66 Baselineours 52.51 54.79 87.78 88.62 67.24 99.57 79.42 Ours-8 57.25 66.27 86.33 90.53 70.28 99.04 80.92 Ours-16 59.71 69.99 88.67 90.52 69.41 97.52 82.44 Ours-32 58.98 74.57 85.16 89.97 68.31 99.19 82.77 表 3

不同N值的检测结果 Table 3 Detection results for different N values

% 模型 mAP50 mAP50:95 Baselinecoco 69.41 37.10 Baselineours 73.30 40.96 本文-8 75.17 41.35 本文-16 76.25 42.50 本文-32 75.60 42.26 表 4 所有模型的检测结果对比

Table 4 Comparison of test results of all models

模型 图像尺寸/像素 金具类别/% mAP50/% mAP50:95/% 锲型耐张线夹 挂板 并沟线夹 U型挂环 间隔棒 Baselinecoco 608×608 32.48 62.25 32.20 53.11 82.02 69.41 37.10 Baselineours 600×800 54.79 65.40 39.27 55.77 87.78 73.30 40.96 SSD 600×600 56.20 61.14 43.88 59.80 71.49 72.33 40.74 YOLOv3 608×608 59.55 55.87 29.15 50.08 80.04 64.96 35.86 YOLOv3-SPP 608×608 61.42 65.93 35.53 56.46 83.80 72.55 41.17 本文-16 600×800 69.99 68.33 46.21 60.11 88.67 76.25 42.50 -

[1] 王宾, 倪江, 王海港, 等. 输电线路弧光高阻接地故障单端测距分析[J]. 中国电机工程学报, 2017, 37(5): 1333–1341. WANG Bin, NI Jiang, WANG Haigang, et al. Single-end fault location for high impedance arc grounding fault in transmission line[J]. Proceedings of the CSEE, 2017, 37(5): 1333–1341. [2] 刘传洋, 吴一全. 基于深度学习的输电线路视觉检测方法研究进展[J/OL]. 中国电机工程学报, 2022: 1−24. (2022−08−31). https://kns.cnki.net/kcms/detail/11.2107.TM.20220831.1053.002.html. LIU Chuanyang, WU Yiquan. Research progress of vision detection methods based on deep learning for transmission lines[J/OL]. Proceedings of the CSEE, 2022: 1−24. (2022−08−31).https://kns.cnki.net/kcms/detail/11.2107.TM.20220831.1053.002.html. [3] 马忠梅, 韩宝卿, 李文娟, 等. 智能识别技术在无人机输电线路巡检中的应用[J]. 集成电路应用, 2022, 39(8): 126–127. doi: 10.19339/j.issn.1674-2583.2022.08.050 MA Zhongmei, HAN Baoqing, LI Wenjuan, et al. Application of intelligent identification in UAV inspection for transmission lines[J]. Application of IC, 2022, 39(8): 126–127. doi: 10.19339/j.issn.1674-2583.2022.08.050 [4] 王杨杨, 曹晖, 莫文昊. 基于深度学习的改进型YOLOv4输电线路鸟巢检测与识别[J]. 智慧电力, 2023, 51(1): 101–107. doi: 10.3969/j.issn.1673-7598.2023.01.015 WANG Yangyang, CAO Hui, MO Wenhao. Bird’s nest detection and identification on improved YOLOv4 transmission line based on deep learning[J]. Smart power, 2023, 51(1): 101–107. doi: 10.3969/j.issn.1673-7598.2023.01.015 [5] 李轶. 基于深度学习的无人机输电线路巡检故障检测研究[J]. 流体测量与控制, 2022, 3(6): 56–58,82. LI Yi. Research on fault detection of UAV transmission line inspection based on deep learning[J]. Fluid measurement & control, 2022, 3(6): 56–58,82. [6] 翟永杰, 杨旭, 赵振兵, 等. 融合共现推理的Faster R-CNN输电线路金具检测[J]. 智能系统学报, 2021, 16(2): 237–246. doi: 10.11992/tis.202012023 ZHAI Yongjie, YANG Xu, ZHAO Zhenbing, et al. Integrating co-occurrence reasoning for Faster R-CNN transmission line fitting detection[J]. CAAI transactions on intelligent systems, 2021, 16(2): 237–246. doi: 10.11992/tis.202012023 [7] 和敬涵, 罗国敏, 程梦晓, 等. 新一代人工智能在电力系统故障分析及定位中的研究综述[J]. 中国电机工程学报, 2020, 40(17): 5506–5516. doi: 10.13334/J.0258-8013.PCSEE.200032 HE Jinghan, LUO Guomin, CHENG Mengxiao, et al. A research review on application of artificial intelligence in power system fault analysis and location[J]. Proceedings of the CSEE, 2020, 40(17): 5506–5516. doi: 10.13334/J.0258-8013.PCSEE.200032 [8] 刘召, 张黎明, 耿美晓, 等. 基于改进的Faster R-CNN高压线缆目标检测方法[J]. 智能系统学报, 2019, 14(4): 627–634. doi: 10.11992/tis.201905026 LIU Zhao, ZHANG Liming, GENG Meixiao, et al. Object detection of high-voltage cable based on improved Faster R-CNN[J]. CAAI transactions on intelligent systems, 2019, 14(4): 627–634. doi: 10.11992/tis.201905026 [9] 宋万潼, 李冰锋, 费树岷. 基于先验知识的航拍绝缘子检测方法[J]. 计算机工程, 2021, 47(8): 301–307,314. SONG Wantong, LI Bingfeng, FEI Shumin. Prior knowledge-based insulator detection method using aerial images[J]. Computer engineering, 2021, 47(8): 301–307,314. [10] 汤踊, 韩军, 魏文力, 等. 深度学习在输电线路中部件识别与缺陷检测的研究[J]. 电子测量技术, 2018, 41(6): 60–65. TANG Yong, HAN Jun, WEI Wenli, et al. Research on part recognition and defect detection of trainsmission line in deep learning[J]. Electronic measurement technology, 2018, 41(6): 60–65. [11] 高强, 廉启旺. 航拍图像中绝缘子目标检测的研究[J]. 电测与仪表, 2019, 56(5): 119–123. GAO Qiang, LIAN Qiwang. Research on target detection of insulator in aerial image[J]. Electrical measurement & instrumentation, 2019, 56(5): 119–123. [12] 赵振兵, 江爱雪, 戚银城, 等. 嵌入遮挡关系模块的SSD模型的输电线路图像金具检测[J]. 智能系统学报, 2020, 15(4): 656–662. doi: 10.11992/tis.202001008 ZHAO Zhenbing, JIANG Aixue, QI Yincheng, et al. Fittings detection in transmission line images with SSD model embedded occlusion relation module[J]. CAAI transactions on intelligent systems, 2020, 15(4): 656–662. doi: 10.11992/tis.202001008 [13] 戚银城, 江爱雪, 赵振兵, 等. 基于改进SSD模型的输电线路巡检图像金具检测方法[J]. 电测与仪表, 2019, 56(22): 7–12,43. doi: 10.19753/j.issn1001-1390.2019.022.002 QI Yincheng, JIANG Aixue, ZHAO Zhenbing, et al. Fittings detection method in patrol images of transmission line based on improved SSD[J]. Electrical measurement & instrumentation, 2019, 56(22): 7–12,43. doi: 10.19753/j.issn1001-1390.2019.022.002 [14] WAN Neng, TANG Xuming, LIU Siyan, et al. Transmission line image object detection method considering fine-grained contexts[C]//2020 IEEE 4th Information Technology, Networking, Electronic and Automation Control Conference. Chongqing: IEEE, 2020: 499−502. [15] 赵振兵, 李延旭, 甄珍, 等. 结合KL散度和形状约束的Faster R-CNN典型金具检测方法[J]. 高电压技术, 2020, 46(9): 3018–3026. ZHAO Zhenbing, LI Yanxu, ZHEN Zhen, et al. Typical fittings detection method with faster R-CNN combining KL divergence and shape constraints[J]. High voltage engineering, 2020, 46(9): 3018–3026. [16] JOYCE J M. Kullback-leibler divergence[M]//International encyclopedia of statistical science. Berlin: Springer, 2011: 720−722. [17] SENHAJI K, RAMCHOUN H, ETTAOUIL M. Training feedforward neural network via multiobjective optimization model using non-smooth L1/2[J]. Neurocomputing, 2020, 410: 1–11. doi: 10.1016/j.neucom.2020.05.066 [18] FAN Qi, ZHOU Wei, TANG Chikeung, et al. Few-shot object detection with attention-RPN and multi-relation detector[C]//Proceedings of the IEEE/CVF conference on computer vision and pattern recognition. Seattle: IEEE, 2020: 4013−4022. [19] 刘兴亚, 周洋. 特高压交流输电线路跳线安装施工技术[J]. 集成电路应用, 2021, 38(12): 94–95. LIU Xingya, ZHOU Yang. Installation and construction technology of jumper for UHV AC transmission line[J]. Application of IC, 2021, 38(12): 94–95. [20] HU Jie, SHEN Li, SUN Gang. Squeeze-and-excitation networks[C]//2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City: IEEE, 2018: 7132−7141. [21] BOTTOU L. Stochastic gradient descent tricks[J]. Neural networks: tricks of the trade (second edition), 2012: 421−436. [22] REN Shaoqing, HE Kaiming, GIRSHICK R, et al. Faster R-CNN: towards real-time object detection with region proposal networks[J]. IEEE transactions on pattern analysis and machine intelligence, 2017, 39(6): 1137–1149. doi: 10.1109/TPAMI.2016.2577031 [23] LIN T Y, DOLLÁR P, GIRSHICK R, et al. Feature pyramid networks for object detection[C]//2017 IEEE Conference on Computer Vision and Pattern Recognition. Honolulu: IEEE, 2017: 936−944. [24] LIN T Y, MAIRE M, BELONGIE S, et al. Microsoft COCO: common objects in context[M]//Computer Vision – ECCV 2014. Cham: Springer International Publishing, 2014: 740−755. [25] LIU Wei, ANGUELOV D, ERHAN D, et al. SSD: single shot MultiBox detector[C]//European Conference on Computer Vision. Cham: Springer, 2016: 21−37. [26] REDMON J, FARHADI A. YOLOv3: an incremental improvement[EB/OL]. (2018−04−08)[2022−02−24]. https://arxiv.org/abs/1804.02767.

下载:

下载: