A method for super resolution processing of bolt image based on feature transfer

-

摘要: 针对输电线路巡检采集的螺栓图像存在模糊、分辨率低等问题,本文根据螺栓之间相似度较高的特点,提出了一种基于特征迁移的螺栓图像超分辨率处理方法。本文首次将特征迁移引入螺栓图像超分中,先对比低分辨率图像与清晰参考图像的特征区域,将图像之间相似度高的区域进行特征迁移,并根据迁移特征的相似度调整迁移特征的比例,然后在感知损失函数中加入迁移特征相似度的约束,保证迁移特征的准确性。不同超分模型的螺栓图像超分实验结果表明,本方法的螺栓超分图像更清晰,峰值信噪比、结构相似性指标更优;此外,超分前后螺栓图像的缺陷识别实验对比结果表明,超分后螺栓的缺陷识别准确率提升了3.61%,实验结果验证了本文方法的有效性。Abstract: Aiming at the problems of blurring and low resolution of bolt images collected during inspection of transmission lines, a super-resolution processing method of bolt images based on feature migration is proposed according to the characteristics of high similarity between bolts. In this paper, feature transfer is introduced into bolt image super resolution for the first time. First, compare feature regions of the low-resolution image and the clear reference image, then carry out feature transfer of the regions with high similarity between the images, and then adjust the proportion of transfer features according to similarity of the transferred features. Then, the constraint of similarity of the transfer features is added to the perceptual loss function to ensure accuracy of the transfer features. The results of the bolt image over-segmentation experiments with different over-segmentation models show that the bolt over-segmentation images of this method are clearer, and the PSNR and SSIM indicators are better; The defect recognition accuracy rate of the bolt increased by 3.61% after ove-segmentation. The experimental results fully verify effectiveness of this method in solving the problem of blurred bolt images.

-

Keywords:

- bolt /

- image super resolution /

- deep learning /

- feature transfer /

- transmission line /

- defect recognition /

- neural network /

- ntelligent patrol

-

螺栓作为固定与连接输电线路各部件的重要部分,是输电线路必不可少的紧固件。由于输电线路长期在野外工作,受环境及螺栓自身张力的影响,螺栓易产生缺销、螺母松动、螺母缺失等缺陷,影响输电线路的安全运行[1]。所以实时有效地识别出螺栓缺陷并排除输电隐患,对保证输电线路的安全稳定十分重要。

目前,无人机巡检已成为输电线路主要的巡检手段[2],受环境与航拍设备自身抖动的影响,航拍采集到的螺栓图像中存在大量模糊、分辨率低的样本,这些样本限制了螺栓识别的准确率。虽然近年一些螺栓识别模型取得了一定的进展[3-4],但提高数据集分辨率,提升螺栓图像的可分析性可以更直接的影响到螺栓识别的结果,对螺栓缺陷识别意义重大。图像超分辨率处理技术(super-resolution, SR)就是将图像从低分辨率(low-resolution, LR)向高分辨率(high-resolution, HR)转化,使低分辨率图像中的细节更加清晰自然。目前,图像超分辨率技术一般分为3类:1) 基于插值的方法[5-7],这种方法较为简单,但这种线性模型输出的图像通常过度平滑导致图像视觉质量较差,很难对图像高频细节进行恢复;2) 基于重建的超分技术,这类超分以均衡及非均衡采样定理为基础,根据低分辨率图像的采样信号对高分辨率信号进行预估[8-12],一般采用基于频域或空域的方法实现,计算复杂度高,难以利用先验知识;3) 基于学习的超分方法,这种方法以高分辨率图像为基础构建学习库生成学习模型,通过学习高分辨率图像对低分辨率图像之间的特点还原图像的高频细节,从而获得分辨率高、视觉效果清晰的图像。相对于其他方法,基于深度学习的超分辨率方法可以自主提取图像特征生成更好的图像结果,输出的图像更加清晰自然,同时生成结果的速度也相对较快,所以本文使用这类方法对螺栓图像进行超分。

基于学习的图像超分辨方法有单图像超分辨率(single image super-resolution, SISR)与多图像超分辨率(multi-image super-resolution, MISR)2种。超分辨率卷积神经网络(super-resolution convolutional neural networks, SRCNN)[13]将深度学习引入到SISR中,使用3层卷积神经网络(convolutional neural networks, CNN)对图像进行提取表达、映射及重构。深度超分辨率网络(very deep super resolution networks, VDSR)[14]与深度递归卷积网络(deeply-recursive convolutional network, DRCN)针对梯度消失问题,应用残差与递归网络,在加深网络层数的同时保证其不受梯度消失的影响。文献[15]提出了单图超分深度残差网络(enhanced deep residual networks for single image super resolution, EDSR),在加深网络的同时删除了批量归一化层,得到的图像有较好的效果。文献[16]提出的密集残差网络(residual dense network, RDN)结合密集网络与残差网络,充分利用了LR图像的特征信息使得图像恢复的更加逼真。文献[17]将对偶回归理论应用到SR中,提出了双回归网络(dual regression networks, DRN),该网络不仅学习图像从LR到HR的映射还学习了从HR到LR的的映射,在实际应用中效果明显。然而SISR会因为图像高频信息在退化过程中被破坏,导致LR图像无法恢复,MISR可以从参考图像中获取更清晰准确的细节,生成的图像也不会过于平滑。文献[18]第1次将参考图像引入图像超分辨率中,在训练过程中结合隐形马尔科夫模型(hidden Markov model, HMM)搜索参考图像相似区域,以恢复LR图像。Landmark[19]通过全局配准结合梯度匹配准则将参考图像与LR图像进行匹配,最后基于能量最小化重构HR图像。CrossNet[20]使用光流网络对图像进行配准,但局限性较大,仅限于光场图像等位移变化较小的参考图像,不利于实际应用。文献[21]提出的内外块匹配卷积网络(internal and external patch matching ConvNet, IENet)将神经网络代替人工特征提取,提升了模型整体效率。神经纹理迁移超分辨率(super-resolution by neural texture transfer, SRNTT)[22]使用卷积代替了图像块匹配,引入纹理迁移最大化参考图像的利用率。纹理转换网络图像超分辨率(texture transformer network for image super-resolution, TTSR)[23]使用注意力机制对参考图像与LR图像相似区域进行转化迁移,跨尺度的对图像特征进行提取转化从而达到更好的效果。因为螺栓之间的相似度较高,螺杆上的螺纹,螺母上的六边形,这些特征都是固定不变的,如果能够利用采集到的清晰图像做参考,对比图像之间的相似部分,将清晰螺栓图像上的特征向模糊螺栓图像进行迁移,就可以提升螺栓图像的分辨率。

为此,本文根据螺栓数据集中存在大量模糊、分辨率低的图像,螺栓之间相似特征明显的情况,提出了一种基于特征迁移的螺栓图像超分辨率方法。本文首次将特征迁移引入螺栓图像超分中,提取LR图像以及参考图像的特征信息,通过对比图像之间的相似区域向LR图像迁移特征信息,为确保迁移特征的准确性,保护图像原有信息不被破坏,本文使用了相似度矫正模块,根据迁移特征的相似程度调整迁移的比例,并且在损失函数中加入了对抗损失函数和感知损失函数,在感知损失函数中增加新的特征相似度约束,以便特征迁移的更为准确,生成的图像更加清晰自然。

1. 特征迁移的图像超分辨率方法

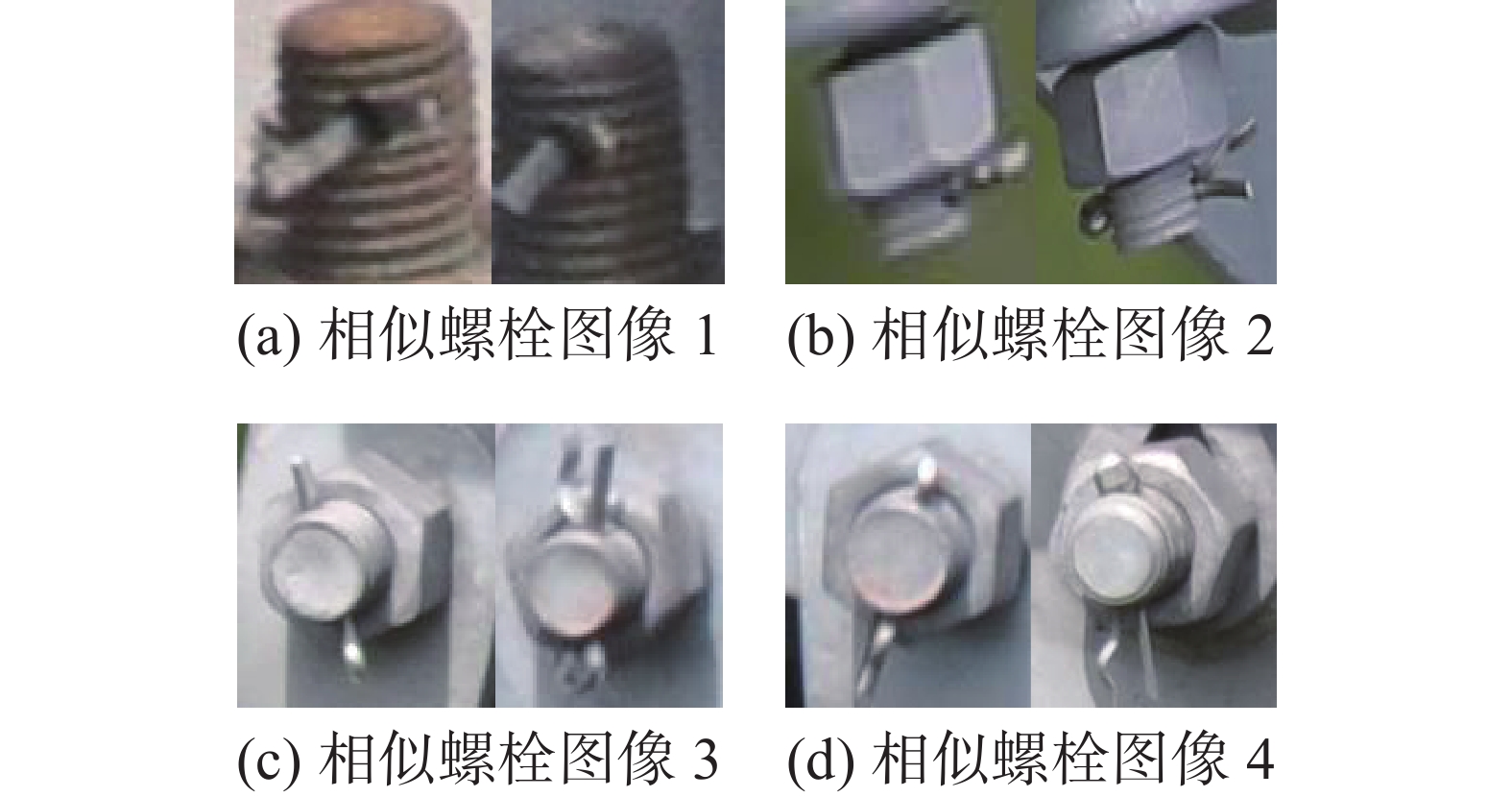

通过对航拍输电线路螺栓样本的观察发现,输电线路上螺栓之间存在大量相似样本,螺栓类内相似度较高,并且螺纹、螺杆等特征都固定不变,如图1所示。

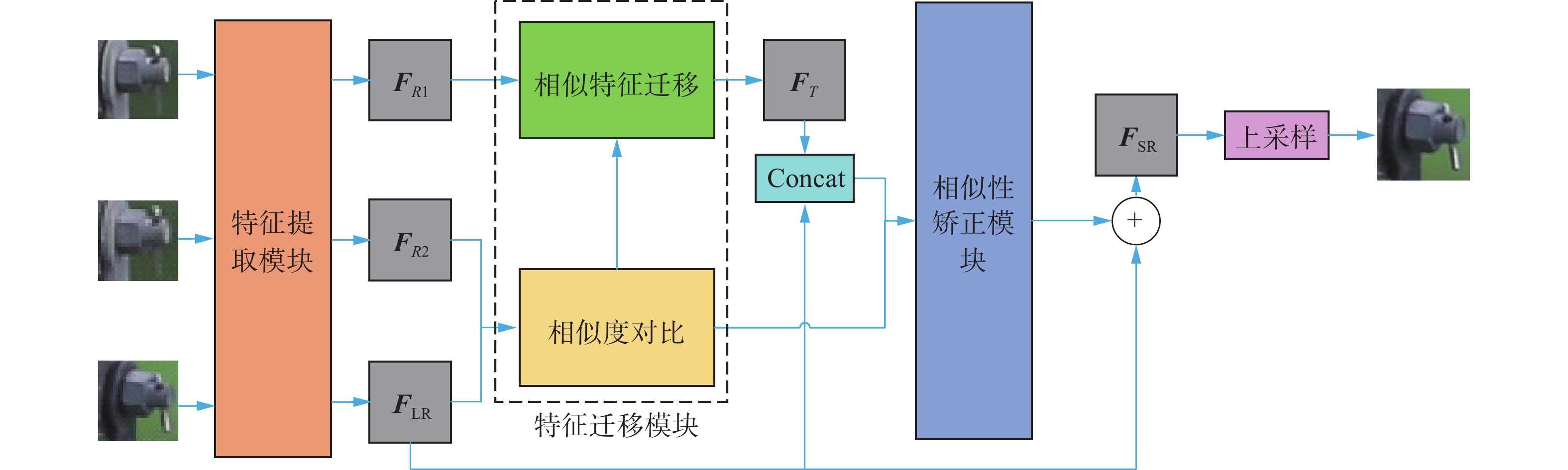

如果能够利用螺栓之间存在相似特征的特点,以HR图像作为参考图像,对比LR图像之后,将图像之间相似特征进行迁移,就可以生成清晰度高且真实自然的螺栓图像。为保证LR图像的原有信息不被破坏,本文提出根据迁移特征的相似度调整特征迁移比例的矫正模块,并且改进了损失函数,最终实现提升螺栓分辨率的目的。网络整体结构图如图2所示,首先利用特征提取模块提取LR图像与参考图像的图像特征,将提取出的特征进行相似度对比,根据相似度对比得出的结果迁移图像的特征信息,得到初级的SR图像特征,为保证LR图像特征的充分利用,这里将LR图像特征与初级的SR图像特征进行连接操作,之后本文根据LR图像与参考图像的相似性关系再次调整特征信息的迁移程度,防止迁移过程中出现过量迁移的问题,最后再融合LR特征并进行上采样处理得到SR结果图。

需要注意,参考图像与LR图像要放缩到相同尺寸才能保证特征迁移的准确,此外由于参考图像分辨率较高而LR图像较为模糊,如果直接提取LR图像和参考图像的特征用于相似度对比,结果往往不理想。因此本文先将参考图像双三次下采样降低其分辨率,再将其放缩到LR图像相同的尺寸,此时降质图像具有参考图像的信息,还具备LR图像近似的分辨率和相同的尺寸,使用降质图像进行相似度对比,图像之间的相似部分会更容易提取。本文的输入图像分别为LR图像、高清参考图像以及降质参考图像,如图3所示。

1.1 特征提取模块

准确高效的提取图像特征有助于超分辨率图像的生成。本文采用VGG19作为图像特征提取的网络,VGGNet(visual geometry group net)具有较强的泛化能力,在提取图像特征时会通过降维的方式优化网络模型,这样不仅能减少网络参数还有利于得到图像高层级的语义信息,但网络在降维的同时也丢失了低层级的像素信息,使得其在图像超分辨处理时不太友好,所以本文使用VGGNet第7层输出的特征信息作为后续模块的输入。输入到特征提取模块的图像包括LR图像、高清参考图像以及降质参考图像,生成的特征图分别用FLR、FR1、FR2表示。

1.2 特征迁移模块

要实现图像之间的特征迁移,就需要将LR图像与参考图像进行对比,找到2张图像之间的相似区域。本文将FLR与FR2展开成Patchs也就是一个一个的小正方形区域,因为这些区域包含更多的像素点,涵盖的信息更加丰富,对比2张图像之间的Patchs,找到相似度最高的部分进行迁移,这样生成图像会更加自然真实。

${L_i}(i \in [1,{H_{{\rm{LR}}}} \times {W_{{\rm{LR}}}}])$ 和$R_{2_j}(j \in [1,{H_{R2}} \times {W_{R2}}])$ 分别代表FLR与FR2的小正方形区域,本文通过归一化内积计算2区域之间的相似度ri,j:$$ {r_{i,j}} = \left\langle {\frac{{{L_i}}}{{\left\| {{L_i}} \right\|}},\frac{{R_{2_j}}}{{\left\| {R_{2_j}} \right\|}}} \right\rangle $$ ri,j的数值越大说明2个区域的相似程度越高,可迁移的特征信息也就越多,从而判断出参考图像和LR图像中哪2个区域的特征信息是可以对应迁移的。网络会选取2张图像之间最相似的区域,将HR特征区域的特征信息迁移到LR特征对应的区域内,由于先前计算相似性对比时使用的是降质参考图像,而网络要迁移的是高清图像中的特征信息,所以要先计算一个区域标志si:

$$ {s_i} = \mathop {\arg \max }\limits_j {r_{i,j}} $$ 代表参考图像中的第j个区域是与LR图像第i个区域最近似的,然后在迁移图像特征时以si为索引,对应降质参考图像找到高清参考图像中相同位置

$R_{1_i} $ 进行迁移:$$ R_{1_i} = R_{2_i}({s_i}) $$ 最终得到LR图像的HR特征表示FT。

1.3 相似度矫正模块

经迁移模块得到的特征图FT已经具备了HR细节特征,为进一步确保迁移特征信息的准确性,本文提出了相似度矫正模块对得到的HR特征进行矫正。在矫正之前,为使LR图像信息得到更充分的利用,本文先在FT基础上合并FLR,将合并之后的特征送入到相似度矫正模块中。现有的矫正方法大多直接对整张图片进行较正,但这种方法可能影响图像的原有信息,本文提出的相似度矫正模块是对相似度更高的迁移特征进行增强,对相似度较低的迁移特征进行削弱,通过矫正迁移特征改善图像质量。本方法从ri,j中计算出一个置信图P,pi表示FT中每个迁移特征区域的相似程度,根据pi值的大小判断该区域迁移特征的相似程度,从而实现对迁移特征的增强与削弱,pi为

$$ {p_i} = \mathop {\max }\limits_j {r_{i,j}} $$ 将得到的置信图P与FLR和FT合并得到的特征进行元素级相乘完成矫正操作。矫正之后的特征会再次与FLR进行融合得到输出结果FSR,其表达式为

$$ {{\boldsymbol{F}}_{{\rm{SR}}}} = {{\boldsymbol{F}}_{{\rm{LR}}}} + {\rm{Conv}}({\rm{Concat}}({{\boldsymbol{F}}_{{\rm{LR}}}},{{\boldsymbol{F}}_T})) \odot {\boldsymbol{P}} $$ 式中:Conv和Concat分别代表协卷积和合并操作;⊙表示特征映射之间的元素级相乘,得到输出结果FSR后再经过上采样处理之后得到最终的SR结果图。

1.4 损失函数

图像超分辨率模型最为常用的就是L1、L22种重建损失函数,如果只依赖L1或L2损失函数,模型会根据超分图像与原图像的差值进行约束,生成的图像较为平滑。为恢复出更多的图像细节,本文在重建损失函数的基础上加入了对抗损失函数和感知损失函数,对抗损失函数运用生成对抗网络的思想,通过训练不断优化生成图像,使超分图像更加自然逼真,感知损失函数可以增强生成图像与真实图像特征空间上的相似性从而提升图像整体的视觉质量:

$$ L = {\lambda _{{\rm{rec}}}}{L_{{\rm{rec}}}} + {\lambda _{{\rm{adv}}}}{L_{{\rm{adv}}}} + {\lambda _{{\rm{per}}}}{L_{{\rm{per}}}} $$ 式中:Lrec为重建损失函数;Ladv为对抗损失函数;Lper为感知损失函数;

$\lambda $ 为每个损失函数的权重系数。经过多组实验证明当${\lambda _{{\rm{rec}}}}$ =1,${\lambda _{{\rm{adv}}}}$ =10−3,${\lambda _{{\rm{per}}}}$ =10−2时模型收敛效果最佳。由重建损失函数L1或L2约束的生成图像与真实图像更为近似,L2损失函数计算目标值(HR图像)与实际值(SR图像)之间像素差值的平方,收敛速度会随着训练过程逐渐变慢,并且容易出现梯度爆炸的情况,L1损失函数则是直接计算目标值与实际值之间的像素差值,其性能比L2更为优越,收敛也更稳定,所以本文采用L1作为重建损失函数。

$$ {L_{{\rm{rec}}}} = \frac{1}{{CHW}}{\left\| {{I^{{\rm{HR}}}} - {I^{{\rm{SR}}}}} \right\|_1} $$ 式中:C、H、W分别为图像特征的通道数、长和宽;

$I^{\rm{HR}} $ 为真实图像;$I^{\rm{SR}} $ 为生成图像。基于生成对抗网络的损失函数可以帮助模型生成清晰且视觉效果良好的图像,本文采用的对抗损失函数根据WGAN-GP[24](wasserstein generative adversarial networks-gradient penalty)的思想,运用梯度范数的惩罚来代替权重裁剪,使得网络在获取清晰图像的同时训练更加稳定,性能更加优良。对抗损失函数分为判别器损失函数LD和生成器损失函数LG2部分:

$$ \begin{gathered} {L_D} = \mathop {{\rm{E}}}\limits_{\tilde x \sim {{{P}}_g}} [D(\tilde x)] - \mathop {{{\rm{E}}}}\limits_{x \sim {{{P}}_r}} [D(x)] + \lambda \mathop {{{\rm{E}}}}\limits_{\hat x \sim {{{P}}_{\hat x}}} [{({\left\| {{\nabla _{\hat x}}D(\hat x)} \right\|_2} - 1)^2}] \end{gathered} $$ $$ {L_G} = - \mathop {{{\rm{E}}}}\limits_{\tilde x \sim {{{P}}_g}} [D(\tilde x)] $$ 式中: E[]为分布的期望;Pg为生成图像的分布;Pr为真实样本的分布。训练过程中先由判别器损失函数计算生成图像与真实图像之间的参数,根据得到参数使用优化器优化网络权重从而影响生成器损失函数的分布,随着网络不断训练,生成的图像会越来越真实自然。

感知损失函数可以增强生成图像与真实图像在特征空间上的相似度,使得生成图像在语义上更接近真实图像,改善图像视觉质量。为进一步提高图像特征迁移的准确性,本文在传统感知损失函数的基础上增加了一项约束条件

$\dfrac{1}{{{C_j}{H_j}{W_j}}}\cdot \left\| {\phi _j^{{\rm{vgg}}}({I^{{\rm{SR}}}}) - {{\boldsymbol{F}}_T}} \right\|_2^2$ ,通过计算生成图像与特征迁移之后的特征图FT在特征空间上的欧氏距离,向网络进行反馈并调整网络的权重因子,随着网络的训练,欧氏距离逐渐变小,说明生成图像的特征与FT越来越相似,进而使得网络更有效的迁移相似特征区域。本文采用的感知损失函数为$$ \begin{gathered} {L_{{\rm{per}}}} = \frac{1}{{{C_i}{H_i}{W_i}}}\left\| {\phi _i^{{\rm{vgg}}}({I^{{\rm{SR}}}}) - \phi _i^{{\rm{vgg}}}({I^{{\rm{HR}}}})} \right\|_2^2 + \\ \frac{1}{{{C_j}{H_j}{W_j}}}\left\| {\phi _j^{{\rm{vgg}}}({I^{{\rm{SR}}}}) - {{\boldsymbol{F}}_T}} \right\|_2^2 \end{gathered} $$ 式中:

$\phi _i^{{\rm{vgg}}}(\;)$ 为VGG19第i层提取的特征;$\phi _j^{{\rm{vgg}}}({\text{ }})$ 为VGG19网络第j层提取的特征。2. 实验结果与分析

本文以实验室构建的螺栓图像超分辨处理数据集为基础进行实验,最初的螺栓数据集是通过对输电线路航拍图像进行裁剪、优化获得。本次数据集构建是将初始螺栓数据集分为模糊与清晰2部分,其中模糊部分按照1∶1的比例从清晰图像中选取相似的图像作为参考图像,这些模糊样本作为测试集1;再将清晰部分仿照模糊图像进行模糊处理,本文采用双三次下采样的方法生成模糊样本,并且按照模糊样本和参考图像1∶1的比例从清晰螺栓图像中挑选与模糊样本相似度高但不相同的图像作为参考图像,再按照训练集与测试集2∶1的比例将人工生成的模糊样本划分为训练集和测试集2两部分。最终螺栓图像超分辨率数据集共包含4 000张样本(不包含参考图像),其中训练集包含2 000张,测试集1包含1 000张,测试集2包含1 000张。数据集中所有图像要放缩到相同大小,本次实验将图像统一放缩到分辨率为64×64,为保证特征相似度对比模块可以准确的对比模糊图像与参考图像,参考图像需生成降质图像,具体过程第1节中已经说明。

实验的硬件环境采用Linux Ubuntu16.04操作系统,使用的GPU为2块8 GB内存的NVIDIA GeForce 1080Ti。实验参数中batch-size为9,epoch为100,学习率为10−4。

2.1 螺栓图像超分辨率处理分析

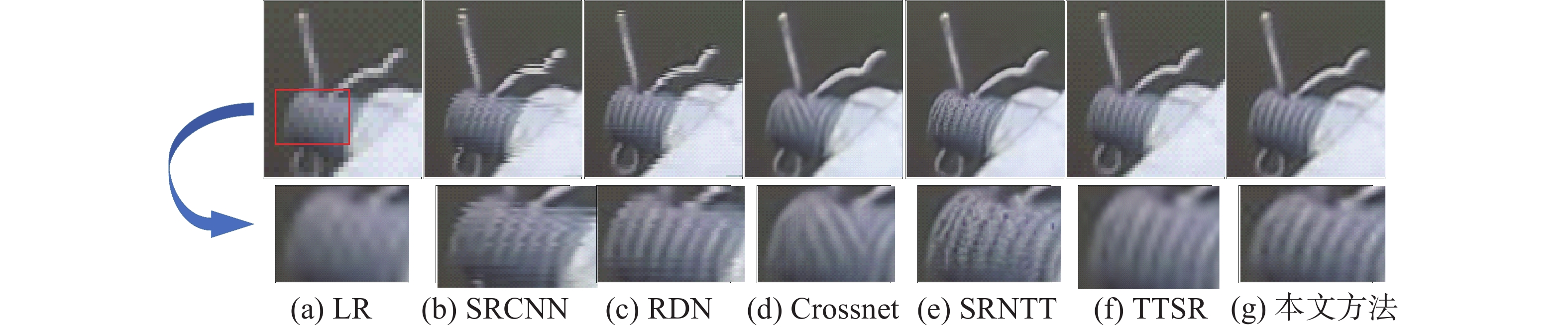

本文对比了多种图像超分辨率模型,包括SISR的SRCNN[13]、RDN[16]和MISR的Crossnet[20]、SRNTT[22]、TTSR[23]。实验应用上述模型分别对螺栓图像进行超分处理,对比了超分后螺栓图像的视觉质量以及峰值信噪比(peak signal-to-noise ratio , PSNR)和结构相似性(structural similarity , SSIM)两指标,图4为应用不同模型的螺栓超分结果,表1为不同模型超分之后的图像指标。

表 1 不同超分辨率模型的螺栓超分图像评估对比Table 1 Comparison of bolt super resolution image evaluation of different super resolution models超分类型 方法 PSNR SSIM SISR SRCNN 24.63 0.755 RDN 26.89 0.784 MISR Crossnet 25.67 0.768 SRNTT 26.13 0.776 TTSR 26.39 0.776 本文方法 26.41 0.781 图4(a)为LR原图,矩形框区域放大后放在下方是为了方便观察图像的细节部分。从图4中可以观察到基于SISR的超分方法出现了波纹状模糊,这是因为螺栓图像较小可提取的特征信息有限,而SISR只提取图像自身信息所以导致超分效果不佳。引入参考图像的超分结果更为优良,显然本文方法的视觉效果最好,最为自然逼真,虽然TTSR的超分图像也有不错的表现,但从放大部分可以看出TTSR生成图像的螺纹较浅,边缘区域也较为模糊,这是因为TTSR迁移的是图像之间的纹理信息,而本文方法则针对螺栓图像的特点,将螺栓的相似特征进行迁移,并且根据相似程度对迁移部分进行矫正,所以生成图像在细节部分更加自然清晰。

表1中加粗标的为该类型超分辨率模型的最高指标数,在MISR中本文提出的超分模型得分最高性能最好,PSNR和SSIM分别为26.41和0.781,但相比SISR中的RDN模型本文提出的方法稍差一些,这是因为SISR是通过提取LR图像特征并上采样得到螺栓超分结果,而MISR引入了参考图像中的特征信息,这些信息会增强图像的视觉效果,让图像看起来更清晰自然,但同时也会影响指标的评定。

本文进行消融实验以验证特征迁移模块和相似度矫正模块的有效性,实验结果如表2所示。本文在基础模型中只加入特征迁移模块时,超分图像的PSNR和SSIM均得到提升,证明了特征迁移模块的有效性,在加入相似度矫正模块后,相似度高的迁移特征得到增强,相似度低的特征被削弱,使得生成图像的质量更高,评价指标进一步提升,也证明了相似度矫正模块可以有效提升模型的性能。

表 2 消融实验Table 2 Ablation experiment方法 PSNR SSIM 基础超分模型 25.52 0.763 加入特征迁移模块 25.95 0.771 加入特征迁移模块及相似度矫正模块 26.41 0.781 实验还比较了不同损失函数下生成的超分图像结果,如图5所示,图5(a)为LR原图,图5(b)~(e)为使用了不同损失函数的超分结果图,图5(b)只使用了Lrec,图5(c)结合了Lrec与Ladv,图5(d)结合了Lrec和Lper,图5(e)为本文使用的损失函数。

从图5(b)中可以观察到只使用重建损失函数的超分结果更为平滑,但也过滤掉了很多细节信息,使得图像看起来不自然;图5(c)出现了很严重的超分伪影,这是因为网络更趋于像素级的相似,缺乏了感知损失函数在图像语义上的关注,使得图像在迁移特征区域时出现误判;图5(d)与图5(e)的视觉效果良好,但图5(d)右下方的螺母部分出现了螺纹伪影,而图5(e)并没有出现,这是因为加入了对抗损失函数,网络生成的图像更贴近真实图像。

2.2 螺栓图像超分辨率在实际缺陷检测中应用

为了更好地验证本方法是有效的,本文将此方法应用到实际问题中加以分析。实验对比了螺栓缺陷分类模型在使用超分图像前后的准确率,通过准确率的变化判断本文超分模型是否有效。螺栓分为正常螺栓、缺销螺栓以及缺螺母螺栓3类,数据集共有6 317张,其中正常螺栓2 990张,缺销螺栓2 797张,缺螺母螺栓530张,训练集和测试集按照4∶1的比例进行划分,其中训练集5 054张,测试集1 263张,测试集中LR图像全部来自于图像超分辨率处理方法的测试集2,这是因为测试集2中的螺栓图像全部是实际采集到的,对这些样本进行测试更能体现出超分方法在实际应用中的效果,测试样例如图6所示。实验先在训练集为LR原图的情况下分别测试螺栓图像超分前后的分类准确率;接着在训练集为SR图像的情况下再次测试超分前后螺栓缺陷图像的分类准确率;最后混合LR与超分后图像做训练集测试超分前后螺栓缺陷图像的分类准确率。螺栓缺陷分类任务使用的是宽残差网络WRN 40-2(wide residual network),这种网络性能优良且计算速度较快,实验参数设定batch-size为16,epoch为100,学习率为0.1,实验结果如表3所示。

表 3 不同训练集图像时不同测试集螺栓缺陷分类准确率Table 3 The accuracy of bolt defect classification in different test sets for different training set images% 训练集图像 测试集图像准确率 LR原图 SR图像 LR原图 93.28 92.81 混合LR与SR图像 93.85 95.25 SR图像 95.94 96.89 表3中显示训练集为LR原图时,以LR图像为测试集的缺陷分类准确率更高,准确率高出0.47%,这是因为训练采用的也为LR原图,在分类模型的训练过程中学习到了螺栓图像的LR特征,超分后的螺栓图像反而和学习到的特征出现了差异,导致准确率略有下降,但十分接近。在训练集中混入超分图像后,螺栓缺陷的分类准确率得到了提升,并且测试图像为超分图像的准确率高于测试集为LR图像的分类准确率。以SR图像为训练集时,测试集为SR图像的螺栓缺陷分类准确率达到96.89%,比测试集为LR原图的准确率高出0.95%,且相较训练集为LR原图时的准确率也有很好的提升。

此外,本文还在其他基线分类模型(resnet50、resnet101、VGG16)下进一步验证了超分方法在螺栓缺陷分类任务中的效果,如表4所示。实验先后在训练集为LR原图和SR图像的情况下,对比了测试集为LR图像和SR图像的准确率。实验结果显示无论哪种基线模型,在使用LR图像进行训练时,对SR图像的识别效果比LR图像的识别效果略高,但两者相差不大;但在使用SR图像进行训练时,对SR图像的识别准确率提升明显,而且准确率最高。

表 4 不同模型的螺栓缺陷分类准确率Table 4 Accuracy of bolt defect classification in different models% 分类模型 训练集图像 测试集图像准确率 LR原图 SR图像 Resnet50 LR原图 90.36 90.53 SR图像 91.23 92.42 Resnet101 LR原图 90.68 90.72 SR图像 90.86 92.51 VGG16 LR原图 88.57 89.12 SR图像 88.96 89.34 本文还将螺栓图像用其他超分模型进行超分,并通过缺陷分类的准确率验证本方法在实际应用中的效果,本次螺栓缺陷分类任务仍使用宽残差网络WRN 40-2进行。如表5所示,使用LR原图直接进行螺栓缺陷分类的准确率为93.28%,使用RDN、SRNTT和TTSR超分之后螺栓缺陷分类的准确率分别为94.57%、93.17%和95.23%,而经过本文超分方法超分之后的螺栓缺陷分类准确率为96.89%,较其他方法要高,这是因为本文超分方法对比了螺栓之间的相似区域,将高分辨率图像上的特征信息向低分辨率图像迁移,既保护了螺栓图像的原始信息,又提升了图像的分辨率和可分析性,自然可以在实际应用中被更好地识别分类。上述实验结果可以说明,本文提出的超分辨率方法在实际的螺栓缺陷分类任务中具有良好成效,在保证原图像信息不被破坏的前提下,通过迁移相似螺栓的特征有效提升了螺栓图像的分辨率与可分析性。

表 5 不同超分模型超分之后螺栓缺陷分类准确率Table 5 Accuracy of bolt defect classification after super resolution of different super resolution models% 超分模型 螺栓图像分类准确率 未使用超分模型 93.28 RDN 94.57 SRNTT 93.17 TTSR 95.23 本文方法 96.89 3. 结束语

本文首次将特征迁移引入螺栓图像超分中,针对航拍输电线路螺栓图像存在分辨率低,模糊不清的问题,根据螺栓之间存在相似特征的特点,提出了一种基于特征迁移的螺栓图像超分变率方法,再根据迁移特征相似程度进行矫正,增强相关特征抑制无关特征,然后在损失函数中加入对抗损失函数和感知损失函数,并在感知损失函数中加入了迁移相似特征的约束,在保护图像自身信息不被破坏的同时提升螺栓图像分辨率。实验结果显示本文提出的方法可以有效提升图像分辨率,对提升输电线路螺栓缺陷分类准确率有积极意义。未来,我们将进一步优化网络模型,并且研究在图像特征迁移时如何有针对性的将前景部分进行迁移,实现对图像局部信息的超分辨率处理。

-

表 1 不同超分辨率模型的螺栓超分图像评估对比

Table 1 Comparison of bolt super resolution image evaluation of different super resolution models

超分类型 方法 PSNR SSIM SISR SRCNN 24.63 0.755 RDN 26.89 0.784 MISR Crossnet 25.67 0.768 SRNTT 26.13 0.776 TTSR 26.39 0.776 本文方法 26.41 0.781 表 2 消融实验

Table 2 Ablation experiment

方法 PSNR SSIM 基础超分模型 25.52 0.763 加入特征迁移模块 25.95 0.771 加入特征迁移模块及相似度矫正模块 26.41 0.781 表 3 不同训练集图像时不同测试集螺栓缺陷分类准确率

Table 3 The accuracy of bolt defect classification in different test sets for different training set images

% 训练集图像 测试集图像准确率 LR原图 SR图像 LR原图 93.28 92.81 混合LR与SR图像 93.85 95.25 SR图像 95.94 96.89 表 4 不同模型的螺栓缺陷分类准确率

Table 4 Accuracy of bolt defect classification in different models

% 分类模型 训练集图像 测试集图像准确率 LR原图 SR图像 Resnet50 LR原图 90.36 90.53 SR图像 91.23 92.42 Resnet101 LR原图 90.68 90.72 SR图像 90.86 92.51 VGG16 LR原图 88.57 89.12 SR图像 88.96 89.34 表 5 不同超分模型超分之后螺栓缺陷分类准确率

Table 5 Accuracy of bolt defect classification after super resolution of different super resolution models

% 超分模型 螺栓图像分类准确率 未使用超分模型 93.28 RDN 94.57 SRNTT 93.17 TTSR 95.23 本文方法 96.89 -

[1] 王毅, 陈启鑫, 张宁, 等. 5G通信与泛在电力物联网的融合: 应用分析与研究展望[J]. 电网技术, 2019, 43(5): 1575–1585. WANG Yi, CHEN Qixin, ZHANG Ning, et al. Fusion of the 5G communication and the ubiquitous electric internet of things: application analysis and research prospects[J]. Power system technology, 2019, 43(5): 1575–1585. [2] 仝卫国, 苑津莎, 李宝树. 图像处理技术在直升机巡检输电线路中的应用综述[J]. 电网技术, 2010, 34(12): 204–208. TONG Weiguo, YUAN Jinsha, LI Baoshu. Application of image processing in patrol inspection of overhead transmission line by helicopter[J]. Power system technology, 2010, 34(12): 204–208. [3] 赵振兵, 段记坤, 孔英会, 等. 基于门控图神经网络的栓母对知识图谱构建与应用[J]. 电网技术, 2021, 45(1): 98–106. doi: 10.13335/j.1000-3673.pst.2020.0063 ZHAO Zhenbing, DUAN Jikun, KONG Yinghui, et al. Construction and application of bolt and nut pair knowledge graph based on GGNN[J]. Power system technology, 2021, 45(1): 98–106. doi: 10.13335/j.1000-3673.pst.2020.0063 [4] 赵振兵, 金超熊, 戚银城, 等. 基于动态监督知识蒸馏的输电线路螺栓缺陷图像分类[J]. 高电压技术, 2021, 47(2): 406–414. doi: 10.13336/j.1003-6520.hve.20200834 ZHAO Zhenbing, JIN Chaoxiong, QI Yincheng, et al. Image classification of transmission line bolt defects based on dynamic supervision knowledge distillation[J]. High voltage engineering, 2021, 47(2): 406–414. doi: 10.13336/j.1003-6520.hve.20200834 [5] DONG Weisheng, ZHANG Lei, LUKAC R, et al. Sparse representation based image interpolation with nonlocal autoregressive modeling[J]. IEEE transactions on image processing:a publication of the IEEE signal processing society, 2013, 22(4): 1382–1394. doi: 10.1109/TIP.2012.2231086 [6] WANG Lingfeng, WU Huaiyu, PAN Chunhong. Fast image upsampling via the displacement field[J]. IEEE transactions on image processing, 2014, 23(12): 5123–5135. doi: 10.1109/TIP.2014.2360459 [7] ZHANG Yunfeng, FAN Qinglan, BAO Fangxun, et al. Single-image super-resolution based on rational fractal interpolation[J]. IEEE transactions on image processing:a publication of the IEEE signal processing society, 2018, 27(8): 3782–3797. doi: 10.1109/TIP.2018.2826139 [8] 赵志辉, 赵瑞珍, 岑翼刚, 等. 基于稀疏表示与线性回归的图像快速超分辨率重建[J]. 智能系统学报, 2017, 63(1): 8–14. ZHAO Zhihui, ZHAO Ruizhen, CEN Yigang. Rapid super-resolution image reconstruction based on sparse representation and linear regression[J]. CAAI transactions on intelligent systems, 2017, 63(1): 8–14. [9] RASTI P, DEMIREL H, ANBARJAFARI G. Improved iterative back projection for video super-resolution[C]//2014 22nd Signal Processing and Communications Applications Conference. Piscataway: IEEE, 2014: 552−555. [10] DONG Weisheng, ZHANG Lei, SHI Guangming, et al. Nonlocally centralized sparse representation for image restoration[J]. IEEE transactions on image processing, 2013, 22(4): 1620–1630. doi: 10.1109/TIP.2012.2235847 [11] YANOVSKY I, LAMBRIGTSEN B H, TANNER A B, et al. Efficient deconvolution and super-resolution methods in microwave imagery[J]. IEEE journal of selected topics in applied earth observations and remote sensing, 2015, 8(9): 4273–4283. doi: 10.1109/JSTARS.2015.2424451 [12] ZHAO Ningning, WEI Qi, BASARAB A, et al. Fast single image super-resolution using a new analytical solution for problems[J]. IEEE transactions on image processing, 2016, 25(8): 3683–3697. doi: 10.1109/TIP.2016.2567075 [13] DONG Chao, LOY C C, HE Kaiming, et al. Image super-resolution using deep convolutional networks[J]. IEEE transactions on pattern analysis and machine intelligence, 2016, 38(2): 295–307. doi: 10.1109/TPAMI.2015.2439281 [14] KIM J, LEE J K, LEE K M. Accurate image super-resolution using very deep convolutional networks[C]//2016 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE, 2016: 1646−1654. [15] LIM B, SON S, KIM H, et al. Enhanced deep residual networks for single image super-resolution[C]//2017 IEEE Conference on Computer Vision and Pattern Recognition Workshops. Piscataway: IEEE, 2017: 1132−1140. [16] ZHANG Yulun, TIAN Yapeng, KONG Yu, et al. Residual dense network for image super-resolution[C]//2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE, 2018: 2472−2481. [17] GUO Yong, CHEN Jian, WANG Jingdong, et al. Closed-loop matters: dual regression networks for single image super-resolution[C]//2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE, 2020: 5406−5415. [18] FREEMAN W T, JONES T R, PASZTOR E C. Example-based super-resolution[J]. IEEE computer graphics and applications, 2002, 22(2): 56–65. doi: 10.1109/38.988747 [19] YUE Huanjing, SUN Xiaoyan, YANG Jingyu, et al. Landmark image super-resolution by retrieving web images[J]. IEEE transactions on image processing, 2013, 22(12): 4865–4878. doi: 10.1109/TIP.2013.2279315 [20] ZHENG Haitian, JI Mengqi, WANG Haoqian, et al. CrossNet: an end-to-end reference-based super resolution network using cross-scale warping[EB/OL]. (2018-01-27)[2022-01-05]. https://arxiv.org/abs/1807.10547. [21] YUE Huanjing, LIU Jianjun, YANG Jingyu, et al. IENet: internal and external patch matching ConvNet for web image guided denoising[J]. IEEE transactions on circuits and systems for video technology, 2020, 30(11): 3928–3942. doi: 10.1109/TCSVT.2019.2930305 [22] ZHANG Zhifei, WANG Zhaowen, LIN Zhe, et al. Image super-resolution by neural texture transfer[C]//2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE, 2020: 7974−7983. [23] YANG Fuzhi, YANG Huan, FU Jianlong, et al. Learning texture transformer network for image super-resolution[C]//2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE, 2020: 5790−5799. [24] GULRAJANI I, AHMED F, ARJOVSKY M, et al. Improved training of Wasserstein GANs[C]//Proceedings of the 31st International Conference on Neural Information Processing Systems. New York: ACM, 2017: 5769−5779.

下载:

下载: